背景意义

随着全球经济的快速发展和电子商务的蓬勃兴起,条形码作为商品识别和信息追踪的重要工具,已广泛应用于零售、物流、生产等多个领域。条形码的高效检测与识别不仅能够提升商品管理的效率,还能为消费者提供更为便捷的购物体验。然而,传统的条形码检测方法往往依赖于特定的光照条件和清晰的图像质量,容易受到环境因素的影响,导致识别率降低。因此,开发一种高效、鲁棒的条形码检测系统显得尤为重要。

近年来,深度学习技术的迅猛发展为计算机视觉领域带来了新的机遇,尤其是目标检测算法的不断演进,使得条形码检测的准确性和实时性得到了显著提升。YOLO(You Only Look Once)系列模型以其快速的检测速度和较高的精度,成为目标检测领域的热门选择。特别是YOLOv11模型在多个数据集上的表现,展示了其在复杂场景下的优越性。然而,针对条形码的特殊性,YOLOv11模型仍需进行改进,以适应不同的环境和条形码类型。

本研究旨在基于改进的YOLOv11模型,构建一个高效的条形码检测系统。通过对1100张图像的训练数据集进行分析与处理,针对条形码的特征进行优化,提升模型在不同光照、角度和背景下的检测能力。该系统不仅能够实现快速、准确的条形码识别,还能为后续的智能化管理提供数据支持,推动条形码技术在各行业的应用。综上所述,本研究不仅具有重要的理论意义,也为实际应用提供了切实可行的解决方案,具有广泛的应用前景和社会价值。

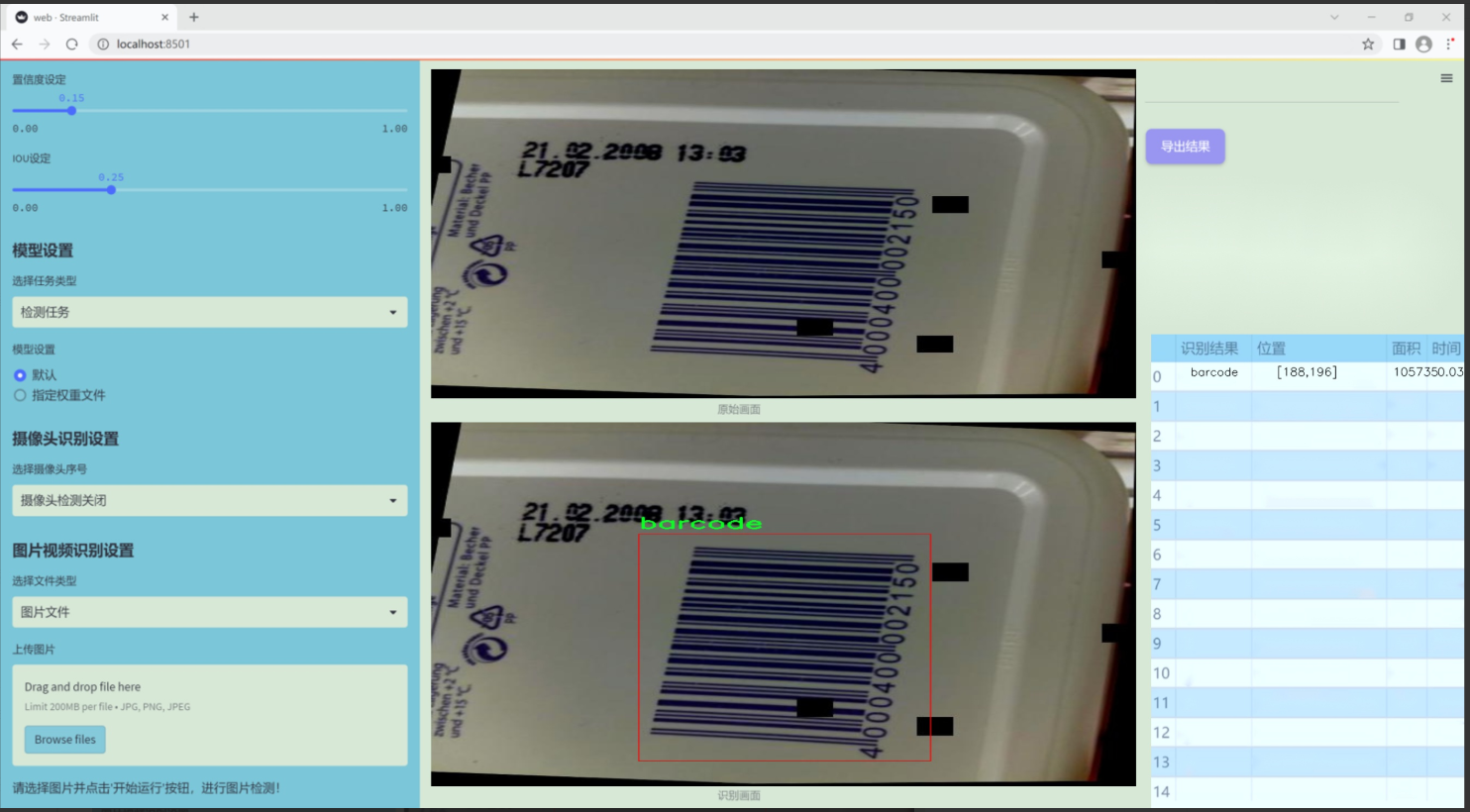

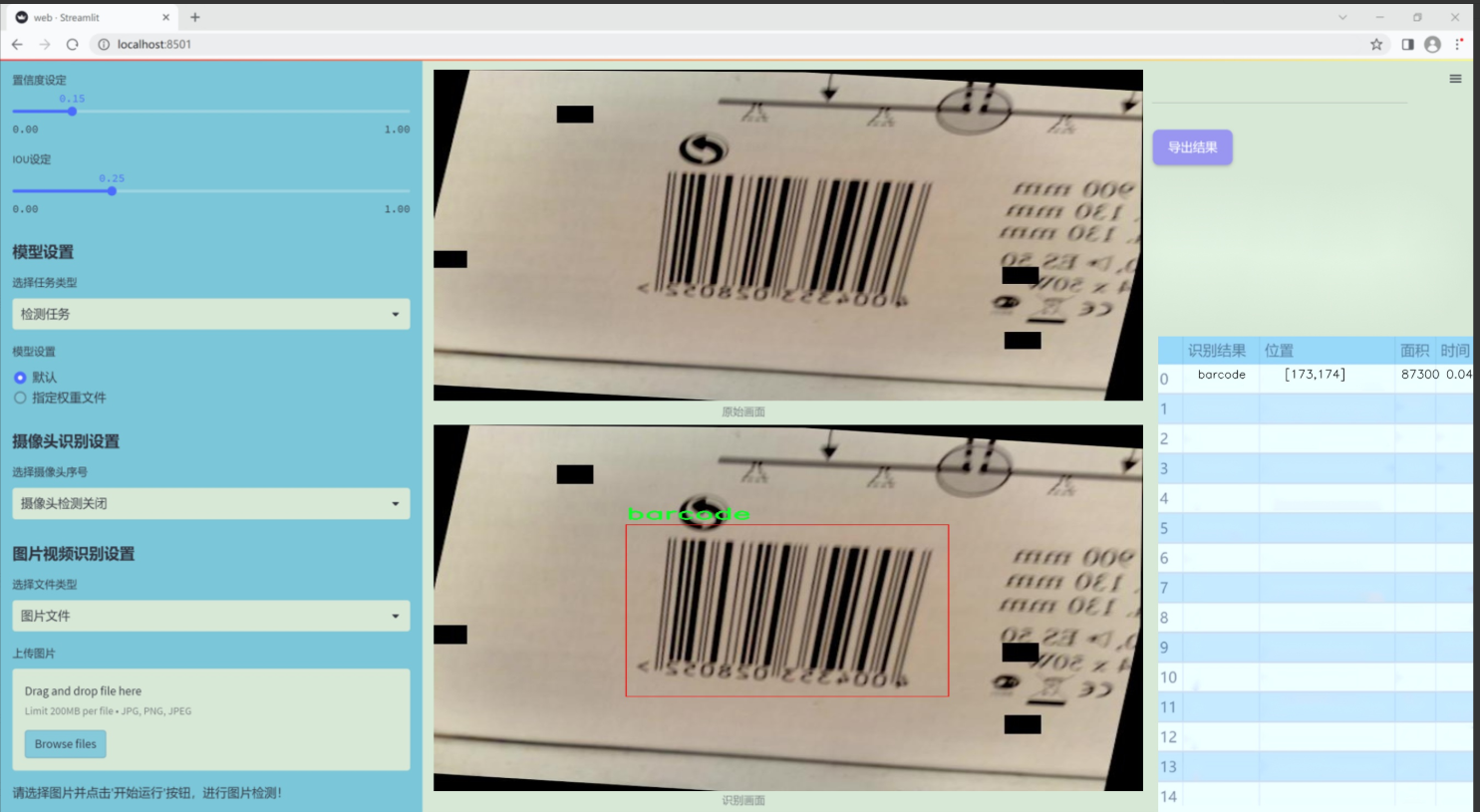

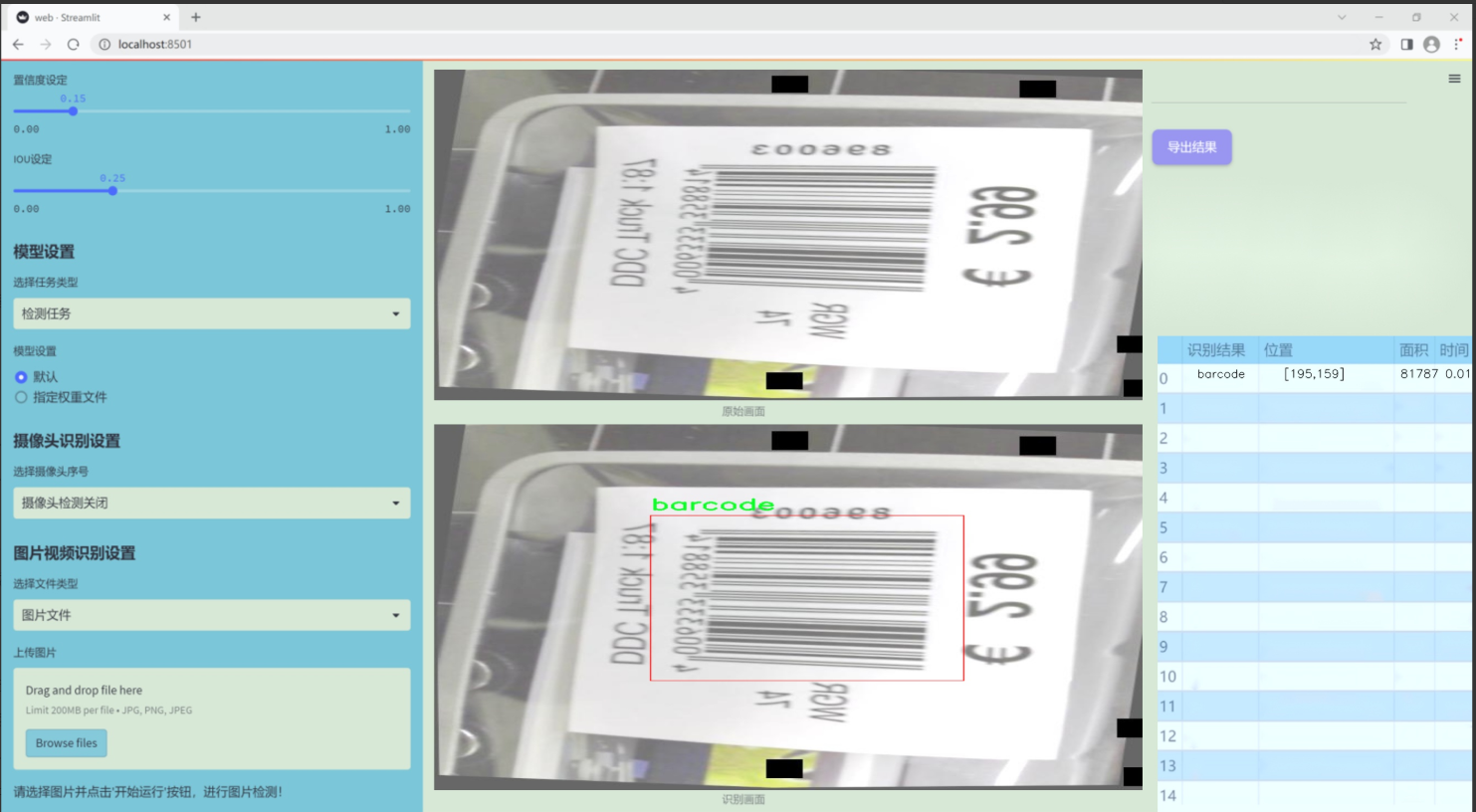

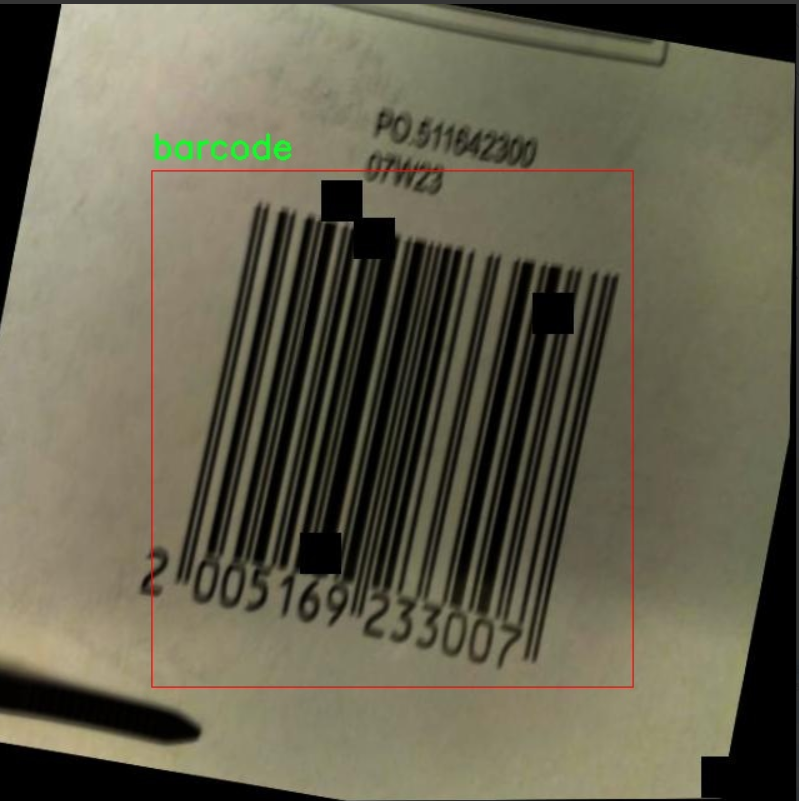

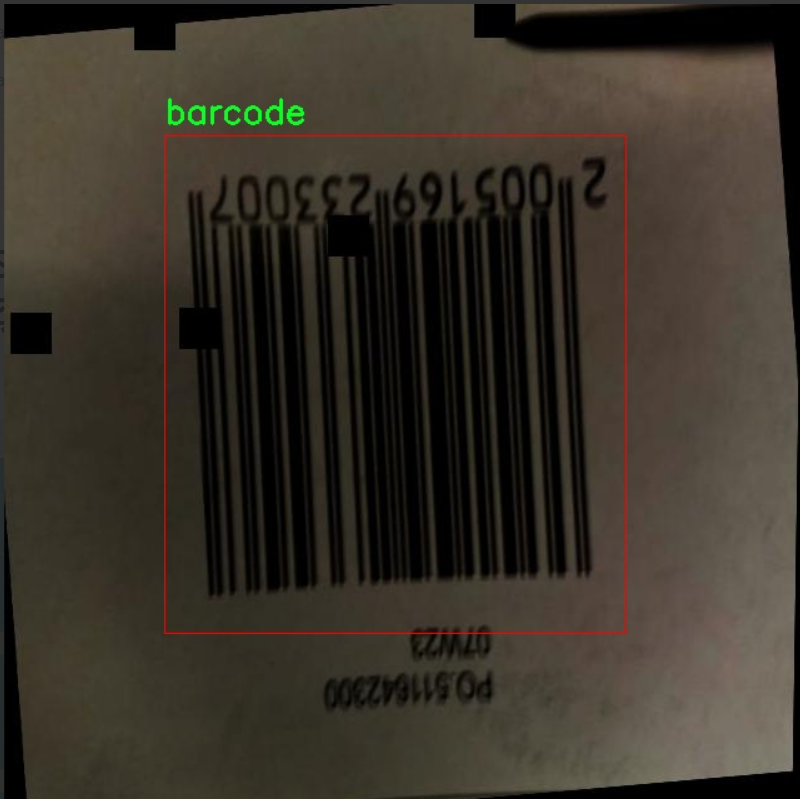

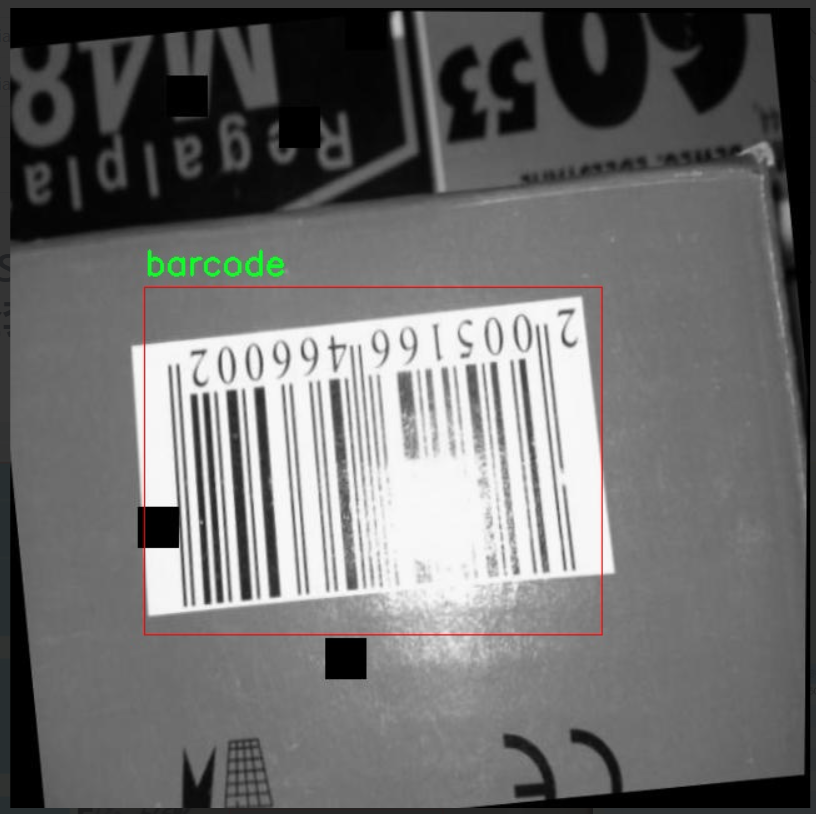

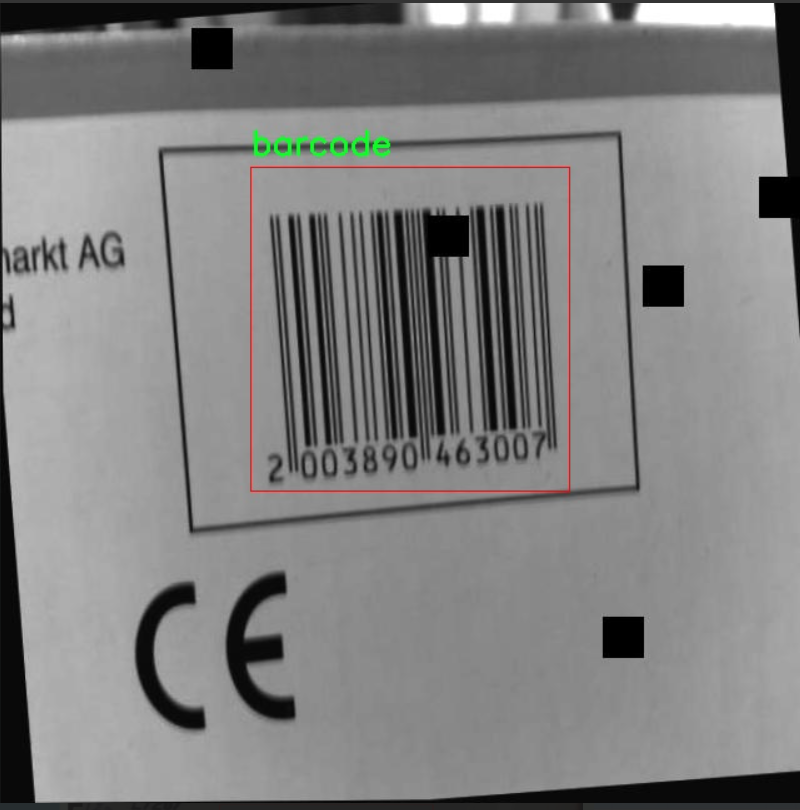

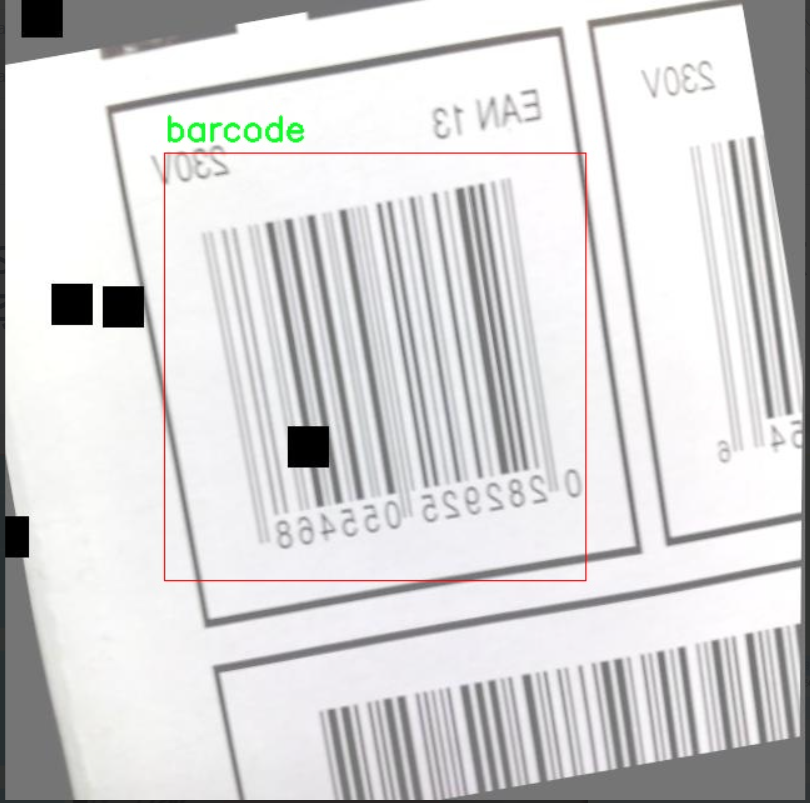

图片效果

数据集信息

本项目采用的数据集名为"skripsi2",旨在为改进YOLOv11的条形码检测系统提供高质量的训练数据。该数据集专注于条形码的识别与检测,包含了丰富的条形码样本,确保模型在多种场景下的鲁棒性和准确性。数据集中目前仅包含一个类别,即"barcode",这使得模型在训练过程中能够专注于条形码的特征提取与学习,减少了因类别多样性带来的复杂性。

"skripsi2"数据集的构建经过精心设计,涵盖了不同类型和尺寸的条形码图像。这些图像不仅来自于标准的商品条形码,还包括了各种环境下的实际应用场景,如超市、仓库和物流中心等。这种多样化的图像来源确保了数据集的代表性,使得训练后的YOLOv11模型能够在真实世界中有效地识别和检测条形码。

在数据集的标注过程中,所有条形码图像均经过专业人员的仔细审核与标注,确保每个条形码的边界框准确无误。这种高质量的标注对于模型的训练至关重要,能够显著提高模型的检测精度和召回率。此外,数据集还考虑到了不同光照条件、背景复杂度以及条形码损坏程度等因素,进一步增强了模型的适应能力。

通过使用"skripsi2"数据集,研究团队期望能够训练出一个高效且精准的条形码检测系统,为各类商业和工业应用提供强有力的技术支持。最终,改进后的YOLOv11模型将为条形码的自动识别与处理带来显著的提升,推动相关领域的技术进步与应用发展。

核心代码

以下是经过简化并添加详细中文注释的核心代码部分:

import torch

import torch.nn as nn

class DySnakeConv(nn.Module):

def init (self, inc, ouc, k=3) -> None:

super().init ()

初始化三个卷积层

self.conv_0 = Conv(inc, ouc, k) # 标准卷积

self.conv_x = DSConv(inc, ouc, 0, k) # 沿x轴的动态蛇形卷积

self.conv_y = DSConv(inc, ouc, 1, k) # 沿y轴的动态蛇形卷积

def forward(self, x):

# 前向传播,连接三个卷积的输出

return torch.cat([self.conv_0(x), self.conv_x(x), self.conv_y(x)], dim=1)class DSConv(nn.Module):

def init (self, in_ch, out_ch, morph, kernel_size=3, if_offset=True, extend_scope=1):

"""

动态蛇形卷积

:param in_ch: 输入通道数

:param out_ch: 输出通道数

:param kernel_size: 卷积核大小

:param extend_scope: 扩展范围(默认1)

:param morph: 卷积核的形态,0表示沿x轴,1表示沿y轴

:param if_offset: 是否需要偏移,False表示标准卷积

"""

super(DSConv, self).init ()

用于学习可变形偏移的卷积层

self.offset_conv = nn.Conv2d(in_ch, 2 * kernel_size, 3, padding=1)

self.bn = nn.BatchNorm2d(2 * kernel_size) # 批归一化

self.kernel_size = kernel_size

# 定义沿x轴和y轴的动态蛇形卷积

self.dsc_conv_x = nn.Conv2d(in_ch, out_ch, kernel_size=(kernel_size, 1), stride=(kernel_size, 1), padding=0)

self.dsc_conv_y = nn.Conv2d(in_ch, out_ch, kernel_size=(1, kernel_size), stride=(1, kernel_size), padding=0)

self.gn = nn.GroupNorm(out_ch // 4, out_ch) # 组归一化

self.act = Conv.default_act # 默认激活函数

self.extend_scope = extend_scope

self.morph = morph

self.if_offset = if_offset

def forward(self, f):

# 前向传播

offset = self.offset_conv(f) # 计算偏移

offset = self.bn(offset) # 批归一化

offset = torch.tanh(offset) # 将偏移限制在[-1, 1]之间

input_shape = f.shape

dsc = DSC(input_shape, self.kernel_size, self.extend_scope, self.morph) # 创建DSC对象

deformed_feature = dsc.deform_conv(f, offset, self.if_offset) # 进行可变形卷积

# 根据形态选择对应的卷积操作

if self.morph == 0:

x = self.dsc_conv_x(deformed_feature.type(f.dtype))

else:

x = self.dsc_conv_y(deformed_feature.type(f.dtype))

x = self.gn(x) # 组归一化

x = self.act(x) # 激活

return xclass DSC(object):

def init (self, input_shape, kernel_size, extend_scope, morph):

self.num_points = kernel_size # 卷积核的点数

self.width = input_shape[2] # 输入特征图的宽度

self.height = input_shape[3] # 输入特征图的高度

self.morph = morph # 卷积核形态

self.extend_scope = extend_scope # 偏移扩展范围

# 定义特征图的形状

self.num_batch = input_shape[0] # 批量大小

self.num_channels = input_shape[1] # 通道数

def deform_conv(self, input, offset, if_offset):

# 进行可变形卷积

y, x = self._coordinate_map_3D(offset, if_offset) # 计算坐标图

deformed_feature = self._bilinear_interpolate_3D(input, y, x) # 双线性插值

return deformed_feature

def _coordinate_map_3D(self, offset, if_offset):

# 计算3D坐标图

# 省略具体实现细节...

pass

def _bilinear_interpolate_3D(self, input_feature, y, x):

# 进行3D双线性插值

# 省略具体实现细节...

pass代码说明:

DySnakeConv: 这是一个动态蛇形卷积的模块,包含三个卷积层:标准卷积、沿x轴的动态卷积和沿y轴的动态卷积。在前向传播中,它将这三个卷积的输出连接在一起。

DSConv: 这是动态蛇形卷积的具体实现。它通过一个卷积层来学习偏移,并根据偏移计算变形后的特征图。根据形态参数选择不同的卷积操作。

DSC: 这是一个辅助类,用于处理坐标映射和双线性插值,完成可变形卷积的具体计算。

注释中详细解释了每个部分的功能和参数,便于理解代码的整体结构和逻辑。

这个程序文件 dynamic_snake_conv.py 实现了一个动态蛇形卷积(Dynamic Snake Convolution)模块,主要用于深度学习中的卷积操作。文件中定义了两个主要的类:DySnakeConv 和 DSConv,以及一个辅助类 DSC。

首先,DySnakeConv 类是一个神经网络模块,继承自 nn.Module。在初始化方法中,它接收输入通道数 inc、输出通道数 ouc 和卷积核大小 k。该类内部定义了三个卷积层:conv_0 是标准卷积,conv_x 和 conv_y 是动态蛇形卷积,分别沿着 x 轴和 y 轴进行卷积。在前向传播方法 forward 中,它将输入 x 通过这三个卷积层进行处理,并将结果在通道维度上拼接,形成最终的输出。

接下来,DSConv 类也是一个卷积模块,专注于实现动态蛇形卷积。它的构造函数接收输入通道、输出通道、卷积核大小、形态参数、是否使用偏移量以及扩展范围等参数。该类内部首先定义了一个用于学习偏移量的卷积层 offset_conv,然后定义了两个卷积层 dsc_conv_x 和 dsc_conv_y,分别用于处理 x 轴和 y 轴的动态卷积。

在 DSConv 的前向传播方法中,首先通过 offset_conv 计算出偏移量,并进行批归一化处理。接着,使用 torch.tanh 将偏移量限制在 -1 到 1 的范围内。然后,创建一个 DSC 对象,用于生成坐标图,并进行双线性插值以实现变形卷积。根据形态参数的不同,选择相应的卷积层进行处理,最后返回卷积结果。

DSC 类是实现动态蛇形卷积的核心部分。它负责生成坐标图和进行双线性插值。该类的初始化方法接收输入形状、卷积核大小、扩展范围和形态参数。它包含两个主要的方法:_coordinate_map_3D 和 _bilinear_interpolate_3D。前者根据偏移量生成新的坐标图,后者则根据生成的坐标图对输入特征图进行双线性插值,得到变形后的特征图。

总的来说,这个文件实现了一个灵活的卷积操作,可以根据输入特征图的形状和偏移量动态调整卷积核的位置,从而增强模型对形状变化的适应能力。这种方法在处理图像等具有空间结构的数据时,能够有效提高卷积神经网络的表现。

10.4 CTrans.py

以下是提取出的核心代码部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import numpy as np

from torch.nn import Dropout, Softmax, Conv2d, LayerNorm

class Channel_Embeddings(nn.Module):

"""构建来自补丁和位置嵌入的嵌入层。"""

def init (self, patchsize, img_size, in_channels):

super().init ()

img_size = (img_size, img_size) # 将图像大小转换为元组

patch_size = (patchsize, patchsize) # 将补丁大小转换为元组

n_patches = (img_size[0] // patch_size[0]) * (img_size[1] // patch_size[1]) # 计算补丁数量

# 定义补丁嵌入层

self.patch_embeddings = nn.Sequential(

nn.MaxPool2d(kernel_size=5, stride=5), # 最大池化层

Conv2d(in_channels=in_channels,

out_channels=in_channels,

kernel_size=patchsize // 5,

stride=patchsize // 5) # 卷积层

)

# 定义位置嵌入参数

self.position_embeddings = nn.Parameter(torch.zeros(1, n_patches, in_channels))

self.dropout = Dropout(0.1) # Dropout层

def forward(self, x):

"""前向传播函数"""

if x is None:

return None

x = self.patch_embeddings(x) # 通过补丁嵌入层

x = x.flatten(2) # 展平

x = x.transpose(-1, -2) # 转置

embeddings = x + self.position_embeddings # 添加位置嵌入

embeddings = self.dropout(embeddings) # 应用Dropout

return embeddingsclass Attention_org(nn.Module):

"""自定义注意力机制"""

def init (self, vis, channel_num):

super(Attention_org, self).init ()

self.vis = vis # 可视化标志

self.KV_size = sum(channel_num) # K和V的总大小

self.channel_num = channel_num # 通道数量

self.num_attention_heads = 4 # 注意力头的数量

# 定义查询、键、值的线性变换

self.query = nn.ModuleList([nn.Linear(c, c, bias=False) for c in channel_num])

self.key = nn.Linear(self.KV_size, self.KV_size, bias=False)

self.value = nn.Linear(self.KV_size, self.KV_size, bias=False)

self.softmax = Softmax(dim=3) # Softmax层

self.attn_dropout = Dropout(0.1) # Dropout层

def forward(self, *embeddings):

"""前向传播函数"""

multi_head_Q = [query(emb) for query, emb in zip(self.query, embeddings) if emb is not None]

multi_head_K = self.key(torch.cat(embeddings, dim=2)) # 计算K

multi_head_V = self.value(torch.cat(embeddings, dim=2)) # 计算V

# 计算注意力分数

attention_scores = [torch.matmul(Q, multi_head_K) / np.sqrt(self.KV_size) for Q in multi_head_Q]

attention_probs = [self.softmax(score) for score in attention_scores] # 计算注意力概率

# 应用Dropout

attention_probs = [self.attn_dropout(prob) for prob in attention_probs]

# 计算上下文层

context_layers = [torch.matmul(prob, multi_head_V) for prob in attention_probs]

return context_layersclass Encoder(nn.Module):

"""编码器类"""

def init (self, vis, channel_num):

super(Encoder, self).init ()

self.vis = vis

self.layer = nn.ModuleList([Block_ViT(vis, channel_num)]) # 添加一个Block_ViT层

def forward(self, *embeddings):

"""前向传播函数"""

for layer_block in self.layer:

embeddings = layer_block(*embeddings) # 通过每个层块

return embeddingsclass ChannelTransformer(nn.Module):

"""通道变换器类"""

def init (self, channel_num=[64, 128, 256, 512], img_size=640, vis=False, patchSize=[40, 20, 10, 5]):

super().init ()

self.embeddings = nn.ModuleList([Channel_Embeddings(patchSize[i], img_size // (2 ** (i + 2)), channel_num[i]) for i in range(len(channel_num))])

self.encoder = Encoder(vis, channel_num) # 初始化编码器

def forward(self, en):

"""前向传播函数"""

embeddings = [embedding(en[i]) for i, embedding in enumerate(self.embeddings) if en[i] is not None]

encoded = self.encoder(*embeddings) # 编码

return encoded代码注释说明:

Channel_Embeddings: 该类负责从输入图像中提取补丁和位置嵌入。使用卷积和池化层来生成补丁嵌入,并将位置嵌入添加到补丁嵌入中。

Attention_org: 该类实现了自定义的多头注意力机制,计算输入嵌入的注意力分数,并生成上下文层。

Encoder: 该类负责将多个层块组合在一起以进行特征提取。

ChannelTransformer: 该类是整个模型的主要结构,负责初始化嵌入层和编码器,并在前向传播中处理输入数据。

以上代码保留了核心功能,去除了冗余部分,并提供了详细的中文注释以便理解。

这个程序文件 CTrans.py 实现了一个基于通道的变换器(Channel Transformer),主要用于图像处理任务。程序中定义了多个类,每个类负责不同的功能,下面是对代码的逐步讲解。

首先,文件导入了一些必要的库,包括 torch 和 torch.nn,这些是 PyTorch 框架的核心模块,用于构建和训练神经网络。文件的开头部分还包含了一些编码声明和作者信息。

接下来,定义了 Channel_Embeddings 类。这个类的主要功能是从输入图像中构建通道嵌入。它通过最大池化和卷积操作将输入图像划分为多个补丁,并为每个补丁添加位置嵌入。位置嵌入是一个可学习的参数,帮助模型理解补丁在图像中的位置。forward 方法负责处理输入数据,返回嵌入后的结果。

然后是 Reconstruct 类,它的作用是重建特征图。该类通过卷积和上采样操作将嵌入的特征图恢复到原始图像的尺寸。它使用了批归一化和 ReLU 激活函数来增强模型的非线性表达能力。

接下来是 Attention_org 类,这是实现多头注意力机制的核心部分。它接收多个嵌入作为输入,计算注意力分数,并通过 softmax 函数得到注意力权重。注意力机制使得模型能够关注输入特征中的重要部分,从而提高性能。该类还包含了一些用于可视化的选项,能够返回注意力权重以供分析。

Mlp 类实现了一个简单的多层感知机(MLP),用于特征的进一步处理。它包含两个全连接层和一个激活函数(GELU),并在每个层之间使用 dropout 来防止过拟合。

Block_ViT 类是一个变换器块,包含了注意力层和前馈网络。它通过残差连接将输入和输出结合起来,确保信息能够在网络中有效传递。每个嵌入都经过层归一化处理,以提高训练的稳定性。

Encoder 类则是多个变换器块的堆叠,负责对输入的嵌入进行编码。它将每个块的输出进行归一化,并在可视化模式下收集注意力权重。

ChannelTransformer 类是整个模型的主体,负责将输入图像划分为多个通道,并通过嵌入、编码和重建过程处理这些通道。它将所有的嵌入、编码和重建模块组合在一起,形成一个完整的处理流程。

最后,GetIndexOutput 类是一个简单的模块,用于从模型的输出中提取特定索引的结果。

总体来说,这个程序实现了一个复杂的通道变换器模型,利用注意力机制和多层感知机来处理图像数据,具有很强的灵活性和可扩展性。

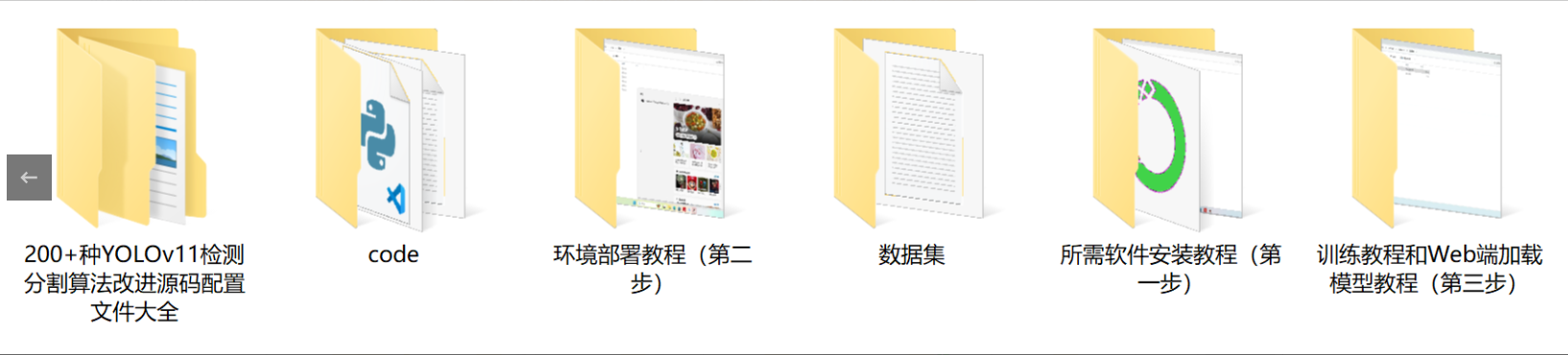

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论 啦 、查看👇🏻获取联系方式