Google提示词白皮书总结(2)

一.自我一致性

LLM在各种NLP中取得了令人瞩目的成果,但是他们的推理能力被视为一个仅靠增加模型大小无法解决的问题,通过之前文章的COT技术可以提示模型生成像人类解决问题一样的推理步骤。然而COT使用简单的贪婪解码会限制有效性,自我一致性通过结合采样和多数投票赖声川多样化的推理路径,并选择最一致的答案,提高了LLM生成相应的准确性和连贯性。

- 生成多样化的推理路径------多次向LLM提供相同的提示。高温度设置鼓励模型生成不同的推理路径和对问题的不同视角。

- 从生成的响应中提取答案。

- 选择最常见的答案。

类似投票制度

示例即使采用零样本COT,在高温下也可能得出不太正确或者不太稳健的结论,生成多个推理路径并进行多数投票提供更稳健的最终答案。

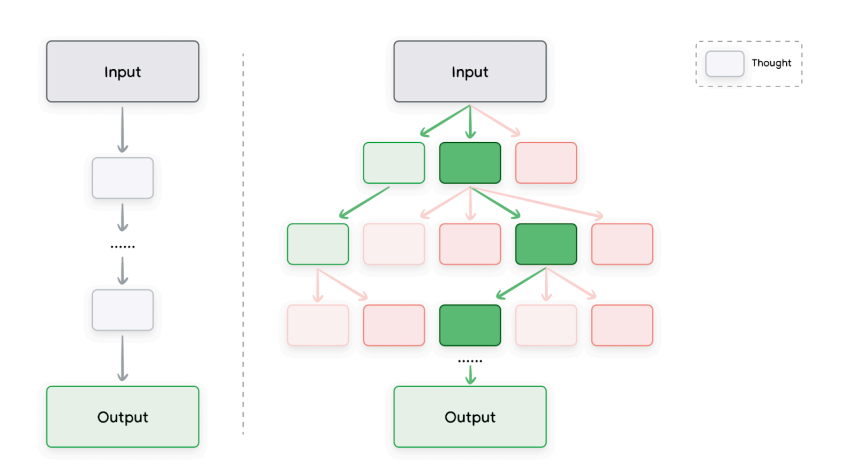

二.思维树

现在我们熟悉了思维链和自我一致性提示,让我们回顾思维树,它泛化了 CoT 提示的概念,因为它允许 LLM 同时探索多个不同的推理路径,而不仅仅是遵循单一的线性思维链。这在图 1 中有所描绘 。ToT 从线性或独立的推理路径转向更结构化的探索策略。它允许模型在每一步考虑替代方案,可能回溯,并评估不同的分支,模仿更深思熟虑的人类解决问题的方法 。

三.ReAct(推理与行动-reason&act)

推理与行动提示是一种范式,使LLM能够通过自然语言与外部工具结合来解决复杂任务,执行某种操作,这是卖相agent的第一步,ReAct 从根本上扩展了LLM 的能力,允许它们与外部世界(或特定工具)交互以收集信息或执行仅靠文本生成无法完成的操作。这将推理过程置于实时、外部数据的基础之上。

ex:

from langchain.agents import load_tools

from langchain.agents import initialize_agent

from langchain.agents import AgentType

from langchain.llms import VertexAI

prompt = "How many kids do the band members of Metallica have "

llm =VertexAI(temperature = 0.1)

tools = load_tools(["serpapi"],llm=llm)

agent = initialize_agent(tools,llm,agent = AgentType.ZERO_SHOT_REACT_DESCRIPTION,verbose = True)

agent.run(prompt)四.自动提示工程

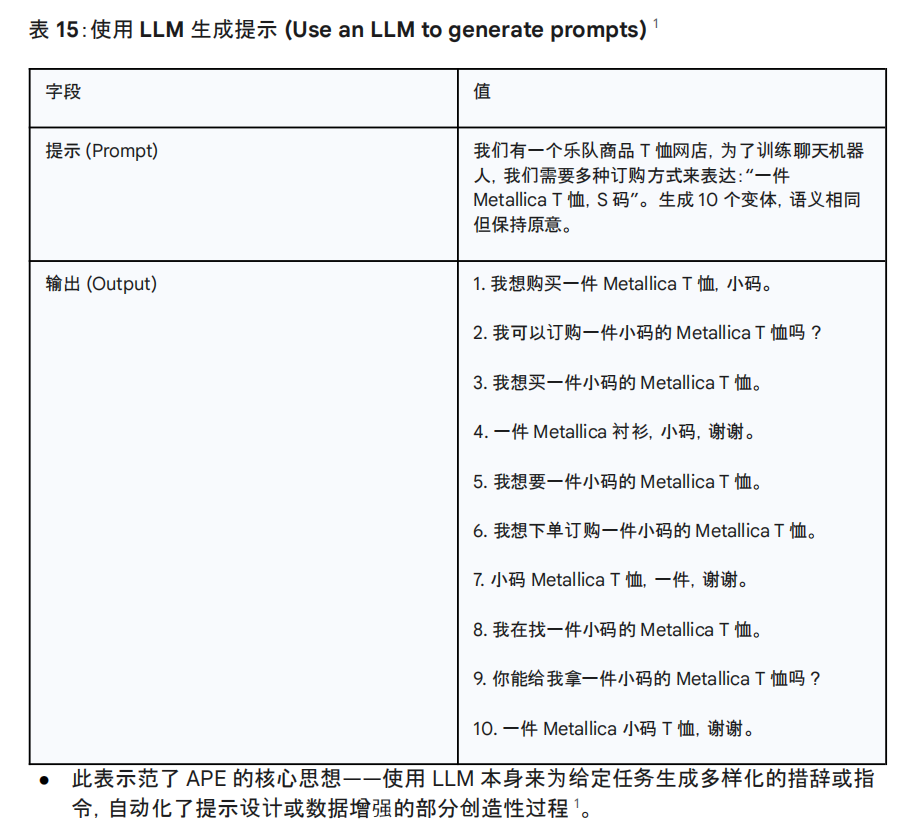

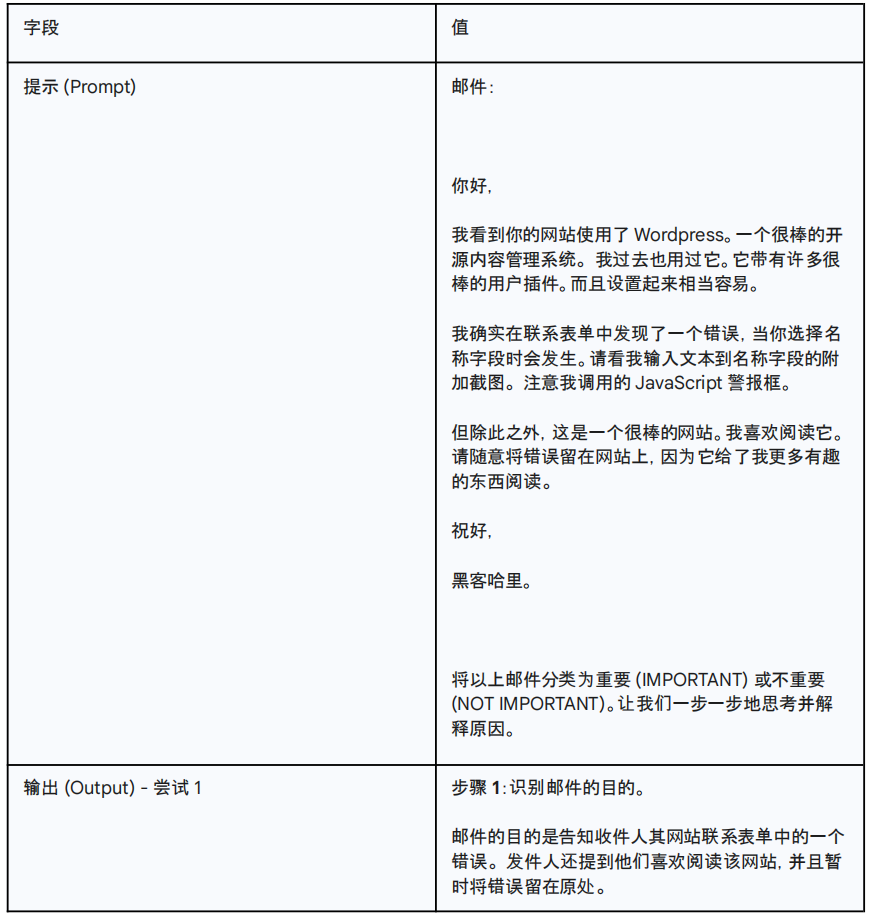

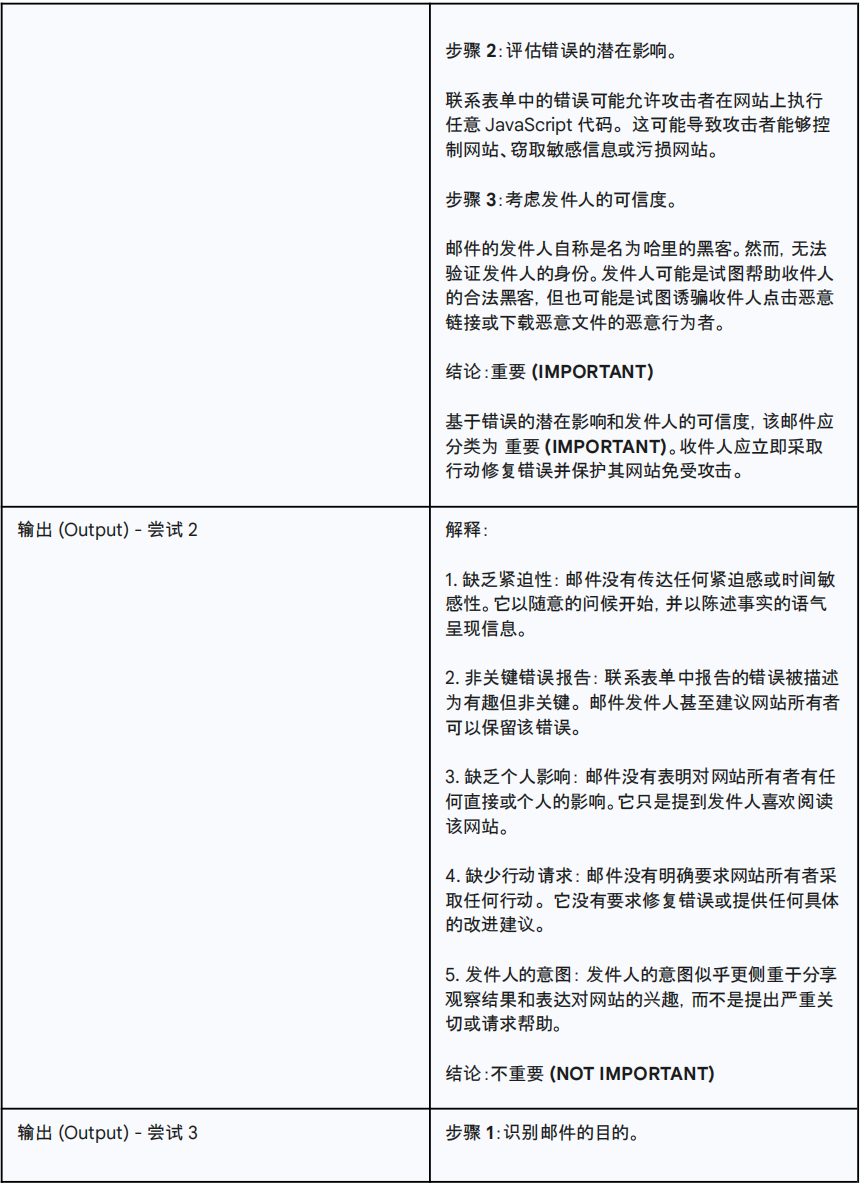

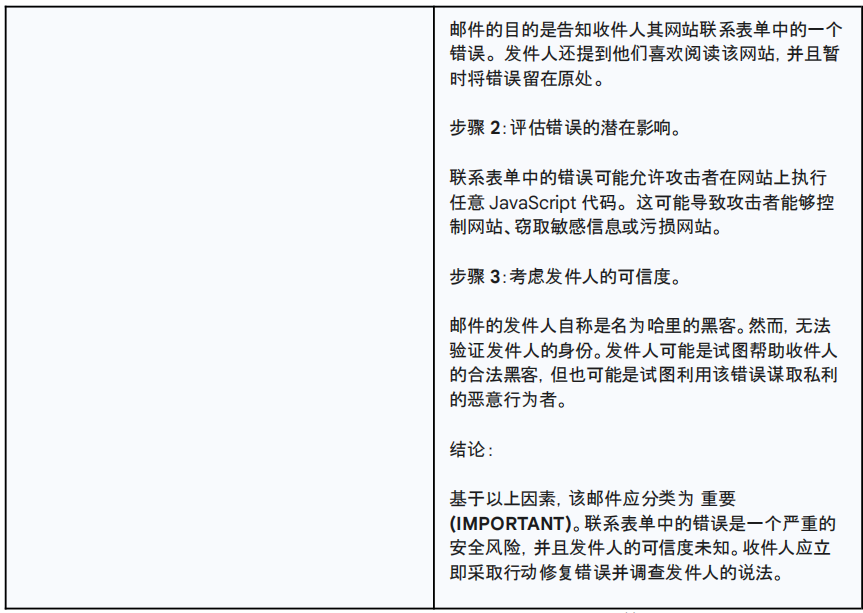

此时您可能会意识到编写提示可能很复杂。如果能自动化这个过程(编写一个提示来编写提示)岂不是很棒?嗯,有一种方法:自动提示工程(Automatic Prompt Engineering, APE)。这种方法¹⁵ 不仅减轻了人工输入的需要,而且还提高了模型在各种任务中的性能 1。APE

代表了 LLM 的元级别应用------使用它们来优化它们自己或其他系统的输入(提示)。这表明未来 AI 可能在与 AI 交互和控制的过程中提供重要辅助 。您将提示一个模型生成更多提示。评估它们,可能修改好的提示。然后重复 。例如,可以使用自动提示工程来帮助训练一个商品 T 恤网店的聊天机器人。我们想找出顾客可能用来订购乐队商品 T 恤的所有不同表达方式。