点一下关注吧!!!非常感谢!!持续更新!!!

🚀 AI篇持续更新中!(长期更新)

AI炼丹日志-31- 千呼万唤始出来 GPT-5 发布!"快的模型 + 深度思考模型 + 实时路由",持续打造实用AI工具指南!📐🤖

💻 Java篇正式开启!(300篇)

目前2025年10月13日更新到: Java-147 深入浅出 MongoDB 分页查询详解:skip() + limit() + sort() 实现高效分页、性能优化与 WriteConcern 写入机制全解析 MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈! 大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

章节内容

上节我们完成了如下的内容:

- Flink 并行度概念

- 全局并行度(Global Parallelism)、作业并行度(Job-level Parallelism)、Slot 并行度(Slot-level Parallelism)

- Flink 并行度的设置方式

- Flink 并行度的优化策略

Flink CEP 详细介绍

基本概念与架构

Flink CEP(Complex Event Processing,复杂事件处理)是Apache Flink的一个核心组件,专门用于处理复杂事件流。它基于Flink的DataStream API构建,提供了一套完整的模式匹配框架,能够对连续到达的流式数据进行实时模式检测和分析。

核心功能特性

-

模式定义能力:

- 支持定义包含多种约束条件的复杂事件模式

- 提供时间约束(within)、次数约束(times)、循环模式(oneOrMore, timesOrMore)等

- 支持贪婪/非贪婪量词匹配策略

-

事件匹配机制:

- 基于NFA(非确定性有限自动机)的高效匹配算法

- 支持严格连续(strict contiguity)和宽松连续(relaxed contiguity)两种匹配策略

- 具备处理乱序事件的能力(结合Watermark机制)

-

结果处理:

- 匹配结果可以触发自定义操作

- 支持将匹配事件序列转换为POJO或Tuple输出

- 提供丰富的API处理匹配结果(select/process等)

典型应用场景

-

金融领域:

- 信用卡欺诈检测(如短时间内多次大额交易)

- 异常交易模式识别(如洗钱行为模式)

- 实时风险预警系统

-

物联网领域:

- 设备异常状态监测(如温度持续升高+压力突降组合模式)

- 生产线故障预测(特定操作序列后出现异常信号)

- 设备生命周期管理

-

网络安全:

- 入侵检测(如多次登录失败后的成功登录)

- DDoS攻击识别(短时间内大量请求)

- 异常访问模式分析

-

电商领域:

- 用户行为分析(浏览-加购-下单模式识别)

- 实时营销活动触发(满足特定浏览路径的用户)

- 异常刷单行为检测

技术优势

- 低延迟高吞吐:基于Flink流处理引擎,可实现毫秒级延迟下的高吞吐处理

- 精确一次语义:保证事件处理的精确一次性(exactly-once)

- 状态管理:内置完善的状态管理机制,支持大规模状态持久化

- 容错机制:基于checkpoint的故障恢复能力

- 可扩展性:可水平扩展以处理海量事件流

与其他CEP系统的对比

相较于传统CEP系统(如Esper),Flink CEP具有以下优势:

- 与流处理引擎深度集成,无需额外系统

- 支持事件时间语义,能正确处理乱序事件

- 提供更丰富的状态管理和容错机制

- 具备更好的水平扩展能力

开发示例

java

// 定义事件模式

Pattern<LoginEvent, ?> pattern = Pattern.<LoginEvent>begin("start")

.where(new SimpleCondition<LoginEvent>() {

@Override

public boolean filter(LoginEvent value) {

return value.getType().equals("fail");

}

})

.next("middle").where(new SimpleCondition<LoginEvent>() {

@Override

public boolean filter(LoginEvent value) {

return value.getType().equals("fail");

}

})

.within(Time.seconds(10));

// 在数据流上应用模式

PatternStream<LoginEvent> patternStream = CEP.pattern(loginEventStream, pattern);

// 处理匹配结果

DataStream<Alert> alerts = patternStream.process(

new PatternProcessFunction<LoginEvent, Alert>() {

@Override

public void processMatch(

Map<String, List<LoginEvent>> match,

Context ctx,

Collector<Alert> out) {

out.collect(new Alert("连续登录失败告警"));

}

});Flink CEP正在成为实时流处理领域中复杂事件模式检测的事实标准,其强大的功能和优异的性能使其在众多行业场景中得到广泛应用。

主要概念

Flink CEP 基于以下核心概念来进行复杂事件处理:

事件流

事件是系统中需要处理的基础数据单元,通常是带有时间戳标记的结构化数据记录。例如:

- 在物联网场景中,一个传感器读数事件可能包含:设备ID、温度值、湿度值和时间戳

- 在金融交易监控中,一个交易事件可能包含:交易ID、账户号、交易金额、交易类型和时间戳

事件流是这些事件的连续序列,具有以下特点:

- 无界性:数据持续产生,没有预定义的结束点

- 有序性:事件通常按时间顺序到达,但也可能发生乱序

- 实时性:需要低延迟处理

模式

Flink CEP 允许定义匹配规则的模式,用来描述你希望在事件流中检测的事件序列。模式定义包括:

-

基本模式:

- 简单条件:如

event.value > 100 - 组合条件:使用AND/OR连接多个条件

- 迭代条件:匹配重复出现的事件

- 简单条件:如

-

模式序列:

- 严格连续:

A followedBy B表示A之后紧跟着B - 宽松连续:

A followedBy B表示A之后可以有其他事件,然后是B - 非确定性宽松:

A followedByAny B表示A之后可以有任意事件,然后是B

- 严格连续:

-

模式量词:

oneOrMore():匹配一次或多次times(n):匹配恰好n次optional():匹配零次或一次

示例模式:

java

Pattern<Event, ?> pattern = Pattern.<Event>begin("start")

.where(new SimpleCondition<Event>() {

@Override

public boolean filter(Event event) {

return event.getTemperature() > 100;

}

})

.followedBy("middle")

.where(new SimpleCondition<Event>() {

@Override

public boolean filter(Event event) {

return event.getHumidity() > 80;

}

})

.within(Time.minutes(10));状态机

Flink CEP 内部使用优化的非确定性有限状态机(NFA)来执行模式匹配:

-

状态机结构:

- 每个模式步骤对应一个状态

- 转换由事件触发,基于模式定义的条件

- 可以同时处于多个状态(非确定性)

-

匹配过程:

- 初始状态:等待第一个模式开始

- 中间状态:部分匹配进行中

- 最终状态:完全匹配成功

-

状态管理:

- 使用共享状态后端存储部分匹配

- 支持容错机制,确保故障恢复后继续正确匹配

时间处理

CEP支持两种时间概念和相应的处理机制:

-

时间类型:

- 事件时间(Event Time):事件实际发生的时间,通常嵌入在事件数据中

- 处理时间(Processing Time):Flink处理该事件的系统时间

-

时间约束:

- 通过

.within()方法设置模式的时间窗口 - 例如:10分钟内完成的事件序列

- 通过

-

乱序处理:

- Watermark机制:标记事件时间进度,允许延迟处理

- 延迟策略:可以设置最大允许延迟时间

- 侧输出:将超时事件输出到侧流进行特殊处理

示例时间处理:

java

Pattern<Event, ?> pattern = Pattern.<Event>begin("start")

.where(...)

.next("middle")

.where(...)

.within(Time.seconds(30)); // 30秒内完成匹配

CEP.pattern(stream, pattern)

.inEventTime() // 使用事件时间

.withLateDataOutputTag(outputTag) // 处理延迟数据

.select(...);这些核心概念共同构成了Flink CEP的强大功能,使其能够高效地处理复杂事件序列,检测业务场景中的关键模式。

Flink CEP 核心组件

Pattern API

Pattern类用于定义模式序列。你可以通过链式调用来指定各类条件,常见的模式组件包括:

- begin("stepName"):定义模式的起始步骤。

- where(predicate):为当前步骤添加过滤条件。

- next("stepName"):定义紧接着的步骤,匹配时要求必须是事件的严格连续。

- followedBy("stepName"):定义松散连续匹配,事件之间可以存在无关事件。

PatternStream

一旦定义了模式,PatternStream是用于将模式应用到输入事件流的组件。可以通过CEP.pattern()方法创建一个PatternStream。匹配结果可以通过select()函数获取。

Conditions

在模式步骤中,你可以定义复杂的条件来过滤事件。除了基本的where(),Flink CEP还支持:

- or():添加多个条件。

- until():指定模式什么时候结束。

- times():要求模式必须匹配多次。

事件匹配的策略

Flink CEP支持多种事件匹配策略,常用的有:

- Strict Contiguity(严格连续):要求事件必须紧接着发生,没有其他不相关的事件出现。

- Relaxed Contiguity(松散连续):允许在相关事件之间存在无关事件。

- Non-Deterministic Relaxed Contiguity(非确定性松散连续):允许多个匹配路径。

Flink CEP 的应用场景

- 欺诈检测: 在金融领域,Flink CEP常用于检测用户账户的可疑行为。例如,检测短时间内多个高额转账行为,或定位多个失败的登录尝试。

- 设备监控: 通过CEP,企业可以实时监控工业设备的传感器数据,及时发现异常的操作模式,并生成告警。例如,设备温度连续超过阈值或设备运行状态频繁切换。

- 网络安全: 在网络安全领域,Flink CEP可以用于实时监控网络流量,识别可能的网络入侵或攻击模式。例如,检测连续出现的多次失败的登录尝试后紧接着的成功登录行为。

- 物流跟踪: 在物流行业中,可以使用CEP实时跟踪运输车辆的状态,监控是否出现延误或不正常的停留。Flink CEP可以根据车辆的GPS数据流,检测连续长时间静止的情况。

Flink CEP 的优势

- 实时性:Flink 本身是一款实时流处理框架,而CEP让其可以处理复杂的事件模式,使得用户可以实时检测和响应。

- 扩展性:Flink CEP基于分布式架构,能够处理高吞吐量的数据流并在大规模集群上运行。

- 灵活性:用户可以通过简单的API定义各种复杂的事件模式,满足各种不同的业务需求。

基础概念

基本定义

复合事件处理(Complex Event Processing, CEP)是一种基于动态环境中事件流的分析技术,事件在这里通常是有意义的状态变化,通过分析事件间的关系,利用过滤、关联、聚合等技术,根据事件间的时序关系和聚合关系制定检测规则,持续的从事件流中查询出符合要求的事件序列,最终分析得到更复杂的复合事件。

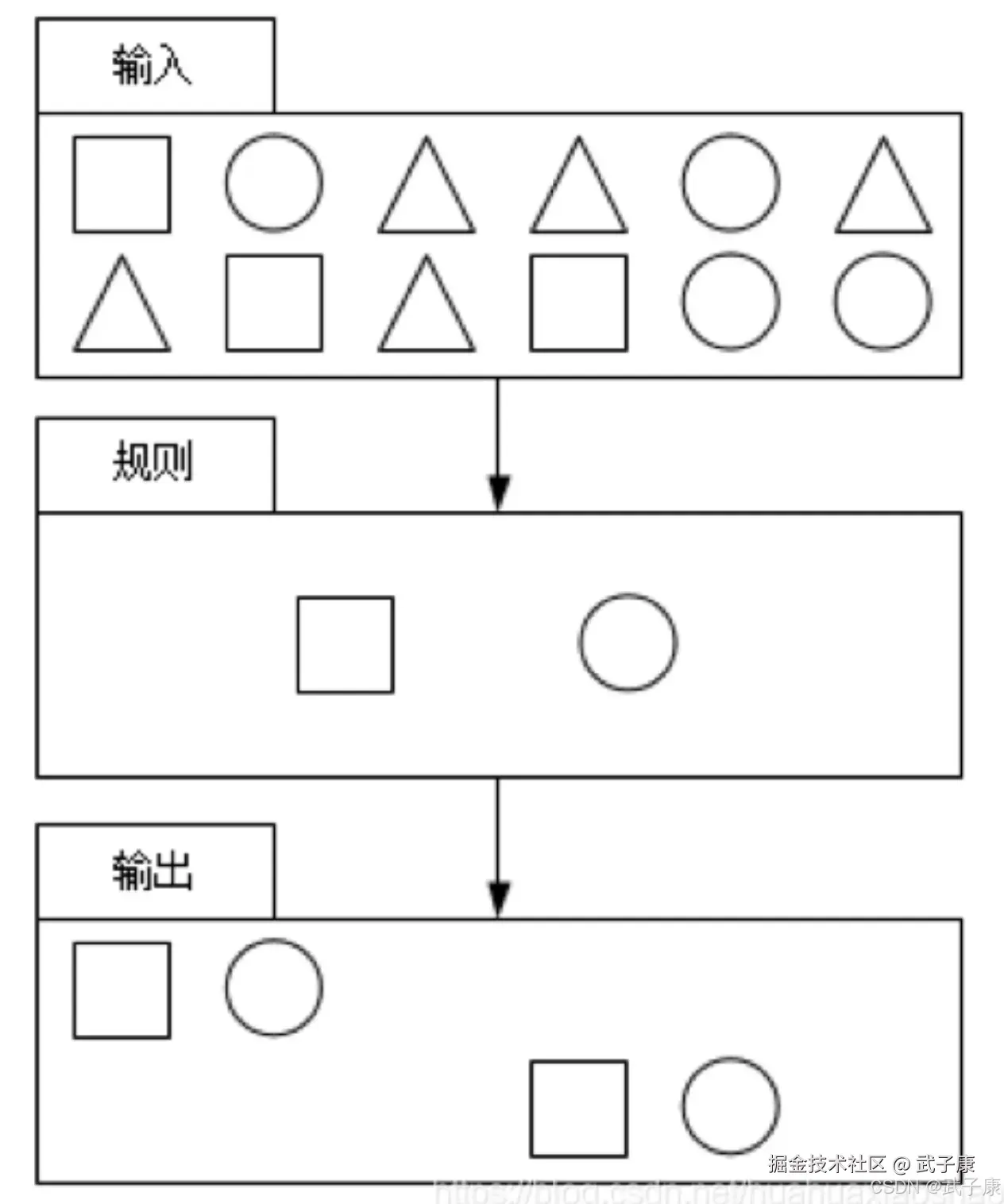

特征定义

CEP的特征如下:

- 目标:从有序的简单事件流中发现一些高阶特征

- 输入:一个或多个简单事件构成的事件流

- 处理:识别简单事件之间的联系,多个符合一定规则的简单事件构成复杂事件

- 输出:满足规则的复杂事件

功能概括

CEP用于分析低延迟、频繁产生的不同来源的事件流,CEP可以帮助在复杂的、不相关的时间流中找出有意义的模式和复杂的关系,以接近实时或准实时的获得通知或组织一些行为。 CEP支持在流上进行模式匹配,根据模式的不同,分为连续的条件或不连续的条件,模式条件允许有时间的限制,当条件范围内没有达到满足的条件时,会导致模式匹配超时。 看起来简单,但是它有很多不同的功能:

- 输入的流数据,尽快产生结果

- 在2个事件流上,基于时间进行聚合类的计算

- 提供实时/准实时的警告和通知

- 在多样的数据源中产生关联分析模式

- 高吞吐、低延迟的处理 市场上有多种CEP的解决方案,如Spark、Samza、Beam等,但是都没有提供专门的库支持,然而Flink提供了专门的CEP库。

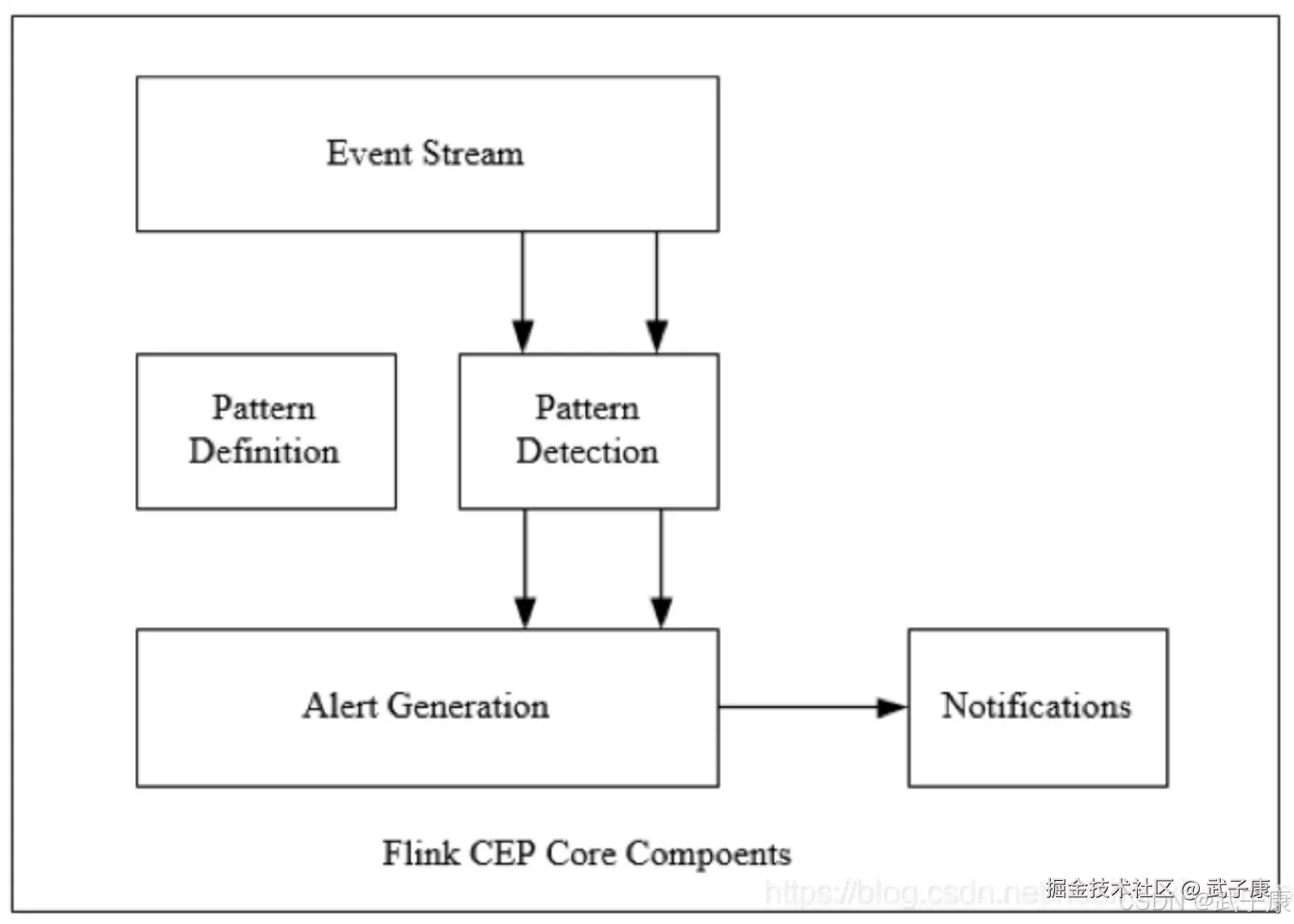

主要组件

Flink为CEP提供了专门的Flink CEP Library,它包含以下的组件:EventStream、Pattern定义,Pattern检测和生成Alert。 首先,开发人员要在DataStream流上定义出模式条件,之后FlinkCEP引擎进行模式检测,必要时生成警告。

PatternAPI

处理事件的规则,被叫做模式(Pattern)。 FlinkCEP提供了PatternAPI用于对输入流数据进行复杂事件规定定义,用来提取符合规则的时间序列。 模式大致分为三类:

- 个体模式(Individual Patterns):组成复杂贵的每一个单独的模式定义,就是个体模式

- 组合模式(Combining Patterns 也叫序列模式):很多个体模式组合起来,就形成了整个的模式序列

- 模式组(Group Of Pattern):将一个模式序列作为条件嵌套在个体模式里,成为一组模式。

个体模式

个体模式包括单例模式和循环模式,单例模式只接受一个事件,而循环模式可以接受多个事件。

量词

可以在一个个体模式后追加量词,也就是指定循环次数。

shell

// 匹配出现4次

start.time(4)

// 匹配出现0次或4次

start.time(4).optional

// 匹配出现2、3或4次

start.time(2,4)

// 匹配出现2、3或4次,并且尽可能多地重复匹配

start.time(2,4).greedy

// 匹配出现1次或多次

start.oneOrMore

// 匹配出现0、2或多次,并且尽可能多地重复匹配

start.timesOrMore(2).optional.greedy条件

每个模式都需要指定触发条件,作为模式是否接受事件进入的判断依据。CEP中的个体模式主要通过 where、or、until来制定条件。按不同的调用方式,可以分成下面几类:

- 简单条件:通过where方法对事件中的字段进行判断筛选 start.where(event=>event.getName.startsWith("foo"))

- 组合条件:将简单的条件进行合并,or方法表示或逻辑相连,where的直接组合就相当于and Pattern.where(event => .../some condition /).or(event => /or condition/)

- 终止条件:如果使用了oneOrMore或oneOrMore.optional,建议使用until作为终止条件,以便清理状态

- 迭代条件:能够对模式之前所有接受的事件进行处理,调用where,可以调用ctx.getEventForPattern("name")

模式序列

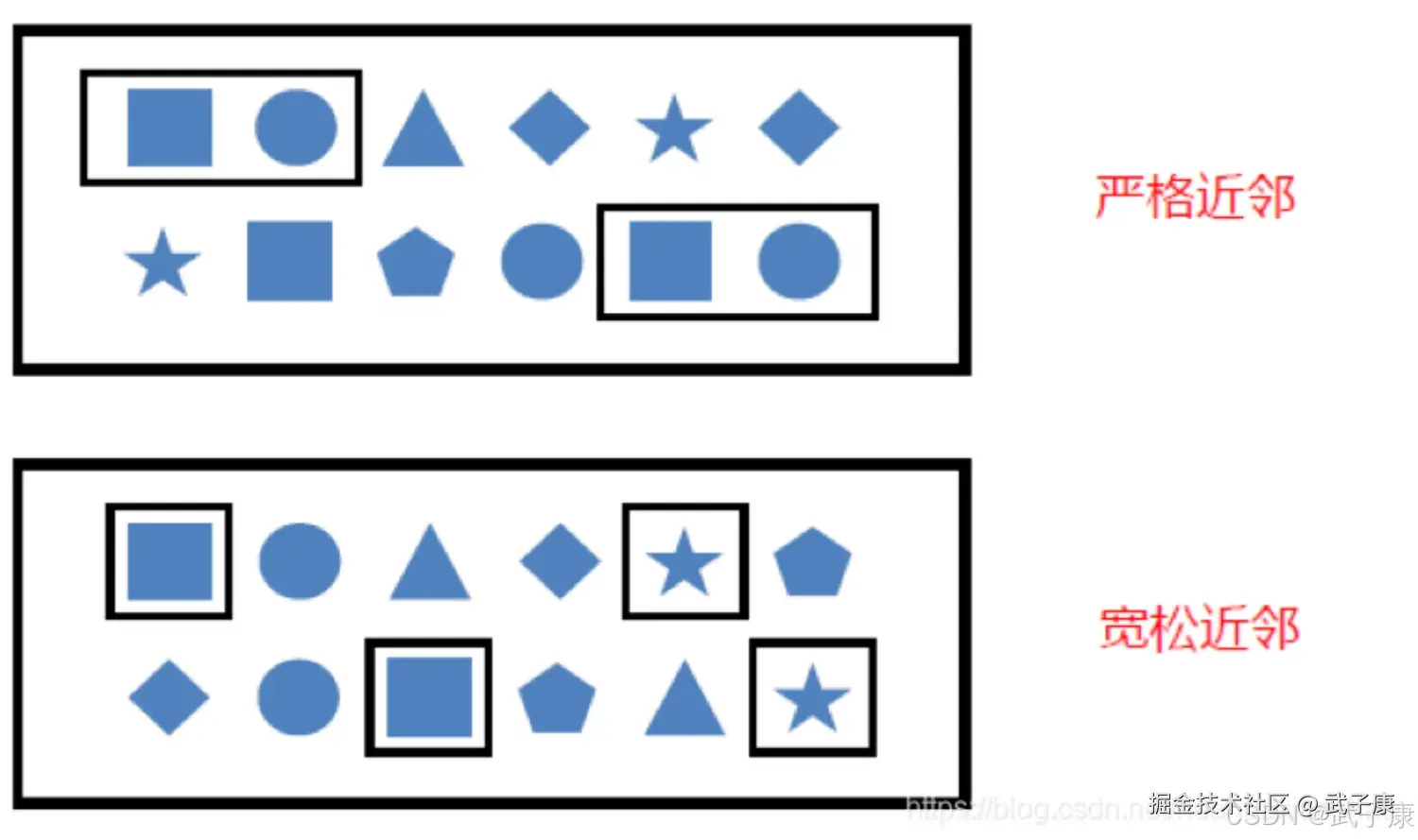

近邻模式

不同的近邻模式如下图

- 严格近邻:所有事件按照严格的顺序出现,中间没有任何不匹配的事件,由next制定,例如对于模式:a next b,事件序列:a c b1 b2 没有匹配

- 宽松近邻:允许中间出现不匹配的事件,由followedBy指定。例如对于模式 a followed by b,事件序列:a c b1 b2,匹配为:a, b1

- 非确定性宽松近邻:进一步放宽条件,之前已经匹配过的事件也可以再次使用,由 followByAny指定,例如对于模式 a followerByAny b,事件序列:a c b1 b2,匹配为: ab1,ab2。

除了以上的序列模式外,还可以定义不希望出现某种近邻关系:

- notNext 不想让某个事件严格近邻前一个事件发生

- notFollowBy 不想让某个事件在两个事件之间发生

额外注意

我们需要注意:

- 所有模式序列必须以 begin 开始

- 模式序列不能以 notFollowedBy结束

- not类型的模式不能被optional所修饰

- 可以为模式指定时间约束,用来要求在多长时间内匹配有效。

模式检测

指定要查找的模式序列后,就可以将其应用于输入流以检测潜在匹配。调用CEP.pattern(),给定输入流和模式,就能得到一个PatternStream

shell

val input:DataStream[Event] = ...

val pattern:Pattern[Event,_] = ...

val patternStream:PatternStream[Event]=CEP.pattern(input,pattern)匹配事件提取

创建 PatternStream之后,就可以应用select或者flatSelect方法,从检测到的事件序列中提取事件。 select()方法需要输入一个select function作为参数,每个成功匹配的事件序列都会调用它。 select()以一个Map[String, Iterable[IN]]来接收匹配到的事件序列,其中key就是每个模式的名称,而value就是所有接收到的事件的Iterable类型。

scala

def selectFn(pattern : Map[String,Iterable[IN]]):OUT={

val startEvent = pattern.get("start").get.next

val endEvent = pattern.get("end").get.next

OUT(startEvent, endEvent)

}flatSelect通过实现PatternFlatSelectFunction实现与Select相似的功能,唯一的区别就是flatSelect方法可以返回多条记录,它通过一个Collector[OUT]类型的参数来将要输出的数据传递到下游。