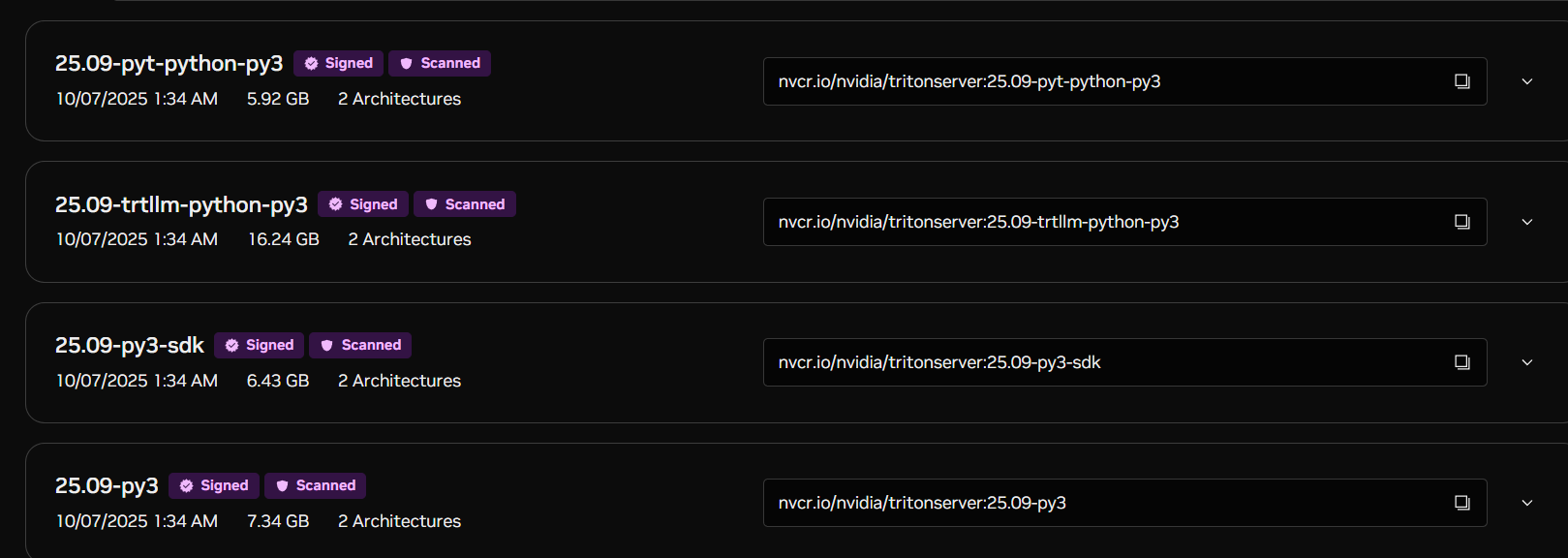

1.选取镜像类型

参考 官方tag 对应的镜像地址

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/tritonserver?version=25.09-trtllm-python-py3

nvcr.io/nvidia/tritonserver 镜像主要分为三类

pyt-python-py3

trtllm-python-py3

py3

看下图

可以看出 py3 < pyt < llm Py3

因为本次安装的是基于 pytorch pth模型,同时需要pytorch 进行数据处理成张量。所以选择 pyt-python-py3

2.确定镜像版本

查看 机器的cuda 和驱动版本

nvidia-smi

NVIDIA-SMI 545.23.08 Driver Version: 545.23.08 CUDA Version: 12.3

确定镜像的版本,否则镜像是不能支持对应的版本的。 nvidia的官网 不同版本对应的环境

https://docs.nvidia.com/deeplearning/triton-inference-server/release-notes/rel-23-11.html#rel-23-11

3.安装pytorch

虽然镜像说是提供了pytorch 但是依旧需要下载torch 包,可能是我选择的版本问题吧...

bash

pip install torch==2.3.1 torchvision==0.18.1 --extra-index-url https://download.pytorch.org/whl/cu121 -i https://pypi.tuna.tsinghua.edu.cn/simple安装工具包

bash

pip install pandas numpy scikit-learn -i https://pypi.tuna.tsinghua.edu.cn/simple4.启动docker 和 triton

我是分开执行,各位可以直接一把启动哈

1.根据命令启动docker

bash

docker run -it \

--gpus device=6 \

-p 18000:8000 -p 18001:8001 -p 18002:8002\

-v /opt/triton_inference_serve/model_repository:/models \

--name triton-pytorch-dsn \

nvcr.io/nvidia/tritonserver:23.12-pyt-python-py3 \

bash--gpus device=6

选择gpu号

-p 18000:8000 -p 18001:8001 -p 18002:8002\

暴露接口

-v /opt/triton_inference_serve/model_repository:/models

挂载模型目录

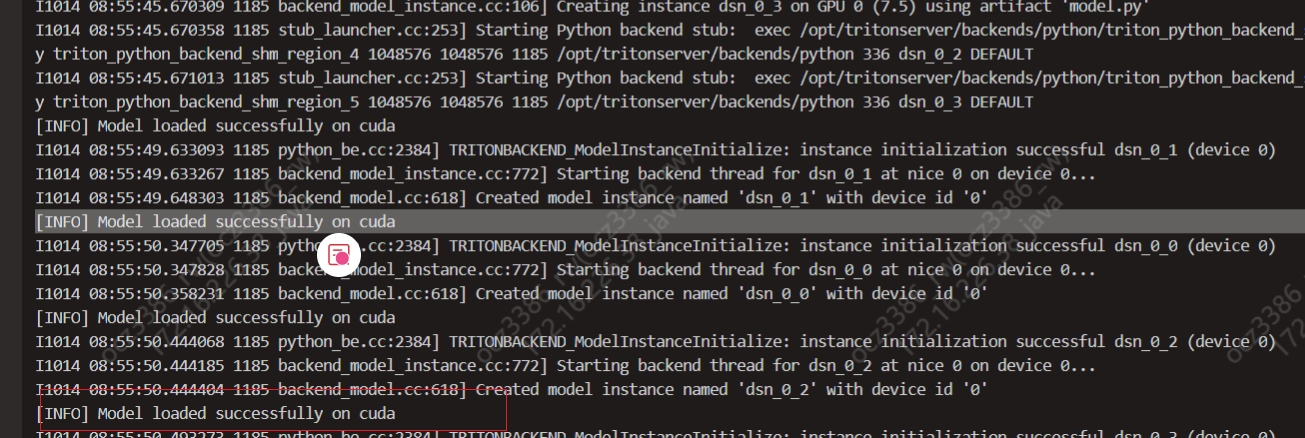

2.启动triton

我使用了nohup,避免每次启动

bash

nohup tritonserver \

--model-repository=/models \

--backend-directory=/opt/tritonserver/backends \

--backend-config=python,execution_mode=enabled \

--log-verbose=2 \

--log-file=/models/dsn/logs/triton.log \

> /models/dsn/logs/nohup.out 2>&1 &--model-repository=/models

指定模型执行地址

--backend-directory=/opt/tritonserver/backends

指定后端启动的python 库

--log-verbose=2 >1 表示开启日志

--log-file=/models/dsn/logs/triton.log \

/models/dsn/logs/nohup.out 2>&1 &

nohup启动日志