- 请问这个里面的浅黄色 fathers brought 是什么含义?是过去生成的?2. 后面颜色更深的咖啡色 forth 和 是未来会生成,但是现在还没有被使用的意思吗??3. Four score and seven years ago our这个部分是什么?不是生成的而是最开始就有的,是初始的时候就有的吗?有什么更专业的数据可以称呼吗

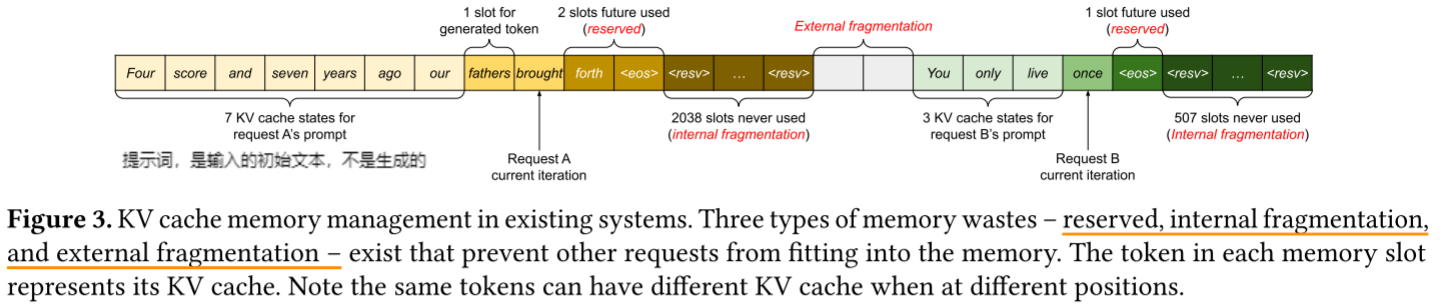

要理解这个图,我们可以把每个部分拆解为请求的"提示词阶段(Prompt)"、"生成阶段(Generation)" 以及显存浪费的三种类型,具体解释如下:

1. 浅黄色"fathers""brought"的含义

浅黄色的"fathers"属于请求A当前生成的token ,"brought"是请求A上一轮生成的token。

- 图中"1 slot for generated token"标注的"fathers",是请求A本轮刚生成的token,其KV缓存需要占用1个显存槽位;

- "brought"是请求A之前生成的token,属于生成阶段中"已经完成但仍需保留用于后续注意力计算"的KV缓存。

2. 深咖啡色"forth"和""的含义

深咖啡色的"forth"和""属于为请求A预留的"未来生成token的槽位",但当前未被使用。

- 图中"2 slots future used (reserved)"标注的"forth"和""(是"生成结束"的标记),是系统为请求A预先预留的显存槽位,用于存储未来将要生成的token的KV缓存。这些槽位当前是空的(未被使用),但属于"预留资源",导致显存被占用却未有效利用(即"内部碎片"的一种)。

3. "Four score and seven years ago our"的含义与专业称呼

"Four score and seven years ago our"属于请求A的"提示词(Prompt)",是用户输入的初始文本,不是生成阶段产生的。

- 专业上称为**"提示词KV缓存"**,是LLM在处理用户输入时,对提示词中每个token计算得到的Key和Value向量,需要长期驻留显存以支持后续生成阶段的注意力计算。

补充:三种显存浪费的总结

图中还展示了传统系统中KV缓存管理的三类显存浪费,这也是论文要解决的核心问题:

- Reserved(预留浪费):如"2 slots future used (reserved)""1 slot future used (reserved)",为未来生成预留的槽位当前未被使用,却占用了显存;

- Internal fragmentation(内部碎片):如"2038 slots never used""507 slots never used",为请求分配的连续显存中,有大量槽位实际未被使用(比如请求A实际只需少量槽位,却分配了连续的大段显存);

- External fragmentation(外部碎片):图中中间的空白区域,是显存中零散的空闲槽位,由于传统系统要求KV缓存连续存储,这些零散空间无法被其他请求利用。

这样拆解后,是不是对传统KV缓存管理的问题和各个模块的含义更清晰了?