本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

是不是经常觉得,虽然现在的AI很强大,但一问到专业问题它就开始胡言乱语?比如问个法律条款解读,或者咨询个医疗建议,它回答得看似有理有据,但你根本不敢信?这是因为通用大模型虽然"读书破万卷",但缺乏行业深度。

别急,今天就带你了解一种让AI"进修深造"的技术------微调(Fine-tuning),教你如何把一个大而全的通用AI,变成你所在领域的专业顾问!

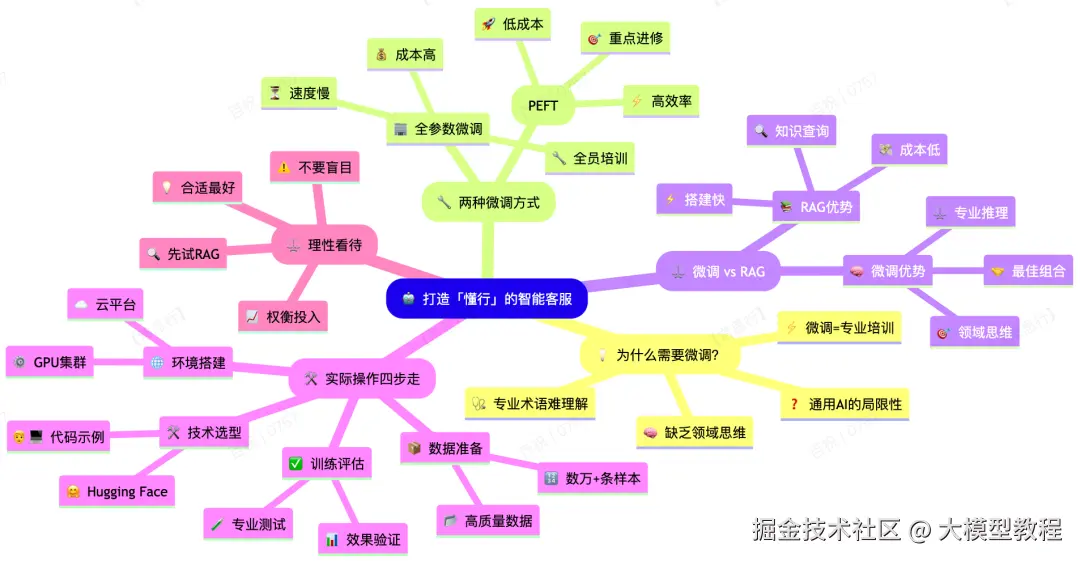

一、什么是微调?为什么你的企业需要它?

想象一下,你请来一位博学多才的通用助理,他上知天文下知地理,但对你的行业术语和业务流程一无所知。"微调"就像是送这位助理去参加你行业的"岗前培训",让他快速掌握专业知识和表达方式。

比如说,如果你在医疗行业,通用AI可能知道"CT"是什么,不一定清楚"增强扫描与平扫的适应区别"。但通过微调,我们可以让AI学习大量医疗文献、诊断指南和病历数据,让它不仅能听懂专业术语,还能按医生的思维模式回答问题。

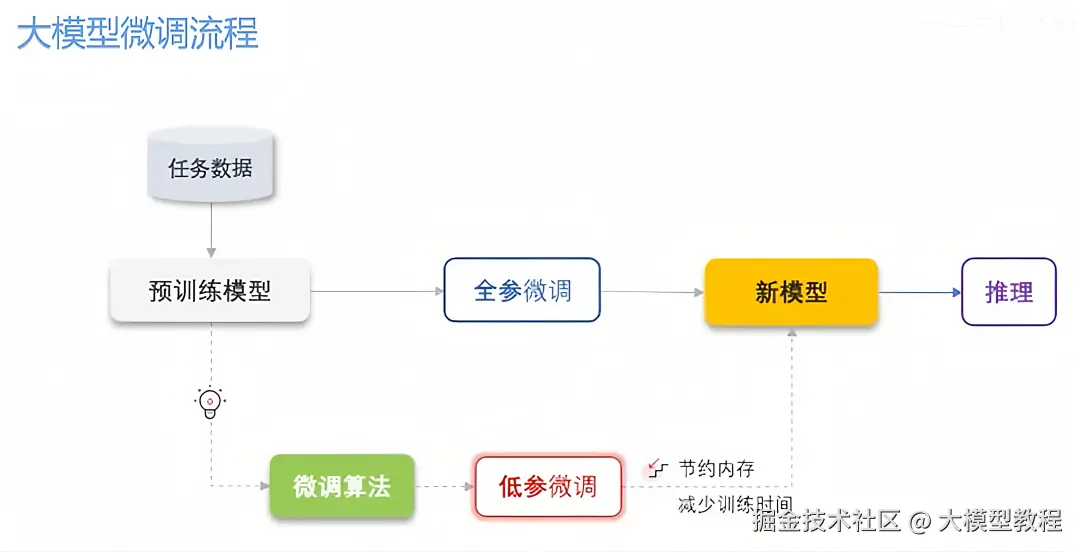

二、微调的两种方式:全员培训 vs 重点进修

微调主要有两种方法,适合不同资源规模的企业:

全参数微调(Full Fine-tuning):相当于让全体员工停工,全部重新培训一遍。这种方法动用模型全部参数(比如DeepSeek的671亿参数),效果理论上最好,但成本极高------需要大量的GPU(比如2000张英伟达显卡)和漫长训练时间,一般企业根本玩不起。

低参数微调(PEFT):更像是选派关键员工去进修,然后让他们回来培训其他人。这种方法只调整模型的一小部分参数(常用LoRA等技术),大大降低了计算和内存需求,训练速度快,效果却不差,是大多数企业的首选方案。

三、微调 vs RAG:不是替代,而是互补

很多人会问:既然有更便宜的RAG(检索增强生成)技术,为什么还要做微调?

简单来说:

- RAG 像是给AI一本随时可查的工具书------成本低、搭建快,适合回答基于明确知识的问题

- 微调 则是让AI真正理解这个行业的"思维方式"------成本高但效果深,适合需要专业推理的场景

比如在法律领域,RAG可以帮你找到相关法条,但微调后的AI才能像律师一样分析"这个法条在某个案例中如何适用"。最好的做法往往是两者结合:先用微调让AI懂行,再用RAG提供最新信息。

四、实际操作:微调需要什么?怎么做?

如果你决定尝试微调,这里有个简单的准备清单:

- 数据准备:收集高质量的行业文本数据(问答对、文档、对话记录等),通常需要数万到数百万条

- 环境搭建:可以选择云服务平台(如阿里云 PAI、腾讯云 TI)或自建GPU集群

- 技术选型:建议从PEFT方法开始,比如使用Hugging Face的PEFT库

- 训练与评估:训练后要用专业问题测试模型效果,确保真正提升了专业能力

ini

# 这是一个简化的微调代码示例(使用Hugging Face)

from transformers import AutoModelForCausalLM, TrainingArguments

from peft import LoraConfig, get_peft_model

# 加载基础模型

model = AutoModelForCausalLM.from_pretrained("deepseek-ai/deepseek-base")

# 配置LoRA微调参数

lora_config = LoraConfig(

r=8,

lora_alpha=16,

target_modules=["query", "value"],

lora_dropout=0.05

)

# 应用微调配置

model = get_peft_model(model, lora_config)微调虽好,但不要盲目使用

虽然微调很强大,但也要理性看待:

- 对于大多数企业,建议先从RAG开始,快速验证效果

- 微调适合有足够数据积累和专业需求的场景

- 成本仍然不菲,需要权衡投入产出比

记住,没有最好的技术,只有最适合的方案。好的智能客服系统往往是多种技术的智能组合,微调只是让你的AI真正"懂行"的关键一环。

现在,你是否对如何让AI变得更专业有了新想法?不妨从整理你的行业数据开始,为你的智能客服打造一次"专业进修"计划吧!

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。