目录

[2.network architecture search(NAS)](#2.network architecture search(NAS))

摘要

本篇文章继续学习李宏毅老师2025春季机器学习课程,学习内容是meta learning可训练的参数,如optimizer相关的参数,network架构相关的参数。

1.optimizer

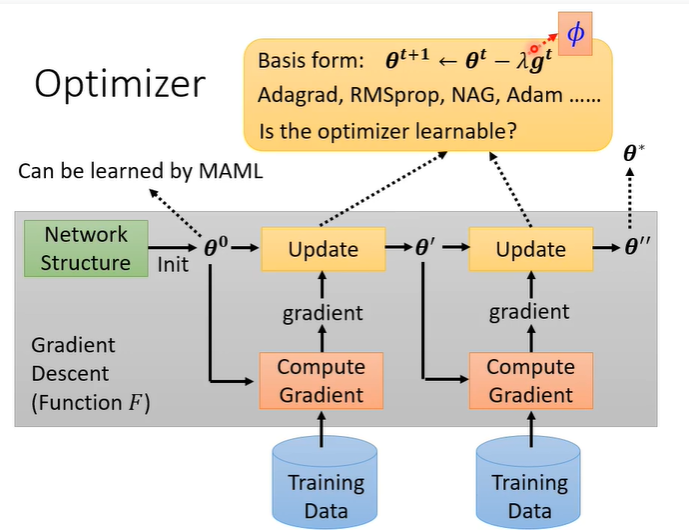

meta learning除了可以学习初始化的参数,还可以学optimizer。在更新参数时我们需要决定learning rate等参数,这些hyper parameter可以用meta learning学出来的。

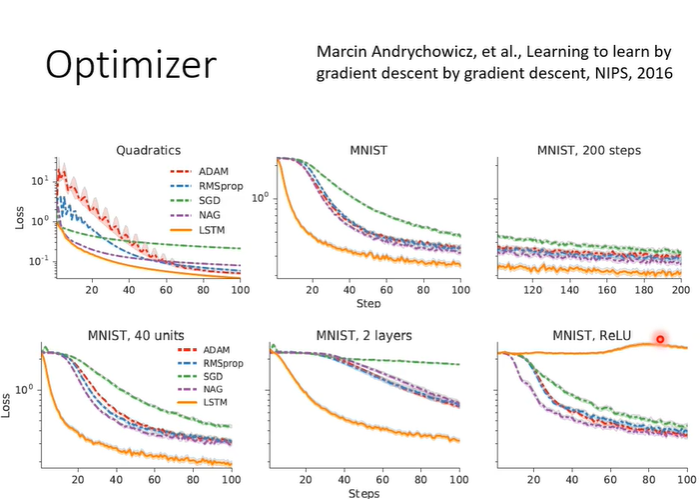

下图的实验结果是自动根据训练任务学出来的,橙色的是学习出来的optimizer,其他的颜色是其他的方法。训练在MNIST上测试在NIST上结果还不错(第一行的测试结果),但是,训练在一层network上,测试在两层network上依然可以学起来,但是改一下active function就不行了(sigmoid更改为ReLu)。

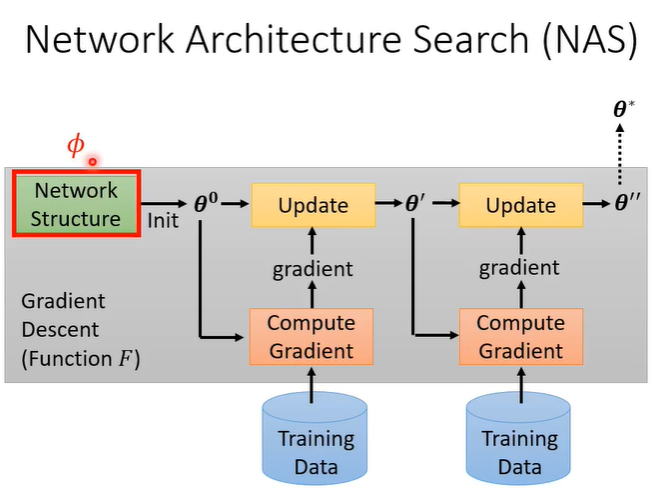

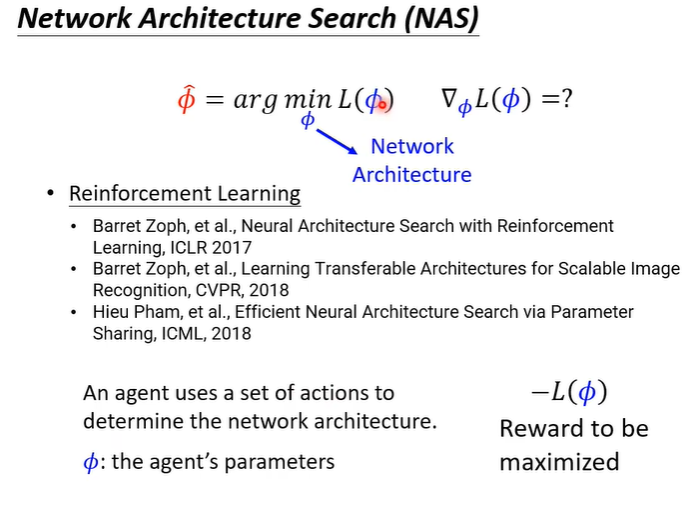

2.network architecture search(NAS)

meta learning也可以训练network架构,训练network架构研究就叫做network architecture search(NAS)。此时的就是network架构。

如果是network架构做微分就有问题,当

无法算微分时,可以尝试用reinforce learning硬做。具体如果实现呢?我们就需要把

当作agent的参数,这个agent的输出就是network架构相关的hyper parameter。接下来需要训练agent让他maximize一个reward,reward直接设置成

。

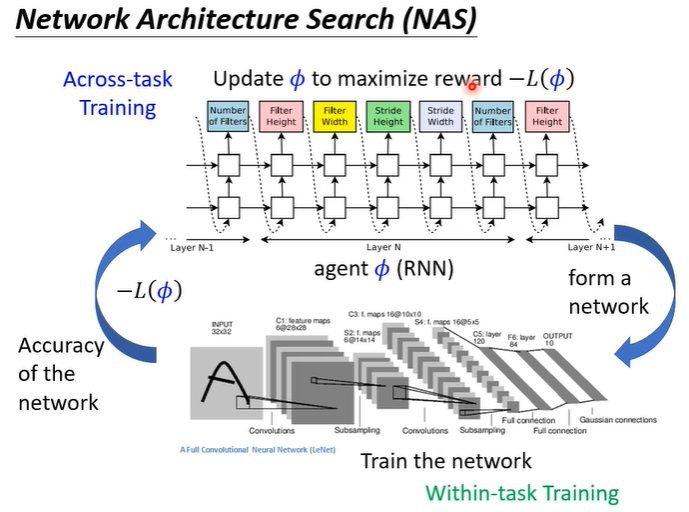

下图可以帮助理解NAS在做什么。将agent当作RNN,每次会输出一个与network架构有关的参数,例如先输出filter的数量,在输出filter的高等等,有了这些参数之后就根据这些参数建出一个network,建出这个network之后去训练这个network,之后继续做reinforce learning,可以把这个network在测试资料上的accuracy当作reward去训练agent。