✅ 一、Batch Size 的重要性

在训练神经网络时,Batch Size(批量大小) 是一个关键超参数,它决定了每次更新模型参数时使用的样本数量。

- Batch Size = 1 → 随机梯度下降(SGD)

- Batch Size = 全部数据 → 批量梯度下降(GD)

- Batch Size = 中等值(如 32, 64, 128) → 小批量梯度下降(Mini-batch GD)

🔍 核心问题:如何选择合适的 Batch Size?

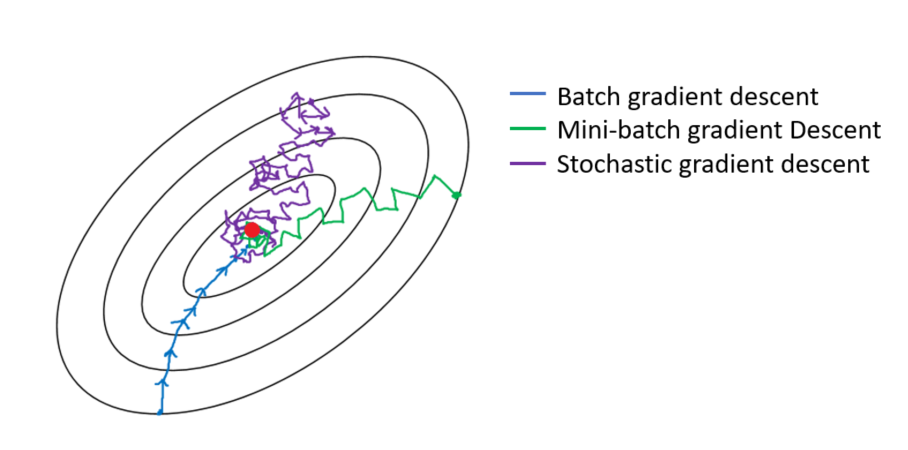

✅ 二、三种优化方式对比

| 方法 | Batch Size | 特点 |

|---|---|---|

| 批量梯度下降(GD) | ( n )(全部样本) | 使用所有数据计算梯度,方向稳定但速度慢 |

| 随机梯度下降(SGD) | 1 | 每次只用一个样本更新,速度快但波动大 |

| 小批量梯度下降(Mini-batch GD) | ( m )(( 1 < m < n )) | 折中方案,兼顾效率与稳定性 |

✅ 三、不同 Batch Size 对训练的影响

3.1 Batch Size 过小(如 1 或 2)

- 优点 :

- 更新频率高,收敛快;

- 能逃出局部极小值(因噪声大);

- 缺点 :

- 梯度估计不准确,方向抖动剧烈;

- 训练不稳定,损失曲线震荡严重;

- GPU 利用率低,无法并行计算。

❌ 类比:像一个人每天只看一本书,虽然学得快,但容易走偏。

3.2 Batch Size 过大(如 512, 1024)

- 优点 :

- 梯度更准确,方向稳定;

- GPU 并行效率高,训练速度快;

- 缺点 :

- 容易陷入局部最优或鞍点;

- 内存占用大,可能超出显存;

- 收敛速度变慢(每轮更新次数减少);

❌ 类比:像一个团队一起做决定,虽然稳,但反应慢且可能僵化。

3.3 合理的 Batch Size(通常 32~256)

- 推荐范围:32、64、128、256

- 原因 :

- 能平衡梯度精度与更新频率;

- 适合现代 GPU 的并行计算架构;

- 在大多数任务中表现良好。

✅ 类比:像一个 6~8 人的小组讨论------既有效率又有灵活性。

✅ 四、为什么使用 Mini-batch?

4.1 实际意义

- 内存限制:无法一次性加载全部数据;

- 计算效率:GPU 更擅长处理向量化操作;

- 泛化能力:适度的噪声有助于模型避免过拟合。

4.2 数学解释

- Mini-batch 提供了一个对总体梯度的无偏估计 :

其中 ( m ) 是 batch size,(

) 是第 ( i ) 个样本的损失。

✅ 五、SGD 与 GD 的区别

| 维度 | 随机梯度下降(SGD) | 批量梯度下降(GD) |

|---|---|---|

| Batch Size | 1 | 全部样本 |

| 梯度计算 | 单样本梯度 | 所有样本梯度之和 |

| 更新频率 | 高(每步一次) | 低(每轮一次) |

| 计算成本 | 低 | 高 |

| 稳定性 | 差(波动大) | 好(平滑) |

| 收敛速度 | 快(初期) | 慢(初期) |

| 是否易陷局部极小值 | 不易(噪声帮助逃脱) | 易(方向太确定) |

✅ 六、实际应用建议

6.1 如何选择 Batch Size?

| 场景 | 推荐 Batch Size |

|---|---|

| 小数据集(<10k) | 16~64 |

| 中等数据集(10k~1M) | 64~256 |

| 大数据集(>1M) | 256~1024 |

| GPU 显存有限 | 尽量小,但保证能运行 |

💡 经验法则:从 32 开始尝试,逐步增大直到性能不再提升或显存不足。

6.2 学习率与 Batch Size 的关系

- Batch Size 增大 → 梯度更准 → 可以使用更大的学习率;

- 但不能无限放大,否则会跳过最优解;

- 一般做法:当 Batch Size 翻倍时,学习率也适当增加 (如乘以 (

));

⚠️ 注意:学习率调整需配合验证集监控。

✅ 七、可视化理解(文字描述)

- GD:像沿着山坡缓慢下山,每一步都走得很稳,但很慢;

- SGD:像在山上蹦蹦跳跳,每一步都可能偏离方向,但整体趋势向下;

- Mini-batch GD:像一群人在山坡上齐步走,既有方向感又不会太慢。

🎯 最终目标:找到全局最小值或足够好的局部最小值。

✅ 八、总结

🌟 Batch Size 是影响训练效率与稳定性的关键因素

它不是越大越好,也不是越小越好,而是要根据数据规模、硬件条件和任务需求综合权衡。

- 小 Batch:适合探索、防止过拟合;

- 大 Batch:适合快速收敛、大规模训练;

- Mini-batch:是目前最主流的选择。

💡 一句话记住 :

"Batch Size 是你训练时的'步长'------太大容易踩空,太小走得太累。"