文章目录

- [日志处理方案大比拼:现有方案 vs ELK/AOP/RocketMQ/大厂方案](#日志处理方案大比拼:现有方案 vs ELK/AOP/RocketMQ/大厂方案)

-

- 一、核心方案全景图:先明确对比基准

- 二、与ELK方案对比:简化版vs全功能版

-

- [1. 核心差异点](#1. 核心差异点)

- [2. 适用场景分析](#2. 适用场景分析)

- [3. 致命短板对比](#3. 致命短板对比)

- 三、与AOP采集方案对比:侵入式vs无侵入式

-

- [1. 核心差异点](#1. 核心差异点)

- [2. 适用场景分析](#2. 适用场景分析)

- [3. 致命短板对比](#3. 致命短板对比)

- [四、与RocketMQ缓冲方案对比:Kafka vs RocketMQ](#四、与RocketMQ缓冲方案对比:Kafka vs RocketMQ)

-

- [1. 核心差异点](#1. 核心差异点)

- [2. 适用场景分析](#2. 适用场景分析)

- [3. 致命短板对比](#3. 致命短板对比)

- 五、与大厂日志方案对比:自建vs托管

-

- [1. 核心差异点](#1. 核心差异点)

- [2. 适用场景分析](#2. 适用场景分析)

- [3. 致命短板对比](#3. 致命短板对比)

- 六、方案选型决策指南

- 七、总结:没有最优方案,只有最合适方案

日志处理方案大比拼:现有方案 vs ELK/AOP/RocketMQ/大厂方案

若对您有帮助的话,请点赞收藏加关注哦,您的关注是我持续创作的动力!有问题请私信或联系邮箱:funian.gm@gmail.com

日志处理是电商微服务架构的"神经中枢",不同技术选型会直接影响系统性能、运维成本和业务价值。本文将系统对比现有方案(Filebeat+Kafka+Flink+Spark+ES+HDFS)与主流替代方案(ELK、AOP采集、RocketMQ缓冲、大厂托管方案),从架构设计、性能表现、适用场景等维度拆解差异,帮你找到最适合业务的日志处理路径。

一、核心方案全景图:先明确对比基准

首先明确本文现有方案的核心架构(作为对比基准):

核心特点:

- 采集无侵入:Filebeat独立于业务代码;

- 处理分层:Flink实时+Spark离线;

- 存储分层:ES热数据+HDFS冷数据;

- 全链路可扩展:支持日均亿级日志。

二、与ELK方案对比:简化版vs全功能版

ELK是最经典的日志处理方案(Elasticsearch+Logstash+Kibana),架构如下:

微服务 采集+处理 Elasticsearch Kibana

1. 核心差异点

| 维度 | 现有方案 | ELK方案 |

|---|---|---|

| 采集层 | Filebeat轻量采集(10MB内存) | Logstash重量级(200MB+内存) |

| 处理能力 | Flink+Spark支持复杂计算(漏斗/路径分析) | Logstash仅支持简单过滤(正则/字段提取) |

| 存储分层 | ES(热)+HDFS(冷),成本低 | 全量存ES,成本高(无冷存储) |

| 吞吐量 | 十万级/秒(Kafka+Flink扩展) | 万级/秒(Logstash性能瓶颈) |

| 运维复杂度 | 高(多组件协同) | 低(仅3个组件) |

2. 适用场景分析

-

ELK适合 :

中小型电商(日均日志<1000万条),需求简单(仅需日志查询+基础统计),运维资源有限。例如:初创电商仅需"查询用户是否浏览过某商品",ELK部署简单(Docker一键启动),可快速满足需求。

-

现有方案适合 :

中大型电商(日均日志>5000万条),需复杂分析(如转化漏斗、用户分群)。例如:成熟电商需要"分析30天内从浏览到下单的转化路径",ELK的Logstash无法支撑批量计算,必须依赖Flink+Spark。

3. 致命短板对比

-

ELK的核心问题:

Logstash基于JVM,资源占用高(单节点需2核4G),在容器化微服务中会挤压业务资源;且不支持复杂计算,无法实现"用户行为序列分析"等深度需求。

-

现有方案的核心问题:

组件多(8+组件),运维成本高(需专人维护Kafka/Flink集群),对中小团队不友好。

三、与AOP采集方案对比:侵入式vs无侵入式

AOP方案通过Spring AOP在微服务代码中埋点采集日志,直接写入Kafka/ES,架构如下:

微服务代码 采集日志 Kafka/ES

1. 核心差异点

| 维度 | 现有方案 | AOP采集方案 |

|---|---|---|

| 业务侵入性 | 无(Filebeat采集文件,不改代码) | 强(需在业务代码中加AOP注解) |

| 故障隔离 | 日志采集故障不影响业务(本地缓存) | 采集故障可能阻塞业务线程(如Kafka宕机) |

| 扩展性 | 新增日志字段仅需改输出格式 | 需改AOP代码+重启服务 |

| 性能影响 | 几乎无(Filebeat独立进程) | 高(AOP切面增加业务接口耗时10%-20%) |

2. 适用场景分析

-

AOP方案适合 :

日志字段高度固定,且需要强关联业务上下文(如接口入参/出参)的场景。例如:支付服务需记录"订单金额+支付状态"等核心字段,且日志量小(日均<100万条),可接受代码侵入。

-

现有方案适合 :

日志量大(日均>1000万条)、字段频繁变更(如运营需新增"页面停留时间"字段),且要求业务无侵入。例如:商品详情页每天有亿级浏览日志,若用AOP会导致接口响应时间从50ms增至60ms,影响用户体验。

3. 致命短板对比

-

AOP方案的核心问题:

与业务代码强耦合,日志逻辑变更需走全量测试流程;高并发下AOP切面可能成为性能瓶颈(如序列化JSON耗时)。

-

现有方案的核心问题:

无法直接获取业务内存数据(如接口内部计算结果),需微服务主动输出到日志文件才能采集。

四、与RocketMQ缓冲方案对比:Kafka vs RocketMQ

现有方案用Kafka做缓冲层,而RocketMQ是另一主流消息队列,两者对比如下:

1. 核心差异点

| 维度 | Kafka(现有方案) | RocketMQ |

|---|---|---|

| 吞吐量 | 单分区10万条/秒(日志场景最优) | 单分区5万条/秒(略低) |

| 消息模型 | 基于主题-分区,适合日志等无序场景 | 支持事务消息/定时消息,适合业务消息 |

| 生态集成 | 与Flink/Spark无缝对接(成熟连接器) | 与Flink集成较新(部分功能待完善) |

| 运维成本 | 需手动调优分区/副本(较复杂) | 自带控制台,运维简单 |

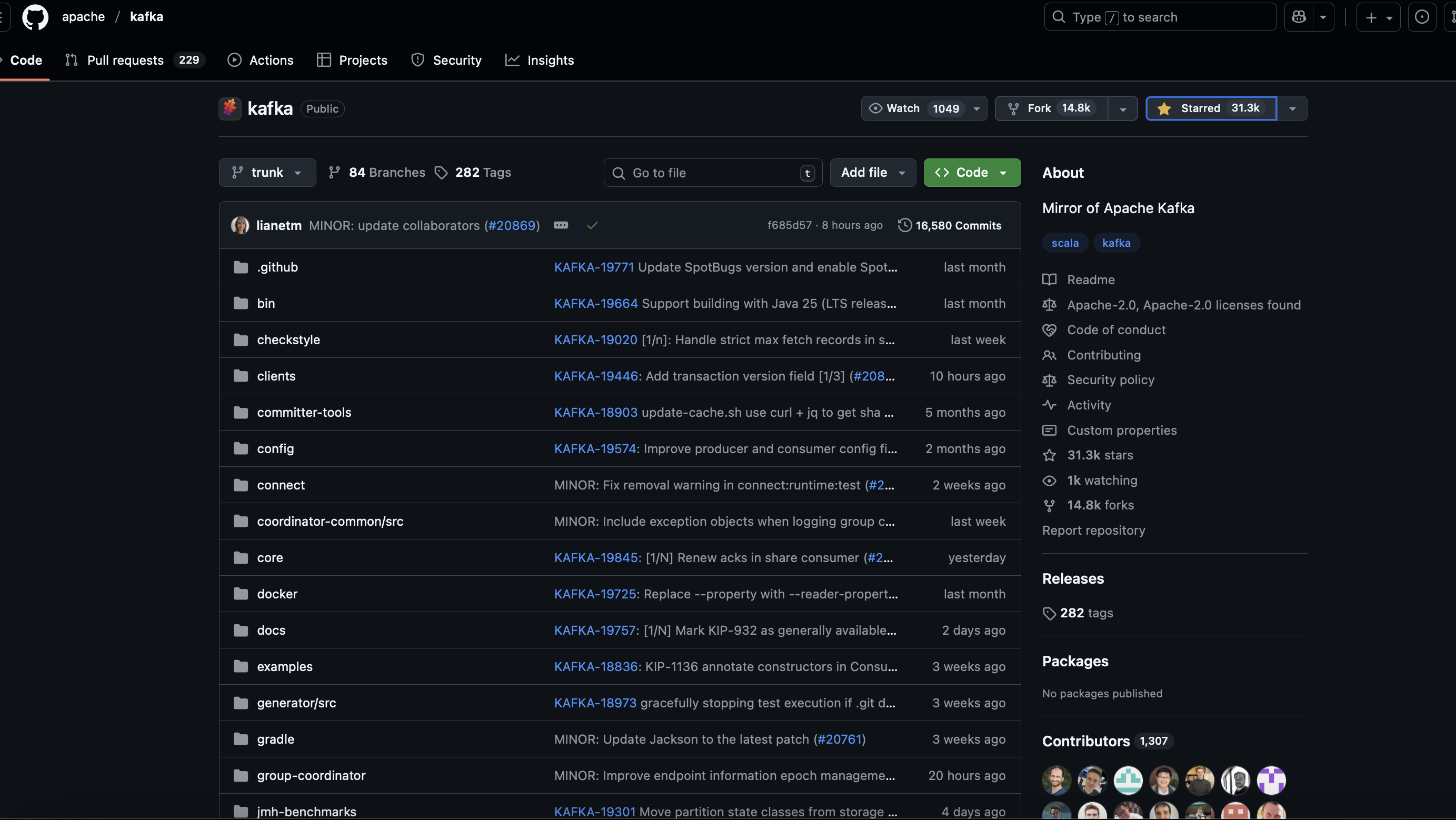

| 社区活跃度 | 全球顶级社区(Apache顶级项目) | 国内社区活跃(阿里主导) |

2. 适用场景分析

-

RocketMQ适合 :

日志与业务消息复用同一队列集群(节省资源),或需日志消息支持事务(如"日志写入成功才确认订单")。例如:中小电商同时用RocketMQ处理订单消息和日志,减少运维组件。

-

Kafka适合 :

纯日志场景,追求极致吞吐量(如日均10亿条日志)。例如:大促期间每秒10万条日志写入,Kafka的分区机制可线性扩展,而RocketMQ在高吞吐下可能出现消息堆积。

3. 致命短板对比

-

RocketMQ的核心问题:

日志场景下吞吐量略逊于Kafka;与Spark等离线组件的集成不如Kafka成熟(需自定义连接器)。

-

Kafka的核心问题:

不支持事务消息/定时消息,若需同时处理业务消息和日志,需额外部署RocketMQ,增加复杂度。

五、与大厂日志方案对比:自建vs托管

大厂日志方案(如阿里LogService、腾讯CLS、字节火山引擎日志)是托管服务,架构如下:

微服务 采集 处理+存储 可视化平台

1. 核心差异点

| 维度 | 现有方案(自建) | 大厂托管方案 |

|---|---|---|

| 成本 | 硬件+人力成本(初期高,长期低) | 按存储/流量收费(初期低,长期高) |

| 定制化 | 完全可控(可改Flink处理逻辑) | 有限(依赖厂商提供的功能) |

| 运维复杂度 | 高(需维护8+组件) | 低(厂商负责运维) |

| 数据安全性 | 数据存本地,符合强合规要求 | 数据存厂商,部分行业(金融)受限 |

| 扩展性 | 需手动扩容集群(耗时) | 自动扩容(秒级响应峰值) |

2. 适用场景分析

-

大厂方案适合 :

快速上线(无运维团队)、日志量波动大(如促销峰值是日常10倍)的场景。例如:初创电商团队仅3人,无力维护Kafka/Flink集群,用腾讯CLS按日付费(日均100GB日志成本约200元),专注业务开发。

-

现有方案适合 :

日志量大(日均>1TB)、需深度定制(如自研用户行为算法)、强合规(数据不可出本地)的场景。例如:上市电商需按《数据安全法》将日志存本地,且需用Flink实时计算个性化推荐特征,自建方案更可控。

3. 致命短板对比

-

大厂方案的核心问题:

长期成本高(日均1TB日志,年成本约7万元,自建仅需硬件成本3万元);定制化弱(如无法用Spark MLlib做用户画像训练)。

-

现有方案的核心问题:

初期投入大(需招聘大数据工程师);扩容不及时可能导致日志丢失(如大促前未提前扩容Kafka)。

六、方案选型决策指南

根据电商业务规模和需求,推荐选型如下:

| 业务规模 | 核心需求 | 推荐方案 | 典型成本(年) |

|---|---|---|---|

| 初创电商(日均<1000万条) | 快速上线+简单查询 | ELK | 硬件成本约1万元(1台服务器) |

| 中小电商(日均1000万-5000万条) | 低侵入+中等分析需求 | Filebeat+Kafka+ES+Kibana | 3-5万元(3台服务器) |

| 中大型电商(日均>5000万条) | 复杂分析+成本控制 | 现有方案(Flink+Spark+分层存储) | 10-20万元(10+台服务器) |

| 无运维团队/强弹性需求 | 零运维+按需付费 | 大厂托管方案(如阿里LogService) | 10-30万元(按流量) |

七、总结:没有最优方案,只有最合适方案

日志处理方案的选型本质是**"需求-成本-复杂度"的平衡**:

- 追求简单选ELK,追求无侵入选Filebeat,追求托管选大厂方案;

- 中小电商可从ELK起步,随着日志量增长逐步过渡到现有方案;

- 大促频繁、日志峰值高的场景,优先考虑Kafka(抗峰)+ 大厂方案(弹性)的混合架构。

最终,无论选择哪种方案,核心目标都是让日志从"存储负担"转化为"业务资产"------通过用户行为分析优化转化路径,通过异常日志监控提前发现系统风险,这才是日志处理的终极价值。