好的,Flink 任务可以通过其内置的 Web UI 进行提交和管理。以下是主要的操作步骤:

📌 步骤 1: 访问 Flink Web UI

- 确保 Flink 集群已启动:Standalone 或 YARN 等集群模式需正常运行。

- 获取 Web UI 地址 :

- 默认端口为

8081,访问格式:http://<JobManager 主机名或 IP>:8081。 - 若端口被修改,需调整访问地址。

- 默认端口为

📌 步骤 2: 提交任务

-

导航至提交页面 :

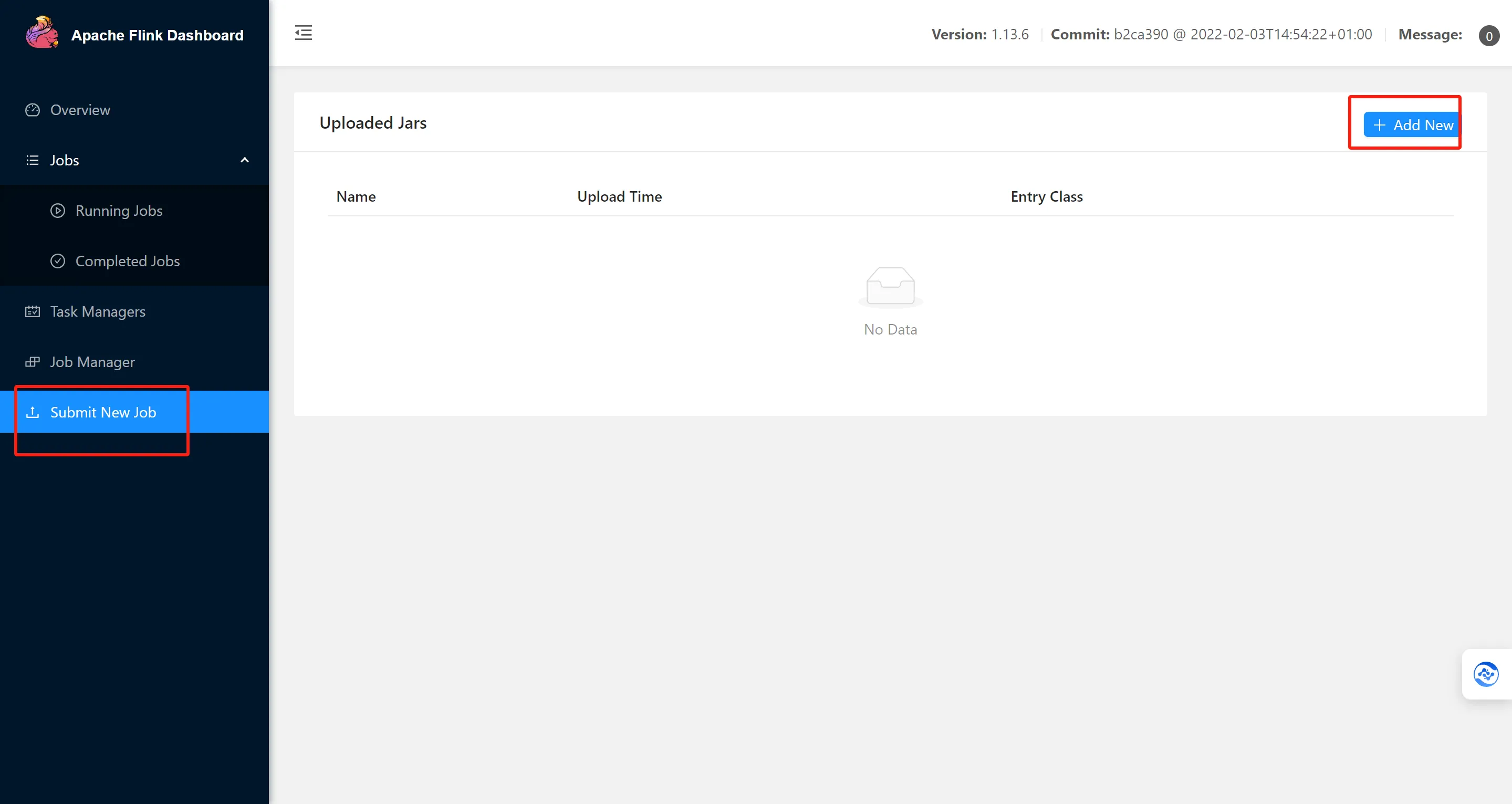

- 在 Web UI 主页点击顶部菜单的 「Submit New Job」。

-

上传 JAR 包 :

- 点击 「Add New」 按钮,上传包含任务逻辑的 JAR 文件(如

my-flink-job.jar)。

- 点击 「Add New」 按钮,上传包含任务逻辑的 JAR 文件(如

-

配置任务参数 :

# 示例参数配置(实际需在 UI 表单中填写) entry_class = "com.example.MyFlinkJob" parallelism = 4 program_args = "--input hdfs:///data --output hdfs:///result"- Entry Class:指定主类名(含包路径)。

- Parallelism:设置任务并行度。

- Program Arguments:输入任务所需的命令行参数。

-

启动任务 :

- 点击 「Submit」 按钮,任务将提交至集群执行。

📌 步骤 3: 监控任务状态

- 任务列表 :在 「Running Jobs」 或 「Completed Jobs」 中查看任务状态。

- 详细监控 :

- 点击任务 ID 进入详情页,可观察:

- 各算子的实时数据处理量(如

records_in)。 - TaskManager 的资源使用率(如

CPU %)。 - 背压状态(Backpressure)。

- 各算子的实时数据处理量(如

- 点击任务 ID 进入详情页,可观察:

⚠️ 注意事项

- 依赖管理 :

- 若任务依赖外部库,需提前将 JAR 包放入 Flink 的

lib/目录,或通过-C参数动态加载。

- 若任务依赖外部库,需提前将 JAR 包放入 Flink 的

- UI 功能限制 :

- 复杂参数(如状态后端配置)建议通过

flink run命令行提交。 - 部分高级功能(如 Savepoint 触发)需结合 API 或命令行操作。

- 复杂参数(如状态后端配置)建议通过

💡 示例场景

假设提交一个实时词频统计任务:

# Web UI 表单填写示例

entry_class = "org.apache.flink.examples.java.wordcount.WordCount"

parallelism = 2

program_args = "--input kafka://topic_logs --output redis://wordcount"通过 Web UI 提交适合快速验证和监控任务,生产环境建议结合脚本或 CI/CD 流程自动化部署。