文章目录

- 智能体经典范式构建

-

-

- [配置 API 密钥](#配置 API 密钥)

- [封装基础 LLM 调用函数](#封装基础 LLM 调用函数)

- ReAct

-

- [ReAct 的工作流程](#ReAct 的工作流程)

- 工具的定义与实现

- [ReAct 智能体的编码实现](#ReAct 智能体的编码实现)

- ReAct的特点、局限性与调试技巧

- PlanAndSolve

- 规划阶段

- 执行器与状态管理

- Reflection

-

- [Reflection 机制的核心思想](#Reflection 机制的核心思想)

- 案例设定与记忆模块设计

-

智能体经典范式构建

- ReAct (Reasoning and Acting): 一种将"思考"和"行动"紧密结合的范式,让智能体边想边做,动态调整。

- Plan-and-Solve: 一种"三思而后行"的范式,智能体首先生成一个完整的行动计划,然后严格执行。

- Reflection: 一种赋予智能体"反思"能力的范式,通过自我批判和修正来优化结果。

python

pip install openai python-dotenv配置 API 密钥

为了让我们的代码更通用,我们将模型服务的相关信息(模型ID、API密钥、服务地址)统一配置在环境变量中。

在你的项目根目录下,创建一个名为 .env 的文件。

在该文件中,添加以下内容。你可以根据自己的需要,将其指向 OpenAI 官方服务,或任何兼容 OpenAI 接口的本地/第三方服务。

如果实在不知道如何获取,可以参考Datawhale另一本教程的1.2 API设置

python

# .env file

LLM_API_KEY="YOUR-API-KEY"

LLM_MODEL_ID="YOUR-MODEL"

LLM_BASE_URL="YOUR-URL"封装基础 LLM 调用函数

为了让代码结构更清晰、更易于复用,我们来定义一个专属的LLM客户端类。这个类将封装所有与模型服务交互的细节,让我们的主逻辑可以更专注于智能体的构建。

python

import os

from openai import OpenAI

from dotenv import load_dotenv

from typing import List, Dict

# 加载 .env 文件中的环境变量

load_dotenv()

class HelloAgentsLLM:

"""

为本书 "Hello Agents" 定制的LLM客户端。

它用于调用任何兼容OpenAI接口的服务,并默认使用流式响应。

"""

def __init__(self, model: str = None, apiKey: str = None, baseUrl: str = None, timeout: int = None):

"""

初始化客户端。优先使用传入参数,如果未提供,则从环境变量加载。

"""

self.model = model or os.getenv("LLM_MODEL_ID")

apiKey = apiKey or os.getenv("LLM_API_KEY")

baseUrl = baseUrl or os.getenv("LLM_BASE_URL")

timeout = timeout or int(os.getenv("LLM_TIMEOUT", 60))

if not all([self.model, apiKey, baseUrl]):

raise ValueError("模型ID、API密钥和服务地址必须被提供或在.env文件中定义。")

self.client = OpenAI(api_key=apiKey, base_url=baseUrl, timeout=timeout)

def think(self, messages: List[Dict[str, str]], temperature: float = 0) -> str:

"""

调用大语言模型进行思考,并返回其响应。

"""

print(f"🧠 正在调用 {self.model} 模型...")

try:

response = self.client.chat.completions.create(

model=self.model,

messages=messages,

temperature=temperature,

stream=True,

)

# 处理流式响应

print("✅ 大语言模型响应成功:")

collected_content = []

for chunk in response:

content = chunk.choices[0].delta.content or ""

print(content, end="", flush=True)

collected_content.append(content)

print() # 在流式输出结束后换行

return "".join(collected_content)

except Exception as e:

print(f"❌ 调用LLM API时发生错误: {e}")

return None

# --- 客户端使用示例 ---

if __name__ == '__main__':

try:

llmClient = HelloAgentsLLM()

exampleMessages = [

{"role": "system", "content": "You are a helpful assistant that writes Python code."},

{"role": "user", "content": "写一个快速排序算法"}

]

print("--- 调用LLM ---")

responseText = llmClient.think(exampleMessages)

if responseText:

print("\n\n--- 完整模型响应 ---")

print(responseText)

except ValueError as e:

print(e)ReAct

在准备好LLM客户端之后,我们将构建第一个,也是最经典的一个智能体范式ReAct(Reson+Act)

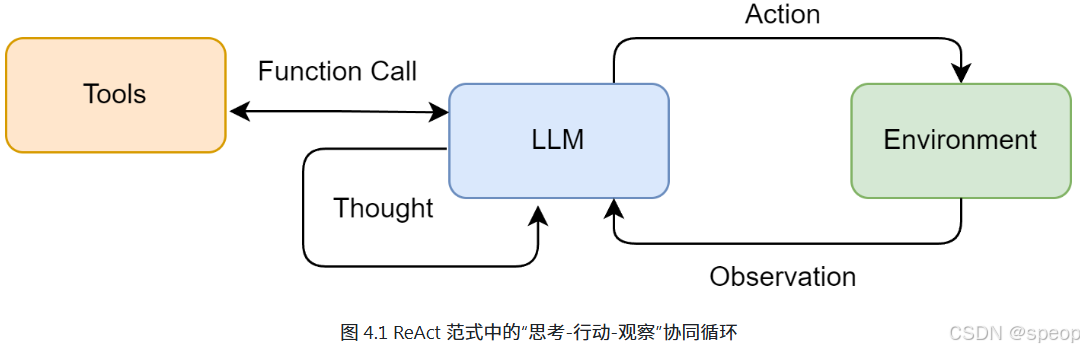

ReAct其核心思想是模仿人类解决问题的方式,将推理 (Reasoning) 与行动 (Acting) 显式地结合起来,形成一个"思考-行动-观察"的循环。

ReAct 的工作流程

在ReAct诞生之前,主流的方法可以分为两类:

一类是"纯思考"型,如思维链 (Chain-of-Thought) ,它能引导模型进行复杂的逻辑推理,但无法与外部世界交互,容易产生事实幻觉;

另一类是"纯行动"型,模型直接输出要执行的动作,但缺乏规划和纠错能力。

ReAct的巧妙之处在于,它认识到思考与行动是相辅相成的 。思考指导行动,而行动的结果又反过来修正思考。为此,ReAct范式通过一种特殊的提示工程来引导模型,使其每一步的输出都遵循一个固定的轨迹:

- Thought (思考): 这是智能体的"内心独白"。它会分析当前情况、分解任务、制定下一步计划,或者反思上一步的结果。

- Action (行动) : 这是智能体决定采取的具体动作,通常是调用一个外部工具,例如

Search['华为最新款手机']。 - Observation (观察): 这是执行Action后从外部工具返回的结果,例如搜索结果的摘要或API的返回值。

智能体将不断重复这个 Thought -> Action -> Observation 的循环,将新的观察结果追加到历史记录中,形成一个不断增长的上下文,直到它在Thought中认为已经找到了最终答案,然后输出结果。这个过程形成了一个强大的协同效应:推理使得行动更具目的性,而行动则为推理提供了事实依据。

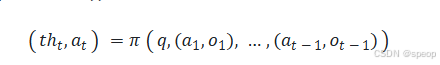

我们可以将这个过程形式化地表示出来,如图所示。具体来说,在每个时间步t,智能体的策略(即大模型Π)会根据初始问题q和之间所有步骤的"行动-观察"历史轨迹 ( ( a 1 . o 1 ) , . . . . . . , ( a t − 1 , o t − 1 ) ) ((a_1.o_1),......,(a_{t-1},o_{t-1})) ((a1.o1),......,(at−1,ot−1))

随后,环境中的工具T会执行行动 a t a_t at,并返回一个新的观察结果 o t o_t ot:

o t = T ( a t ) o_t=T(a_t) ot=T(at)

这个循环不断进行,将新的 ( a t , o t ) (a_t,o_t) (at,ot)对追加到历史中,直到模型在思考 t h t th_t tht中判断任务已完成。

这种机制特别适用于以下场景:

- 需要外部知识的任务:如查询实时信息(天气、新闻、股价)、搜索专业领域的知识等。

- 需要精确计算的任务:将数学问题交给计算器工具,避免LLM的计算错误。

- 需要与API交互的任务 :如操作数据库、调用某个服务的API来完成特定功能。

因此我们将构建一个具备使用外部工具能力的ReAct智能体,来回答一个大语言模型仅凭自身知识库无法直接回答的问题。例如:"华为最新的手机是哪一款?它的主要卖点是什么?" 这个问题需要智能体理解自己需要上网搜索,调用工具搜索结果并总结答案。

工具的定义与实现

如果说大语言模型是智能体的大脑,那么工具 (Tools) 就是其与外部世界交互的"手和脚"。为了让ReAct范式能够真正解决我们设定的问题,智能体需要具备调用外部工具的能力。

针对本节设定的目标------回答关于"华为最新手机"的问题,我们需要为智能体提供一个网页搜索工具。在这里我们选用 SerpApi,它通过API提供结构化的Google搜索结果,能直接返回"答案摘要框"或精确的知识图谱信息,

首先,需要安装该库:

python

pip install google-search-results同时,你需要前往 SerpApi官网 注册一个免费账户,获取你的API密钥,并将其添加到我们项目根目录下的 .env 文件中:

# .env file

# ... (保留之前的LLM配置)

SERPAPI_API_KEY="YOUR_SERPAPI_API_KEY"接下来,我们通过代码来定义和管理这个工具。我们将分步进行:首先实现工具的核心功能,然后构建一个通用的工具管理器。

(1)实现搜索工具的核心逻辑

一个良好定义的工具应包含以下三个核心要素:

- 名称 (Name): 一个简洁、唯一的标识符,供智能体在 Action 中调用,例如 Search。

- 描述 (Description): 一段清晰的自然语言描述,说明这个工具的用途。这是整个机制中最关键的部分,因为大语言模型会依赖这段描述来判断何时使用哪个工具。

- 执行逻辑 (Execution Logic) : 真正执行任务的函数或方法。

我们的第一个工具是 search 函数,它的作用是接收一个查询字符串,然后返回搜索结果。

python

from serpapi import SerpApiClient

def search(query:str ) -> str:

"""

一个基于SerpApi的实战网页搜索引擎工具,

它会智能的解析搜索结果,优先返回直接答案或知识图谱信息。

"""

print(f"正在执行[serpaApi]网页搜索:{query}")

try:

api_key = os.getenv("SERPAPI_API_KEY")

if not api_key:

return "错误:SERPAPI_API_KEY未设置"

params = {

"engine":"google",

"q":query,

"api_key":api_key,

"gl":"cn",#gl 代表 "geolocation"(地理位置)

"hl":"zh-cn",#语言代码 "zh-cn"代表简体中文

}

client = SerpApiClient(params)

results = client.get_dict()

#智能解析:优先搜索最直接的答案

if "answer_box_list" in results:

return "\n".join(results["answer_box_list"])

if "answer_box" in results and "answer" in results["answer_box"]:

return results["answer_box"]["answer"]

if "knowledge_graph" in results and "description" in results["knowledge_graph"]:

return results["knowledge_graph"]["description"]

#前两项都不存在时,检查是否存在知识图谱

if "organic_results" in results and results["organic_results"]:

snippets = [

f"[{i+1}] {res.get('title','')}\n{res.get('snippet','')}"

for i,res in enumerate(results["organic_results"][:3])

]

return "\n\n".join(snippets)

#最低优先级:organic_results

return f"对不起,没有找到关于'{query}'的信息。"

except Exception as e:

return f"搜索的时候发生错误:{e}"(2) 构建通用的工具执行器

当智能体需要使用多种工具时(例如,除了搜索,还可能需要计算、查询数据库等),我们需要一个统一的管理器来注册和调度这些工具。为此,我们创建一个 ToolExecutor 类。

python

from typing import Dict, Any

class ToolExecutor:

"""

一个工具执行器,负责管理和执行工具。

"""

def __init__(self):

self.tools: Dict[str, Dict[str, Any]] = {}

def registerTool(self, name: str, description: str, func: callable):

"""

向工具箱中注册一个新工具。

"""

if name in self.tools:

print(f"警告:工具 '{name}' 已存在,将被覆盖。")

self.tools[name] = {"description": description, "func": func}

print(f"工具 '{name}' 已注册。")

def getTool(self, name: str) -> callable:

"""

根据名称获取一个工具的执行函数。

"""

return self.tools.get(name, {}).get("func")

def getAvailableTools(self) -> str:

"""

获取所有可用工具的格式化描述字符串。

"""

return "\n".join([

f"- {name}: {info['description']}"

for name, info in self.tools.items()

])(3)测试

现在,我们将 search 工具注册到 ToolExecutor 中,并模拟一次调用,以验证整个流程是否正常工作。

python

# --- 工具初始化与使用示例 ---

if __name__ == '__main__':

# 1. 初始化工具执行器

toolExecutor = ToolExecutor()

# 2. 注册我们的实战搜索工具

search_description = "一个网页搜索引擎。当你需要回答关于时事、事实以及在你的知识库中找不到的信息时,应使用此工具。"

toolExecutor.registerTool("Search", search_description, search)

# 3. 打印可用的工具

print("\n--- 可用的工具 ---")

print(toolExecutor.getAvailableTools())

# 4. 智能体的Action调用,这次我们问一个实时性的问题

print("\n--- 执行 Action: Search['英伟达最新的GPU型号是什么'] ---")

tool_name = "Search"

tool_input = "英伟达最新的GPU型号是什么"

tool_function = toolExecutor.getTool(tool_name)

if tool_function:

observation = tool_function(tool_input)

print("--- 观察 (Observation) ---")

print(observation)

else:

print(f"错误:未找到名为 '{tool_name}' 的工具。")

>>>

工具 'Search' 已注册。

--- 可用的工具 ---

- Search: 一个网页搜索引擎。当你需要回答关于时事、事实以及在你的知识库中找不到的信息时,应使用此工具。

--- 执行 Action: Search['英伟达最新的GPU型号是什么'] ---

🔍 正在执行 [SerpApi] 网页搜索: 英伟达最新的GPU型号是什么

--- 观察 (Observation) ---

[1] GeForce RTX 50 系列显卡

GeForce RTX™ 50 系列GPU 搭载NVIDIA Blackwell 架构,为游戏玩家和创作者带来全新玩法。RTX 50 系列具备强大的AI 算力,带来升级体验和更逼真的画面。

[2] 比较GeForce 系列最新一代显卡和前代显卡

比较最新一代RTX 30 系列显卡和前代的RTX 20 系列、GTX 10 和900 系列显卡。查看规格、功能、技术支持等内容。

[3] GeForce 显卡| NVIDIA

DRIVE AGX. 强大的车载计算能力,适用于AI 驱动的智能汽车系统 · Clara AGX. 适用于创新型医疗设备和成像的AI 计算. 游戏和创作. GeForce. 探索显卡、游戏解决方案、AI ...ReAct 智能体的编码实现

现在,我们将所有独立的组件,LLM客户端和工具执行器组装起来,构建一个完整的 ReAct 智能体。我们将通过一个 ReActAgent 类来封装其核心逻辑。为了便于理解,我们将这个类的实现过程拆分为以下几个关键部分进行讲解。

(1)系统提示词设计

提示词是整个 ReAct 机制的基石,它为大语言模型提供了行动的操作指令。我们需要精心设计一个模板,它将动态地插入可用工具、用户问题以及中间步骤的交互历史。

python

# ReAct 提示词模板

REACT_PROMPT_TEMPLATE = """

请注意,你是一个有能力调用外部工具的智能助手。

可用工具如下:

{tools}

请严格按照以下格式进行回应:

Thought: 你的思考过程,用于分析问题、拆解任务和规划下一步行动。

Action: 你决定采取的行动,必须是以下格式之一:

- `{{tool_name}}[{{tool_input}}]`:调用一个可用工具。

- `Finish[最终答案]`:当你认为已经获得最终答案时。

- 当你收集到足够的信息,能够回答用户的最终问题时,你必须在Action:字段后使用 finish(answer="...") 来输出最终答案。

现在,请开始解决以下问题:

Question: {question}

History: {history}

"""这个模板定义了智能体与LLM之间交互的规范:

- 角色定义: "你是一个有能力调用外部工具的智能助手",设定了LLM的角色。

- 工具清单 ({tools}): 告知LLM它有哪些可用的"手脚"。

- 格式规约 (Thought/Action): 这是最重要的部分,它强制LLM的输出具有结构性,使我们能通过代码精确解析其意图。

- 动态上下文 ({question}/{history}): 将用户的原始问题和不断累积的交互历史注入,让LLM基于完整的上下文进行决策。

(2) 核心循环的实现

ReActAgent的核心是一个循环,它不断地"格式化提示词->调用LLM->执行操作->整合结果".直到任务完整或达到最大步数限制。

python

class ReActAgent:

def __init__(self, llm_client: HelloAgentsLLM, tool_executor: ToolExecutor, max_steps: int = 5):

self.llm_client = llm_client

self.tool_executor = tool_executor

self.max_steps = max_steps

self.history = []

def run(self, question: str):

"""

运行ReAct智能体来回答一个问题。

"""

self.history = [] # 每次运行时重置历史记录

current_step = 0

#while循环是主题

while current_step < self.max_steps:

#max_steps参数是一个重要的安全阀.防止智能体陷入无限循环耗尽资源.

current_step += 1

print(f"--- 第 {current_step} 步 ---")

# 1. 格式化提示词

tools_desc = self.tool_executor.getAvailableTools()

history_str = "\n".join(self.history)

prompt = REACT_PROMPT_TEMPLATE.format(

tools=tools_desc,

question=question,

history=history_str

)

# 2. 调用LLM进行思考

messages = [{"role": "user", "content": prompt}]

response_text = self.llm_client.think(messages=messages)

if not response_text:

print("错误:LLM未能返回有效响应。")

break

# ... (后续的解析、执行、整合步骤)run方法是智能体的入口,它的while循环构成了ReAct范式的主体,max_steps参数则是一个重要的安全阀,防止智能体陷入无限循环而耗尽资源。

(3)输出解析器的实现

LLM 返回的是纯文本,我们需要从中精确地提取出Thought和Action。这是通过几个辅助解析函数完成的,它们通常使用正则表达式来实现。

python

# (这些方法是 ReActAgent 类的一部分)

def _parse_output(self, text: str):

"""解析LLM的输出,提取Thought和Action。"""

thought_match = re.search(r"Thought: (.*)", text)

action_match = re.search(r"Action: (.*)", text)

thought = thought_match.group(1).strip() if thought_match else None

action = action_match.group(1).strip() if action_match else None

return thought, action

def _parse_action(self, action_text: str):

"""解析Action字符串,提取工具名称和输入。"""

match = re.match(r"(\w+)\[(.*)\]", action_text)

if match:

return match.group(1), match.group(2)

return None, None

- _parse_output: 负责从LLM的完整响应中分离出Thought和Action两个主要部分。

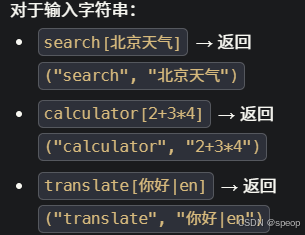

- _parse_action: 负责进一步解析Action字符串,例如从 Search[华为最新手机] 中提取出工具名 Search 和工具输入 华为最新手机。

(4) 工具调用与执行

python

# (这段逻辑在 run 方法的 while 循环内)

# 3. 解析LLM的输出

thought, action = self._parse_output(response_text)

if thought:

print(f"思考: {thought}")

if not action:

print("警告:未能解析出有效的Action,流程终止。")

break

# 4. 执行Action

if action.startswith("Finish"):

# 如果是Finish指令,提取最终答案并结束

final_answer = re.match(r"Finish\[(.*)\]", action).group(1)

print(f"🎉 最终答案: {final_answer}")

return final_answer

tool_name, tool_input = self._parse_action(action)

if not tool_name or not tool_input:

# ... 处理无效Action格式 ...

continue

print(f"🎬 行动: {tool_name}[{tool_input}]")

tool_function = self.tool_executor.getTool(tool_name)

if not tool_function:

observation = f"错误:未找到名为 '{tool_name}' 的工具。"

else:

observation = tool_function(tool_input) # 调用真实工具这段代码是Action的执行中心。它首先检查是否为Finish指令,如果是,则流程结束。否则,它会通过tool_executor获取对应的工具函数并执行,得到observation。

(5)观测结果的整合

最后一步,也是形成闭环的关键,是将Action本身和工具执行后的Observation添加回历史记录中,为下一轮循环提供新的上下文。

python

# (这段逻辑紧随工具调用之后,在 while 循环的末尾)

print(f"👀 观察: {observation}")

# 将本轮的Action和Observation添加到历史记录中

self.history.append(f"Action: {action}")

self.history.append(f"Observation: {observation}")

# 循环结束

print("已达到最大步数,流程终止。")

return None通过将Observation追加到self.history,智能体在下一轮生成提示词时,就能"看到"上一步行动的结果,并据此进行新一轮的思考和规划。

(6)运行实例与分析

将以上所有部分组合起来,我们就得到了完整的 ReActAgent 类。完整的代码运行实例可以在本书配套的代码仓库 code 文件夹中找到。

下面是一次真实的运行记录:

工具 'Search' 已注册。

--- 第 1 步 ---

🧠 正在调用 xxxxxx 模型...

✅ 大语言模型响应成功:

Thought: 要回答这个问题,我需要查找华为最新发布的手机型号及其主要特点。这些信息可能在我的现有知识库之外,因此需要使用搜索引擎来获取最新数据。

Action: Search[华为最新手机型号及主要卖点]

🤔 思考: 要回答这个问题,我需要查找华为最新发布的手机型号及其主要特点。这些信息可能在我的现有知识库之外,因此需要使用搜索引擎来获取最新数据。

🎬 行动: Search[华为最新手机型号及主要卖点]

🔍 正在执行 [SerpApi] 网页搜索: 华为最新手机型号及主要卖点

👀 观察: [1] 华为手机- 华为官网

智能手机 ; Mate 系列. 非凡旗舰 · HUAWEI Mate XTs. 非凡大师 ; Pura 系列. 先锋影像 · HUAWEI Pura 80 Pro+ ; Pocket 系列. 美学新篇. HUAWEI Pocket 2 ; nova 系列. 专业人像.

[2] 2025年华为手机哪一款性价比高?华为手机推荐与市场分析 ...

现在华为手机最大的卖点只剩下鸿蒙HarmonyOS系统,以及饱受争议的品牌信仰。 这里推荐目前值得入手的几款华为系列手机,根据不同预算自行选择:. 华为目前最受欢迎,也是搭载 ...

[3] 2025年华为新款手机哪个性价比高?10款华为新款手机推荐

选华为主要还是要推荐高端手机,Mate 70和Pura 70系列是最新发布的旗舰机型。 HUAWEI Mate 70. 优点是,拍照配置依旧顶级,全焦段覆盖,适合专业摄影,做工出色,户外抗摔 ...

--- 第 2 步 ---

🧠 正在调用 xxxxxx 模型...

✅ 大语言模型响应成功:

Thought: 根据搜索结果,华为最新发布的旗舰机型包括Mate 70和Pura 80 Pro+。为了确定最新型号及其主要卖点,我将重点放在这些信息上。从提供的链接来看,Mate 70系列和Pura 80 Pro+都是近期发布的产品,但具体哪一个是"最新"还需要进一步确认。同时,我可以从这些信息中提取出它们的主要

卖点。

Action: Finish[根据最新信息,华为的最新手机可能是HUAWEI Pura 80 Pro+或HUAWEI Mate 70。其中,HUAWEI Mate 70的主要卖点包括顶级的拍照配置,全焦段覆盖,适合专业摄影,做工出色,并且具有良好的户外抗摔性能。而HUAWEI Pura 80 Pro+则强调了先锋影像技术。]

🤔 思考: 根据搜索结果,华为最新发布的旗舰机型包括Mate 70和Pura 80 Pro+。为了确定最新型号及其主要卖点,我将重点放在这些信息上。从提供的链接来看,Mate 70系列和Pura 80 Pro+都是近期发布的产品,但具体哪一个是"最新"还需要进一步确认。同时,我可以从这些信息中提取出它们的主要

卖点。

🎉 最终答案: 根据最新信息,华为的最新手机可能是HUAWEI Pura 80 Pro+或HUAWEI Mate 70。其中,HUAWEI Mate 70的主要卖点包括顶级的拍照配置,全焦段覆盖,适合专业摄影,做工出色,并且具有良好的户外抗摔性能。而HUAWEI Pura 80 Pro+则强调了先锋影像技术。ReAct的特点、局限性与调试技巧

通过亲手实现一个 ReAct 智能体,我们不仅掌握了其工作流程,也应该对其内在机制有了更深刻的认识。任何技术范式都有其闪光点和待改进之处,本节将对 ReAct 进行总结。

(1)ReAct 的主要特点

- 高可解释性: ReAct 最大的优点之一就是透明。通过

Thought链,我们可以清晰地看到智能体每一步的"心路历程"------它为什么会选择这个工具,下一步又打算做什么。这对于理解、信任和调试智能体的行为至关重要。 - 动态规划与纠错能力: 与一次性生成完整计划的范式不同,ReAct 是"走一步,看一步"。它根据每一步从外部世界获得的

Observation来动态调整后续的Thought和Action。如果上一步的搜索结果不理想,它可以在下一步中修正搜索词,重新尝试。 - 工具协同能力: ReAct 范式天然地将大语言模型的推理能力与外部工具的执行能力结合起来。LLM 负责运筹帷幄 (规划和推理),工具负责解决具体问题(搜索、计算),二者协同工作,突破了单一 LLM 在知识时效性、计算准确性等方面的固有局限。

(2)ReAct 的固有局限性

- 对LLM自身能力的强依赖:ReAct 流程的成功与否,高度依赖于底层 LLM 的综合能力。如果 LLM 的逻辑推理能力、指令遵循能力或格式化输出能力不足,就很容易在 Thought 环节产生错误的规划,或者在 Action 环节生成不符合格式的指令,导致整个流程中断。

- 执行效率问题:由于其循序渐进的特性,完成一个任务通常需要多次调用 LLM。每一次调用都伴随着网络延迟和计算成本。对于需要很多步骤的复杂任务,这种串行的"思考-行动"循环可能会导致较高的总耗时和费用。

- 提示词的脆弱性:整个机制的稳定运行建立在一个精心设计的提示词模板之上。模板中的任何微小变动,甚至是用词的差异,都可能影响 LLM 的行为。此外,并非所有模型都能持续稳定地遵循预设的格式,这增加了在实际应用中的不确定性。

- 可能陷入局部最优:步进式的决策模式意味着智能体缺乏一个全局的、长远的规划。它可能会因为眼前的 Observation 而选择一个看似正确但长远来看并非最优的路径,甚至在某些情况下陷入"原地打转"的循环中。

(3)调试技巧

当你构建的 ReAct 智能体行为不符合预期时,可以从以下几个方面入手进行调试:

- **检查完整的提示词:**在每次调用 LLM 之前,将最终格式化好的、包含所有历史记录的完整提示词打印出来。这是追溯 LLM 决策源头的最直接方式。

- **分析原始输出:**当输出解析失败时(例如,正则表达式没有匹配到 Action),务必将 LLM 返回的原始、未经处理的文本打印出来。这能帮助你判断是 LLM 没有遵循格式,还是你的解析逻辑有误。

- **验证工具的输入与输出:**检查智能体生成的 tool_input 是否是工具函数所期望的格式,同时也要确保工具返回的 observation 格式是智能体可以理解和处理的。

- **调整提示词中的示例 (Few-shot Prompting):**如果模型频繁出错,可以在提示词中加入一两个完整的"Thought-Action-Observation"成功案例,通过示例来引导模型更好地遵循你的指令。

- **尝试不同的模型或参数:**更换一个能力更强的模型,或者调整 temperature 参数(通常设为0以保证输出的确定性),有时能直接解决问题。

PlanAndSolve

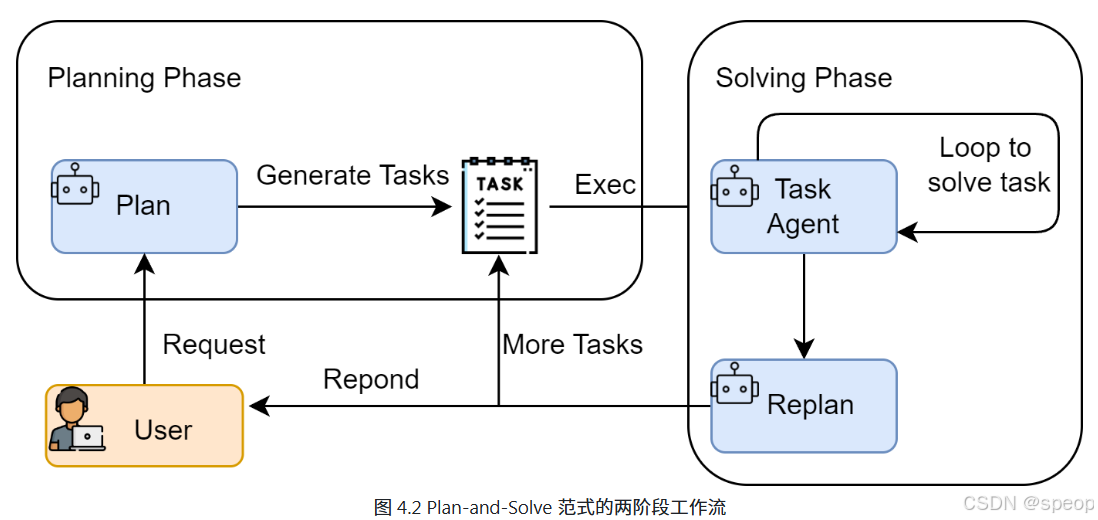

在我们掌握了 ReAct 这种反应式的、步进决策的智能体范式后,接下来将探讨一种风格迥异但同样强大的方法,Plan-and-Solve。顾名思义,这种范式将任务处理明确地分为两个阶段:先规划 (Plan),后执行 (Solve)。

如果说 ReAct 像一个经验丰富的侦探,根据现场的蛛丝马迹(Observation)一步步推理,随时调整自己的调查方向;那么 Plan-and-Solve 则更像一位建筑师,在动工之前必须先绘制出完整的蓝图(Plan),然后严格按照蓝图来施工(Solve)。事实上我们现在用的很多大模型工具的Agent模式都融入了这种设计模式。

Plan-and-Solve的工作原理

Plan-and-Solve Prompting 由 Lei Wang 在2023年提出[2]。其核心动机是为了解决思维链在处理多步骤、复杂问题时容易"偏离轨道"的问题。

与 ReAct 将思考和行动融合在每一步不同,Plan-and-Solve 将整个流程解耦为两个核心阶段,如图4.2所示:

- 规划阶段 (Planning Phase): 首先,智能体会接收用户的完整问题。它的第一个任务不是直接去解决问题或调用工具,而是将问题分解 ,并制定出一个清晰、分步骤的行动计划。这个计划本身就是一次大语言模型的调用产物。

- 执行阶段 (Solving Phase): 在获得完整的计划后,智能体进入执行阶段。它会严格按照计划中的步骤,逐一执行。每一步的执行都可能是一次独立的 LLM 调用,或者是对上一步结果的加工处理,直到计划中的所有步骤都完成,最终得出答案。

这种"先谋后动"的策略,使得智能体在处理需要长远规划的复杂任务时,能够保持更高的目标一致性,避免在中间步骤中迷失方向。

我们可以将这个两阶段过程进行形式化表达。首先,规划模型 π p l a n \pi_{plan} πplan根据原始问题q生成一个包含n个步骤的计划 P = ( p 1 , p 2 , . . . , p n ) P=(p_1,p_2,...,p_n) P=(p1,p2,...,pn)

P = π p l a n ( q ) P=\pi_{plan}(q) P=πplan(q)

随后,在执行阶段,执行模型 π s o l v e \pi_{solve} πsolve会逐一完成计划中的步骤。对于 i i i个步骤,其解决方案 s i s_i si的生成会同时依赖于原始问题 q q q、完整计划 P P P以及之前所有步骤的执行结果 ( s 1 , . . . , s i − 1 ) (s_1,...,s_{i-1}) (s1,...,si−1)

s i = π s o l v e ( q , P , ( s 1 , . . . , s i − 1 ) ) s_i = \pi_{solve}(q,P,(s_1,...,s_{i-1})) si=πsolve(q,P,(s1,...,si−1))

最终的答案就是最后一个步骤的执行结果 s n s_n sn

Plan-and-Solve 尤其适用于那些结构性强、可以被清晰分解的复杂任务,例如:

- 多步数学应用题:需要先列出计算步骤,再逐一求解。

- 需要整合多个信息源的报告撰写:需要先规划好报告结构(引言、数据来源A、数据来源B、总结),再逐一填充内容。

- 代码生成任务:需要先构思好函数、类和模块的结构,再逐一实现。

规划阶段

为了凸显 Plan-and-Solve 范式在结构化推理任务上的优势,我们将不使用工具的方式,而是通过提示词的设计 ,完成一个推理任务。

这类任务的特点是,答案无法通过单次查询或计算得出,必须先将问题分解 为一系列逻辑连贯的子步骤,然后按顺序求解。这恰好能发挥 Plan-and-Solve "先规划,后执行"的核心能力。

我们的目标问题是:"一个水果店周一卖出了15个苹果。周二卖出的苹果数量是周一的两倍。周三卖出的数量比周二少了5个。请问这三天总共卖出了多少个苹果?"

这个问题对于大语言模型来说并不算特别困难,但它包含了一个清晰的逻辑链条可供参考。在某些实际的逻辑难题上,如果大模型不能高质量的推理出准确的答案,可以参考这个设计模式来设计自己的Agent完成任务。智能体需要:

- 规划阶段:首先,将问题分解为三个独立的计算步骤(计算周二销量、计算周三销量、计算总销量)。

- 执行阶段 :然后,严格按照计划,一步步执行计算,并将每一步的结果作为下一步的输入,最终得出总和。

规划阶段的目标是让大语言模型接收原始问题,并输出一个清晰、分步骤的行动计划。这个计划必须是结构化的,以便我们的代码可以轻松解析并逐一执行。因此,我们设计的提示词需要明确地告诉模型它的角色和任务,并给出一个输出格式的范例。

python

PLANNER_PROMPT_TEMPLATE = """

你是一个顶级的AI规划专家。你的任务是将用户提出的复杂问题分解成一个由多个简单步骤组成的行动计划。

请确保计划中的每个步骤都是一个独立的、可执行的子任务,并且严格按照逻辑顺序排列。

你的输出必须是一个Python列表,其中每个元素都是一个描述子任务的字符串。

问题: {question}

请严格按照以下格式输出你的计划,```python与```作为前后缀是必要的:

["步骤1", "步骤2", "步骤3", ...]

"""这个提示词通过以下几点确保了输出的质量和稳定性:

- 角色设定: "顶级的AI规划专家",激发模型的专业能力。

- 任务描述: 清晰地定义了"分解问题"的目标。

- 格式约束: 强制要求输出为一个 Python 列表格式的字符串,这极大地简化了后续代码的解析工作,使其比解析自然语言更稳定、更可靠。

接下来,我们将这个提示词逻辑封装成一个 Planner 类,这个类也是我们的规划器。

python

# 假定 llm_client.py 中的 HelloAgentsLLM 类已经定义好

# from llm_client import HelloAgentsLLM

class Planner:

def __init__(self, llm_client):

self.llm_client = llm_client

def plan(self, question: str) -> list[str]:

"""

根据用户问题生成一个行动计划。

"""

prompt = PLANNER_PROMPT_TEMPLATE.format(question=question)

# 为了生成计划,我们构建一个简单的消息列表

messages = [{"role": "user", "content": prompt}]

print("--- 正在生成计划 ---")

# 使用流式输出来获取完整的计划

response_text = self.llm_client.think(messages=messages) or ""

print(f"✅ 计划已生成:\n{response_text}")

# 解析LLM输出的列表字符串

try:

# 找到```python和```之间的内容

plan_str = response_text.split("```python")[1].split("```")[0].strip()

# 使用ast.literal_eval来安全地执行字符串,将其转换为Python列表

plan = ast.literal_eval(plan_str)

return plan if isinstance(plan, list) else []

except (ValueError, SyntaxError, IndexError) as e:

print(f"❌ 解析计划时出错: {e}")

print(f"原始响应: {response_text}")

return []

except Exception as e:

print(f"❌ 解析计划时发生未知错误: {e}")

return []response_text.split("```python")[1] 为例:

如果 response_text 包含 "python 代码内容"

分割后会得到类似 ['前面的文本', ' 代码内容```', '后面的文本'] 的列表'

ast.literal_eval 是 Python 的 ast 模块中的一个安全函数,主要作用是:安全地将字符串形式的 Python 字面量表达式转换为对应的 Python 对象。

执行器与状态管理

在规划器 (Planner) 生成了清晰的行动蓝图后,我们就需要一个执行器 (Executor) 来逐一完成计划中的任务。执行器 不仅负责调用大语言模型来解决每个子问题,还承担着一个至关重要的角色:状态管理 。它必须记录每一步的执行结果,并将其作为上下文提供给后续步骤,确保信息在整个任务链条中顺畅流动。

执行器的提示词与规划器不同。它的目标不是分解问题,而是在已有上下文的基础上,专注解决当前这一个步骤。因此,提示词需要包含以下关键信息:

- 原始问题: 确保模型始终了解最终目标。

- 完整计划: 让模型了解当前步骤在整个任务中的位置。

- 历史步骤与结果: 提供至今为止已经完成的工作,作为当前步骤的直接输入。

- 当前步骤: 明确指示模型现在需要解决哪一个具体任务。

python

EXECUTOR_PROMPT_TEMPLATE = """

你是一位顶级的AI执行专家。你的任务是严格按照给定的计划,一步步地解决问题。

你将收到原始问题、完整的计划、以及到目前为止已经完成的步骤和结果。

请你专注于解决"当前步骤",并仅输出该步骤的最终答案,不要输出任何额外的解释或对话。

# 原始问题:

{question}

# 完整计划:

{plan}

# 历史步骤与结果:

{history}

# 当前步骤:

{current_step}

请仅输出针对"当前步骤"的回答:

"""我们将执行逻辑封装到 Executor 类中。这个类将循环遍历计划,调用 LLM,并维护一个历史记录(状态)。

python

class Executor:

def __init__(self, llm_client):

self.llm_client = llm_client

def execute(self, question: str, plan: list[str]) -> str:

"""

根据计划,逐步执行并解决问题。

"""

history = "" # 用于存储历史步骤和结果的字符串

print("\n--- 正在执行计划 ---")

for i, step in enumerate(plan):

print(f"\n-> 正在执行步骤 {i+1}/{len(plan)}: {step}")

prompt = EXECUTOR_PROMPT_TEMPLATE.format(

question=question,

plan=plan,

history=history if history else "无", # 如果是第一步,则历史为空

current_step=step

)

messages = [{"role": "user", "content": prompt}]

response_text = self.llm_client.think(messages=messages) or ""

# 更新历史记录,为下一步做准备

history += f"步骤 {i+1}: {step}\n结果: {response_text}\n\n"

print(f"✅ 步骤 {i+1} 已完成,结果: {response_text}")

# 循环结束后,最后一步的响应就是最终答案

final_answer = response_text

return final_answer现在已经分别构建了负责"规划"的 Planner 和负责"执行"的 Executor 。最后一步是将这两个组件整合到一个统一的智能体 PlanAndSolveAgent 中,并赋予它解决问题的完整能力。我们将创建一个主类 PlanAndSolveAgent ,它的职责非常清晰:接收一个 LLM 客户端,初始化内部的规划器和执行器,并提供一个简单的 run 方法来启动整个流程。

python

class PlanAndSolveAgent:

def __init__(self, llm_client):

"""

初始化智能体,同时创建规划器和执行器实例。

"""

self.llm_client = llm_client

self.planner = Planner(self.llm_client)

self.executor = Executor(self.llm_client)

def run(self, question: str):

"""

运行智能体的完整流程:先规划,后执行。

"""

print(f"\n--- 开始处理问题 ---\n问题: {question}")

# 1. 调用规划器生成计划

plan = self.planner.plan(question)

# 检查计划是否成功生成

if not plan:

print("\n--- 任务终止 --- \n无法生成有效的行动计划。")

return

# 2. 调用执行器执行计划

final_answer = self.executor.execute(question, plan)

print(f"\n--- 任务完成 ---\n最终答案: {final_answer}")这个 PlanAndSolveAgent 类的设计体现了"组合优于继承"的原则。它本身不包含复杂的逻辑,而是作为一个协调者 (Orchestrator),清晰地调用其内部组件来完成任务。

运行实例与分析

python

--- 开始处理问题 ---

问题: 一个水果店周一卖出了15个苹果。周二卖出的苹果数量是周一的两倍。周三卖出的数量比周二少了5个。请问这三天总共卖出了多少个苹果?

--- 正在生成计划 ---

🧠 正在调用 xxxx 模型...

✅ 大语言模型响应成功:

```python

["计算周一卖出的苹果数量: 15个", "计算周二卖出的苹果数量: 周一数量 × 2 = 15 × 2 = 30个", "计算周三卖出的苹果数量: 周二数量 - 5 = 30 - 5 = 25个", "计算三天总销量: 周一 + 周二 + 周三 = 15 + 30 + 25 = 70个"]✅ 计划已生成:

python

["计算周一卖出的苹果数量: 15个", "计算周二卖出的苹果数量: 周一数量 × 2 = 15 × 2 = 30个", "计算周三卖出的苹果数量: 周二数量 - 5 = 30 - 5 = 25个", "计算三天总销量: 周一 + 周二 + 周三 = 15 + 30 + 25 = 70个"]--- 正在执行计划 ---

-> 正在执行步骤 1/4: 计算周一卖出的苹果数量: 15个

🧠 正在调用 xxxx 模型...

✅ 大语言模型响应成功:

15

✅ 步骤 1 已完成,结果: 15

-> 正在执行步骤 2/4: 计算周二卖出的苹果数量: 周一数量 × 2 = 15 × 2 = 30个

🧠 正在调用 xxxx 模型...

✅ 大语言模型响应成功:

30

✅ 步骤 2 已完成,结果: 30

-> 正在执行步骤 3/4: 计算周三卖出的苹果数量: 周二数量 - 5 = 30 - 5 = 25个

🧠 正在调用 xxxx 模型...

✅ 大语言模型响应成功:

25

✅ 步骤 3 已完成,结果: 25

-> 正在执行步骤 4/4: 计算三天总销量: 周一 + 周二 + 周三 = 15 + 30 + 25 = 70个

🧠 正在调用 xxxx 模型...

✅ 大语言模型响应成功:

70

✅ 步骤 4 已完成,结果: 70

--- 任务完成 ---

最终答案: 70从上面的输出日志中,我们可以清晰地看到 Plan-and-Solve 范式的工作流程:

规划阶段: 智能体首先调用 Planner,成功地将复杂的应用题分解成了一个包含四个逻辑步骤的 Python 列表。这个结构化的计划为后续的执行奠定了基础。

执行阶段: Executor 严格按照生成的计划,一步一步地向下执行。在每一步中,它都将历史结果作为上下文,确保了信息的正确传递(例如,步骤2正确地使用了步骤1的结果"15个",步骤3也正确使用了步骤2的结果"30个")。

结果:整个过程逻辑清晰,步骤明确,最终智能体准确地得出了正确答案"70个"。

Reflection

在我们已经实现的 ReAct 和 Plan-and-Solve 范式中,智能体一旦完成了任务,其工作流程便告结束。然而,它们生成的初始答案,无论是行动轨迹还是最终结果,都可能存在谬误或有待改进之处。Reflection 机制的核心思想,正是为智能体引入一种**事后(post-hoc)**的自我校正循环,使其能够像人类一样,审视自己的工作,发现不足,并进行迭代优化。

Reflection 机制的核心思想

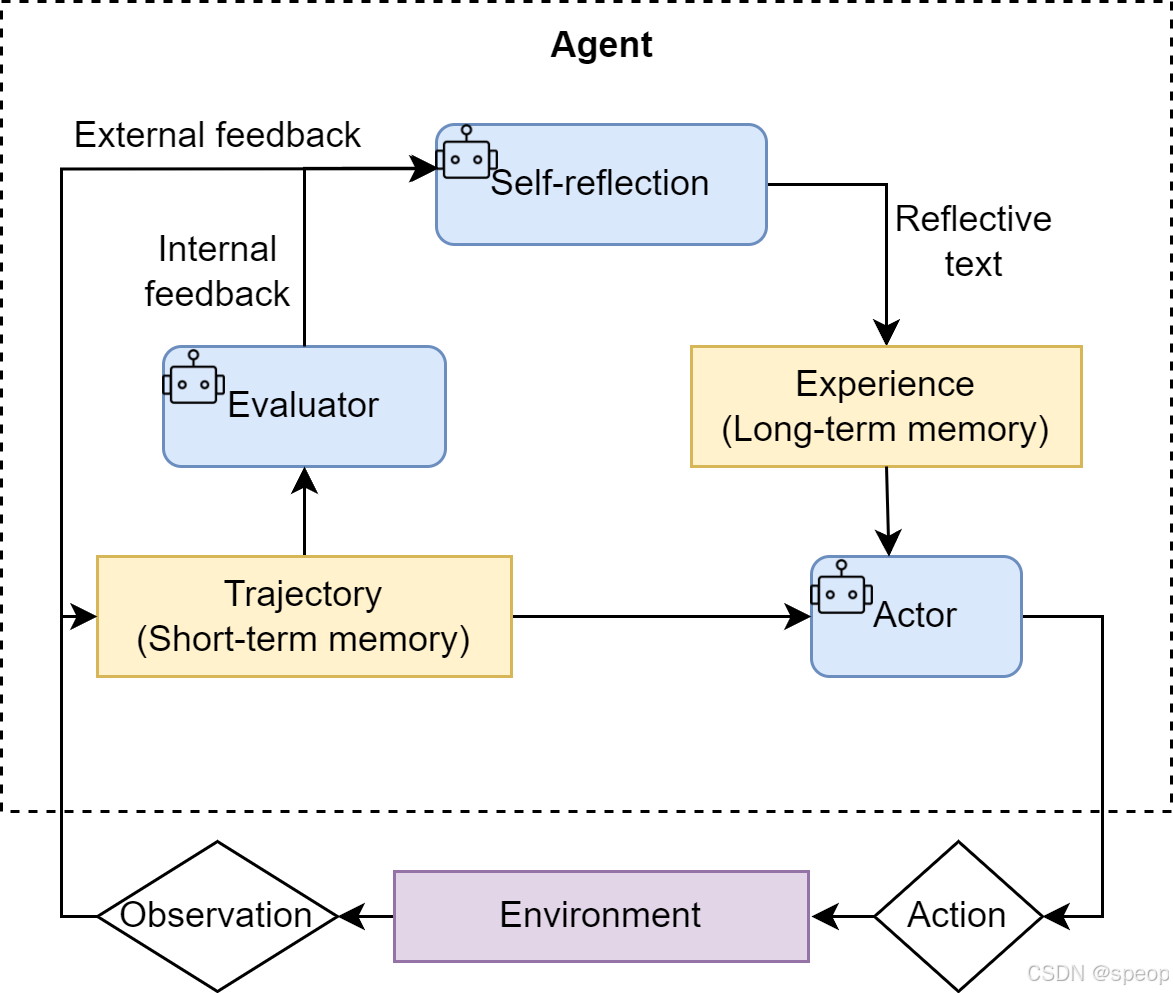

Reflection 机制的灵感来源于人类的学习过程:我们完成初稿后会进行校对,解出数学题后会进行验算。这一思想在多个研究中得到了体现,例如 Shinn, Noah 在2023年提出的 Reflexion 框架[3]。其核心工作流程可以概括为一个简洁的三步循环:执行 -> 反思 -> 优化。

- 执行 (Execution):首先,智能体使用我们熟悉的方法(如 ReAct 或 Plan-and-Solve)尝试完成任务,生成一个初步的解决方案或行动轨迹。这可以看作是"初稿"。

- 反思 (Reflection) :接着,智能体进入反思阶段 。它会调用一个独立的、或者带有特殊提示词的大语言模型实例,来扮演一个"评审员"的角色。这个"评审员"会审视第一步生成的"初稿",并从多个维度进行评估,例如:

- 事实性错误:是否存在与常识或已知事实相悖的内容?

- 逻辑漏洞:推理过程是否存在不连贯或矛盾之处?

- 效率问题:是否有更直接、更简洁的路径来完成任务?

- 遗漏信息:是否忽略了问题的某些关键约束或方面? 根据评估,它会生成一段结构化的反馈 (Feedback),指出具体的问题所在和改进建议。

- 优化 (Refinement):最后,智能体将**"初稿"和"反馈"**作为新的上下文,再次调用大语言模型,要求它根据反馈内容对初稿进行修正,生成一个更完善的"修订稿"。

如图所示,这个循环可以重复进行多次,直到反思阶段不再发现新的问题,或者达到预设的迭代次数上限。我们可以将这个迭代优化的过程形式化地表达出来。假设 O i O_i Oi 是第 i i i 次迭代产生的输出( O 0 O_0 O0 为初始输出),反思模型 π reflect \pi_{\text{reflect}} πreflect 会生成针对 O i O_i Oi 的反馈 F i F_i Fi:

F i = π reflect ( Task , O i ) F_i = \pi_{\text{reflect}}(\text{Task}, O_i) Fi=πreflect(Task,Oi)

随后,优化模型 π refine \pi_{\text{refine}} πrefine 会结合原始任务、上一版输出以及反馈,生成新一版的输出 O i + 1 O_{i+1} Oi+1:

O i + 1 = π refine ( Task , O i , F i ) O_{i+1} = \pi_{\text{refine}}(\text{Task}, O_i, F_i) Oi+1=πrefine(Task,Oi,Fi)

与前两种范式相比,Reflection 的价值在于:

- 它为智能体提供了一个内部纠错回路 ,使其不再完全依赖于外部工具的反馈(ReAct 的 Observation),从而能够修正更高层次的逻辑 和策略错误。

- 它将一次性的任务执行,转变为一个持续优化的过程,显著提升了复杂任务的最终成功率和答案质量。

- 它为智能体构建了一个临时的"短期记忆 "。整个"执行-反思-优化"的轨迹形成了一个宝贵的经验记录,智能体不仅知道最终答案,还记得自己是如何从有缺陷的初稿迭代到最终版本的。更进一步,这个记忆系统还可以是多模态的,允许智能体反思和修正文本以外的输出(如代码、图像等),为构建更强大的多模态智能体奠定了基础。

案例设定与记忆模块设计

为了在实战中体现 Reflection 机制,我们将引入记忆管理机制,因为reflection通常对应着信息的存储和提取,如果上下文足够长的情况,想让"评审员"直接获取所有的信息然后进行反思往往会传入很多冗余信息。这一步实践我们主要完成代码生成与迭代优化。

这一步的目标任务是:"编写一个Python函数,找出1到n之间所有的素数 (prime numbers)。"

这个任务是检验 Reflection 机制的绝佳场景:

- 存在明确的优化路径:大语言模型初次生成的代码很可能是一个简单但效率低下的递归实现。

- **反思点清晰:**可以通过反思发现其"时间复杂度过高"或"存在重复计算"的问题。

- **优化方向明确:**可以根据反馈,将其优化为更高效的迭代版本或使用备忘录模式的版本。

Reflection 的核心在于迭代,而迭代的前提是能够记住之前的尝试和获得的反馈。因此,一个"短期记忆"模块是实现该范式的必需品。这个记忆模块将负责存储每一次"执行-反思"循环的完整轨迹。