在WSL Ubuntu中部署CUDAToolkit cuDNN pytorch显卡加速

| 软件 | 版本 |

|---|---|

| ubuntu | 24.04 |

| cuda-tookit | 13.0 |

| cudnn | 9.15.0 |

| pytorch | 2.9.0+cu130 |

| torchaudio | 2.9.0+cu130 |

| torchvision | 2.9.0+cu130 |

在WSLUbuntu中部署Python3.12、CUDAToolkit和cuDNN的官方下载页面及步骤如下:

bash

mkdir ~/cuda ~/cudnn1.安装WindowsGPU驱动(WSL专用)

WSL2的GPU加速依赖Windows驱动,需下载NVIDIAWSL2专用驱动。

官方下载页面 :NVIDIACUDAonWSLDownloads

选择适合你显卡型号的驱动版本(如471.21或更新),下载后直接在Windows中安装。

注意:安装驱动后需重启Windows,并确保WSL已升级到版本2。

2.安装CUDAToolkit(WSL专用)

NVIDIA提供针对WSL的CUDAToolkit安装包。

官方下载页面 :CUDAToolkit13forWSL

选择以下命令下载并安装:

bash

wget https://developer.download.nvidia.com/compute/cuda/repos/wsl-ubuntu/x86_64/cuda-keyring_1.1-1_all.deb -P ~/cuda

sudo dpkg -i ~/cuda/cuda-keyring_1.1-1_all.deb

sudo apt-get update

sudo apt-get -y install cuda-toolkit-13-0安装完成后,配置环境变量:

bash

echo 'export PATH=/usr/local/cuda-13/bin:$PATH' >> ~/.bashrc

echo 'export LD_LIBRARY_PATH=/usr/local/cuda-13/lib64:$LD_LIBRARY_PATH' >> ~/.bashrc

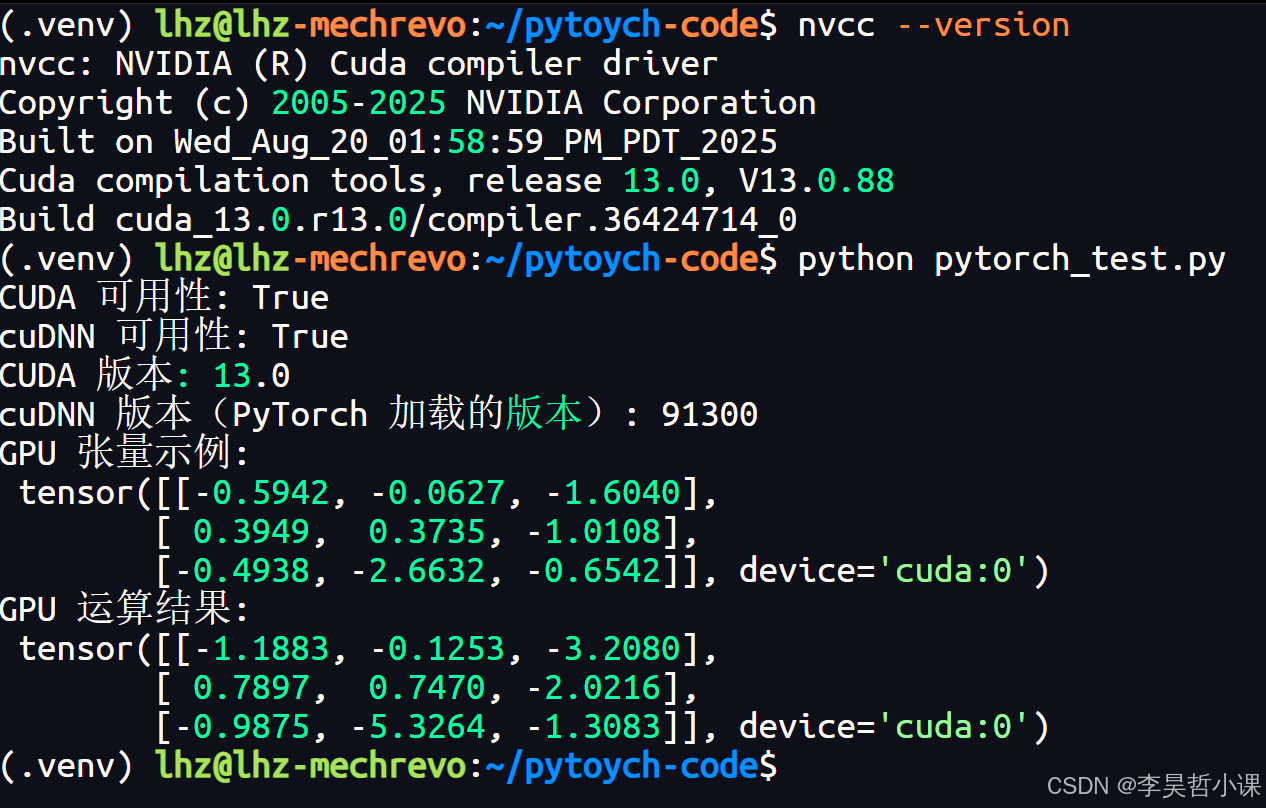

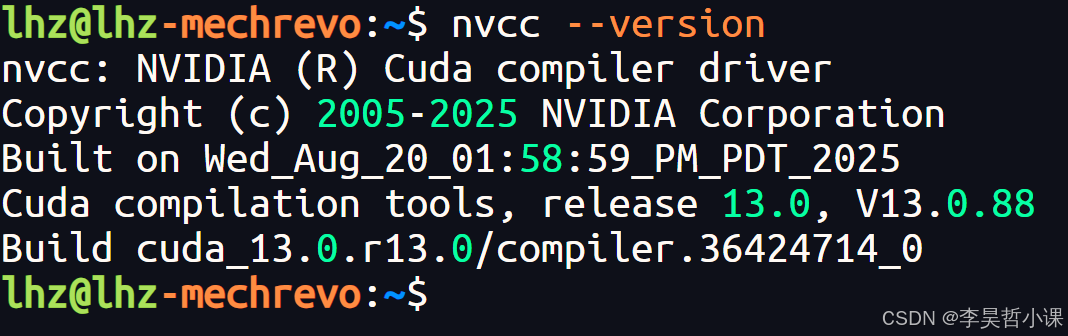

source ~/.bashrc验证安装:

bash

nvcc --version

3.安装cuDNN

cuDNN需与CUDAToolkit版本匹配,不推荐当独安装,在安装tpytorch的时候会自动安装匹配的版本。

-官方下载页面 :

NVIDIAcuDNNDownload

下载后执行以下命令安装:

bash

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2404/x86_64/cuda-keyring_1.1-1_all.deb -P ~/cudnn

sudo dpkg -i ~/cudnn/cuda-keyring_1.1-1_all.deb

sudo apt-get update

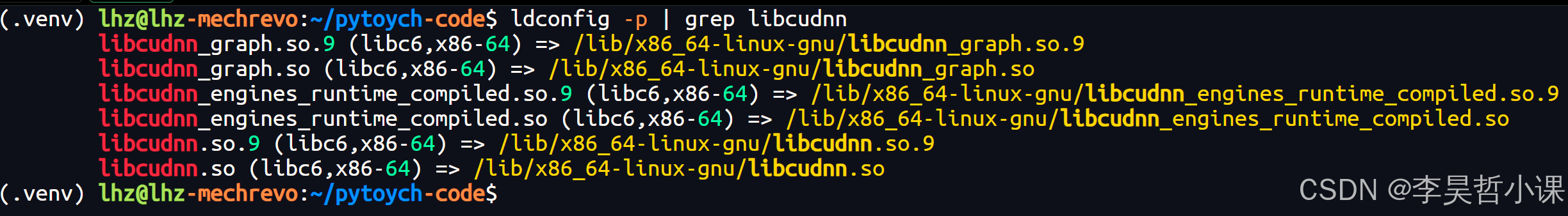

sudo apt-get -y install cudnn-jit-验证cudnn

bash

ldconfig -p | grep libcudnn

4.安装Python3.12和PyTorch

-

安装Python3.12相关工具(WSLUbuntu中默认可能未预装):

bashsudo apt update sudo apt -y install python3 python3-pip python3.12-venv -

创建虚拟环境

bashmkdir pytorch-code && cd pytorch-code python3 -m venv .venv source .venv/bin/activate python -m pip install --upgrade pip setuptools -i https://pypi.tuna.tsinghua.edu.cn/simple -

安装PyTorch(GPU版本) :

可通过官方 nightly 版本安装,命令示例:

bashpip install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cu130 -

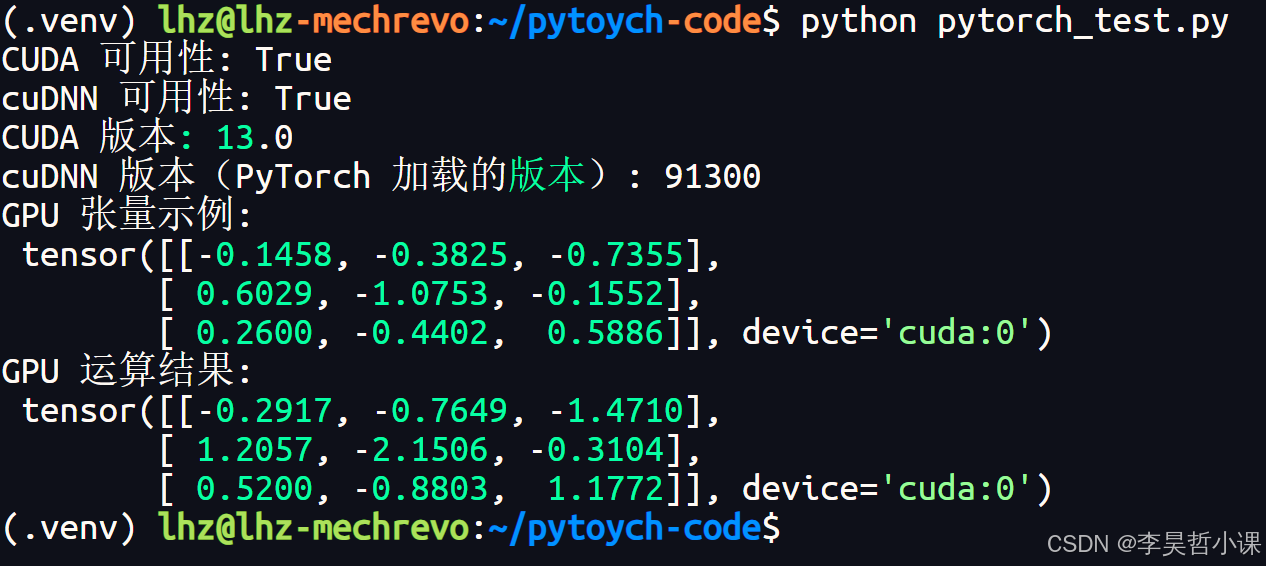

验证PyTorch可调用CUDA和cuDNN:

pythonimport torch # 验证 CUDA 是否可用 print("CUDA 可用性:", torch.cuda.is_available()) # 验证 cuDNN 是否可用 print("cuDNN 可用性:", torch.backends.cudnn.is_available()) # 查看 CUDA 版本 print("CUDA 版本:", torch.version.cuda) # 查看 cuDNN 版本 print("cuDNN 版本(PyTorch 加载的版本):", torch.backends.cudnn.version()) # 测试 GPU 张量运算 if torch.cuda.is_available(): # 在 GPU 上创建随机张量 gpu_tensor = torch.randn(3, 3).cuda() print("GPU 张量示例:\n", gpu_tensor) # 执行简单运算并验证结果 result = gpu_tensor + gpu_tensor print("GPU 运算结果:\n", result) else: print("未检测到可用 GPU,建议检查 CUDA 或 PyTorch 安装")

通过以上步骤,可在WSLUbuntu中完成Python3.12、CUDAToolkit和cuDNN的部署,并验证GPU加速功能。