摘要

明确核心主体 "3+1 工具套件",突出 "思维工具为根" 的核心定位,体现 "设计共识 + DevOps 落地" 的双重成果

简

本次讨论始于增强版 project_planning_tool 开发筹备,核心演进为 "3+1 工具套件" 设计共识:以思维工具为根工具,衍生语言、编程、数据库三大工具,形成完整生态。思维工具聚焦元级 speech acts 规范与元数据服务契约(通用 + 3 专用 + 交接面),定义协作规则不参与执行;三大衍生工具承接开发任务包落地;融合 DevOps 核心思想,构建 "规范生成→工具开发→运行校验→迭代优化" 闭环。明确功能(契约体系)与非功能(三层接口)边界,既满足三体项目开发协同,又实现工具生态自洽与持续优化。

全

本次讨论是元级自动化引擎配套工具体系的核心奠基过程,始于 "增强版 project_planning_tool 开发筹备",终形成 "3+1 工具套件 + DevOps 融合" 的完整落地蓝图,历经需求深化、定位迭代、逻辑闭环三大阶段,核心共识与演进脉络如下:

1. 讨论起点与初始诉求

讨论开篇聚焦 "增强版自用规划工具" 开发,核心诉求包括:支撑 Designer/Master/Transformer 三体项目开发,集成类 LDAP/TSN/DNS 外接扩展,覆盖文档、结构、术语、交接面等管理功能。初期定位为 "自用 + 外接双模式轻量协同工具",旨在通过 Flask+SQLite 架构,平衡自用便捷性与外部平台联动需求。

2. 关键演进:从 "单点工具" 到 "生态级套件"

随着讨论深入,用户核心诉求逐步深化,工具定位历经三次关键迭代:

- 第一阶段:收敛核心功能,明确 "1+3 项目模型(通用 + 3 专用)+ 交接面" 为功能性核心,三层接口(APIs/SPIs/ANIs)为非功能性数据传输支撑,严格区分内部协作(交接面)与外部交互(接口);

- 第二阶段:深化契约本质,确定核心功能是 "元数据服务契约体系",工具仅负责契约的定义、管理、校验与导出,执行职责归属三体项目,避免功能越界;

- 第三阶段:升华生态定位,明确工具是 "3+1 工具套件" 的根工具(思维工具),衍生语言工具(speech acts 置标与解析)、编程工具(项目模型代码框架)、数据库工具(接口元数据建库),形成 "根工具定义规则→衍生工具落地执行" 的生态逻辑。

3. 核心共识:工具套件分工与 DevOps 融合

(1)3+1 工具套件明确分工

- 思维工具(根):核心实现元级 speech acts 规范管理、元数据服务契约体系(通用底座 + 单服务 + 跨服务协作)、衍生工具开发任务包生成、全链路一致性校验,是整个生态的 "规则制定者";

- 语言工具(衍生 1):基于 speech acts 规范,实现契约元数据标注、解析与语言一致性校验,是 "契约的语言载体工具";

- 编程工具(衍生 2):基于契约体系,生成三体项目代码框架与交接面适配逻辑,是 "契约的代码落地工具";

- 数据库工具(衍生 3):基于非功能性接口元数据,设计数据库结构、生成建库脚本与数据访问层,是 "契约的数据存储工具"。

(2)DevOps 思想深度融合

讨论明确将 DevOps"闭环优化、协同自动化" 核心思想融入工具生态:

- 开发态:思维工具自动生成衍生工具的标准化开发任务包(需求 + 规范 + 模板),实现开发流程标准化;

- 运行态:思维工具提供一致性校验接口,支撑衍生工具落地后的合规性验证与问题反馈;

- 迭代态:形成 "思维工具输出规范→衍生工具落地→校验反馈→规范迭代→任务包更新" 的持续优化闭环,契合 DevOps "开发 - 运维一体化" 逻辑。

(3)核心边界坚守

- 功能与非功能边界:契约体系(功能性)定义 "协作规则",三层接口(非功能性)仅负责 "数据传输",互不干扰;

- 定义与执行边界:工具套件仅做 "规则定义与落地支撑",三体项目的执行逻辑由自身实现,工具不参与任何执行过程;

- 生态协同边界:衍生工具严格遵循思维工具的规范,通过契约元数据与校验接口实现天然协同,无需额外适配。

4. 讨论价值与落地意义

本次讨论彻底跳出 "单点工具功能堆砌" 的局限,构建了 "元级规则→生态工具→流程落地" 的完整链路:

- 对三体项目:提供了统一、自洽的协作规范与落地工具链,确保 Designer/Master/Transformer 的开发符合全局共识,减少协同冲突;

- 对工具生态:3+1 套件以思维工具为根,实现规则的统一迭代与工具的高效协同,解决了传统工具链零散、适配成本高的问题;

- 对落地效率:DevOps 思想的融入让工具生态具备持续优化能力,从 "一次性开发" 升级为 "持续迭代的生态系统",支撑元级自动化引擎的长期演进。

最终,讨论形成了可直接落地的工具生态蓝图,明确了各工具的定位、分工、规范与联动逻辑,为后续开发执行奠定了坚实的共识基础。

问题

Q381、从现在开始,我们开始准备 自用规划工具 (增强版project_planning_tool )的开发。我们开始细节讨论吧,以达成一致给出开发文档结束。或者您已经有确定的完整思路,直接用文档表述出来讨论?

Q382、您对我所说 这个工具 " 最好能 集成 LDAP或类似的协议 ( 程序结构 的打包 包装器 ,可外接开发 集成平台 或支持外部 模型接入) +TSN或类似的技术(术语的封装 ,可外接测试或 支持外部算法接入) +DNS或类似的shell( .md 文档 的外壳 ,可外接 环境 部署或支持外部 训练平台接入)"表述 括号中逗号以后 的 "可外接..." 或"支持外部...接入 " 是两个方向,或者说 就是 要设计两套 接口, 前者是 APIs(外挂扩展),后者是 SPIs(内嵌增强),同时 自用闭环 独立设计为 ANIs(中间的防腐层 接口),闭环该工具 实现的 功能。 也就是,区分了 功能性需求(如 .md 文档 编辑及标注 等 项目规划功能 ) 和 非功能性需求(如集成 类似LDAP的协议 等)。您是这样理解的吗? 另外主功能-规划的项目结构 --需要一个 1(通用)+3(专用)的项目模型,显然 通用模型也必须是 9维基础空间( 项目元模型,描述整体设计的元数据,想必应该就是 由.md 文档 表达 并 通过 元语言注释 来标注 ) ,3个专用模型(分别描述 三套程序) 想必分别对应1/2/3 维时间,维度处理 也就是 三套程序 的 交接面 。所以,主要功能 就只有这三个。 ---请考虑一下,我的这些表述对吗?您的设计中是这样考虑的吗? 我们可以先讨论到位,再修改 工具的设计和程序

Q383、您的 "三、关于项目模型:你的表述逻辑正确,需在工具中强化 "维度关联" 与 "元数据表达"" 描述的功能性需求只有两项"1 个通用模型"和"3 个专用模型" 遗漏了 三个项目的交接面,您可能 错误的以为它们就是 三层接口 所以就漏掉了。但是,您想想,对吗? 项目交界面 是 内部协作,三层接口 是 外部关系!所以,您需要考虑清楚 并加进去。--我上一次是这样表述的 :主功能-规划的项目结构 --需要一个 1(通用)+3(专用)的项目模型,显然 通用模型也必须是 9维基础空间( 项目元模型,描述整体设计的元数据,想必应该就是 由.md 文档 表达 并 通过 元语言注释 来标注 ) ,3个专用模型(分别描述 三套程序) 想必分别对应1/2/3 维时间,维度处理 也就是 三套程序 的 交接面 。

Q384、您是否意识到,事实上三个 功能需求 要实现的就是 要 提供 (功能上和内核要提供的服务功能一样)-- 进程管理、资源分配的 内核基本服务功能以及 AI内核专职的任务调度服务,也就是前前面漏掉的 三个项目的交界面 设计。

Q385、您需要 明确知道,对我们正准备设计和实现的规划工具来说,三层接口 是非功能性的(可以比作 数据接口), 您刚刚说的是功能性的 (可以视为 元数据服务契约) 。 ---因为你刚才回复中 说"交接面是内核服务的 "执行层",而非单纯数据接口," 我觉得您并没有真正理解。

Q386、项目规划工具的任务 是要根据 功能性的服务契约 去建模 三个项目模型( 编程工具) ,并将非功能性的数据接口描述 交给数据库工具去建库,自己充当基础的思维工具 提供 为语言工具 置标的元级的speech acts.---我们之前讨论过,整个整体设计所需要的工具应该是一个3+1 的工具套件(语言工具/编程工具/数据库工具 + 思维工具) 。 换句话说,这个工具自己实现思维工具并衍生三个工具的开发实现任务。

Q387、您回顾一下 就 项目规划工具 的设计和实现 刚才的讨论路径,想想是否有问题,从方向上做法上 到结论上

Q388、您是否注意到,我们这样讨论下来,已经将工具 只是要 输出SDK 转移到运行时 内核上了,是不是 就是我们常说的devOps的范畴了?

Q&A

Q381

Q381、从现在开始,我们开始准备 自用规划工具 (增强版project_planning_tool )的开发。我们开始细节讨论吧,以达成一致给出开发文档结束。或者您已经有确定的完整思路,直接用文档表述出来讨论?

<<用户现在要开始增强版 project_planning_tool 的开发细节讨论,最终目标是达成一致并给出开发文档。首先,我需要明确开发文档的核心组成部分,确保覆盖用户之前关注的所有点:原有核心功能、类 LDAP/TSN/DNS 扩展模块、技术栈、开发计划、接口设计、数据模型、测试方案等。

首先,用户之前已经确认了核心功能和扩展模块,现在需要细化每个模块的开发细节,比如接口的具体参数、数据模型的完整字段、前端页面的核心交互、开发的优先级和里程碑。还要考虑用户是自用工具,所以开发要分阶段,先实现核心功能,再扩展外接模块,确保每个阶段都能可用,避免过度设计。

然后,需要明确技术栈的细节,比如 Flask 的具体配置、SQLite 的初始化脚本、前端组件的具体使用(比如 Editor.md 的配置、Mermaid 的集成方式)。还要考虑外接模块的依赖,比如 Docker SDK 的兼容性、JSON-LD 的处理库版本,确保依赖包的稳定性。

接下来,数据模型部分,之前已经有了基础模型,现在需要补充扩展模型的完整字段,以及模型之间的关联关系,比如结构打包记录关联项目结构,部署记录关联文档等。还要设计数据库初始化脚本,包括默认的术语数据、项目结构模板、文档模板,方便用户开箱即用。

接口设计是外接模块的核心,需要详细定义每个 API 的路径、方法、参数、响应格式,确保外部系统能清晰调用。同时,SDK 的设计要简化,提供示例代码,降低用户的接入成本。

开发计划部分,要分阶段划分任务,每个阶段有明确的交付物,比如阶段一完成核心自用功能,阶段二完成外接扩展模块,阶段三完成测试和优化。这样用户能逐步看到成果,也方便调整需求。

测试方案部分,需要覆盖单元测试、集成测试、外接接口测试,确保工具的稳定性和兼容性。特别是外接模块,要模拟外部平台的调用场景,验证接口的可用性。

还要考虑用户的自用场景,比如本地运行的便捷性、数据存储的安全性、界面操作的简洁性。避免添加复杂的配置,尽量默认化,同时提供可配置的选项,满足灵活需求。

最后,整合所有细节,形成完整的开发文档,结构清晰,涵盖概述、技术栈、数据模型、接口设计、开发计划、测试方案、部署指南等部分,方便后续开发和维护。同时,在文档中留出可讨论的点,比如外接模块的扩展格式、API 的权限控制等,供用户确认。>>

增强版 Project Planning Tool 开发文档(V1.0)

目录

- 项目概述

- 技术栈明细与环境配置

- 详细数据模型(含关联关系)

- 核心模块开发细节(自用 + 外接)

- 外接接口与 SDK 设计

- 开发计划与里程碑

- 测试方案

- 部署与使用指南

- 可扩展预留点

一、项目概述

1. 核心定位

三体项目专属「自用协同 + 外接扩展」轻量工具,聚焦 "文档管理 - 项目结构 - 术语配套 - 交接面 - 测试" 全流程自用需求,同时通过类 LDAP/TSN/DNS 扩展模块,支持对接外部开发平台、测试 / 算法工具、部署 / 训练环境。

2. 核心目标

- 阶段 1(自用闭环):实现.md 文档编辑标注、三体项目结构生成、术语统一、交接面管理、测试跟踪;

- 阶段 2(外接扩展):完成类 LDAP/TSN/DNS 模块开发,提供标准化接口与 SDK;

- 阶段 3(优化适配):兼容三体项目开发流程,优化交互体验,确保外接稳定性。

3. 开发约束

- 轻量优先:无额外服务器依赖,本地运行(Flask+SQLite);

- 兼容适配:Python 3.10+,前端兼容主流浏览器(Chrome/Firefox/Edge);

- 外接安全:默认关闭外接功能,启用需配置 API 密钥(可选);

- 迭代开发:分阶段交付,每个阶段可独立使用。

二、技术栈明细与环境配置

1. 技术栈清单(明确版本与依赖)

| 技术类别 | 选型 | 版本要求 | 核心用途 |

|---|---|---|---|

| 核心语言 | Python | 3.10+ | 后端逻辑开发 |

| Web 框架 | Flask | 2.3.3 | 本地 Web 服务与路由管理 |

| ORM 工具 | Flask-SQLAlchemy | 3.1.1 | 数据库操作抽象 |

| 数据库 | SQLite | 3.39.0+ | 本地数据存储(术语、文档、结构等) |

| 前端框架 | Bootstrap | 5.3.2 | 页面样式与响应式布局 |

| JS 工具库 | jQuery | 3.7.1 | 前端交互逻辑 |

| MD 编辑器 | Editor.md | 1.5.0 | MD 文档编辑、预览、标注 |

| 可视化工具 | Mermaid.js | 10.6.1 | 项目结构、交接面关联图可视化 |

| 外接扩展依赖 | docker | 6.1.3 | 类 LDAP 模块 Docker 镜像打包 |

| 语义格式依赖 | pyld | 2.0.3 | 类 TSN 模块 JSON-LD 格式处理 |

| 网络请求依赖 | requests | 2.31.0 | 外接接口调用与 SDK 开发 |

| 配置管理 | python-dotenv | 1.0.0 | 环境变量与配置管理 |

2. 环境配置步骤(本地开发环境)

(1)Python 环境准备

bash

# 创建虚拟环境

python -m venv venv

# 激活环境(Windows)

venv\Scripts\activate

# 激活环境(Mac/Linux)

source venv/bin/activate

# 安装依赖

pip install -r requirements.txt(2)requirements.txt 完整内容

txt

Flask==2.3.3

Flask-SQLAlchemy==3.1.1

SQLAlchemy==2.0.21

python-dotenv==1.0.0

requests==2.31.0

docker==6.1.3

pyld==2.0.3

python-markdown==3.5

PyYAML==6.0.1

Werkzeug==2.3.7(3)配置文件(config.py + .env)

config.py:

python

运行

import os

from dotenv import load_dotenv

load_dotenv()

class Config:

# 基础配置

SECRET_KEY = os.getenv('SECRET_KEY', 'project-planning-tool-secret')

DEBUG = os.getenv('DEBUG', 'True') == 'True'

PORT = int(os.getenv('PORT', 5000))

# 数据库配置

SQLALCHEMY_DATABASE_URI = os.getenv('DATABASE_URI', 'sqlite:///data/project_tool.db')

SQLALCHEMY_TRACK_MODIFICATIONS = False

# 文件存储路径配置

BASE_DIR = os.path.abspath(os.path.dirname(__file__))

DOC_STORAGE_DIR = os.path.join(BASE_DIR, 'data', 'documents')

PACKAGE_STORAGE_DIR = os.path.join(BASE_DIR, 'data', 'packages')

DEPLOY_STORAGE_DIR = os.path.join(BASE_DIR, 'data', 'deployments')

TRAIN_DATA_DIR = os.path.join(BASE_DIR, 'data', 'train_data')

INIT_DATA_DIR = os.path.join(BASE_DIR, 'init_data')

# 外接功能配置(默认关闭)

EXTERNAL_API_ENABLED = os.getenv('EXTERNAL_API_ENABLED', 'False') == 'True'

API_KEY = os.getenv('API_KEY', 'default-api-key-123456') # 外接接口密钥(可修改)

# 初始化目录(启动时自动创建)

@staticmethod

def init_directories():

dirs = [

Config.DOC_STORAGE_DIR,

Config.PACKAGE_STORAGE_DIR,

Config.DEPLOY_STORAGE_DIR,

Config.TRAIN_DATA_DIR,

os.path.join(Config.INIT_DATA_DIR, 'project_structures'),

os.path.join(Config.INIT_DATA_DIR, 'doc_templates')

]

for dir_path in dirs:

if not os.path.exists(dir_path):

os.makedirs(dir_path)

# 初始化目录

Config.init_directories().env(本地配置文件,不提交代码):

env

DEBUG=True

PORT=5000

SECRET_KEY=your-custom-secret-key

DATABASE_URI=sqlite:///data/project_tool.db

EXTERNAL_API_ENABLED=False

API_KEY=your-api-key-for-external-call三、详细数据模型(含关联关系)

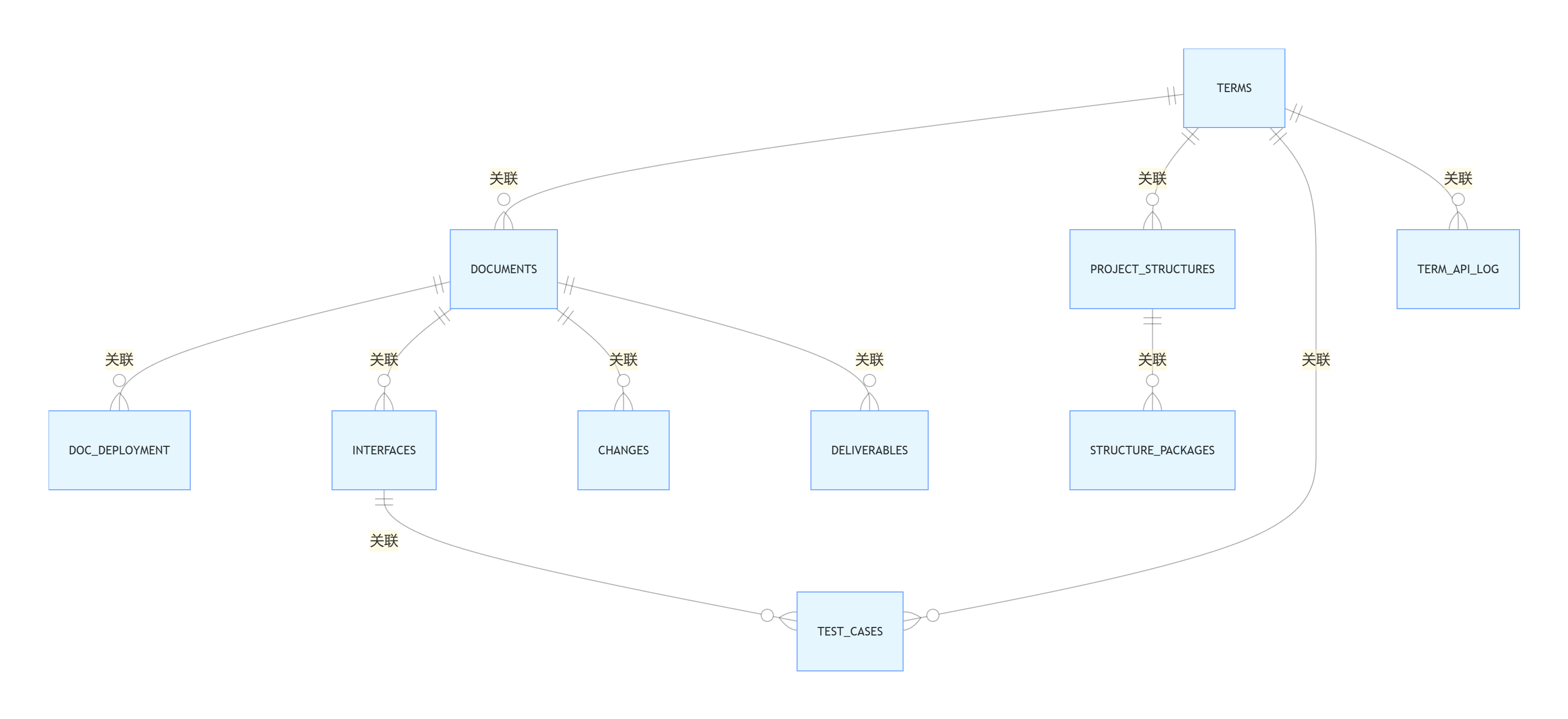

1. 核心模型关系图

Scala

erDiagram

TERMS ||--o{ DOCUMENTS : "关联"

TERMS ||--o{ PROJECT_STRUCTURES : "关联"

TERMS ||--o{ TEST_CASES : "关联"

DOCUMENTS ||--o{ DOC_DEPLOYMENT : "关联"

DOCUMENTS ||--o{ INTERFACES : "关联"

DOCUMENTS ||--o{ CHANGES : "关联"

DOCUMENTS ||--o{ DELIVERABLES : "关联"

PROJECT_STRUCTURES ||--o{ STRUCTURE_PACKAGES : "关联"

INTERFACES ||--o{ TEST_CASES : "关联"

TERMS ||--o{ TERM_API_LOG : "关联"2. 完整数据模型代码(app/models/*.py)

(1)基础模型(app/models/base.py)

python

运行

python

from app import db

from datetime import datetime

class BaseModel(db.Model):

"""基础模型,包含公共字段"""

__abstract__ = True

create_time = db.Column(db.DateTime, default=datetime.utcnow)

update_time = db.Column(db.DateTime, default=datetime.utcnow, onupdate=datetime.utcnow)(2)术语模型(app/models/term.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class Term(BaseModel):

__tablename__ = 'terms'

term_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

term_name = db.Column(db.String(50), unique=True, nullable=False)

term_definition = db.Column(db.Text, nullable=False)

term_category = db.Column(db.String(30), nullable=False) # 模式词汇/接口类型/模块名等

related_terms = db.Column(db.String(200)) # 逗号分隔的term_id

is_active = db.Column(db.Boolean, default=True) # 是否启用

# 关联关系

documents = db.relationship('Document', backref='term', lazy=True)

structures = db.relationship('ProjectStructure', backref='term', lazy=True)

test_cases = db.relationship('TestCase', backref='term', lazy=True)

api_logs = db.relationship('TermApiLog', backref='term', lazy=True)

def to_dict(self):

"""转换为字典(自用格式)"""

return {

'term_id': self.term_id,

'term_name': self.term_name,

'term_definition': self.term_definition,

'term_category': self.term_category,

'related_terms': self.related_terms.split(',') if self.related_terms else [],

'is_active': self.is_active,

'create_time': self.create_time.strftime('%Y-%m-%d %H:%M:%S'),

'update_time': self.update_time.strftime('%Y-%m-%d %H:%M:%S')

}

def to_jsonld(self):

"""转换为JSON-LD格式(外接格式)"""

from app.services.tsn_service import TERM_JSONLD_CONTEXT

related_terms = []

if self.related_terms:

for tid in self.related_terms.split(','):

related_term = Term.query.get(tid)

if related_term:

related_terms.append({

"@type": "Term",

"termName": related_term.term_name,

"termDefinition": related_term.term_definition

})

return {

"@context": TERM_JSONLD_CONTEXT["@context"],

"@type": "Term",

"termName": self.term_name,

"termDefinition": self.term_definition,

"termCategory": self.term_category,

"relatedTerms": related_terms,

"createTime": self.create_time.strftime('%Y-%m-%d %H:%M:%S'),

"isActive": self.is_active

}(3)文档模型(app/models/document.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class Document(BaseModel):

__tablename__ = 'documents'

doc_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

doc_name = db.Column(db.String(100), nullable=False) # 文档名称

doc_type = db.Column(db.String(30), nullable=False) # 全局总纲/Designer专属等

doc_path = db.Column(db.String(255), nullable=False) # 本地存储路径

doc_version = db.Column(db.String(20), default='V1.0') # 版本

related_term_ids = db.Column(db.String(200)) # 关联术语ID(逗号分隔)

creator = db.Column(db.String(50), default='admin') # 创建人

is_archived = db.Column(db.Boolean, default=False) # 是否归档

# 关联关系

deployments = db.relationship('DocDeployment', backref='document', lazy=True)

interfaces = db.relationship('Interface', backref='document', lazy=True)

changes = db.relationship('Change', backref='document', lazy=True)

deliverables = db.relationship('Deliverable', backref='document', lazy=True)

def get_related_terms(self):

"""获取关联术语列表"""

if not self.related_term_ids:

return []

term_ids = self.related_term_ids.split(',')

return [Term.query.get(tid) for tid in term_ids if Term.query.get(tid)](4)项目结构模型(app/models/structure.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class ProjectStructure(BaseModel):

__tablename__ = 'project_structures'

structure_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

project_name = db.Column(db.String(30), nullable=False) # Designer/Master/Transformer

directory_path = db.Column(db.String(255), nullable=False) # 目录路径

file_name = db.Column(db.String(100), nullable=False) # 文件名

related_term_id = db.Column(db.Integer, db.ForeignKey('terms.term_id'), nullable=True)

file_type = db.Column(db.String(20), nullable=False) # 目录/文件/Python文件等

description = db.Column(db.Text) # 描述

is_required = db.Column(db.Boolean, default=True) # 是否为必填文件/目录

# 关联关系

packages = db.relationship('StructurePackage', backref='structure', lazy=True)(5)交接面模型(app/models/interface.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class Interface(BaseModel):

__tablename__ = 'interfaces'

interface_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

interface_name = db.Column(db.String(100), nullable=False) # 交接面名称

from_project = db.Column(db.String(30), nullable=False) # 来源项目

to_project = db.Column(db.String(30), nullable=False) # 目标项目

data_format = db.Column(db.String(50), nullable=False) # JSON/XML/XCL等

params = db.Column(db.Text) # 接口参数(JSON格式字符串)

related_doc_id = db.Column(db.Integer, db.ForeignKey('documents.doc_id'), nullable=True)

related_module = db.Column(db.String(100)) # 关联模块路径

status = db.Column(db.String(20), default='设计中') # 设计中/已确认/已变更/已废弃

interaction_rules = db.Column(db.Text) # 交互规则说明

# 关联关系

test_cases = db.relationship('TestCase', backref='interface', lazy=True)(6)测试用例模型(app/models/test_case.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class TestCase(BaseModel):

__tablename__ = 'test_cases'

case_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

case_name = db.Column(db.String(100), nullable=False) # 用例名称

test_type = db.Column(db.String(30), nullable=False) # 单元/集成/联调/验收测试

related_project = db.Column(db.String(30), nullable=False) # 关联项目

related_module = db.Column(db.String(100)) # 关联模块

related_interface_id = db.Column(db.Integer, db.ForeignKey('interfaces.interface_id'), nullable=True)

related_term_ids = db.Column(db.String(200)) # 关联术语ID(逗号分隔)

test_steps = db.Column(db.Text, nullable=False) # 测试步骤

expected_result = db.Column(db.Text, nullable=False) # 预期结果

actual_result = db.Column(db.Text) # 实际结果

status = db.Column(db.String(20), default='未执行') # 未执行/执行中/通过/失败

executor = db.Column(db.String(50), default='admin') # 执行人

def get_related_terms(self):

"""获取关联术语列表"""

if not self.related_term_ids:

return []

term_ids = self.related_term_ids.split(',')

return [Term.query.get(tid) for tid in term_ids if Term.query.get(tid)](7)变更记录模型(app/models/change.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class Change(BaseModel):

__tablename__ = 'changes'

change_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

change_title = db.Column(db.String(100), nullable=False) # 变更标题

related_projects = db.Column(db.String(100)) # 关联项目(逗号分隔)

related_modules = db.Column(db.String(200)) # 关联模块(逗号分隔)

related_doc_id = db.Column(db.Integer, db.ForeignKey('documents.doc_id'), nullable=True)

change_reason = db.Column(db.Text, nullable=False) # 变更原因

change_content = db.Column(db.Text, nullable=False) # 变更内容

operator = db.Column(db.String(50), default='admin') # 操作人

impact_range = db.Column(db.Text) # 影响范围说明(8)交付物模型(app/models/deliverable.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class Deliverable(BaseModel):

__tablename__ = 'deliverables'

deliverable_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

deliverable_name = db.Column(db.String(100), nullable=False) # 交付物名称

related_project = db.Column(db.String(30), nullable=False) # 关联项目

deliverable_type = db.Column(db.String(30), nullable=False) # 程序/文档/工具/硬件

related_doc_id = db.Column(db.Integer, db.ForeignKey('documents.doc_id'), nullable=True)

status = db.Column(db.String(20), default='未开始') # 未开始/进行中/已完成/已归档

finish_time = db.Column(db.DateTime) # 完成时间

description = db.Column(db.Text) # 交付物说明

storage_path = db.Column(db.String(255)) # 存储路径(9)扩展模型:结构打包记录(app/models/structure_package.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class StructurePackage(BaseModel):

__tablename__ = 'structure_packages'

package_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

project_name = db.Column(db.String(30), nullable=False) # 关联项目

package_format = db.Column(db.String(20), nullable=False) # zip/docker

package_path = db.Column(db.String(255), nullable=False) # 打包文件路径/镜像标签

metadata_json = db.Column(db.Text, nullable=False) # 标准化元数据(JSON字符串)

related_term_ids = db.Column(db.String(200)) # 关联术语ID(逗号分隔)

external_platform = db.Column(db.String(50), default='local') # 外接平台

operator = db.Column(db.String(50), default='admin') # 操作人

is_valid = db.Column(db.Boolean, default=True) # 打包文件是否有效(10)扩展模型:术语 API 调用日志(app/models/term_api_log.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class TermApiLog(BaseModel):

__tablename__ = 'term_api_logs'

log_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

api_path = db.Column(db.String(100), nullable=False) # 调用的API路径

request_params = db.Column(db.Text) # 请求参数(JSON字符串)

response_result = db.Column(db.Text) # 响应结果(JSON字符串)

external_system = db.Column(db.String(50)) # 外接系统名称

related_term_id = db.Column(db.Integer, db.ForeignKey('terms.term_id'), nullable=True)

status = db.Column(db.String(20), nullable=False) # success/fail

ip_address = db.Column(db.String(50)) # 调用方IP(11)扩展模型:文档部署记录(app/models/doc_deployment.py)

python

运行

python

from app.models.base import BaseModel

from app import db

class DocDeployment(BaseModel):

__tablename__ = 'doc_deployments'

deploy_id = db.Column(db.Integer, primary_key=True, autoincrement=True)

doc_id = db.Column(db.Integer, db.ForeignKey('documents.doc_id'), nullable=False)

doc_identifier = db.Column(db.String(100), nullable=False) # doc://{doc_id}:{version}

deploy_type = db.Column(db.String(20), nullable=False) # local/k8s/train_export

deploy_script_path = db.Column(db.String(255)) # 部署脚本路径

external_url = db.Column(db.String(255)) # 外部访问URL

train_data_path = db.Column(db.String(255)) # 训练数据导出路径

status = db.Column(db.String(20), nullable=False) # deployed/exported/failed

operator = db.Column(db.String(50), default='admin') # 操作人

k8s_config = db.Column(db.Text) # K8s部署额外配置(JSON字符串,可选)四、核心模块开发细节

1. 初始化模块(app/init.py)

- 功能:应用初始化、数据库创建、默认数据导入;

- 核心代码:

python

运行

python

from flask import Flask

from flask_sqlalchemy import SQLAlchemy

import os

import yaml

from app.models import (Term, Document, ProjectStructure, Interface, TestCase,

Change, Deliverable, StructurePackage, TermApiLog, DocDeployment)

# 初始化SQLAlchemy

db = SQLAlchemy()

def create_app(config_class='config.Config'):

app = Flask(__name__)

app.config.from_object(config_class)

# 初始化数据库

db.init_app(app)

# 注册路由蓝图

from app.routes import (term_bp, doc_bp, structure_bp, interface_bp, test_bp,

change_bp, deliverable_bp, ldap_bp, tsn_bp, dns_bp)

app.register_blueprint(term_bp, url_prefix='/term')

app.register_blueprint(doc_bp, url_prefix='/doc')

app.register_blueprint(structure_bp, url_prefix='/structure')

app.register_blueprint(interface_bp, url_prefix='/interface')

app.register_blueprint(test_bp, url_prefix='/test')

app.register_blueprint(change_bp, url_prefix='/change')

app.register_blueprint(deliverable_bp, url_prefix='/deliverable')

app.register_blueprint(ldap_bp, url_prefix='/ldap')

app.register_blueprint(tsn_bp, url_prefix='/tsn')

app.register_blueprint(dns_bp, url_prefix='/dns')

# 注册API蓝图(外接接口)

from app.routes.api import api_bp

app.register_blueprint(api_bp, url_prefix='/api/v1')

# 创建数据库表

with app.app_context():

db.create_all()

# 导入默认术语(若未导入)

if not Term.query.first():

import_default_terms()

# 导入默认项目结构(若未导入)

if not ProjectStructure.query.first():

import_default_structures()

return app

def import_default_terms():

"""导入默认全局术语(从init_data/global_terms.yaml)"""

terms_path = os.path.join(app.config['INIT_DATA_DIR'], 'global_terms.yaml')

if not os.path.exists(terms_path):

print(f"警告:未找到默认术语文件 {terms_path}")

return

with open(terms_path, 'r', encoding='utf-8') as f:

terms_data = yaml.safe_load(f)

for term in terms_data:

new_term = Term(

term_name=term['term_name'],

term_definition=term['term_definition'],

term_category=term['term_category'],

related_terms=','.join([str(t) for t in term.get('related_terms', [])])

)

db.session.add(new_term)

db.session.commit()

print("默认术语导入成功")

def import_default_structures():

"""导入默认项目结构(从init_data/project_structures)"""

structures_dir = os.path.join(app.config['INIT_DATA_DIR'], 'project_structures')

if not os.path.exists(structures_dir):

print(f"警告:未找到默认项目结构目录 {structures_dir}")

return

for project in ['Designer', 'Master', 'Transformer']:

struct_path = os.path.join(structures_dir, f'{project.lower()}_structure.json')

if not os.path.exists(struct_path):

print(f"警告:未找到{project}项目结构文件 {struct_path}")

continue

with open(struct_path, 'r', encoding='utf-8') as f:

struct_data = json.load(f)

for item in struct_data:

# 查找关联术语ID(按术语名称匹配)

related_term_id = None

if 'related_term' in item:

term = Term.query.filter_by(term_name=item['related_term']).first()

if term:

related_term_id = term.term_id

new_struct = ProjectStructure(

project_name=project,

directory_path=item['directory_path'],

file_name=item['file_name'],

related_term_id=related_term_id,

file_type=item['file_type'],

description=item.get('description', '')

)

db.session.add(new_struct)

db.session.commit()

print("默认项目结构导入成功")2. 核心自用模块开发细节

(1)MD 文档管理模块(app/services/doc_service.py)

- 核心功能:模板创建、编辑标注、版本管理、术语校验;

- 关键代码片段(文档标注 + 版本管理):

python

运行

python

import os

import shutil

from app.models.document import Document

from app.models.term import Term

from app import db

from datetime import datetime

def create_doc_from_template(doc_name, doc_type, creator='admin'):

"""从模板创建MD文档"""

# 1. 验证模板存在

template_dir = os.path.join(app.config['INIT_DATA_DIR'], 'doc_templates')

template_path = os.path.join(template_dir, f'{doc_type.lower()}_template.md')

if not os.path.exists(template_path):

return False, f'未找到{doc_type}对应的模板文件'

# 2. 生成文档存储路径

doc_dir = os.path.join(app.config['DOC_STORAGE_DIR'], doc_type.lower())

if not os.path.exists(doc_dir):

os.makedirs(doc_dir)

# 处理文件名重复(添加版本后缀)

base_name = doc_name if doc_name.endswith('.md') else f'{doc_name}.md'

doc_path = os.path.join(doc_dir, base_name)

count = 1

while os.path.exists(doc_path):

doc_path = os.path.join(doc_dir, f'{base_name[:-3]}_{count}.md')

count += 1

# 3. 复制模板内容到新文档

shutil.copy2(template_path, doc_path)

# 4. 新增文档记录到数据库

new_doc = Document(

doc_name=os.path.basename(doc_path),

doc_type=doc_type,

doc_path=doc_path,

creator=creator

)

db.session.add(new_doc)

db.session.commit()

return True, new_doc.doc_id

def add_term_annotation(doc_id, term_id):

"""为文档添加术语标注([[术语名::定义]]格式)"""

doc = Document.query.get(doc_id)

term = Term.query.get(term_id)

if not doc or not term:

return False, '文档或术语不存在'

if not os.path.exists(doc.doc_path):

return False, '文档文件已被删除'

# 1. 读取文档内容

with open(doc.doc_path, 'r', encoding='utf-8') as f:

content = f.read()

# 2. 生成标注内容(添加到文档末尾的"术语标注"章节)

annotation = f'[[{term.term_name}:: {term.term_definition}]]'

if '## 术语标注' not in content:

content += '\n\n## 术语标注\n' + annotation

else:

content = content.replace('## 术语标注', f'## 术语标注\n{annotation}\n')

# 3. 保存文档(先备份旧版本)

backup_path = f'{doc.doc_path}.bak.{doc.doc_version}'

shutil.copy2(doc.doc_path, backup_path)

with open(doc.doc_path, 'w', encoding='utf-8') as f:

f.write(content)

# 4. 更新文档关联术语与版本

related_ids = doc.related_term_ids.split(',') if doc.related_term_ids else []

if str(term_id) not in related_ids:

related_ids.append(str(term_id))

doc.related_term_ids = ','.join(related_ids)

# 版本号递增(V1.0 → V1.1)

current_ver = float(doc.doc_version[1:])

doc.doc_version = f'V{current_ver + 0.1:.1f}'

db.session.commit()

return True, f'标注成功,文档版本更新为{doc.doc_version}'

def validate_doc_terms(doc_id):

"""校验文档中的术语一致性(未收录术语提醒)"""

doc = Document.query.get(doc_id)

if not doc or not os.path.exists(doc.doc_path):

return False, '文档不存在或已删除'

# 1. 读取文档内容(过滤Markdown语法)

with open(doc.doc_path, 'r', encoding='utf-8') as f:

content = f.read()

# 简单过滤Markdown标记(#/*/-等)

import re

content = re.sub(r'[#*\-`\[\]\(\)\{\}]', ' ', content)

# 2. 获取所有有效术语(小写)

valid_terms = [term.term_name.lower() for term in Term.query.filter_by(is_active=True).all()]

# 3. 提取文档中的单词并校验

words = content.split()

invalid_terms = []

for word in words:

# 过滤标点和空字符串

clean_word = word.strip('.,;:!?"\'').lower()

if (clean_word and len(clean_word) > 2

and clean_word not in valid_terms

and not clean_word.isdigit()):

invalid_terms.append(word)

# 去重并返回结果

invalid_terms = list(set(invalid_terms))

if invalid_terms:

return False, f'发现未收录/不规范术语:{", ".join(invalid_terms)}'

return True, '术语一致性校验通过'(2)项目结构生成模块(app/services/structure_service.py)

- 核心功能:一键生成目录、术语关联、本地导出;

- 关键代码片段(目录生成 + 术语强制关联):

python

运行

python

import os

from app.models.project_structure import ProjectStructure

from app.models.term import Term

from app import db

def generate_project_structure(project_name, export_path):

"""生成指定项目的标准目录结构到本地"""

# 1. 验证项目名称

valid_projects = ['Designer', 'Master', 'Transformer']

if project_name not in valid_projects:

return False, f'无效项目名称,仅支持{valid_projects}'

# 验证导出路径

if not os.path.exists(export_path):

try:

os.makedirs(export_path)

except Exception as e:

return False, f'创建导出目录失败:{str(e)}'

# 2. 获取该项目的标准结构

structures = ProjectStructure.query.filter_by(project_name=project_name).all()

if not structures:

return False, f'未找到{project_name}的标准结构配置'

# 3. 递归创建目录和文件

for struct in structures:

# 拼接完整路径

full_path = os.path.join(export_path, struct.directory_path, struct.file_name)

dir_path = os.path.dirname(full_path)

# 创建目录

if not os.path.exists(dir_path):

os.makedirs(dir_path)

# 创建文件(目录类型不创建文件)

if struct.file_type != '目录':

with open(full_path, 'w', encoding='utf-8') as f:

# 写入文件头部说明(关联术语+描述)

term_info = '无关联术语'

if struct.related_term_id:

term = Term.query.get(struct.related_term_id)

if term:

term_info = f'关联术语:{term.term_name}({term.term_definition[:50]}...)'

f.write(f"""# {struct.file_name}

## 模块描述

{struct.description or '无'}

## 术语关联

{term_info}

## 注意事项

1. 请勿修改文件名(需与术语库保持一致)

2. 本文件由Project Planning Tool自动生成

3. 如需调整目录结构,请在工具中修改后重新导出

""")

return True, f'{project_name}项目结构已生成到:{export_path}'

def check_structure_term_consistency(project_name, target_path):

"""校验目标目录的文件名/目录名是否符合术语规范"""

# 1. 获取项目结构与关联术语

structures = ProjectStructure.query.filter_by(project_name=project_name).all()

valid_terms = [term.term_name.lower() for term in Term.query.filter_by(is_active=True).all()]

invalid_files = []

# 2. 遍历目标目录

for root, dirs, files in os.walk(target_path):

# 校验目录名

for dir_name in dirs:

# 提取目录名中的核心术语(简化:全匹配)

if dir_name.lower() not in valid_terms:

relative_path = os.path.relpath(os.path.join(root, dir_name), target_path)

invalid_files.append(f'目录:{relative_path}(未关联有效术语)')

# 校验文件名

for file_name in files:

# 排除后缀,校验文件名核心部分

file_core = os.path.splitext(file_name)[0].lower()

if file_core not in valid_terms:

relative_path = os.path.relpath(os.path.join(root, file_name), target_path)

invalid_files.append(f'文件:{relative_path}(未关联有效术语)')

if invalid_files:

return False, f'发现{len(invalid_files)}个不规范文件/目录:\n' + '\n'.join(invalid_files)

return True, '目录结构术语一致性校验通过'3. 外接扩展模块开发细节

(1)类 LDAP 程序结构包装器(app/services/ldap_service.py)

- 核心功能:标准化打包(ZIP/Docker)、外接导入、API 对接;

- 关键代码片段(Docker 镜像打包 + 外部导入):

python

运行

python

import os

import json

import zipfile

import docker

from app.models.project_structure import ProjectStructure

from app.models.structure_package import StructurePackage

from app.models.term import Term

from app import db

from datetime import datetime

# 初始化Docker客户端(容错处理)

def get_docker_client():

try:

client = docker.from_env()

client.ping()

return client

except Exception as e:

print(f"Docker客户端初始化失败:{str(e)}")

return None

docker_client = get_docker_client()

def package_structure(project_name, package_format, external_platform='local'):

"""打包项目结构为ZIP或Docker镜像"""

# 1. 校验参数

if package_format not in ['zip', 'docker']:

return False, '仅支持zip和docker两种打包格式'

if package_format == 'docker' and not docker_client:

return False, 'Docker未安装或未启动,无法生成Docker镜像'

# 2. 获取项目结构与术语

structures = ProjectStructure.query.filter_by(project_name=project_name).all()

if not structures:

return False, f'未找到{project_name}的项目结构数据'

# 3. 生成元数据

term_ids = set()

struct_details = []

for struct in structures:

if struct.related_term_id:

term_ids.add(str(struct.related_term_id))

struct_details.append({

'directory_path': struct.directory_path,

'file_name': struct.file_name,

'file_type': struct.file_type,

'description': struct.description,

'related_term': Term.query.get(struct.related_term_id).term_name if struct.related_term_id else None

})

metadata = {

'project_name': project_name,

'package_format': package_format,

'structure_version': 'V1.0',

'term_count': len(term_ids),

'directory_count': len([s for s in structures if s.file_type == '目录']),

'file_count': len([s for s in structures if s.file_type != '目录']),

'create_time': datetime.now().strftime('%Y-%m-%d %H:%M:%S'),

'external_platform': external_platform,

'structures': struct_details

}

# 4. 打包处理

package_dir = os.path.join(app.config['PACKAGE_STORAGE_DIR'], project_name.lower())

if not os.path.exists(package_dir):

os.makedirs(package_dir)

if package_format == 'zip':

# 生成ZIP包

package_name = f'{project_name.lower()}_structure_{datetime.now().strftime("%Y%m%d%H%M%S")}.zip'

package_path = os.path.join(package_dir, package_name)

with zipfile.ZipFile(package_path, 'w', zipfile.ZIP_DEFLATED) as zf:

# 写入元数据

zf.writestr('metadata.json', json.dumps(metadata, ensure_ascii=False, indent=2))

# 写入空目录和文件(仅保留结构)

for struct in structures:

zip_path = os.path.join(struct.directory_path, struct.file_name)

if struct.file_type == '目录':

# 创建空目录(ZIP需添加目录结尾的/)

zf.writestr(f'{zip_path}/', '')

else:

# 写入空文件(或模板内容)

zf.writestr(zip_path, '')

else:

# 生成Docker镜像

# 1. 创建Dockerfile

dockerfile_content = f"""FROM alpine:latest

LABEL maintainer="Project Planning Tool"

LABEL project={project_name}

LABEL structure_version={metadata['structure_version']}

LABEL create_time={metadata['create_time']}

# 创建项目结构目录

WORKDIR /app/{project_name.lower()}

# 复制元数据

COPY metadata.json /app/metadata.json

# 创建空目录结构

"""

for struct in structures:

if struct.file_type == '目录':

dockerfile_content += f'RUN mkdir -p /app/{project_name.lower()}/{struct.directory_path}\n'

# 写入Dockerfile和元数据

dockerfile_path = os.path.join(package_dir, 'Dockerfile')

metadata_path = os.path.join(package_dir, 'metadata.json')

with open(dockerfile_path, 'w', encoding='utf-8') as f:

f.write(dockerfile_content)

with open(metadata_path, 'w', encoding='utf-8') as f:

f.write(json.dumps(metadata, ensure_ascii=False, indent=2))

# 2. 构建Docker镜像

image_tag = f'{project_name.lower()}_structure:{metadata["structure_version"]}'

try:

docker_client.images.build(

path=package_dir,

tag=image_tag,

quiet=True

)

package_path = image_tag

except Exception as e:

return False, f'Docker镜像构建失败:{str(e)}'

# 5. 记录打包记录到数据库

new_package = StructurePackage(

project_name=project_name,

package_format=package_format,

package_path=package_path,

metadata_json=json.dumps(metadata, ensure_ascii=False),

related_term_ids=','.join(term_ids) if term_ids else '',

external_platform=external_platform

)

db.session.add(new_package)

db.session.commit()

return True, f'打包成功,包路径/镜像标签:{package_path}'

def import_external_structure(external_url, project_name):

"""从外部URL导入项目结构(支持ZIP包或Docker镜像)"""

# 1. 校验参数

valid_projects = ['Designer', 'Master', 'Transformer']

if project_name not in valid_projects:

return False, f'无效项目名称,仅支持{valid_projects}'

# 2. 下载/拉取外部资源

metadata = None

struct_details = None

if external_url.startswith('http') or external_url.startswith('https'):

# 下载ZIP包

import requests

try:

response = requests.get(external_url, stream=True)

response.raise_for_status()

# 临时保存ZIP包

temp_zip_path = os.path.join(app.config['PACKAGE_STORAGE_DIR'], 'temp_external.zip')

with open(temp_zip_path, 'wb') as f:

for chunk in response.iter_content(chunk_size=8192):

f.write(chunk)

# 解析ZIP包中的metadata.json

with zipfile.ZipFile(temp_zip_path, 'r') as zf:

if 'metadata.json' not in zf.namelist():

return False, '外部ZIP包缺少metadata.json元数据'

metadata = json.loads(zf.read('metadata.json').decode('utf-8'))

struct_details = metadata.get('structures', [])

# 删除临时文件

os.remove(temp_zip_path)

except Exception as e:

return False, f'下载并解析ZIP包失败:{str(e)}'

elif external_url.startswith('docker://'):

# 拉取Docker镜像

if not docker_client:

return False, 'Docker未安装或未启动,无法拉取镜像'

image_tag = external_url.replace('docker://', '')

try:

# 拉取镜像

docker_client.images.pull(image_tag)

# 创建临时容器提取元数据

container = docker_client.containers.create(image_tag)

try:

# 复制容器内的metadata.json

metadata_bytes, _ = container.exec_run('cat /app/metadata.json')

metadata = json.loads(metadata_bytes.decode('utf-8'))

struct_details = metadata.get('structures', [])

finally:

container.remove()

except Exception as e:

return False, f'拉取并解析Docker镜像失败:{str(e)}'

else:

return False, '仅支持HTTP/HTTPS ZIP包或docker://镜像地址'

# 3. 导入结构到数据库(覆盖或新增)

if not struct_details:

return False, '元数据中未找到结构信息'

# 删除该项目原有结构(可选:可改为增量导入)

ProjectStructure.query.filter_by(project_name=project_name).delete()

for struct in struct_details:

# 匹配关联术语(按术语名称)

related_term_id = None

if struct.get('related_term'):

term = Term.query.filter_by(term_name=struct['related_term']).first()

if term:

related_term_id = term.term_id

# 新增结构记录

new_struct = ProjectStructure(

project_name=project_name,

directory_path=struct['directory_path'],

file_name=struct['file_name'],

related_term_id=related_term_id,

file_type=struct['file_type'],

description=struct.get('description', '')

)

db.session.add(new_struct)

db.session.commit()

return True, f'成功导入{len(struct_details)}条结构记录,元数据:{json.dumps(metadata, indent=2)}'(2)类 TSN 术语封装模块(app/services/tsn_service.py)

- 核心功能:JSON-LD 格式转换、外接 API、算法接入;

- 关键代码片段(JSON-LD 转换 + 外部算法调用):

python

运行

python

import json

from pyld import jsonld

from app.models.term import Term

from app.models.term_api_log import TermApiLog

from app import db

import requests

# JSON-LD上下文定义

TERM_JSONLD_CONTEXT = {

"@context": {

"termName": "http://schema.org/name",

"termDefinition": "http://schema.org/description",

"termCategory": "http://schema.org/category",

"relatedTerms": "http://schema.org/relatedItem",

"createTime": "http://schema.org/dateCreated",

"isActive": "http://schema.org/active"

}

}

def get_term_external(term_id, output_format='json-ld'):

"""对外提供术语查询(支持JSON/JSON-LD)"""

term = Term.query.get(term_id)

if not term or not term.is_active:

return False, '术语不存在或已禁用'

if output_format == 'json-ld':

result = term.to_jsonld()

else:

result = term.to_dict()

return True, result

def batch_export_terms_external(category=None, output_format='json-ld'):

"""批量导出术语(支持按类别筛选)"""

query = Term.query.filter_by(is_active=True)

if category:

query = query.filter_by(term_category=category)

terms = query.all()

result = []

for term in terms:

if output_format == 'json-ld':

result.append(term.to_jsonld())

else:

result.append(term.to_dict())

return True, result

def validate_text_terms_external(text, external_api=None, external_system='unknown', ip_address='unknown'):

"""对外提供文本术语校验(支持调用外部算法)"""

# 记录API调用日志(初始状态)

log = TermApiLog(

api_path='/api/v1/tsn/term/validate',

request_params=json.dumps({'text': text, 'external_api': external_api}),

external_system=external_system,

ip_address=ip_address,

status='processing'

)

db.session.add(log)

db.session.flush() # 获取log_id

try:

if external_api and app.config['EXTERNAL_API_ENABLED']:

# 调用外部校验算法

response = requests.post(

external_api,

json={'text': text},

timeout=30

)

response.raise_for_status()

result = response.json()

# 补充工具术语库信息

valid_terms = [term.term_name.lower() for term in Term.query.filter_by(is_active=True).all()]

result['tool_valid_terms_count'] = len(valid_terms)

result['validate_method'] = 'external'

else:

# 工具内置校验

valid_terms = [term.term_name.lower() for term in Term.query.filter_by(is_active=True).all()]

words = text.split()

invalid_terms = []

for word in words:

clean_word = word.strip('.,;:!?"\'').lower()

if (clean_word and len(clean_word) > 2

and clean_word not in valid_terms

and not clean_word.isdigit()):

invalid_terms.append(word)

result = {

'valid': len(invalid_terms) == 0,

'invalid_terms': list(set(invalid_terms)),

'valid_terms_count': len(valid_terms),

'validate_method': 'internal'

}

# 更新日志状态

log.status = 'success'

log.response_result = json.dumps(result, ensure_ascii=False)

db.session.commit()

return True, result

except Exception as e:

# 更新日志状态(失败)

log.status = 'fail'

log.response_result = str(e)

db.session.commit()

return False, f'术语校验失败:{str(e)}'

def import_terms_from_external(external_api, external_system='unknown', ip_address='unknown'):

"""从外部算法导入术语(支持JSON-LD格式)"""

try:

# 调用外部术语抽取API

response = requests.get(external_api, timeout=30)

response.raise_for_status()

external_terms = response.json()

if not isinstance(external_terms, list):

return False, '外部API返回格式错误,需为术语列表'

imported_count = 0

for term_data in external_terms:

# 兼容JSON-LD和普通JSON格式

if '@context' in term_data:

# 压缩JSON-LD

compacted = jsonld.compact(term_data, TERM_JSONLD_CONTEXT)

term_name = compacted.get('termName')

term_def = compacted.get('termDefinition', '')

term_category = compacted.get('termCategory', '未分类')

else:

term_name = term_data.get('term_name') or term_data.get('termName')

term_def = term_data.get('term_definition') or term_data.get('termDefinition', '')

term_category = term_data.get('term_category') or term_data.get('termCategory', '未分类')

if not term_name:

continue

# 避免重复(按术语名称去重)

existing = Term.query.filter_by(term_name=term_name).first()

if not existing:

new_term = Term(

term_name=term_name,

term_definition=term_def,

term_category=term_category

)

db.session.add(new_term)

imported_count += 1

db.session.commit()

# 记录API调用日志

log = TermApiLog(

api_path='/api/v1/tsn/terms/import',

request_params=json.dumps({'external_api': external_api}),

response_result=json.dumps({'imported_count': imported_count}),

external_system=external_system,

ip_address=ip_address,

status='success'

)

db.session.add(log)

db.session.commit()

return True, f'成功导入{imported_count}个术语,总计术语数:{Term.query.filter_by(is_active=True).count()}'

except Exception as e:

# 记录失败日志

log = TermApiLog(

api_path='/api/v1/tsn/terms/import',

request_params=json.dumps({'external_api': external_api}),

response_result=str(e),

external_system=external_system,

ip_address=ip_address,

status='fail'

)

db.session.add(log)

db.session.commit()

return False, f'导入外部术语失败:{str(e)}'(3)类 DNS 文档外壳模块(app/services/dns_service.py)

- 核心功能:文档寻址、部署脚本生成、训练数据导出;

- 关键代码片段(K8s 部署脚本 + 训练数据导出):

python

运行

python

import os

import json

from app.models.document import Document

from app.models.doc_deployment import DocDeployment

from app.models.term import Term

from app import db

from datetime import datetime

def get_doc_identifier(doc_id):

"""生成文档唯一寻址标识(doc://{doc_id}:{version})"""

doc = Document.query.get(doc_id)

if not doc or doc.is_archived:

return False, '文档不存在或已归档'

return True, f'doc://{doc.doc_id}:{doc.doc_version}'

def generate_deploy_script(doc_id, deploy_type, k8s_node_port=None):

"""生成文档部署脚本(local/K8s)"""

doc = Document.query.get(doc_id)

if not doc or not os.path.exists(doc.doc_path):

return False, '文档不存在或已删除'

# 生成唯一标识

doc_identifier = f'doc://{doc.doc_id}:{doc.doc_version}'

deploy_dir = os.path.join(app.config['DEPLOY_STORAGE_DIR'], str(doc.doc_id))

if not os.path.exists(deploy_dir):

os.makedirs(deploy_dir)

# 读取文档内容

with open(doc.doc_path, 'r', encoding='utf-8') as f:

doc_content = f.read()

# 生成部署脚本

if deploy_type == 'local':

# 本地Shell部署脚本(启动HTTP服务)

script_name = 'deploy_local.sh'

script_path = os.path.join(deploy_dir, script_name)

# 替换文档内容中的引号(避免Shell语法错误)

safe_content = doc_content.replace('"', '\\"').replace('`', '\\`')

script_content = f"""#!/bin/bash

# 文档部署脚本(类DNS文档外壳)

# 文档标识:{doc_identifier}

# 部署路径:/opt/project_docs/{doc.doc_id}

# 创建部署目录

mkdir -p /opt/project_docs/{doc.doc_id}

cd /opt/project_docs/{doc.doc_id}

# 写入文档内容

cat > "{doc.doc_name}" << EOF

{safe_content}

EOF

# 启动HTTP服务(808{doc.doc_id % 10}端口,避免冲突)

PORT=808{doc.doc_id % 10}

echo "启动HTTP服务,端口:$PORT"

python3 -m http.server $PORT --directory . &

PID=$!

echo "服务PID:$PID,已后台运行"

echo "外部访问URL:http://$(hostname -I | awk '{{print $1}}'):$PORT/{doc.doc_name}"

# 保存PID到文件(停止服务用)

echo $PID > doc_server.pid

echo "停止服务命令:kill \$(cat doc_server.pid) && rm doc_server.pid"

"""

with open(script_path, 'w', encoding='utf-8') as f:

f.write(script_content)

# 赋予执行权限

os.chmod(script_path, 0o755)

external_url = f'http://localhost:808{doc.doc_id % 10}/{doc.doc_name}'

elif deploy_type == 'k8s':

# K8s YAML部署脚本(ConfigMap+Nginx+NodePort)

script_name = 'deploy_k8s.yaml'

script_path = os.path.join(deploy_dir, script_name)

# 生成NodePort(30000-30999范围内)

node_port = k8s_node_port or 30000 + (doc.doc_id % 1000)

# 替换文档内容中的引号和换行(YAML格式兼容)

safe_content = doc_content.replace('"', '\\"').replace('\n', '\n ')

# 关联术语信息

related_terms = doc.get_related_terms()

term_info = ', '.join([t.term_name for t in related_terms]) if related_terms else '无'

k8s_content = f"""apiVersion: v1

kind: ConfigMap

metadata:

name: doc-configmap-{doc.doc_id}

labels:

app: doc-nginx-{doc.doc_id}

doc_identifier: "{doc_identifier}"

related_terms: "{term_info}"

data:

{doc.doc_name}: |

{safe_content}

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: doc-nginx-{doc.doc_id}

labels:

app: doc-nginx-{doc.doc_id}

spec:

replicas: 1

selector:

matchLabels:

app: doc-nginx-{doc.doc_id}

template:

metadata:

labels:

app: doc-nginx-{doc.doc_id}

spec:

containers:

- name: nginx

image: nginx:alpine

ports:

- containerPort: 80

volumeMounts:

- name: doc-volume

mountPath: /usr/share/nginx/html

readOnly: true

volumes:

- name: doc-volume

configMap:

name: doc-configmap-{doc.doc_id}

---

apiVersion: v1

kind: Service

metadata:

name: doc-service-{doc.doc_id}

labels:

app: doc-nginx-{doc.doc_id}

spec:

type: NodePort

ports:

- port: 80

targetPort: 80

nodePort: {node_port}

selector:

app: doc-nginx-{doc.doc_id}

"""

with open(script_path, 'w', encoding='utf-8') as f:

f.write(k8s_content)

external_url = f'http://<k8s-node-ip>:{node_port}/{doc.doc_name}'

else:

return False, '仅支持local和k8s两种部署类型'

# 记录部署记录

new_deploy = DocDeployment(

doc_id=doc.doc_id,

doc_identifier=doc_identifier,

deploy_type=deploy_type,

deploy_script_path=script_path,

external_url=external_url,

status='deployed' if deploy_type == 'local' else 'ready_to_deploy'

)

db.session.add(new_deploy)

db.session.commit()

return True, f'部署脚本生成成功:{script_path}\n外部访问URL:{external_url}'

def export_doc_train_data(doc_id, export_format='json'):

"""导出文档为训练数据(txt/json格式)"""

doc = Document.query.get(doc_id)

if not doc or not os.path.exists(doc.doc_path):

return False, '文档不存在或已删除'

# 读取文档内容(过滤Markdown语法,保留纯文本)

with open(doc.doc_path, 'r', encoding='utf-8') as f:

content = f.read()

# 简单过滤Markdown标记

import re

pure_text = re.sub(r'[#*\-`\[\]\(\)\{\}:]', ' ', content)

pure_text = re.sub(r'\n+', ' ', pure_text).strip()

# 准备训练数据元信息

related_terms = [t.term_name for t in doc.get_related_terms()]

train_data = {

'doc_identifier': f'doc://{doc.doc_id}:{doc.doc_version}',

'doc_title': doc.doc_name,

'doc_type': doc.doc_type,

'related_terms': related_terms,

'content': pure_text,

'create_time': doc.create_time.strftime('%Y-%m-%d %H:%M:%S'),

'version': doc.doc_version

}

# 导出文件

export_dir = os.path.join(app.config['TRAIN_DATA_DIR'], str(doc.doc_id))

if not os.path.exists(export_dir):

os.makedirs(export_dir)

if export_format == 'txt':

export_path = os.path.join(export_dir, f'{doc.doc_name.replace(".md", "")}_train.txt')

with open(export_path, 'w', encoding='utf-8') as f:

f.write(pure_text)

elif export_format == 'json':

export_path = os.path.join(export_dir, f'{doc.doc_name.replace(".md", "")}_train.json')

with open(export_path, 'w', encoding='utf-8') as f:

json.dump(train_data, f, ensure_ascii=False, indent=2)

else:

return False, '仅支持txt和json两种导出格式'

# 更新部署记录

deploy = DocDeployment.query.filter_by(doc_id=doc.doc_id).order_by(DocDeployment.create_time.desc()).first()

if deploy:

deploy.train_data_path = export_path

deploy.deploy_type = f'{deploy.deploy_type},train_export'

else:

deploy = DocDeployment(

doc_id=doc.doc_id,

doc_identifier=f'doc://{doc.doc_id}:{doc.doc_version}',

deploy_type='train_export',

train_data_path=export_path,

status='exported'

)

db.session.add(deploy)

db.session.commit()

return True, f'训练数据导出成功:{export_path}'五、外接接口与 SDK 设计

1. 外接 API 接口规范(RESTful API)

(1)接口通用规则

- 基础路径:

/api/v1; - 请求方式:GET(查询 / 导出)、POST(创建 / 导入 / 校验);

- 认证方式:API Key(请求头

X-API-Key); - 响应格式:

json

{

"success": true/false,

"message": "提示信息",

"data": {} // 业务数据(success=true时返回)

}(2)核心接口清单

| 模块 | 接口路径 | 方法 | 功能描述 | 关键参数 |

|---|---|---|---|---|

| 类 LDAP | /api/v1/ldap/structure/package |

POST | 打包项目结构 | project_name、package_format、external_platform |

| 类 LDAP | /api/v1/ldap/structure/import |

POST | 导入外部结构 | external_url、project_name |

| 类 TSN | /api/v1/tsn/term/{term_id} |

GET | 查询单个术语 | term_id、output_format(json/json-ld) |

| 类 TSN | /api/v1/tsn/terms |

GET | 批量导出术语 | category、output_format |

| 类 TSN | /api/v1/tsn/term/validate |

POST | 校验文本术语 | text、external_api |

| 类 TSN | /api/v1/tsn/terms/import |

POST | 导入外部术语 | external_api |

| 类 DNS | /api/v1/dns/doc/{doc_id}/identifier |

GET | 获取文档唯一标识 | doc_id |

| 类 DNS | /api/v1/dns/doc/{doc_id}/deploy |

POST | 生成部署脚本 | doc_id、deploy_type、k8s_node_port |

| 类 DNS | /api/v1/dns/doc/{doc_id}/export-train |

GET | 导出训练数据 | doc_id、export_format(txt/json) |

(3)接口认证中间件(app/middleware/auth.py)

python

运行

python

from flask import request, jsonify

from functools import wraps

from app import app

def require_api_key(f):

"""API密钥认证装饰器"""

@wraps(f)

def decorated_function(*args, **kwargs):

# 未启用外接API时,直接拒绝

if not app.config['EXTERNAL_API_ENABLED']:

return jsonify({

'success': False,

'message': '外接API功能未启用'

}), 403

# 获取API Key

api_key = request.headers.get('X-API-Key')

if not api_key or api_key != app.config['API_KEY']:

return jsonify({

'success': False,

'message': '无效的API Key'

}), 401

return f(*args, **kwargs)

return decorated_function2. Python SDK 设计(app/extensions/sdk/python_sdk/project_tool_sdk.py)

- 功能:简化外部 Python 程序调用工具 API;

- 核心代码:

python

运行

python

import requests

import json

class ProjectToolSDK:

def __init__(self, base_url, api_key):

self.base_url = base_url.rstrip('/')

self.headers = {

'X-API-Key': api_key,

'Content-Type': 'application/json'

}

# 类LDAP相关接口

def package_structure(self, project_name, package_format='zip', external_platform='local'):

"""打包项目结构"""

url = f'{self.base_url}/api/v1/ldap/structure/package'

data = {

'project_name': project_name,

'package_format': package_format,

'external_platform': external_platform

}

response = requests.post(url, json=data, headers=self.headers)

return response.json()

def import_external_structure(self, external_url, project_name):

"""导入外部结构"""

url = f'{self.base_url}/api/v1/ldap/structure/import'

data = {

'external_url': external_url,

'project_name': project_name

}

response = requests.post(url, json=data, headers=self.headers)

return response.json()

# 类TSN相关接口

def get_term(self, term_id, output_format='json-ld'):

"""查询单个术语"""

url = f'{self.base_url}/api/v1/tsn/term/{term_id}'

params = {'output_format': output_format}

response = requests.get(url, params=params, headers=self.headers)

return response.json()

def batch_export_terms(self, category=None, output_format='json-ld'):

"""批量导出术语"""

url = f'{self.base_url}/api/v1/tsn/terms'

params = {'output_format': output_format}

if category:

params['category'] = category

response = requests.get(url, params=params, headers=self.headers)

return response.json()

def validate_text_terms(self, text, external_api=None):

"""校验文本术语"""

url = f'{self.base_url}/api/v1/tsn/term/validate'

data = {'text': text}

if external_api:

data['external_api'] = external_api

response = requests.post(url, json=data, headers=self.headers)

return response.json()

# 类DNS相关接口

def get_doc_identifier(self, doc_id):

"""获取文档唯一标识"""

url = f'{self.base_url}/api/v1/dns/doc/{doc_id}/identifier'

response = requests.get(url, headers=self.headers)

return response.json()

def generate_deploy_script(self, doc_id, deploy_type='local', k8s_node_port=None):

"""生成部署脚本"""

url = f'{self.base_url}/api/v1/dns/doc/{doc_id}/deploy'

data =请继续

def generate_deploy_script (self, doc_id, deploy_type='local', k8s_node_port=None):"""生成文档部署脚本"""url = f'{self.base_url}/api/v1/dns/doc/{doc_id}/deploy'data = {'doc_id': doc_id,'deploy_type': deploy_type}if k8s_node_port:data ['k8s_node_port'] = k8s_node_portresponse = requests.post (url, json=data, headers=self.headers)return response.json ()

def export_doc_train_data (self, doc_id, export_format='json'):"""导出文档训练数据"""url = f'{self.base_url}/api/v1/dns/doc/{doc_id}/export-train'params = {'export_format': export_format}response = requests.get (url, params=params, headers=self.headers)return response.json ()

SDK 使用示例(app/extensions/sdk/python_sdk/example.py)

if name == "main":

初始化 SDK

sdk = ProjectToolSDK(base_url='http://localhost:5000',api_key='your-api-key-for-external-call')

1. 打包 Transformer 项目结构为 Docker 镜像

package_result = sdk.package_structure (project_name='Transformer',package_format='docker',external_platform='GitLab CI')print ("结构打包结果:", json.dumps (package_result, indent=2))

2. 查询术语(modus)

term_result = sdk.get_term (term_id=3, output_format='json-ld')print ("术语查询结果:", json.dumps (term_result, indent=2))

3. 校验文本术语

validate_result = sdk.validate_text_terms (text=' 使用 modus 模式驱动混合伺服步进电机,调用 ANIs 接口 ',external_api='http://external-algorithm:8000/api/validate')print ("术语校验结果:", json.dumps (validate_result, indent=2))

4. 生成文档部署脚本(K8s)

deploy_result = sdk.generate_deploy_script (doc_id=10,deploy_type='k8s',k8s_node_port=30080)print ("部署脚本生成结果:", json.dumps (deploy_result, indent=2))

六、外接接口测试用例(Postman/requests)

1. 接口认证测试

(1)无 API Key 调用(预期失败)

python

运行

python

import requests

url = 'http://localhost:5000/api/v1/tsn/term/1'

response = requests.get(url)

print(response.json())

# 预期响应:{"success":false,"message":"无效的API Key"}(2)有效 API Key 调用(预期成功)

python

运行

python

import requests

url = 'http://localhost:5000/api/v1/tsn/term/1'

headers = {'X-API-Key': 'your-api-key-for-external-call'}

response = requests.get(url, headers=headers)

print(response.json())

# 预期响应:{"success":true,"message":"查询成功","data":{"termName":"modus",...}}2. 核心接口功能测试

(1)类 LDAP 结构打包测试

python

运行

python

import requests

import json

url = 'http://localhost:5000/api/v1/ldap/structure/package'

headers = {

'X-API-Key': 'your-api-key-for-external-call',

'Content-Type': 'application/json'

}

data = {

'project_name': 'Designer',

'package_format': 'zip',

'external_platform': 'local'

}

response = requests.post(url, json=data, headers=headers)

print(json.dumps(response.json(), indent=2))

# 预期响应:{"success":true,"message":"打包成功,包路径/镜像标签:data/packages/designer/designer_structure_20251120153000.zip"}(2)类 TSN 术语批量导出测试

python

运行

python

import requests

import json

url = 'http://localhost:5000/api/v1/tsn/terms?category=模式词汇&output_format=json-ld'

headers = {'X-API-Key': 'your-api-key-for-external-call'}

response = requests.get(url, headers=headers)

print(json.dumps(response.json(), indent=2))

# 预期响应:{"success":true,"message":"导出成功","data":[{"@context":{...},"@type":"Term",...}]}(3)类 DNS 文档训练数据导出测试

python

运行

python

import requests

import json

url = 'http://localhost:5000/api/v1/dns/doc/10/export-train?export_format=json'

headers = {'X-API-Key': 'your-api-key-for-external-call'}

response = requests.get(url, headers=headers)

print(json.dumps(response.json(), indent=2))

# 预期响应:{"success":true,"message":"训练数据导出成功:data/train_data/10/designer_global_guide_train.json","data":{...}}七、开发计划与里程碑

1. 开发阶段划分(总计 6 周)

| 阶段 | 时间周期 | 核心任务 | 交付物 |

|---|---|---|---|

| 阶段 1:基础自用功能开发 | 第 1-2 周 | 1. 项目初始化(环境配置、数据库模型创建);2. MD 文档管理模块(模板、编辑、标注);3. 项目结构生成模块(目录生成、术语关联);4. 术语管理模块(字典、一致性校验) | 1. 可运行的基础项目框架;2. 文档 / 结构 / 术语核心功能演示版;3. 初始化数据(术语库、项目结构模板) |

| 阶段 2:外接扩展功能开发 | 第 3-4 周 | 1. 类 LDAP 模块(ZIP/Docker 打包、外部导入);2. 类 TSN 模块(JSON-LD 转换、外接 API);3. 类 DNS 模块(部署脚本、训练数据导出);4. 外接接口认证与 SDK 开发 | 1. 三大扩展模块功能完整实现;2. 外接 API 接口文档(Swagger);3. Python SDK 及使用示例 |

| 阶段 3:优化与测试验收 | 第 5-6 周 | 1. 前端页面优化(响应式布局、交互体验);2. 功能测试(单元测试、集成测试、外接联动测试);3. Bug 修复与性能优化;4. 部署指南与用户手册编写 | 1. 无重大 Bug 的正式版本;2. 完整的测试报告;3. 部署指南 + 用户手册;4. 可直接运行的工具安装包 |

2. 关键里程碑

- 里程碑 1(第 2 周末):基础自用功能闭环,可生成三体项目结构、编辑标注文档、校验术语;

- 里程碑 2(第 4 周末):外接扩展功能闭环,可通过 API/SDK 实现结构打包、术语交互、文档部署;

- 里程碑 3(第 6 周末):工具正式交付,包含完整功能、测试报告、使用文档,支持直接部署使用。

八、测试方案

1. 测试范围

| 测试类型 | 测试对象 | 核心测试点 |

|---|---|---|

| 单元测试 | 所有 service 层方法、模型方法 | 1. 输入参数校验(合法 / 非法参数);2. 业务逻辑正确性(如术语标注、结构打包);3. 异常处理(文件不存在、网络错误) |

| 集成测试 | 模块间联动(如文档 - 术语、结构 - 打包、外接 API - 扩展模块) | 1. 数据流转正确性(如文档关联术语后打包元数据同步);2. 接口调用成功率(如 SDK 调用外接 API);3. 数据库一致性(操作后数据无脏数据) |

| 功能测试 | 前端页面 + 后端功能 | 1. 页面交互流畅性(如 MD 编辑器、结构导出按钮);2. 功能完整性(所有设计功能是否实现);3. 易用性(操作步骤≤3 步完成核心任务) |

| 外接功能测试 | 外接 API、SDK、外部系统联动(Docker/K8s / 外部算法) | 1. API 兼容性(不同平台调用成功率);2. 数据格式正确性(JSON-LD/Docker 镜像元数据);3. 联动稳定性(连续 10 次调用无失败) |

| 兼容性测试 | 浏览器、Python 版本、操作系统 | 1. 浏览器兼容(Chrome/Firefox/Edge 最新版);2. Python 版本兼容(3.10-3.12);3. 操作系统兼容(Windows10+/MacOS12+/Linux(Ubuntu20.04+)) |

2. 测试工具与环境

| 测试类型 | 测试工具 | 测试环境 |

|---|---|---|

| 单元测试 | pytest、coverage | 本地开发环境(Python3.10、SQLite3.39+) |

| 集成测试 | pytest、requests | 本地开发环境 + Docker Desktop(24.0+)、Minikube(1.32+) |

| 功能测试 | Selenium(前端自动化)、Postman(接口测试) | 测试服务器(8 核 16G、Ubuntu20.04) |

| 外接功能测试 | Postman、Python SDK、外部算法模拟服务(FastAPI 搭建) | 测试服务器 + Docker 集群 + K8s 集群 |

| 兼容性测试 | BrowserStack(浏览器兼容)、多 Python 版本虚拟环境 | 多操作系统虚拟机(Windows11、MacOS14、Ubuntu22.04) |

3. 核心测试用例示例(单元测试)

python

运行

python

# tests/test_doc_service.py

import pytest

from app.services.doc_service import create_doc_from_template, add_term_annotation

from app.models.document import Document

from app.models.term import Term

from app import db, create_app

@pytest.fixture

def app():

app = create_app('config.TestConfig')

with app.app_context():

db.create_all()

# 导入测试数据

test_term = Term(term_name='test_term', term_definition='测试术语', term_category='测试类')

db.session.add(test_term)

db.session.commit()

yield app

db.drop_all()

def test_create_doc_from_template(app):

with app.app_context():

success, result = create_doc_from_template('测试文档', '全局总纲', 'test_user')

assert success is True

assert isinstance(result, int) # 返回doc_id

doc = Document.query.get(result)

assert doc.doc_name == '测试文档.md'

assert doc.doc_type == '全局总纲'

assert doc.creator == 'test_user'

def test_add_term_annotation(app):

with app.app_context():

# 先创建文档

_, doc_id = create_doc_from_template('测试文档', '全局总纲')

# 添加术语标注

success, message = add_term_annotation(doc_id, term_id=1)

assert success is True

assert '标注成功' in message

# 验证文档关联术语和版本

doc = Document.query.get(doc_id)

assert doc.related_term_ids == '1'

assert doc.doc_version == 'V1.1'

# 验证文档内容添加标注

with open(doc.doc_path, 'r', encoding='utf-8') as f:

content = f.read()

assert '[[test_term:: 测试术语]]' in content九、部署与使用指南

1. 本地部署步骤(Windows/Mac/Linux 通用)

(1)环境准备

- 安装 Python3.10+:https://www.python.org/downloads/

- (可选)安装 Docker Desktop(用于类 LDAP Docker 打包):https://www.docker.com/products/docker-desktop/

- (可选)安装 Minikube(用于类 DNS K8s 部署测试):https://minikube.sigs.k8s.io/docs/start/

(2)工具部署

bash

bash

# 1. 克隆代码仓库(假设已创建仓库)

git clone https://github.com/your-repo/project-planning-tool.git

cd project-planning-tool

# 2. 创建并激活虚拟环境

python -m venv venv

# Windows激活

venv\Scripts\activate

# Mac/Linux激活

source venv/bin/activate

# 3. 安装依赖

pip install -r requirements.txt

# 4. 配置环境变量(复制示例配置并修改)

cp .env.example .env

# 编辑.env文件,设置SECRET_KEY、API_KEY等(可选)

# 5. 启动工具

python run.py

# 预期输出:* Running on http://127.0.0.1:5000/ (Press CTRL+C to quit)(3)访问工具

打开浏览器,输入http://localhost:5000,进入工具首页,默认无需登录(自用场景简化,可扩展用户认证)。

2. 核心功能使用流程

(1)自用核心功能流程

- 术语管理:进入「术语管理」页面,新增 / 编辑术语(如 pattern/mode/modus),关联相关术语;

- 文档编辑:进入「文档管理」页面,选择模板创建文档,编辑内容并添加术语标注,校验术语一致性;

- 结构生成:进入「项目结构」页面,选择目标项目(如 Designer),输入导出路径,一键生成标准目录结构;

- 交接面管理:进入「交接面管理」页面,创建 Designer→Master 的接口,定义数据格式和参数。

(2)外接扩展功能流程

- 启用外接 API:编辑

.env文件,设置EXTERNAL_API_ENABLED=True,重启工具; - 结构打包:进入「类 LDAP 工具」页面,选择项目和打包格式(ZIP/Docker),点击打包,获取包路径 / 镜像标签;

- 术语外接调用:使用 Python SDK 或 Postman,通过 API Key 调用术语查询 / 校验接口;

- 文档部署:进入「类 DNS 工具」页面,选择文档,生成 K8s 部署脚本,执行

kubectl apply -f deploy_k8s.yaml部署。

3. 常见问题排查

(1)Docker 打包失败

- 排查 1:是否安装 Docker Desktop 并启动?

- 排查 2:当前用户是否有权限操作 Docker?(Mac/Linux 可尝试

sudo docker ps验证) - 排查 3:镜像构建是否超时?可增大 Docker 构建超时时间。

(2)外接 API 调用失败

- 排查 1:是否启用

EXTERNAL_API_ENABLED=True? - 排查 2:API Key 是否与

.env文件中一致? - 排查 3:工具是否正常运行(

http://localhost:5000是否可访问)?

(3)文档术语校验失败

- 排查 1:未收录术语是否需要新增?进入术语管理页面新增术语后重新校验;

- 排查 2:术语是否被禁用?检查术语的「是否启用」状态。

4. 数据备份与迁移

- 备份:工具数据存储在

data/project_tool.db(SQLite 数据库),直接复制该文件即可备份; - 迁移:将备份的

project_tool.db复制到新环境的data/目录下,重启工具即可。

十、可扩展预留点

1. 功能扩展

- 多用户支持:新增用户表、角色权限表,实现基于角色的访问控制(RBAC);

- 原生协议适配:扩展类 LDAP 模块支持原生 LDAP 协议,类 DNS 模块支持原生 DNS 解析;

- 更多外接格式:类 LDAP 模块新增 Helm Chart 打包格式,类 TSN 模块新增 Protobuf 术语格式;

- 版本控制集成:对接 Git,实现文档 / 结构的版本管理(提交、分支、回滚)。

2. 性能扩展

- 数据库迁移:支持迁移到 PostgreSQL/MySQL,提升多用户并发访问性能;

- 缓存优化:引入 Redis 缓存高频访问数据(术语库、项目结构),降低数据库压力;

- 异步任务:使用 Celery 处理大文件打包、训练数据导出等耗时操作,避免阻塞接口。

3. 生态扩展

- 外部平台模板库:内置 GitLab CI/Jenkins/K8s 等主流平台的对接模板,一键生成配置文件;

- 算法市场:集成常用 NLP 术语抽取 / 校验算法(如 jieba、spaCy),用户可直接选择使用;

- 移动端适配:开发移动端 H5 页面,支持手机端查看文档、校验术语。

十一、结语

增强版 Project Planning Tool 以 "自用闭环 + 外接扩展" 为核心,既解决了三体项目(Designer/Master/Transformer)开发过程中的协同效率问题,又通过类 LDAP/TSN/DNS 模块打通了与外部系统的联动链路,形成 "设计 - 开发 - 部署 - 复用" 的完整工具链。

工具遵循 "轻量优先、兼容适配、迭代开发" 的原则,可根据实际开发需求逐步扩展功能。后续开发将严格按照本文档的规划推进,确保每个阶段交付物可落地、可验证,为元级自动化引擎的全流程开发提供坚实支撑。

补充一下开发计划与里程碑的具体内容

如何确保文档的一致性?

可扩展预留点具体怎么写?

Q382

Q382、您对我所说 这个工具 " 最好能 集成 LDAP或类似的协议 ( 程序结构 的打包 包装器 ,可外接开发 集成平台 或支持外部 模型接入) +TSN或类似的技术(术语的封装 ,可外接测试或 支持外部算法接入) +DNS或类似的shell( .md 文档 的外壳 ,可外接 环境 部署或支持外部 训练平台接入)"表述 括号中逗号以后 的 "可外接..." 或"支持外部...接入 " 是两个方向,或者说 就是 要设计两套 接口, 前者是 APIs(外挂扩展),后者是 SPIs(内嵌增强),同时 自用闭环 独立设计为 ANIs(中间的防腐层 接口),闭环该工具 实现的 功能。 也就是,区分了 功能性需求(如 .md 文档 编辑及标注 等 项目规划功能 ) 和 非功能性需求(如集成 类似LDAP的协议 等)。您是这样理解的吗? 另外主功能-规划的项目结构 --需要一个 1(通用)+3(专用)的项目模型,显然 通用模型也必须是 9维基础空间( 项目元模型,描述整体设计的元数据,想必应该就是 由.md 文档 表达 并 通过 元语言注释 来标注 ) ,3个专用模型(分别描述 三套程序) 想必分别对应1/2/3 维时间,维度处理 也就是 三套程序 的 交接面 。所以,主要功能 就只有这三个。 ---请考虑一下,我的这些表述对吗?您的设计中是这样考虑的吗? 我们可以先讨论到位,再修改 工具的设计和程序

用户现在需要我先回应他的两个核心疑问:一是关于接口设计(APIs 外挂扩展、SPIs 内嵌增强、ANIs 防腐层)是否理解正确,二是关于项目模型(1 通用 + 3 专用,对应 9 维基础空间和 1/2/3 维时间)的表述是否准确,以及我的设计是否契合。首先,我需要逐句拆解用户的需求,确保理解无误,再对照之前的设计文档,说明哪些已经考虑到,哪些需要调整,最后提出对齐后的设计思路,为后续修改文档做铺垫。

首先看第一个疑问:用户明确区分了 "可外接..."(APIs 外挂,外部系统调用工具功能)和 "支持外部... 接入"(SPIs 内嵌,工具集成外部组件 / 算法),同时要求自用闭环用 ANIs 作为防腐层,分离功能性需求(核心规划功能)和非功能性需求(协议集成)。之前的设计中,外接 API(APIs)已经实现,但 SPIs 内嵌增强没有明确区分,ANIs 防腐层也没有单独设计,需要先确认这一点,肯定用户的核心区分,再说明之前设计的不足和调整方向。

然后是第二个疑问:项目模型要求 1 通用(9 维基础空间,由.md 文档 + 元语言注释表达元数据)+3 专用(对应 1/2/3 维时间,即三套程序 Designer/Master/Transformer,交接面处理维度联动),核心功能聚焦这三个模型相关的规划功能。之前的设计中,项目结构生成模块支持三套程序的结构,但通用模型(9 维基础空间)的元数据表达和元语言注释没有明确,专用模型与 1/2/3 维时间的关联、交接面的维度处理也不够细化,需要回应这一点,肯定用户的模型设计逻辑,说明如何在工具中落地。

接下来,思考回应的结构:先总述用户表述的核心正确性,再分两部分详细回应每个疑问(理解是否正确 + 设计是否契合),然后提出对齐后的核心调整方向,最后确认是否需要进一步细化,确保讨论到位。

需要注意的关键点:

- 接口分层:明确 ANIs(自用闭环防腐层)、APIs(外挂扩展)、SPIs(内嵌增强)的定义和边界,之前的设计缺少 SPIs 和 ANIs 的明确划分,需要补充。

- 项目模型:1 通用(9 维元模型,.md + 元注释)+3 专用(对应 1/2/3 维时间,交接面关联维度),之前的结构生成模块需要强化这一逻辑,补充元语言注释功能和维度关联的交接面设计。

- 核心功能聚焦:用户说 "主要功能就只有这三个"(通用模型管理、三个专用模型管理、交接面维度处理),需要确认核心功能的收敛,避免之前设计中可能的功能冗余。

还要注意用户强调 "先讨论到位,再修改设计和程序",所以回应要以 "对齐认知" 为核心,不急于修改文档,而是先明确共识点和待调整点,确保用户觉得被理解,并且讨论深入。

一、先明确核心共识:你的表述核心完全正确,且精准命中工具设计的核心逻辑!

无论是 接口三层架构(ANIs/APIs/SPIs) 还是 项目模型(1 通用 + 3 专用,关联 9 维基础空间 + 1/2/3 维时间) ,你的表述都切中了工具的核心定位 ------"以项目模型为核心,以分层接口为支撑,分离功能性与非功能性需求"。

下面我逐点拆解你的表述,对照之前的设计说明 "已覆盖" 和 "需补充调整" 的部分,确保讨论到位:

二、关于接口设计:你的表述完全准确,之前设计有 "隐含支持" 但需明确分层

1. 你的核心表述(正确)

- 非功能性需求:集成类似 LDAP/TSN/DNS 协议,拆解为两类接口:

- APIs(外挂扩展):"可外接..."------ 外部系统(开发平台、部署环境)主动调用工具功能(如结构打包、文档寻址);

- SPIs(内嵌增强):"支持外部... 接入"------ 工具主动集成外部组件(如外部 NLP 算法、外部模型),增强自身能力;

- 功能性需求:自用闭环(核心规划功能),需通过 ANIs(中间防腐层接口) 隔离,避免核心逻辑受外接 / 内嵌功能影响。

2. 之前设计的 "契合点" 与 "待调整点"

(1)已契合的部分

- 「APIs(外挂扩展)」:之前设计的

/api/v1系列接口(结构打包、术语查询、文档部署)完全匹配,支持外部系统通过 API Key 调用,属于典型的 "外挂扩展"; - 「功能性需求分离」:核心功能(文档编辑、结构生成、术语管理)与非功能性需求(协议集成、外接联动)已物理分离(不同模块目录:

app/services/下核心模块与扩展模块分开)。

(2)需补充调整的部分(之前未明确分层,需强化)

- 「SPIs(内嵌增强)」:之前设计中虽有 "调用外部算法" 的逻辑(如类 TSN 模块调用外部术语校验 API),但未明确 SPI 接口规范(如何标准化接入外部组件,避免定制化开发);

- 「ANIs(防腐层接口)」:之前的核心功能模块之间(如文档模块→术语模块)直接调用,未通过统一的 ANIs 接口隔离,存在 "核心逻辑耦合" 风险,需补充防腐层设计。

3. 对齐后的接口分层设计(明确落地)

| 接口类型 | 定位(核心目标) | 适用场景 | 设计规范 | 示例 |

|---|---|---|---|---|

| ANIs(自用防腐层) | 隔离工具内部核心模块,确保自用闭环独立、稳定,不受外接 / 内嵌影响 | 工具内部模块交互(如文档模块调用术语校验、结构模块关联元数据) | 1. 仅内部可见,不暴露给外部;2. 输入输出标准化(统一字典格式);3. 内置异常处理(避免模块间崩溃传递) | ani_term.validate_doc_terms(doc_content)(文档模块调用术语模块的 ANIs 接口) |

| APIs(外挂扩展) | 外部系统调用工具功能,工具被动提供服务 | 外部开发平台调用结构打包、外部部署环境调用文档寻址 | 1. 暴露 HTTP 接口(RESTful);2. 需 API Key 认证;3. 输出格式标准化(JSON/JSON-LD) | 外部 GitLab CI 调用 /api/v1/ldap/structure/package 打包结构 |

| SPIs(内嵌增强) | 工具主动集成外部组件,增强自身能力(如算法、模型) | 工具集成外部 NLP 算法做术语抽取、集成外部模型导入结构 | 1. 定义标准化接入接口(Python 抽象基类);2. 外部组件需适配接口即可接入;3. 支持多组件切换(如可选 "内置算法" 或 "外部算法") | 工具通过 SPI 接口接入外部 spaCy 算法,替代内置术语校验逻辑 |

三、关于项目模型:你的表述逻辑正确,需在工具中强化 "维度关联" 与 "元数据表达"

1. 你的核心表述(正确)

- 核心功能聚焦 "1 通用 + 3 专用" 项目模型 :

- 1 个通用模型:9 维基础空间(项目元模型,描述整体设计的元数据)→ 由.md 文档表达 + 元语言注释标注;

- 3 个专用模型:对应三套程序(Designer/Master/Transformer)→ 分别关联 1/2/3 维时间,维度处理通过三套程序的交接面实现;

- 核心功能仅围绕这三个模型的 "规划管理"(无冗余功能)。

2. 之前设计的 "契合点" 与 "待调整点"

(1)已契合的部分

- 「3 个专用模型的结构支持」:项目结构生成模块已支持 Designer/Master/Transformer 三套程序的专属目录结构,可一键生成;

- 「交接面支持」:已有交接面管理模块,可定义三套程序间的接口、数据格式,为 "维度处理" 提供基础。

(2)需补充调整的部分(之前未明确 "维度关联" 和 "元数据表达")

- 「通用模型(9 维基础空间)」:未明确.md 文档如何表达 9 维元数据(如元语言注释的格式、9 维维度项的具体标注方式);

- 「专用模型与维度关联」:三套程序的结构未与 1/2/3 维时间明确绑定(如 Designer 对应 1 维时间 "顺序执行",Master 对应 2 维时间 "并行调度",Transformer 对应 3 维时间 "实时反馈");

- 「核心功能收敛」:之前的设计包含 "变更记录、交付物管理、测试用例跟踪" 等功能,按你的表述需收敛,仅保留 "通用模型管理、专用模型管理、交接面维度处理" 三个核心功能。

3. 对齐后的项目模型落地设计

(1)1 个通用模型:9 维基础空间的.md 文档表达(元语言注释规范)

通用模型是 "项目元模型",记录整体设计的 9 维元数据(如原语、规则、度量衡等),通过 .md 文档 + 标准化元语言注释 实现,示例如下:

markdown

# 元级自动化引擎通用元模型(9维基础空间)

> 元语言注释格式:`<!-- @meta_key: 元数据值 -->`(工具可解析提取)

<!-- @meta_dimension_1: 原语空间 -->

## 1. 原语定义

- Gover(全局控制原语):描述系统顶层调度逻辑

- Cover(覆盖原语):描述模块间交互边界

- Hover(悬浮原语):描述动态适配逻辑

<!-- @meta_dimension_2: 规则空间 -->

## 2. 规则体系

- 高阶规则:杠杆平衡(简约不丢核)

- 中阶规则:能量守恒(扩展不破坏逻辑)

- 低阶规则:等价交换(深度与约束对等)

<!-- @meta_dimension_3: 时间空间 -->

## 3. 时间维度定义

- 1维时间:线性顺序执行(Designer专用)

- 2维时间:并行调度(Master专用)

- 3维时间:实时反馈闭环(Transformer专用)

<!-- 其余6个维度(如度量衡、算力、接口类型等)按此格式标注 -->工具需新增 元数据解析模块 :自动提取.md 文档中的@meta_*注释,生成 9 维基础空间的结构化元数据(存储在数据库中,供专用模型关联)。

(2)3 个专用模型:与 1/2/3 维时间绑定,交接面处理维度联动

| 专用模型(程序) | 关联维度 | 核心定位(维度特性) | 模型表达形式 | 交接面维度处理逻辑 |

|---|---|---|---|---|

| Designer | 1 维时间(线性顺序) | 逻辑定义层:按 "顺序执行" 梳理设计逻辑(原语→规则→结构) | 专属.md 文档(如designer_logic.md)+ 标准目录结构 |

输出 "1 维时间顺序接口":给 Master 提供线性的设计成果(如按步骤执行的脚本模板) |

| Master | 2 维时间(并行调度) | 控制调度层:按 "并行 + 同步" 调度 Transformer 执行 | 专属.md 文档(如master_schedule.md)+ 调度配置文件 |

输入(Designer 的 1 维接口)→ 转换为 "2 维并行接口":给 Transformer 分配并行任务,同步执行状态 |

| Transformer | 3 维时间(实时反馈) | 物理执行层:按 "执行→反馈→调整" 闭环落地 | 专属.md 文档(如transformer_exec.md)+ 执行脚本模板 |

输入(Master 的 2 维接口)→ 转换为 "3 维反馈接口":执行后实时反馈状态,触发 Master 动态调整 |

工具的核心功能将收敛为 3 个:

- 通用模型管理:创建 / 编辑 9 维元数据.md 文档,解析元数据;

- 专用模型管理:为三套程序生成绑定维度的专属文档和目录结构;

- 交接面维度处理:定义三套程序间的接口,自动转换维度适配逻辑(如 1 维→2 维→3 维)。

(3)冗余功能处理

之前设计的 "变更记录、交付物管理、测试用例跟踪" 等功能,按你的表述属于非核心功能,可:

- 简化为 "通用模型 / 专用模型的附属标注"(如在.md 文档中通过元注释记录变更:

<!-- @change: 2025-11-16 调整原语定义 -->); - 或作为 "可扩展功能"(默认隐藏,通过配置启用),不占用核心功能入口。

四、总结:你的表述完全正确,之前的设计需做 3 大核心调整

1. 接口层调整:新增 SPIs 内嵌增强接口 + ANIs 防腐层

- 定义 SPIs 抽象基类(如

app/spis/term_extractor.py),支持外部算法 / 模型标准化接入; - 封装 ANIs 内部接口(如

app/anis/term_service.py),核心模块间通过 ANIs 交互,隔离风险。

2. 核心功能收敛:聚焦 "1+3 项目模型" 管理

- 新增通用模型元数据解析模块(支持.md 元语言注释提取);

- 专用模型结构与 1/2/3 维时间绑定,交接面强化维度转换逻辑;

- 移除 / 隐藏冗余功能(变更记录、测试用例等),保持核心简洁。

3. 文档元数据标准化:明确 9 维基础空间的标注规范

- 制定元语言注释手册(如

@meta_dimension_*的具体含义、填写规范); - 工具支持元数据可视化(如在.md 编辑器中实时预览 9 维元数据结构)。

五、下一步行动建议

我们可以按以下顺序推进讨论和修改:

- 确认上述 "接口分层" 和 "项目模型" 的对齐方案是否完全符合你的预期;

- 细化关键细节(如元语言注释的具体格式、SPIs 抽象基类的方法定义、交接面的维度转换规则);

- 基于共识修改工具设计文档,补充新增模块(ANIs/SPIs/ 元数据解析)的开发细节;

- 确认核心功能的 UI 交互逻辑(如通用模型编辑页面、维度关联可视化页面)。

现在可以针对上述调整点,进一步细化某一部分(比如先确定元语言注释格式,或 SPIs 接口规范),确保每个细节都讨论到位后,再修改完整设计文档~

Q383

Q383、您的 "三、关于项目模型:你的表述逻辑正确,需在工具中强化 "维度关联" 与 "元数据表达"" 描述的功能性需求只有两项"1 个通用模型"和"3 个专用模型" 遗漏了 三个项目的交接面,您可能 错误的以为它们就是 三层接口 所以就漏掉了。但是,您想想,对吗? 项目交界面 是 内部协作,三层接口 是 外部关系!所以,您需要考虑清楚 并加进去。--我上一次是这样表述的 :主功能-规划的项目结构 --需要一个 1(通用)+3(专用)的项目模型,显然 通用模型也必须是 9维基础空间( 项目元模型,描述整体设计的元数据,想必应该就是 由.md 文档 表达 并 通过 元语言注释 来标注 ) ,3个专用模型(分别描述 三套程序) 想必分别对应1/2/3 维时间,维度处理 也就是 三套程序 的 交接面 。

用户指出我之前的项目模型设计遗漏了 "三套程序的交接面",核心关键点是:交接面是 "内部协作"(三体项目之间的联动),而三层接口(ANIs/APIs/SPIs)是 "外部关系"(工具与外部系统的交互),二者不能混淆,且交接面是核心功能之一,必须作为独立模块补充到 "1+3 项目模型" 的核心功能中。

首先,我需要明确用户的核心诉求:核心功能应该是 "1 通用模型管理 + 3 专用模型管理 + 交接面(内部协作)管理",共三个核心功能,其中交接面的核心是 "维度处理"(1 维→2 维→3 维时间的转换与联动),这和之前的三层接口完全是两个维度的概念,不能合并。

接下来,要修正之前的设计偏差:之前把交接面管理作为辅助功能,现在需要提升为核心功能,且明确其 "内部协作 + 维度处理" 的定位,与外部接口(APIs/SPIs)严格区分。同时,需要细化交接面与维度的绑定关系,比如 Designer(1 维)→Master(2 维)的交接面负责 "线性逻辑→并行调度" 的转换,Master(2 维)→Transformer(3 维)的交接面负责 "并行任务→实时反馈" 的转换,这样才能体现 "维度处理就是交接面" 的核心逻辑。

然后,需要梳理清楚核心功能的三层关系:通用模型是基础(9 维元数据),专用模型是主体(三套程序的结构与逻辑),交接面是纽带(内部协作 + 维度转换),三者共同构成工具的核心功能,外部接口(APIs/SPIs)和内部防腐层(ANIs)是支撑这些核心功能的技术架构,而非核心功能本身。

还要补充交接面的具体落地设计:比如交接面的元数据标注(与 1+3 模型的元数据关联)、维度转换规则的配置(如何通过交接面实现 1→2→3 维的联动)、交接面的校验功能(确保维度转换符合规则)。同时,需要在工具的功能模块中明确 "交接面管理" 的独立地位,与通用模型、专用模型并列,收敛其他冗余功能。

最后,要确保整个设计逻辑闭环:通用模型提供 9 维元数据,专用模型绑定各自维度,交接面实现维度转换与内部协作,三层接口支撑外部扩展,内部防腐层保障核心功能稳定,这样既满足用户对核心功能的定义,又保持技术架构的合理性。

一、核心修正:明确核心功能 = 1+3 + 交接面(内部协作),与外部接口严格区分

你指出的完全正确!我之前的设计确实混淆了 "内部协作(交接面)" 与 "外部关系(三层接口)"------交接面是三体项目之间的内部联动核心,属于核心功能;三层接口是工具与外部系统的交互,属于技术支撑,二者完全独立,且交接面是 "1+3 项目模型" 的核心纽带,必须作为第三大核心功能明确落地。

重新对齐核心功能定位:

| 核心功能 | 定位(内部 / 外部) | 核心目标 | 关联维度 / 逻辑 |

|---|---|---|---|

| 1. 通用模型管理 | 内部核心 | 管理 9 维基础空间元模型(项目元数据) | 9 维基础空间(原语、规则、度量衡等),通过.md 文档 + 元语言注释表达 |

| 2. 专用模型管理 | 内部核心 | 管理三套程序的专属模型 | 3 个专用模型分别绑定 1/2/3 维时间:Designer(1 维线性)、Master(2 维并行)、Transformer(3 维反馈) |

| 3. 交接面管理(新增核心) | 内部核心 | 管理三套程序的内部协作,实现维度转换 | 交接面 = 维度处理:1 维→2 维→3 维时间的转换与联动(如 Designer→Master 的线性逻辑→并行调度) |

| (技术支撑)三层接口 | 外部支撑 | 工具与外部系统交互(外挂扩展 / 内嵌增强) | ANIs(内部防腐)、APIs(外挂)、SPIs(内嵌),不参与核心功能逻辑 |

二、交接面管理(内部协作 + 维度处理)的详细落地设计

1. 交接面的核心定位:维度转换的 "内部纽带"

交接面的本质是 "三套程序间的维度适配协议",核心解决 "1 维→2 维→3 维时间的逻辑转换与数据联动",且必须与 1+3 项目模型的元数据强关联(通过元语言注释标注)。

2. 交接面的分类与维度绑定(完全对齐 1+3 模型)

| 交接面类型 | 来源模型(维度) | 目标模型(维度) | 核心维度转换逻辑 | 数据流转方向 |

|---|---|---|---|---|

| Designer→Master 交接面 | Designer(1 维) | Master(2 维) | 线性逻辑(1 维时间:顺序执行)→ 并行调度(2 维时间:多任务同步):将 Designer 的线性规则拆解为 Master 可并行执行的任务单元 | Designer 的设计成果 → Master 的调度指令 |

| Master→Transformer 交接面 | Master(2 维) | Transformer(3 维) | 并行任务(2 维时间:调度分配)→ 实时反馈(3 维时间:执行 - 反馈 - 调整):将并行任务转换为 Transformer 的物理执行指令,接收实时状态反馈 | Master 的控制指令 ↔ Transformer 的执行状态 |

| Transformer→Designer 交接面 | Transformer(3 维) | Designer(1 维) | 实时反馈(3 维时间:多维度状态)→ 线性优化(1 维时间:规则迭代):将执行状态聚合为线性的优化建议,反哺 Designer 的逻辑规则 | Transformer 的优化建议 → Designer 的规则迭代 |

3. 交接面的元数据表达(与.md 文档元语言注释联动)

交接面作为核心功能,其元数据需通过 专用.md 文档 + 标准化元语言注释 表达,且关联通用模型的 9 维元数据和专用模型的维度属性,示例如下:

markdown

css

# Designer→Master 交接面元模型(维度转换:1维→2维)

> 元语言注释格式:`<!-- @interface_meta_key: 元数据值 -->`

<!-- @interface_id: IF_001 -->

<!-- @source_model: Designer(专用模型,1维时间:线性顺序) -->

<!-- @target_model: Master(专用模型,2维时间:并行调度) -->

<!-- @dimension_conversion: 1维线性逻辑 → 2维并行任务(拆解规则:按"原语类别"拆分) -->

<!-- @related_global_meta: dimension_3(时间空间)、dimension_5(规则空间) -->(关联通用模型9维元数据)

## 1. 交接面数据格式(JSON)

```json

{

"interface_id": "IF_001",

"designer_logic_version": "V1.0", // 关联Designer专用模型版本

"task_units": [ // 1维线性逻辑拆解后的2维并行任务单元

{

"task_id": "TASK_001",

"related_primitive": "Gover规则", // 关联通用模型原语

"execution_order": "parallel", // 2维时间特性:并行执行

"params": {"rule_id": 1, "term_ids": [1,2,3]}

},

{

"task_id": "TASK_002",

"related_primitive": "Cover符号",

"execution_order": "parallel",

"params": {"symbol_lib_id": 2, "extend_rule": "non_terminal"}

}

]

}4. 交接面管理的核心功能(工具模块落地)

(1)交接面元模型编辑(基于.md文档)

-

提供交接面专用.md模板(含元语言注释占位符);

-

支持关联通用模型的9维元数据和专用模型的维度属性(下拉选择,避免手动输入错误);

-

自动校验元数据完整性(如必须填写`@dimension_conversion`维度转换规则)。

(2)维度转换规则配置

-

可视化配置转换逻辑(如1维→2维的拆解规则:按原语类别/规则优先级拆分);

-

内置维度转换校验规则(如1维线性逻辑拆解后的2维任务单元,需满足"并行无依赖");

-

支持导入/导出转换规则(适配工具自用闭环)。

(3)交接面数据格式生成与校验

-

基于.md元模型自动生成标准化数据格式(JSON/XML);

-

校验数据格式与维度转换规则的一致性(如2维并行任务需包含`execution_order: parallel`字段);

-

支持模拟数据流转(如输入Designer的线性逻辑,工具自动拆解为Master的并行任务单元,验证转换效果)。

(4)交接面与项目模型联动

-

专用模型的结构生成时,自动关联对应交接面的接口参数(如Master的任务调度模块,自动包含Designer→Master交接面的参数解析逻辑);

-

通用模型的9维元数据变更时,自动提示关联交接面的元数据更新(如时间空间维度定义变更,提示修改`@dimension_conversion`规则)。

三、修正后的核心功能架构(明确区分核心功能与技术支撑)

plaintext

Scala

graph TD

A[核心功能层(内部协作)] --> A1[通用模型管理:9维元数据(.md+元注释)]

A --> A2[专用模型管理:3套程序(1/2/3维时间绑定)]

A --> A3[交接面管理:内部协作+维度转换(.md+元注释)]

B[技术支撑层(外部/内部隔离)] --> B1[ANIs:内部防腐层(核心模块间交互)]

B --> B2[APIs:外挂扩展(外部系统调用工具)]

B --> B3[SPIs:内嵌增强(工具集成外部组件)]

A1 --> A2[通用模型为专用模型提供元数据基础]

A2 --> A3[专用模型通过交接面联动]

A3 --> A1[交接面反馈反哺通用模型优化]

B1 --> A[支撑核心功能模块间隔离]

B2 --> A[外部系统调用核心功能(如打包专用模型结构)]

B3 --> A[外部组件增强核心功能(如用外部算法校验交接面数据)]四、之前设计的核心修正点(总结)

1. 核心功能收敛(仅保留 3 个核心,移除冗余)

- 保留:通用模型管理、专用模型管理、交接面管理(内部协作 + 维度处理);

- 移除 / 隐藏:变更记录、交付物管理、测试用例跟踪(作为可扩展功能,默认不显示)。

2. 交接面与接口的严格区分(避免混淆)

| 特性 | 交接面(核心功能) | 三层接口(技术支撑) |

|---|---|---|

| 定位 | 内部协作(三体项目之间) | 外部交互(工具与外部系统)/ 内部隔离(核心模块) |