一、研究背景与核心痛点

机器人操作研究长期受困于数据稀缺瓶颈:即便最大的机器人数据集,在规模和多样性上也远逊于自然语言处理(NLP)和计算机视觉(CV)领域的数据集,导致通用机器人政策的泛化能力落后于语言和视觉模型。

人类视频蕴含海量真实世界操作场景,是机器人数据的理想补充,但存在两大关键障碍:一是缺乏精确动作标签 ,二是视觉体现差距 ------人类的外观和运动方式与机器人差异显著,现有方法多依赖模型隐式学习两者对应关系,效果有限。

项目主页:https://masquerade-robot.github.io/

论文链接:https://arxiv.org/pdf/2508.09976

二、核心方法:Masquerade 框架

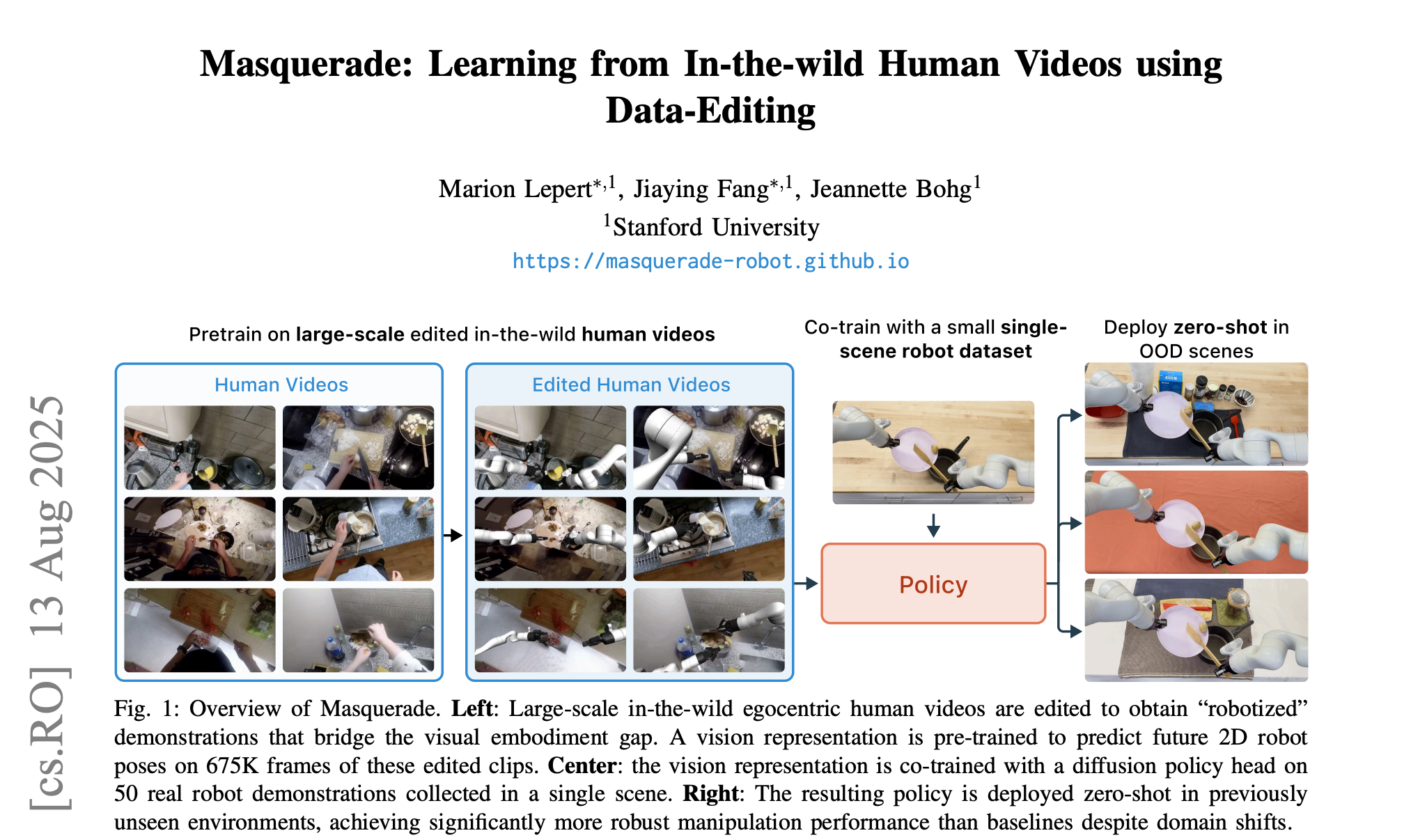

Masquerade 的核心思路是显式缩小人类与机器人的视觉体现差距,并通过"预训练+联合训练"的范式,充分利用野外人类视频数据提升机器人政策的泛化能力,整体流程分为三阶段:

注意:"野外人类视频" 特指未经过人工筛选、非刻意为机器人学习采集的 "无约束日常人类视频"

1. 野外人类视频的"机器人化"编辑

通过三步数据处理,将无约束的野外第一视角人类视频转化为机器人可学习的"拟机器人演示数据":

- 姿态估计与映射:用 HaMeR 估计人类双手3D关键点,映射为双机械臂机器人的末端执行器姿态(位置、朝向、夹爪开度),并进行时间平滑去噪;

- 视觉差距消除:用 Detectron2 和 SAM2 分割人类手臂,通过 E2FGVI 修复移除,再渲染虚拟机器人并叠加到原视频帧中,形成"机器人执行任务"的视觉效果;

- 标签提取与数据过滤:将3D末端执行器姿态投影为2D关键点序列作为辅助训练标签,过滤掉相机运动过大、关键点无效的帧,保证数据质量。

2. 视觉编码器预训练

基于编辑后的"机器人化"视频(675K帧),训练 ViT-Base 视觉编码器:

- 训练目标:预测未来H帧的2D机器人关键点序列,补偿相机运动带来的视角变化;

- 语言增强:通过 FiLM 层将视频的自然语言描述嵌入编码器,让模型结合语义理解视觉特征。

3. 政策联合训练

仅使用单一场景下的50条真实机器人演示数据,联合编辑后的人类视频进行训练:

- 双损失函数优化:同时最小化"2D关键点预测辅助损失"(来自编辑视频)和"模仿学习政策损失"(来自真实机器人数据);

- 视觉一致性保障:在真实机器人数据中也叠加虚拟机器人渲染层,确保模型训练时的视觉输入一致性。

三、核心贡献

-

突破视觉体现差距瓶颈:首次将显式数据编辑(2D机器人叠加+人类手臂修复)应用于大规模野外人类视频,即便编辑效果不完美,也大幅提升了跨体现迁移学习的效率,证明"粗糙视觉对齐"即可释放人类视频的学习信号。

-

高效的训练范式设计:提出"预训练+联合训练"框架,预训练阶段学习野外场景的通用视觉特征,联合训练阶段保留辅助损失避免特征遗忘,仅需少量真实机器人数据即可实现分布外场景的零样本迁移。

-

实证验证与性能突破:在三个长时程双机械臂厨房任务(叠锅、刮土豆、扫辣椒)、三个分布外场景中,平均成功率从基线的12%提升至74%,超越 HRP、DINOv2 等强基线5-6倍,且性能随编辑视频数据量呈对数级增长。

-

关键组件的必要性验证:通过消融实验证明,机器人叠加(无叠加时性能大幅下降)和联合训练(仅微调会遗忘预训练特征)是实现强泛化能力的核心,为后续相关研究提供了明确的设计准则。

四、实验关键结果

- 分布外泛化:在所有任务和陌生场景中均显著优于基线,且从训练场景到分布外场景的性能下降幅度最小;

- 数据缩放效应:编辑后的人类视频数据量越多,机器人政策性能越高,100%数据量时叠锅任务成功率达68%,远高于0%数据量的2%;

- 核心组件不可替代:移除机器人叠加或联合训练时,平均成功率下降超50%,验证了方法设计的合理性。

五、局限性与未来方向

局限性

- 依赖手部姿态估计效果,快速运动或严重遮挡的帧需丢弃;

- 缺乏深度数据,导致机器人渲染时可能出现遮挡处理错误;

- 需过滤相机运动过大的帧,限制了数据利用率;

- 人类灵巧抓取与机器人平行夹爪的映射不够精准。

未来工作

- 优化姿态估计和深度推理能力,提升编辑数据的真实性;

- 适配移动机器人或可动相机,减少数据过滤带来的损失;

- 引入灵巧末端执行器和更精细的运动映射 pipeline,进一步缩小体现差距;

- 将数据编辑框架扩展到奖励学习、运动先验提取等其他机器人学习任务。

六、总结

Masquerade 的核心价值在于通过显式视觉体现差距消除,解锁了野外人类视频这一海量数据资源,为机器人政策学习提供了"低成本、高泛化"的新路径。其"数据编辑+联合训练"的范式,不仅解决了当前机器人学习的数据稀缺问题,也为后续跨体现迁移学习提供了可复用的技术框架,有望推动机器人从"特定场景专用"向"真实世界通用"迈进。

看法

这篇工作中所谓的人类数据,都是把相机固定到人的头上,但是我们好像今年以前的所有网上的人类操作数据,好像都不是从头部相机视角进行录制的,这样的话,我又如何用之前的网络上的人类数据进行转换和训练?

这篇论文(Masquerade)以及许多类似的研究,确实依赖于第一人称视角(egocentric,即头戴式相机)的人类视频数据,而这在互联网上存量巨大的历史视频数据中只占一小部分。

那么,如何将Masquerade的思路应用到更普遍的、非第一人称视角的网络视频上呢?这确实是一个巨大的挑战,也是机器人学习领域一个非常前沿的研究方向。我们可以从挑战和可能的解决方案两个方面来分析:

核心挑战:视角不匹配 (Viewpoint Mismatch)

机器人策略学习的是一个"观察-动作"的映射。如果训练数据(人类视频)的"观察"视角与机器人实际执行任务时的"观察"视角完全不同,那么学到的策略几乎是无法直接迁移的。具体挑战包括:

- 坐标系不一致:第一人称视角下,人手相对于镜头的运动,可以直接(或通过简单的变换)映射到机器人手臂相对于其"眼睛"(摄像头)的运动。但在第三人称视角下(比如一个固定的监控摄像头或者别人手持拍摄的视频),人手的运动是在一个"世界坐标系"中,你无法直接知道这个运动相对于机器人自身坐标系应该是什么样的。

- 视觉特征差异巨大:机器人看到的是桌子、物体和自己的夹爪。而一个第三人称视频可能看到的是人的背影、侧脸、以及完全不同的场景布局。模型从这种视频里学到的视觉特征,在机器人自己的视角下很可能完全不适用。

- 遮挡问题更严重:在第三人称视角下,人的身体、其他物体,甚至拍摄角度本身,都可能严重遮挡住手部和被操作的物体,使得姿态估计和轨迹提取变得极为困难。