文章目录

- 摘要

- [CCS Concepts](#CCS Concepts)

- 关键词

- [1 引言](#1 引言)

- [2 相关工作](#2 相关工作)

-

- [2.1 传统视频异常检测](#2.1 传统视频异常检测)

- [2.2 基于 LLMs 和 MLLMs 的视频异常检测](#2.2 基于 LLMs 和 MLLMs 的视频异常检测)

- [2.3 LLM 中间层分析](#2.3 LLM 中间层分析)

- [3 面向视频异常检测的信息富集现象](#3 面向视频异常检测的信息富集现象)

-

- [3.1 探索 MLLMs 的中间层表征](#3.1 探索 MLLMs 的中间层表征)

-

- [3.1.1 面向 VAD 的统计量化分析](#3.1.1 面向 VAD 的统计量化分析)

-

- [• 基于 KL 散度的异常敏感性(Anomaly Sensitivity via KL Divergence)](#• 基于 KL 散度的异常敏感性(Anomaly Sensitivity via KL Divergence))

- [• 基于局部判别率(Local Discriminant Ratio, LDR)的类别可分性](#• 基于局部判别率(Local Discriminant Ratio, LDR)的类别可分性)

- [• 基于特征熵的 信息集中度(Information Concentration via Feature Entropy)[2]](#• 基于特征熵的 信息集中度(Information Concentration via Feature Entropy)[2])

- [3.1.2 隐状态可分性验证(Hidden States Separability Validation)](#3.1.2 隐状态可分性验证(Hidden States Separability Validation))

- [3.2 发现:MLLM 中的中间层信息富集现象(Finding: Intermediate Layer Information-rich Phenomenon in MLLMs)](#3.2 发现:MLLM 中的中间层信息富集现象(Finding: Intermediate Layer Information-rich Phenomenon in MLLMs))

- [4 HiProbe-VAD:通过隐状态探测实现免微调视频异常检测](#4 HiProbe-VAD:通过隐状态探测实现免微调视频异常检测)

-

- [4.1 基于 MLLMs 隐状态的准备工作](#4.1 基于 MLLMs 隐状态的准备工作)

-

- [4.1.1 动态层显著性探测(Dynamic Layer Saliency Probing)](#4.1.1 动态层显著性探测(Dynamic Layer Saliency Probing))

- [4.1.2 轻量级异常评分器训练(Lightweight Anomaly Scorer Training)](#4.1.2 轻量级异常评分器训练(Lightweight Anomaly Scorer Training))

- [4.2 HiProbe-VAD 中的推理:帧级处理与可解释性分析](#4.2 HiProbe-VAD 中的推理:帧级处理与可解释性分析)

-

- [4.2.1 帧级异常评分(Frame-Level Anomaly Scoring)](#4.2.1 帧级异常评分(Frame-Level Anomaly Scoring))

- [4.2.2 时间异常定位(Temporal Anomaly Localization)](#4.2.2 时间异常定位(Temporal Anomaly Localization))

- [4.2.3 基于 MLLMs 的可解释异常检测(Explainable VAD via MLLMs)](#4.2.3 基于 MLLMs 的可解释异常检测(Explainable VAD via MLLMs))

- [5 实验](#5 实验)

-

- [5.1 实验设置(Experimental Setup)](#5.1 实验设置(Experimental Setup))

-

- [5.1.1 数据集(Datasets)](#5.1.1 数据集(Datasets))

- [5.1.2 评估指标(Evaluation Metrics)](#5.1.2 评估指标(Evaluation Metrics))

- [5.1.3 实现细节(Implementation Details)](#5.1.3 实现细节(Implementation Details))

- [5.2 性能与对比(Performance and Comparisons)](#5.2 性能与对比(Performance and Comparisons))

-

- [5.2.1 与最新方法的对比(Comparison with State-of-the-arts)](#5.2.1 与最新方法的对比(Comparison with State-of-the-arts))

- [5.2.2 跨模型泛化能力(Cross-Model Generalization)](#5.2.2 跨模型泛化能力(Cross-Model Generalization))

- [5.2.3 零样本泛化能力(Zero-shot Generalization Capability)](#5.2.3 零样本泛化能力(Zero-shot Generalization Capability))

- [5.2.4 定性结果(Qualitative Results)](#5.2.4 定性结果(Qualitative Results))

- [5.3 消融实验](#5.3 消融实验)

-

- [5.3.1 动态层显著性探测(DLSP)的有效性](#5.3.1 动态层显著性探测(DLSP)的有效性)

- [5.3.2 轻量级异常评分器的影响](#5.3.2 轻量级异常评分器的影响)

- [5.3.3 时间定位模块的贡献](#5.3.3 时间定位模块的贡献)

- [5.3.4 关键帧采样率的影响](#5.3.4 关键帧采样率的影响)

- [6 结论](#6 结论)

HiProbe-VAD: Video Anomaly Detection via Hidden States Probing in Tuning-Free Multimodal LLMs

ACM MM'25

新疆大学;西安交通大学;

这篇论文的创新是首次发现并量化了 MLLM 中间层对视频异常具有天然的高敏感性和可分性,并提出利用该特性进行 training-free 的 VAD 框架。

摘要

视频异常检测(Video Anomaly Detection, VAD)旨在识别并定位视频序列中偏离正常模式的行为或事件。传统方法通常面临巨大的计算开销,并依赖大量带标注的数据集,从而限制了其实用性。为解决这些问题,我们提出了 HiProbe-VAD,一种利用预训练多模态大语言模型(Multimodal Large Language Models, MLLMs)实现无需微调的视频异常检测的新框架。

在本文中,我们发现 MLLMs 的中间隐状态(intermediate hidden states)包含信息丰富的表征,相较于输出层,对异常表现出更高的敏感性和线性可分性。为充分利用这一点,我们提出了一种动态层显著性探测(Dynamic Layer Saliency Probing, DLSP) 机制,它能够在 MLLMs 推理过程中智能识别并提取来自最优中间层的最具信息量的隐状态。随后,一个轻量级异常评分器与时间定位模块利用这些提取的隐状态有效地检测异常,并最终生成解释。

在 UCF-Crime 和 XD-Violence 数据集上的实验表明,HiProbe-VAD 超越了现有的免训练方法以及大多数传统方法。此外,我们的框架在不同的 MLLMs 中展现出显著的跨模型泛化能力,无需任何微调即可应用。这释放了预训练 MLLMs 在视频异常检测中的潜力,并为更实用、更可扩展的解决方案铺平了道路。

CCS Concepts

- Computing methodologies → Visual content-based indexing and retrieval.

关键词

多模态大语言模型,视频异常检测

1 引言

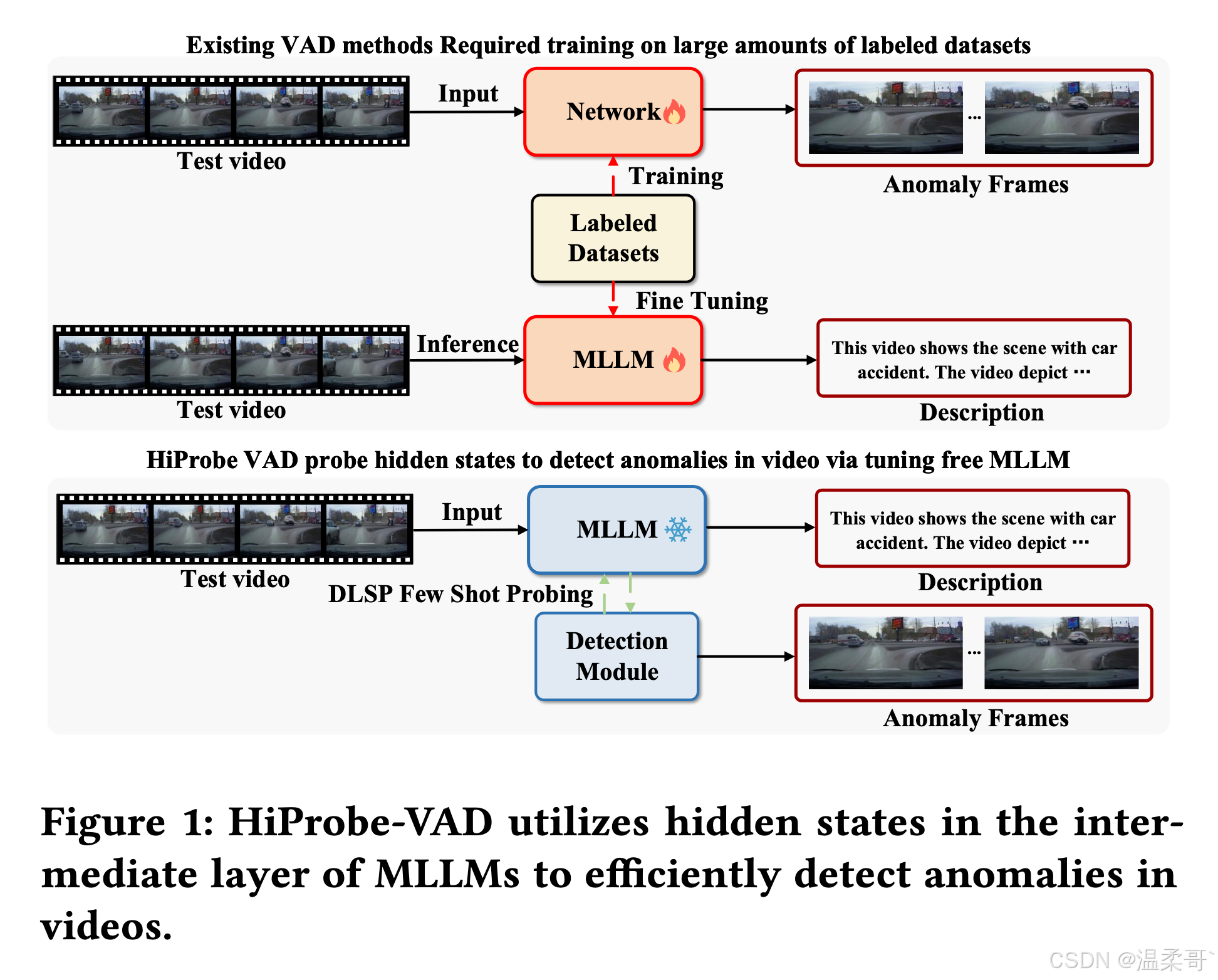

视频异常检测(Video Anomaly Detection, VAD)旨在定位视频中偏离正常模式的事件或行为,这对于诸多应用场景至关重要,例如视频监控 [41]、工业质量检测 [38] 以及自动驾驶 [4, 61]。虽然实现高精度非常关键,但异常本身的复杂性以及其对数据集的依赖性,为 VAD 系统带来了显著挑战。现有基于深度学习的 VAD 方法涵盖监督、弱监督与无监督三类学习范式。监督方法 [19, 26] 能达到较高精度,但需要大量且昂贵的帧级标注。弱监督方法 [11, 16, 31] 通过利用有限或视频级标签来缓解标注负担,但往往以检测粒度或性能为代价。无监督方法 [27, 29, 46] 则通过学习未标注数据中的正常模式来检测异常。然而,这些方法可能难以处理异常情况,同时仍需要大量标注数据用于预训练,从而可能限制其部署(见 Fig. 1)。这些限制表明当前仍亟需一种数据依赖更少且效率更高的 VAD 解决方案。

近年来,多模态大语言模型(Multimodal Large Language Models, MLLMs)[25, 55, 57, 73] 的出现,为多种视觉任务提供了新的可能性。MLLMs 具备同时处理与推理视觉--文本信息的强大能力,为 VAD 带来了新的发展方向 [8, 71]。已有研究尝试通过微调或提示工程来适配这些模型以执行特定异常检测任务 [36, 68, 69]。然而,这类方法通常存在两个主要问题:(1)需要在 VAD 数据集上进行特定任务的微调 ,这不仅计算开销巨大,而且往往要求大量标注数据。(2)过度依赖由视觉输入生成的文本表征,可能导致推理过程中关键视觉细节的丢失,进而造成不完整或偏差的视频理解。

自然语言处理领域的最新研究表明,大语言模型的中间层(intermediate layers)通常相比输出层包含更丰富、更可迁移的表征 [6, 10, 35]。这些中间层在多种任务中展现出更优性能 [39, 40],这表明它们能够捕获对输入数据更细致的理解 [1, 34]。受到这些 LLM 研究结果的启发,我们推测 MLLMs 的中间隐状态同样能够封装丰富的表征信息,甚至可能比最终输出层更有效地识别视频异常。进一步地,我们假设,这些预训练 MLLMs 的中间层所蕴含的丰富信息,可能天然包含或能够更好激活模型区分正常与异常视觉模式的能力,即便没有针对 VAD 的显式微调。这种通过中间层表征来利用模型内在异常检测能力的潜力,为探索一种基于 MLLM 的全新免微调 VAD 框架奠定了关键基础。

在本文中,我们对多模态大语言模型(MLLMs)中的中间信息进行了系统分析,并揭示了一个关键发现:MLLMs 的中间隐状态相比输出层表现出更高的异常敏感性和线性可分性。因此,我们将这一现象定义为中间层信息富集现象(Intermediate Layer Information-rich Phenomenon) 。基于这一发现,我们提出了用于视频异常检测的隐状态探测框架(Hidden-state Probing for Video Anomaly Detection, HiProbe-VAD),这是一种利用预训练 MLLMs 实现免微调 VAD 的新框架。

HiProbe-VAD 采用动态层显著性探测(Dynamic Layer Saliency Probing, DLSP)模块,从 MLLM 的中间层提取隐状态,并在单次前向推理过程中动态选择最有效的层。随后,一个基于逻辑回归的轻量级异常评分器和时间定位模块被集成,以实现高效检测和精确定位。最终,为了提供对检测到的异常的可解释性洞察,将异常帧和正常帧输入自回归过程以生成检测事件的详细文本描述。

我们通过在 UCF-Crime [41] 和 XD-Violence [52] 数据集上的大量实验评估了所提出框架的有效性。这些数据集覆盖多种真实世界场景,为评估 VAD 性能提供了稳健的测试平台。通过全面的实验,我们证明了 HiProbe-VAD 框架在视频异常检测中的有效性。

我们的主要贡献如下:

-

我们首次系统性量化了 MLLMs 中的"中间层信息富集现象"在视频异常检测中的作用。 结果表明,中间隐状态在异常敏感性和可分性方面均优于输出层,这对依赖输出层的 MLLM 方法构成挑战。

-

我们提出了 HiProbe-VAD,一个有效利用预训练 MLLMs 中间信息的免微调 VAD 框架。 该框架无需对 MLLM 进行微调,只需极少的粗粒度标签即可训练一个轻量级异常评分器。

-

实验表明,HiProbe-VAD 相比最先进的免训练、无监督与自监督 VAD 方法取得了具有竞争力的结果。 该框架展现了强大的跨模型泛化能力,证明其在多种 MLLM 架构中的稳健性和适应性。

2 相关工作

2.1 传统视频异常检测

视频异常检测(VAD)是一项识别视频中偏离正常模式的帧的任务 [14, 28, 32],在多媒体研究中已经得到广泛研究。现有 VAD 方法可分为监督、弱监督与无监督三类。监督方法 [19, 26] 通过详细的帧级标注实现较高精度,但因标注成本高昂而面临显著限制。弱监督方法 [21, 31, 49, 67] 利用视频级标签来训练并检测异常视频,但往往难以处理细微异常并可能表现出偏差的预测。无监督方法 [47](如 one-class learning [13, 56, 59])仅基于正常数据训练模型,并在测试时对偏离进行标记;尽管这些方法具有灵活性,但由于难以完整建模正常模式的多样性,往往产生较高的误报率。

2.2 基于 LLMs 和 MLLMs 的视频异常检测

大型语言模型(LLMs)[5, 45, 48] 与多模态大型语言模型(MLLMs)[22, 25, 73] 的出现,为视频异常检测带来了新的发展方向与方法 [53, 66]。大多数方法对预训练的 MLLMs 进行微调以执行异常检测与分析 [30, 63, 68, 69],这通常需要大量标注数据及高计算资源。一些方法如 [65] 尝试使用生成的视频帧文本描述(由 VLM 生成)并通过 LLM 推断异常,以实现免微调;[62] 则尝试通过语言化学习引导预训练 VLM 进行更好的推理。但对文本的依赖可能导致忽略细微视觉线索。尽管这些方法具有潜力,但往往受限于对文本输出或微调的依赖,从而未能充分发挥 MLLMs 的多模态能力。

2.3 LLM 中间层分析

最近对大型语言模型(LLMs)中间层的研究 [15, 17, 18, 33] 表明,这些层通常包含比最终层更丰富且更具信息性的表征 [34, 42, 60]。研究显示,中间层在各种任务中优于最终层,这可能归因于它们能够通过压缩与特征蒸馏等机制在信息保留与噪声抑制之间取得平衡 [6, 39, 40]。此外,中间层在复杂推理任务中也发挥着关键作用,因为此类模型在这些深度往往保留更多上下文信息,从而增强多步推理能力 [34, 35, 70]。

基于来自通用 LLM 的这些见解,我们假设预训练 MLLMs 的中间隐状态同样包含更加丰富且信息量更高的表征。这一假设促使我们探索一种新的免微调 VAD 框架,通过有效探测这些中间层来实现异常检测。

3 面向视频异常检测的信息富集现象

受到大型语言模型中间层丰富性已有证据的启发,我们进一步研究类似现象是否存在于多模态大型语言模型(MLLMs)中,以用于视频异常检测。我们假设,相较于主要针对文本生成进行优化的最终输出层,这些中间层可能提供更直接、更细致的异常表征,从而潜在提升异常检测性能。

3.1 探索 MLLMs 的中间层表征

为验证我们在 MLLMs 中的假设,我们对预训练 MLLMs 不同层提取的隐状态表征进行了系统分析。对于来自基准 VAD 数据集(XD-Violence [52] 和 UCF-Crime [41])的每个输入视频 V V V,我们使用预训练 MLLM(InternVL2.5 [9])执行一次前向传播。在此过程中,我们从每一层 l l l 中提取隐状态 h l h_l hl。随后,我们通过统计方法与几何分析评估这些表征在区分正常视频与异常视频方面的有效性,关注特征质量的不同方面。以下小节介绍了我们的具体方法与评估指标。

3.1.1 面向 VAD 的统计量化分析

为了从统计角度量化跨层捕获的信息,我们关注对隐状态 h l h_l hl 的关键属性量化。我们采用以下指标,用于捕获异常检测中不同方面的特征质量:

• 基于 KL 散度的异常敏感性(Anomaly Sensitivity via KL Divergence)

Kullback--Leibler(KL)散度用于量化正常特征与异常特征之间的统计可区分性。对于第 l l l 层的每个特征维度 d d d,我们假设正常样本隐状态( h l N h_l^N hlN)和异常样本隐状态( h l A h_l^A hlA)均近似服从高斯分布,即:

- 正常: N ( μ l , d N , ( σ l , d N ) 2 ) \mathcal{N}(\mu_{l,d}^N, (\sigma_{l,d}^N)^2) N(μl,dN,(σl,dN)2)

- 异常: N ( μ l , d A , ( σ l , d A ) 2 ) \mathcal{N}(\mu_{l,d}^A, (\sigma_{l,d}^A)^2) N(μl,dA,(σl,dA)2)

则第 d d d 个特征维度上两者分布的 KL 散度为:

D K L ( d ) ( l ) = 1 2 [ log ( ( σ l , d A ) 2 ( σ l , d N ) 2 ) + ( σ l , d N ) 2 + ( μ l , d N − μ l , d A ) 2 ( σ l , d A ) 2 - 1 ] . (1) D_{\mathrm{KL}}^{(d)}(l) = \frac{1}{2} \left[ \log \left( \frac{(\sigma_{l,d}^A)^2}{(\sigma_{l,d}^N)^2} \right) \text{+} \frac{(\sigma_{l,d}^N)^2 + (\mu_{l,d}^N - \mu_{l,d}^A)^2}{(\sigma_{l,d}^A)^2} \text{-} 1 \right]. \tag{1} DKL(d)(l)=21[log((σl,dN)2(σl,dA)2)+(σl,dA)2(σl,dN)2+(μl,dN−μl,dA)2-1].(1)

251118:这里是一个标准的一维高斯之间的 KL 公式,里面有两项,保证了如果两个分布差异越大,KL 就越大。

层 l l l 的整体异常敏感性通过所有特征维度的平均 KL 散度获得:

D K L ( l ) = 1 D ∑ d = 1 D D K L ( d ) ( l ) . (2) D_{\mathrm{KL}}(l) = \frac{1}{D} \sum_{d=1}^{D} D_{\mathrm{KL}}^{(d)}(l). \tag{2} DKL(l)=D1d=1∑DDKL(d)(l).(2)

更高的 D K L ( l ) D_{\mathrm{KL}}(l) DKL(l) 表明在该层中正常特征与异常特征之间存在更大的分布差异。

• 基于局部判别率(Local Discriminant Ratio, LDR)的类别可分性

局部判别率(LDR)用于衡量特征将不同类别进行线性分离的能力。对于第 l l l 层的每一个特征维度 d d d,我们计算 LDR,其定义为正常特征均值 μ l , d N \mu_{l,d}^N μl,dN 与异常特征均值 μ l , d A \mu_{l,d}^A μl,dA 之差的平方与两者方差之和 ( ( σ l , d N ) 2 + ( σ l , d A ) 2 ) ((\sigma_{l,d}^N)^2 + (\sigma_{l,d}^A)^2) ((σl,dN)2+(σl,dA)2) 的比值,并加入一个常数 ϵ \epsilon ϵ 以保证数值稳定性:

L D R ( d ) ( l ) = ( μ l , d N − μ l , d A ) 2 ( σ l , d N ) 2 + ( σ l , d A ) 2 + ϵ . (3) \mathrm{LDR}^{(d)}(l) \text{=} \frac{(\mu_{l,d}^N - \mu_{l,d}^A)^2} {(\sigma_{l,d}^N)^2 + (\sigma_{l,d}^A)^2 + \epsilon}. \tag{3} LDR(d)(l)=(σl,dN)2+(σl,dA)2+ϵ(μl,dN−μl,dA)2.(3)

层 l l l 的整体类别可分性通过所有 D D D 个特征维度的平均 LDR 获得:

L D R ( l ) = 1 D ∑ d = 1 D L D R ( d ) ( l ) . (4) \mathrm{LDR}(l) \text{=} \frac{1}{D} \sum_{d=1}^{D} \mathrm{LDR}^{(d)}(l). \tag{4} LDR(l)=D1d=1∑DLDR(d)(l).(4)

更高的 L D R ( l ) \mathrm{LDR}(l) LDR(l) 表示在该层中正常与异常类别之间具有更强的线性可分性,意味着该层特征更具判别性。

• 基于特征熵的 信息集中度(Information Concentration via Feature Entropy)[2]

为了评估特征表征中的信息集中度,对于第 l l l 层的每个特征维度 d d d,我们通过将特征值离散化为 B B B 个固定分箱(bins)来估计其概率分布,这些分箱具有等间距边界,其范围由所有样本的特征值范围决定。第 d d d 个特征维度的熵定义为:

H ( d ) ( l ) =- ∑ j = 1 B p ( h l [ d ] ∈ bin j ) log 2 p ( h l [ d ] ∈ bin j ) , (5) H^{(d)}(l) \text{=} \text{-} \sum_{j=1}^{B} p\left(h_l[d] \in \text{bin}_j \right) \log_2 p\left(h_l[d] \in \text{bin}_j \right), \tag{5} H(d)(l)=-j=1∑Bp(hl[d]∈binj)log2p(hl[d]∈binj),(5)

其中

- p ( h l [ d ] ∈ bin j ) p(h_l[d] \in \text{bin}_j) p(hl[d]∈binj) 表示特征值落入第 j j j 个分箱的概率,

- log 2 \log_2 log2 为以 2 为底的对数,熵常以比特表示。

层 l l l 的整体熵为所有 D D D 个特征维度熵的平均值:

H ( l ) = 1 D ∑ d = 1 D H ( d ) ( l ) . (6) H(l) \text{=} \frac{1}{D} \sum_{d=1}^{D} H^{(d)}(l). \tag{6} H(l)=D1d=1∑DH(d)(l).(6)

更高的熵值意味着特征值在分箱间分布更均匀,捕获的信息更加多样、丰富。

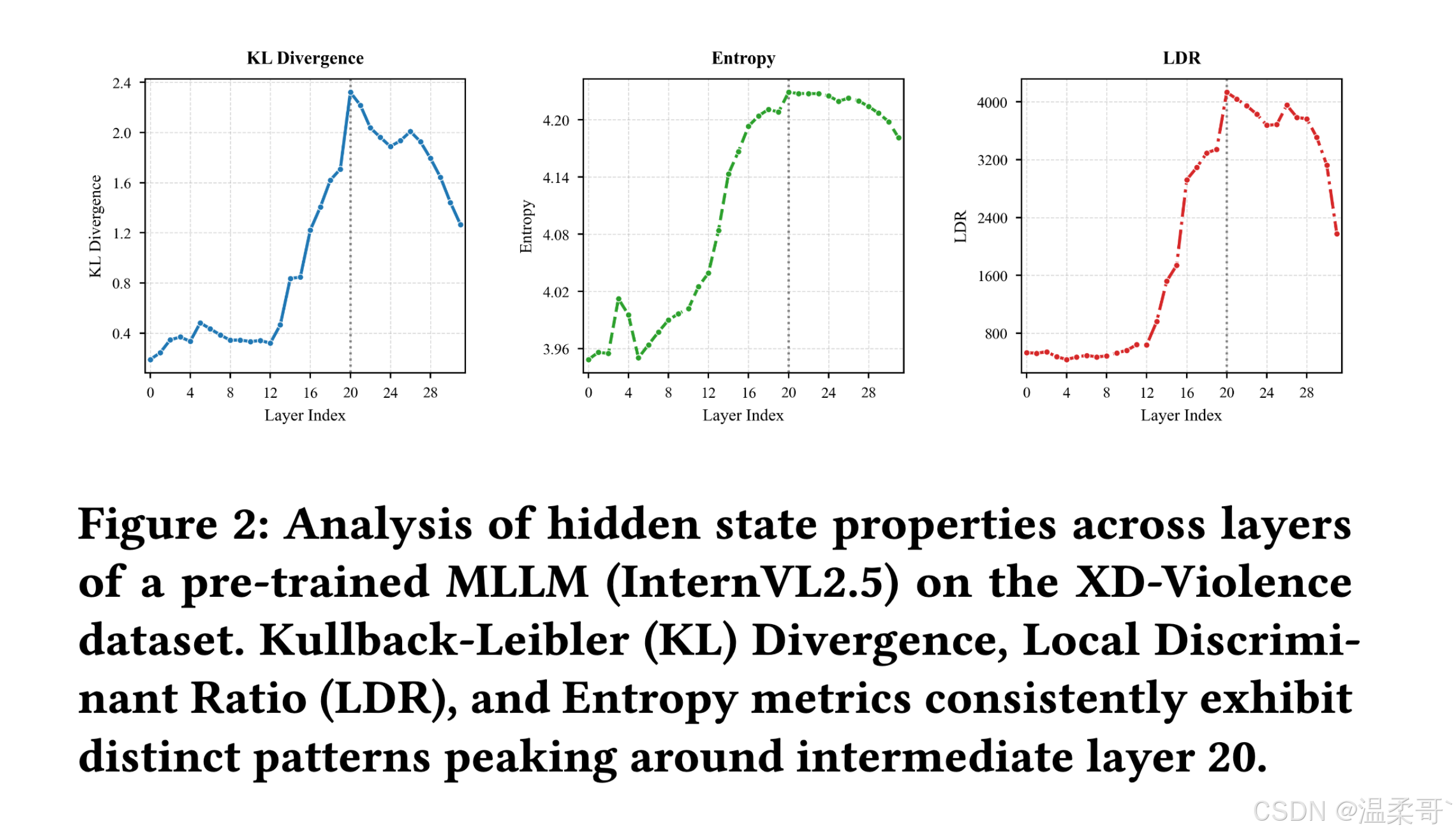

我们的统计分析基于 XD-Violence 数据集,在所有指标上(见 Fig. 2)都观察到了相同趋势:KL 散度、LDR 以及特征熵均在 MLLM 的中间层出现上升,并在约第 20 层达到峰值,之后在更深层出现轻微下降。这表明:

- 在中间层,正常与异常样本之间的统计可区分性最强;

- 所捕获的信息最为丰富,有利于异常检测。

而在更深层的下降趋势则说明 MLLM 开始优先保留对下游文本生成更有利的信息,从而在一定程度上牺牲细粒度的异常特征与整体信息丰富度。

更多统计结果可见补充材料。这些结果强烈表明,异常相关信息在 MLLM 的中间层中具有显著集中现象。

3.1.2 隐状态可分性验证(Hidden States Separability Validation)

虽然统计指标提供了关于各层判别能力的定量证据,但我们进一步从几何视角验证这些发现,即通过分析隐状态 h l h_l hl 的线性可分性。这些实验旨在提供更直观的结果,展示正常样本与异常样本在不同层上的分布情况。

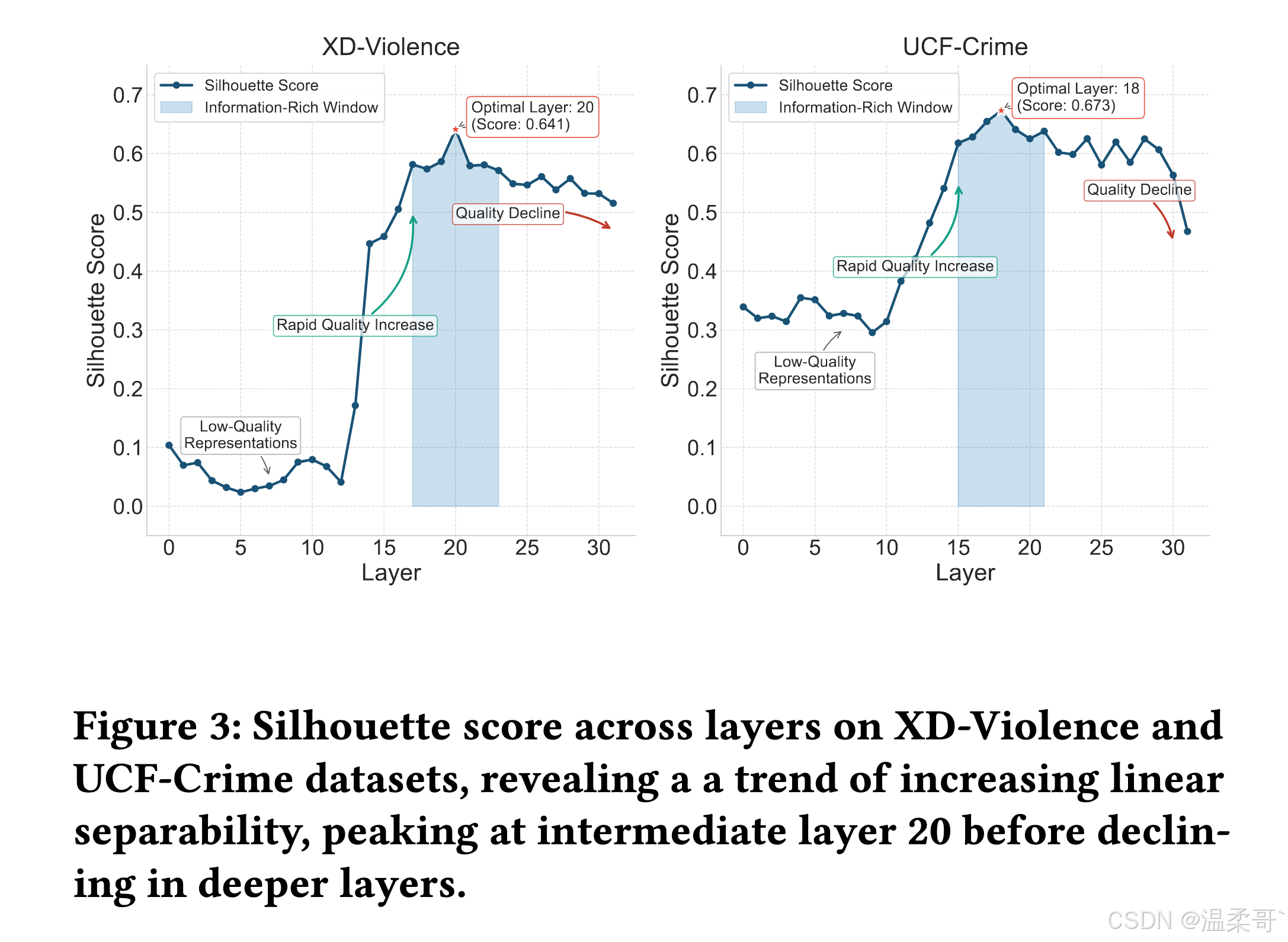

我们使用 轮廓系数(Silhouette score) 来评估线性可分性。该指标衡量每个样本在其自身类别中的聚类效果相对于其他类别的聚类效果------更高的轮廓系数意味着更明确的聚类结构与更强的线性可分性。

Fig. 3 显示,在 XD-Violence 和 UCF-Crime 数据集中,轮廓系数均在约第 20 层达到峰值。

更多验证结果见补充材料。该结果强有力地支持了我们的假设,并与统计分析一致,即 MLLMs 的中间层相比浅层与深层表现出更优的正常---异常可分性。

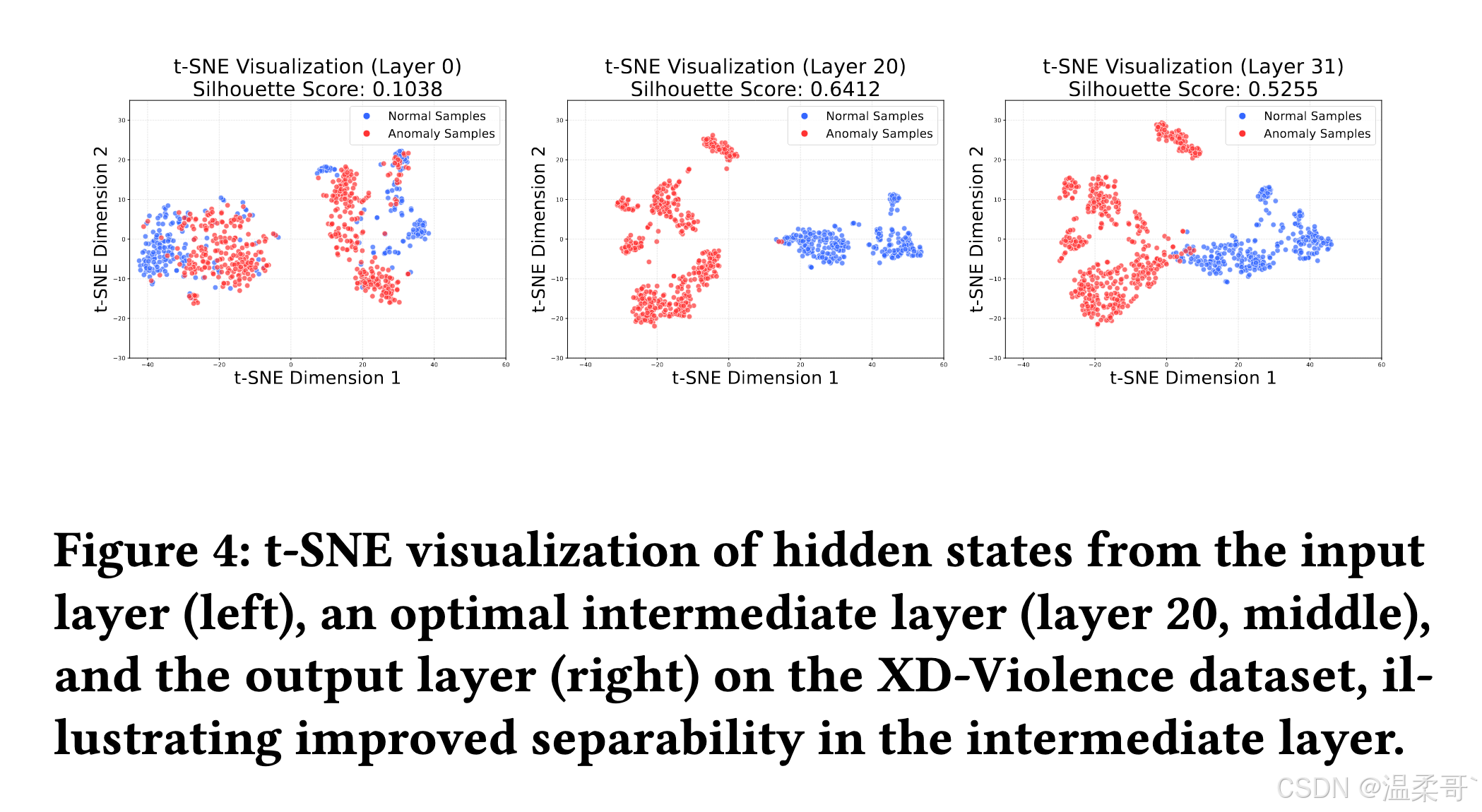

我们使用 t 分布随机邻居嵌入(t-distributed Stochastic Neighbor Embedding, t-SNE) 进行降维与可视化。Fig. 4 展示了在 XD-Violence 数据集上,从输入层(第 0 层)、中间层(第 20 层)和最终输出层(第 31 层)提取的隐状态的 t-SNE 可视化结果。

可视化结果清晰展示了如下趋势:

- 从输入层到中间层,正常与异常样本的聚类明显逐步分离;

- 而输出层的特征空间中,两类样本出现明显混合。

这种混合现象表明,在输出层中,与异常检测相关的细粒度判别信息可能丢失,因为模型开始偏向保存对下游文本生成更有利的信息。

这一可视化证据与轮廓系数的定量结果高度一致,进一步强化了中间层表征所具有的信息富集特性。

3.2 发现:MLLM 中的中间层信息富集现象(Finding: Intermediate Layer Information-rich Phenomenon in MLLMs)

基于我们的实证观察与分析,我们进一步巩固了这一发现:中间层信息富集现象(Intermediate Layer Information-rich Phenomenon)。该发现展示了预训练 MLLM 所蕴含知识的强大性与可迁移性,表明这些模型即使在没有任务特定微调的情况下,也具备完成诸如异常检测等复杂任务的内在能力。

这种现象可归因于预训练 MLLMs 中跨模态表征学习的强大能力。中间层似乎在捕获用于检测细微异常的细粒度视觉线索与利用预训练期间获得的高层语义理解之间达成了最佳平衡。这种平衡使得中间层能够有效地编码对规范行为的全面理解,从而保留用于区分偏差的重要特征,同时避免由于早期融合或深层过度抽象(偏向文本生成)而导致的信息损失。

我们的发现表明,预训练 MLLMs 的中间层表征本身就包含足够的视频异常检测所需的信息。这一观察直接激发了我们提出探测机制(probing mechanism)的动机:

即充分利用这些信息丰富的中间层隐状态,从而在无需高计算成本与大量数据的任务微调的情况下,实现异常检测。

这一核心原则构成了我们所提出的 HiProbe-VAD 框架的理论基础。

4 HiProbe-VAD:通过隐状态探测实现免微调视频异常检测

基于"中间层信息富集现象"的发现,我们提出 HiProbe-VAD ,这是一个利用预训练多模态大语言模型(MLLMs)的、无需微调(tuning-free) 的视频异常检测框架。

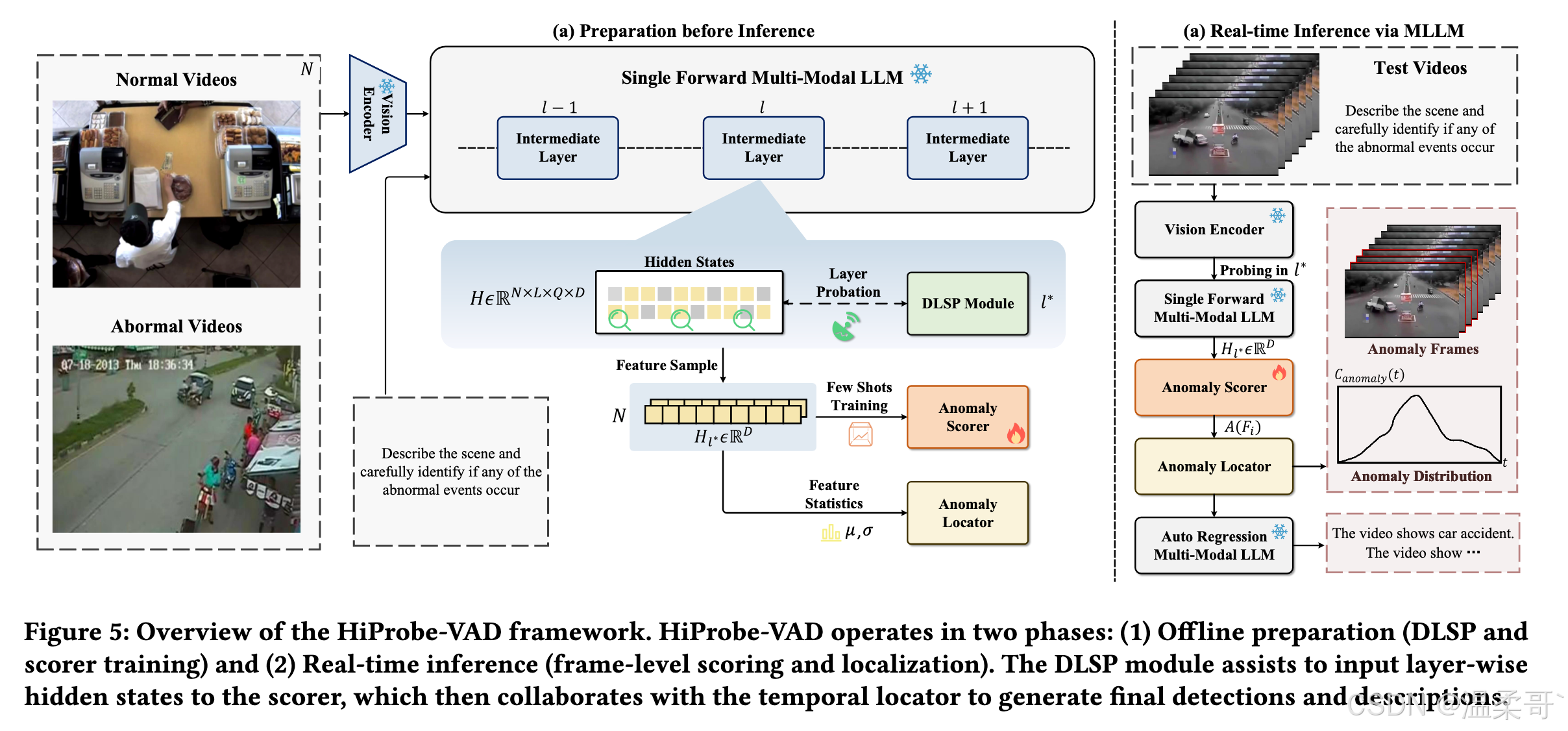

Fig. 5 展示了 HiProbe-VAD 的整体结构。

该框架包含三个核心组件:

- 动态层显著性探测(Dynamic Layer Saliency Probing, DLSP)模块:用于从不同中间层提取隐状态,并确定最适合用于异常检测的中间层;

- 轻量级异常评分器(Lightweight Anomaly Scorer):利用选择出的层的特征进行少样本探测式训练;

- 时间异常定位模块(Temporal Anomaly Localization):用于检测异常帧。

最后,我们会聚合检测出的异常帧,并生成对异常事件的完整文本描述。

4.1 基于 MLLMs 隐状态的准备工作

在进行实时推理之前,我们需要从 MLLM 中确定最佳层,并训练一个轻量级异常评分器。

该阶段基于视频级别进行,使用训练集中少量子集提取的隐状态来捕获全面信息,以用于有效的层选择与评分器训练。

4.1.1 动态层显著性探测(Dynamic Layer Saliency Probing)

DLSP 模块的目标是识别提供最具判别能力特征的中间层 l ∗ l^* l∗,用于区分正常与异常的视频内容。

该过程仅使用极少量训练集(约 1% 的 UCF-Crime 和 XD-Violence 训练集)。

对于子集中的每个视频 v v v,我们在 MLLM 生成第一个 token 时,在每一层 l l l 处提取隐状态 H ( v , l ) \mathbf{H}(v,l) H(v,l),随后计算以下特征在正常与异常样本间的差异(详见 Sec. 3.1.1):

- 异常敏感性(KL divergence)

- 类别可分性(LDR)

- 信息集中度(Entropy)

为了有效结合这些指标,我们对 KL、LDR 和 Entropy 在所有层范围内做 Z-score 标准化 。

对于任意指标 M ∈ { D K L ( l ) , L D R ( l ) , H ( l ) } M \in \{D_{\mathrm{KL}}(l), \mathrm{LDR}(l), H(l)\} M∈{DKL(l),LDR(l),H(l)},其标准化得分为:

N o r m ( M ( l ) ) = M ( l ) − μ M σ M , (5) \mathrm{Norm}(M(l)) \text{=} \frac{M(l)-\mu_M}{\sigma_M}, \tag{5} Norm(M(l))=σMM(l)−μM,(5)

其中

- μ M \mu_M μM 表示指标 M M M 在所有层 { 1 , ... , L } \{1,\dots,L\} {1,...,L} 上的均值

- σ M \sigma_M σM 为标准差

接着,层 l l l 的显著性得分 S ( l ) S(l) S(l) 定义为三个标准化指标的和:

S ( l ) = N o r m ( D K L ( l ) ) + N o r m ( L D R ( l ) ) + N o r m ( H ( l ) ) . (6) S(l) = \mathrm{Norm}(D_{\mathrm{KL}}(l)) \text{+} \mathrm{Norm}(\mathrm{LDR}(l)) \text{+} \mathrm{Norm}(H(l)). \tag{6} S(l)=Norm(DKL(l))+Norm(LDR(l))+Norm(H(l)).(6)

我们选择使该得分最大的层作为最佳层 l ∗ l^* l∗:

l ∗ = arg max l ∈ { 1 , ... , L } S ( l ) . (7) l^* \text{=} \arg\max_{l \in \{1,\dots,L\}} S(l). \tag{7} l∗=argl∈{1,...,L}maxS(l).(7)

这种基于视频级别的分析可确保所选层在不同视频场景下都具有鲁棒性与有效性。

最终确定的最佳层索引 l ∗ l^* l∗ 将用于训练异常评分器,并用于 MLLM 的实时推理。

4.1.2 轻量级异常评分器训练(Lightweight Anomaly Scorer Training)

异常评分器采用一个轻量级的逻辑回归分类器(logistic regression classifier),在离线阶段基于由 DLSP 识别出的最佳层 l ∗ l^* l∗ 的隐状态进行训练。

设第 i i i 个样本的重采样隐状态为 h l ∗ ( i ) \mathbf{h}_{l^*}^{(i)} hl∗(i)。

模型预测的异常概率为:

p i = σ ( w ⊤ h l ∗ ( i ) + b ) , p_i = \sigma(\mathbf{w}^\top \mathbf{h}_{l^*}^{(i)} + b), pi=σ(w⊤hl∗(i)+b),

其中

- σ ( ⋅ ) \sigma(\cdot) σ(⋅) 为 sigmoid 函数,

- w \mathbf{w} w 和 b b b 分别是学习得到的权重向量和偏置项。

分类器通过最小化二元交叉熵损失(binary cross-entropy loss)来区分正常样本( y i = 0 y_i = 0 yi=0)和异常样本( y i = 1 y_i = 1 yi=1):

L ( w , b ) =- 1 N ∑ i = 1 N [ y i log ( p i ) = ( 1 − y i ) log ( 1 − p i ) ] . (8) \mathcal{L}(\mathbf{w}, b) \text{=} \text{-}\frac{1}{N} \sum_{i=1}^{N} \big[ y_i \log(p_i) \text{=} (1 - y_i)\log(1 - p_i) \big]. \tag{8} L(w,b)=-N1i=1∑N[yilog(pi)=(1−yi)log(1−pi)].(8)

训练过程中使用 LBFGS 优化器 进行 1000 个 epochs 的优化。

这个简单却有效的模型确保异常评分器能够充分利用来自所选 MLLM 层的异常敏感特征,在实时推理中兼具准确性与高效性。

251118:这里是全监督?还是用的视频级标签来训练的?

4.2 HiProbe-VAD 中的推理:帧级处理与可解释性分析

在 MLLMs 中,实时推理阶段聚焦于处理未见过的视频,以检测并定位异常帧,并最终为视频生成完整的异常描述。

4.2.1 帧级异常评分(Frame-Level Anomaly Scoring)

对于输入视频,我们将其分割成一系列帧,并从每个片段中均匀采样关键帧 F i F_i Fi。

对于每个采样的关键帧 F i F_i Fi,我们使用 MLLM 的一次前向传播,从最佳层 l ∗ l^* l∗ 中提取隐状态 h l ∗ ( F i ) \mathbf{h}_{l^*}(F_i) hl∗(Fi)。

将提取的特征输入轻量级异常评分器,以得到每个片段的异常概率 A ( F i ) A(F_i) A(Fi):

A ( F i ) = σ ( w T ⋅ h l ∗ ( F i ) + b ) , (9) A(F_i) = \sigma (\mathbf{w}^T \cdot \mathbf{h}_{l^*}(F_i) + b), \tag{9} A(Fi)=σ(wT⋅hl∗(Fi)+b),(9)

其中

- σ \sigma σ 代表 sigmoid 函数,

- w \mathbf{w} w 和 b b b 是逻辑回归分类器的已学习参数。

该帧级评分会生成输入视频中各帧的异常概率时间序列,每个帧都关联一个其为异常帧的概率分数。

4.2.2 时间异常定位(Temporal Anomaly Localization)

为了生成完整的异常描述,我们对帧级异常得分随时间进行聚合。

首先,我们对异常概率序列应用高斯核平滑(Gaussian kernel smoothing),以减少噪声并得到更平滑的异常概率曲线 C ( t ) C(t) C(t)。

然后我们根据平滑后的曲线,使用阈值 T T T 来识别潜在的异常片段。

该阈值自适应地定义为:

T = μ A + κ ⋅ σ A , (10) T = \mu_A + \kappa \cdot \sigma_A, \tag{10} T=μA+κ⋅σA,(10)

其中

- μ A \mu_A μA 和 σ A \sigma_A σA 分别为基于少样本训练集从 DLSP 模块获得的异常得分的均值与标准差,

- κ \kappa κ 为调节参数。

当连续帧的平滑异常得分超过阈值时,将其分组为异常片段;反之,则分为正常片段。

251118:这个模块就是一个高斯平滑,还起了一个好听的名字。。。而且这个是个 trick 吧,可以把 k 随便调节,这样性能不是自己定的吗?

4.2.3 基于 MLLMs 的可解释异常检测(Explainable VAD via MLLMs)

为提供对检测到的异常的可解释洞察,我们将异常片段与正常片段分别输入预训练 MLLMs 的自回归过程(auto-regression)。

该过程会将视频片段转化为精确的文本解释,从而:

- 提升 HiProbe-VAD 框架的可解释性,

- 为用户提供对视频中异常行为的深层理解。

5 实验

5.1 实验设置(Experimental Setup)

5.1.1 数据集(Datasets)

我们在两个常用的视频异常检测数据集上评估了我们的框架:UCF-Crime [41] 和 XD-Violence [52]。

-

UCF-Crime 数据集包含 1900 个未剪辑的真实监控视频(约 128 小时),并提供帧级注释 ,涵盖 13 类异常事件。

数据集划分为 1610 个训练视频 和 290 个测试视频。

-

XD-Violence 数据集包含 4754 个未剪辑视频(约 217 小时),来自电影与 YouTube 视频,并在视频级别(弱标签)上标注了 6 种暴力异常类型。该数据集由 3954 个训练视频和 800 个测试视频组成。

251118:UCF 哪来的帧级 GT?

5.1.2 评估指标(Evaluation Metrics)

- 在 UCF-Crime 数据集上,我们使用 ROC 曲线下面积(AUC) 作为评估指标。

- 在 XD-Violence 数据集上,我们使用 平均精度(AP),与其他已有方法保持一致。

5.1.3 实现细节(Implementation Details)

-

我们在每个长度为 24 帧的视频片段中 均匀采样 K = 8 个关键帧。

-

HiProbe-VAD 的主干 MLLM 采用 InternVL2.5 [9],

并额外在 Qwen2.5-VL [3]、LLaVA-OneVision [24] 和 Holmes-VAU [69] 作为 backbone 上进行了实验。

-

轻量级逻辑回归分类器基于 DLSP 所选最佳层的隐状态进行训练。

-

时间定位的高斯核宽度参数 σ \sigma σ = 0.4。

-

阈值参数 κ \kappa κ = 0.2。

所有实验均在一台配备 NVIDIA 4090 GPU 的服务器上进行。

5.2 性能与对比(Performance and Comparisons)

5.2.1 与最新方法的对比(Comparison with State-of-the-arts)

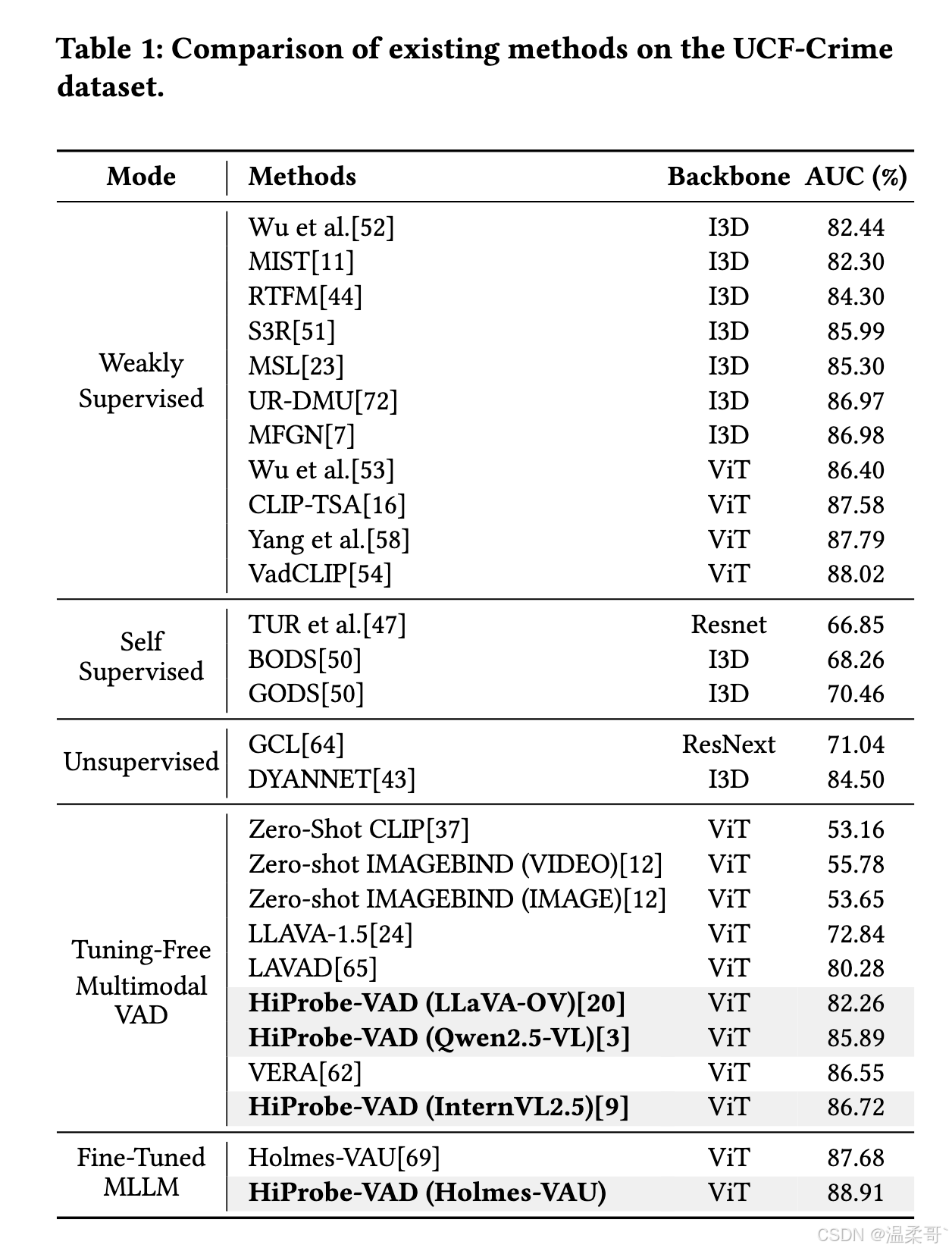

表 1 给出了 HiProbe-VAD 与 UCF-Crime 数据集上其他最新方法的对比结果。实验表明,我们的框架优于所有现有的免微调方法。

基于 InternVL2.5 [9] 作为 backbone 的 HiProbe-VAD 在 UCF-Crime 上取得 86.72% 的 AUC:

- 相比 LAVAD 提升了 +6.44%

- 相比 VERA 提升了 +0.17%

此外,我们的框架也显著优于所有现有的无监督和自监督方法。

值得注意的是,HiProbe-VAD 甚至超过了部分依赖大量标注数据的弱监督方法,这凸显了其在层选择与评分器训练数据有限情况下的强大性能。

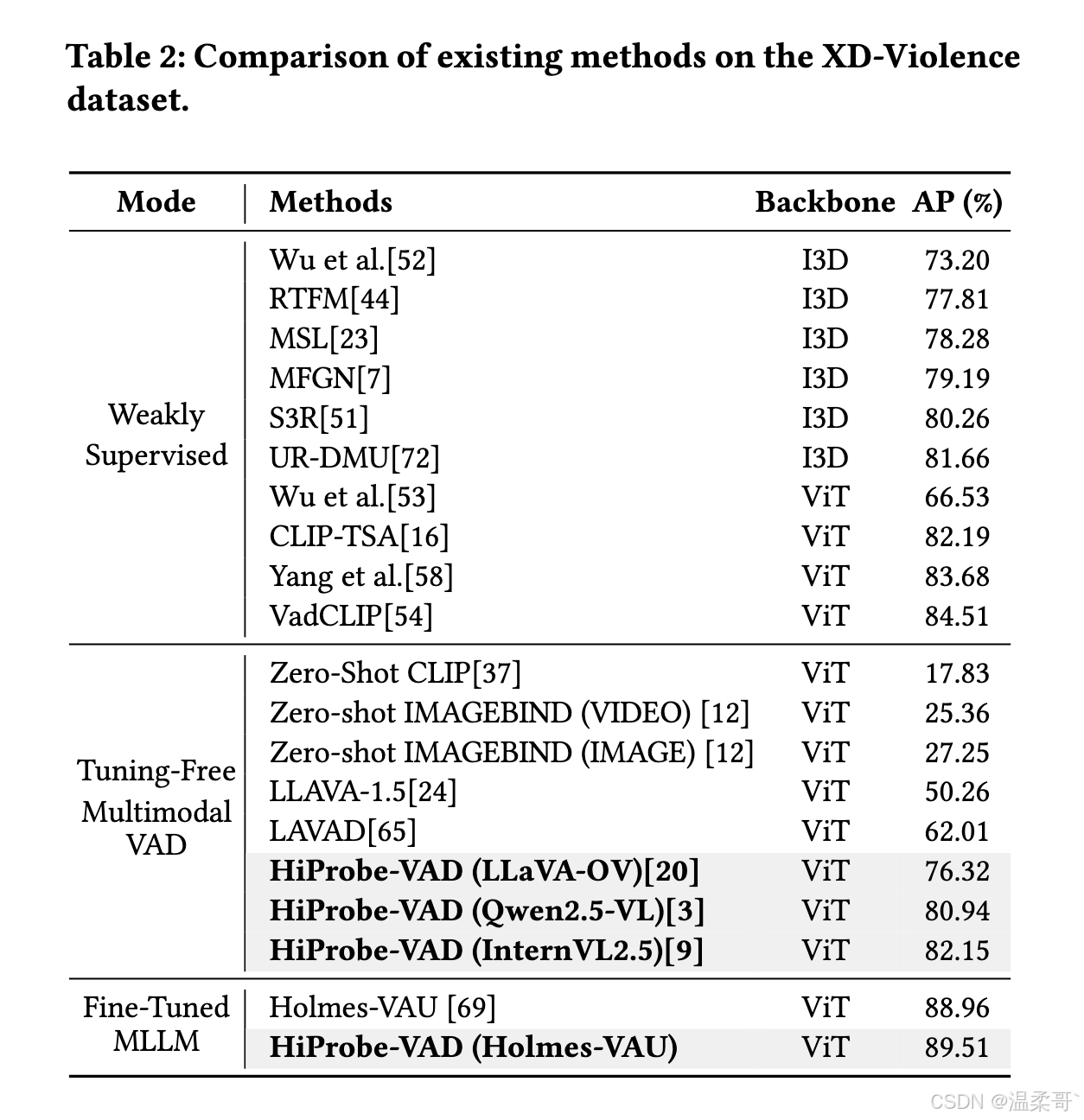

表 2 展示了在 XD-Violence 数据集上与最新方法的对比结果。

与在 UCF-Crime 上的结果类似,HiProbe-VAD 取得了具有竞争力的性能 。

在免微调方法中,HiProbe-VAD 体现出适用于不同 MLLM 的潜力,在无需任何 MLLM 微调、无需大量标注数据的情况下实现了显著性能提升。

5.2.2 跨模型泛化能力(Cross-Model Generalization)

我们使用三个不同的预训练 MLLM 评估 HiProbe-VAD 的跨模型泛化能力。如表 1 和表 2 所示:

- InternVL2.5 backbone 取得最佳性能

- Qwen2.5-VL 与 LLaVA-OneVision backbone 也取得了有竞争力的结果

这些结果说明了我们方法在不同架构的 MLLM 上的鲁棒性与适应性。此外,我们还采用了经过微调的 Holmes-VAU 作为 backbone,结果显示我们的方法比所有现有方法都取得了更好的性能。

这进一步表明 HiProbe-VAD 在多种 MLLM backbone 上都是一种鲁棒、性能优秀的视频异常检测方案。

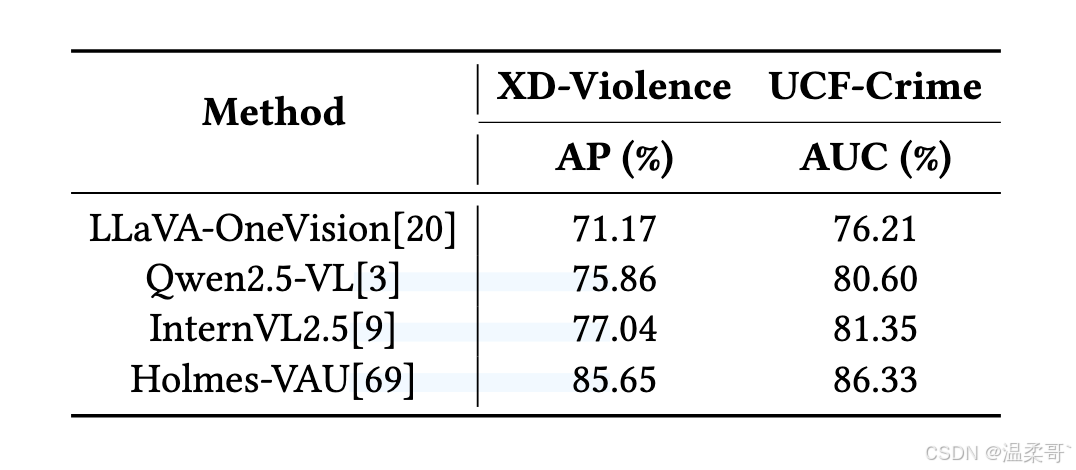

5.2.3 零样本泛化能力(Zero-shot Generalization Capability)

我们进一步研究了 HiProbe-VAD 的零样本泛化能力,即:

- 在 UCF-Crime 上训练,在 XD-Violence 上测试

- 以及反过来

表 3 显示:

- 在 UCF-Crime(Zero-shot)上 AUC = 81.35%

- 在 XD-Violence(Zero-shot)上 AP = 77.04%

与此同时,Qwen2.5-VL、LLaVA-OneVision、Holmes-VAU 的 Zero-shot 实验同样取得了良好表现。

这表明:

预训练 MLLM 的中间层隐状态天然捕获了可迁移的异常相关特征,使其能够在无需任务特定适配的情况下对新数据集进行有效泛化,同时减少在新环境中大量采集标注数据的需求。

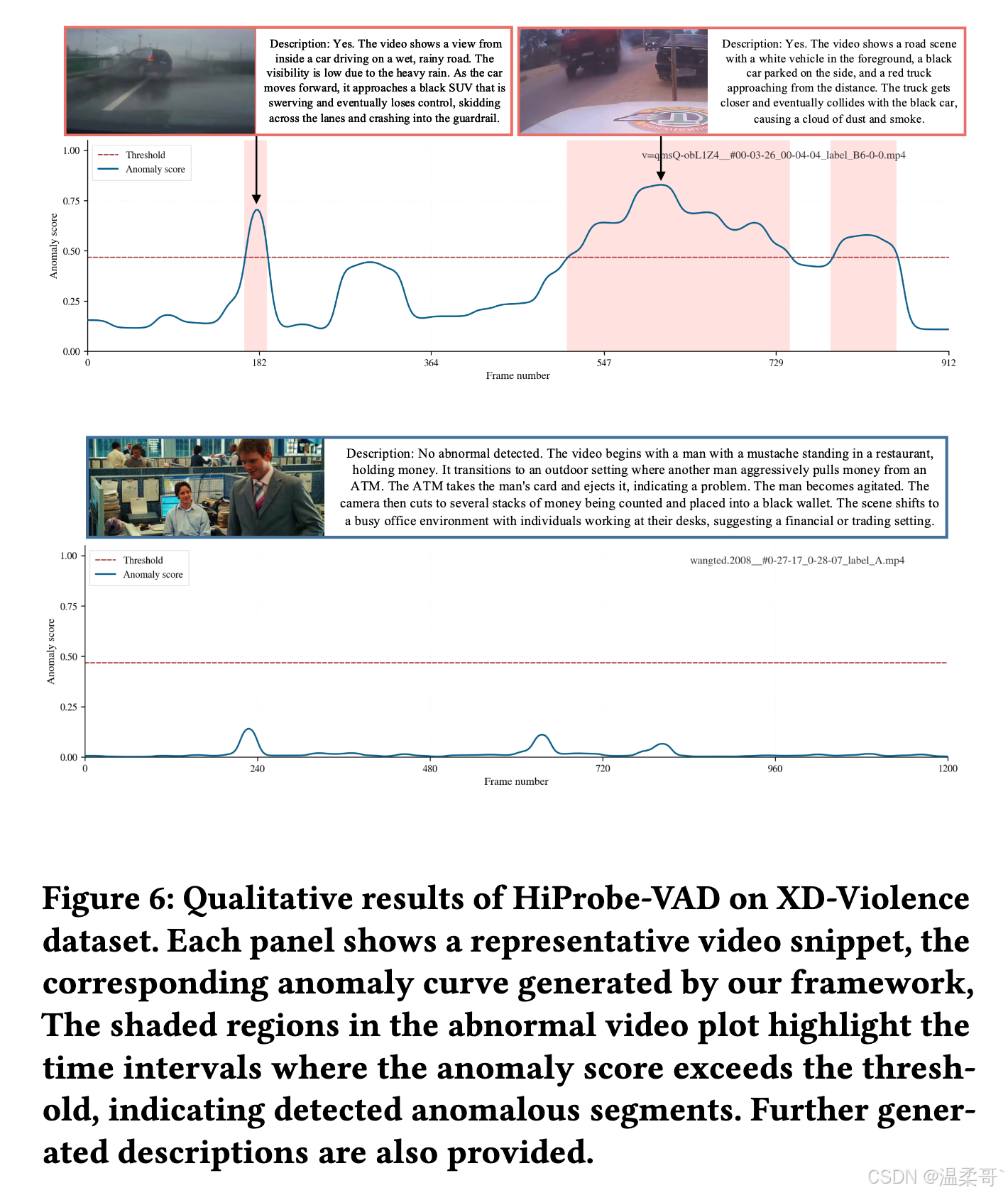

5.2.4 定性结果(Qualitative Results)

Fig. 6 展示了在 XD-Violence 数据集中针对异常视频和正常视频的定性结果,为我们的框架提供了直观的视觉验证。

-

对于异常视频,图中显示了随帧变化的异常分数曲线,

红色阴影区域表示检测到的异常片段,即异常得分超过学习到的阈值的部分,能够准确定位异常行为发生的时刻。

-

正常视频则持续保持低异常得分。

同时,我们展示了 MLLM 生成的相关描述,表明了将我们的异常检测框架与 MLLM 的高级语义理解相结合的潜力。

更多实验与分析见补充材料。

251118:这个图画的很有心机呀,如果没有注意看的话,会以为预测的分数完全预测对了,但是那个阴影部分并不是 GT 值范围。

5.3 消融实验

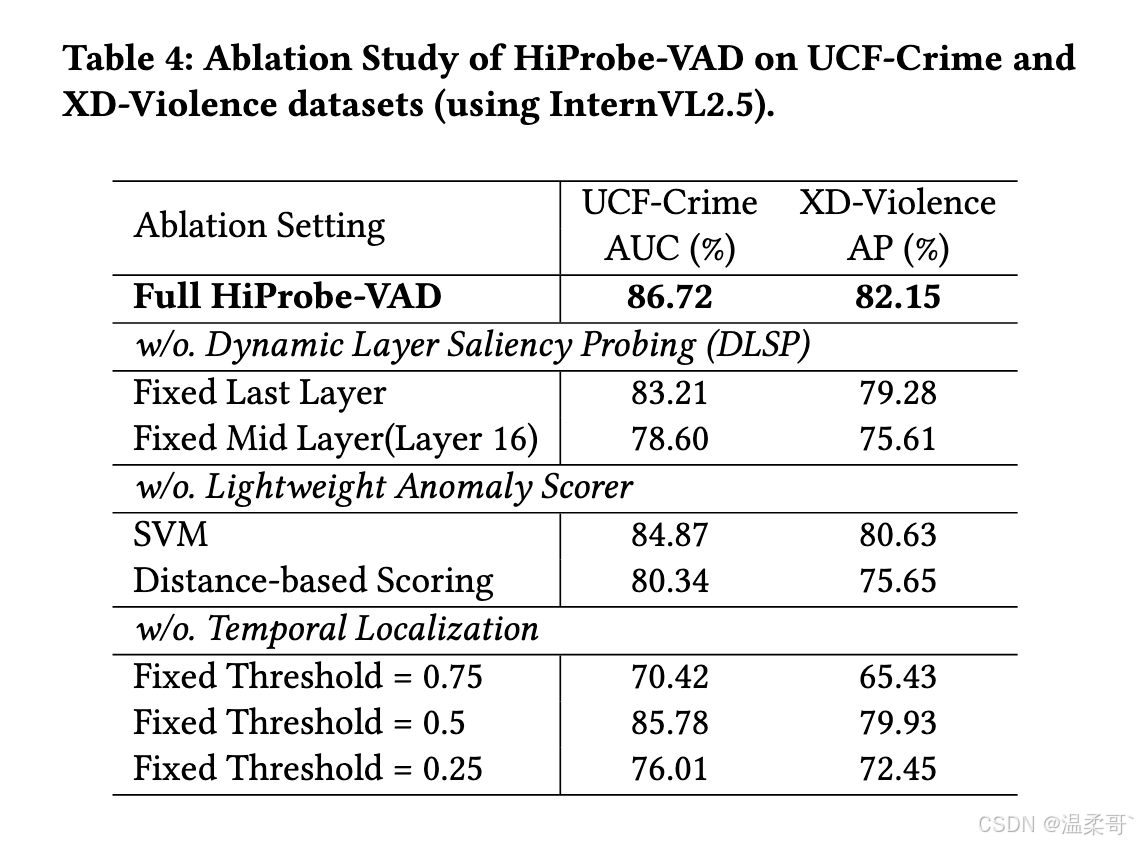

为了更好地理解我们 HiProbe-VAD 框架中每个组件的贡献,我们在 UCF-Crime 和 XD-Violence 数据集上,以 InternVL2.5 作为骨干模型进行了系列消融实验。结果总结在 Tab.4 中。

5.3.1 动态层显著性探测(DLSP)的有效性

为了验证我们的动态层显著性探测模块在识别 MLLM 中最相关的异常检测特征方面的有效性,我们进行了消融实验,将其与固定层选择策略进行对比。Tab.4 显示,使用 InternVL2.5 的固定最后一层导致在 UCF-Crime 上 AUC 明显下降 3.51%,在 XD-Violence 上 AP 下降 2.87%。将层固定为中间层(第 16 层)则导致更显著的性能下降,分别下降 8.12% 和 6.54%。这些显著的性能退化凸显了 DLSP 在动态识别和利用这些信息丰富层方面的有效性。

5.3.2 轻量级异常评分器的影响

为了评估逻辑回归分类器作为异常评分器的有效性,我们将其与两种替代评分机制进行性能对比:支持向量机(SVM)和基于距离的评分方法。如 Tab.4 所示,使用 SVM 在 UCF-Crime 上导致 AUC 下降 1.85%,在 XD-Violence 上 AP 下降 1.52%,相比逻辑回归分类器更低。基于距离的评分方法表现更差,在 UCF-Crime 上 AUC 下降 6.38%,在 XD-Violence 上 AP 下降 6.50%。这些结果表明,尽管 SVM 和基于距离的方法能够捕获部分异常模式,但逻辑回归分类器在区分正常与异常事件方面更为有效,尤其基于我们框架提取的特征表现更佳。

5.3.3 时间定位模块的贡献

为了评估定位模块的贡献,我们将自适应方法中的阈值 T T T 替换为固定阈值以确定异常帧。如 Tab.4 所示,使用固定阈值 0.75 会导致 AUC 和 AP 分别大幅下降 16.30% 和 16.72%,表明过高的静态阈值会错过许多细微异常。阈值 0.5 在 UCF-Crime(85.78% AUC)上取得相对较接近的性能,但仍比完整方法低 0.94%,并且在 XD-Violence(79.93% AP)上明显下降 2.22%。更低的阈值 0.25 会导致 AUC(76.01%)和 AP(72.45%)显著下降,并产生更多误报。这些结果表明,我们的自适应时间定位方法更为有效,它能够动态聚合异常帧并抑制误警,从而比固定阈值实现更准确、更稳健的检测。

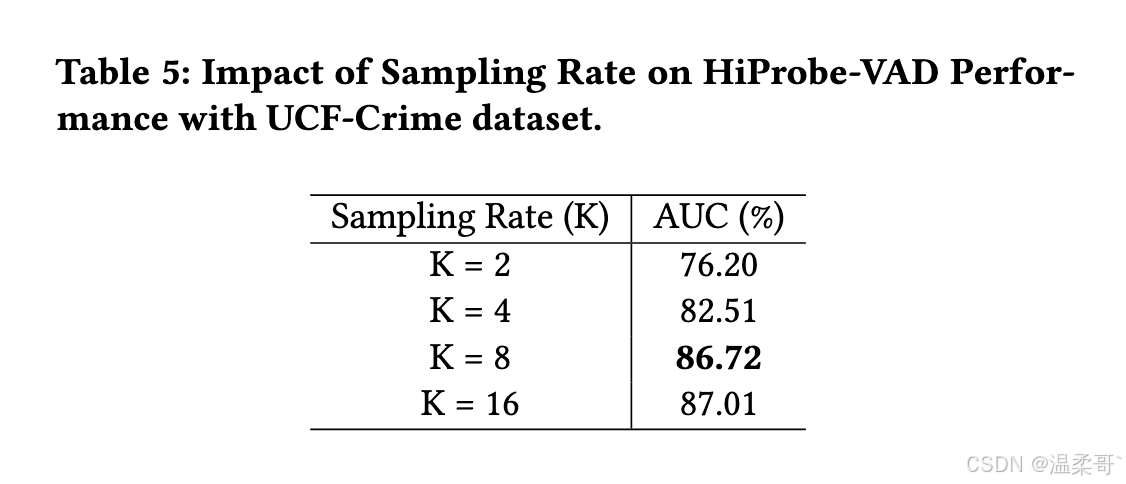

5.3.4 关键帧采样率的影响

为了研究关键帧数量对 HiProbe-VAD 性能的影响,我们通过改变每个 24 帧视频段中提取的关键帧数量 K K K 来实验不同采样率。如 Tab.5 所示,增加关键帧数量通常会提高性能,表明更多关键帧可以捕获更丰富的时间信息。然而,将采样率增加到 K = 16 K=16 K=16 仅带来轻微性能提升(达到 87.01%),这表明额外关键帧的收益可能在逐渐减弱。

考虑到超过 K = 8 K=8 K=8 后性能提升有限,以及处理更多关键帧所需的显著计算成本,我们选择 K = 8 K=8 K=8 作为默认设置。这一选择在保持计算效率的同时,为高精度异常检测提供了良好平衡。

6 结论

在本文中,我们提出了 HiProbe-VAD,这是一种受我们在预训练 MLLMs 中发现的"Intermediate Layer Information-rich Phenomenon"启发的全新免微调视频异常检测框架。我们的框架利用动态层显著性探测模块来识别最优中间层,并结合轻量级异常评分器和定位模块来识别异常,最终生成描述。

实验表明,HiProbe-VAD 在免微调方法中达到了最先进的性能,超过了现有的无监督和自监督方法。HiProbe-VAD 在不同 MLLM 架构上的显著跨模型泛化能力进一步证明了其稳健性和适应性。我们希望该工作能够激发对中间层 MLLM 表征和视频异常检测在更广泛应用中的进一步研究。