论文题目:SpiralMLP: A Lightweight Vision MLP Architecture(一个轻量级的视觉MLP架构)

会议:WACV2025

摘要:我们提出了SpiralMLP,这是一种新的架构,引入了螺旋FC层,作为传统令牌混合方法的替代品。与现有的几种主要强调轴的基于mlp的模型不同,我们的螺旋FC层被设计为具有螺旋状偏移的可变形卷积层。我们进一步将螺旋FC调整为两种变体:自螺旋FC和交叉螺旋FC,使本地和全局功能无缝集成,消除了额外处理步骤的需要。为了彻底研究螺旋状偏移的有效性并验证我们的设计,我们进行了烧蚀研究并探索了最佳配置。在实证测试中,SpiralMLP达到了最先进的性能,类似于Transformers、cnn和其他mlp,在ImageNet1k、COCO和ADE20K上进行基准测试。SpiralMLP仍然保持线性计算复杂度O (HW),并与不同的输入图像分辨率兼容。我们的研究表明,瞄准整个感受野并不是获得高性能的必要条件,相反,采用一种改进的方法可以提供更好的结果。

Code:https://github.com/Kookree/ SpiralMLP

SpiralMLP - 突破传统的轻量级视觉MLP架构

📋 论文概述

这篇发表在WACV 2025的论文提出了SpiralMLP,一种创新的轻量级视觉MLP架构。论文的核心贡献是设计了Spiral FC(螺旋全连接层)来替代传统的Token Mixing方法,在保持线性复杂度的同时实现了与Transformers和CNNs相媲美的性能。

🎯 一、论文指出的核心问题

1.1 现有架构的局限性

CNN的困境:

- 在受控数据集上表现优异,但在有偏差或不受控环境下表现不佳

- 归纳偏置过强,泛化能力受限

Transformer的挑战:

- 自注意力机制带来二次计算复杂度O(n²)

- 预训练成本高昂

- 需要大规模数据集才能在下游任务上表现良好

1.2 现有MLP架构的问题

MLP-Mixer的限制:

- 计算复杂度为O(H²W²),随图像尺寸二次增长

- 需要固定的图像输入尺寸

- 全连接的Token Mixing层参数量大

轴向MLP的局限: 论文发现,许多现有MLP模型(SparseMLP、ASMLP、CycleMLP、ATM)存在一个共同问题:

它们将token mixing限制在水平和垂直轴上,无法有效整合不同空间维度的特征信息

具体来说:

- CycleMLP:使用固定偏移的Cycle FC进行稀疏通道级混合

- ATM:虽然使用可训练偏移,但仍局限于交叉轴向模式

- 传统交叉全连接层:未能优化偏移函数,导致空间覆盖不足

💡 二、创新点详解

2.1 核心创新:Spiral FC层

设计灵感:

- 来自自然界的螺旋模式(如贝壳、星系)

- Transformer注意力可视化中观察到的螺旋模式(AttentionViz)

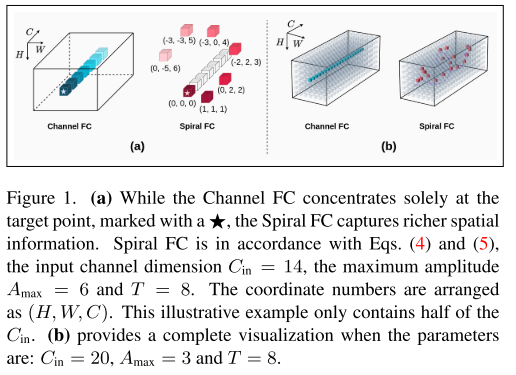

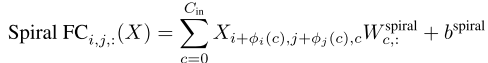

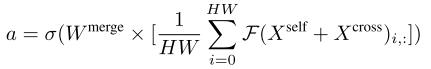

数学定义:

Spiral FC在位置(i,j,:)的输出定义为:

其中螺旋偏移函数定义为:

φᵢ(c) = A(c) · cos(c × 2π / T)

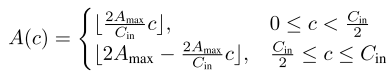

φⱼ(c) = A(c) · sin(c × 2π / T)振幅函数A(c)采用分段线性模式:

关键特性:

- 螺旋轨迹:沿通道维度形成螺旋采样模式

- 可控感受野:通过A_max控制螺旋宽度

- 线性复杂度:O(HW),与图像尺寸线性相关

- 尺寸无关:使用步长为1的滑动窗口,支持任意输入分辨率

2.2 双分支设计

Self-Spiral FC (A_max = 0):

- 等价于Channel FC

- 捕获位置(i,j)的局部信息

- 输出:X^self ∈ R^{H×W×C_out}

Cross-Spiral FC (A_max ≠ 0):

- 形成螺旋采样模式

- 在感受野内选择性整合空间信息

- 输出:X^cross ∈ R^{H×W×C_out}

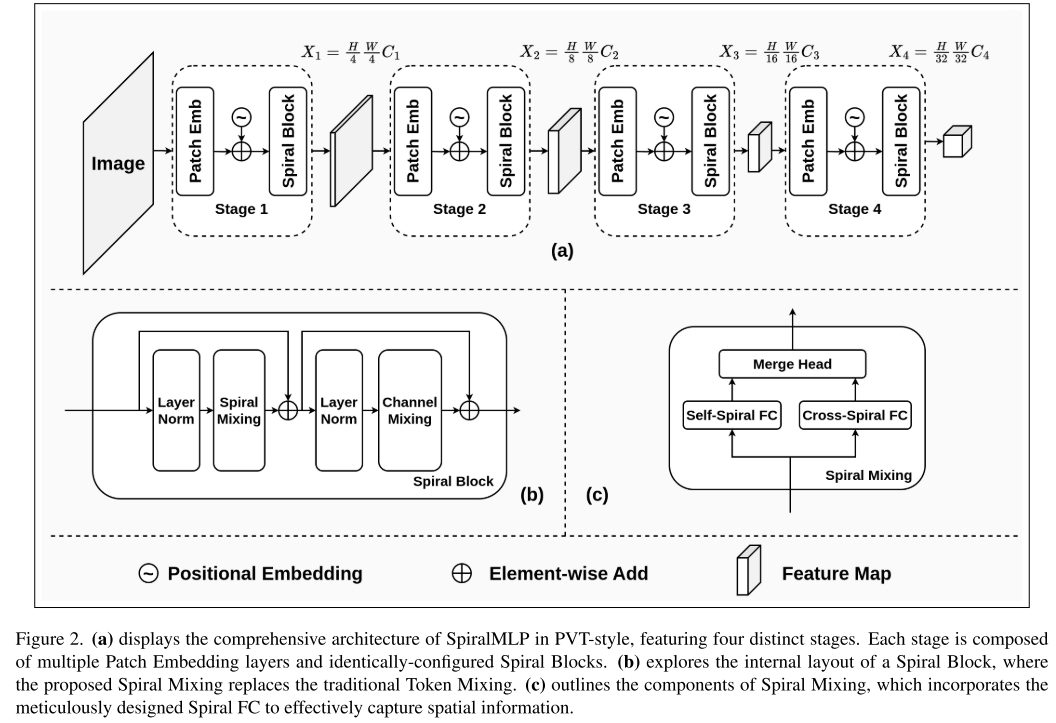

2.3 Spiral Mixing机制

Merge Head自适应融合:

优势:

- 动态调整局部和全局特征的贡献

- 权重a通过SoftMax归一化,确保稳定性

- 全局平均池化提供上下文信息指导融合

2.4 架构设计

Spiral Block结构:

X' = Spiral Mixing(LayerNorm(X)) + X

Y = Channel Mixing(LayerNorm(X')) + X'整体架构:

- 提供PVT-style 和Swin-style两种变体

- 4个阶段,逐步降低空间分辨率,增加通道维度

- 模型缩放:B1到B5(PVT-style);Tiny/Small/Base(Swin-style)

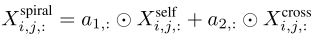

📊 三、实验结果分析

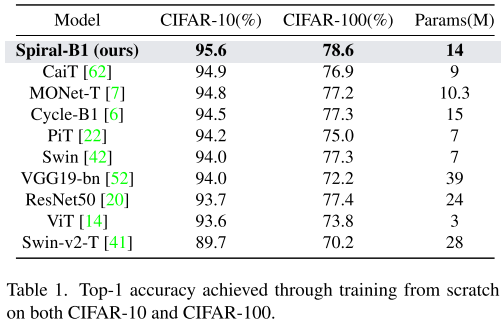

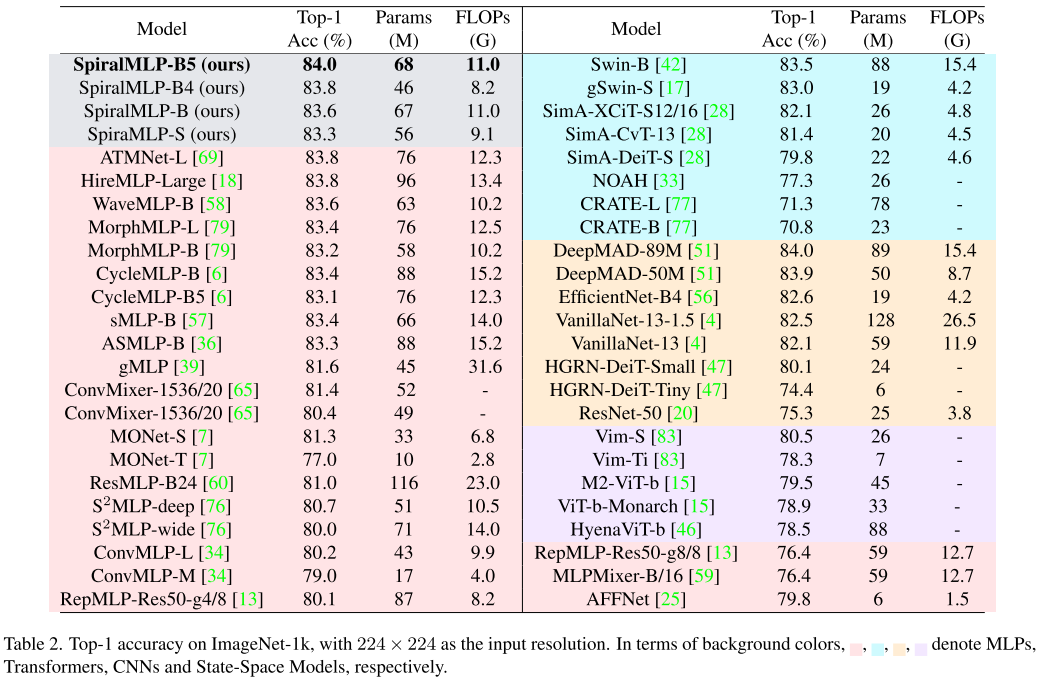

3.1 图像分类(ImageNet-1k)

与MLP模型对比:

亮点:

- 在精度超过83%的所有MLP模型中,SpiralMLP-B5的FLOPs最低(11.0G)

- 相比S²MLP-wide(71M参数,80.0%),SpiralMLP用更少参数实现+4.0%提升

与Transformers/CNNs对比:

- 比Swin-B少20M参数,精度高**+0.5%**

- 与DeepMAD-89M精度相当,但参数少21M

- 优于State-Space Models(Vim系列)约+4.0%

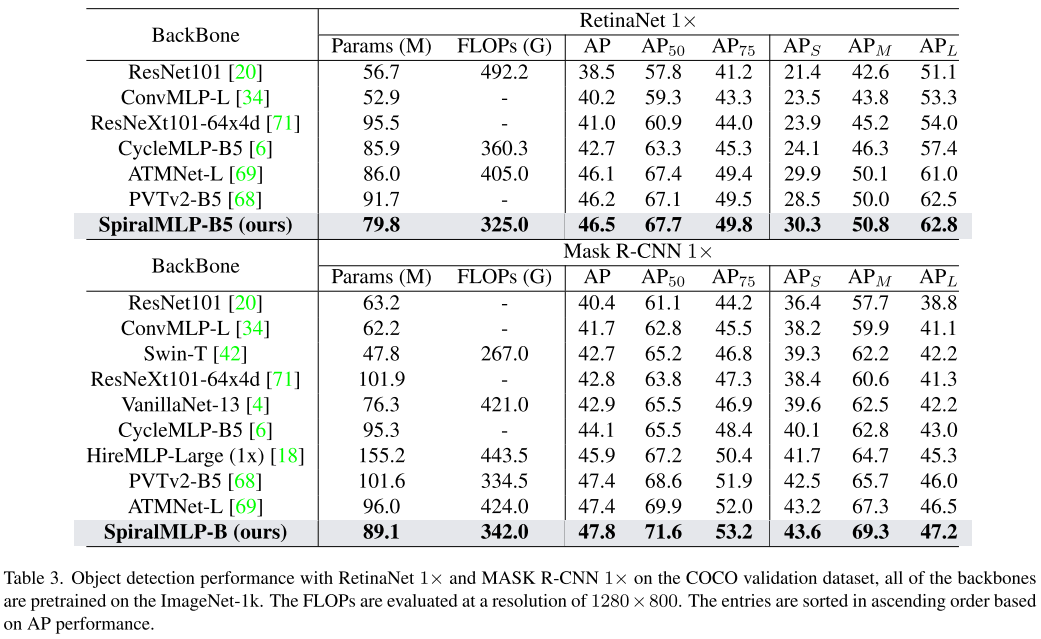

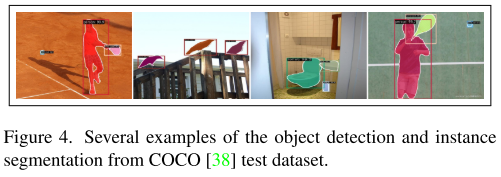

3.2 目标检测与实例分割(COCO)

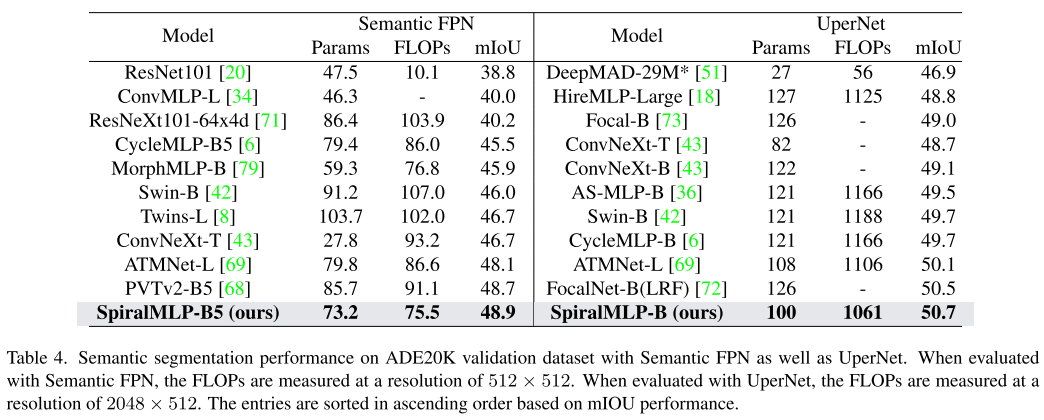

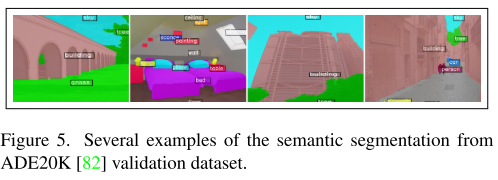

3.3 语义分割(ADE20K)

Semantic FPN:

- SpiralMLP-B5 :mIoU 48.9%(超越PVTv2-B5 +0.2%)

- 参数73.2M,FLOPs 75.5G(均为最低)

UperNet:

- SpiralMLP-B :mIoU 50.7%(超越FocalNet-B +0.2%)

- 超越ATMNet-L +0.6%

3.4 推理速度

在A100 GPU上测试(224×224输入):

| 模型 | Params (M) | 延迟 (ms) |

|---|---|---|

| SpiralMLP-B5 | 68 | 39.22 |

| CycleMLP-B5 | 76 | 48.38 |

| ATM-L | 76 | 54.09 |

| PVTv2-B5 | 82 | 55.71 |

SpiralMLP在相似规模模型中速度最快!

🔬 四、消融实验

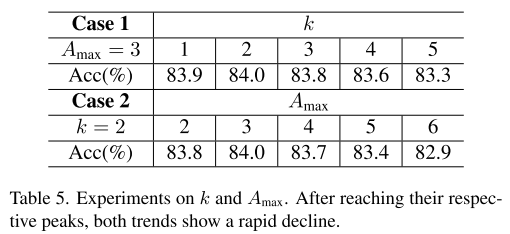

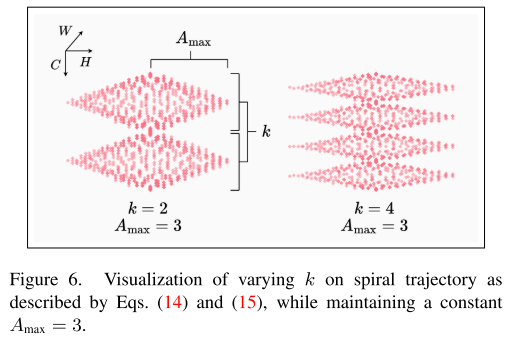

4.1 螺旋分区数k的影响

更新偏移函数以支持多分区:

| k | 1 | 2 | 3 | 4 | 5 |

|---|---|---|---|---|---|

| Acc(%) | 83.9 | 84.0 | 83.8 | 83.6 | 83.3 |

发现:

- k=2时达到最佳性能

- k值过低:特征点过于密集集中

- k值过高:特征点分布过于稀疏

4.2 最大振幅A_max的影响

固定k=2:

| A_max | 2 | 3 | 4 | 5 | 6 |

|---|---|---|---|---|---|

| Acc(%) | 83.8 | 84.0 | 83.7 | 83.4 | 82.9 |

结论:

- A_max=3时最优

- 过小:无法覆盖足够的邻域特征

- 过大:稀疏采样无法捕获细节信息

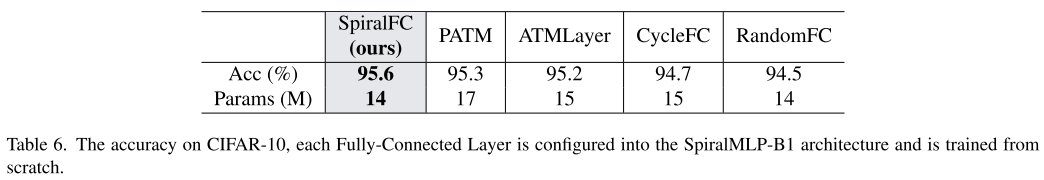

4.3 不同FC层对比(CIFAR-10)

验证了精心设计的螺旋偏移函数的有效性!

💭 五、核心贡献总结

5.1 理论贡献

- 首次系统性地使用精心设计的偏移函数捕获全面的特征信息

- 证明了不需要覆盖整个感受野就能达到SOTA性能

- 提出了采用精细化方法比盲目扩大感受野更有效

5.2 方法创新

- Spiral FC:螺旋轨迹采样 + 线性复杂度 + 尺寸无关

- 双分支设计:局部与全局特征的协同

- 自适应融合:Merge Head动态平衡

5.3 实验验证

- 多任务验证:分类、检测、分割均达到SOTA

- 效率优势:参数少、FLOPs低、速度快

- 消融充分:验证了每个设计选择的有效性

🎨 六、可视化分析

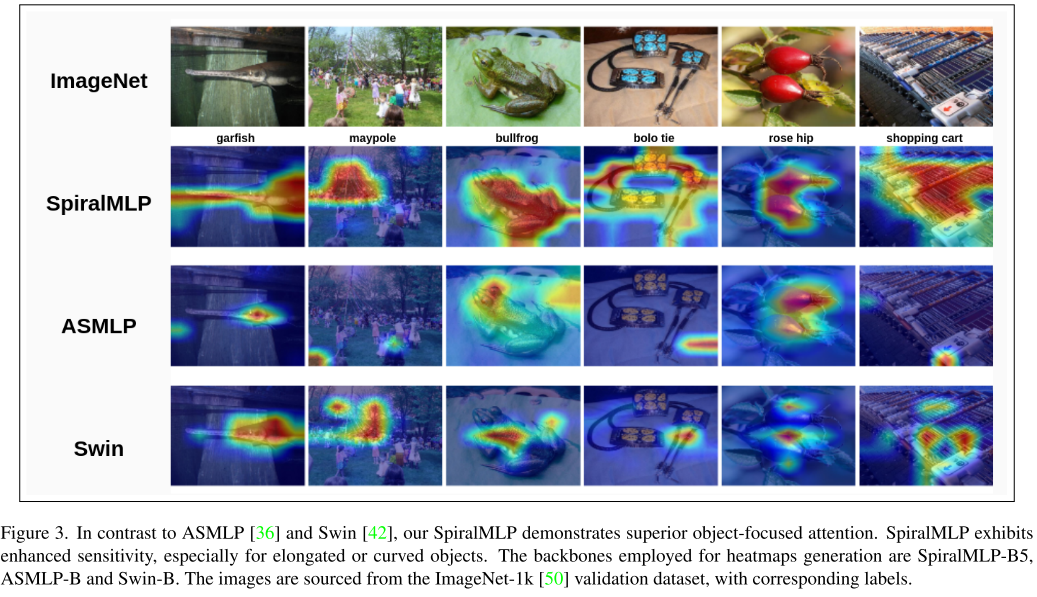

论文提供了与ASMLP和Swin的注意力热图对比(Figure 3):

SpiralMLP的优势:

- 对细长或弯曲物体的敏感度更高

- 注意力更聚焦于目标对象

- 边界定位更精确

例如:

- 对"garfish"(细长的鱼)有更准确的定位

- 对"bolo tie"(领结)的形状捕捉更好

- 对"shopping cart"的结构理解更清晰

🔮 七、未来展望与局限

潜在改进方向

- 超参数自动搜索:当前k和A_max需要手动调优

- 可学习的偏移函数:将螺旋模式参数化为可训练的

- 3D扩展:将Spiral FC扩展到视频和3D视觉任务

- 多尺度螺旋:在不同层使用不同的螺旋参数

适用场景

推荐使用SpiralMLP的场景:

- 需要高效模型的移动端部署

- 资源受限的边缘设备

- 需要处理不同分辨率输入的应用

- 对细长、曲线物体敏感的任务

特别值得学习的点:

- 如何从可视化(AttentionViz)中获得设计灵感

- 如何通过数学公式(正弦/余弦)优雅地实现复杂模式

- 如何系统地进行消融实验

这篇论文证明了:在深度学习中,精心设计的归纳偏置(如螺旋模式)仍然有巨大价值,不是所有问题都需要靠堆参数和数据解决!

希望这篇详细的论文解读对你有帮助!如果你对某个部分有更深入的问题,欢迎继续交流~ 🚀