Linux 低内存平台文件缓存导致的虚假内存不足问题分析与解决方案

目录

1. 引言

在嵌入式设备或低配置云主机等低内存环境中,经常会出现"虚假内存不足"的现象:free 命令显示内存似乎被占满,但实际上大部分是被 Page Cache(文件缓存) 占用。当应用程序申请内存时,内核未能及时回收缓存,导致系统卡顿甚至触发 OOM Killer(内存溢出杀手),误杀关键进程。本文将深入分析这一机制,并提供系统性的解决方案。

2. 技术深度分析

2.1 Linux 内存管理机制

文件缓存 (Page Cache)

Linux 遵循"空闲内存即浪费"的原则。当文件从磁盘读取时,内核会将其缓存在 Page Cache 中,以便下次访问时直接从 RAM 读取,极大提升 I/O 性能。Page Cache 属于可回收内存 (Reclaimable)。

内存回收机制 (Memory Reclaim)

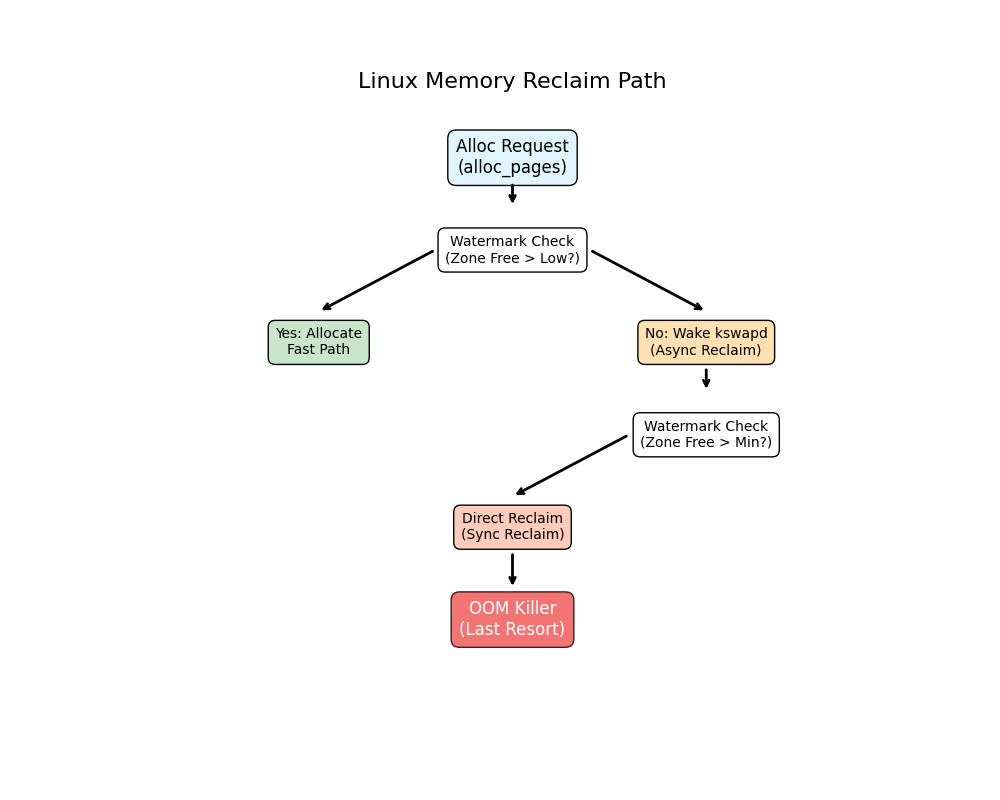

当物理内存不足时,内核通过两种方式回收内存:

- kswapd (异步回收) : 当空闲内存低于

WMARK_LOW水位时,后台线程kswapd唤醒,开始扫描 LRU (Least Recently Used) 链表,将不常用的页写入磁盘(Swap)或直接丢弃(如果是干净的文件页)。 - Direct Reclaim (直接回收) : 当空闲内存低于

WMARK_MIN水位,且kswapd来不及回收时,进程在申请内存时会被迫同步阻塞,亲自去回收内存。这会导致系统严重的卡顿(Stall)。

OOM Killer (内存溢出杀手)

如果 Direct Reclaim 仍然无法释放足够的内存(通常是因为所有内存都在使用中,或者回收速度远低于分配速度),内核会触发 OOM Killer,根据 oom_score 选择一个进程杀死,以释放内存保护系统内核。

2.2 低内存环境下的特殊表现

缓存与应用的竞争

在内存充裕的系统中,Page Cache 的存在是透明且有益的。但在低内存(如 512MB/1GB)系统中,Page Cache 的释放需要 CPU 时间和 I/O 带宽(如果是脏页)。如果应用程序瞬间请求大量内存,内核可能来不及"腾挪"出空间,从而误判为内存不足。

水位线 (Watermark) 计算

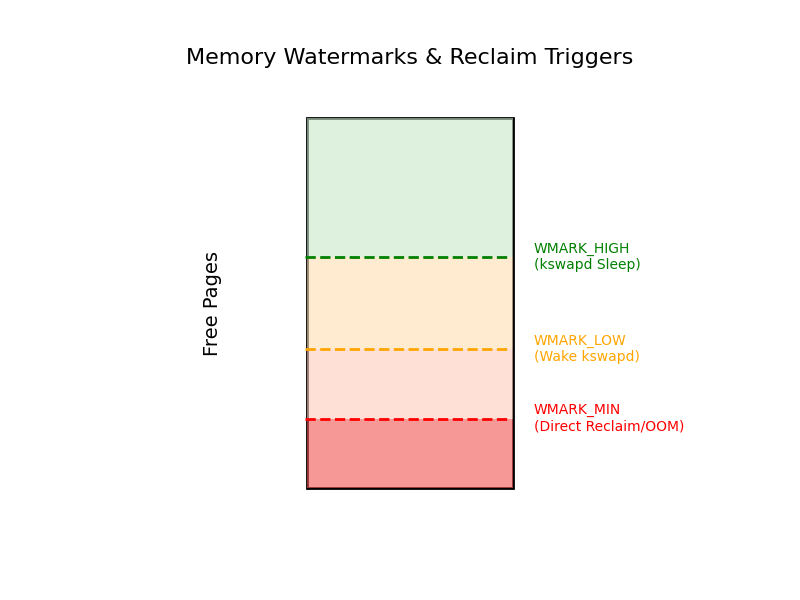

内核根据 min_free_kbytes 参数计算三个水位线:

- WMARK_MIN: 绝对底线,低于此线触发 Direct Reclaim / OOM。

- WMARK_LOW : 警戒线,低于此线唤醒

kswapd。 - WMARK_HIGH : 安全线,

kswapd回收到此线后停止。

如果 min_free_kbytes 设置过低,WMARK_LOW 和 WMARK_MIN 之间的缓冲区太小,容易导致直接进入 Direct Reclaim 状态,造成系统抖动。

3. 问题诊断方法

3.1 关键指标解读

1. free -h

bash

total used free shared buff/cache available

Mem: 981M 120M 50M 1.0M 811M 800M- buff/cache : 系统当前缓存的文件数据量。不要只看 free 列!

- available: 估算的可用内存(包含可回收的 cache)。如果此值很低,说明真正的内存不足。

2. /proc/meminfo

关注以下字段:

Active(file)/Inactive(file): 活跃/非活跃的文件缓存页。Inactive通常更容易被回收。Dirty: 等待写入磁盘的脏页。如果此值过高,回收缓存会阻塞在磁盘 I/O 上。Slab: 内核数据结构占用。如果Slab很高且SReclaimable低,可能是内核泄漏。

3. vmstat 1

bash

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

2 1 0 50000 10000 800000 0 0 0 0 100 50 10 5 80 5 0- b: 处于不可中断睡眠状态(通常是等待 I/O)的进程数。

- si/so : Swap In / Swap Out。如果有持续的

so,说明物理内存确实不够了。 - wa: CPU 等待 I/O 的时间百分比。

3.2 复现测试

使用提供的脚本 cache_pressure_test.sh 模拟大文件读取后的内存分配场景。

bash

sudo ./cache_pressure_test.sh4. 解决方案

4.1 内核参数调优

通过调整 /etc/sysctl.conf 中的参数来优化内存行为。

1. vm.min_free_kbytes (关键)

增加保留的空闲内存量,扩大 WMARK_LOW 和 WMARK_MIN 之间的缓冲区,让 kswapd 更早介入,减少 Direct Reclaim 的发生。

建议值 : 物理内存的 3% - 5%。

例如 1GB 内存:

bash

vm.min_free_kbytes = 327682. vm.vfs_cache_pressure

控制内核回收 VFS 缓存(dentry/inode)的倾向。默认 100。

调优: 增大该值(如 150-200),让内核更积极地回收目录项和索引节点缓存,释放 Slab 内存。

bash

vm.vfs_cache_pressure = 1503. vm.swappiness

控制使用 Swap 的倾向(0-100)。

低内存建议: 适当降低(如 10-20),尽量保留代码段在内存中,仅在必要时交换匿名页。但在 zram 场景下,可适当调高(60-80)。

bash

vm.swappiness = 104. vm.dirty_ratio / vm.dirty_background_ratio

控制脏页刷回磁盘的时机。

优化: 减小这两个值,让脏页更早、更频繁地刷回磁盘,避免内存回收时遇到大量脏页导致阻塞。

bash

vm.dirty_background_ratio = 5

vm.dirty_ratio = 104.2 应用程序优化

-

文件访问模式:

- 使用

posix_fadvise(fd, 0, 0, POSIX_FADV_DONTNEED):在读取完大文件后,显式告知内核不需要缓存该文件。 - 避免一次性读取超大文件到内存。

- 使用

-

mlock()使用:- 对于延迟敏感的关键应用(如实时控制),使用

mlock()或mlockall()将内存锁定在 RAM 中,防止被 Swap 出去。

- 对于延迟敏感的关键应用(如实时控制),使用

-

内存预分配:

- 在程序启动阶段预先分配所需内存池,避免在运行时动态分配导致的不确定性。