很多刚入行甚至想入行数据分析的朋友,往往会陷入一个误区 :以为数据分析就是不停地做报表 、画饼图。

其实,数据分析的核心魅力在于 "推断"------即见微知著。

在现实生活中,我们很难获取"全量数据"(比如你不可能调查全国每一个人的身高),那么,如何通过手中的"小样本"去推测"大总体"的规律?

这就需要用到统计学中的推断分析。

本文将结合代码来介绍推断分析 中最常用的三大方法:参数估计 、假设检验 、非参数检验。

1. 参数估计

想象你在煮一锅排骨汤。你想知道汤咸不咸,你不会把整锅汤都喝完,而是舀起一勺尝一尝。

- 那一勺汤就是样本。

- 那一勺的咸度就是样本统计量。

- 整锅汤的咸度就是我们要猜的总体参数。

参数估计 就是:根据样本的特征(比如样本均值 ),去估计总体的特征(比如总体均值)。

它通常分为两种:

- 点估计:直接说"这锅汤是1.5%的盐度"。(但这很容易被打脸,因为太绝对)

- 区间估计:说"这锅汤的盐度在1.4%到1.6%之间,我有95%的把握"。(这就是置信区间,更科学)

区间估计 是最常使用的方式,下面通过一个示例来演示参数估计的具体使用。

python

import numpy as np

from scipy import stats

# 1. 模拟数据

np.random.seed(42)

true_mean = 15 # 上帝视角的真实均值

sample_salaries = np.random.normal(loc=true_mean, scale=3, size=100) # 模拟100个样本

# 2. 计算统计量

sample_mean = np.mean(sample_salaries)

sample_std = np.std(sample_salaries, ddof=1)

n = len(sample_salaries)

# 计算95%置信区间

# 这里的 scale 使用的是标准误 (Standard Error) = 样本标准差 / sqrt(n)

conf_int = stats.t.interval(

confidence=0.95, df=n - 1, loc=sample_mean, scale=sample_std / np.sqrt(n)

)

lower_bound, upper_bound = conf_int

print(f"样本均值: {sample_mean:.2f}k")

print(f"95%置信区间: [{lower_bound:.2f}k, {upper_bound:.2f}k]")

# 运行结果:

'''

样本均值: 14.69k

95%置信区间: [14.15k, 15.23k]

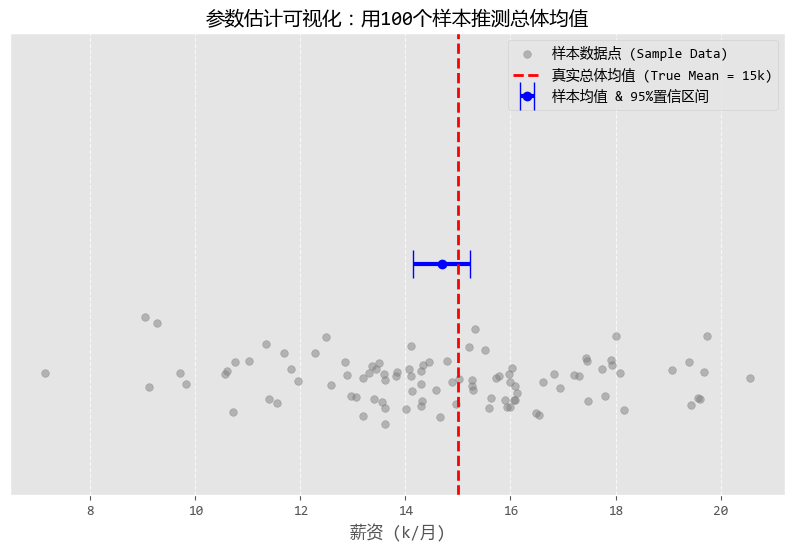

'''图形化之后的结果如下:

从图中可以看出:

- 灰色的散点:是你调研的那100个数据分析师的工资。你会发现有的高有的低,散落在各地。

- 蓝色的点和横线:

- 蓝点是你算出来的样本均值(约14.67k),虽然不完全等于真实的15k,但很接近。

- 蓝色的横线就是置信区间。它的含义是:"虽然我不知道确切数字,但我敢打赌,真实数字就在这根蓝线的范围内。"

- 红色的虚线:这是真实的总体均值(15k)。

- 结论:你可以清楚地看到,红色的虚线确实穿过了蓝色的横线。恭喜你!这次"参数估计"成功捕获了真理!

数据分析不是算命,算出来的不是一个死的数字,而是一个科学的范围。

我们就是用参数估计的方法,在不确定性中寻找确定性。

2. 假设检验

假设检验 是数据分析中最常用的决策工具。它的逻辑是:先立一个Flag(假设),然后看证据(数据)是否打脸。

- 原假设 :通常代表"无事发生"、"没有变化"、"运气好"。

- 备择假设:通常代表"有事发生"、"真的有效果"。

- P值:表示原假设成立时,出现当前数据的概率。P值越小,说明原假设越不靠谱(通常以0.05为界限)。

下面通过一个电商APP的A/B测试场景,来演示假设检验的使用。

假设某电商APP想把 "购买" 按钮从 蓝色 改成 红色 。

- 原假设:红色按钮和蓝色按钮的转化率没区别(差别纯属偶然)。

- 备择假设:红色按钮的转化率显著高于蓝色按钮。

我们采集了两组用户的消费金额数据来进行T检验。

python

# 1. 模拟AB测试数据

# 蓝色按钮组(对照组):平均消费 100元

group_blue = np.random.normal(loc=100, scale=20, size=1000)

# 红色按钮组(实验组):平均消费 105元 (我们要检验这个提升是否显著)

group_red = np.random.normal(loc=105, scale=25, size=1000)

# 2. 进行独立样本T检验 (T-test)

t_stat, p_val = stats.ttest_ind(group_blue, group_red)

print(f"P值: {p_val:.5f}")

# 3. 判断结论

alpha = 0.05

if p_val < alpha:

print("结论:拒绝原假设。红色按钮带来的消费提升是【统计显著】的,建议全量上线!")

else:

print("结论:无法拒绝原假设。两组差异可能是误差导致的,建议维持原状。")

# 运行结果:

'''

P值: 0.00000

结论:拒绝原假设。红色按钮带来的消费提升是【统计显著】的,建议全量上线!

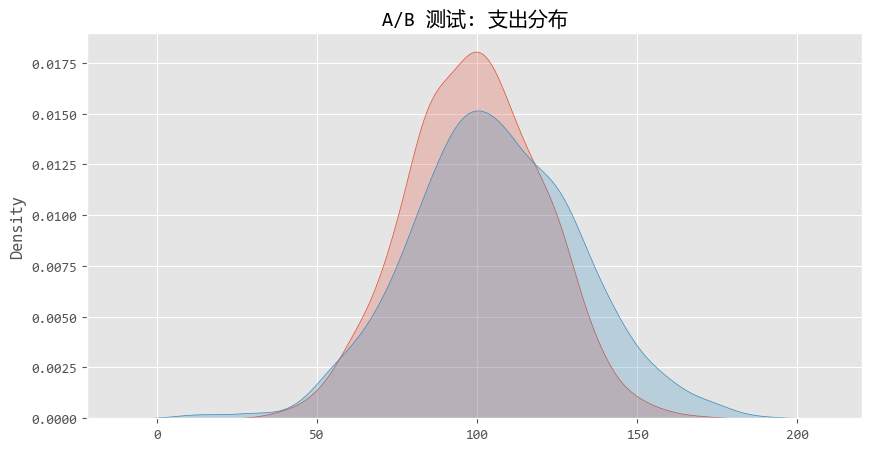

'''图形化结果如下:

从图中,我们可以看出,两条曲线(红色和蓝色)其实重叠度很高。

对于新手,看到这个图,可能会陷入一个误区,觉得"这两座山峰看起来差不多嘛,没啥区别"。

但在统计学上,两座山峰的 "重心" (均值)发生了 显著偏移 。这就是假设检验的威力--在重叠的噪声中识别出偏移的信号。

3. 非参数估计

前面的 "参数估计" 和 "T检验" 都有一个娇气的脾气:它们通常假设数据是服从 "正态分布" 的(也就是漂亮的钟形曲线)。

但在现实生活中,很多数据并不正态,或者数据甚至是定序的(比如:非常满意、满意、一般、不满意)。

这时候,传统的 T检验 就失效了,我们需要请出 非参数检验 。

它不依赖数据的分布形状,非常抗造。

假设我们要对比两款手游《王者荣耀》和《原神》玩家每天的游玩时长。

由于《原神》玩家可能存在大量的"长尾"用户(玩特别久),数据往往是严重右偏的,不符合正态分布。

这时候对比两组数据差异,就不能用T检验 ,我们使用非参数估计中的一种方式:曼-惠特尼U检验 (Mann-Whitney U test)。

python

# 1. 模拟非正态分布数据 (使用指数分布模拟由偏数据)

# 游戏A:平均时长较短

game_a_hours = np.random.exponential(scale=1.0, size=100)

# 游戏B:平均时长较长

game_b_hours = np.random.exponential(scale=1.5, size=100)

# 2. 首先,检查一下正态性 (Shapiro-Wilk检验)

# 如果P < 0.05,说明不是正态分布

_, p_norm_a = stats.shapiro(game_a_hours)

print(f"游戏A正态性检验P值: {p_norm_a:.4f} (小于0.05则非正态)")

# 3. 使用非参数检验:Mann-Whitney U检验

# 它可以比较两个独立样本的分布是否存在差异(侧重于中位数/秩次的比较)

u_stat, p_val_nonparam = stats.mannwhitneyu(game_a_hours, game_b_hours, alternative='two-sided')

print(f"Mann-Whitney U检验 P值: {p_val_nonparam:.5f}")

if p_val_nonparam < 0.05:

print("结论:两款游戏的玩家游玩时长分布存在显著差异。")

else:

print("结论:两款游戏玩家游玩时长无显著差异。")

# 运行结果:

'''

游戏A正态性检验P值: 0.0000 (小于0.05则非正态)

Mann-Whitney U检验 P值: 0.00003

结论:两款游戏的玩家游玩时长分布存在显著差异。

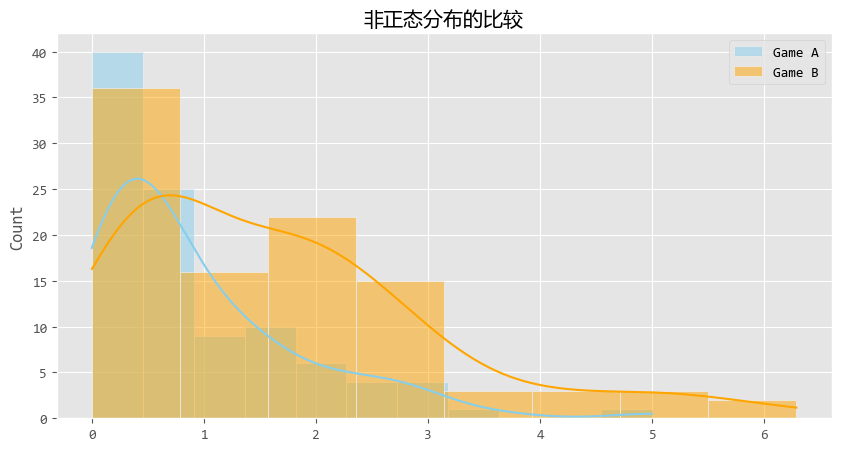

'''可视化结果如下:

尽管数据长得歪瓜裂枣(严重右偏),U检验 依然稳健地告诉我们:这两组数据不一样。

U检验 比较的不仅仅是平均值,它更多是在比较 "秩次" (Ranking)。

通俗点说,它发现如果我们把两组玩家混在一起排名,Game B的玩家即使不看具体时长,排名也普遍比Game A的玩家靠前。

从图中来看,你会看到橙色(Game B)的尾巴明显比蓝色(Game A)拖得更长、更厚实。

这说明Game B(比如《原神》)更容易让玩家沉浸更久,或者拥有更多的重度玩家。

4. 总结

恭喜你!你已经掌握了数据推断分析的核心逻辑:

- 参数估计:当你只有样本,想知道总体的数值范围时使用。(比如估算平均薪资)

- 假设检验:当你数据比较"完美"(正态分布),想判断差异是不是真的时使用。(比如A/B测试)

- 非参数检验:当你数据分布奇怪、或者只有排名/等级数据时使用。(比如评分对比、长尾数据分析)

这三板斧是数据分析师行走江湖的必备技能。掌握了它们,你就不仅仅是一个"做表的",而是一个能从数据中挖掘真相的"侦探"!