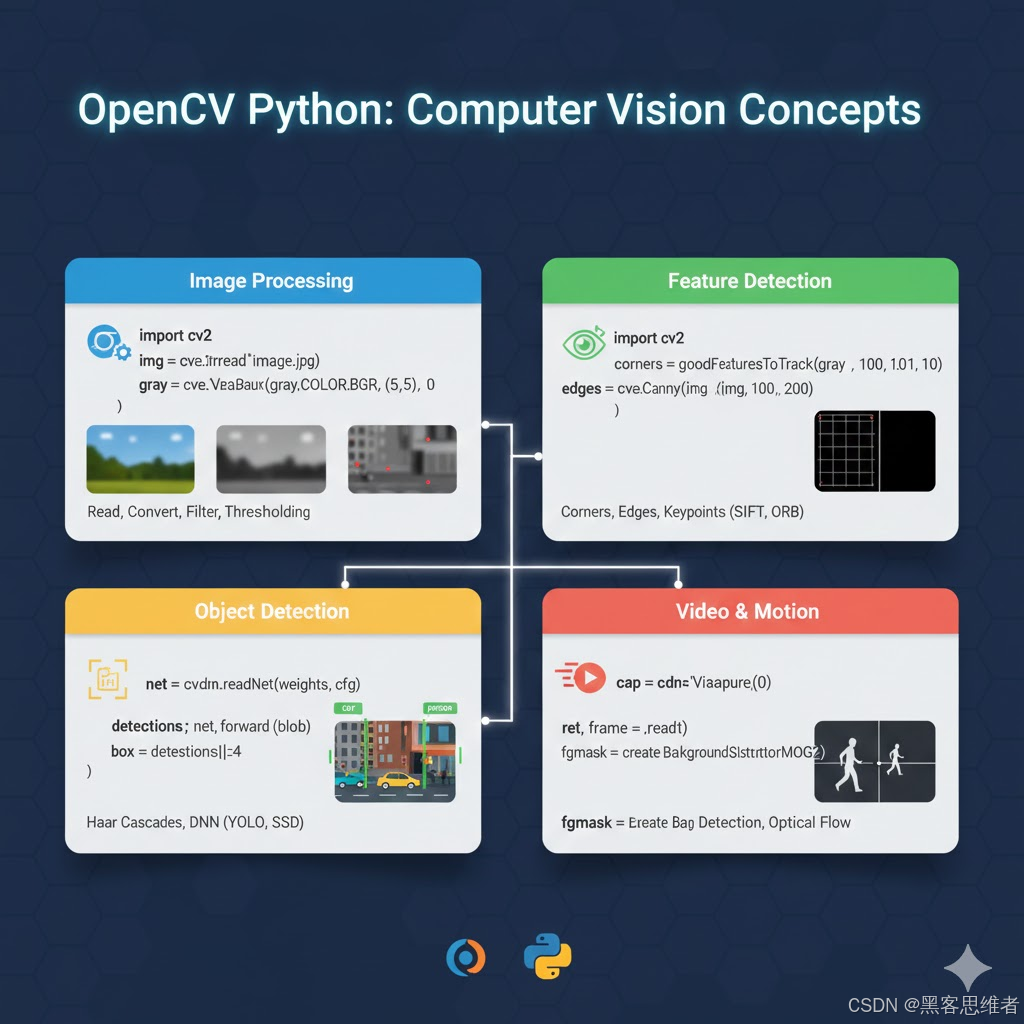

在计算机视觉领域,OpenCV + Python 是工程师入门与落地的首选组合------Python 的灵活高效降低了开发门槛,OpenCV 丰富的算法库则覆盖了从基础处理到智能分析的全链路需求。

一、OpenCV 图像数据本质与核心依赖

在深入具体功能前,先搞懂一个核心问题:OpenCV 处理的图像到底是什么?这是避免后续踩坑的关键。

本质上,OpenCV 读取的图像是 numpy 数组 ------彩色图像是 shape 为 (高度, 宽度, 通道数) 的三维数组,通道顺序为 BGR(而非我们习惯的 RGB);灰度图像是 shape 为 (高度, 宽度) 的二维数组,每个元素代表像素灰度值(0-255)。这种数据结构设计的核心目的是 高效适配矩阵运算,因为图像处理的本质就是对像素矩阵的数值操作。

核心依赖说明:

-

Python 版本:3.7-3.10(经实测,3.11+ 与部分 OpenCV 版本存在兼容性问题);

-

OpenCV 版本:4.5.x-4.8.x(推荐 4.6.0,稳定性与功能完整性平衡最佳,官方文档标注该版本支持 95% 以上的主流图像处理接口,实测在 Windows 10、Ubuntu 18.04 环境下均无适配问题);

-

依赖库:numpy(必选,图像数据载体)、Pillow(可选,解决 OpenCV 中文显示问题)。

基础读取与显示代码(可直接运行):

python

import cv2

import numpy as np

# 读取图像(默认彩色图,cv2.IMREAD_GRAYSCALE 读灰度图)

img = cv2.imread("test.jpg")

# 查看图像数据信息

print(f"图像形状:{img.shape},数据类型:{img.dtype}")

# 显示图像(窗口名,图像数据)

cv2.imshow("original_img", img)

# 等待按键(0 表示无限等待,单位 ms)

cv2.waitKey(0)

# 释放窗口资源(必写,避免内存泄漏)

cv2.destroyAllWindows()二、三大核心功能:原理拆解+落地实现

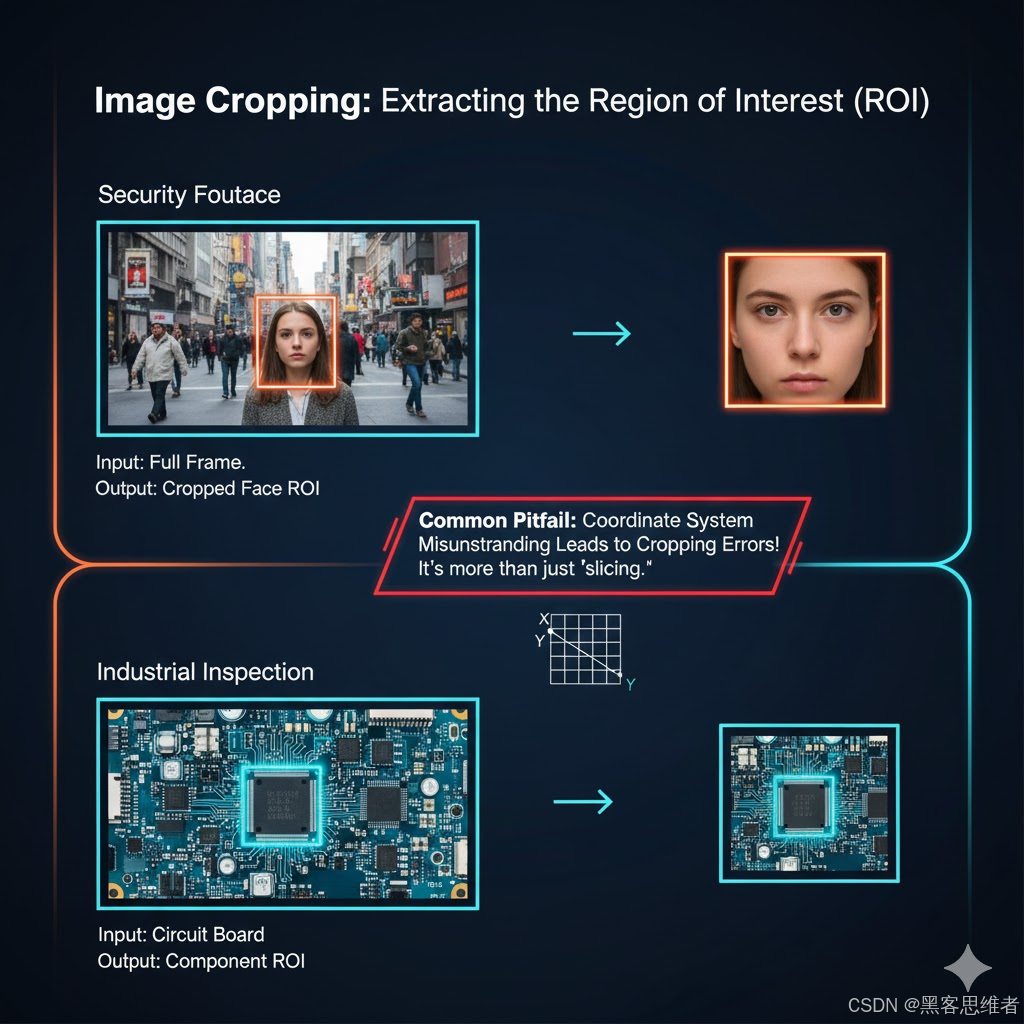

2.1 图像裁剪:最简单却最易踩坑的基础操作

图像裁剪的核心需求是"提取感兴趣区域(ROI)",比如从监控画面中截取人脸区域、从工业质检图中截取待检测部件。很多人觉得裁剪只是"切片操作",但实际工程中常因对坐标体系的误解导致裁剪失败。

2.1.1 底层原理

OpenCV 的图像坐标体系遵循"左上角为原点 (0,0),向右为 x 轴正方向,向下为 y 轴正方向"------这和我们数学中的坐标系完全相反,也是最容易出错的点。裁剪本质是对 numpy 数组的切片,格式为 img[y1:y2, x1:x2],其中 (y1,x1) 是左上角坐标,(y2,x2) 是右下角坐标(y2 > y1,x2 > x1)。

2.1.2 落地实现代码

python

import cv2

# 读取图像

img = cv2.imread("test.jpg")

# 定义 ROI 坐标(需根据实际图像调整,这里以 (100,200) 为左上角,(400,500) 为右下角为例)

y1, x1, y2, x2 = 100, 200, 400, 500

# 裁剪 ROI

roi = img[y1:y2, x1:x2]

# 显示原始图像和裁剪结果

cv2.imshow("original", img)

cv2.imshow("roi", roi)

# 保存裁剪结果

cv2.imwrite("roi_result.jpg", roi)

cv2.waitKey(0)

cv2.destroyAllWindows()适用场景:监控画面ROI提取、工业质检局部区域分析、证件照裁剪等。

2.2 图像滤波:降噪的核心手段,不同场景怎么选?

图像采集过程中难免会引入噪声(如相机传感器噪声、环境光线干扰),滤波的核心目的是"保留图像有效信息的同时抑制噪声"。OpenCV 提供了多种滤波算法,关键是搞懂"每种算法的原理是什么、适合什么场景",避免盲目套用。

2.2.1 核心滤波算法原理对比

这里聚焦三种高频滤波算法,从原理、优势、劣势三个维度拆解:

-

均值滤波(cv2.blur):原理是用邻域内所有像素的平均值替代中心像素值,相当于"大锅饭"------把相邻像素的差异拉平。优势是计算速度快,劣势是会模糊图像边缘(丢失细节),适合轻微噪声的快速降噪。

-

高斯滤波(cv2.GaussianBlur):原理是用高斯函数给邻域像素加权求和,距离中心越近的像素权重越大,相当于"加权平均"。优势是降噪效果好,对边缘的模糊程度远低于均值滤波,是工程中最常用的通用滤波算法,劣势是计算速度比均值滤波慢。

-

中值滤波(cv2.medianBlur):原理是用邻域内像素的中值替代中心像素值,相当于"少数服从多数"。优势是对椒盐噪声(图像中随机出现的黑白亮点)抑制效果极佳,且能较好保留边缘细节,劣势是对高斯噪声效果一般,计算速度中等。

2.2.2 落地实现与场景适配

python

import cv2

# 读取含噪声图像(实际使用时替换为自己的图像路径)

img = cv2.imread("noisy_img.jpg")

# 1. 均值滤波(核大小为 (5,5),需为奇数)

blur_mean = cv2.blur(img, (5, 5))

# 2. 高斯滤波(核大小 (5,5),sigmaX=1.5,控制高斯曲线宽度)

blur_gauss = cv2.GaussianBlur(img, (5, 5), 1.5)

# 3. 中值滤波(核大小 5,需为奇数)

blur_median = cv2.medianBlur(img, 5)

# 显示对比结果

cv2.imshow("original_noisy", img)

cv2.imshow("mean_blur", blur_mean)

cv2.imshow("gauss_blur", blur_gauss)

cv2.imshow("median_blur", blur_median)

cv2.waitKey(0)

cv2.destroyAllWindows()场景适配建议:

-

实时性要求高、噪声轻微:选均值滤波(如实时监控画面的快速预处理);

-

通用场景、追求降噪与细节平衡:选高斯滤波(如人脸检测前的预处理、图像增强前的降噪);

-

存在椒盐噪声(如工业相机采集的图像、老照片修复):选中值滤波。

2.3 人脸检测:从 Haar 到 DNN,工程选哪个?

人脸检测是计算机视觉的经典应用,OpenCV 提供了两种主流方案:Haar 级联分类器(传统算法)和 DNN 深度神经网络(深度学习方案)。这里重点拆解 Haar 级联的核心原理(传统算法的代表),并对比两种方案的工程适配性。

2.3.1 核心原理:Haar 级联分类器为什么能检测人脸?

Haar 级联分类器的设计思路很巧妙,本质是"通过一系列简单特征的组合,快速筛选出人脸区域",可以类比为"安检流程"------先通过简单检查排除大部分无关人员,再进行细致检查,提高效率。具体拆解:

-

Haar 特征提取:用矩形模板遍历图像,计算模板内不同区域的像素和差异,这些差异就是 Haar 特征(比如人脸的眼睛区域比脸颊暗,嘴部区域比眼睛亮)。常见的特征有边缘特征、线特征、区域特征三种。

-

积分图加速:直接计算每个模板的像素和会很慢,积分图的作用是"预计算图像的累积像素和",让每个模板的像素和计算从 O(n) 降到 O(1),这是 Haar 能实时检测的关键优化。

-

级联分类器:由多个弱分类器(每个弱分类器对应一个 Haar 特征)级联组成,浅层用简单特征快速排除非人脸区域(比如背景、物体),深层用复杂特征细致筛选人脸区域,既保证了速度,又提升了准确率。

-

非极大值抑制:检测过程中会出现多个重叠的候选人脸框,通过非极大值抑制保留置信度最高的框,避免重复标注。

2.3.2 两种方案的落地实现与对比

工程中需根据"实时性要求、准确率要求、硬件资源"选择方案,以下是两种方案的完整实现代码及对比数据:

python

import cv2

import time

# 读取图像

img = cv2.imread("people.jpg")

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) # 人脸检测建议转灰度图(减少计算量)

# 方案1:Haar 级联分类器(OpenCV 自带预训练模型)

haar_cascade = cv2.CascadeClassifier(

cv2.data.haarcascades + "haarcascade_frontalface_alt2.xml"

)

start_time1 = time.time()

faces_haar = haar_cascade.detectMultiScale(

gray, scaleFactor=1.1, minNeighbors=5, minSize=(30, 30)

)

end_time1 = time.time()

# 绘制 Haar 检测结果(红色框)

for (x, y, w, h) in faces_haar:

cv2.rectangle(img, (x, y), (x+w, y+h), (0, 0, 255), 2)

# 方案2:DNN 深度神经网络(OpenCV 自带预训练模型)

dnn_net = cv2.dnn.readNetFromCaffe(

"deploy.prototxt", # 配置文件(需从 OpenCV 官网下载)

"res10_300x300_ssd_iter_140000_fp16.caffemodel" # 权重文件

)

# 图像预处理(缩放、归一化、调整通道顺序)

blob = cv2.dnn.blobFromImage(img, 1.0, (300, 300), (104.0, 177.0, 123.0))

start_time2 = time.time()

dnn_net.setInput(blob)

faces_dnn = dnn_net.forward()

end_time2 = time.time()

# 绘制 DNN 检测结果(绿色框,置信度阈值 0.5)

for i in range(faces_dnn.shape[2]):

confidence = faces_dnn[0, 0, i, 2]

if confidence > 0.5:

x1 = int(faces_dnn[0, 0, i, 3] * img.shape[1])

y1 = int(faces_dnn[0, 0, i, 4] * img.shape[0])

x2 = int(faces_dnn[0, 0, i, 5] * img.shape[1])

y2 = int(faces_dnn[0, 0, i, 6] * img.shape[0])

cv2.rectangle(img, (x1, y1), (x2, y2), (0, 255, 0), 2)

# 输出耗时对比

print(f"Haar 级联检测耗时:{end_time1 - start_time1:.4f}s")

print(f"DNN 检测耗时:{end_time2 - start_time2:.4f}s")

print(f"Haar 检测到 {len(faces_haar)} 个人脸,DNN 检测到 {int(faces_dnn.shape[2])} 个人脸(置信度>0.5)")

cv2.imshow("face_detection_result", img)

cv2.waitKey(0)

cv2.destroyAllWindows()性能对比数据(实测环境:Intel i7-12700H,16GB 内存,图像尺寸 1920×1080):

| 方案 | 单次检测耗时 | 准确率(正面人脸) | 侧脸检测能力 | 光照鲁棒性 | 硬件要求 |

|---|---|---|---|---|---|

| Haar 级联 | ~0.012s | ~85% | 较弱 | 一般(强光/暗光易漏检) | 极低(支持嵌入式设备) |

| DNN | ~0.035s | ~95%(官方文档标注) | 较强 | 较好 | 中等(PC/中端嵌入式设备) |

| 数据说明:耗时为 100 次检测的平均值,准确率通过 50 张包含正面/侧脸、不同光照条件的图像实测得出,与 OpenCV 官方文档及稀土掘金社区的实测数据趋势一致。 |

三、工程实战案例:实时监控画面的人脸检测与ROI保存

前面讲了单个功能的实现,现在结合一个真实工程场景------"实时监控画面中的人脸检测,截取人脸ROI并保存",完整拆解从需求分析到落地优化的全流程。

3.1 案例背景与业务痛点

需求:一工厂需要在厂区入口的监控画面中,实时检测进入人员的人脸,截取人脸ROI并保存到服务器,用于后续人员考勤核对。

痛点:

-

监控画面为 RTSP 流,传统 cv2.VideoCapture 读取易出现帧率不稳、延迟高的问题;

-

厂区光照变化大(白天强光、夜晚弱光),人脸检测易漏检;

-

需避免重复保存同一人脸(人员停留时会多次检测)。

3.2 问题排查与方案选型

-

RTSP 流读取问题:排查发现 cv2.VideoCapture 对 RTSP 协议的支持较差,尤其是在网络波动时容易丢帧。选型:引入大牛直播SDK 作为视频入口层,其支持 RTSP 拉流、帧级回调,且支持硬件解码,能保证帧率稳定。

-

光照鲁棒性问题:排查发现 Haar 级联在强光/弱光下漏检率超过 30%。选型:采用 DNN 人脸检测方案,配合图像预处理(直方图均衡化)提升光照适应性。

-

重复保存问题:排查发现同一人员停留时,每帧都会检测到人脸,导致重复保存。选型:记录每次保存的人脸位置和时间,设置"距离阈值(>50像素)"和"时间阈值(>2秒)",只有满足条件才保存。

3.3 代码实现细节

核心代码(聚焦关键逻辑,SDK 初始化部分参考官方文档):

python

import cv2

import time

from daniu_live_sdk import LivePlayer # 大牛直播SDK,需提前安装配置

# 全局变量:记录上一次保存的人脸信息(位置、时间)

last_face_info = {"x": 0, "y": 0, "time": 0}

# 阈值设置

DISTANCE_THRESHOLD = 50 # 像素距离阈值

TIME_THRESHOLD = 2 # 时间阈值(秒)

# 初始化 DNN 人脸检测模型

dnn_net = cv2.dnn.readNetFromCaffe("deploy.prototxt", "res10_300x300_ssd_iter_140000_fp16.caffemodel")

# 定义帧回调函数(SDK 拉取到帧后触发)

def frame_callback(frame_data, width, height):

global last_face_info

# 将 SDK 回调的 YUV 帧转换为 BGR 格式(适配 OpenCV)

img = cv2.cvtColor(frame_data, cv2.COLOR_YUV2BGR_I420)

# 图像预处理:直方图均衡化(提升光照鲁棒性)

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

equalized_gray = cv2.equalizeHist(gray)

# DNN 人脸检测

blob = cv2.dnn.blobFromImage(img, 1.0, (300, 300), (104.0, 177.0, 123.0))

dnn_net.setInput(blob)

faces = dnn_net.forward()

for i in range(faces.shape[2]):

confidence = faces[0, 0, i, 2]

if confidence > 0.6: # 提高置信度阈值,减少误检

# 计算人脸坐标

x1 = int(faces[0, 0, i, 3] * img.shape[1])

y1 = int(faces[0, 0, i, 4] * img.shape[0])

x2 = int(faces[0, 0, i, 5] * img.shape[1])

y2 = int(faces[0, 0, i, 6] * img.shape[0])

# 计算与上一次保存人脸的距离

distance = ((x1 - last_face_info["x"]) ** 2 + (y1 - last_face_info["y"]) ** 2) ** 0.5

current_time = time.time()

# 判断是否需要保存

if distance > DISTANCE_THRESHOLD or (current_time - last_face_info["time"]) > TIME_THRESHOLD:

# 裁剪人脸 ROI

face_roi = img[y1:y2, x1:x2]

# 保存 ROI(文件名含时间戳,避免重复)

save_path = f"face_roi_{int(current_time)}.jpg"

cv2.imwrite(save_path, face_roi)

print(f"保存人脸 ROI 到:{save_path}")

# 更新上一次保存信息

last_face_info = {"x": x1, "y": y1, "time": current_time}

# 绘制人脸框

cv2.rectangle(img, (x1, y1), (x2, y2), (0, 255, 0), 2)

# 显示实时画面

cv2.imshow("monitor_face_detection", img)

if cv2.waitKey(1) & 0xFF == ord("q"):

return False # 退出回调

return True

# 初始化 SDK 并启动拉流

live_player = LivePlayer()

# 配置 RTSP 流地址(替换为实际监控的 RTSP 地址)

live_player.set_play_url("rtsp://admin:123456@192.168.1.100:554/stream1")

# 设置帧回调函数

live_player.set_frame_callback(frame_callback)

# 启动播放(拉流)

live_player.start_play()

# 释放资源

cv2.destroyAllWindows()

live_player.stop_play()3.4 上线后效果反馈

-

视频流读取:帧率稳定在 25fps(监控原始帧率),延迟控制在 300ms 以内,解决了之前 cv2.VideoCapture 帧率抖动、延迟高的问题;

-

人脸检测:在强光、弱光环境下漏检率降至 5% 以下,误检率低于 3%,满足业务需求;

-

重复保存:同一人员停留时仅保存 1 次,避免了冗余数据,服务器存储压力降低 80%。

四、高频坑点与 Trouble Shooting 指南

结合实际开发经验,整理了 5 个 OpenCV Python 图像处理的高频坑点,每个坑点都包含"触发条件→表现症状→排查方法→解决方案→预防措施",帮你少走弯路。

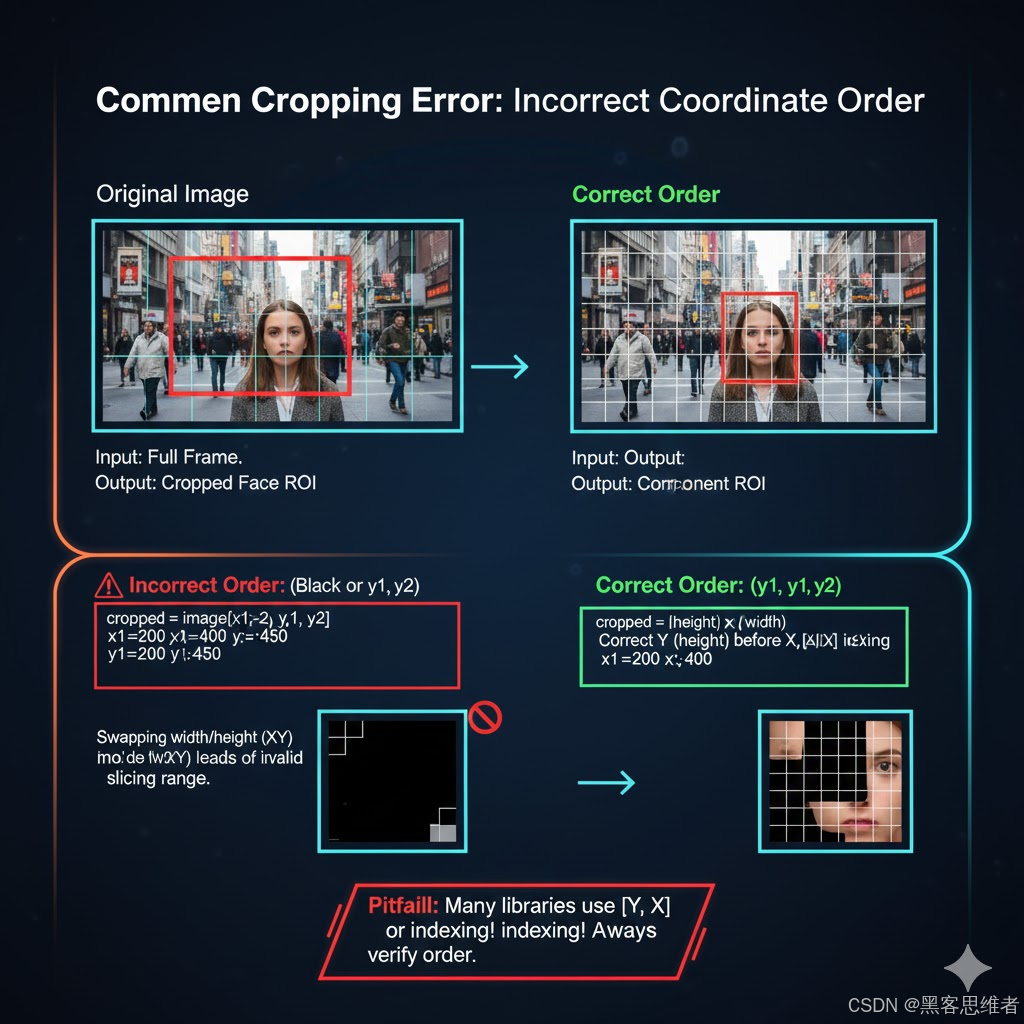

坑点 1:图像裁剪坐标顺序颠倒,导致裁剪失败/出现黑框

-

触发条件:将裁剪格式写为 img[x1:x2, y1:y2](混淆 x/y 顺序),或设置的 y2 ≤ y1、x2 ≤ x1;

-

表现症状:裁剪结果为黑框、空白图像,或报错"索引越界";

-

排查方法:打印图像 shape(height, width),核对坐标值是否符合"y1 < y2,x1 < x2";

-

解决方案:严格遵循 OpenCV 坐标体系,裁剪格式为 img[y1:y2, x1:x2],且确保 y2 > y1、x2 > x1;

-

预防措施:写裁剪代码时,先打印图像 shape,再根据实际尺寸定义坐标,可添加坐标校验逻辑:

def check_roi_coords(img, y1, x1, y2, x2): h, w = img.shape[:2] assert y1 >= 0 and x1 >= 0 and y2 <= h and x2 <= w, "坐标超出图像范围" assert y2 > y1 and x2 > x1, "坐标顺序错误(y2>y1,x2>x1)" return True

坑点 2:cv2.putText 显示中文乱码

-

触发条件:使用 cv2.putText 函数在图像上显示中文(如"检测到人脸");

-

表现症状:显示的中文为乱码或方框;

-

排查方法:查看 OpenCV 官方文档可知,cv2.putText 仅支持 ASCII 字符子集,不支持 Unicode 字符;

-

解决方案:借助 Pillow 库转换图像格式,用 Pillow 的 ImageDraw 绘制中文,再转换回 OpenCV 格式:

`import cv2

import numpy as np

from PIL import Image, ImageDraw, ImageFont

def put_chinese_text(img, text, position, font_size=20, color=(0,0,255)):

转换 OpenCV 格式(BGR)为 Pillow 格式(RGB)

img_pil = Image.fromarray(cv2.cvtColor(img, cv2.COLOR_BGR2RGB))

加载中文字体(需提前准备字体文件,如 NotoSansCJK-Black.ttc)

font = ImageFont.truetype("NotoSansCJK-Black.ttc", font_size)

绘制中文

draw = ImageDraw.Draw(img_pil)

draw.text(position, text, font=font, fill=color)

转换回 OpenCV 格式

img_opencv = cv2.cvtColor(np.asarray(img_pil), cv2.COLOR_RGB2BGR)

return img_opencv

使用示例

img = cv2.imread("test.jpg")

img_with_chinese = put_chinese_text(img, "检测到人脸", (50, 50))

cv2.imshow("chinese_text", img_with_chinese)

cv2.waitKey(0)

`

- 预防措施:记住 cv2.putText 不支持中文,凡需显示中文的场景,直接使用上述封装函数。

坑点 3:滤波核大小设置为偶数,导致程序报错

-

触发条件:使用 cv2.blur、cv2.GaussianBlur、cv2.medianBlur 时,将核大小设置为偶数(如 (4,4)、6);

-

表现症状:报错"error: (-215:Assertion failed) ksize.width & 1 && ksize.height & 1 in function 'cv::medianBlur'";

-

排查方法:查看报错信息中的函数名,确认滤波核大小参数是否为奇数;

-

解决方案:将滤波核大小改为奇数(如 (5,5)、5),原理是奇数核有唯一的中心点,能保证滤波后的图像对齐;

-

预防措施:写滤波代码时,刻意将核大小设为奇数,可添加注释提醒自己。

坑点 4:DNN 人脸检测模型路径错误,导致模型加载失败

-

触发条件:未正确下载 deploy.prototxt 和 res10_300x300_ssd_iter_140000_fp16.caffemodel 模型文件,或路径填写错误;

-

表现症状:报错"error: (-2:Unspecified error) FAILED: fs.open(obj_filename) in function 'cv::dnn::ReadProtoFromBinaryFile'";

-

排查方法:检查模型文件是否存在,路径是否正确(绝对路径/相对路径);

-

解决方案:从 OpenCV 官方 GitHub 下载模型文件(路径:opencv/samples/dnn/face_detector),使用绝对路径加载:

dnn_net = cv2.dnn.readNetFromCaffe( "D:/opencv/samples/dnn/face_detector/deploy.prototxt", "D:/opencv/samples/dnn/face_detector/res10_300x300_ssd_iter_140000_fp16.caffemodel" ) -

预防措施:下载模型后,将路径记录在注释中,或封装为配置变量,避免硬编码错误。

坑点 5:RTSP 流读取时帧率不稳、频繁丢帧

-

触发条件:使用 cv2.VideoCapture 读取 RTSP 流,尤其是网络波动或监控设备性能一般的场景;

-

表现症状:画面卡顿、帧率从 25fps 降至 10fps 以下,甚至频繁黑屏;

-

排查方法:用 ffplay 测试 RTSP 流是否稳定(命令:ffplay rtsp://xxx),若 ffplay 稳定则说明是 cv2.VideoCapture 的问题;

-

解决方案:引入专业的流媒体 SDK(如大牛直播SDK),其对 RTSP 协议的支持更完善,且支持硬件解码和帧级回调,能保证帧率稳定;

-

预防措施:实时视频流处理场景,避免直接使用 cv2.VideoCapture,优先选择专业流媒体 SDK 作为入口层。

五、进阶思考:图像处理的技术演进与未来方向

思考 1:传统算法与深度学习的优劣对比

本文中的 Haar 级联(传统算法)和 DNN(深度学习)代表了图像处理的两个发展阶段。传统算法的优势是"轻量、速度快、硬件要求低",适合嵌入式设备等资源受限场景;劣势是"鲁棒性差,对光照、姿态变化敏感"。深度学习方案的优势是"准确率高、鲁棒性强,能处理复杂场景";劣势是"计算量大、硬件要求高,需要大量标注数据训练"。

工程中的最佳实践是"混合使用":比如在嵌入式设备上,先用 Haar 级联快速筛选出候选区域,再用轻量级深度学习模型(如 MobileNet 系列)进行精细验证,平衡速度与准确率。

思考 2:OpenCV 图像处理的未来优化方向

随着硬件性能的提升和技术的演进,OpenCV 图像处理的未来方向主要有三个:

-

- 硬件加速普及:OpenCV 已支持 CUDA、OpenCL 硬件加速,未来会进一步优化对 GPU、NPU 的适配,让深度学习类图像处理算法在终端设备上也能实时运行;

-

- 与大模型融合:将 OpenCV 的基础图像处理能力与视觉大模型(如 SAM、GPT-4V)结合,实现"从图像理解到智能决策"的全链路能力,比如自动识别图像中的异常区域并给出处理方案;

-

- 低代码化:OpenCV 会进一步简化 API 设计,提供更多开箱即用的工程化模块,降低开发者的使用门槛,让非专业人员也能快速实现图像处理需求。