一、大文件上传的挑战

传统上传方式存在三大痛点:

- 传输中断风险:网络波动导致整个上传失败

- 服务端限制:通常限制在2-10MB范围

- 用户体验差:大文件上传耗时过长,无法显示进度

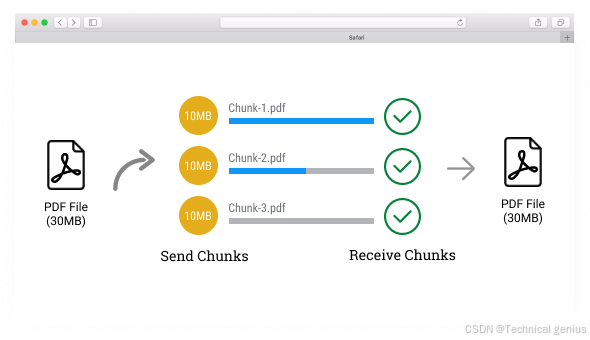

二、分片上传核心原理

2.1 技术实现

html

graph LR

A[大文件] --> B(分片切割)

B --> C{并行上传}

C --> D[服务端合并]

D --> E[完整文件]2.2 关键技术点

- 分片切割:将文件按固定大小(如5MB)分割

- 唯一标识:通过文件hash值(MD5/SHA1)识别文件

- 断点续传:记录已上传分片索引

- 并发控制:合理控制并行上传线程数

三、Vue3 实现方案

3.1 安装依赖

javascript

npm install spark-md5 axios3.2 核心组件实现

javascript

<template>

<div>

<input type="file" @change="handleFileSelect" />

<div v-if="progress > 0">

上传进度: {{ progress }}%

<div class="progress-bar">

<div class="progress" :style="{ width: progress + '%' }"></div>

</div>

</div>

</div>

</template>

<script setup>

import { ref } from 'vue'

import SparkMD5 from 'spark-md5'

import axios from 'axios'

const progress = ref(0)

const file = ref(null)

const handleFileSelect = async (e) => {

const file = e.target.files

if (!file) return

// 计算文件hash

const reader = new FileReader()

reader.onload = (e) => {

const spark = new SparkMD5.ArrayBuffer()

spark.append(e.target.result)

const hash = spark.end()

console.log('File hash:', hash)

}

reader.readAsArrayBuffer(file)

// 分片上传逻辑

const chunkSize = 5 * 1024 * 1024 // 5MB

const chunks = Math.ceil(file.size / chunkSize)

for (let i = 0; i < chunks; i++) {

const start = i * chunkSize

const end = Math.min(start + chunkSize, file.size)

const chunk = file.slice(start, end)

await uploadChunk(chunk, i, chunks)

progress.value = Math.round((i + 1) / chunks * 100)

}

}

const uploadChunk = async (chunk, index, total) => {

const formData = new FormData()

formData.append('chunk', chunk)

formData.append('index', index)

formData.append('total', total)

formData.append('filename', file.value.name)

try {

await axios.post('/api/upload-chunk', formData, {

headers: {

'Content-Type': 'multipart/form-data'

}

})

console.log(`Chunk ${index + 1}/${total} uploaded`)

} catch (error) {

console.error('Chunk upload failed:', error)

}

}

</script>3.3 进阶功能实现

1. 断点续传

javascript

// 在服务端记录已上传分片

const uploadedChunks = ref(new Set())

const uploadChunk = async (chunk, index, total) => {

if (uploadedChunks.value.has(index)) {

console.log(`Skipping already uploaded chunk ${index}`)

return

}

// ...上传逻辑...

uploadedChunks.value.add(index)

}2. 秒传验证

java

const checkInstantUpload = async (file) => {

const response = await axios.get('/api/check-file', {

params: {

filename: file.name,

size: file.size

}

})

if (response.data.exists) {

console.log('File already exists on server')

return true

}

return false

}3. 进度计算优化

javascript

// 使用Web Workers计算MD5

const calculateMD5 = (file) => {

return new Promise((resolve) => {

const worker = new Worker(new URL('./md5-worker.js', import.meta.url))

worker.onmessage = (e) => resolve(e.data)

worker.postMessage(file)

})

}四、Node.js 服务端实现

4.1 分片接收

javascript

const express = require('express')

const multer = require('multer')

const path = require('path')

const app = express()

const upload = multer({ dest: 'uploads/' })

app.post('/api/upload-chunk', upload.single('chunk'), (req, res) => {

const { index, total, filename } = req.body

// 保存分片到临时文件

const chunkPath = path.join('uploads', `${filename}.part${index}`)

fs.writeFileSync(chunkPath, req.file.buffer)

res.send({ success: true })

})

app.post('/api/merge-chunks', (req, res) => {

const { filename } = req.body

// 合并分片

const chunks = []

for (let i = 0; i < Math.ceil(req.body.size / 5e6); i++) {

chunks.push(fs.readFileSync(`uploads/${filename}.part${i}`))

}

fs.writeFileSync(`uploads/${filename}`, Buffer.concat(chunks))

// 清理临时文件

for (let i = 0; i < Math.ceil(req.body.size / 5e6); i++) {

fs.unlinkSync(`uploads/${filename}.part${i}`)

}

res.send({ success: true, url: `/uploads/${filename}` })

})4.2 数据库设计

javascript

const fileSchema = new Schema({

filename: String,

size: Number,

chunks: Number,

uploaded: Number,

hash: String,

createdAt: { type: Date, default: Date.now }

})五、性能优化技巧

5.1 前端优化

- 分片大小动态调整:根据网络状况自动调整分片大小

- 并发控制:限制同时上传的分片数量(建议3-5个)

- 压缩分片:对图片/视频分片进行压缩处理

5.2 服务端优化

- 内存管理:使用流式处理避免内存溢出

- 断点续传存储:使用数据库记录上传状态

- CDN加速:将合并后的文件自动上传到CDN

六、常见问题解决方案

6.1 分片乱序问题

javascript

// 服务端实现分片排序

const sortedChunks = Array.from({ length: totalChunks }, (_, i) => i)

.map(i => ({ index: i, path: `uploads/${filename}.part${i}` }))

.sort((a, b) => a.index - b.index)6.2 浏览器兼容性

javascript

// 检测浏览器支持情况

if (!window.FileReader || !window.Blob) {

console.error('Current browser does not support required features')

}6.3 安全防护

- 文件类型验证:检查MIME类型和文件扩展名

- 大小限制:前端和后端双重验证

- 病毒扫描:集成ClamAV等杀毒软件

七、总结与最佳实践

7.1 实施建议

- 对于小于10MB的文件,使用普通上传

- 10-100MB文件采用分片上传

- 超过100MB文件建议增加进度显示和暂停功能

7.2 监控指标

- 上传成功率

- 平均上传速度

- 断点续传频率

- 用户取消率

7.3 未来趋势

- WebAssembly加速分片计算

- WebRTC实现P2P传输

- 区块链技术确保文件完整性

通过本文的完整实现方案,开发者可以构建出稳定高效的大文件上传系统,显著提升用户体验。实际部署时建议根据具体业务需求调整分片大小和并发策略,并通过压力测试找到最佳配置。