前言:大模型选型的"隐形成本"

当你打开第17个大模型官网,对着"128K上下文""0.01元/千Token"的参数表陷入迷茫时,或许已经踩中了AI开发的第一个坑:选型失误的成本,远高于技术开发本身 **。2025年,国内大模型服务供应商已超20家,模型数量突破230个。开发者常因"免费模型延迟过高""付费服务吞吐量不达标"被迫重构系统------而这一切,本可以通过科学的性能评测**避免。

AI Ping,这个被称为"大模型服务界大众点评"的平台,正是为解决这一痛点而生。它以7×24小时的实时监测、全维度的性能指标,让开发者从"盲选模型"转向"数据驱动的精准匹配"。

目录

一、AI Ping:大模型服务的"性能透视镜"

官方链接入口:【点击进入】

本平台面对所有开发者免费使用,并免费送30算例金供大家使用更多大模型

1.1 平台定位:从"评测工具"到"决策中枢"

AI Ping是清华系团队打造的大模型****服务性能评测与选型平台,核心定位是"用数据消除大模型选型的信息差"。它并非直接提供AI服务,而是通过整合20+供应商、400+模型服务,输出延迟、吞吐、成本等12项核心指标,成为开发者的"性能罗盘"。

1.2 核心功能:三大模块构建选型闭环

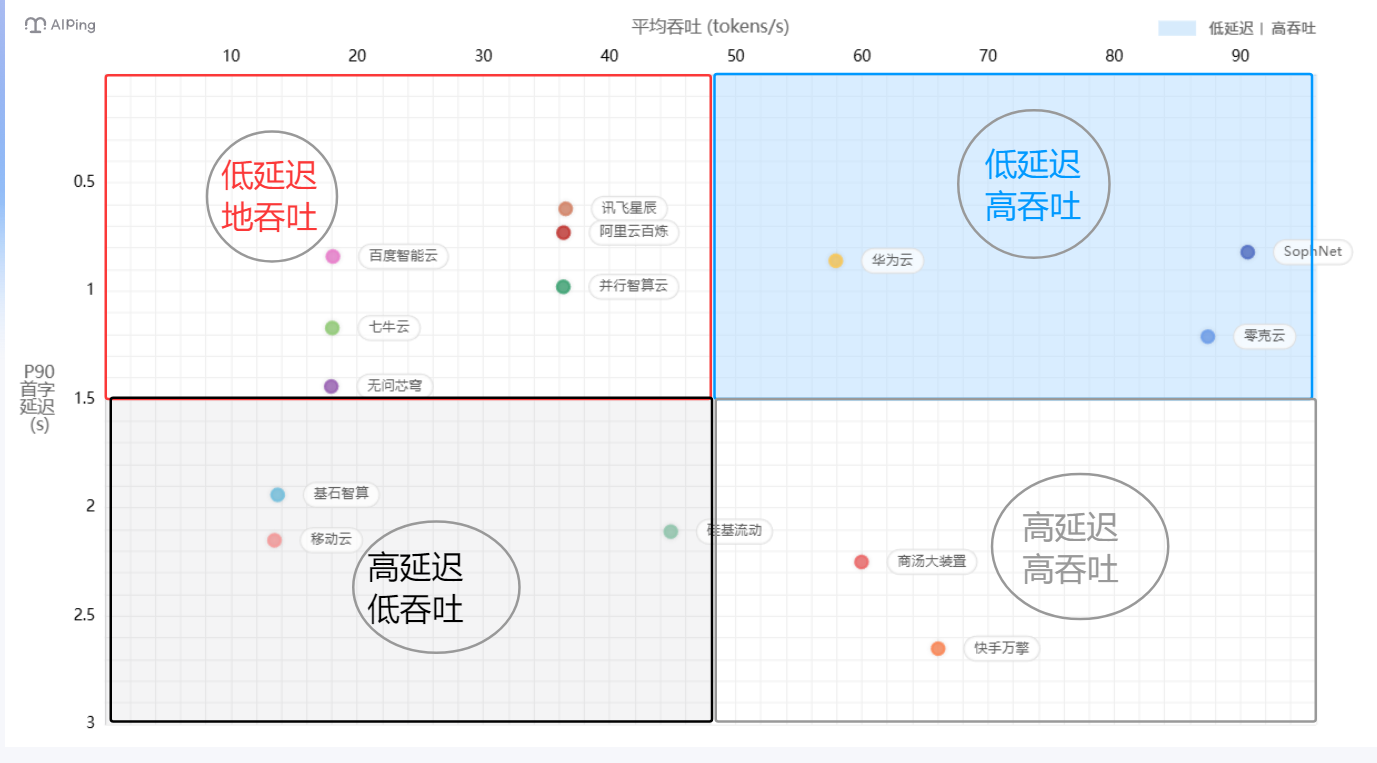

- 性能榜单:以"吞吐-延迟"二维坐标图呈现模型实时表现,标注"低延迟+高吞吐"的理想区域;

- 模型详情库:收录每个模型的上下文长度、输入/输出成本、最大输出长度等参数;

- 智能对比工具:支持多模型指标横向对比,自动生成TCO(总拥有成本)分析报告。

我们可通过如下性能坐标图查看各种模型的吞吐表现:

1.3 智能路由:静态配置到动态优化

- 传统困境

- 供应商选择依赖经验,无法实时响应性能变化

- 固定绑定单一供应商,缺乏灵活性

- 人工切换成本高,响应速度慢

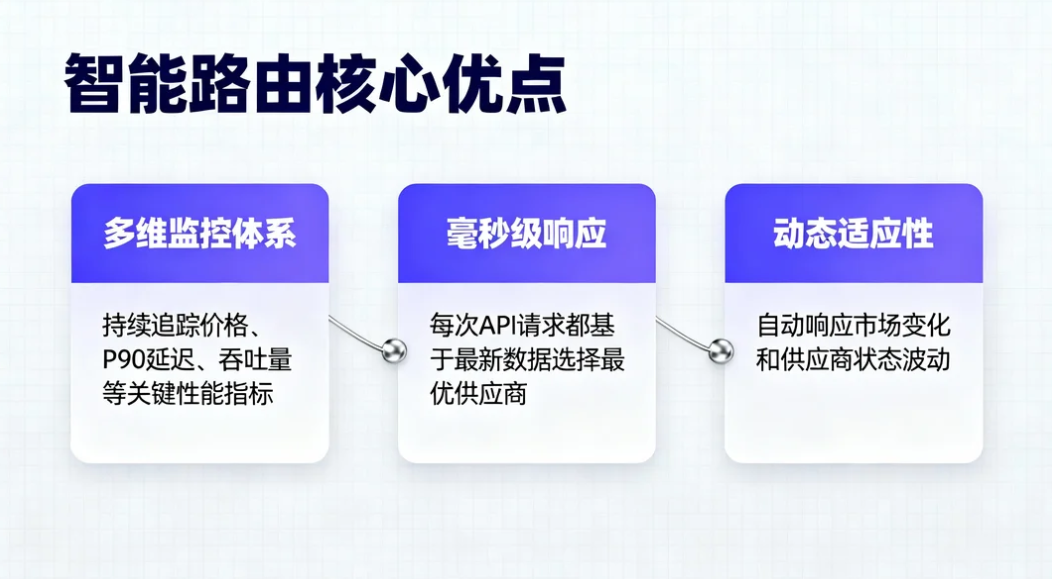

- 智能路由---数据驱动的实时决策

- 多维监控体系:持续追踪价格、P90延迟、吞吐量等关键性能指

- 毫秒级响应:每次API请求都基于最新数据选择最优供应商

- 动态适应性:自动响应市场变化和供应商状态波动

总而言之,智能路由技术的兴起,标志着AI服务消费模式从"选择供应商" 到"选择最优能力" 的根本转变。它不仅仅是技术工具的升级,更是整个行业思维模式的变革。 智能路由正在这条正确的道路上稳步前行,为构建更加智能、高效、普惠的AI应用生态奠定坚实基础。

二、AI Ping的核心优势:让选型"有理有据"

2.1 中立性:数据驱动,拒绝"厂商滤镜"

AI Ping的评测数据由清华大学与中国软件评测中心联合提供,通过自动化压力测试(模拟10万级QPS场景)、长周期监测(7×24小时)确保客观性------你不会看到"收推广费只夸优点"的测评,只会看到某模型"上下文超2000Token后延迟陡增300%"的真实数据。

2.2 全维度:12项指标覆盖业务全场景

相比传统评测仅关注"生成质量",AI Ping的指标体系直击开发痛点:

| 核心维度 | 关键指标 | 业务价值 |

|---|---|---|

| 性能表现 | P90首字延迟、平均吞吐 | 决定实时交互/批量任务的体验 |

| 成本控制 | 输入/输出Token单价 | 避免"小业务用出大账单" |

| 场景适配 | 上下文长度、最大输出长度 | 匹配长文本处理/代码生成需求 |

| 稳定性 | 7日性能波动曲线 | 规避高峰期服务"掉链子" |

2.3 低门槛:零部署,网页端直接用

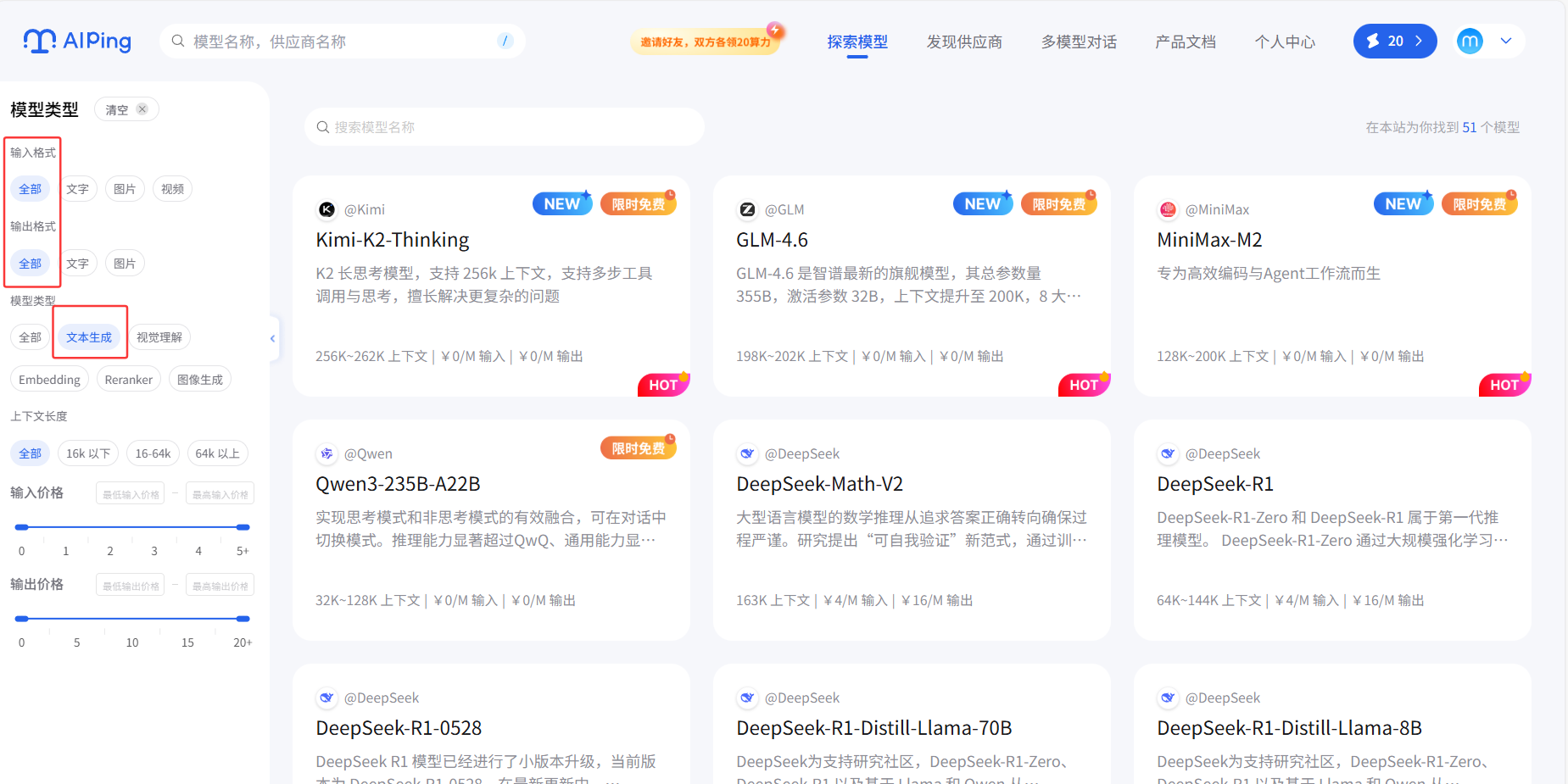

无需安装任何工具,打开【aiping.cn】即可查看所有公开数据:选择关键词,比如文本生成,平台会自动筛选出Kimi、千问,DeepSeek等相关模型。

三、精准匹配:如何用AI Ping找到"你的模型"

3.1 第一步:明确业务场景的核心诉求

首先得明确我们自己的任务需求,入以下不同场景的指标优先级截然不同:

- 实时交互(如智能客服):优先选"延迟≤0.8s"的模型(如并行智算云的DeepSeek);

- 批量处理(如文本摘要):优先选"吞吐≥35 tokens/s"的服务(如阿里云百炼);

- 长文本任务(如文档分析):优先选"上下文≥128K"的模型(如百度智能云ERNIE)。

3.2 第二步:用"性能坐标图"缩小范围

AI Ping的"吞吐-延迟"坐标图中,每个数据点代表一个模型服务:

| 区域位置 | 性能特征(延迟+吞吐) | 适用场景 |

|---|---|---|

| 右上区域 | 低延迟 + 高吞吐 | 实时对话、高并发交互等核心场景("全能优选") |

| 左上区域 | 低延迟 + 低吞吐 | 轻量、对处理速度要求不高的场景 |

| 右下区域 | 高延迟 + 高吞吐 | 批量数据处理、非实时推理等场景 |

| 左下区域 | 高延迟 + 低吞吐 | 尽量避开(体验差+效率低) |

3.3 第三步:用"成本模拟器"做最终决策

输入"每日调用10万次,每次输出2000Token",AI Ping会自动计算不同模型的月度成本:

- 免费模型(如MiniMax-M2):月度成本约500元,但延迟波动大;

- 付费模型(如GLM-4.6):月度成本约1200元,但稳定性提升80%。

四、实战:基于AI Ping的API配置全流程

以GLM-4.6模型为例接入它的API进行测试模型为例,演示从选型到调用的步骤:

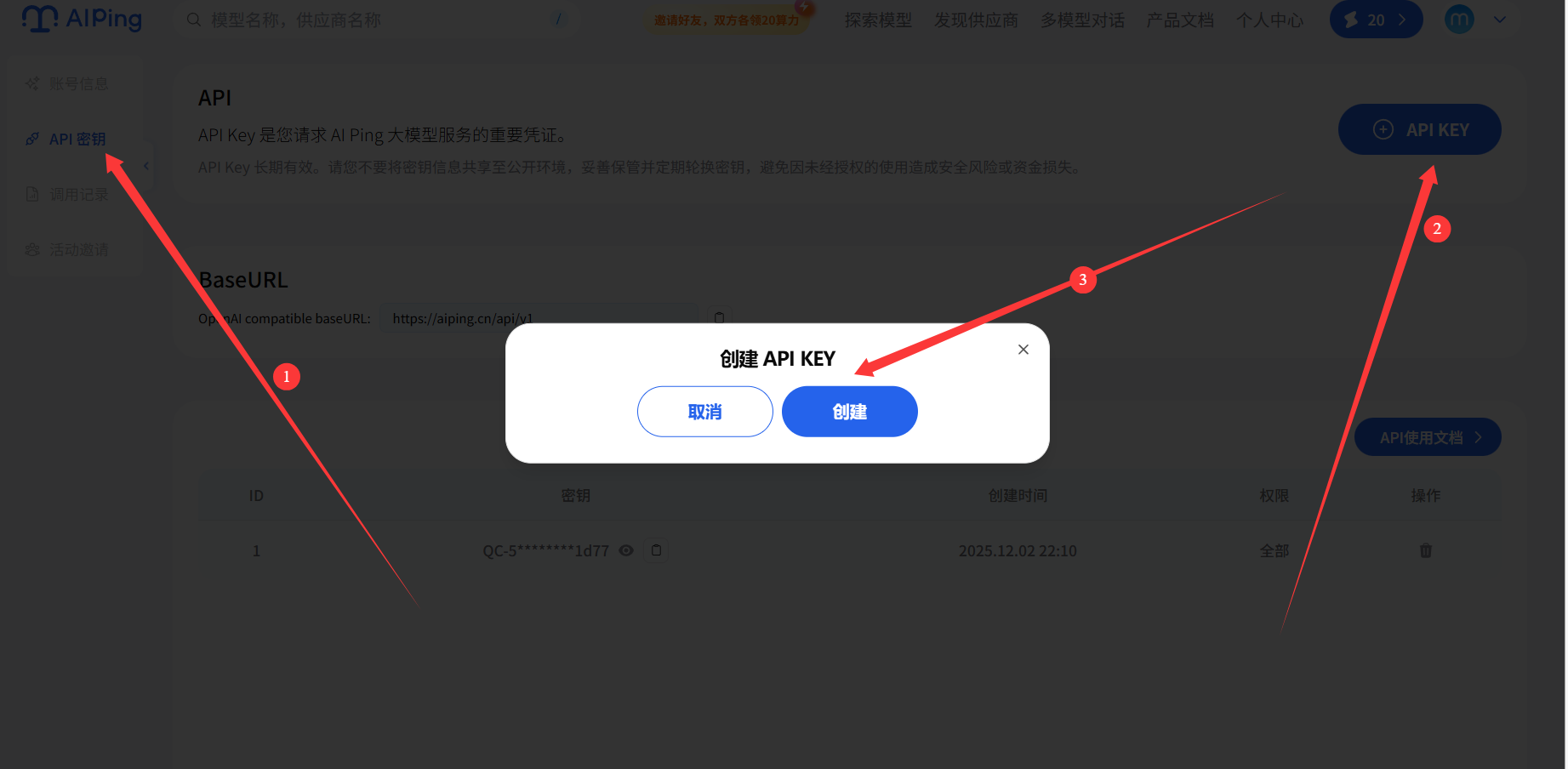

4.1 步骤1:创建API密钥

创建之后如图所示:

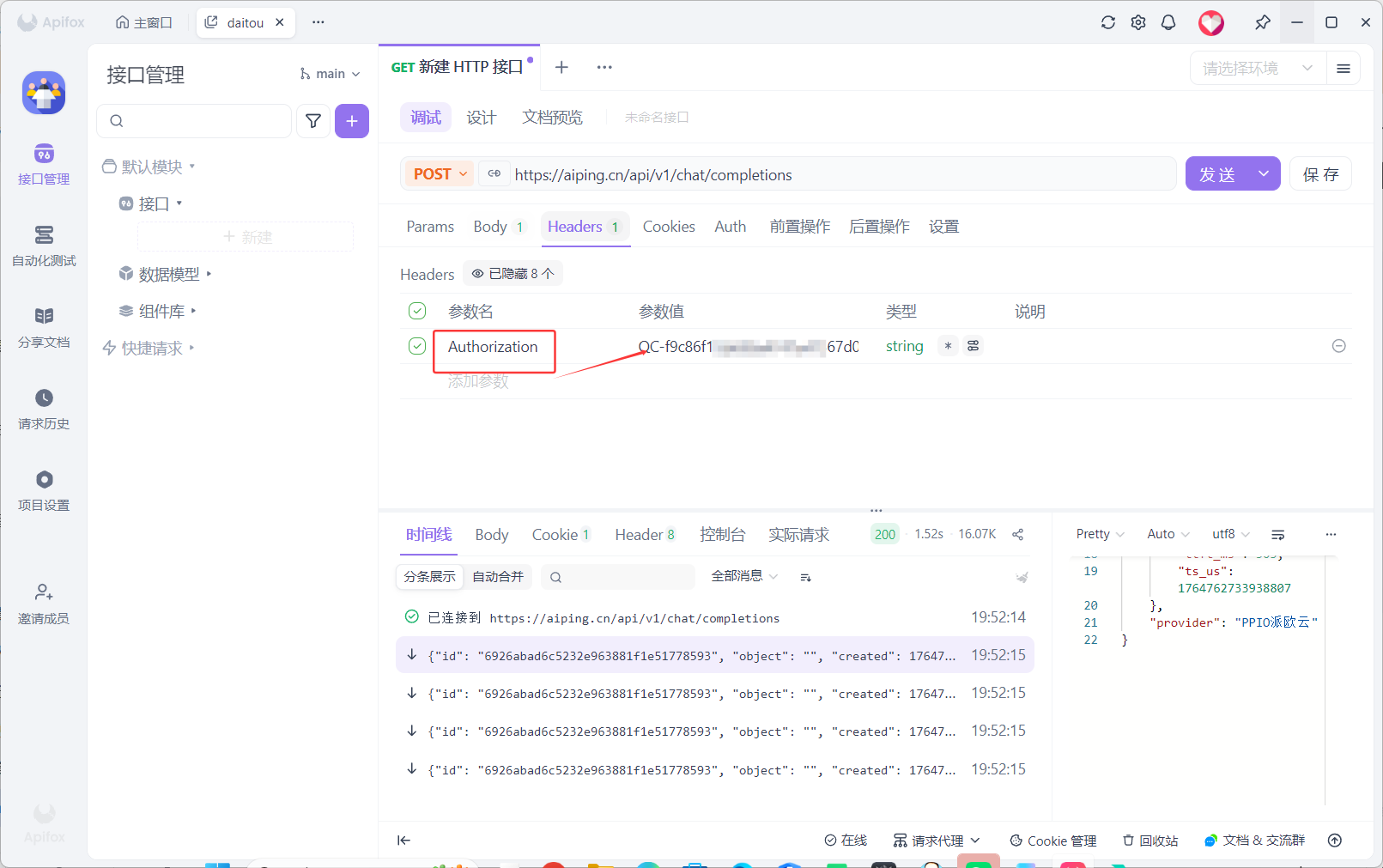

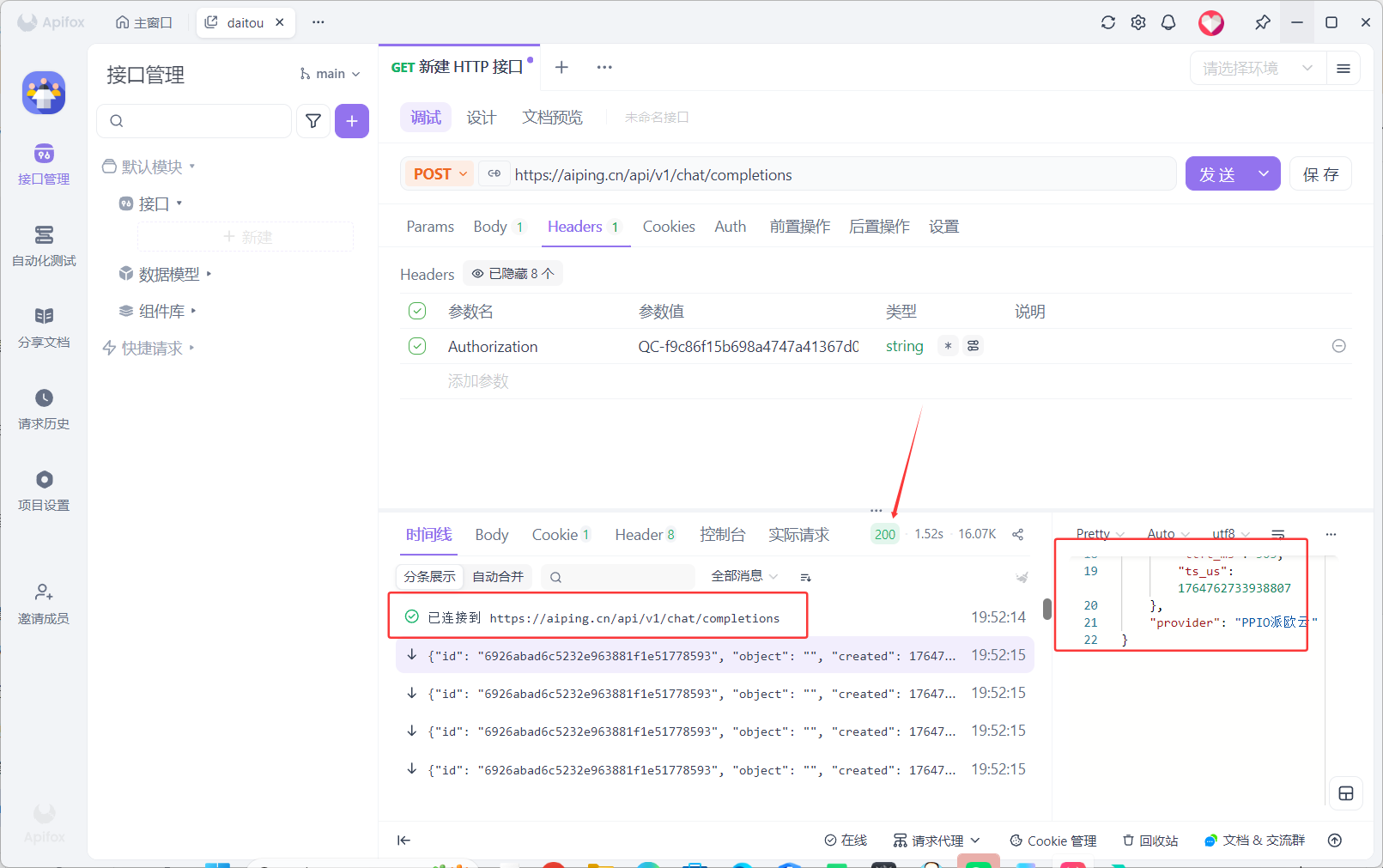

将其复制到ApifoxHeaders处,选择 Authorization

4.2 步骤2:使用Apifox进行调试

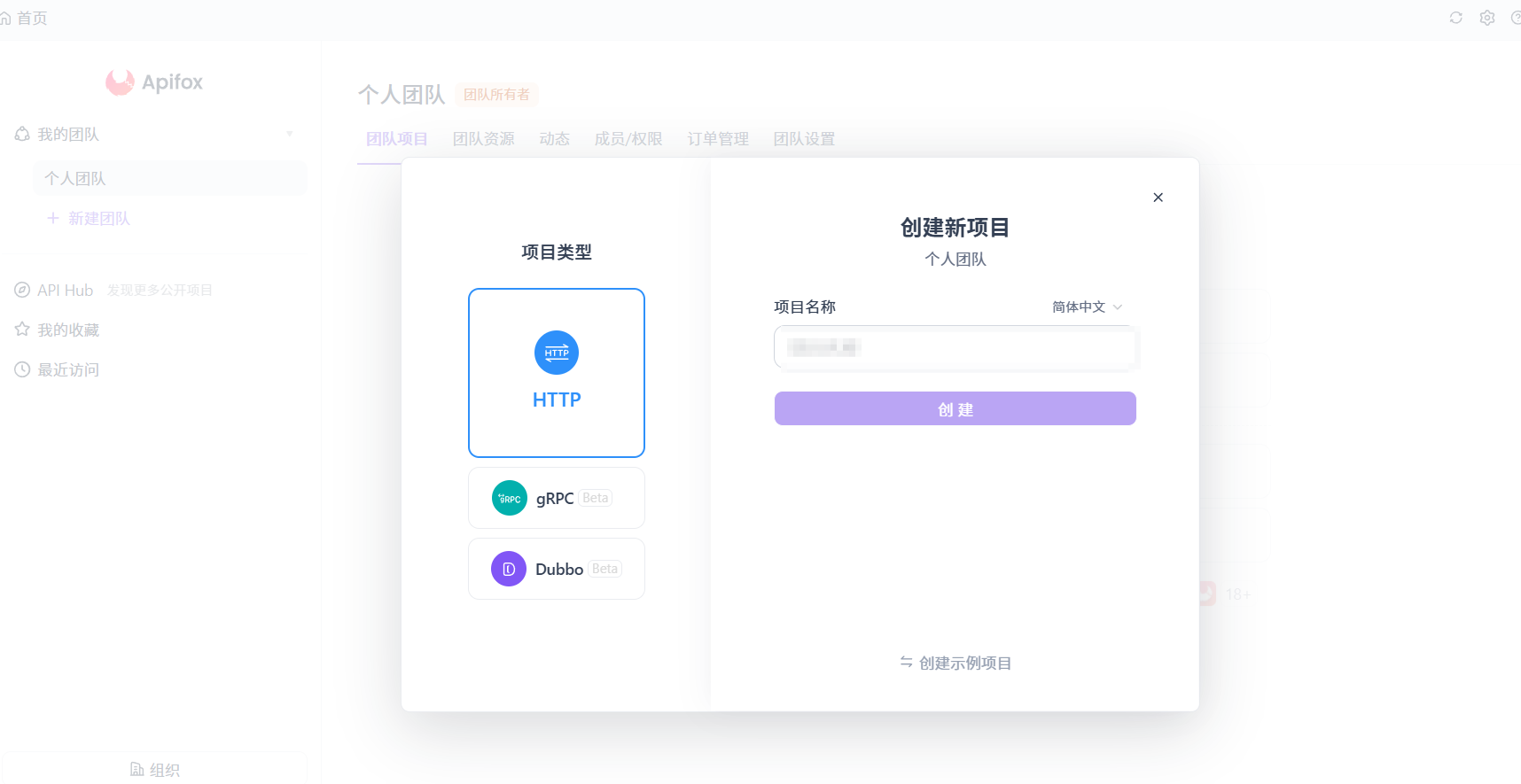

Apifox官网链接:https://app.apifox.com/main(注意这里需要下载)

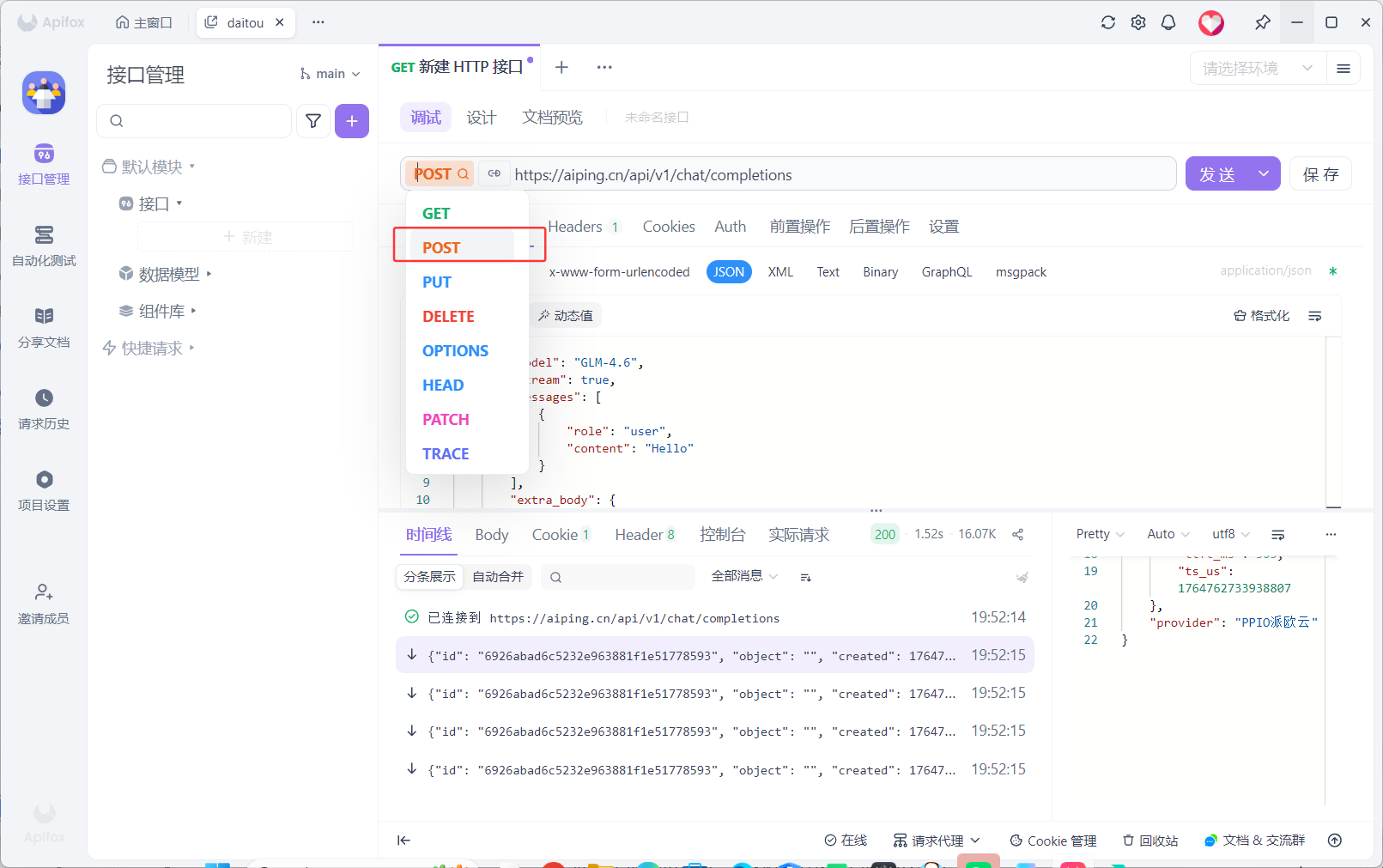

- 选择

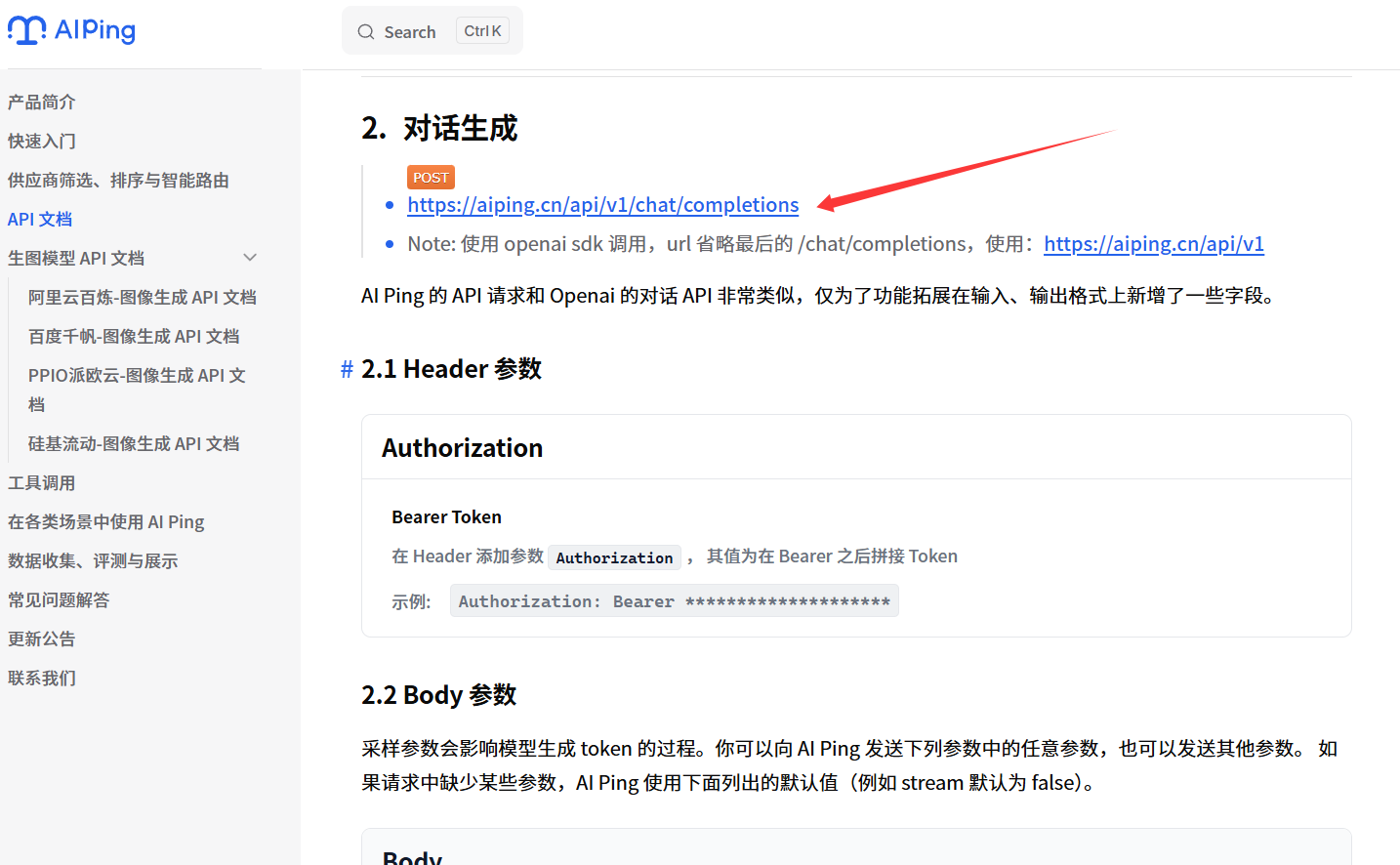

post,进入文档查看链接

- 进入官方复制链接

4.3 步骤3:编写调用代码

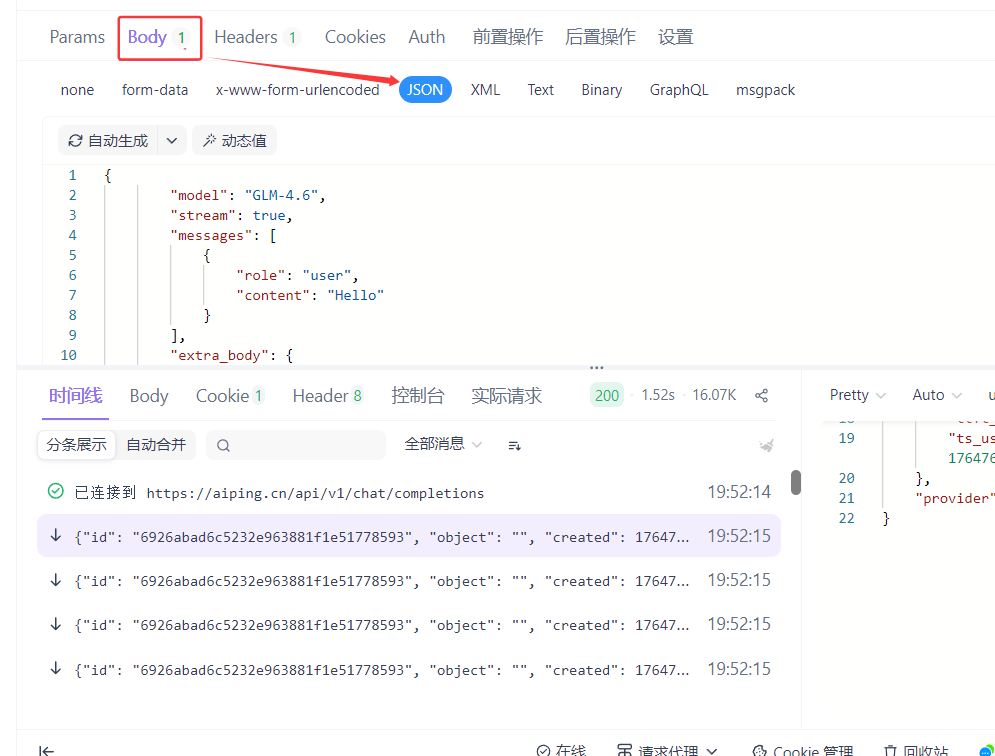

- 选择Body-JSON

modle处填写自己调用的大模型

plain

{

"model": "GLM-4.6",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"enable_thinking": false

}

}4.4 解结果检查

说明我们已经打通自动化生产线!

五、总结与展望:AI Ping的"下一步"

AI Ping的价值,在于将大模型选型从"经验驱动"转向"数据驱动"------它让开发者不再依赖"博主推荐",而是用7×24小时的性能数据做决策。

未来,AI Ping将向"AI效能中枢"进化:

- 推出"自动优化引擎":根据业务负载自动切换模型;

- 新增"合规性评测":覆盖数据本地化、隐私保护等政策要求;

- 接入"边缘模型":适配AIPC(AI个人计算机)的端侧部署需求。

在大模型从"可用"到"好用"的路上,AI Ping是开发者的"性能罗盘"------用数据拨开迷雾,让AI真正成为业务增长的引擎。

✨ 坚持用 清晰易懂的图解 + 代码语言, 让每个知识点都 简单直观 !

🚀 个人主页 :不呆头 · CSDN

🌱 代码仓库 :不呆头 · Gitee

📌 专栏系列 :

💬 座右铭 : "不患无位,患所以立。"