BP算法,即反向传播算法(Backpropagation Algorithm),是一种用于训练人工神经网络的监督学习算法。它是神经网络中最常用、最核心的学习算法之一,尤其在深度学习中扮演着基础角色。

一、核心思想

反向传播是误差反向传播算法的简称,它是用于训练人工神经网络(尤其是多层前馈网络)的最经典、最核心的算法。其核心思想是:

通过链式法则,计算神经网络中每个参数(权重和偏置)对于最终输出误差的"贡献"(即梯度),然后利用梯度下降法来更新这些参数,以最小化误差。

简单来说,它是一个高效的计算梯度的方法。

二、基本流程

BP算法主要包括两个阶段:

前向传播(Forward Propagation)

输入数据从输入层传入,经过隐藏层逐层计算,最终得到输出层的预测值。

每一层的输出作为下一层的输入,直到输出层。

反向传播(Backward Propagation)

计算输出层的预测值与真实值之间的误差(通常使用损失函数,如均方误差或交叉熵)。

将误差从输出层反向传播到隐藏层,计算每一层的梯度(即误差对权重和偏置的偏导数)。

使用梯度下降(或其变种)更新每一层的权重和偏置,以减小误差。

三、算法详细步骤

阶段一:前向传播

输入:从输入层传入样本数据。

计算:数据与权重相乘,加上偏置,通过激活函数(如Sigmoid, ReLU),逐层传递,直到得到输出层的预测值。

输出 :得到网络的预测输出。

计算损失 :使用损失函数(如均方误差MSE、交叉熵)计算预测值 和真实标签

之间的误差

。

阶段二:反向传播

这是算法的精髓。目标是求出损失函数 对每一个权重

和每一个偏置

的偏导数(即梯度

和

)。

核心数学工具:链式法则

假设一个简单的三层网络(输入-隐藏-输出),对于连接隐藏层神经元 到输出层神经元

的权重

:

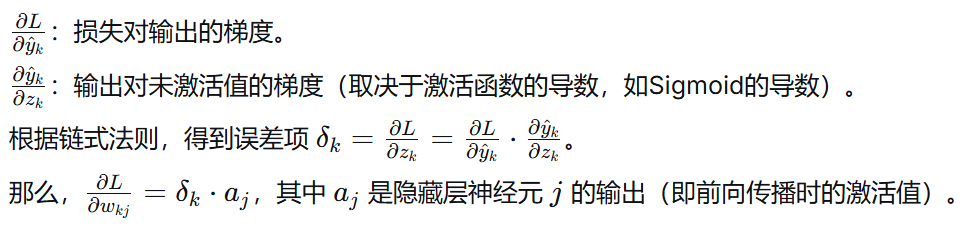

1.计算输出层梯度:

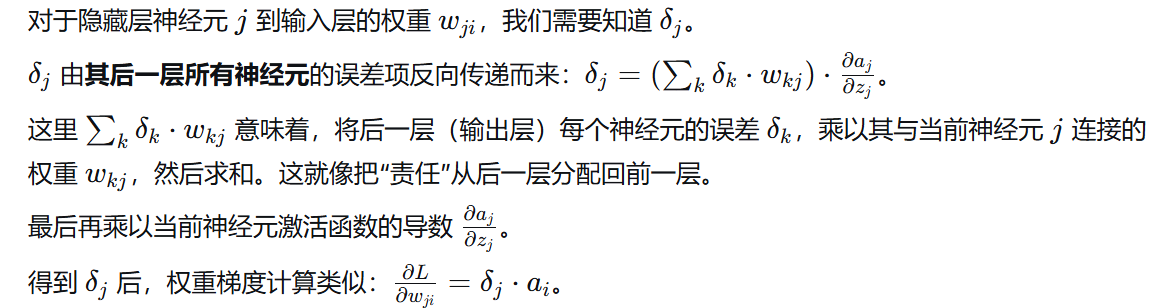

2.计算隐藏层梯度(反向传播的关键):

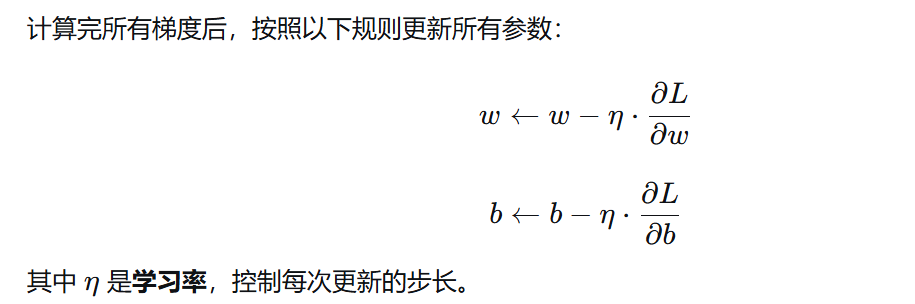

3.参数更新(梯度下降):

4.算法的意义与优势

-

高效性 :与直接对每个参数进行数值微分(微小扰动求变化)相比,反向传播利用链式法则和矩阵运算,能一次性、高效地计算出所有参数的梯度,计算复杂度与一次前向传播相当。

-

普适性:它是一个通用的框架,只要网络结构是可微的(即每一层的运算都可求导),无论有多少层,都可以通过链式法则层层反推。

-

奠定了深度学习的基础:正是由于BP算法的存在,才使得训练具有数百万甚至数十亿参数的深层神经网络成为可能。