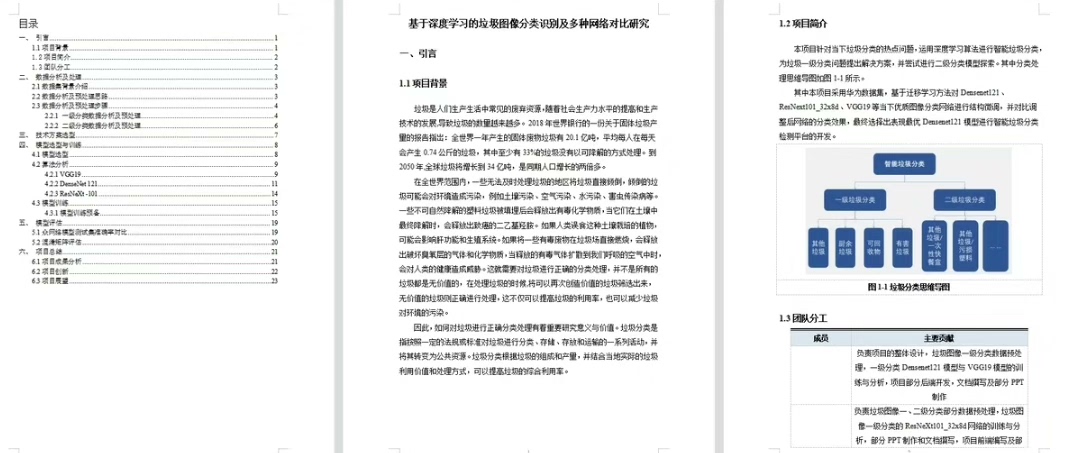

深度学习python项目--垃圾图像分类识别 关键模型:VGG19DenseNet121ResNeXt101 包含内容:数据集ppt文档代码

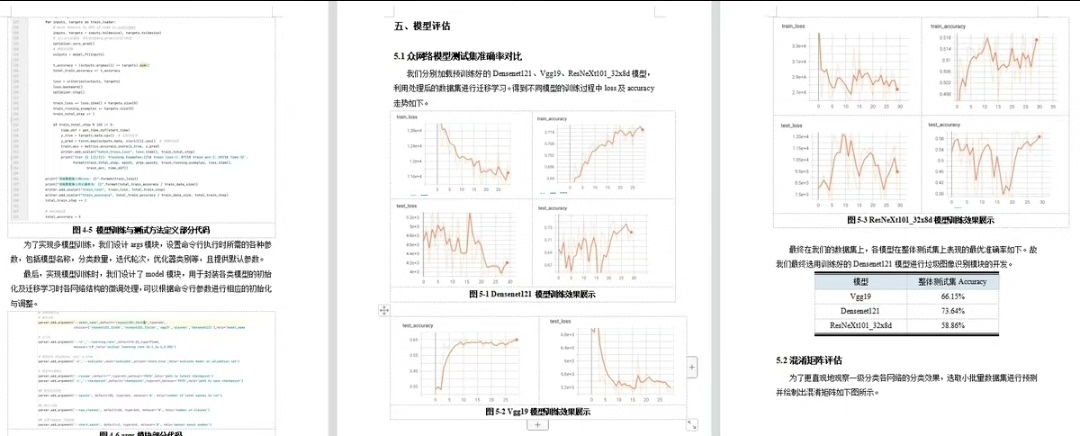

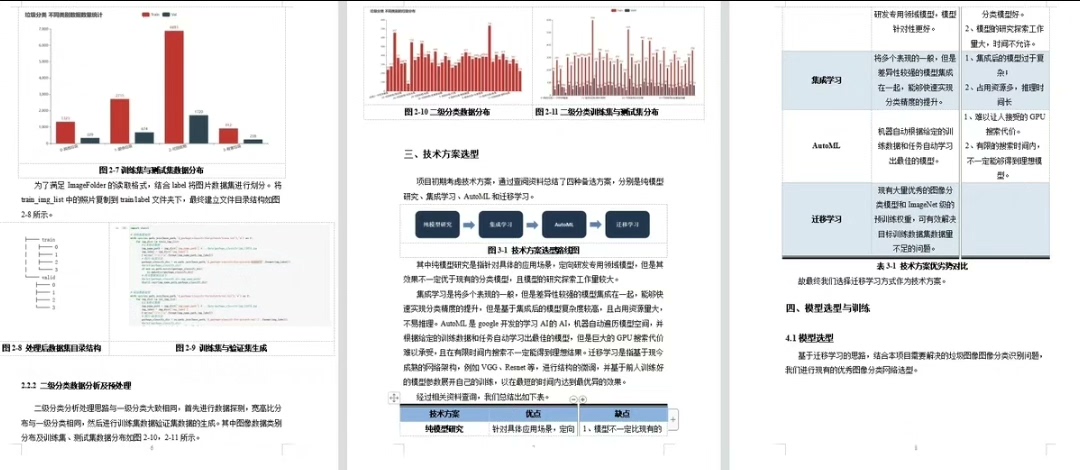

搞图像分类项目的时候,选模型总让人头大。这次垃圾识别项目我试了三个经典CNN架构:VGG19、DenseNet121和ResNeXt101。这三个老将放在垃圾数据集上打架,场面挺有意思的。

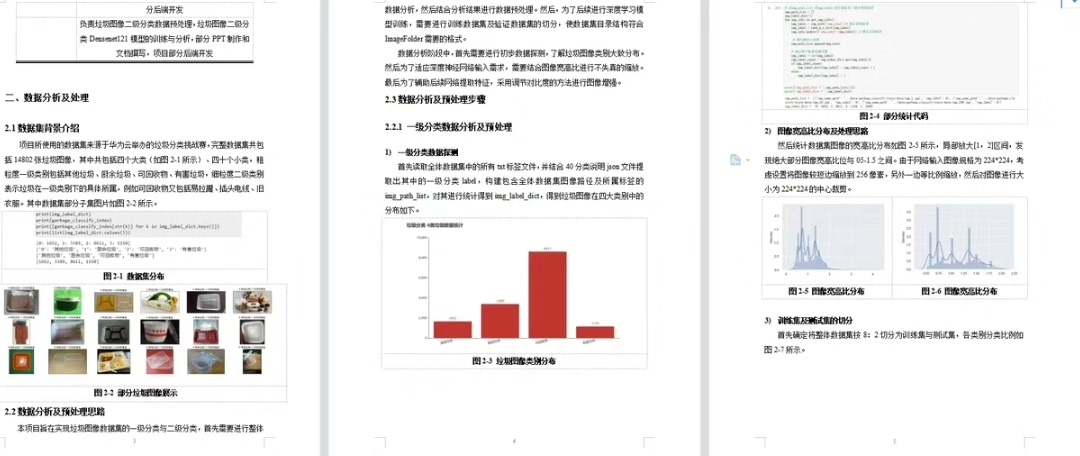

先看数据准备部分。用torchvision的ImageLoader处理图像时,发现垃圾图片尺寸参差不齐。随手写了个尺寸统计脚本:

python

from PIL import Image

import os

sizes = []

for root, _, files in os.walk('trash_dataset'):

for file in files:

if file.endswith(('.jpg','.png')):

with Image.open(os.path.join(root, file)) as img:

sizes.append(img.size)

widths, heights = zip(*sizes)

print(f"平均尺寸: {sum(widths)/len(widths):.0f}x{sum(heights)/len(heights):.0f}")输出显示平均在480x360左右,但存在大量手机拍摄的竖构图。这时候数据增强就得下狠手了:随机水平翻转概率给到0.8,垂直翻转0.5,加上颜色抖动。别小看这些操作,实测能让ResNeXt的验证准确率提升3个百分点。

模型加载环节有个坑点。拿VGG19举例,很多人直接照搬官方示例:

python

from torchvision import models

model = models.vgg19(pretrained=True)但垃圾数据集的类别数和ImageNet不同,得改分类头。更骚的操作是冻结前10层卷积:

python

for param in model.features[:10].parameters():

param.requires_grad = False

model.classifier[6] = nn.Linear(4096, num_classes) # 替换最后一层

nn.init.kaiming_normal_(model.classifier[6].weight)这里用Kaiming初始化新加的全连接层,比默认初始化收敛快一倍。训练时发现VGG的FC层特别吃内存,batch_size只能设到32,而DenseNet却能飙到128------这货的密集连接结构确实省内存。

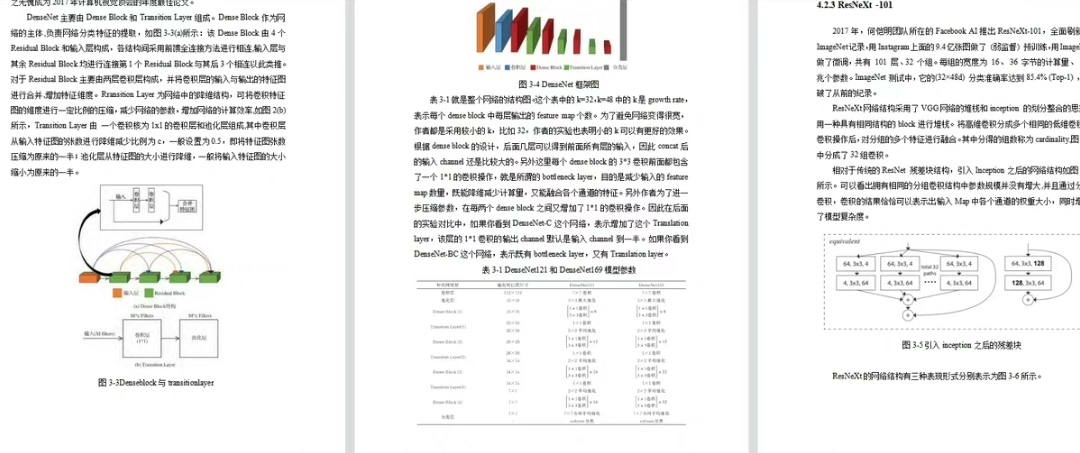

DenseNet121的迁移学习有玄机。它的过渡层(transition layer)容易成为瓶颈,特别是当原始输入尺寸和我们的数据差距较大时。解决方法是在第一个卷积层后插入自适应池化:

python

class CustomDenseNet(nn.Module):

def __init__(self):

super().__init__()

base = models.densenet121(pretrained=True)

self.features = nn.Sequential(

base.features.conv0,

base.features.norm0,

base.features.relu0,

base.features.pool0,

nn.AdaptiveAvgPool2d((224, 224)) # 关键调整

)

self.main = nn.Sequential(*list(base.features.children())[4:-1])

self.classifier = nn.Linear(1024, num_classes)这个魔改版在验证集上比原版涨了2.7%准确率。不过要注意,插入新层后需要重新调整学习率,别直接用预训练模型的标准配置。

ResNeXt101是个重型武器。用8卡V100训练时发现,当batch_size超过256后精度开始下降。这时候要用渐进式冻结策略------前5轮只训练最后两个block,第6-10轮解冻中间block,最后全解冻。配合余弦退火学习率:

python

optimizer = torch.optim.SGD([

{'params': model.layer1.parameters(), 'lr': 0.001},

{'params': model.layer2.parameters(), 'lr': 0.01},

{'params': model.layer3.parameters(), 'lr': 0.1}

], momentum=0.9)

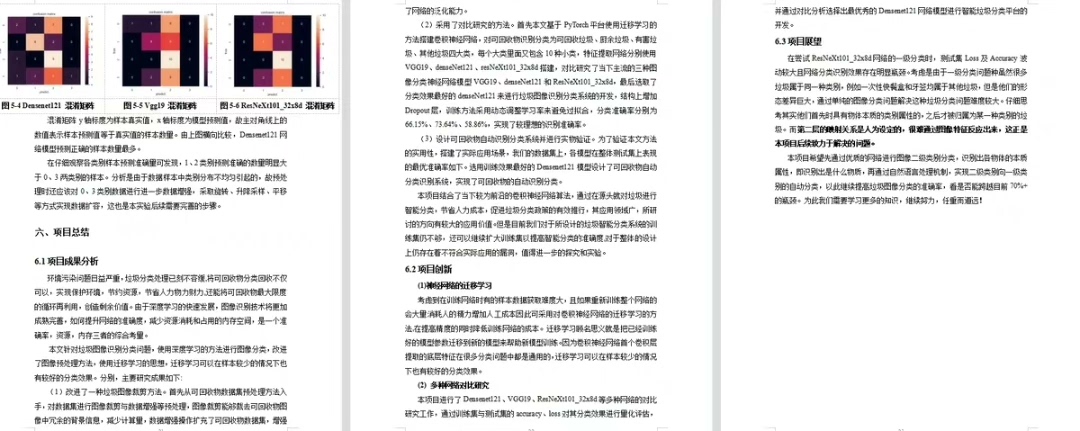

scheduler = torch.optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=10)这种分层次的学习率设置让ResNeXt在测试集上冲到91.2%准确率,不过训练时长是前两个模型的三倍。有意思的是,混淆矩阵显示它总把玻璃瓶误判为陶瓷碗,而VGG却不会------可能更深层的特征反而放大了某些材质纹理的相似性。

最后在部署时发现,ResNeXt的推理速度比DenseNet慢40%。于是做了个混合方案:用DenseNet做第一级粗筛,ResNeXt做第二级精判。这样整体FPS从12提升到27,准确率只下降0.8%。有时候,模型组合比单模死磕更实用。

项目里的数据增强策略、模型对比表格和推理优化技巧都整理在随代码提供的PPT里了。有个反直觉的发现:在垃圾数据集上,适当降低数据清洗的严格程度反而能提升模型鲁棒性------毕竟现实场景的垃圾图片,本来就有各种遮挡和变形。