一、网络爬虫库

1、网络爬虫库

网络爬虫通俗来讲就是使用代码将HTML网页的内容下载到本地的过程。爬取网页主要是为了获取网的中的关键信息,例如网页中的数据、图片、视频等。Python语言中提供了多个具有爬虫功能的库,下面将具体介绍

**urllib库:**是Python自带的标准库,无须下载、安装即可直接使用。urllib库中包含大量的爬虫功能,但其代码编写略显复杂。

**reguests库:**是Python的第三方库,需要下载、安装之后才能使用。由于requests库是在urllib库的基的上建立的,它包含urllib库的功能,这使得requests库中的函数和方法的使用更加友好,因此requests库使用起来更方便。

scrapy库:是Python的第三方库,需要下载、安装之后才能使用。是一个适用于专业应用程序开发的网络爬虫库。scrapy库集合了爬虫的框架,通过框架可创建一个专业爬虫系统。

**selenium库:**是Python的第三方库,需要下载、安装后才能使用。selenium库可用于驱动计算机中的浏览器执行相关命令,而无须用户手动操作。常用于自动驱动浏览器实现办公自动化和Web应用程序测试。

2、robots.txt 规则

在正式学习网络爬虫之前,需要掌握爬取规则,不是网站中的所有信息都允许被爬取,也不是所有的网站都允许被爬取。在大部分网站的根目录中存在一个robots.txt文件,该文件用于声明此网站中禁止访问的url和可以访问的url。用户只需在网站域名后面加上/robots.txt即可读取此文件的内容。

介绍robots.txt文件的内容:

User - agent :表示访问网站的搜索引擎,User - agent的值为 * 表示所有类型的搜索引擎;如果User - agent后面加Wandoujia Spider ,就表示Wandoujia Spider搜索引擎需要遵守的规则

Disallow:表示该搜索引擎不允许访问的url

**Allow:**表示该搜索引擎允许访问的url

Sitemap:网站地图,用于提供网站中所有可以被爬取的url,方便搜索引擎能够快速爬取到对应网页

**#:**代表注释,与python的概念相同

Crawl - delay :Crawl - delay: 5 是说爬虫每次访问时间间隔5秒,为了避免因用户频繁访问而导致服务器拥挤,使用户无法正常使用浏览器

二、requests库和网页源代码

1、request库的安装

在命令提示符或终端安装:

python

pip install requests安装完成后可以用以下命令查看库的信息

python

pip show requests2、网页源代码

打开网页后鼠标右击,在点击检查,或者快捷键F12就可以查看网页的源代码

三、获取网页资源

requests库具有获取网页内容和向网页中提交信息的功能

1、get()函数

在requests库中获取HTML网页内容的方法是使用get()函数,形式如下:

python

requests.get(url, params=None, headers=None,**kwargs)参数url:表示获取的HTML网址

参数params:表示可选参数,以字典的形式发送信息,当需要向网页中提交查询信息时使用

参数**kwargs:表示请求采用的可选参数

返回值:返回一个由类Response创建的对象。类Response位于requests库的models.py文件中

用get()搜索信息

python

import requests

r = requests.get('https://www.ptpress.com.cn/search?keyword=excel')

print(r.text)

search表示搜索,keyword表示要搜索的关键词,?用于分隔search和keyword

用get()添加信息

get()函数中第二个参数params会以字典的形式在url后自动添加信息,需要提前将params定义为字典

python

import requests

info ={'keyword':'excel' }

r = requests.get('https://www.ptpress.com.cn/search',params=info)

print(r.url)

print(r.text)代码解释:

第2行代码建立字典info,包含一个键值对

r = requests.get('https://www.ptpress.com.cn/search', params=info)

调用get()方法向邮电出版社搜索接口发送请求,参数params=info会自动将字典转为?keyword=excel拼接到 URL 后。变量r接收服务器返回的响应对象。

2、返回Response对象

通过get()函数获取HTML网页内容后,由于网页多样性,通常还需要对网页返回Reaponse对象进行设置

Response属性

Response包含的属性有status_code、headers、url、encoding、cookies等。

status_code(状态码):当获取一个HTML网页时,网页所在的服务器会返回一个状态码,表明本次获取网页的状态。例如访问人民邮电出版社官网,当使用get()函数发出请求时,人民邮电出版社官网的服务器接收到请求信息后,会先判断请求信息是否合理,如果请求合理则返回状态码200和网页信息;如果请求不合理则返回一个异常状态码。

常见的HTTP(Hypertext Transfer Protocol,超文本传送协议)状态码有200(请求成功)、301(网页内容被永久转移到其他url)、404(请求的网页不存在)、500(内部服务器错误)等,更多状态码可以使用搜索引擎查询。

因此在使用get()函数请求访问网页时,为了确保获取正确的网页信息,需要判断服务器返回的状态码是否为200。Response对象中的status_code为服务器返回的状态码。

示例代码:

python

import requests

r = requests.get('https://www.ptpress.com.cn')

print(r.status_code)

if r.status_code == 200:

print(r.text)

else:

print('本次访问失败')代码解释:

第3行代码输出Response对象返回的状态码。

第4行代码用于判断状态码是否为200,如果为200,则输出获取的网页内容,否则表明访问存在异常。

• headers(响应头):服务器返回的附加信息,主要包括服务器传递的数据类型、使用的压缩方法、语言、服务器的信息、响应该请求的时间等。

• url:响应的最终url位置。

• encoding:访问r.text时使用的编码。

• cookies:服务器返回的文件。这是服务器为辨别用户身份,对用户操作进行会话跟踪而存储在用户本地终端上的数据

设置编码

当访问网页时,若获取的内容是乱码,是网页读取编码错误导致的,可通过设置requests.get(url)返回的**Response对象的encoding='utf-8'**来修改"Response对象.text"文本内容的编码方式。

Response对象还提供了apparent_encoding()方法自动识别网页编码,但该方法由机器识别,可能存在错误(大部分情况可用)。

若要设置自动识别编码,可使用以下形式:

Response对象.encoding=Response对象.apparent_encoding

示例代码:

python

import requests

r = requests.get('此处填入"百度官网地址".com')

r.encoding = r.apparent_encoding

print(r.text)第3行代码设置自动识别编码,执行后输出可识别文字;若仍乱码,需自行设置encoding编码方式。

返回网页内容

Response对象返回网页内容有两种方法:

• text():以字符串形式返回网页内容(前文已介绍)。

• content():以二进制形式返回网页内容,常用于保存网页中的媒体文件。

示例代码(下载人民邮电出版社官网中的图片):

01

python

import requests

r = requests.get('https://cdn.ptpress.cn/uploading/Material/978-7-115-41359-8/72jpq/41359-8-72.jpg')

f2 = open('b.jpg','wb')

f2.write(r.content)

f2.close()代码说明:

• 第2行:用get()访问图片URL。

• 第3行:用open()创建b.jpg文件,以二进制写入模式(wb)打开。

• 第4行:将获取的URL内容以二进制形式写入文件。

• 执行后,对应文件夹会存储该图片

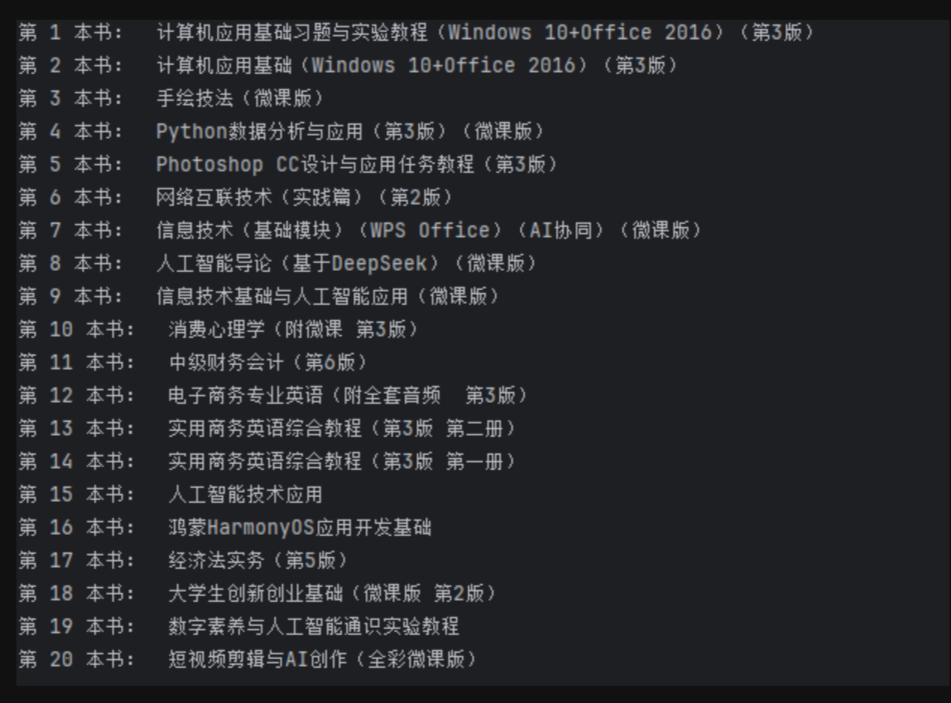

小项目:实现处理获取的网页信息

**任务:**在某个网站上上架了新书,现在需要用request方法获取所有新书的书名

示例代码:

python

import requests

import re

r = requests.get('https://www.ryjiaoyu.com/book')

result = re.findall(r'title=(.+?)">(.+?)</a></h4>',r.text)

for i in range(len(result)):

print('第',i+1,'本书: ',result[i][1])

运行结果: