引言

近年来,AI翻译软件已悄然融入我们的日常工作与生活。从跨国企业的合同审阅到旅行者的菜单解读,从学术文献的快速浏览到社交媒体的多语言互动,机器翻译的质量提升有目共睹。这背后并非简单的规则堆砌或词典匹配,而是一系列深度学习技术的系统性突破。

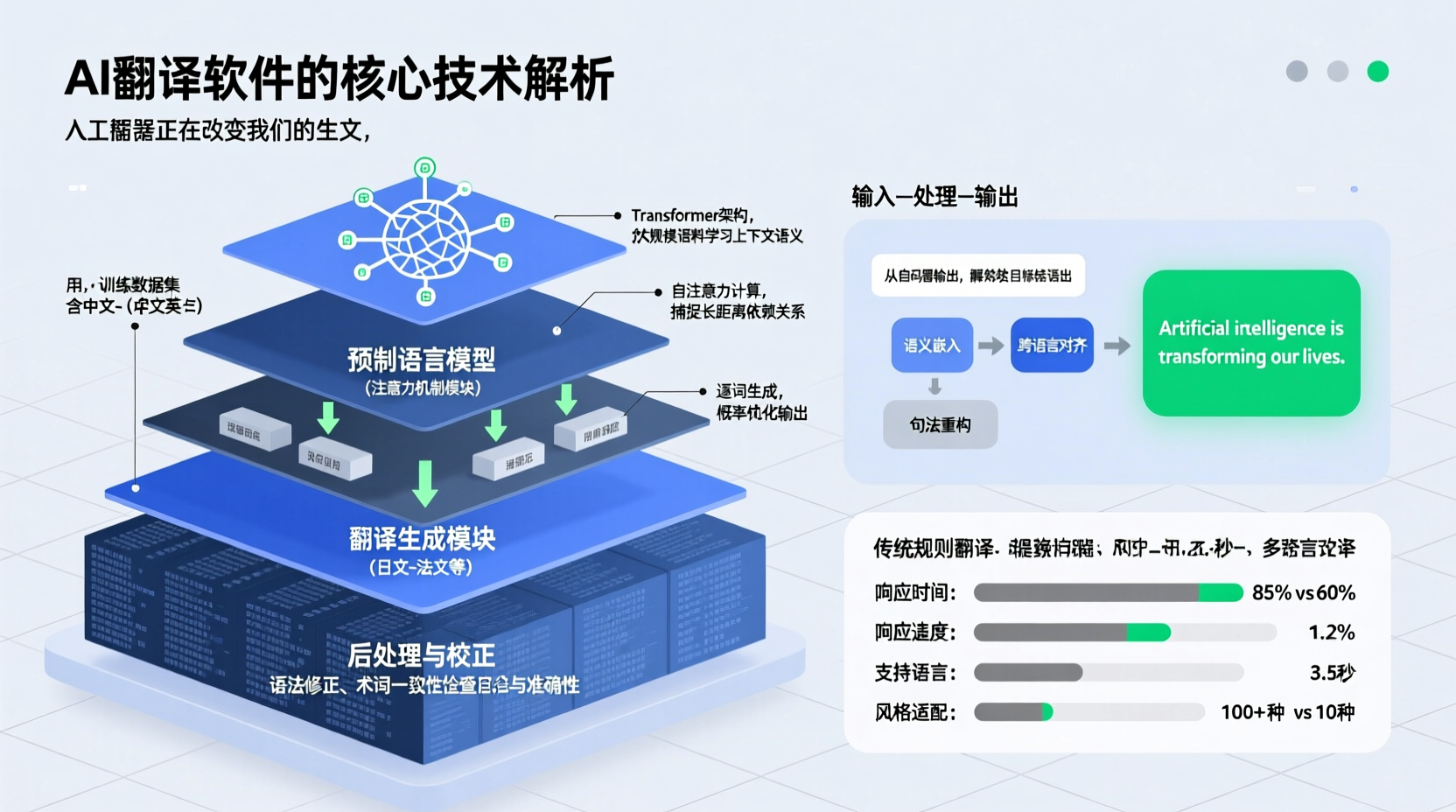

本文将深入剖析现代AI翻译软件的四项核心技术:神经网络机器翻译、Transformer架构、预训练语言模型以及多模态翻译技术,并客观讨论当前面临的技术挑战。理解这些原理,不仅能帮助我们更合理地使用翻译工具,也能洞察自然语言处理领域的发展脉络。

一、神经网络机器翻译:从统计到深度学习的范式转移

在2010年代中期之前,统计机器翻译(SMT)主导着整个行业。它通过分析海量平行语料,学习短语翻译概率和语言模型。然而,这种方法依赖复杂的特征工程,翻译结果往往呈现片段化、不连贯的特点。

神经网络机器翻译(NMT) 的出现标志着根本性的转变。其核心思想是将整个翻译过程建模为一个端到端的神经网络,直接从源语言映射到目标语言,无需人工设计特征。

编码器-解码器框架

早期NMT系统普遍采用**序列到序列(seq2seq)**结构:

- 编码器 :将源语言句子(如"我喜欢机器学习")转换为一个固定长度的上下文向量(context vector)。这个向量试图压缩句子的全部语义信息。

- 解码器:基于该上下文向量,逐个生成目标语言的词元(如"I"、"love"、"machine"、"learning")。

然而,固定长度向量成为瓶颈。当处理长句时,信息压缩损失严重,导致翻译质量急剧下降。这一局限直接催生了注意力机制的诞生。

注意力机制的引入

2015年,注意力机制被引入NMT系统。其核心创新在于:解码器在生成每个词时,可以动态地"回看"编码器中的所有输入词,并计算它们与当前生成步骤的相关性权重。

具体而言,当翻译"机器学习"时,模型会自动赋予"机器"和"学习"较高的注意力权重,而不是依赖一个笼统的句子向量。这种软对齐机制极大提升了长句翻译质量,也为后续Transformer架构奠定了基础。

二、Transformer架构:自注意力驱动的并行革命

2017年,Google发表的《Attention Is All You Need》论文彻底改变了NLP领域。Transformer架构摒弃了循环神经网络(RNN)和卷积神经网络(CNN),完全依赖自注意力机制(Self-Attention) 捕捉序列依赖关系,实现了前所未有的训练效率与翻译质量。

自注意力机制详解

自注意力的核心是让序列中的每个词都能"关注"到其他所有词,从而动态构建上下文表示。以句子"Bank of the river"为例:

- Query, Key, Value三元组:每个词被映射为三个向量。Query代表"我想查询什么",Key代表"我能提供什么信息",Value则是实际传递的内容。

- 相关性计算:通过Query与所有Key的点积运算,得到词与词之间的相关性分数。例如,"river"的Query与"bank"的Key会计算出强相关性,帮助模型理解此处"bank"指"河岸"而非"银行"。

- 加权聚合:用softmax归一化后的权重对Value进行加权求和,得到每个词的上下文增强表示。

多头注意力与位置编码

多头注意力(Multi-Head Attention) 通过并行运行多个自注意力层,让模型从不同子空间捕捉多样化的语义关系(如句法结构、指代关系、语义角色等)。

由于Transformer没有RNN的时序递归结构,它需要位置编码(Positional Encoding) 来注入词序信息。通过三角函数生成的位置向量与词向量相加,使模型感知词语在序列中的相对位置。

并行计算的优势

与RNN必须顺序处理序列不同,Transformer的自注意力机制允许所有词同时计算,充分利用GPU并行能力。这使得训练速度提升数倍至数十倍,也为后续更大规模预训练模型铺平了道路。

目前,包括Google翻译、DeepL、微软Translator在内的主流服务均基于Transformer或其变体构建。不同产品间的质量差异主要来自训练数据筛选、模型调优策略和后处理技术,而非架构本质区别。

三、预训练语言模型:从单任务到通用语义理解

尽管Transformer提升了翻译质量,但早期模型仍需为每对语言单独训练。2018年后,预训练语言模型(PLM) 的兴起带来了新范式:先在超大规模多语言语料上进行通用语言理解训练,再微调至翻译任务。

BERT与GPT的差异化路径

- BERT(双向编码器):通过掩码语言模型(MLM)任务,学习词语的双向上下文表示。它对理解源语言句子的深层语义极为有效。

- GPT(自回归解码器):通过预测下一个词的任务,学习生成连贯文本。其解码器结构天然适合目标语言生成。

现代翻译系统往往融合两者优势:用类似BERT的编码器深度理解源语言,用类似GPT的解码器流畅生成目标语言。

多语言预训练与零样本翻译

模型如mBERT、XLM-R在100多种语言上联合预训练,共享同一套模型参数。这种多语言表示空间的对齐带来了惊人效果:

- 零样本翻译:模型从未见过德语-日语平行语料,但通过学习德语→英语和英语→日语,它竟能直接执行德语→日语翻译,且质量可观。

- 低资源语言提升:对斯瓦希里语、冰岛语等训练数据稀少的语言,借助与英语、法语等富资源语言的联合训练,翻译质量显著提高。

大模型的涌现能力

当模型参数规模达到百亿甚至千亿级别(如GPT-3、PaLM),翻译能力出现涌现现象:不仅能直译,还能处理俚语、双关语、文化隐喻等复杂现象。例如,中文成语"画蛇添足"可能被译为"to gild the lily"而非字面直译,因为模型在预训练中习得了文化等效表达。

四、多模态翻译技术:超越文本的边界

现代翻译需求已不限于纯文本。AI翻译软件正融合计算机视觉、语音识别等技术,构建多模态翻译能力。

图像翻译(OCR+MT)

流程如下:

- 文字检测:定位图像中的文本区域(如街牌、菜单、海报)

- 光学字符识别(OCR):将图像文字转为文本

- 机器翻译:执行文本翻译

- 图像渲染:将译文自然融入原图背景

技术挑战在于处理艺术字体、复杂背景、排版保留等问题。当前主流方案采用端到端模型,如Facebook的M4模型,将OCR与MT联合训练,减少误差累积。

语音到语音翻译(S2ST)

完整链路包含三个串联的AI模块:

- 自动语音识别(ASR):将源语言语音转为文本

- 机器翻译(MT):翻译文本

- 文本到语音合成(TTS):生成目标语言语音

更先进的系统(如Google的Translatotron)尝试跳过中间文本表示,直接从语音波形到语音波形,保留原说话人的音色、语调,减少信息损失和延迟。

实时视频翻译

结合OCR、MT与增强现实(AR)技术,实现视频流的实时字幕翻译。核心技术包括动态文本跟踪、时间轴对齐、低延迟翻译引擎优化等。这在国际会议直播、外语视频学习等场景具有实用价值。

五、技术挑战与局限性

尽管进步显著,AI翻译仍面临根本挑战:

1. 低资源语言困境

全球约7000种语言中,绝大多数缺乏数字化语料。即便采用迁移学习,质量仍远不及主流语言。此外,方言、古语、口语化表达的处理能力有限。

2. 领域适应性不足

通用模型在法律、医疗、金融等专业领域表现不稳定。术语翻译错误可能引发严重后果。领域自适应技术(如术语注入、微调)虽有进展,但部署成本较高。

3. 文化语境与常识推理

翻译不仅是语言转换,更是文化转码。当前模型缺乏真正的世界知识和常识推理能力。例如,中文"吃了吗"直译为"Have you eaten?"在英语文化中显得突兀,恰当译法应为"How are you?",但多数系统仍选择字面翻译。

4. 计算成本与可持续性

训练千亿参数模型需要数百万美元的算力,碳足迹巨大。推理阶段的实时响应也对服务器集群提出高要求。模型压缩、量化、蒸馏等技术正在探索更高效的部署方案。

5. 评估指标的局限

BLEU等传统指标侧重n-gram匹配,无法全面衡量语义准确性和流畅度。人工评估虽可靠但成本高昂。如何设计更合理的自动评估体系仍是开放问题。

总结

AI翻译软件的演进,本质上是深度学习技术从"模式匹配"到"语义理解"再到"多模态认知"的递进。神经网络机器翻译奠定了端到端基础,Transformer架构通过自注意力实现效率与质量的双重突破,预训练语言模型赋予系统通用语言理解能力,而多模态技术则拓展了应用场景的边界。

然而,技术的天花板依然存在。真正的"信、达、雅"翻译不仅需要语言知识,更依赖文化理解、常识推理和领域专长。未来的突破可能来自:

- 结合符号逻辑与神经网络的混合架构

- 更有效的低资源语言学习范式

- 融入世界知识的增强型预训练

- 更轻量、更绿色的模型设计

对于用户而言,理解这些技术原理有助于建立合理预期:AI翻译是强大的辅助工具,但在关键场景仍需谨慎验证。对于开发者,这些挑战指明了持续创新的方向。机器翻译的终极目标不是替代人类译者,而是让人类跨越语言障碍,更高效地连接彼此的知识与思想。