TL;DR

场景:在 ELK 7.3.x 环境用 Logstash 7.3.0 快速把控制台/日志文件数据跑通到 stdout(rubydebug) 结论:file 输入是否"从头读"由 sincedb 决定,start_position 只对"首次见到的文件"生效 产出:可复用的最小可跑命令、文件监听配置骨架、以及高频故障定位/修复速查表

版本矩阵

| 项目 | 状态 | 说明 |

|---|---|---|

| 已验证说明 | - | Logstash 7.3.0(tar.gz 下载解压,bin/logstash 直接运行)是最小链路 |

| input{stdin{}} -> output{stdout{codec=>rubydebug}} | - | 用于先验证运行环境与管道语法 |

| file 输入的断点机制 | 是 | 通过 sincedb 记录文件读取位置,支持重启续读 |

| start_position 的边界 | 是 | 仅对"未被记录过"的文件生效(已存在 sincedb 记录时不会从头读) |

| sincedb 默认落点 | 部分 | 通常在运行用户的 $HOME(不同安装方式/运行用户会影响实际路径) |

| Java 运行时 | 部分 | 7.x 早期常见 Java 8/11 组合;具体以环境与插件兼容性为准 |

简要介绍

Logstash 是一个功能强大的开源服务器端数据处理管道工具,由 Elastic 公司开发维护。它采用基于插件的模块化架构,主要用于实时收集、解析、过滤、丰富和转发各种类型的数据。

核心功能

-

数据收集:

- 支持从多种数据源采集数据,包括但不限于:

- 日志文件(通过 filebeat 或直接读取)

- 数据库(MySQL、PostgreSQL 等)

- 消息队列(Kafka、RabbitMQ)

- 网络协议(TCP/UDP)

- 云服务(AWS S3、Azure Blob)

- 示例:可以配置 input 插件监控

/var/log/nginx/access.log获取网站访问日志

- 支持从多种数据源采集数据,包括但不限于:

-

数据处理:

- 提供丰富的过滤器插件进行数据转换:

- grok:模式匹配解析非结构化日志

- mutate:字段修改和类型转换

- date:时间戳处理

- geoip:IP地址地理位置解析

- 典型处理流程:原始日志 → 解析字段 → 过滤无用数据 → 添加元数据

- 提供丰富的过滤器插件进行数据转换:

-

数据输出:

- 支持多种目的地:

- Elasticsearch(最常用)

- 关系型数据库

- 文件系统

- 消息队列

- 监控系统(如 Prometheus)

- 支持多种目的地:

在 ELK Stack 中的角色

作为 Elastic Stack(ELK)的关键组件,Logstash 承担数据预处理管道的角色:

- 与 Beats 轻量级采集器配合,构建完整数据采集链

- 为 Elasticsearch 提供结构化的索引数据

- 通过 Kibana 实现数据可视化时,依赖 Logstash 处理后的规范数据格式

典型应用场景

-

日志集中管理:

- 收集分散在多个服务器上的应用日志

- 统一进行错误分析和性能监控

-

安全信息与事件管理(SIEM):

- 处理安全设备日志(防火墙、IDS)

- 支持实时安全事件分析

-

业务数据分析:

- 处理交易日志生成业务报表

- 用户行为分析

性能特点

- 支持多线程处理,可通过 pipeline 配置提高吞吐量

- 提供持久化队列防止数据丢失

- 具有插件热加载能力,无需重启服务

配置文件采用简洁的 DSL 语法,主要包含 input、filter 和 output 三个部分,通过条件判断可以实现复杂的数据路由逻辑。其丰富的插件生态系统(200+官方和社区插件)使其能够适应各种数据处理需求。

Logstash 的架构

Logstash 由三大核心组件组成,构成了完整的数据处理流水线:

- 输入(Inputs): 输入插件作为数据采集入口,支持从多种异构数据源实时或批量获取数据。典型应用场景包括:

- 文件日志采集:通过 filebeat 或直接监控日志文件(如 Nginx 访问日志)

- 数据库同步:支持 JDBC 输入插件定期轮询 MySQL/Oracle 等关系型数据库

- 消息队列消费:从 Kafka/RabbitMQ 等消息中间件获取数据流

- 网络协议:通过 TCP/UDP 套接字、HTTP API 接收数据

- 系统输入:支持从标准输入(STDIN)直接读取数据

- 过滤(Filters): 过滤器提供强大的数据处理能力,可组合使用多个插件形成处理链:

- grok:使用正则表达式解析非结构化日志(如将 Apache 日志解析为独立字段)

- mutate:字段操作(重命名/删除/类型转换),如将字符串"200"转为整型

- date:时间格式化,将"Aug 13 15:33:22"转为 ISO8601 格式

- json:自动解析 JSON 字符串为结构化字段

- csv:解析逗号分隔的文本数据

- geoip:根据 IP 地址添加地理位置信息

- 输出(Outputs): 输出插件支持将处理后的数据路由到不同目的地:

- Elasticsearch:最常用输出,支持批量写入和自动索引管理

- 文件系统:按日期分片存储处理结果

- Kafka:作为数据缓冲或分发中心

- 关系型数据库:通过 JDBC 插件写入 MySQL/PostgreSQL

- 监控系统:输出到 Prometheus 或 Graphite

- 调试输出:stdout 用于开发测试

补充处理组件:

- 编解码器(Codecs):

- JSON 编解码:在输入输出时自动序列化/反序列化

- 多行处理:合并异常堆栈等跨行日志

- 压缩解压:支持 gzip 等压缩格式

- 管道间通信:支持多个 pipeline 之间通过 Redis/Kafka 传递数据

- 监控端点:提供 HTTP API 查看运行指标和队列状态

典型处理流程示例:

- 从 Kafka 消费原始日志(输入)

- 用 grok 解析日志格式(过滤)

- 添加处理时间戳(date插件)

- 删除敏感字段(mutate插件)

- 写入 Elasticsearch 集群(输出)

Logstash 的工作流程

Logstash 的工作流程如下:

- 数据输入(Input): Logstash 从数据源中收集原始数据,如应用程序日志、系统日志或网络流量日志等。

- 数据过滤(Filter): 收集到的数据通过配置的过滤器进行处理。这一步可以解析日志、过滤无用数据、格式化字段、添加或删除字段、进-行数据聚合等操作。

- 数据输出(Output): 最终经过处理的数据被输出到一个或多个目标系统,如 Elasticsearch 用于存储和搜索,或者输出到文件用于归档。

Logstash 的功能特性

- 多种输入插件支持: Logstash 支持多种输入源,几乎可以从任何类型的系统或文件中收集数据。这些输入源可以是本地的日志文件、数据库、HTTP、TCP、UDP 连接等。

- 强大的数据处理能力: Logstash 提供了丰富的过滤插件,可以对数据进行复杂的操作。通过 grok 插件,用户可以解析复杂的日志格式,提取关键信息。Logstash 还支持条件语句,可以根据条件对不同的数据进行不同的处理。

- 灵活的输出机制: Logstash 支持多种输出方式,可以将数据发送到多个目标系统。常见的输出包括 Elasticsearch、文件系统、标准输出、Kafka 等。

- 扩展性: Logstash 通过插件架构设计,用户可以根据需要开发和使用自定义插件,从而满足各种特殊需求。

- 实时性: Logstash 可以实时处理大量数据,适合于实时日志分析、事件响应、监控告警等场景。

- 错误处理和重试机制: Logstash 支持对处理失败的数据进行重试和错误处理,确保数据不丢失,并提供可靠的传输保障。

官方网站

shell

https://www.elastic.co/logstash对应的页面截图如下:  Logstash就是一个具备实时数据传输能力的管道,负责将数据信息从管道的输入传出到管道的输出端,与此同时这根管道还可以让你根据自己的需求在中间加上滤网,Logstash提供里很多功能强大的滤网以满足你的各种应用场景。是一个 input | filter | output 的数据流。

Logstash就是一个具备实时数据传输能力的管道,负责将数据信息从管道的输入传出到管道的输出端,与此同时这根管道还可以让你根据自己的需求在中间加上滤网,Logstash提供里很多功能强大的滤网以满足你的各种应用场景。是一个 input | filter | output 的数据流。

项目下载

下载指定版本的Logstash,我这里适配着ES的版本,7.3版本:

shell

https://www.elastic.co/downloads/past-releases#logstash这里放一个直达链接,7.3 版本的:

shell

https://www.elastic.co/downloads/past-releases/logstash-7-3-0我这里直接下载到服务器上 h121.wzk.icu 节点。

shell

wget https://artifacts.elastic.co/downloads/logstash/logstash-7.3.0.tar.gz对应的截图如下图所示:

解压配置

shell

cd /opt/software

mv logstash-7.3.0 ../servers/

cd /opt/servers/logstash-7.3.0/对应的截图如下所示:

Input插件

stdin与stdout

标准输入和标准输出,实现我们的数据从控制台输入,从控制台输出。

shell

cd /opt/servers/logstash-7.3.0/

bin/logstash -e 'input{stdin{}}output{stdout{codec=>rubydebug}}'

{

"@version" => "1",

"host" => "h121.wzk.icu",

"@timestamp" => 2024-08-16T08:33:13.126Z,

"message" => "hello"

}运行之后,可以看到控制台对应的输出为如下的内容:

监控日志文件变化

修改配置

Logstash 使用一个名叫 FileWatch 的 Ruby Gem 库来监听文件变化,这个库支持glob展开路径,而且会记录一个叫 .sincedb 的数据库文件来跟踪被监听的日志文件的当前读取位置。所以,不要担心 Logstash 会漏掉你的数据。

shell

cd /opt/servers/logstash-7.3.0/config

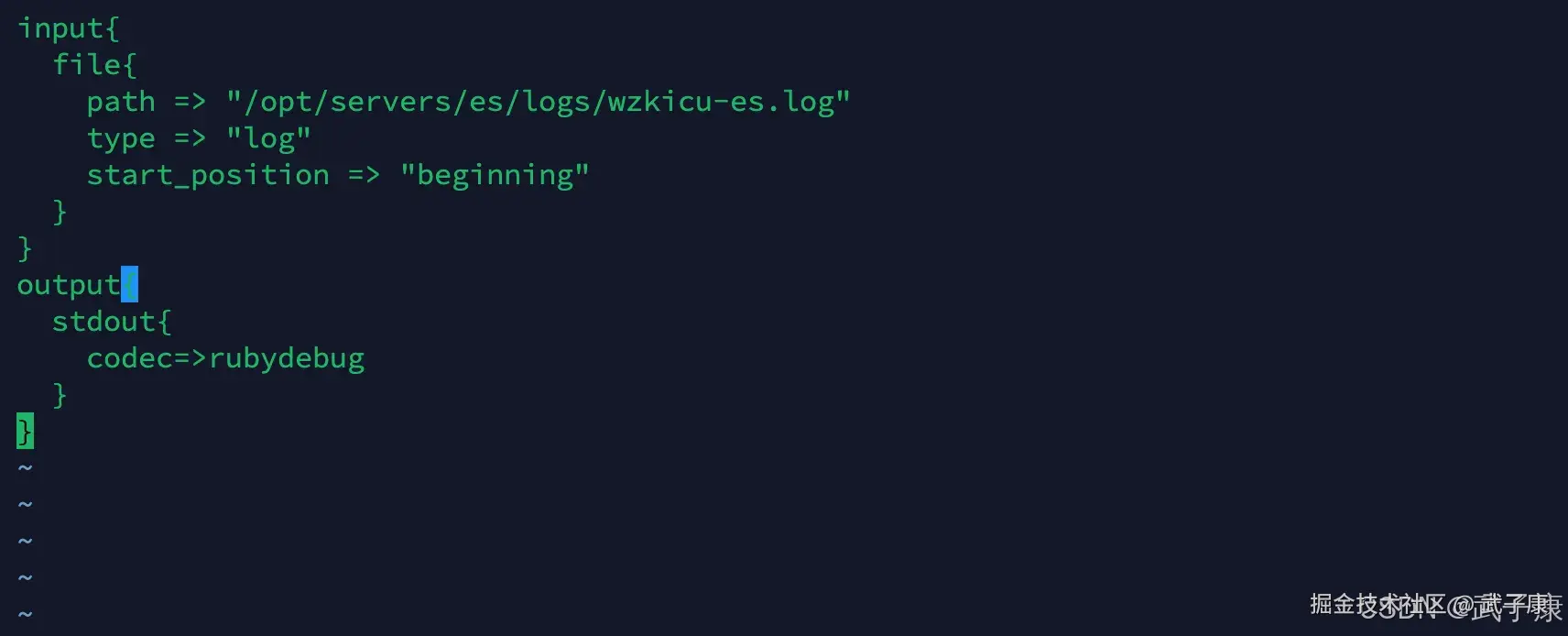

vim monitor_file.conf向其中写入对应的内容,并退出保存:

shell

input{

file{

path => "/opt/servers/es/logs/wzkicu-es.log"

type => "log"

start_position => "beginning"

}

}

output{

stdout{

codec=>rubydebug

}

}写入的内容如下图所示:  补充一下:start_positon => beginning 或者是 end

补充一下:start_positon => beginning 或者是 end

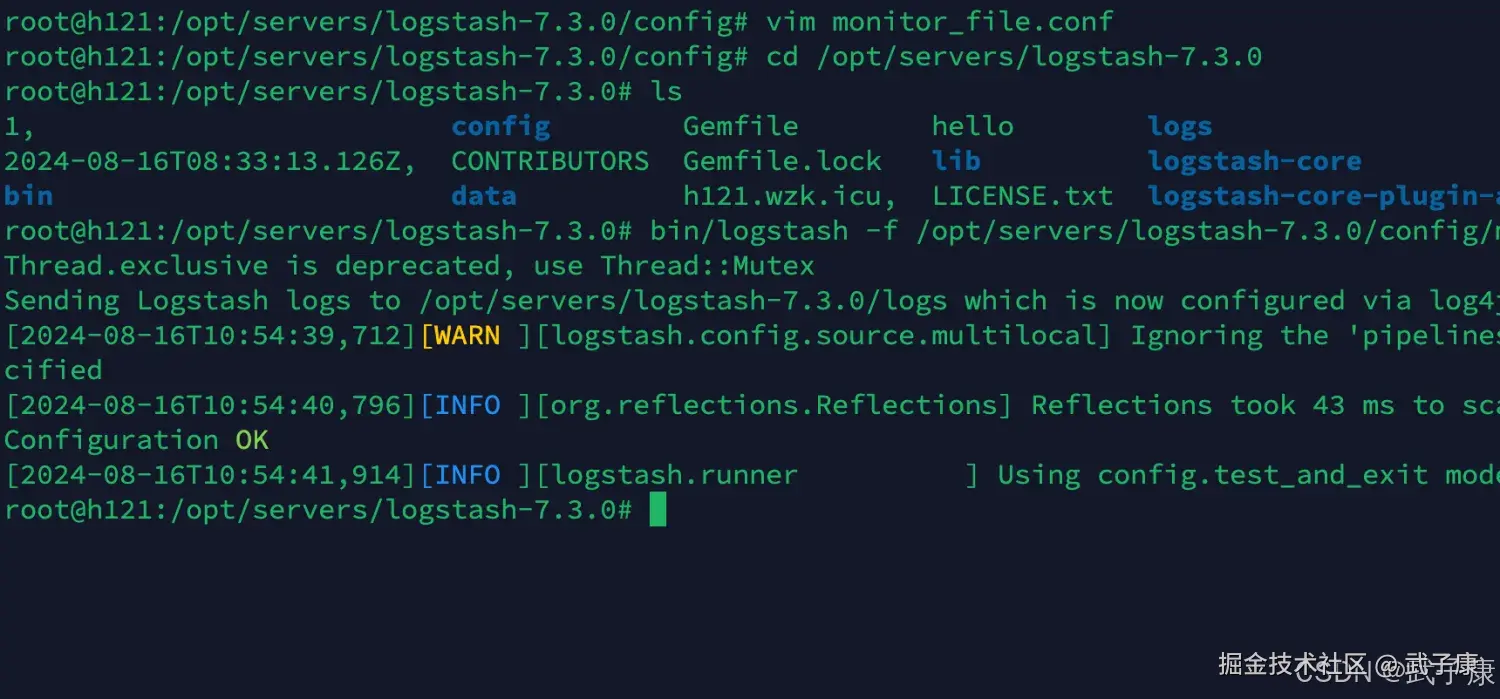

检查配置

通过下面的指令进行检查:

shell

cd /opt/servers/logstash-7.3.0

bin/logstash -f /opt/servers/logstash-7.3.0/config/monitor_file.conf -t截图如下图所示:  可以看到:"Configuration OK",说明我们的配置文件是正确的。

可以看到:"Configuration OK",说明我们的配置文件是正确的。

启动服务

shell

cd /opt/servers/logstash-7.3.0

bin/logstash -f /opt/servers/logstash-7.3.0/config/monitor_file.conf启动结果如下图所示:

发送数据

我们监听到是ES的日志,只要你进行一些操作,就会看到日志被解析了:

其他参数

以下是扩展后的内容,增加了更多细节说明和实际应用示例:

File Input 配置参数详解

Path

- 定义:指定需要监控的文件路径,支持通配符匹配多个文件

- 示例 :

/var/log/nginx/*.log监控nginx目录下所有.log文件/var/log/**/*.log递归监控所有子目录中的.log文件["/var/log/app1.log", "/var/log/app2.log"]监控多个具体文件

Type

- 作用:为不同类型的日志文件打上标记,便于后续处理流程区分

- 应用场景 :

- 设置

type => "nginx"标记nginx日志 - 设置

type => "syslog"标记系统日志 - 在filter阶段可通过

if [type] == "nginx"进行条件处理

- 设置

Start_position

- 行为说明 :

beginning:从文件开头读取,适用于首次导入历史日志end:从文件末尾读取(默认值),适用于持续监控新日志

- 注意事项:切换位置会导致重复读取,建议配合sincedb使用

Discover_interval

- 工作机制 :

- 定期扫描path模式匹配的新文件

- 默认15秒的间隔是性能和实时性的平衡点

- 调优建议 :

- 高频扫描(如5s):适用于日志文件快速轮转的场景

- 低频扫描(如30s):适用于稳定环境减少IO开销

Exclude

- 排除规则 :

- 支持glob模式匹配

- 示例:

exclude => "*.gz"排除所有压缩文件

- 典型应用 :

- 排除归档日志:

exclude => ["*.1", "*.bak"] - 排除临时文件:

exclude => "*.tmp"

- 排除归档日志:

Close_older

- 文件句柄管理 :

- 默认1小时无更新则释放句柄

- 影响:过长占用导致文件无法轮转,过短导致频繁重开

- 特殊场景 :

- 低频日志可设为86400(1天)

- 高并发日志可设为1800(30分钟)

Sincedb

- 元数据存储 :

- 默认路径:

/data/plugins/inputs/file/.sincedb_* - 记录内容:inode号、设备号、读取位置等

- 默认路径:

- 集群部署 :

- 建议显式指定路径如:

sincedb_path => "/var/lib/logstash/sincedb" - 避免多实例冲突

- 建议显式指定路径如:

Sincedb_write_interval

- 持久化策略 :

- 默认15秒写入一次

- 在crash时最多丢失15秒的读取进度

- 可靠性权衡 :

- 重要日志可设为5秒

- 高性能场景可设为30秒

Start_interval

- 文件检测机制 :

- 默认每秒检查文件更新

- 检测内容包括:文件大小变化、inode变更等

- 性能影响 :

- 高频检测(0.1秒):实时性高但CPU开销大

- 低频检测(5秒):适用于批量写入场景

最佳实践示例

ruby

input {

file {

path => ["/var/log/app/*.log", "/var/log/nginx/access.log"]

type => "combined_logs"

start_position => "beginning"

exclude => "*.swp"

close_older => 7200

sincedb_path => "/opt/logstash/sincedb/db"

discover_interval => 30

}

}错误速查

| 症状 | 根因 | 定位 | 修复 |

|---|---|---|---|

start_position => "beginning" 但仍从文件末尾开始读 |

目标文件已被 sincedb 记录过;start_position 只对"首次见到的文件"生效 |

查找/确认 sincedb 是否存在、是否记录了该 inode/路径;看 Logstash 启动日志里 sincedb 路径提示 |

明确策略:要"从头重读"就清理对应 sincedb 记录或更换 sincedb_path;要"断点续读"就保留 sincedb 并不要改 path/inode |

| 监听文件不出数据/一直空跑 | 路径写错、权限不足、文件无新增、或目标是轮转文件但匹配不到新文件 | -t 先验配置;确认 path 是否命中(glob 展开);看进程是否有读权限 |

修正 path/glob;给 Logstash 运行用户加读权限;轮转场景用通配符并调 discover_interval(避免只盯死一个固定文件名) |

| 重启后重复采集大量历史数据 | 关闭/丢失 sincedb,或 sincedb_path 指到了临时目录/容器易失盘 |

查 sincedb 是否持久化;容器环境检查挂载卷 |

需要"续读"就把 sincedb_path 固定到持久化目录;需要"每次全量重读"才用不可持久化策略(代价是重复数据) |

| 以为会从头读,结果只读到"首次启动时刻之后"的新增 | 误解:start_position 不会覆盖已存在的 sincedb 偏移 |

对比首次启动时间与 Kibana/输出中的最早事件时间 | 明确一次性导历史:首次运行前准备好配置与 start_position => "beginning";之后不要复用旧 sincedb 去做"从头导入" |

| 配置校验通过但运行时报语法/插件错误 | 配置段落括号/引号问题、插件名拼错、参数名写错(常见于手敲 conf) |

bin/logstash -f xxx.conf -t;运行时看具体报错行号 |

对照插件文档校参数名;最小化配置逐步加回;必要时先用 stdout{} 做输出端隔离 |

file 输入读着读着"卡住"或文件轮转后漏数据 |

inode 复用/轮转策略导致"同路径不同文件"被当成已读,或轮转频繁但扫描间隔偏大 |

观察轮转方式(rename/copytruncate);查看讨论中对 inode 复用的解释 |

轮转配通配符;调整扫描参数;关键场景把采集交给 Filebeat 再进 Logstash(降低 file input 轮转坑位) |

sincedb 找不到/写不进去 |

默认落到运行用户 $HOME,该目录不可写或运行用户变化 |

看启动日志中 sincedb 实际路径;检查目录权限 |

显式设置 sincedb_path 到可写且稳定的目录,并保证多实例不共享同一个 sincedb 文件 |

安装/运行有 Java 相关 warning 或插件安装失败 |

Java 版本与特定插件/依赖不兼容,或 JVM 参数/模块访问限制(7.x + 新 JDK 常见) | 看 warning 关键词(illegal reflective access / add-opens 等) |

将 Java 版本固定到"能稳定跑通你插件集合"的组合;不要在未验证前升级 JDK;必要时按报错提示补 --add-opens |

其他系列

🚀 AI篇持续更新中(长期更新)

AI炼丹日志-29 - 字节跳动 DeerFlow 深度研究框斜体样式架 私有部署 测试上手 架构研究 ,持续打造实用AI工具指南! AI研究-132 Java 生态前沿 2025:Spring、Quarkus、GraalVM、CRaC 与云原生落地

💻 Java篇持续更新中(长期更新)

Java-196 消息队列选型:RabbitMQ vs RocketMQ vs Kafka MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务已完结,Dubbo已完结,MySQL已完结,MongoDB已完结,Neo4j已完结,FastDFS 已完结,OSS已完结,GuavaCache已完结,EVCache已完结,RabbitMQ正在更新... 深入浅出助你打牢基础!

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈! 大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解