破局路侧感知困境:毫米波雷达+相机融合算法如何重塑智能交通

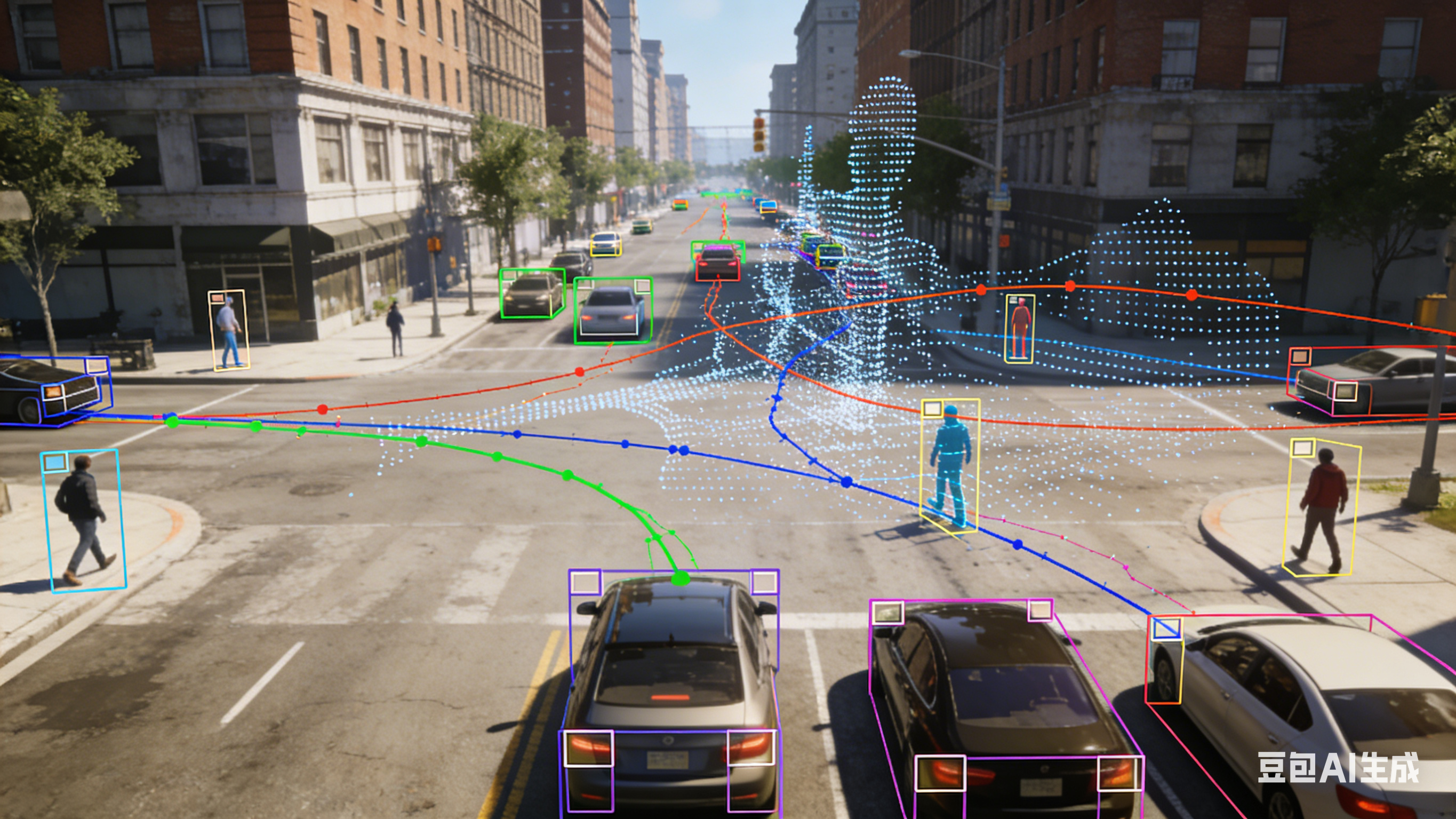

随着城市化进程的加速与汽车保有量的爆发式增长,交通拥堵已成城市运行的"顽疾",交通事故频发更直接威胁着人们的出行安全。在此背景下,智能交通系统(ITS)成为破解上述难题的核心抓手,而路侧感知设备作为智能交通系统的"眼睛",其感知精度与稳定性直接决定了整个系统的运行效能。然而,当前主流的单一车辆检测传感器均存在难以规避的局限性------激光雷达成本高昂且易受恶劣天气影响,相机在光照不足、遮挡场景下检测精度骤降,毫米波雷达虽抗干扰能力强但目标识别能力较弱,均无法满足智能交通系统全量、高精度、全天候的协同感知需求。由此,深耕毫米波雷达与相机的检测、跟踪及融合算法,成为提升路侧感知设备性能的关键突破口。本文将围绕路侧感知系统的核心研究内容,详细拆解毫米波雷达与计算机视觉融合方案的技术路径与实践成效。

一、毫米波雷达信号处理:筑牢感知基础,突破距离与精度瓶颈

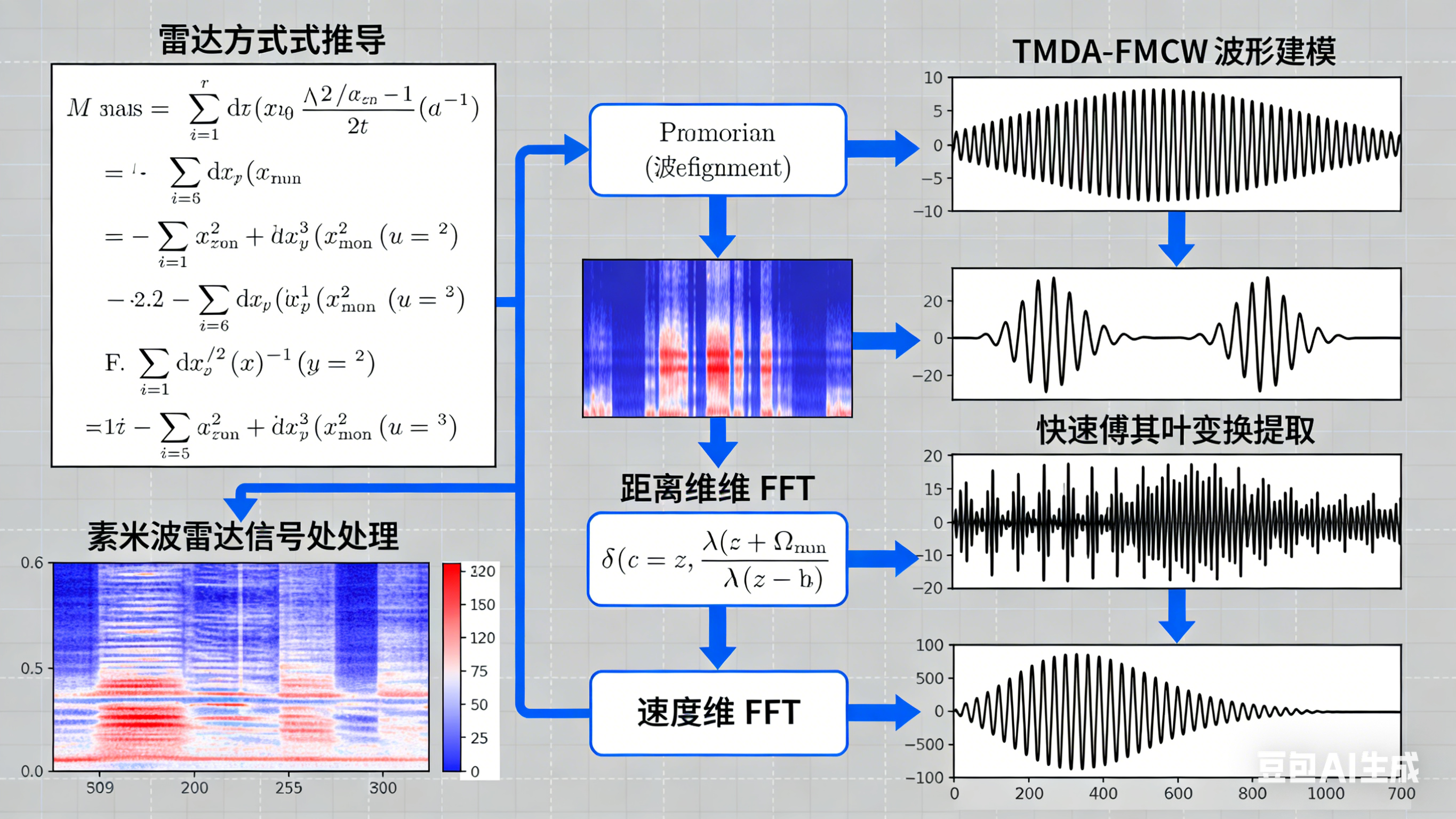

毫米波雷达凭借其强抗干扰性、全天候工作能力的优势,成为路侧感知的核心设备之一,而精准的信号处理则是其发挥效能的基础。本研究从雷达方程的根本推导入手,充分考虑传播损耗、目标散射特性、天线增益、系统噪声等多种关键因素,建立了更贴合实际应用场景的雷达方程及最大作用距离方程,为后续雷达感知的精度提升提供了理论支撑。

针对MIMO雷达系统的信号特性,本研究对TMDA-FMCW波形进行了精细化建模与仿真验证。仿真结果表明,该波形模型能够有效提升雷达的距离分辨率与角度分辨率,为后续目标检测与跟踪奠定了良好的信号基础。在此基础上,本研究详细阐述并仿真实现了雷达信号处理的核心流程,包括距离维FFT、速度维FFT等关键算法------距离维FFT通过傅里叶变换将时域信号转换为频域信号,实现对目标距离的精准测量;速度维FFT则通过对多帧信号的相位分析,完成对目标运动速度的计算。

为进一步提升雷达目标感知的准确性,本研究还设计了基于相对标定法的目标RCS(雷达散射截面)测量方法。该方法通过对标准目标与被测目标的雷达回波信号进行对比分析,实现对目标RCS的精准测量。实验数据显示,该测量方法的误差控制在实际应用允许范围内,能够为雷达目标识别与分类提供可靠的特征依据。

二、毫米波雷达数据处理:应对复杂场景,提升多目标跟踪稳定性

在实际道路场景中,毫米波雷达易受杂波干扰、多目标重叠、弱目标存在等问题影响,导致原始数据中包含大量无效信息,严重影响目标跟踪的精度与稳定性。为此,本研究针对复杂道路场景的特性,设计了多步骤的数据预处理流程:首先通过选择感兴趣区域(ROI),剔除道路范围外的无效信号;再通过弱目标剔除算法,过滤掉因噪声干扰产生的虚假目标,有效提升了雷达数据的信噪比。

在目标状态估计环节,考虑到道路目标运动存在非线性特性,本研究引入卡尔曼滤波(KF)及扩展卡尔曼滤波(EKF)算法。卡尔曼滤波能够对线性系统的目标状态进行最优估计,而扩展卡尔曼滤波则通过一阶泰勒展开将非线性系统线性化,实现对非线性系统的目标状态估计,有效解决了车辆、行人等目标运动过程中的状态突变问题。

针对多目标跟踪过程中易出现的目标粘连、跟踪丢失等问题,本研究提出了基于马氏距离的高效多扩展目标聚类和跟踪算法。马氏距离能够充分考虑目标特征的协方差矩阵,有效区分不同目标的特征差异,提升聚类的准确性。经仿真验证与实地测试表明,该算法在多目标密集分布、杂波干扰严重的场景下,仍能保持较高的跟踪精度与稳定性,显著优于传统跟踪算法。

三、计算机视觉目标检测:轻量化改进,满足实时感知需求

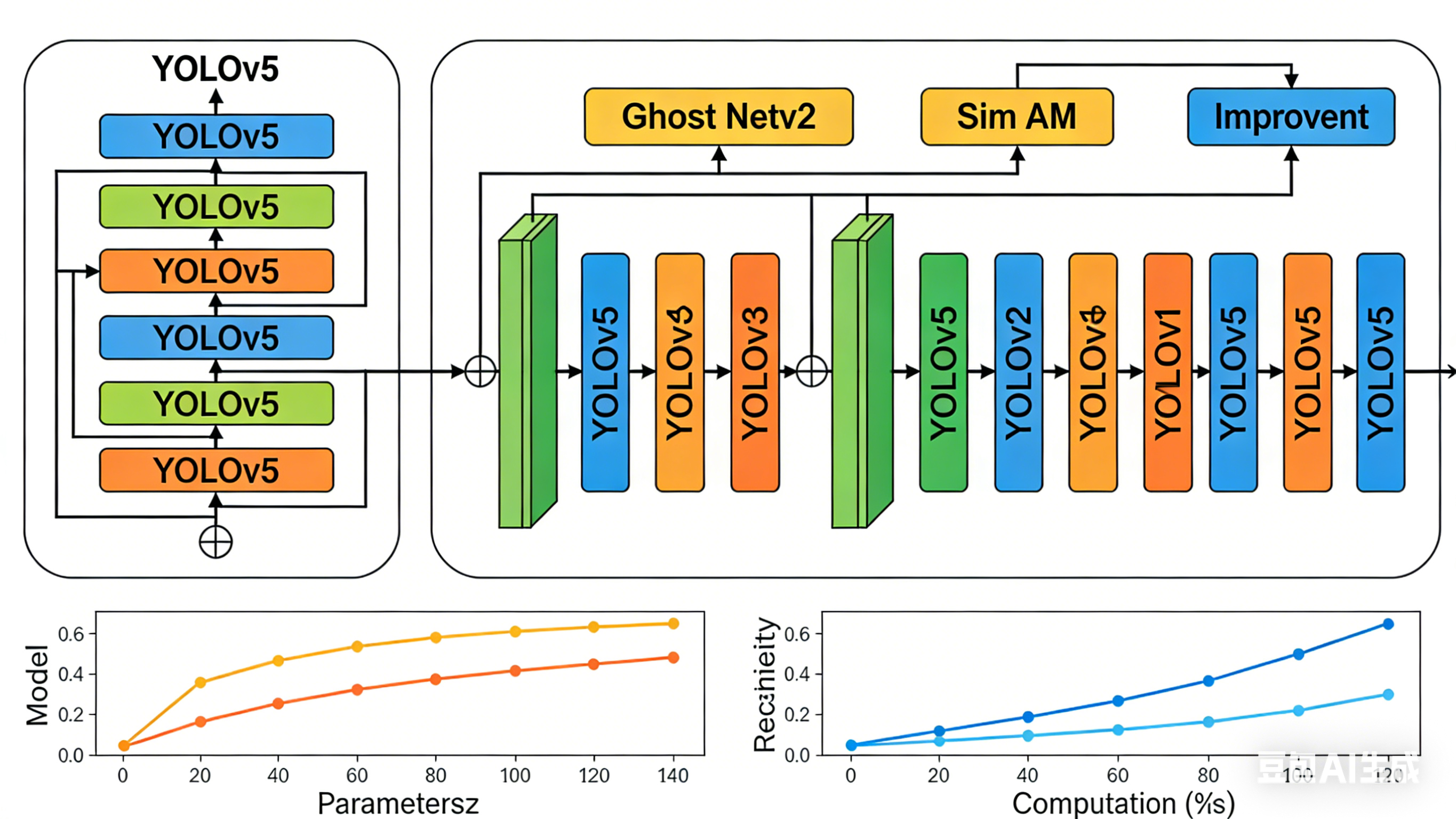

计算机视觉凭借其丰富的目标特征识别能力,成为路侧感知的重要补充。本研究从深度学习及神经网络的基本原理入手,详细阐述了当前主流的目标检测模型YOLOv5的核心架构------YOLOv5采用CSPDarknet作为骨干网络,通过Focus结构进行下采样,利用SPPF结构增强特征提取能力,具备检测速度快、精度高的优势,非常适合路侧实时目标检测场景。

考虑到路侧感知设备的硬件资源限制,本研究提出了基于轻量化YOLOv5的多目标检测与跟踪算法。该算法通过两大核心改进提升模型的轻量化程度与检测性能:一是引入Ghost Netv2网络作为骨干网络,Ghost Netv2通过设计低成本的Ghost模块,在保证特征提取能力的前提下,大幅减少了模型的参数量与计算量;二是融入Sim AM注意力机制,该机制能够自适应地聚焦目标关键特征区域,提升模型对小目标、遮挡目标的检测能力。

为验证改进算法的有效性,本研究开展了消融实验。实验结果表明,改进后的轻量化YOLOv5算法在检测准确率基本保持不变的前提下,模型参数量减少35%以上,计算复杂度降低40%以上,完全满足路侧感知设备的实时检测需求,为后续与毫米波雷达的融合奠定了良好的算法基础。

四、异构融合感知:优势互补,实现全场景高精度感知

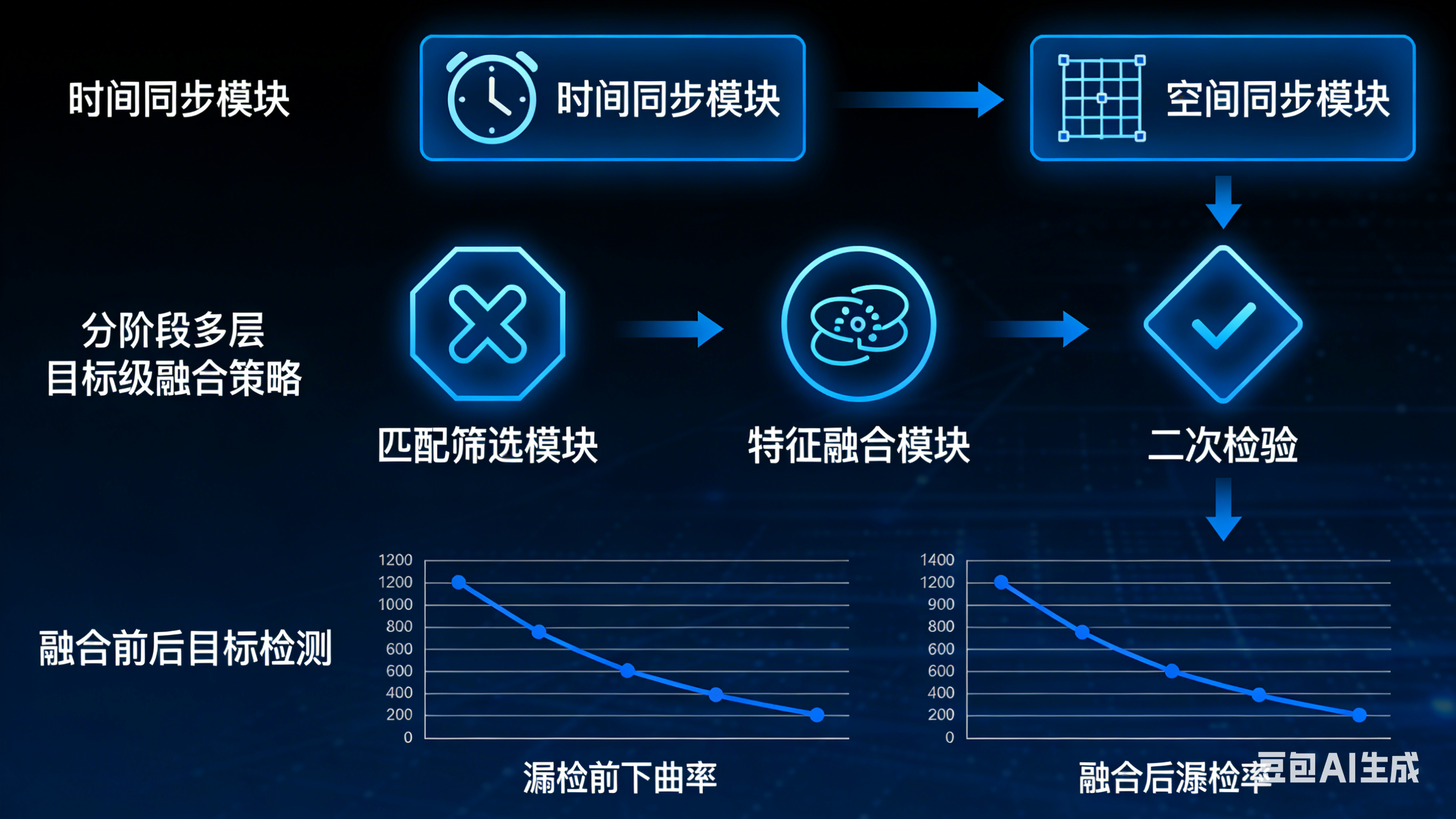

单一传感器的局限性决定了其无法满足智能交通系统全场景感知需求,而毫米波雷达与计算机视觉的异构融合则能够实现优势互补------毫米波雷达擅长目标距离与速度的精准测量,抗干扰能力强;相机擅长目标识别与分类,特征提取能力丰富。为此,本研究提出了基于毫米波雷达和计算机视觉的异构融合感知算法,核心在于实现两大传感器的时间同步、空间同步及目标级融合。

时间同步通过对两大传感器的采样时间进行校准,确保同一时刻采集到的目标数据能够进行融合处理;空间同步通过坐标转换矩阵,将毫米波雷达的极坐标数据转换为相机的像素坐标数据,实现两大传感器数据的空间对齐。在此基础上,本研究设计了分阶段的多层目标级融合策略:第一阶段对两大传感器的目标检测结果进行初步匹配与筛选;第二阶段对匹配成功的目标特征进行融合,提升目标状态估计的精度;第三阶段对未匹配的目标进行二次校验,减少漏检与误检现象。

实验验证表明,该异构融合感知算法有效提升了目标检测的准确性与鲁棒性------在光照不足、雨雪天气、目标遮挡等复杂场景下,目标漏检率降低50%以上,跟踪丢失率显著下降,成功弥补了单一传感器的局限性,为智能交通系统的信号控制、事故预警、路径规划等核心功能提供了可靠的感知数据支撑。

五、总结与展望:融合算法引领智能交通感知升级

本研究围绕路侧感知系统的核心需求,从毫米波雷达信号处理、数据处理、计算机视觉目标检测到异构融合感知,构建了一套完整的技术方案。通过对核心算法的研究与改进,有效解决了单一传感器在复杂道路场景下的感知局限性,提升了路侧感知设备的性能。

未来,随着自动驾驶技术与智能交通系统的深度融合,路侧感知将朝着"车路协同"的方向发展。后续研究可进一步优化融合算法的实时性与自适应能力,结合5G、边缘计算等技术,实现路侧感知数据的实时传输与云端协同处理;同时,可引入更多传感器类型(如激光雷达),构建多传感器融合感知体系,为智能交通系统的全面升级提供更加强劲的技术支撑。