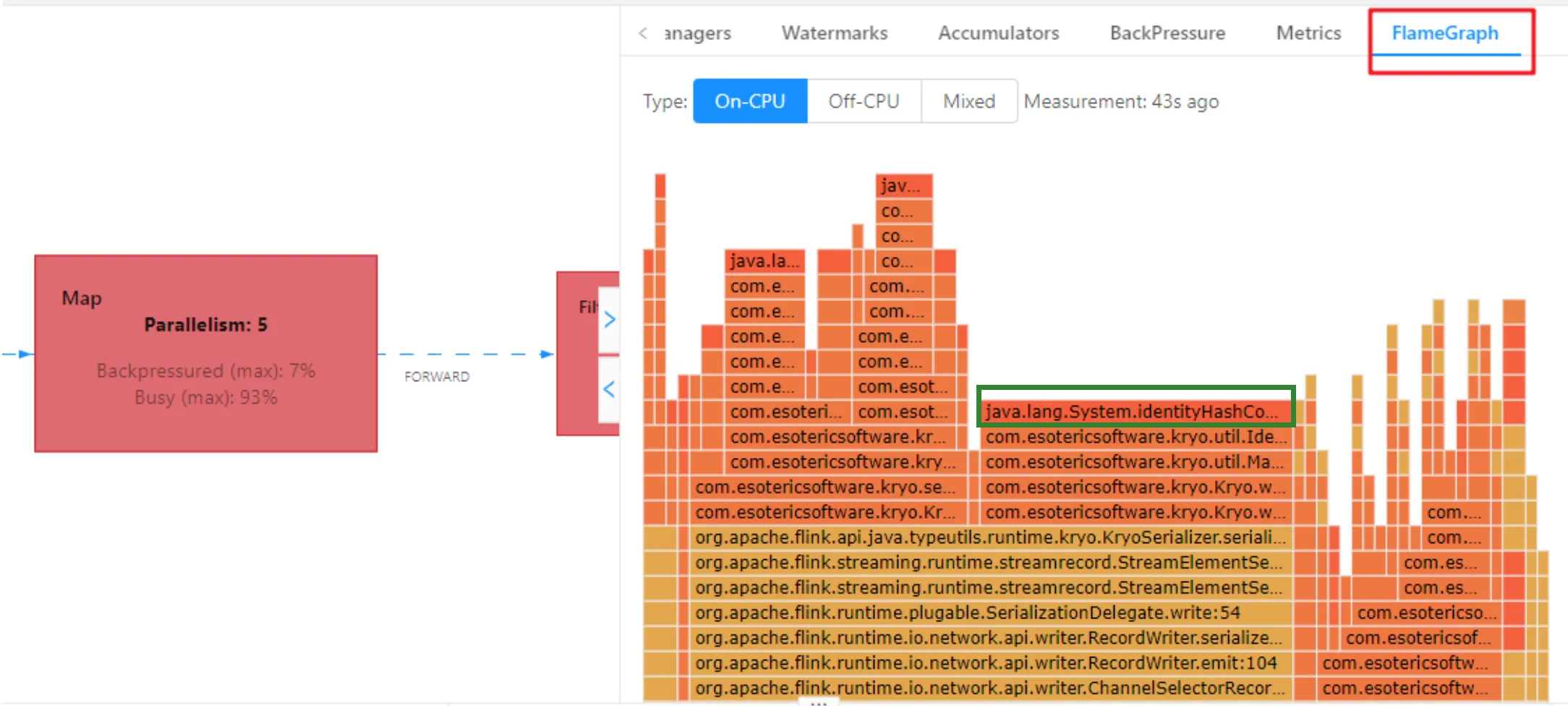

在 Flink 中排查反压(Backpressure)问题时,火焰图(Flame Graph)是定位性能瓶颈的有效工具。以下是详细步骤:

1. 确认反压存在

通过 Flink Web UI 或指标系统检查反压指标:

outputBufferUsage接近 1inPoolUsage持续高位- 下游算子出现

BackPressure标记

2. 生成火焰图

方法一:使用 Async Profiler

# 下载并启动 Profiler

wget https://github.com/async-profiler/async-profiler/releases/download/v2.8/async-profiler-2.8-linux-x64.tar.gz

tar -xzf async-profiler-*.tar.gz

# 附加到 Flink TaskManager 进程

./profiler.sh -d 60 -f /tmp/flamegraph.html <TaskManager_PID>方法二:通过 Flink 配置

在 flink-conf.yaml 中启用分析器:

metrics.profiler.dump.interval: 30s

metrics.profiler.enabled: true

metrics.profiler.dir: /tmp/flink-profiles重启集群后,火焰图将定期生成到指定目录。

3. 分析火焰图关键点

火焰图垂直方向表示调用栈深度,水平方向表示 CPU 时间占比。重点关注:

- 阻塞线程 (如

Netty Server或Checkpoint Barrier) - 高耗时方法(如序列化/反序列化、外部系统调用)

- 资源竞争 (如锁竞争

synchronized或ReentrantLock)

4. 常见反压原因与火焰图特征

| 问题类型 | 火焰图表现 |

|---|---|

| 数据倾斜 | 少数线程的调用栈异常宽大 |

| 外部系统瓶颈 | 大量时间消耗在 JDBC/Kafka 调用 |

| GC 频繁 | GC 线程占用大量 CPU |

| 序列化瓶颈 | ByteBuffer 相关操作耗时高 |

5. 优化建议

-

资源调整:增加 TM 内存或并行度

-

反压源头处理 :

- 数据倾斜:添加

rebalance()或自定义分区 - 外部系统:增加连接池或批量写入

- 数据倾斜:添加

-

代码优化 :

// 避免频繁对象创建 public void flatMap(String value, Collector<Tuple2<String, Integer>> out) { // 使用重用对象代替 new Tuple2<>() reuseTuple.f0 = value; reuseTuple.f1 = 1; out.collect(reuseTuple); }

火焰图示例解析

下图显示 KafkaConsumer 线程因网络延迟阻塞:

▼ 95% KafkaConsumerThread

├─ 70% NetworkClient.poll

│ ├─ 50% Selector.select

│ └─ 20% handleCompletedReceives

└─ 25% Deserialization结论:需检查 Kafka Broker 或网络配置。

通过火焰图定位反压根源后,针对性优化可显著提升作业稳定性。建议结合 Flink 的 Checkpoint 耗时 与 垃圾回收日志 进行交叉验证。