目录

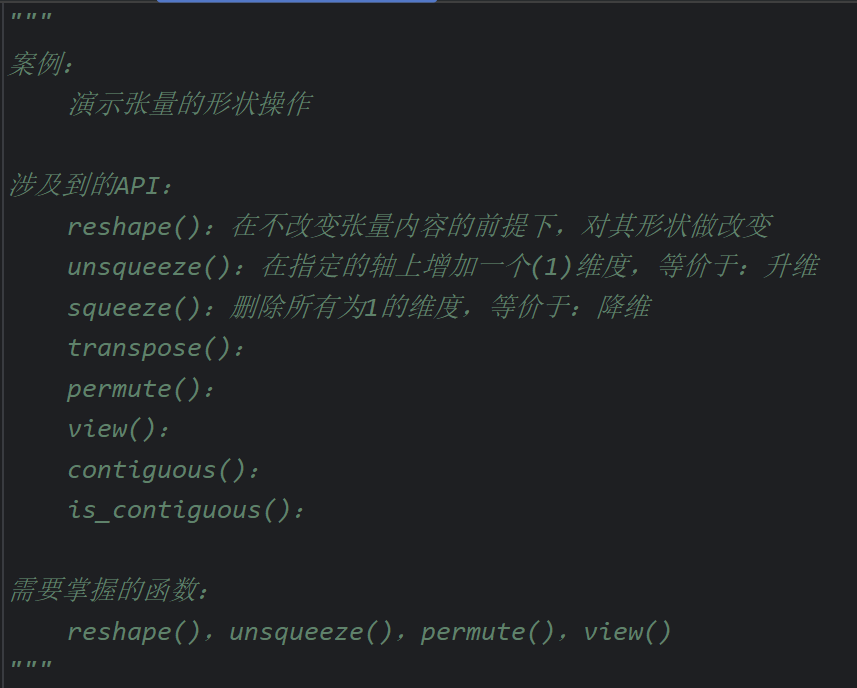

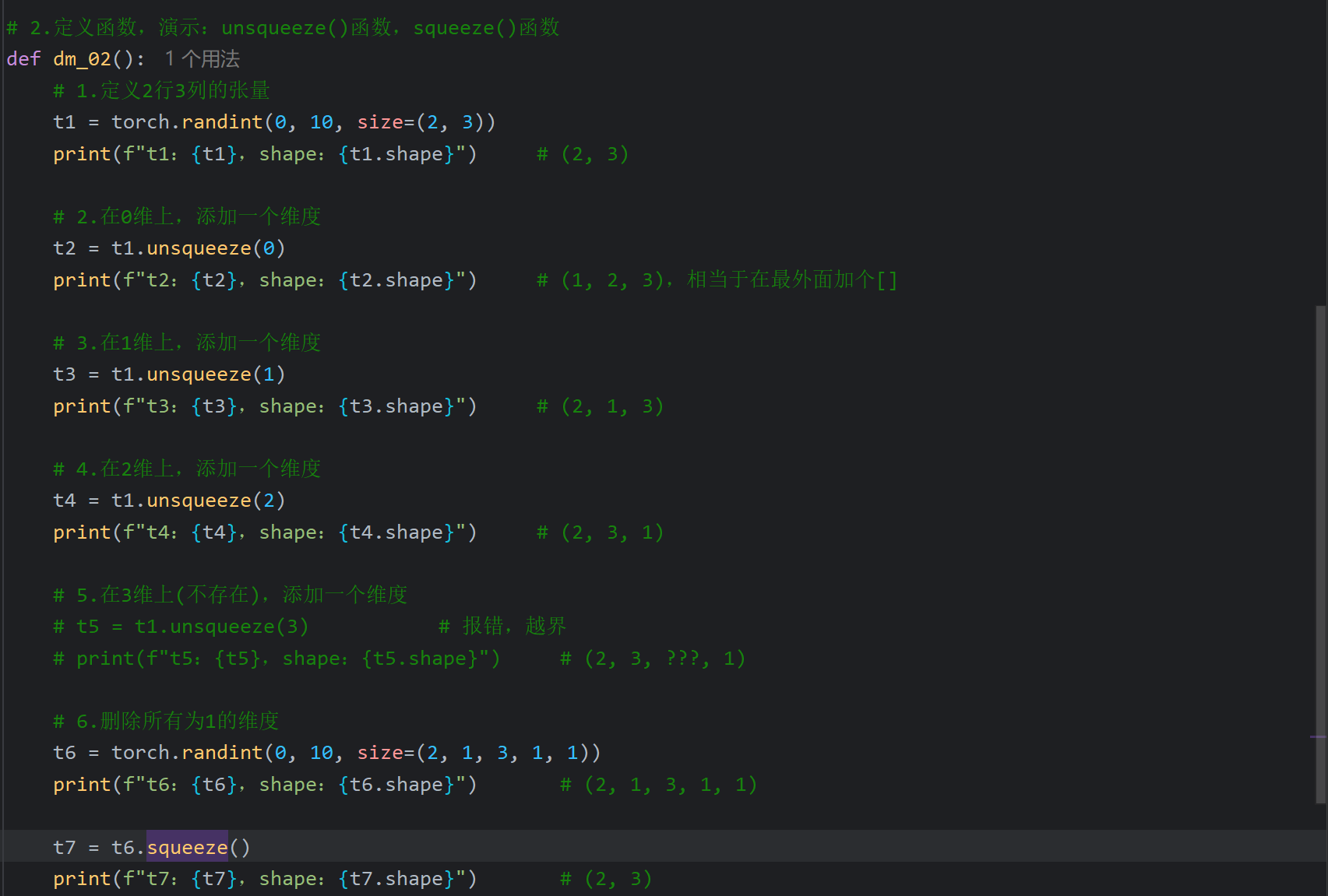

10、张量的形状操作_unsqueeze和squeeze函数

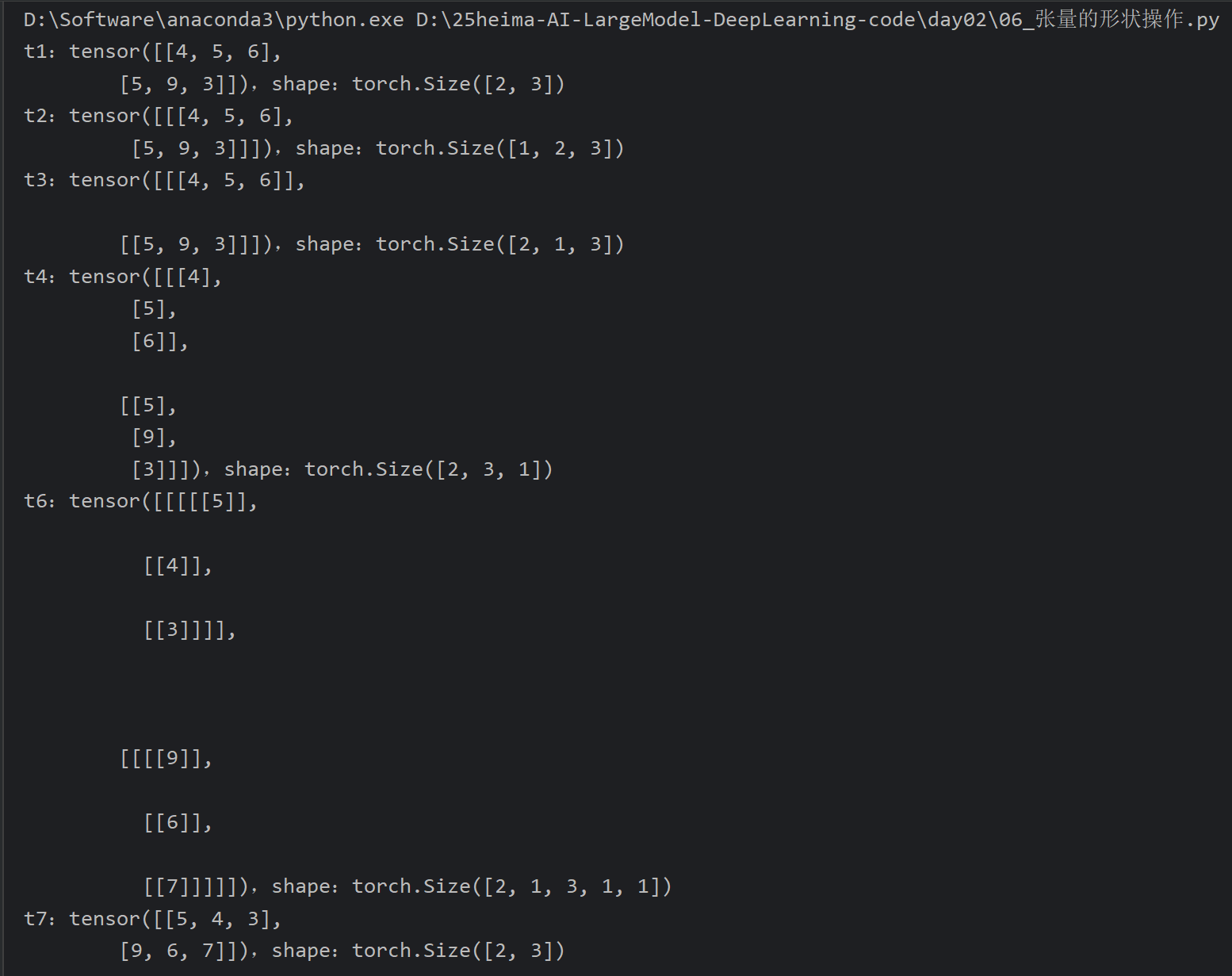

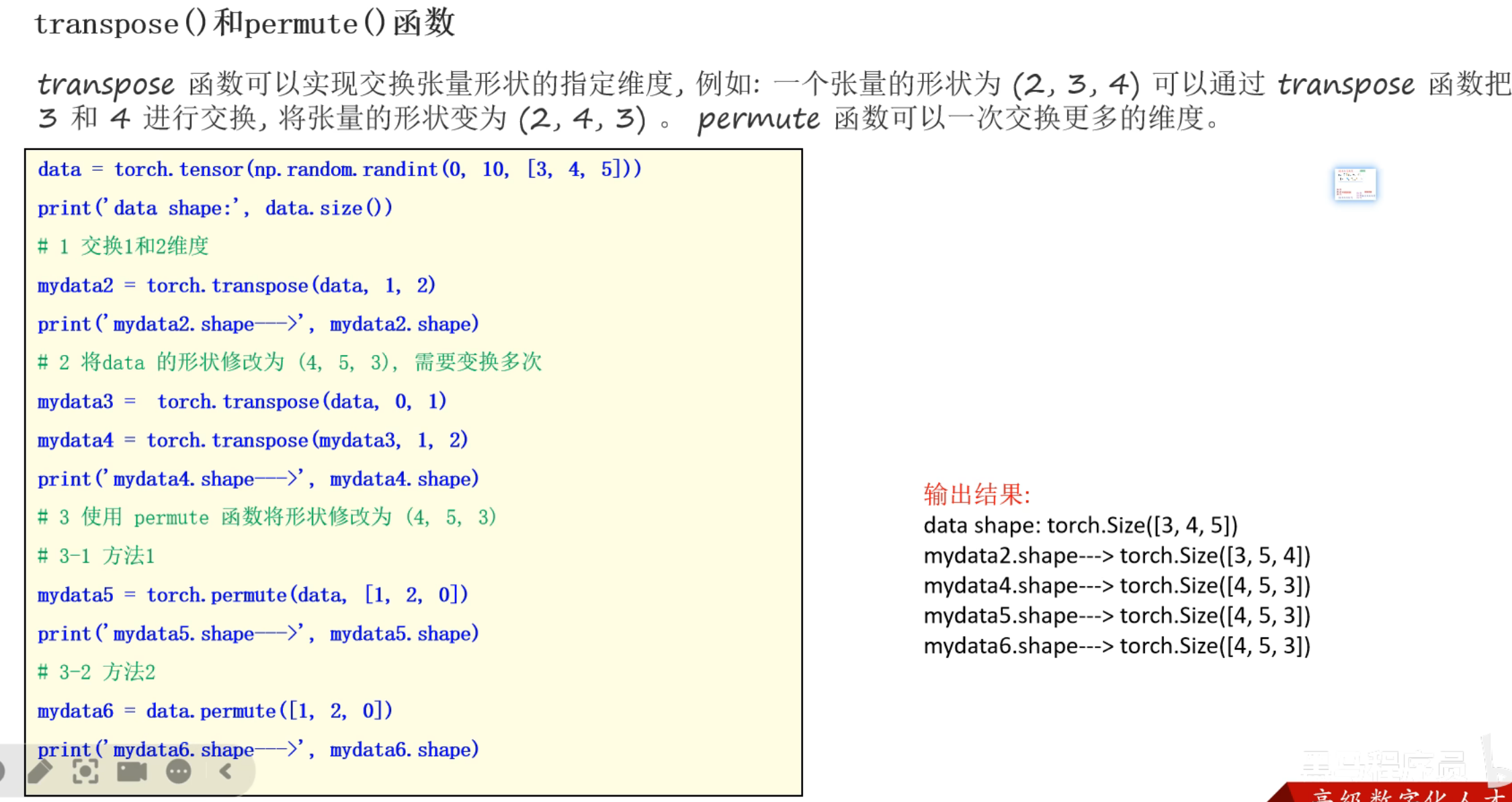

11、张量的形状操作_transpose和premute函数

[6、如何构建神经网络(neural network)](#6、如何构建神经网络(neural network))

[11、损失函数_Smooth L1损失函数介绍](#11、损失函数_Smooth L1损失函数介绍)

一、前言

整体来说整个课程还是不错的,但是我感觉像我这样速成的话知识容量还是太大了,特别是到后面综合起来感觉还是有点力不从心。老师讲解的还可以,不过还是老样子,有的点讲解的很清晰透彻但是有的点又讲的有些混乱。不过我也是第一次接触,没看过其他的课程,个人感觉作为基础入门还是很不错的,至于把知识点串联起来可能还得多复盘学习吧。特别是最后的案例我跟着敲完感觉还是有点理不清,后续我自己再复盘总结一下

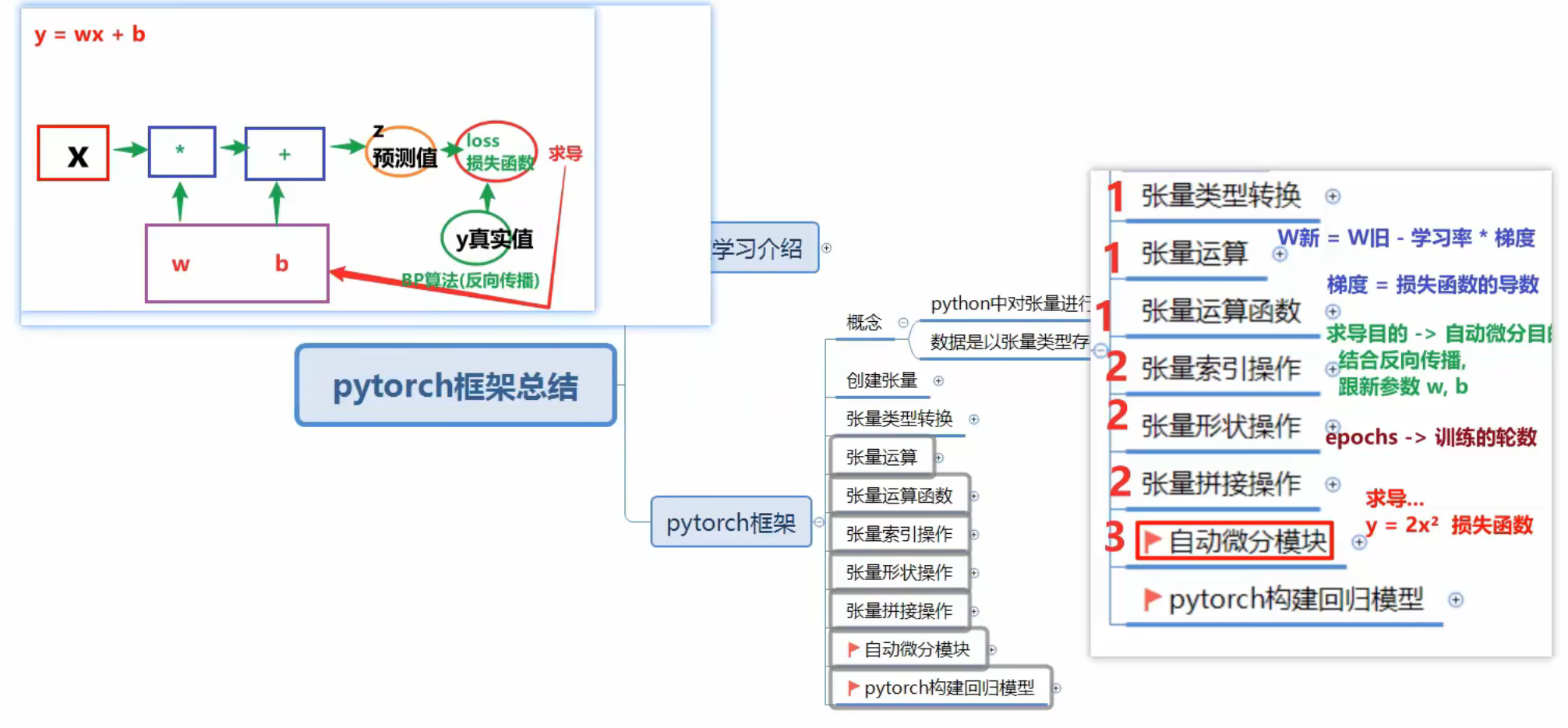

二、Day01

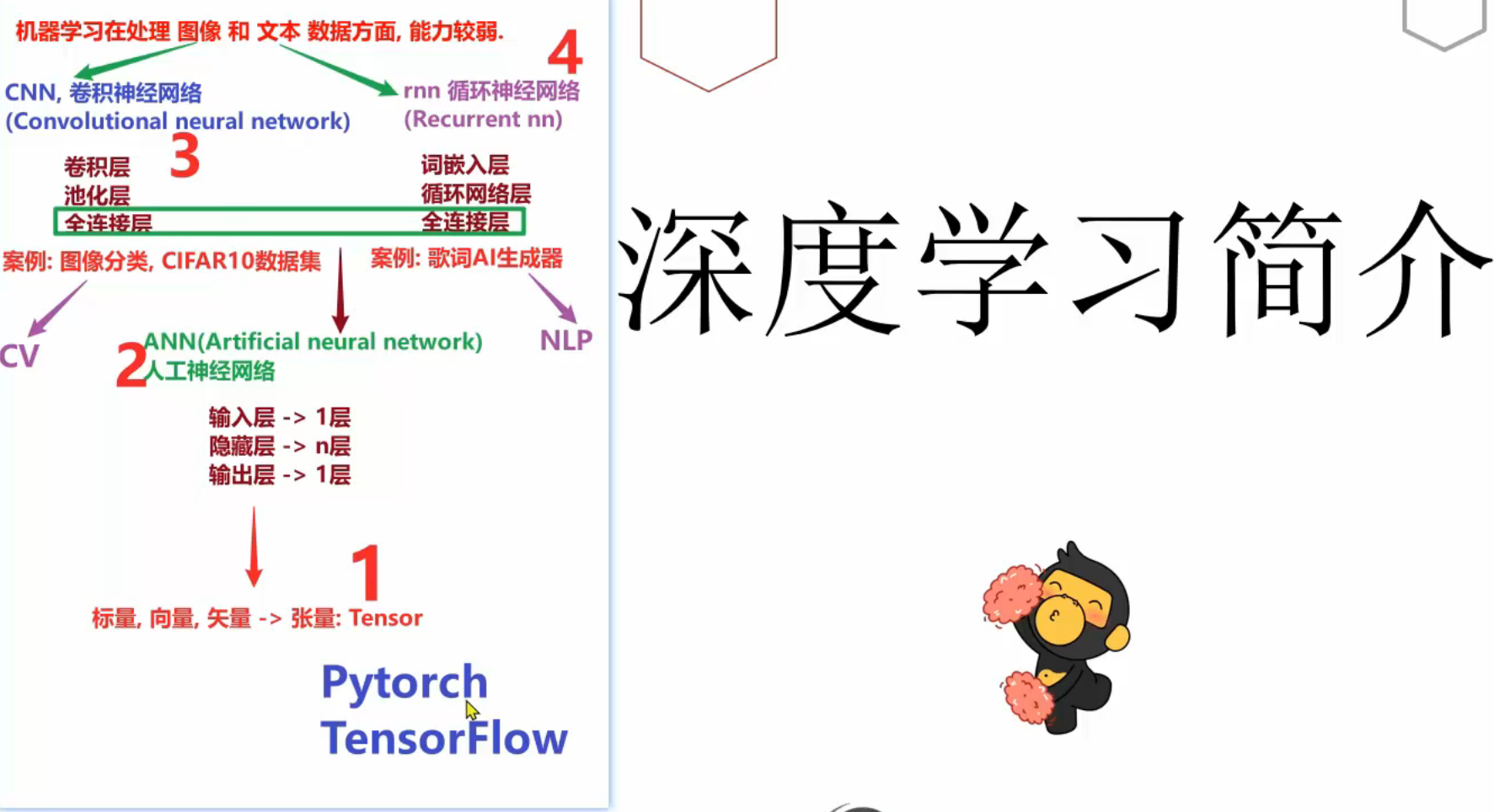

1、深度学习_知识框架介绍

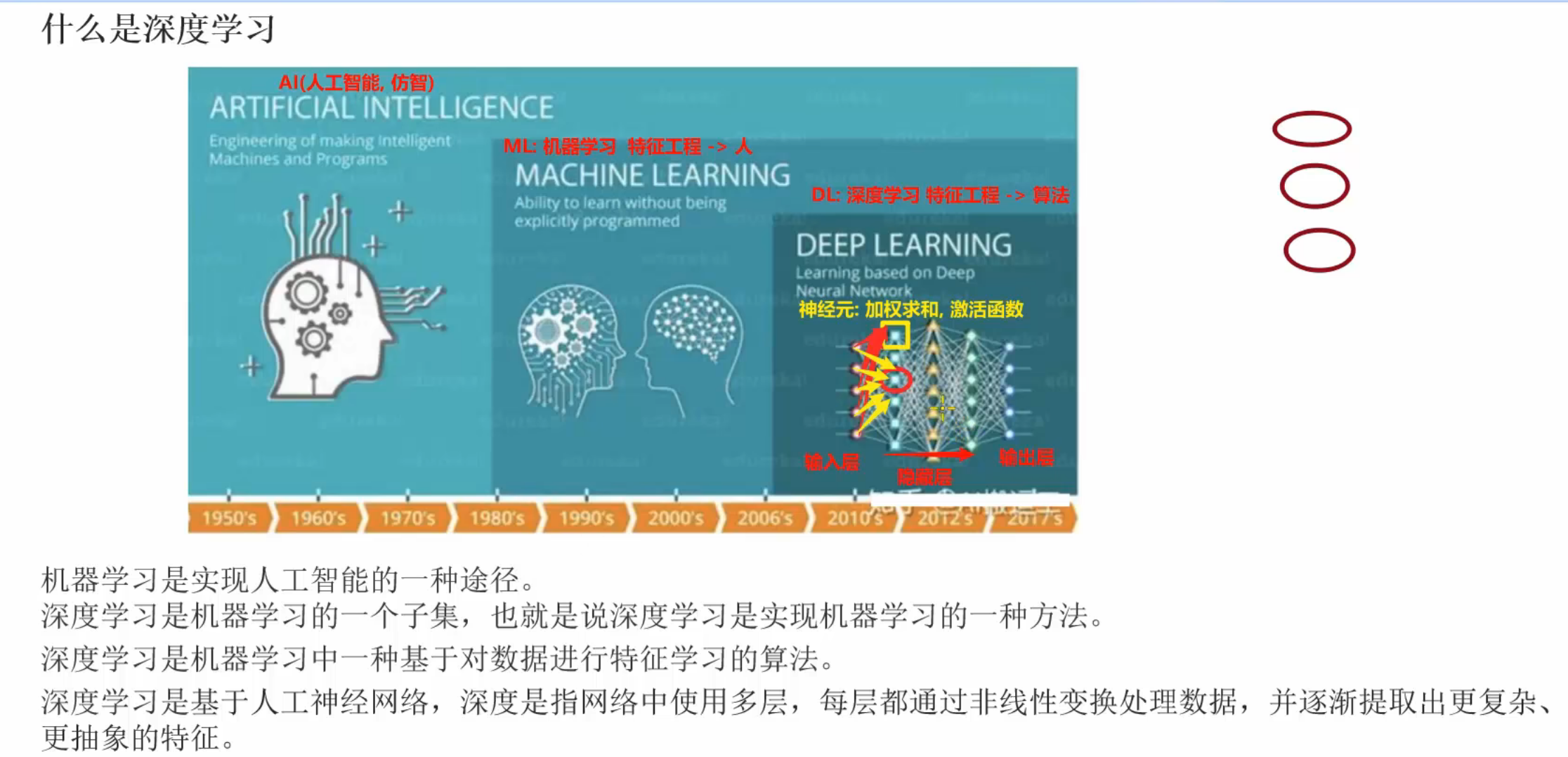

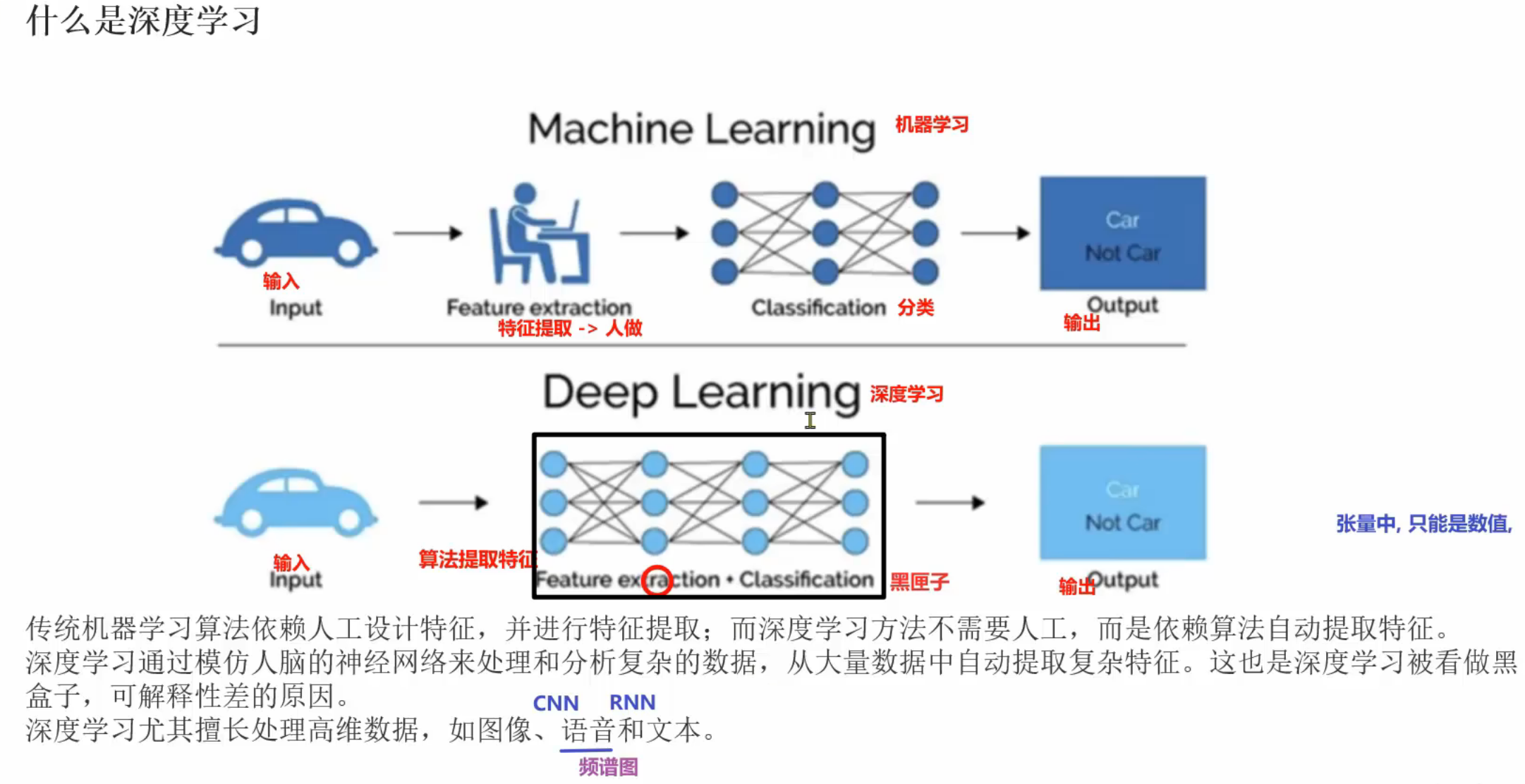

2、深度学习_简介

3、深度学习_特点

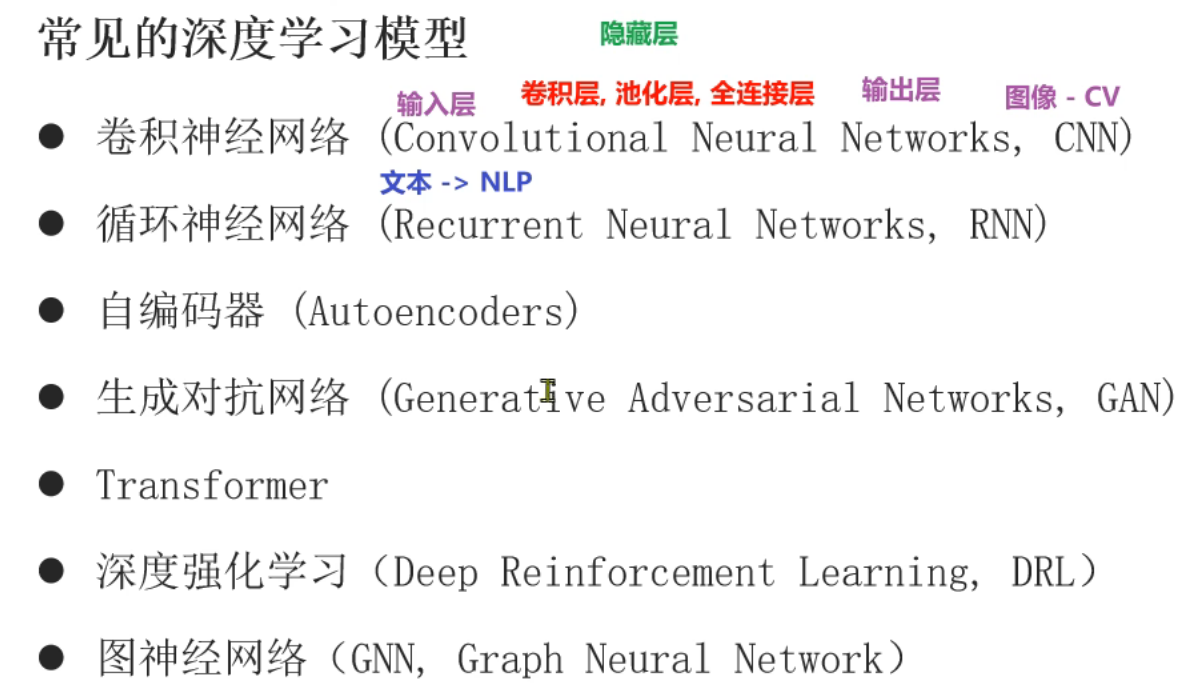

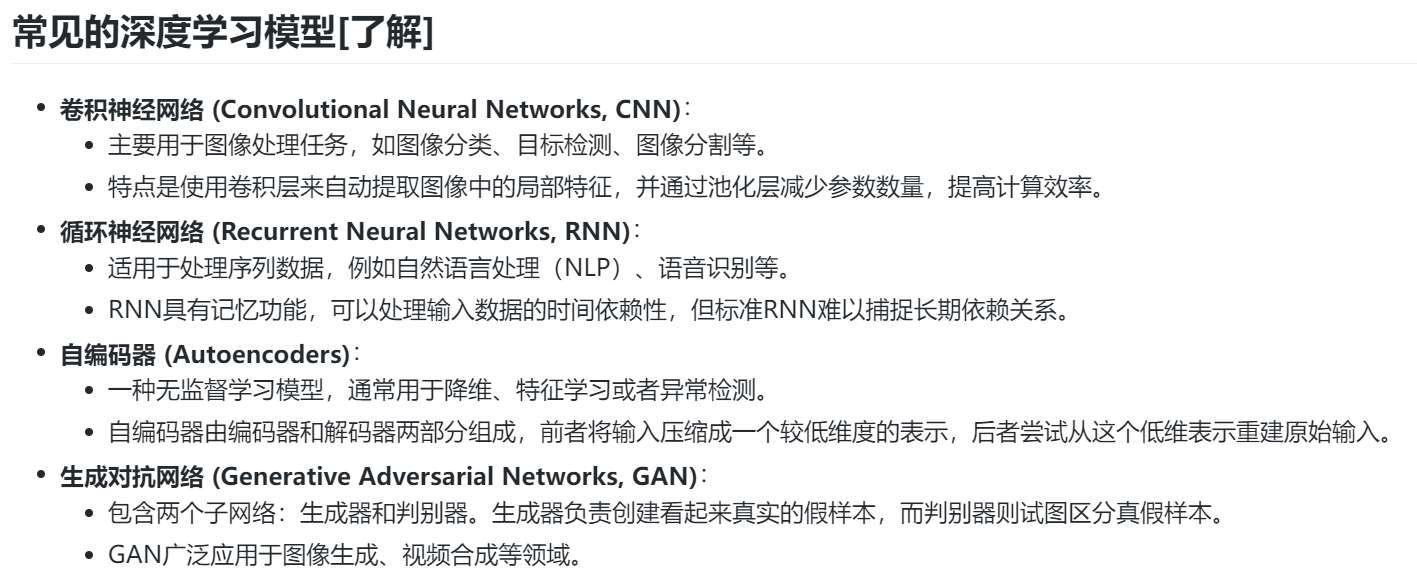

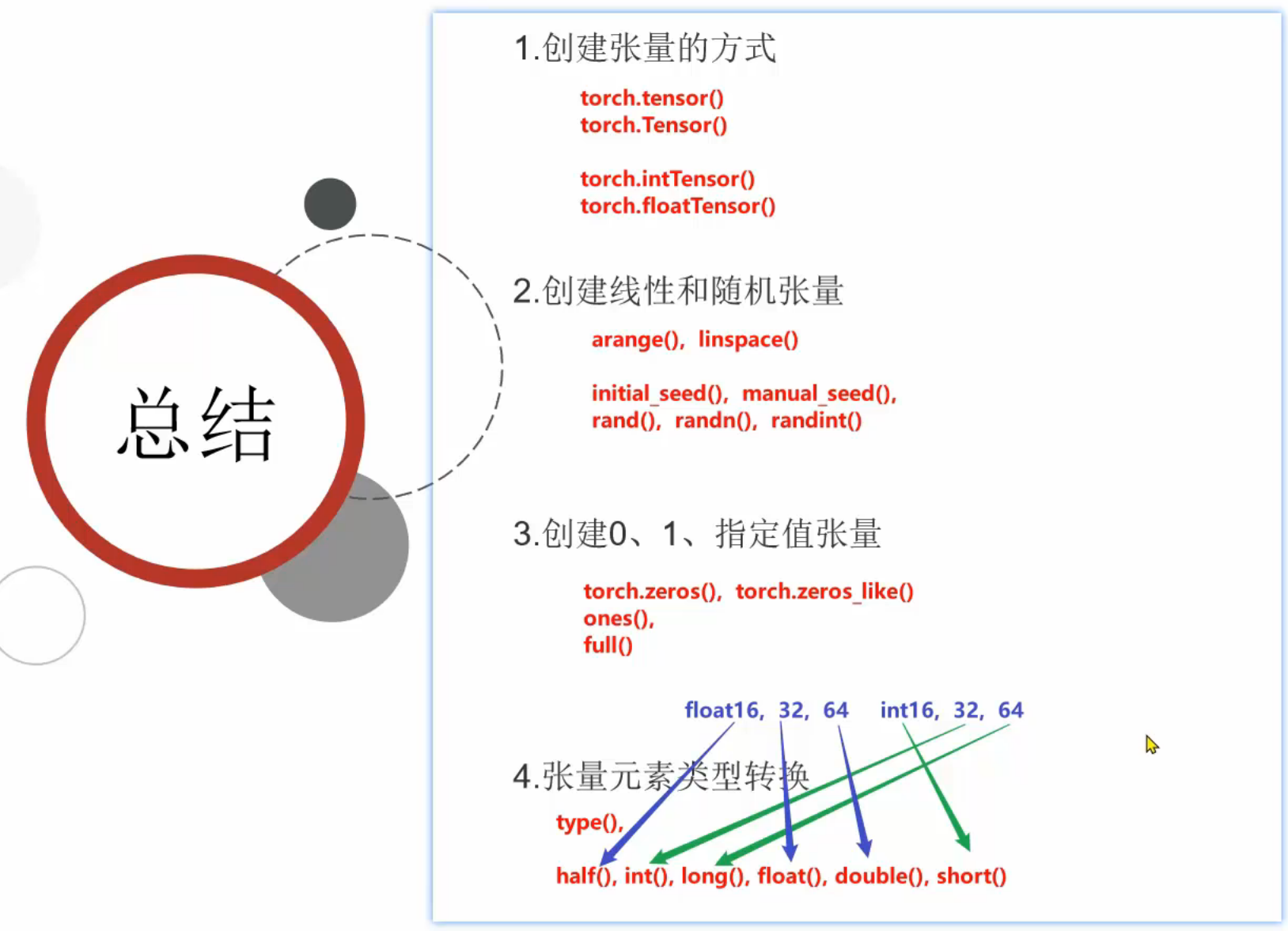

4、深度学习_常用模型介绍

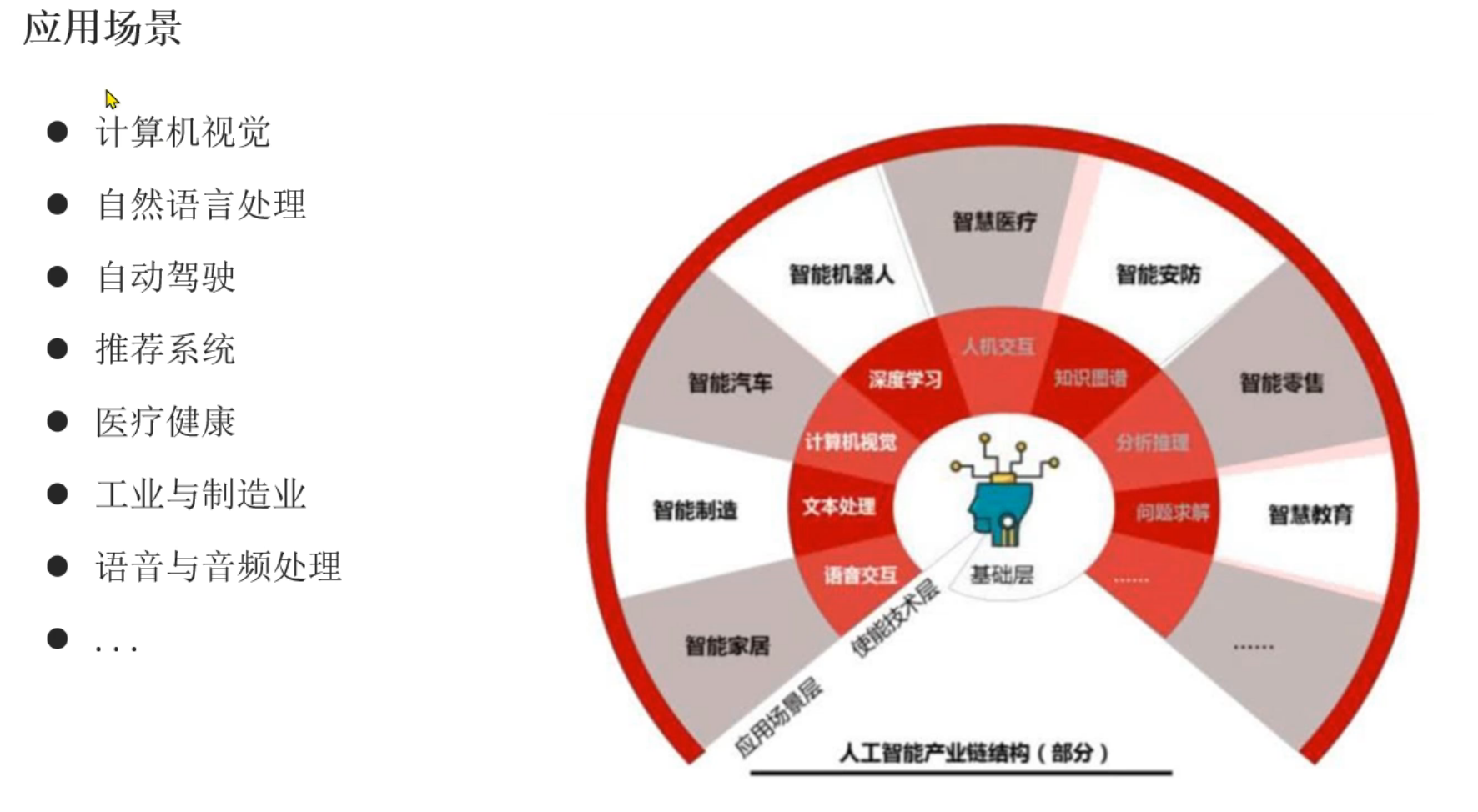

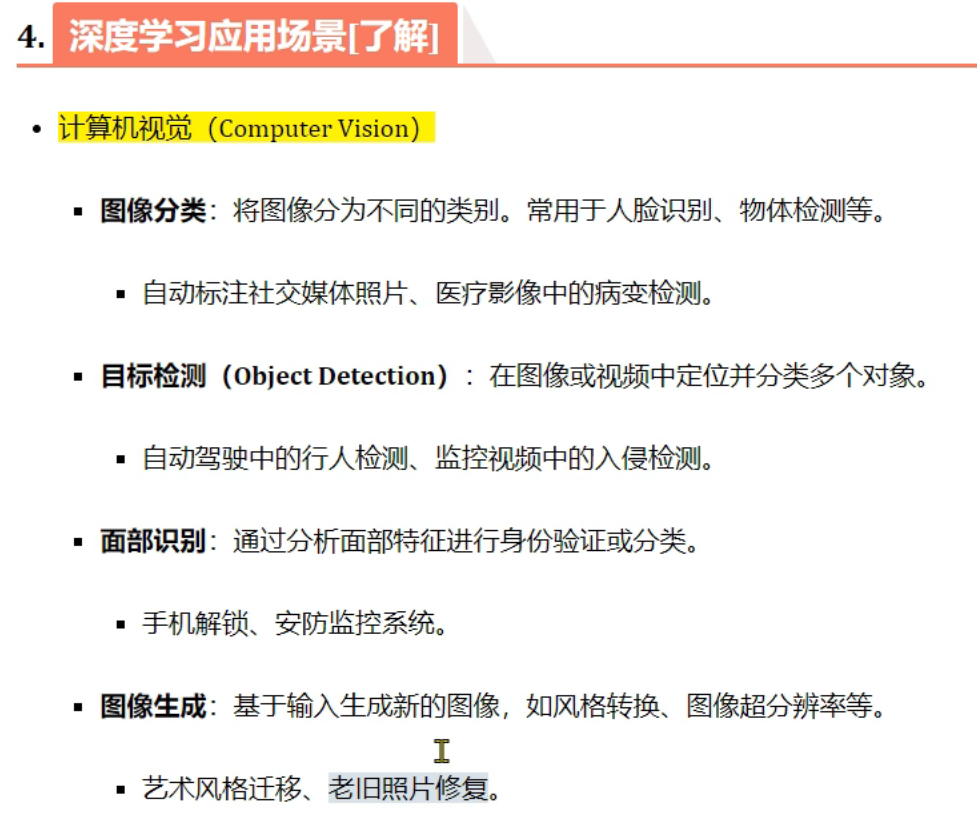

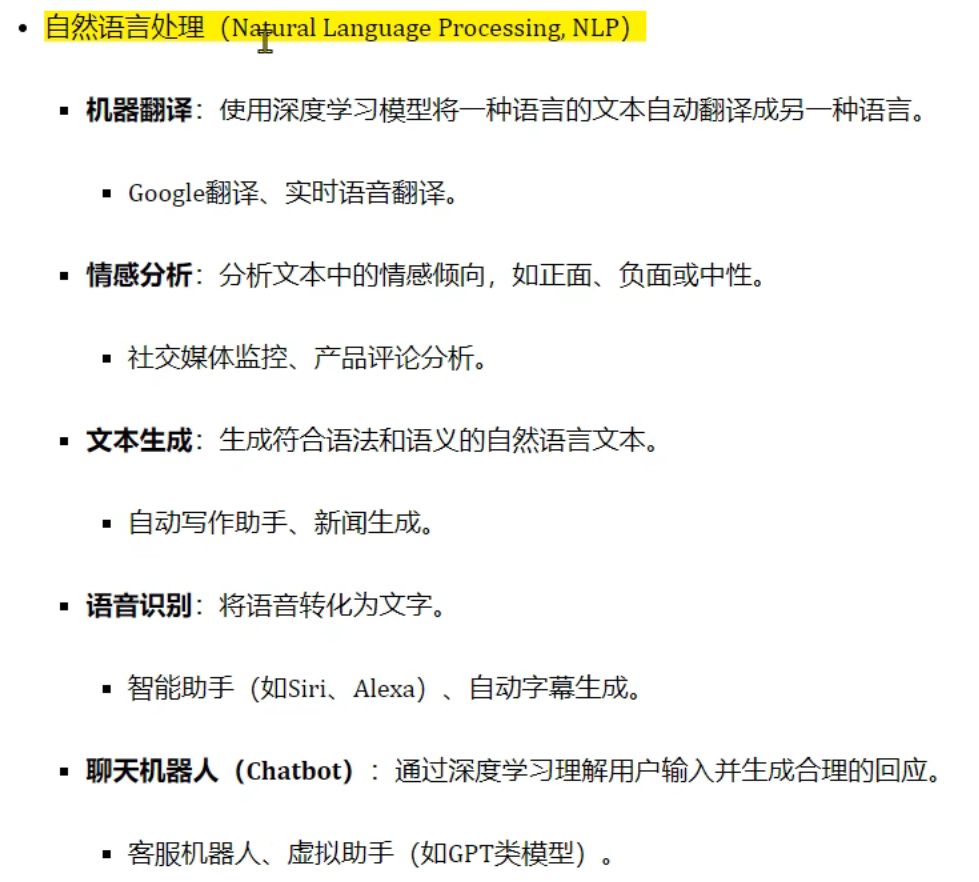

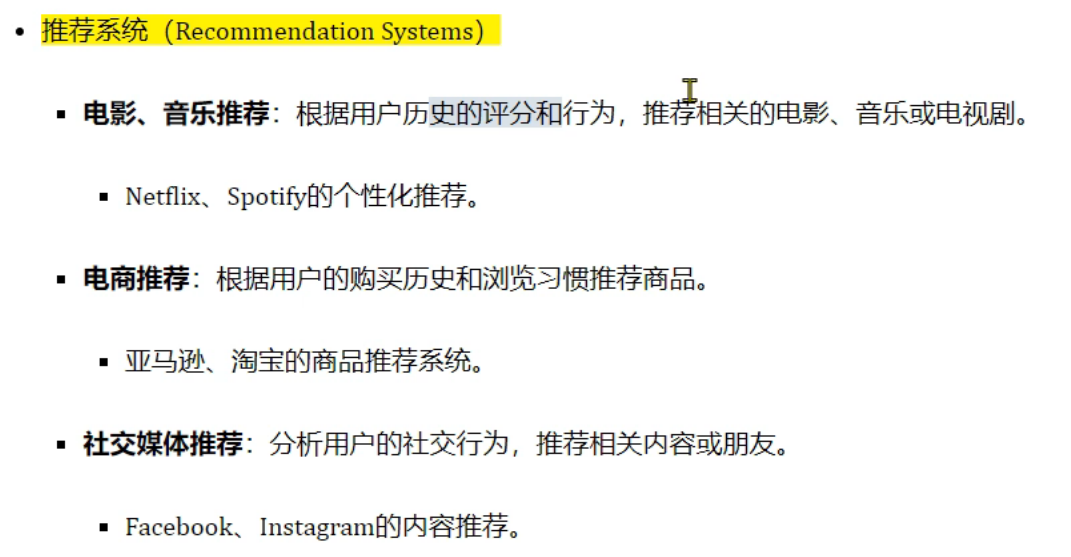

5、深度学习_应用场景介绍

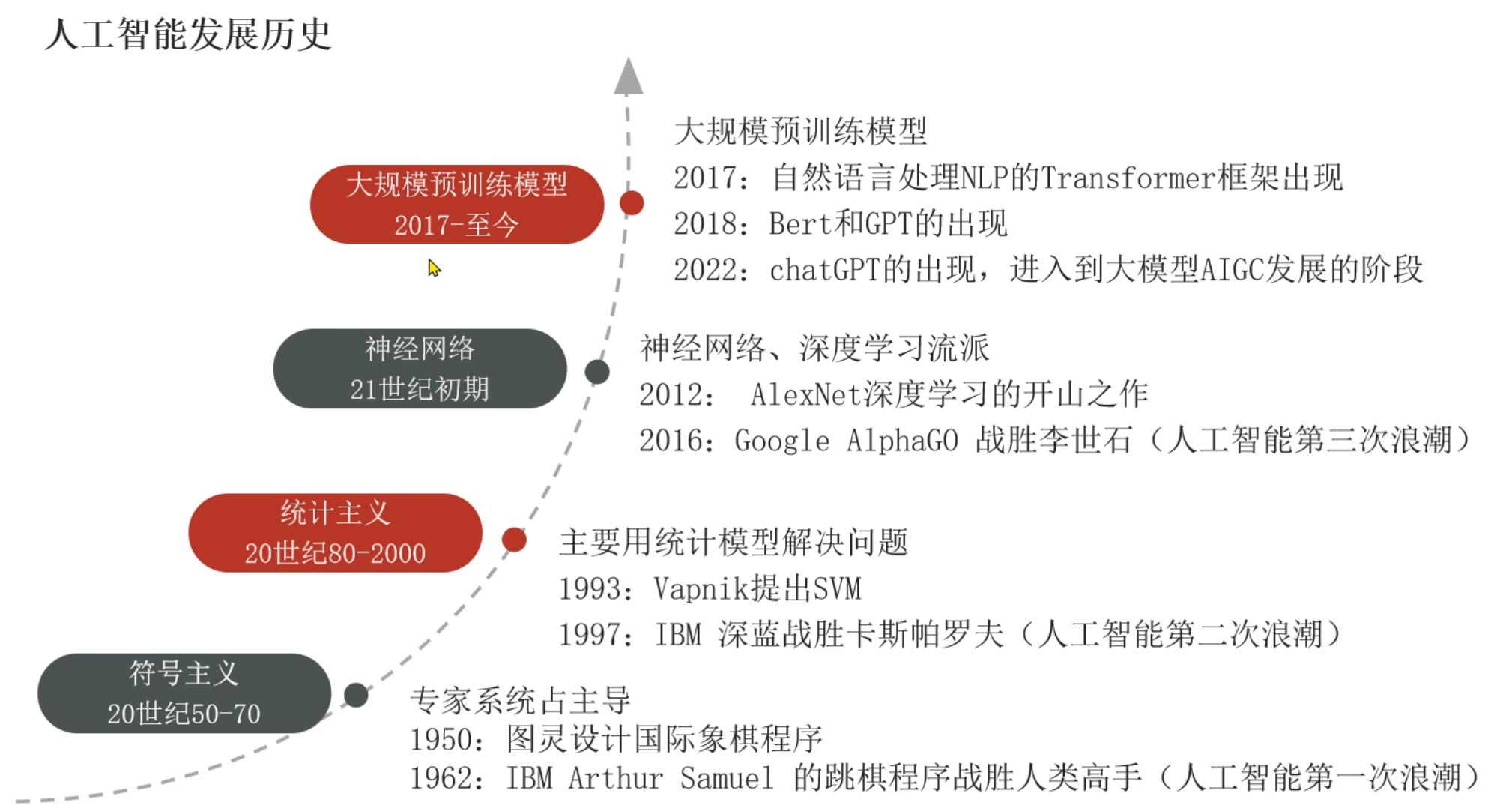

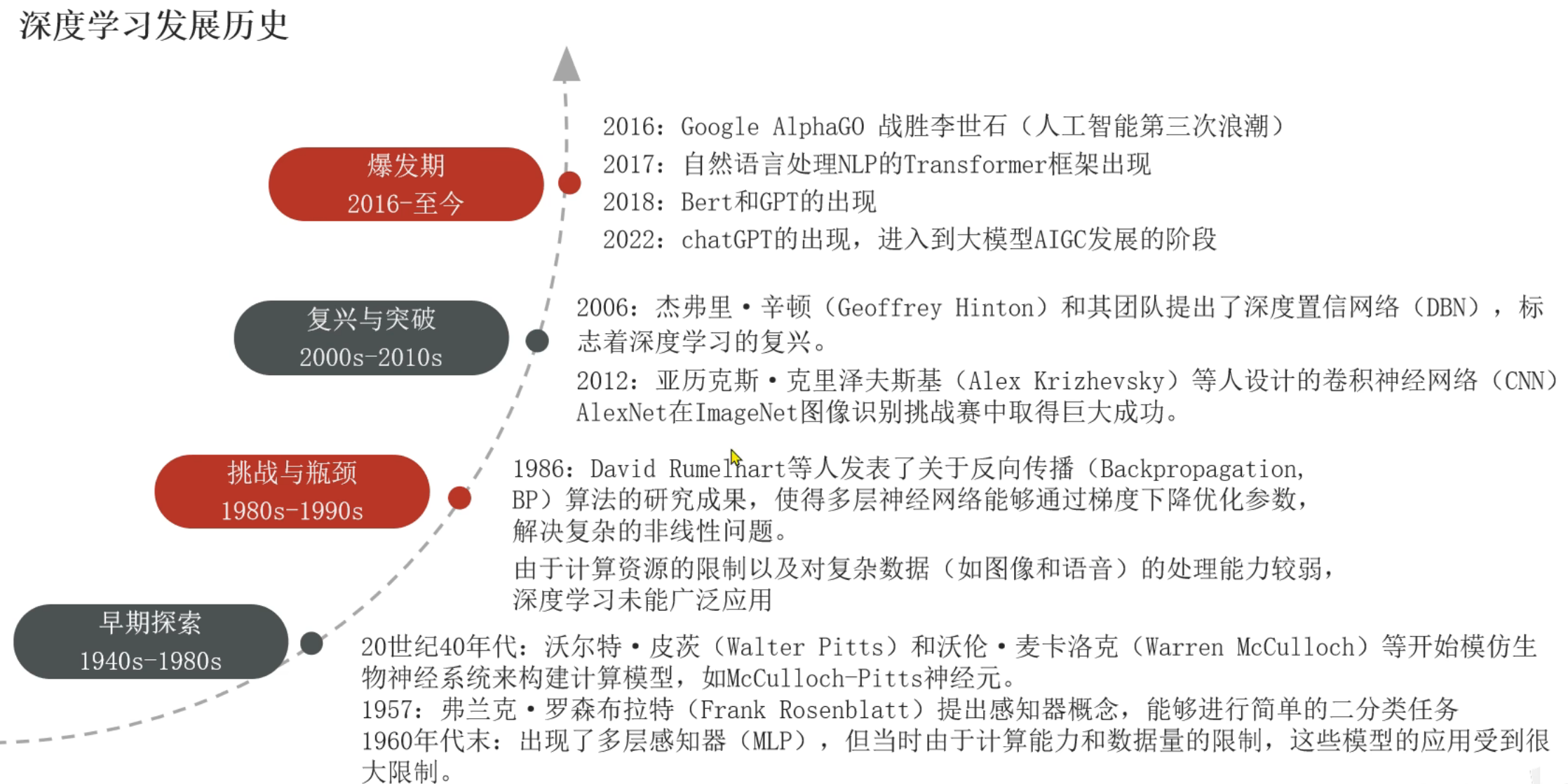

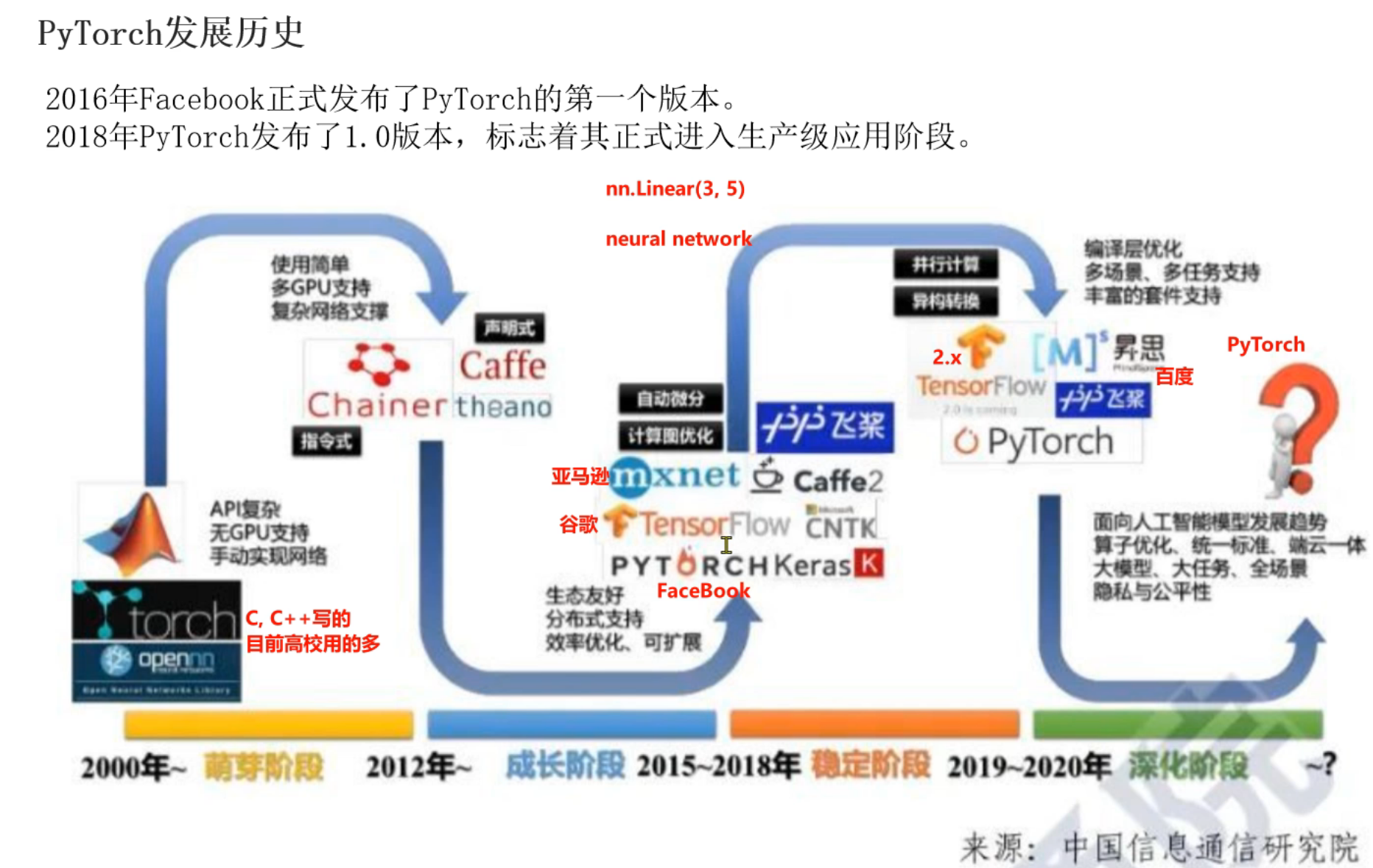

6、深度学习_发展史介绍

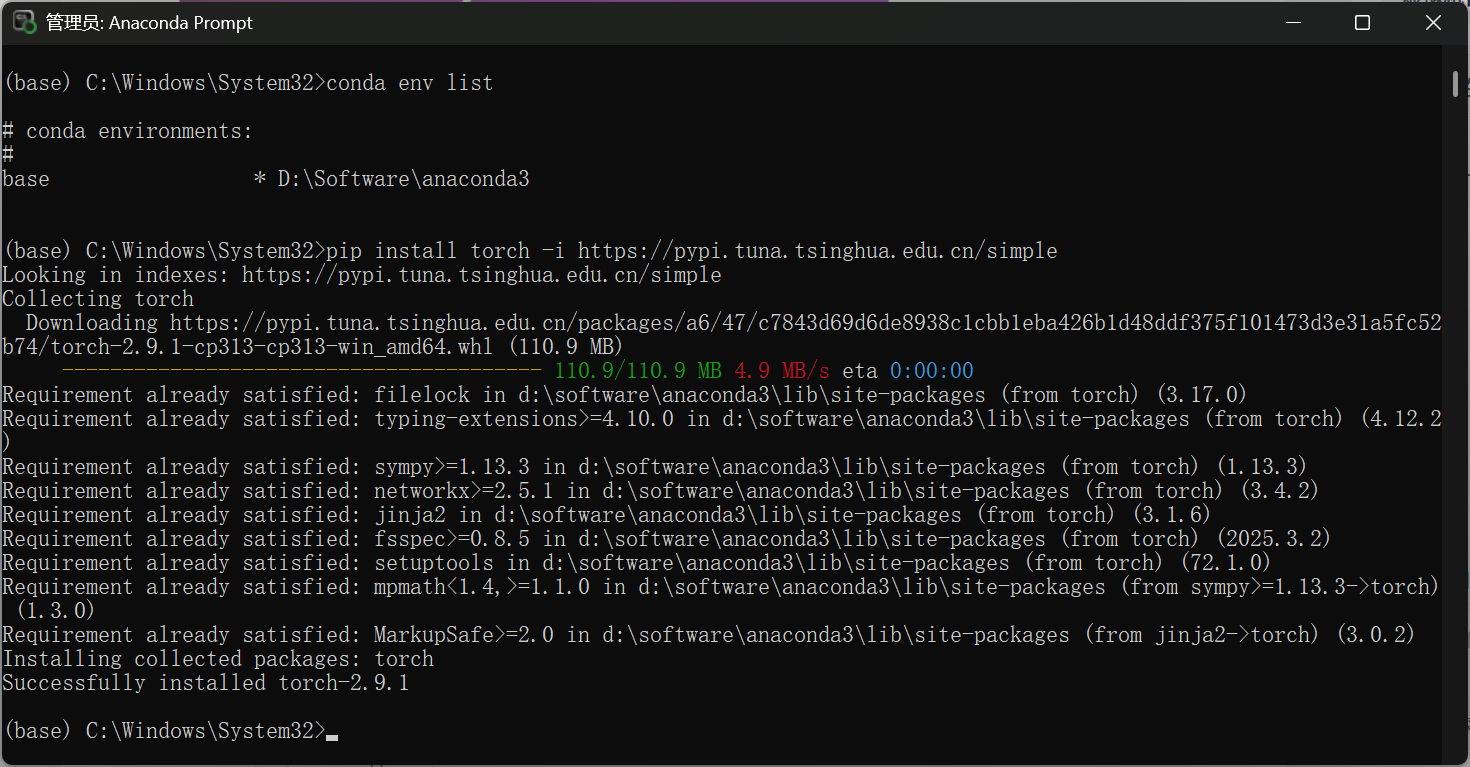

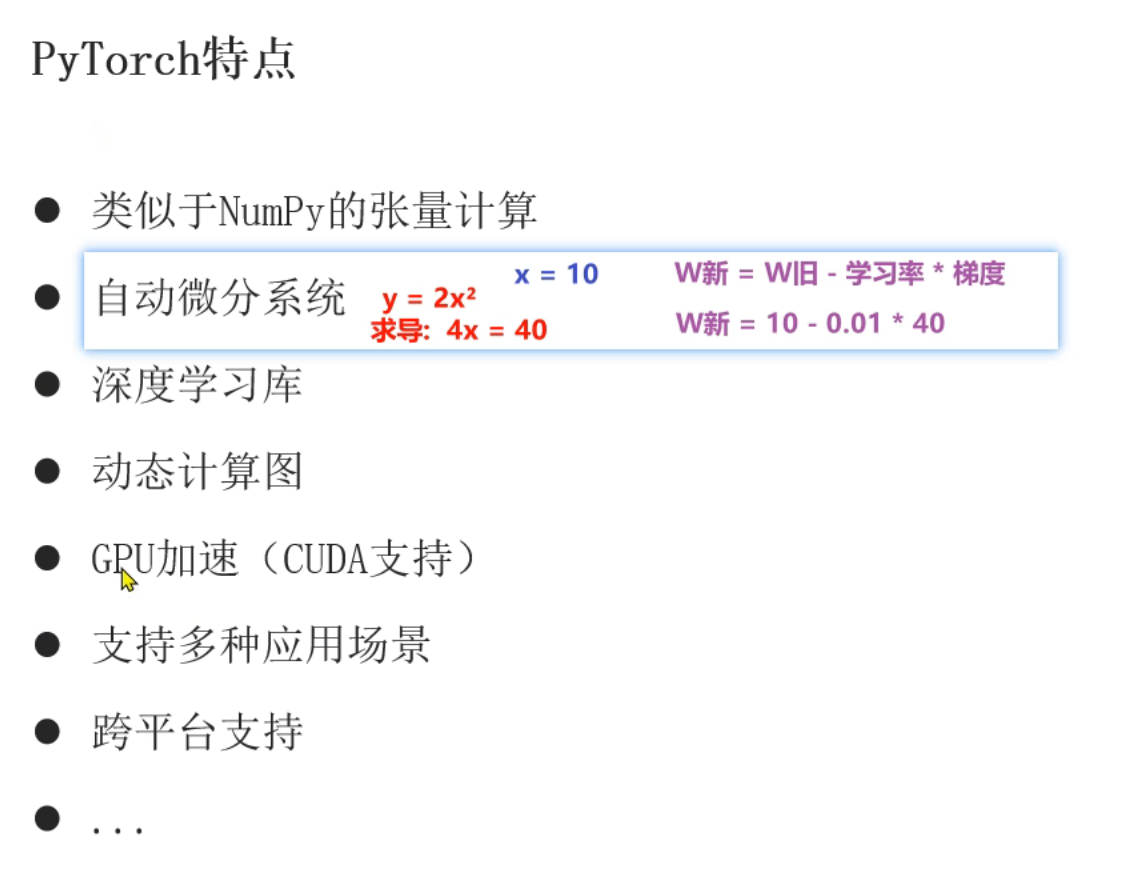

7、PyTorch框架简介

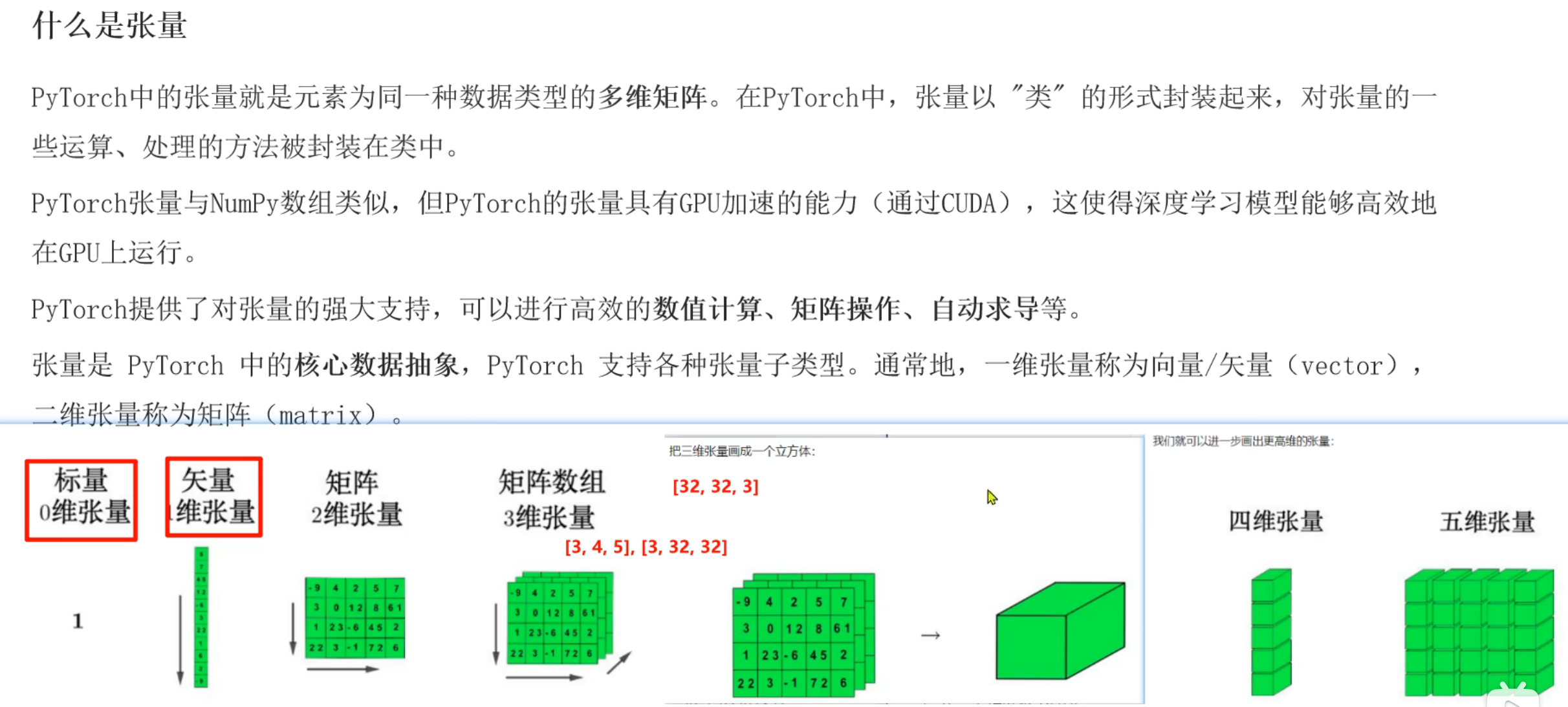

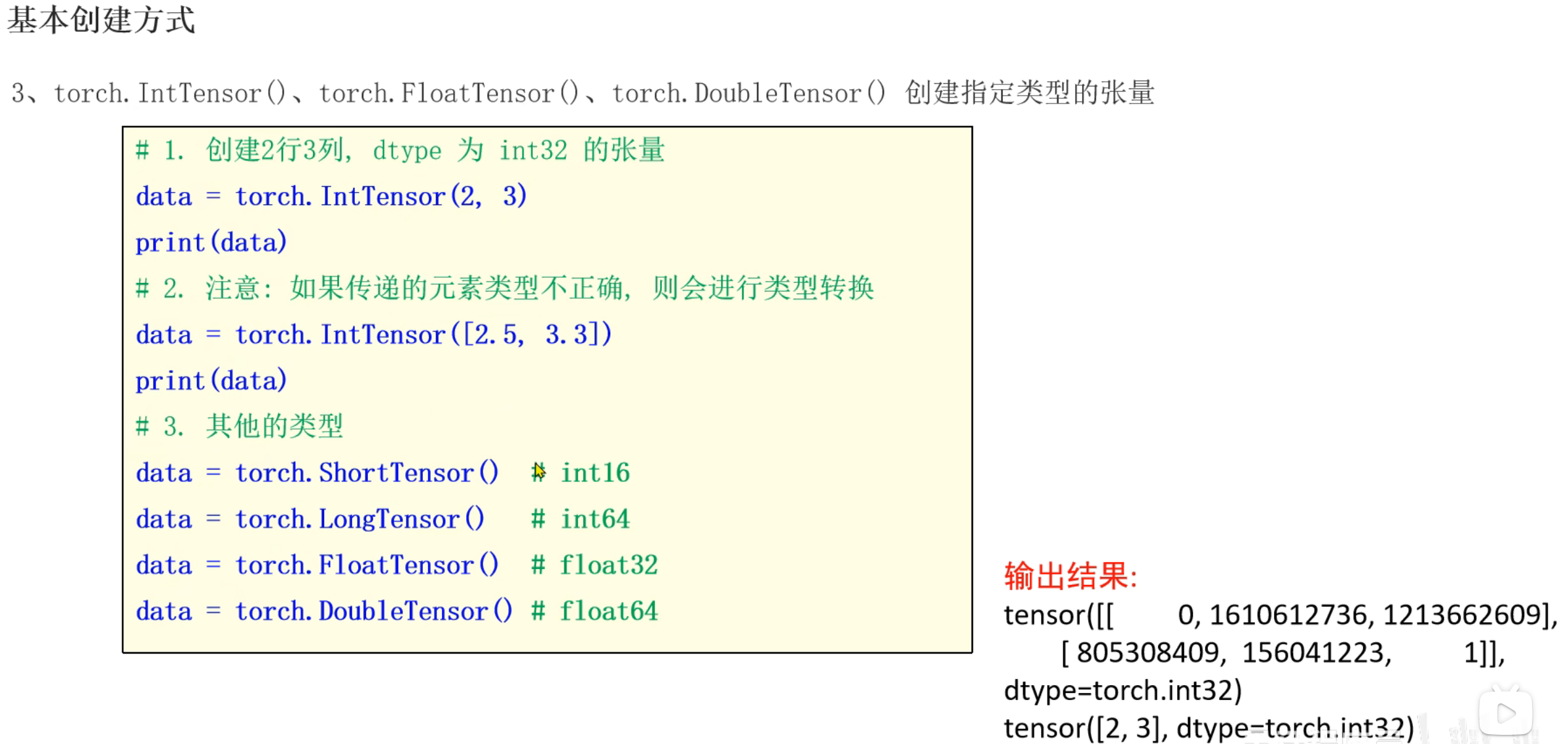

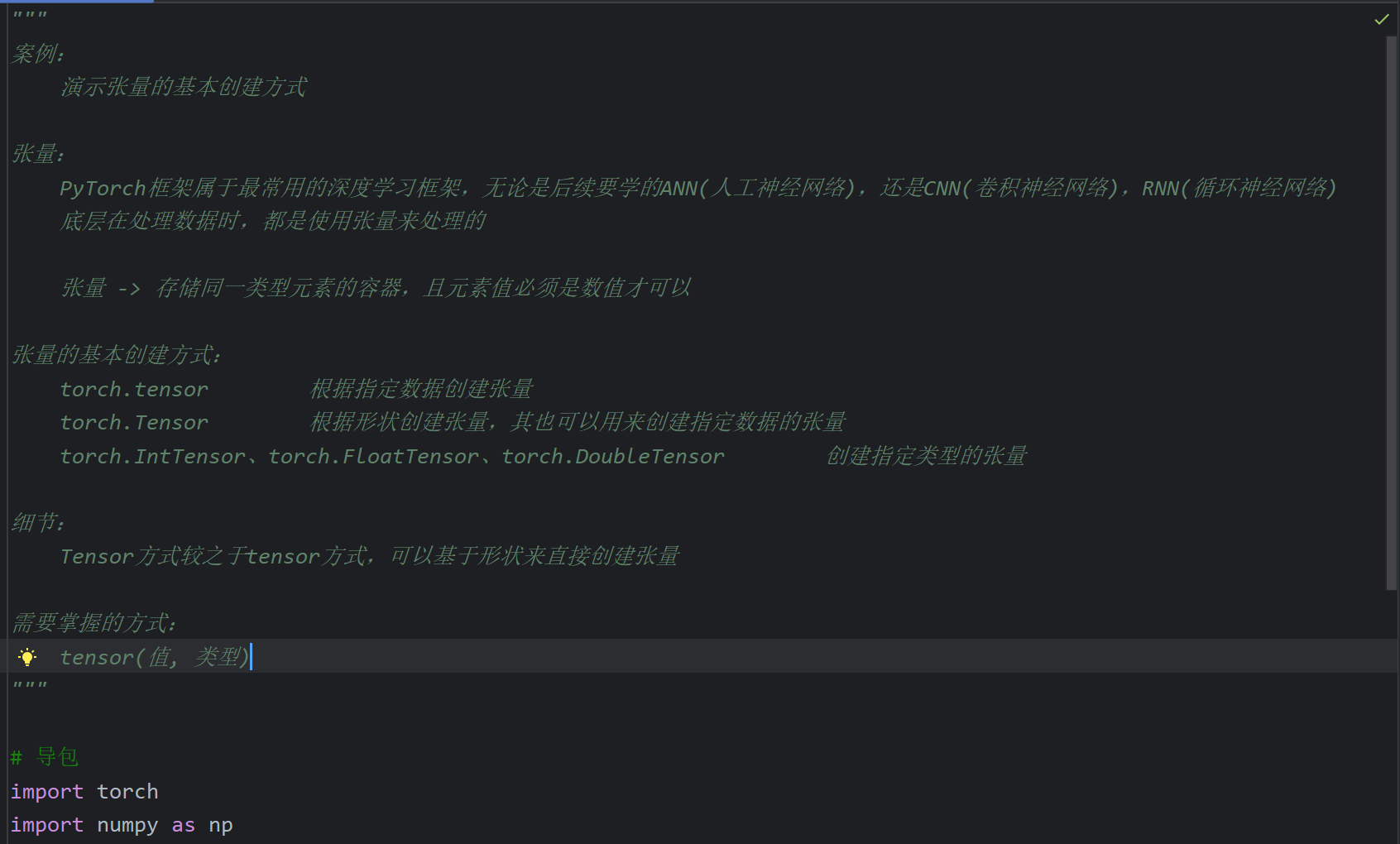

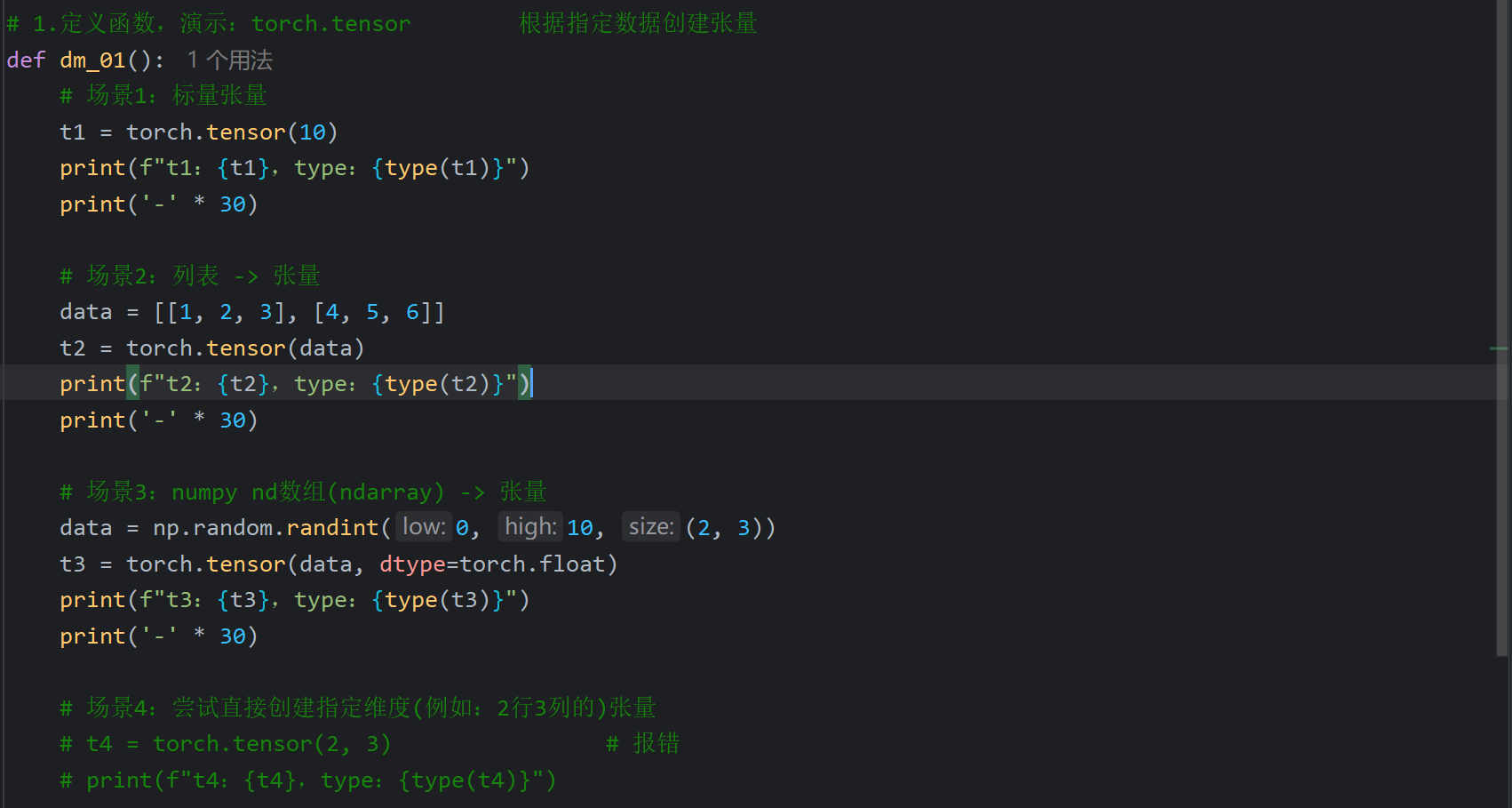

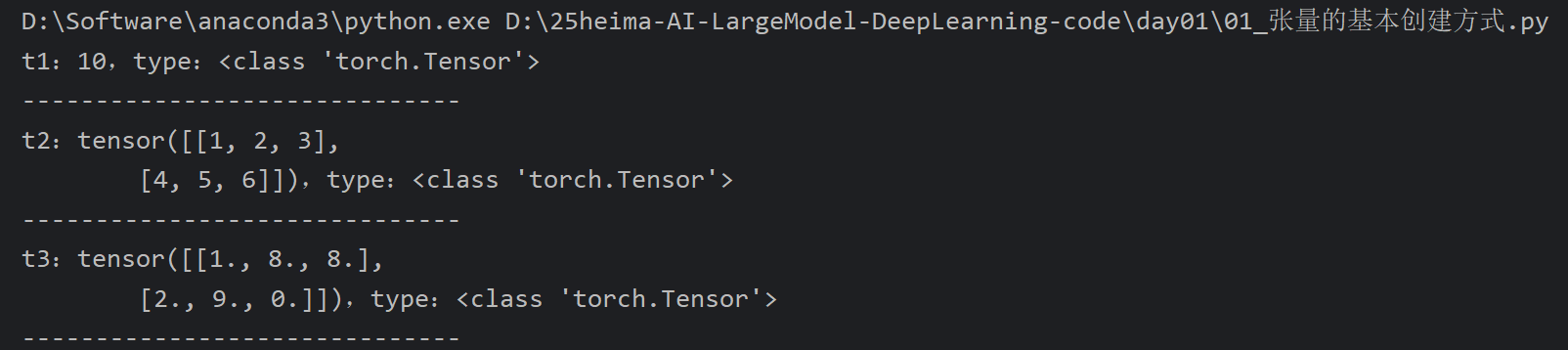

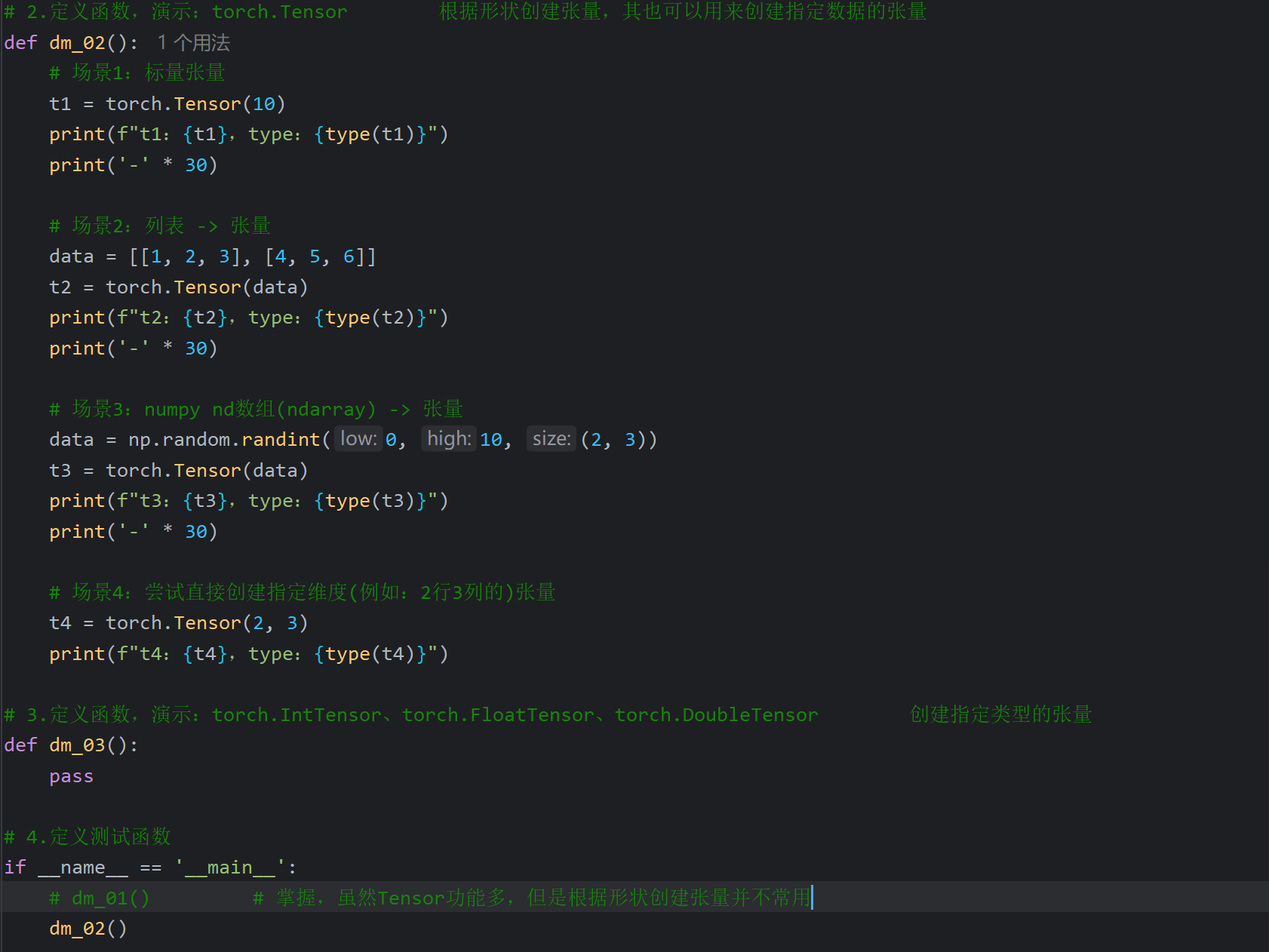

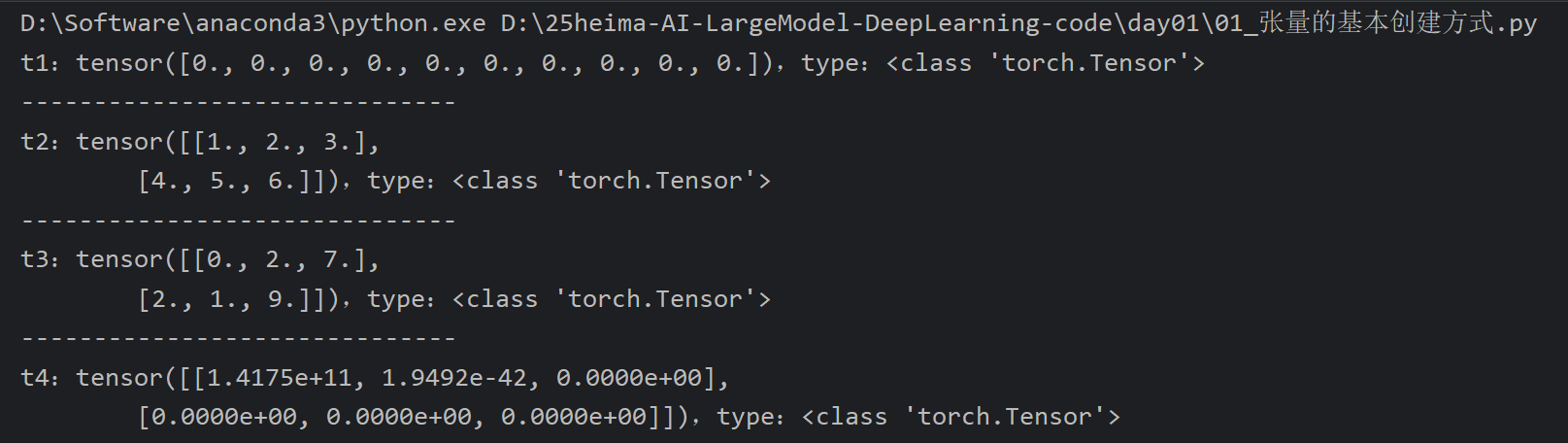

8、PyTorch_张量基本创建方式

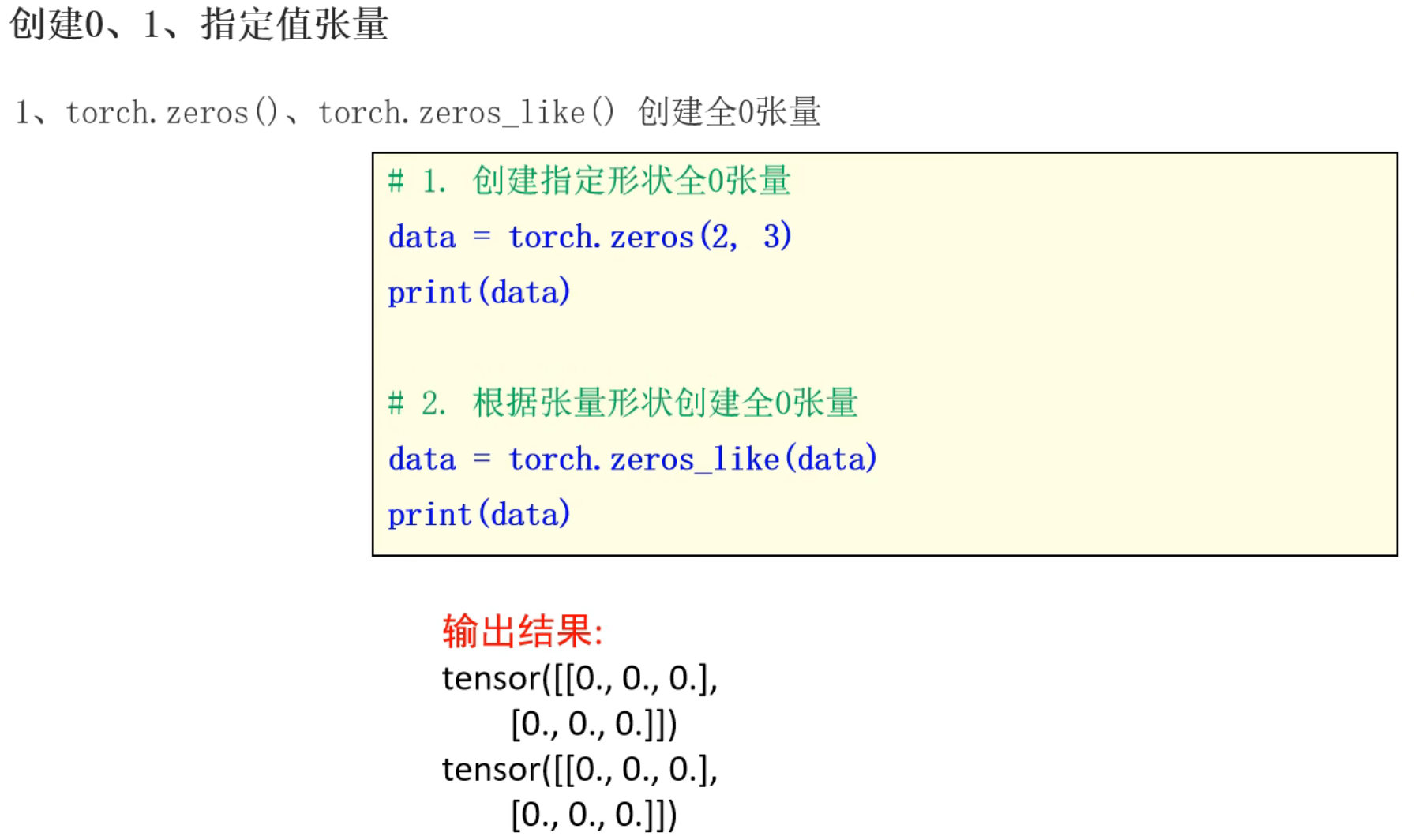

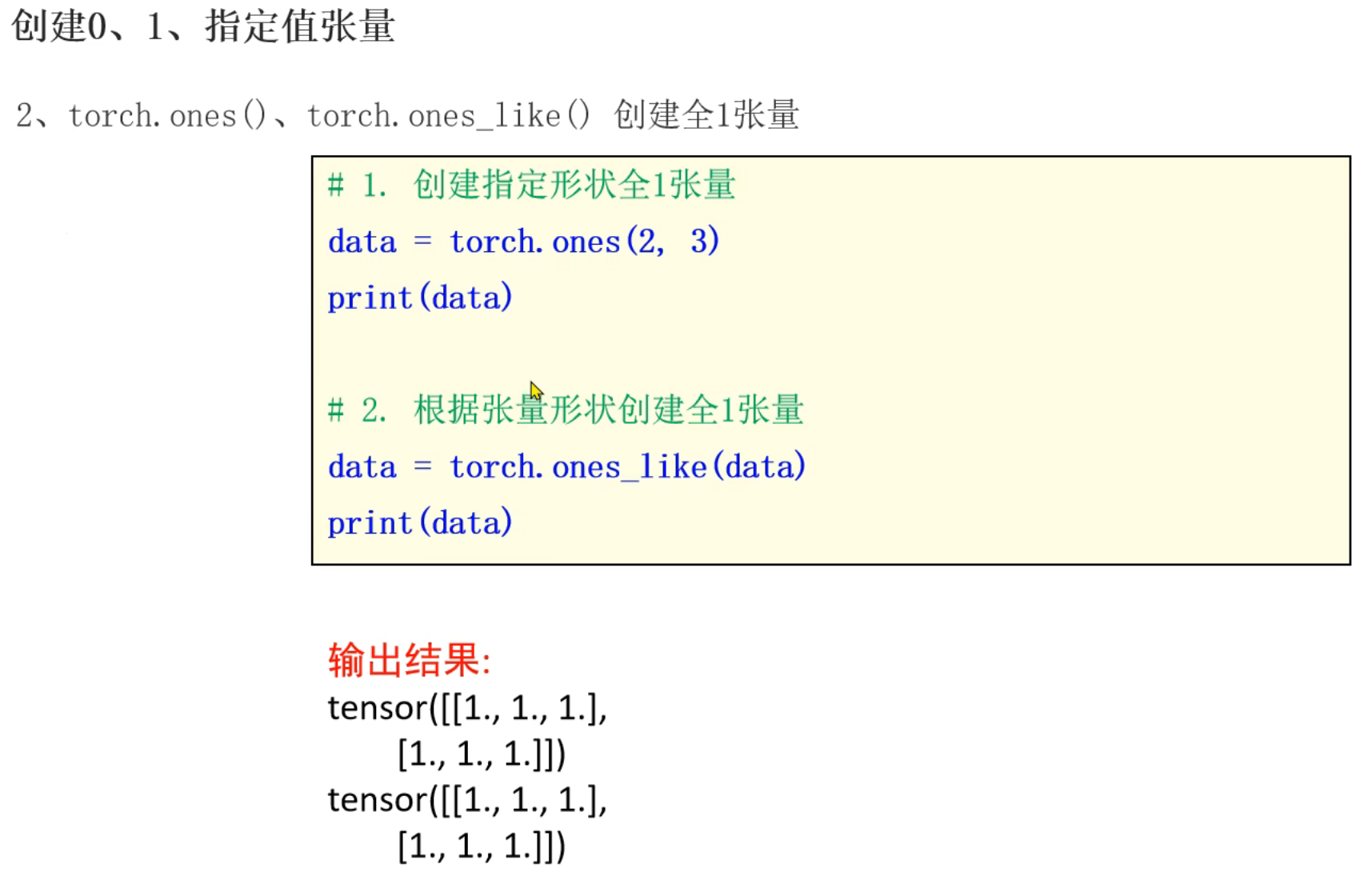

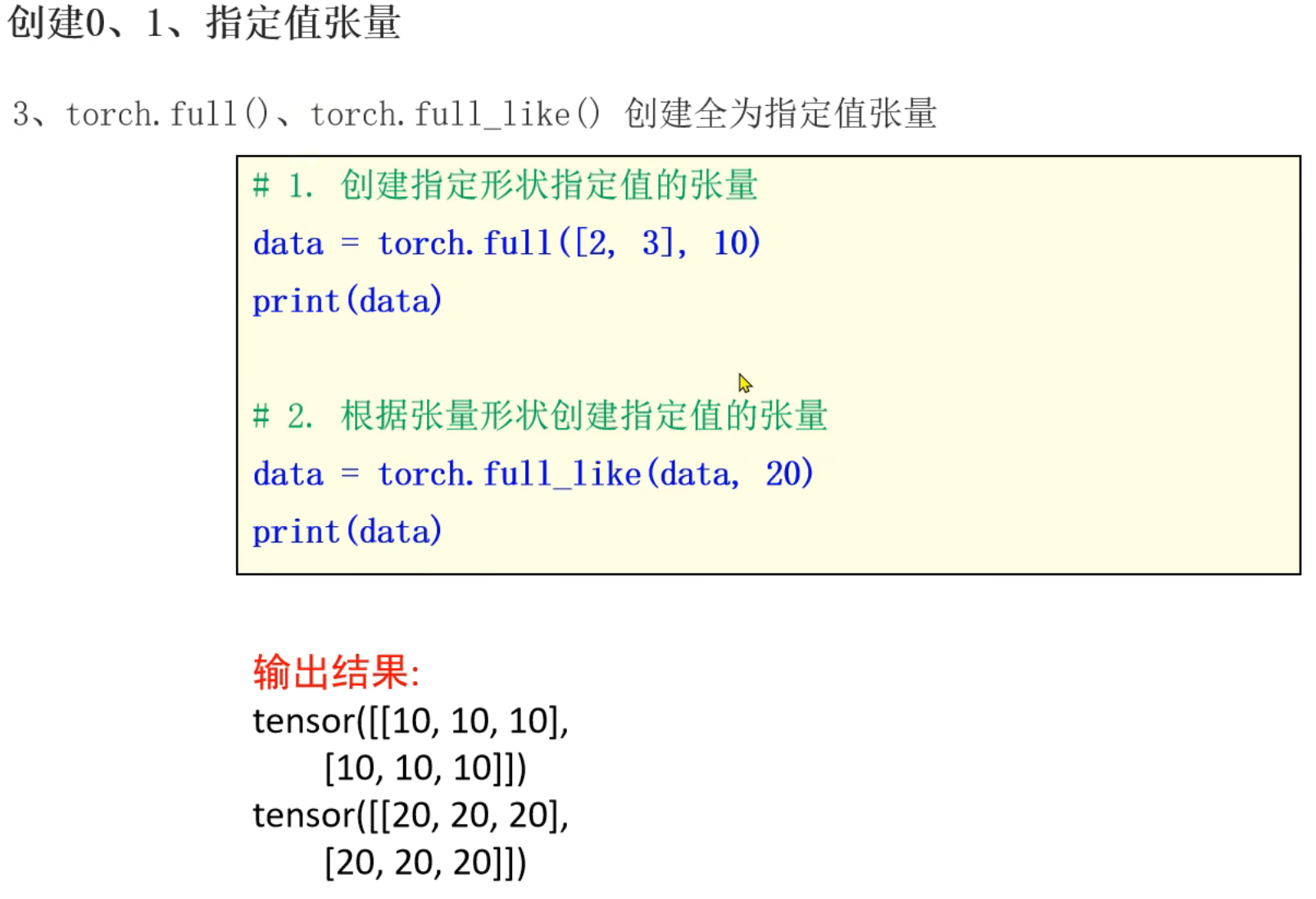

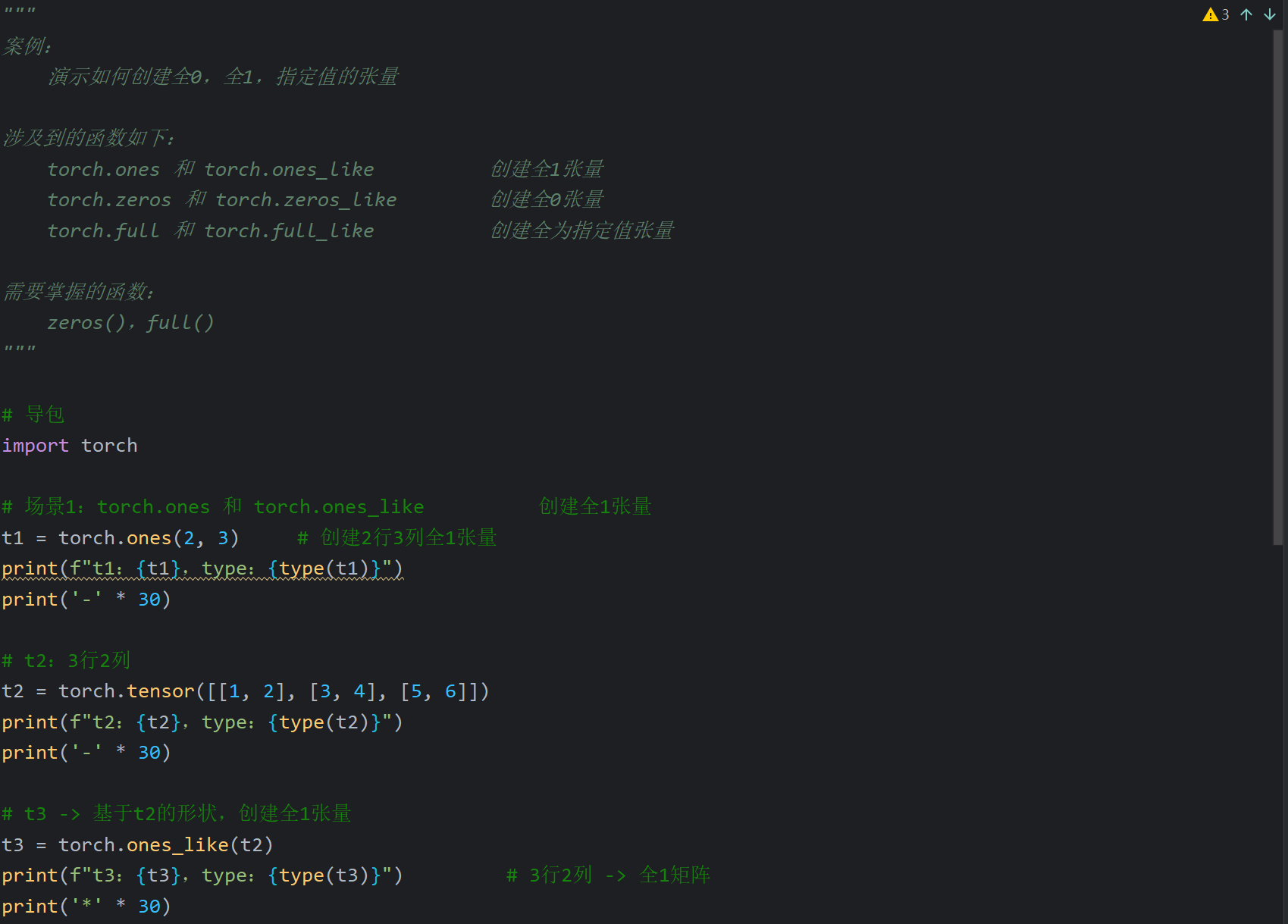

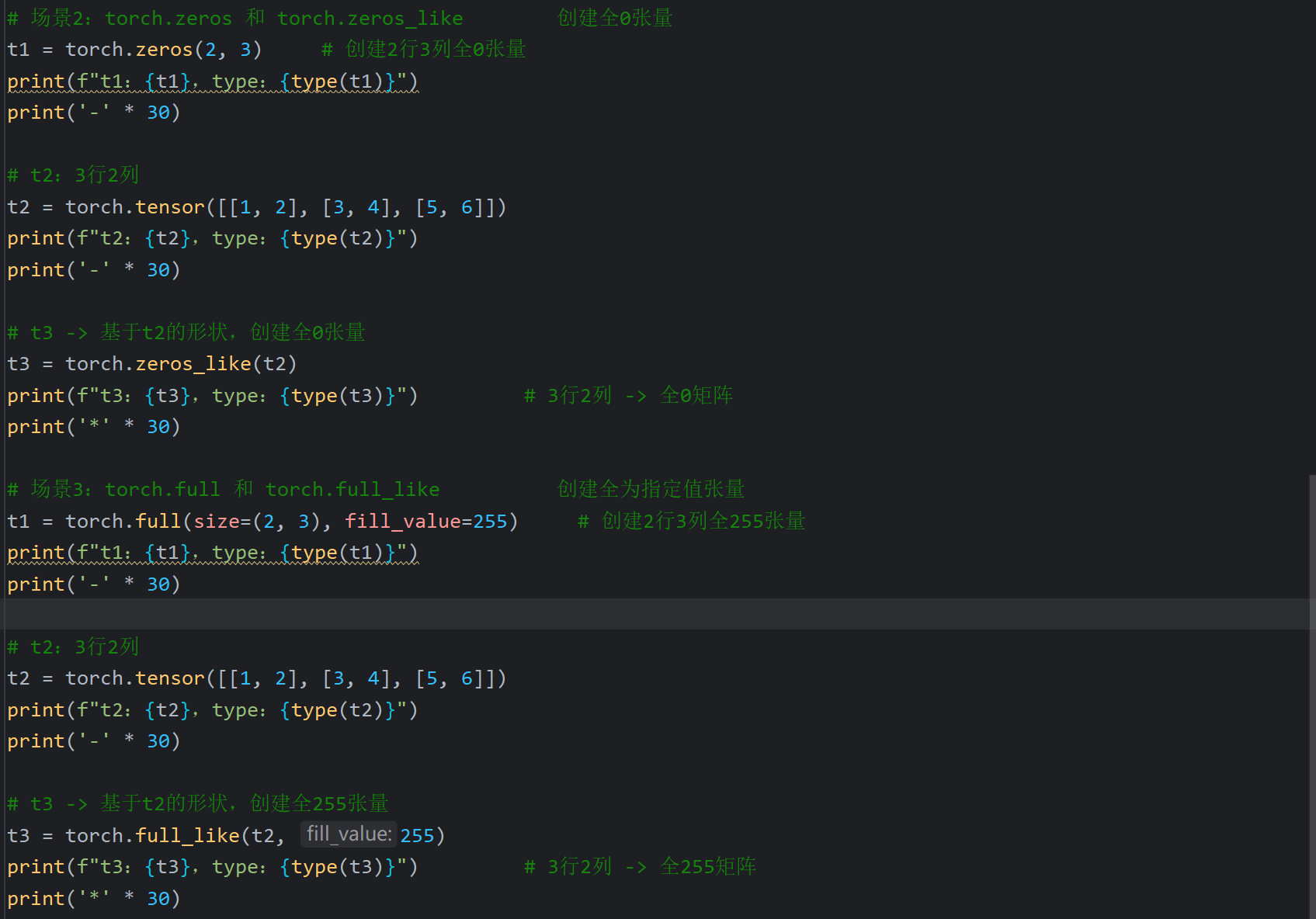

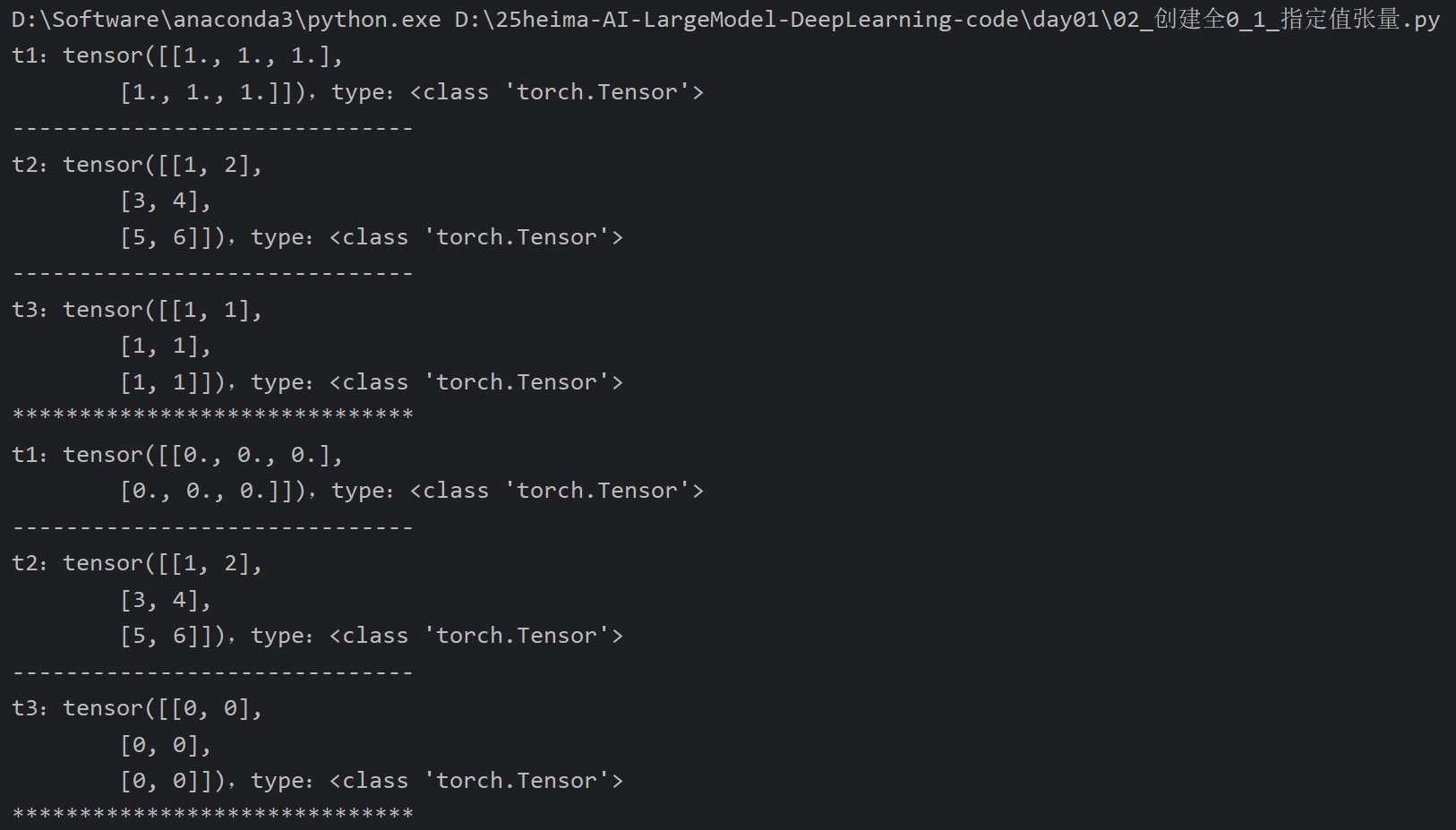

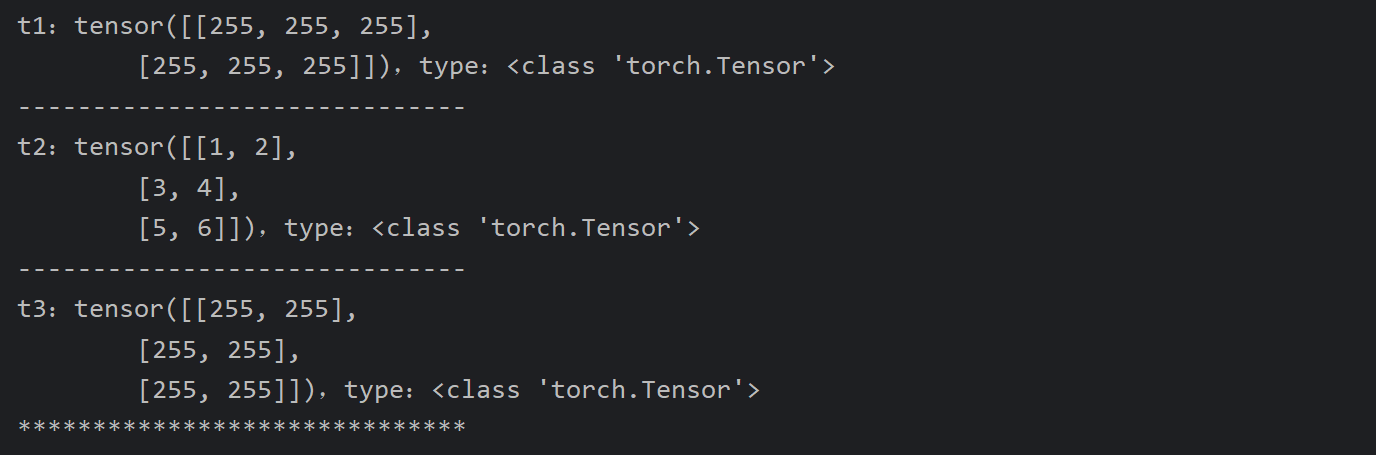

9、PyTorch_创建全0_1_指定值张量

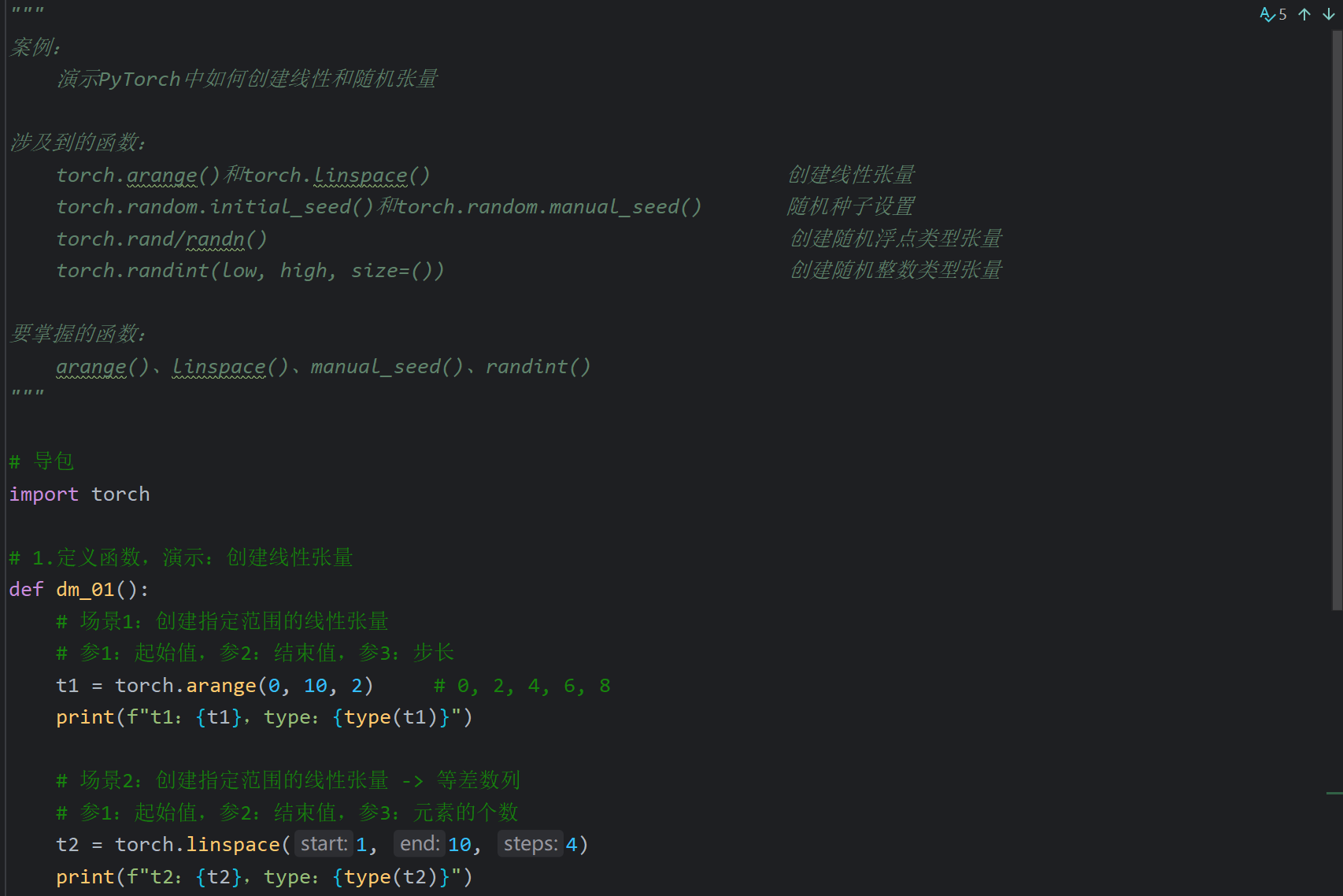

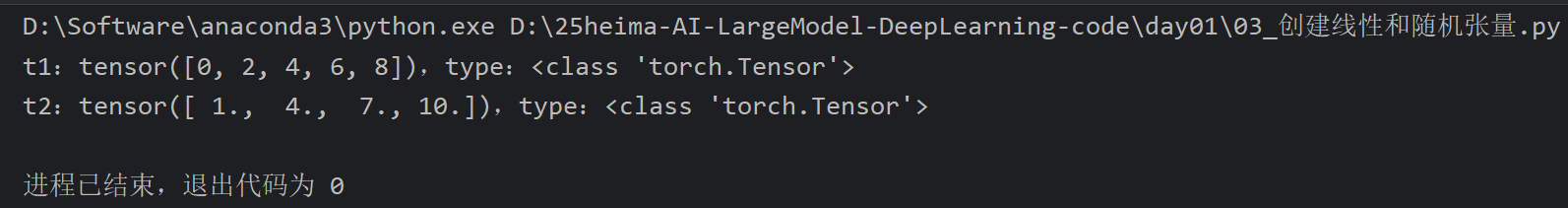

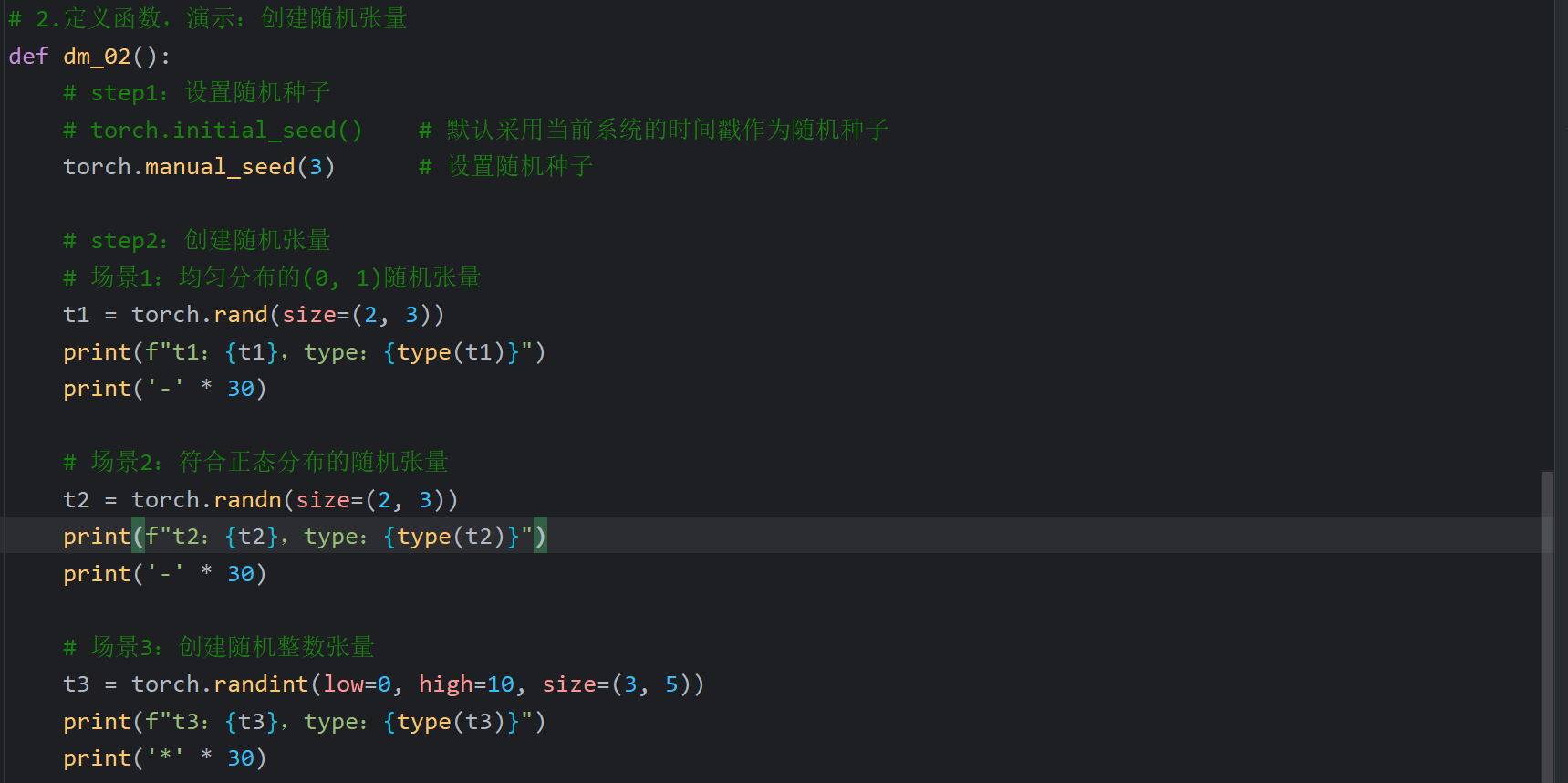

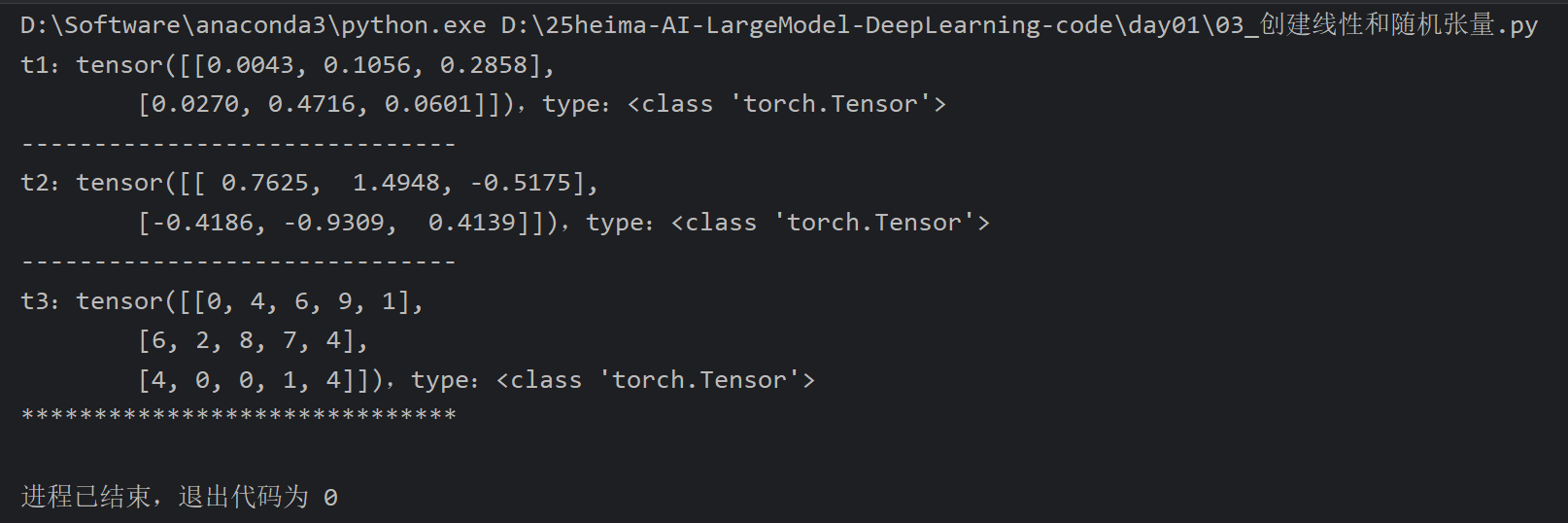

9、PyTorch_创建线性和随机张量

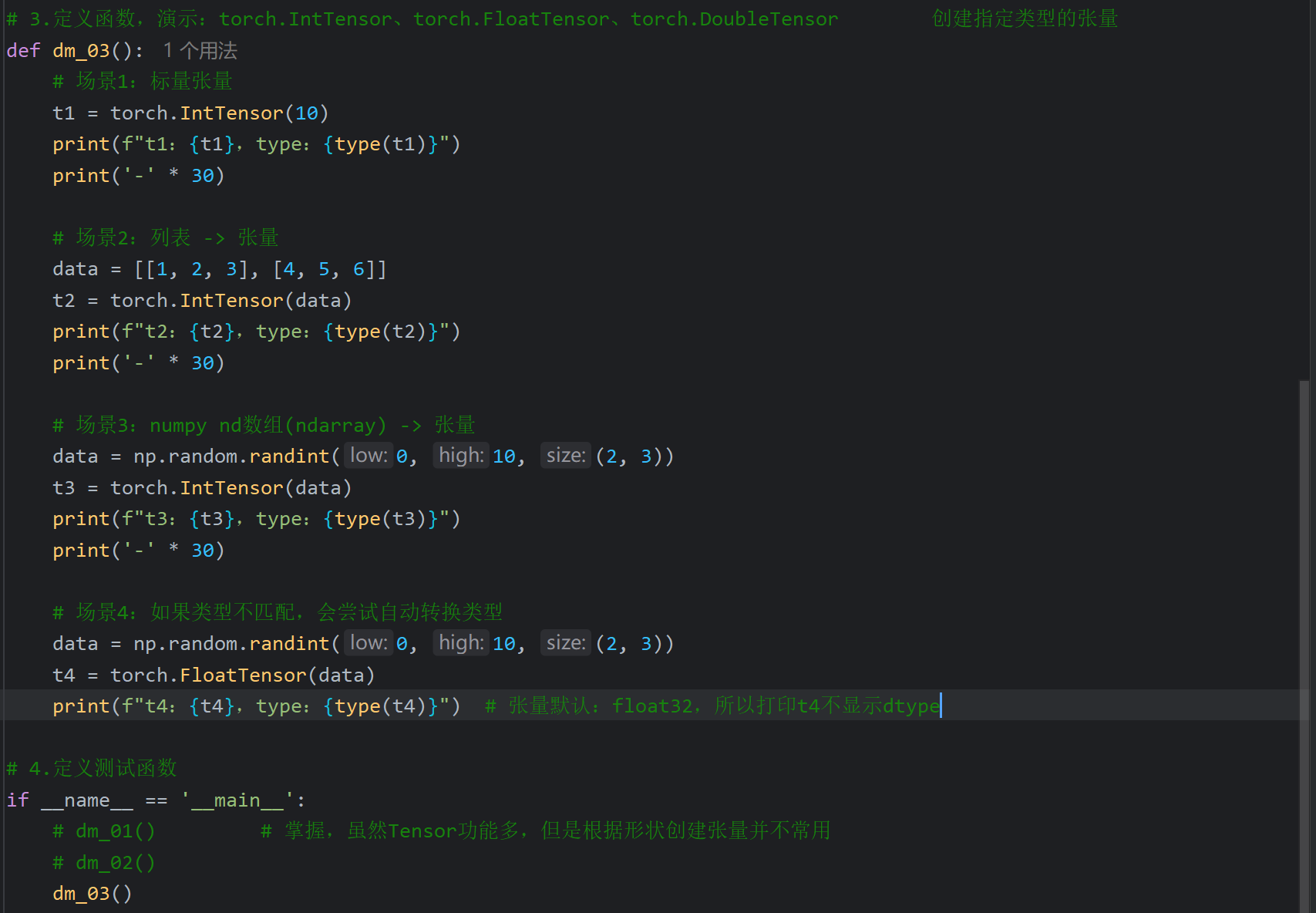

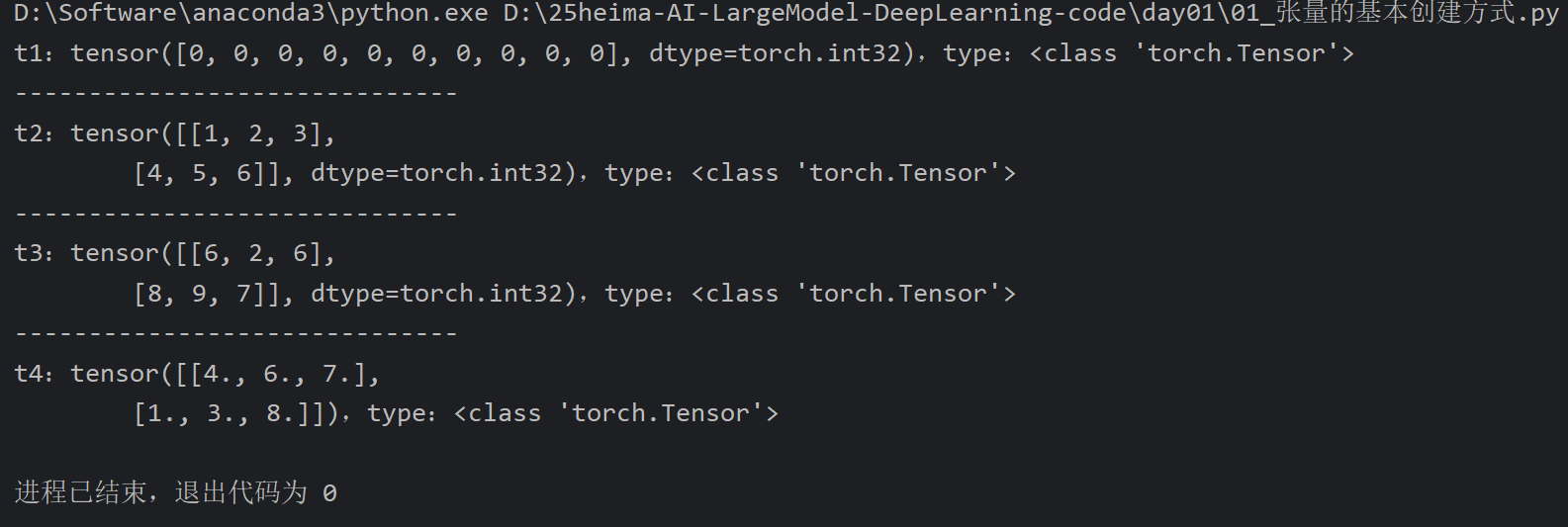

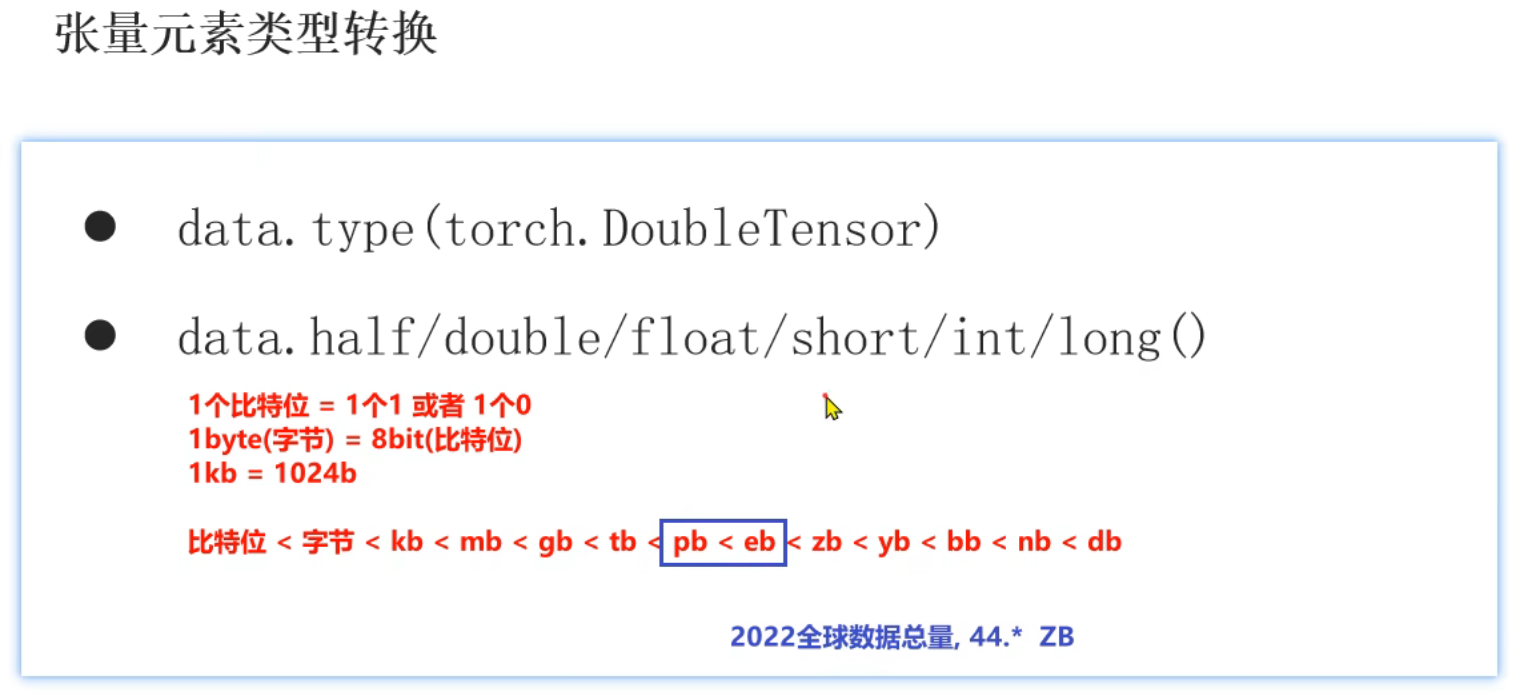

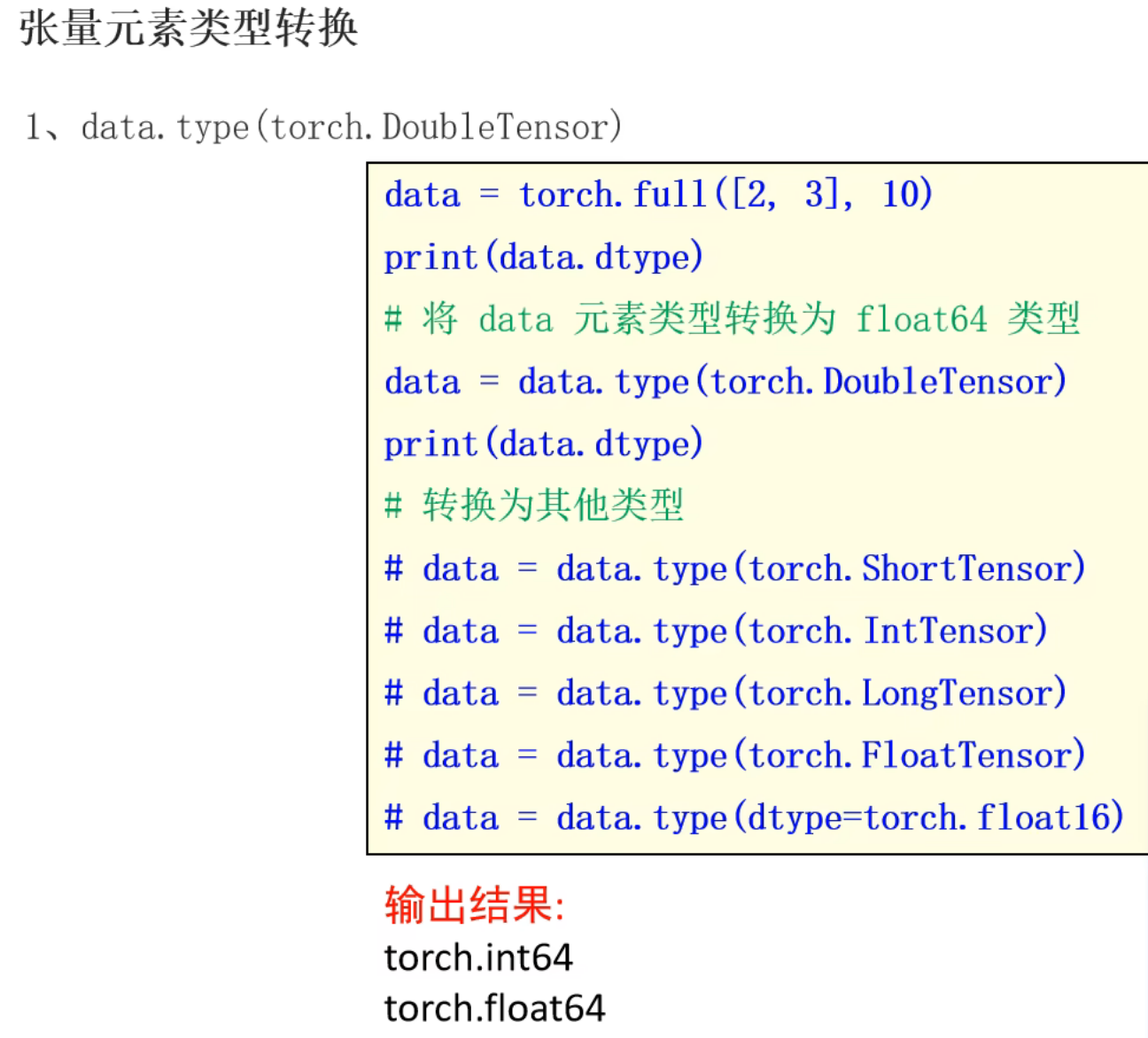

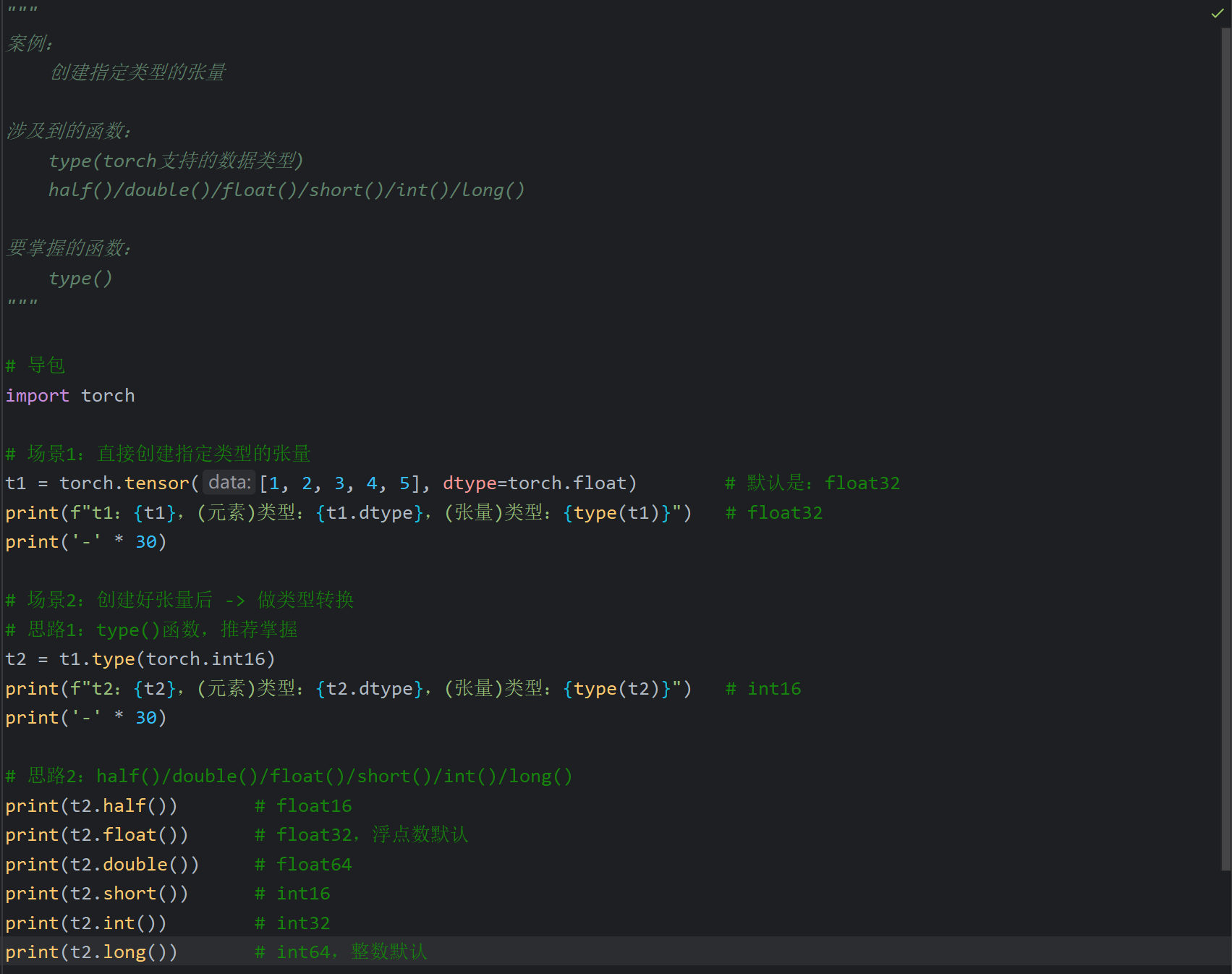

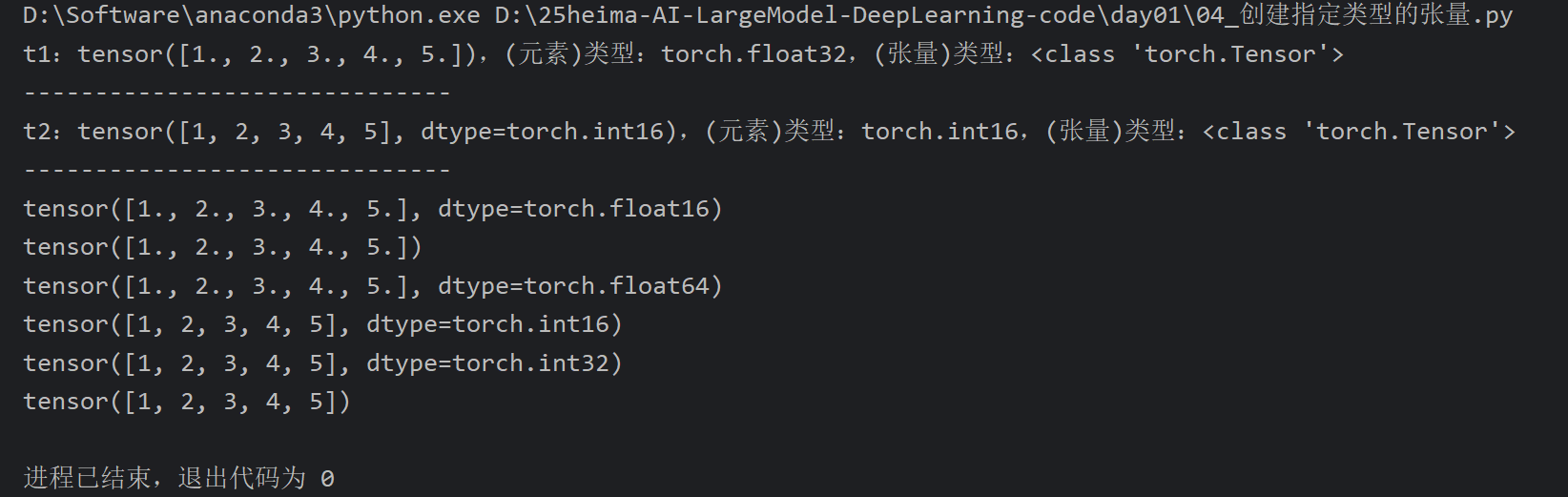

10、PyTorch_元素类型转换

11、PyTorch_创建张量方式总结

三、Day02

1、今日内容大纲介绍

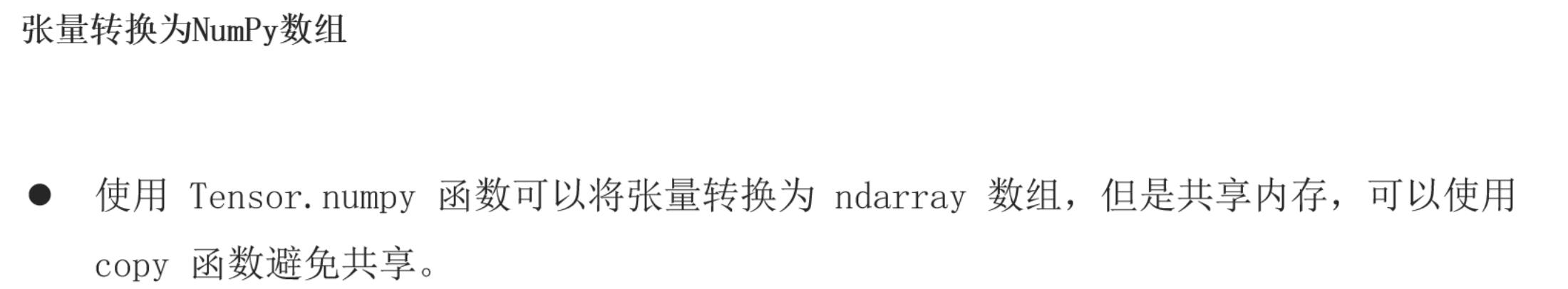

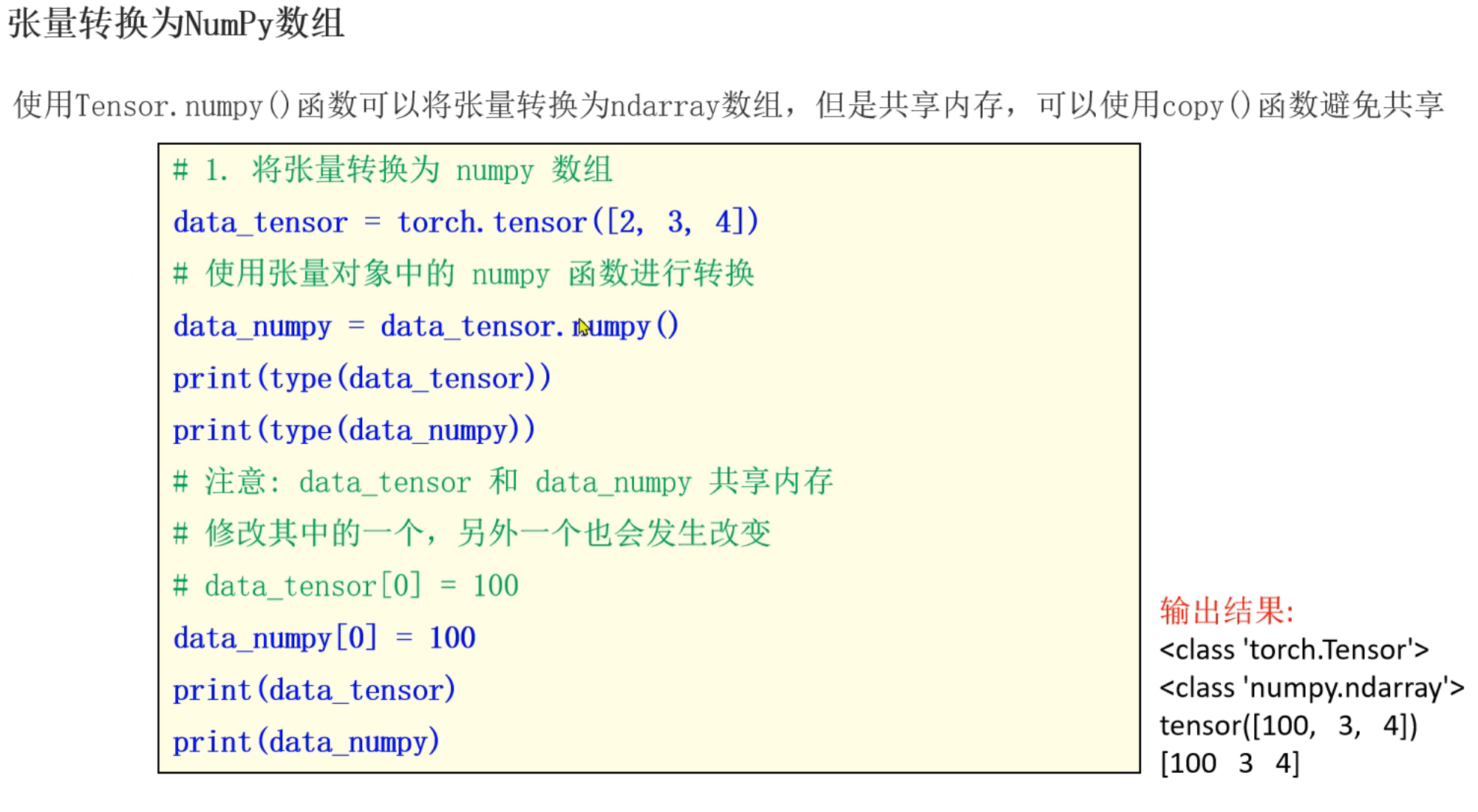

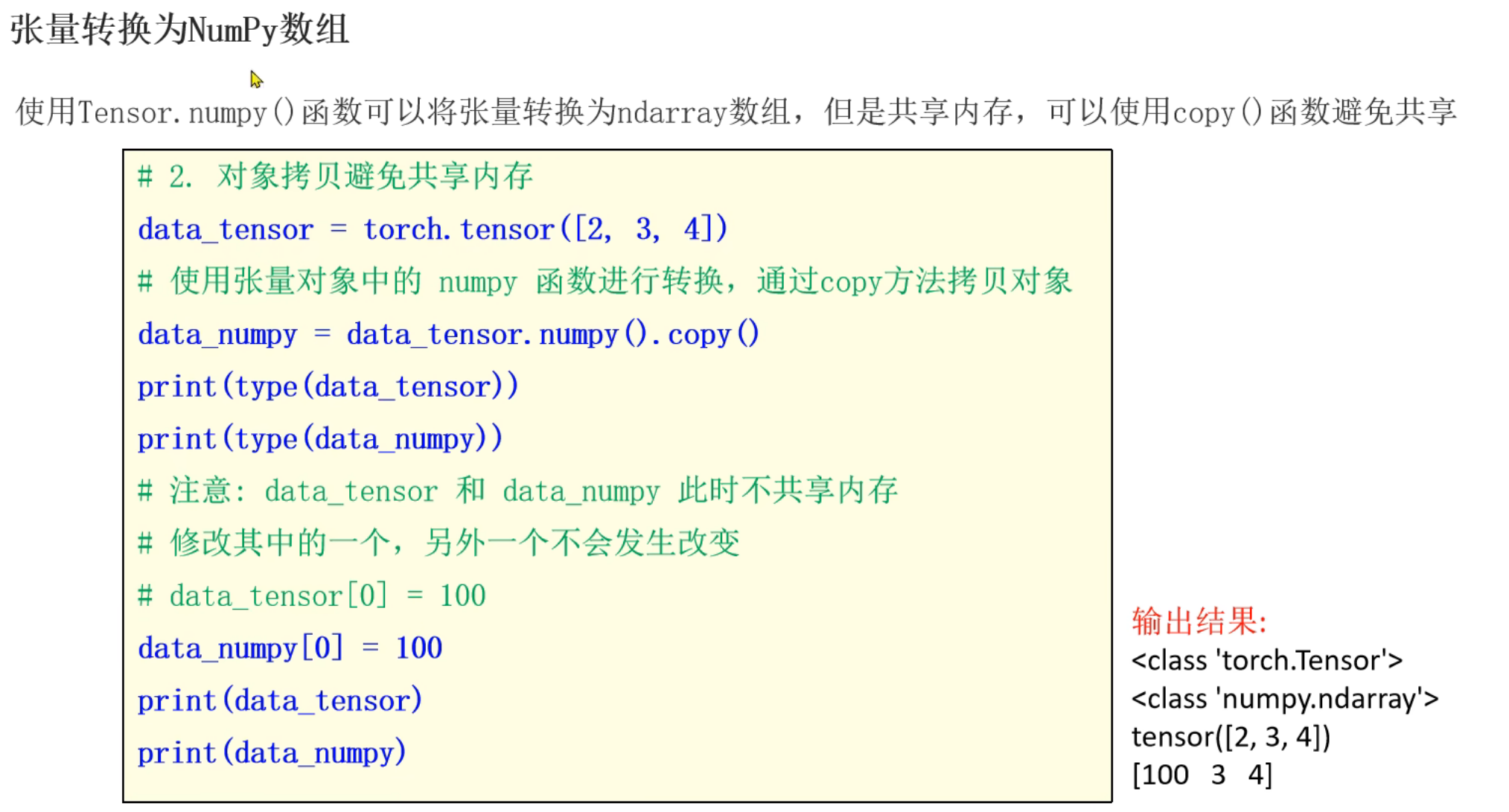

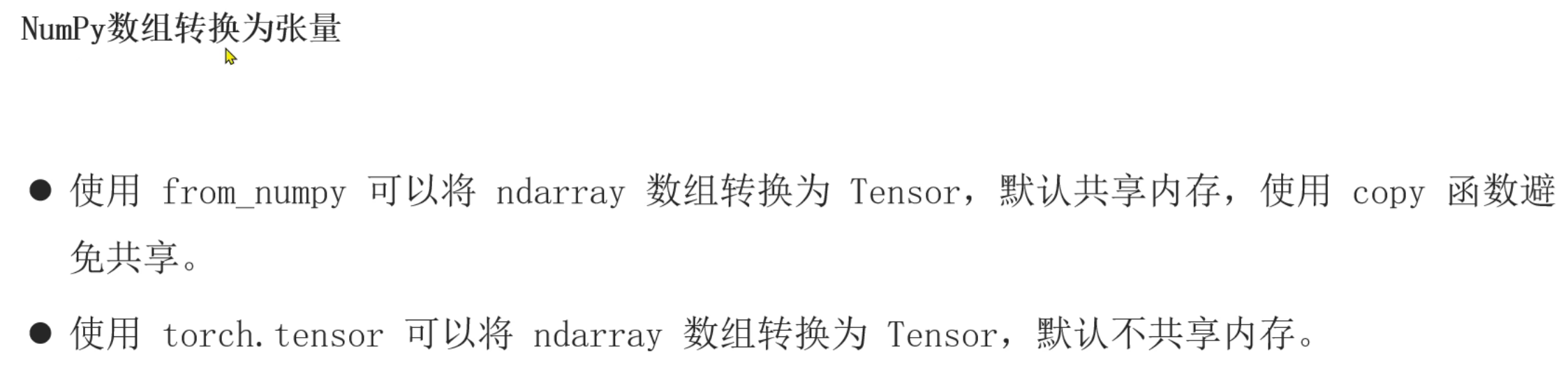

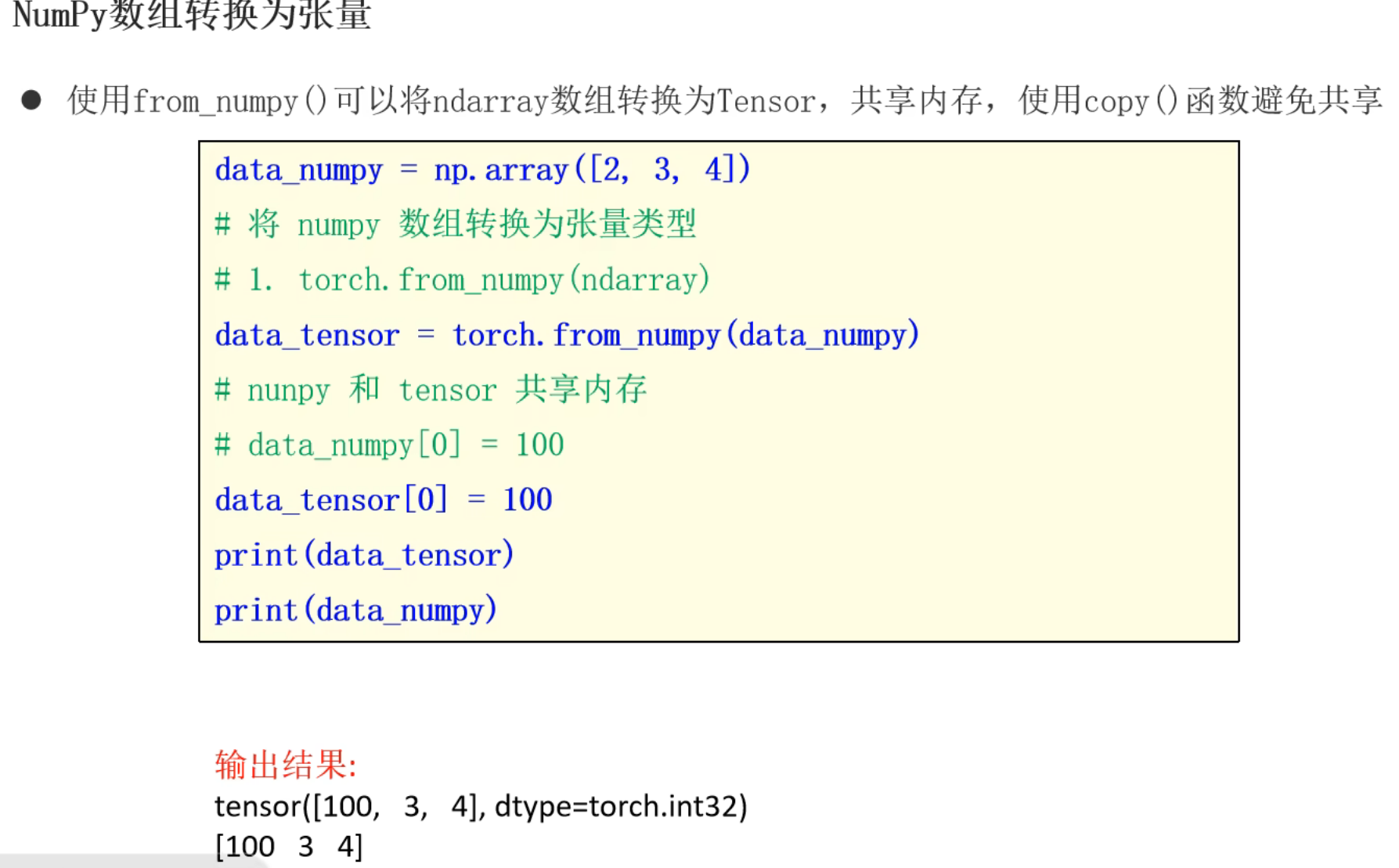

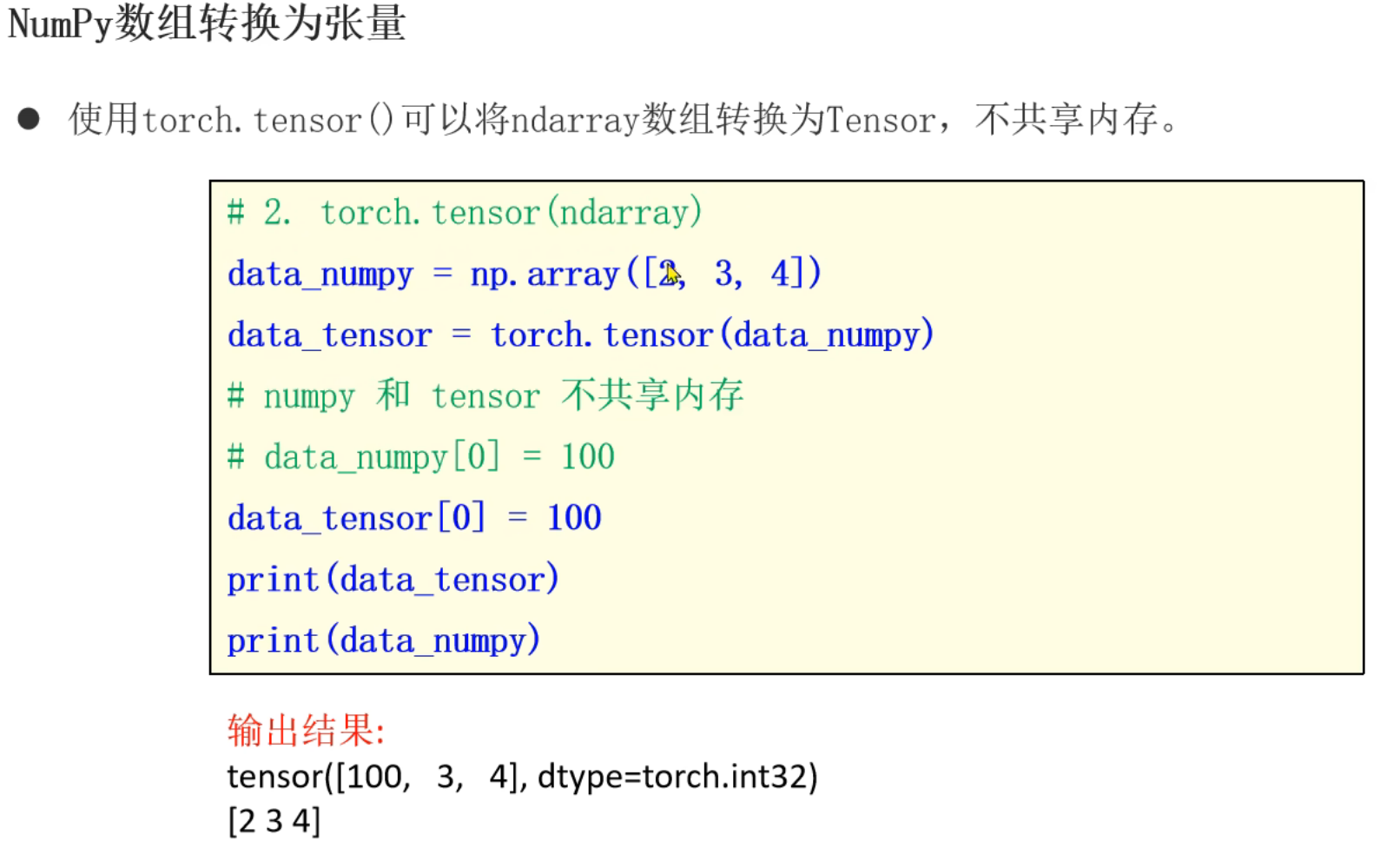

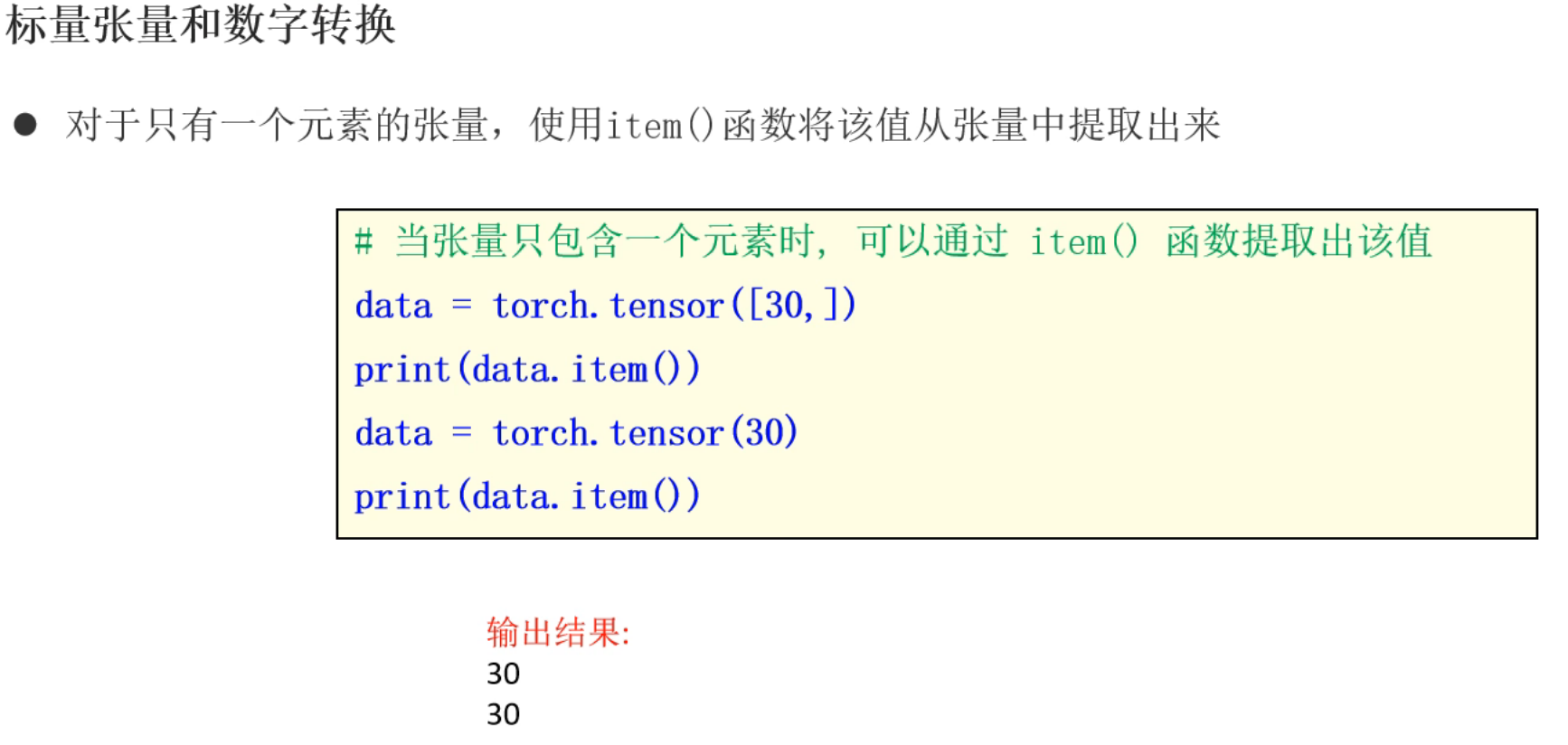

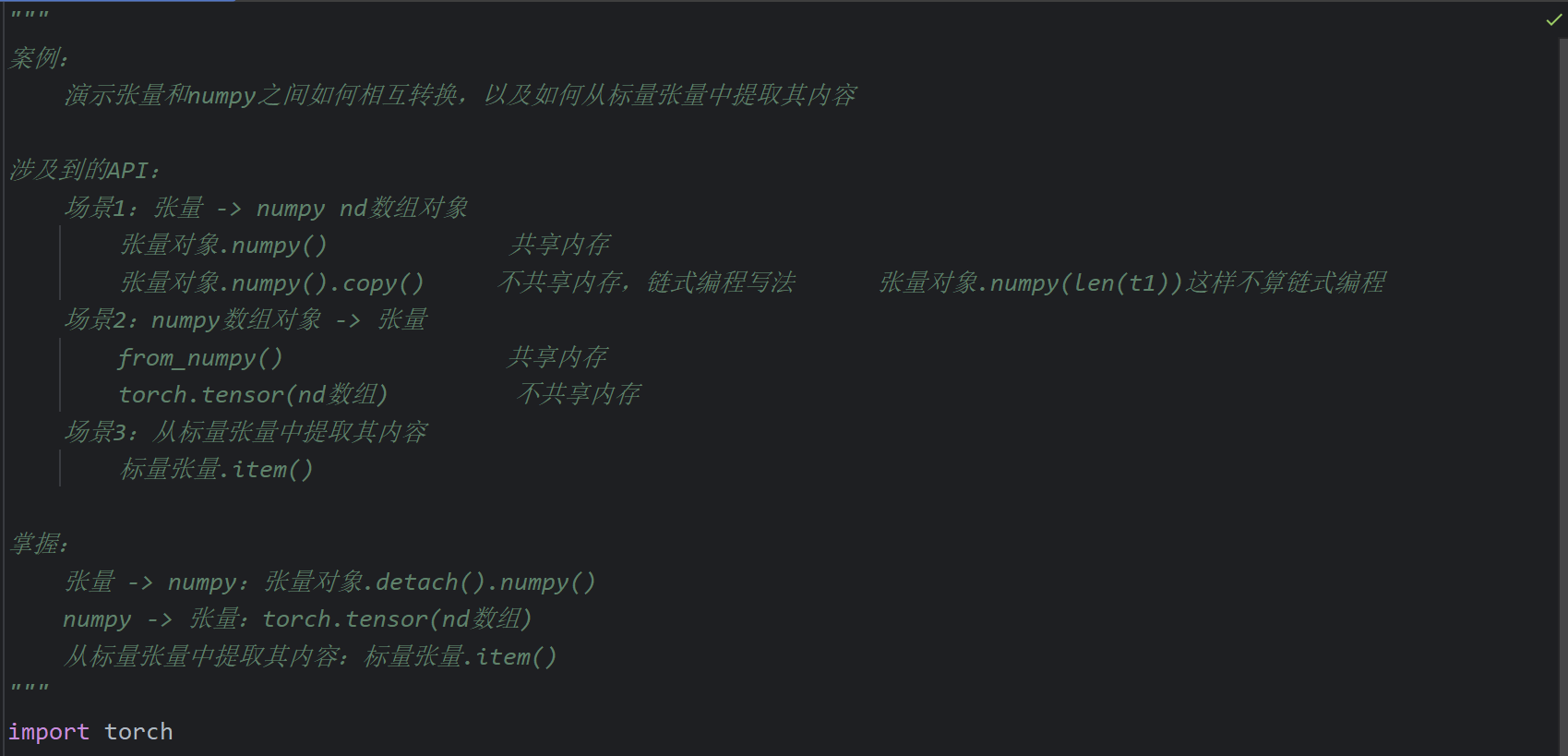

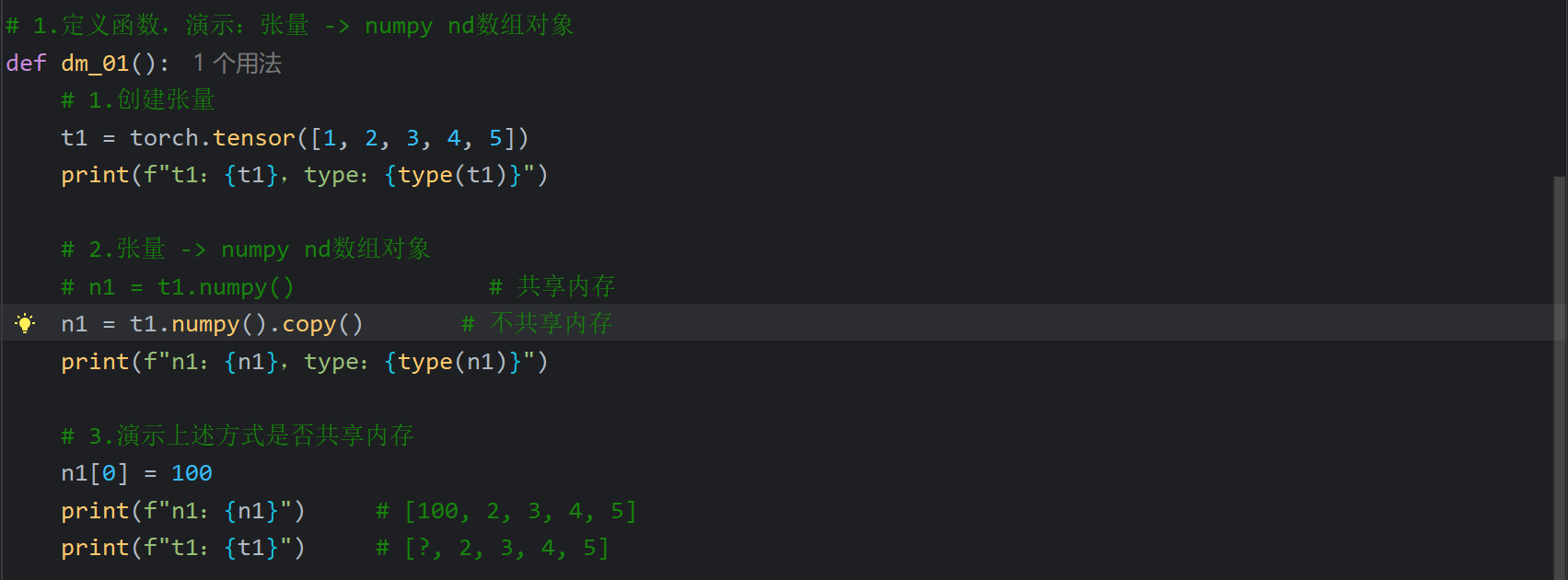

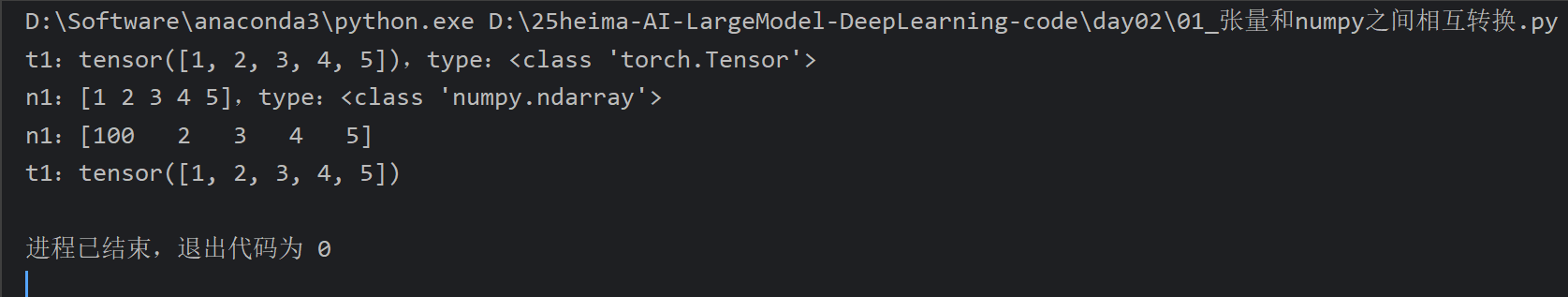

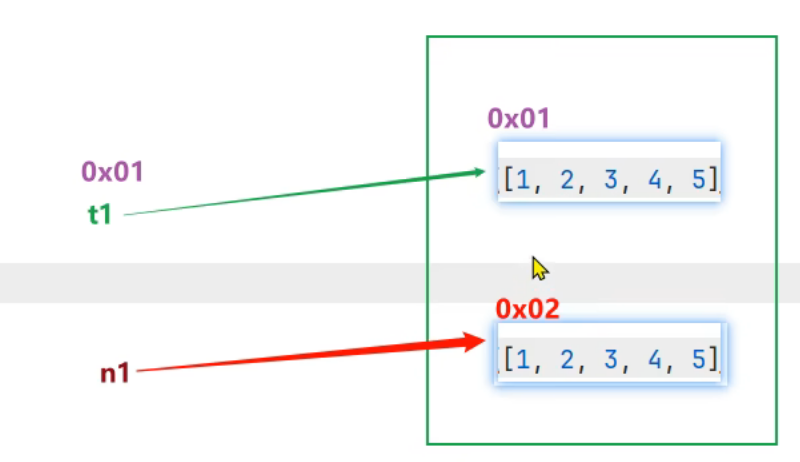

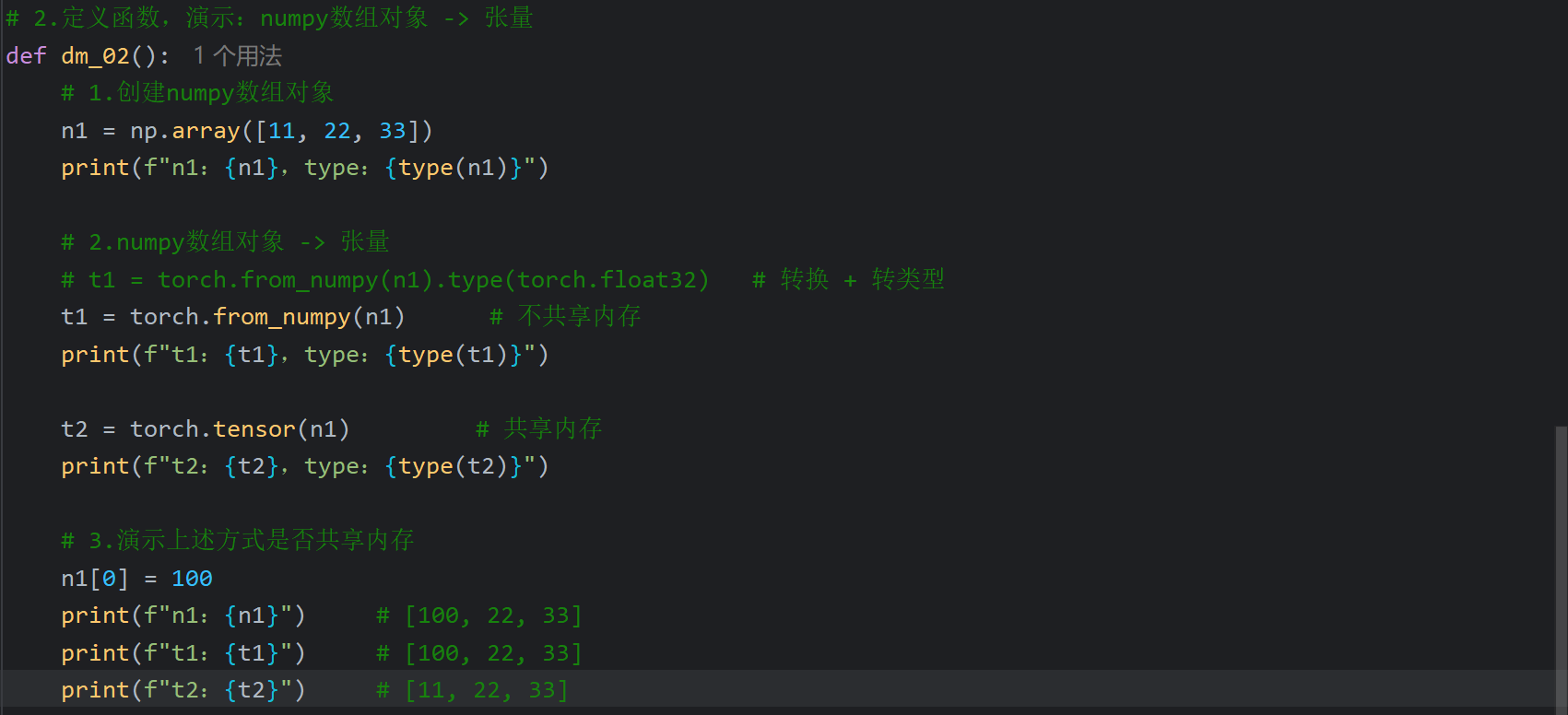

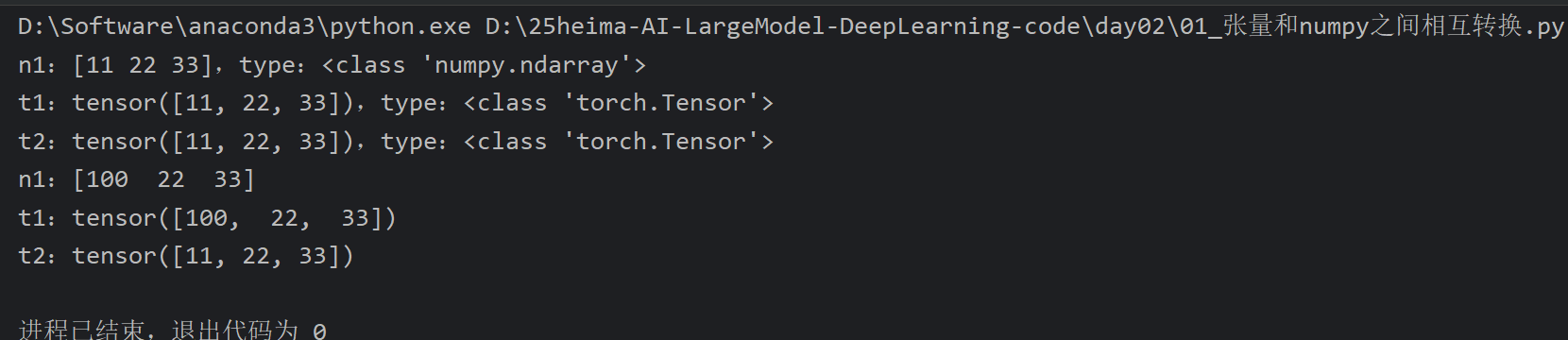

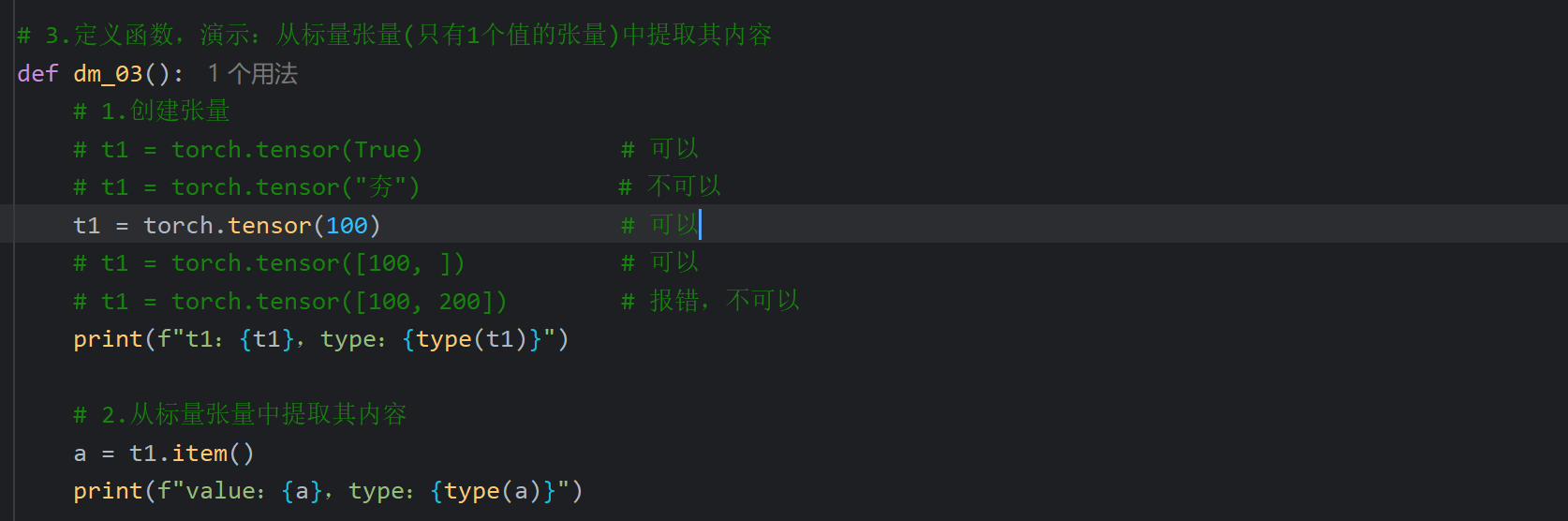

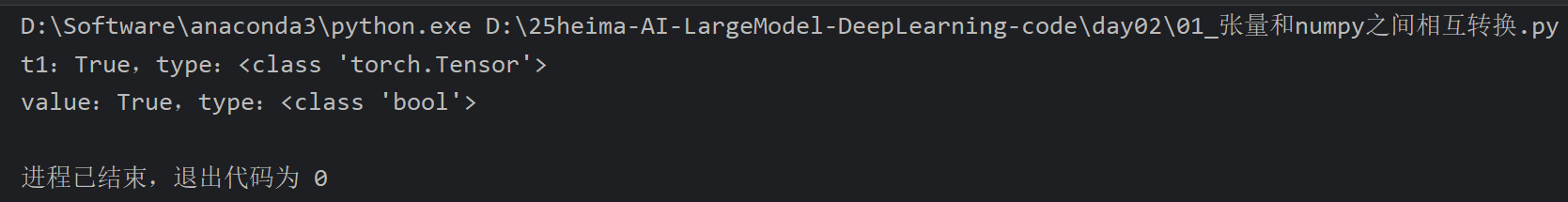

2、张量和Numpy之间相互转换

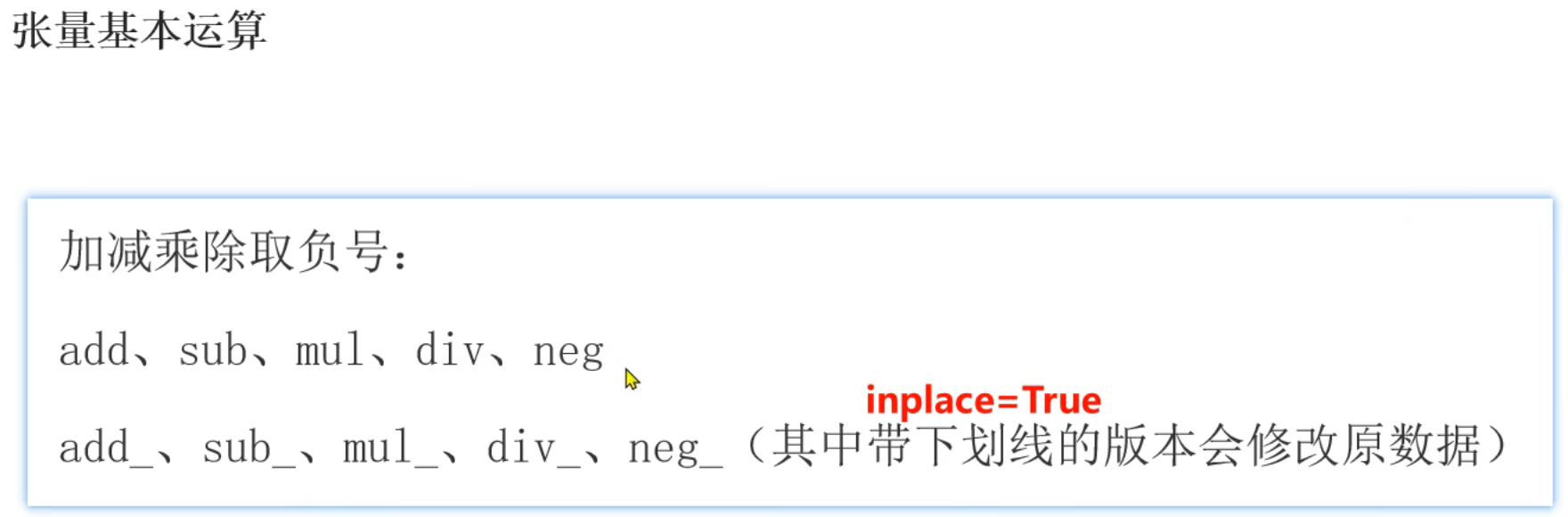

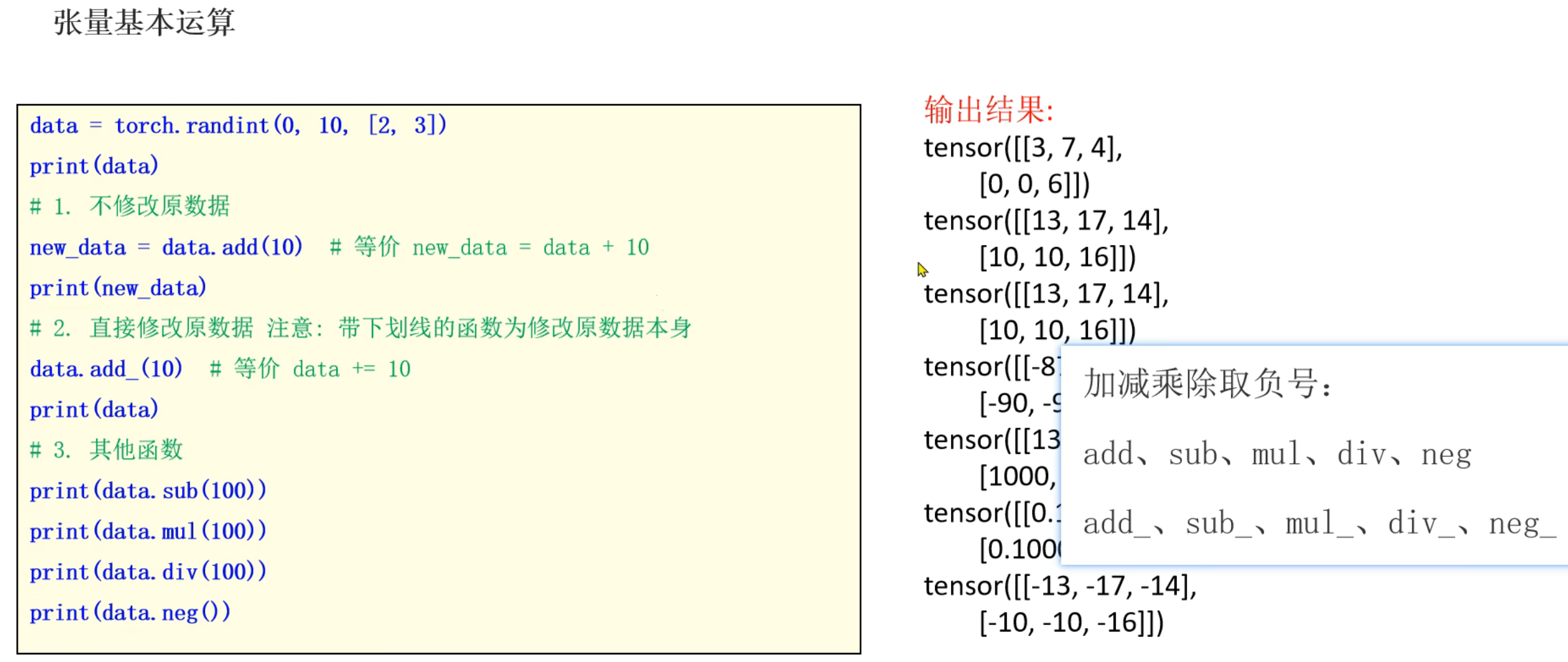

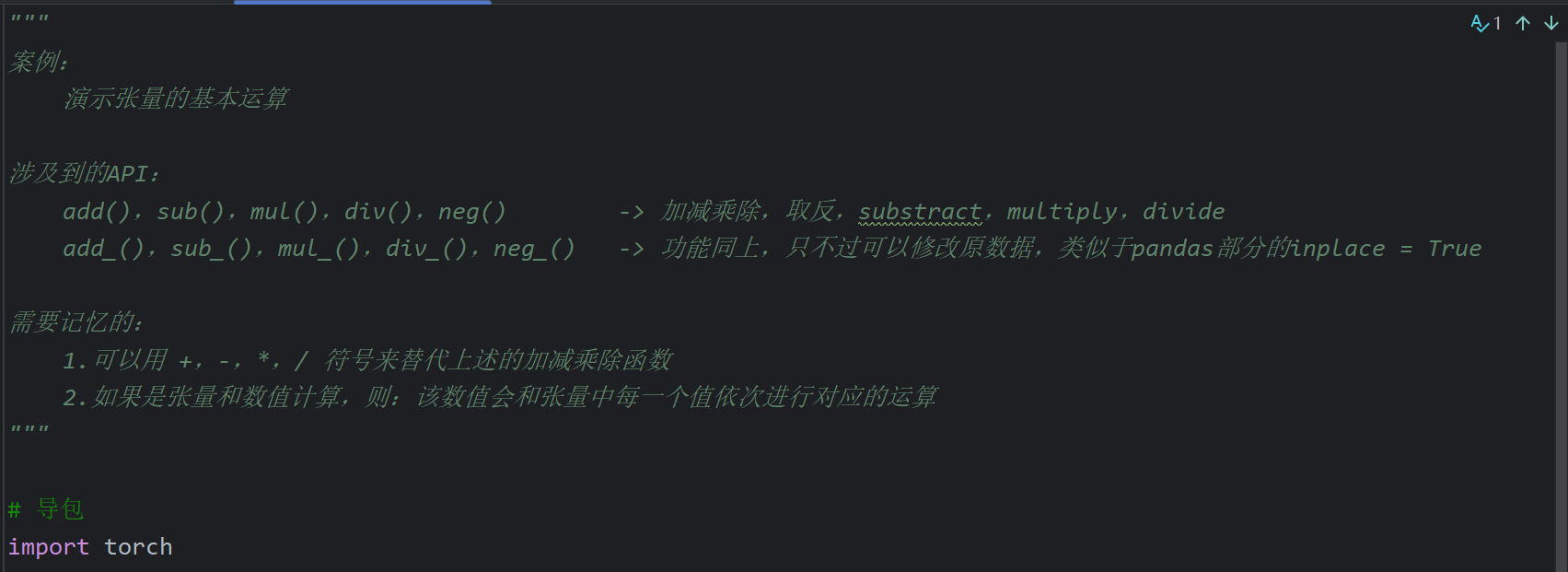

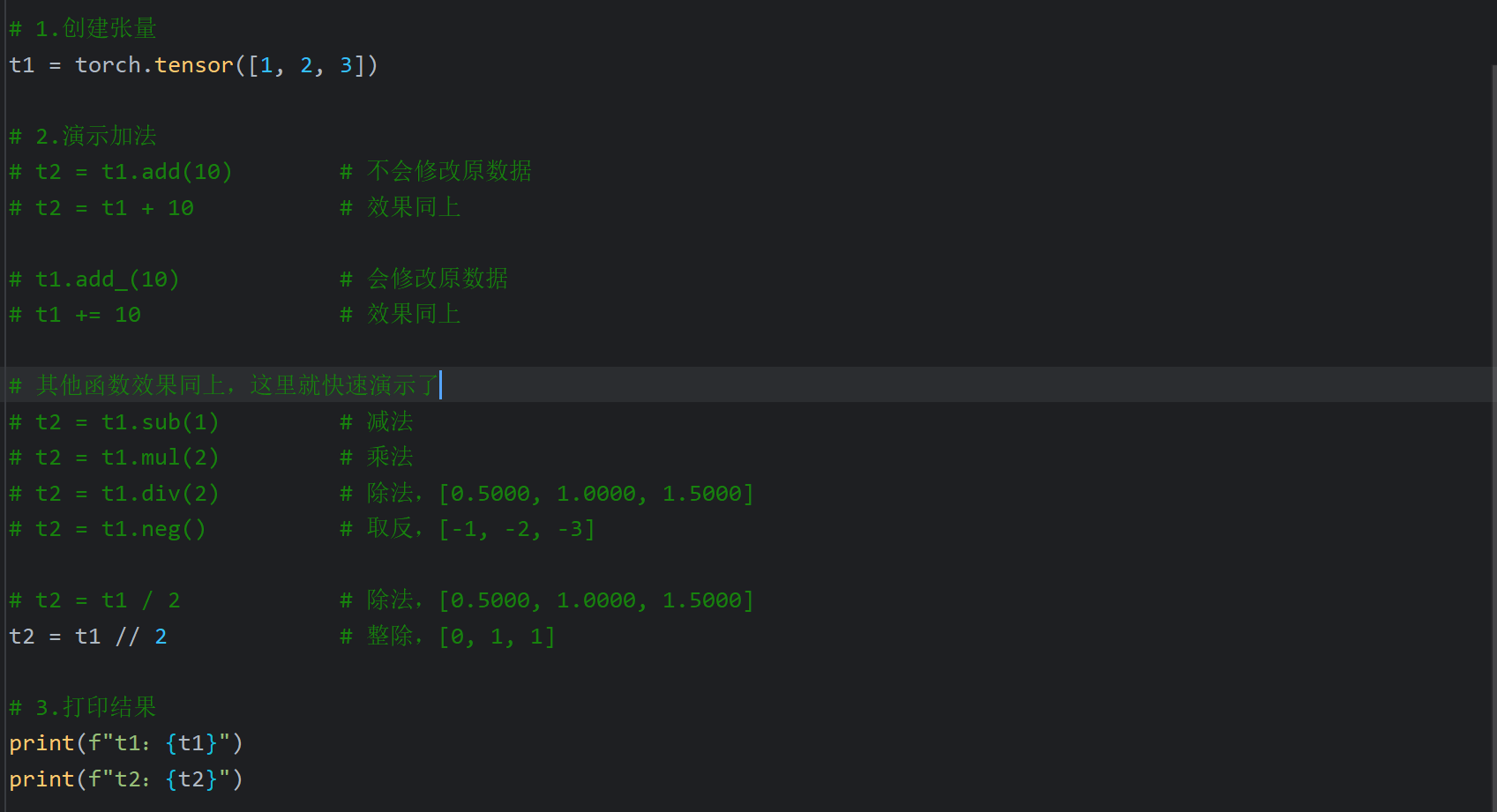

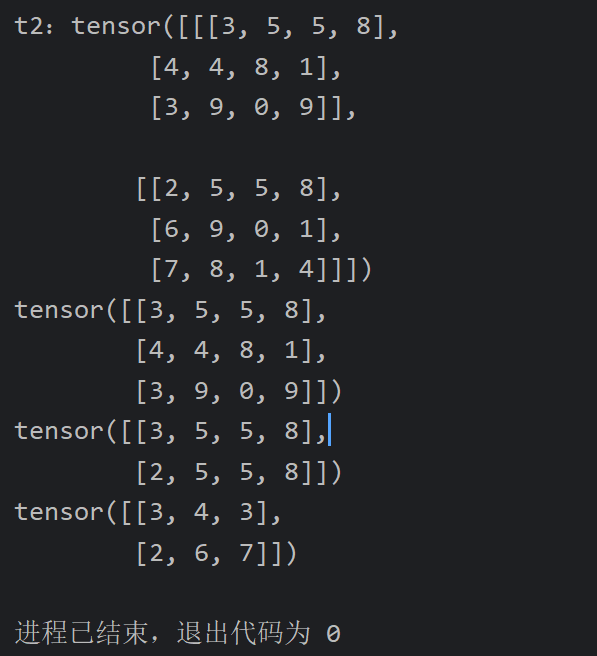

3、张量的基本运算

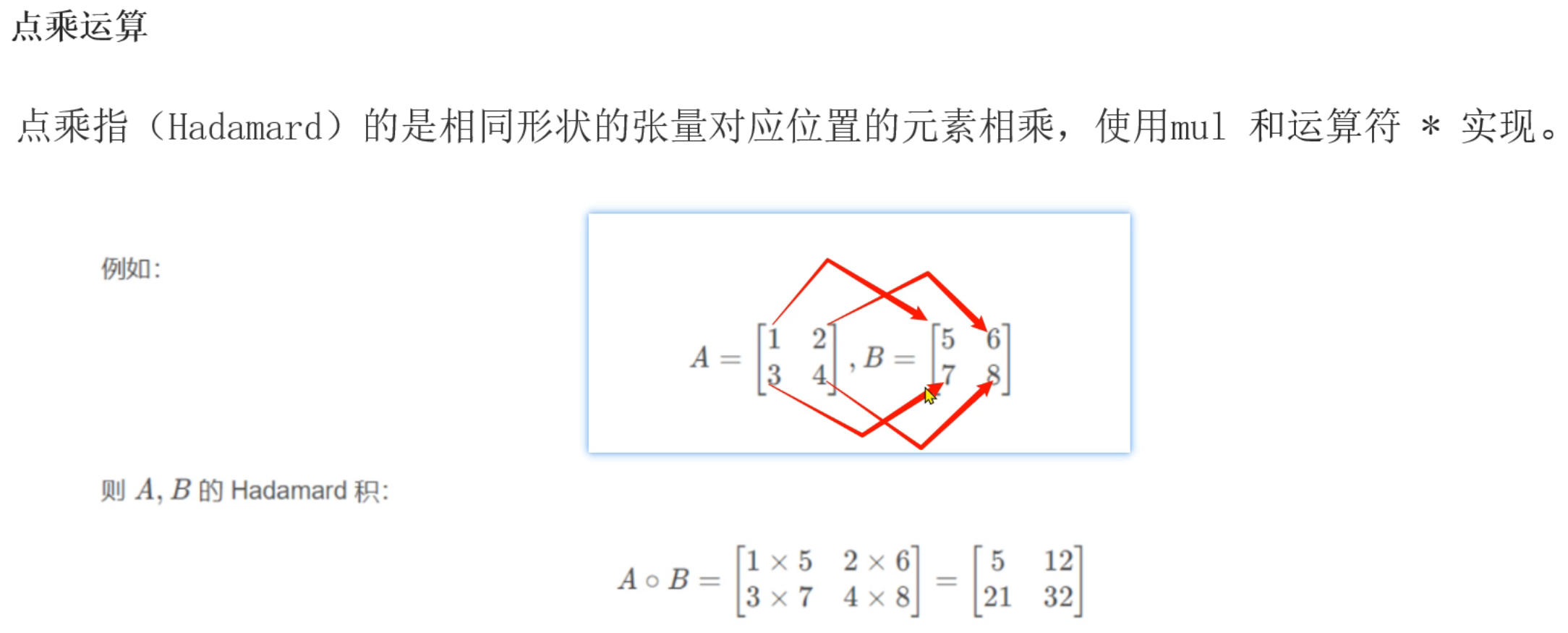

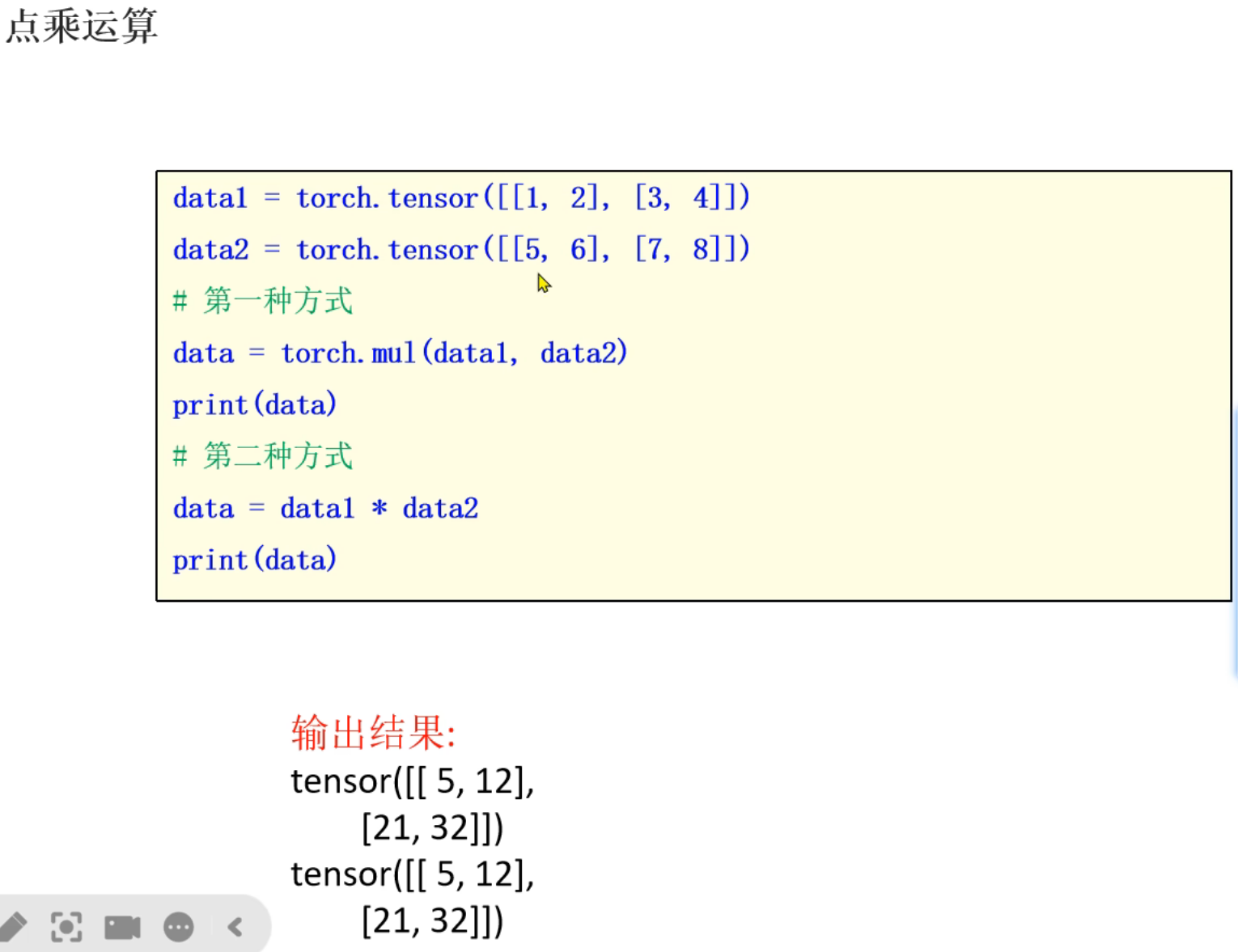

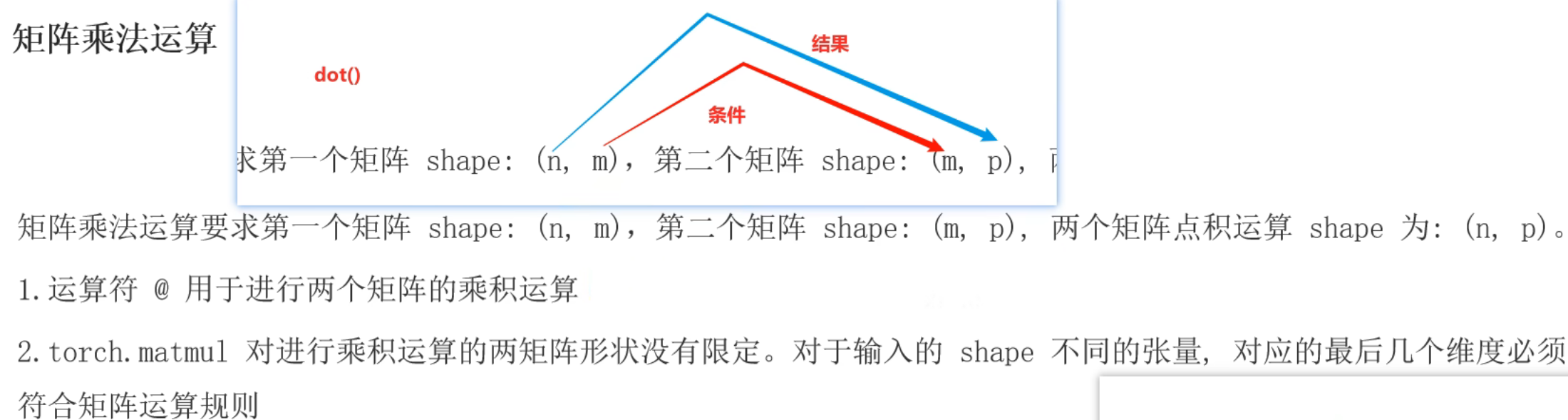

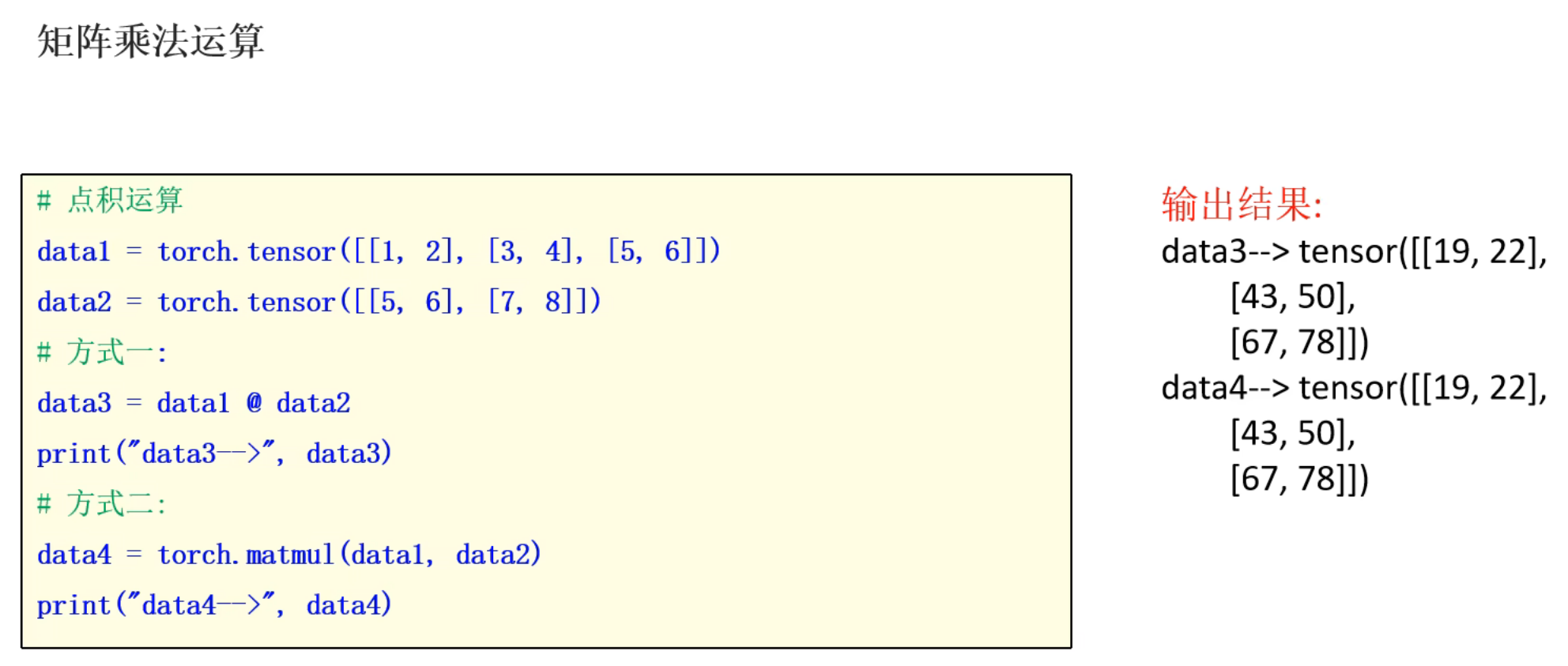

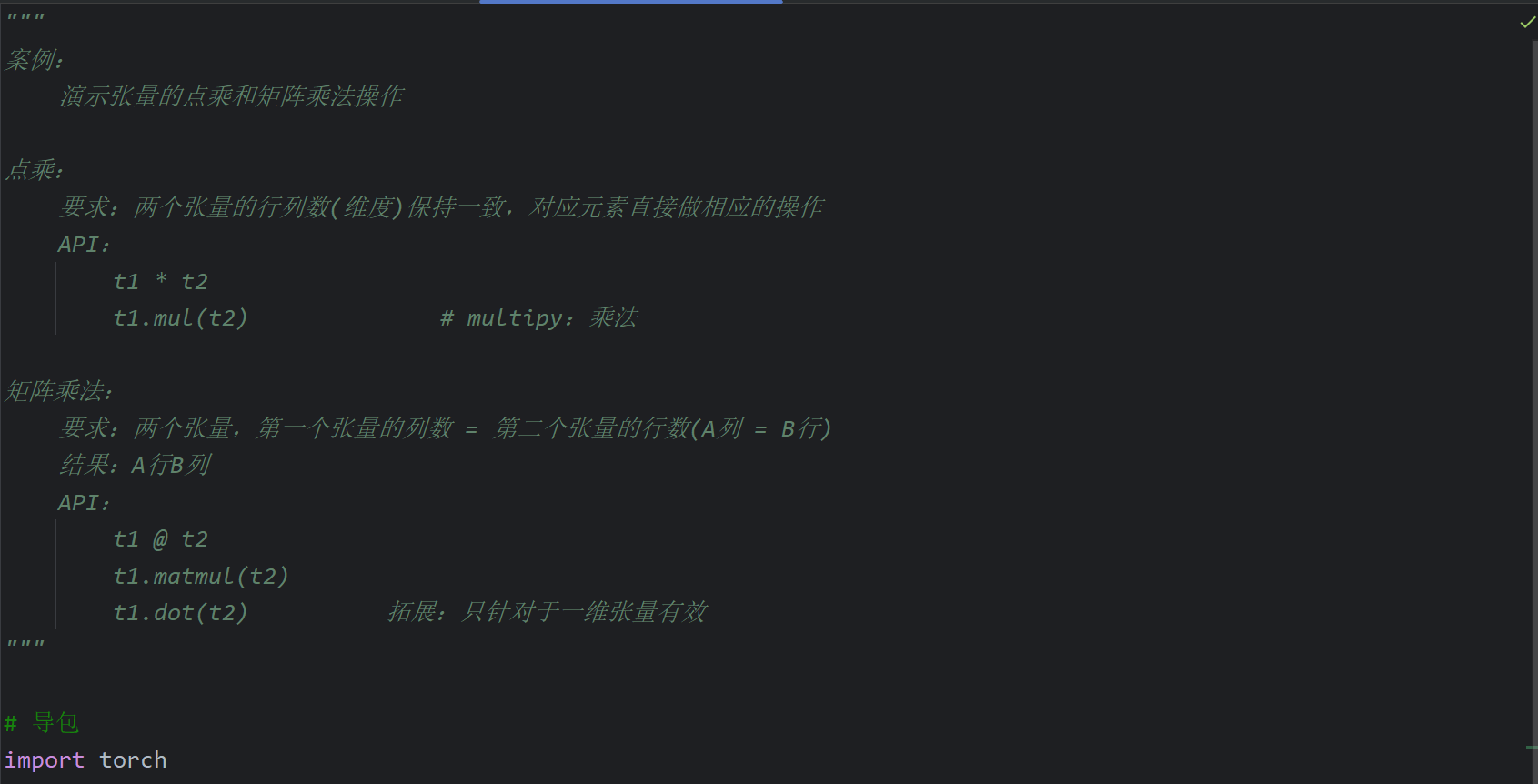

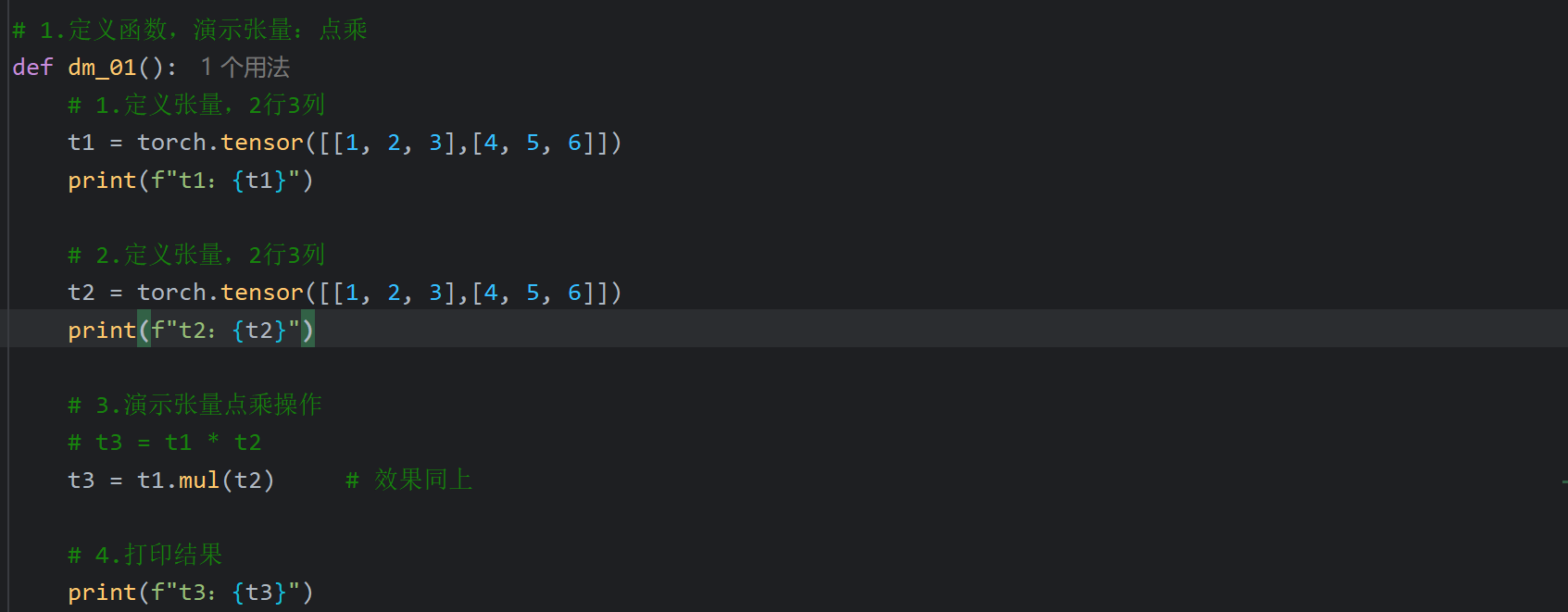

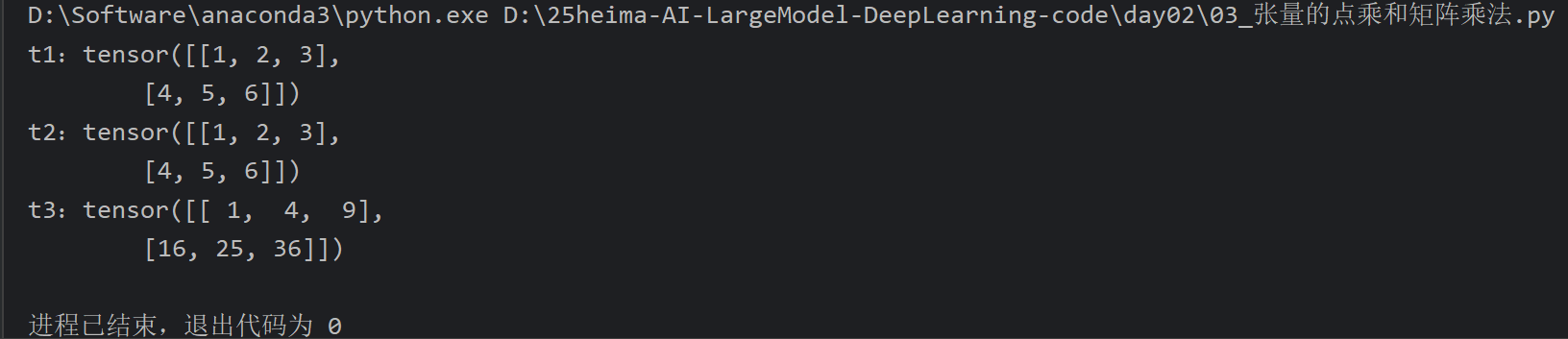

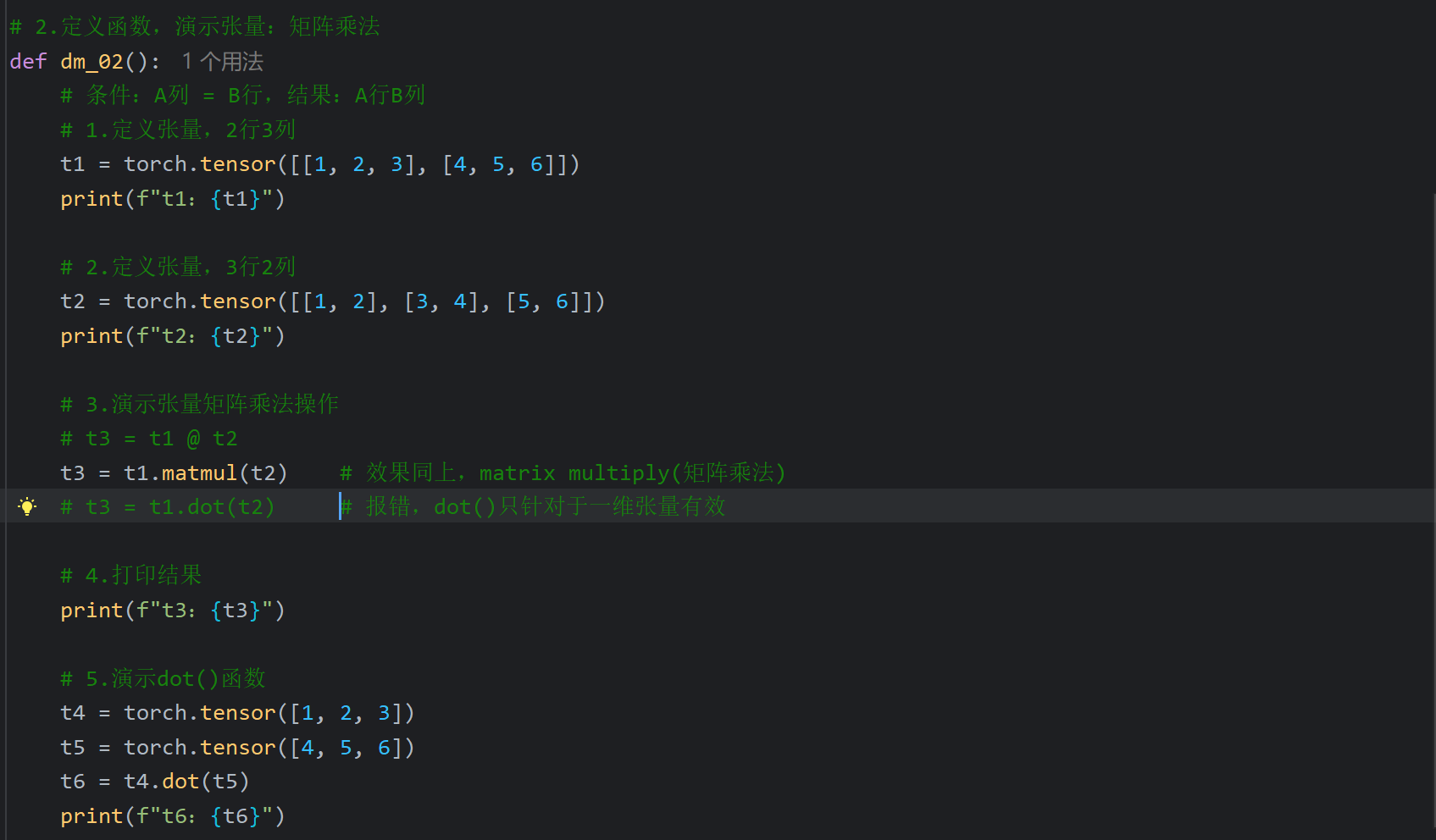

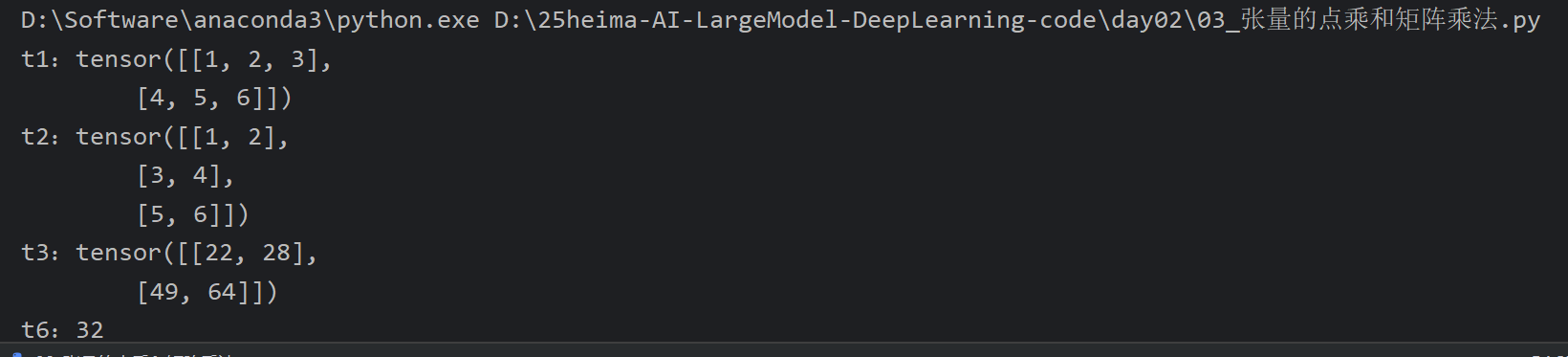

4、张量点乘和矩阵乘法

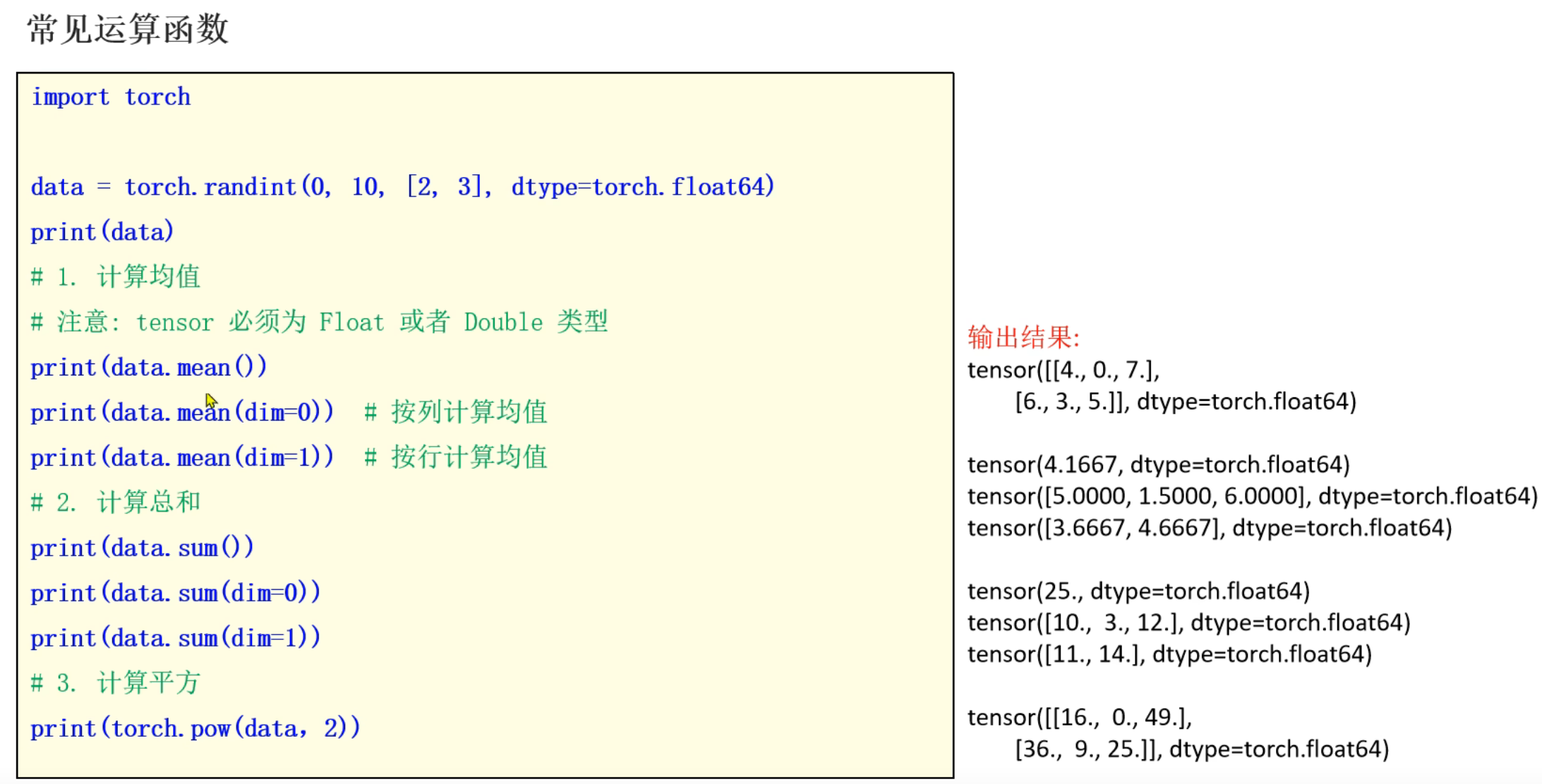

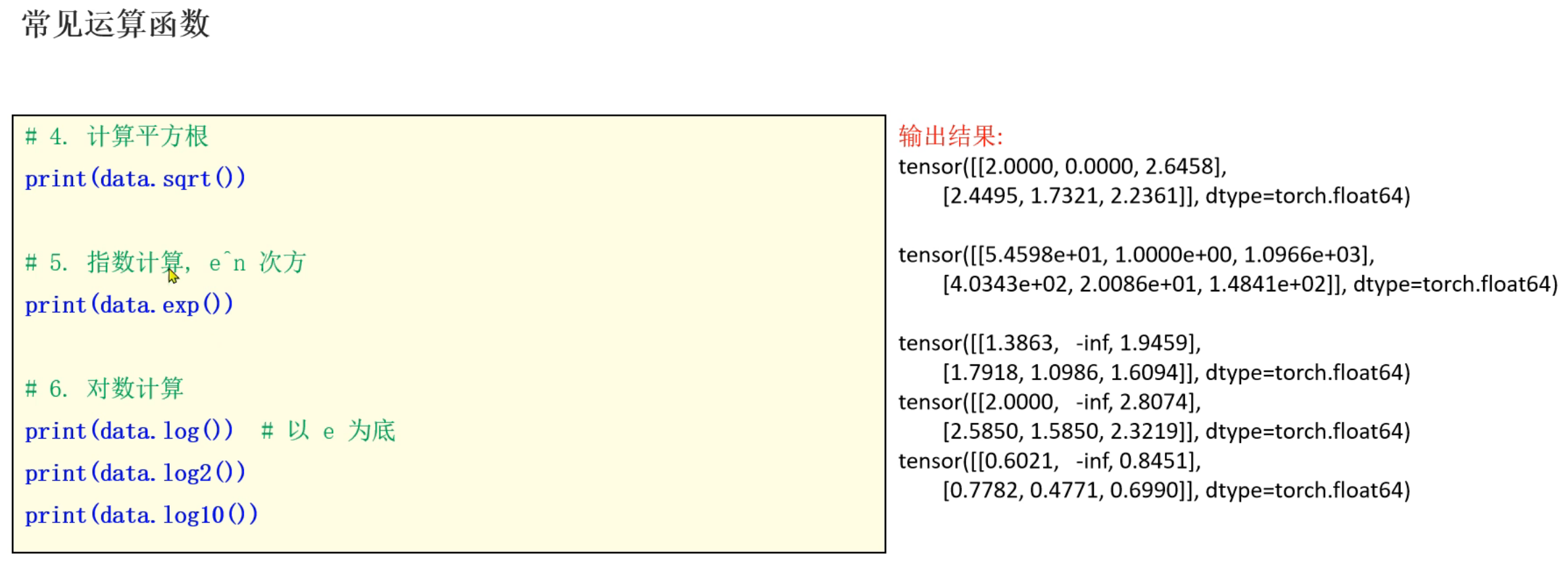

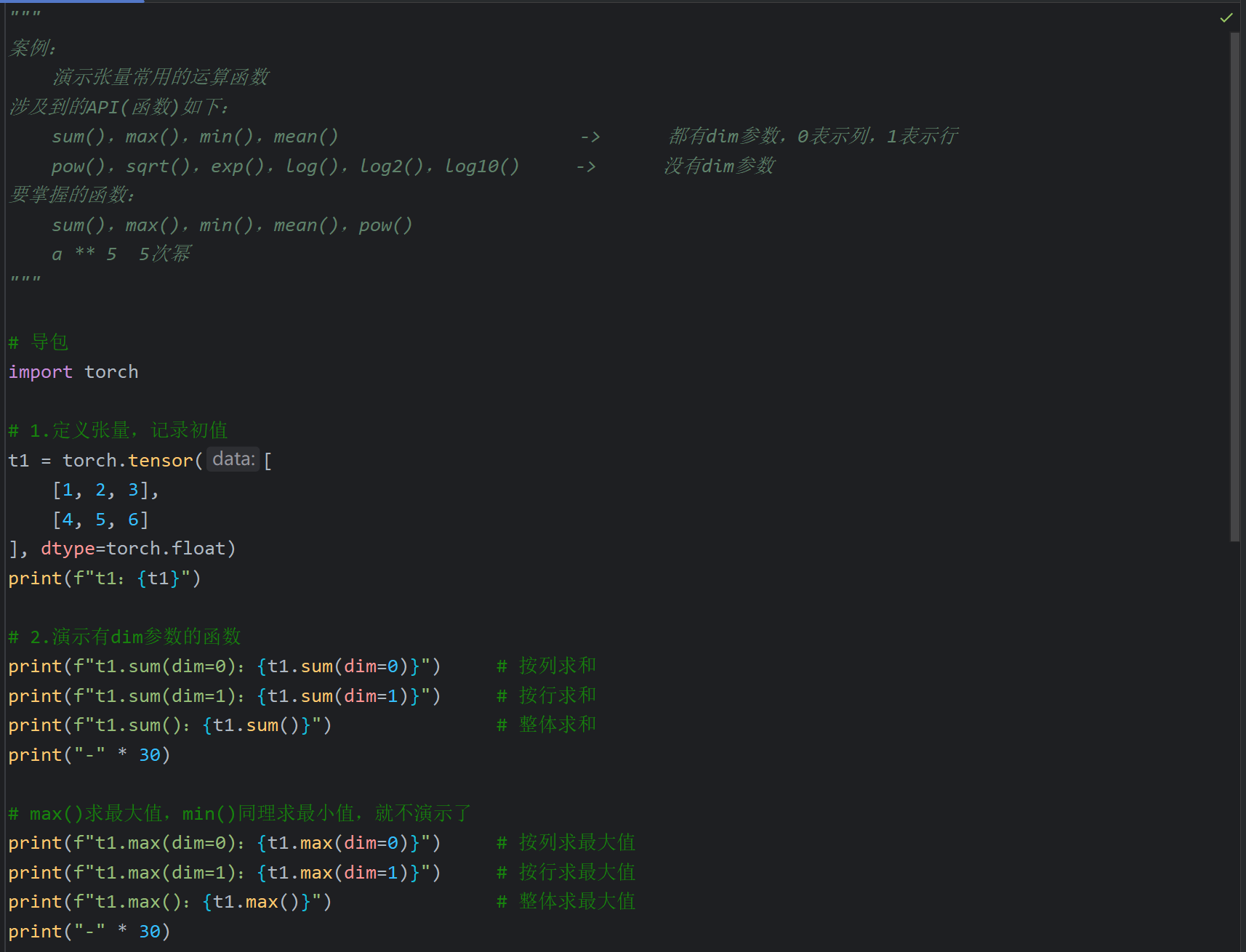

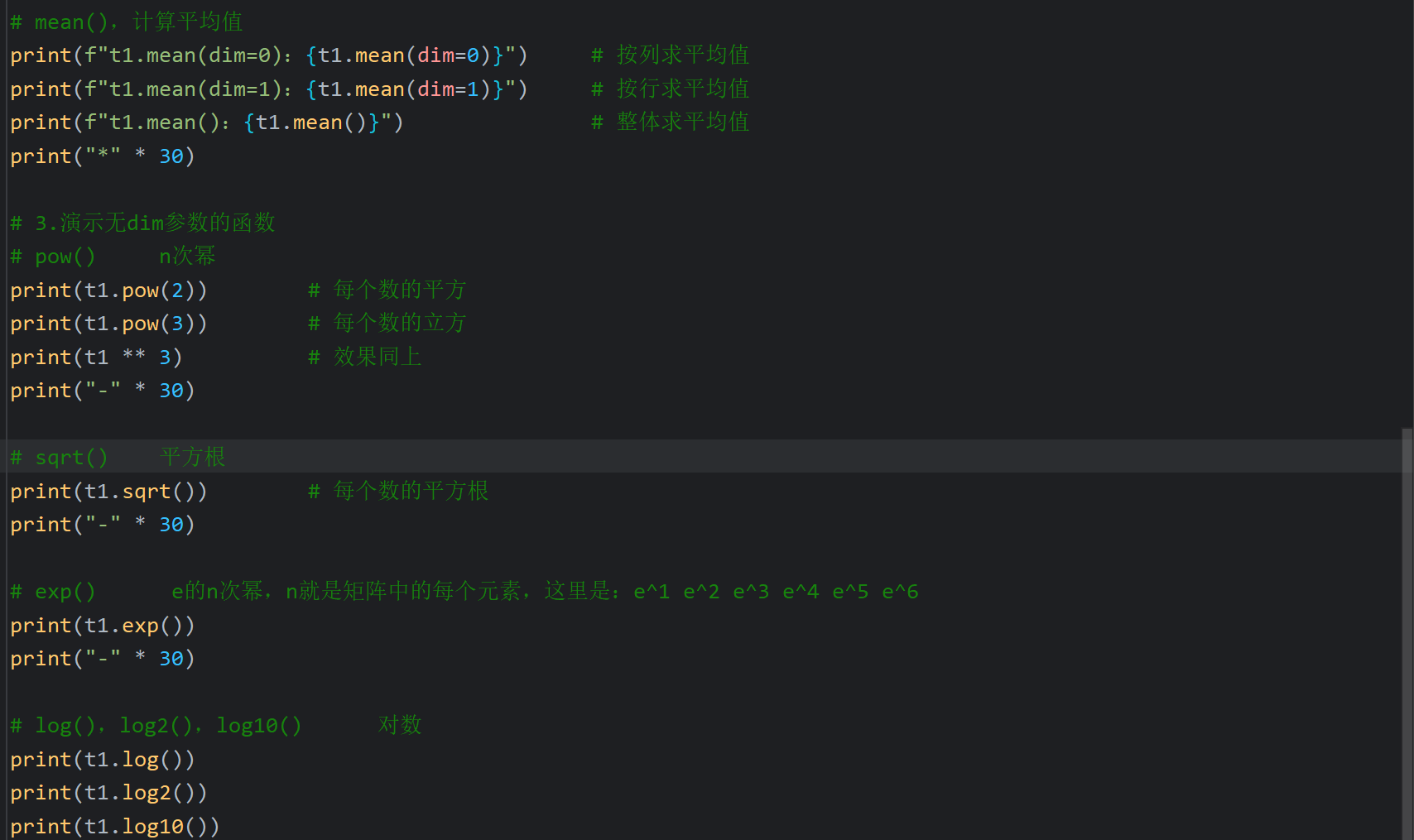

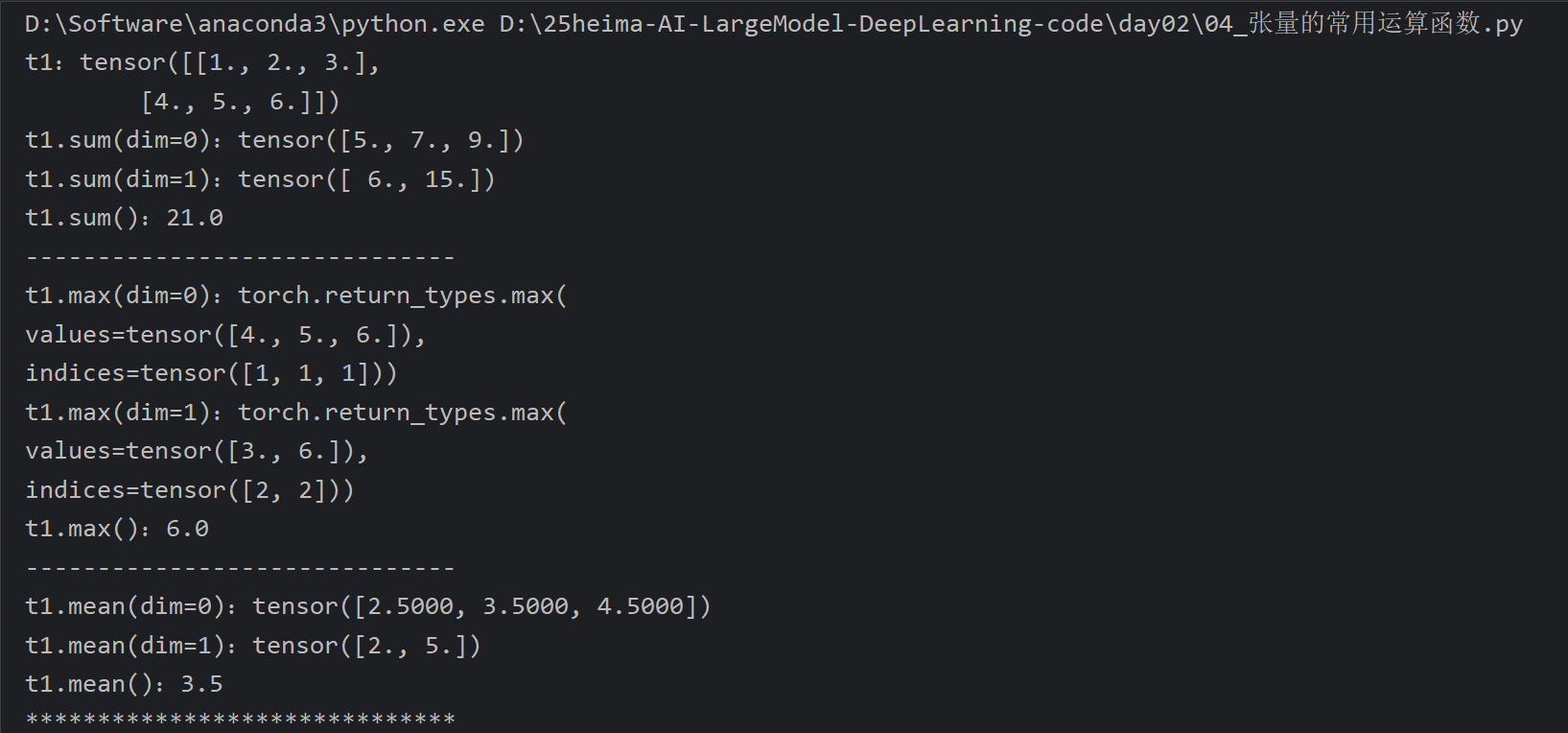

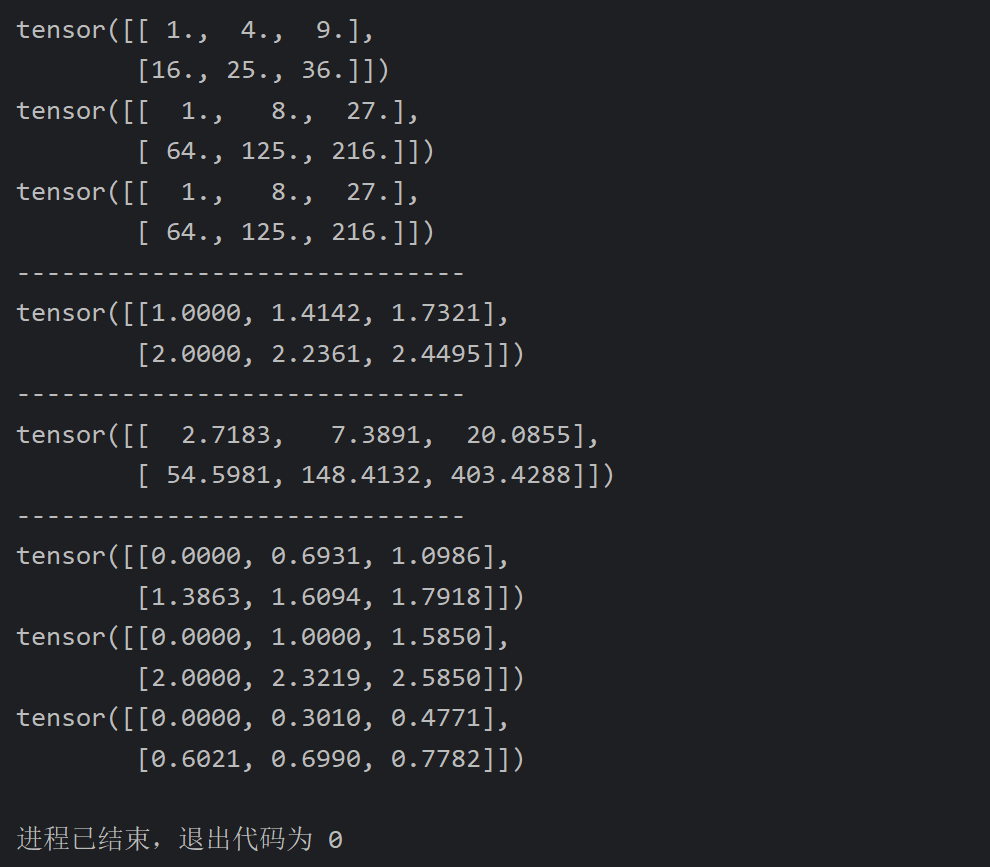

5、张量的常用运算函数

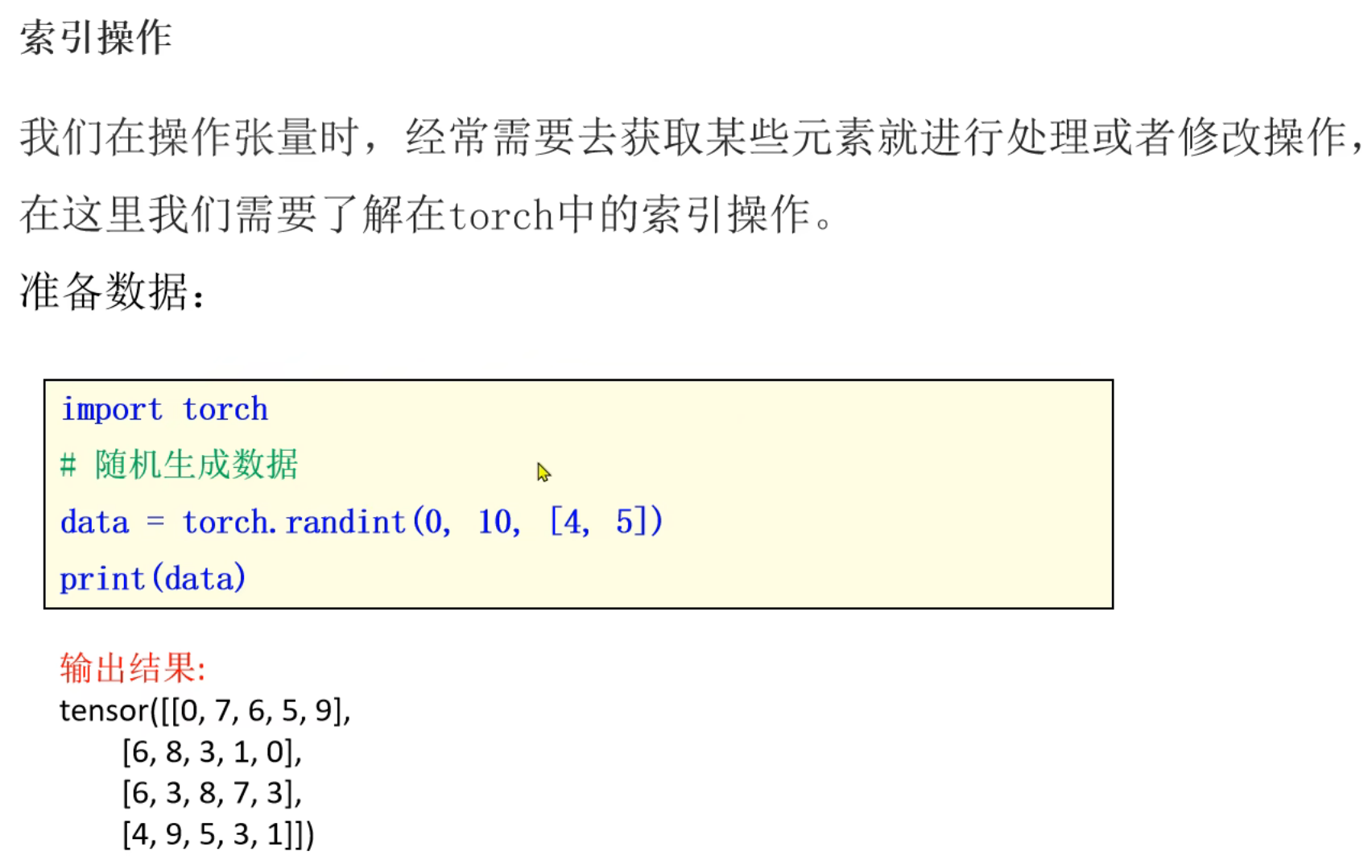

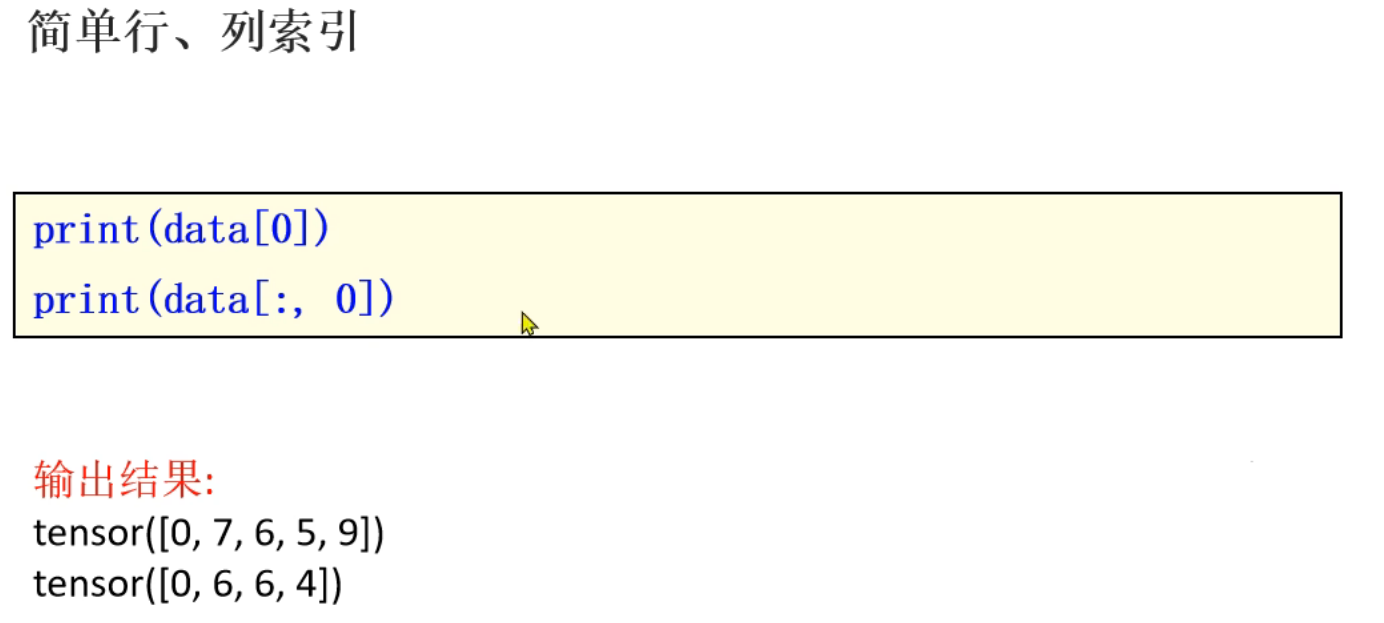

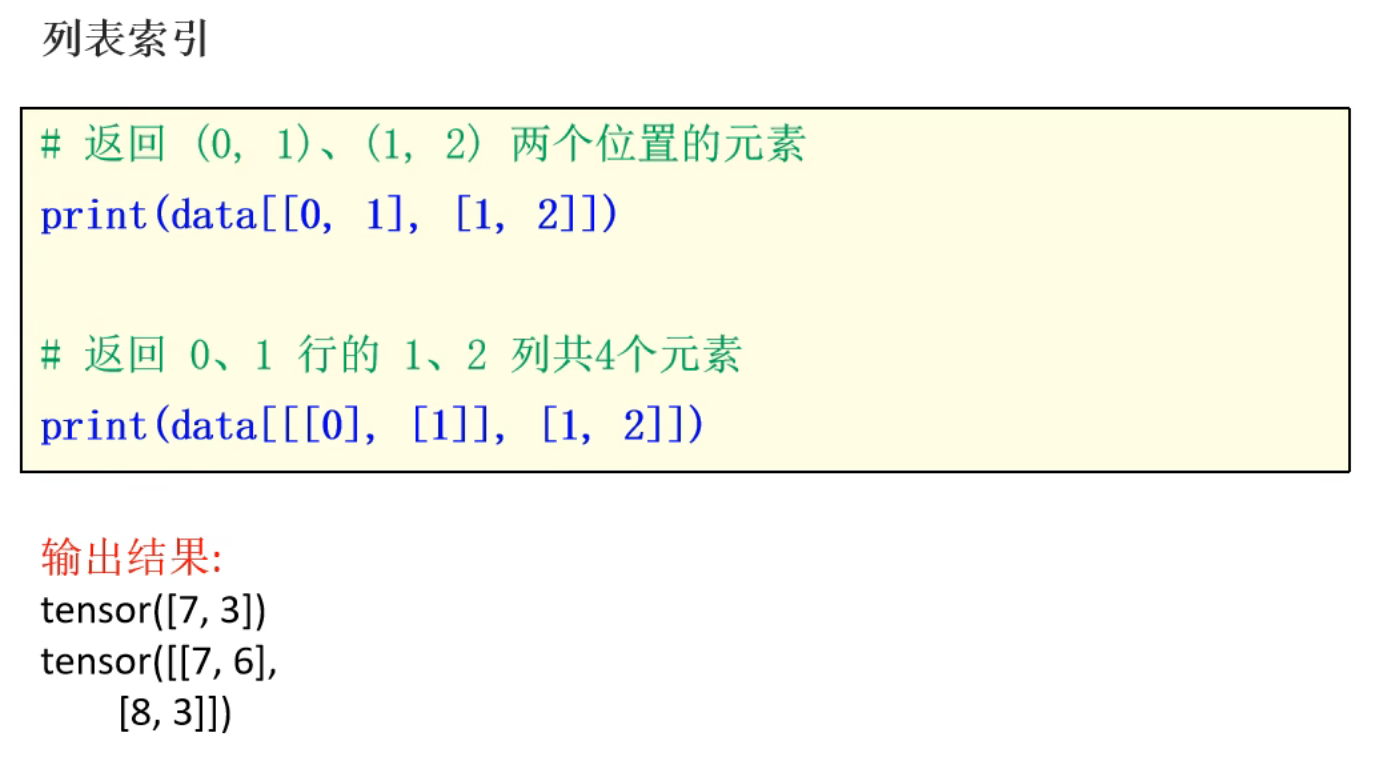

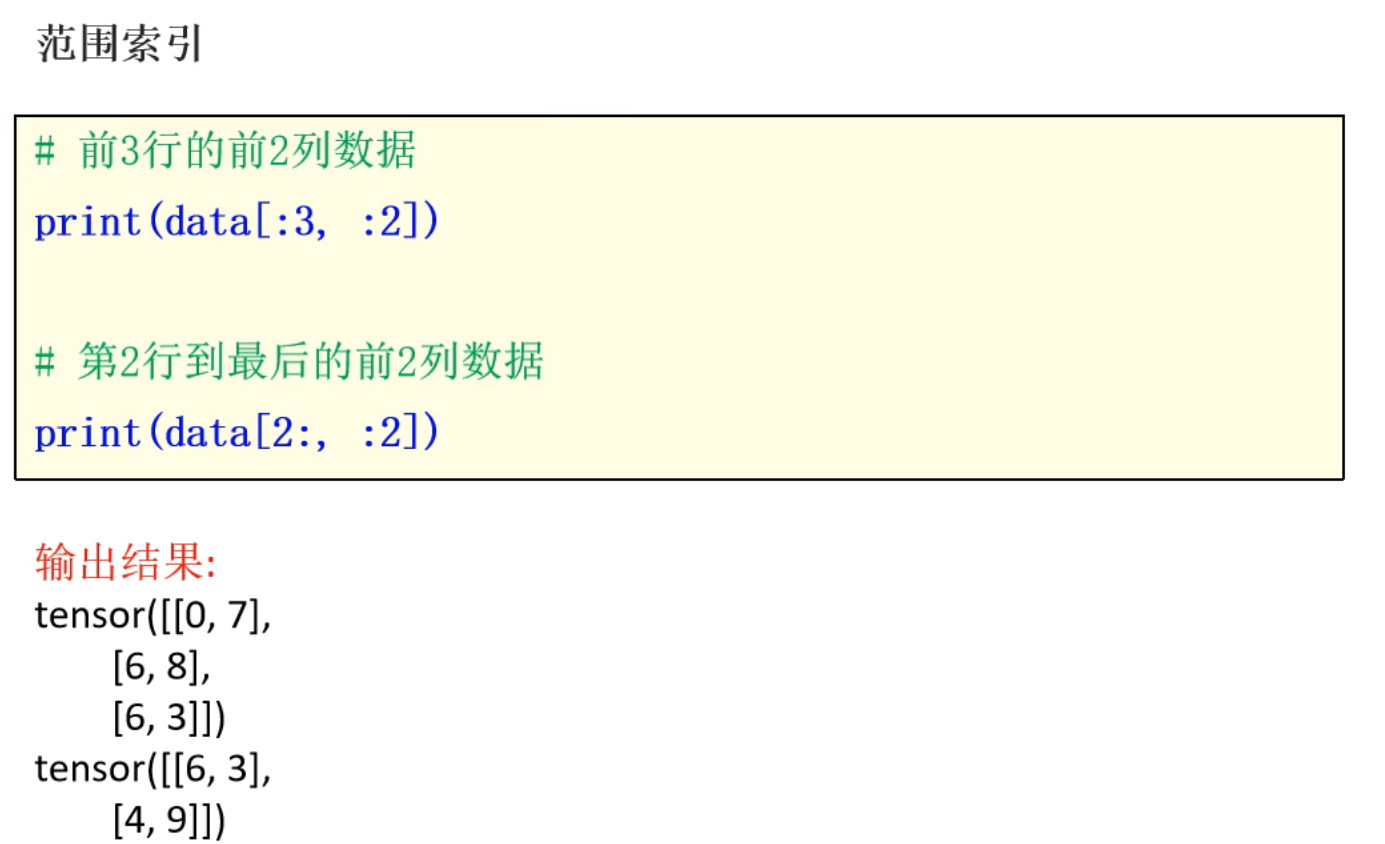

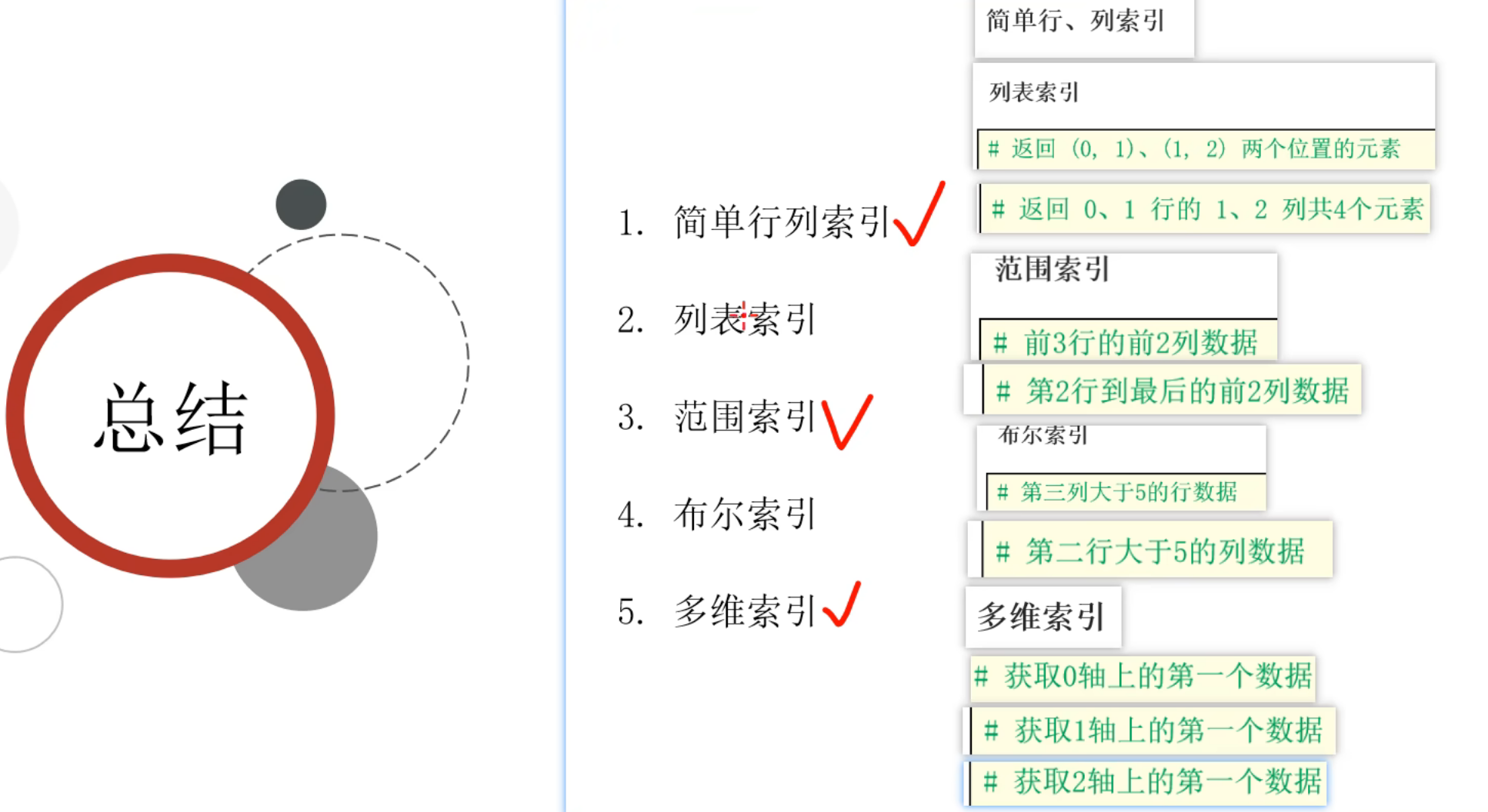

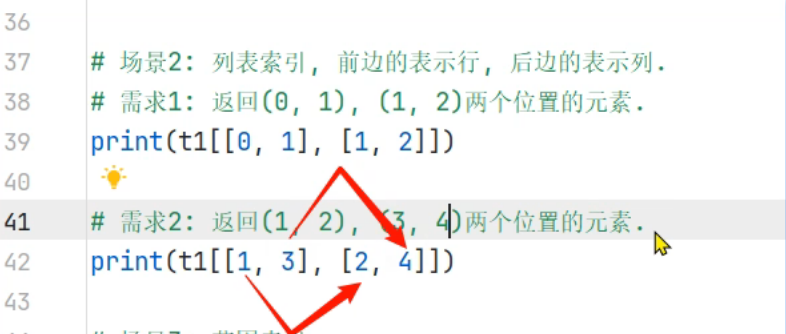

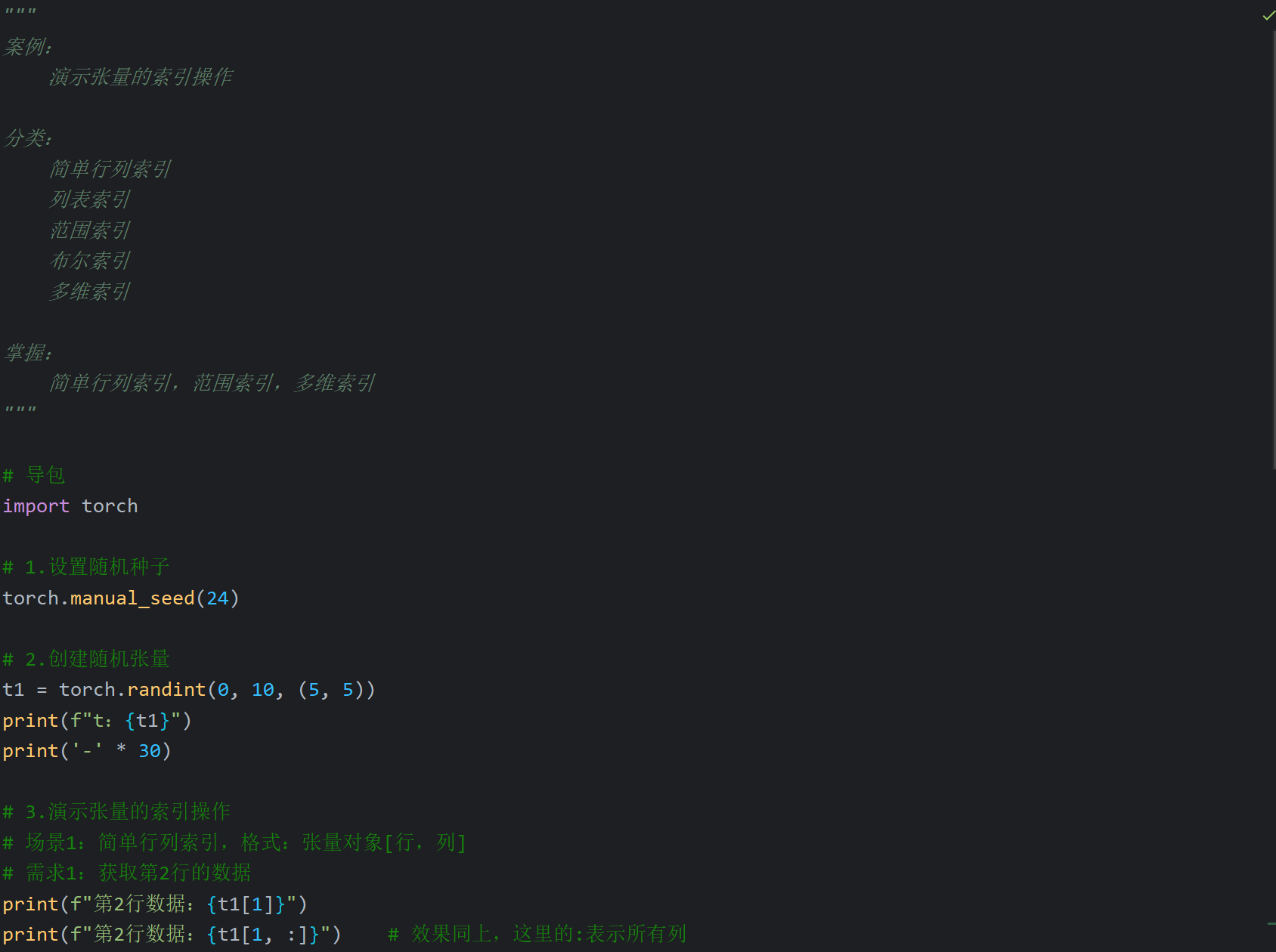

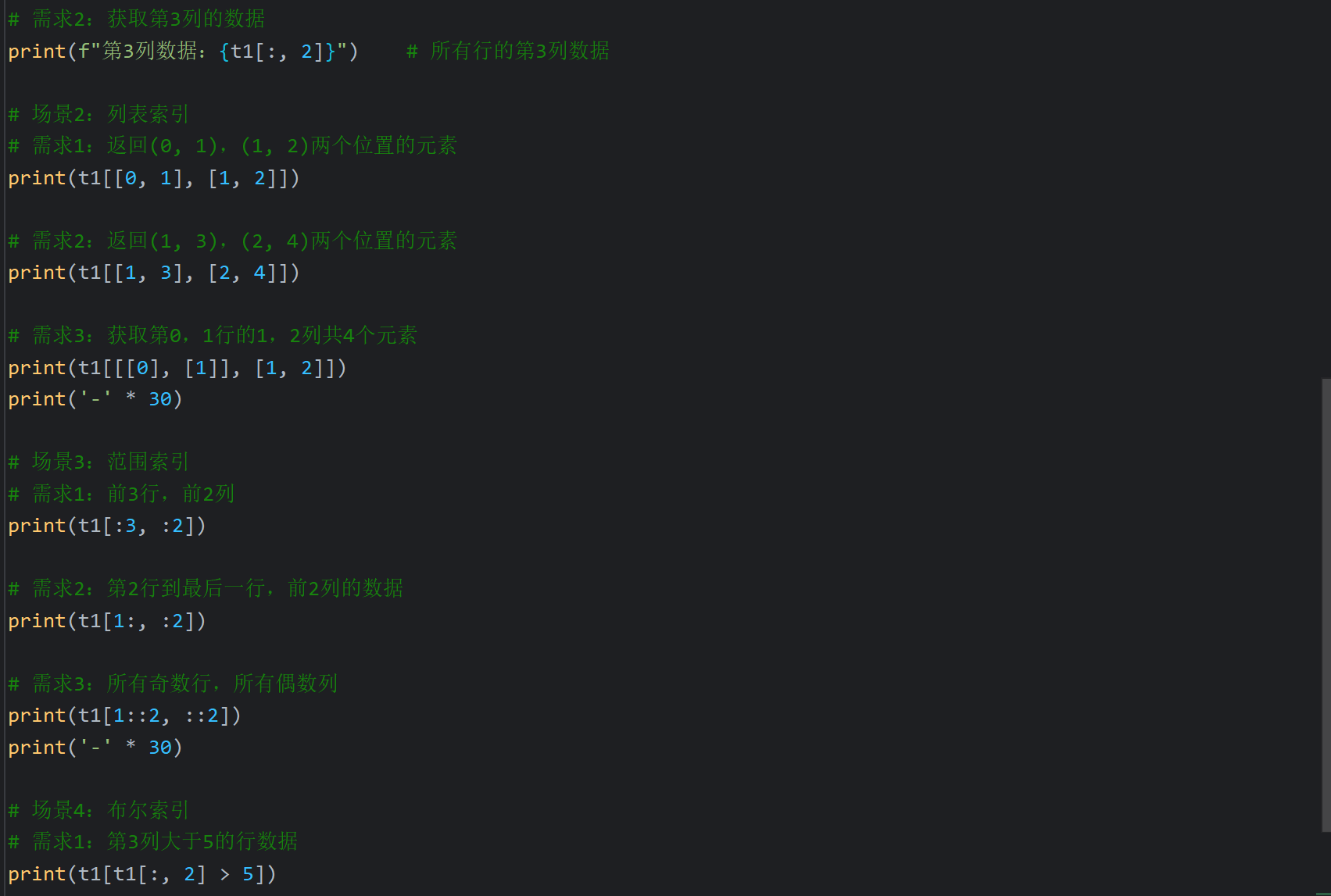

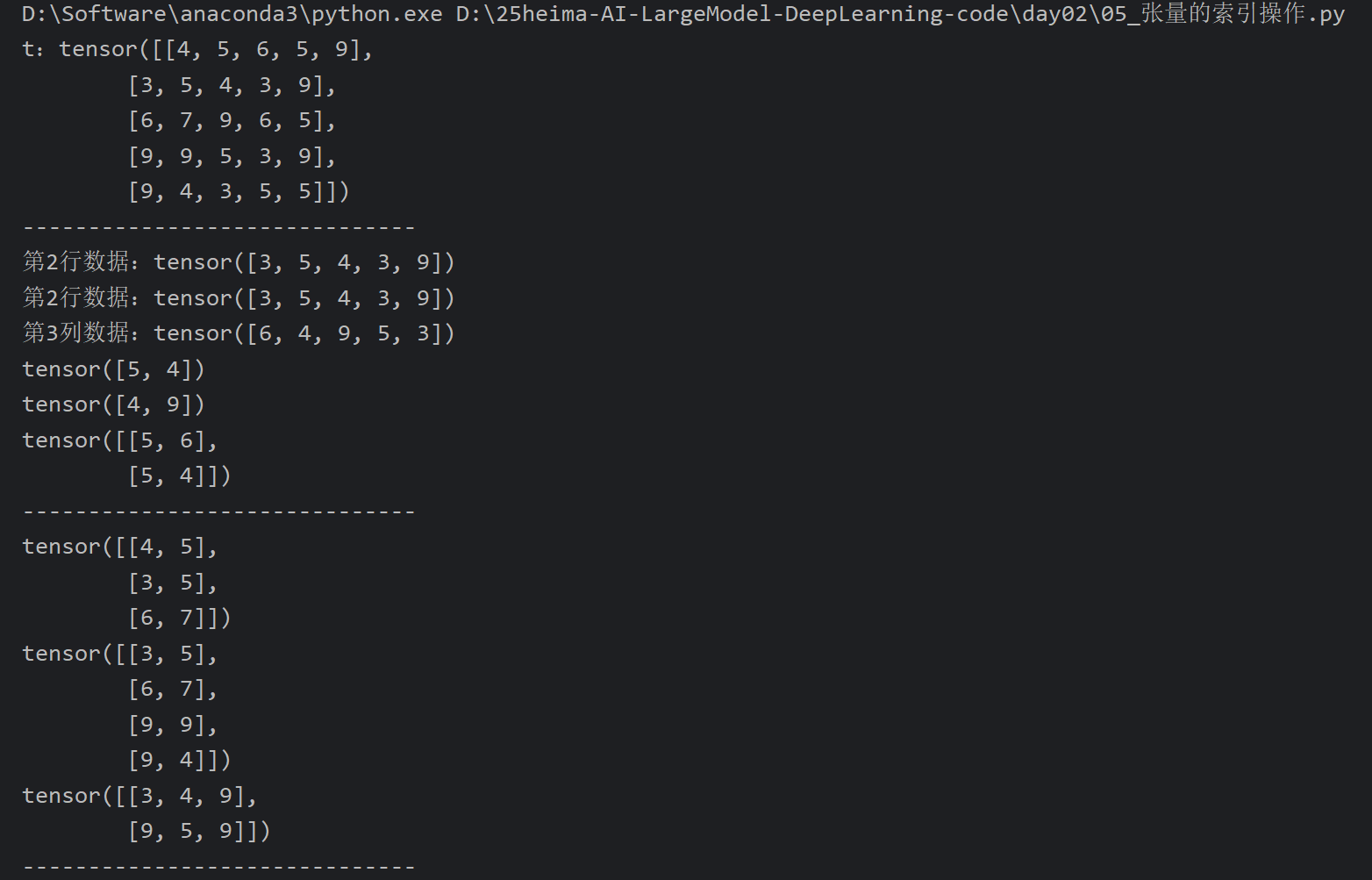

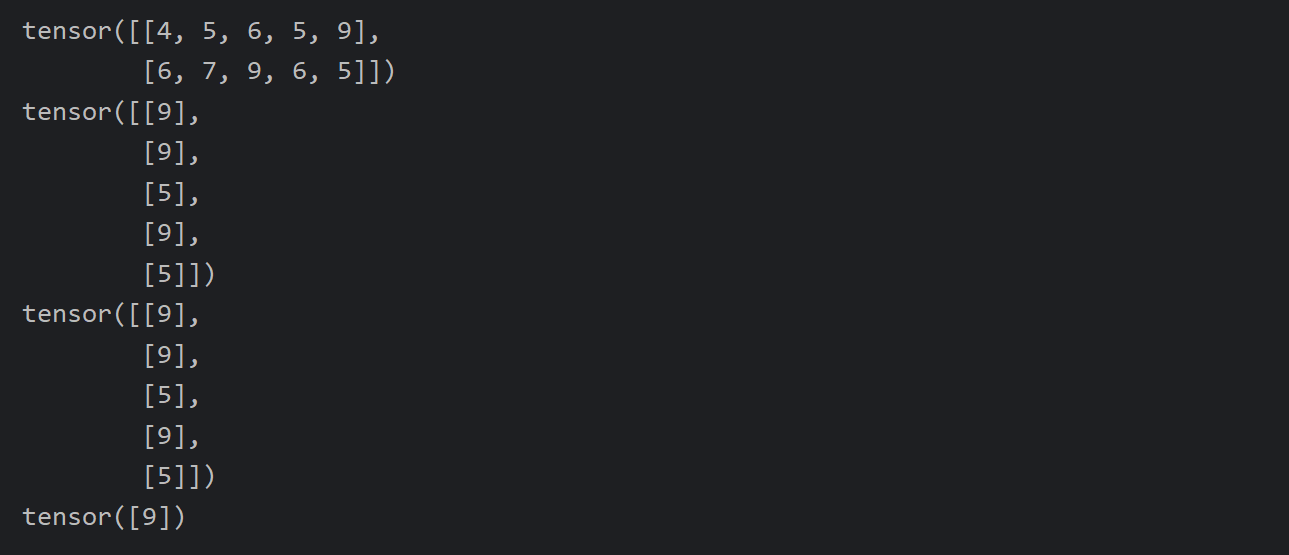

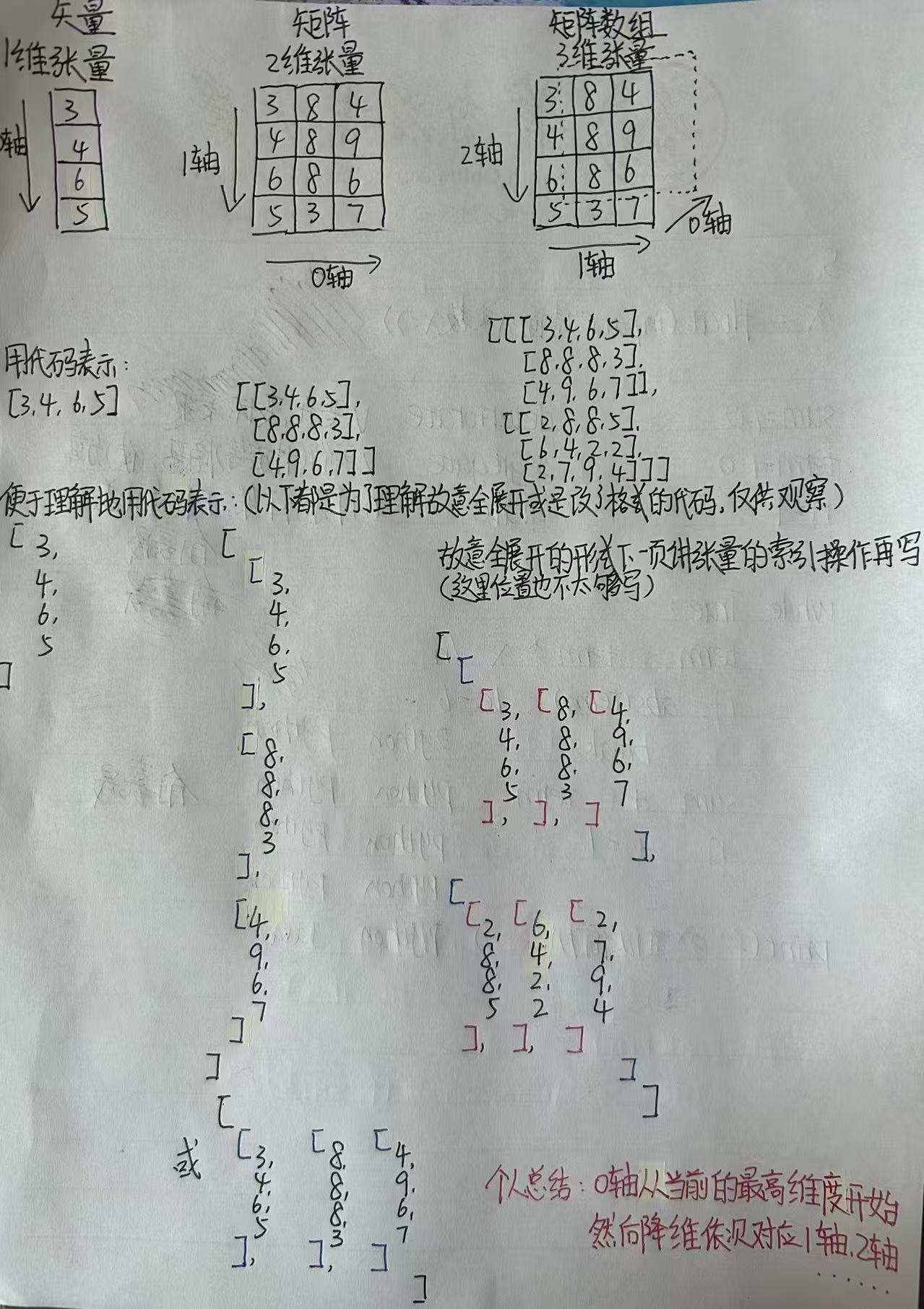

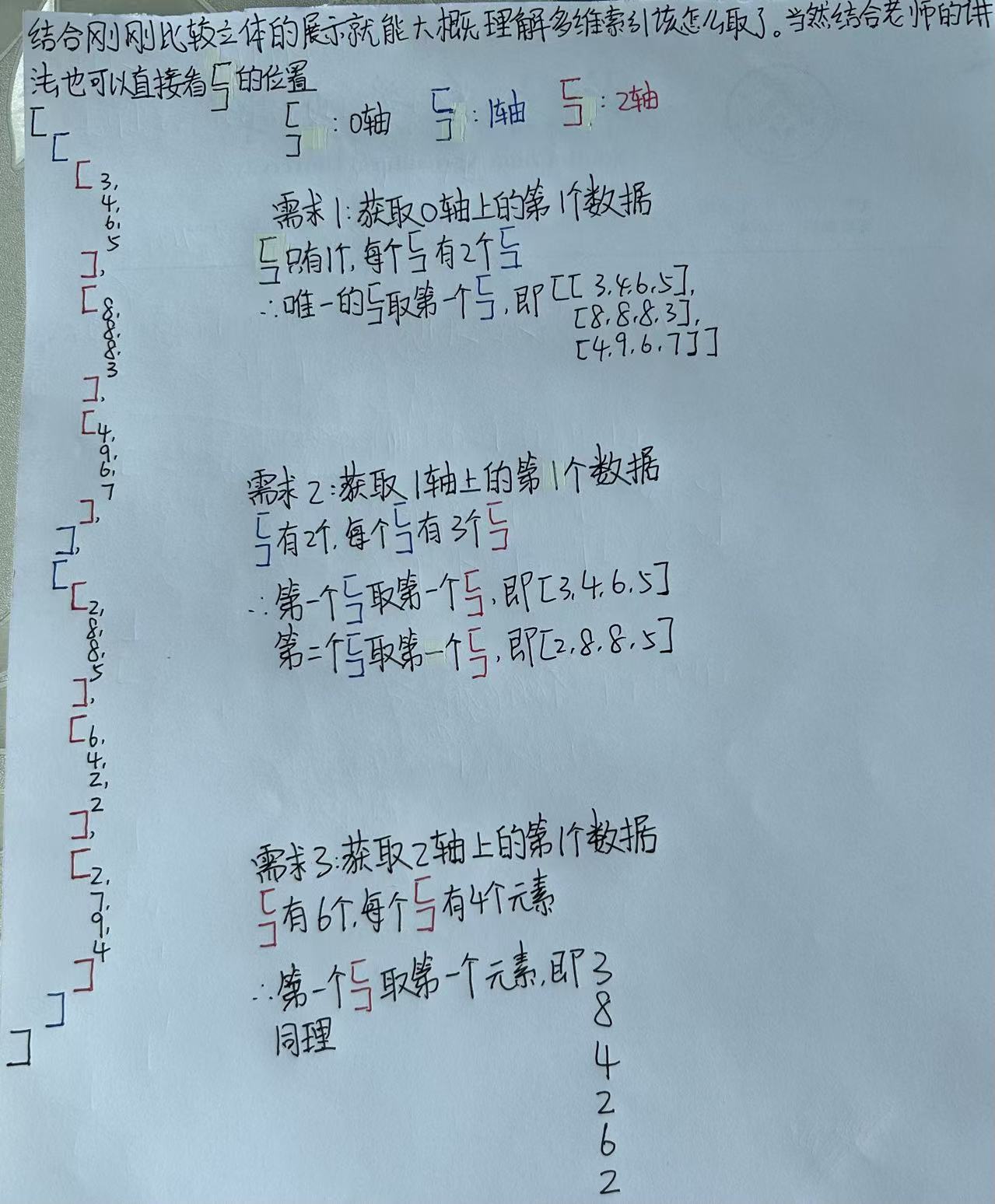

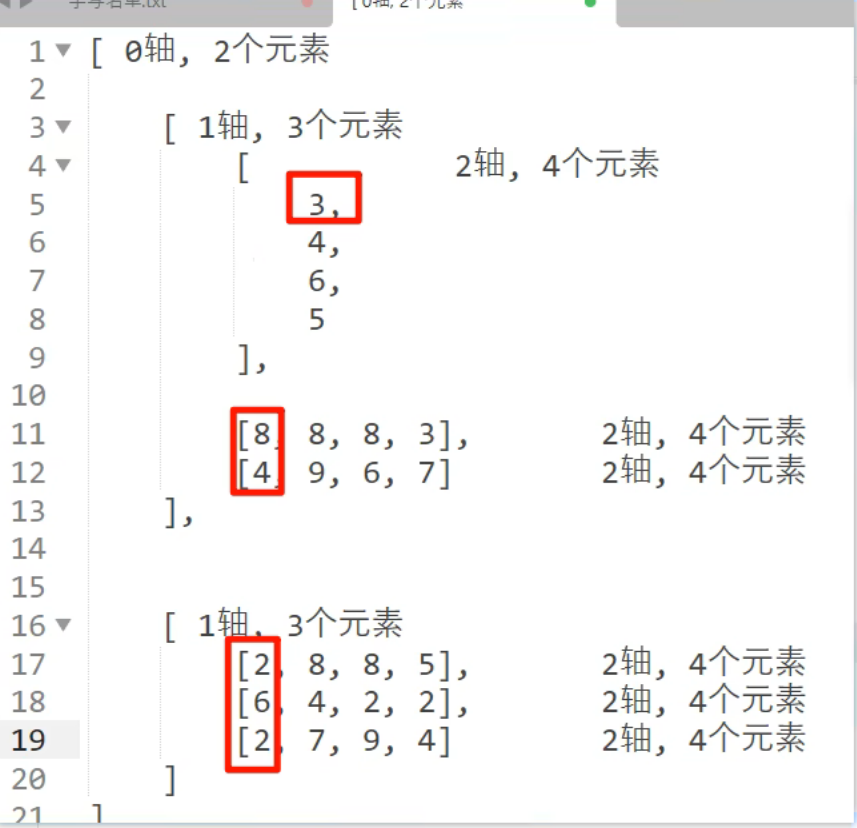

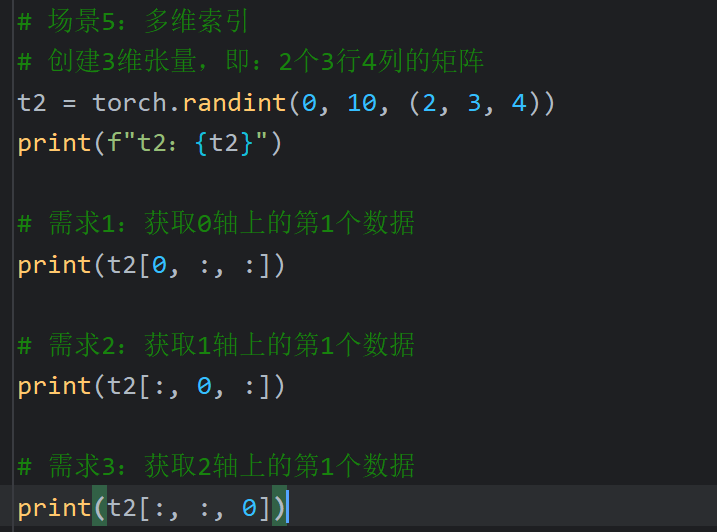

6、张量的索引操作(上)

列表索引:那前面行的索引和后面列的索引进行匹配

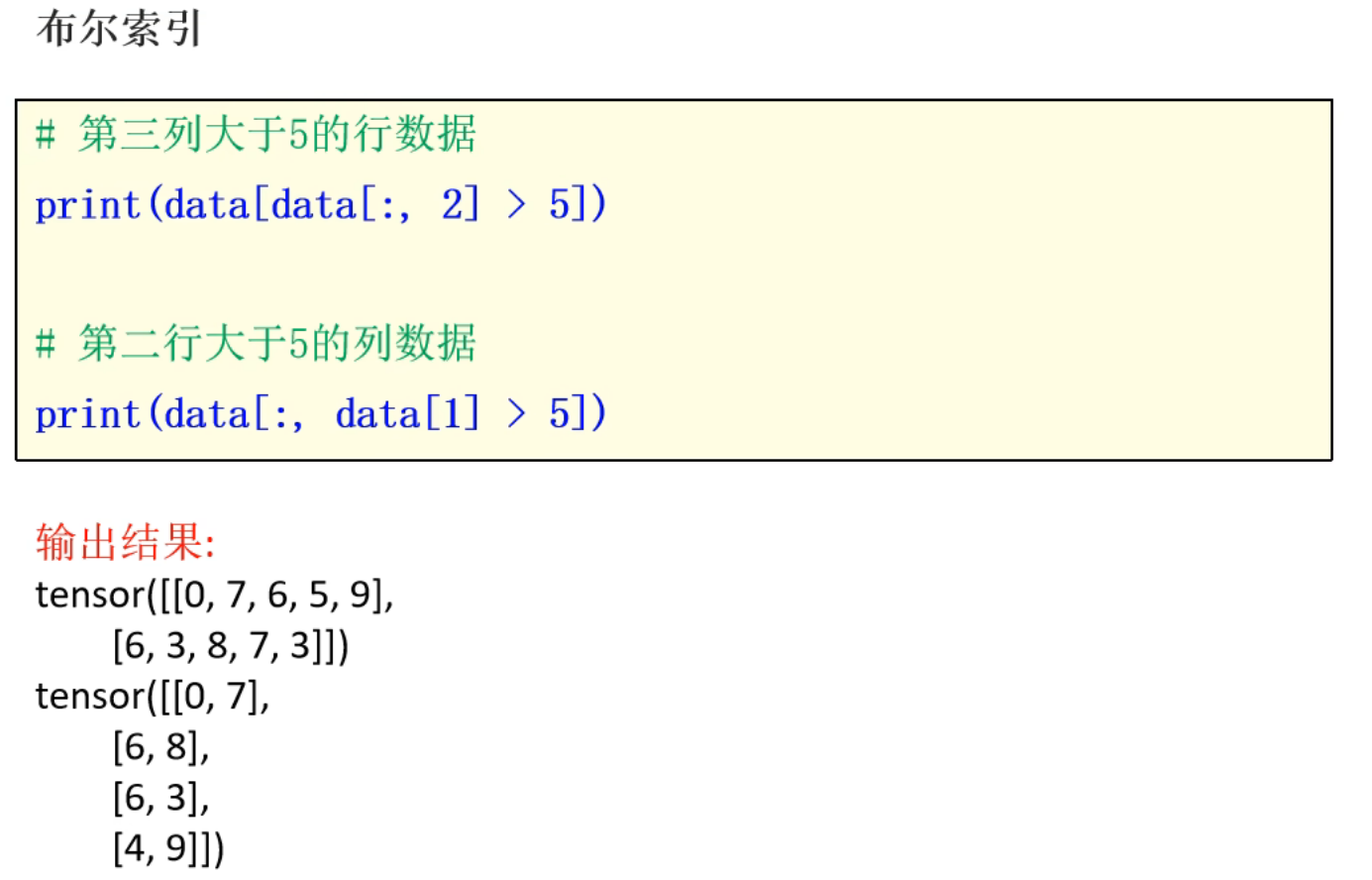

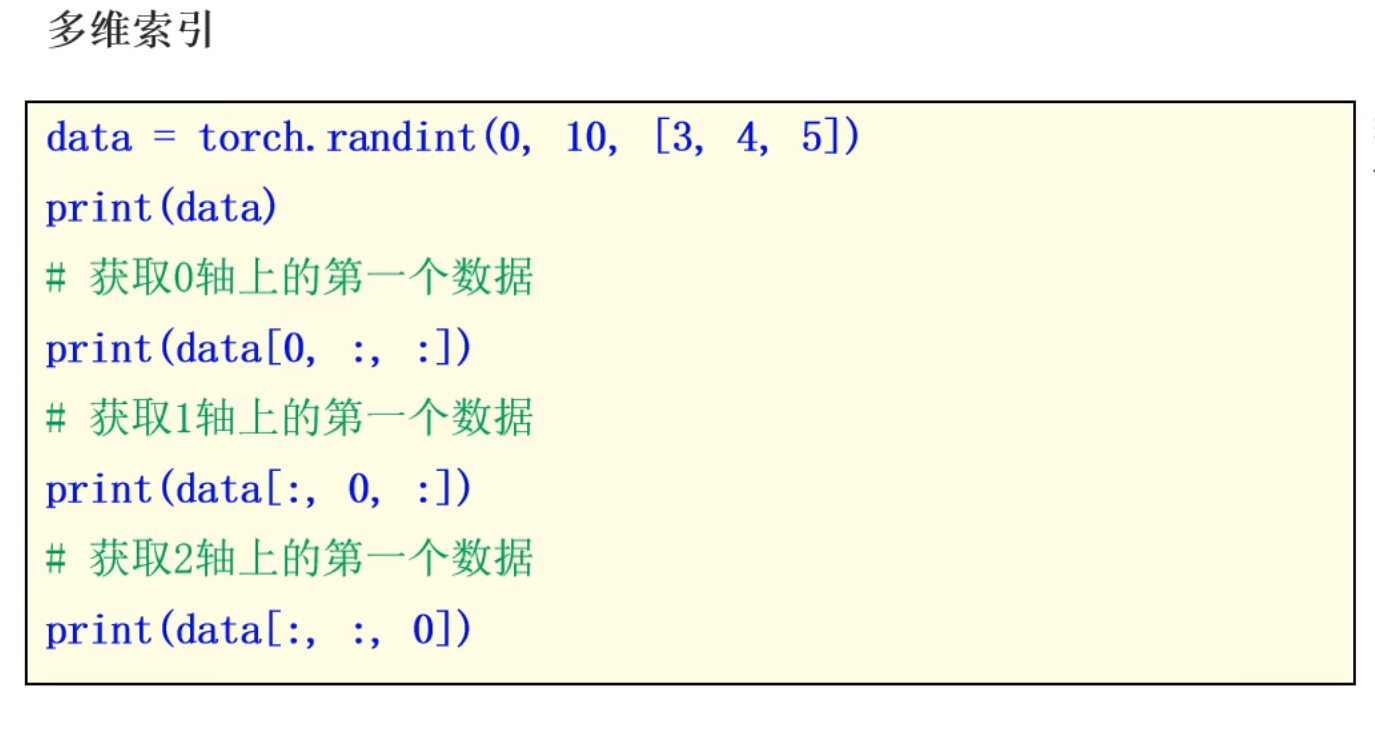

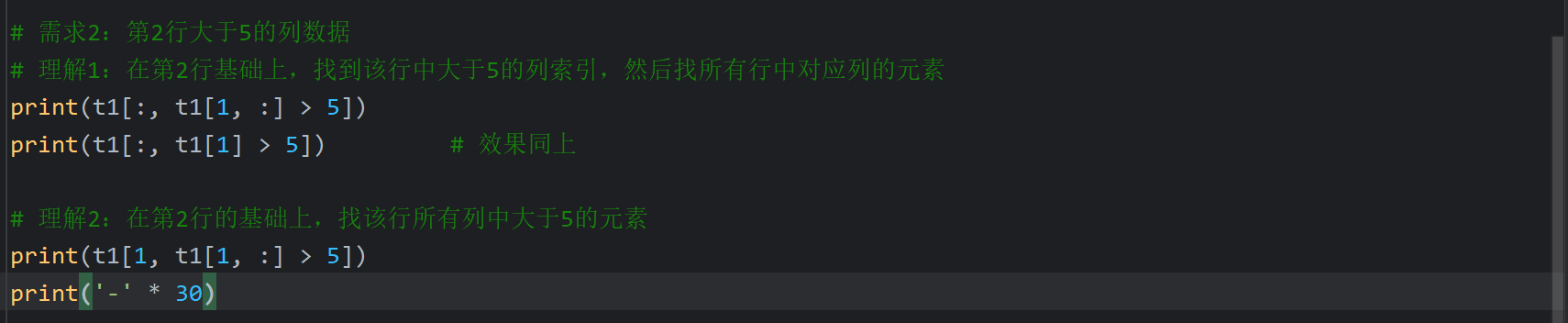

7、张量的索引操作(下)

8、上午内容回顾

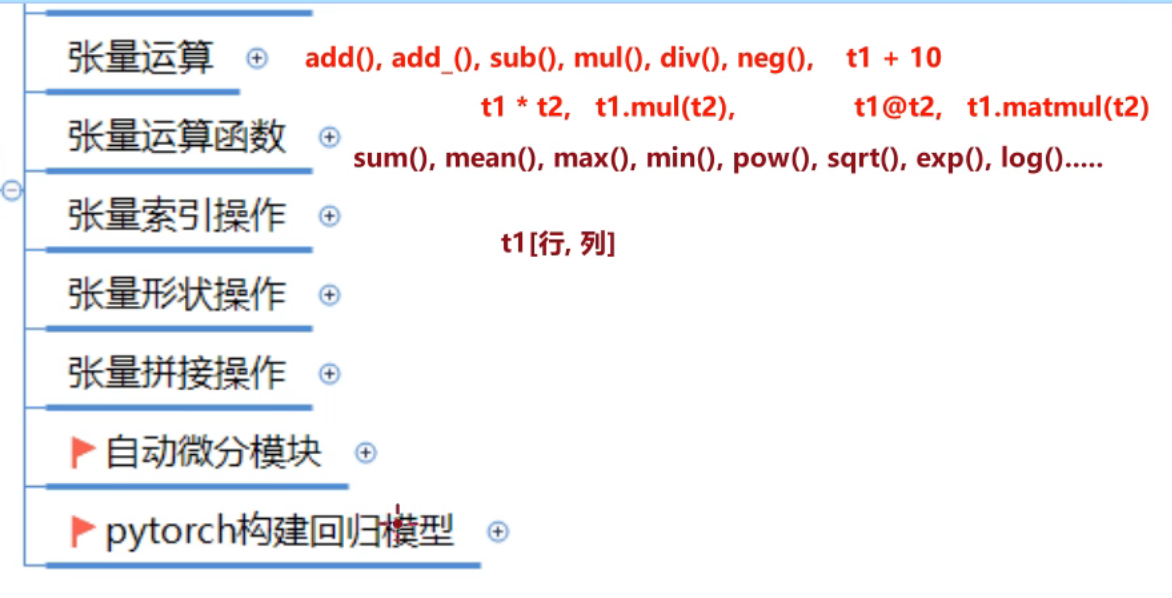

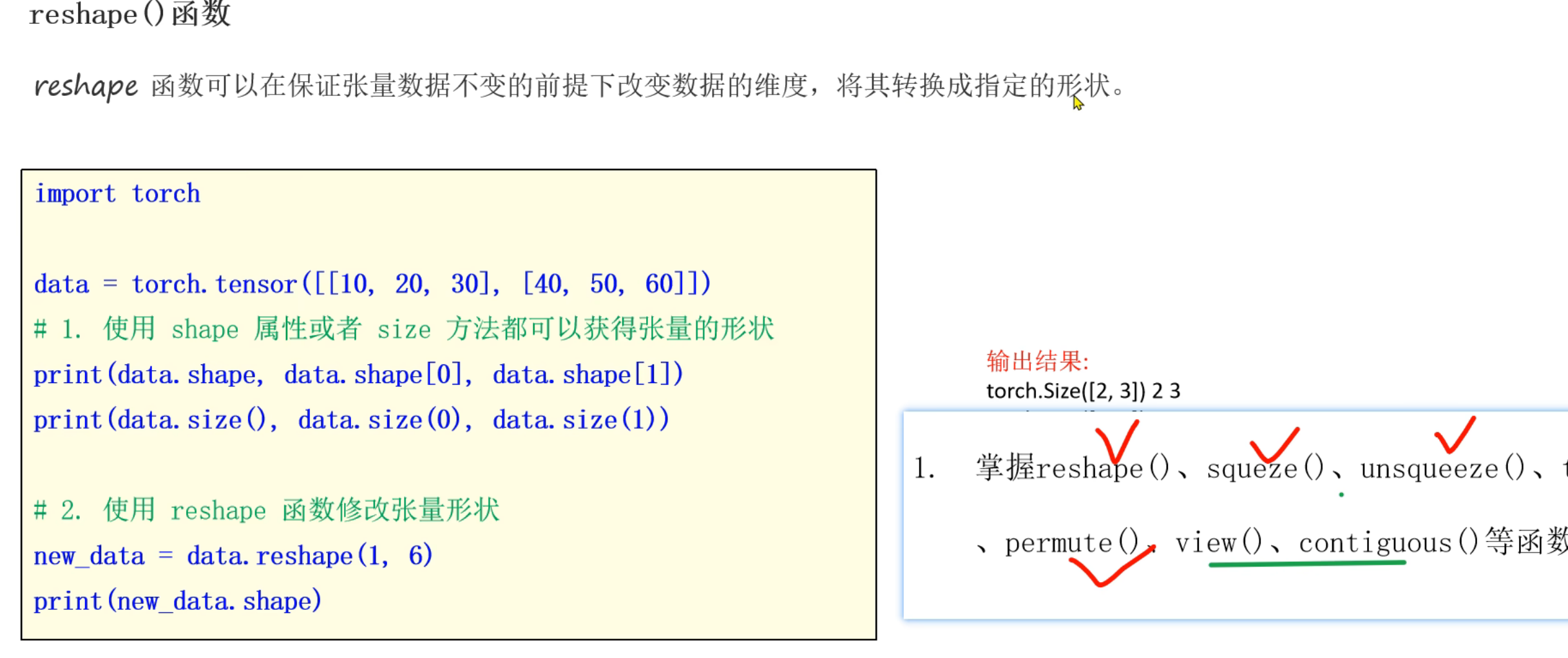

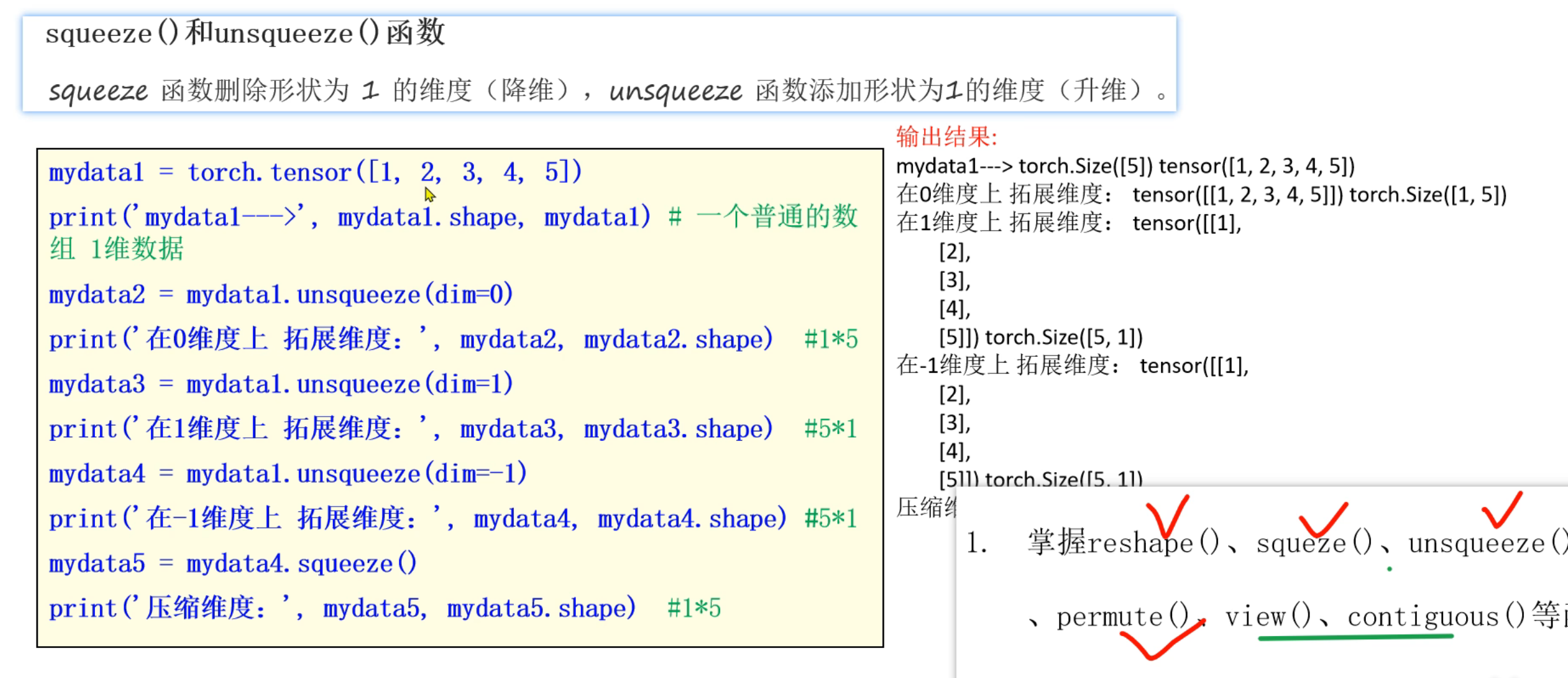

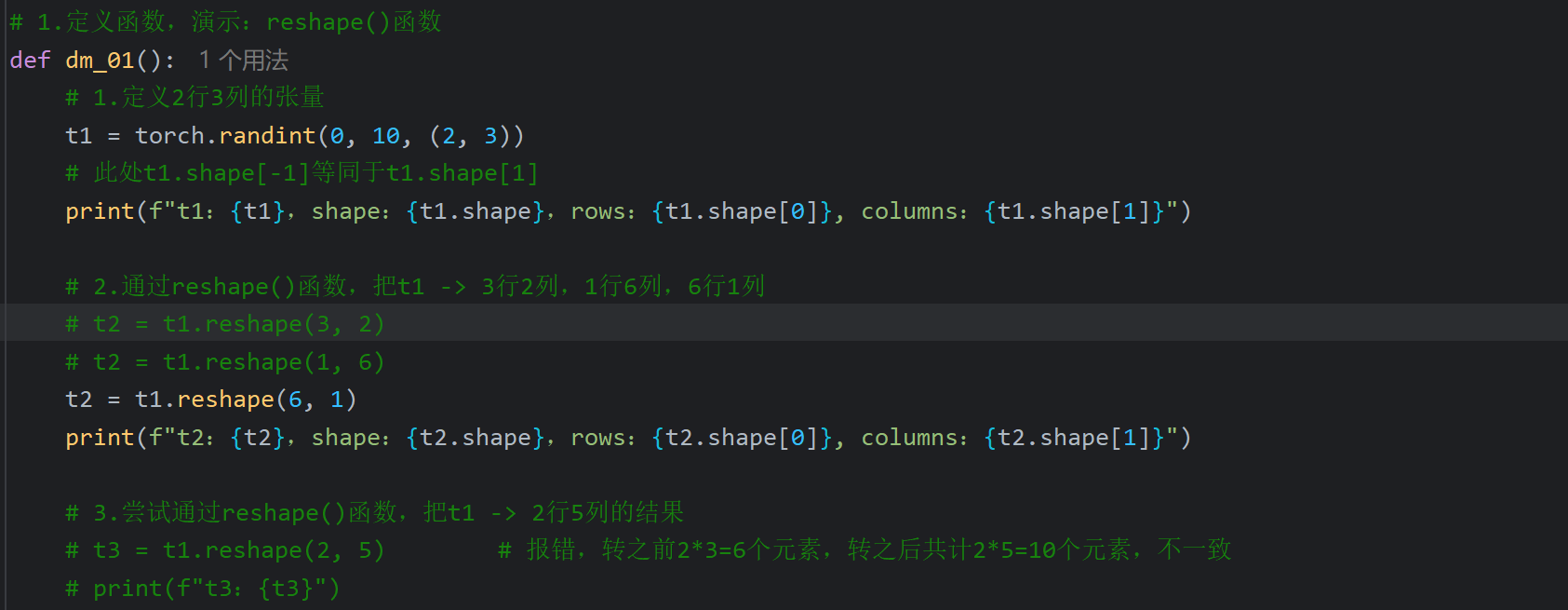

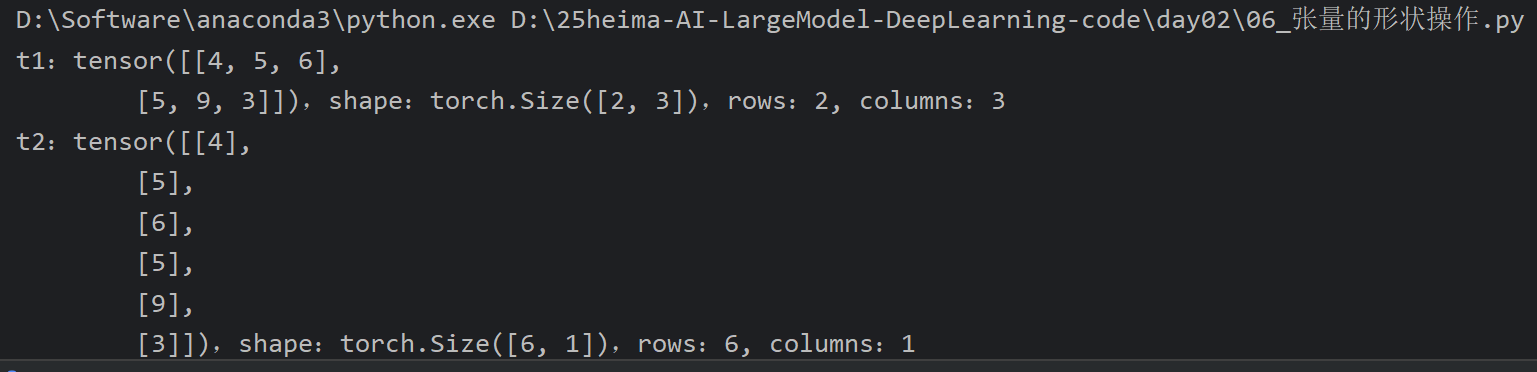

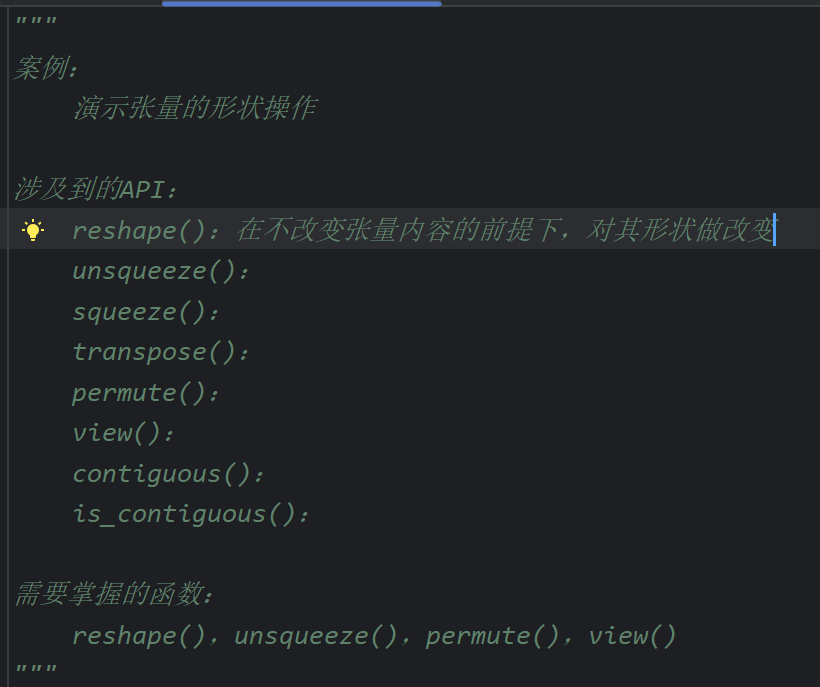

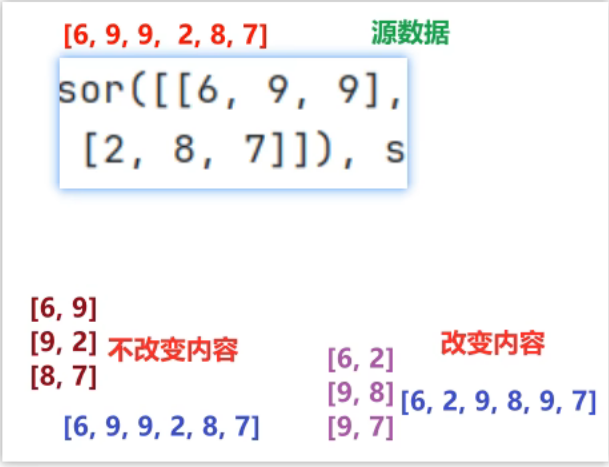

9、张量的形状操作_reshape函数

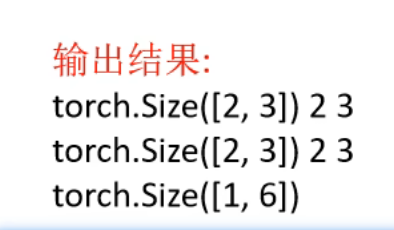

10、张量的形状操作_unsqueeze和squeeze函数

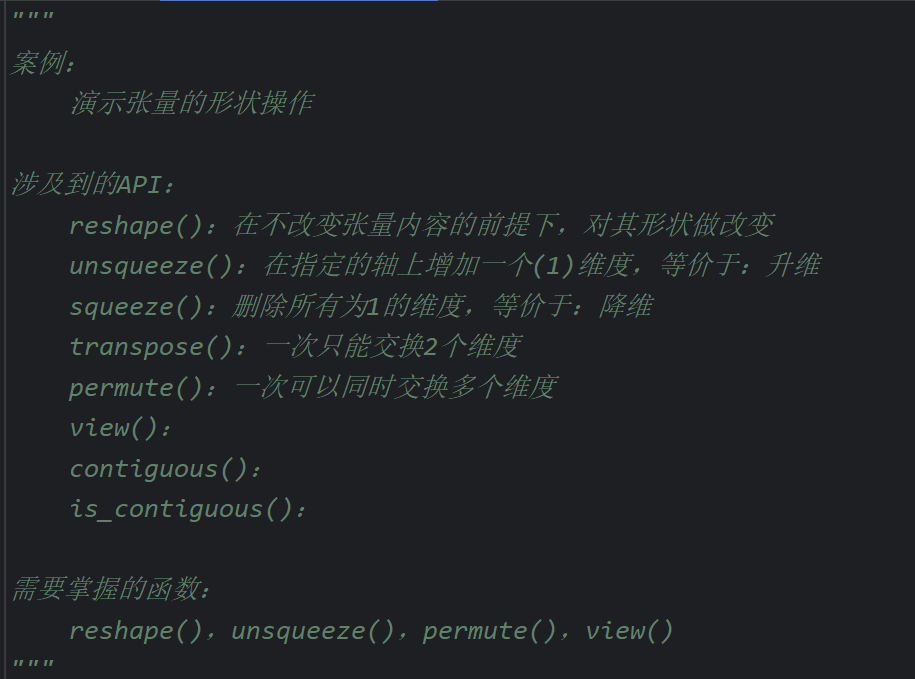

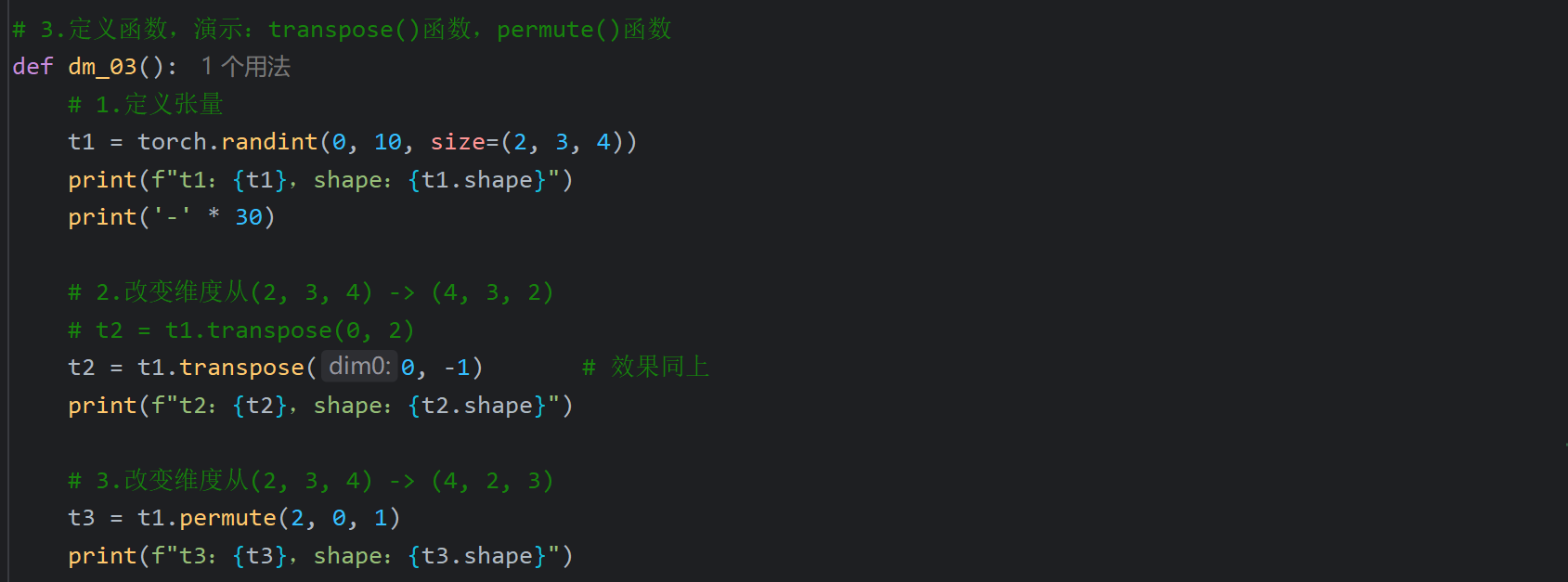

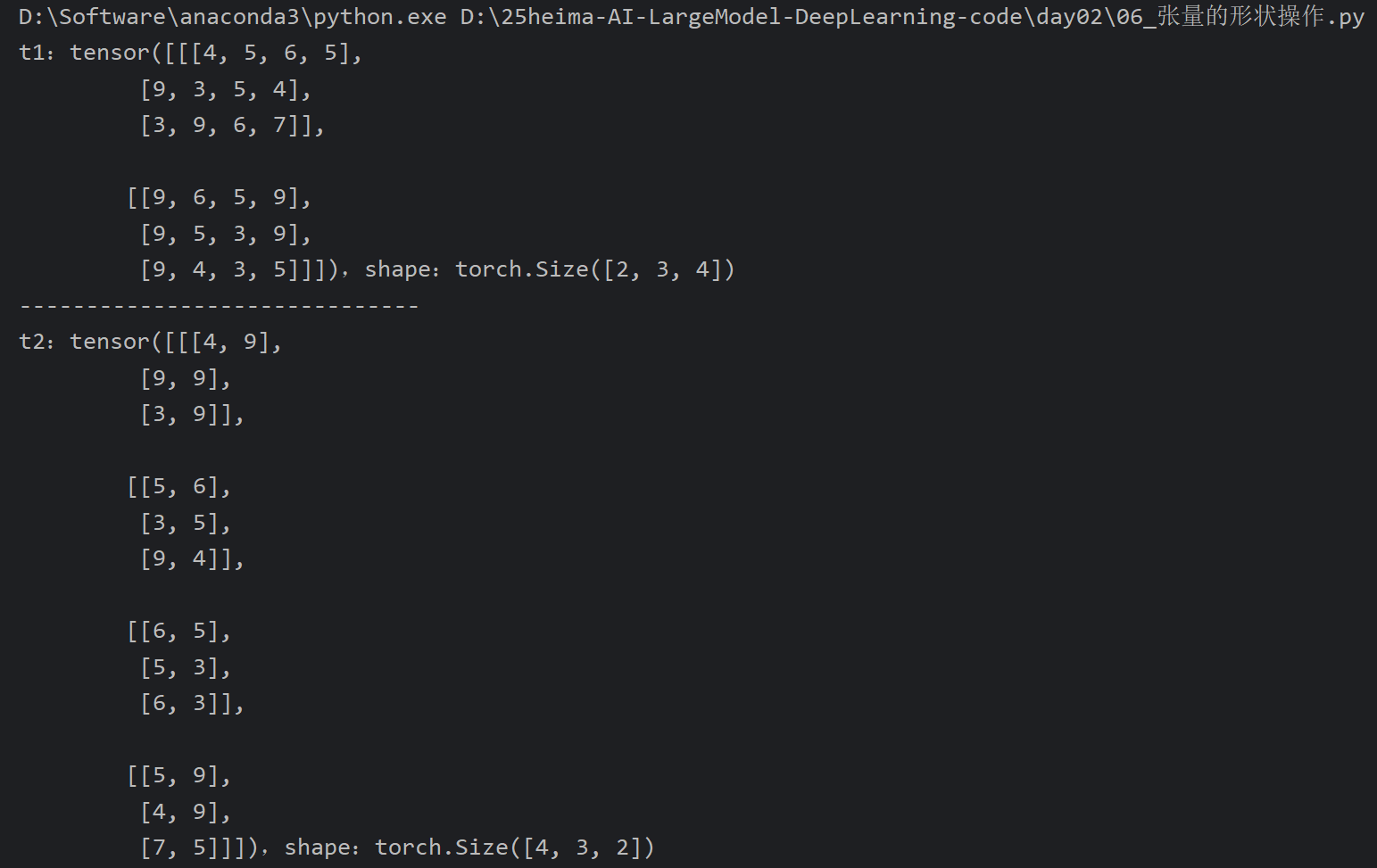

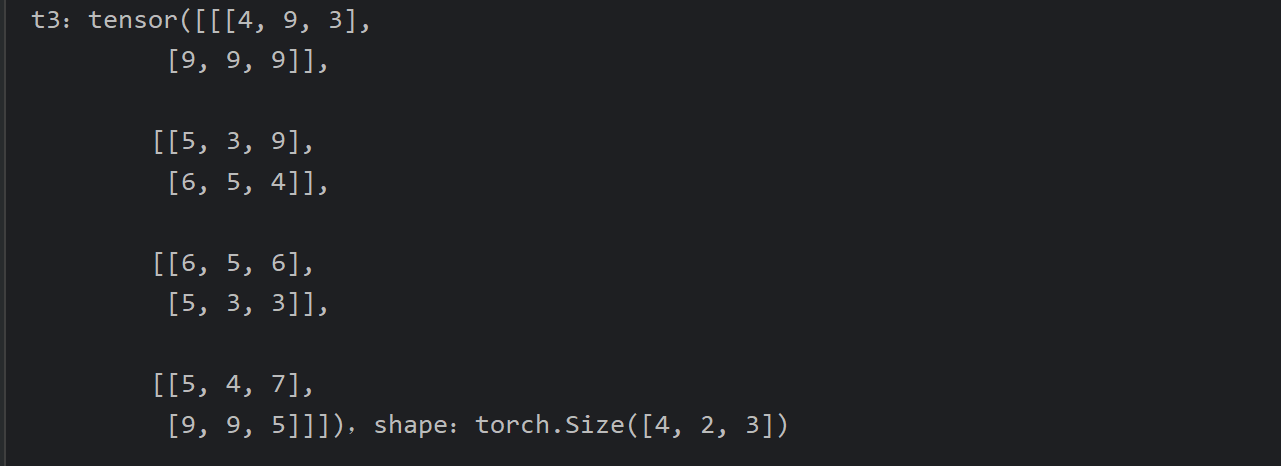

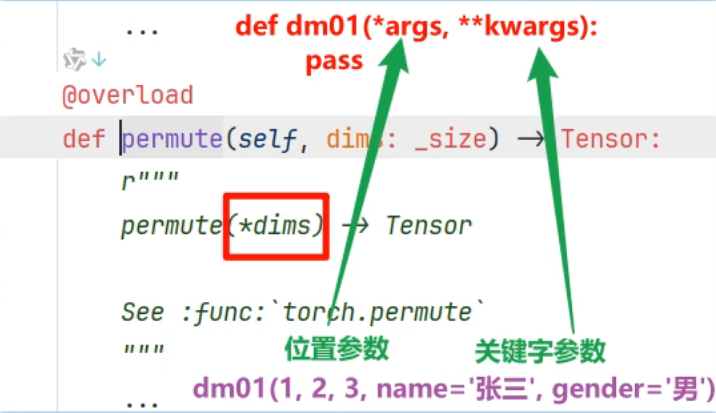

11、张量的形状操作_transpose和premute函数

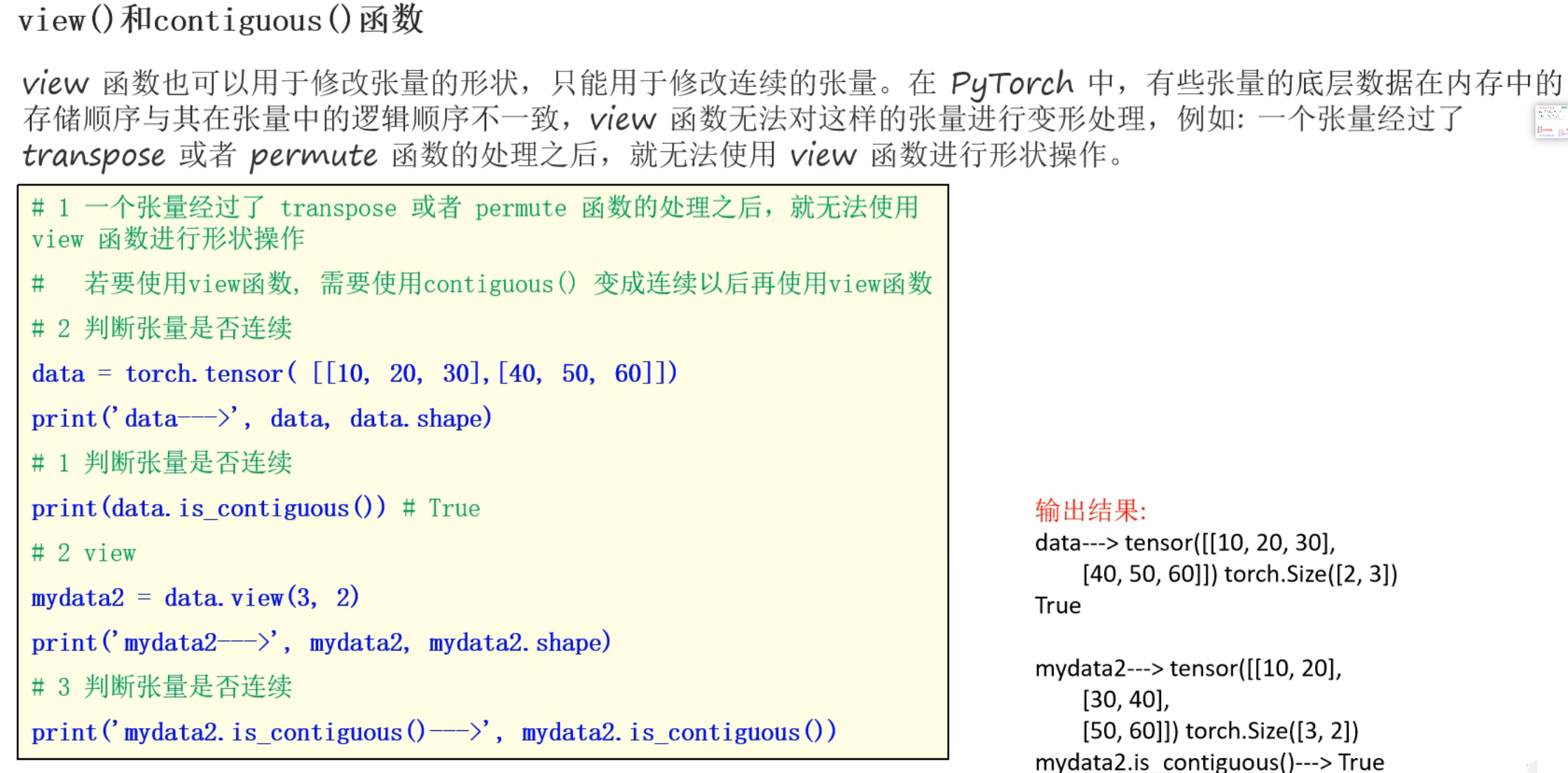

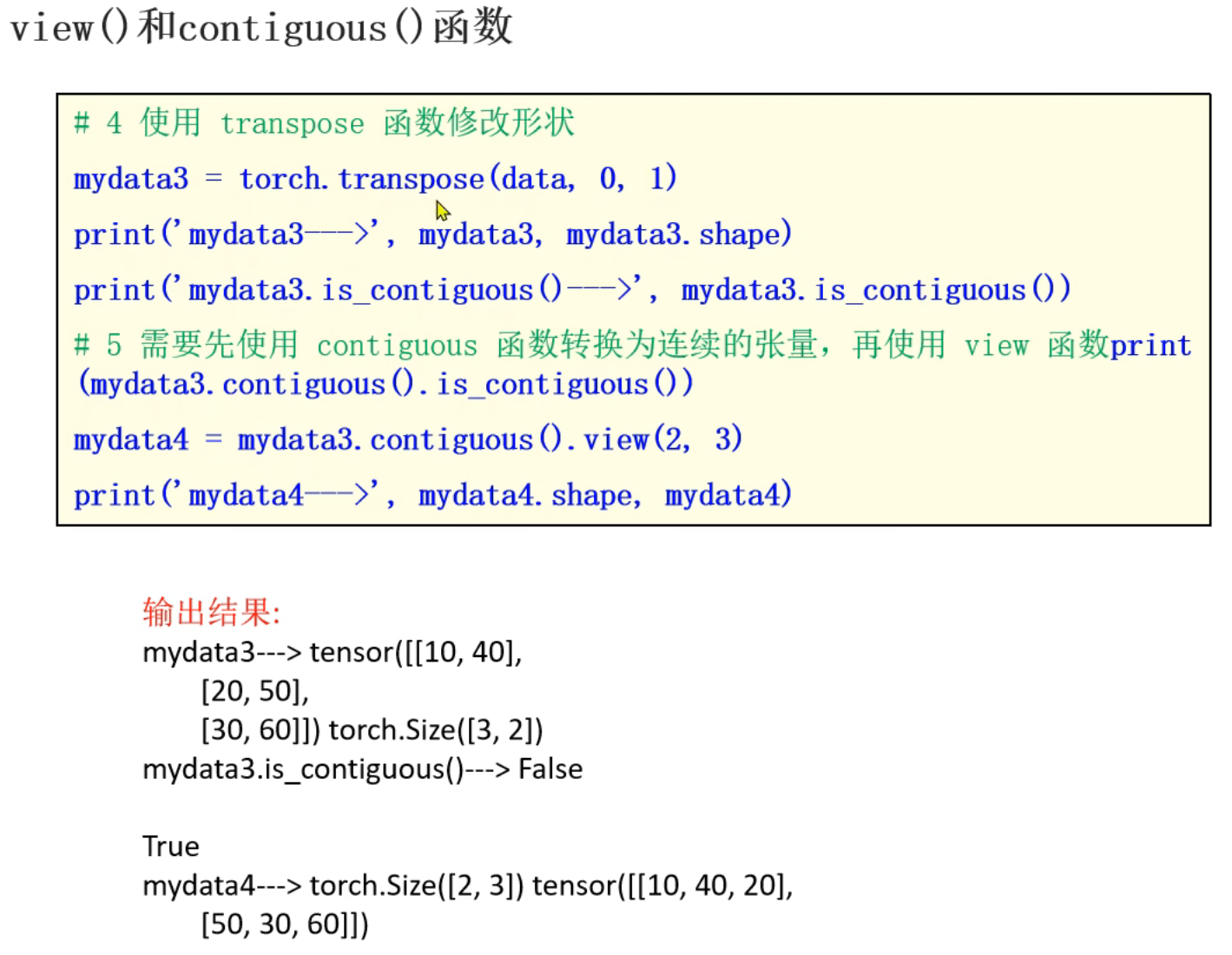

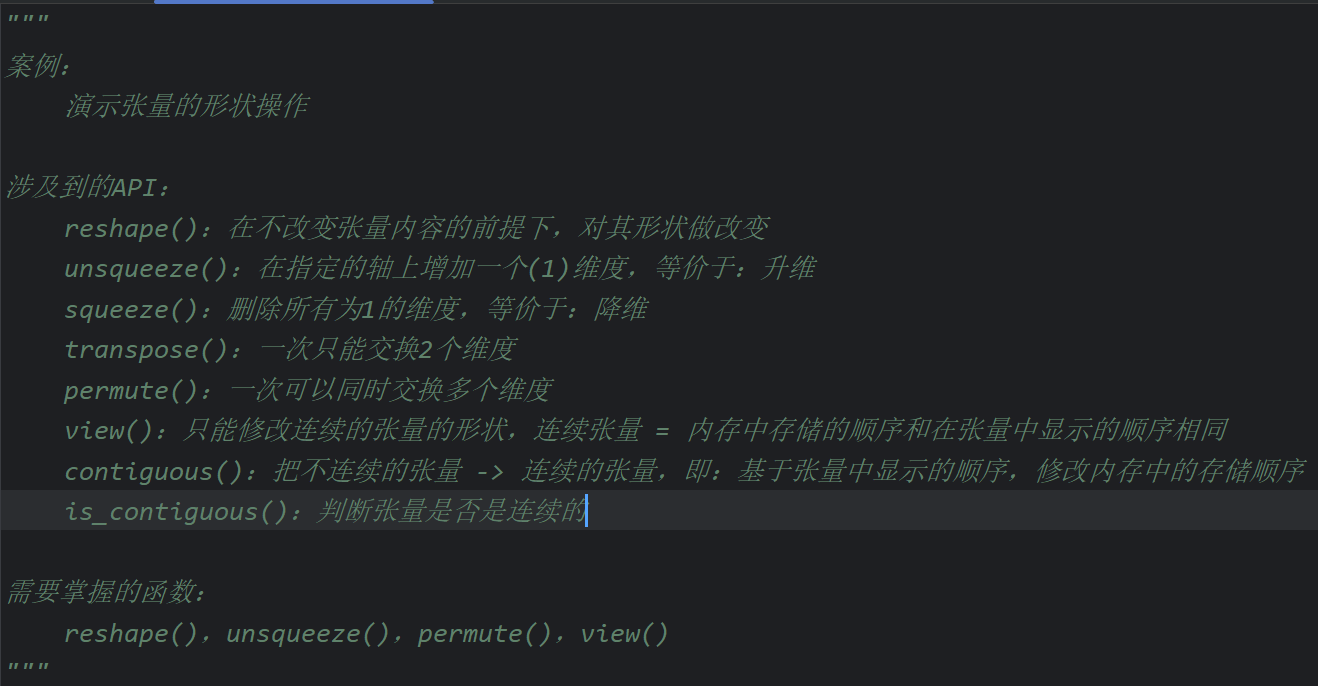

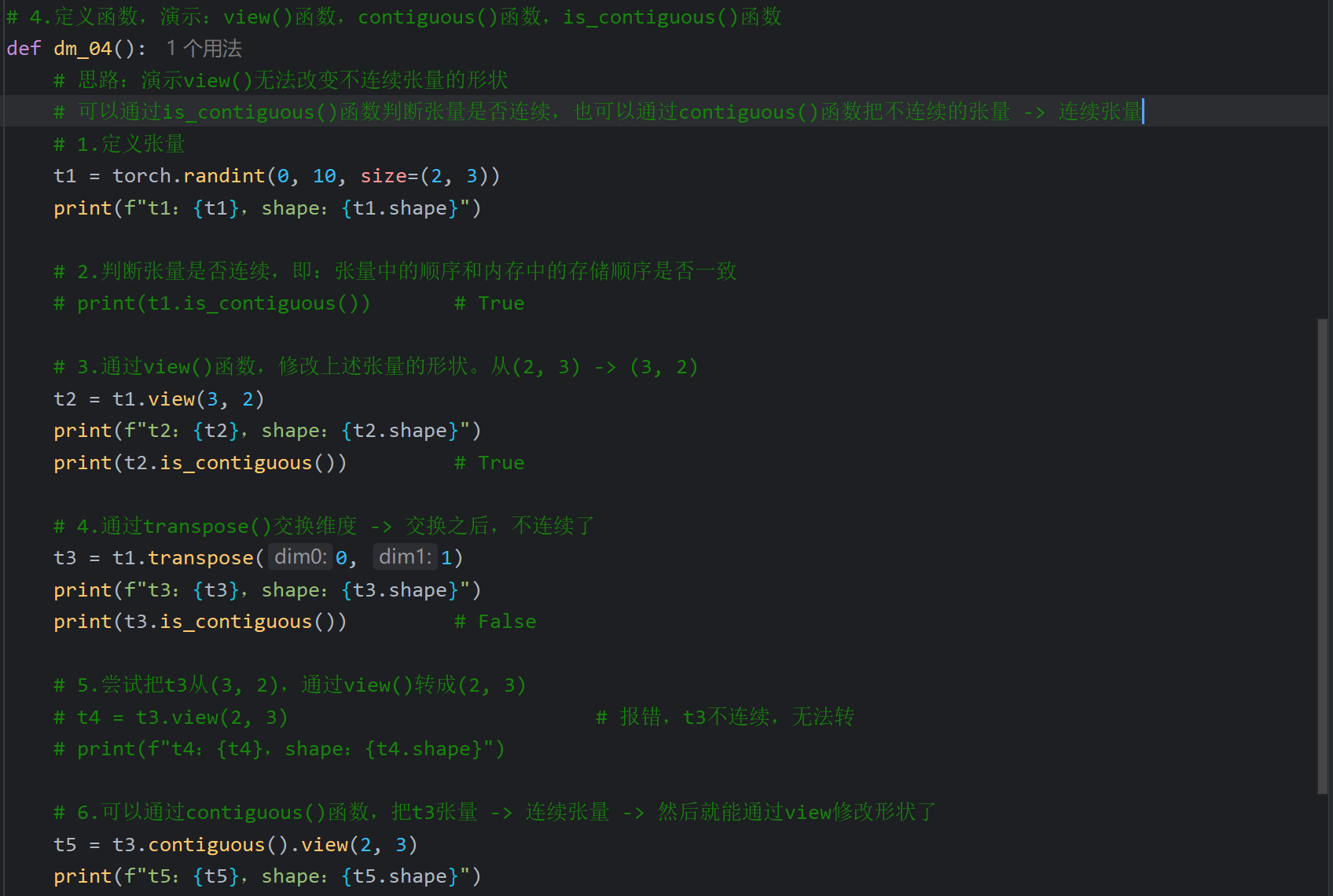

12、张量的形状操作_view和contiguous函数

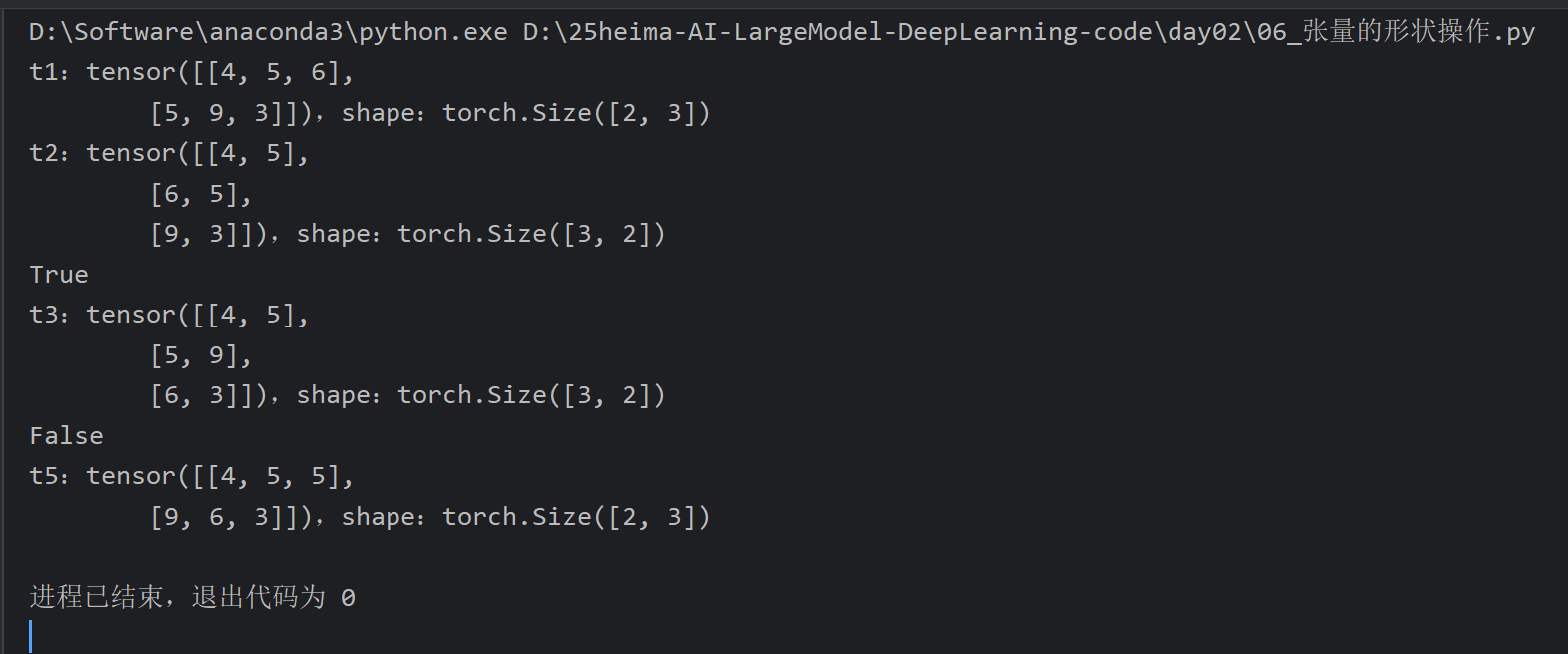

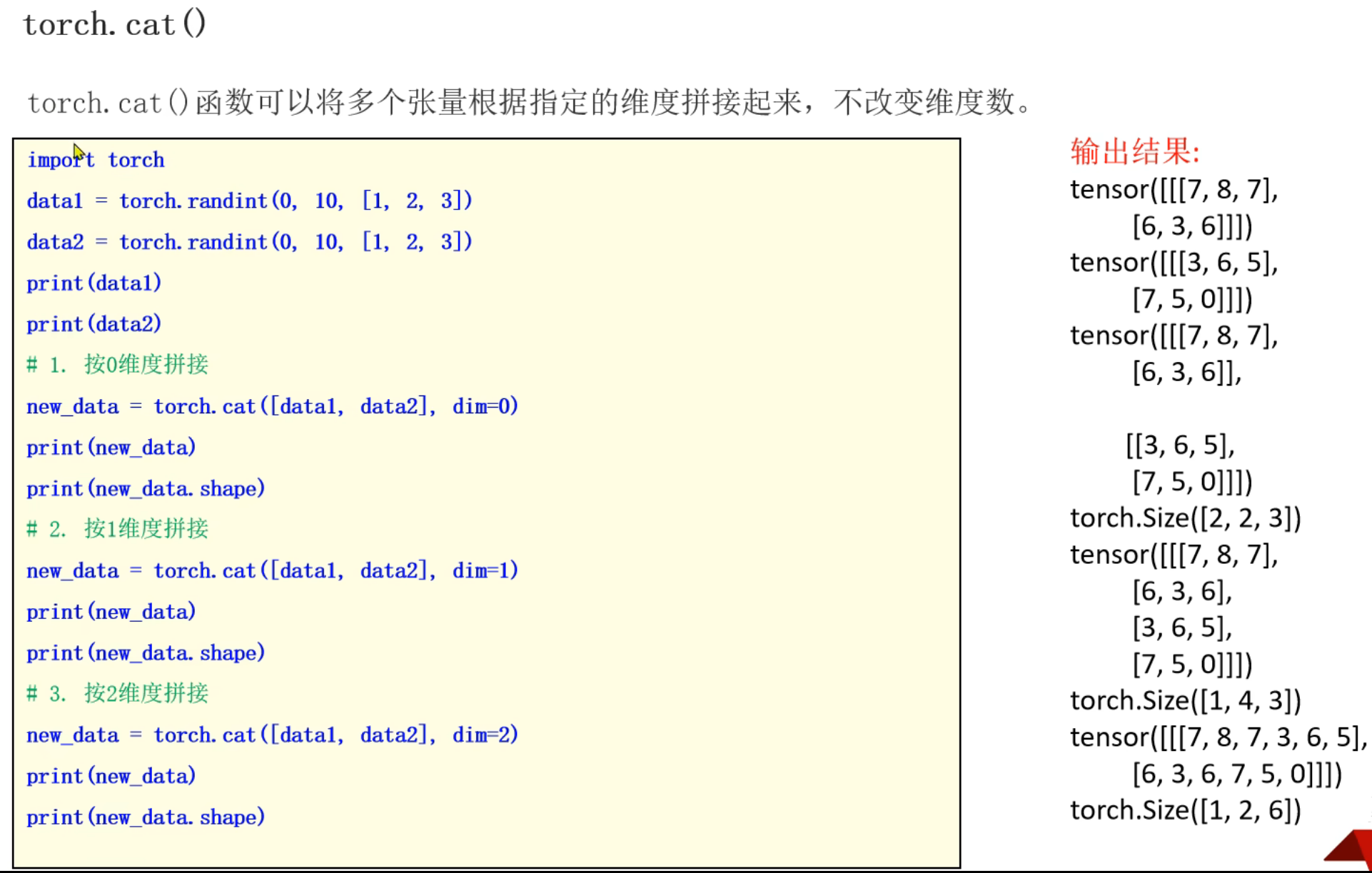

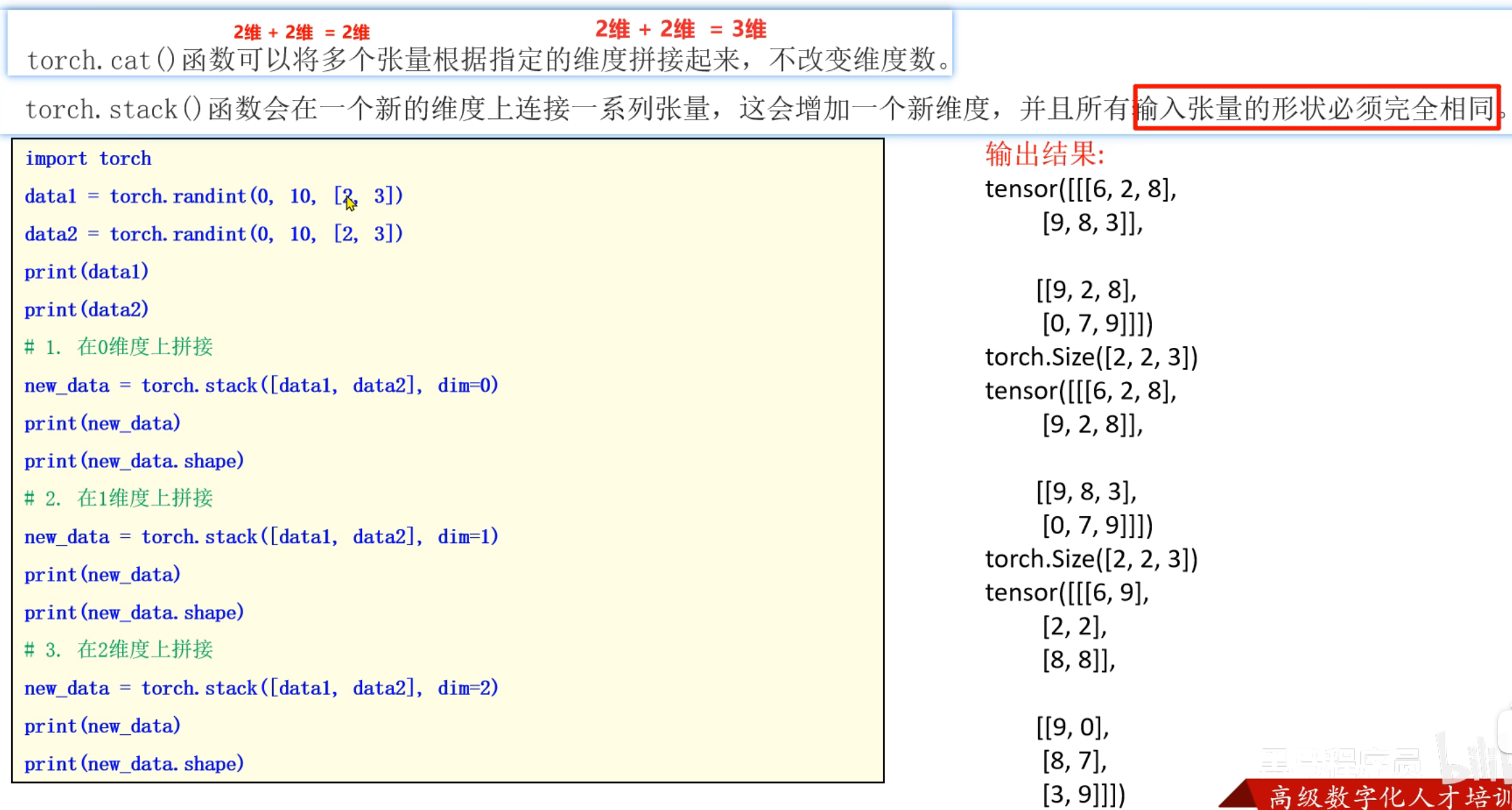

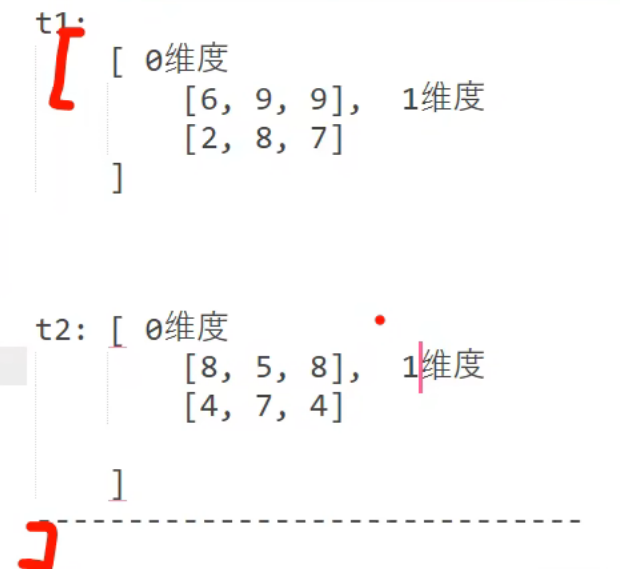

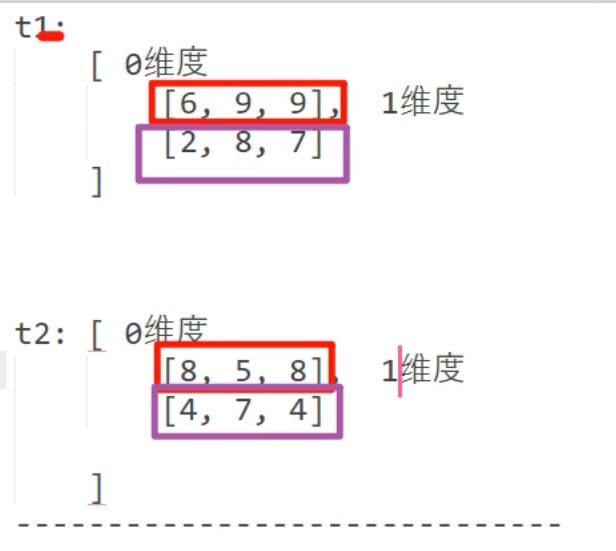

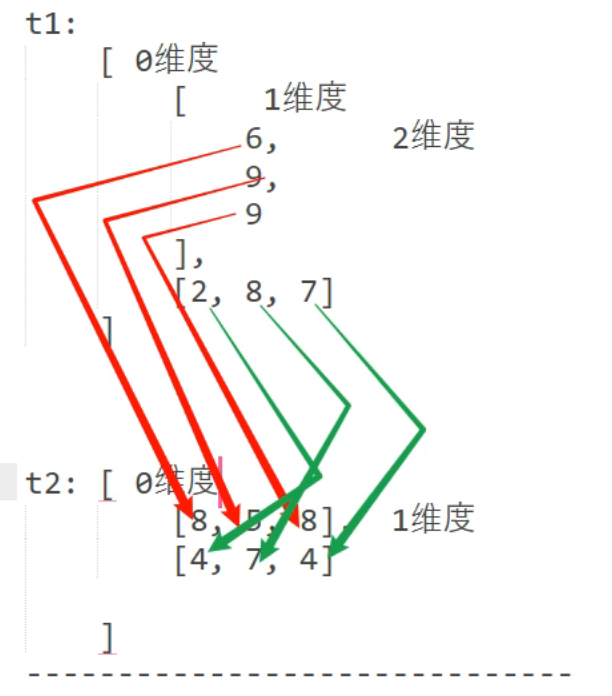

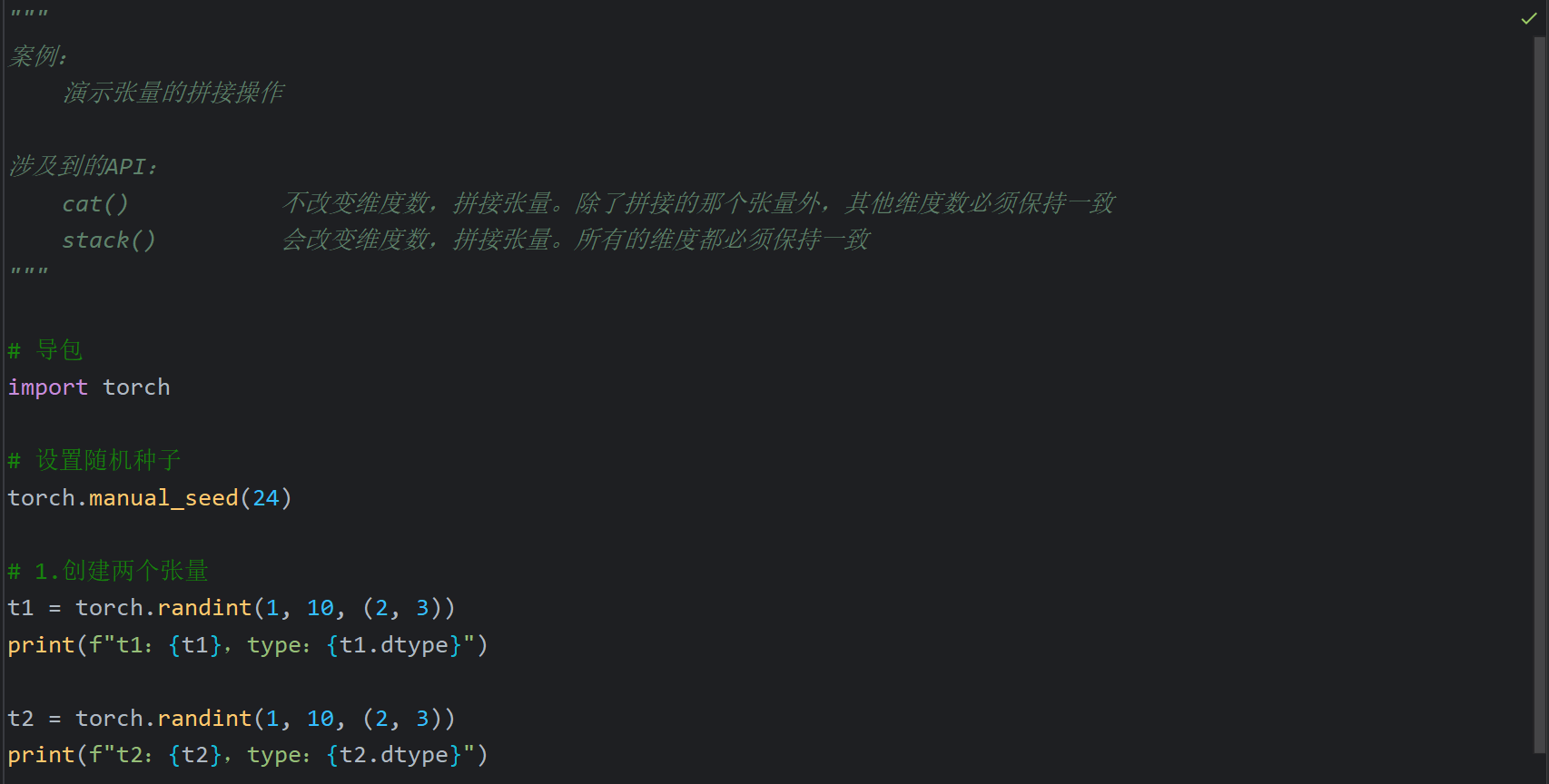

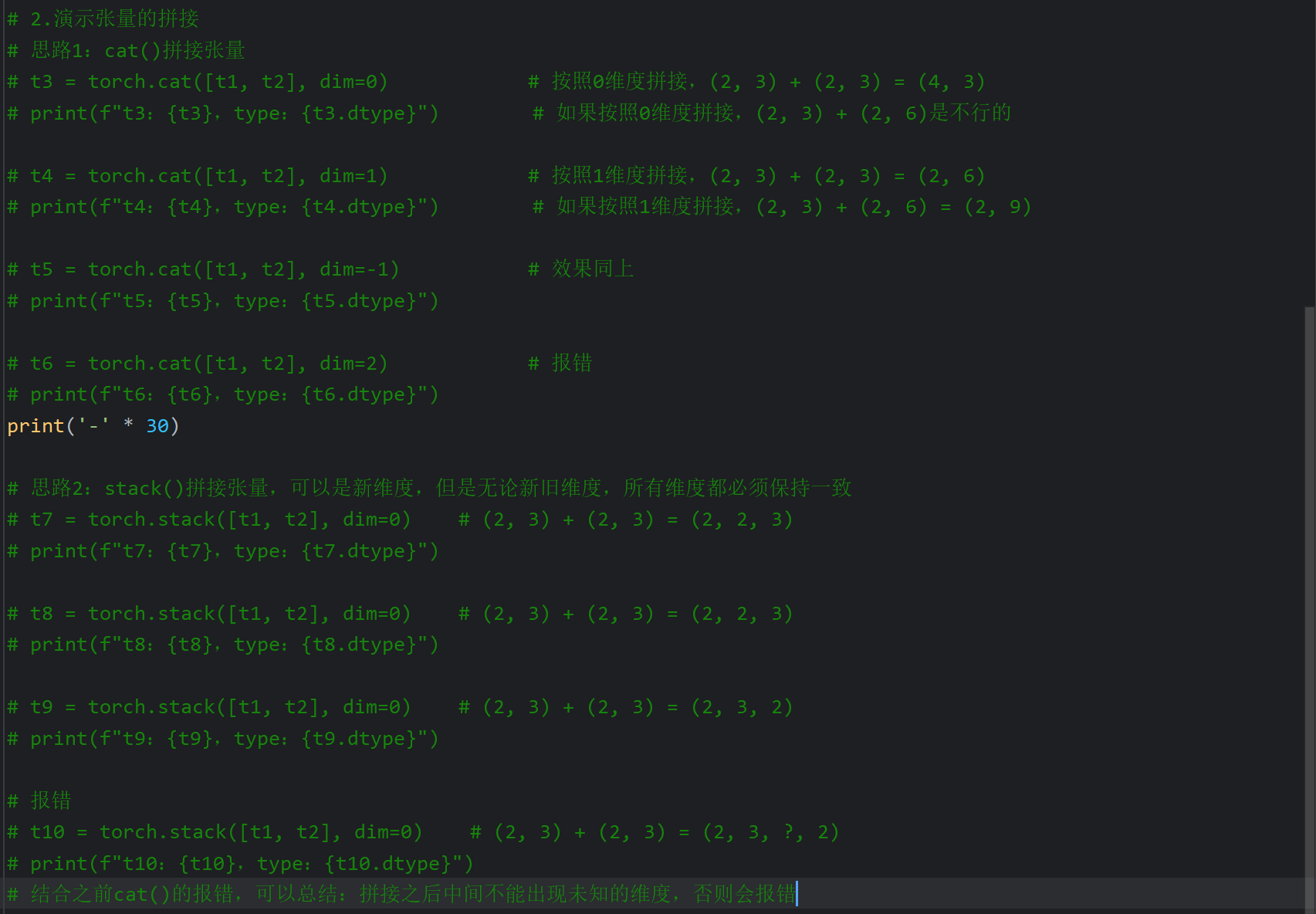

13、张量的拼接操作

stack()按照0维度拼接

stack()按照1维度拼接

stack()按照2维度拼接

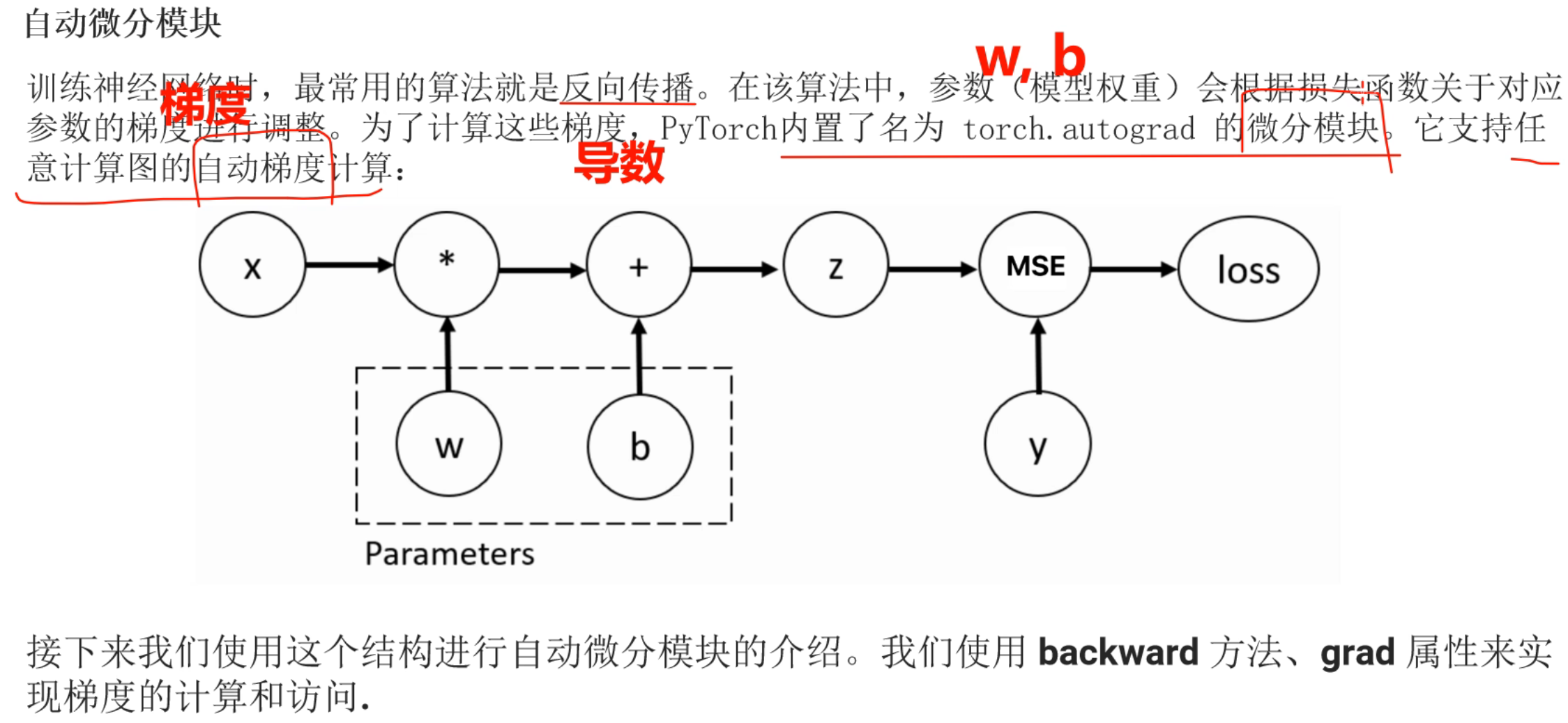

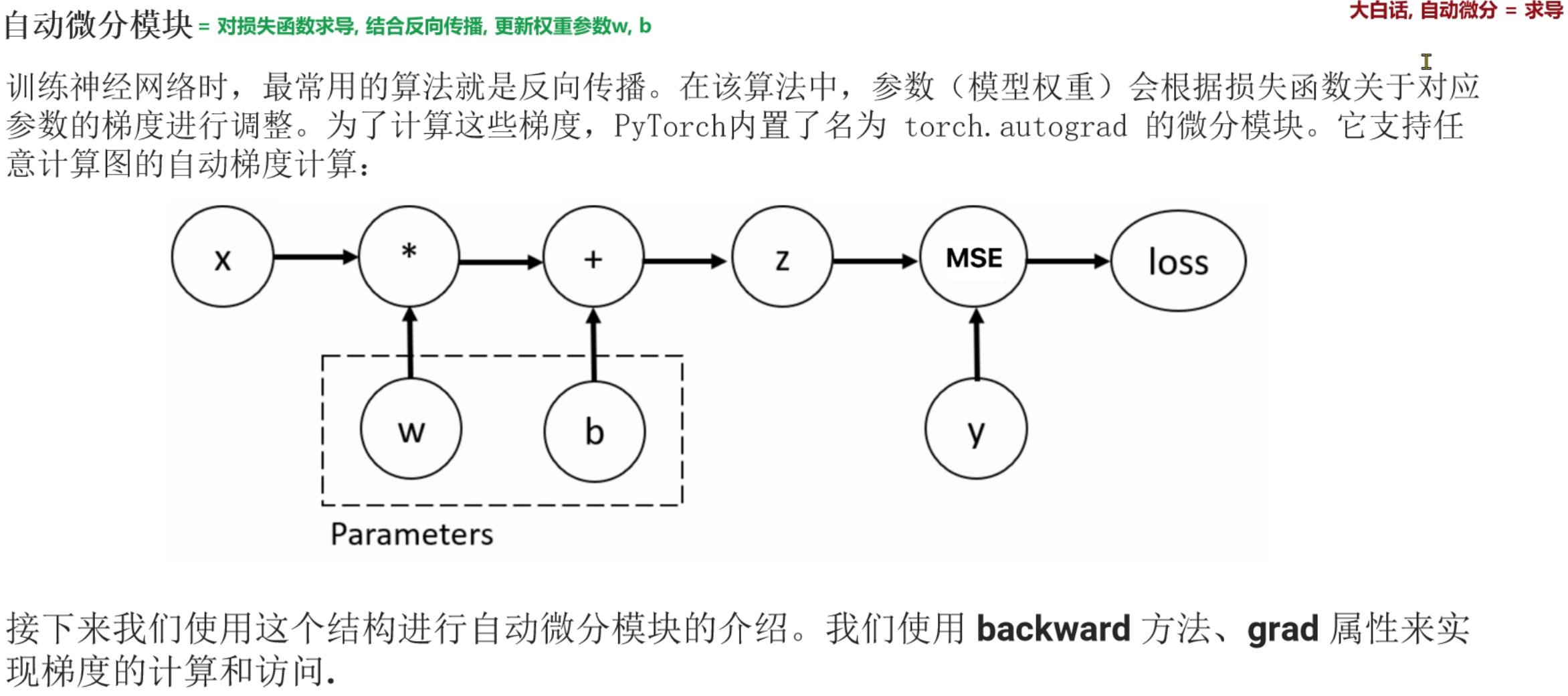

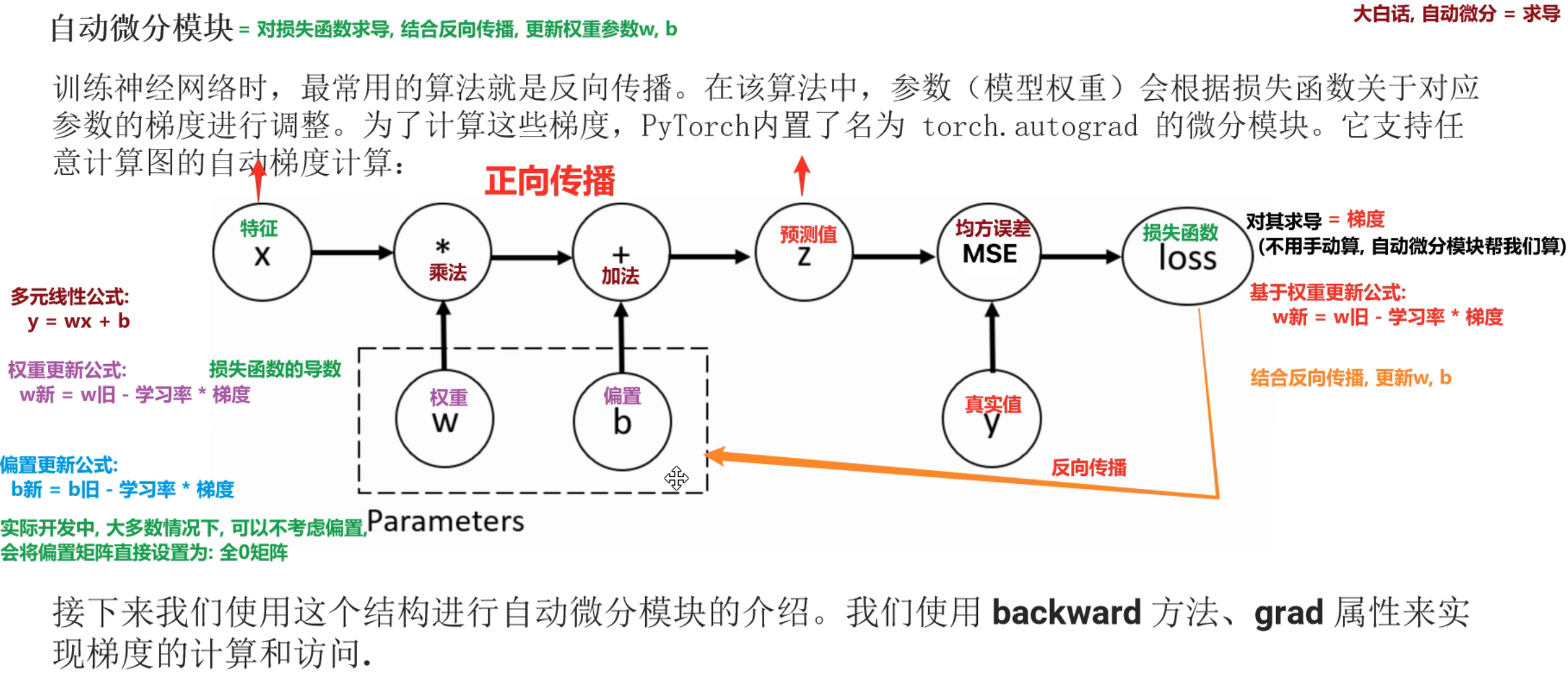

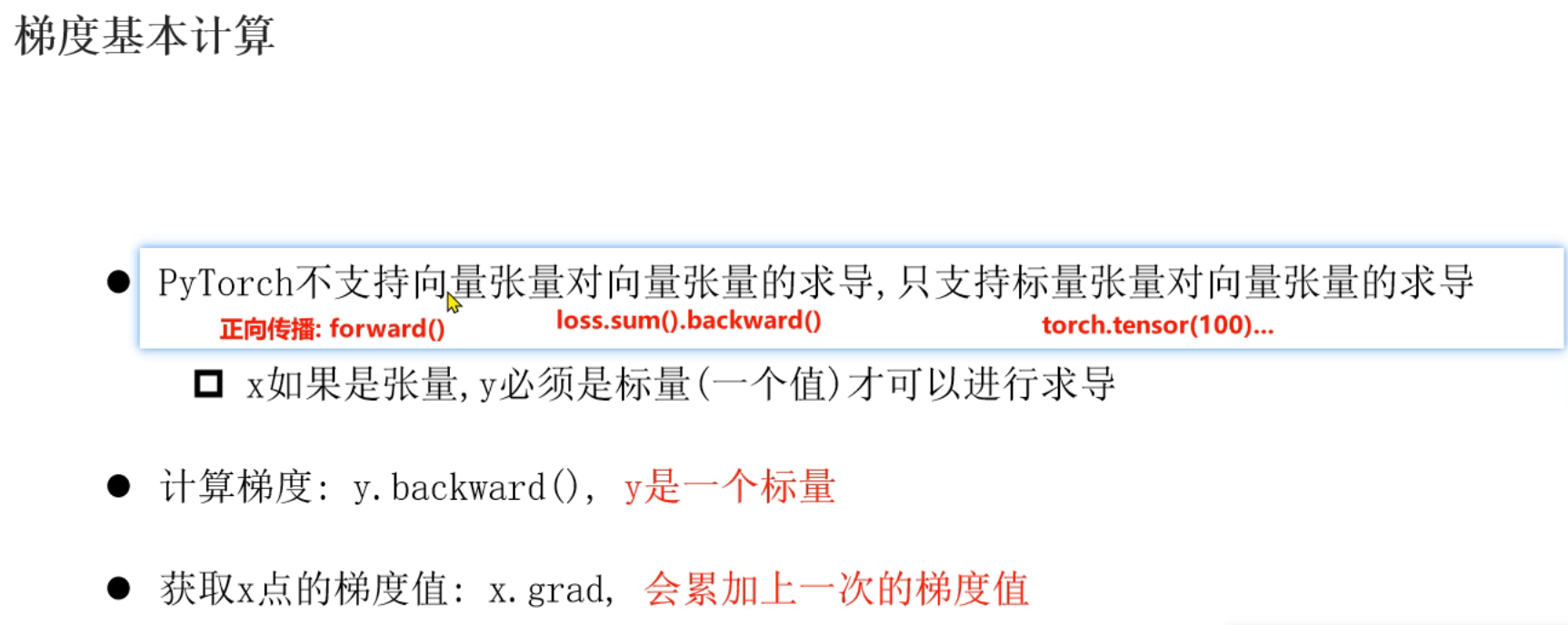

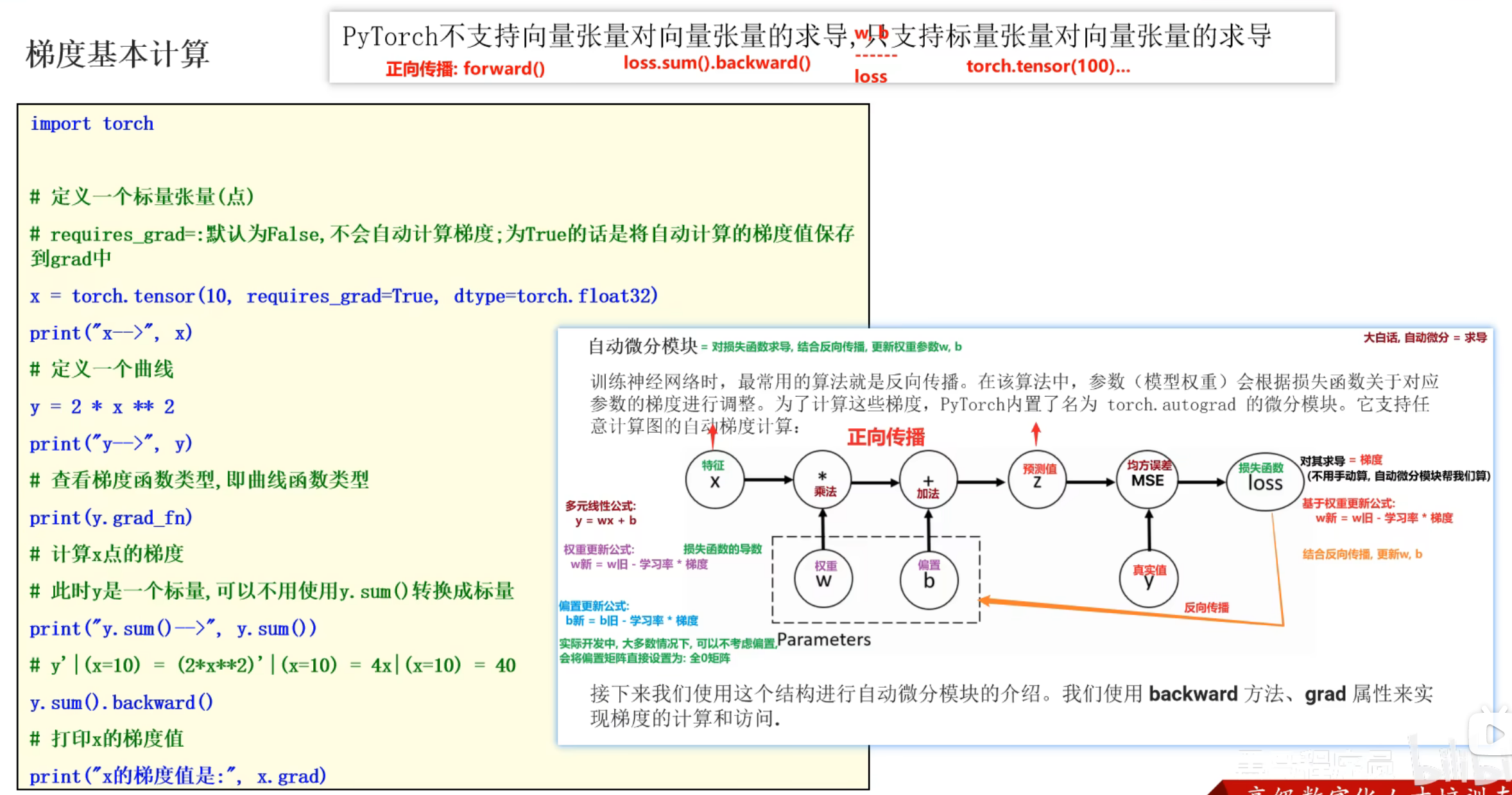

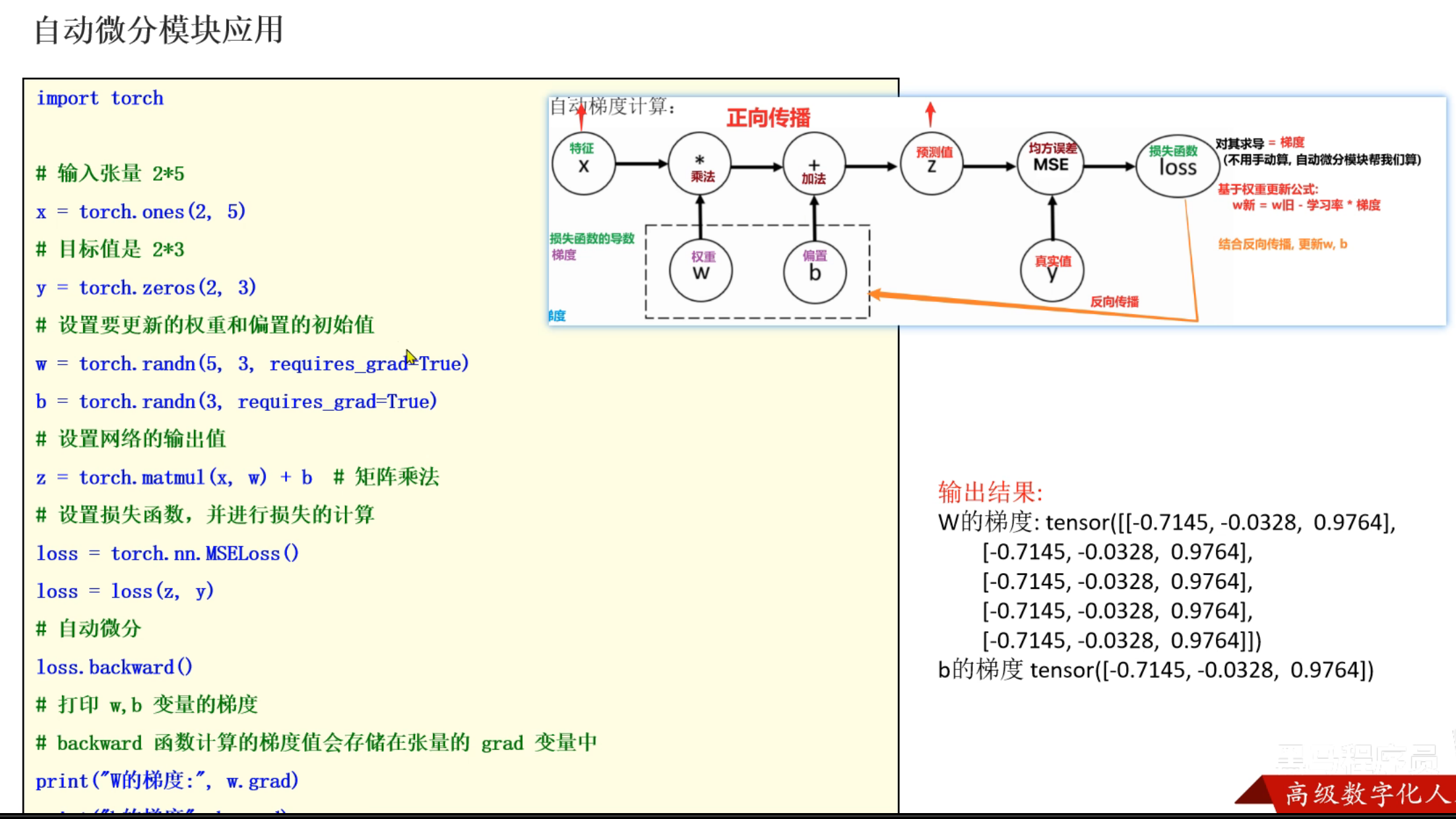

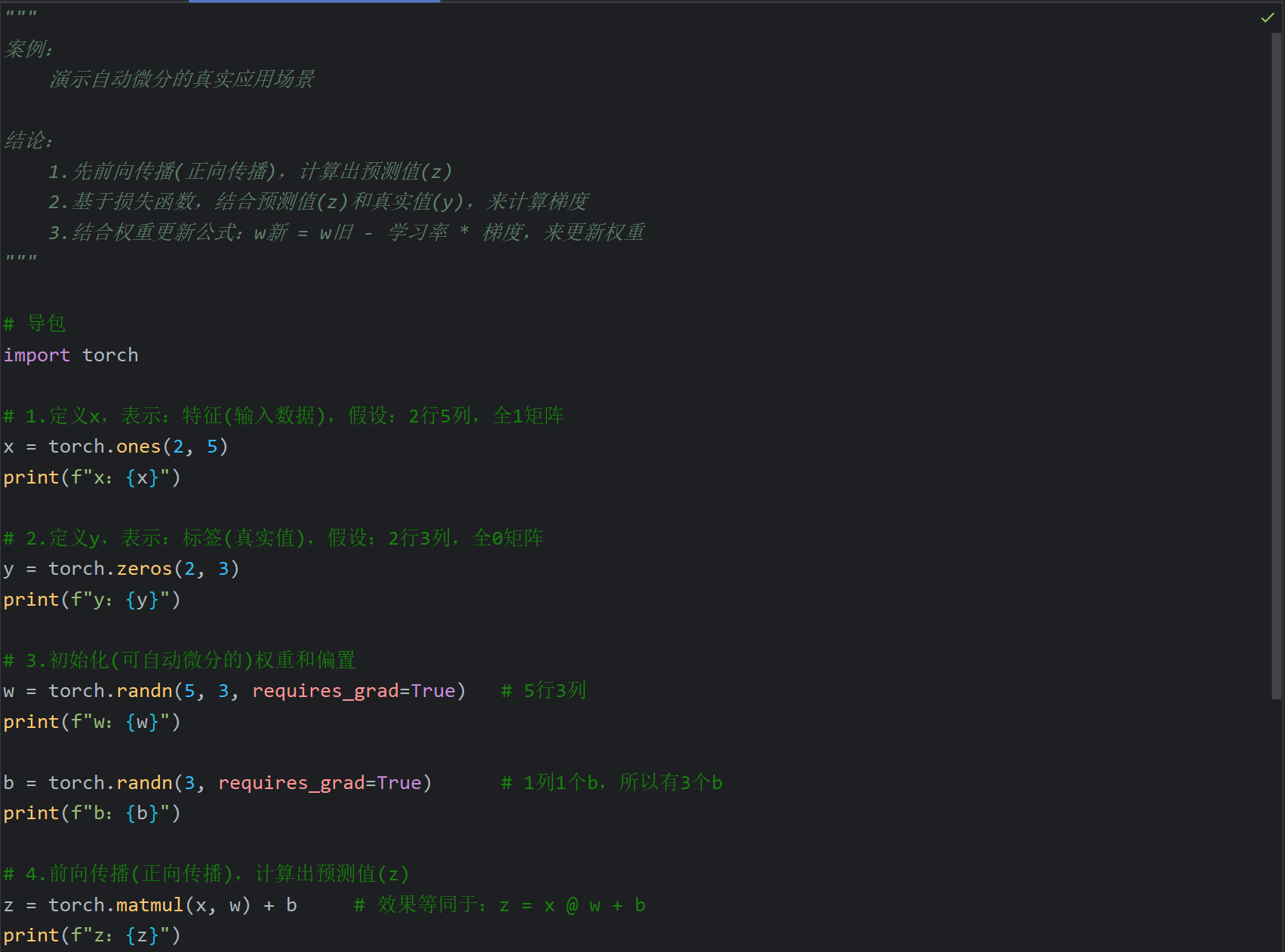

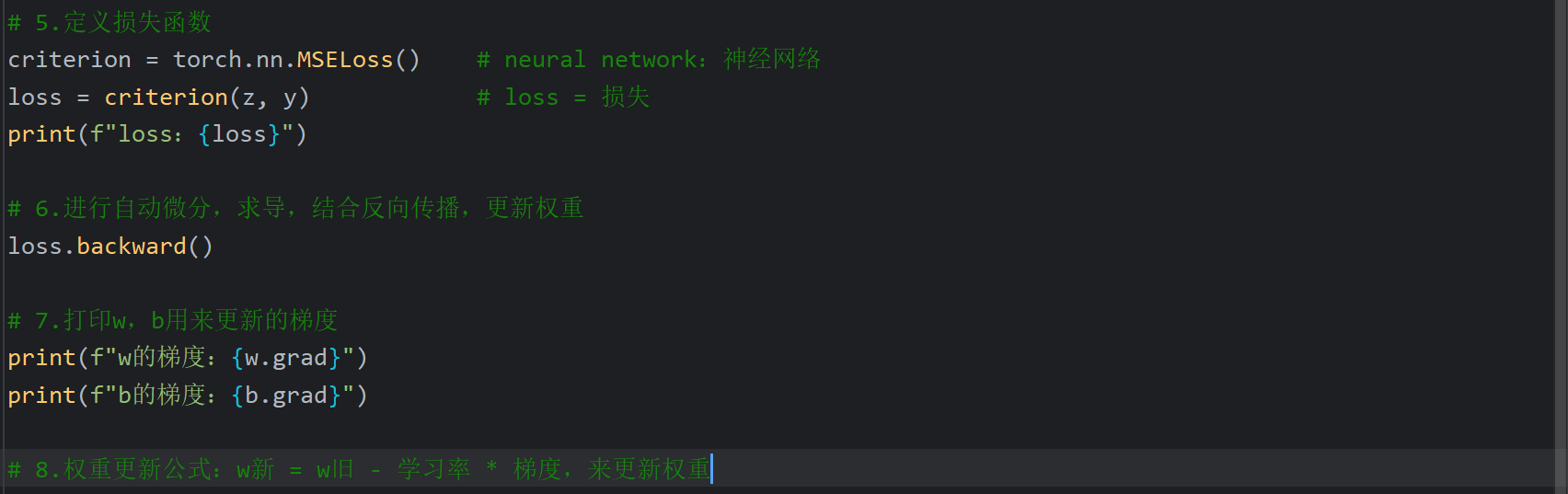

14、自动微分模块_介绍

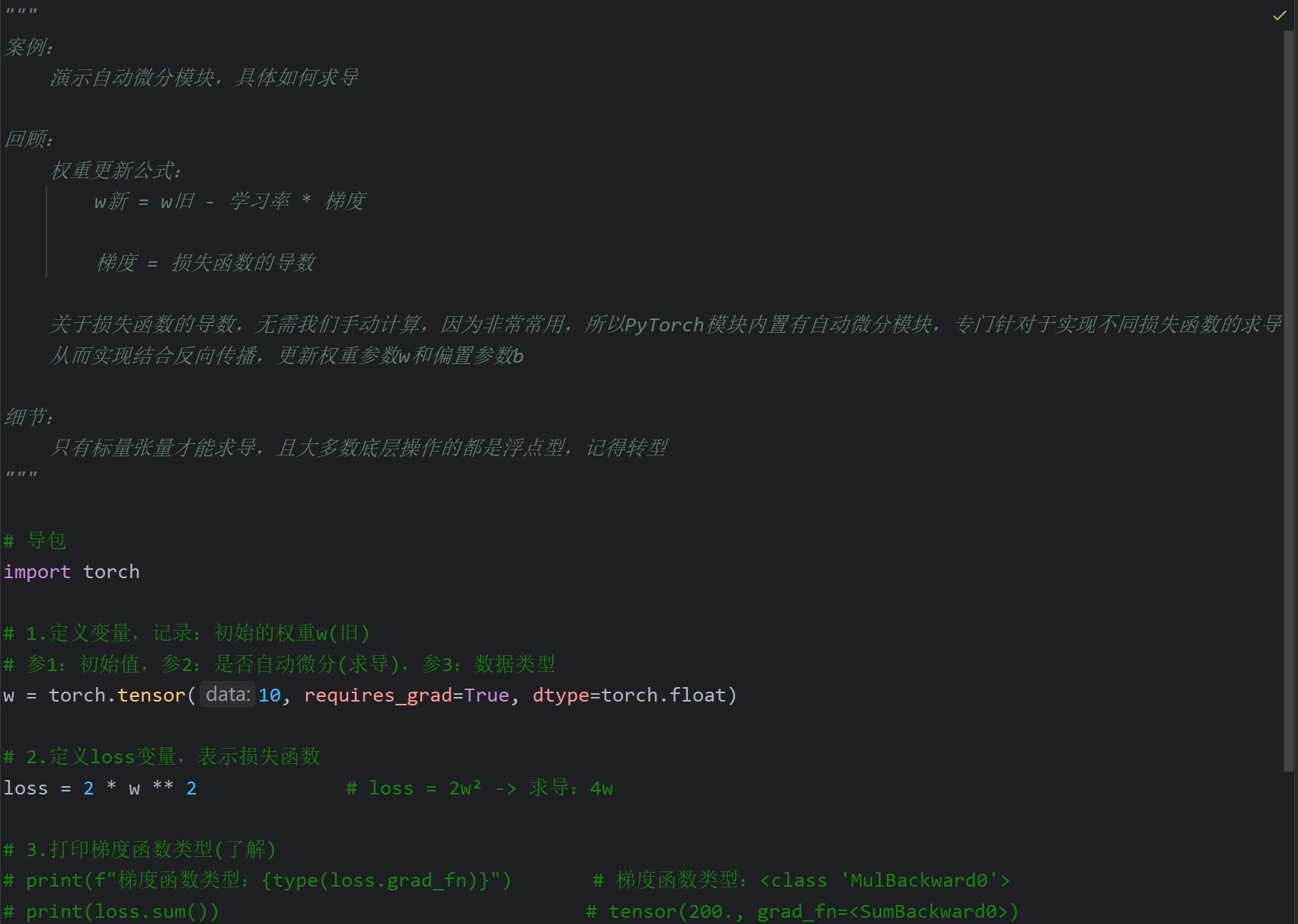

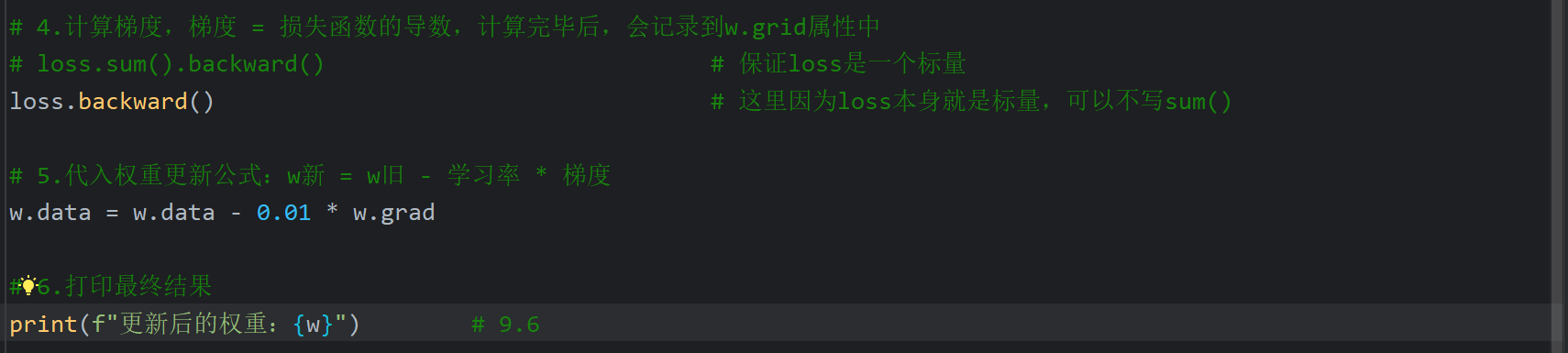

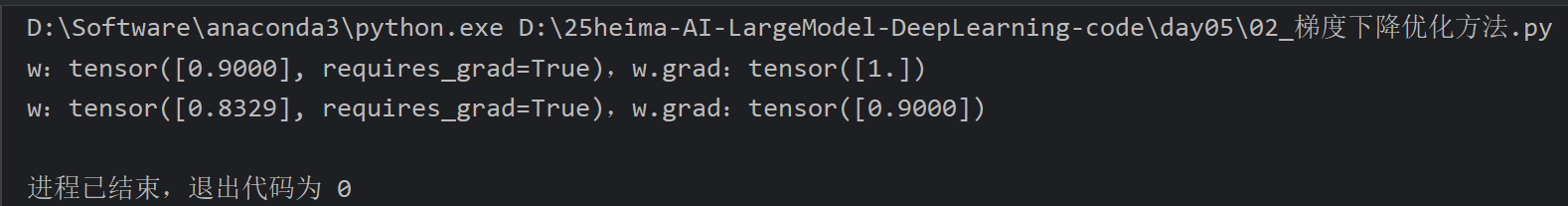

15、自动微分模块案例_更新一次参数

ppt中代码的x指的是权重w,y指的是损失函数loss,等下自己写代码会改一下字母

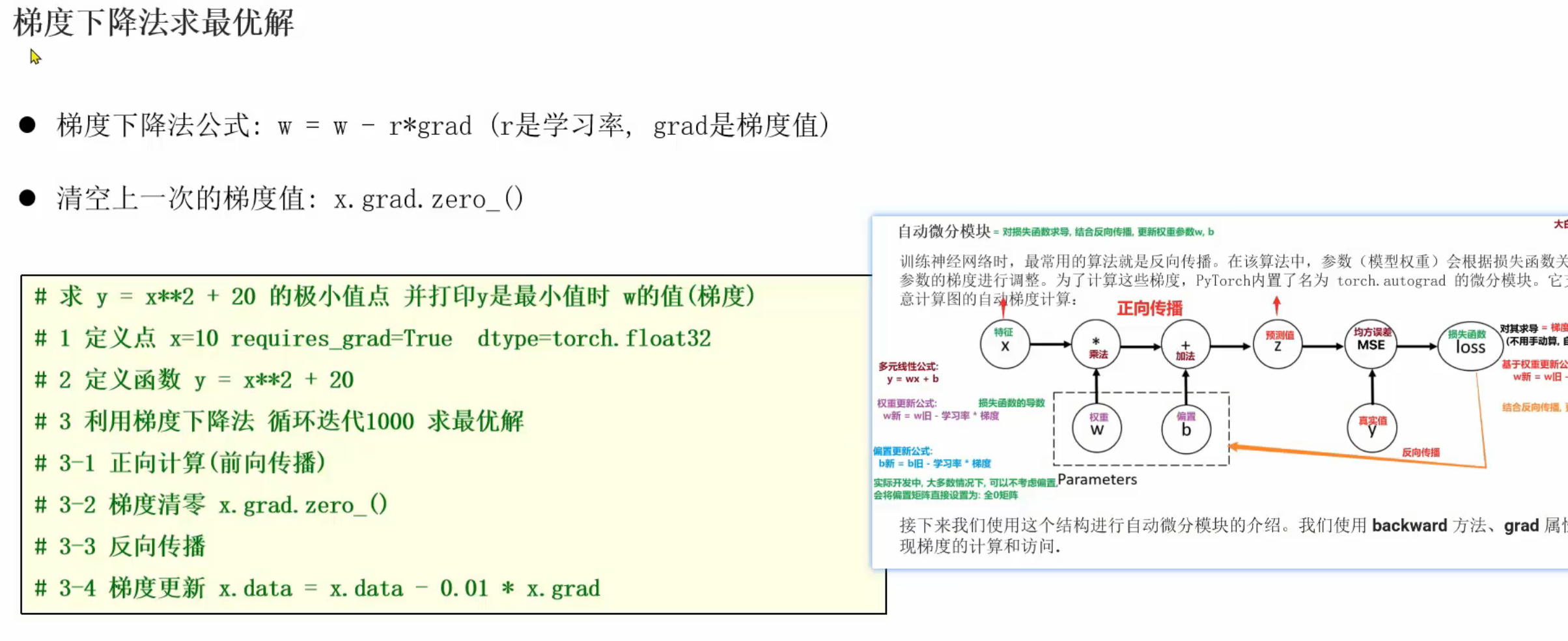

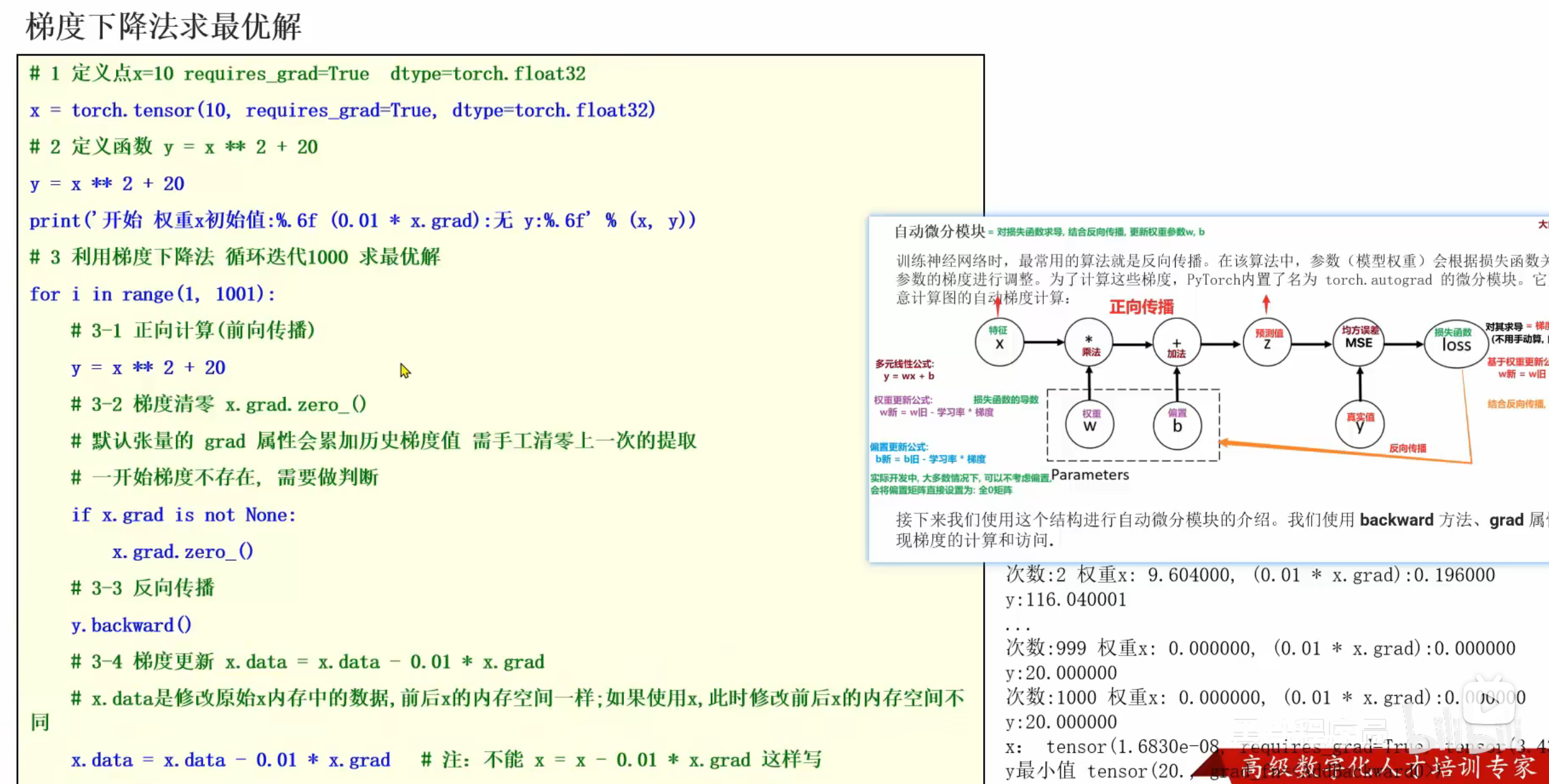

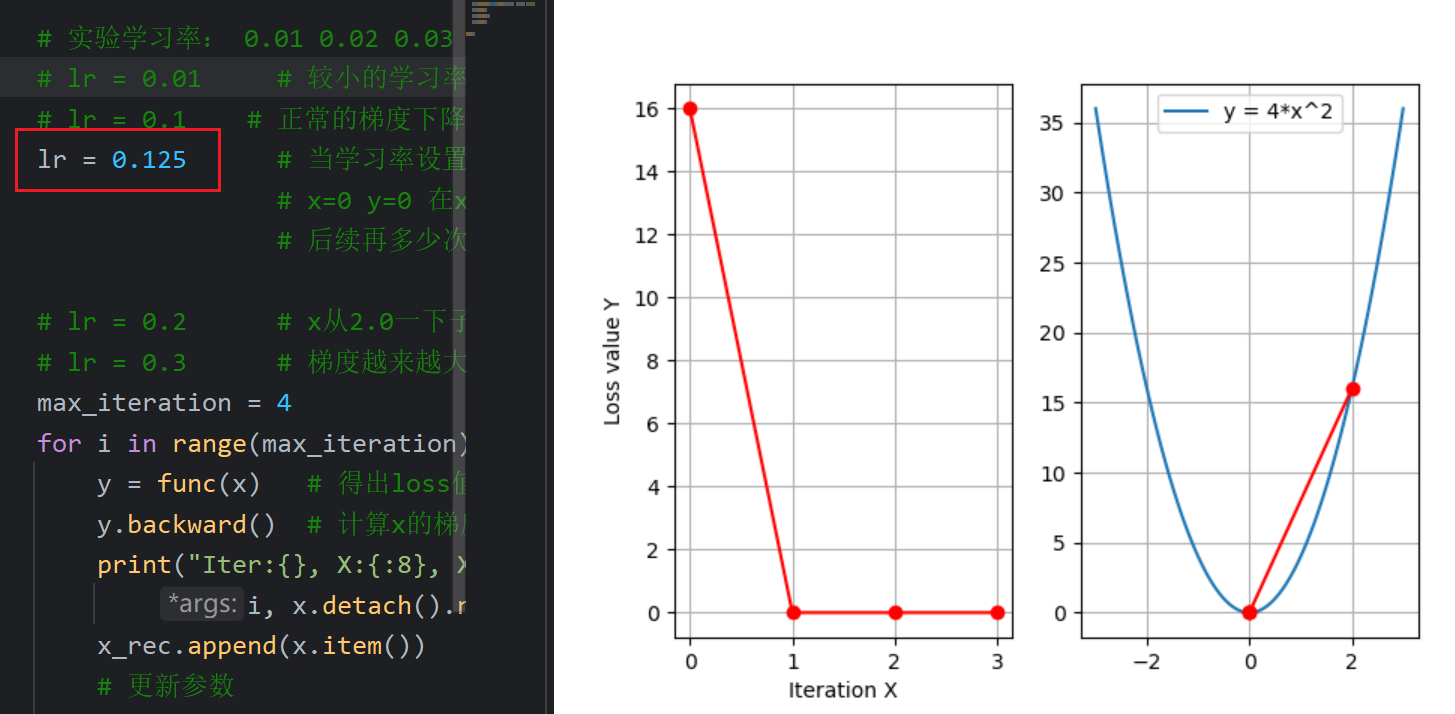

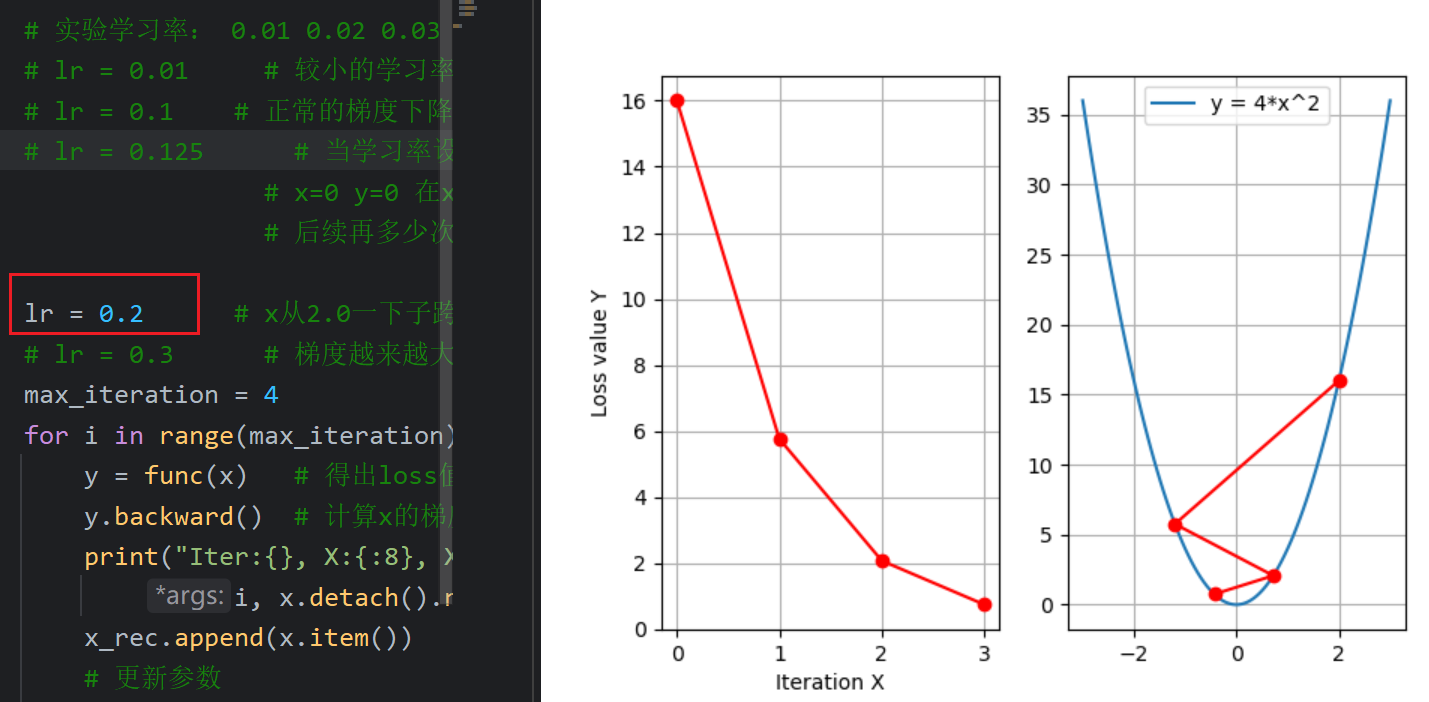

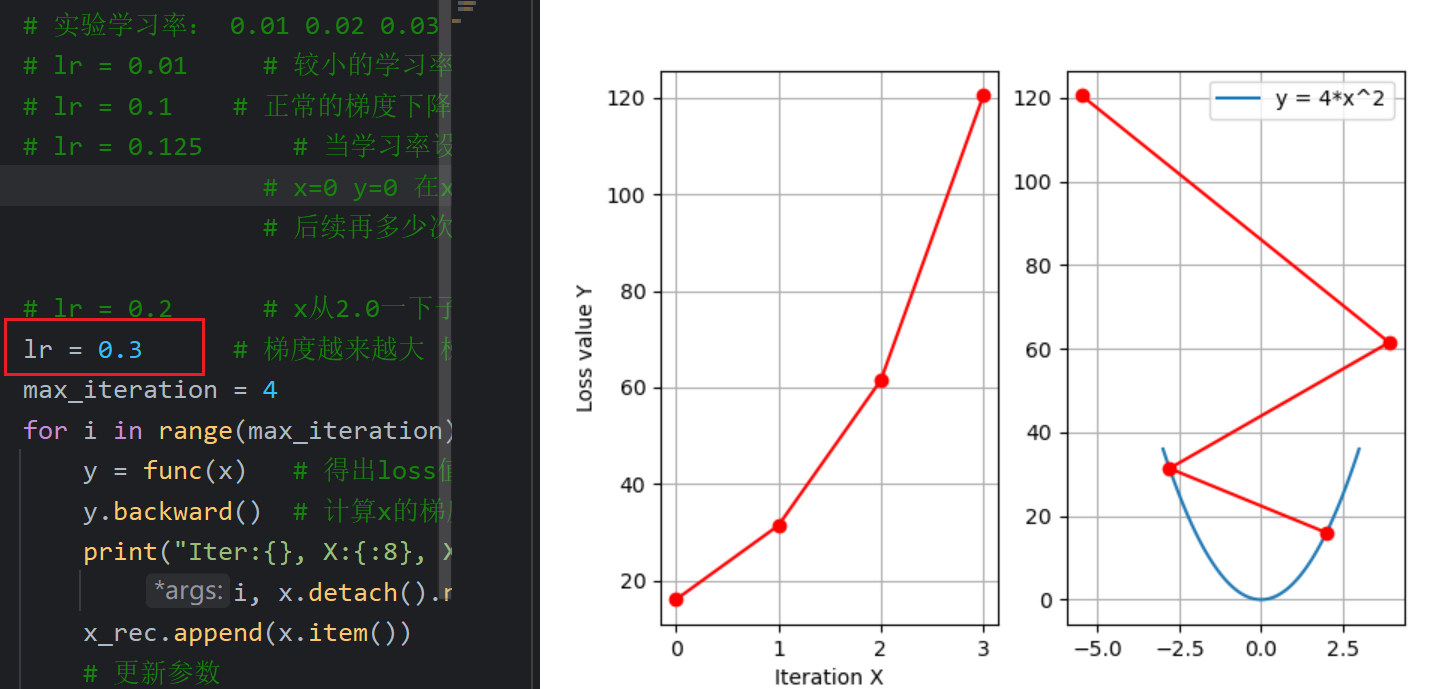

16、自动微分模块案例_循环更新参数

四、Day03

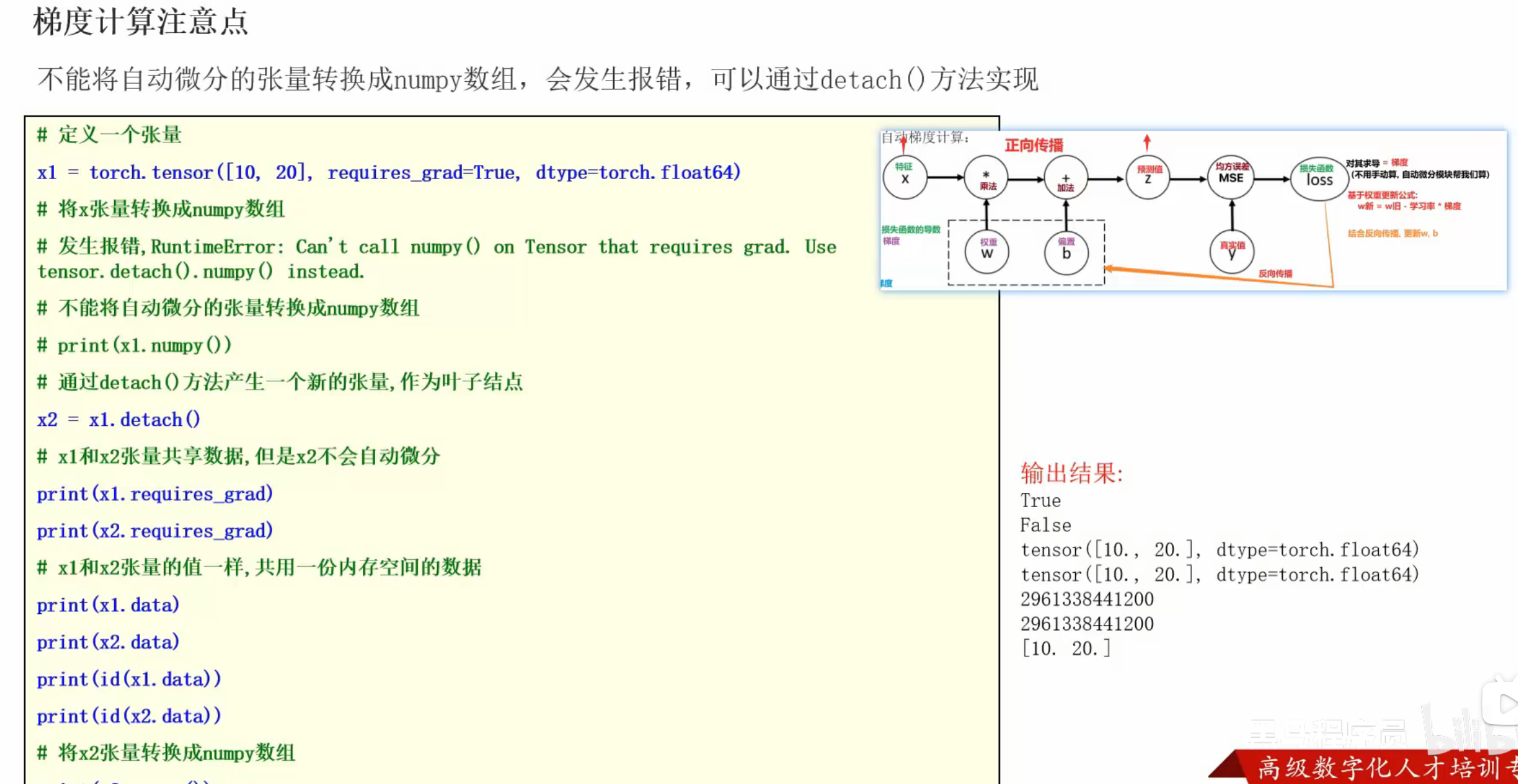

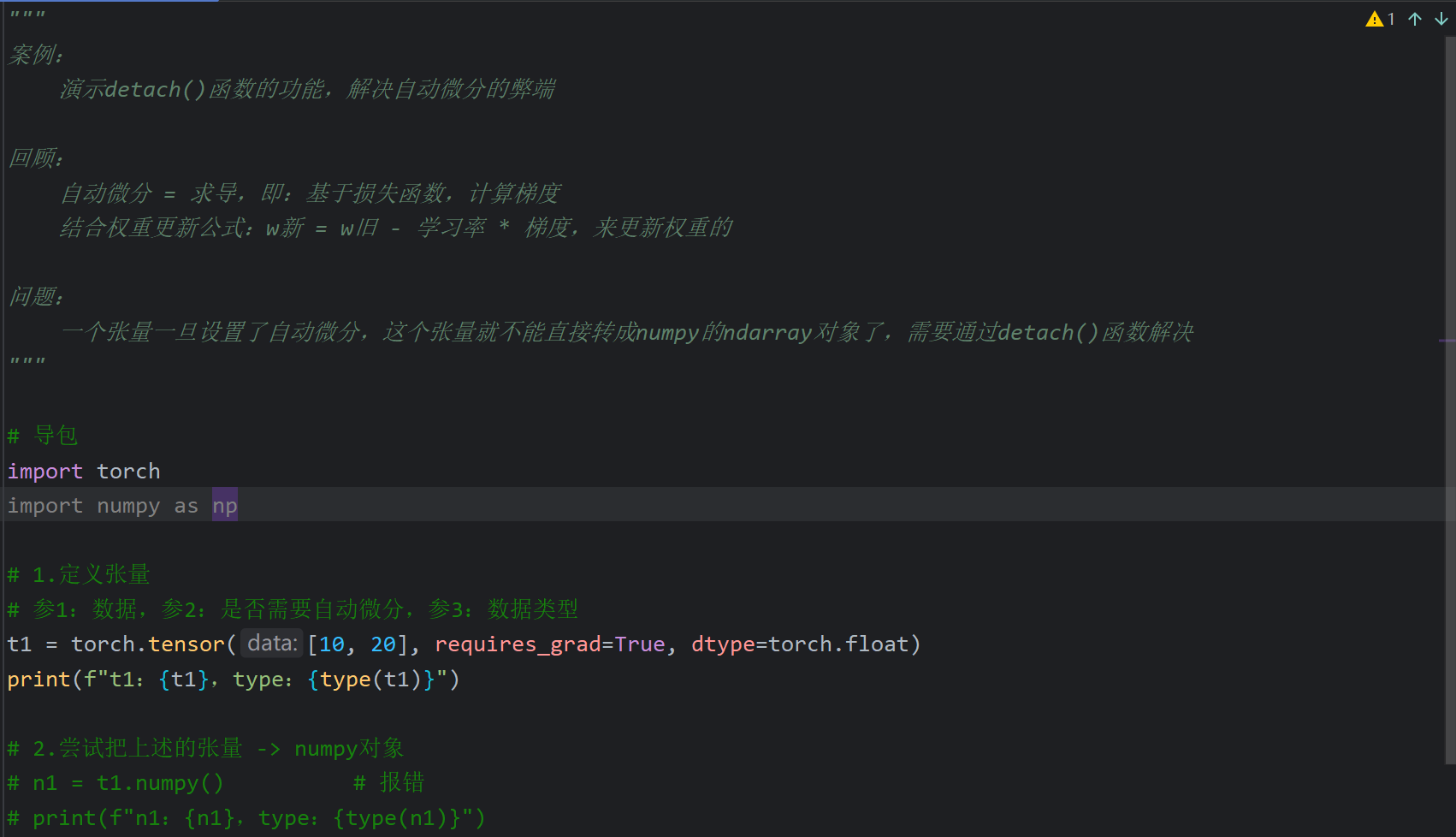

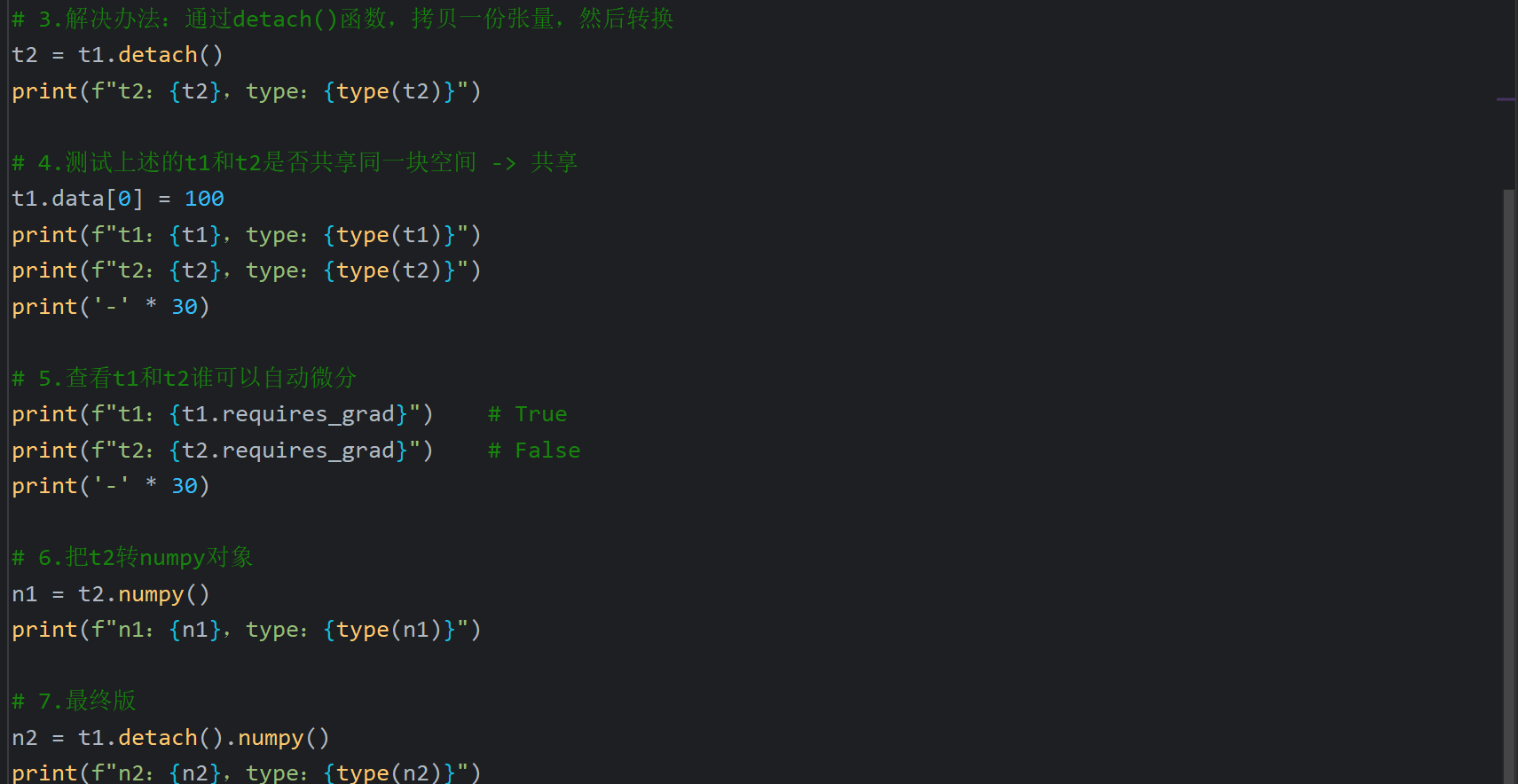

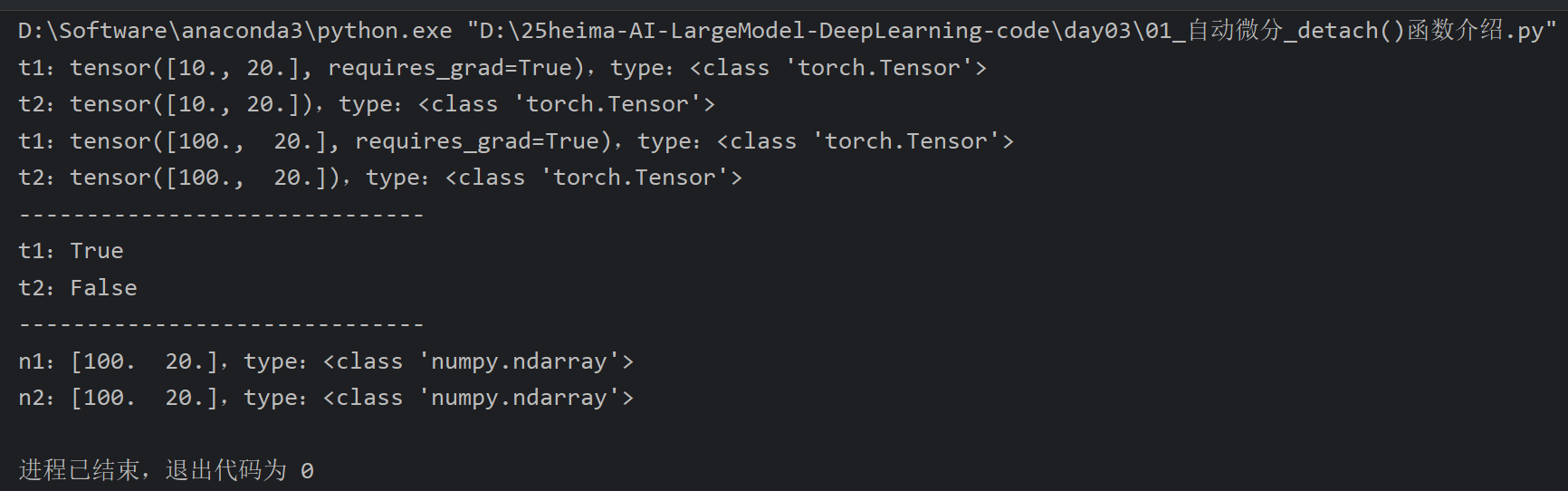

1、自动微分小问题_detach函数

2、自动微分真实应用场景

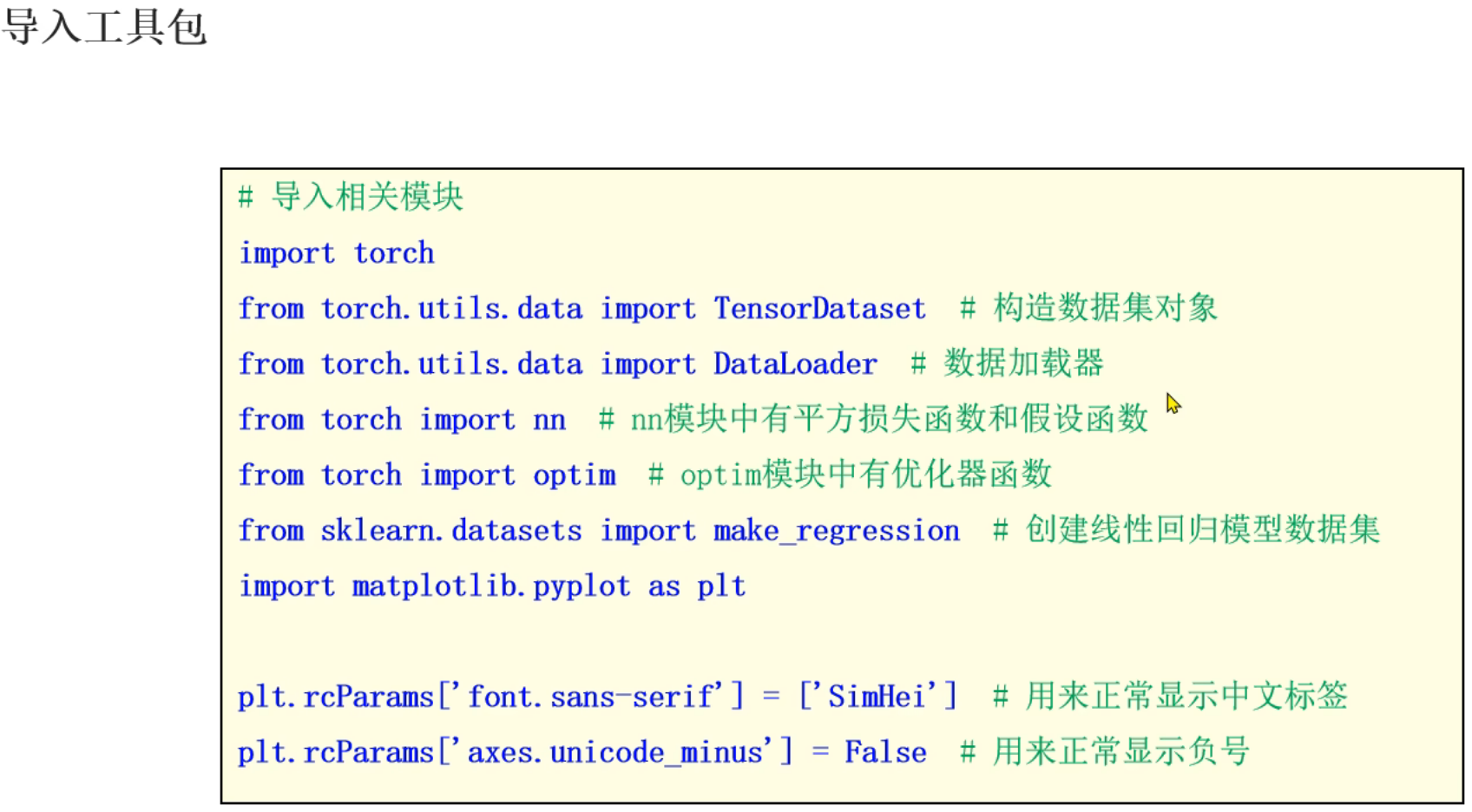

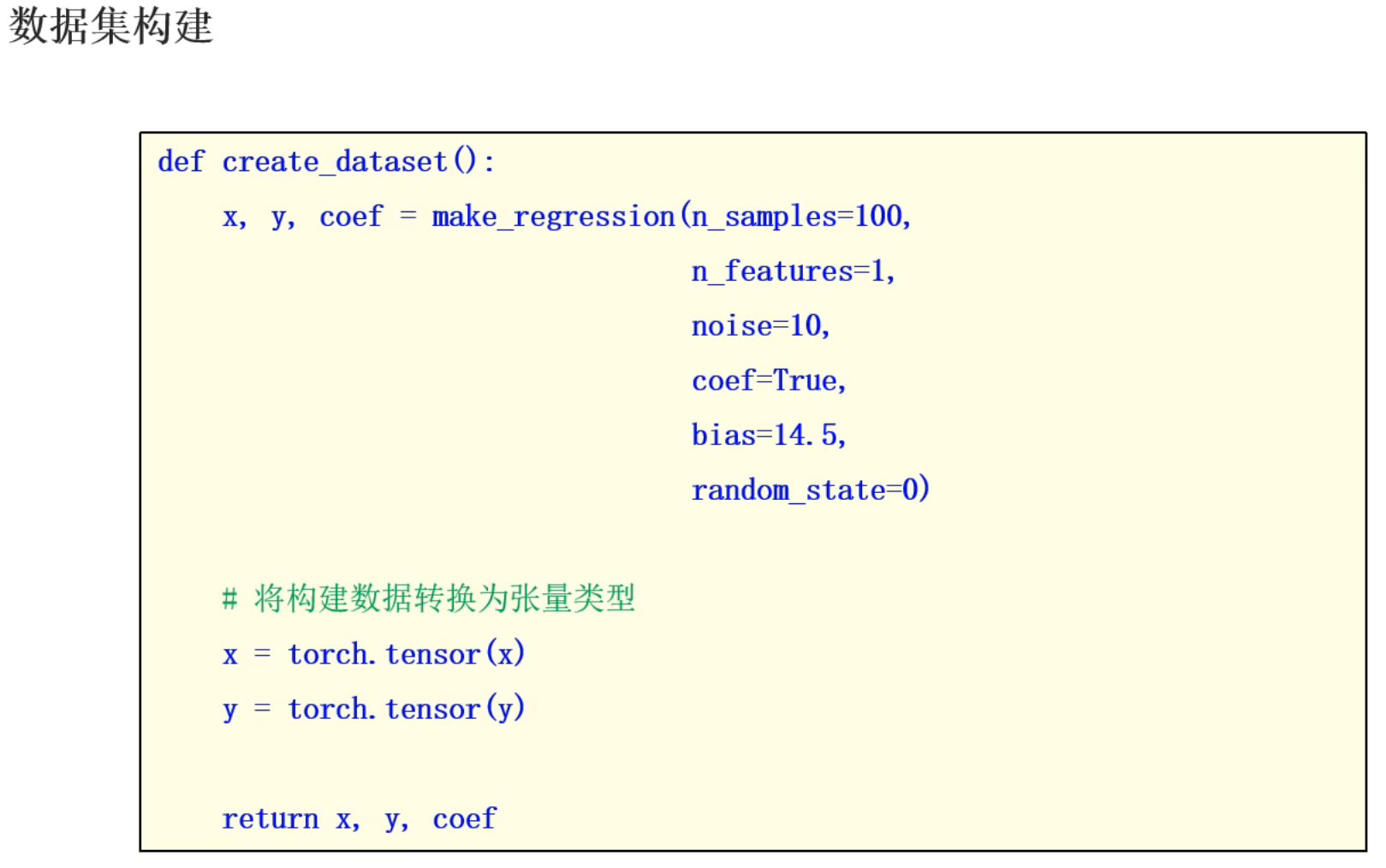

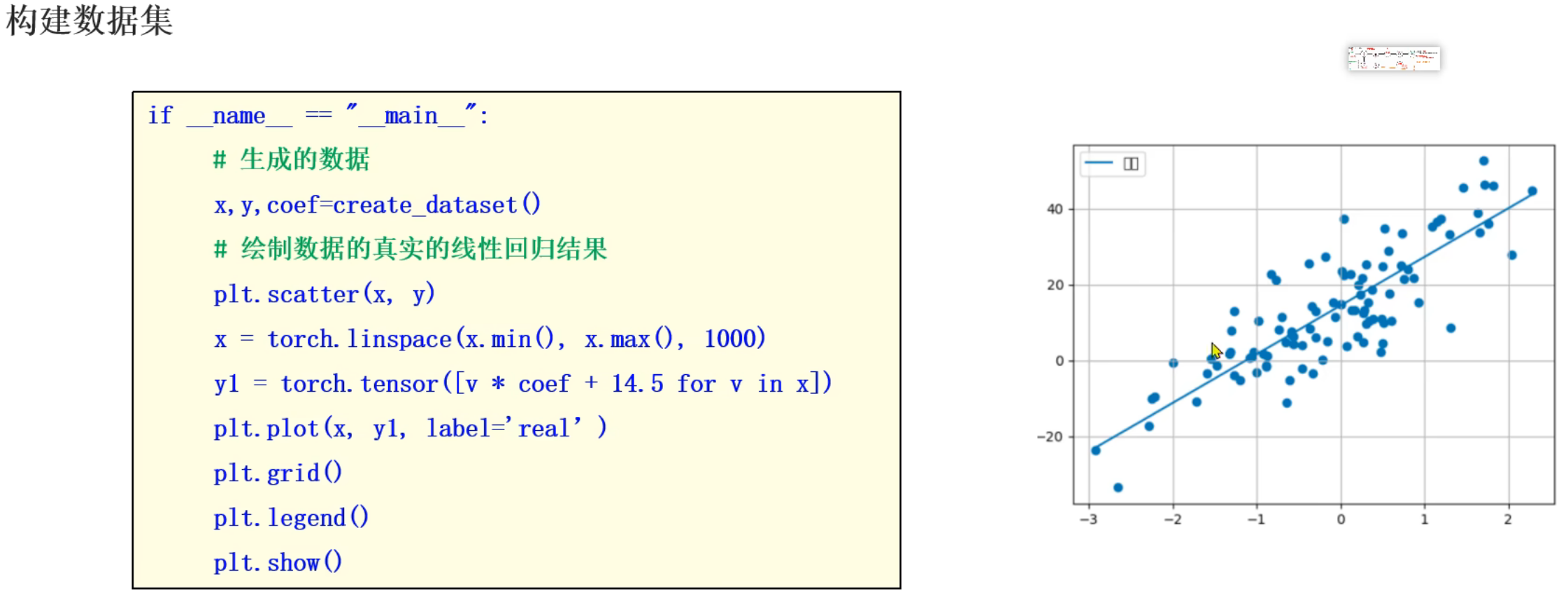

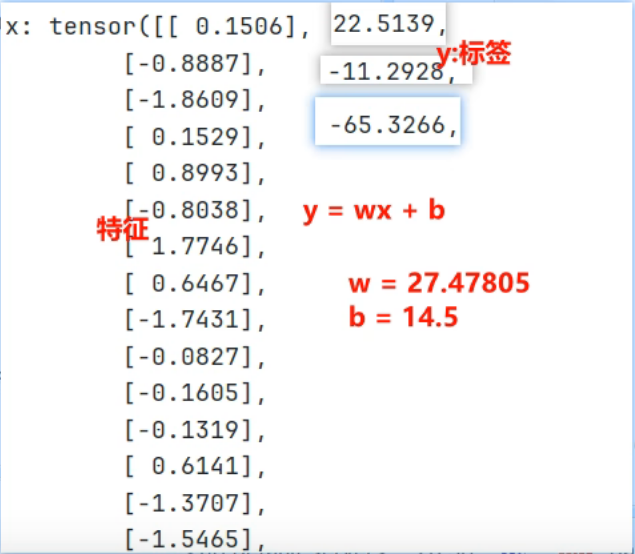

3、PyTorch模拟线性回归_准备数据集

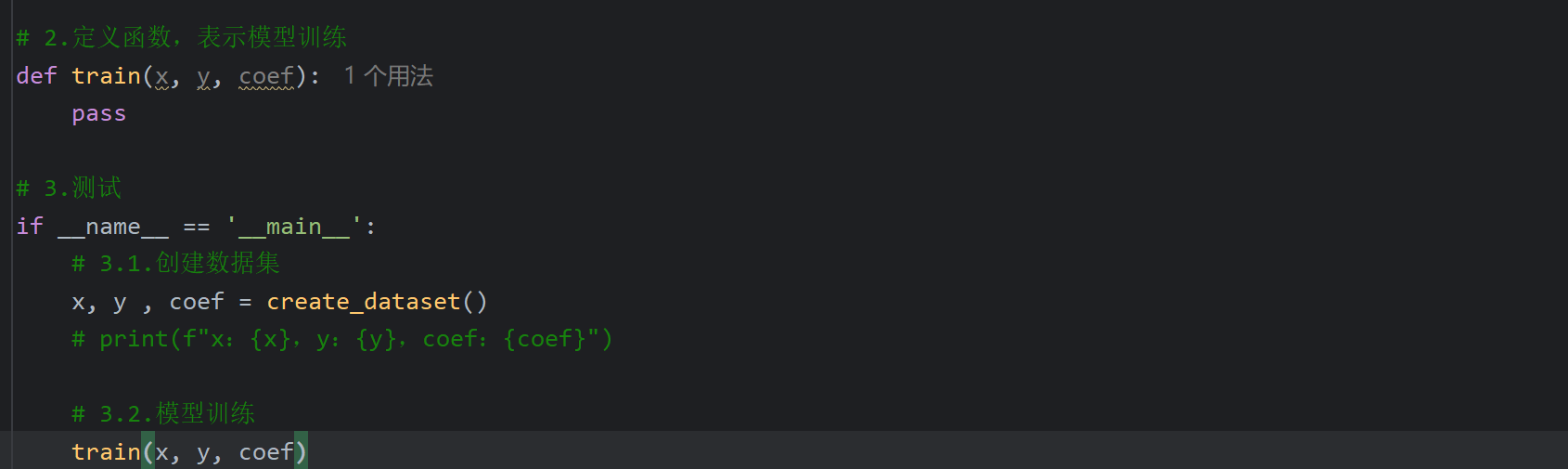

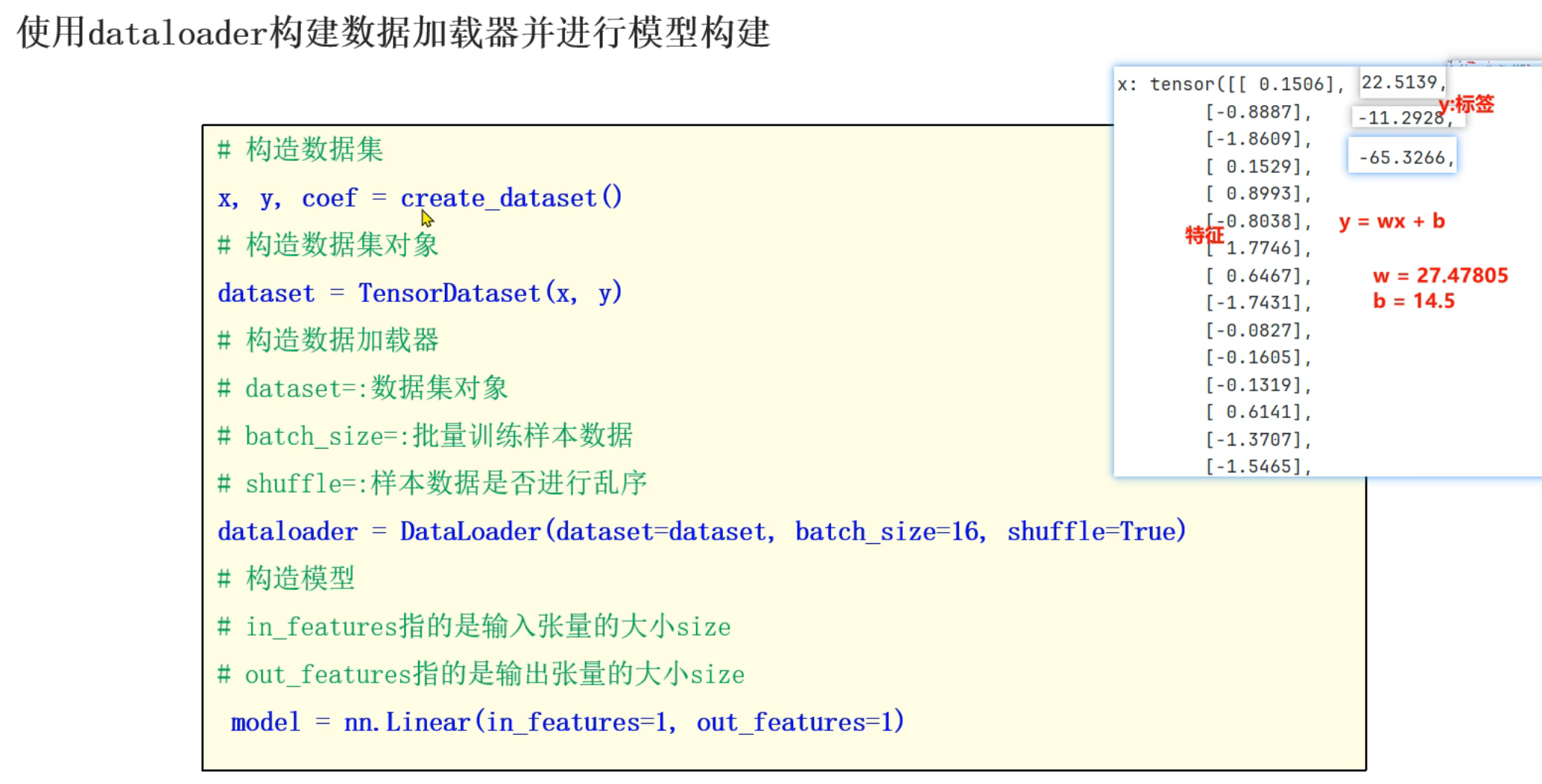

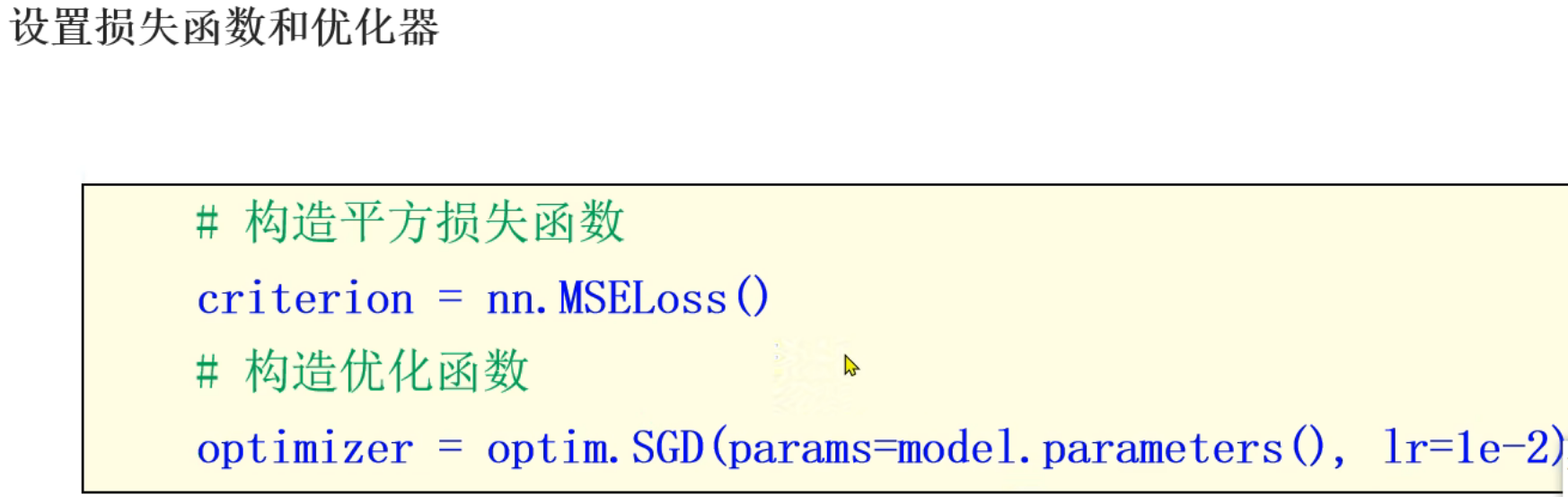

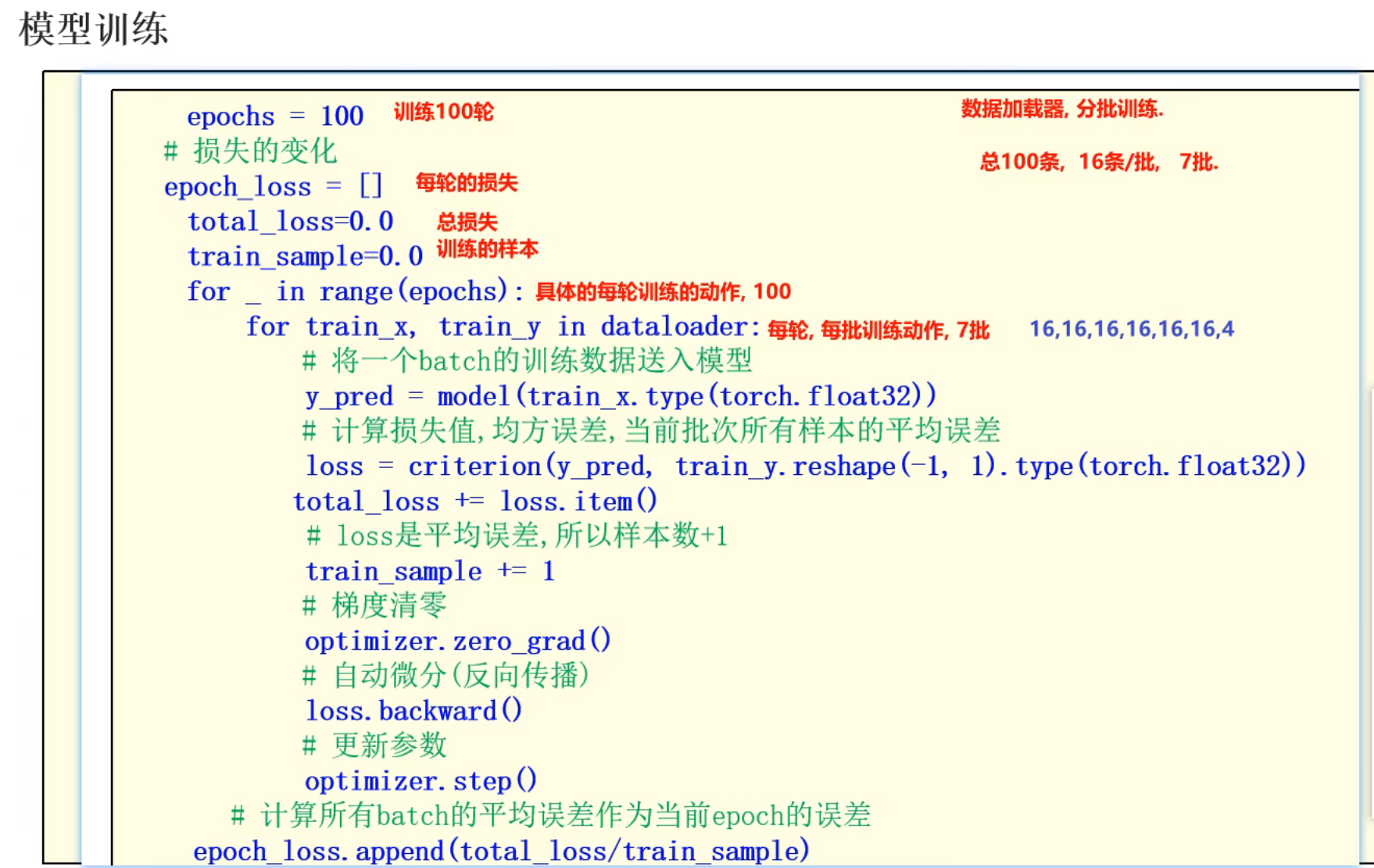

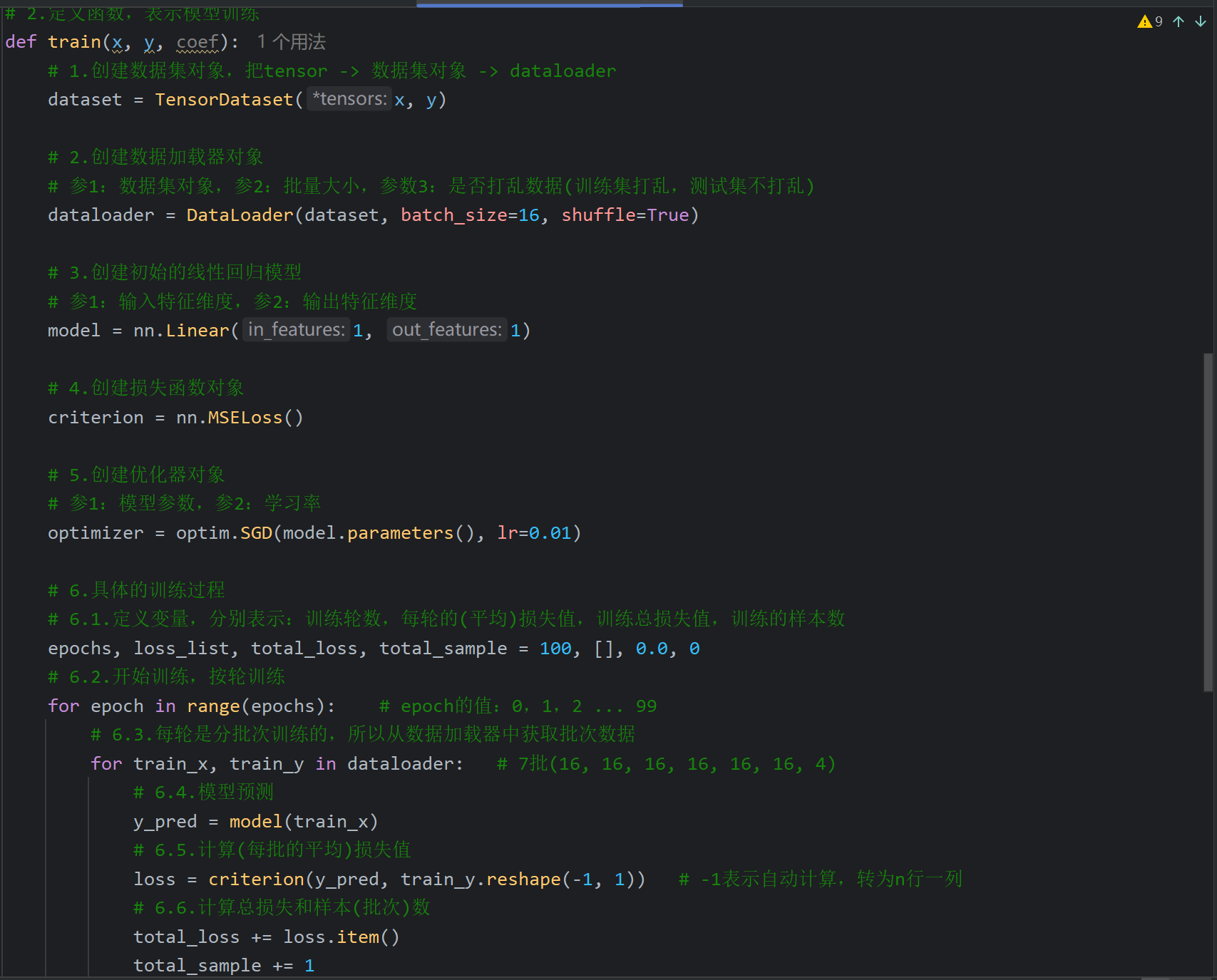

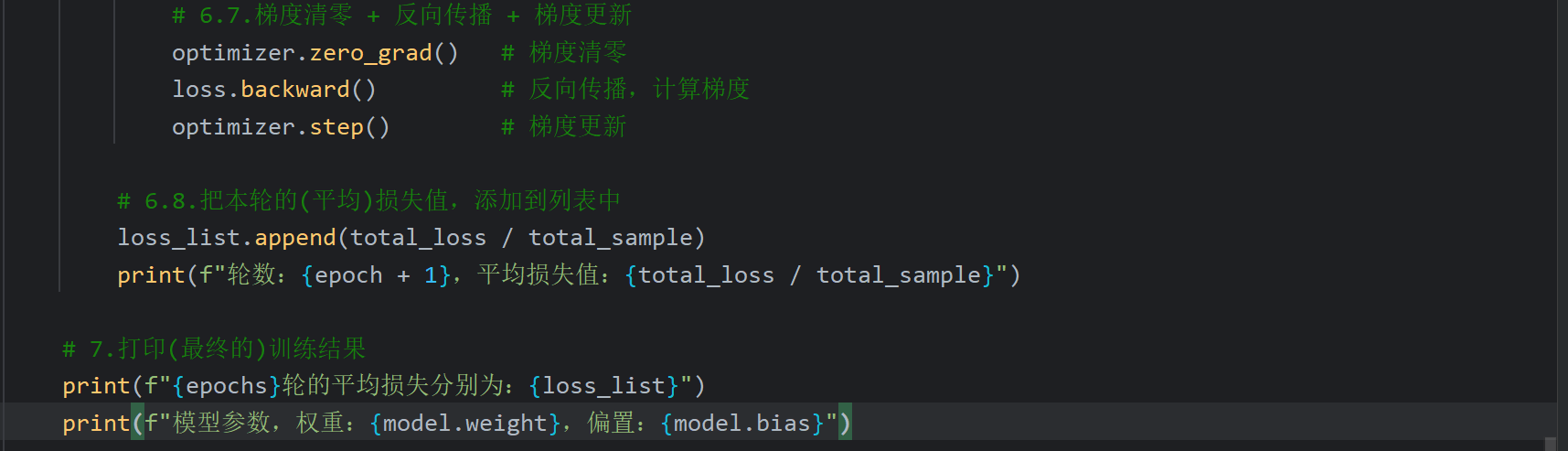

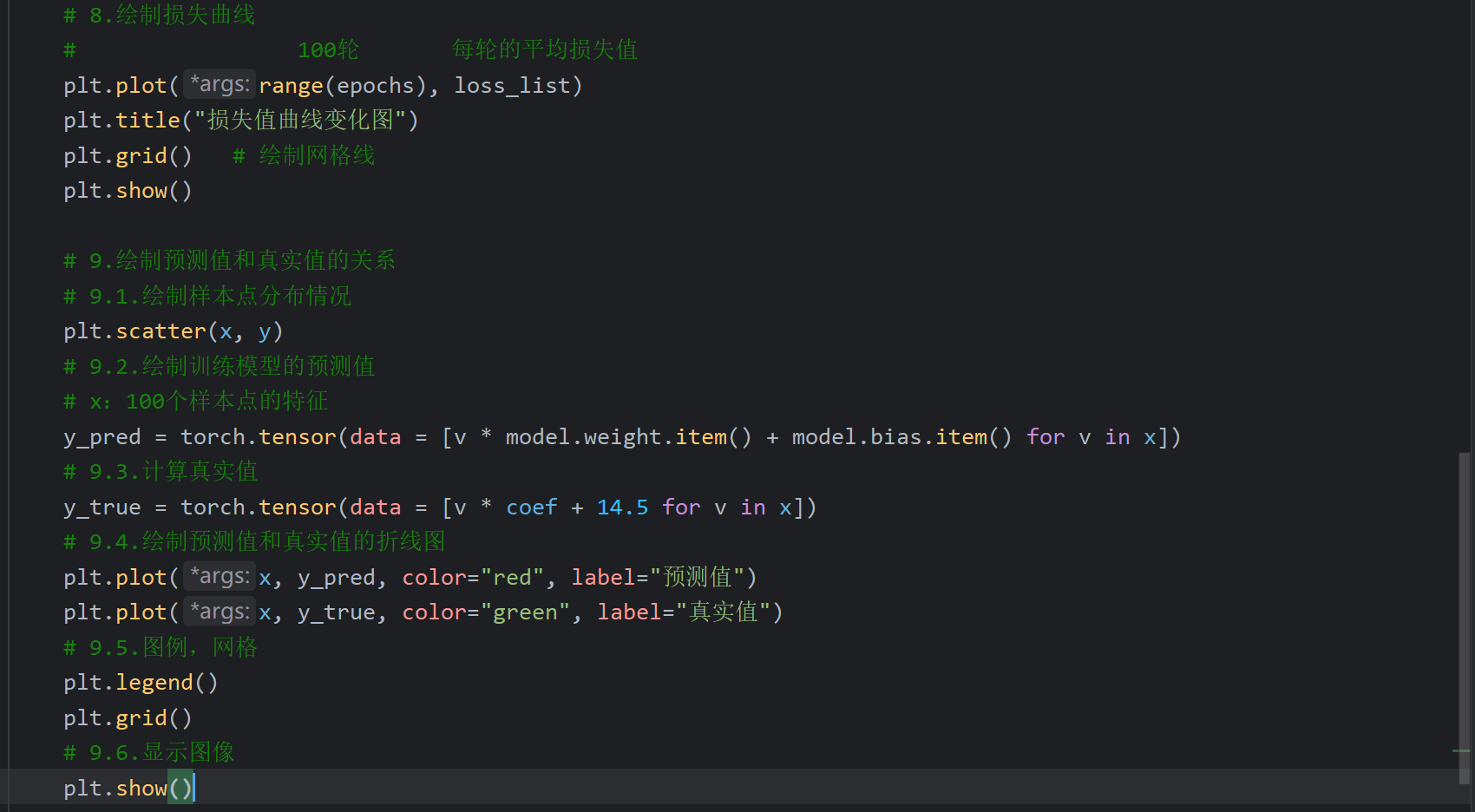

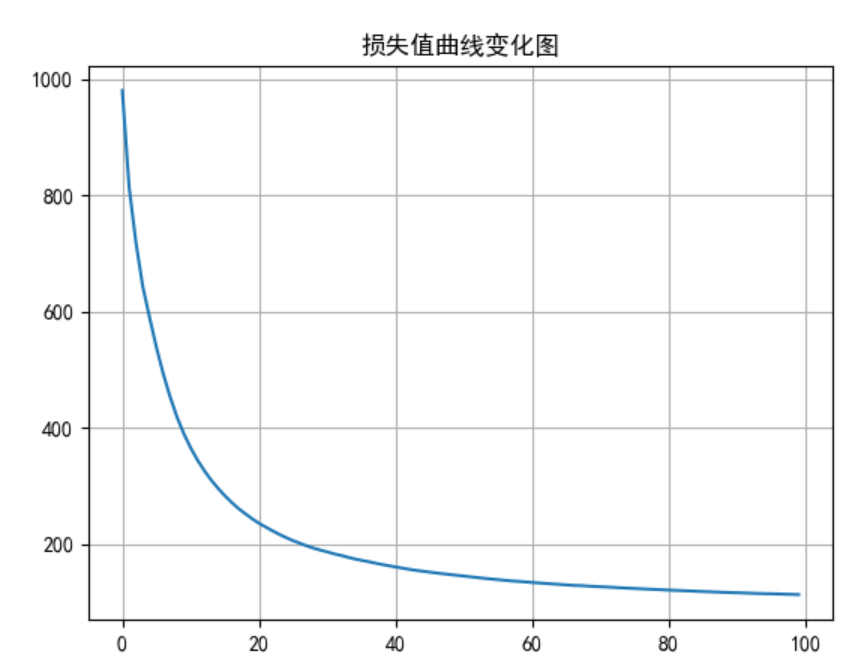

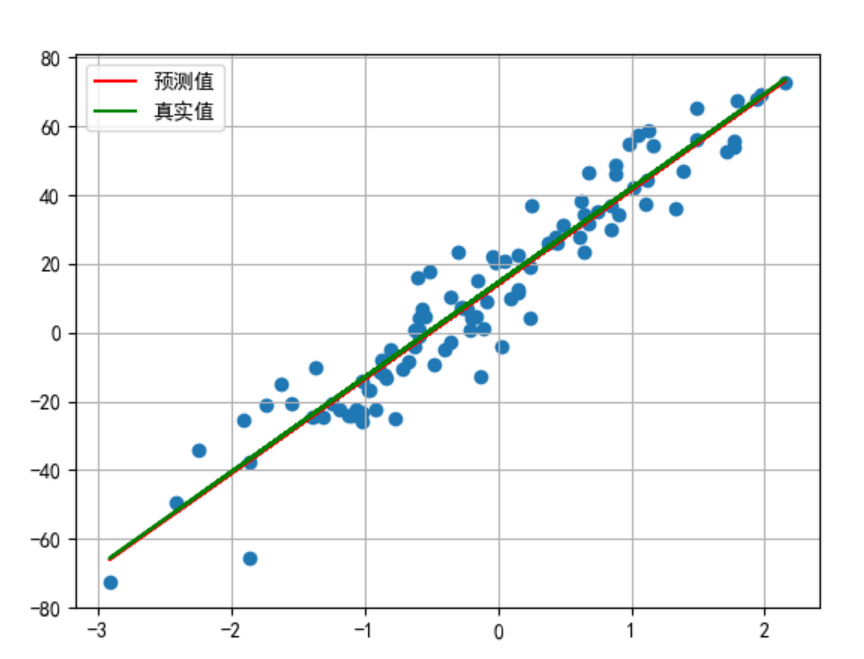

4、PyTorch模拟线性回归_模型训练

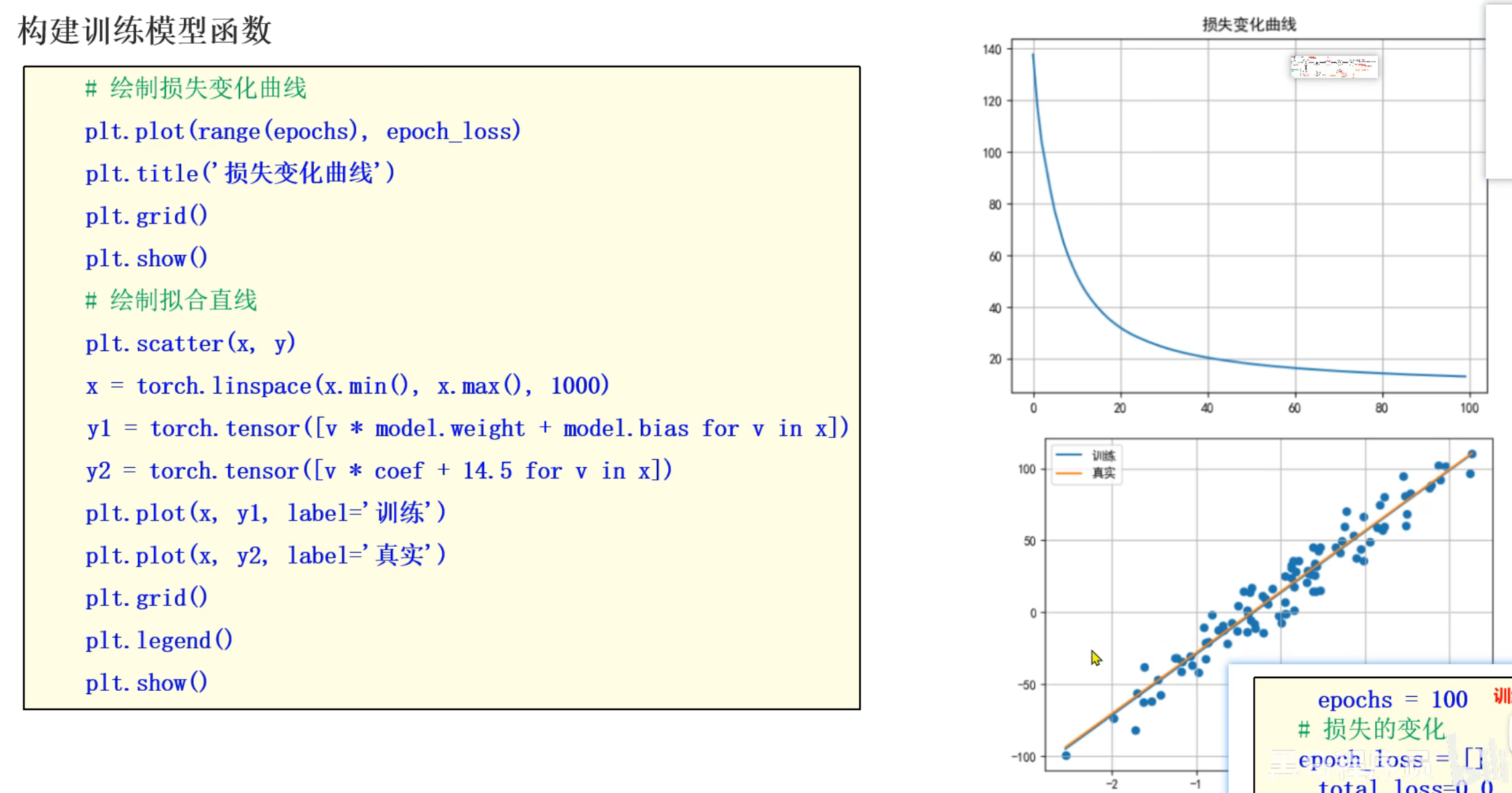

5、PyTorch模拟线性回归_可视化操作

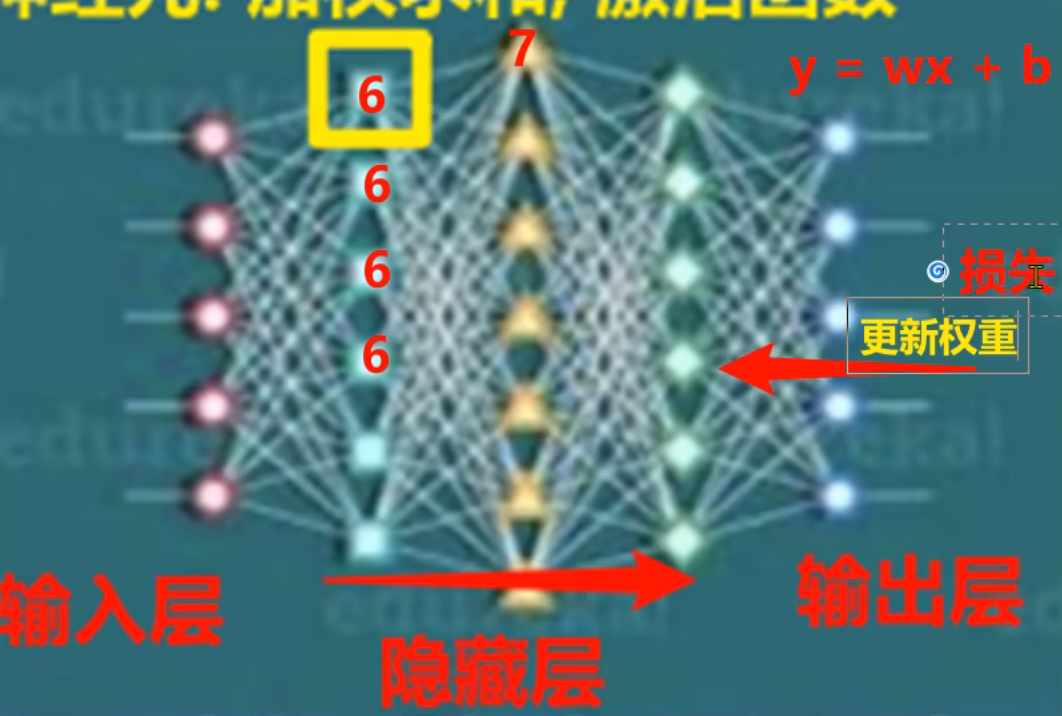

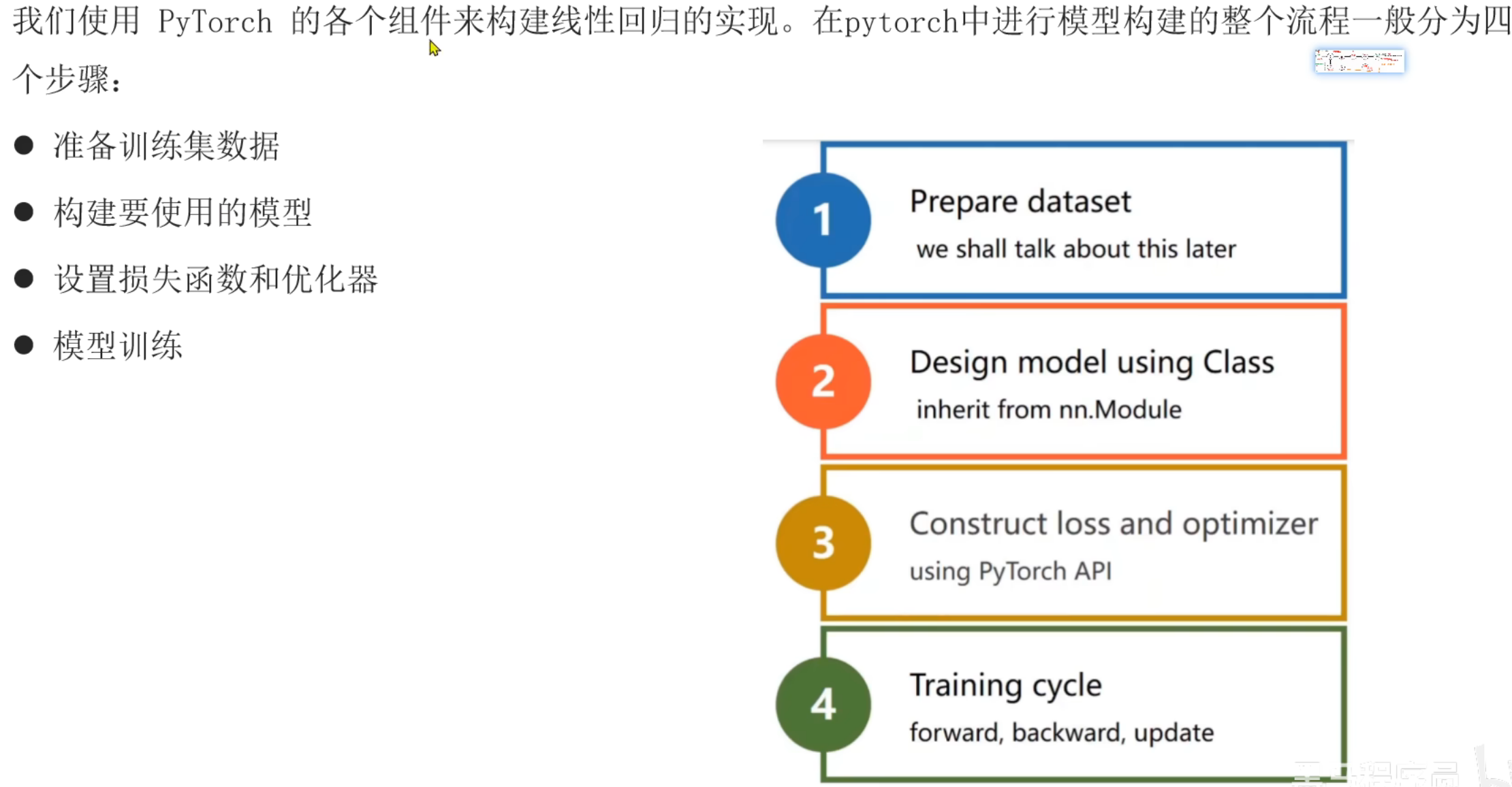

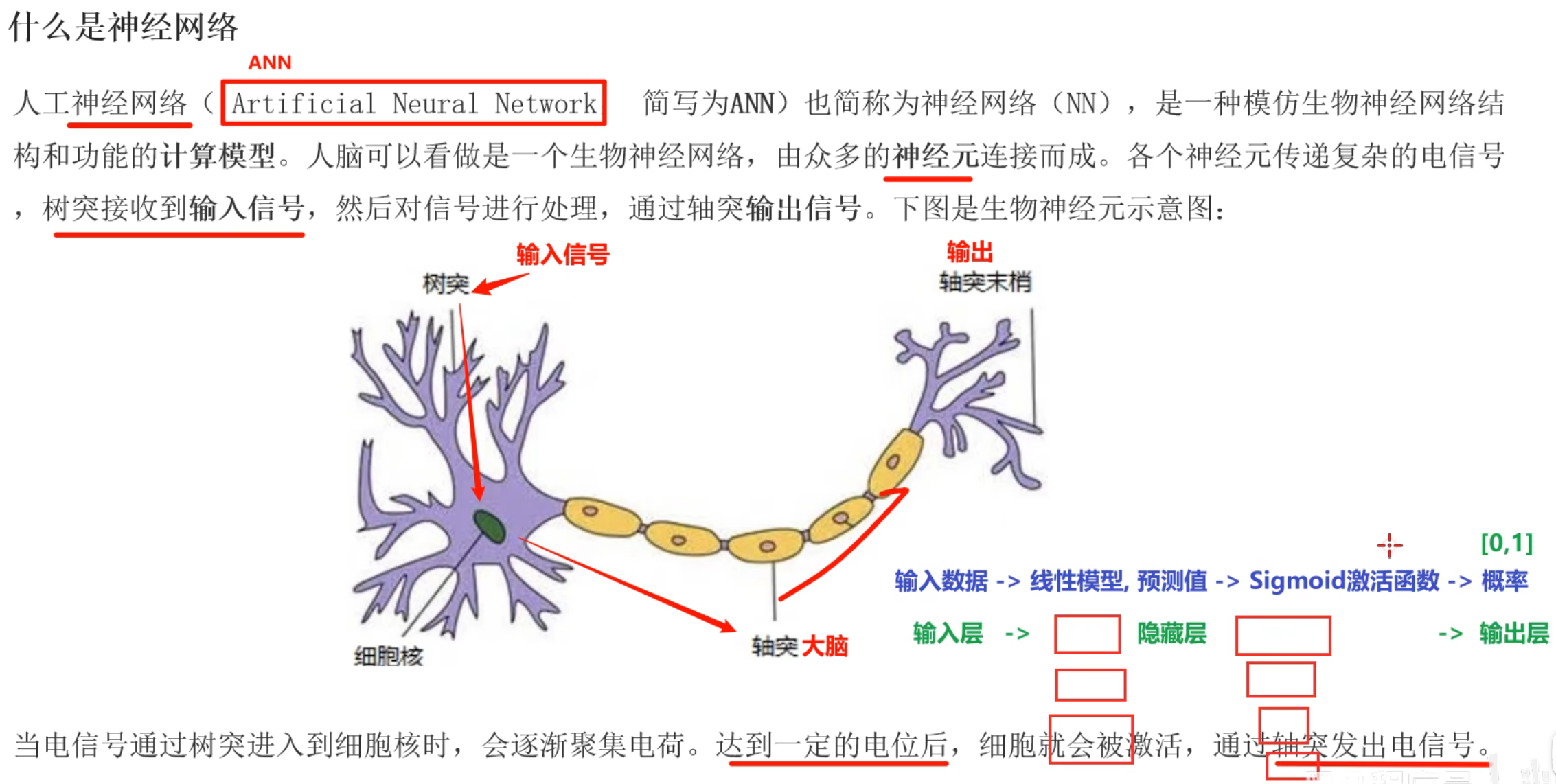

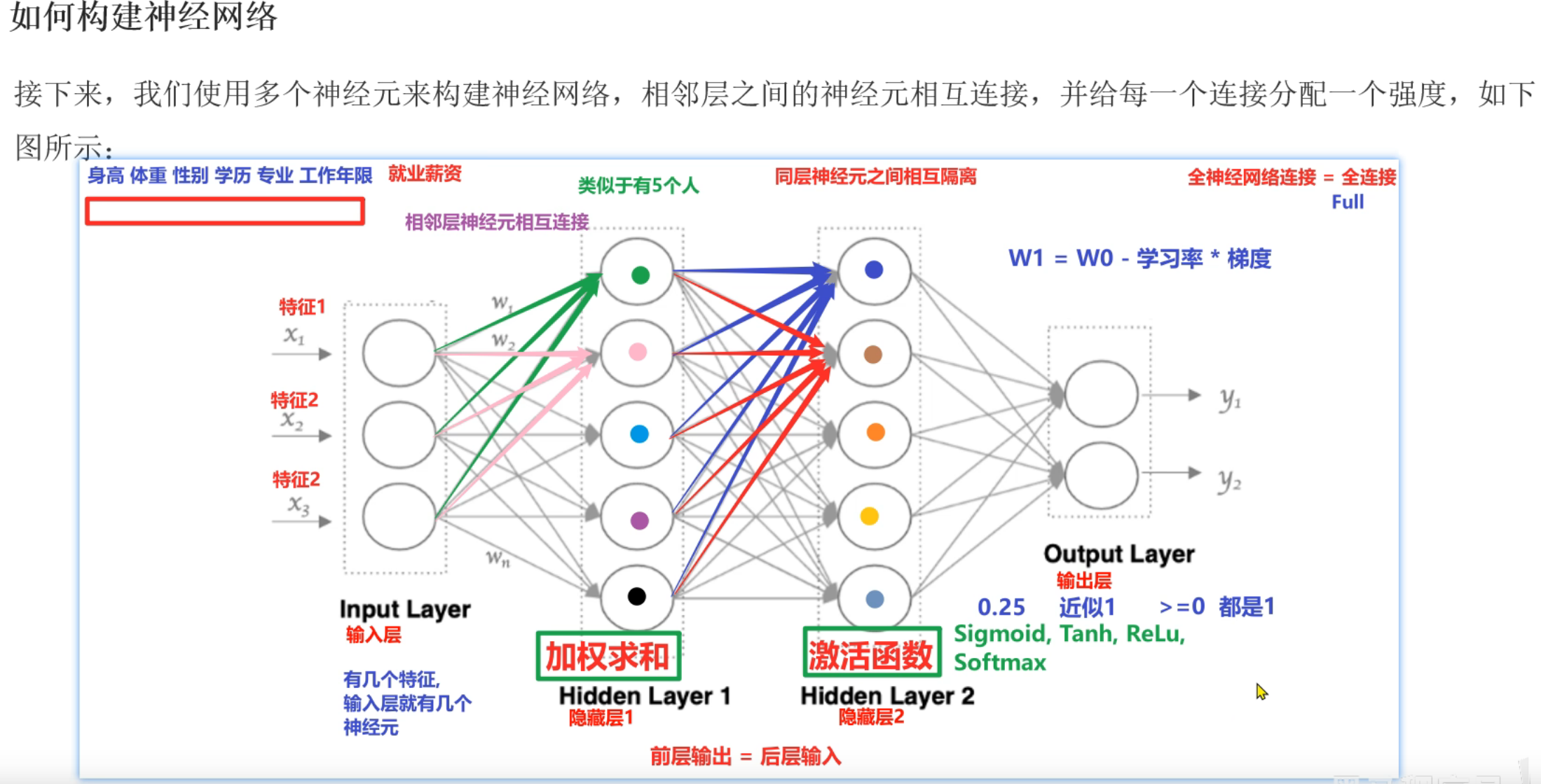

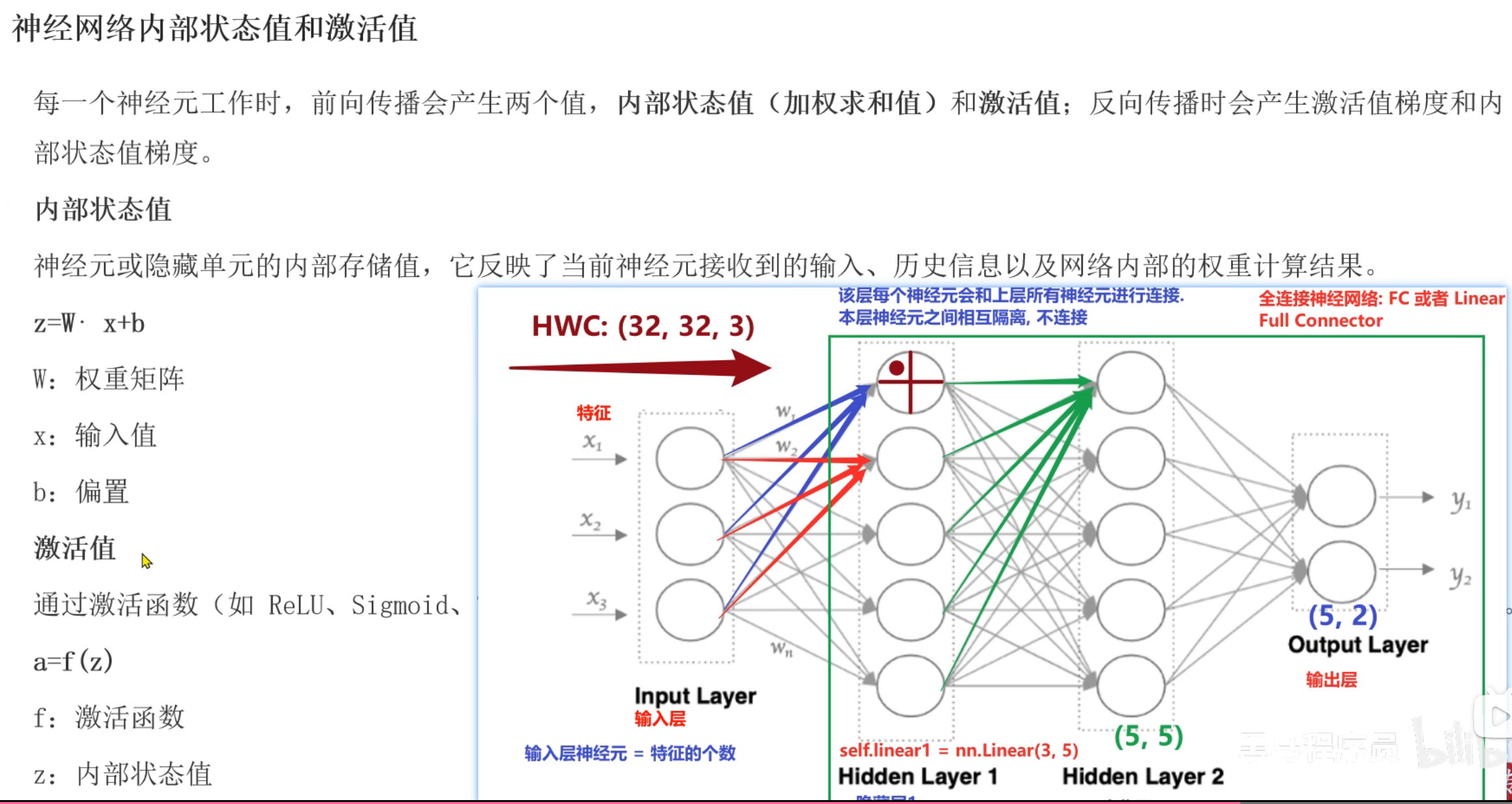

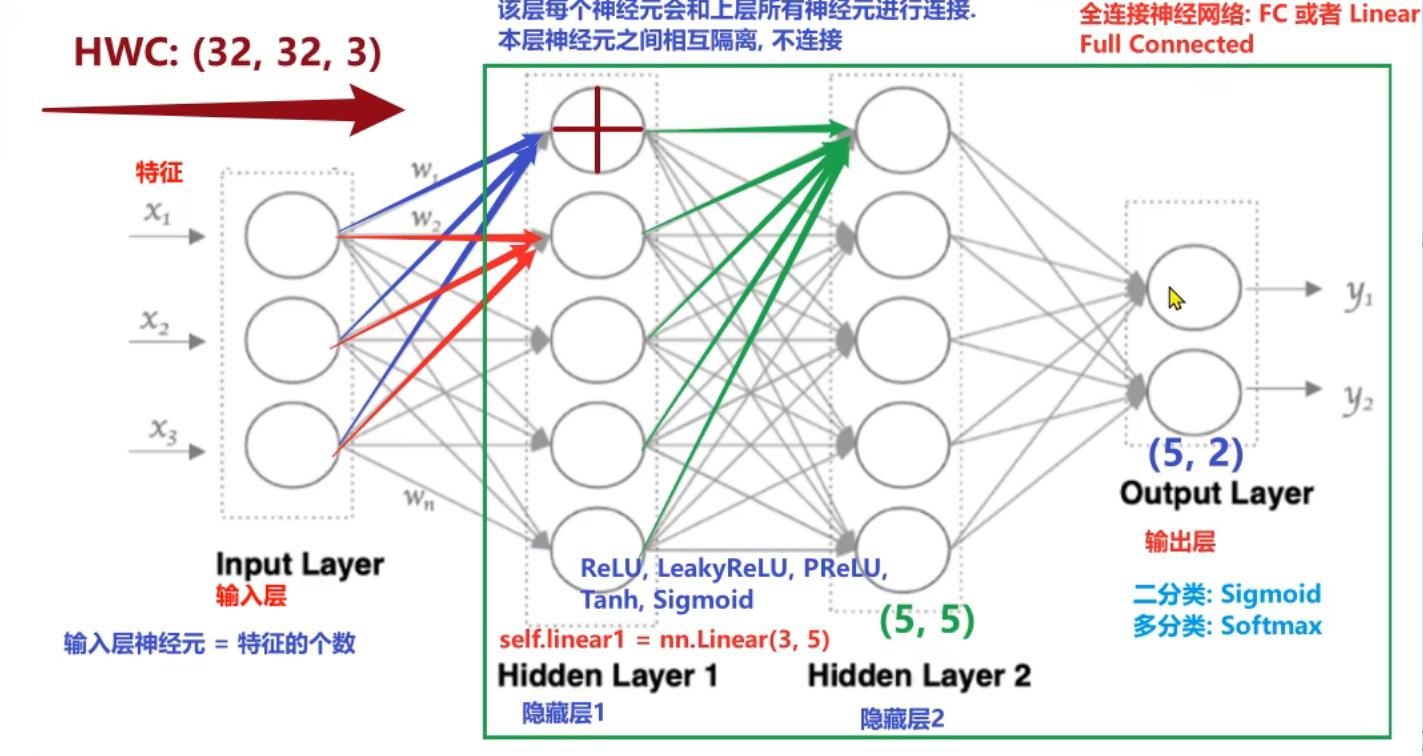

6、如何构建神经网络(neural network)

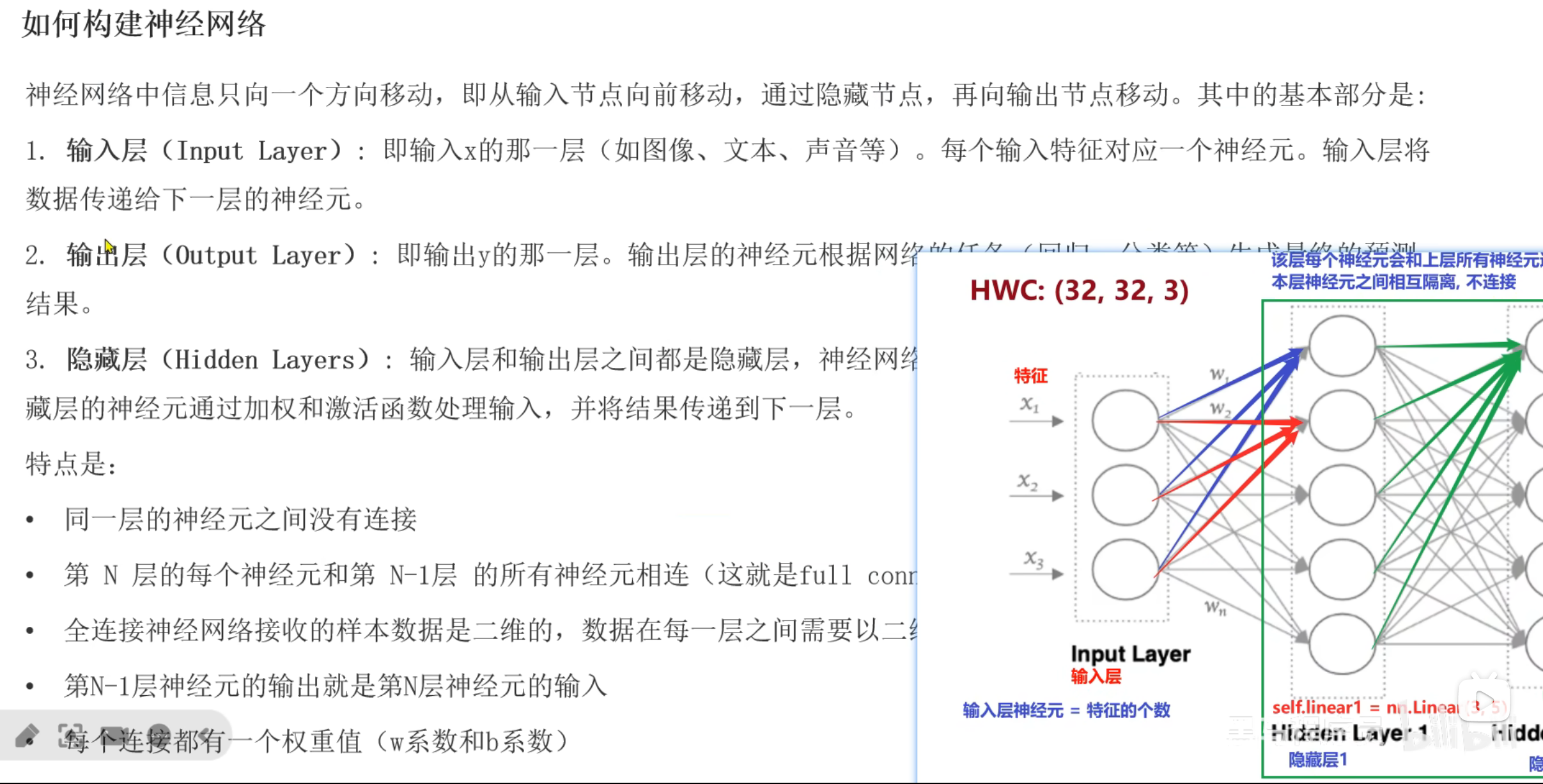

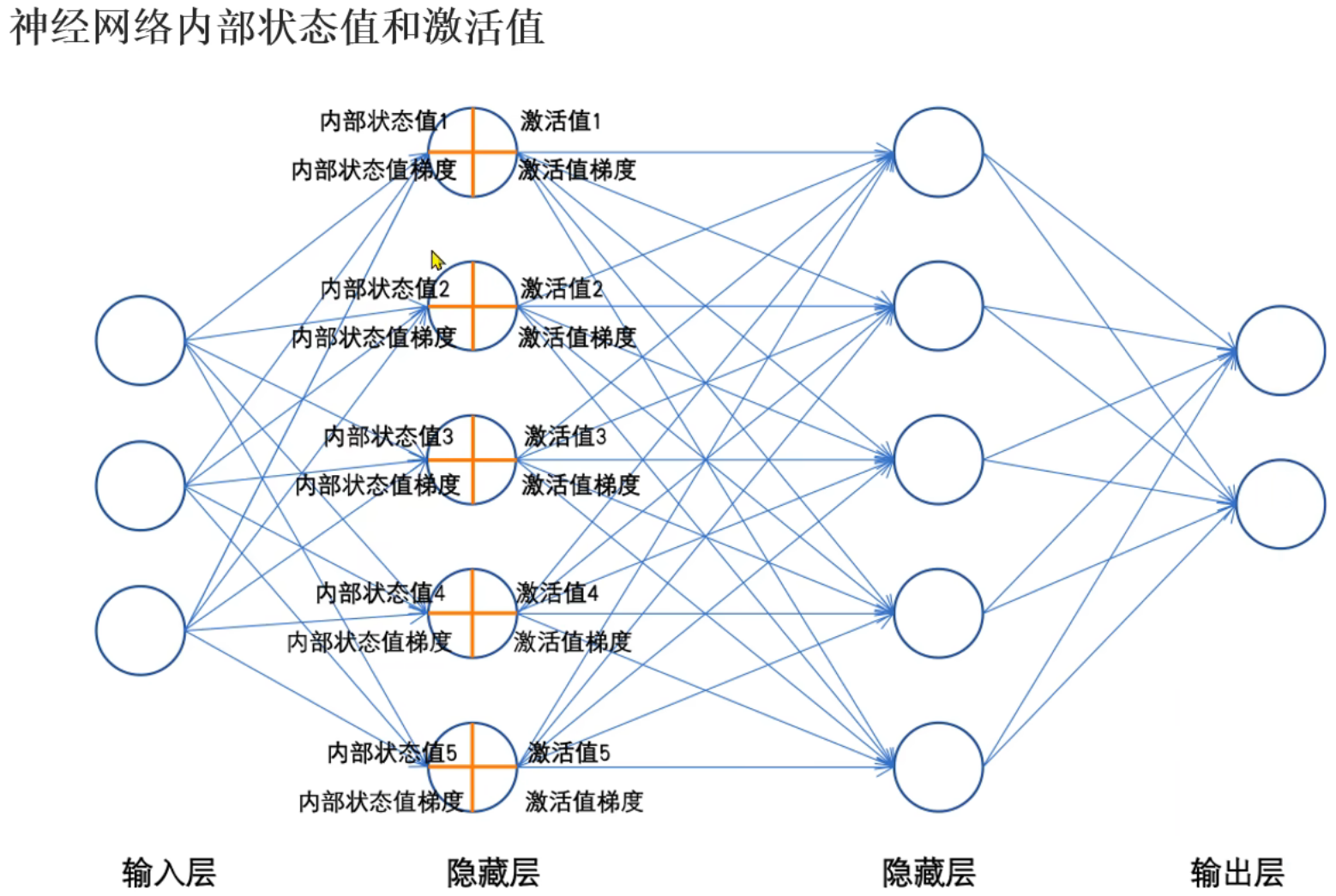

7、神经网络_文字介绍

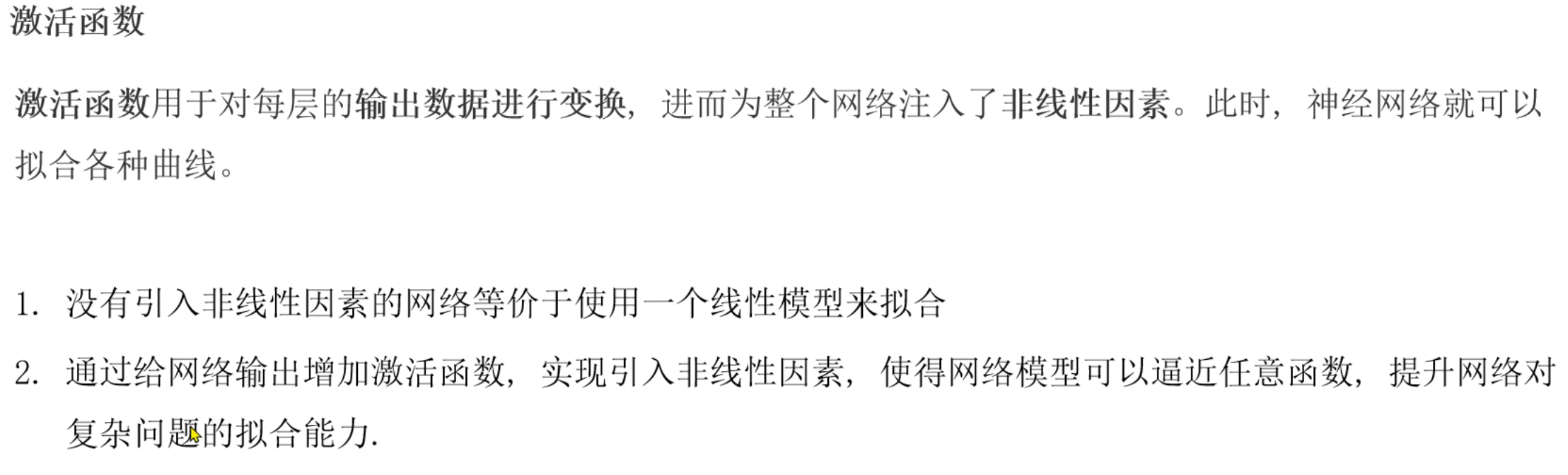

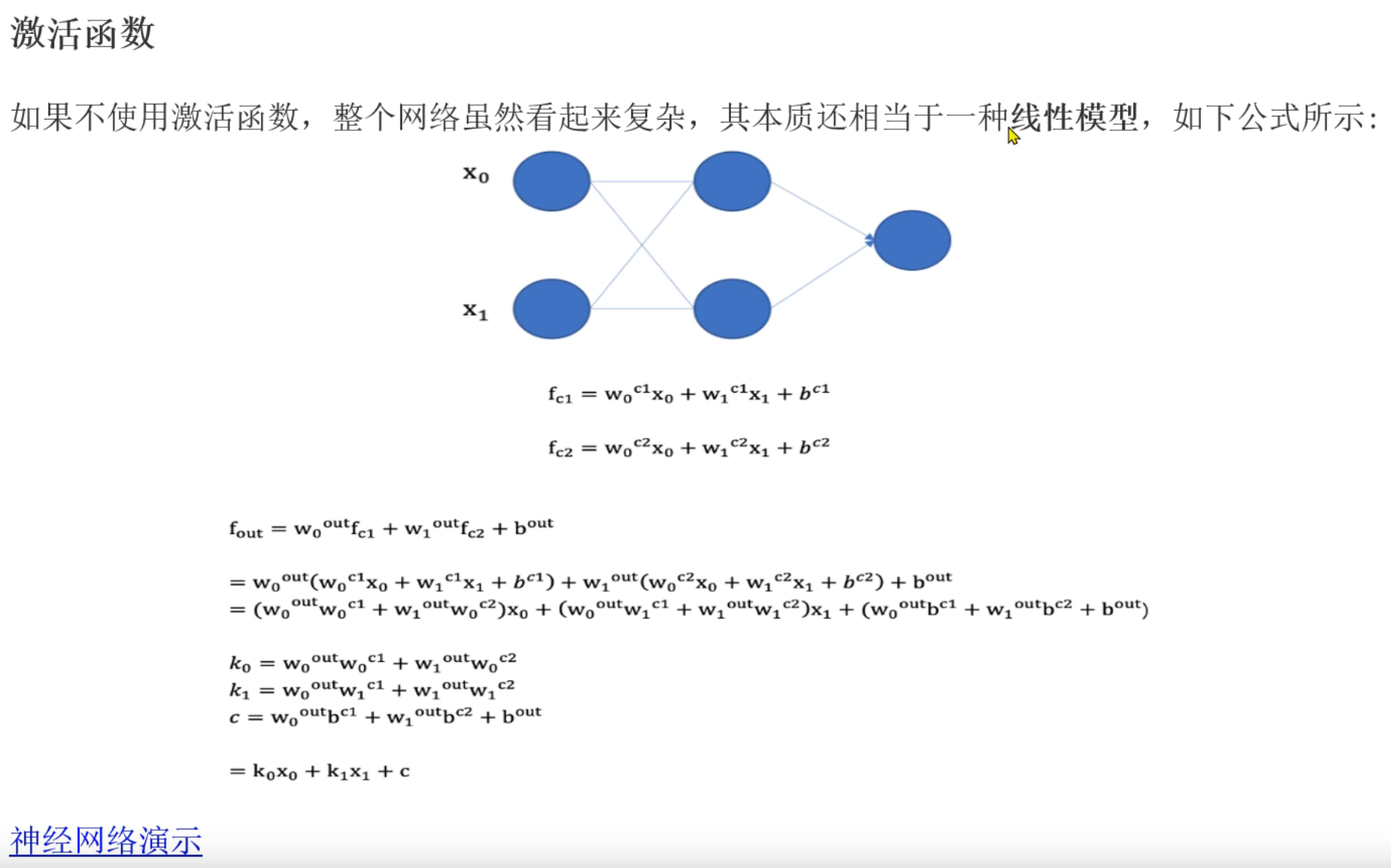

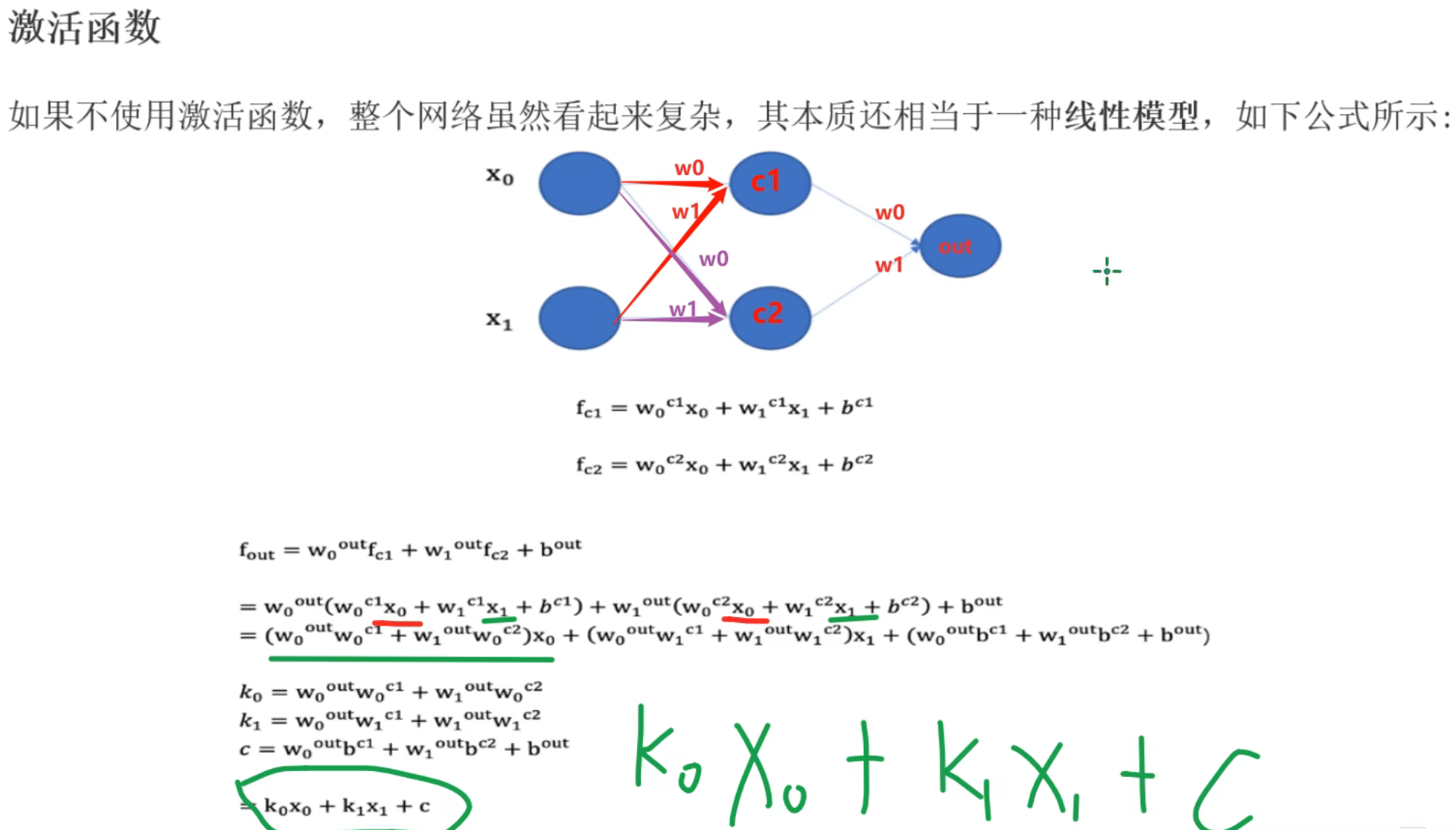

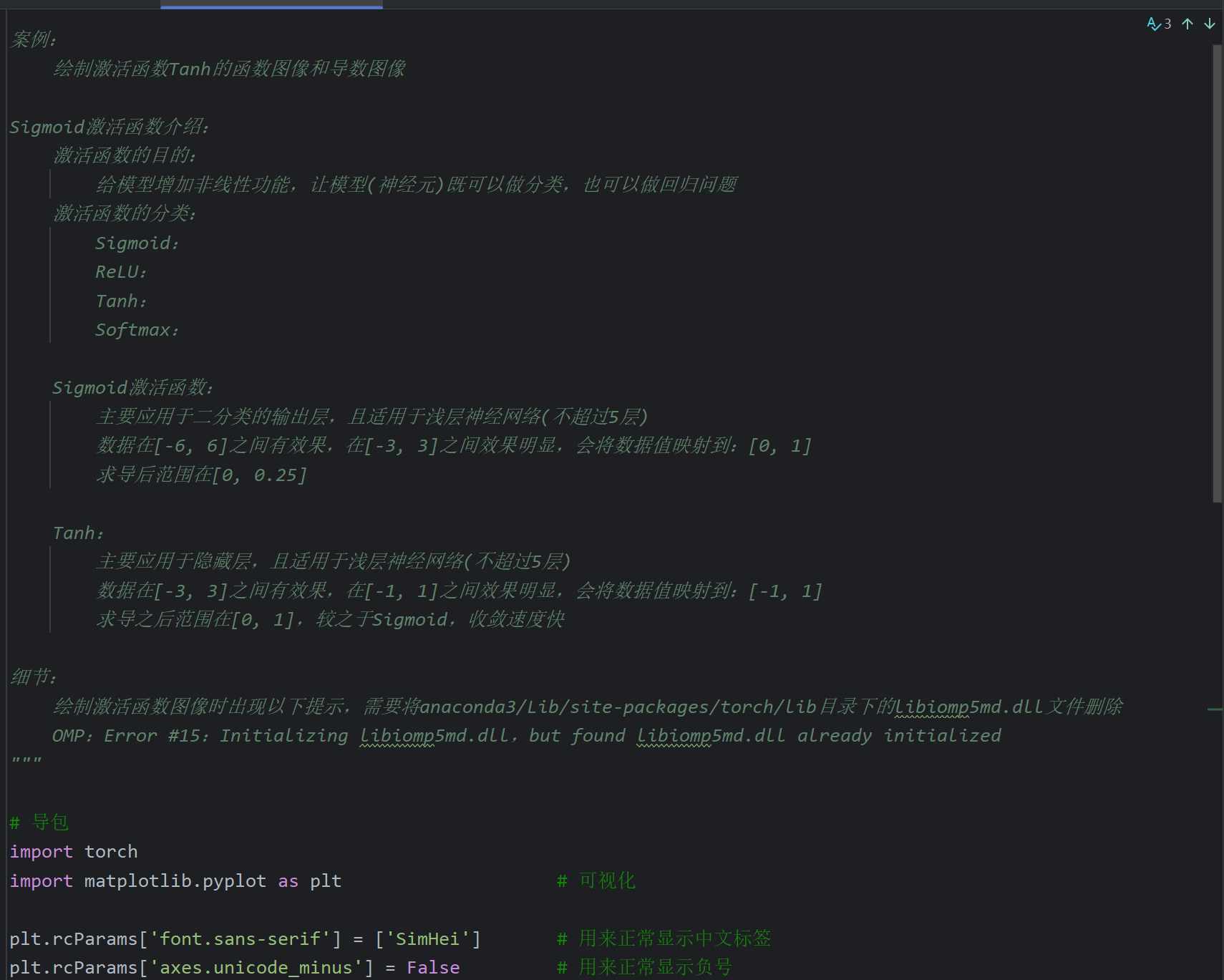

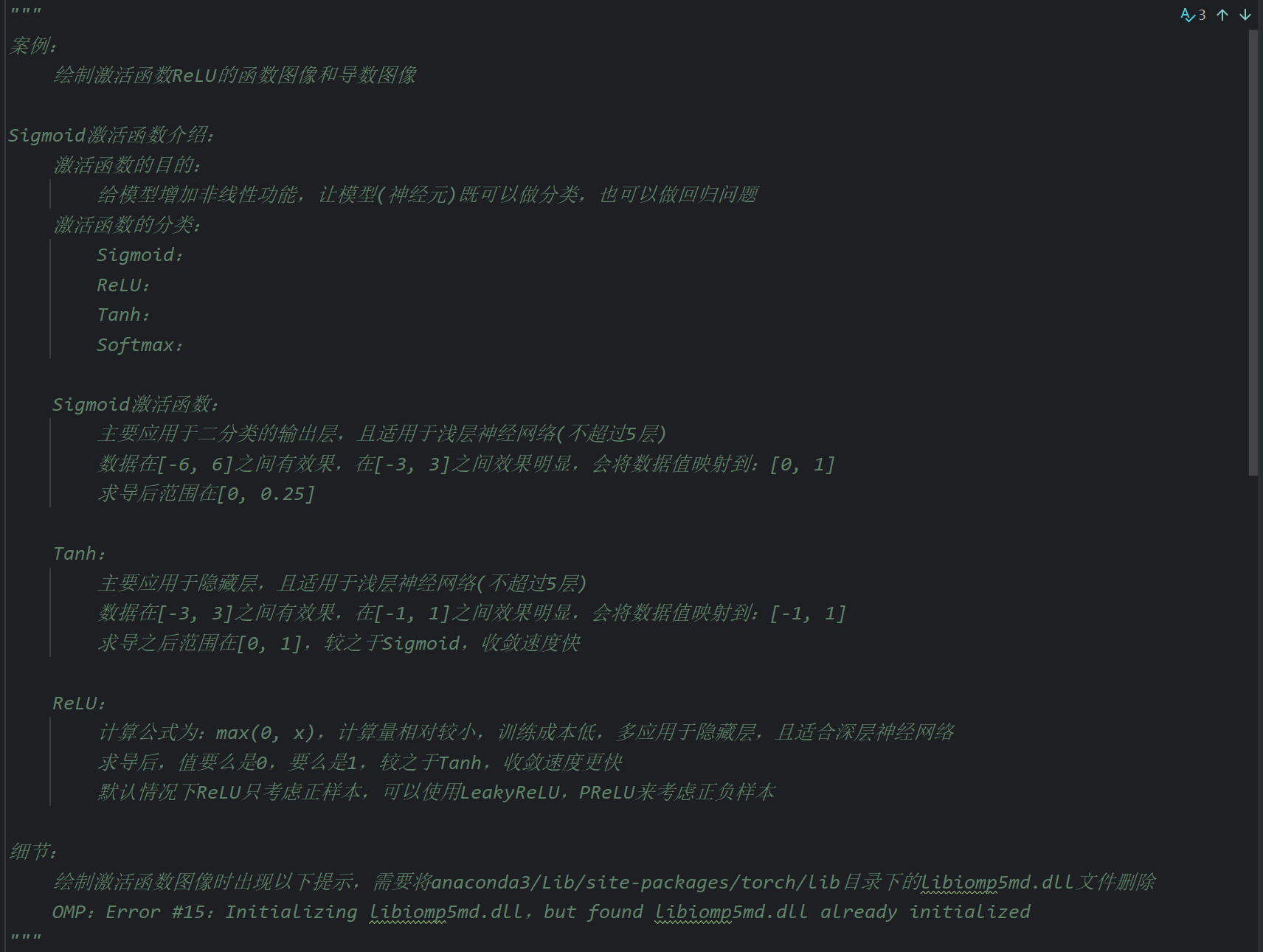

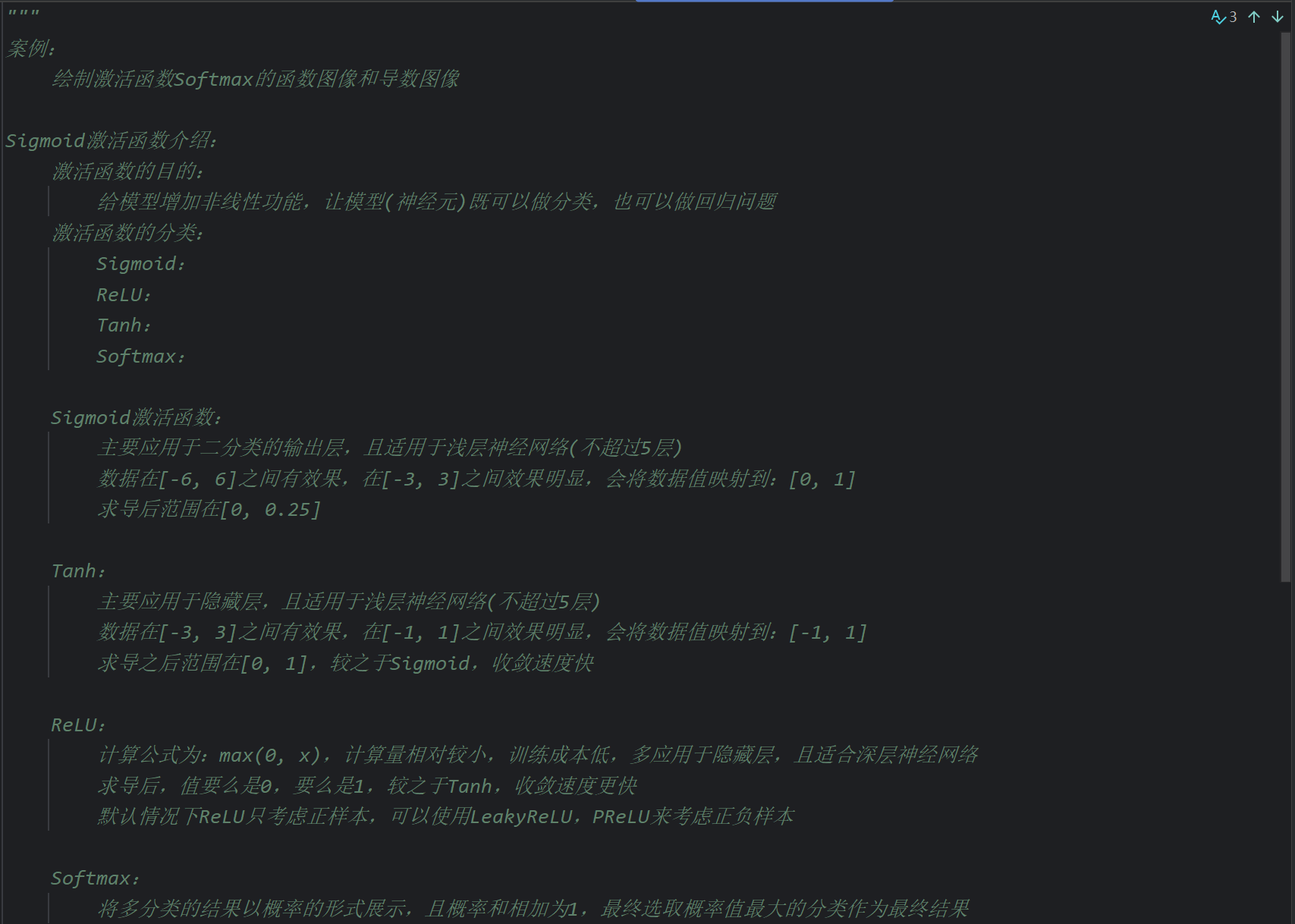

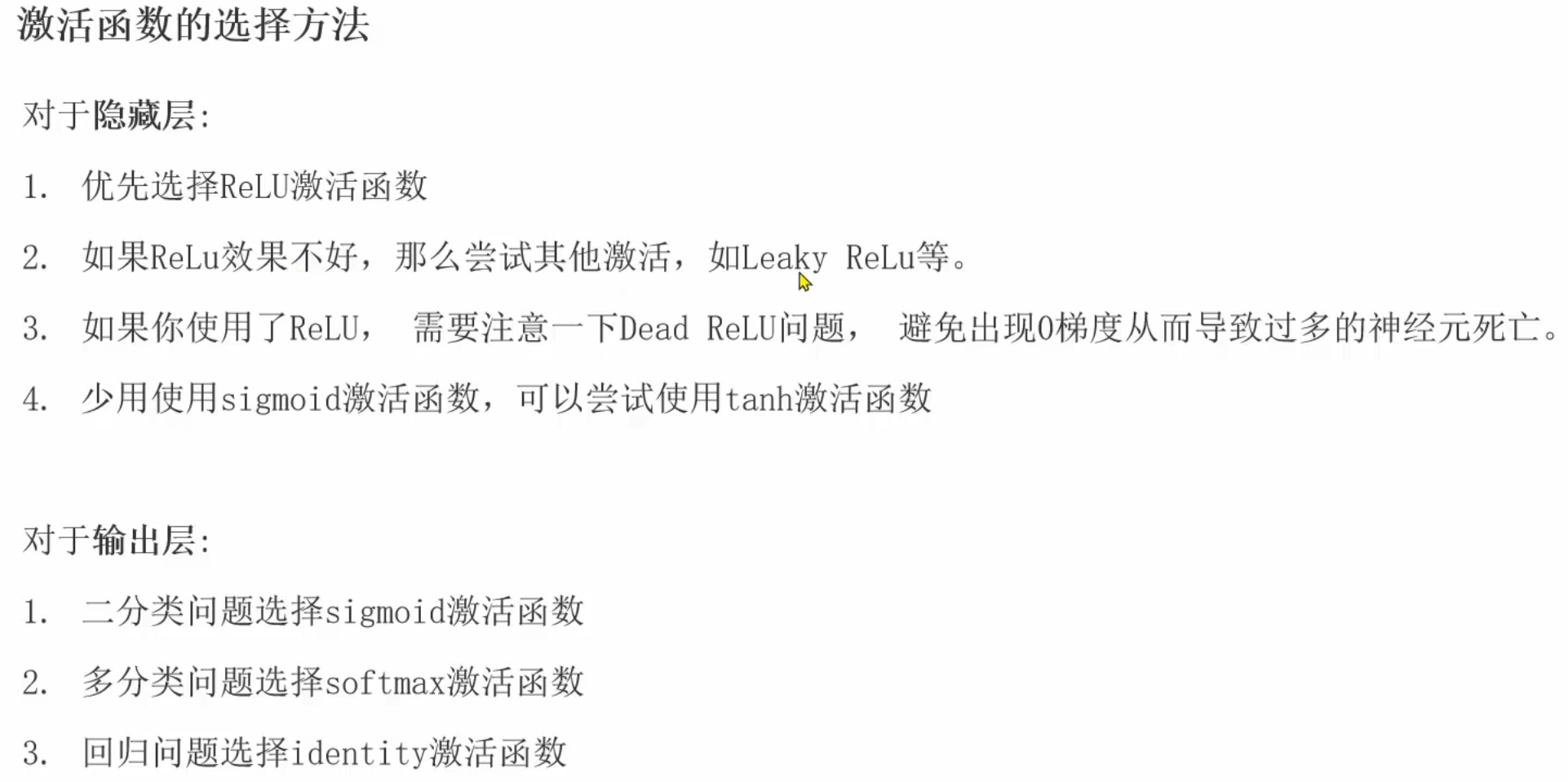

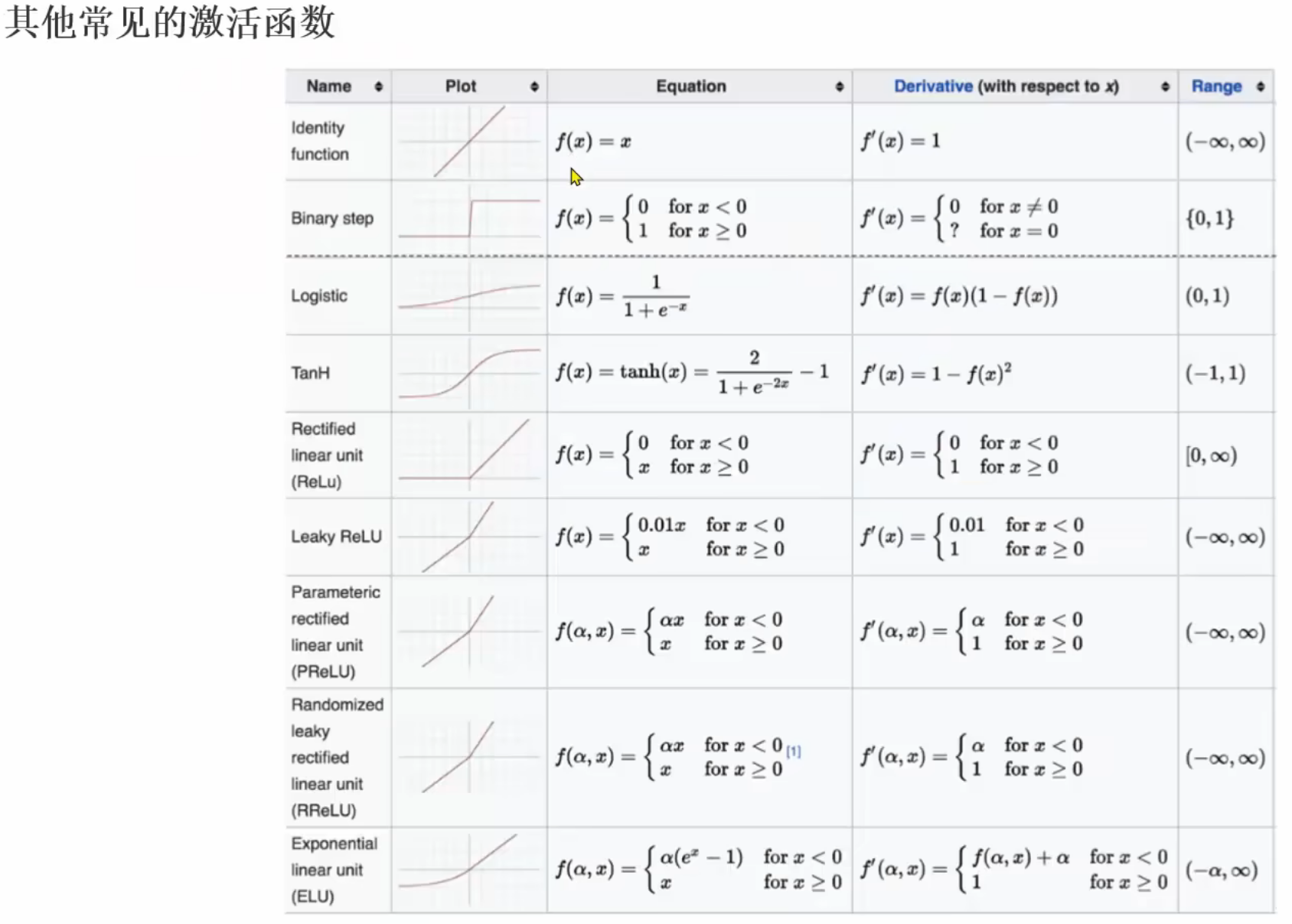

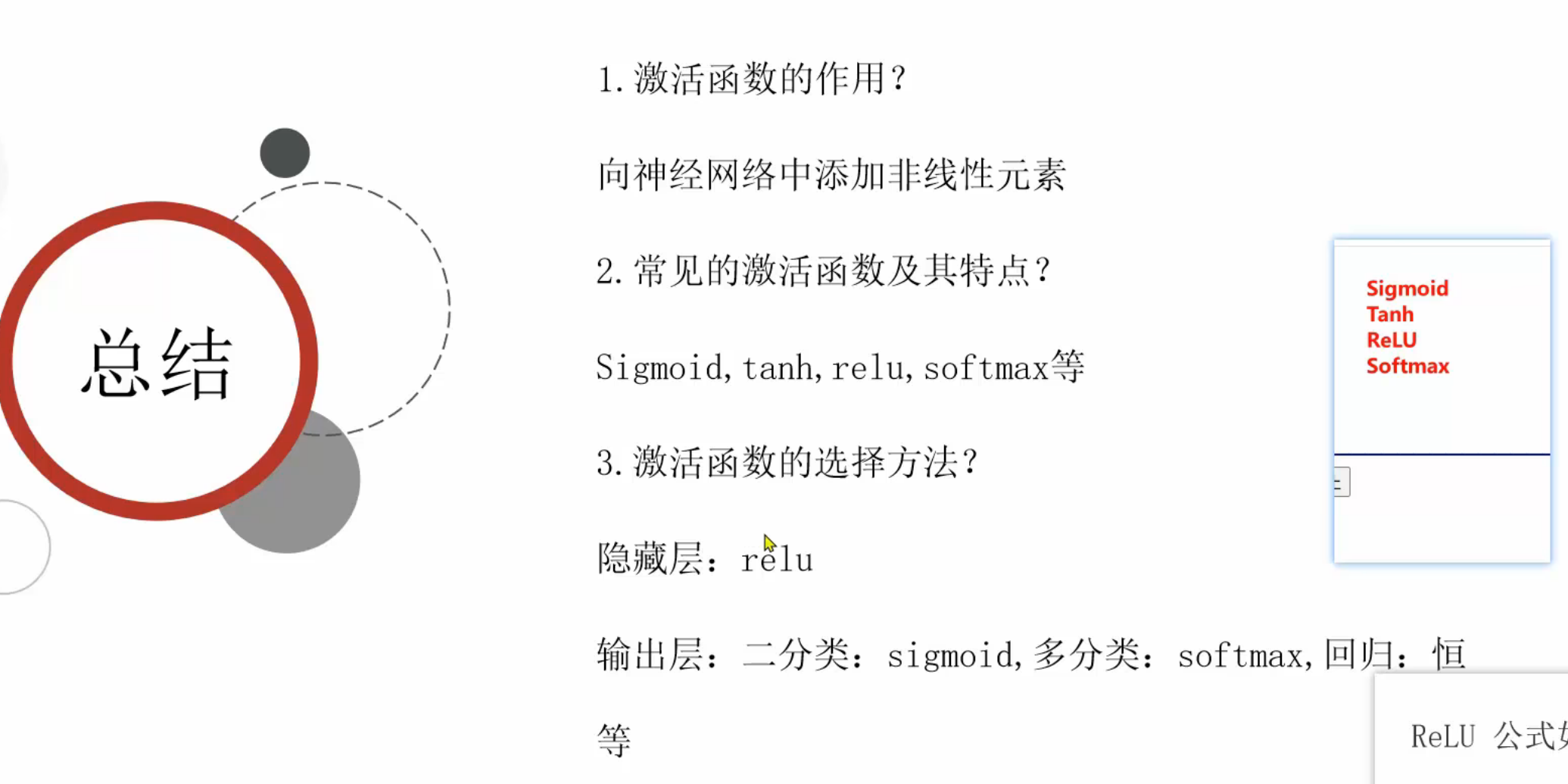

8、激活函数介绍

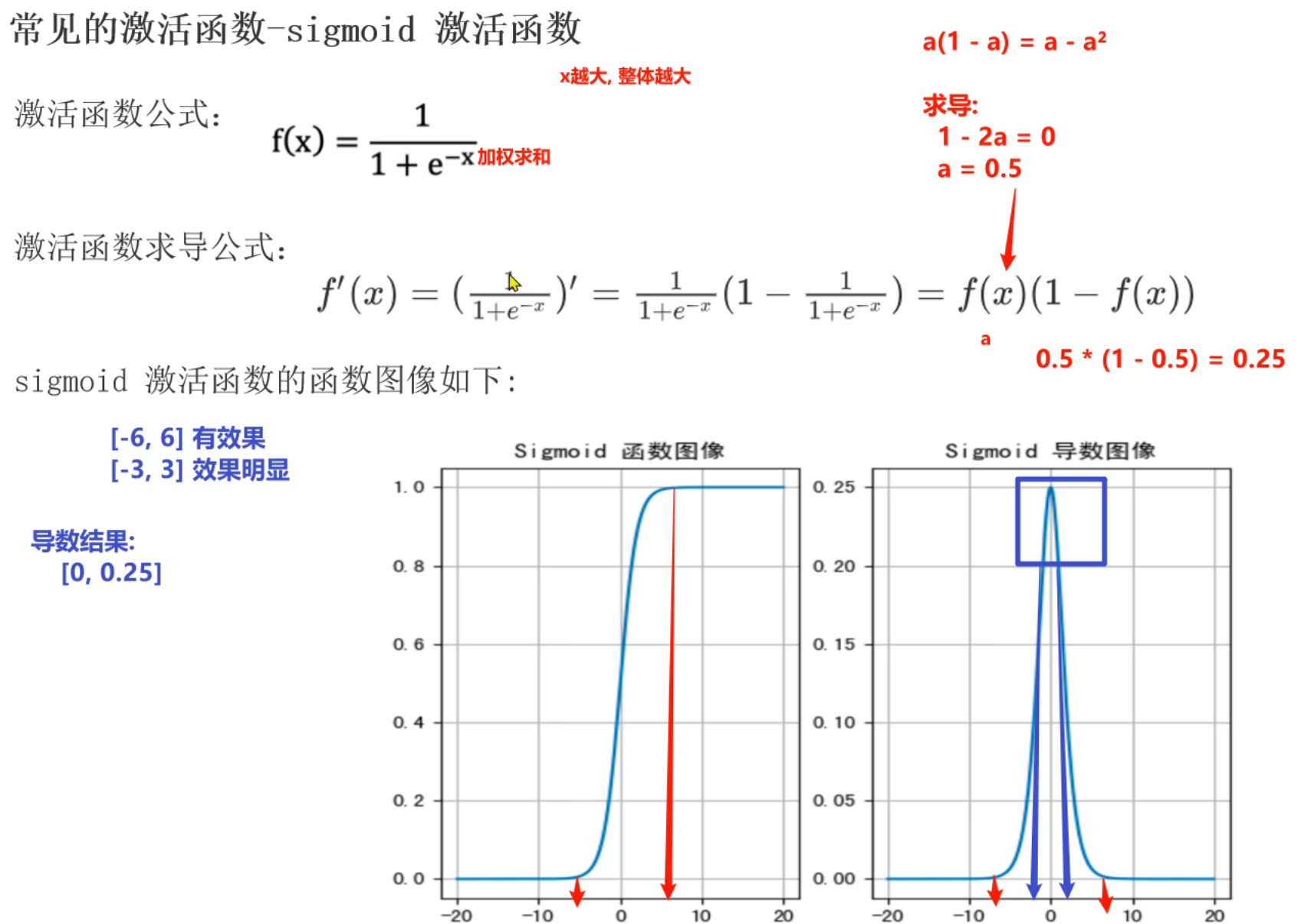

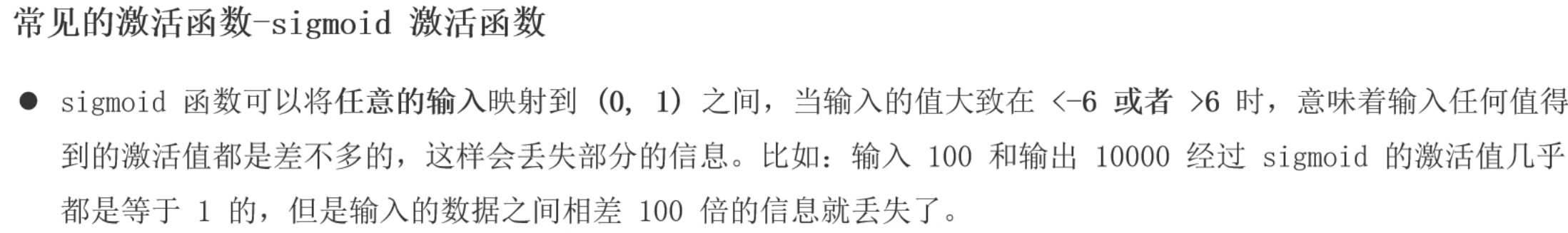

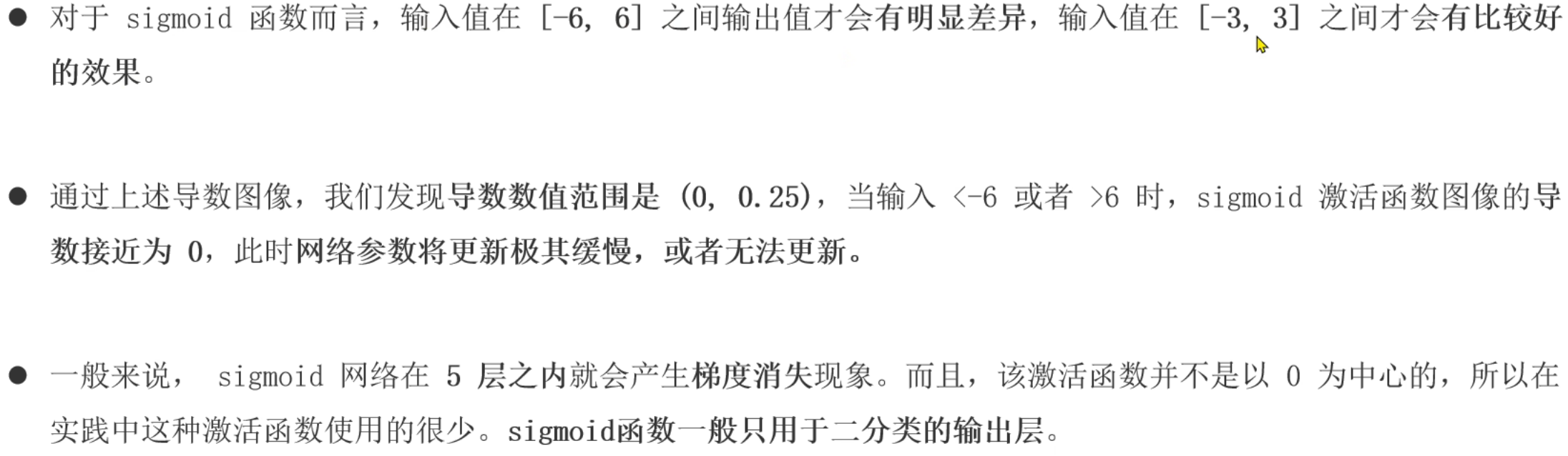

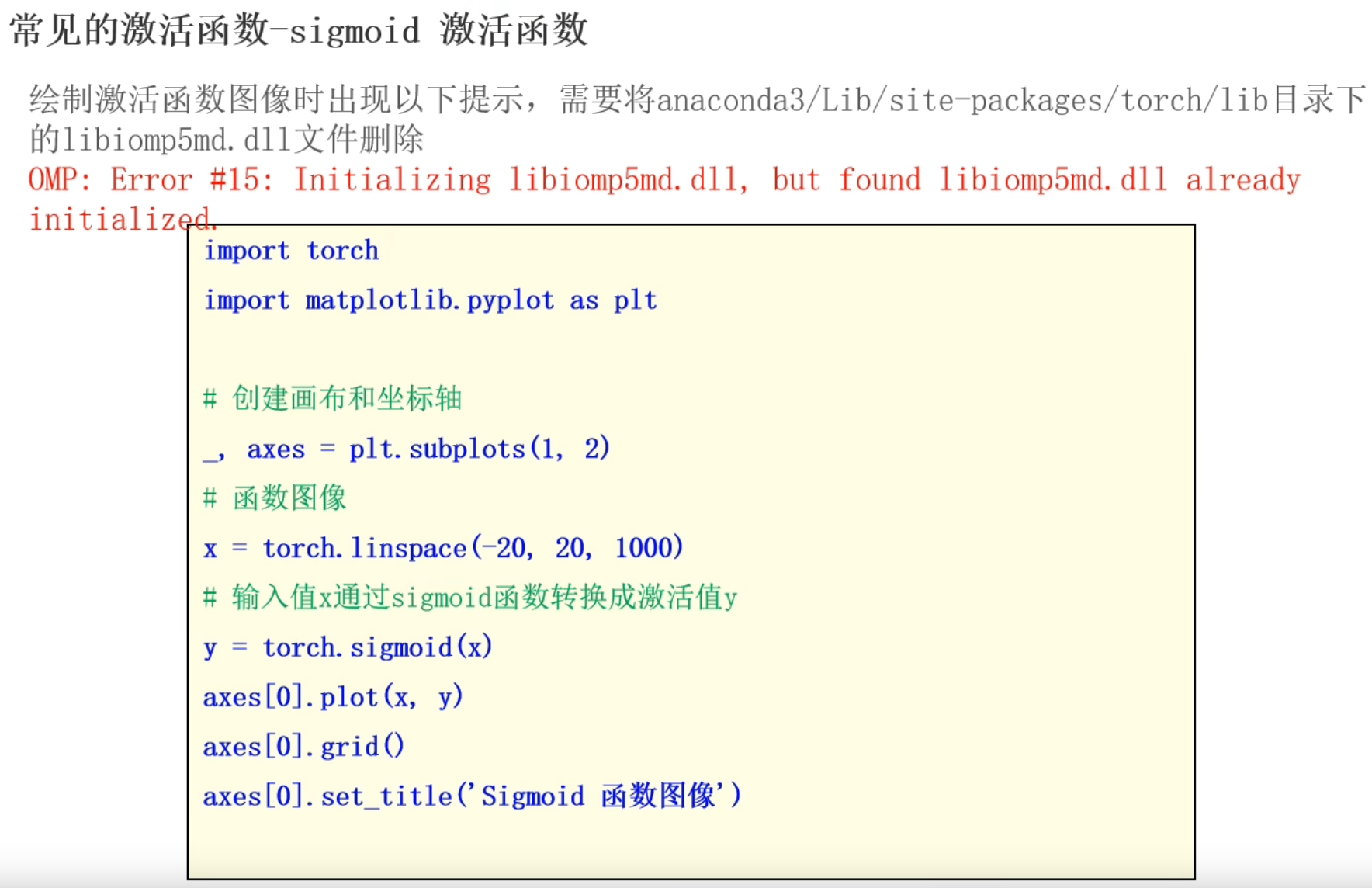

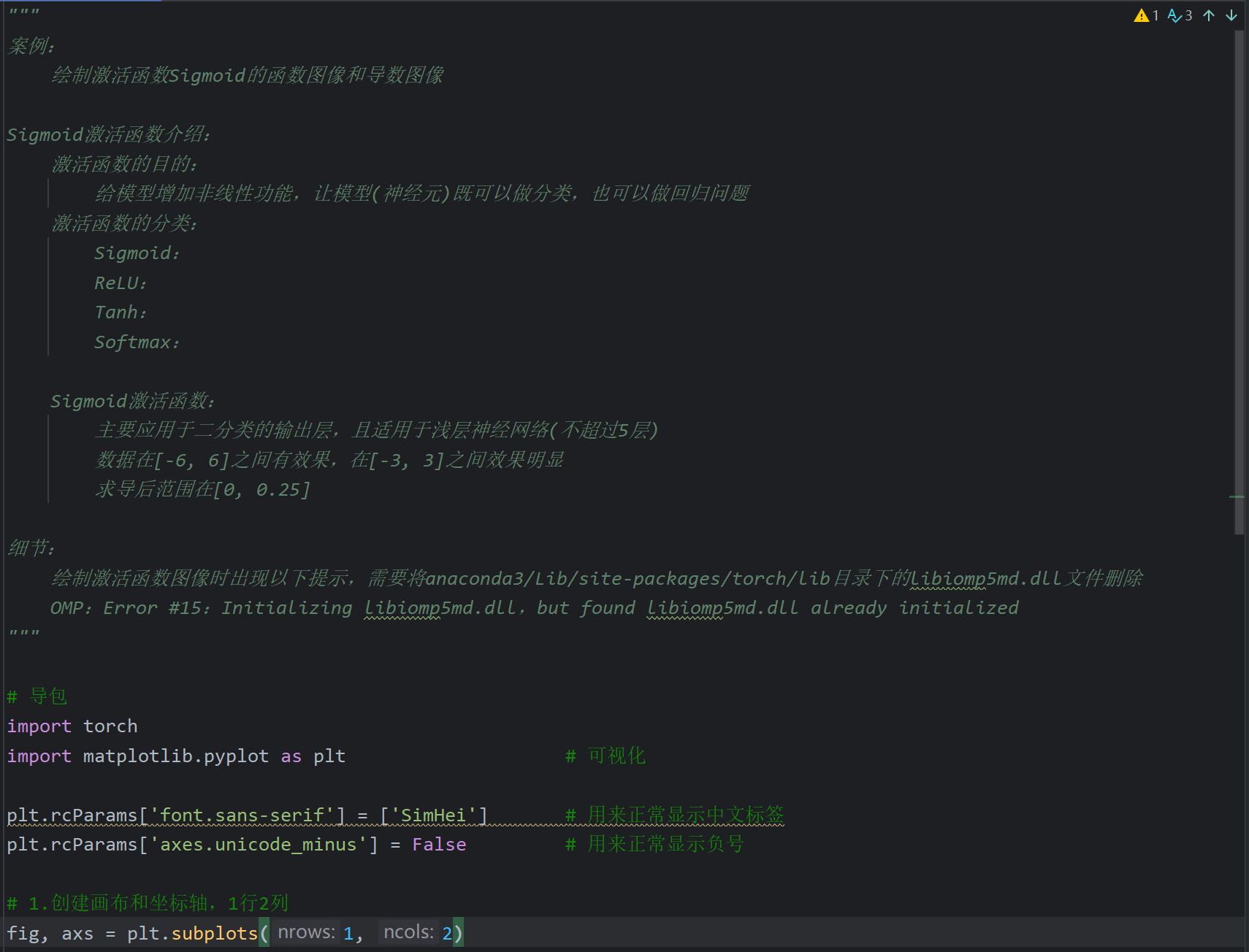

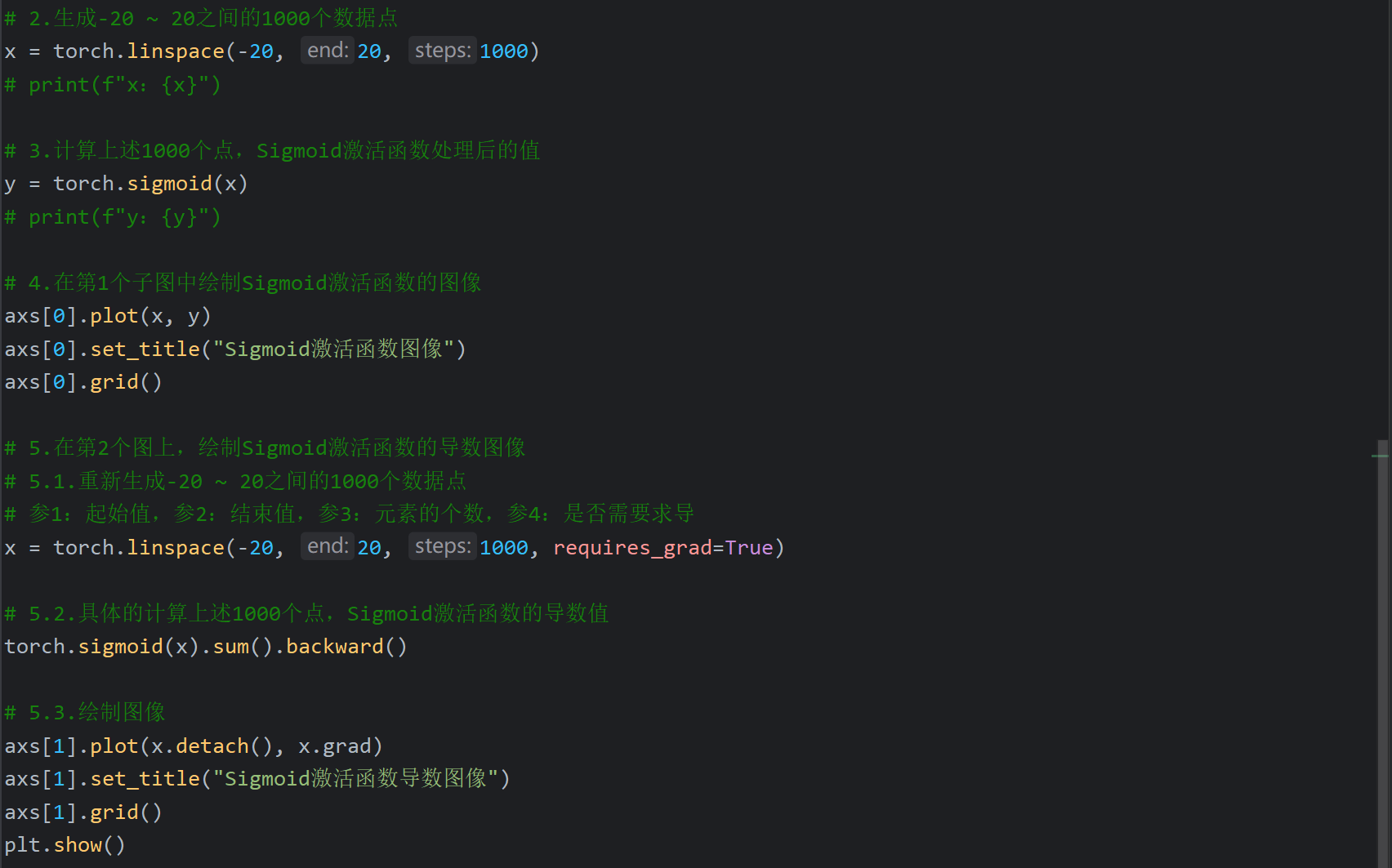

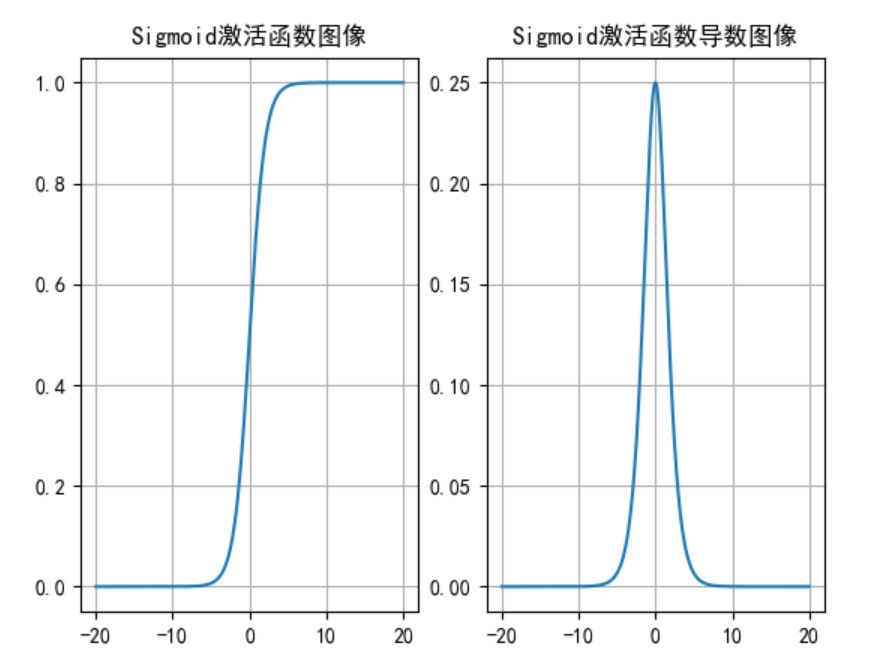

9、Sigmoid激活函数介绍

这里后续是代码演示但是视频不全,我根据下一个视频中Tanh激活函数的代码返回来敲了一下

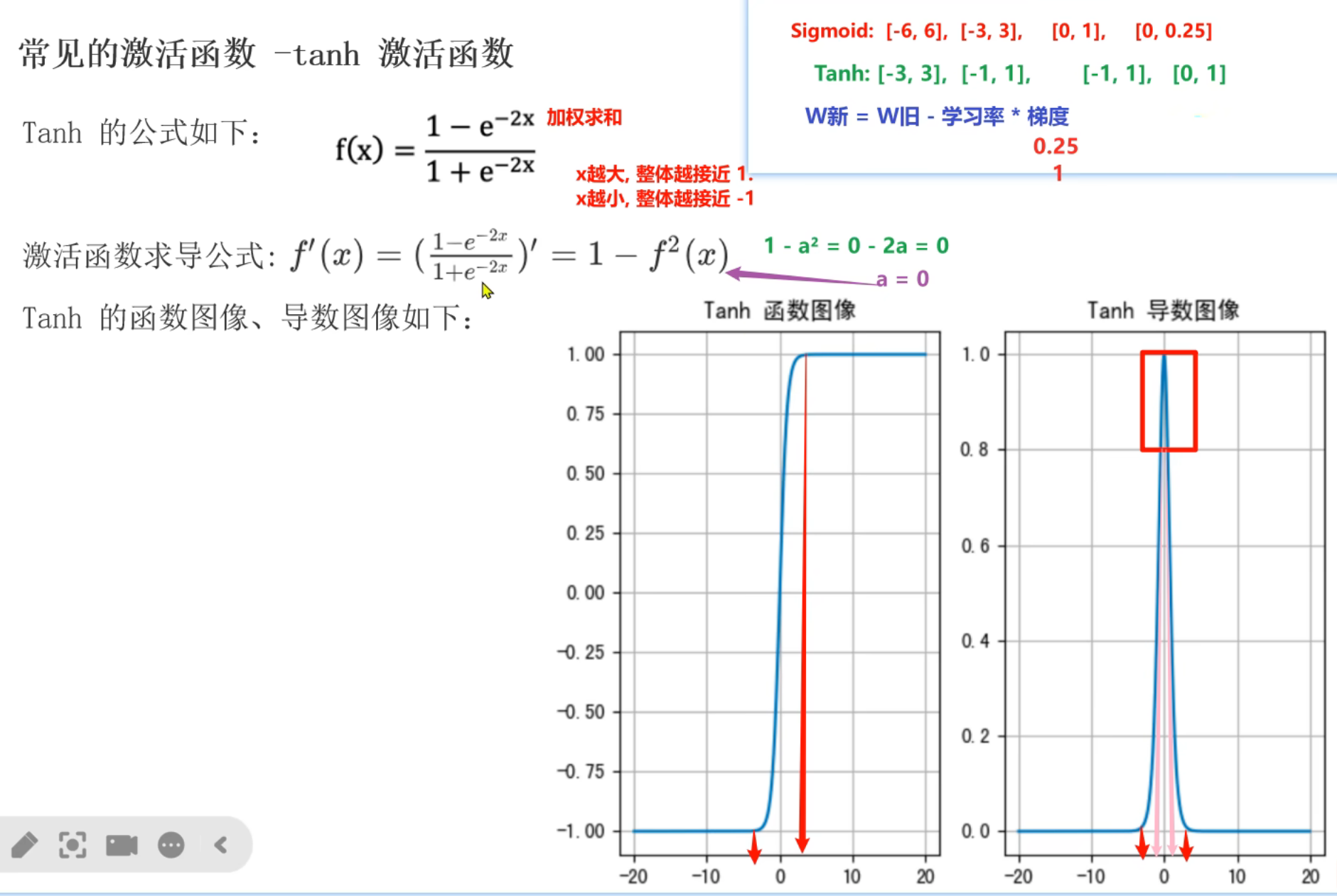

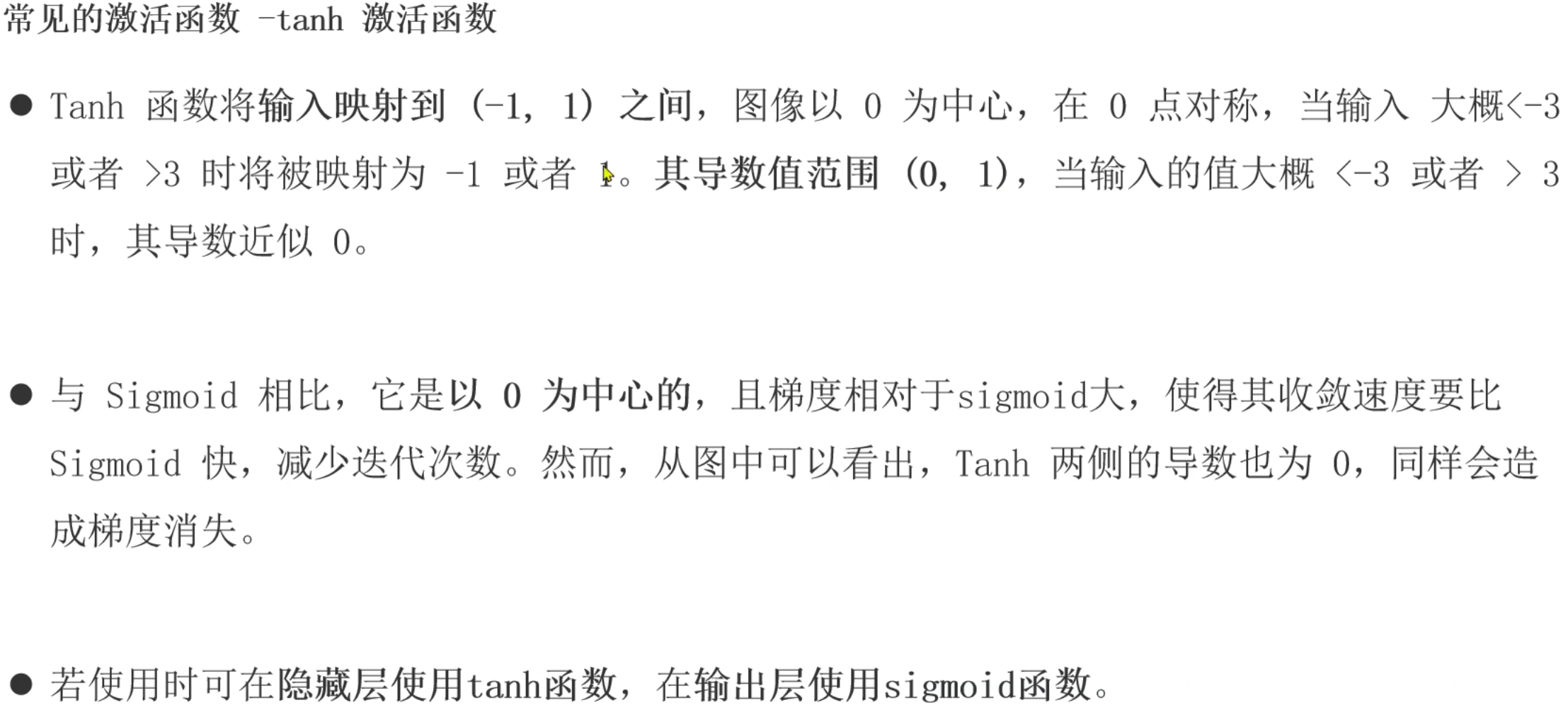

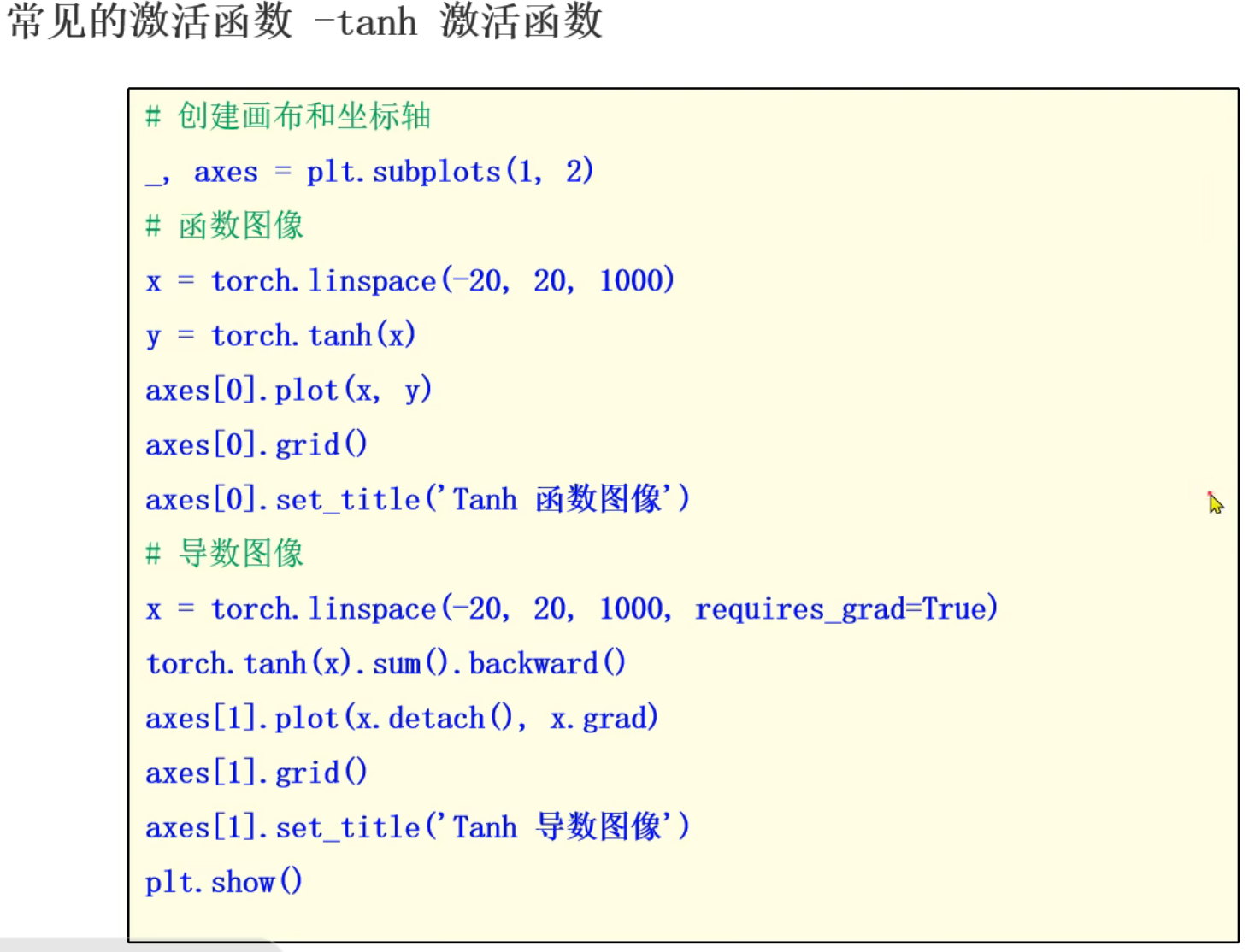

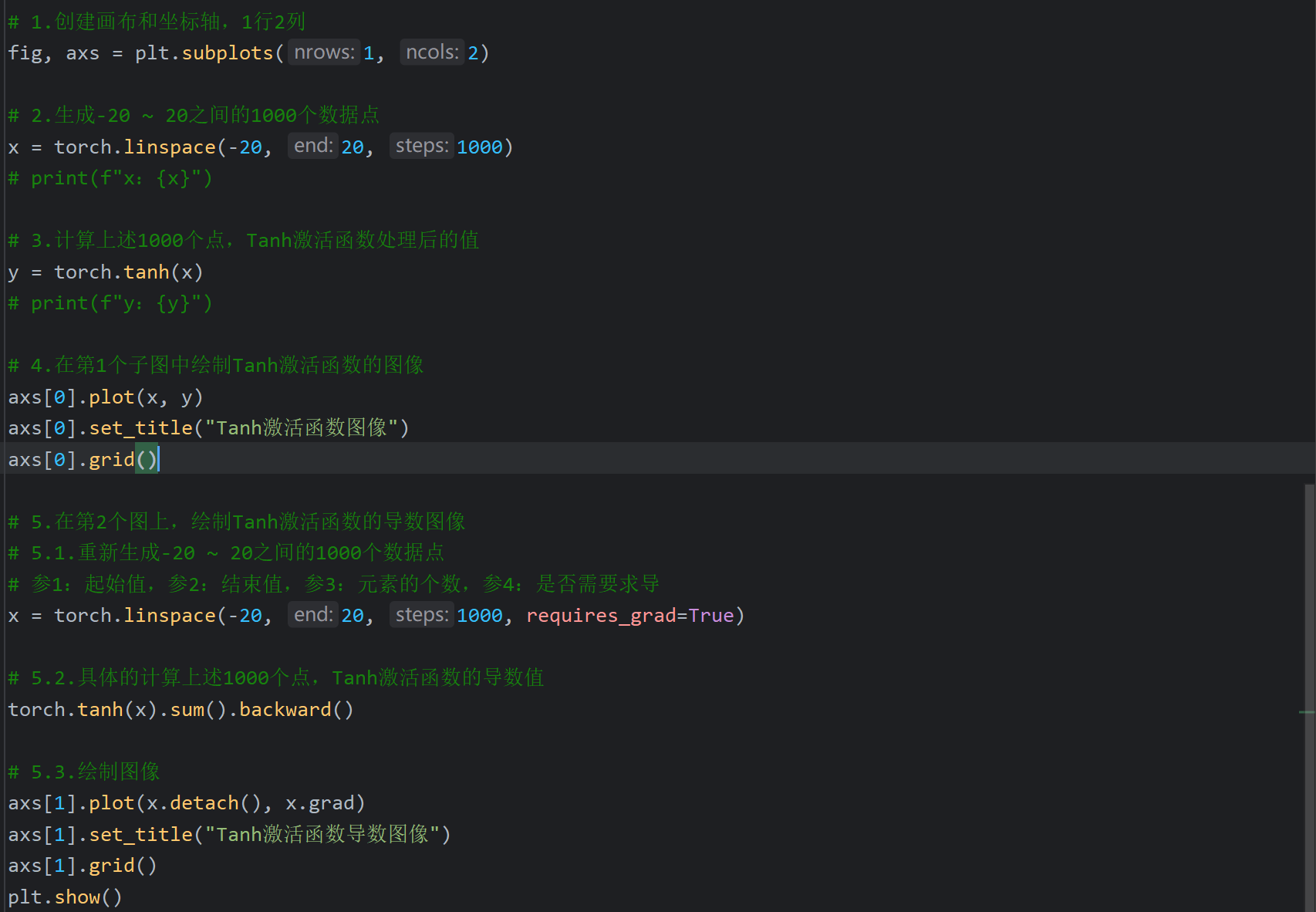

10、Tanh激活函数介绍

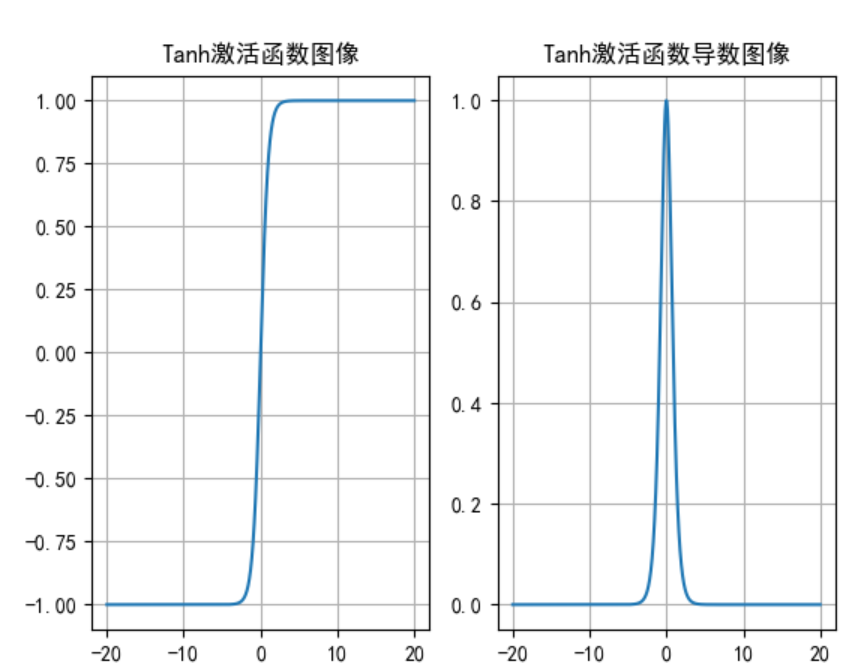

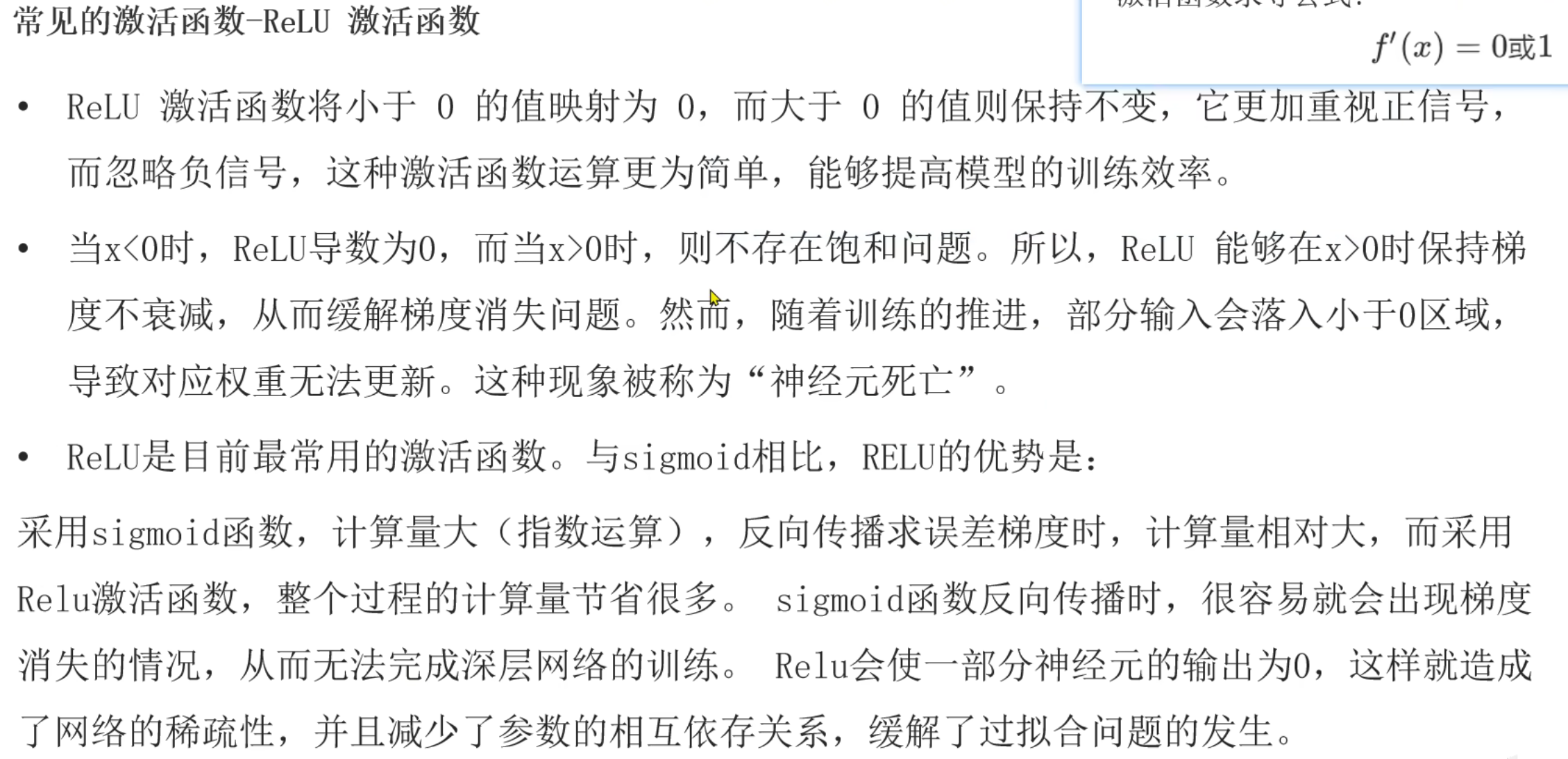

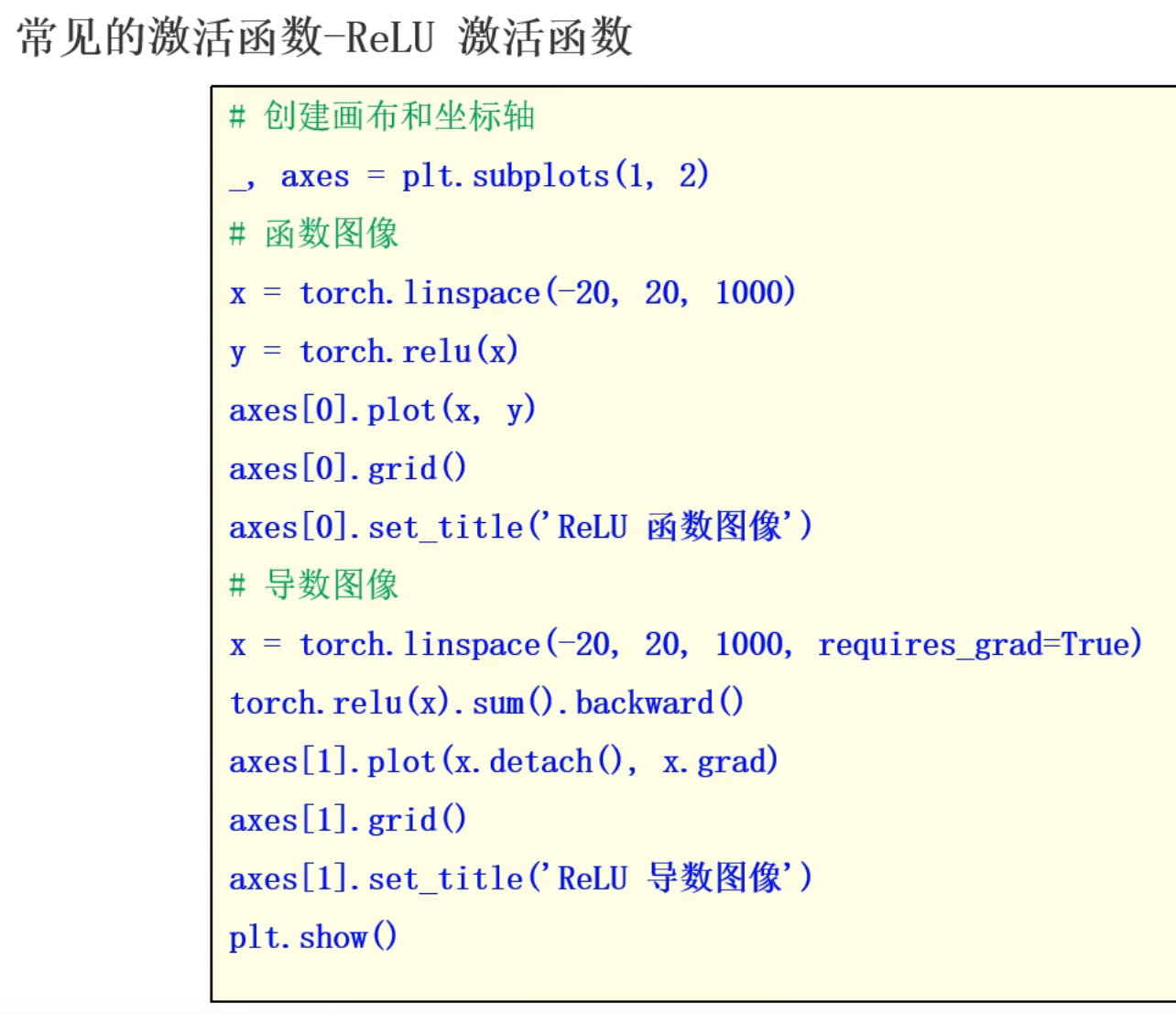

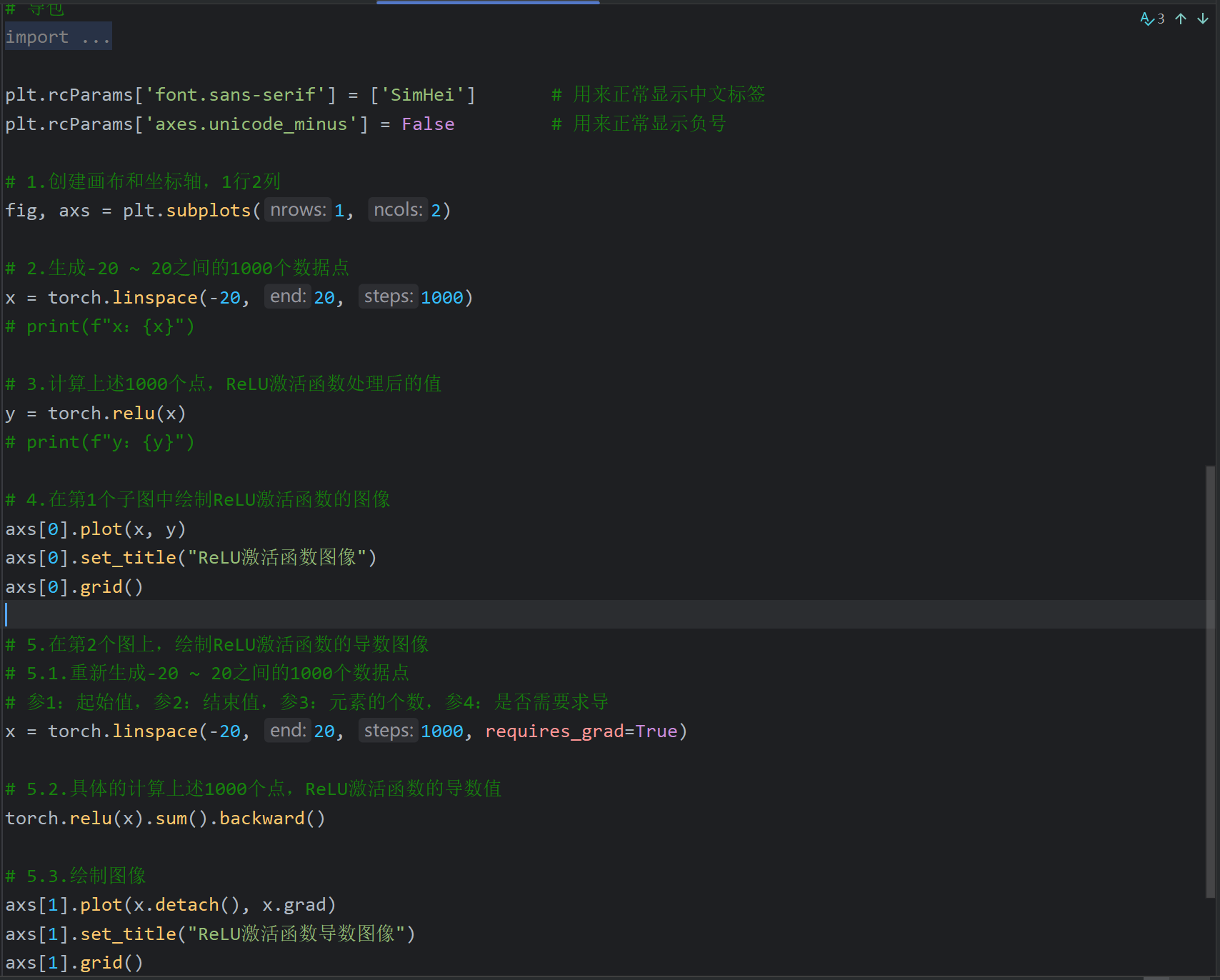

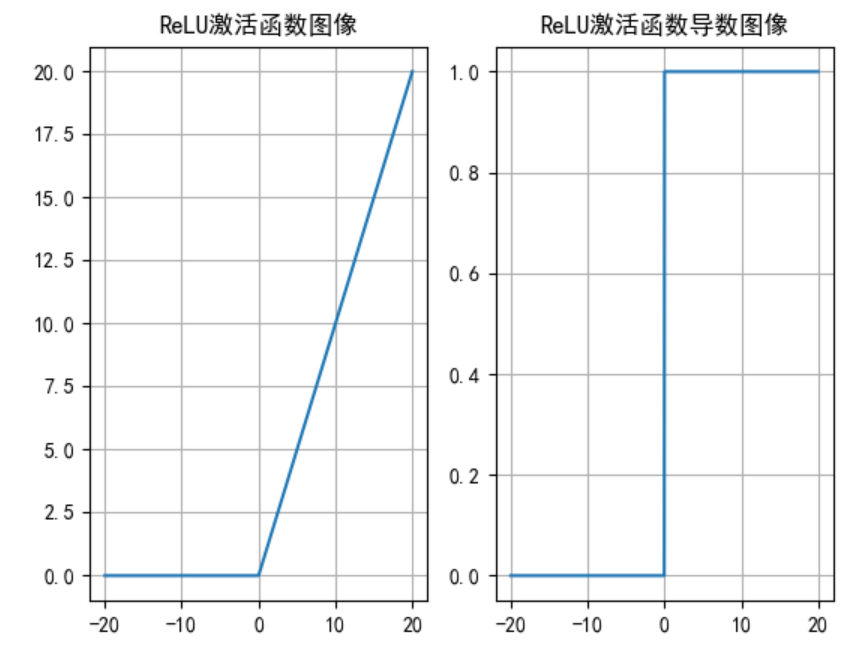

11、ReLu激活函数介绍

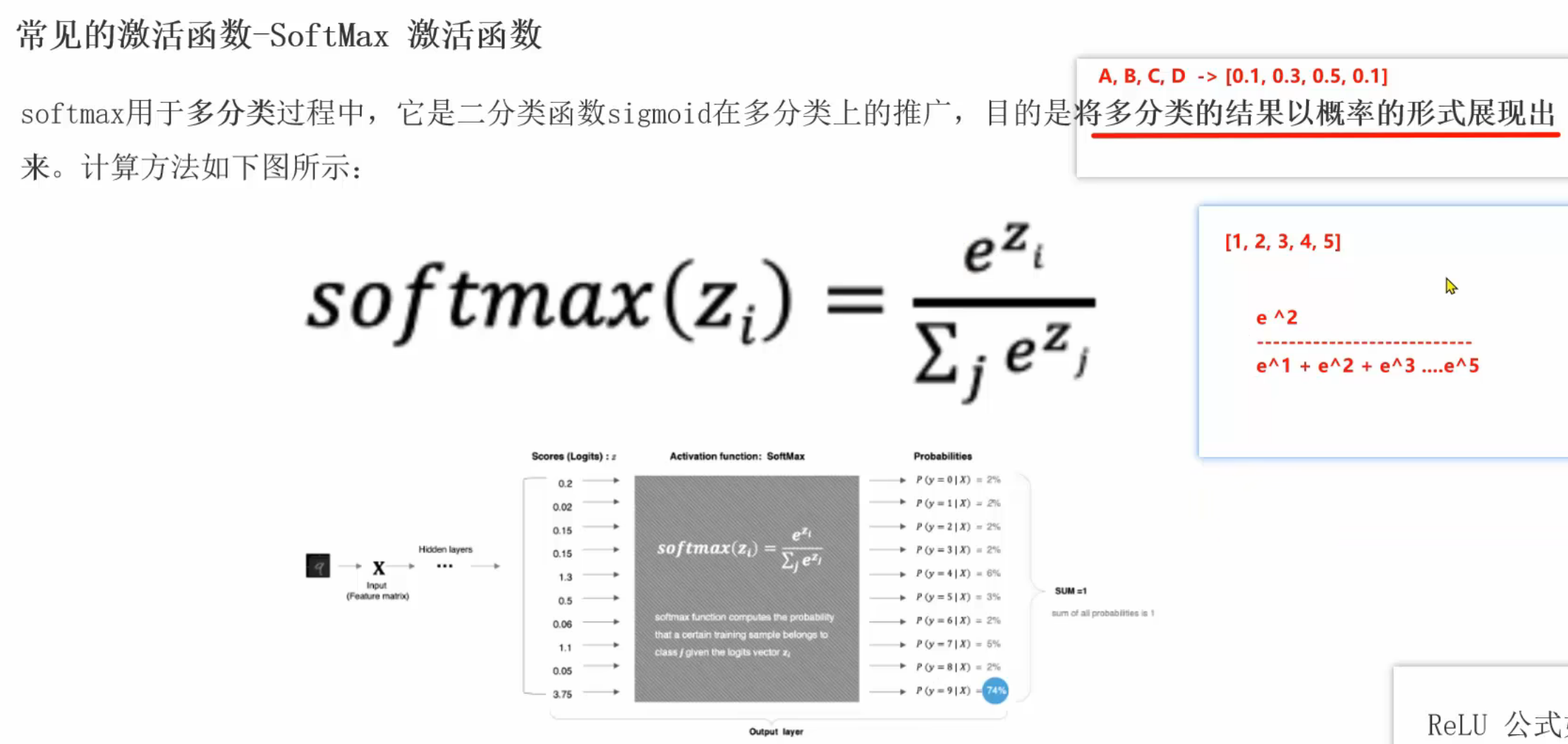

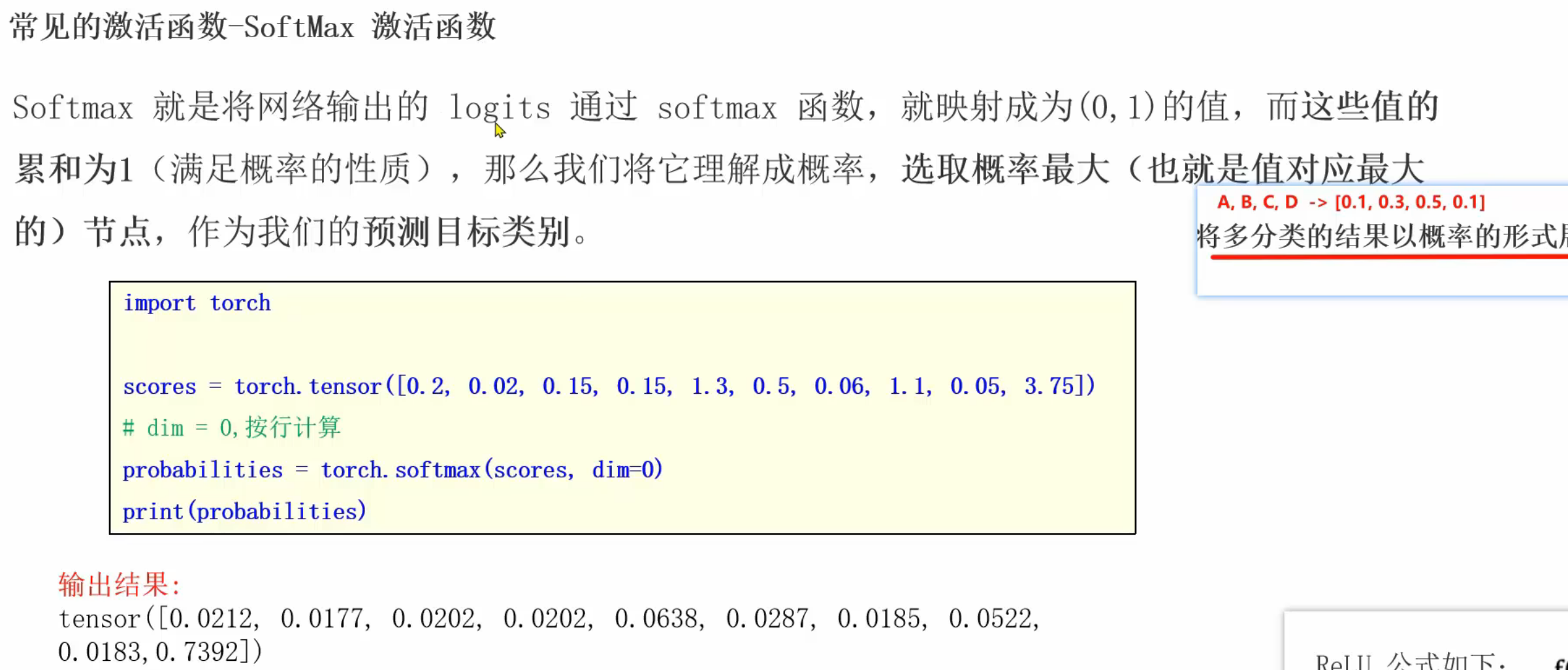

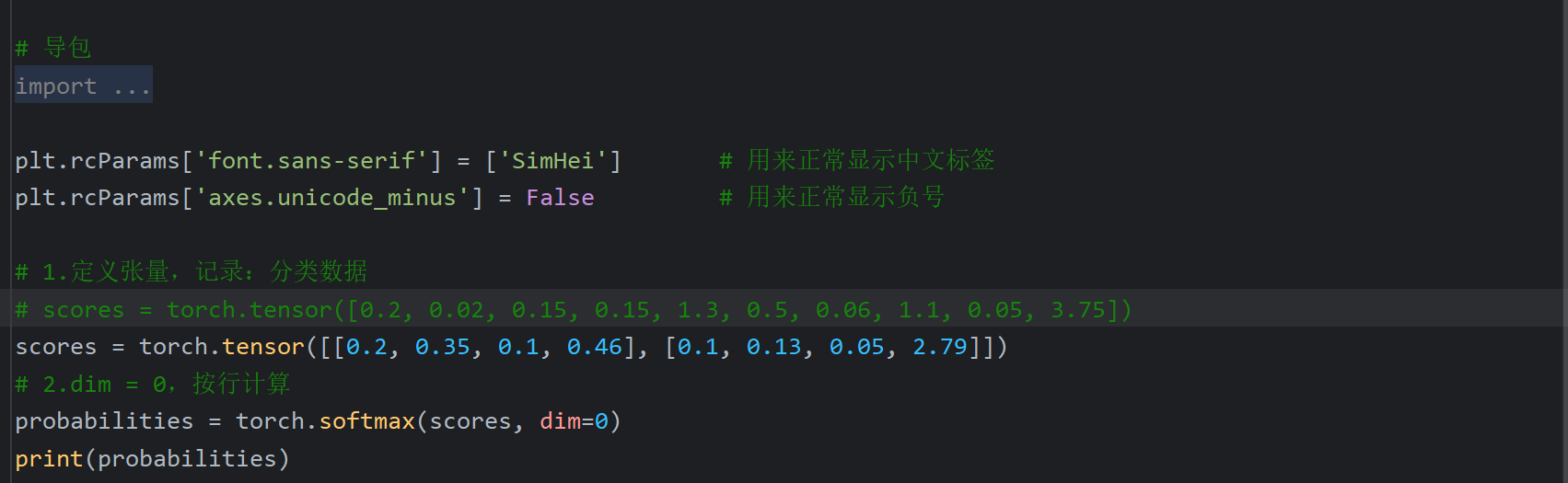

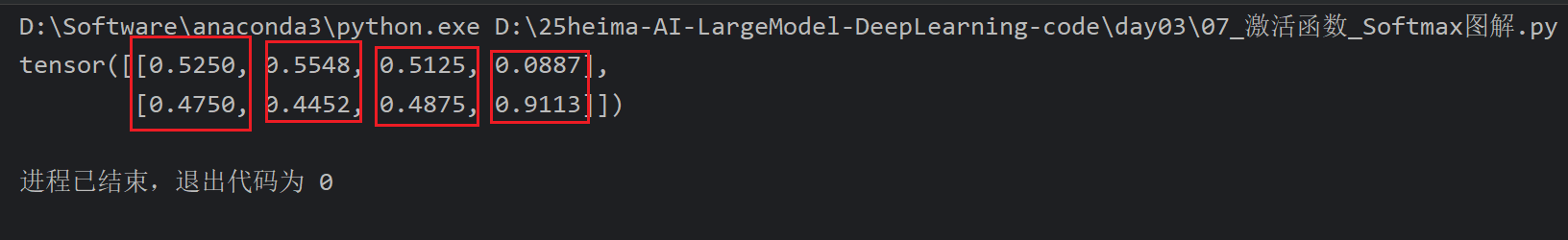

12、Softmax激活函数介绍

五、Day04

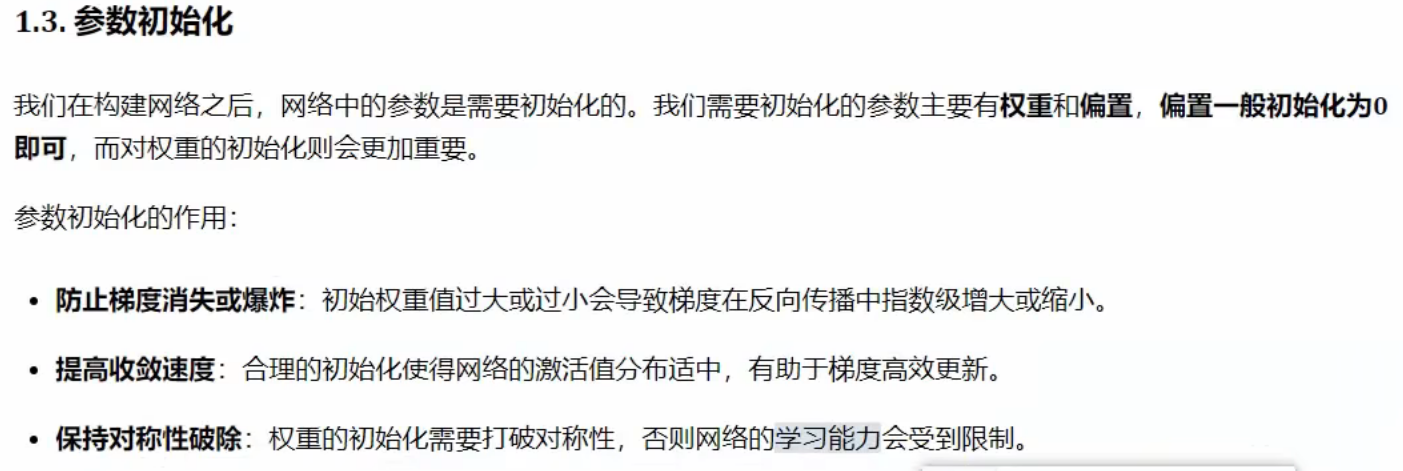

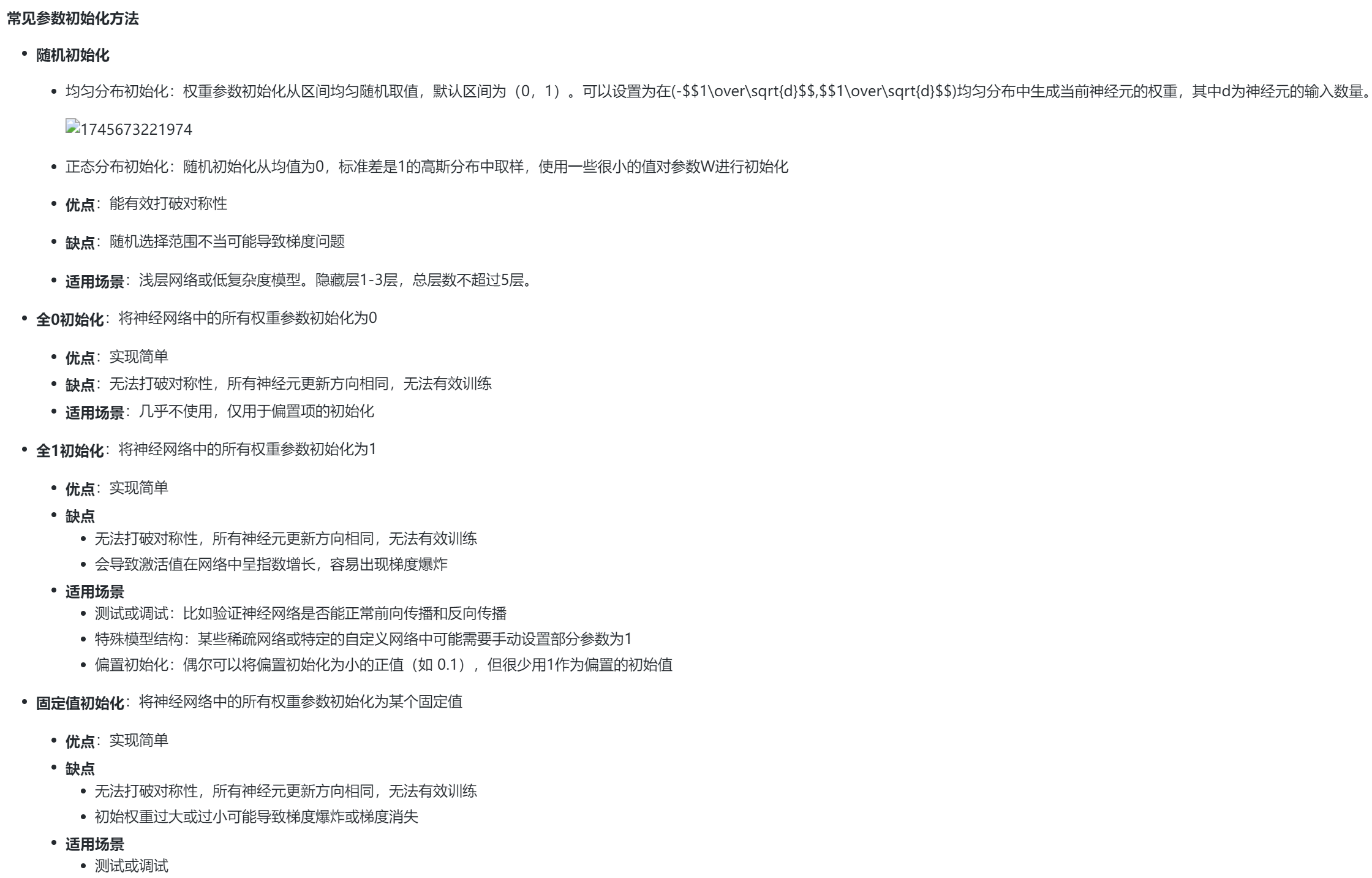

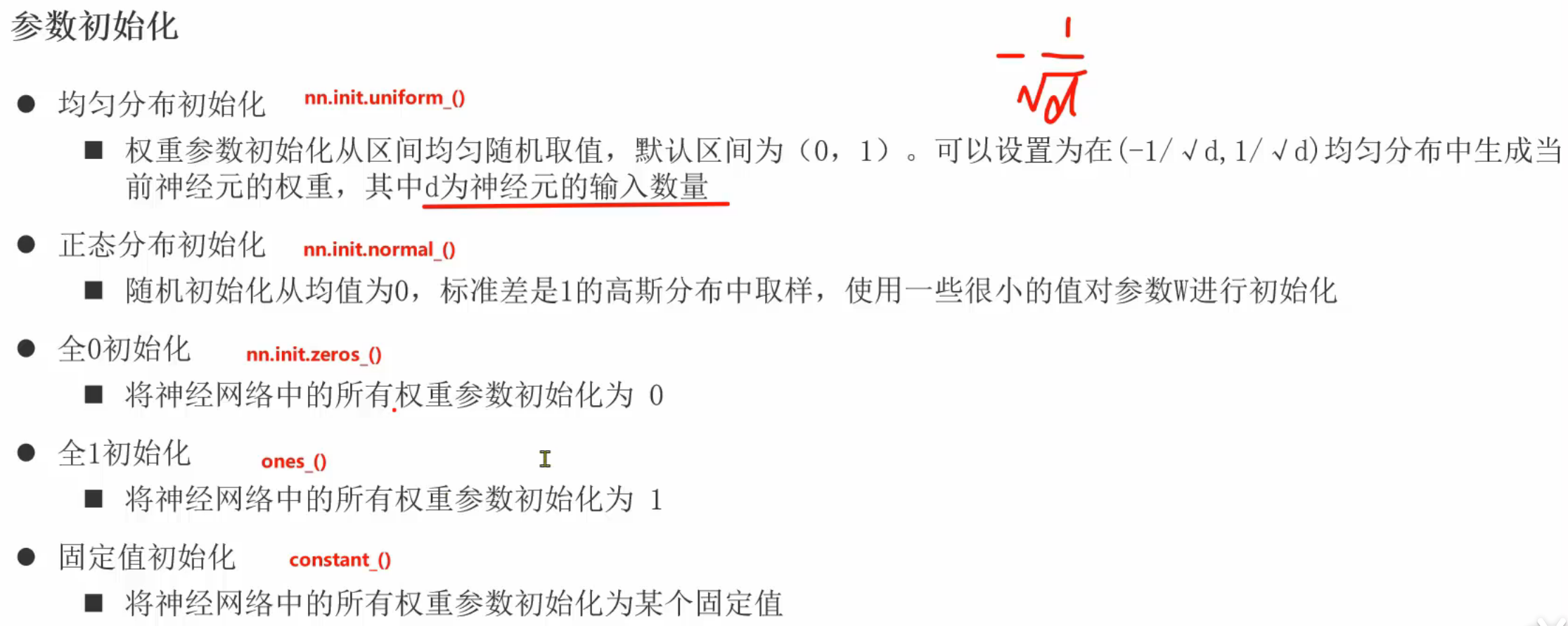

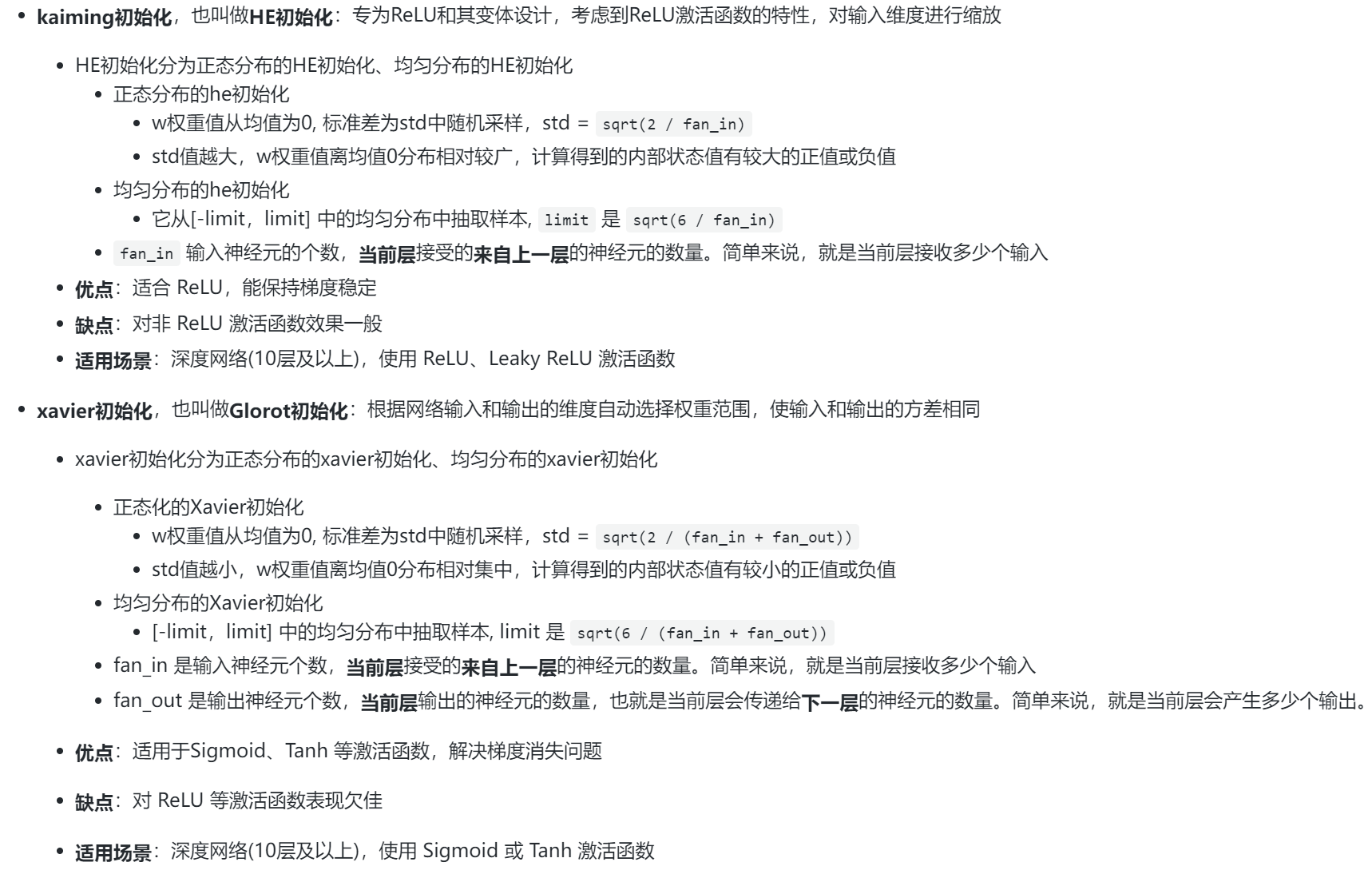

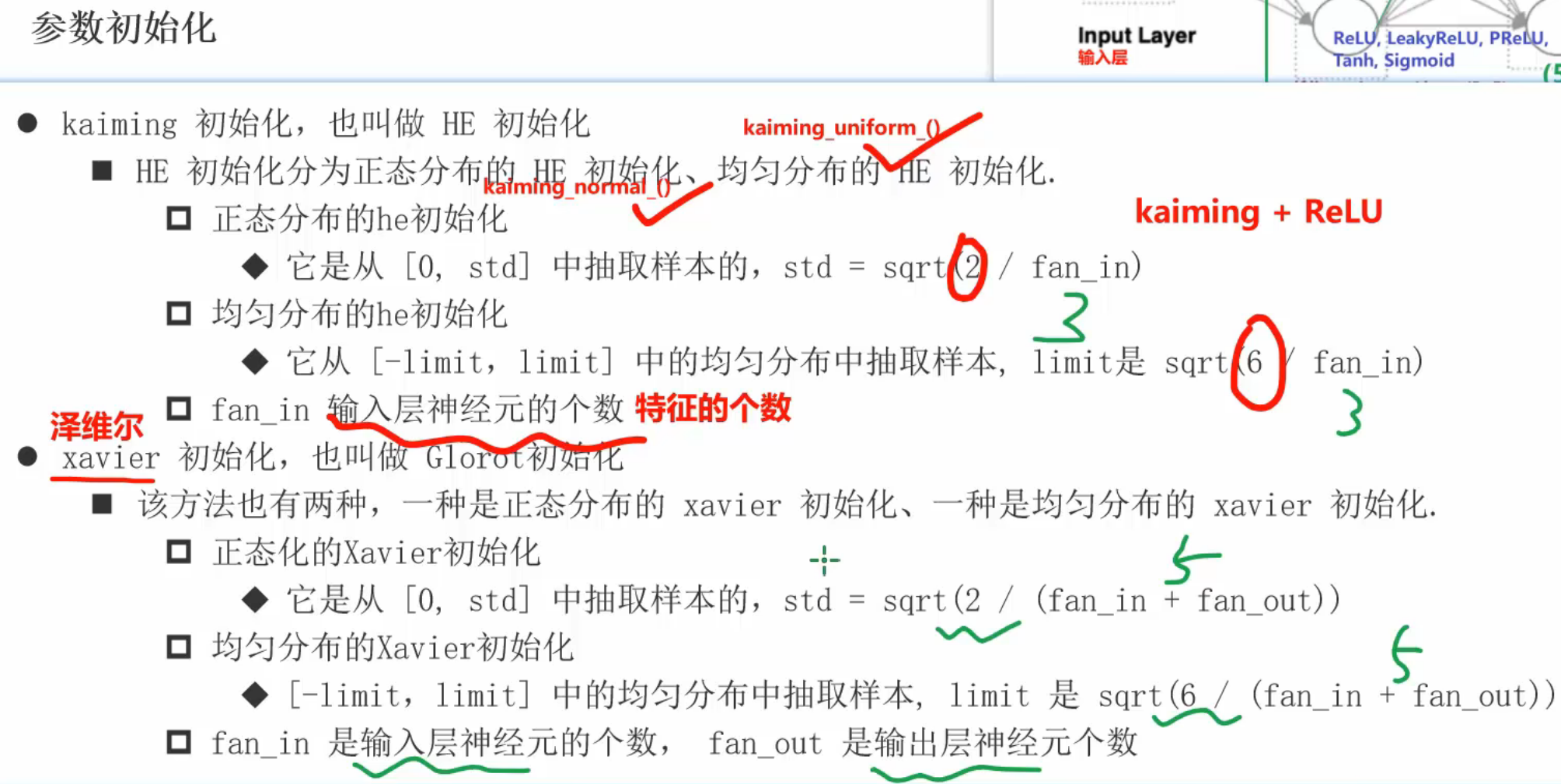

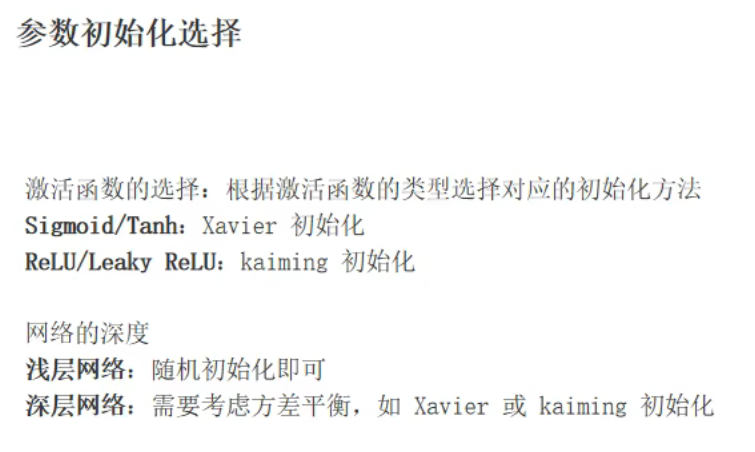

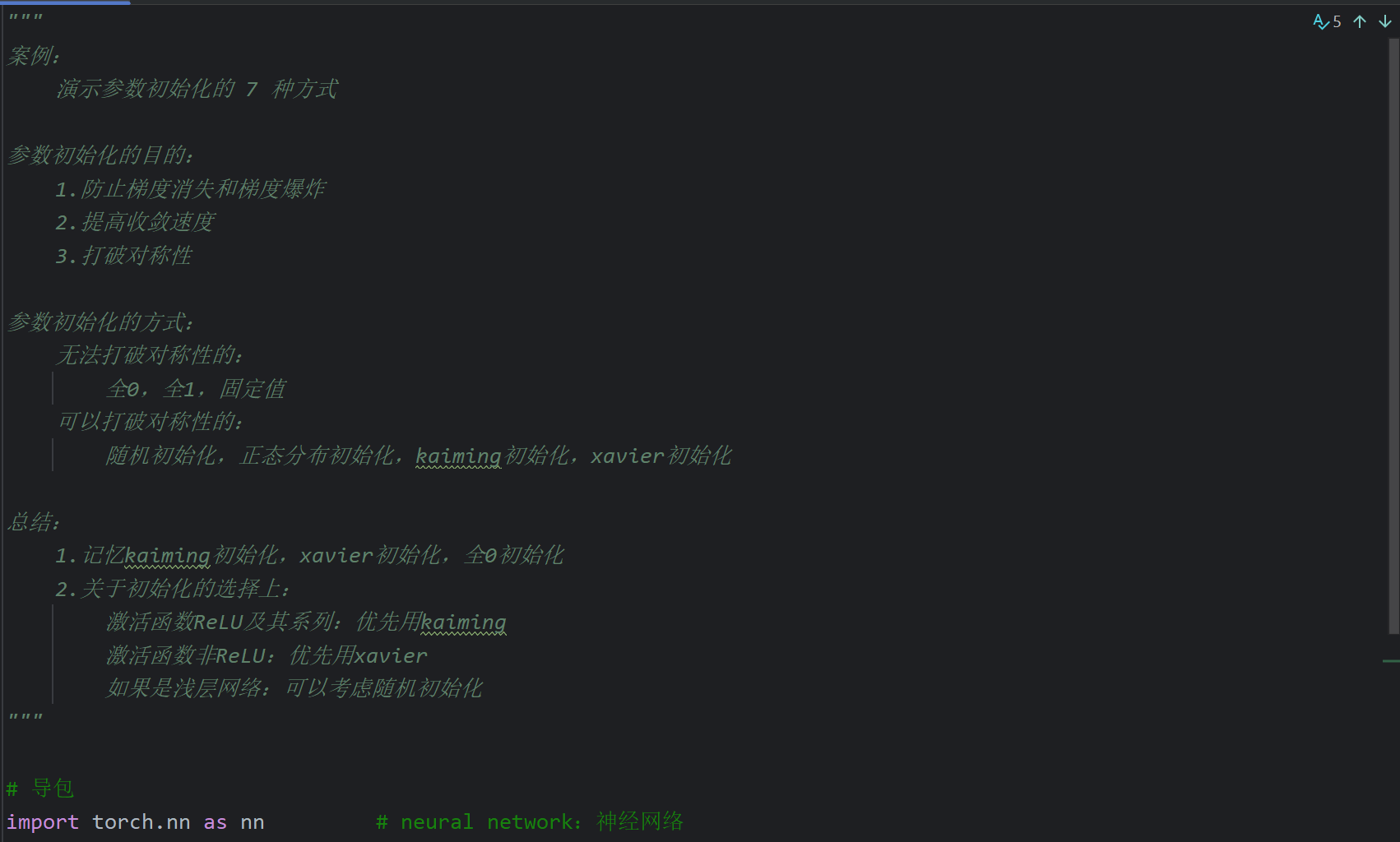

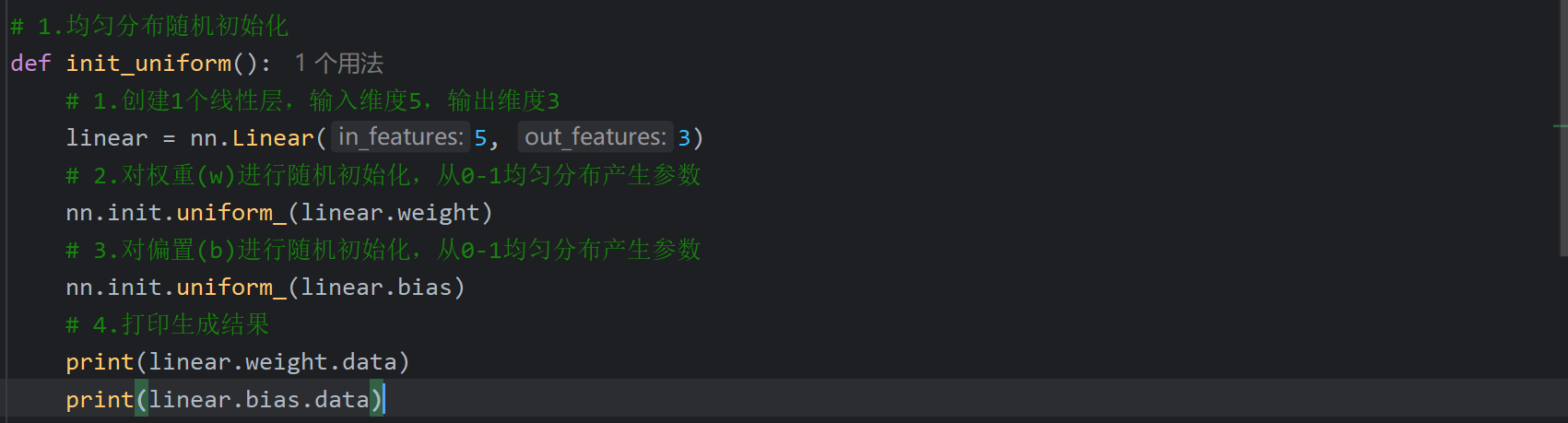

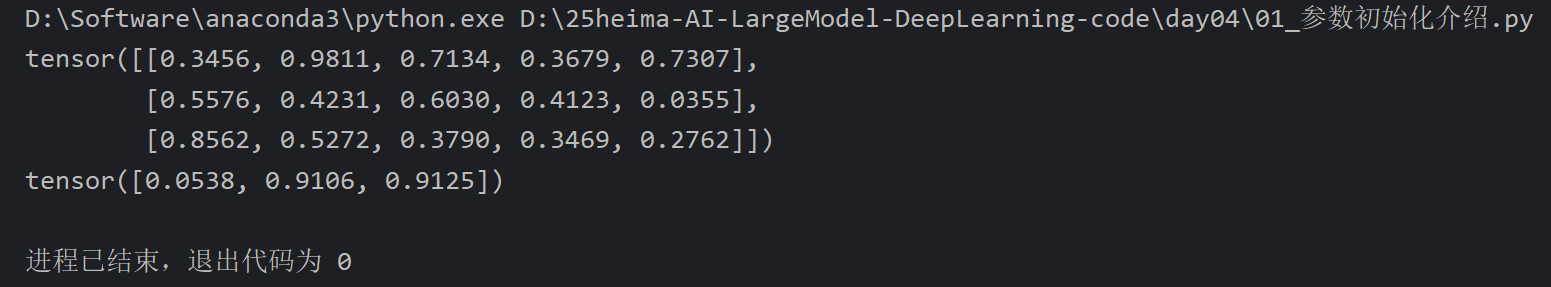

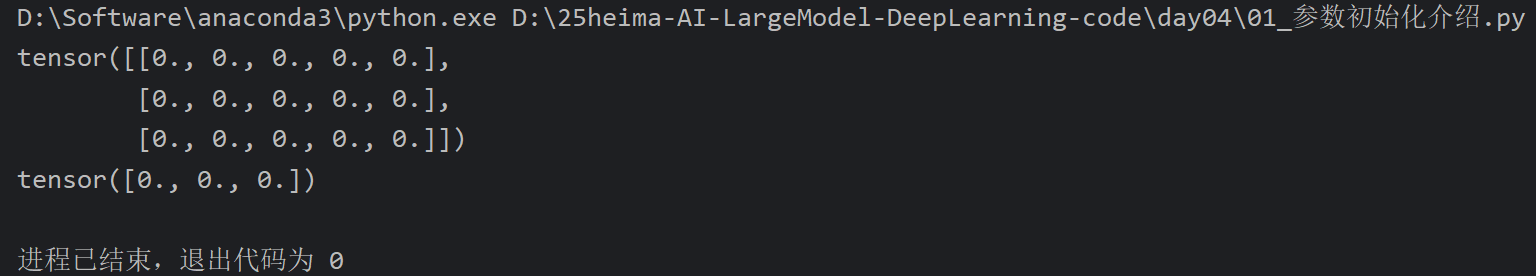

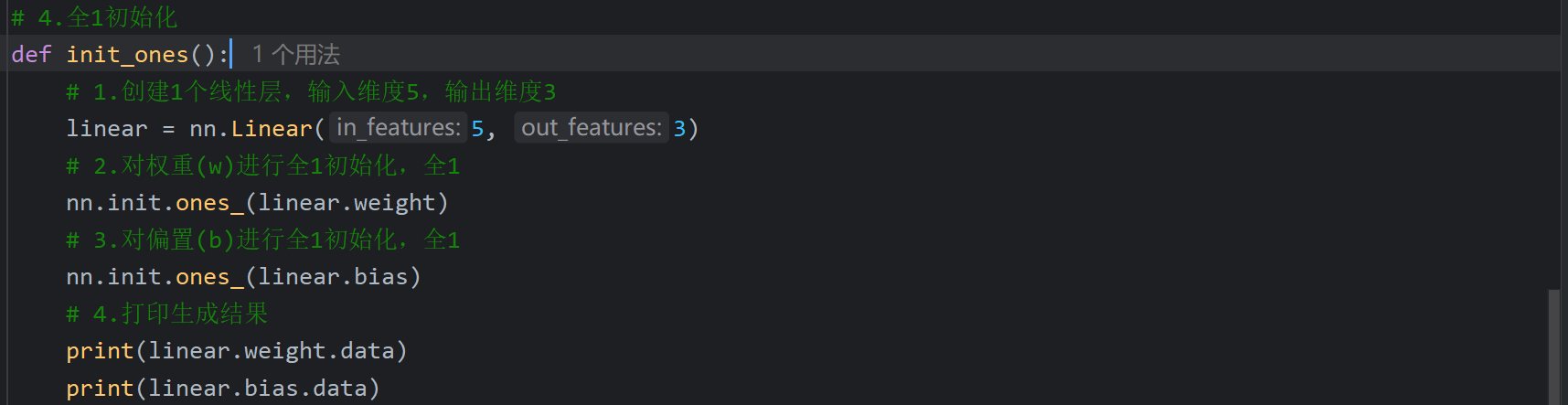

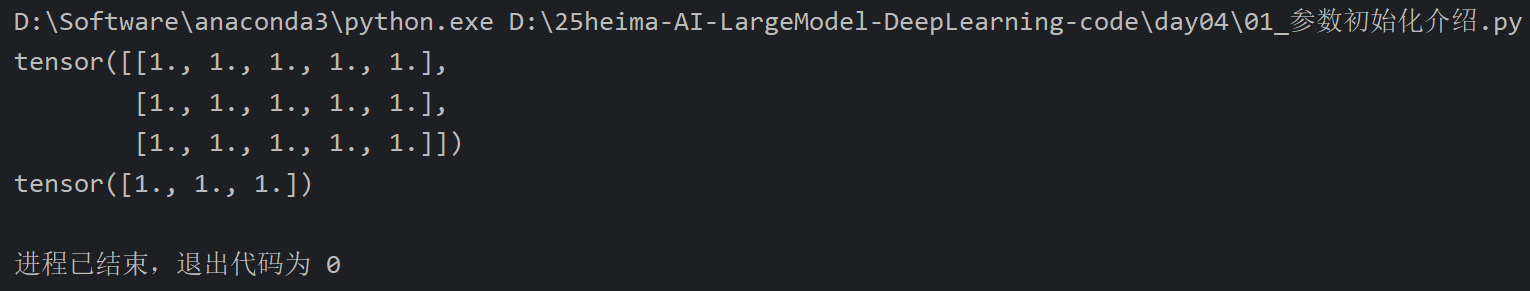

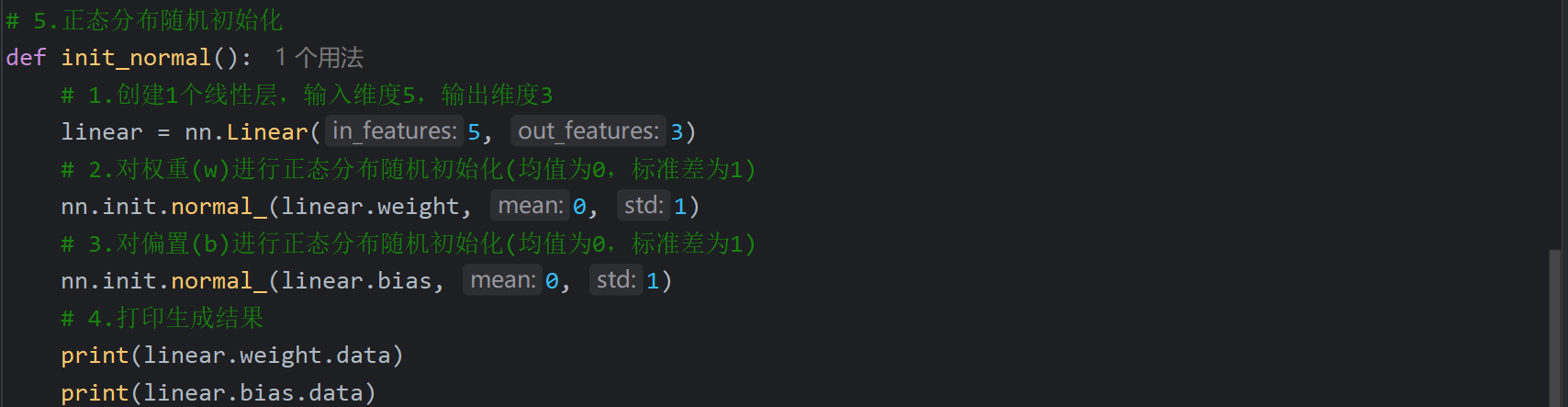

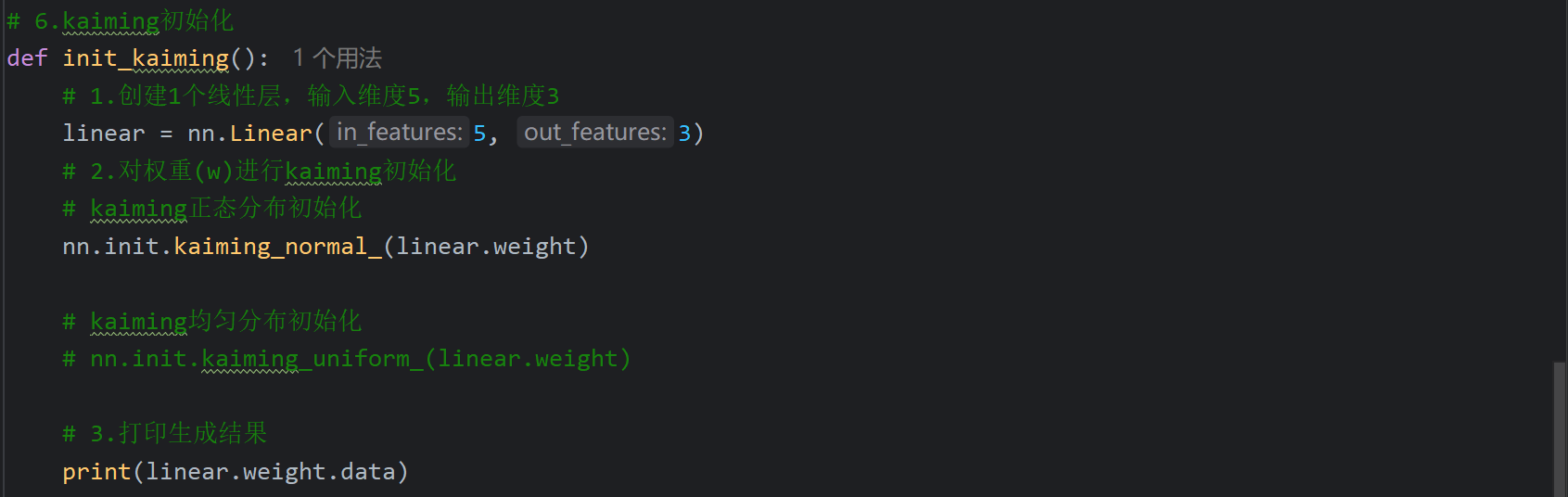

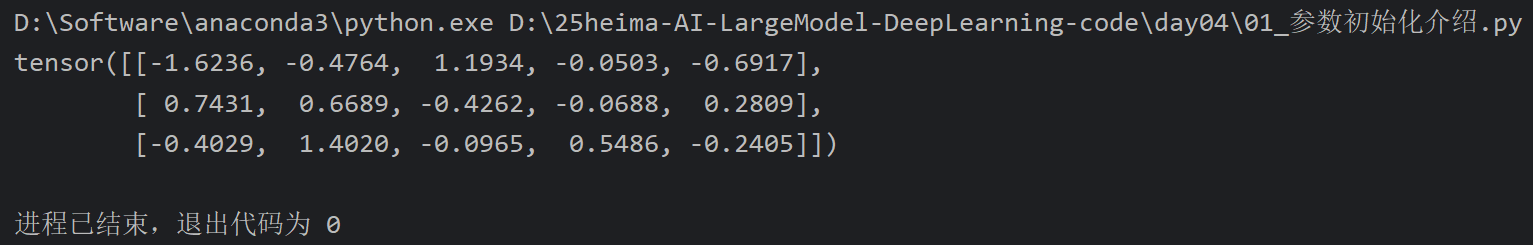

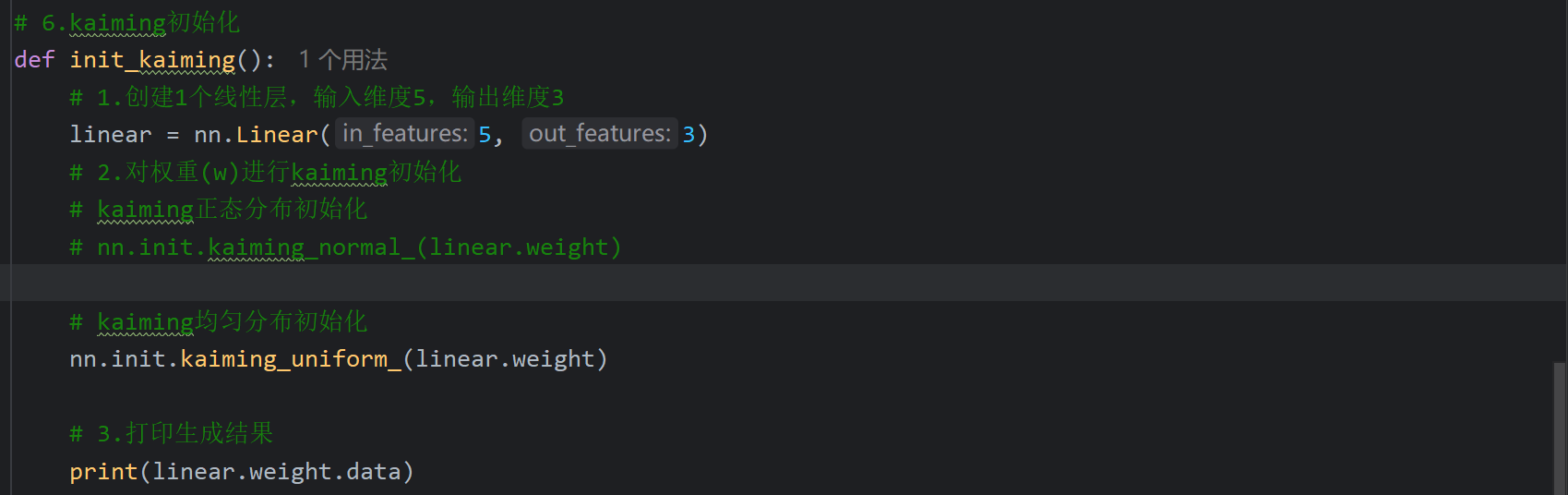

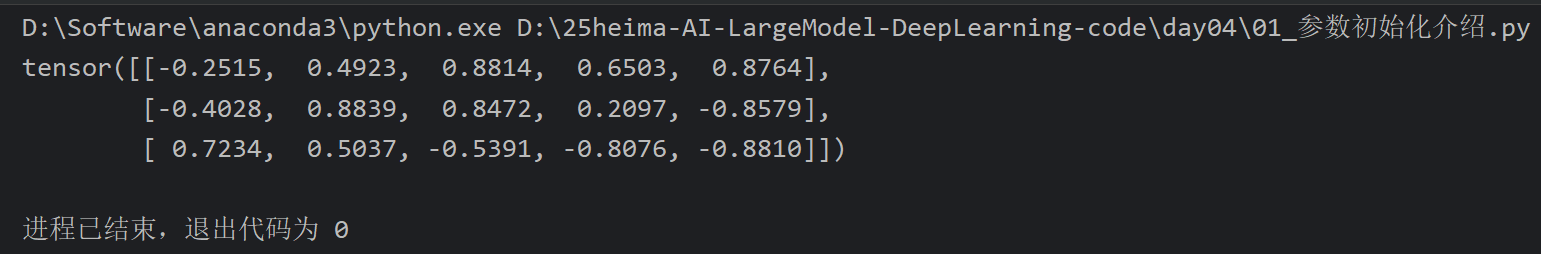

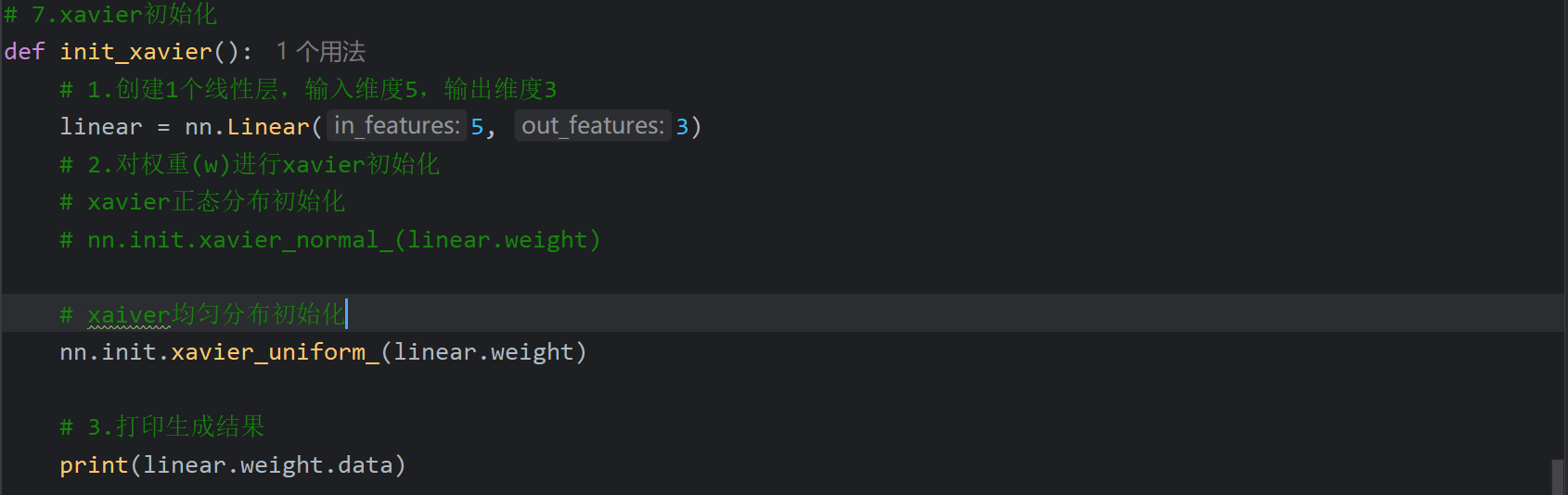

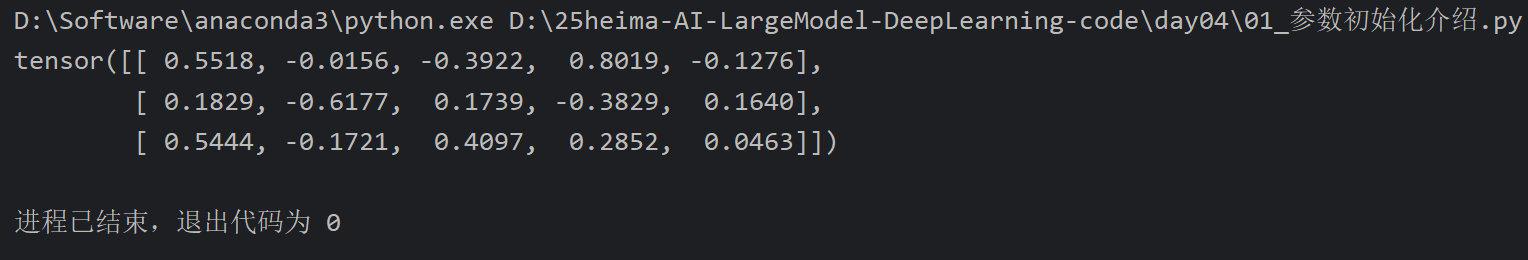

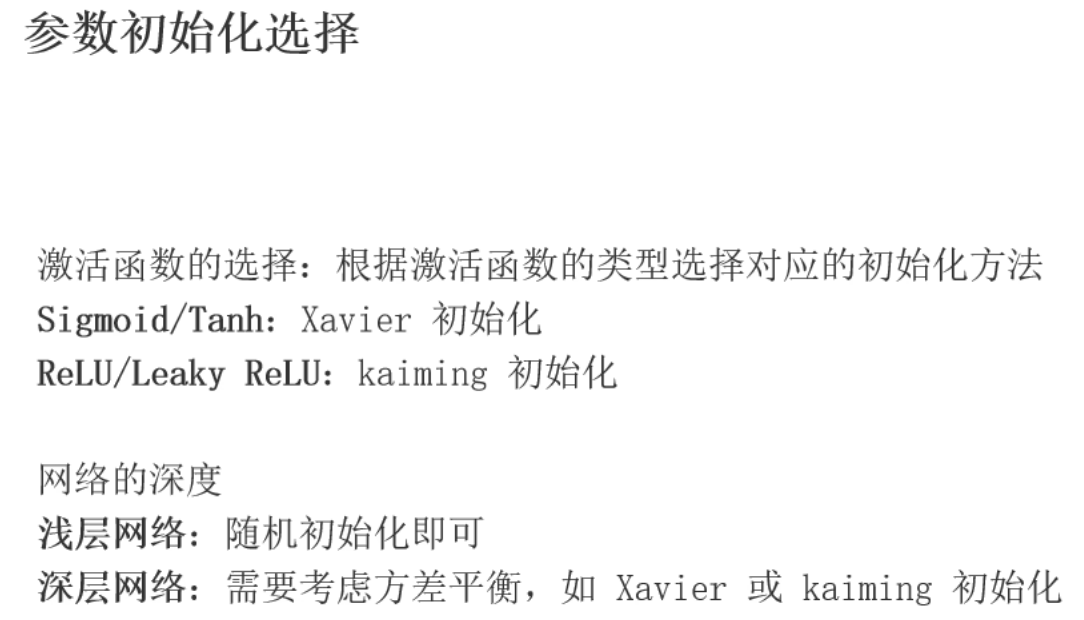

1、参数初始化_介绍

这里后面又说按md文档的来,fan_in是当前层接受的来自上一层的神经元。fan_out是当前层输出的神经元的数量,也就是当前层会传递给下一层的神经元的数量

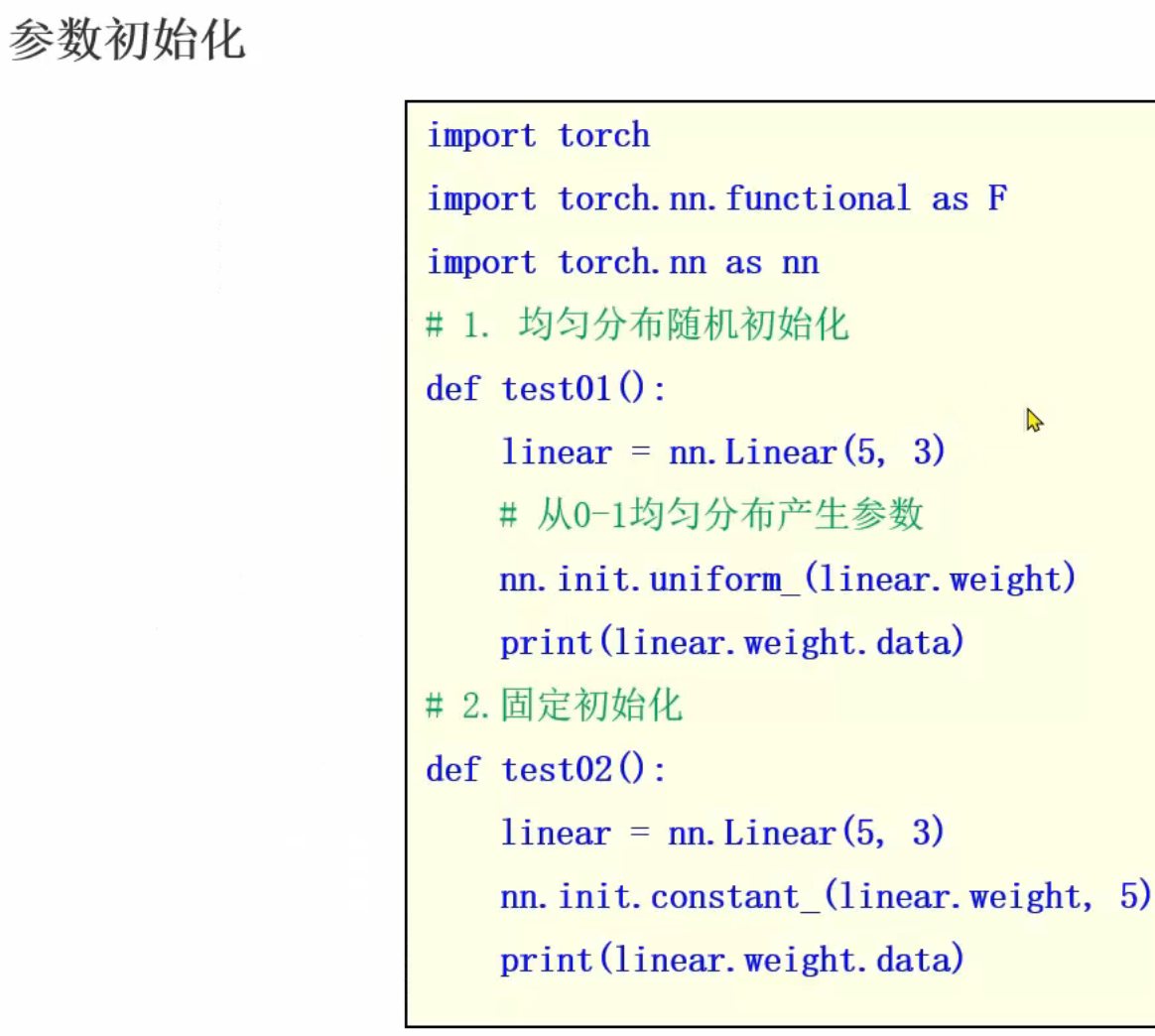

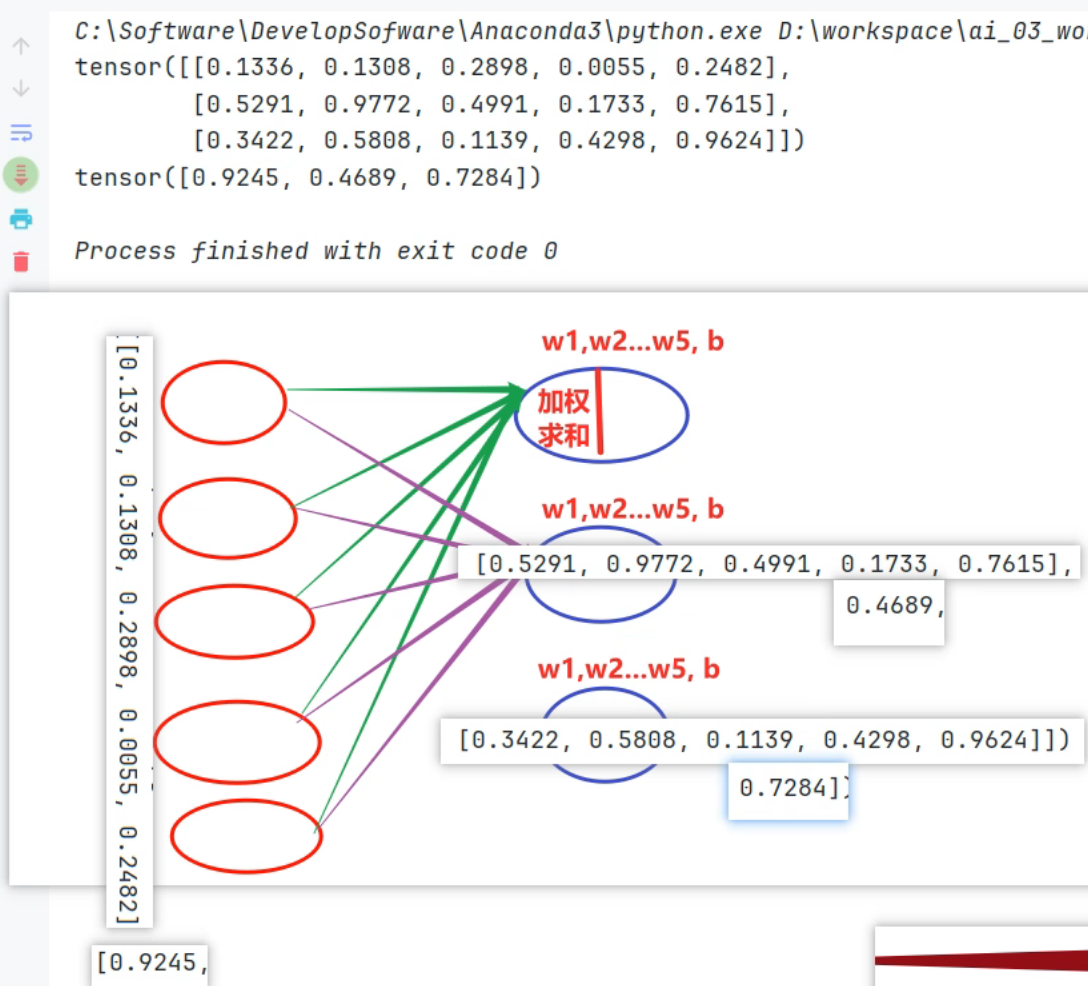

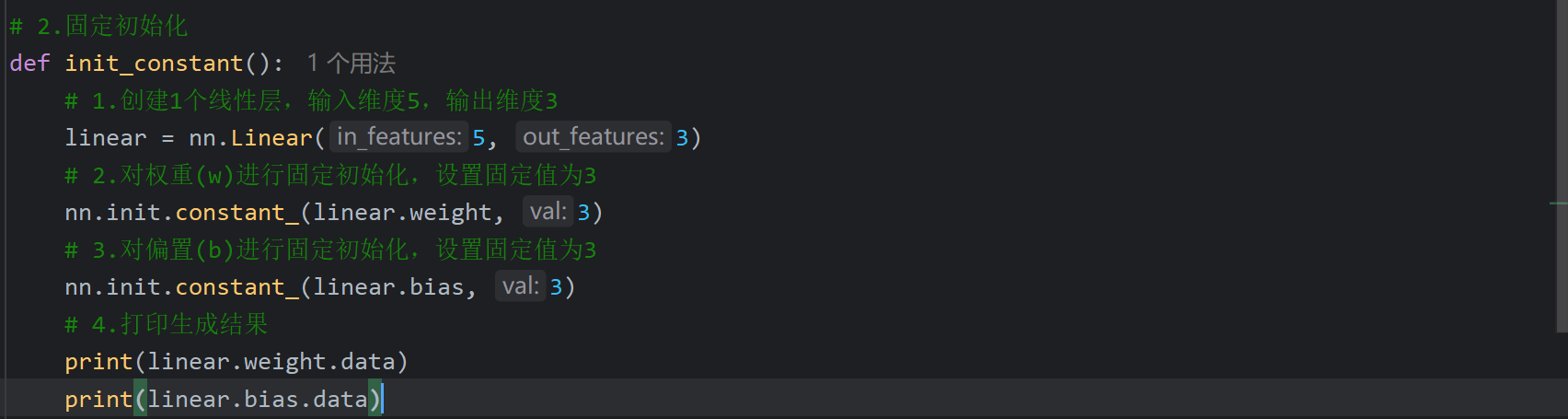

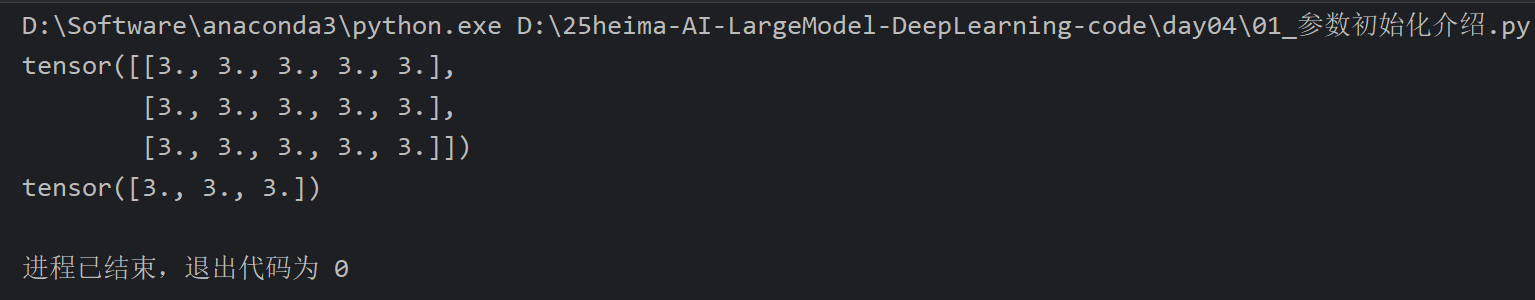

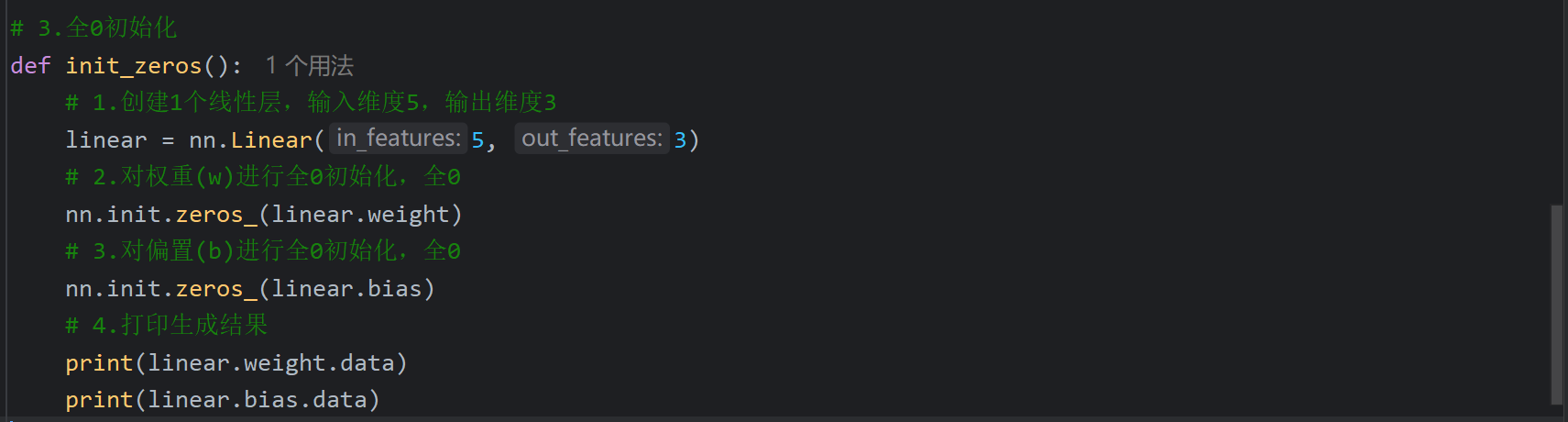

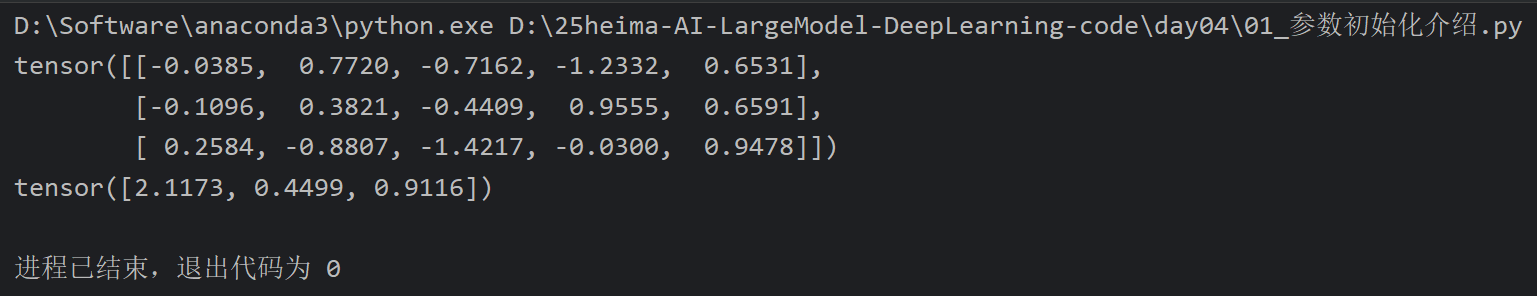

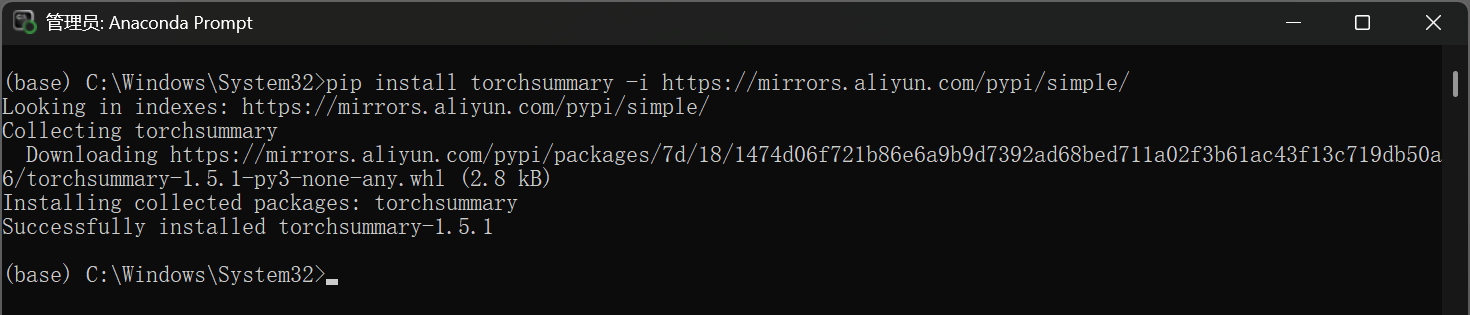

2、参数初始化_代码演示

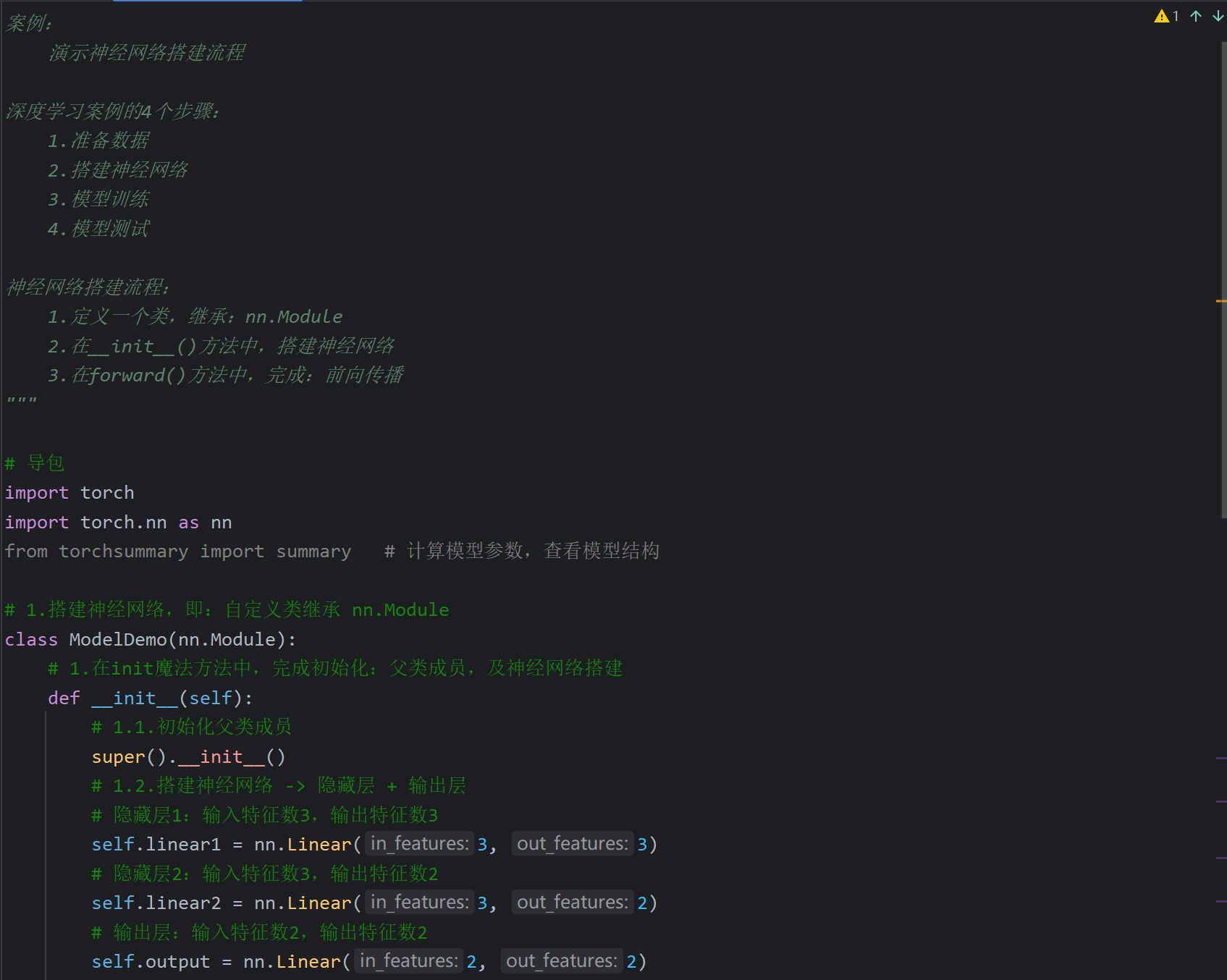

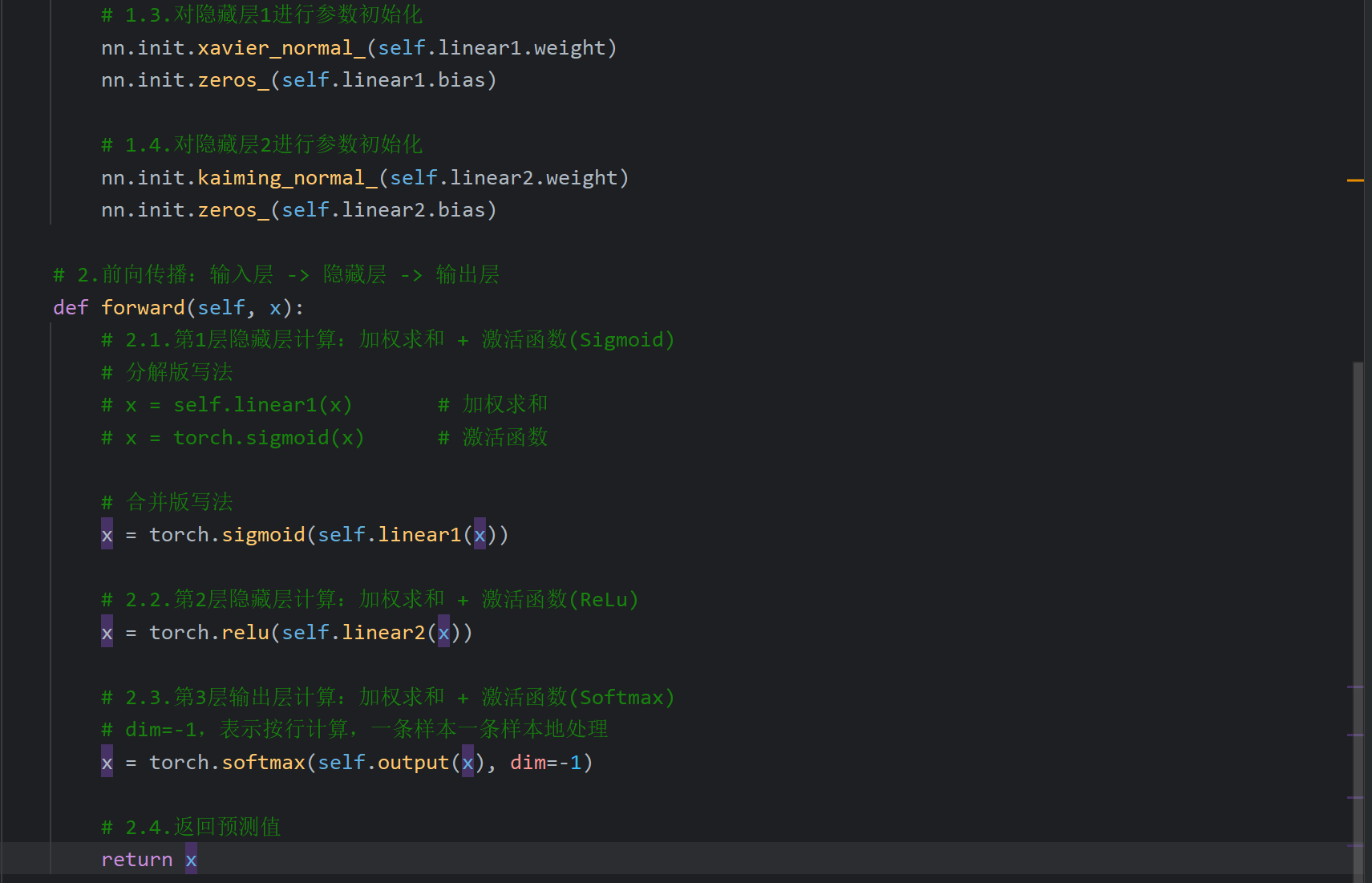

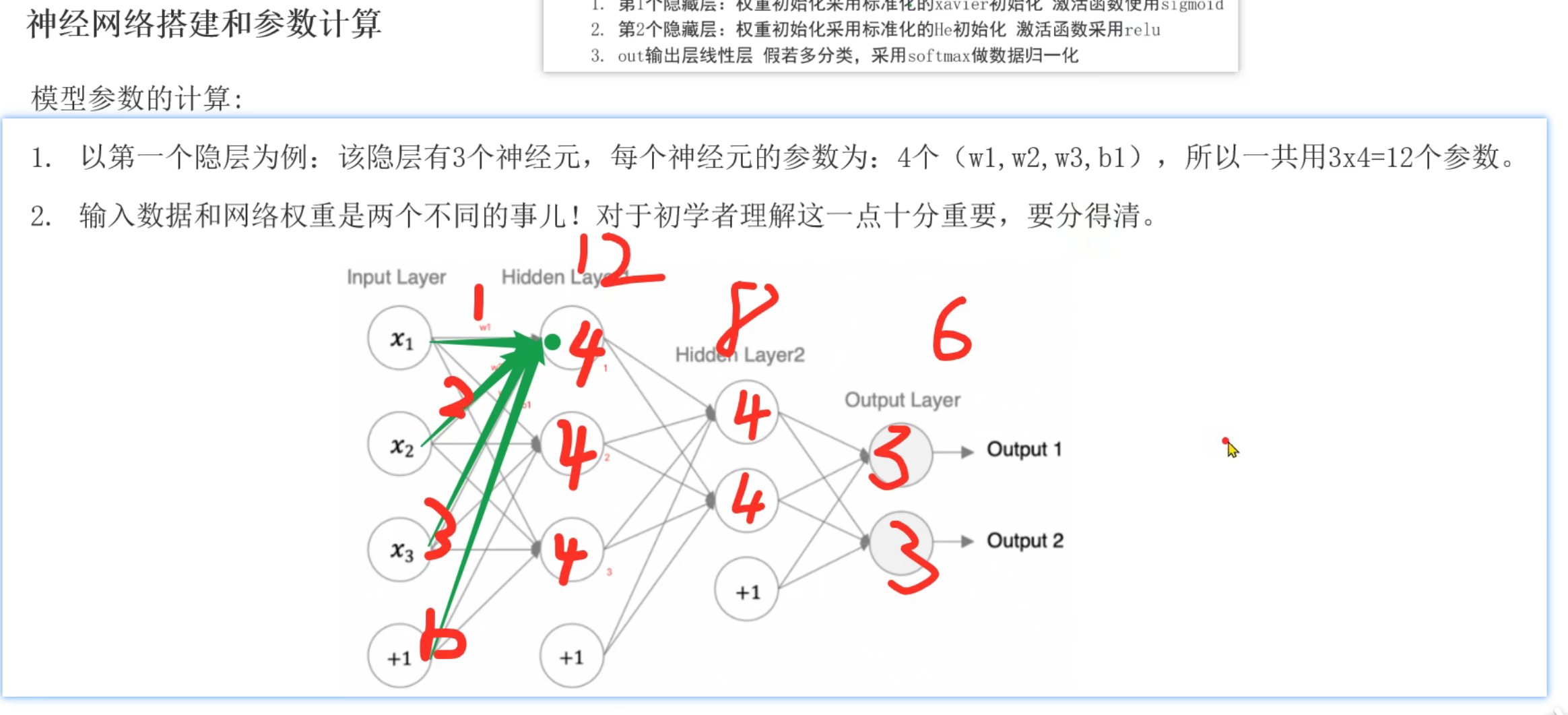

3、神经网络_搭建流程介绍

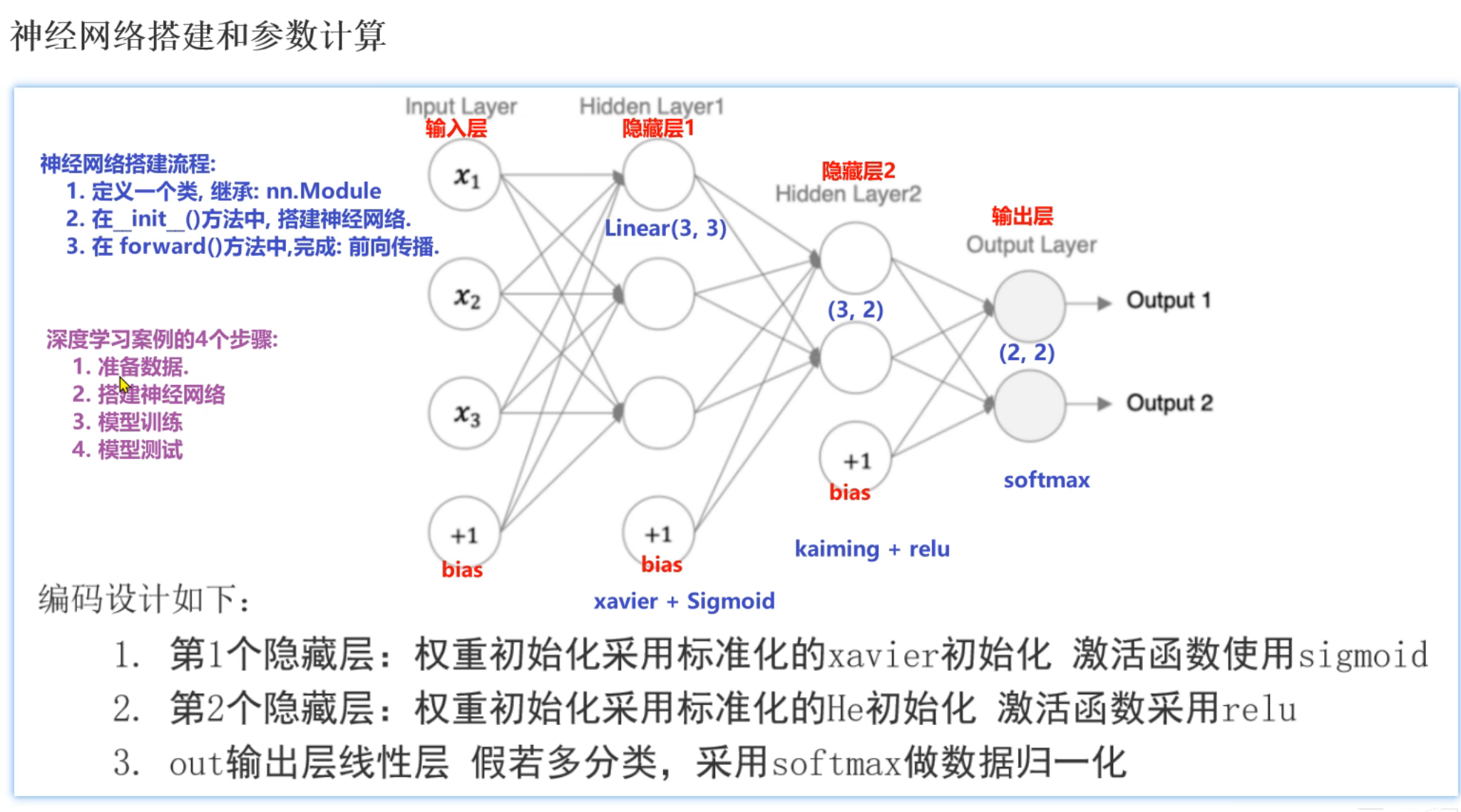

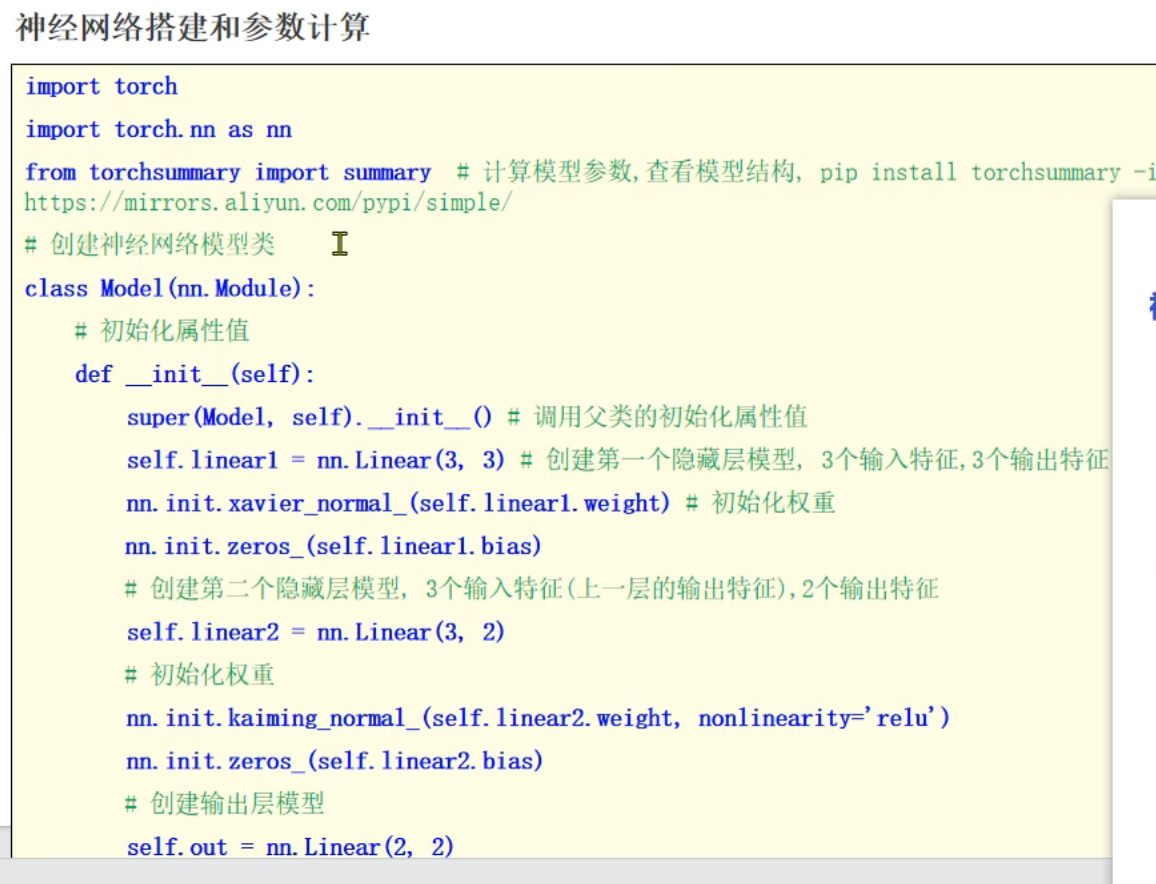

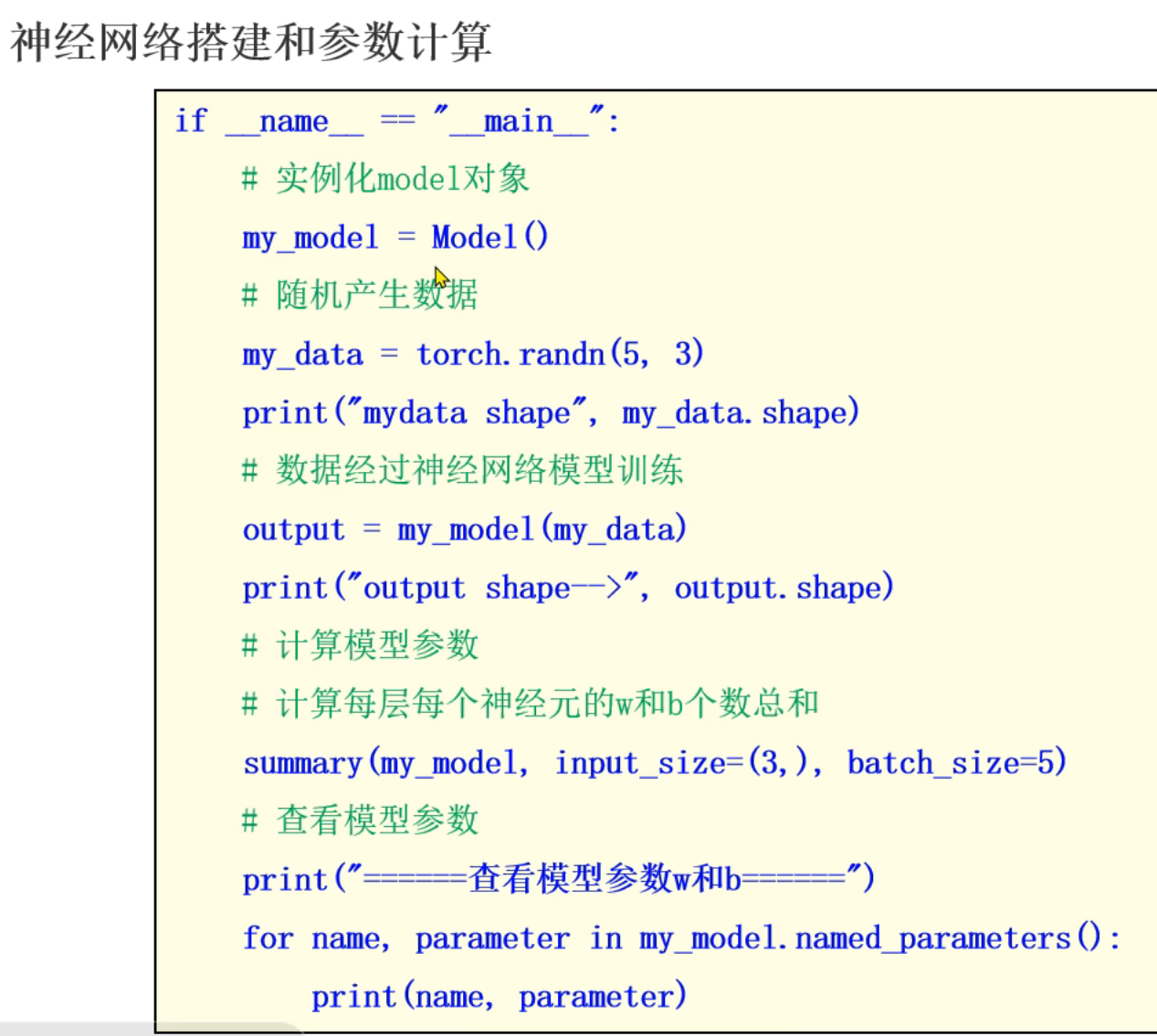

4、神经网络_搭建代码实现

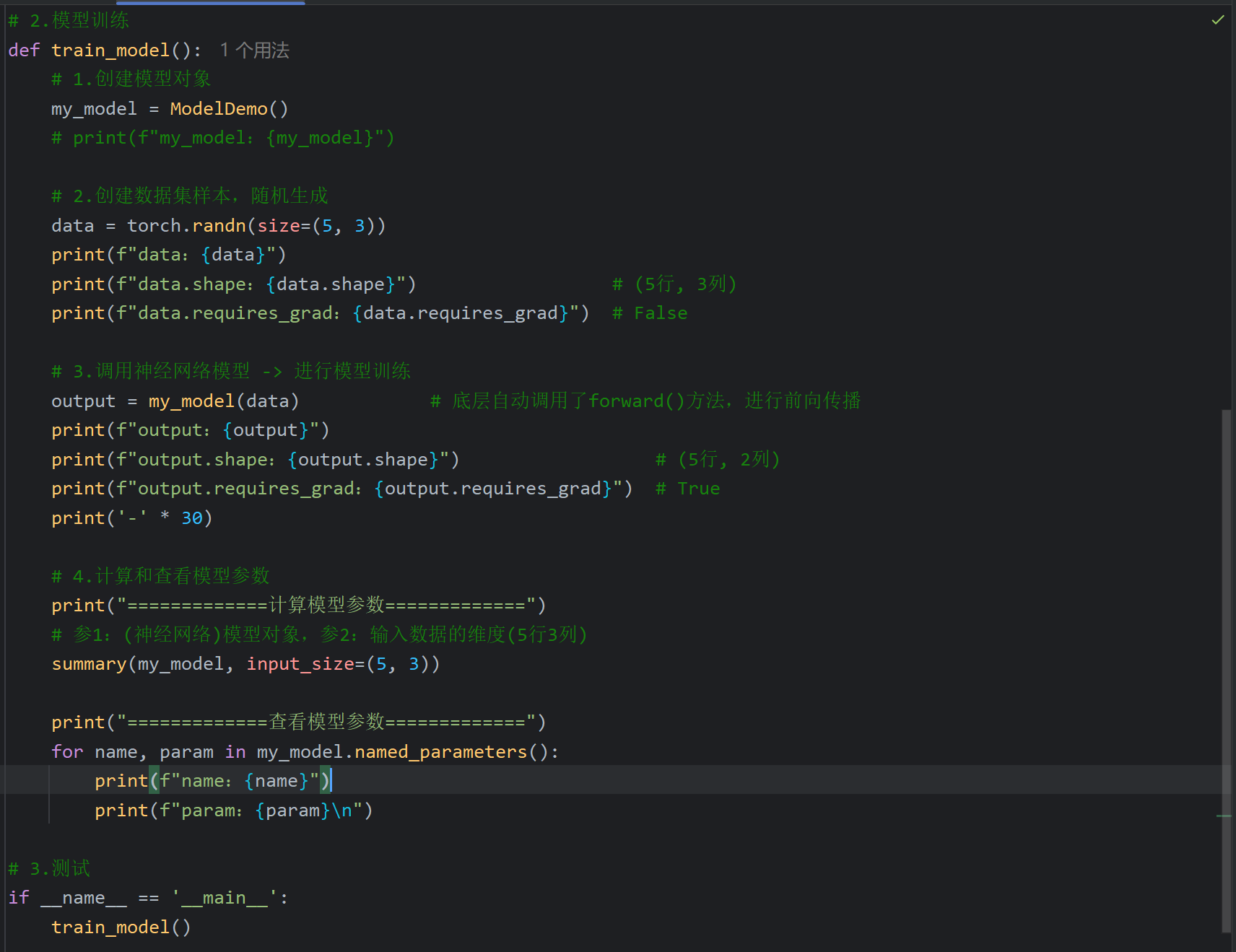

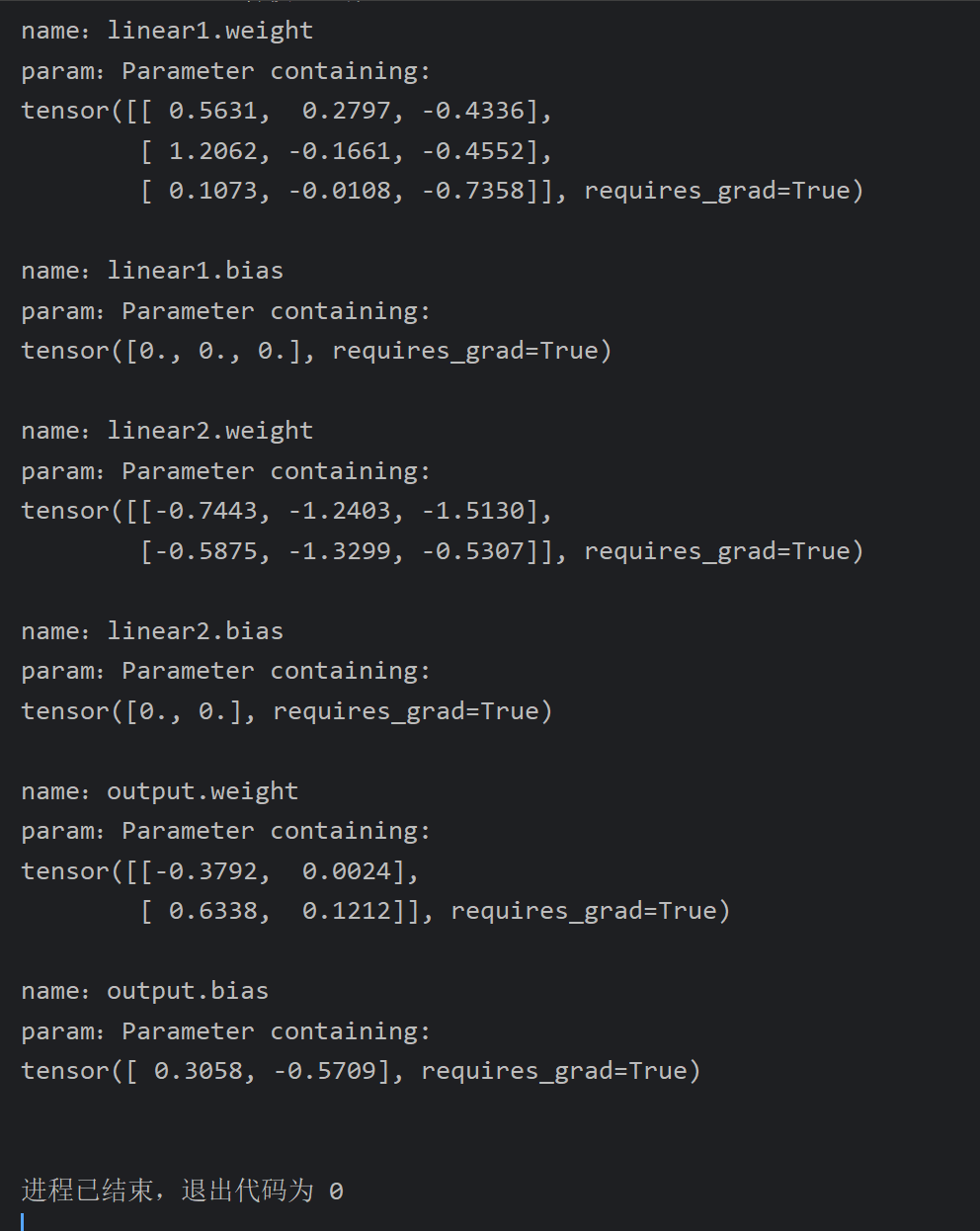

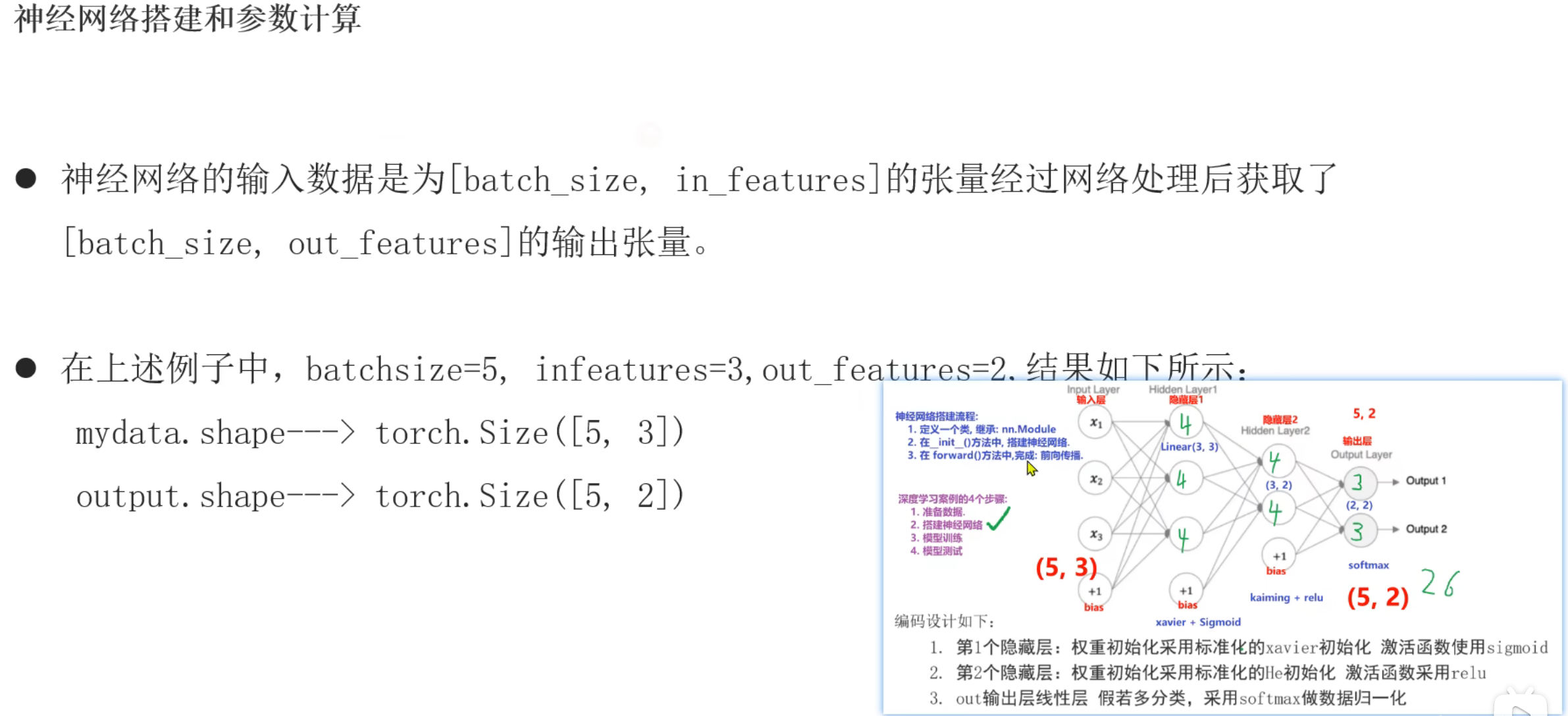

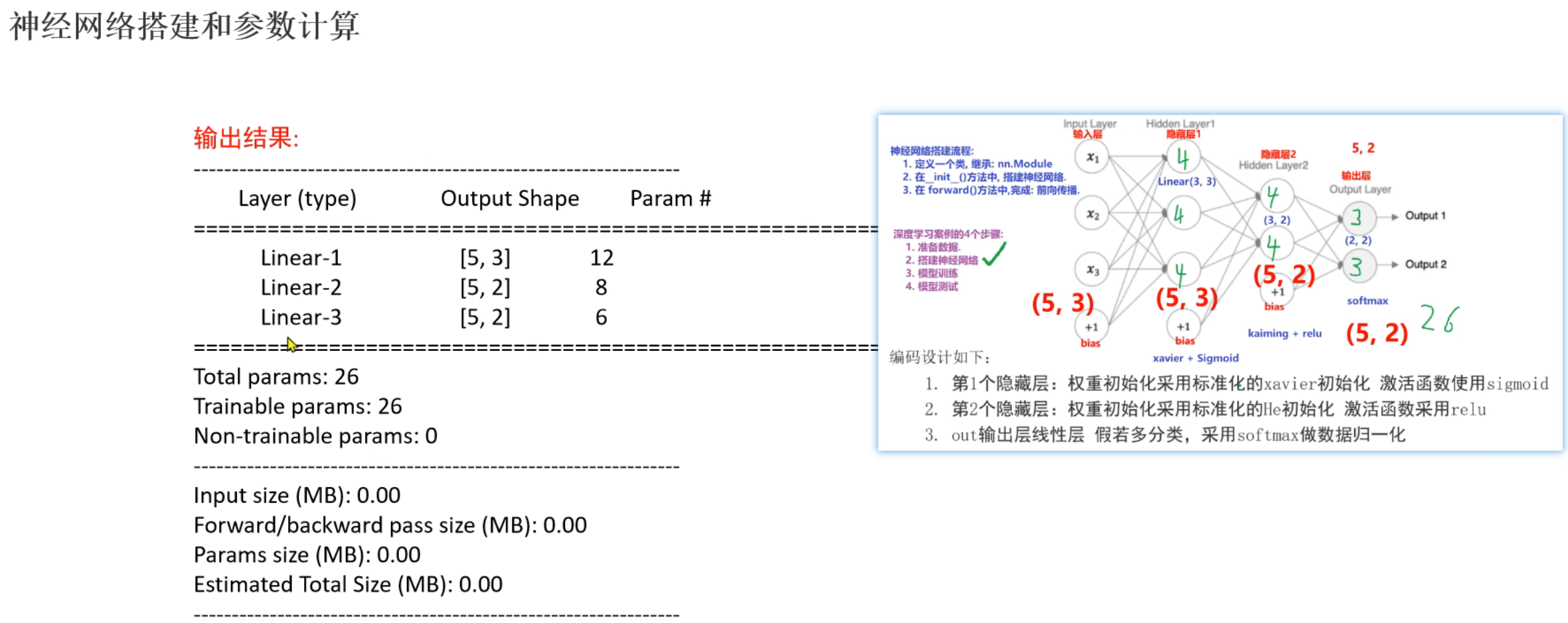

5、神经网络_模型训练

6、神经网络_总结

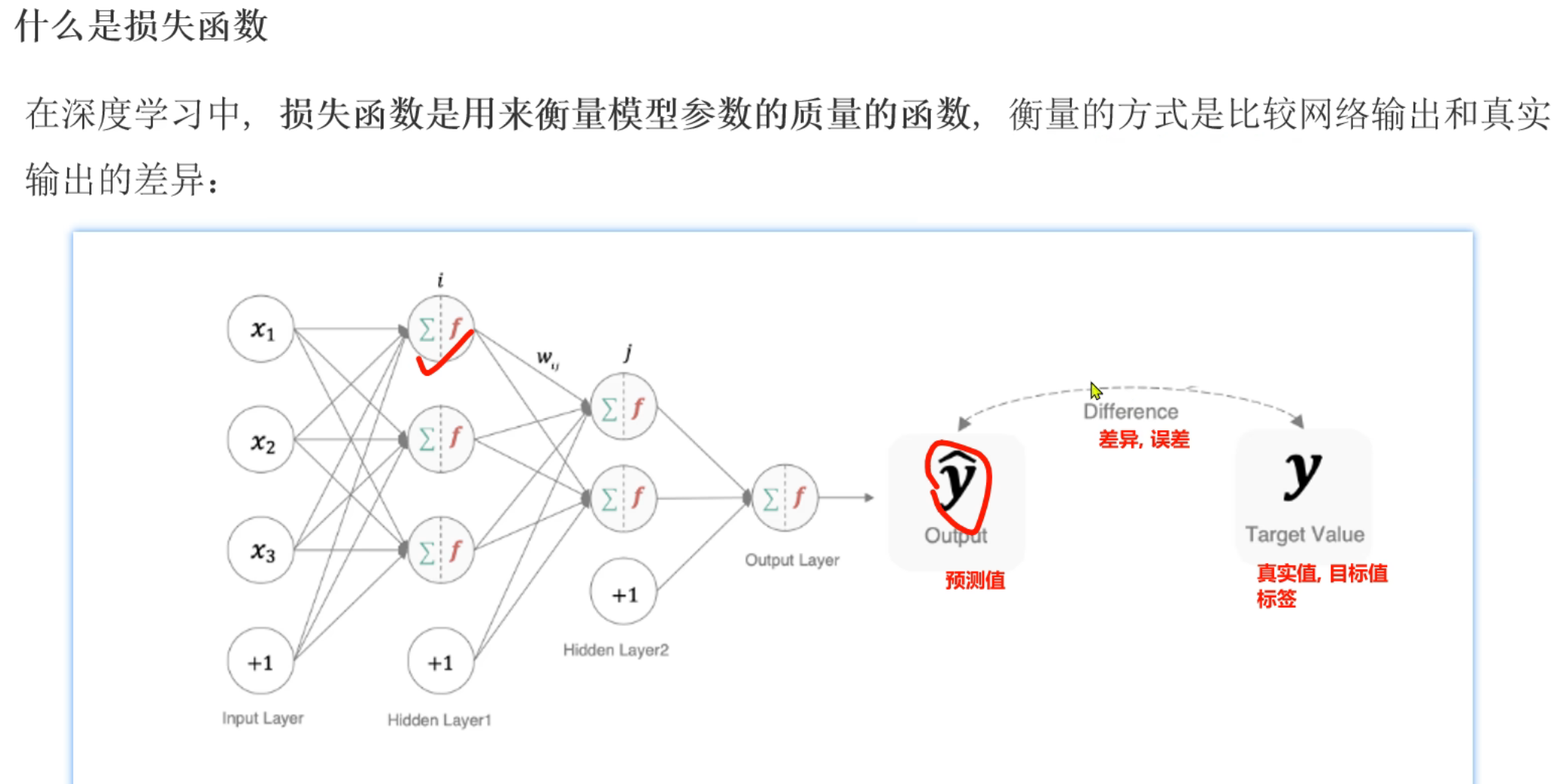

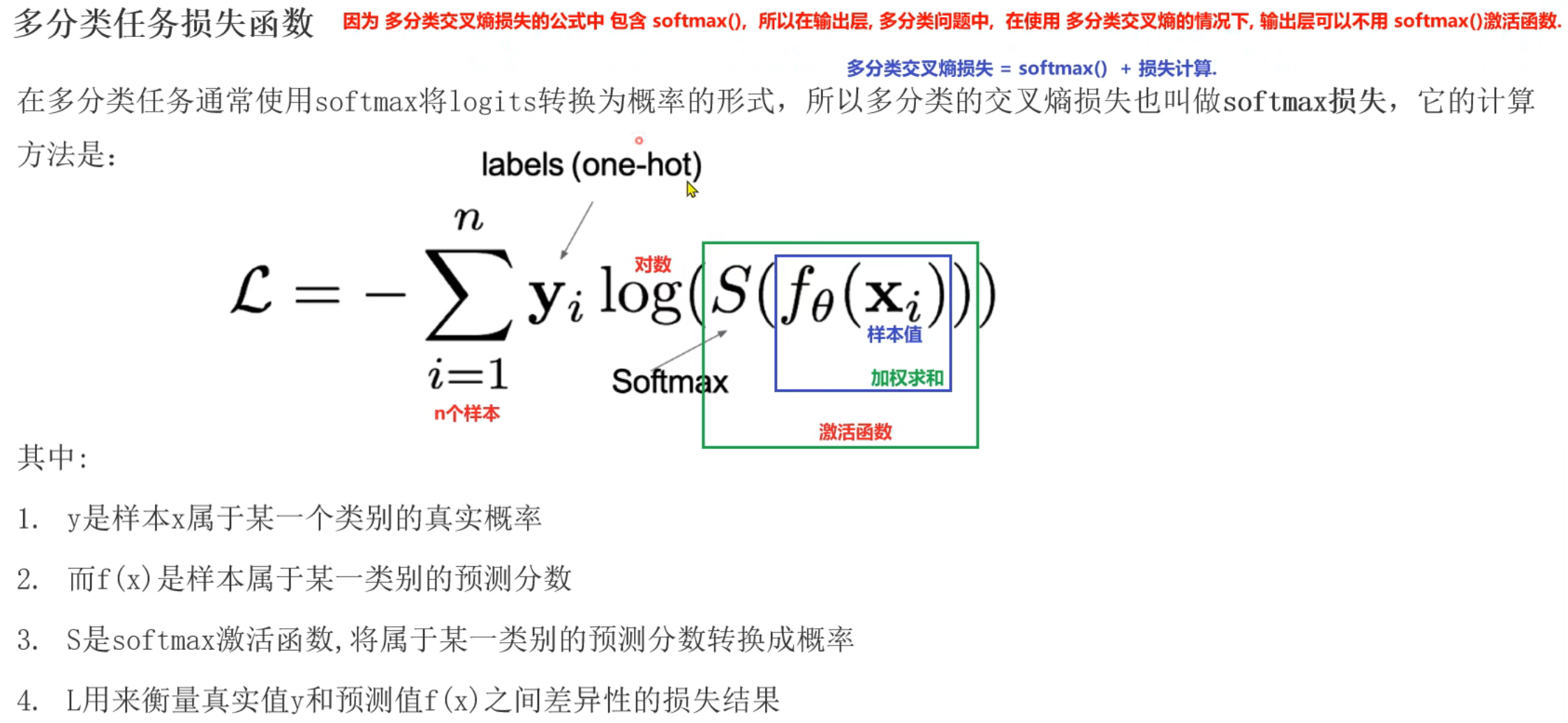

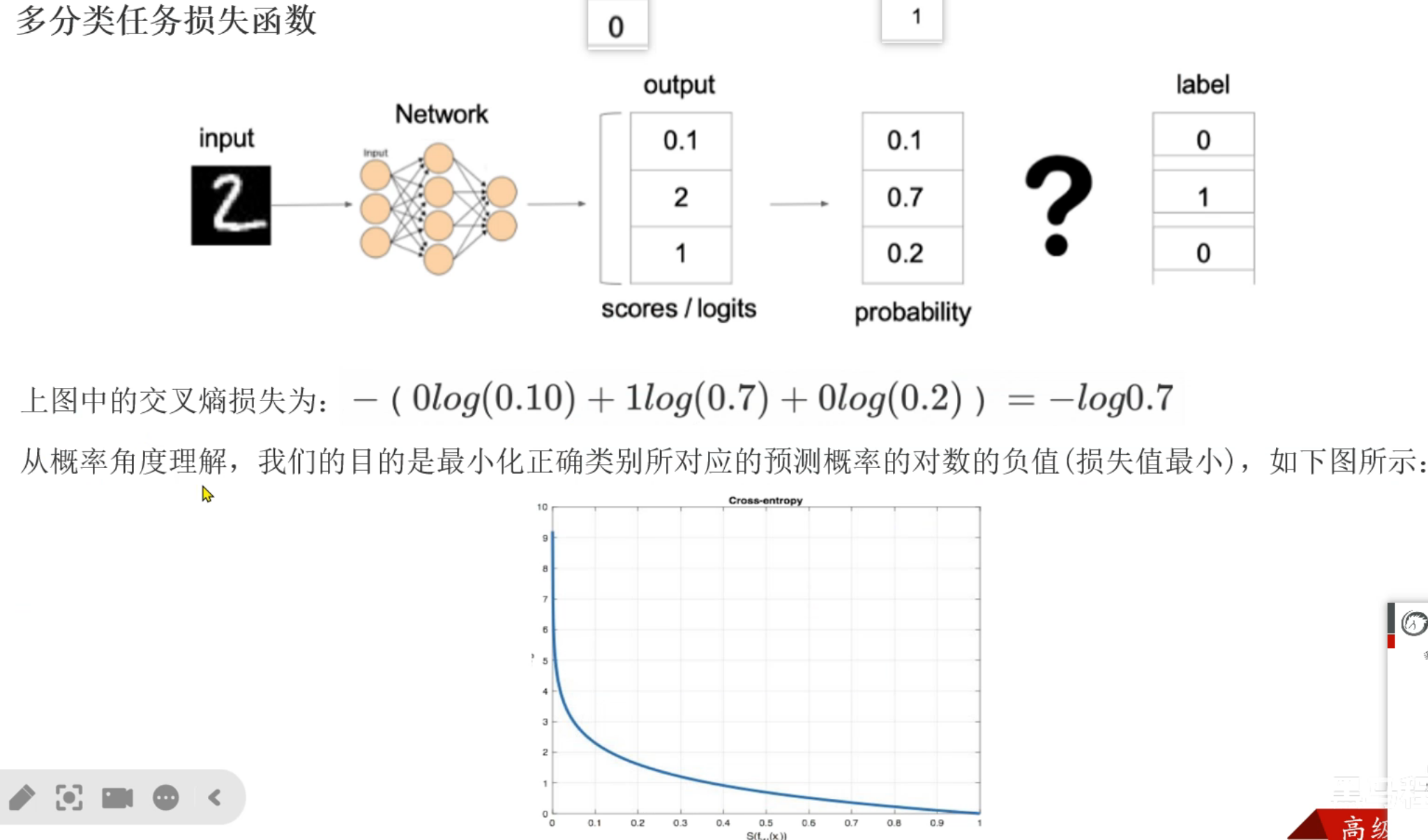

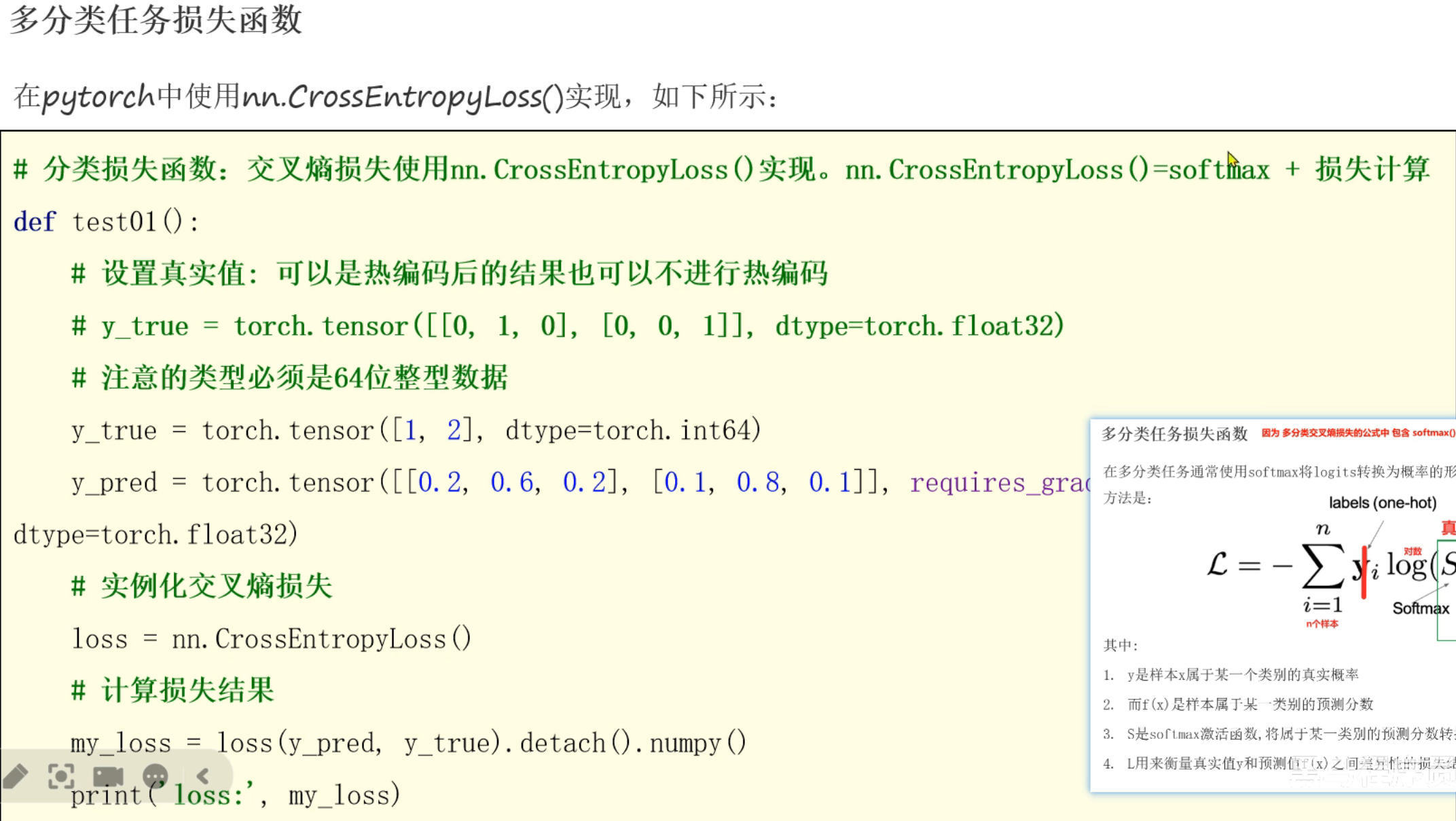

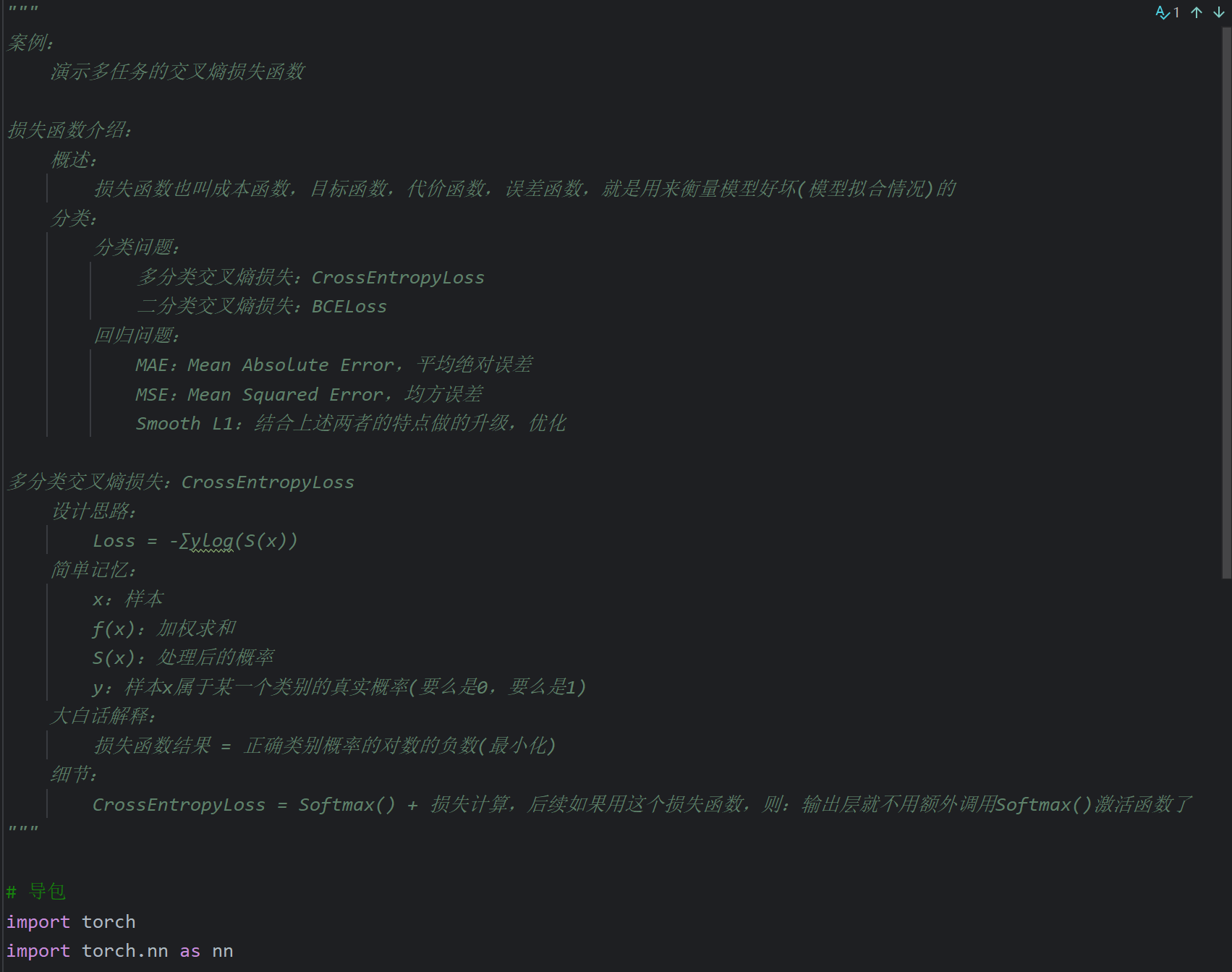

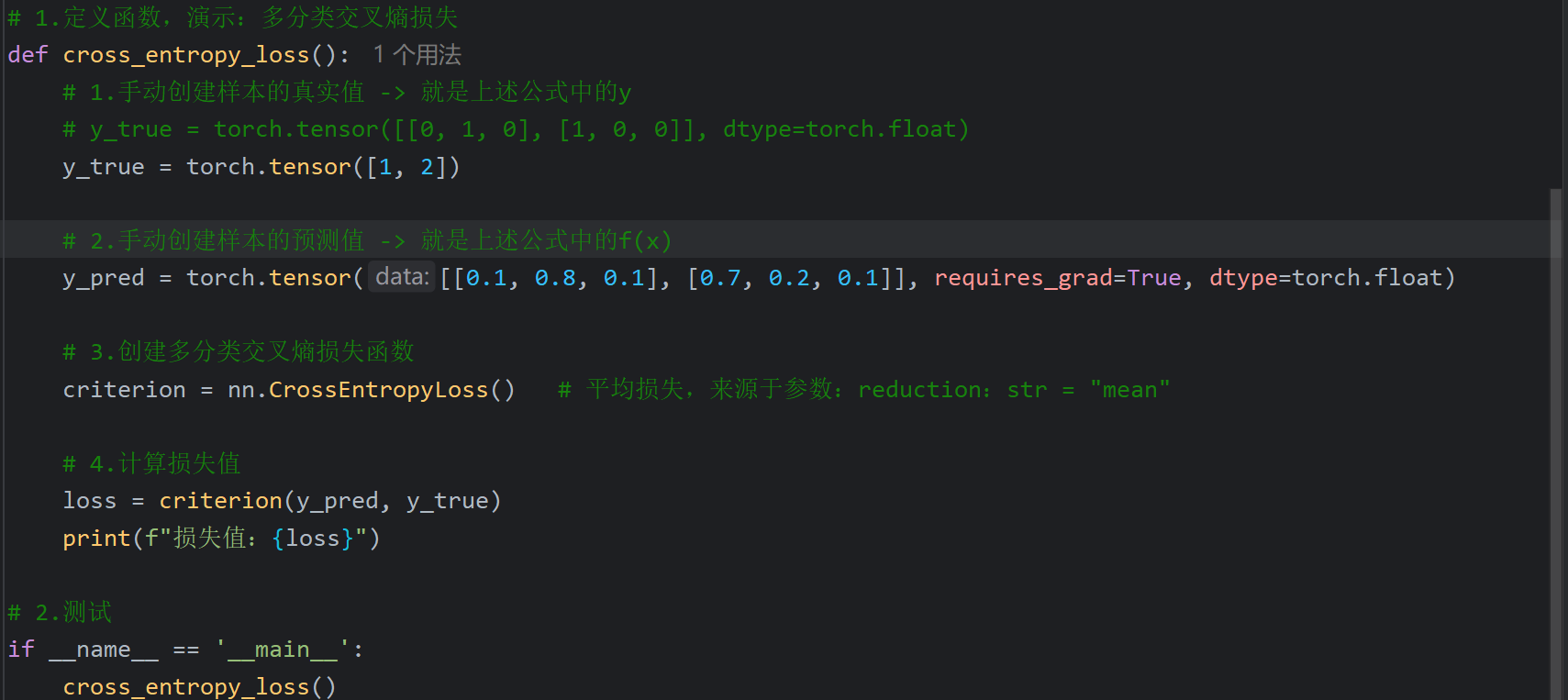

7、损失函数_多分类交叉熵损失介绍

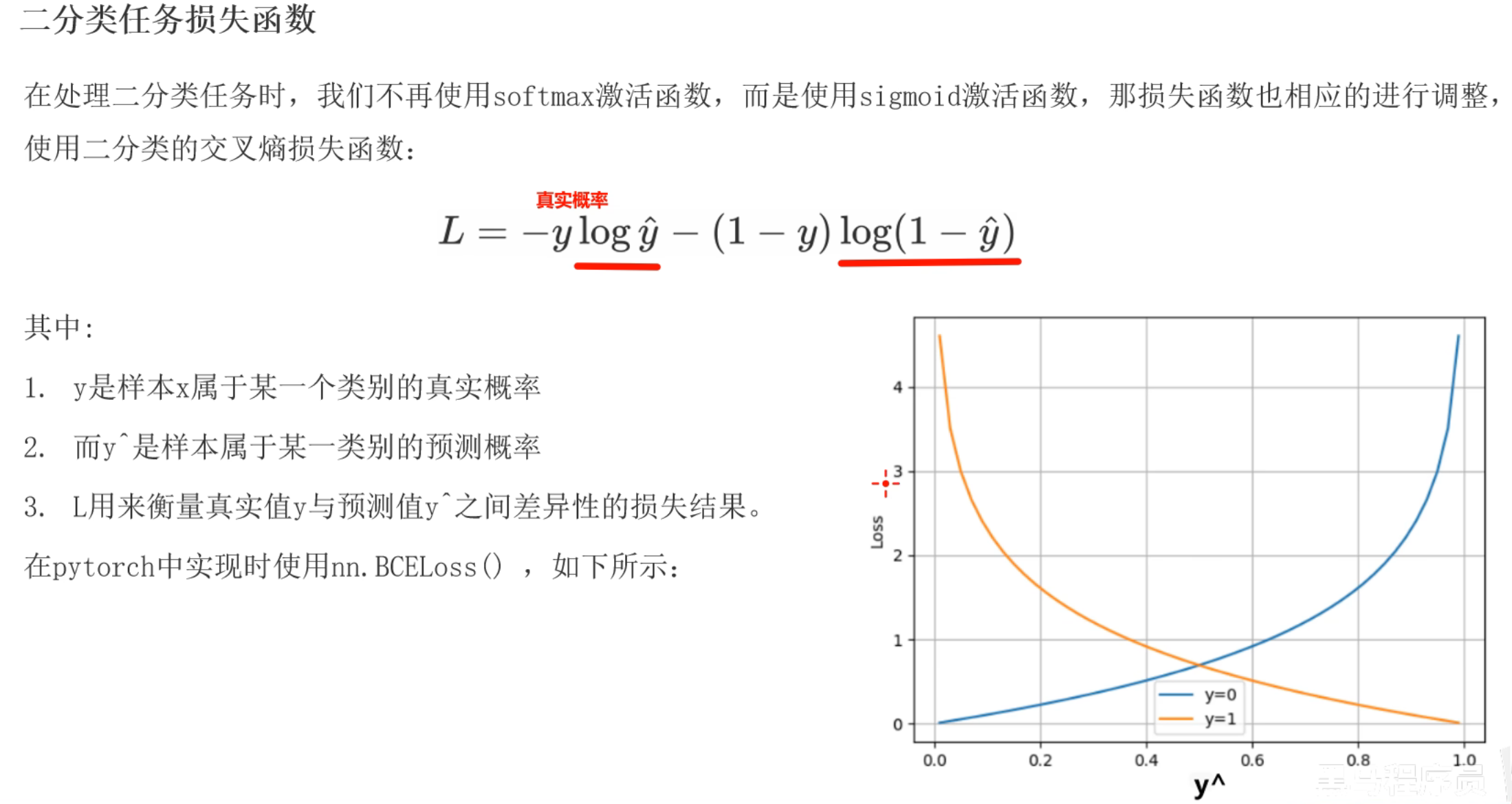

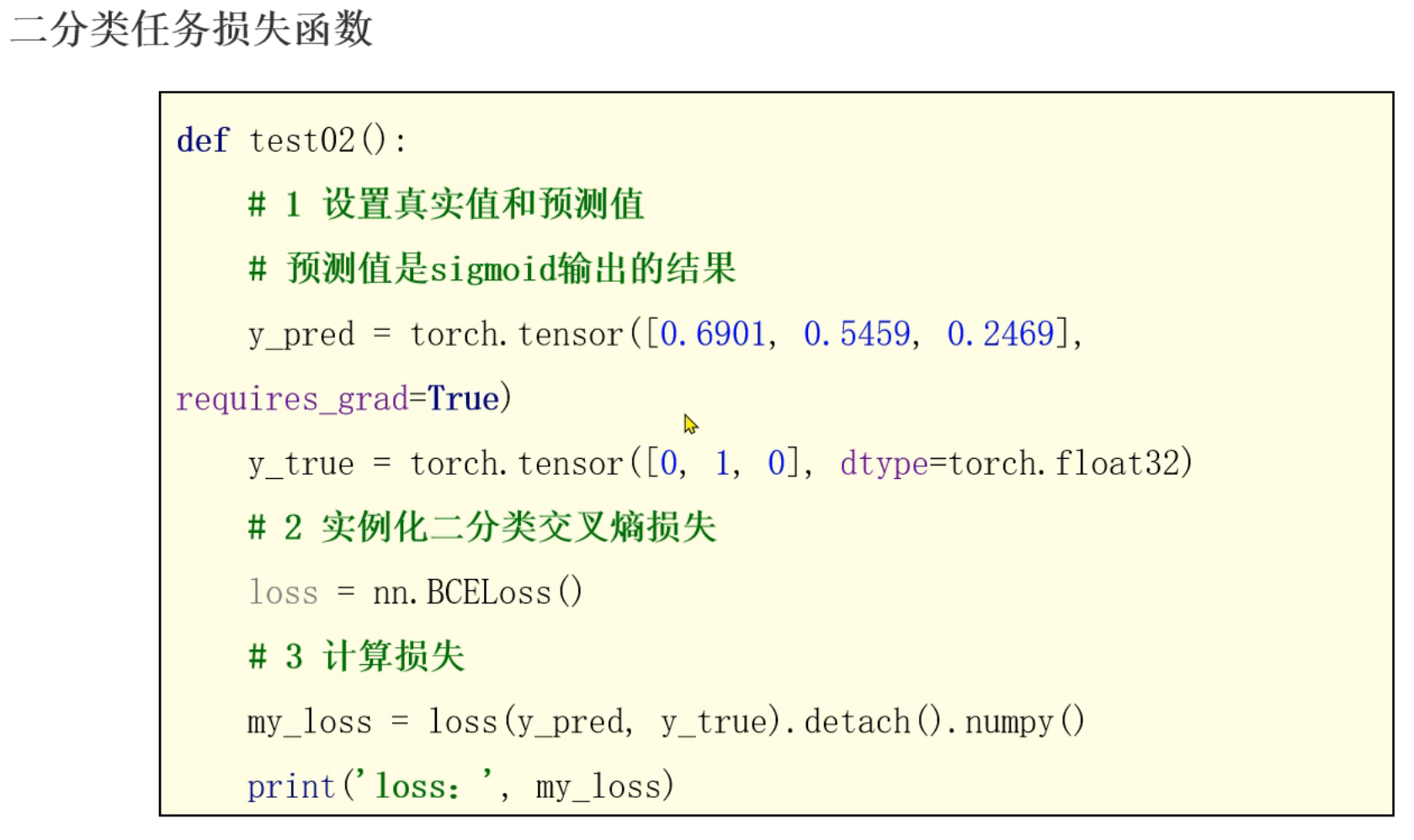

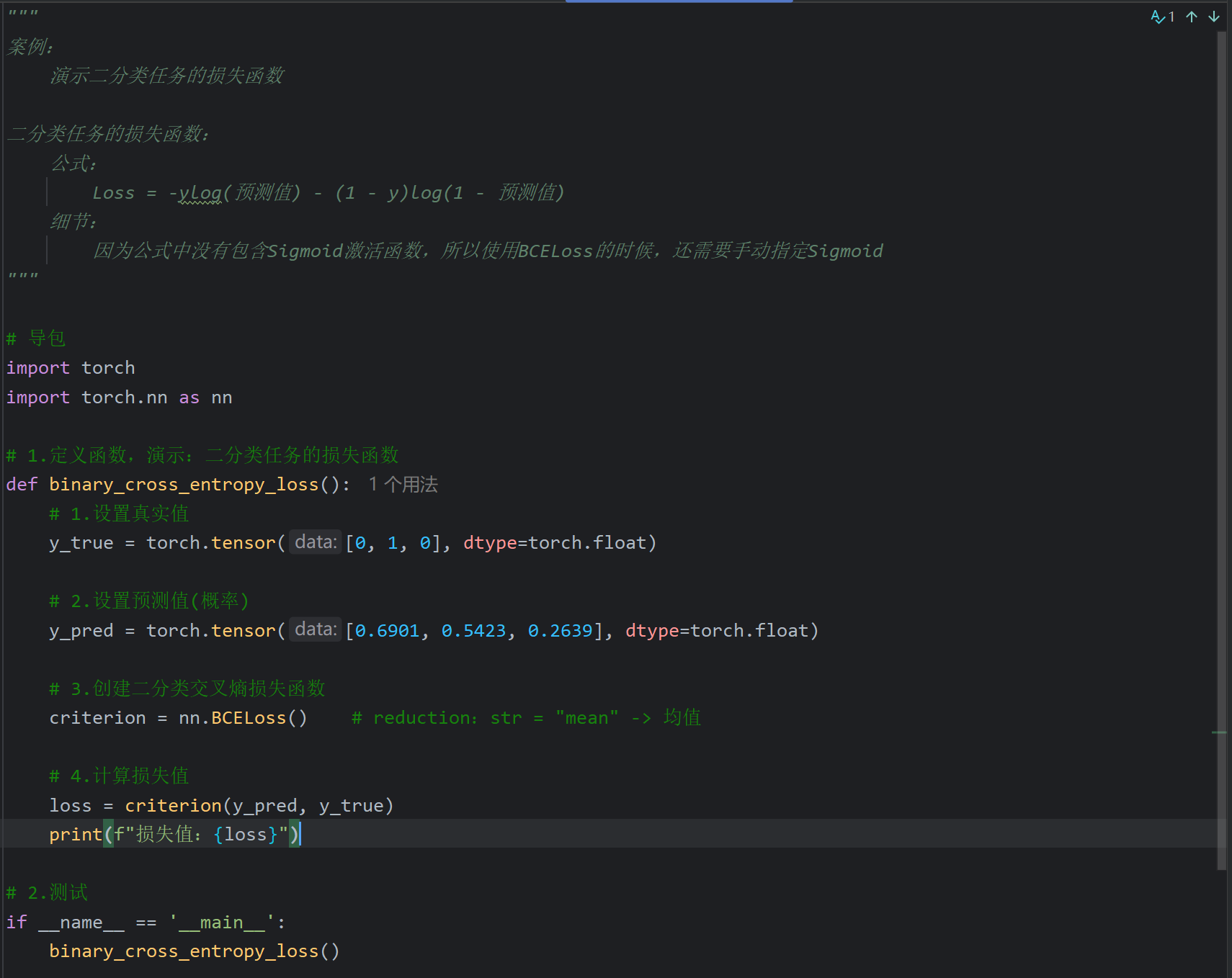

8、损失函数_二分类交叉熵损失介绍

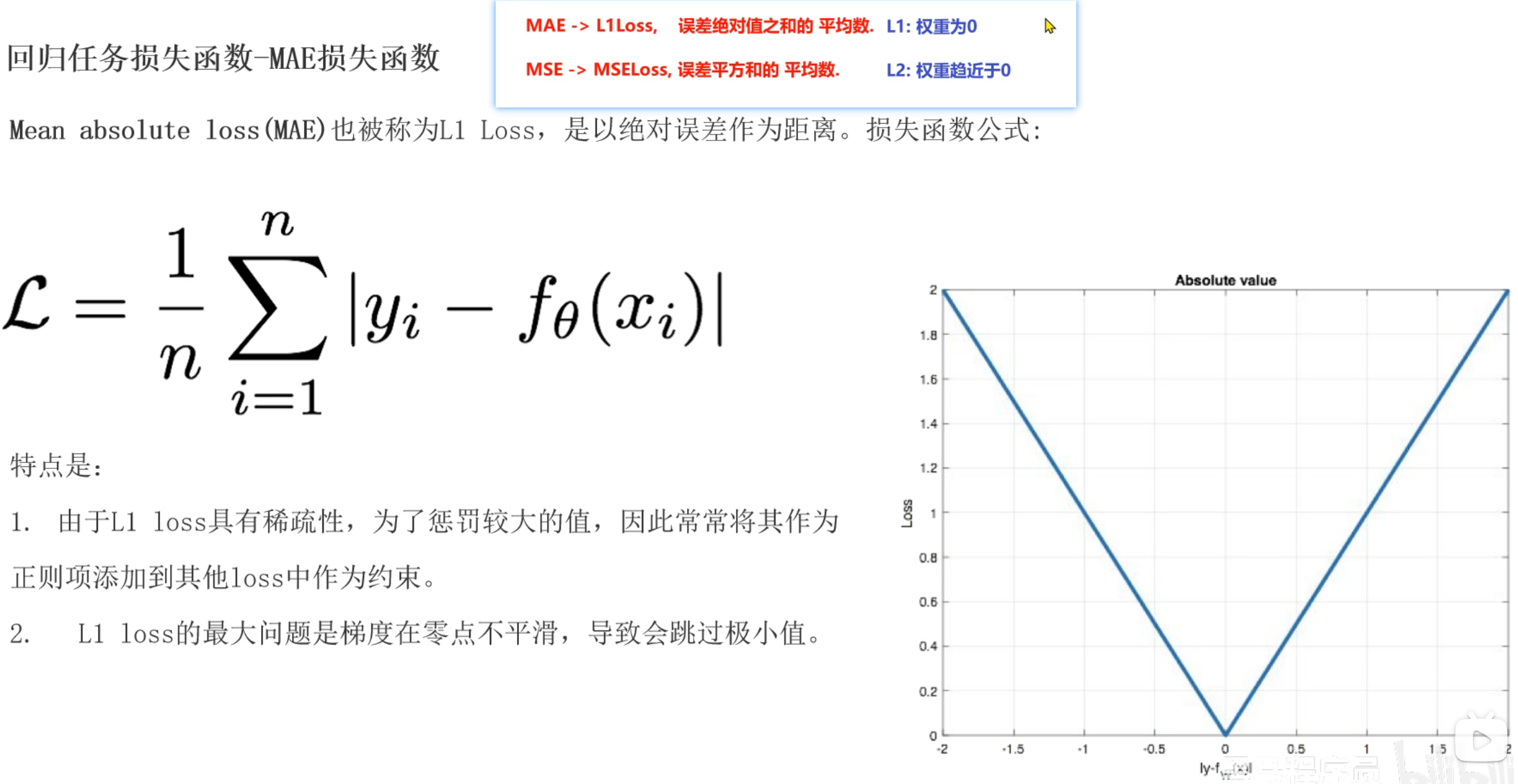

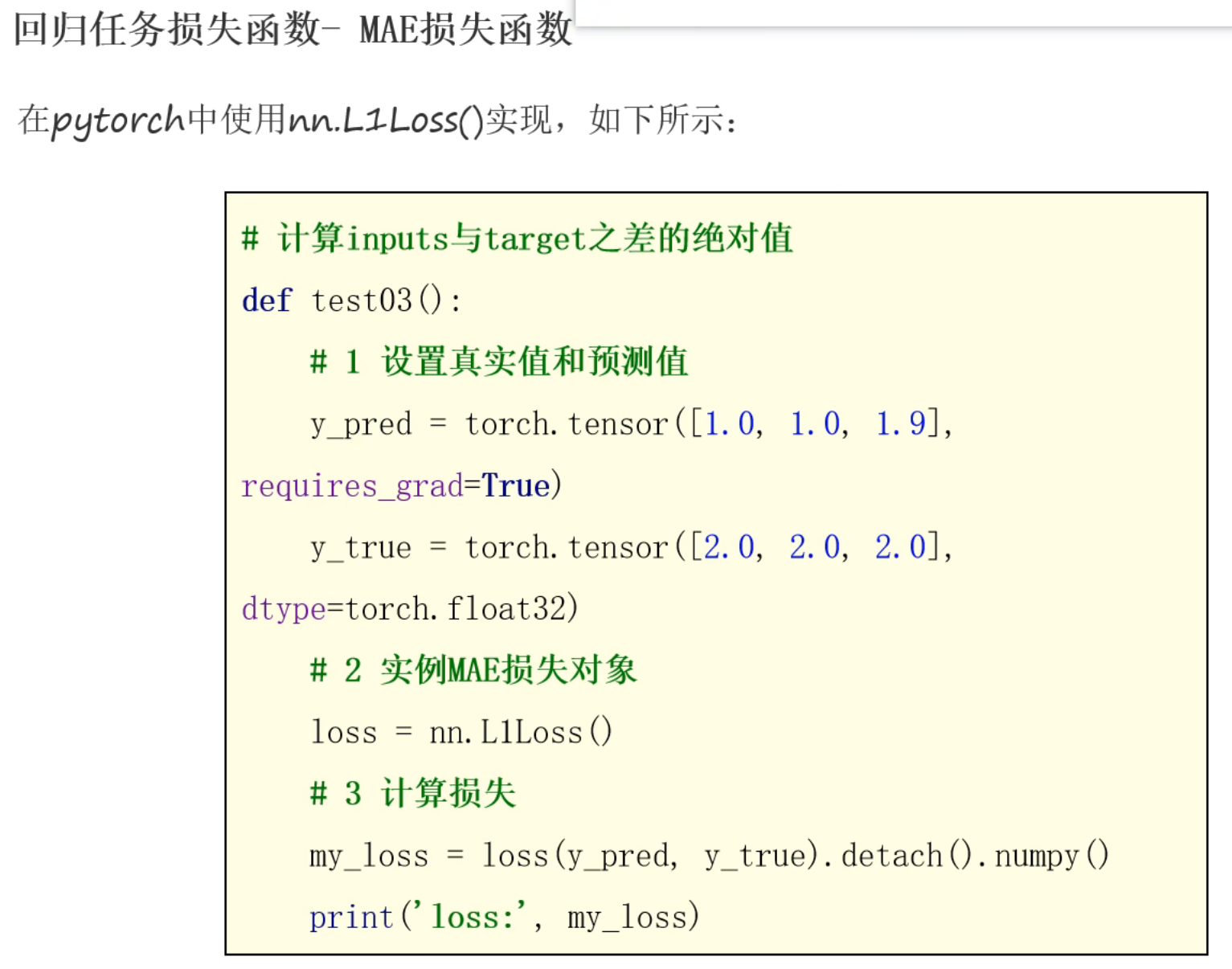

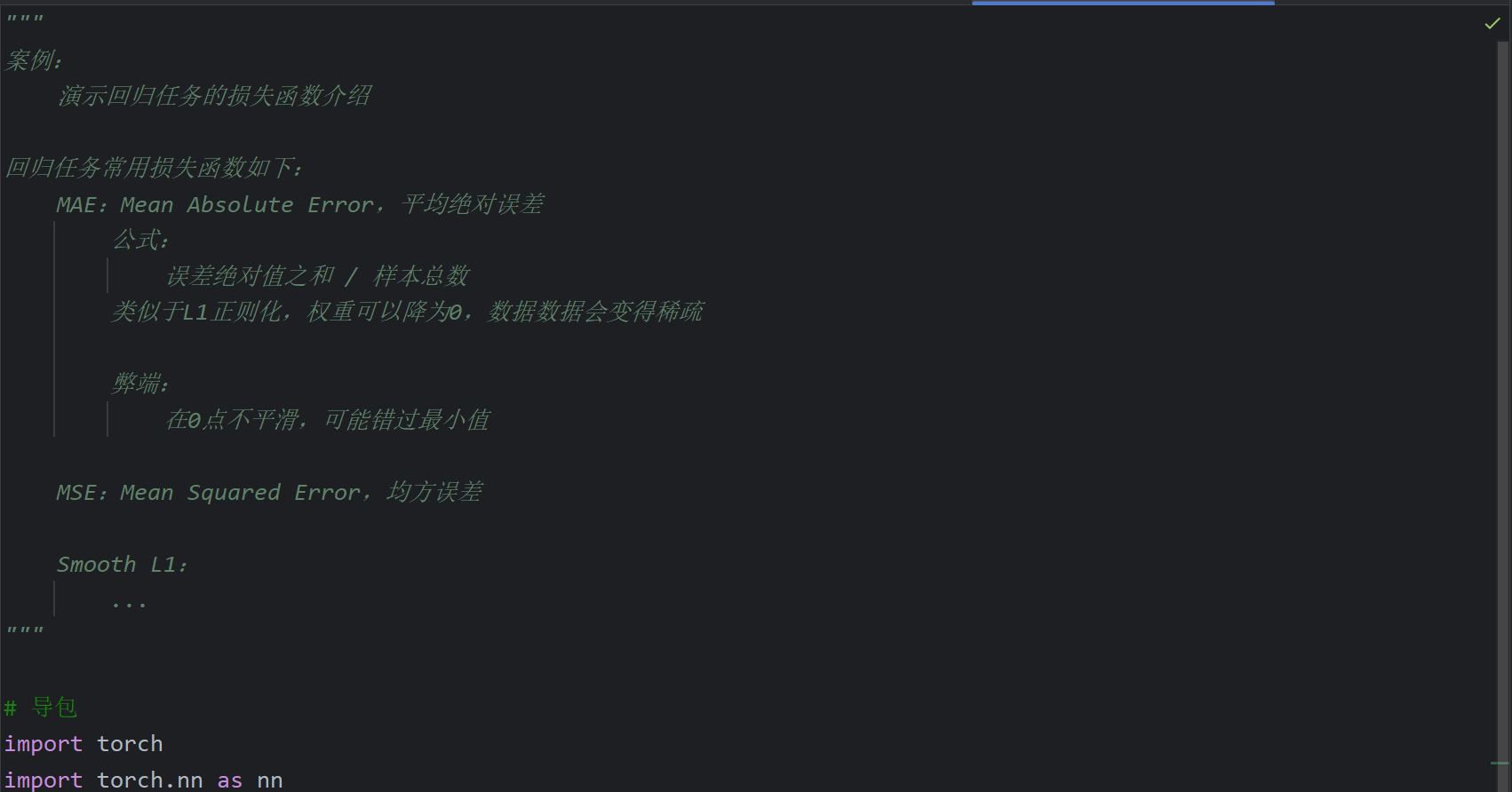

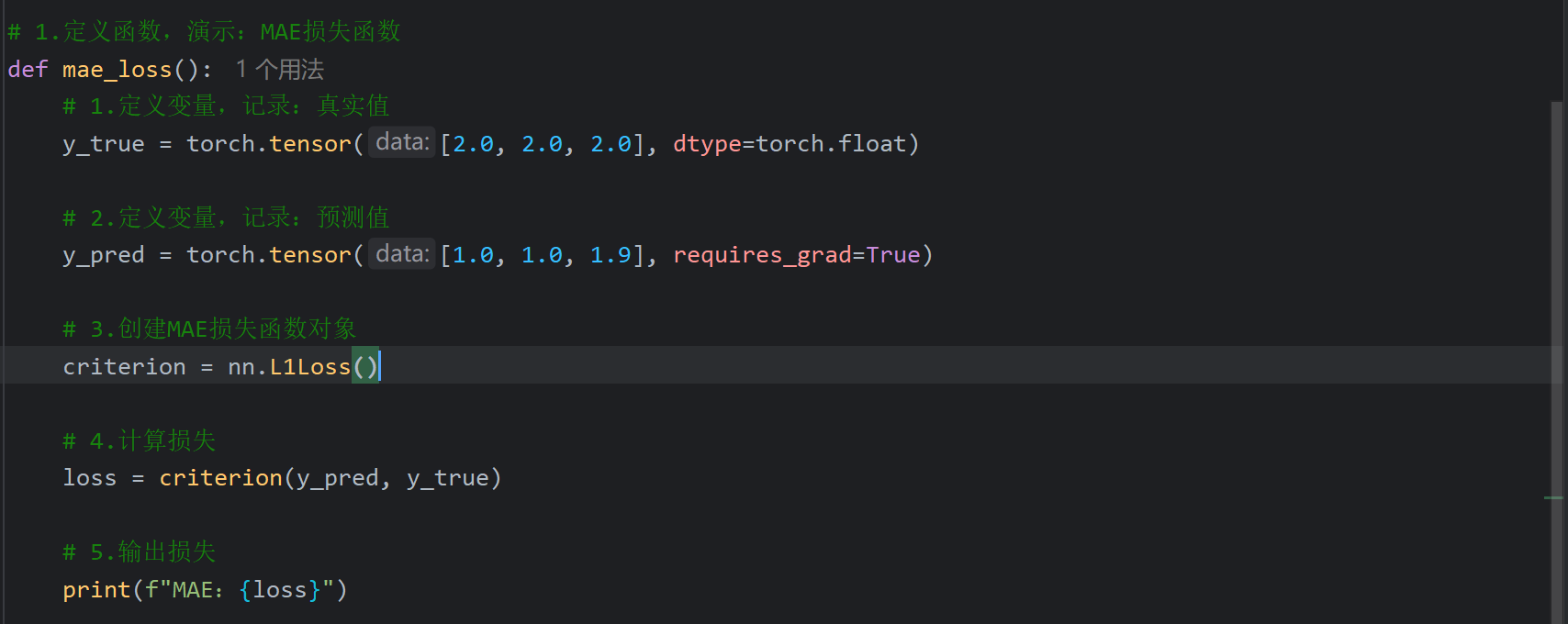

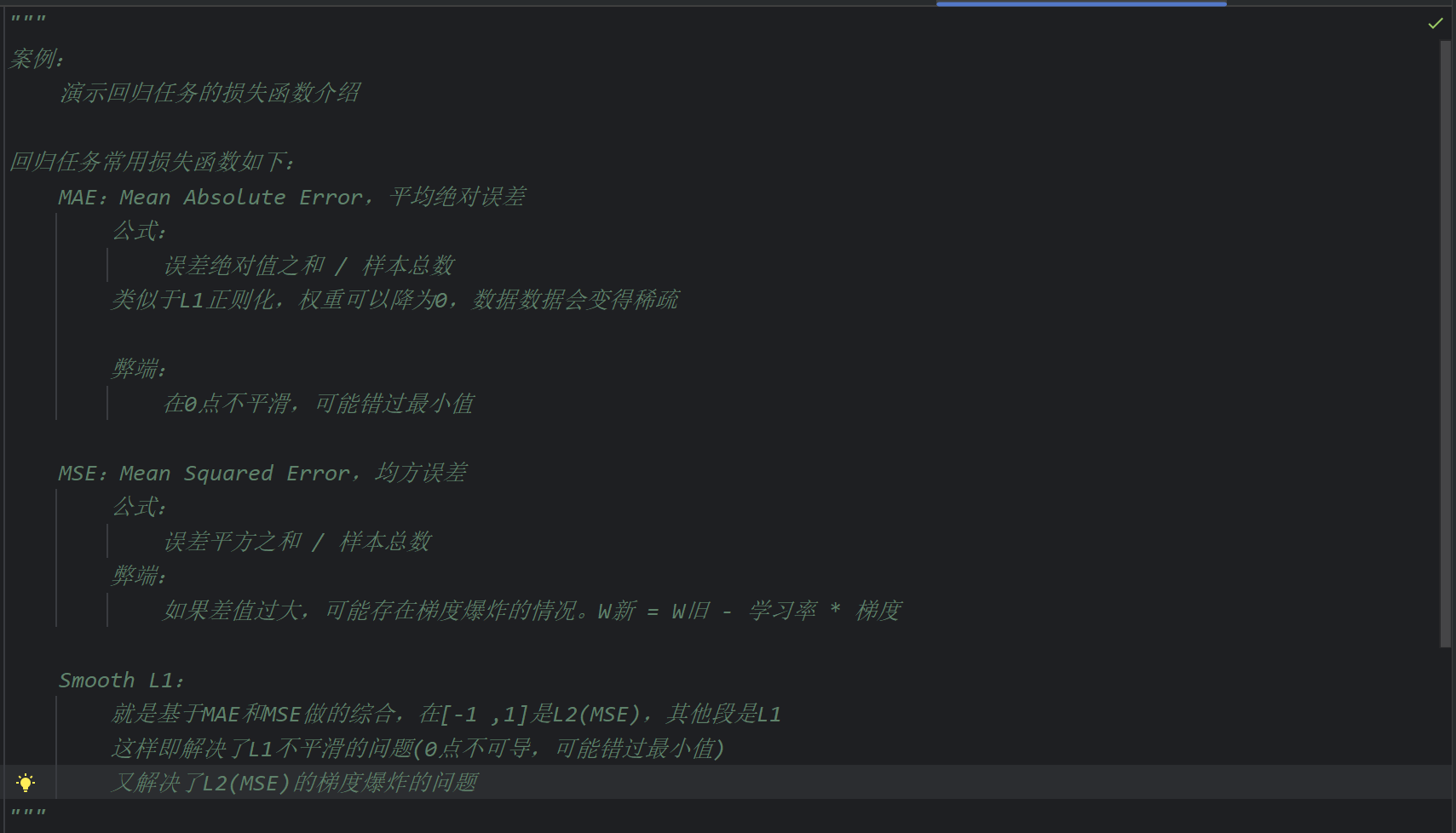

9、损失函数_MAE损失函数介绍

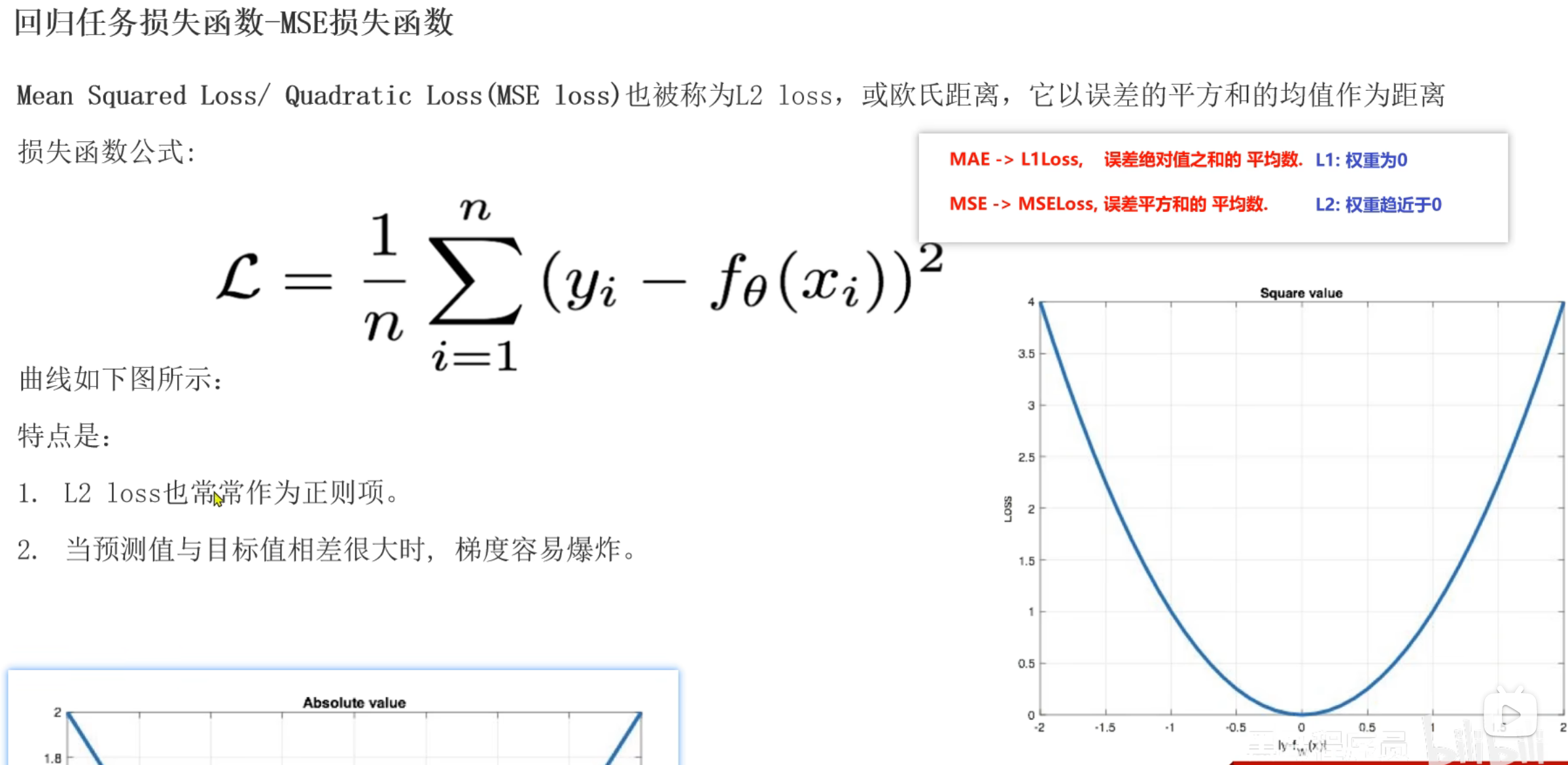

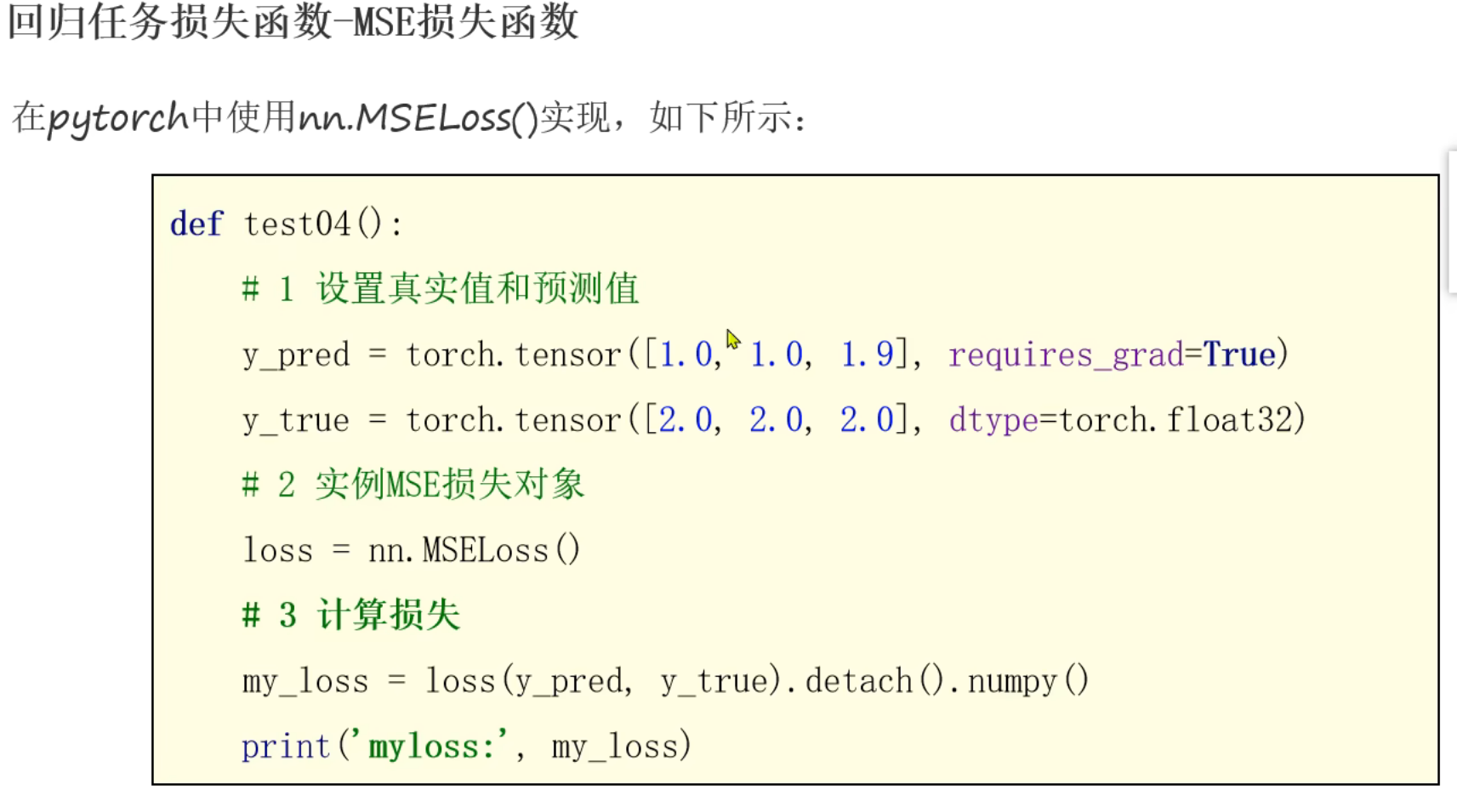

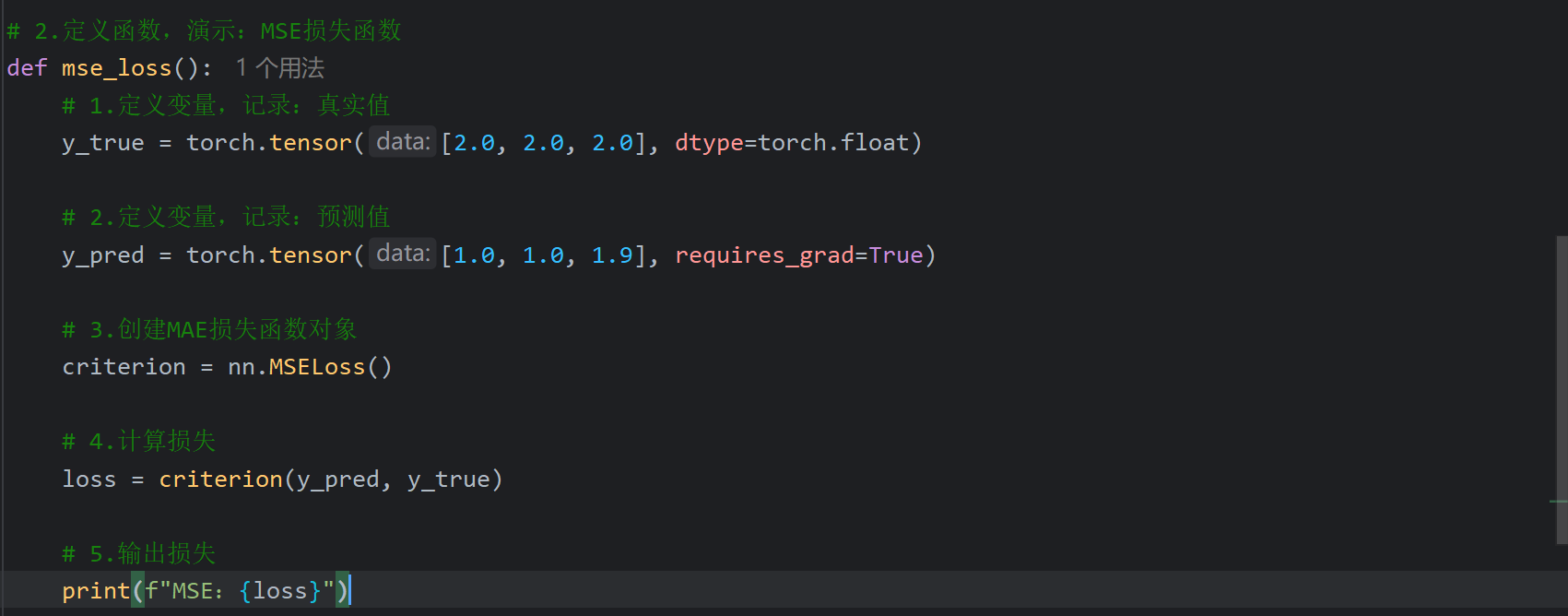

10、损失函数_MSE损失函数介绍

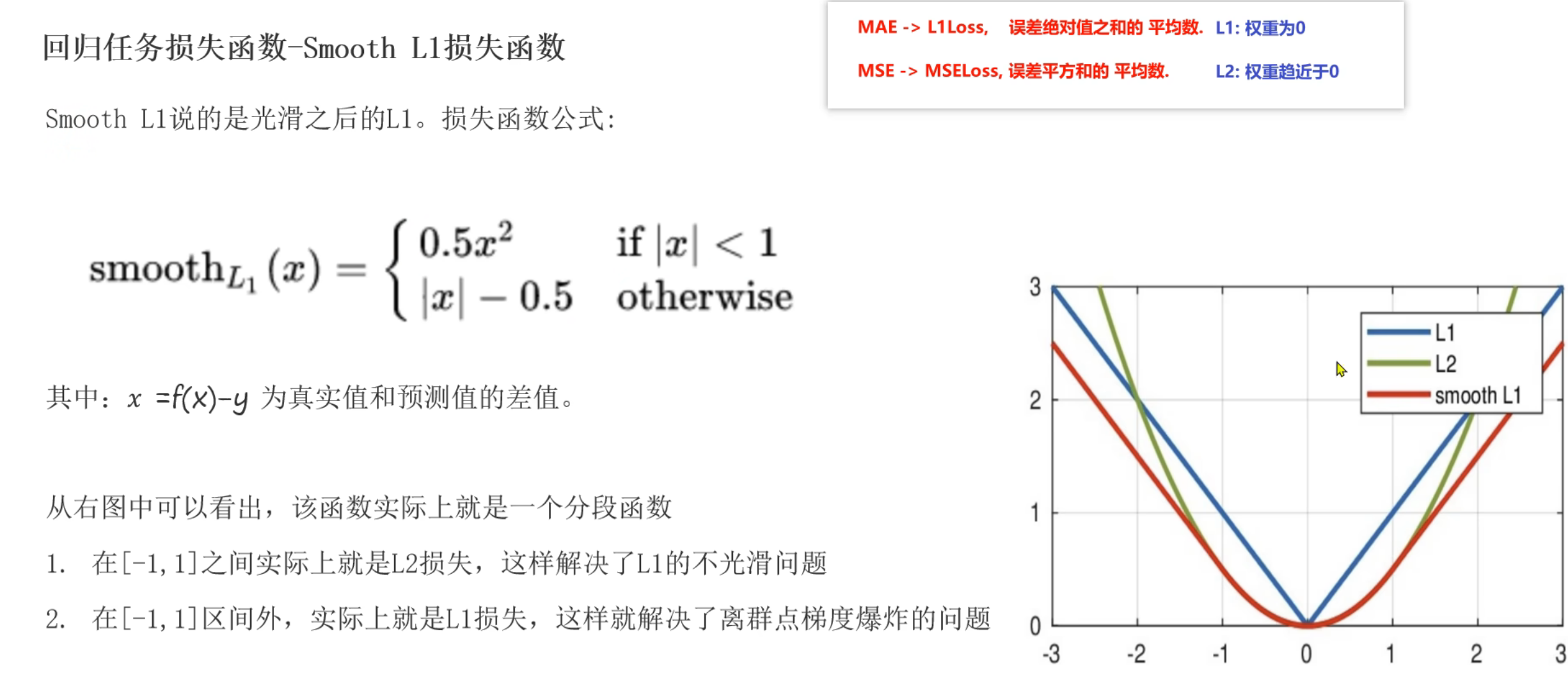

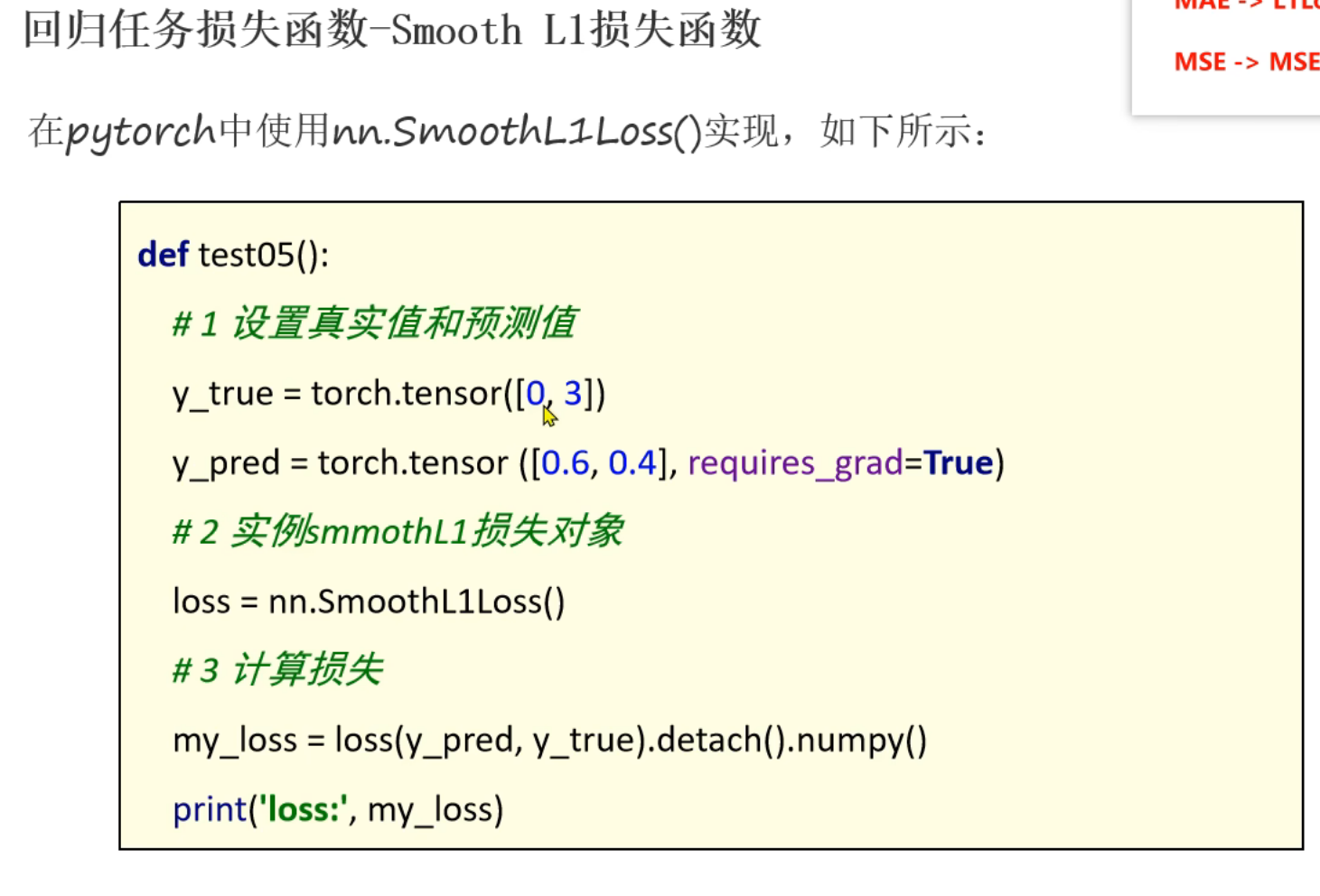

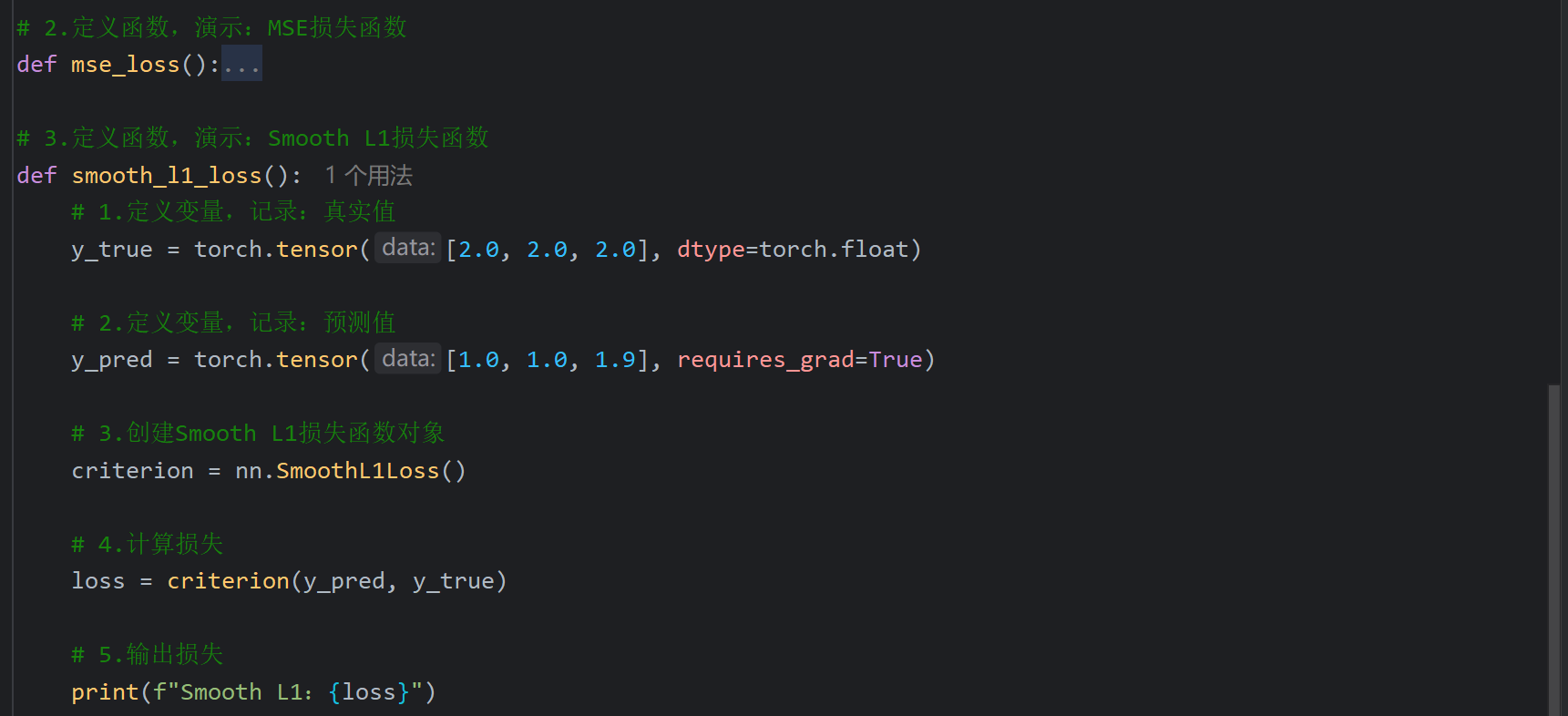

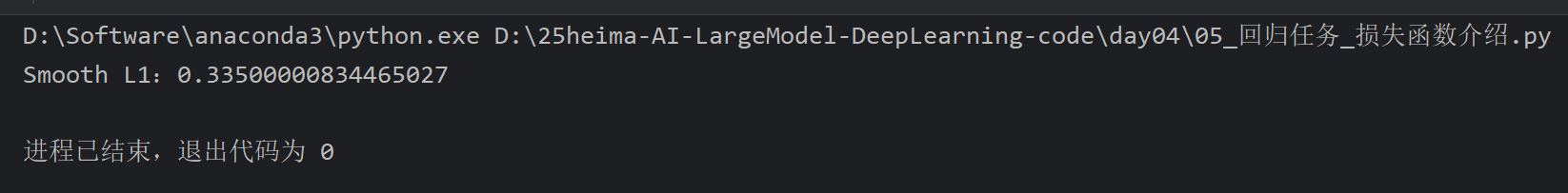

11、损失函数_Smooth L1损失函数介绍

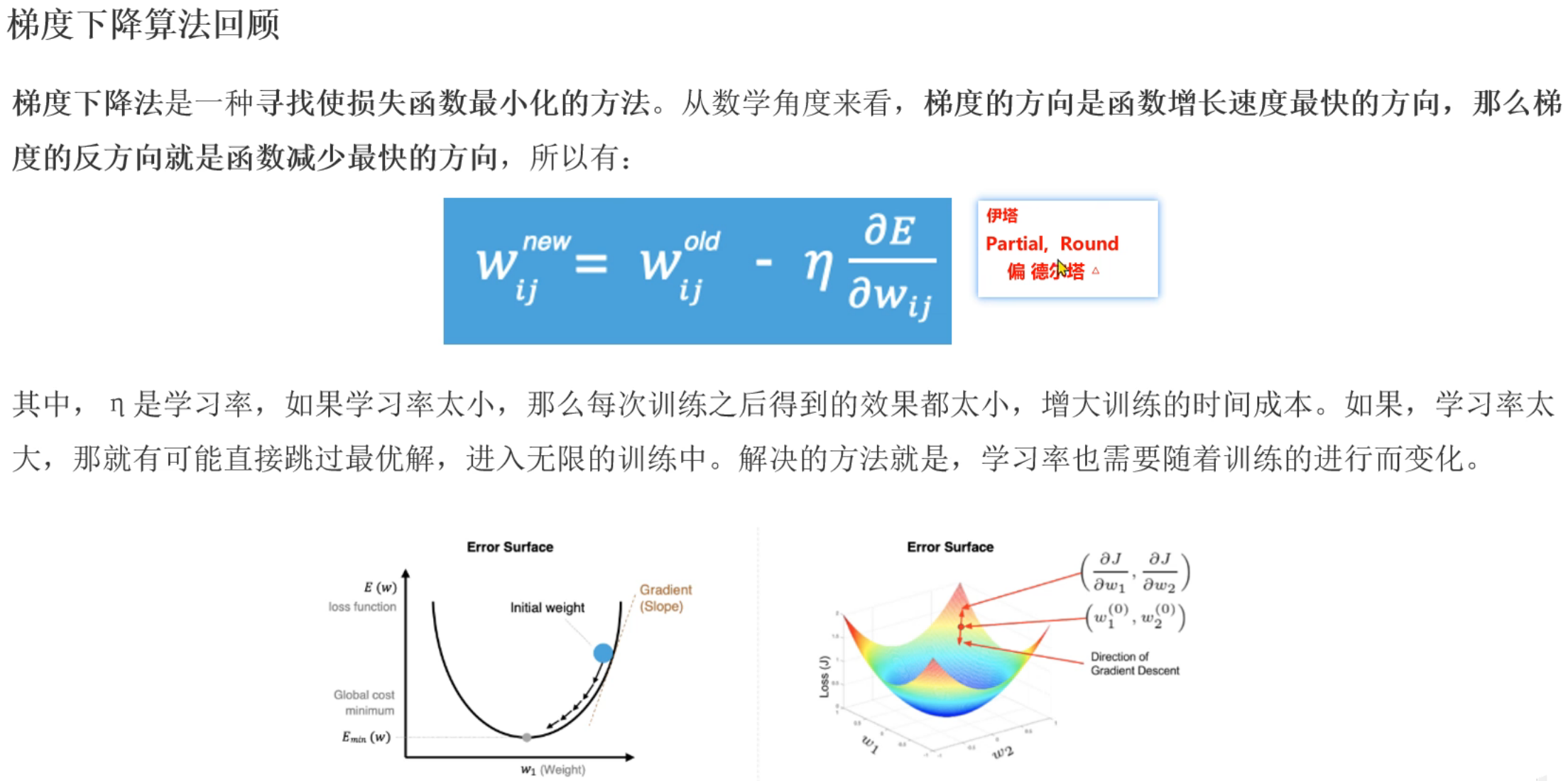

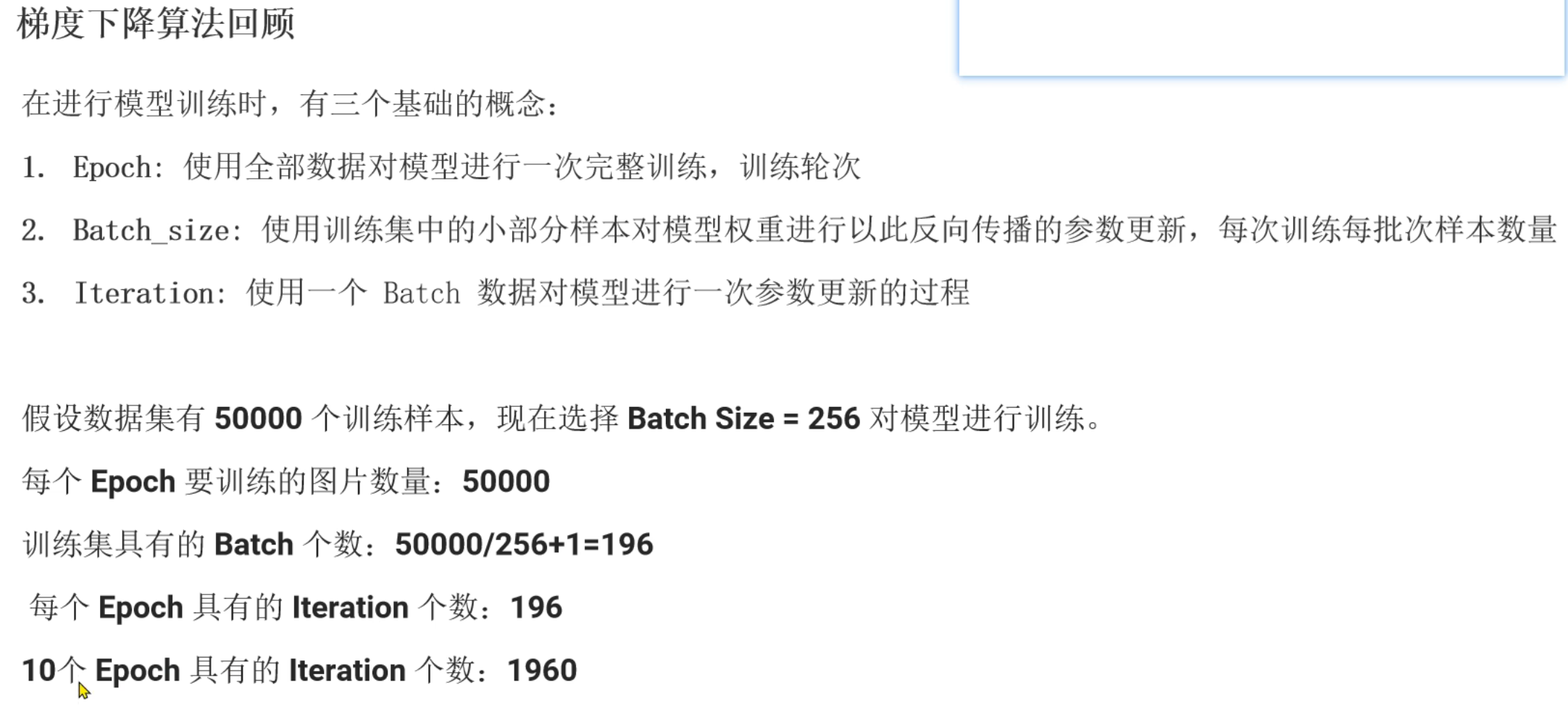

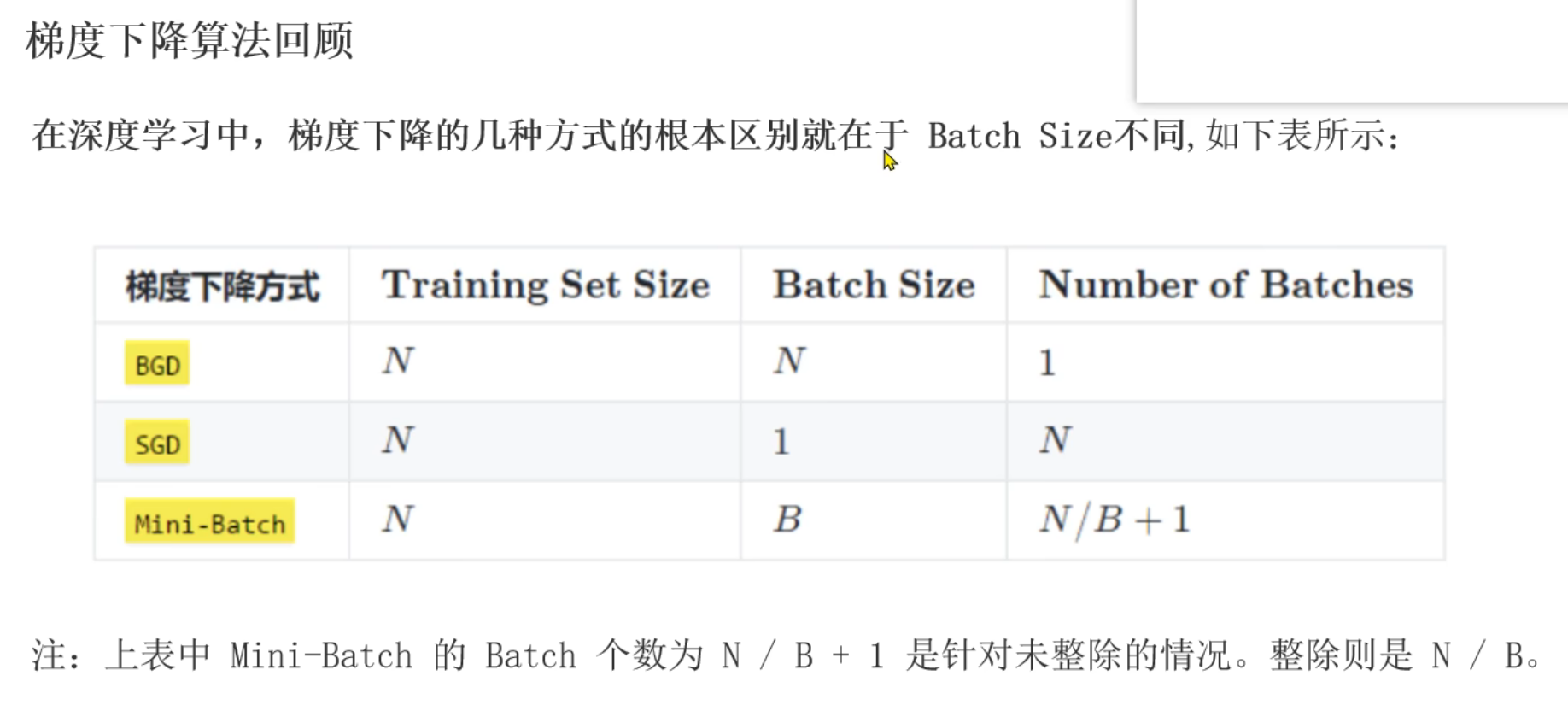

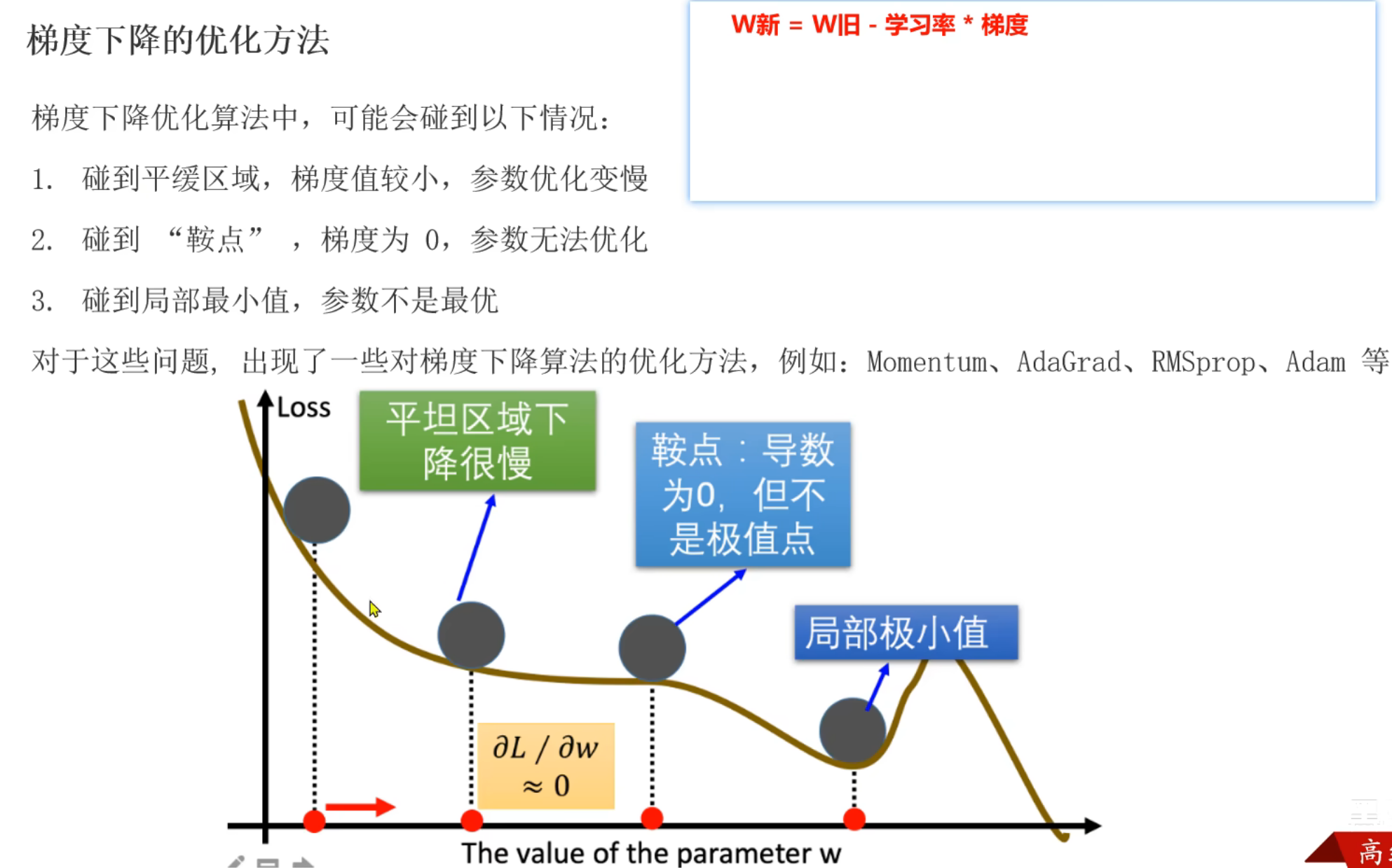

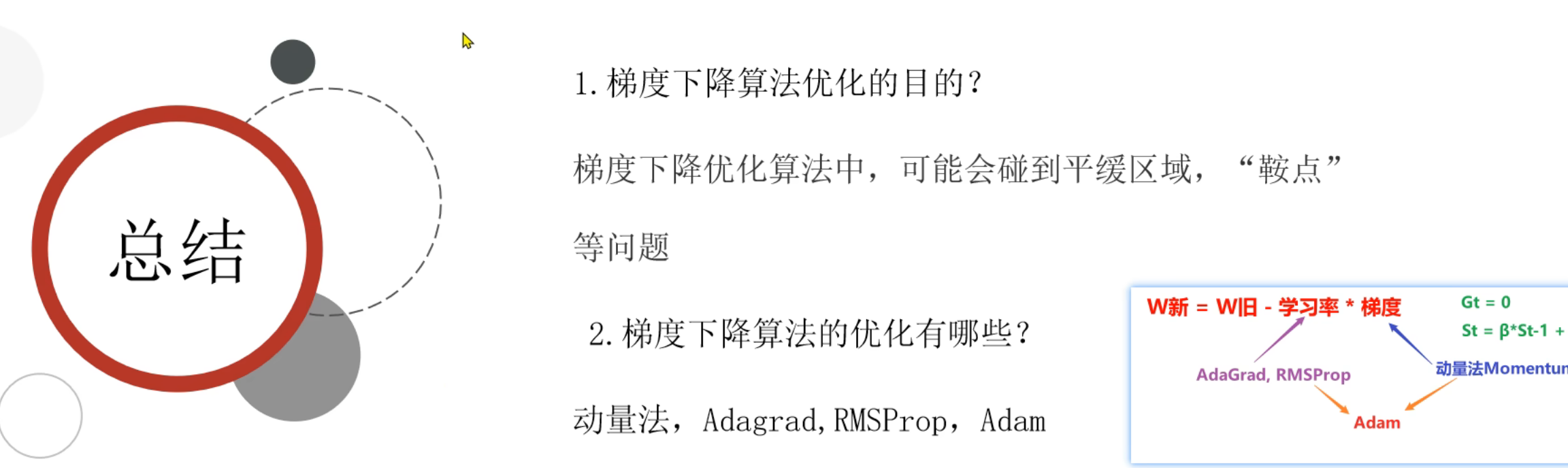

12、梯度下降算法回顾

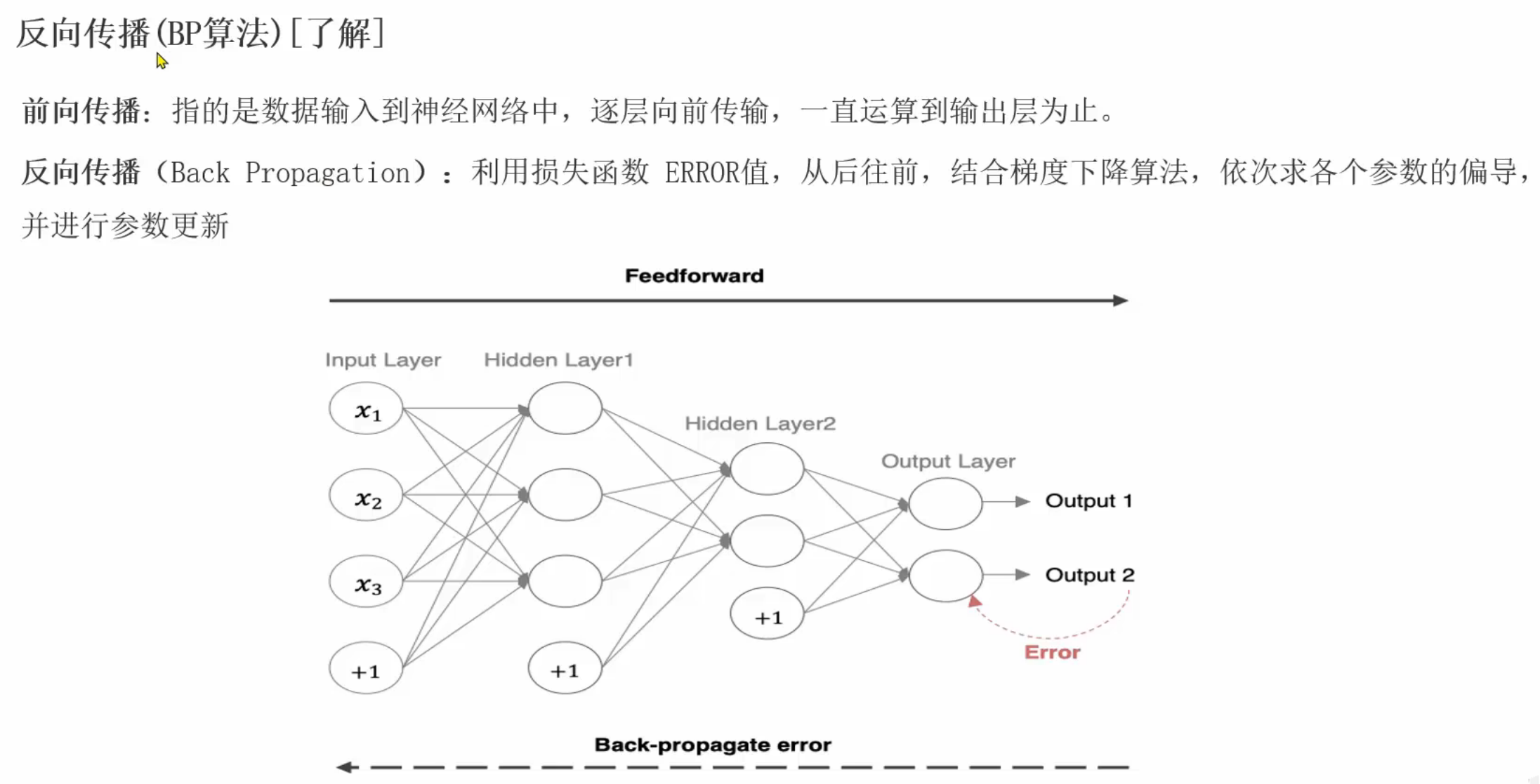

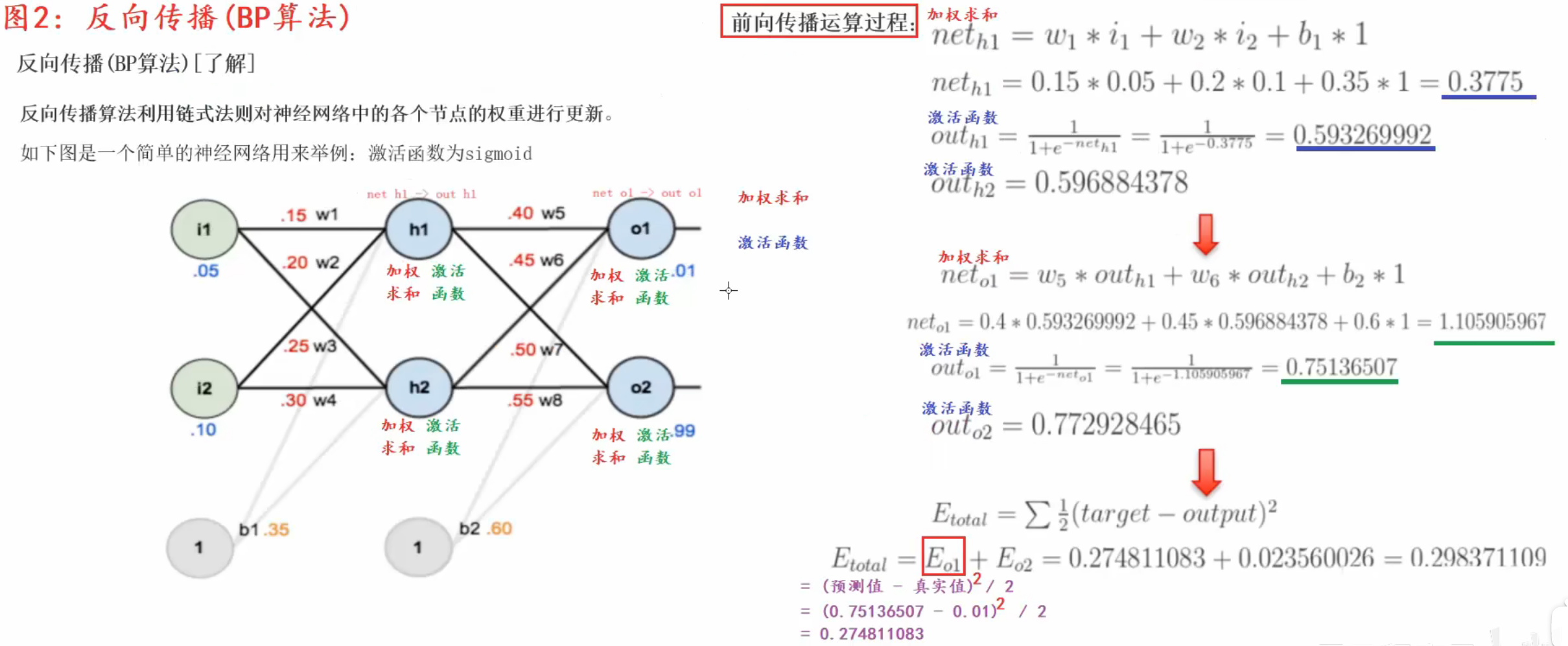

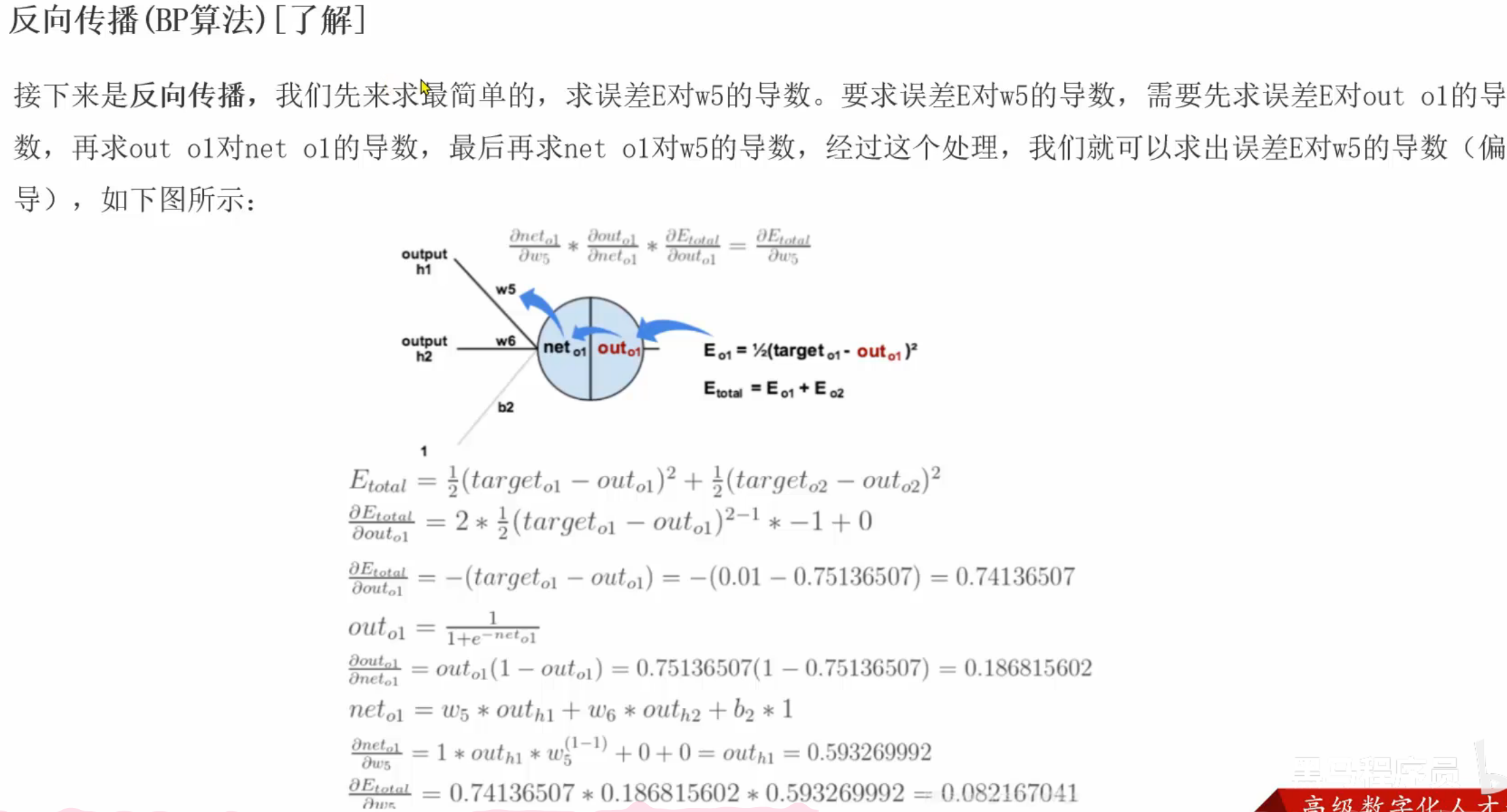

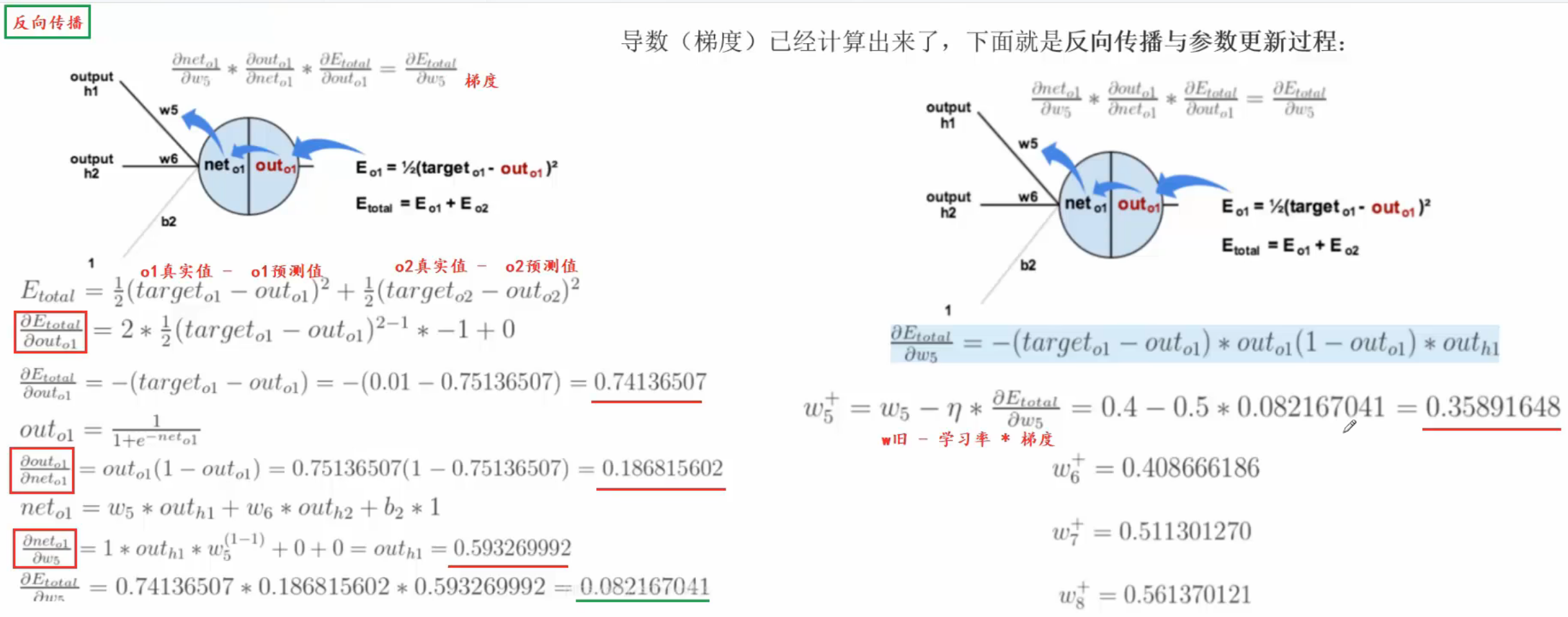

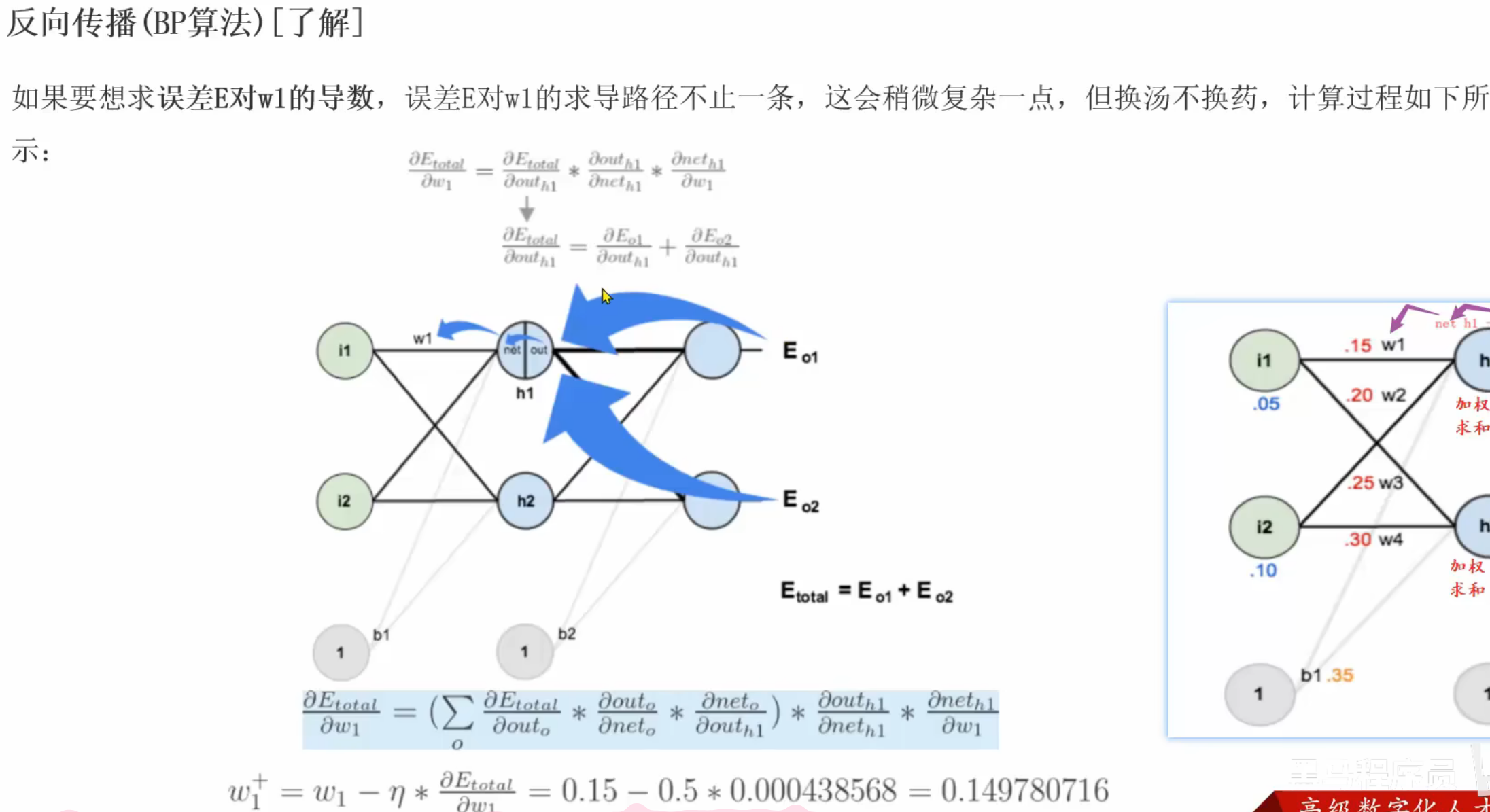

13、反向传播(了解)

六、Day05

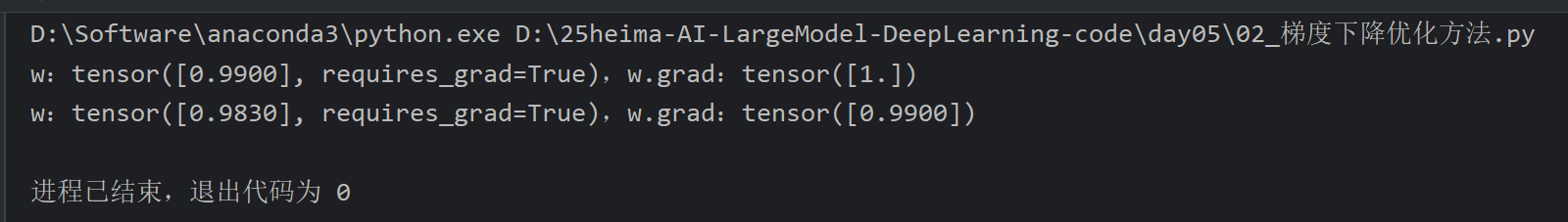

1、梯度相关知识回顾

就是拿之前的ppt过了一遍

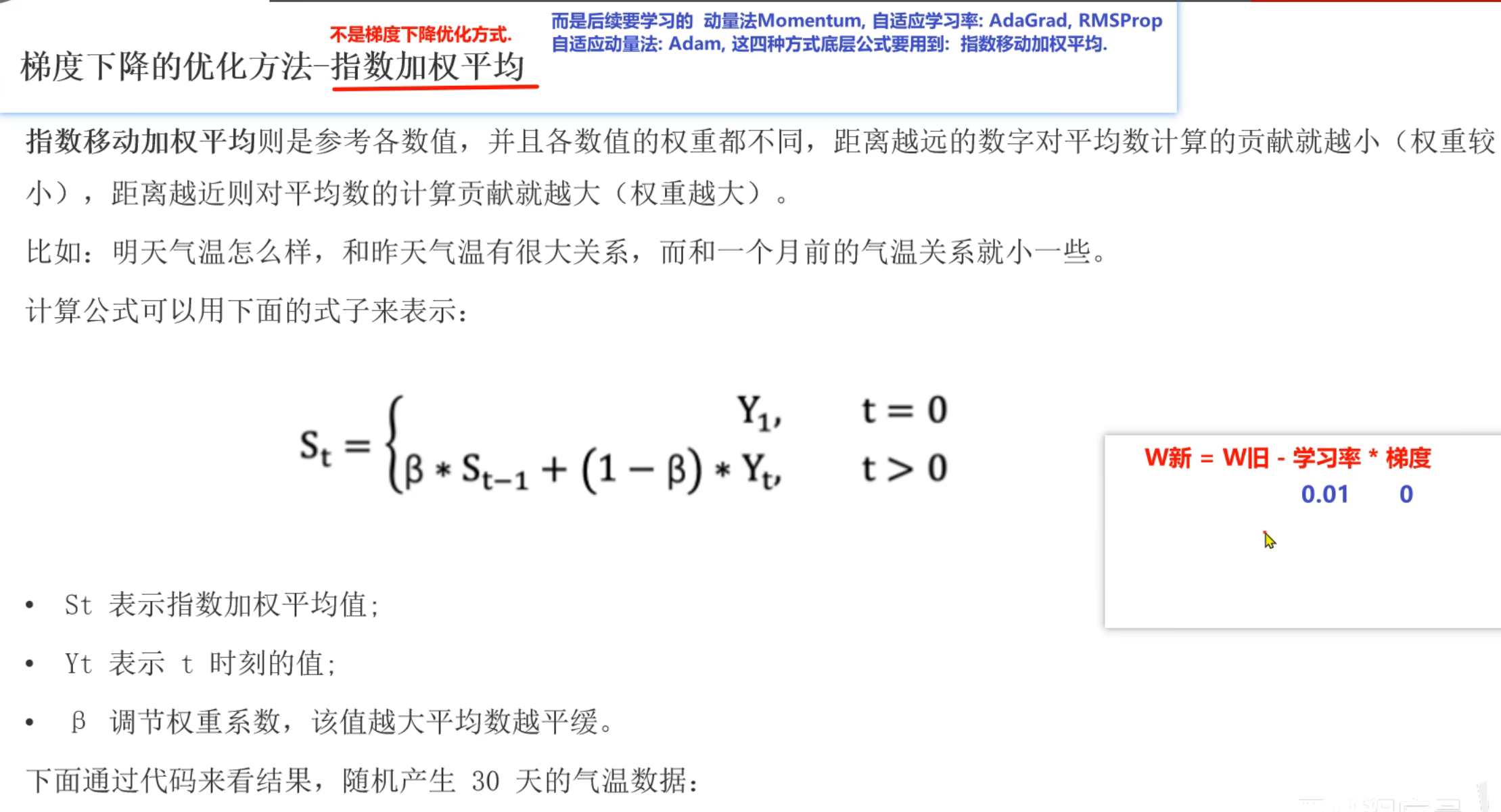

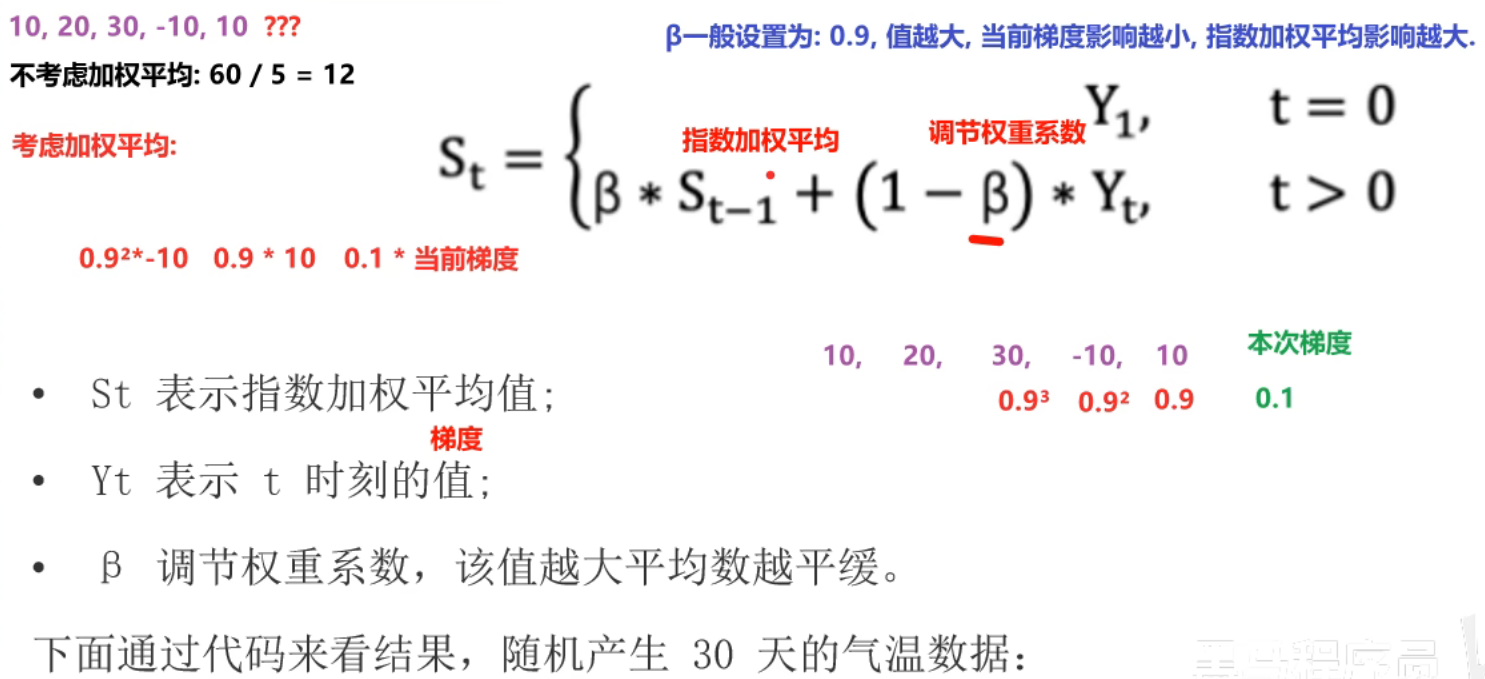

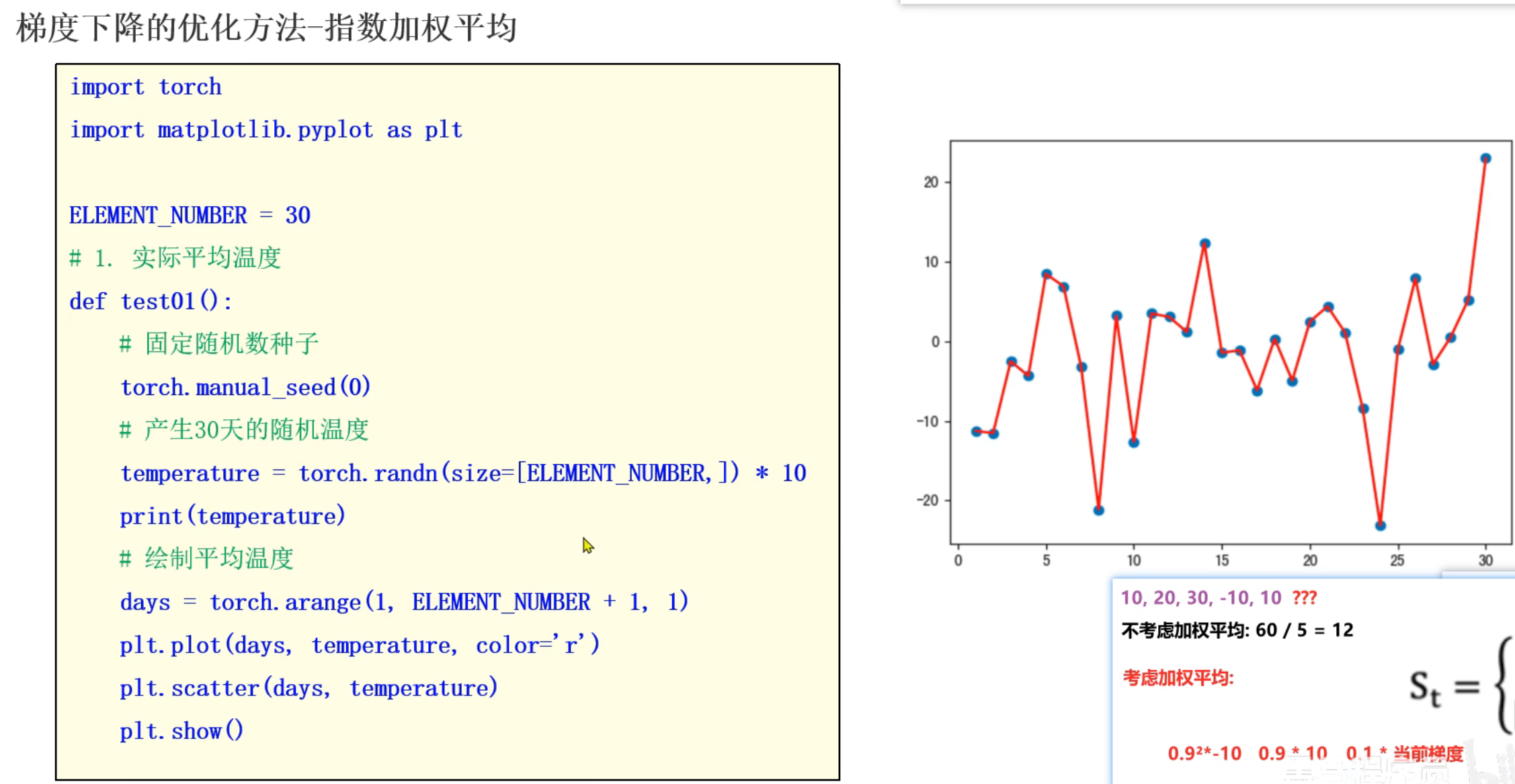

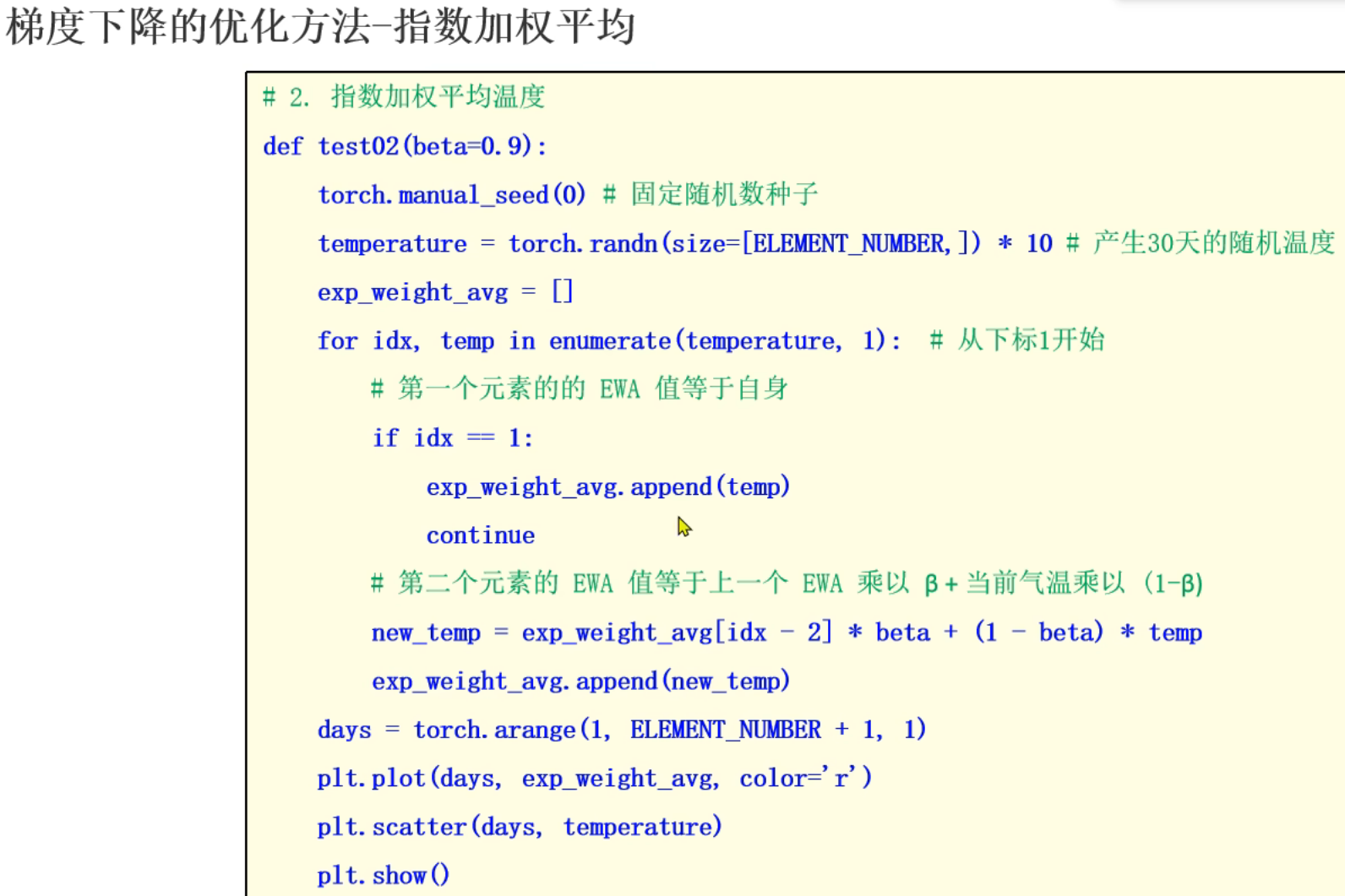

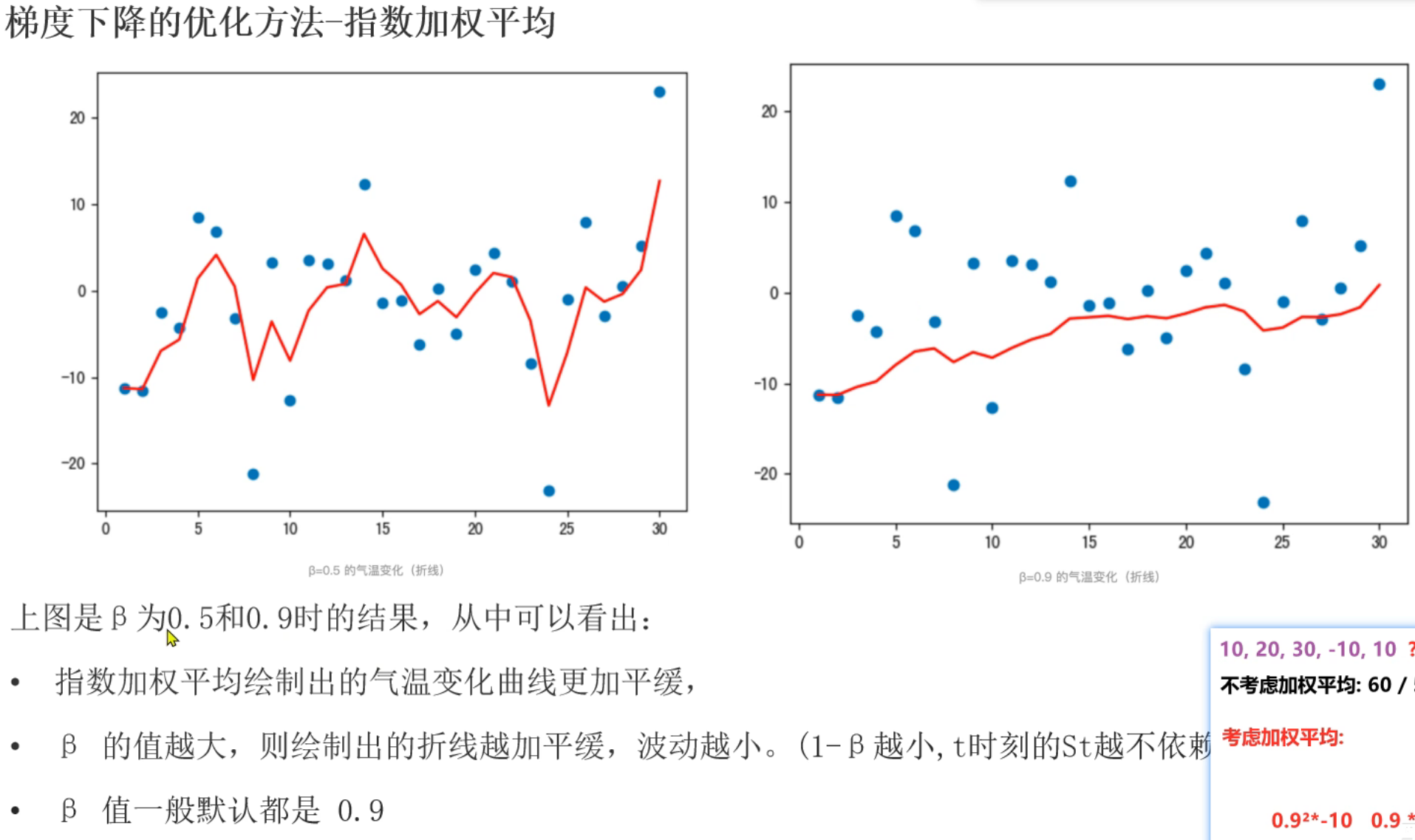

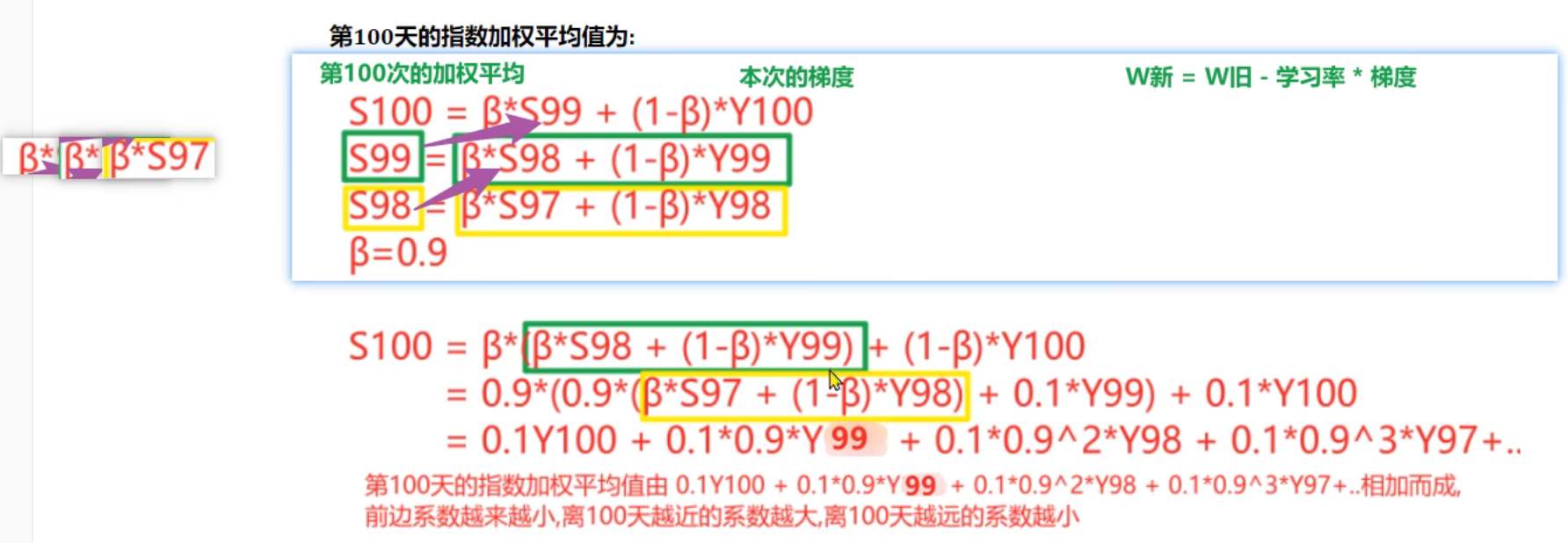

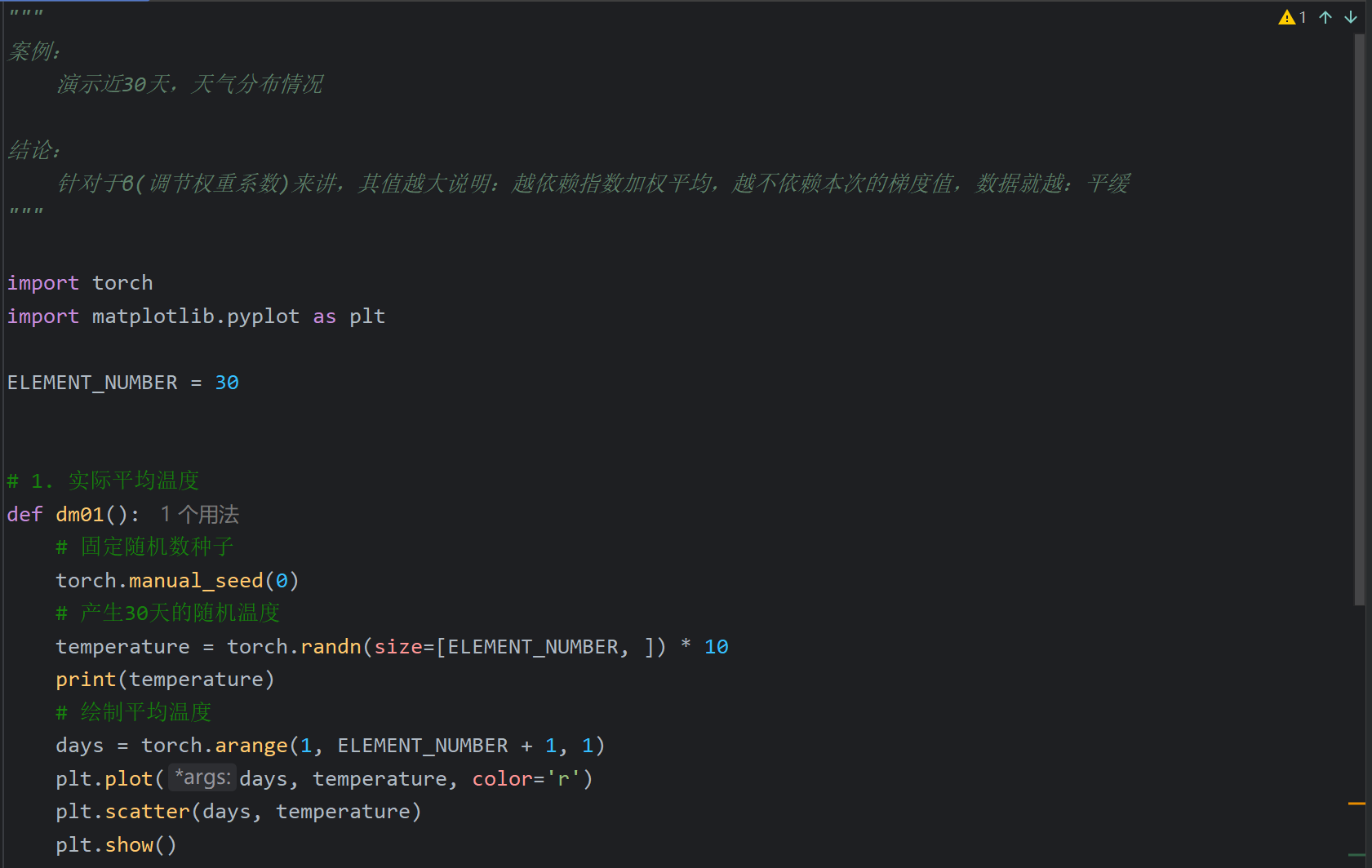

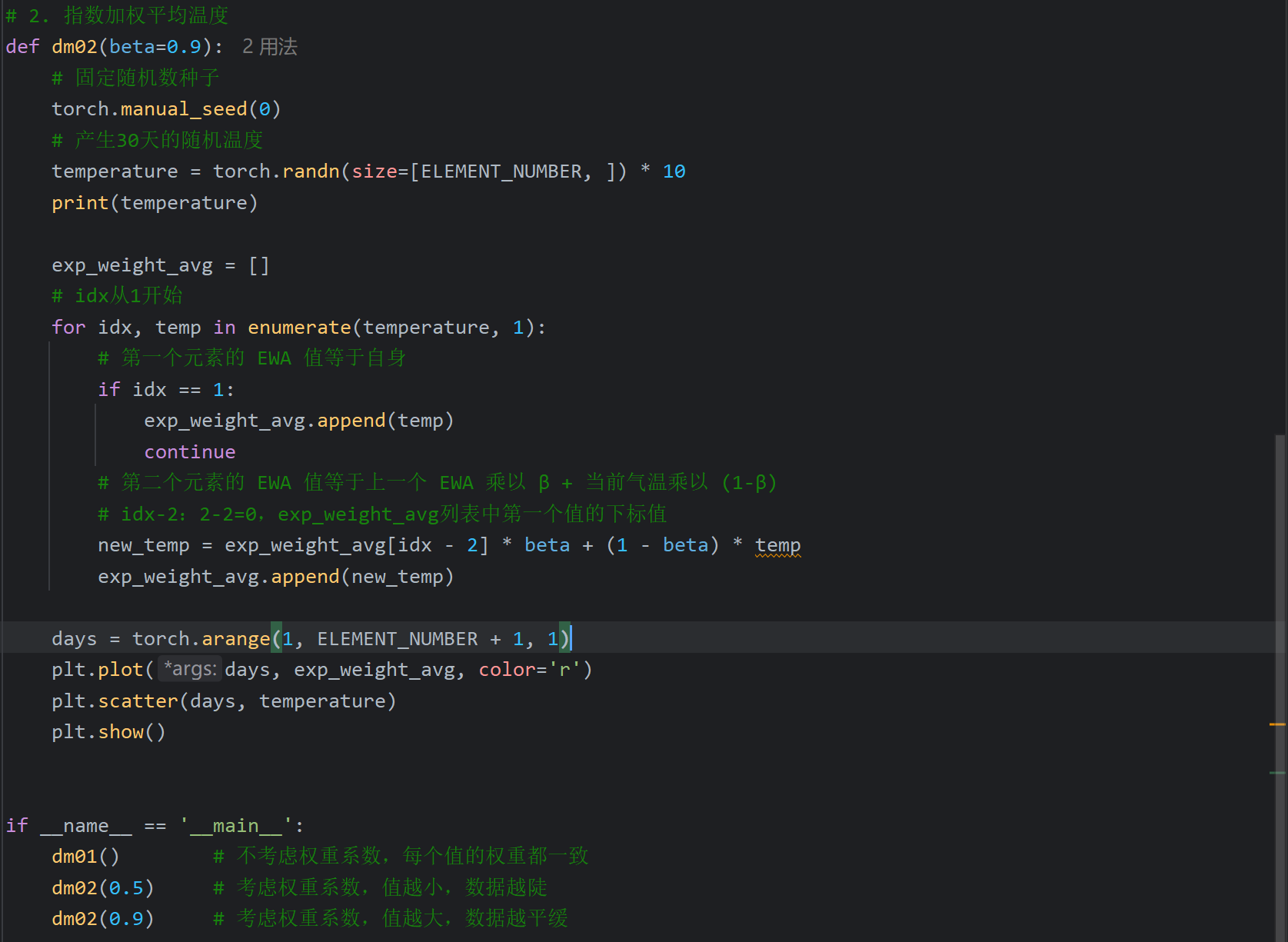

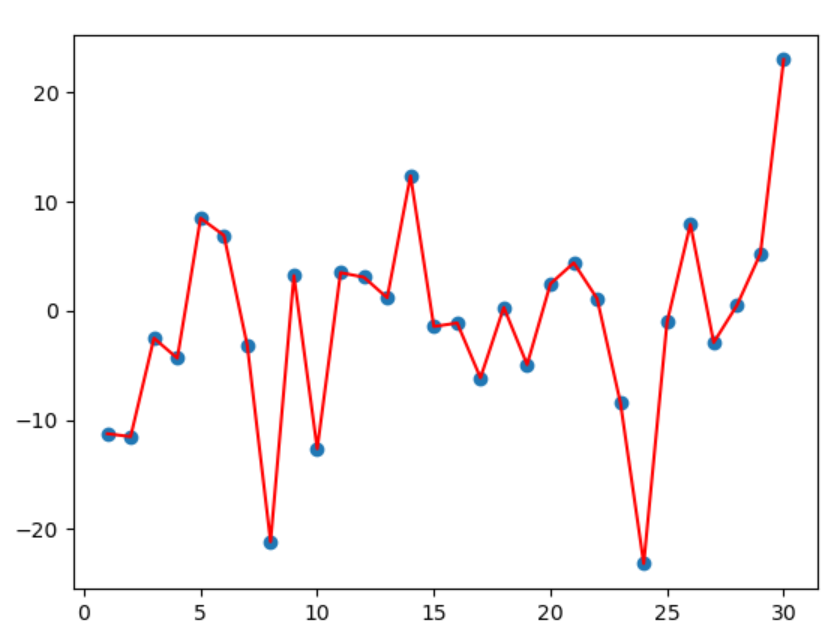

2、指数移动加权平均介绍

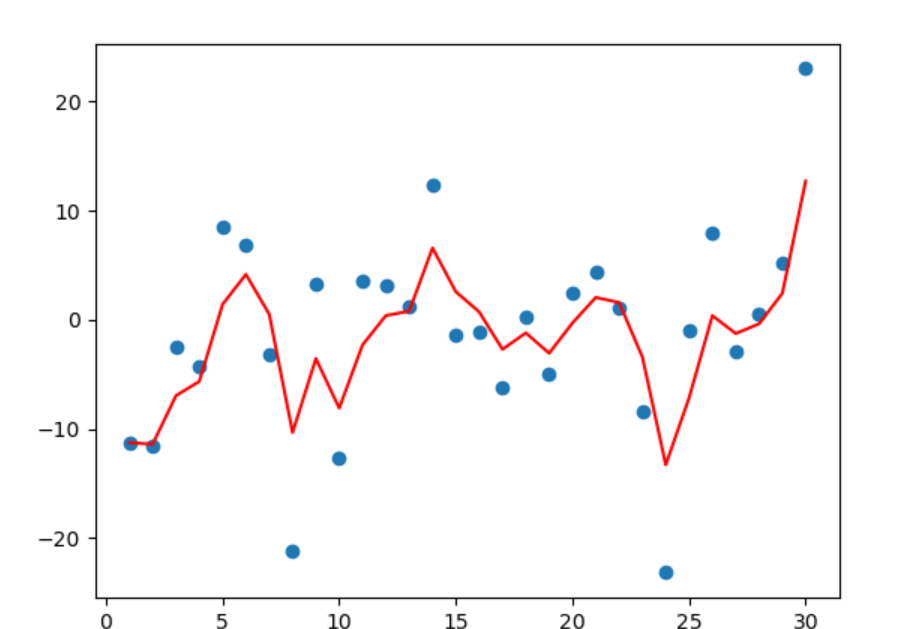

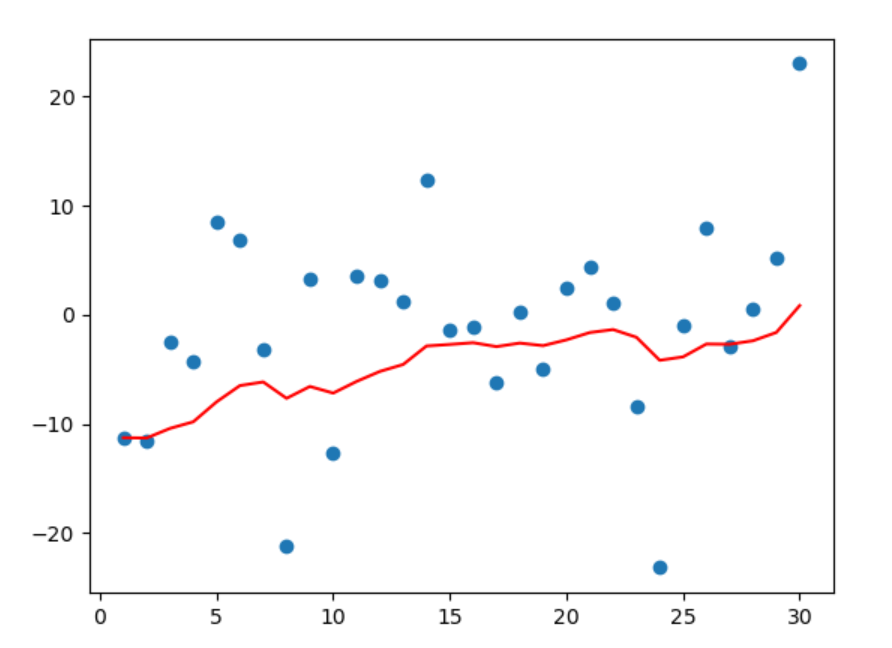

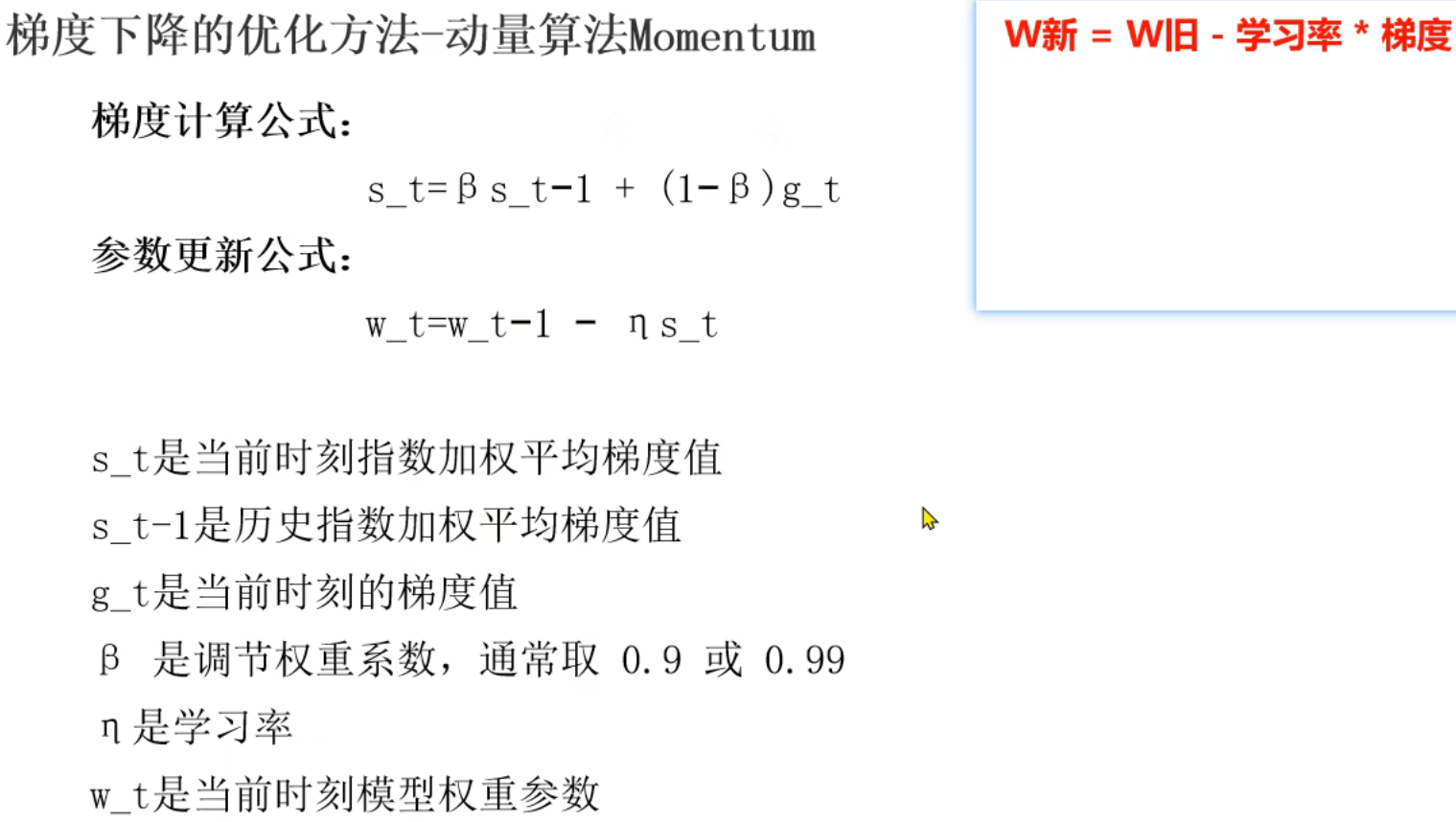

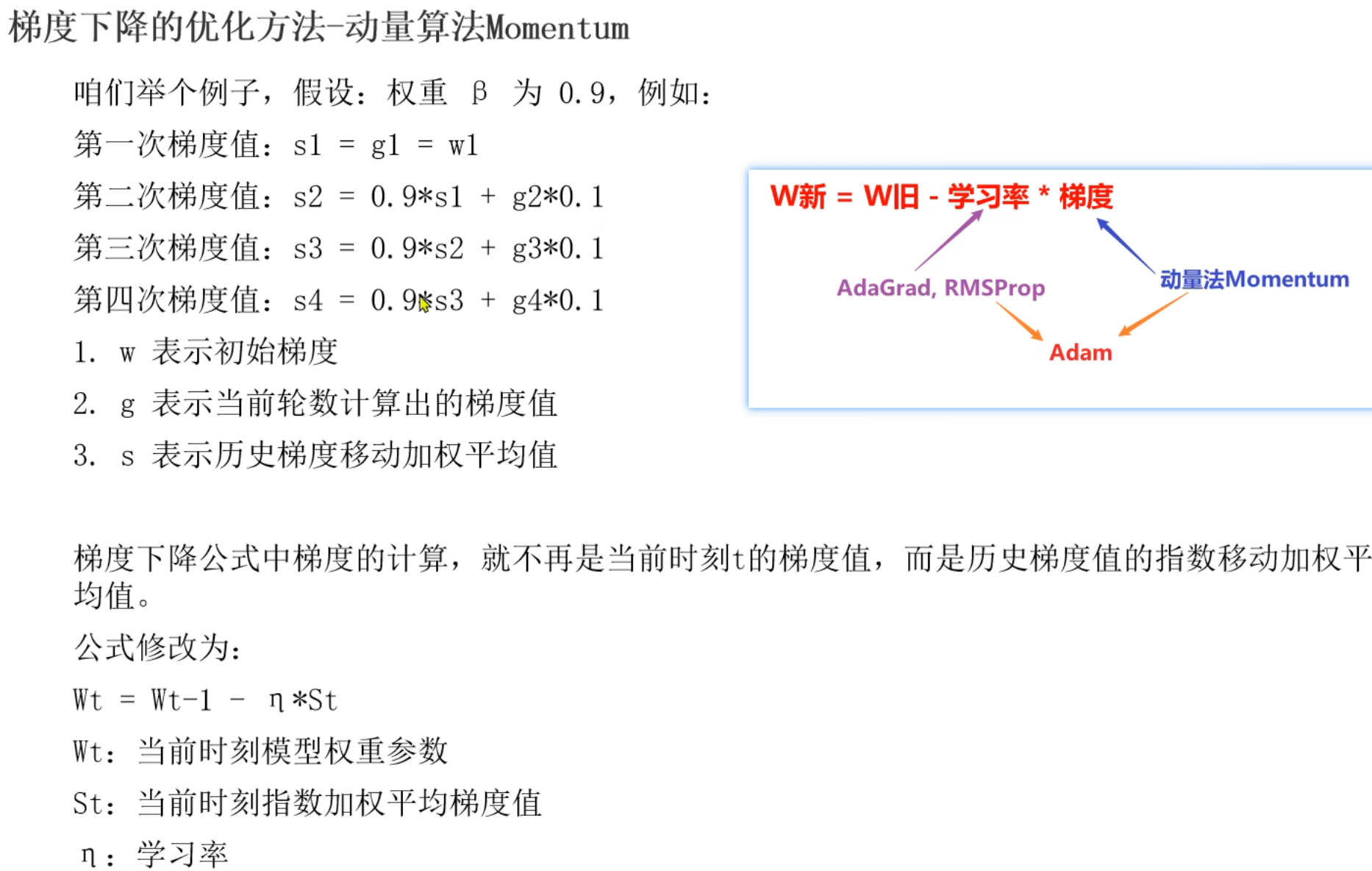

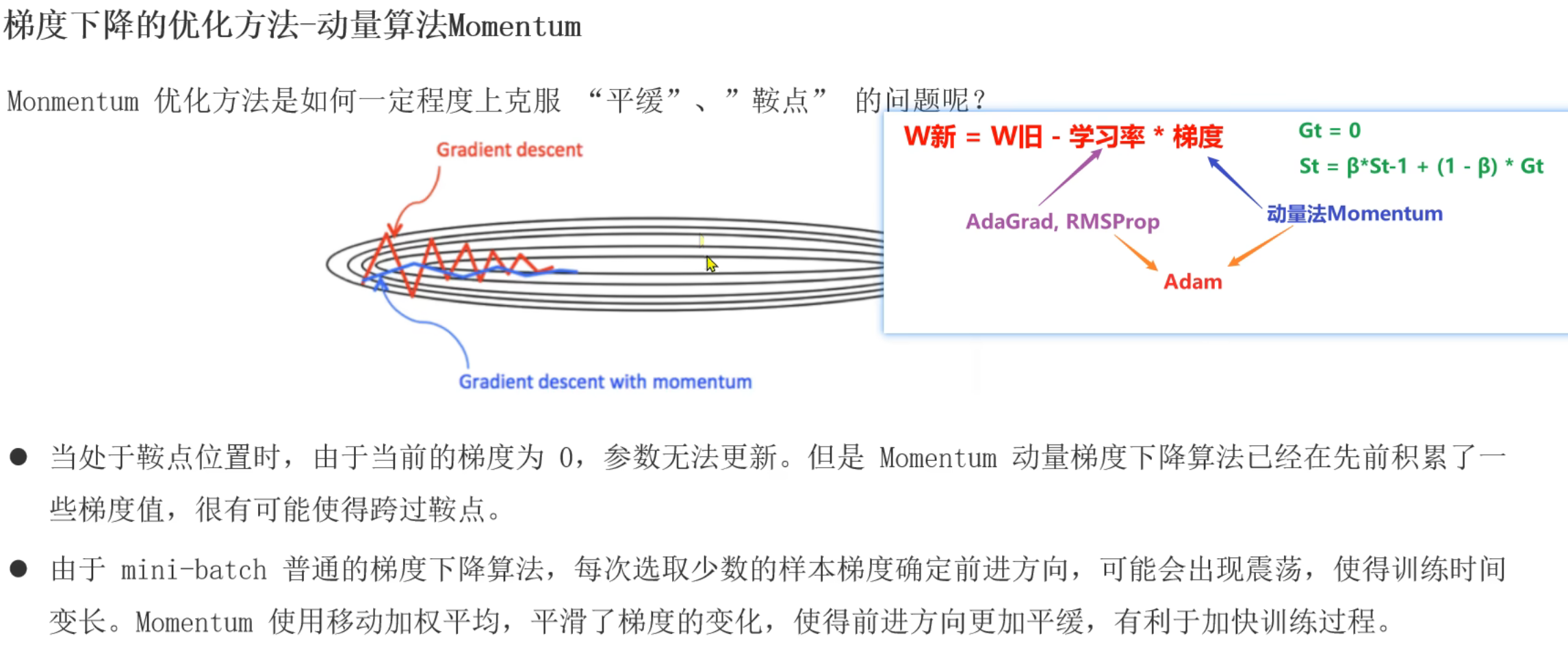

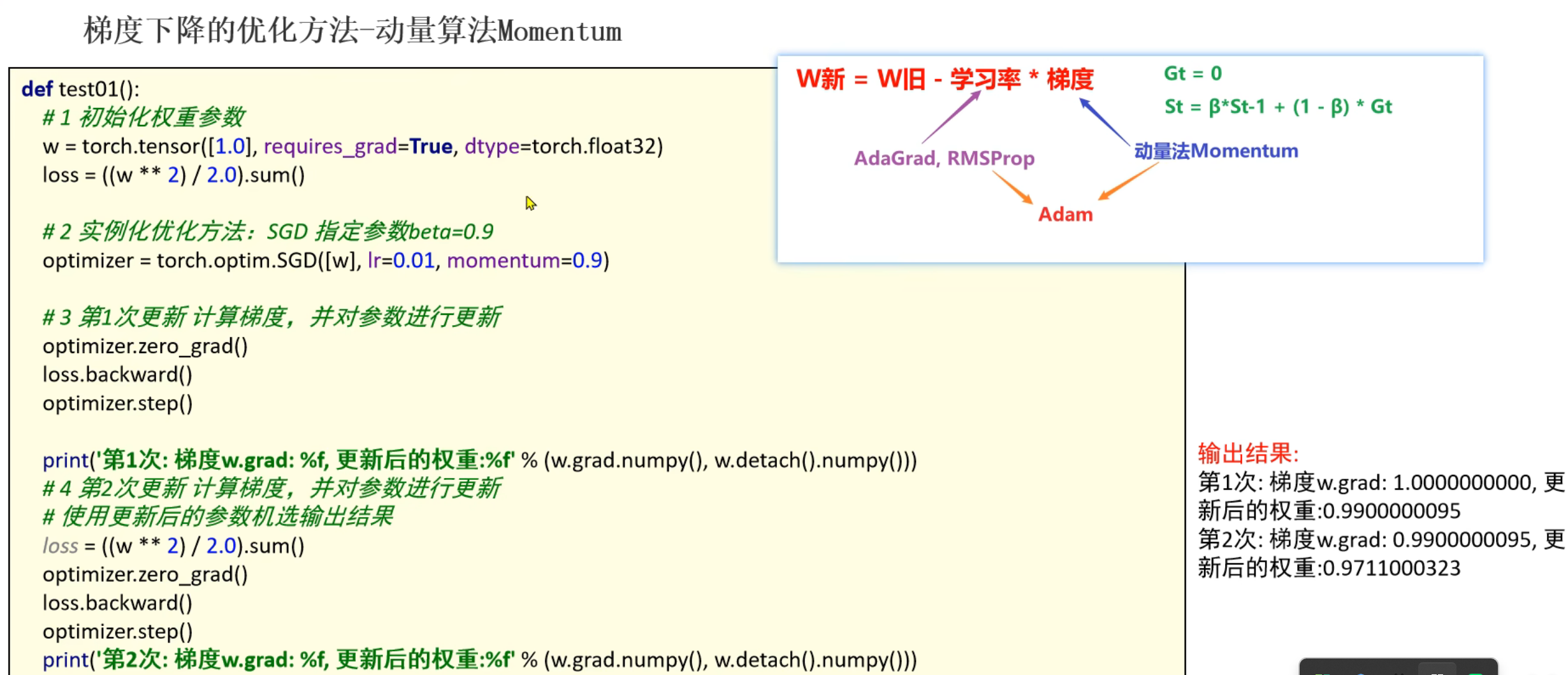

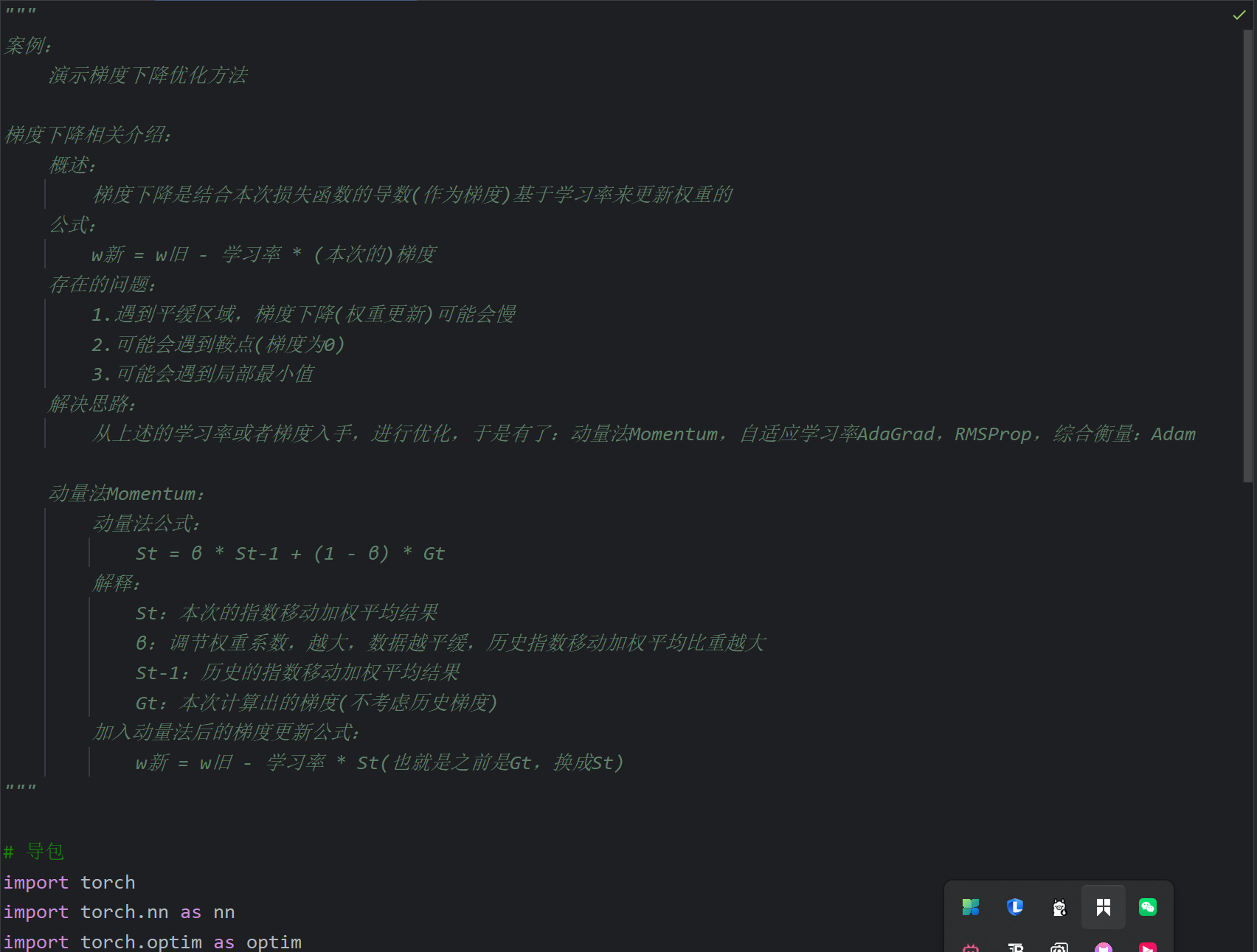

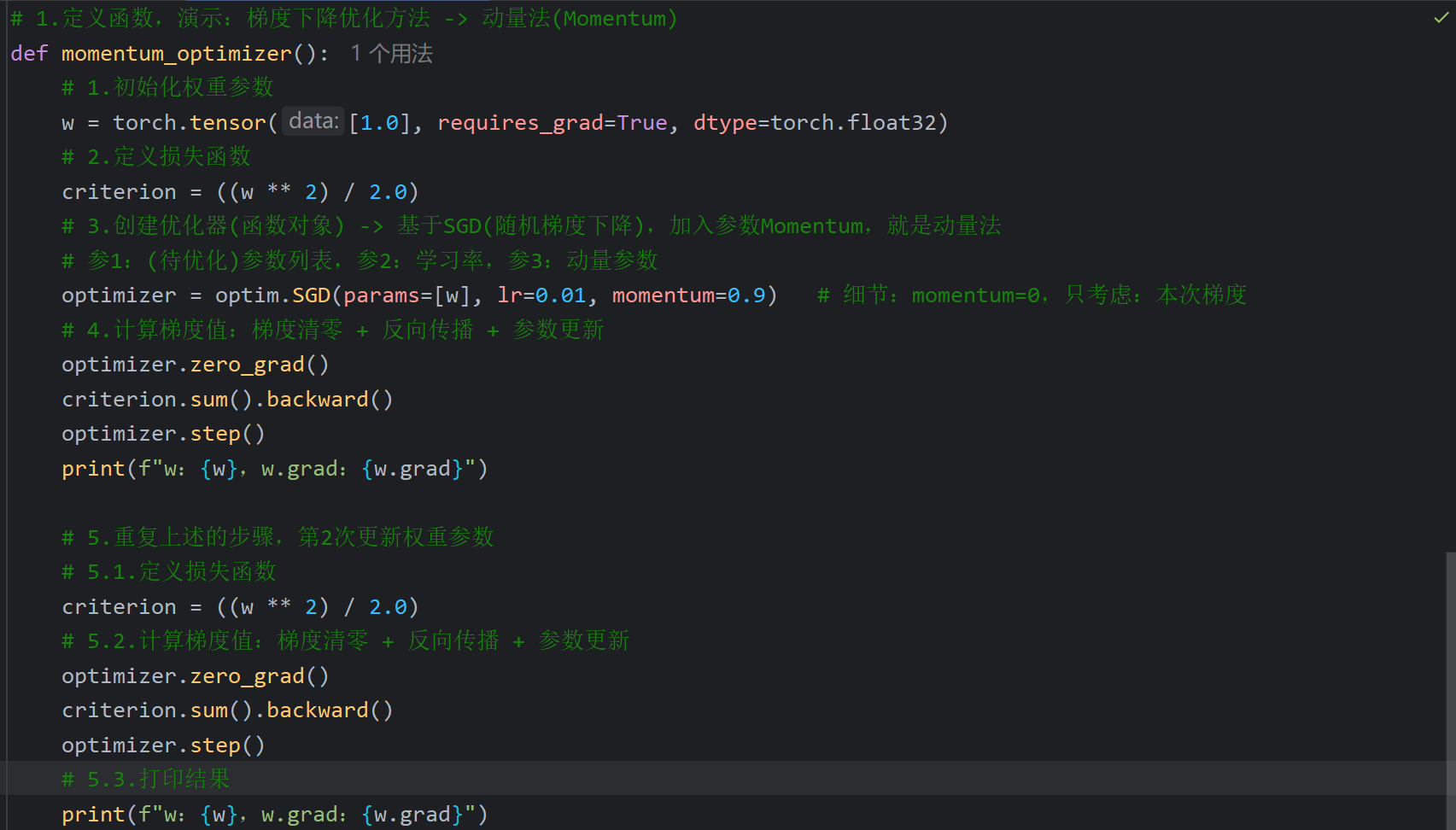

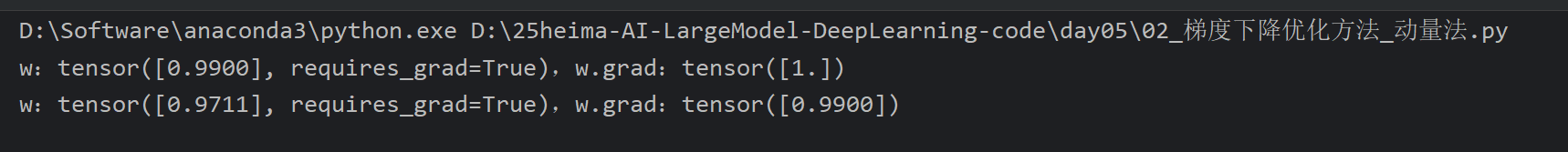

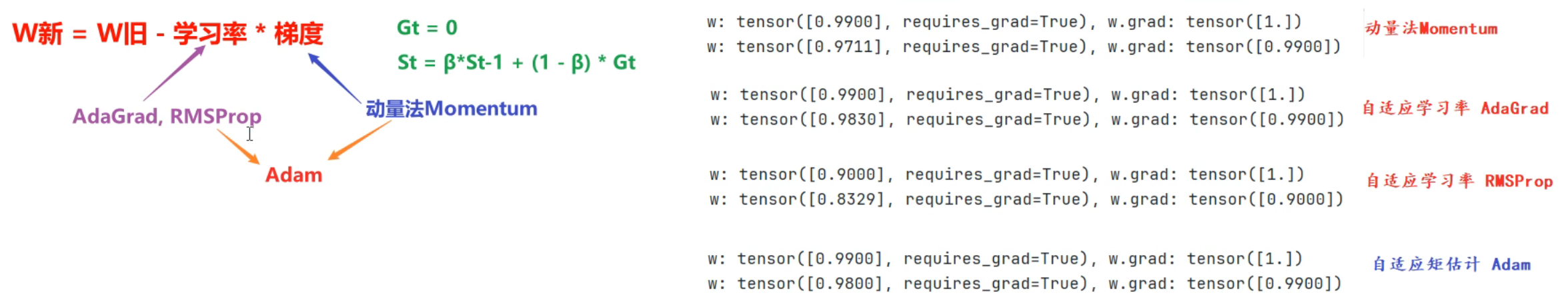

3、梯度下降优化方法_动量法

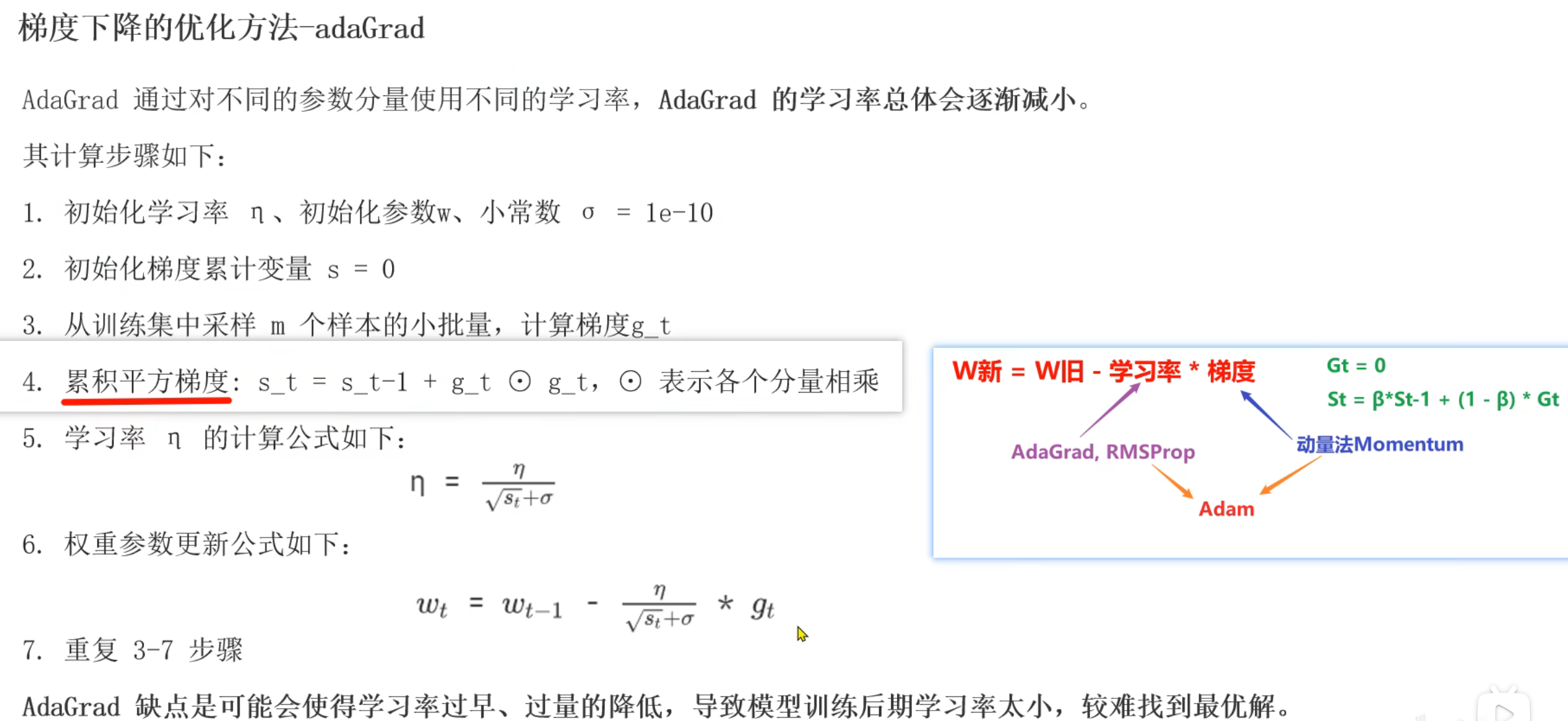

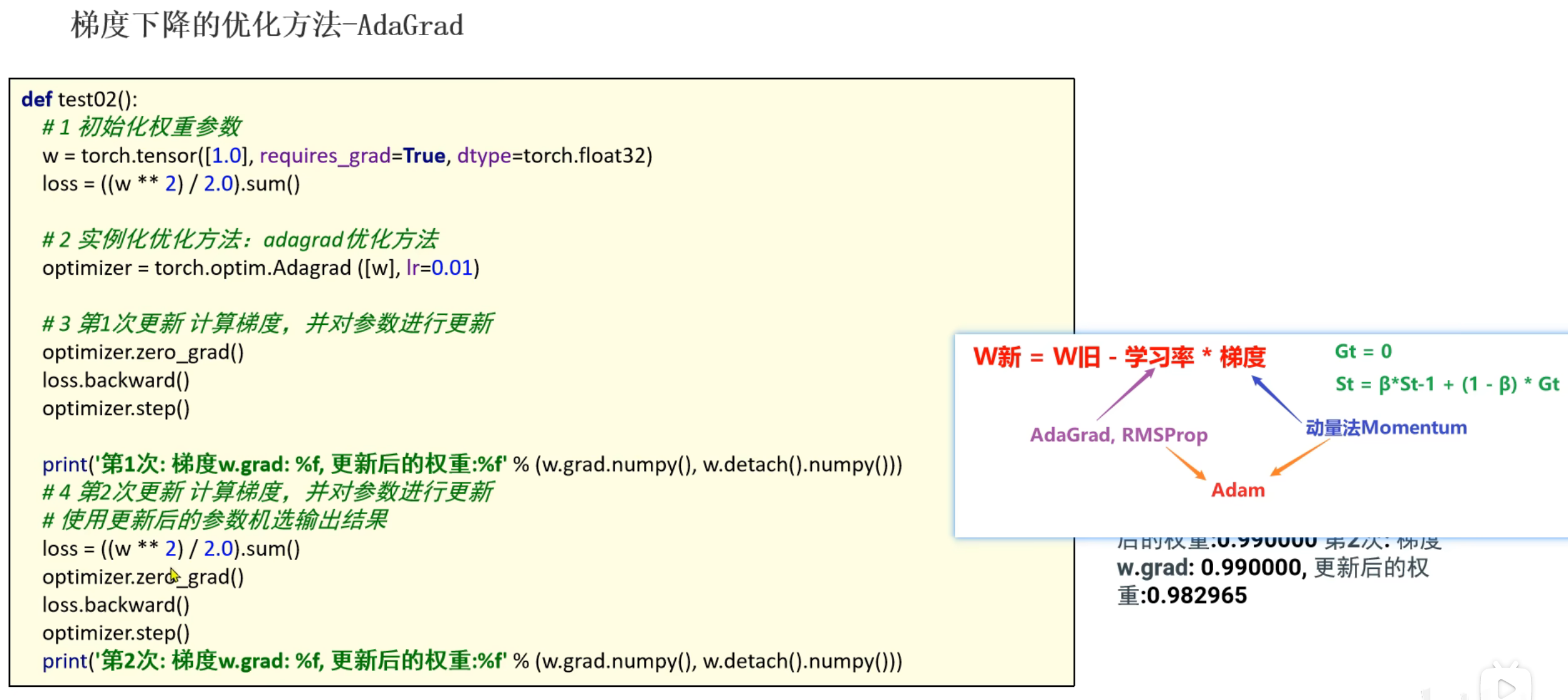

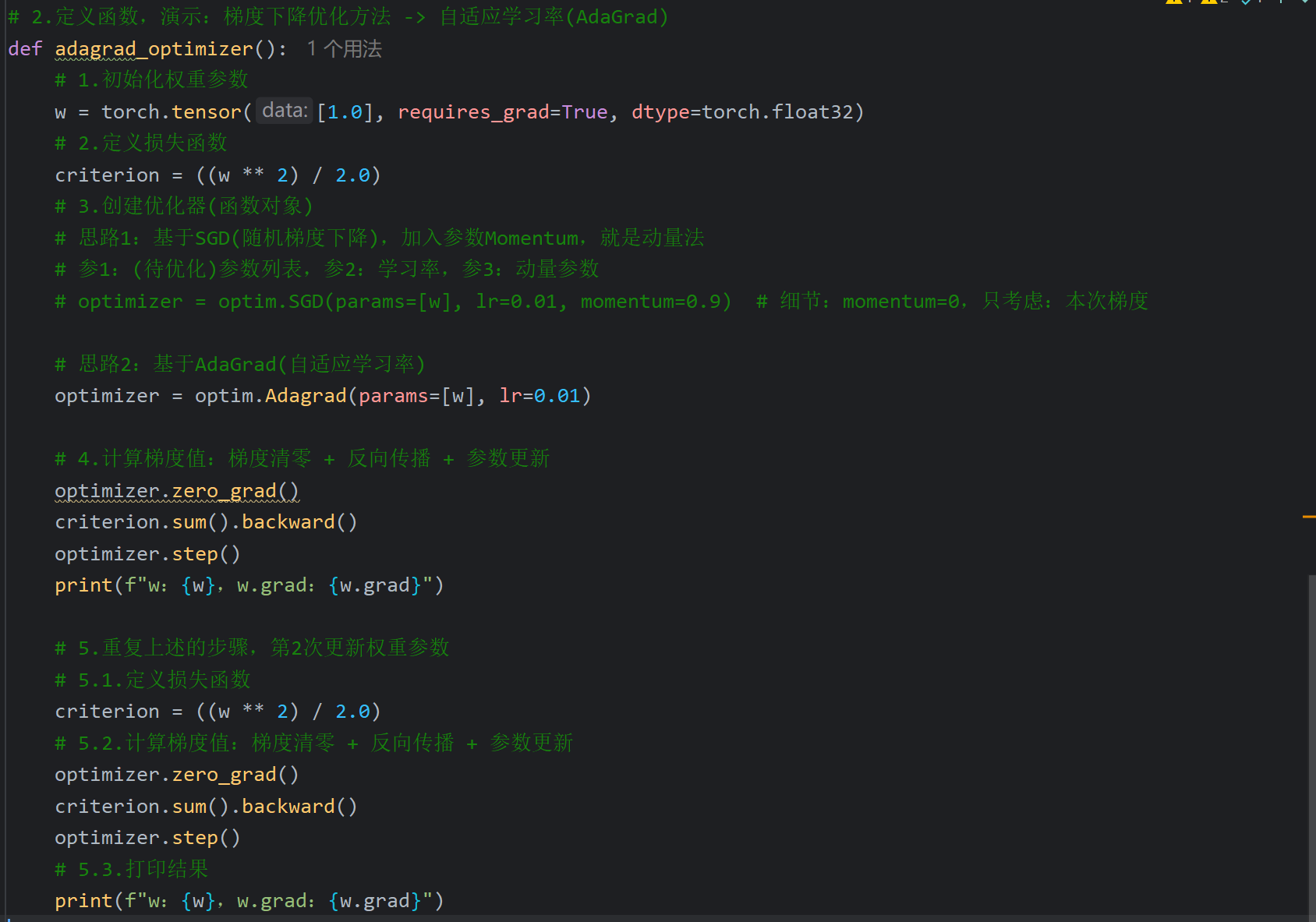

4、梯度下降优化方法_AdaGrad

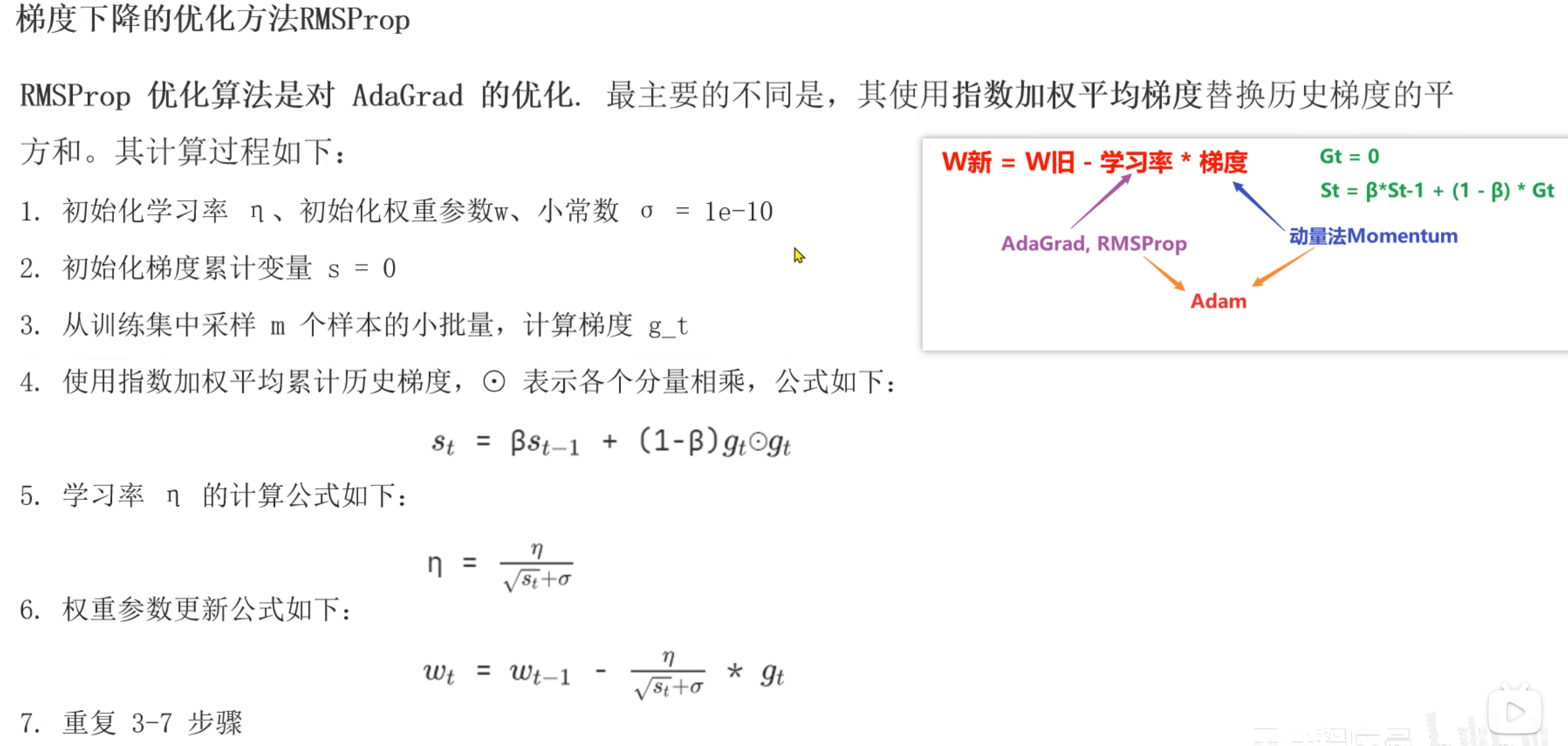

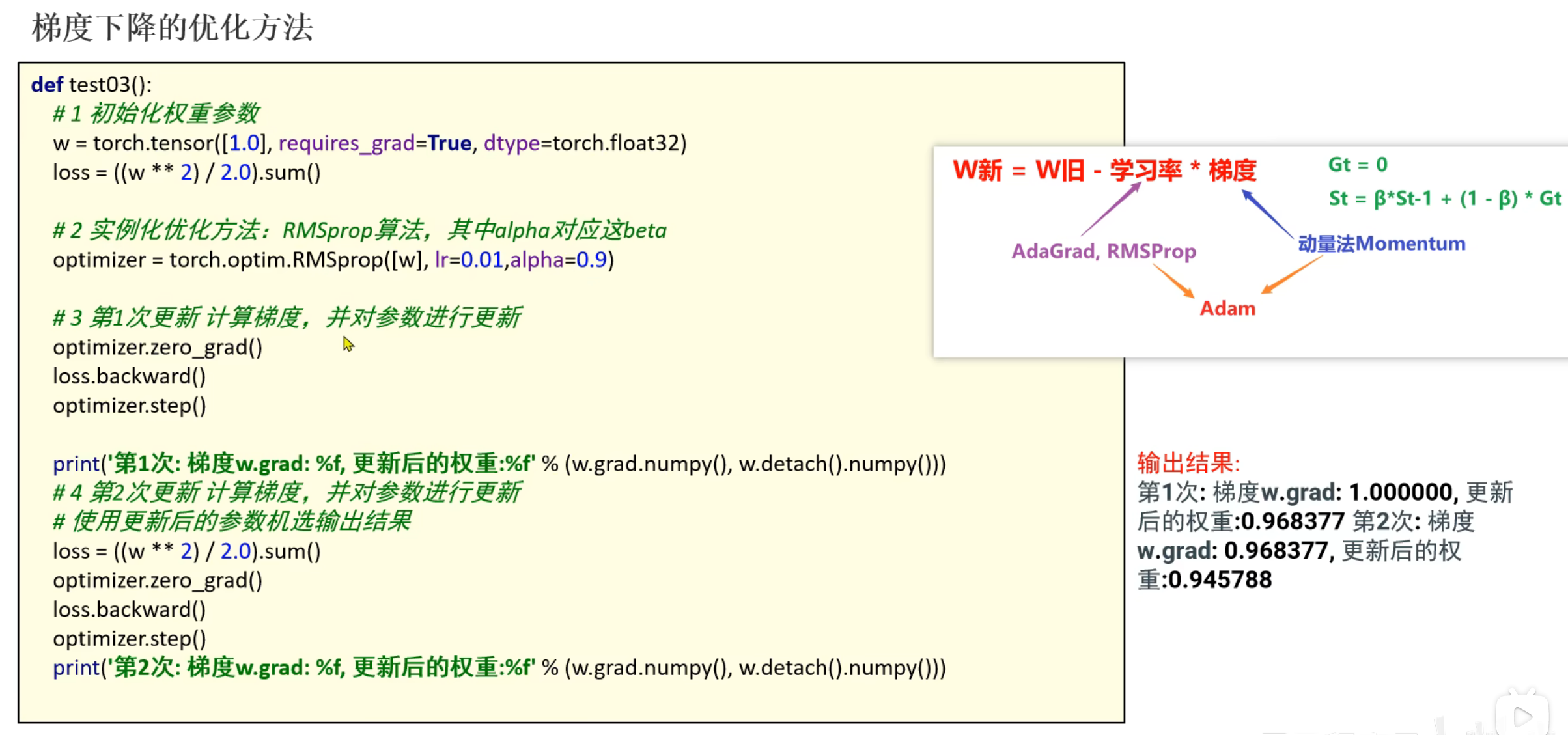

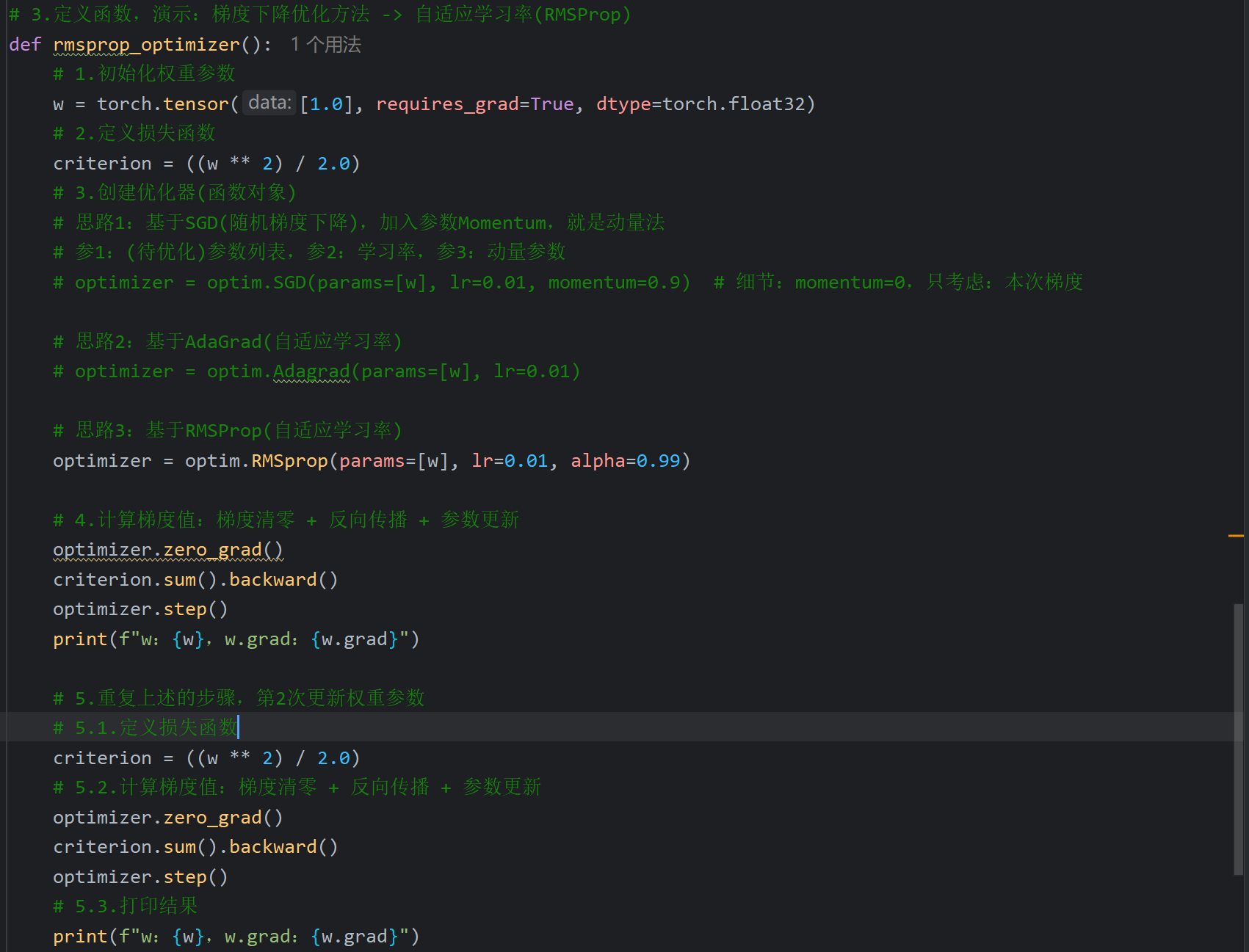

5、梯度下降优化方法_RMSProp

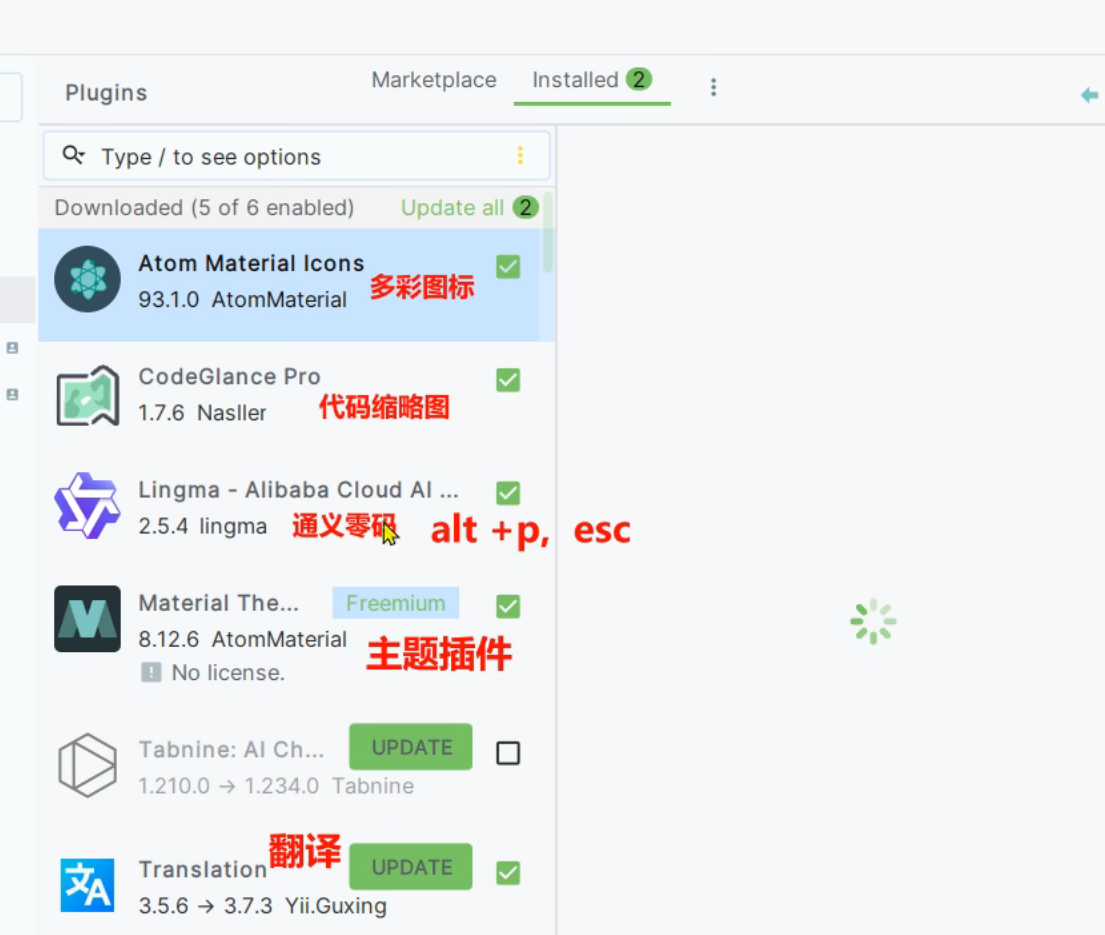

6、拓展_PyCharm常用插件介绍

7、拓展_如何快速修改PyCharm主题

看视频操作即可

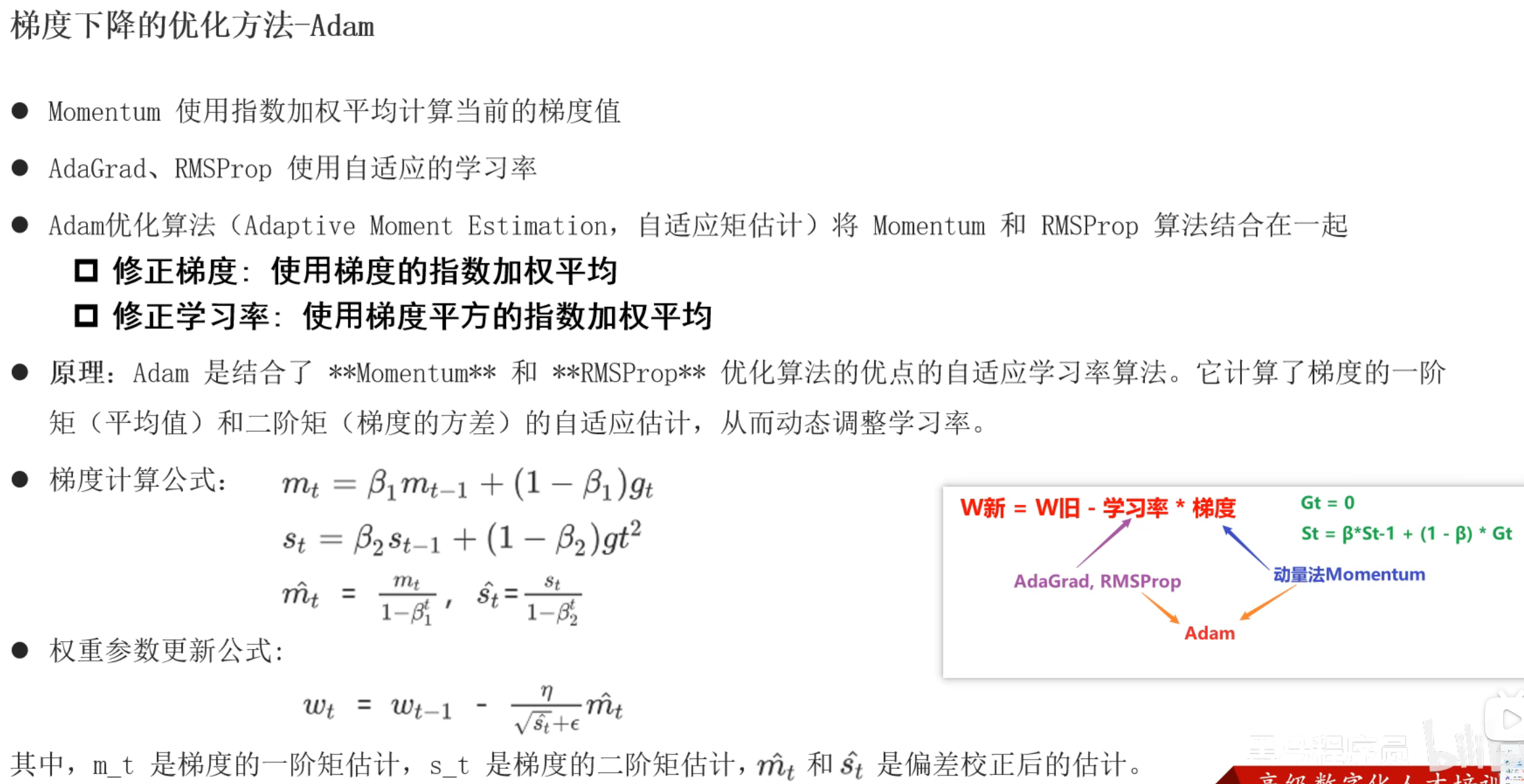

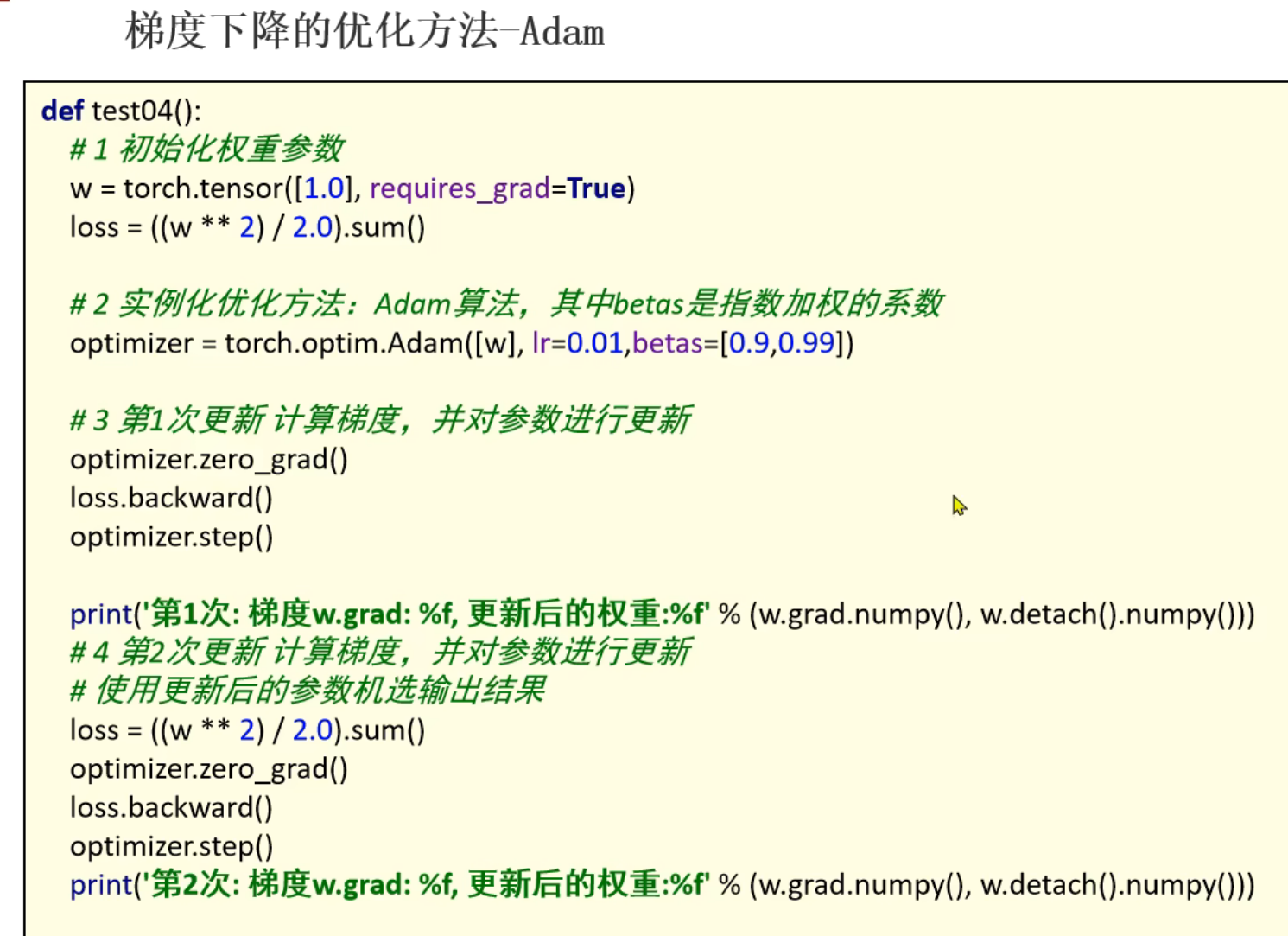

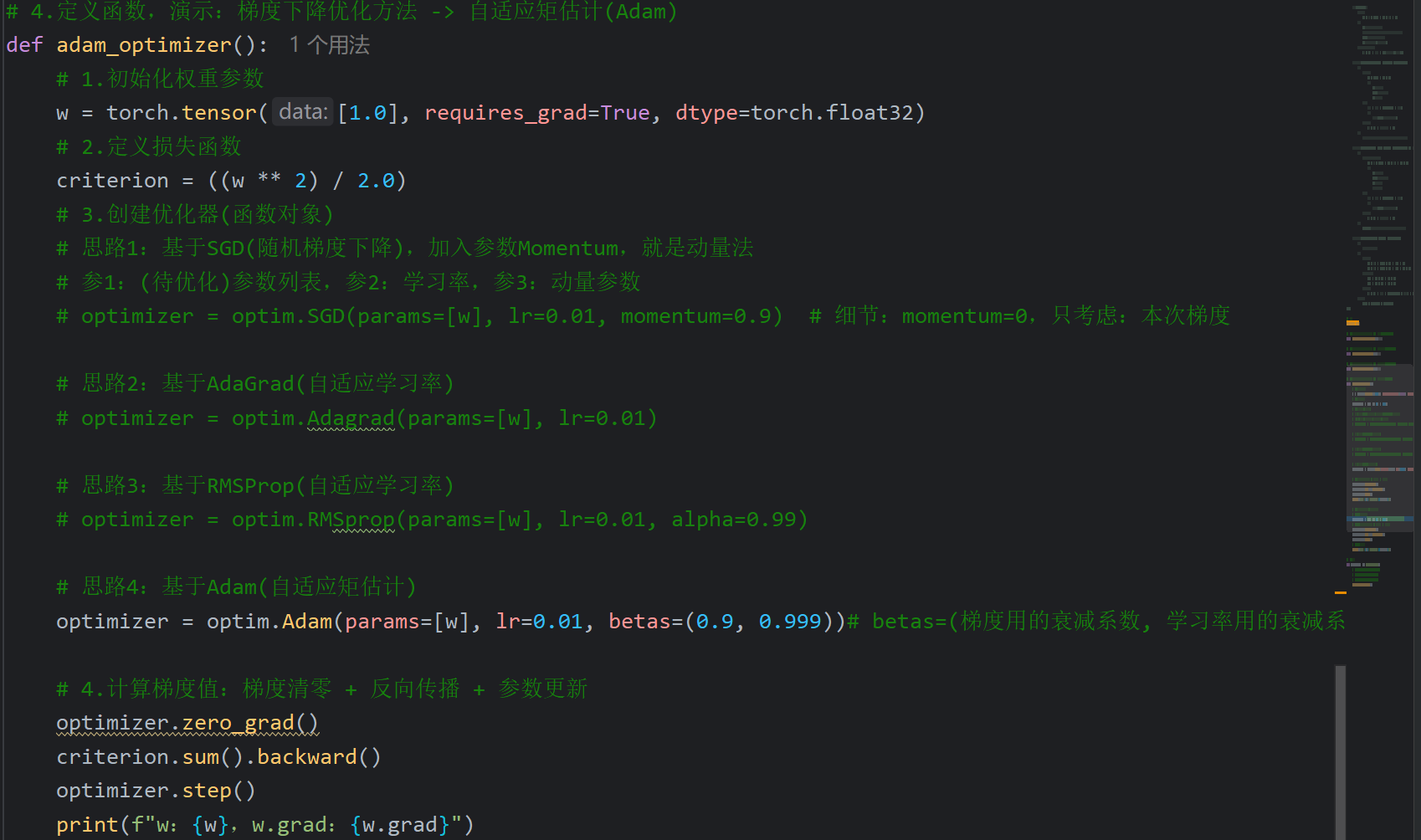

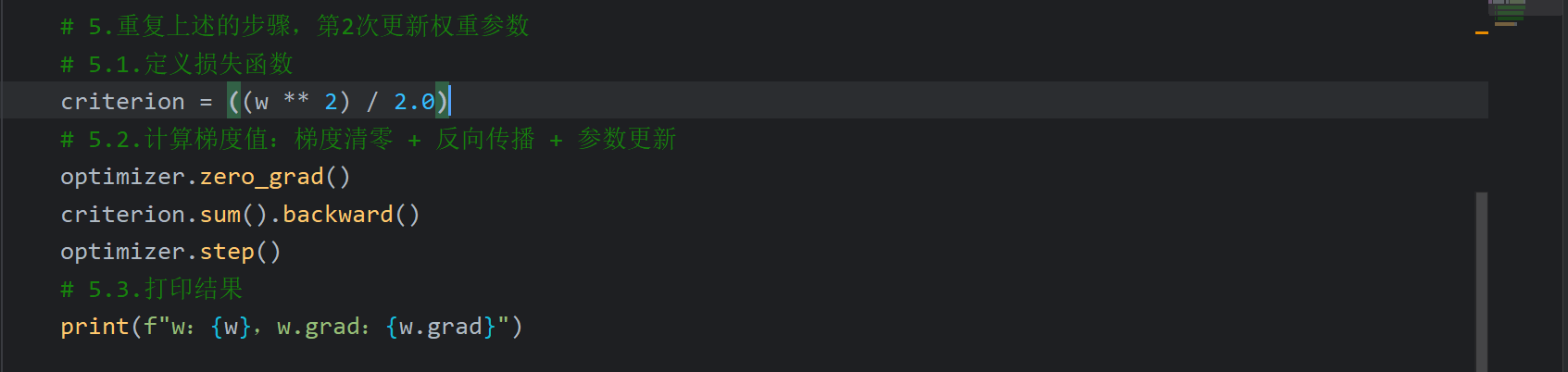

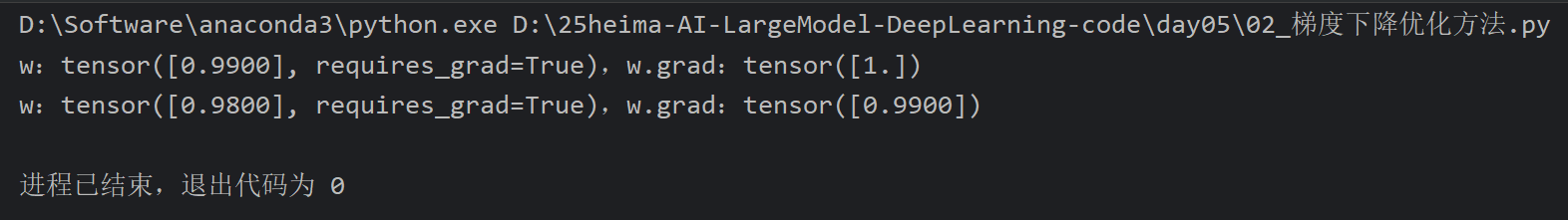

8、梯度下降优化方法_Adam

9、梯度下降优化算法_总结

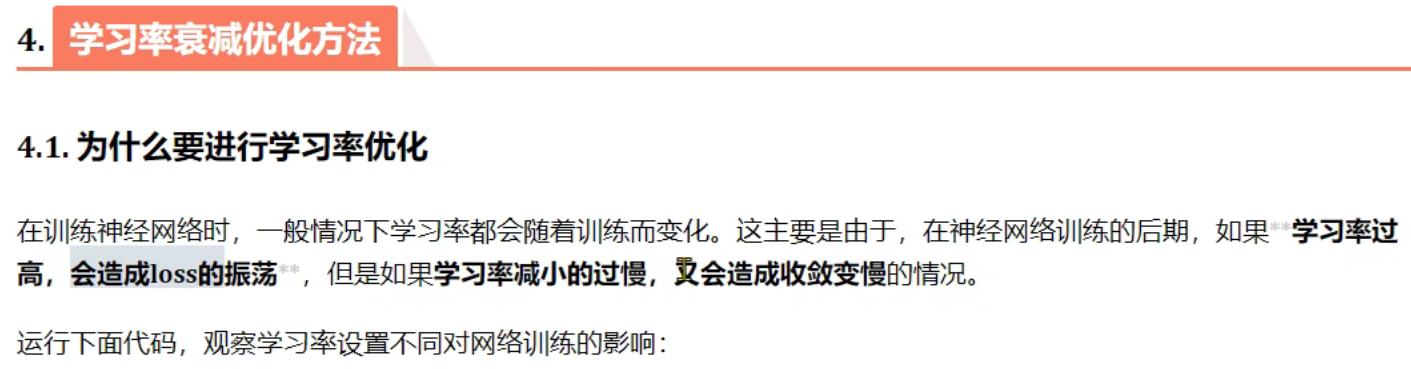

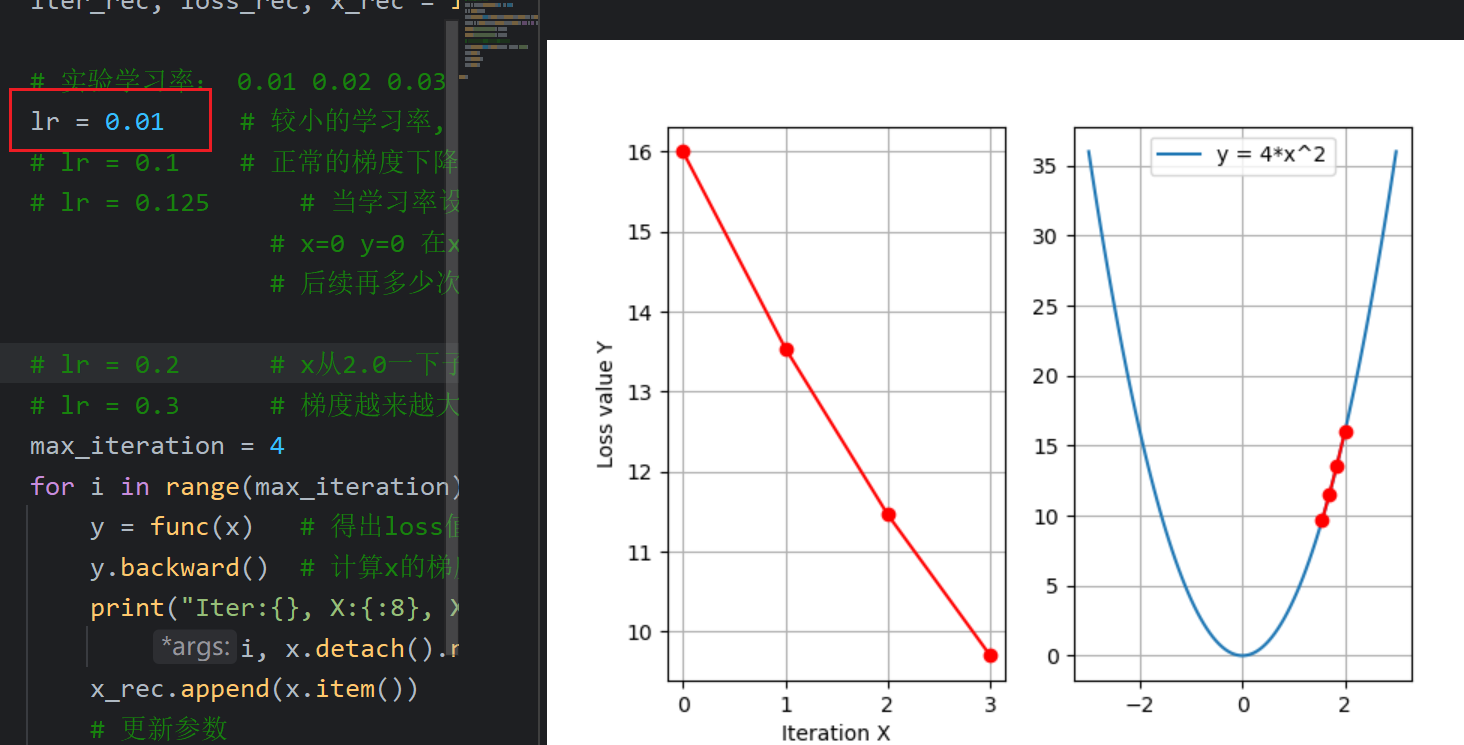

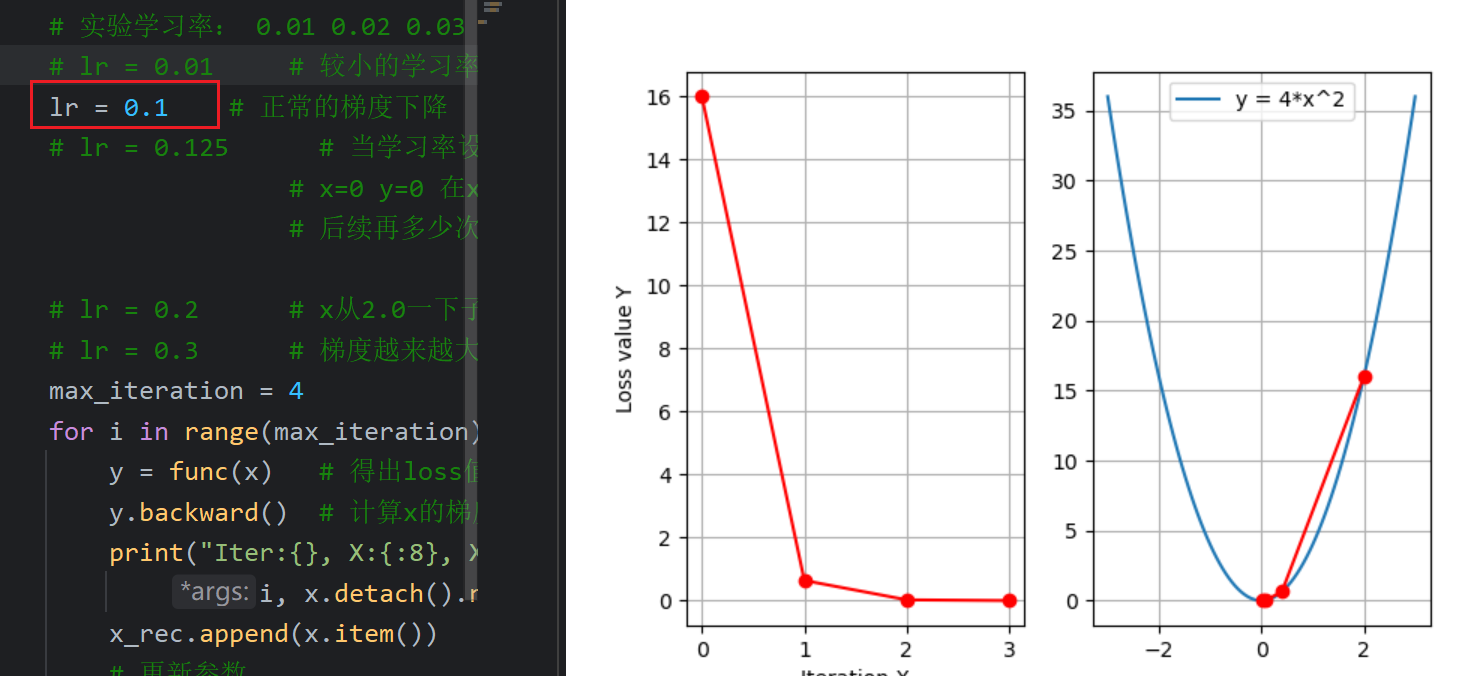

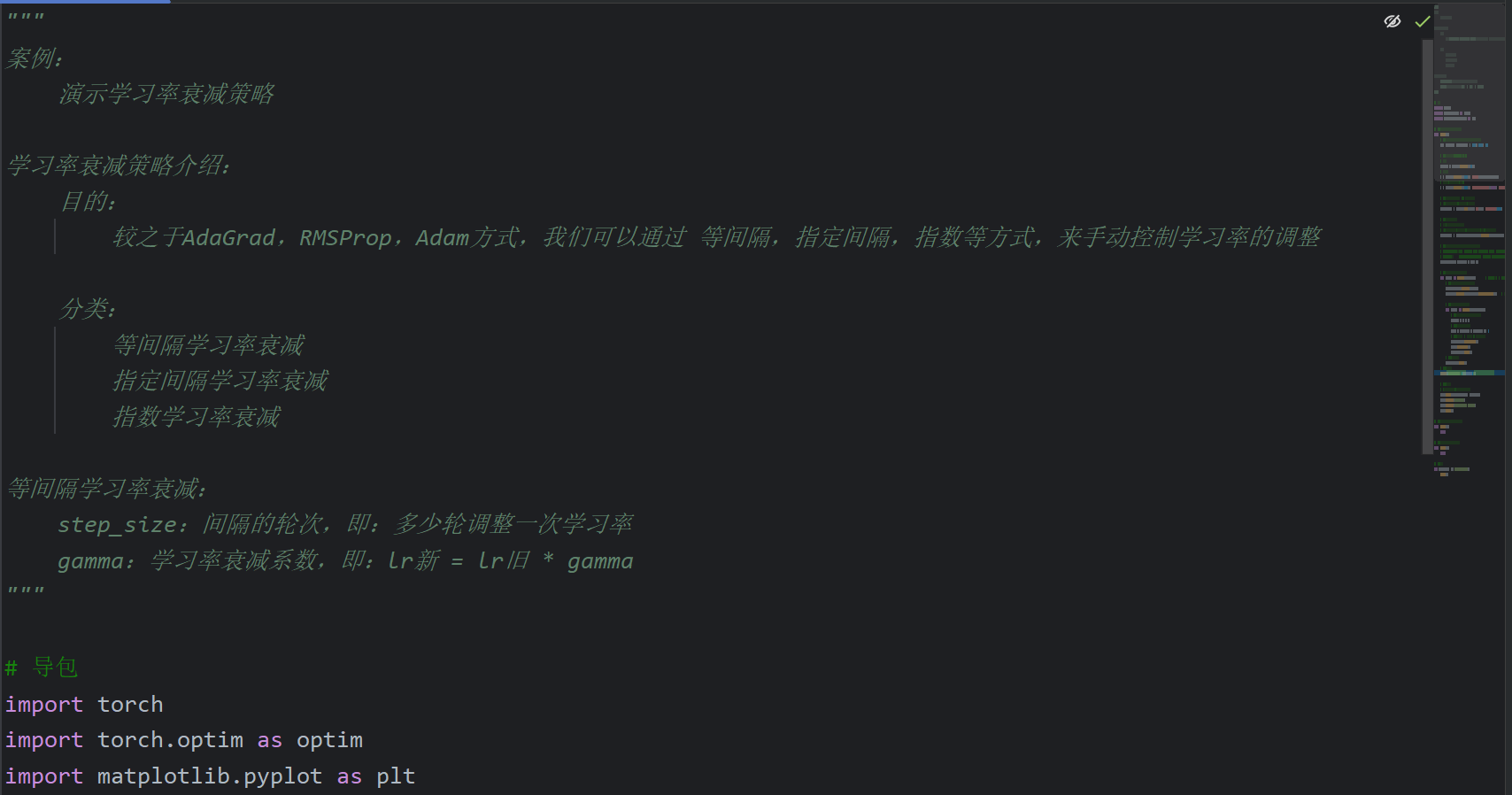

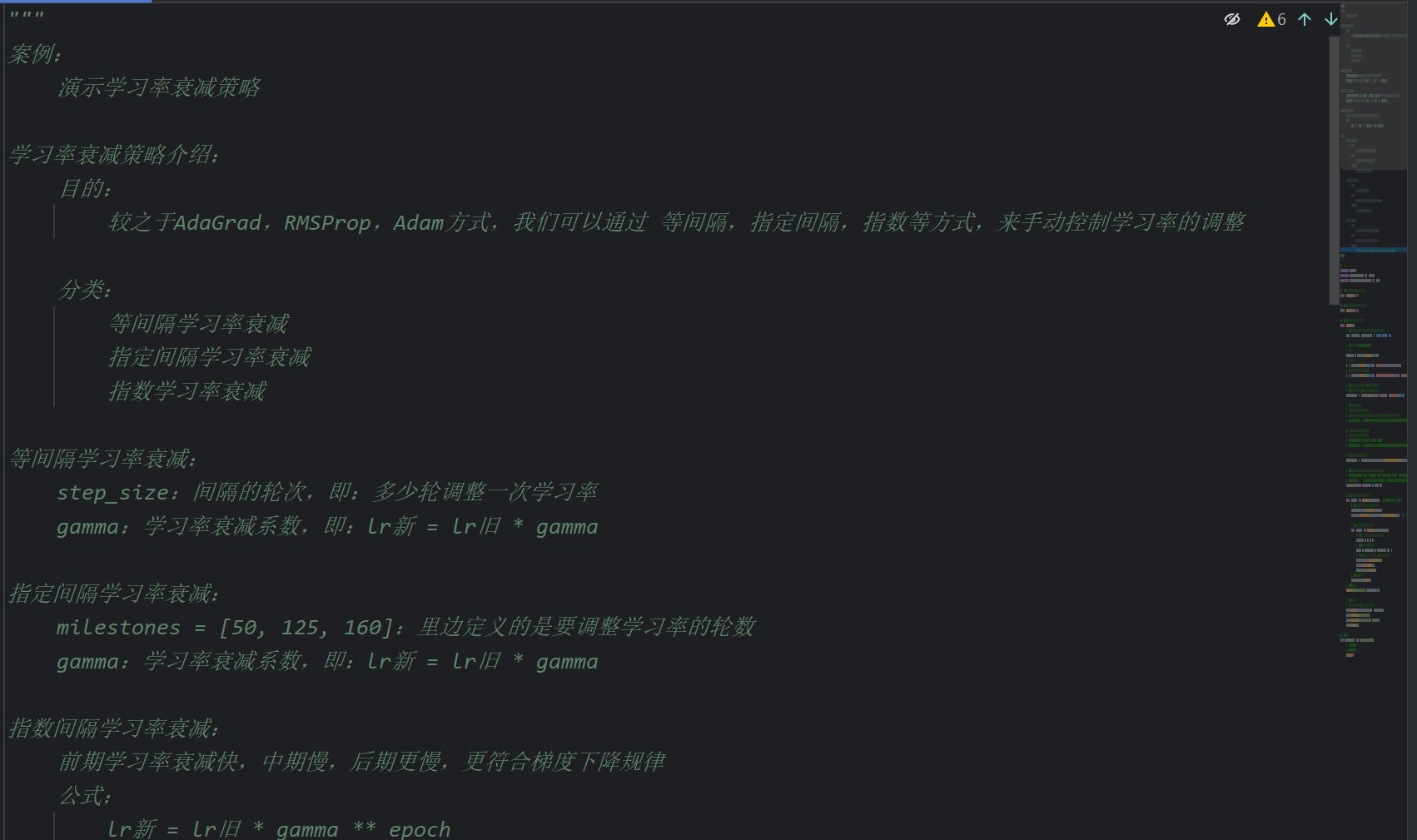

10、学习率优化_背景介绍

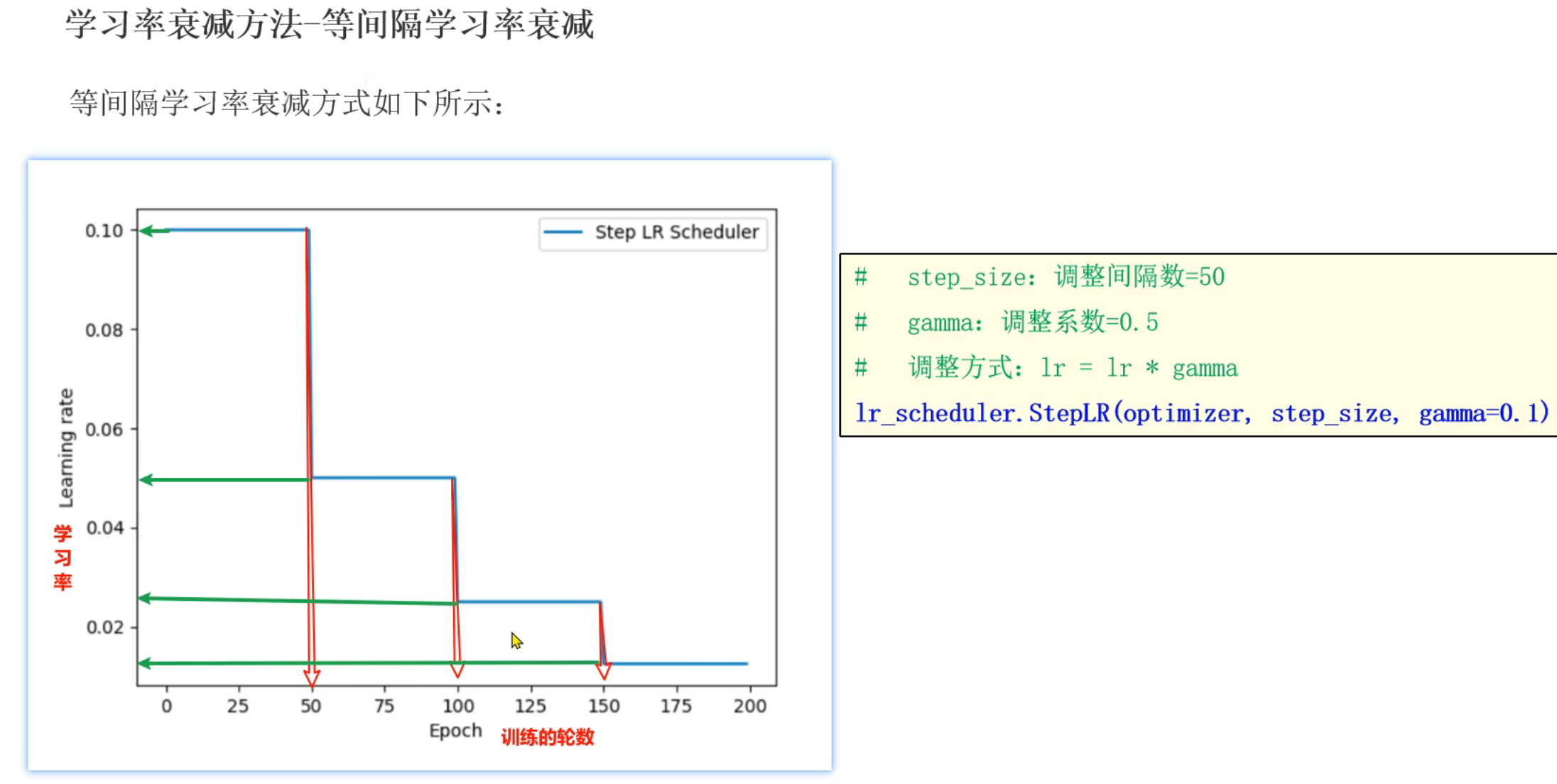

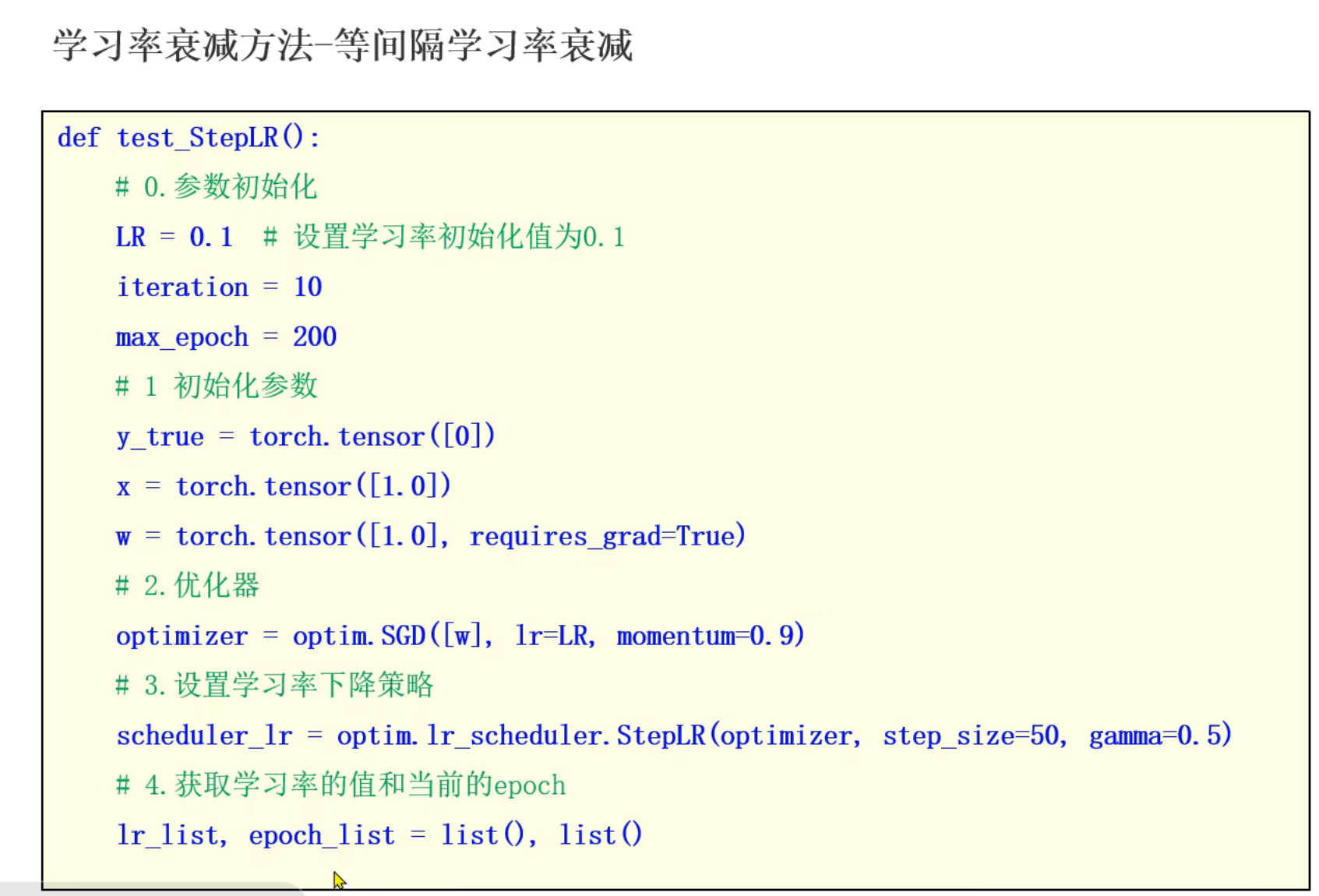

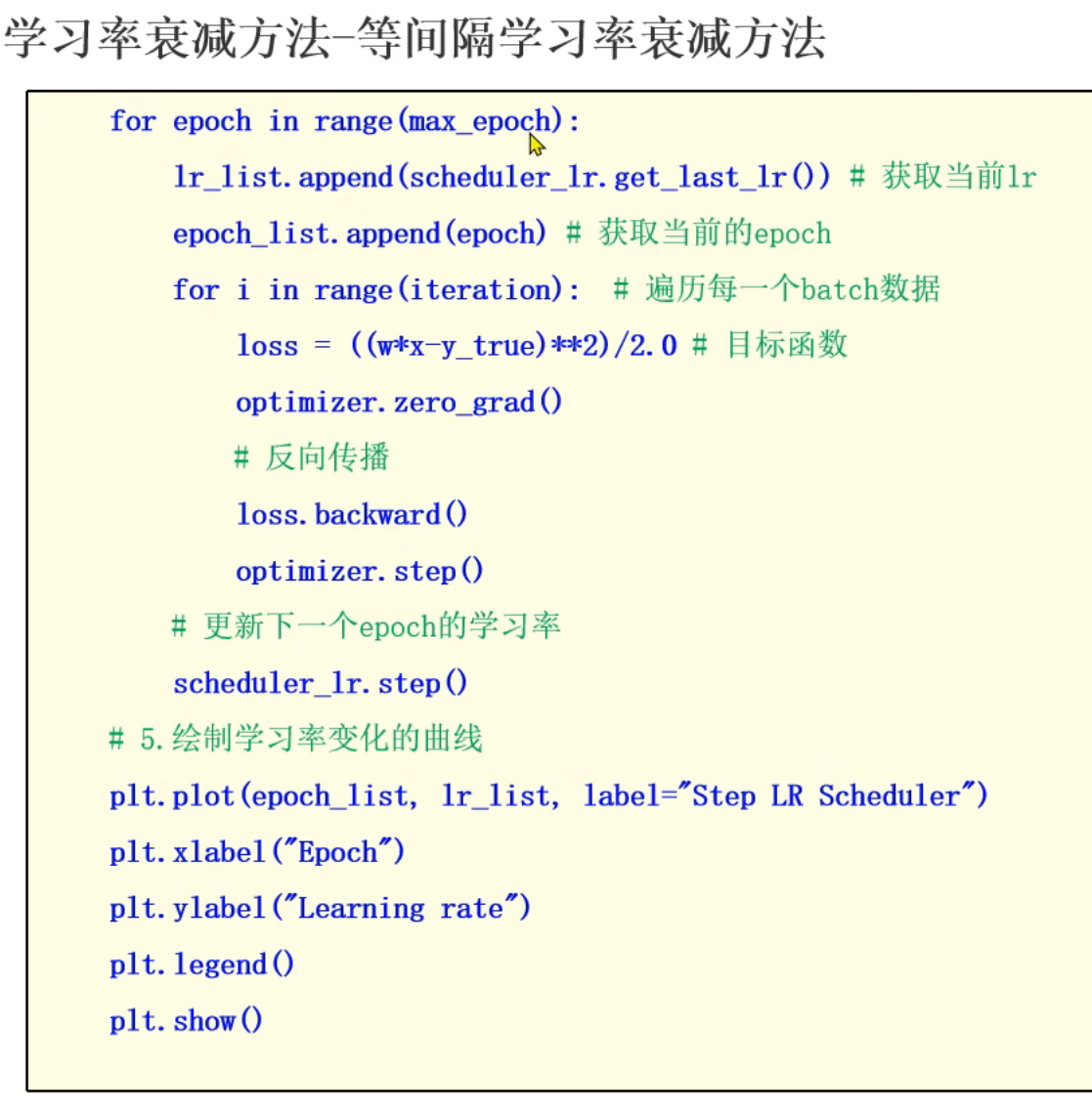

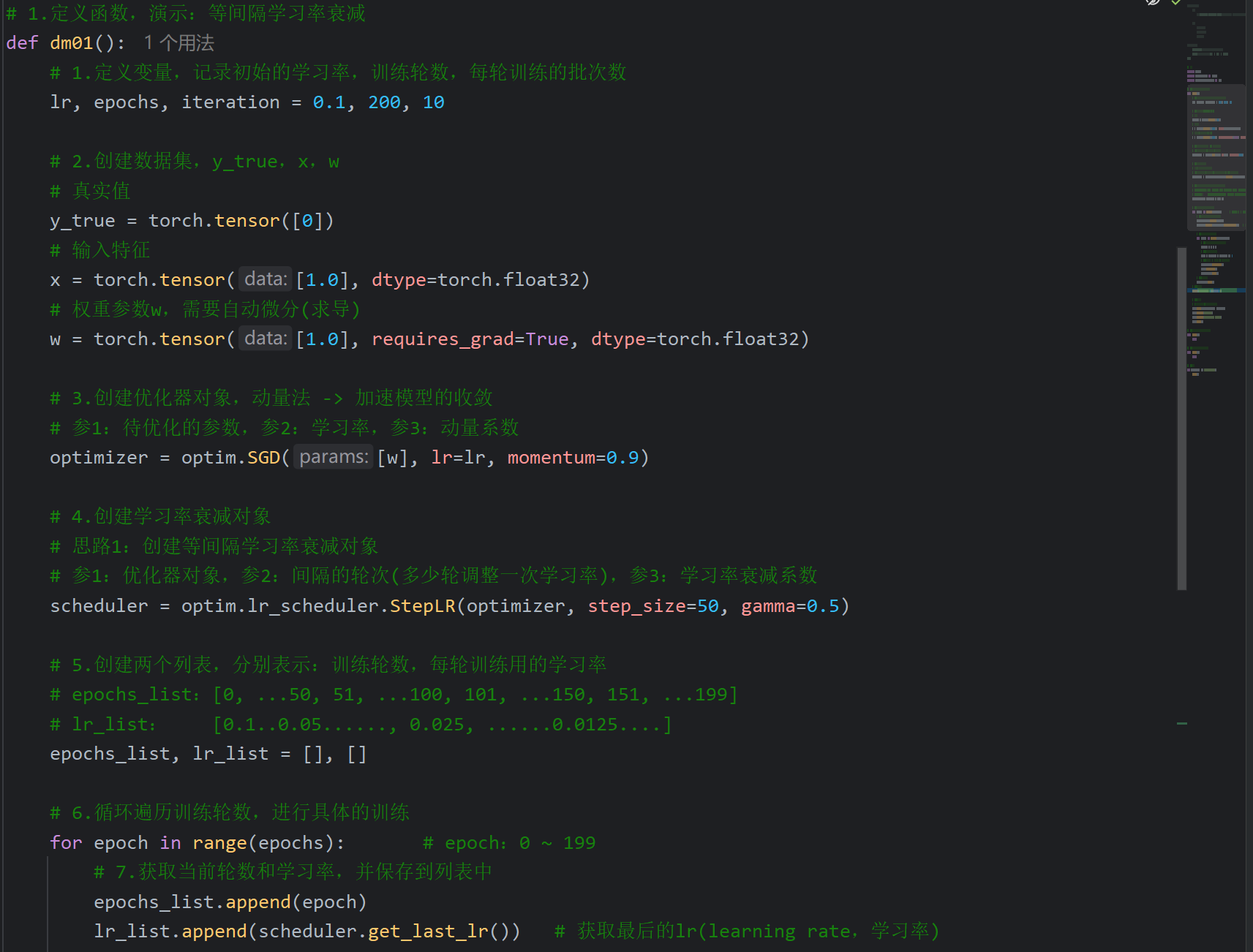

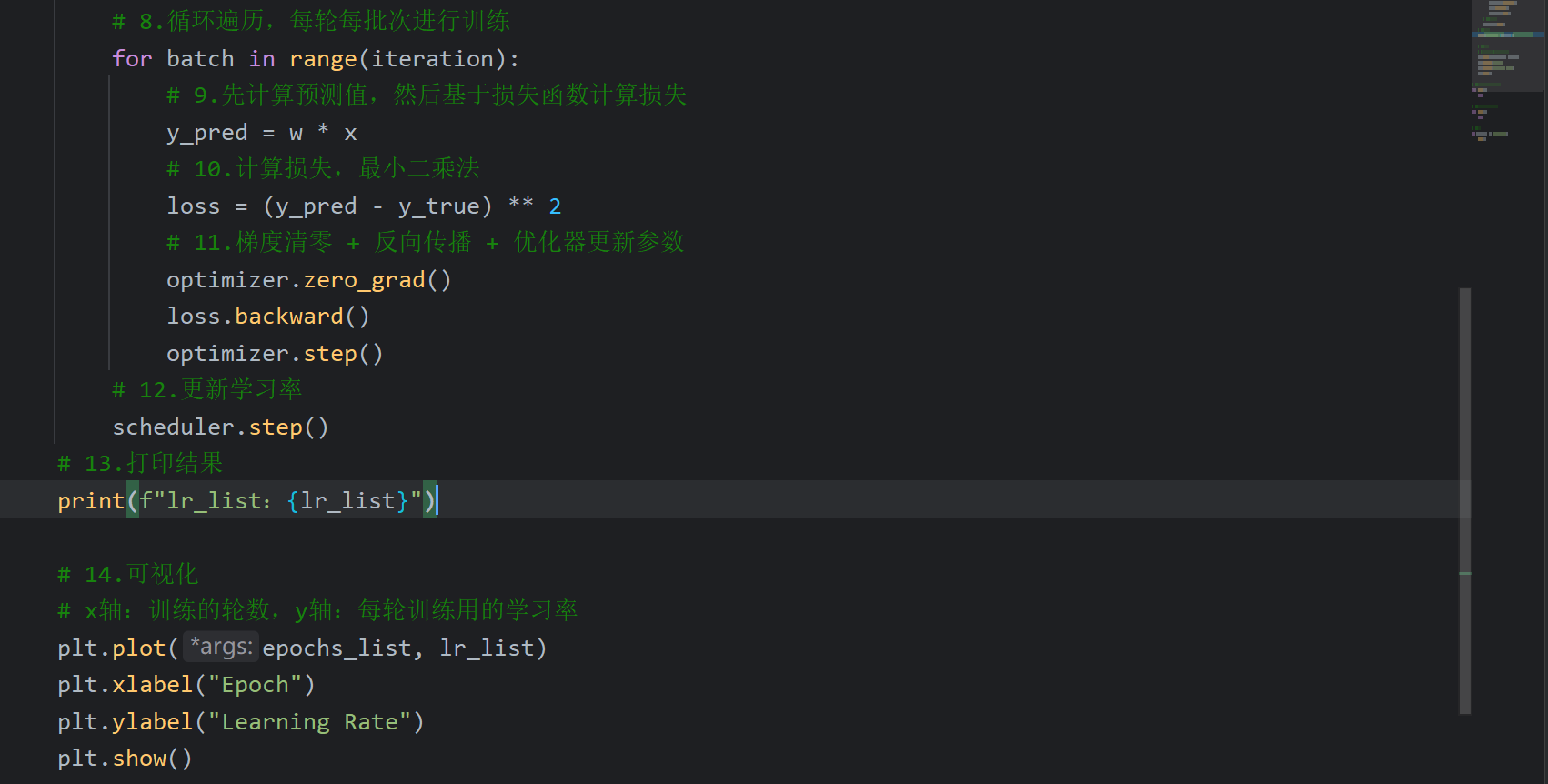

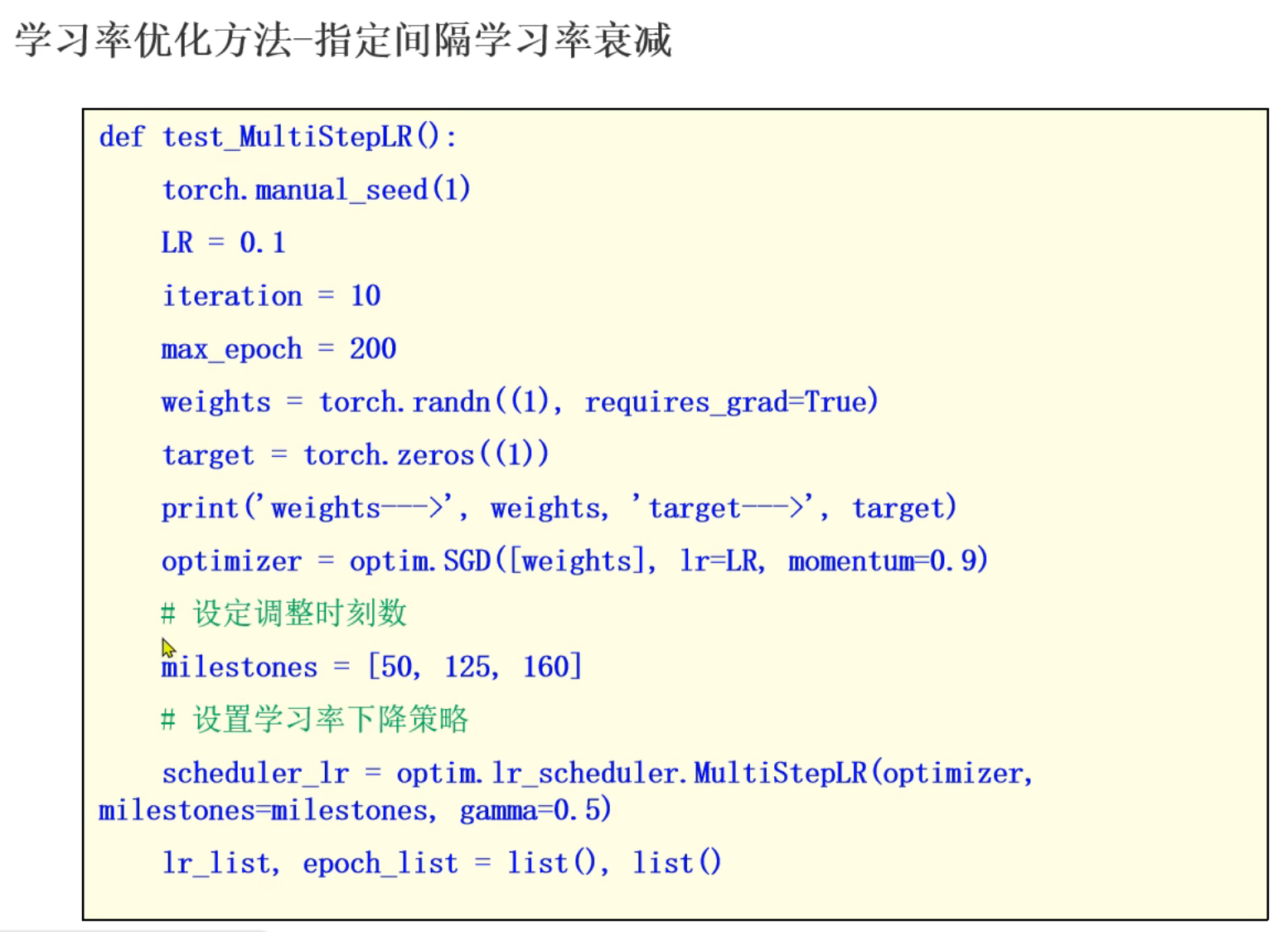

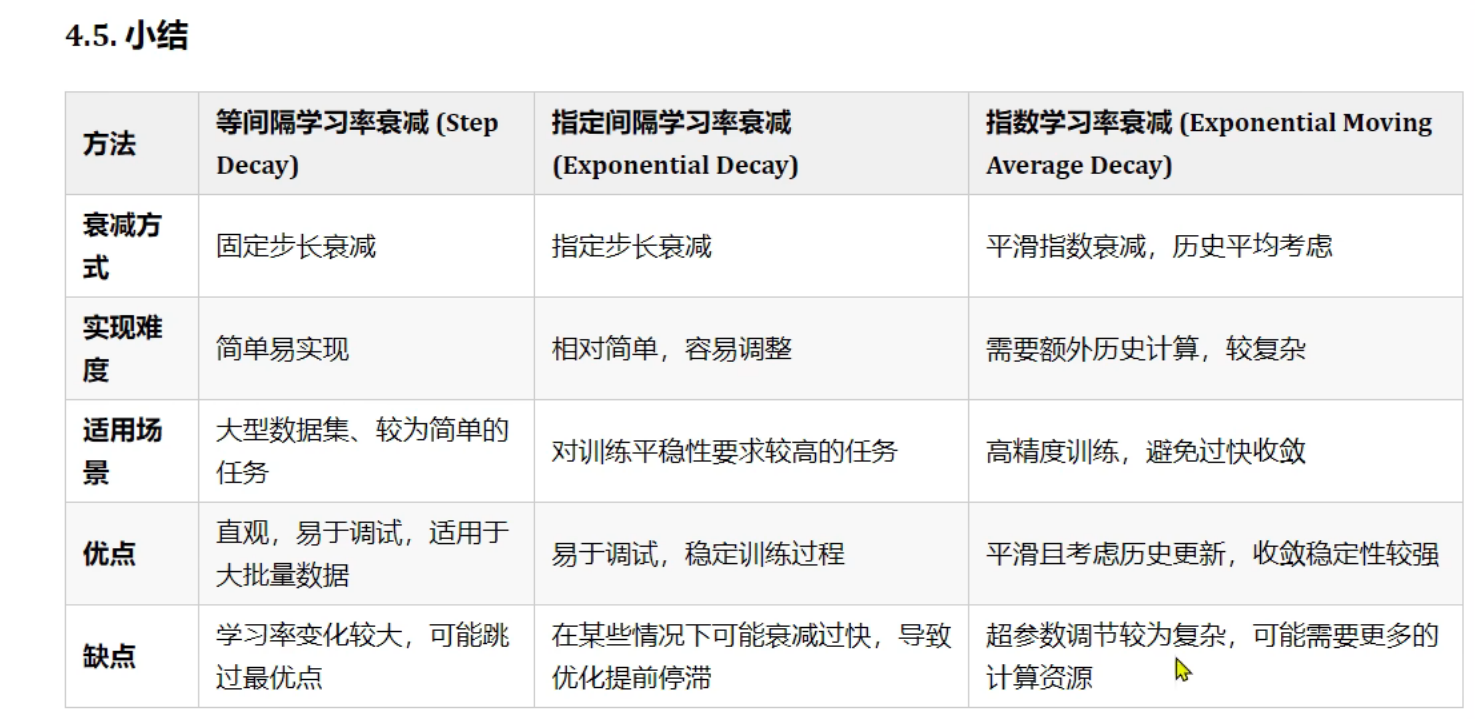

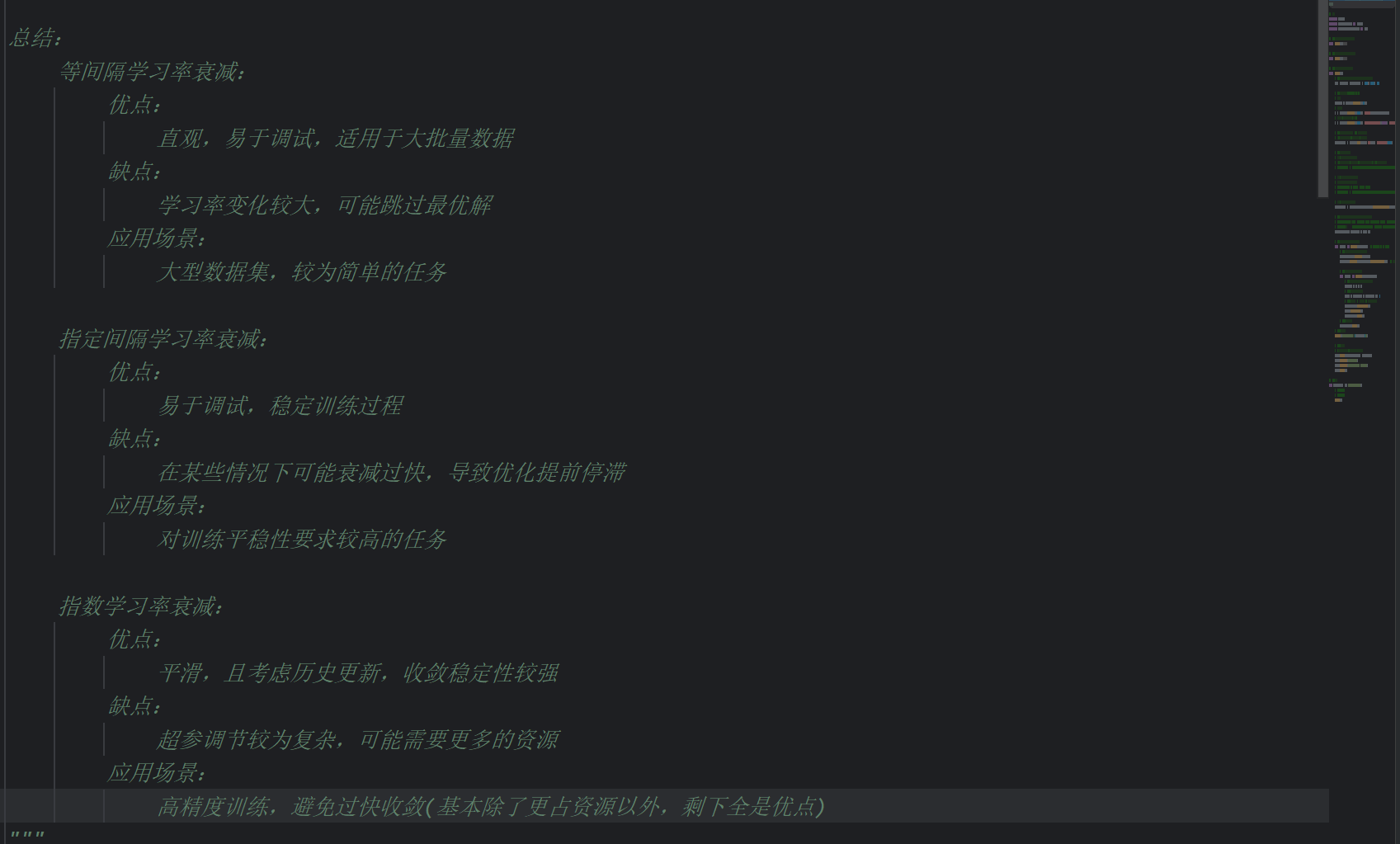

11、学习率衰减策略_等间隔学习率衰减

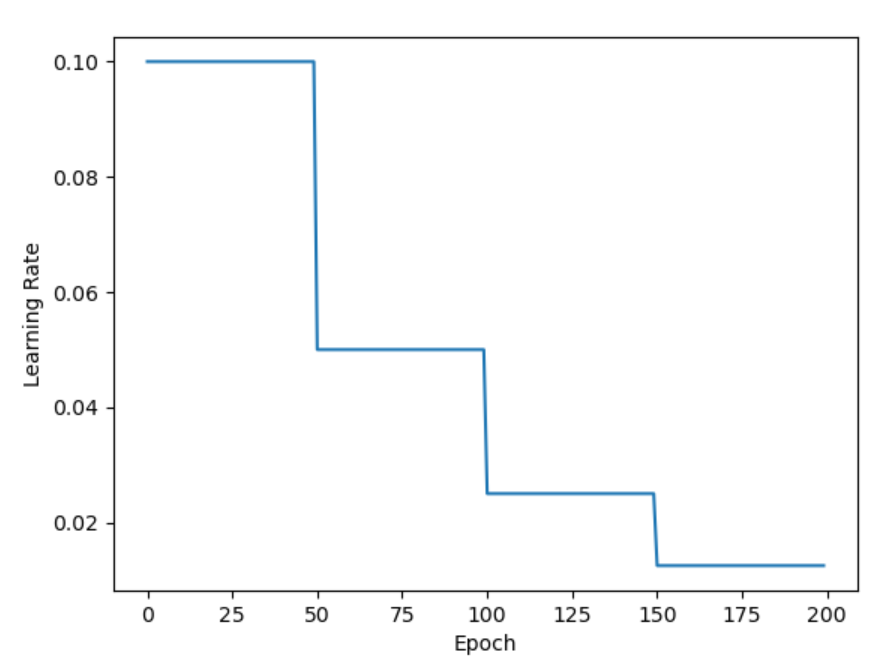

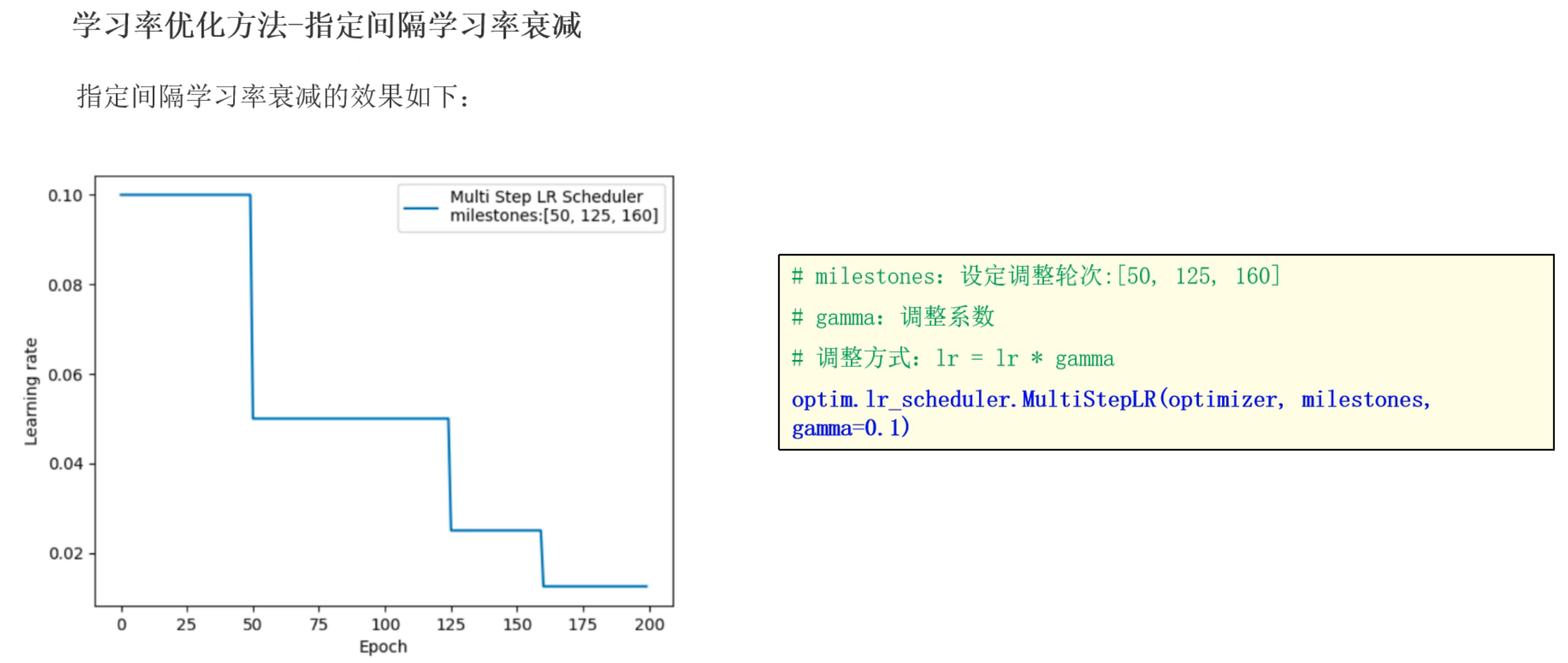

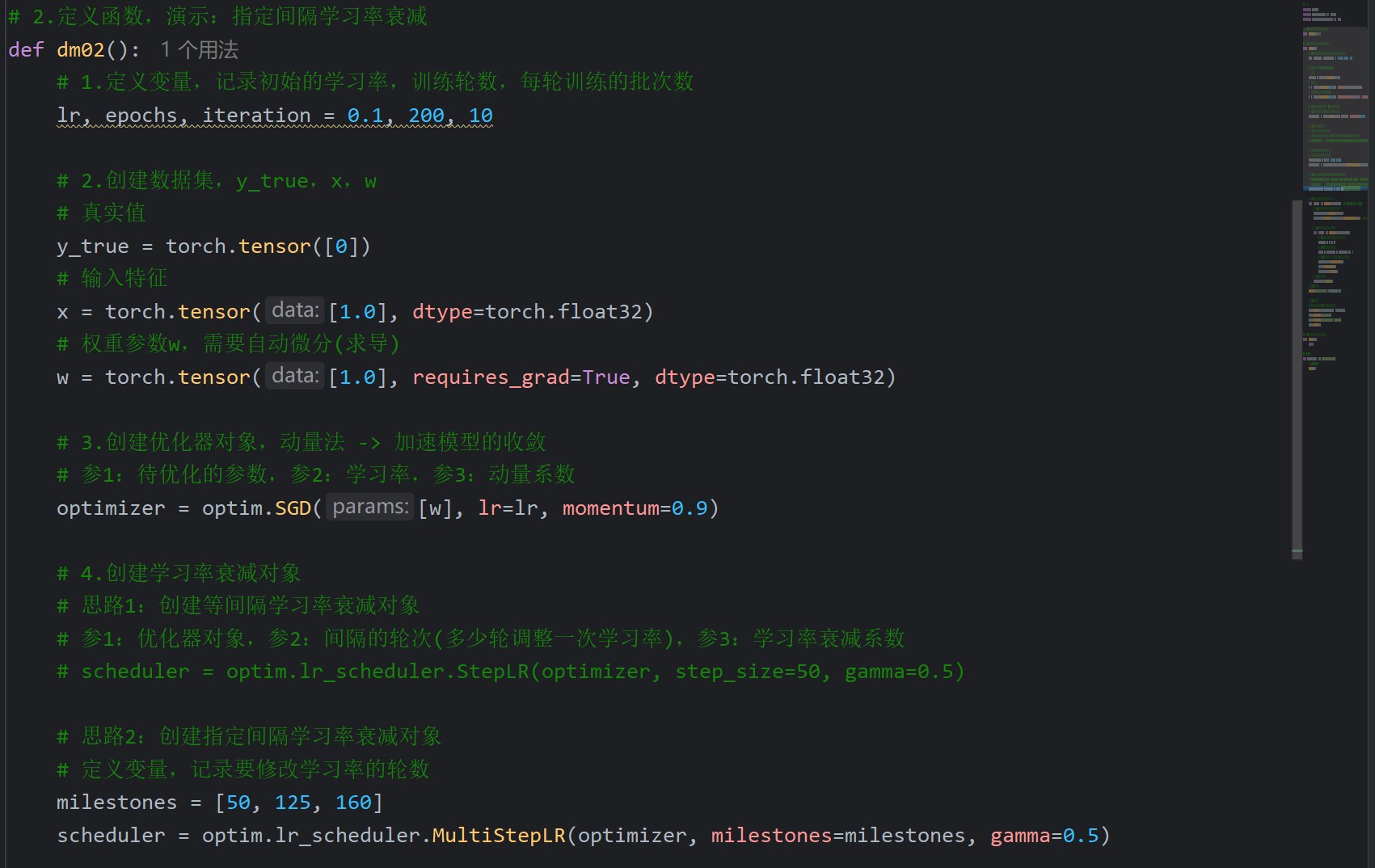

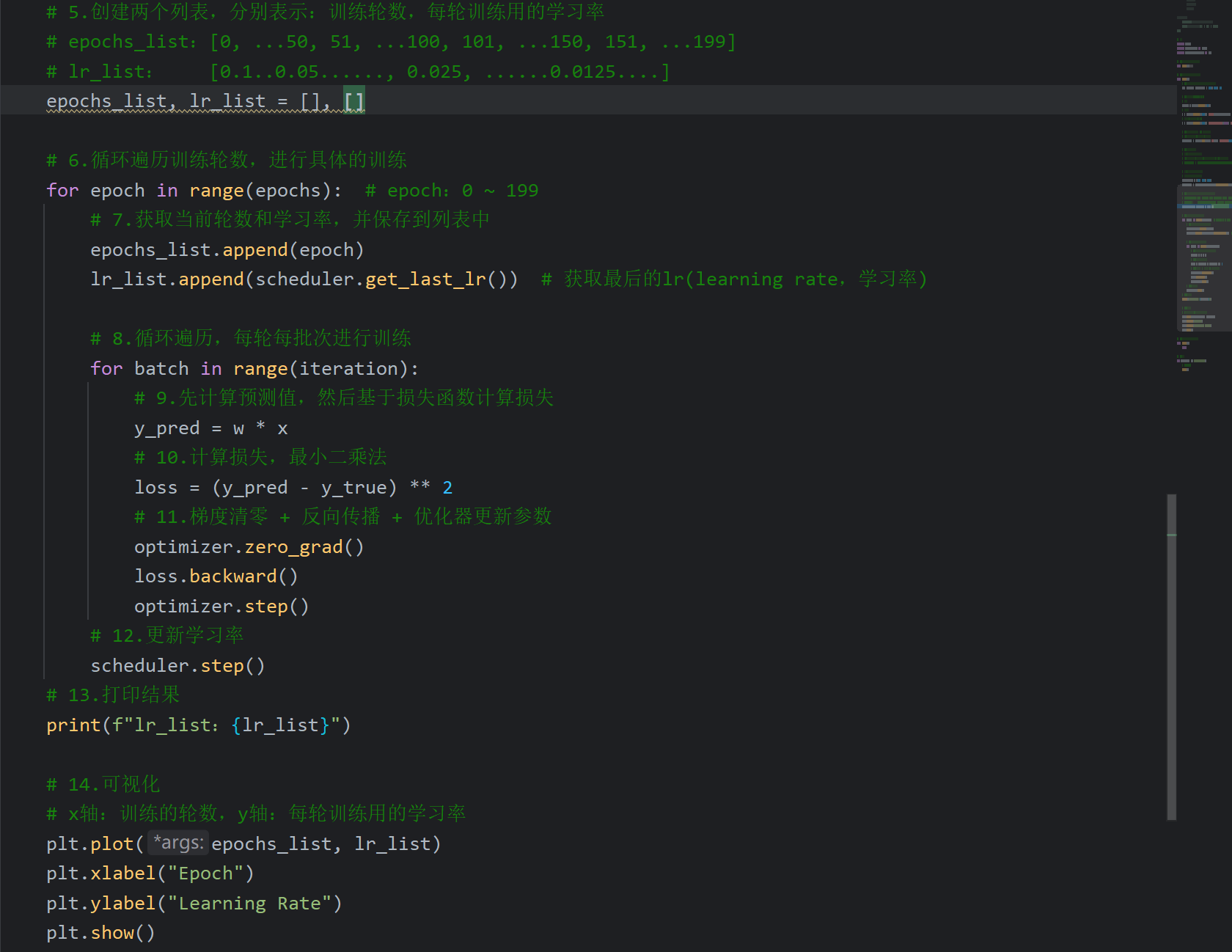

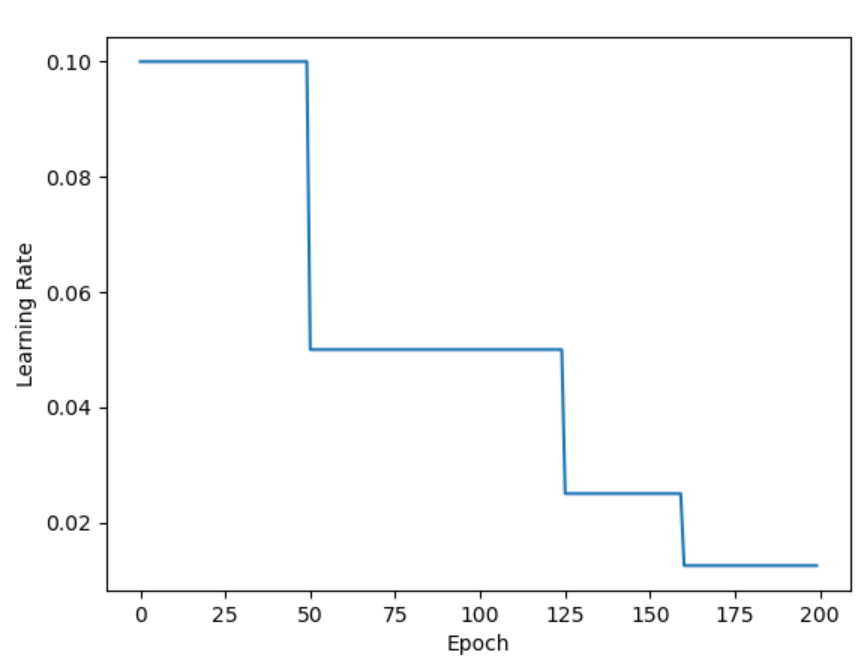

12、学习率衰减策略_指定间隔学习率衰减

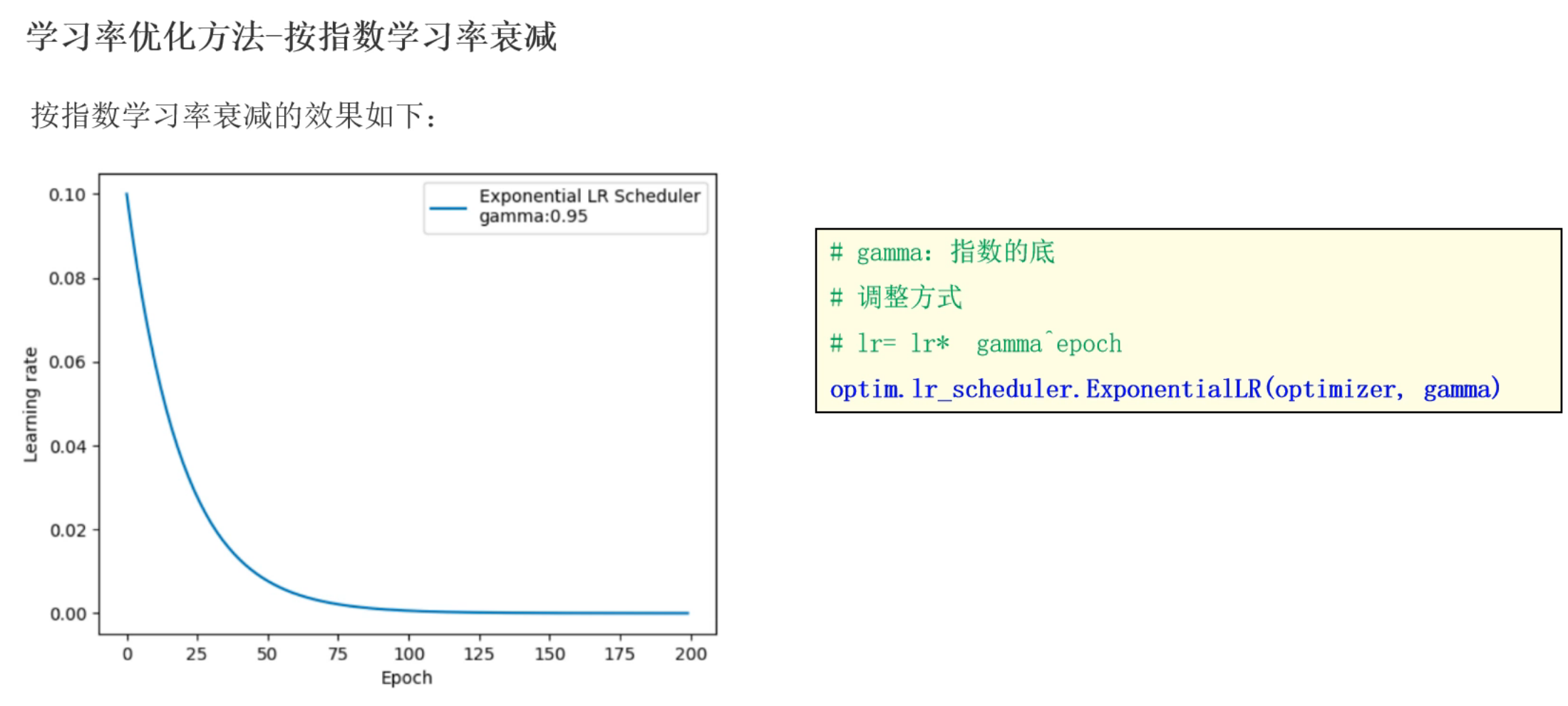

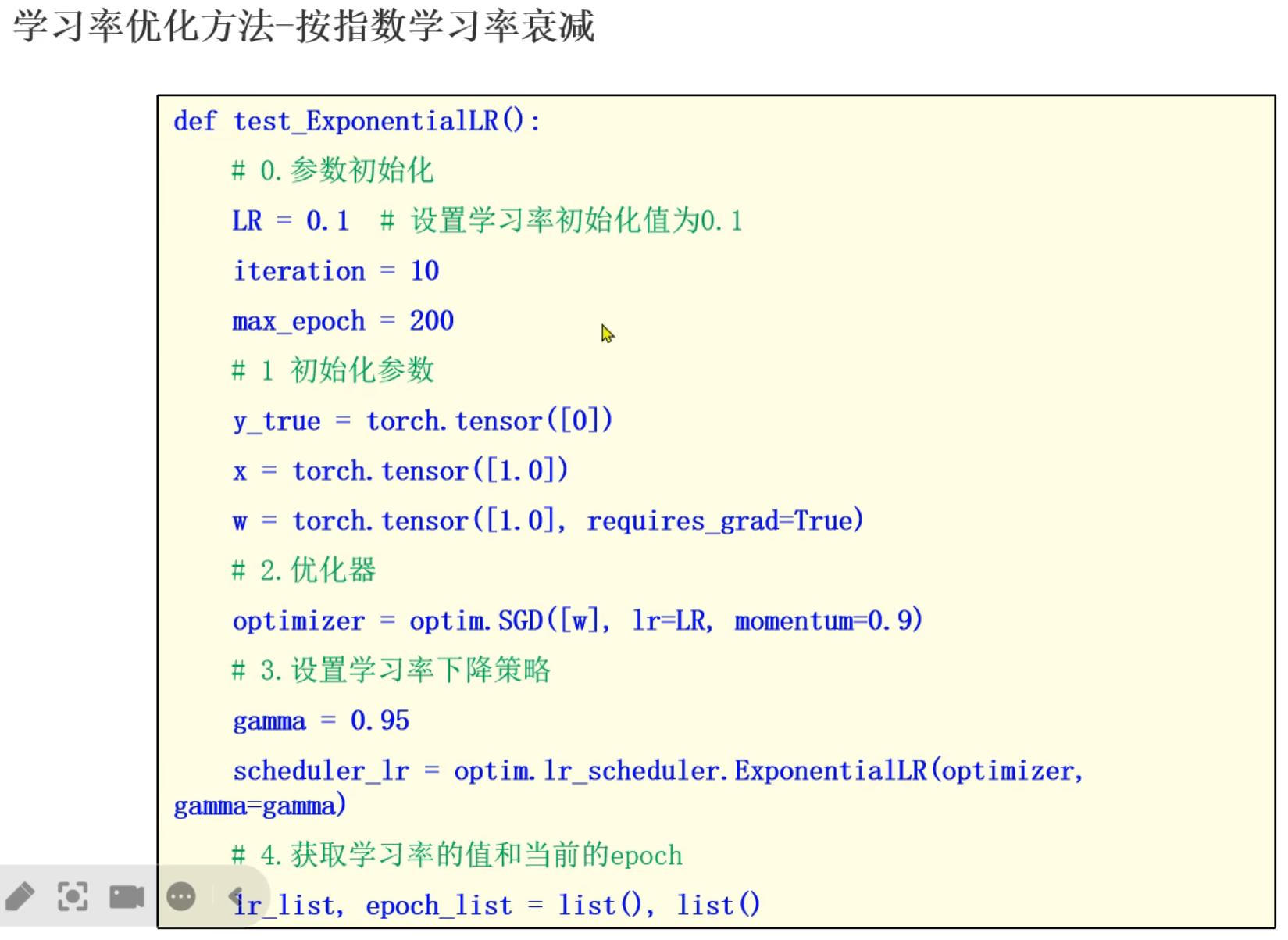

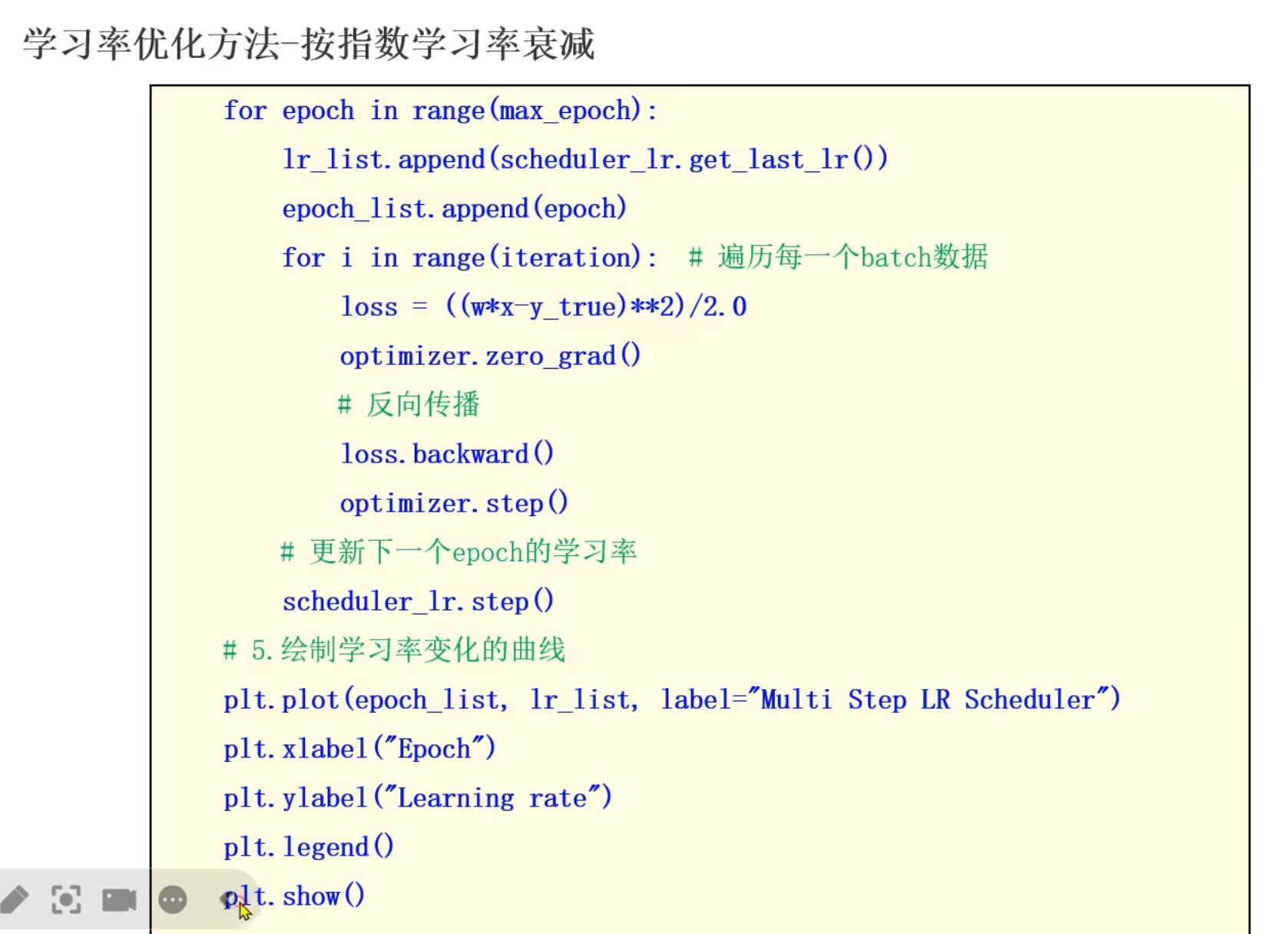

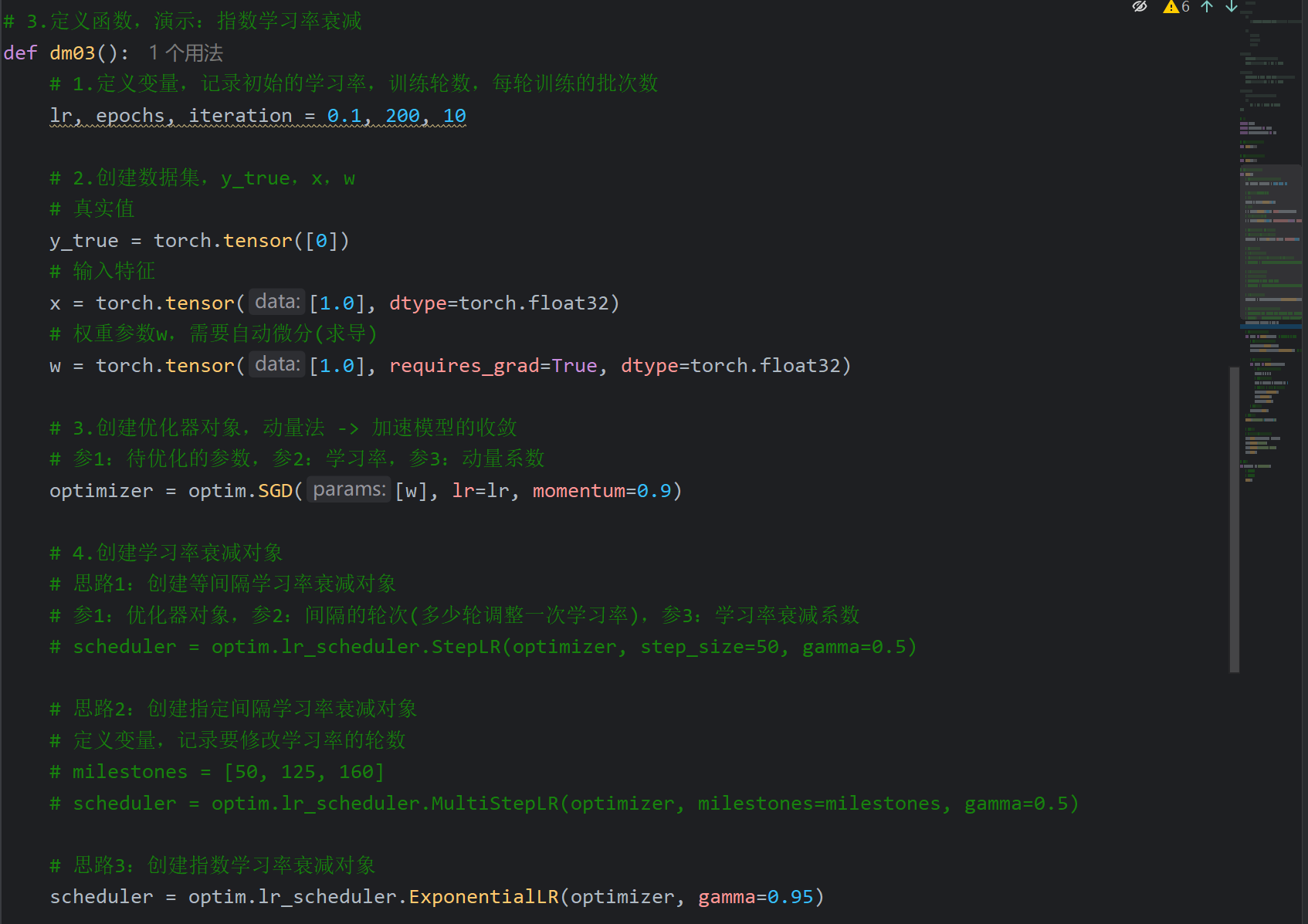

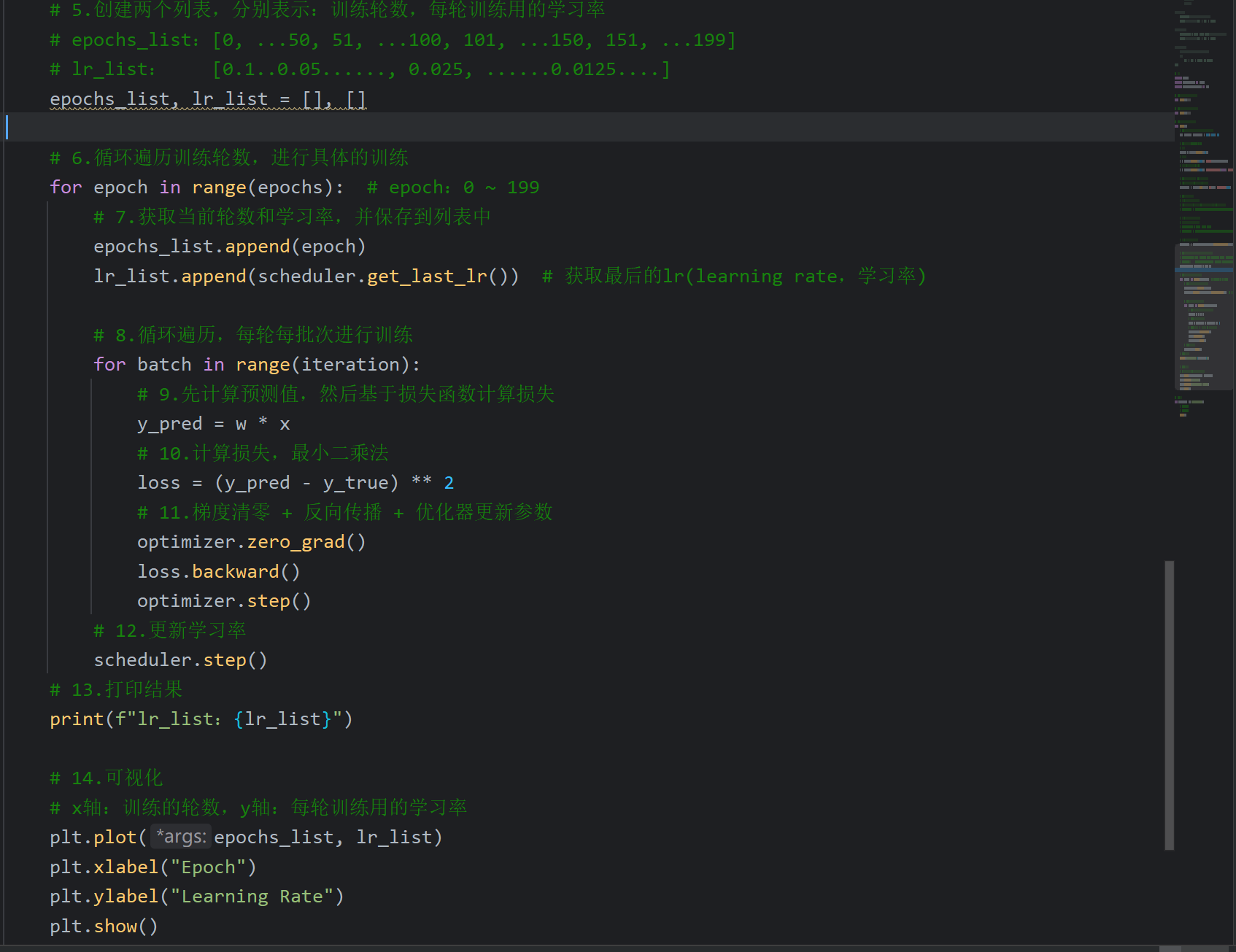

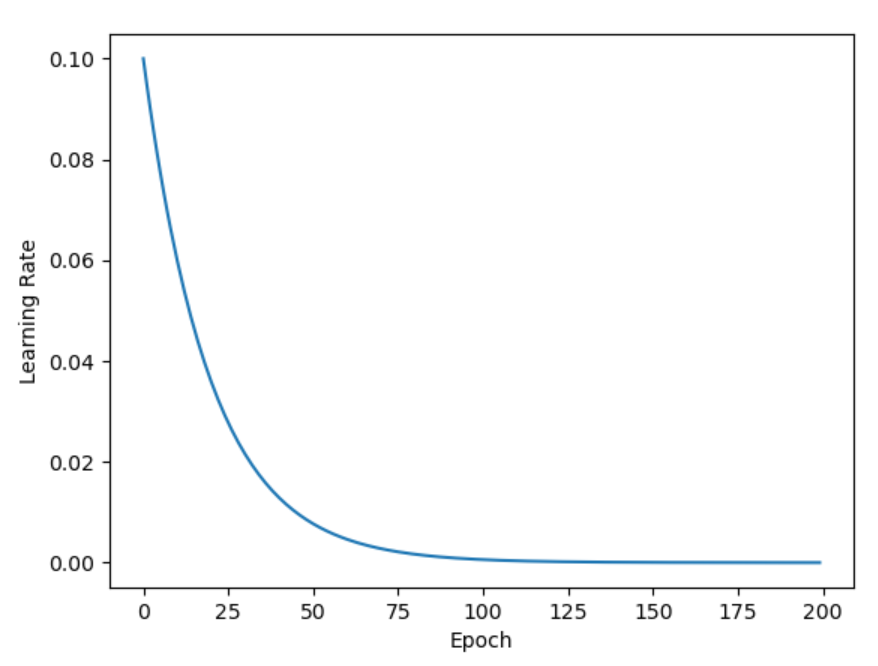

13、学习率衰减策略_指数间隔学习率衰减

14、学习率衰减策略_总结

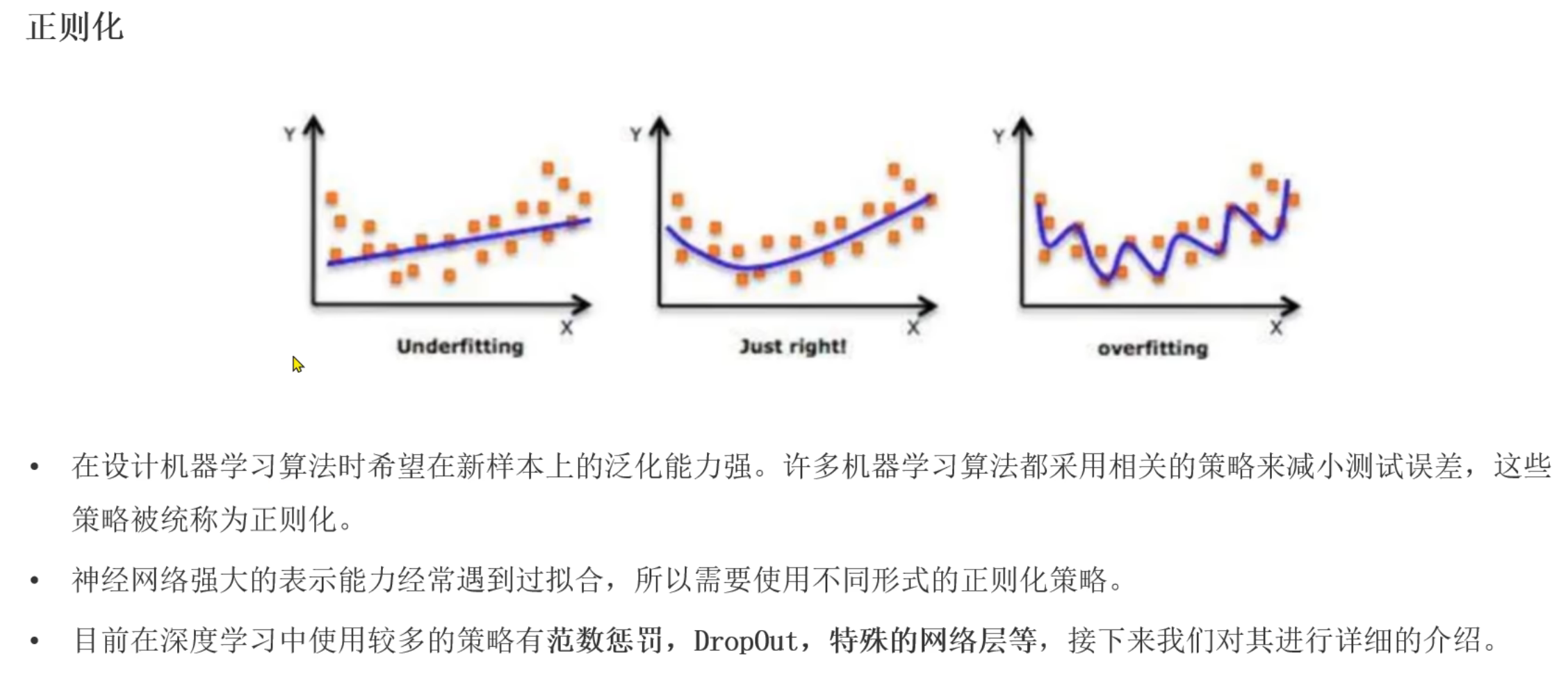

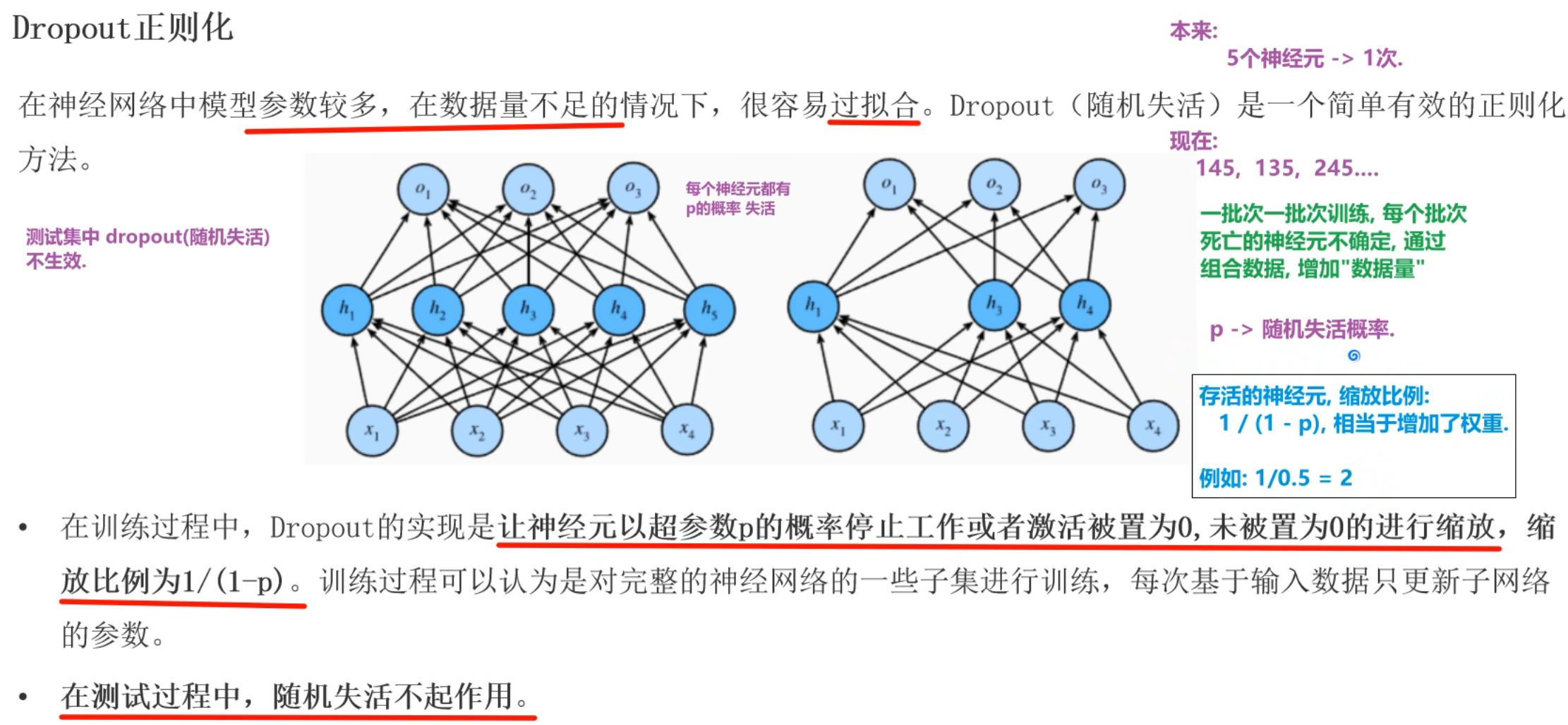

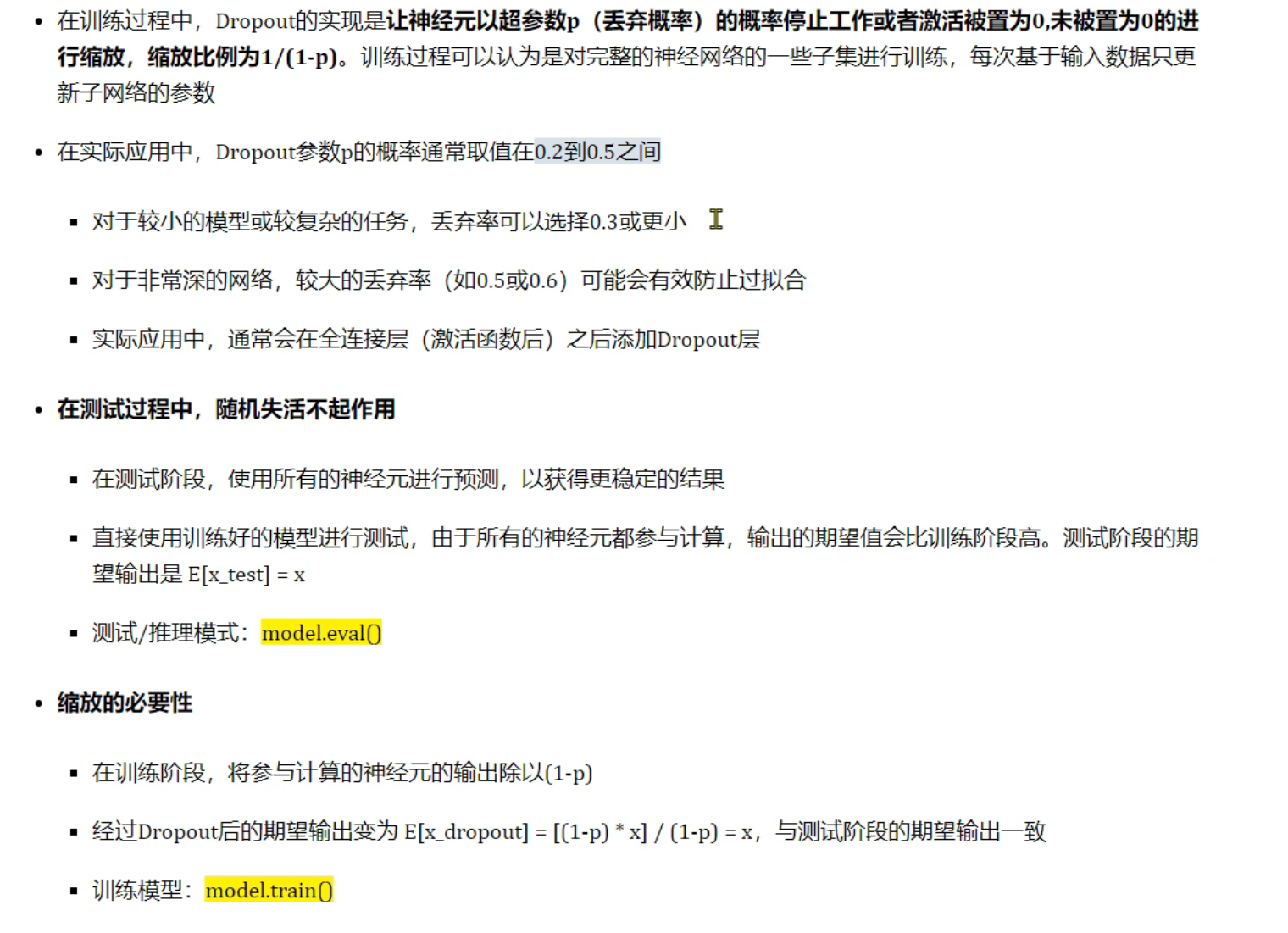

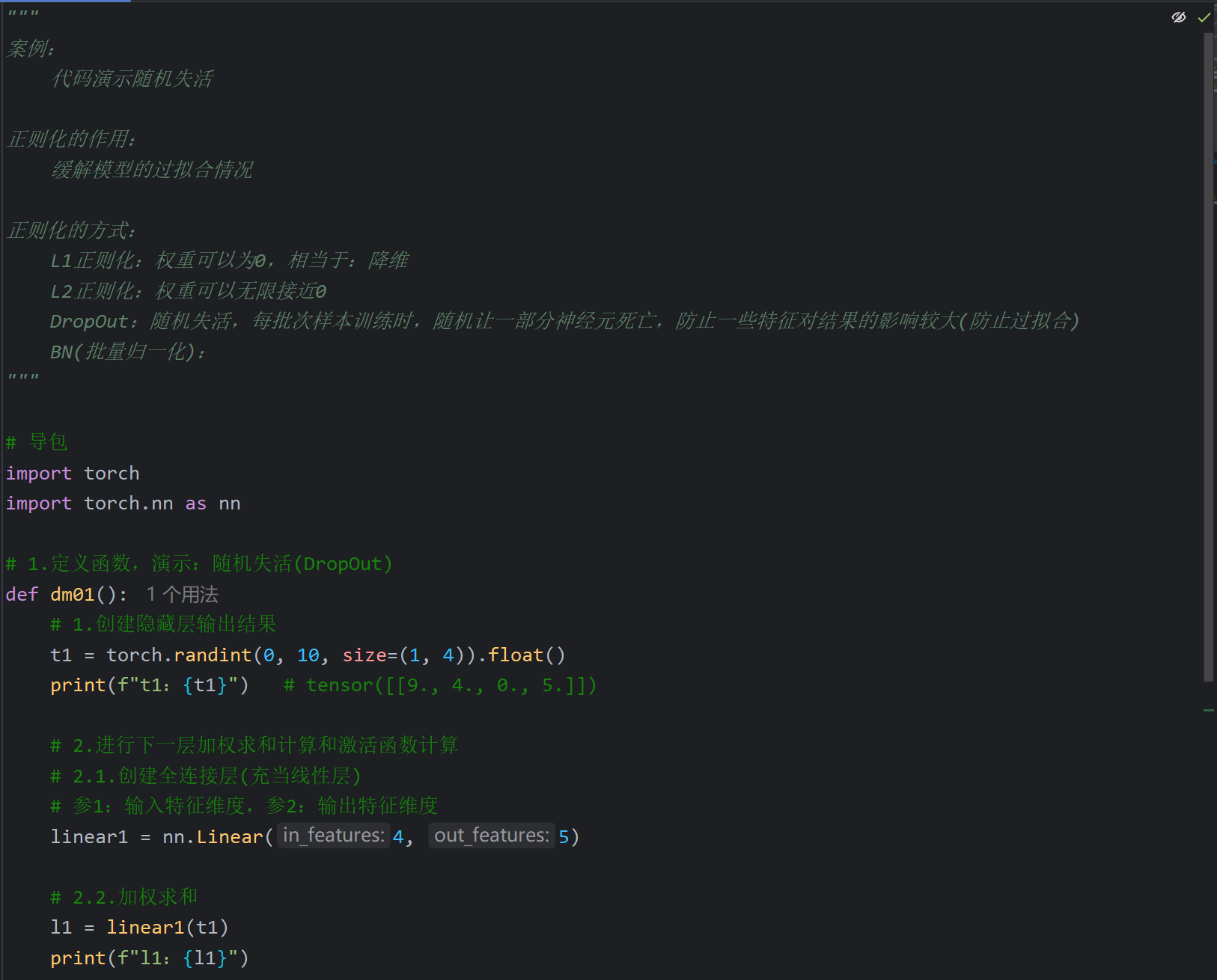

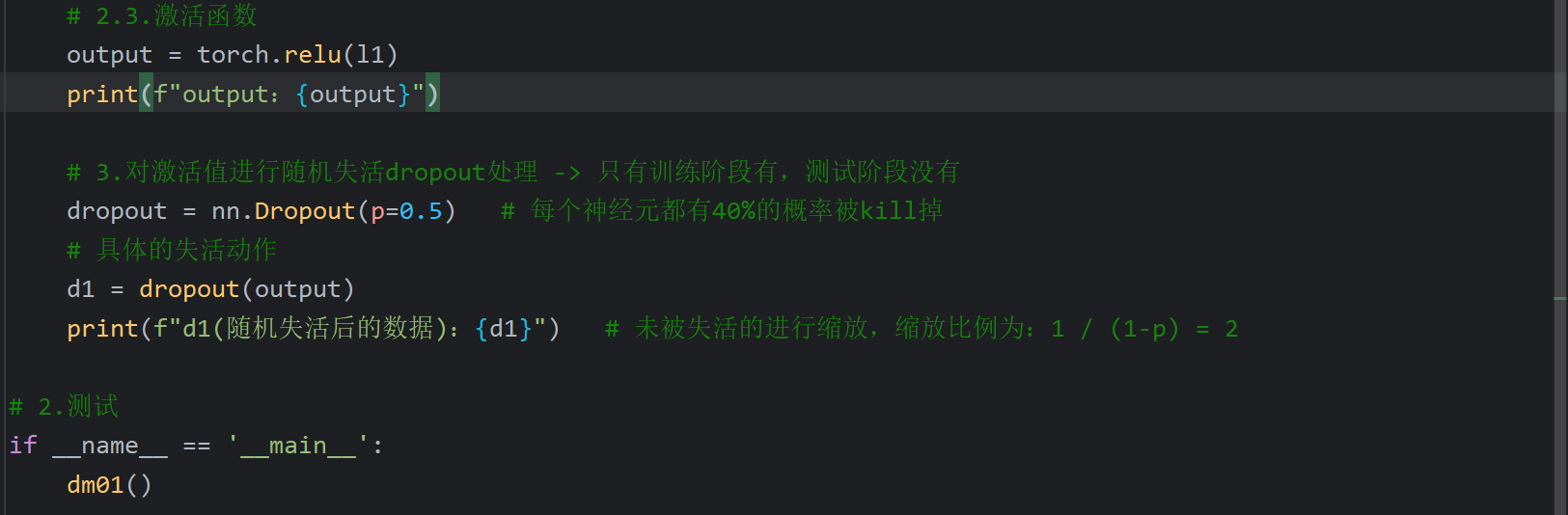

15、正则化_dropout(随机失活)介绍

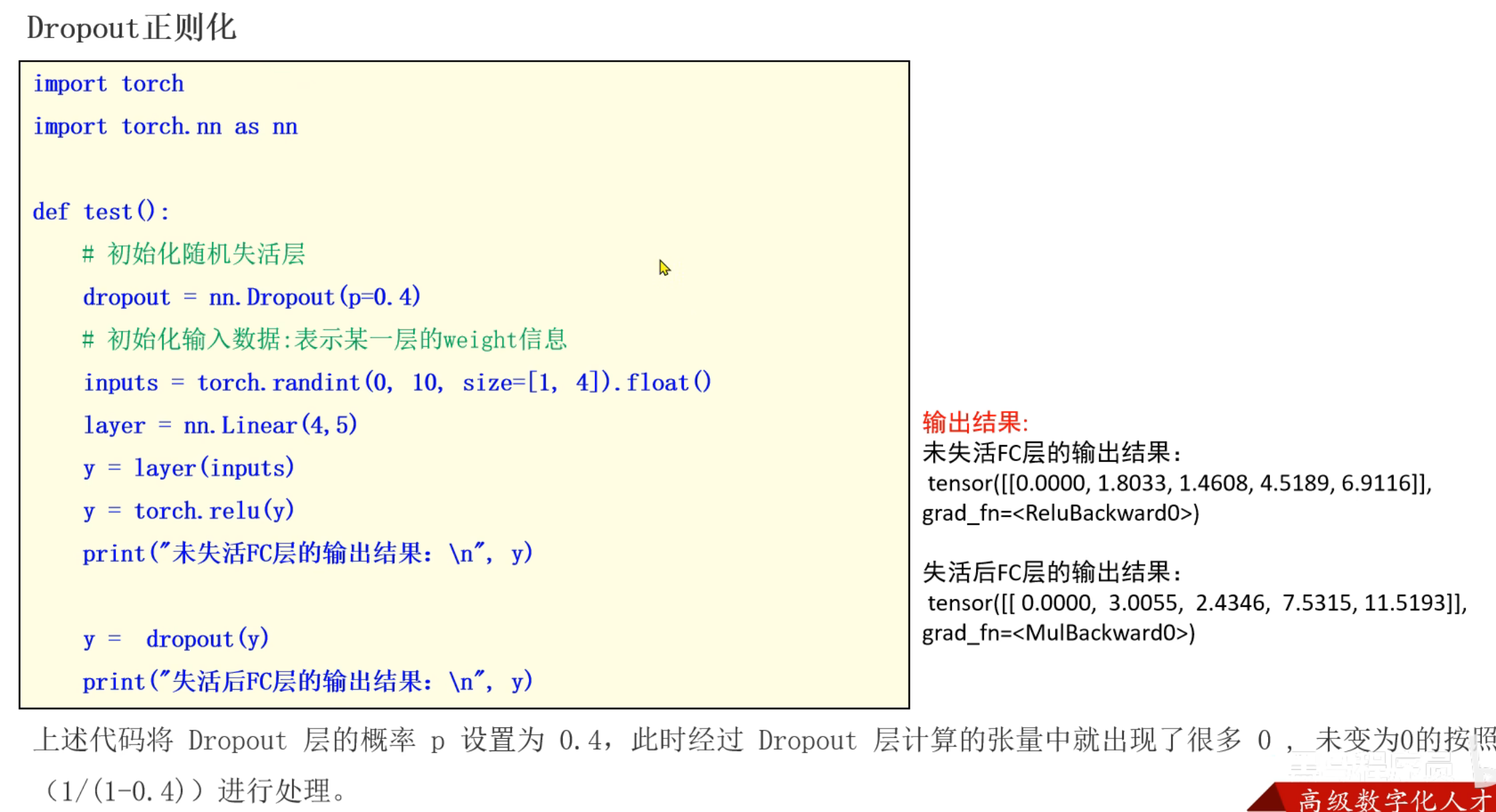

16、正则化_dropout(随机失活)代码演示

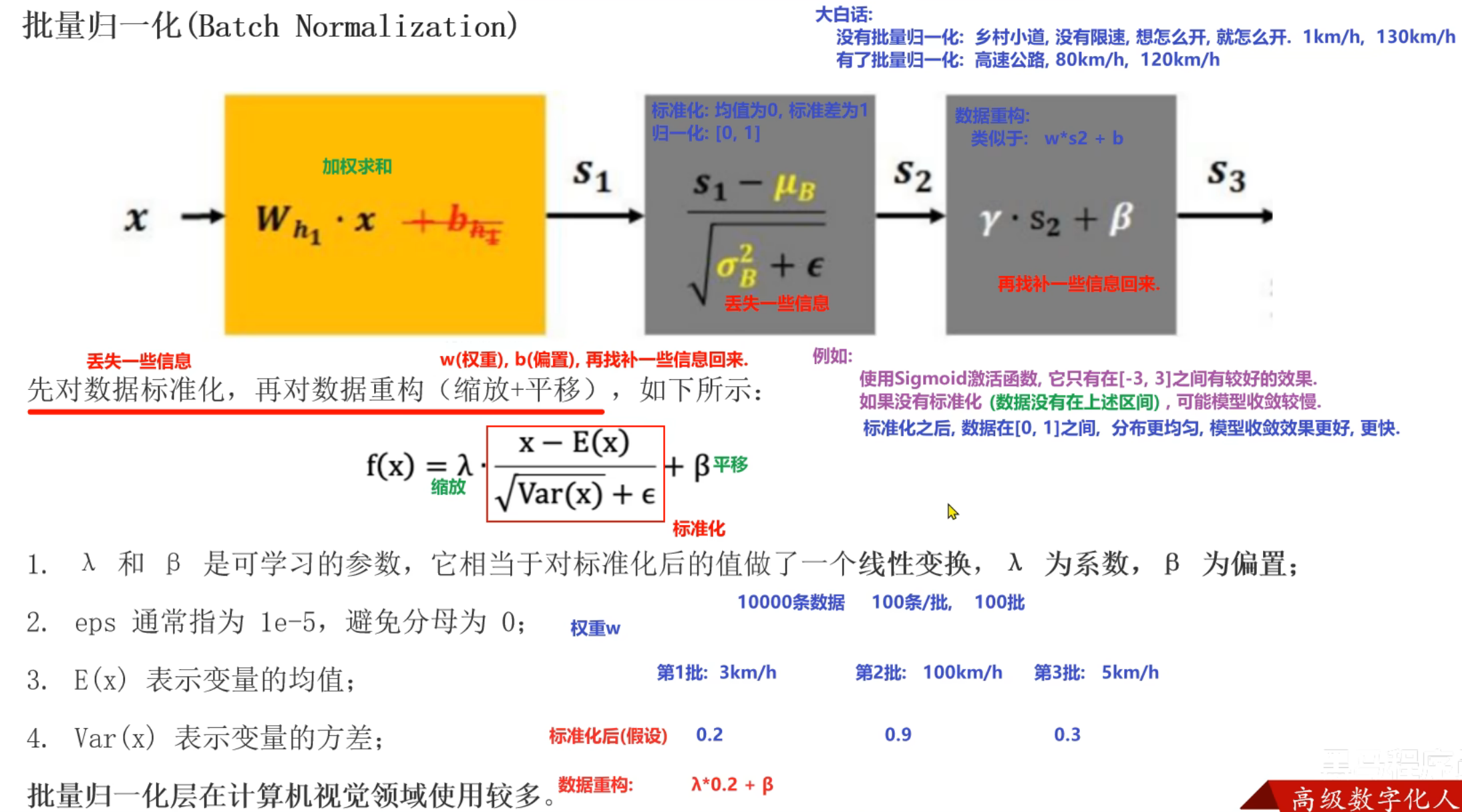

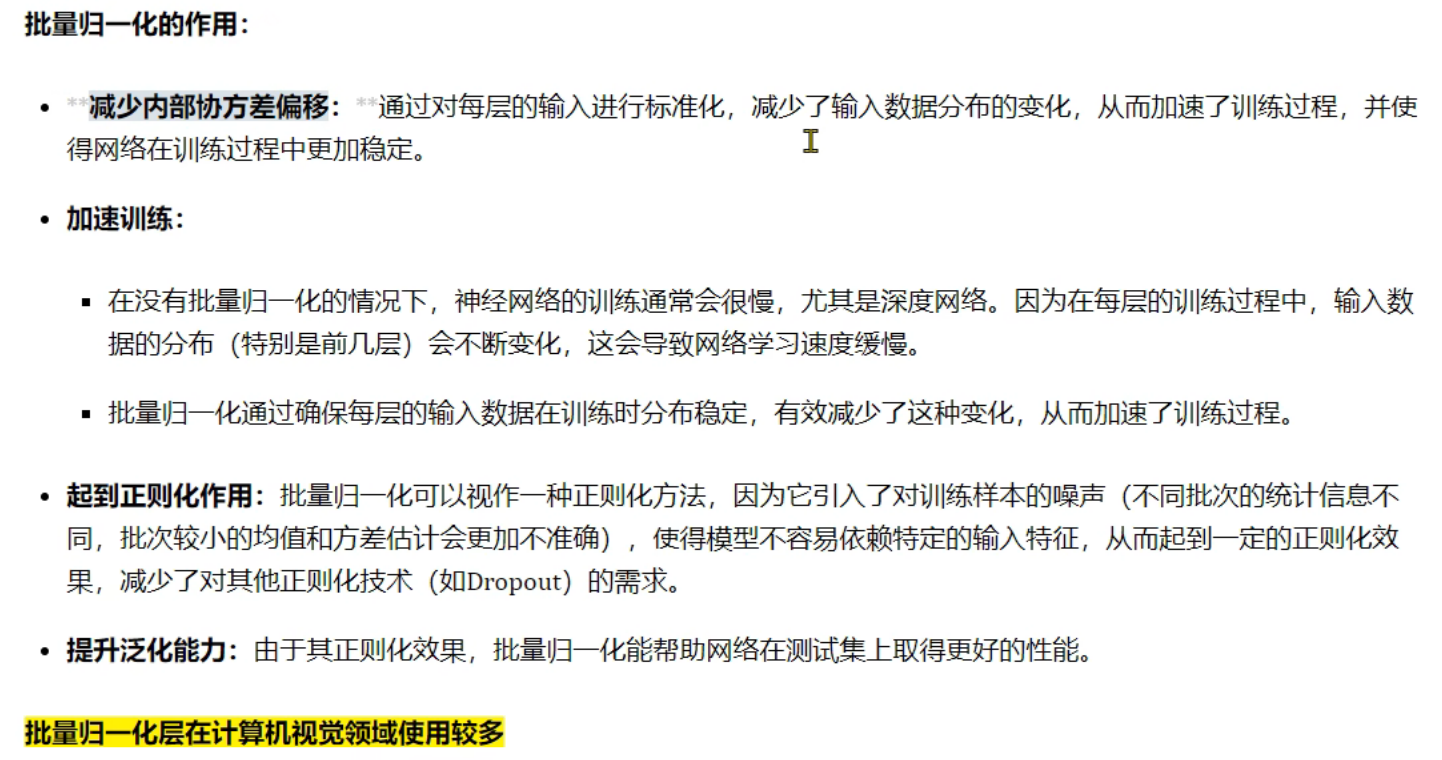

17、正则化_批量归一化(BN)介绍

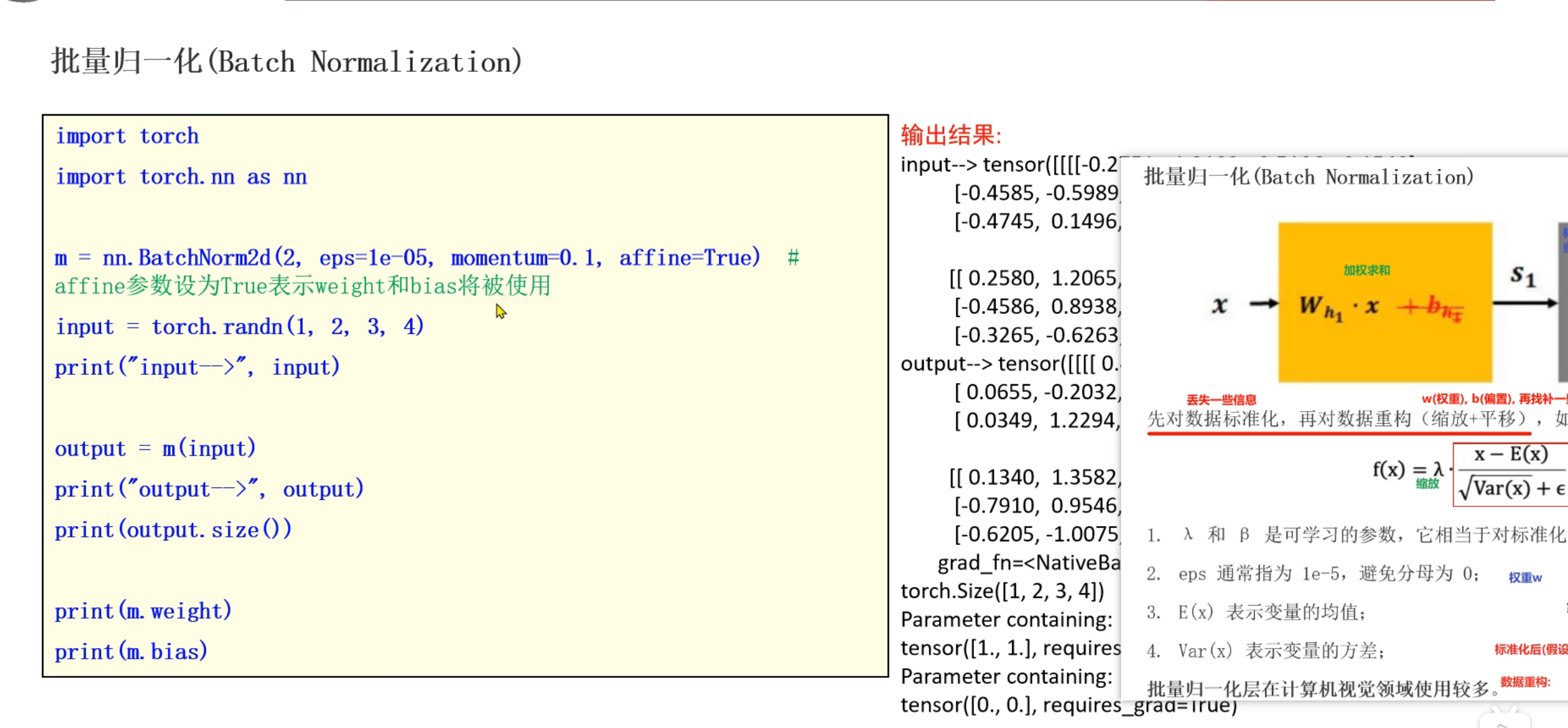

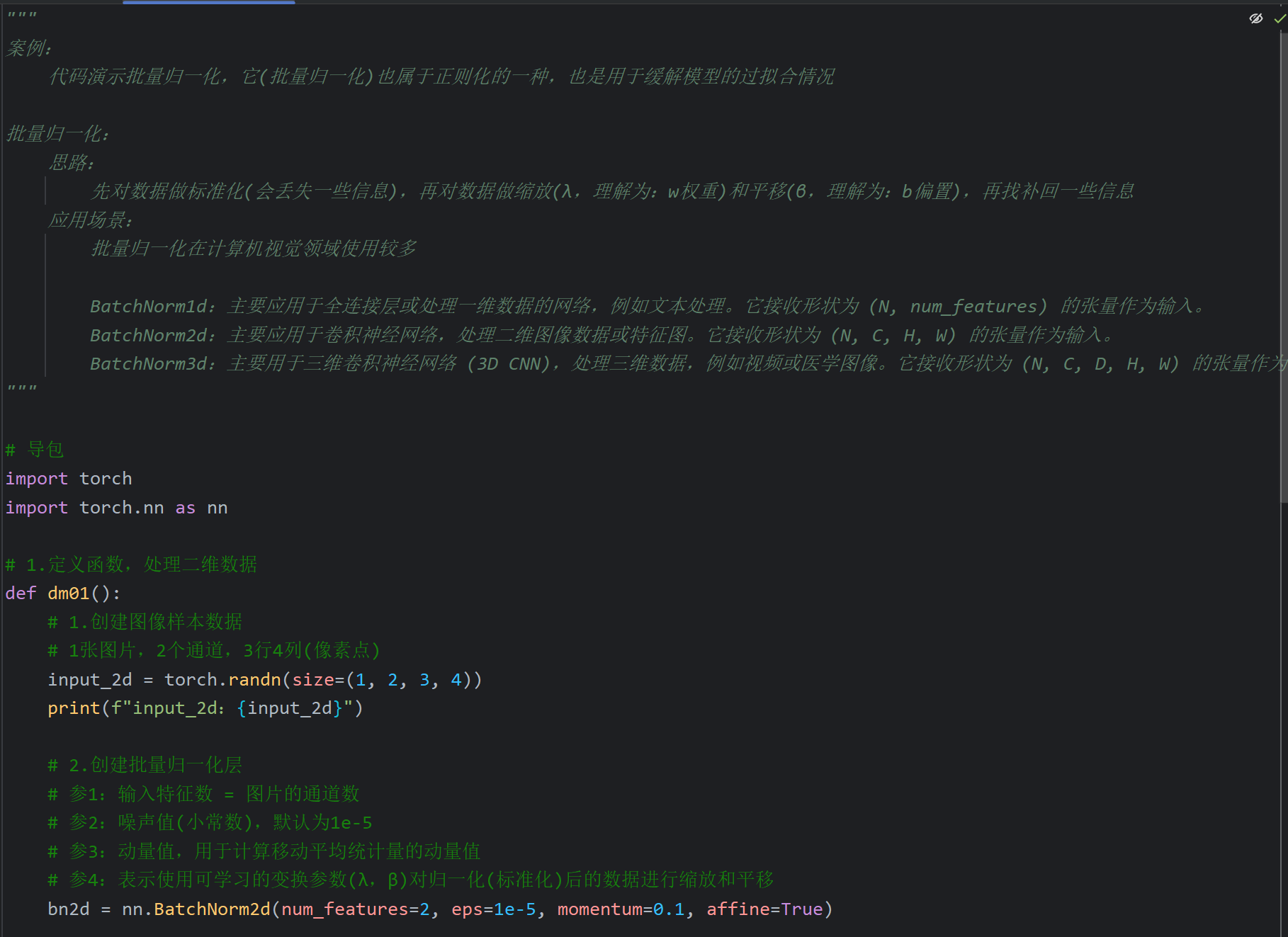

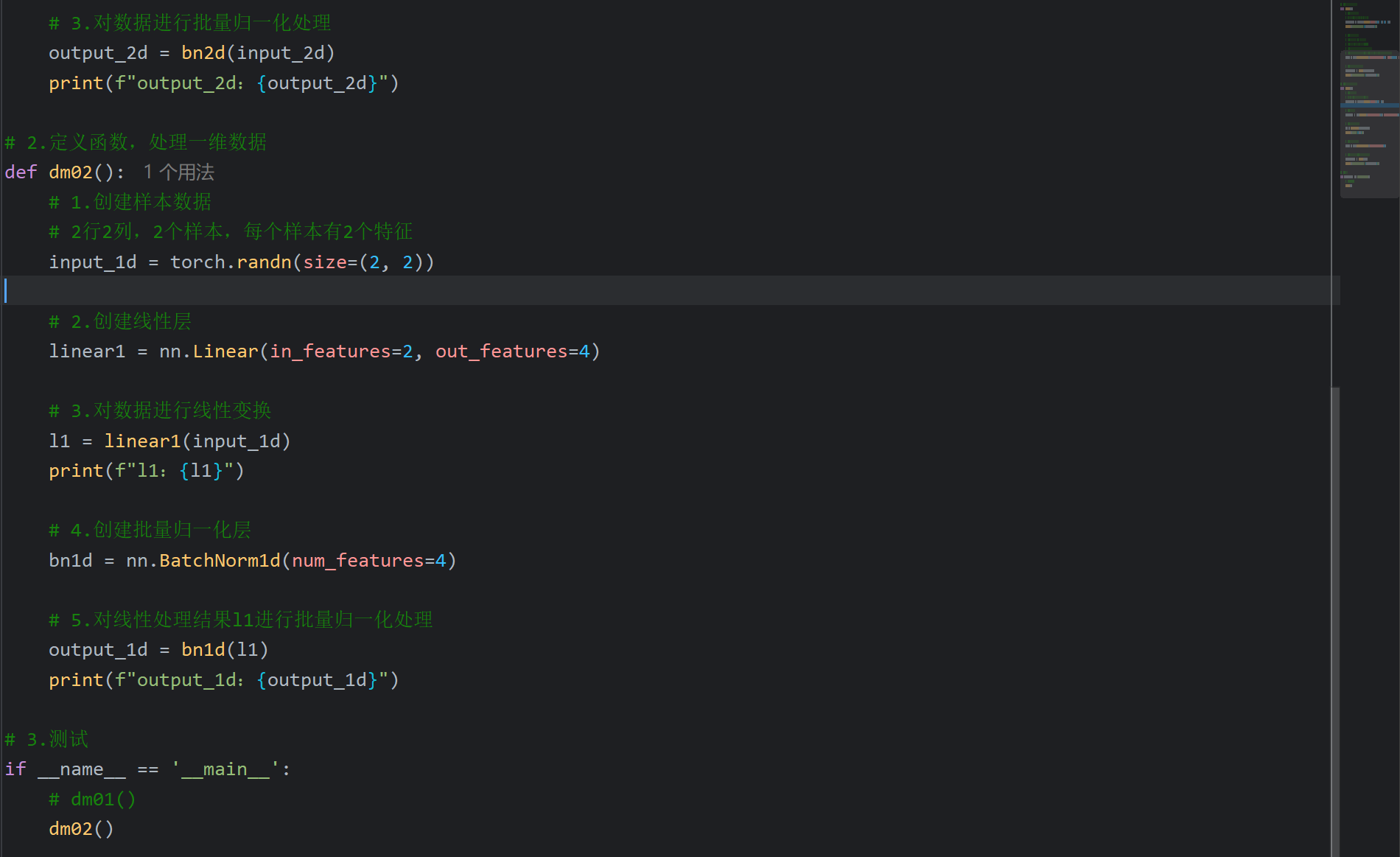

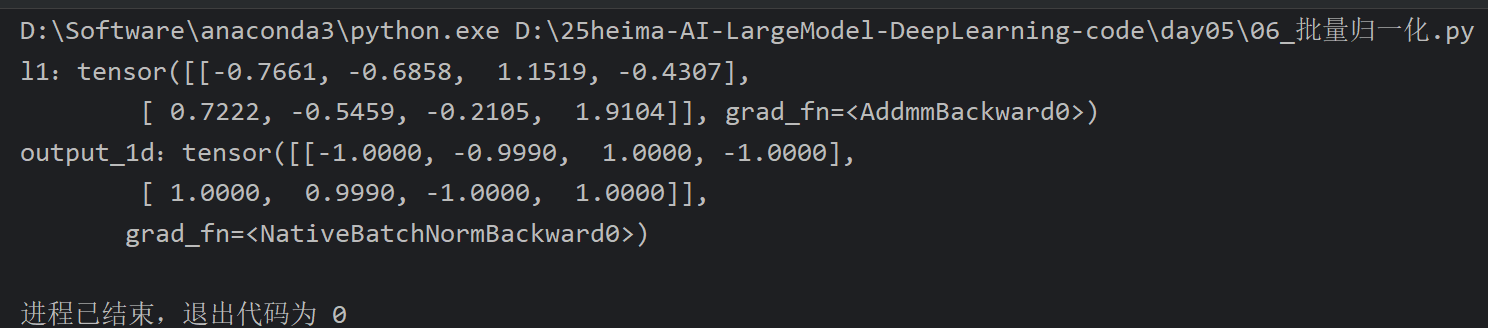

18、正则化_批量归一化(BN)代码实现

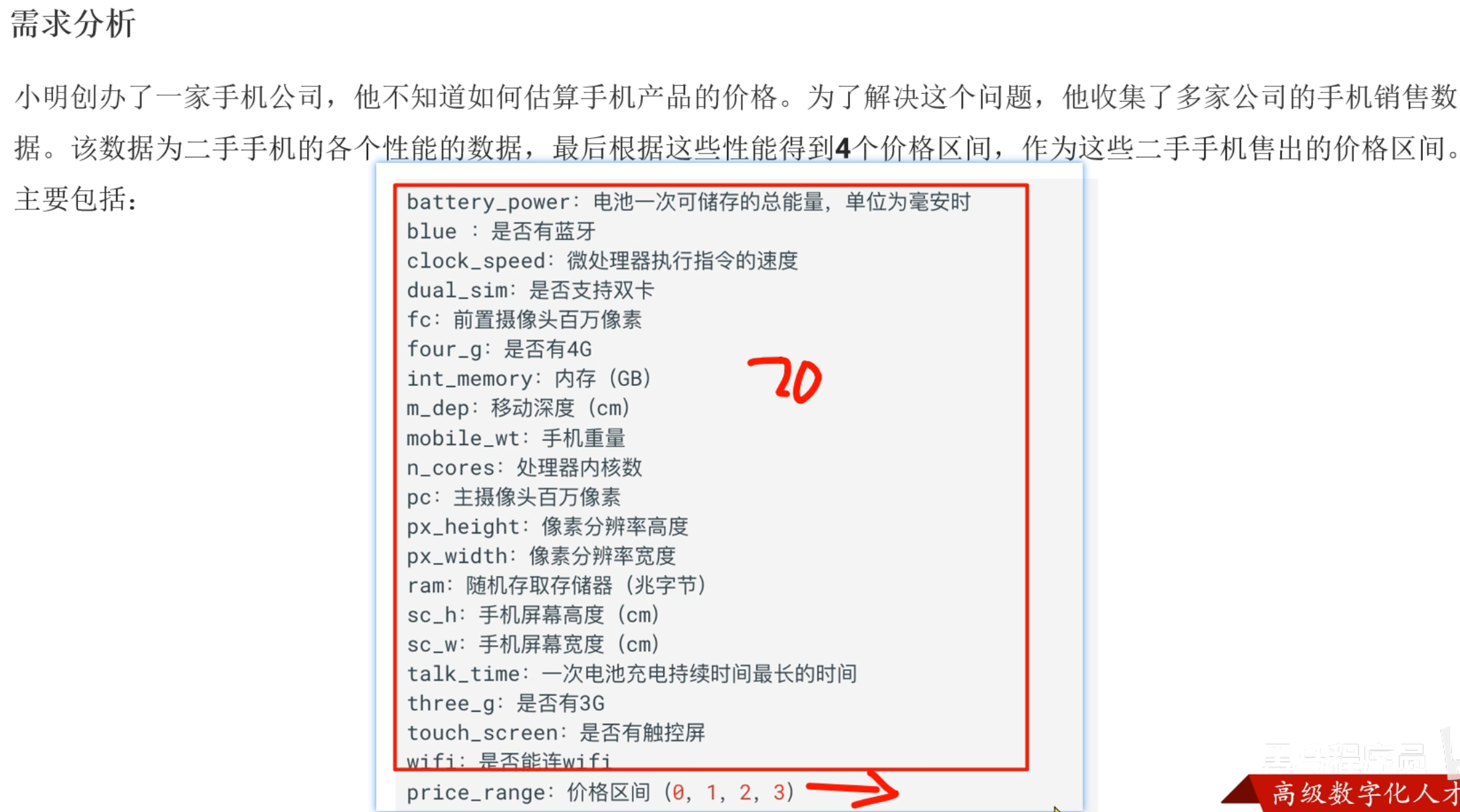

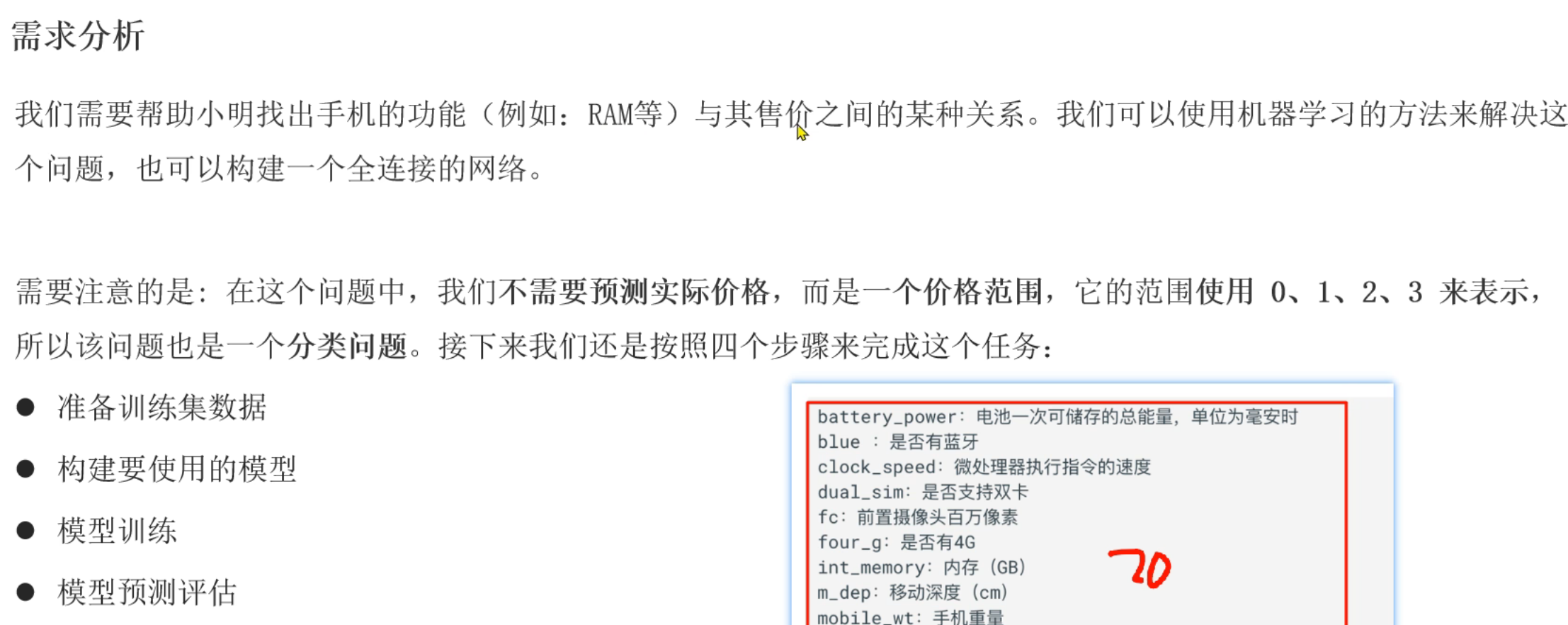

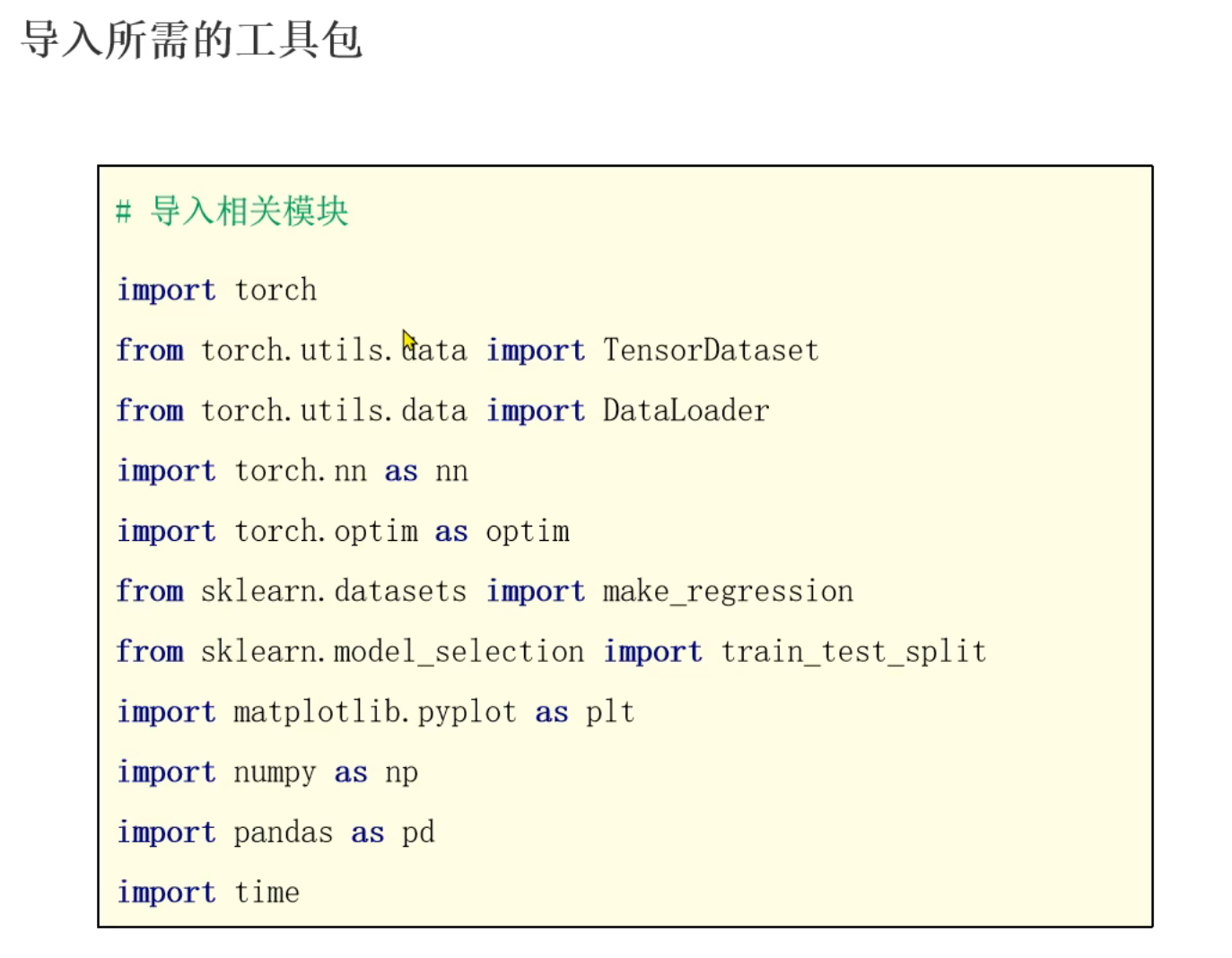

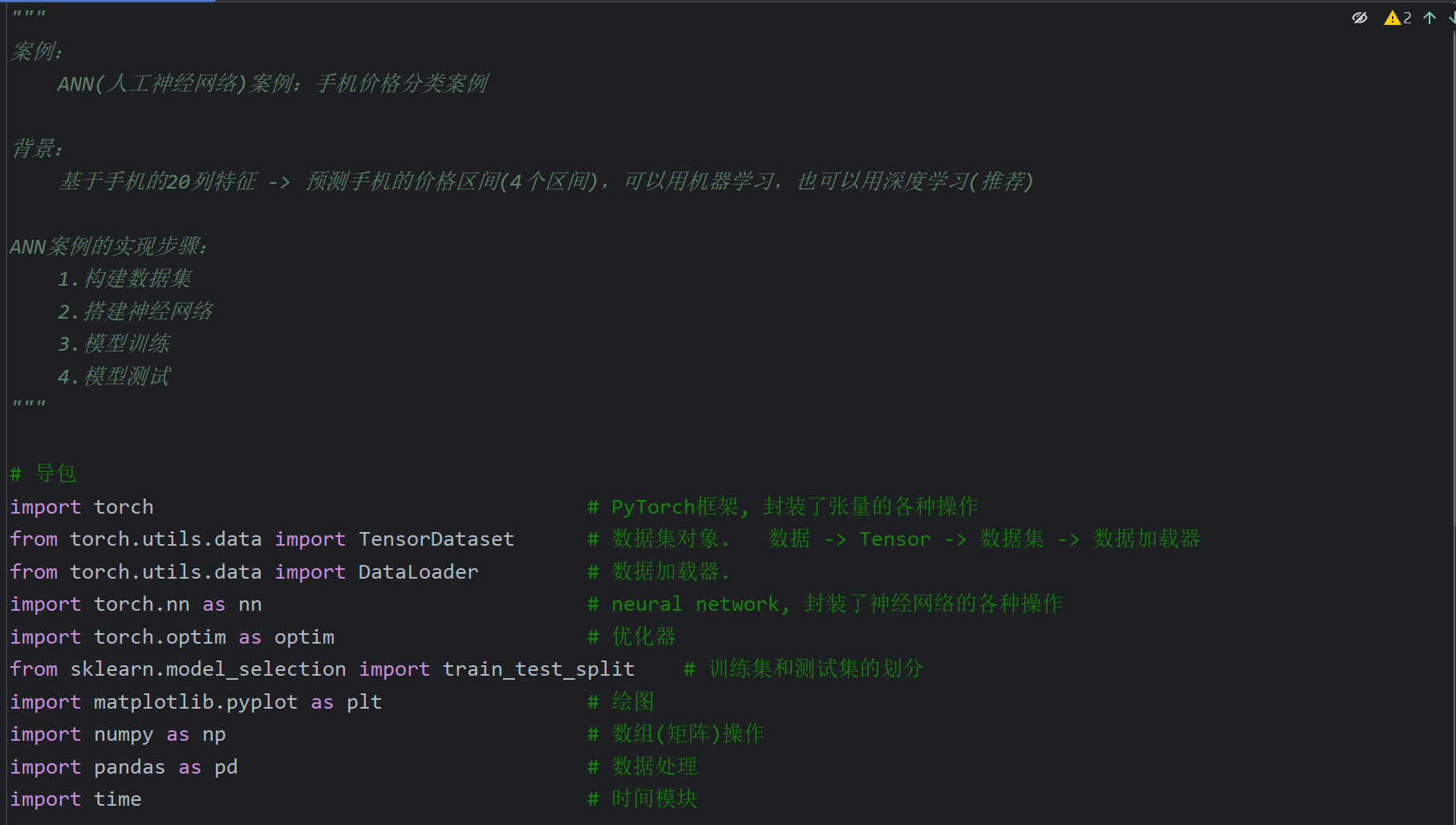

19、ANN案例_手机价格分类_需求介绍

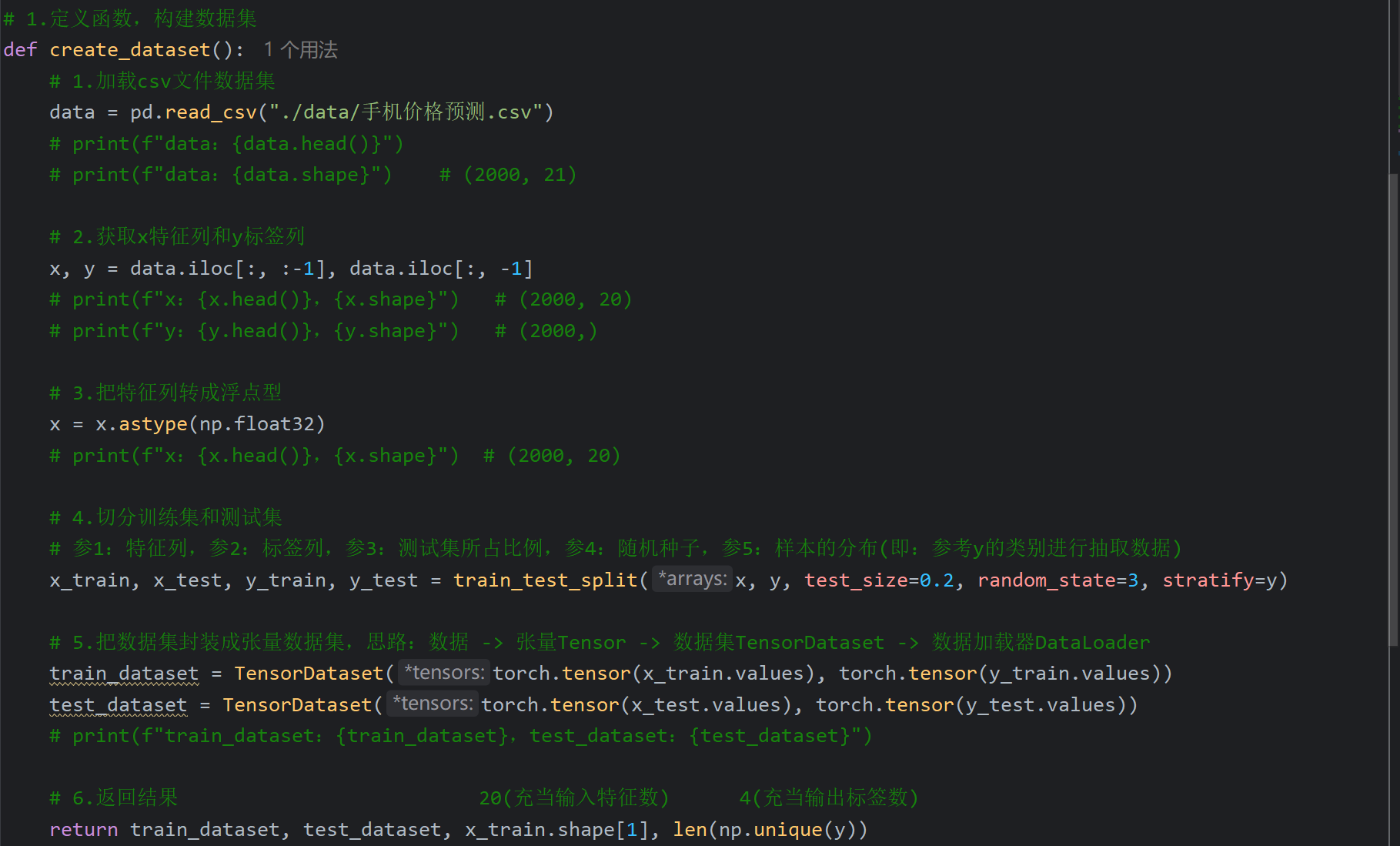

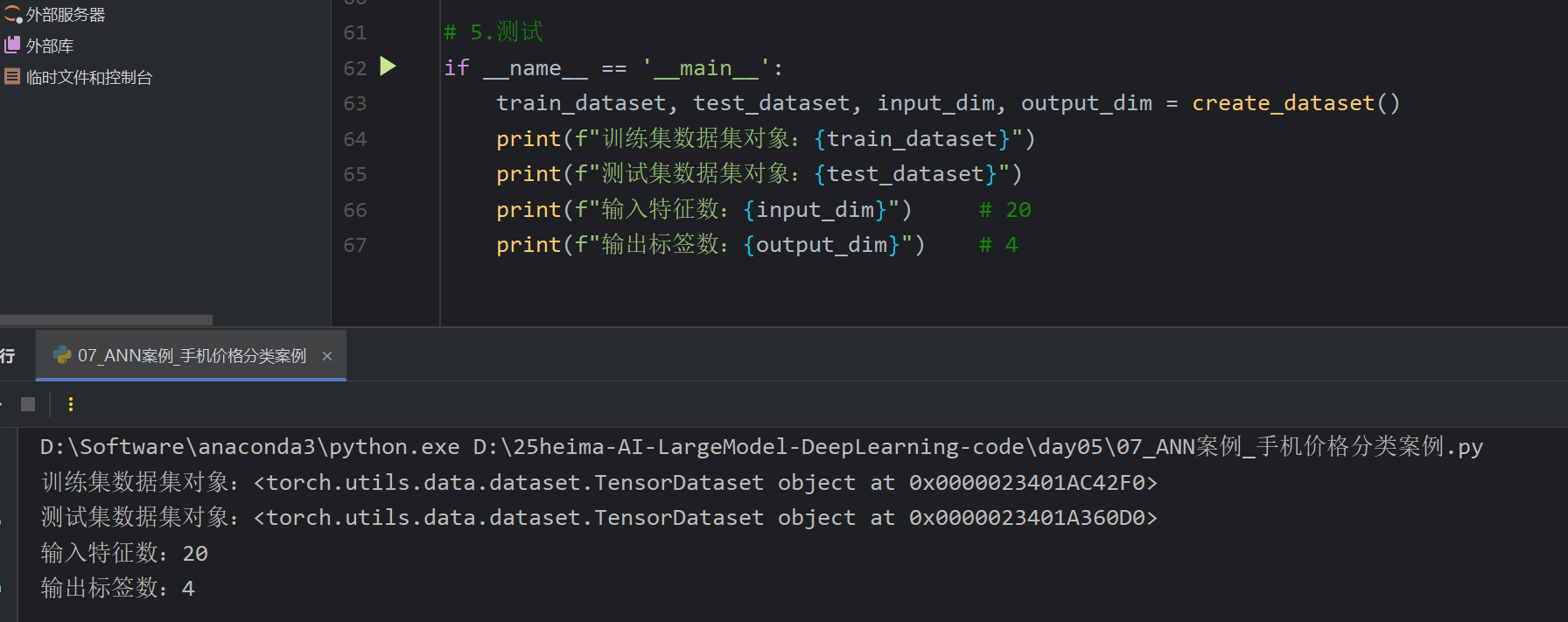

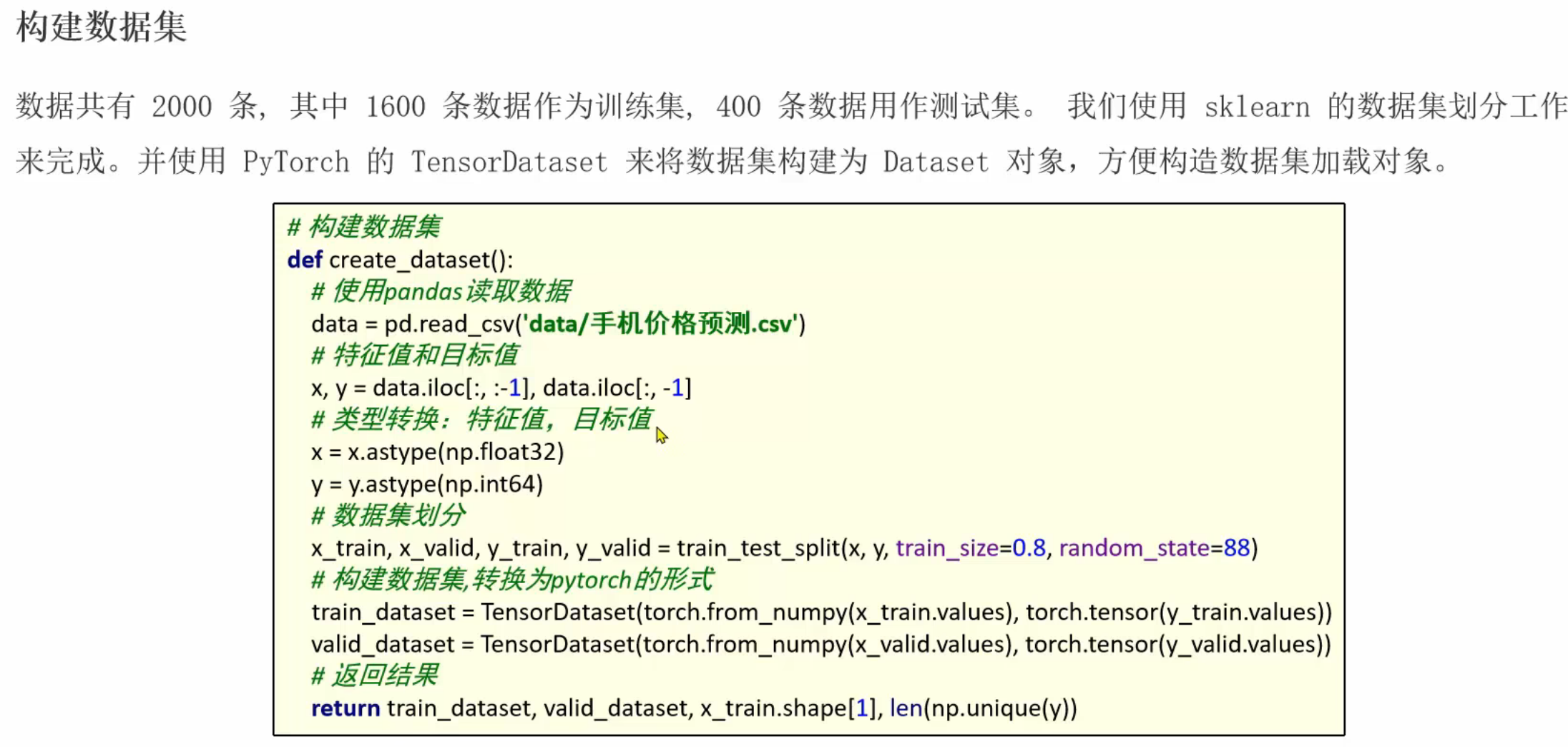

20、ANN案例_手机价格分类_准备数据集

七、Day06

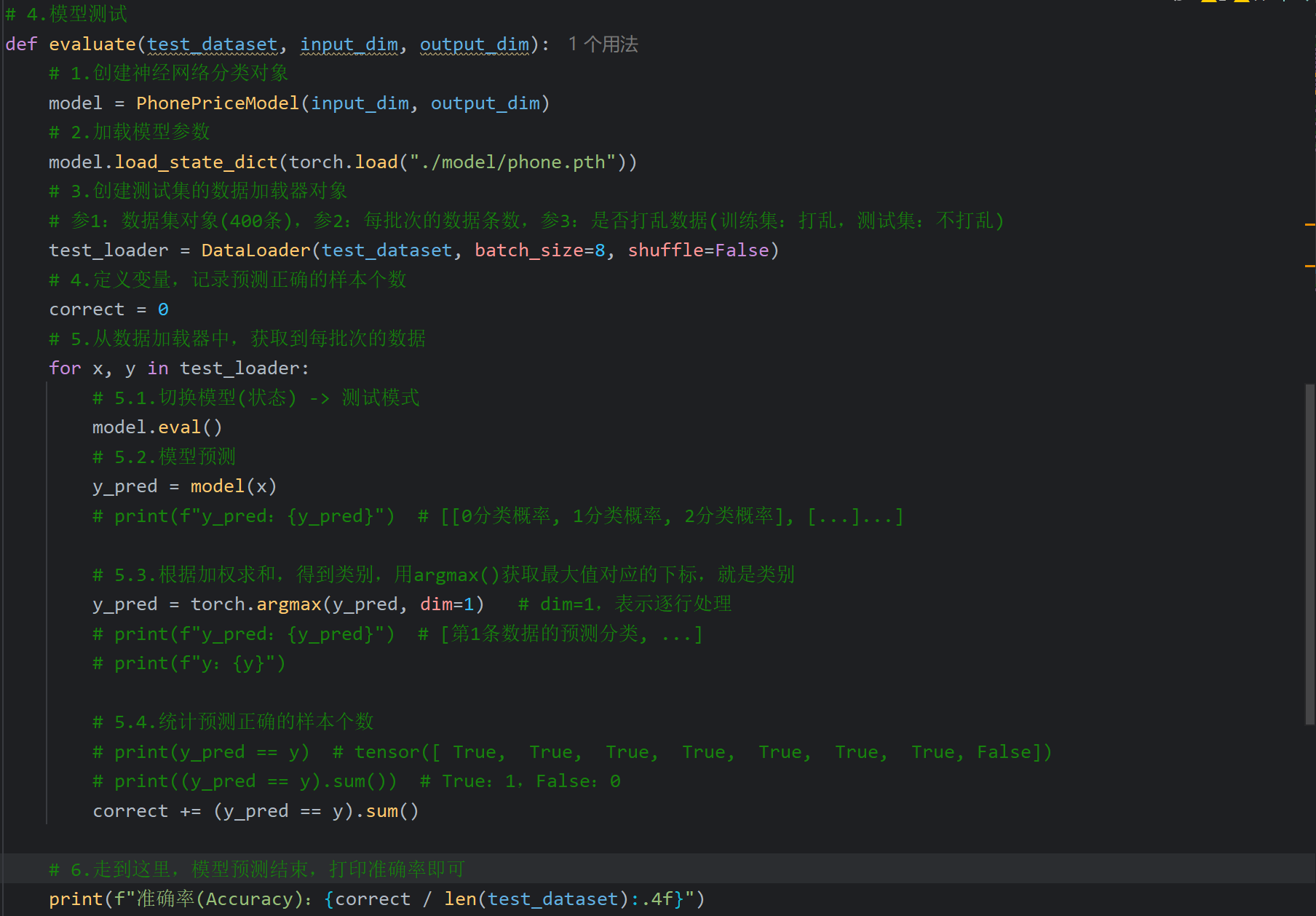

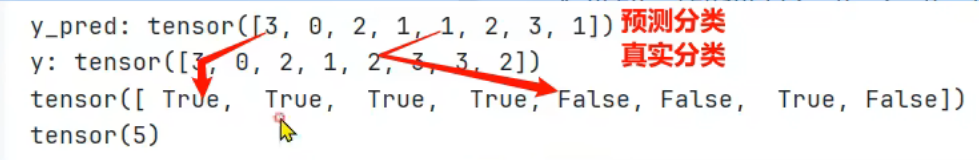

1、ANN案例_手机价格分类_准备数据集(回顾)

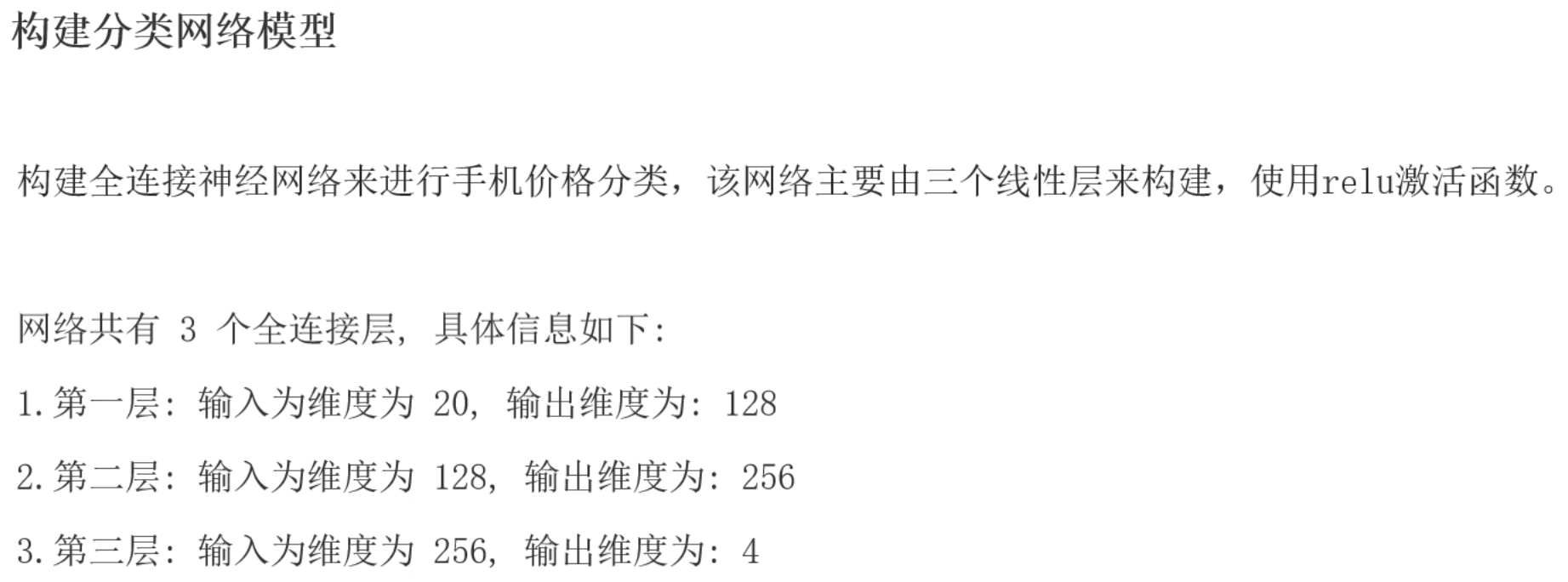

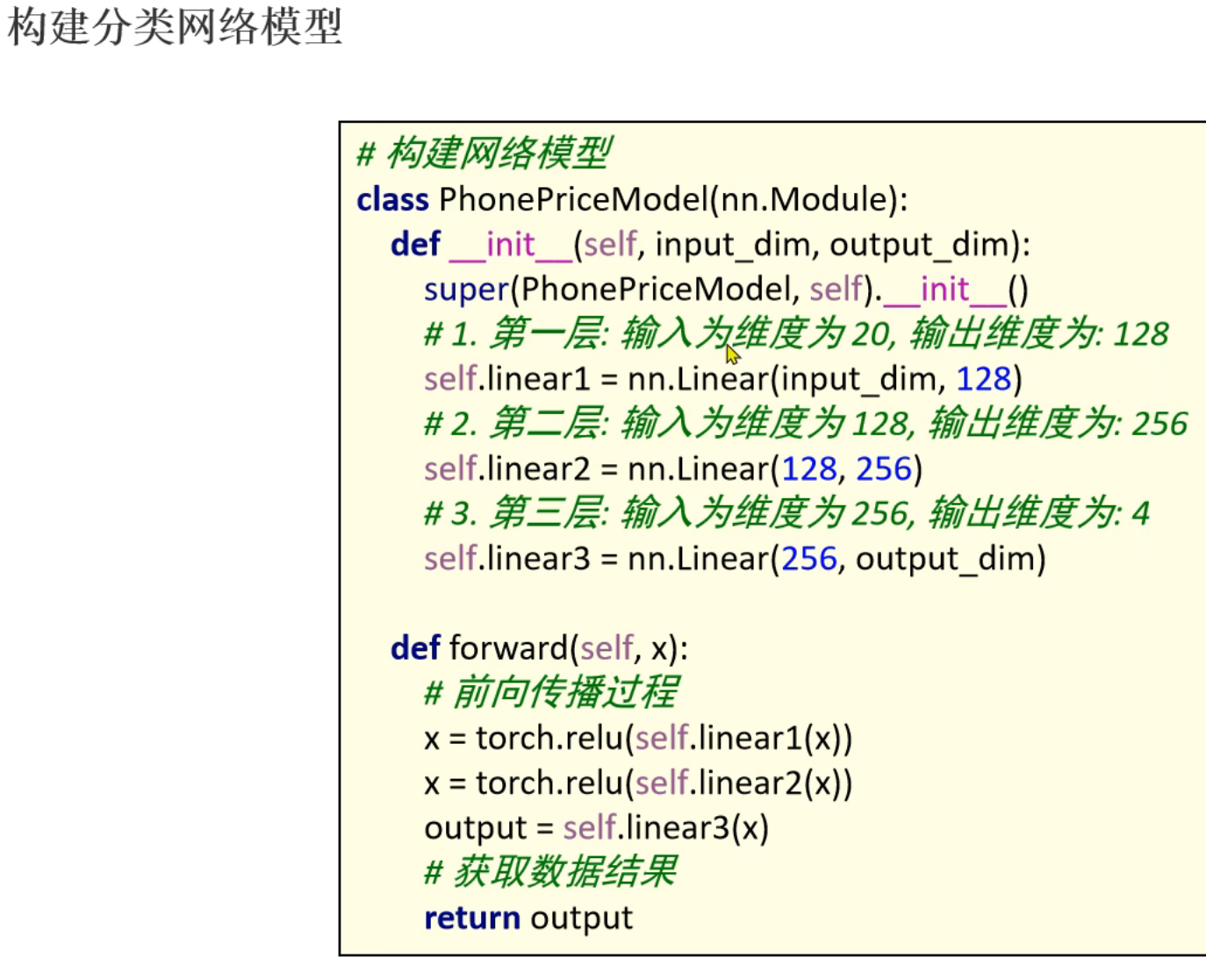

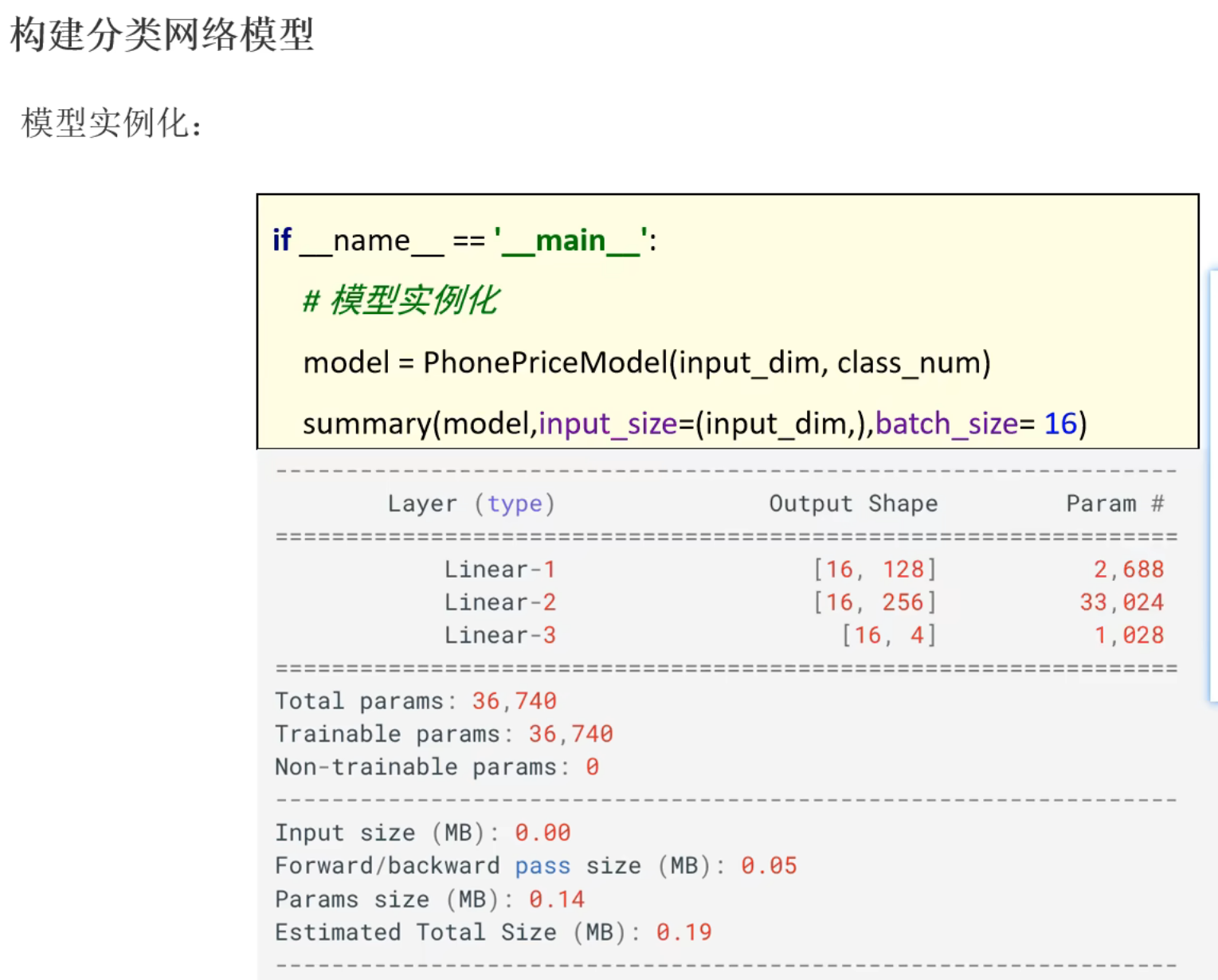

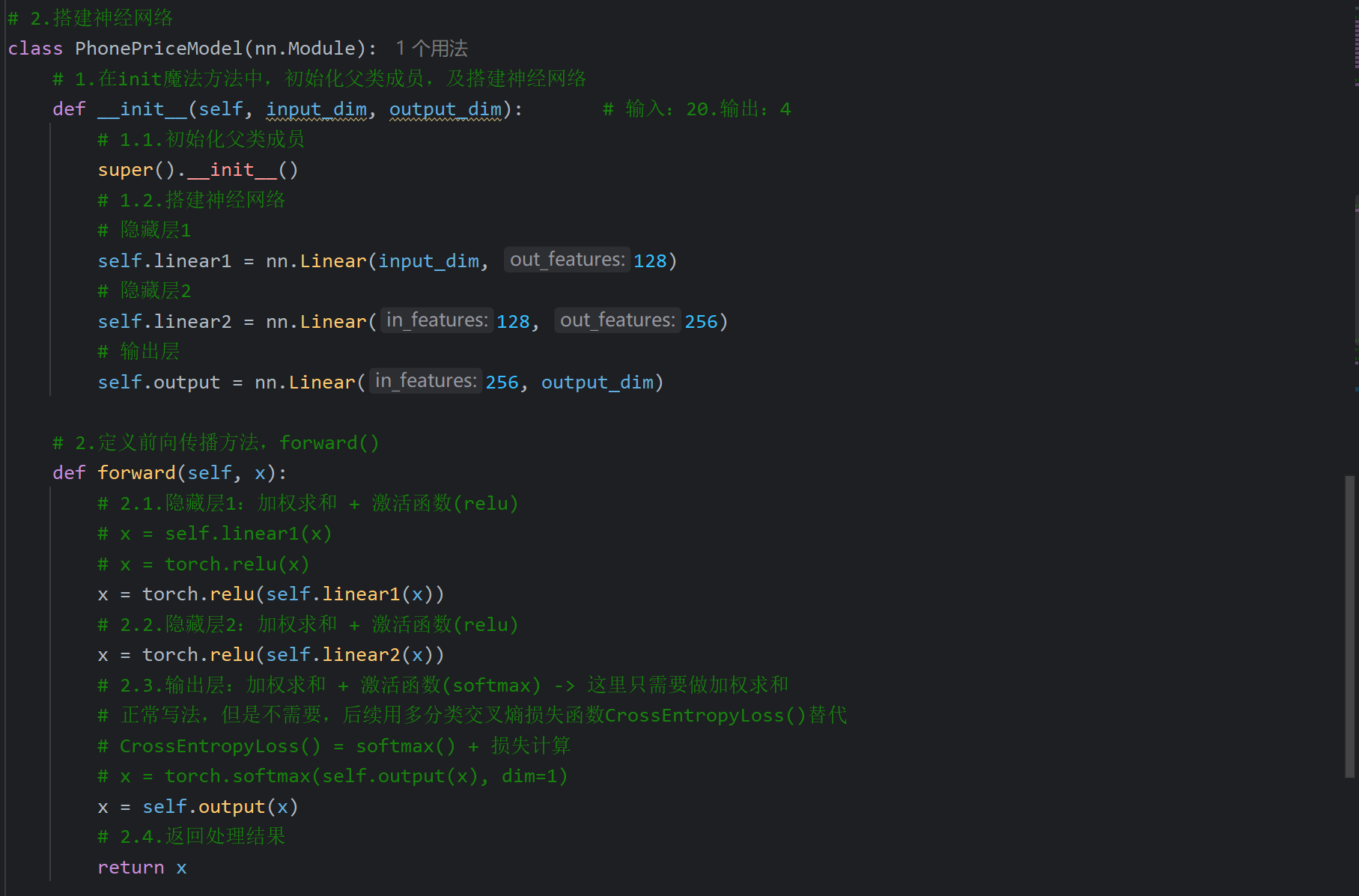

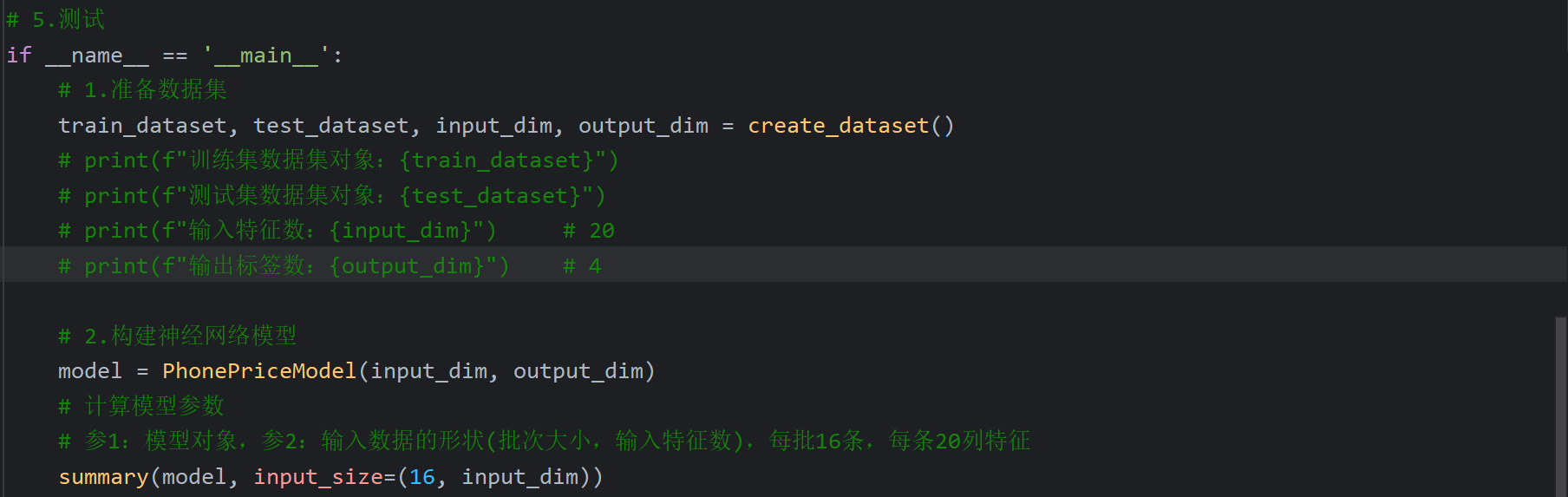

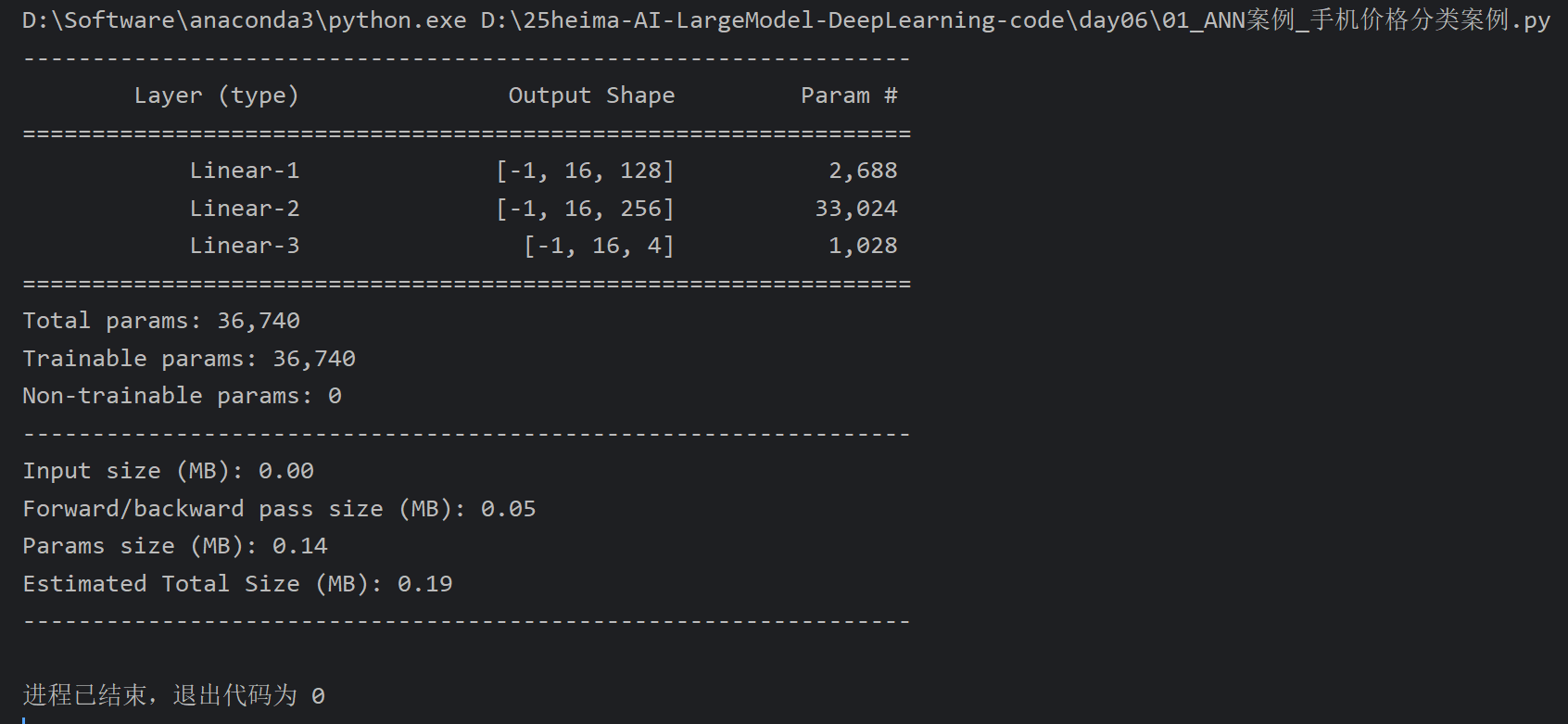

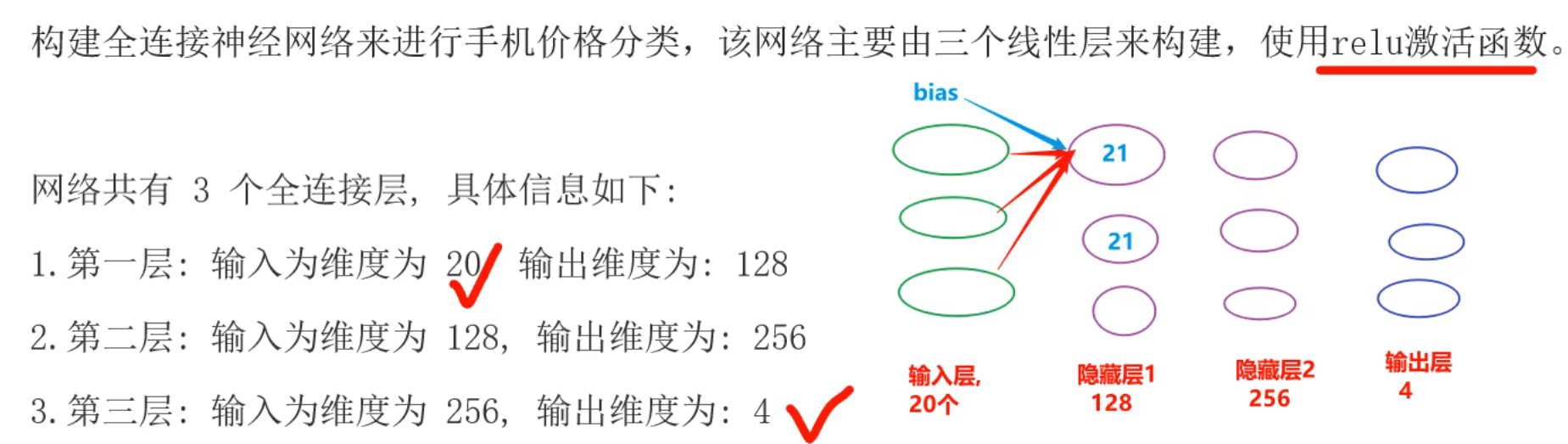

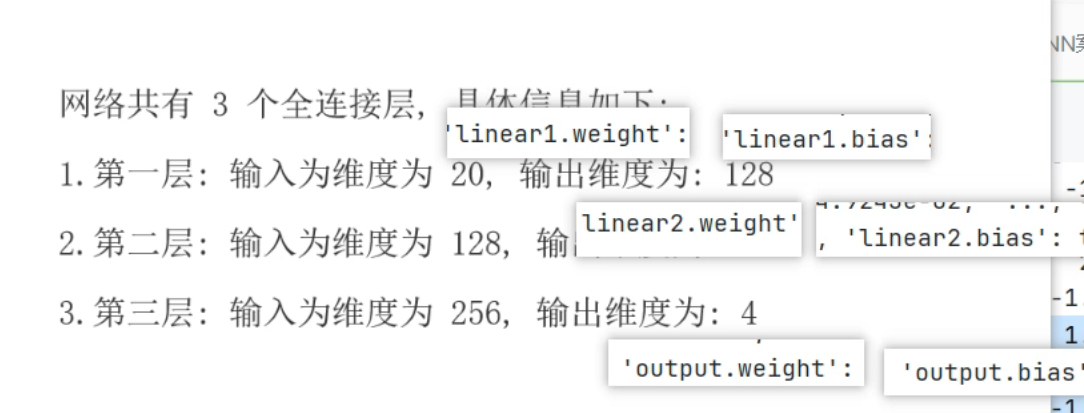

2、ANN案例_手机价格分类_搭建神经网络

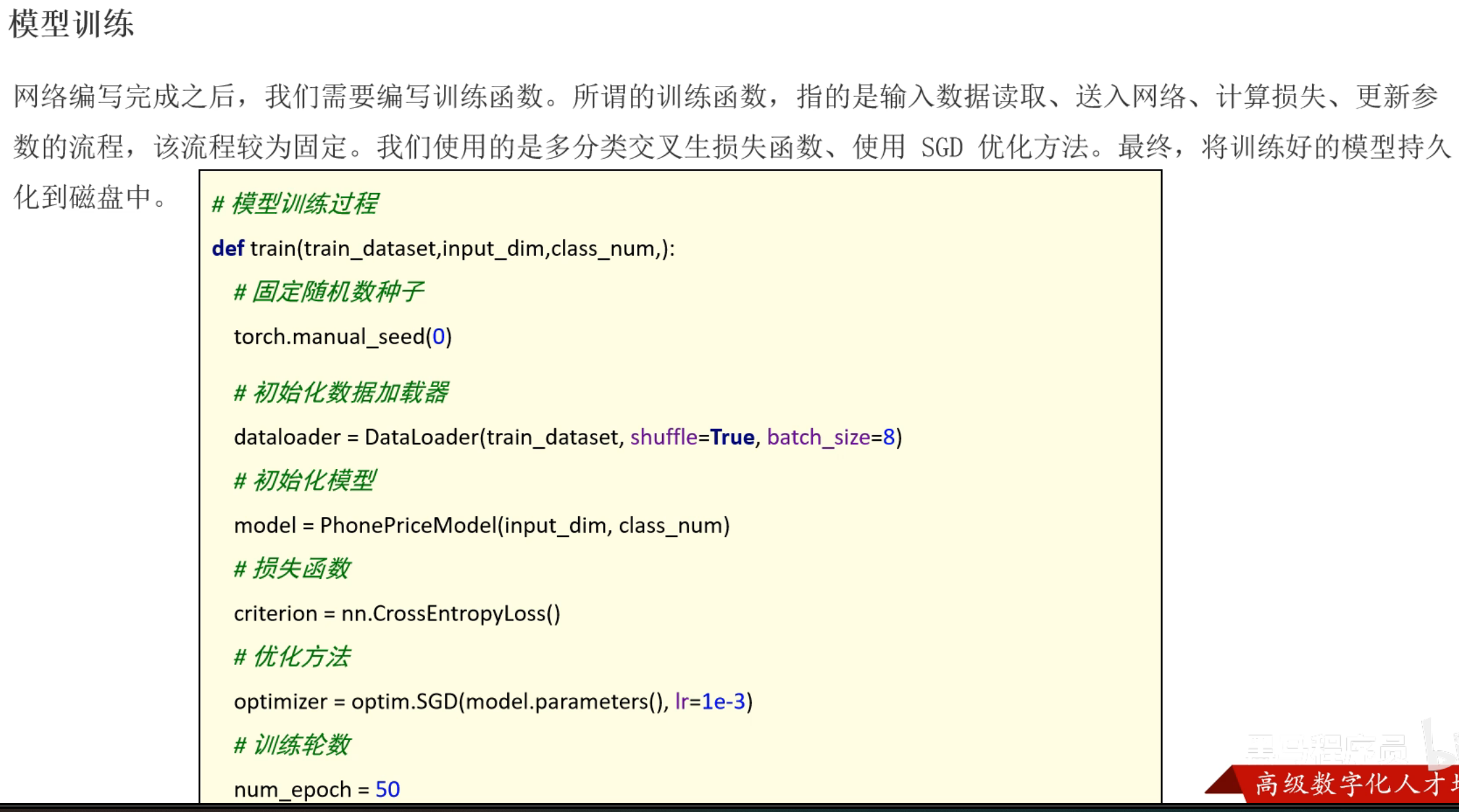

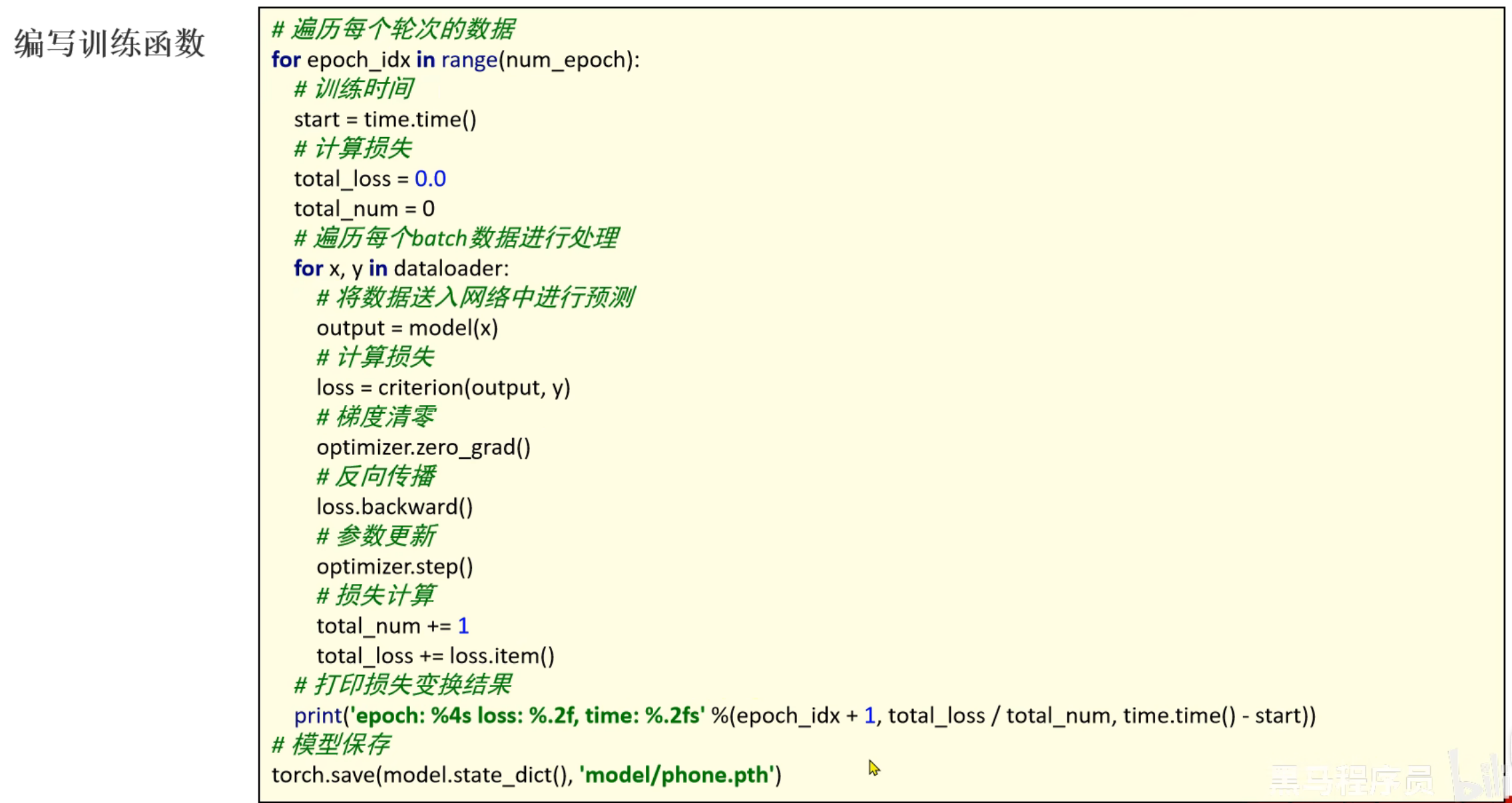

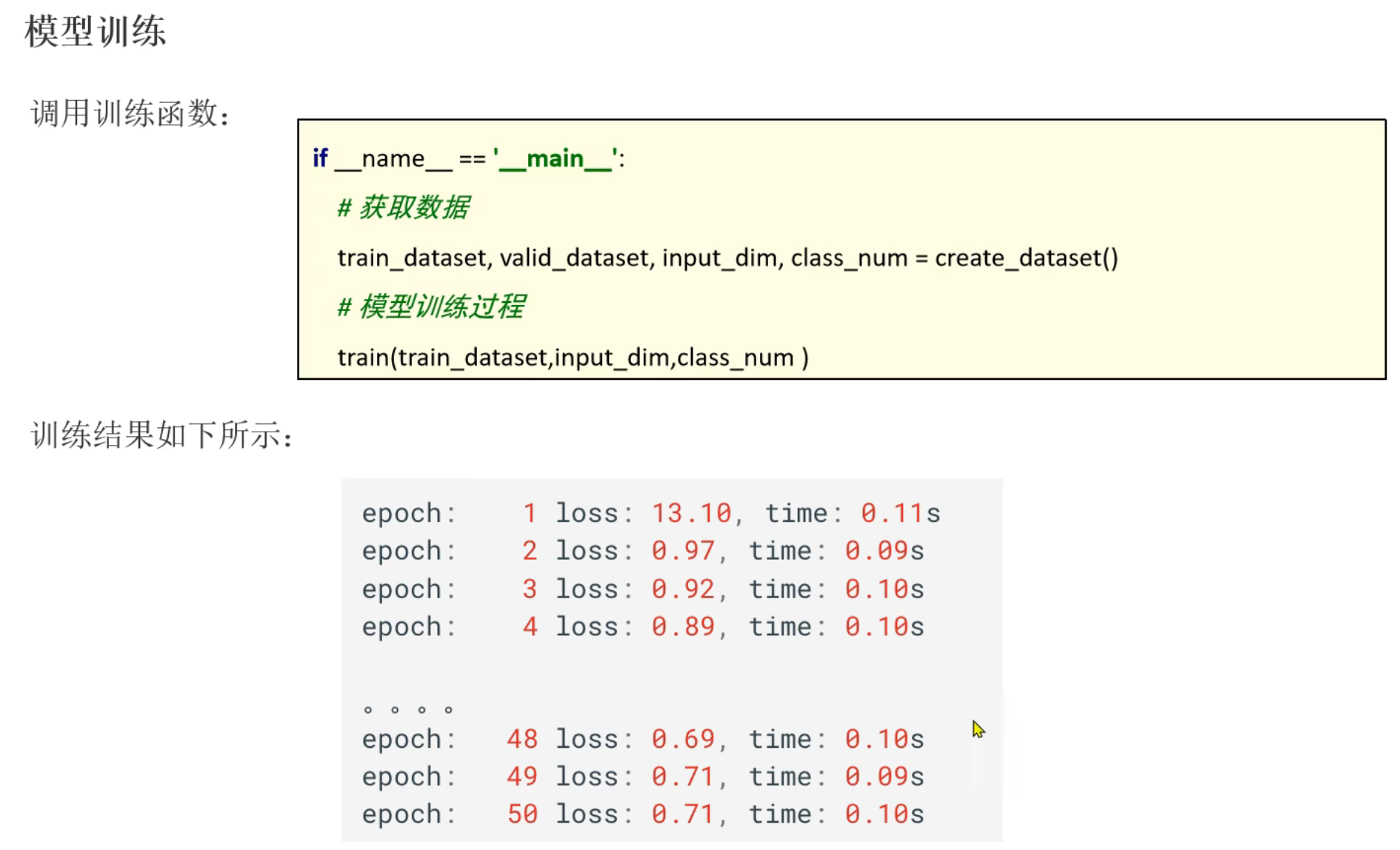

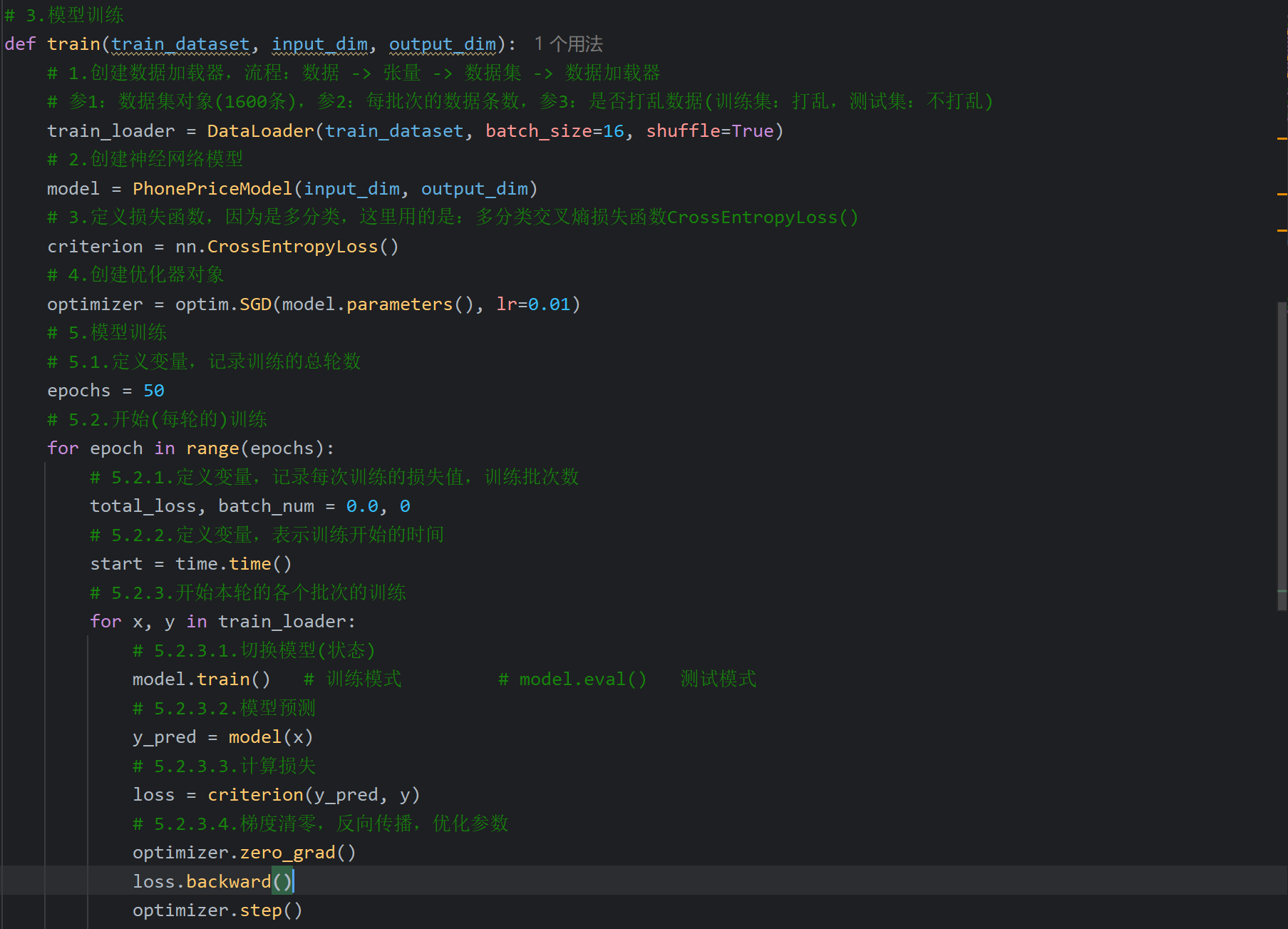

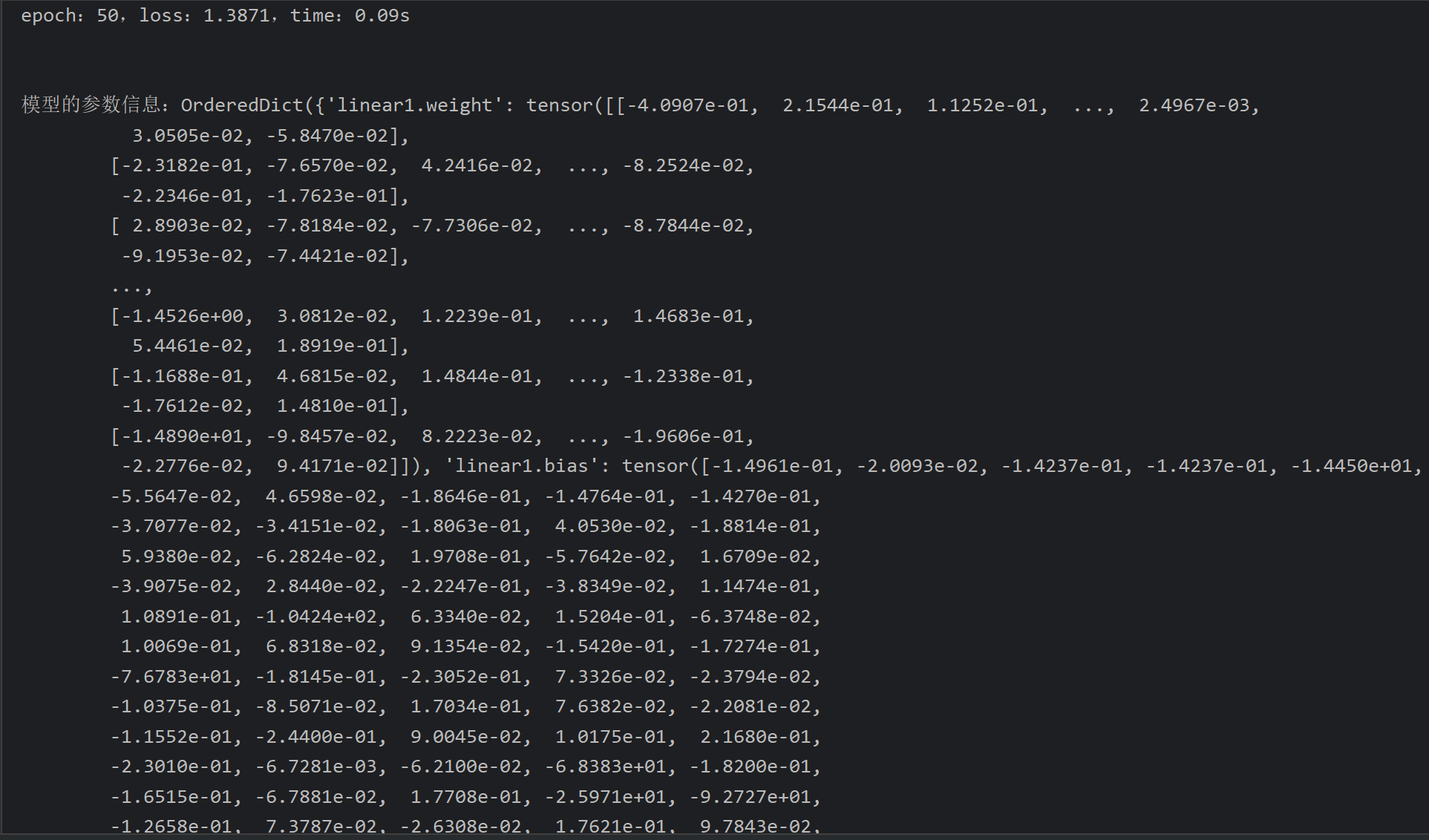

3、ANN案例_手机价格分类_模型训练

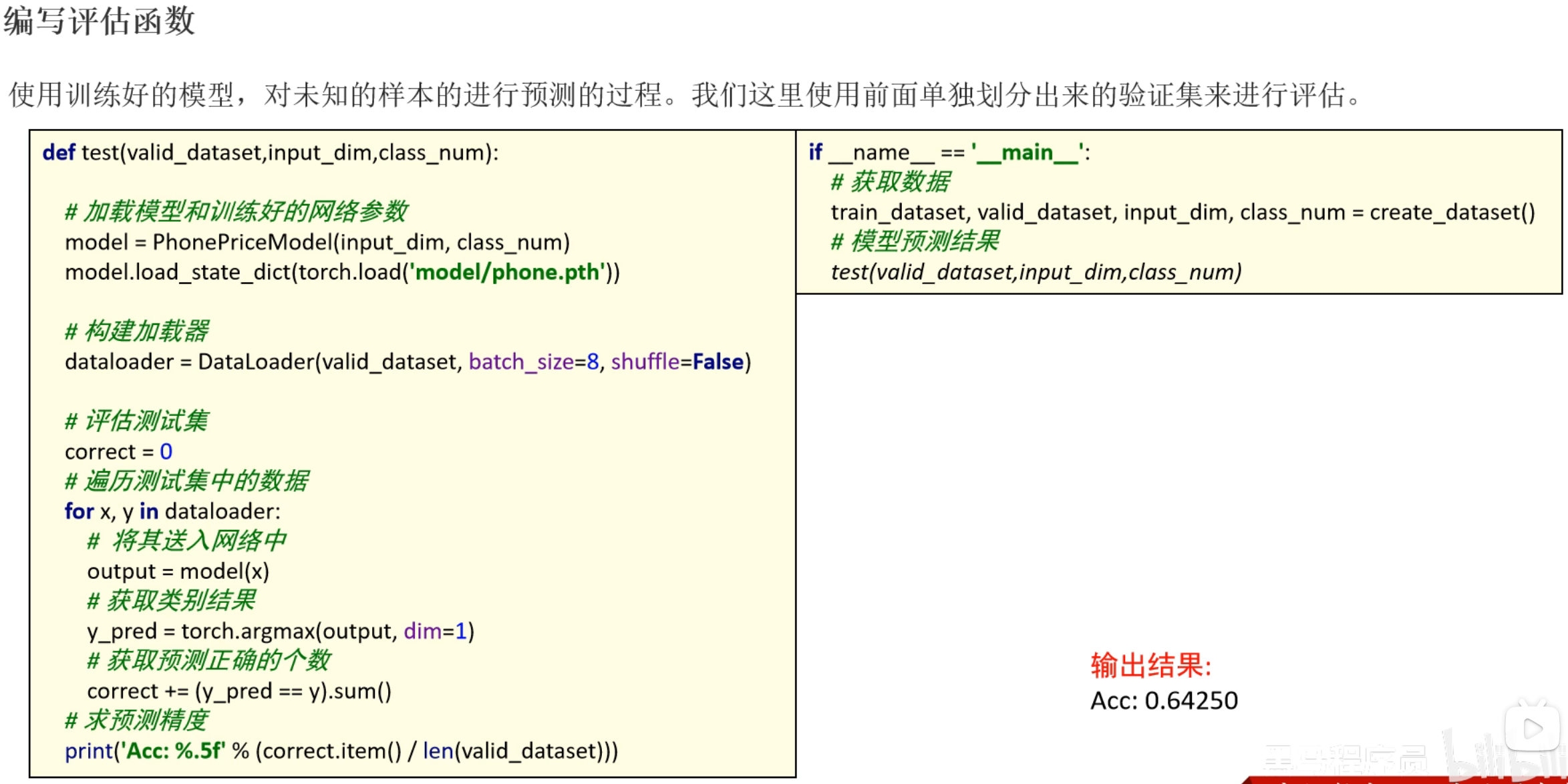

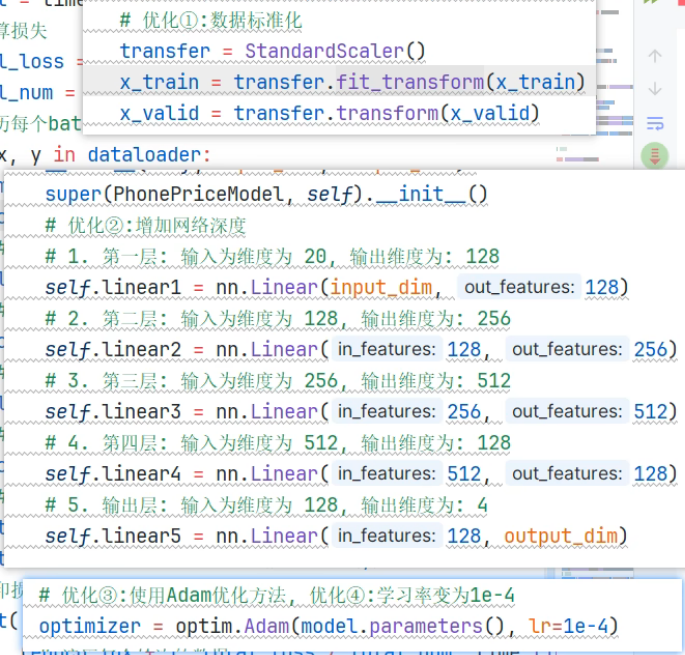

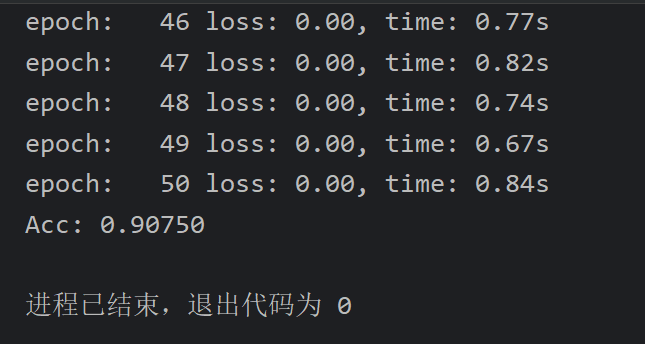

4、ANN案例_手机价格分类_模型调试

5、ANN案例_手机价格分类_调优思路

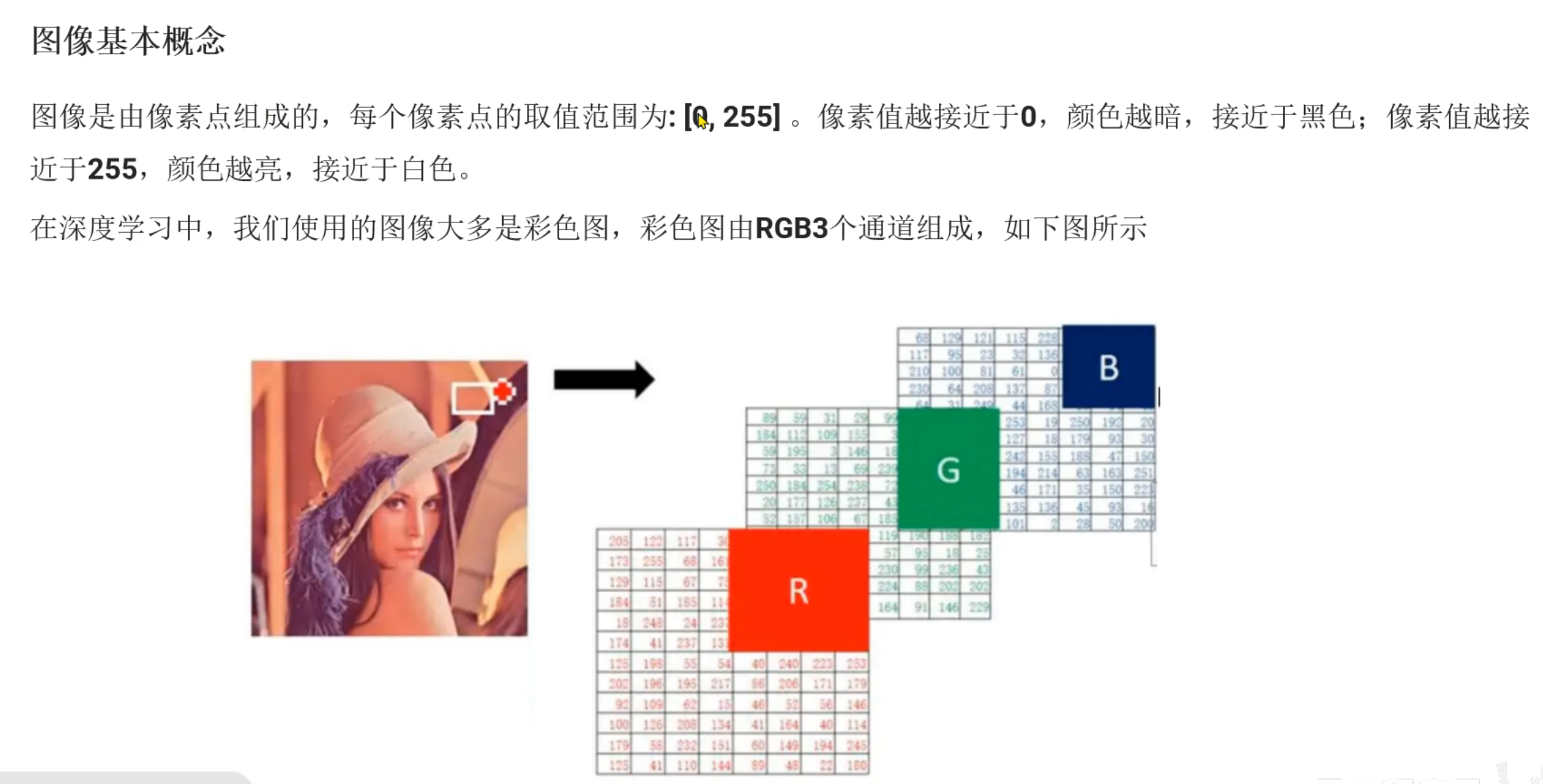

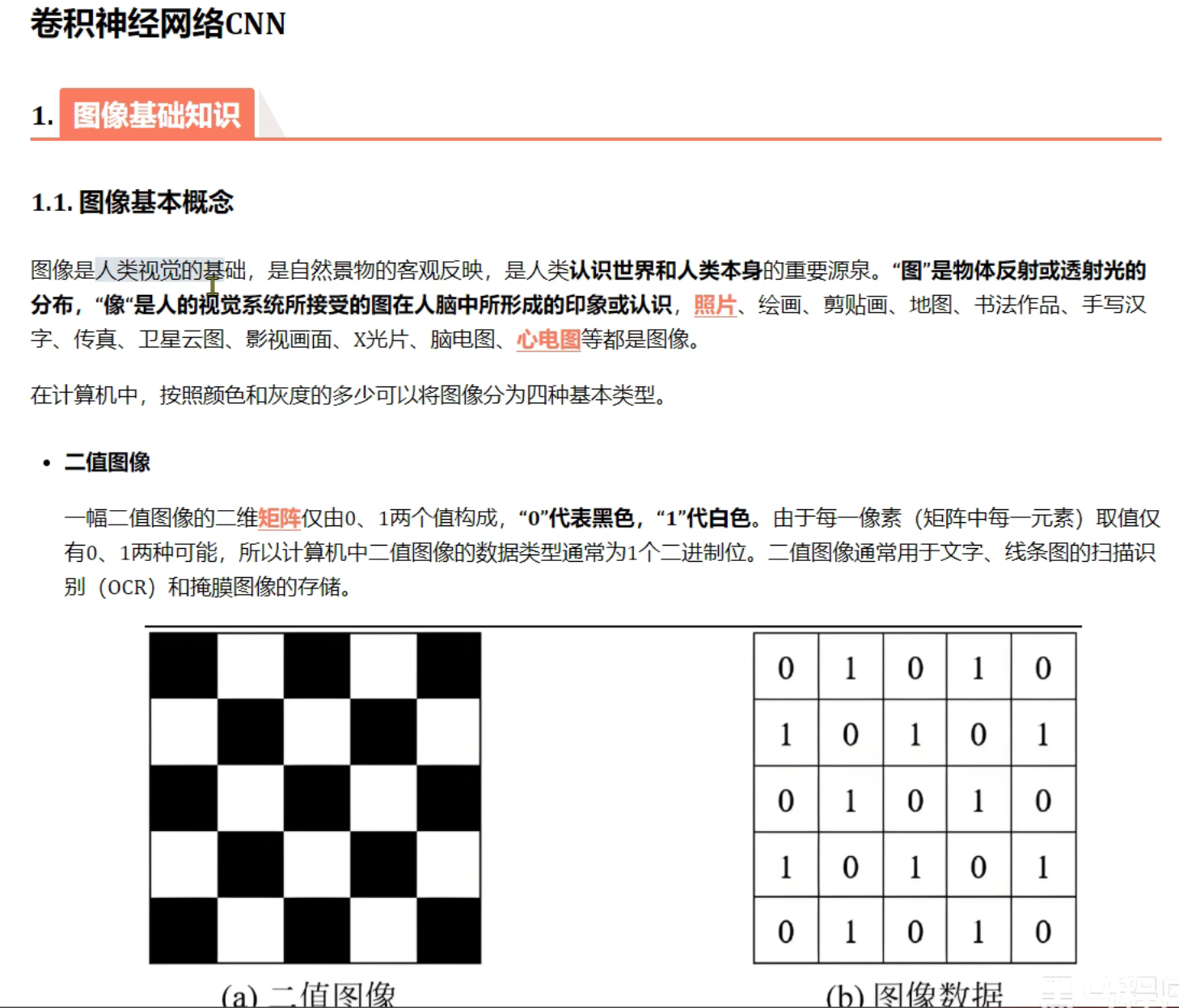

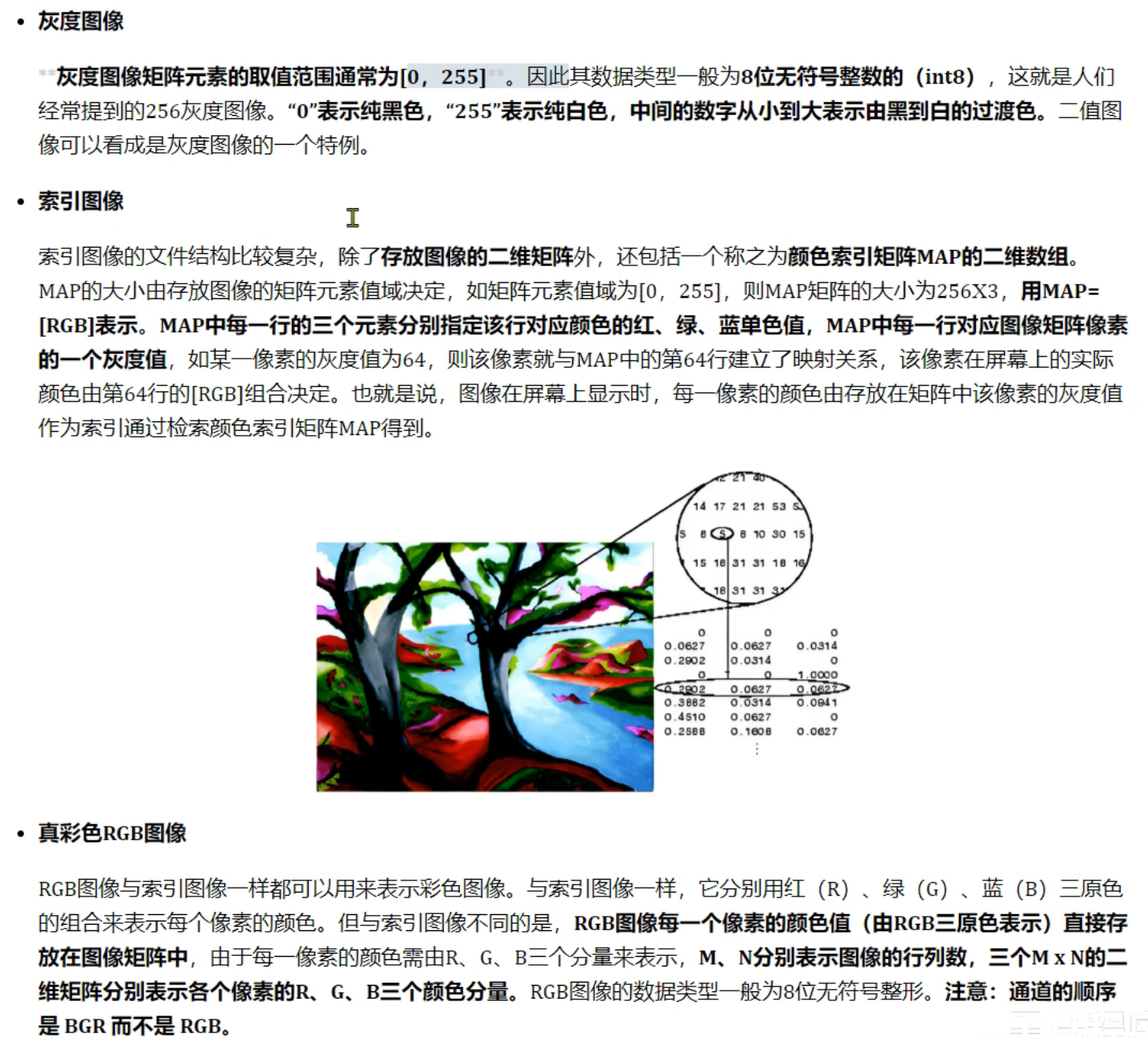

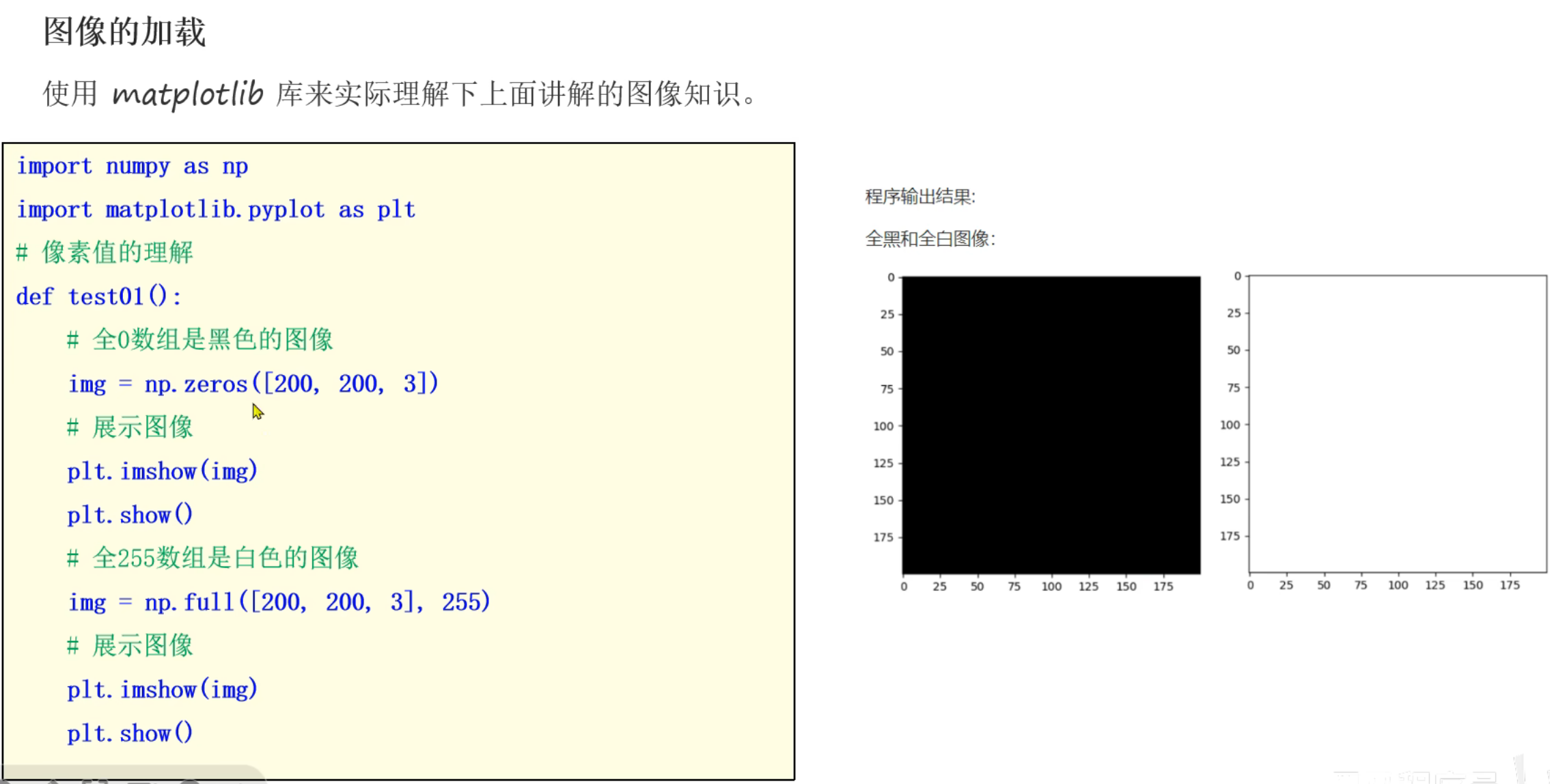

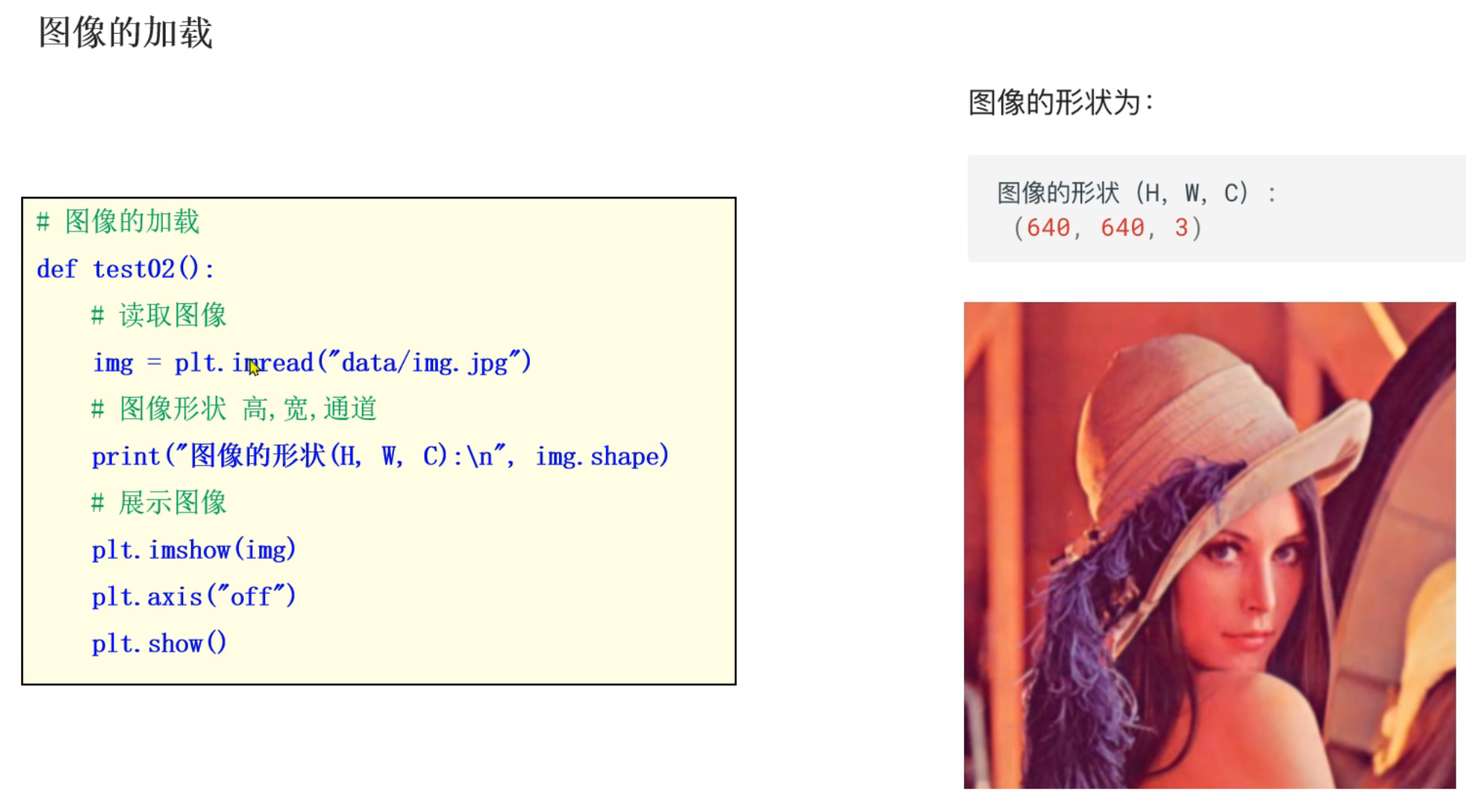

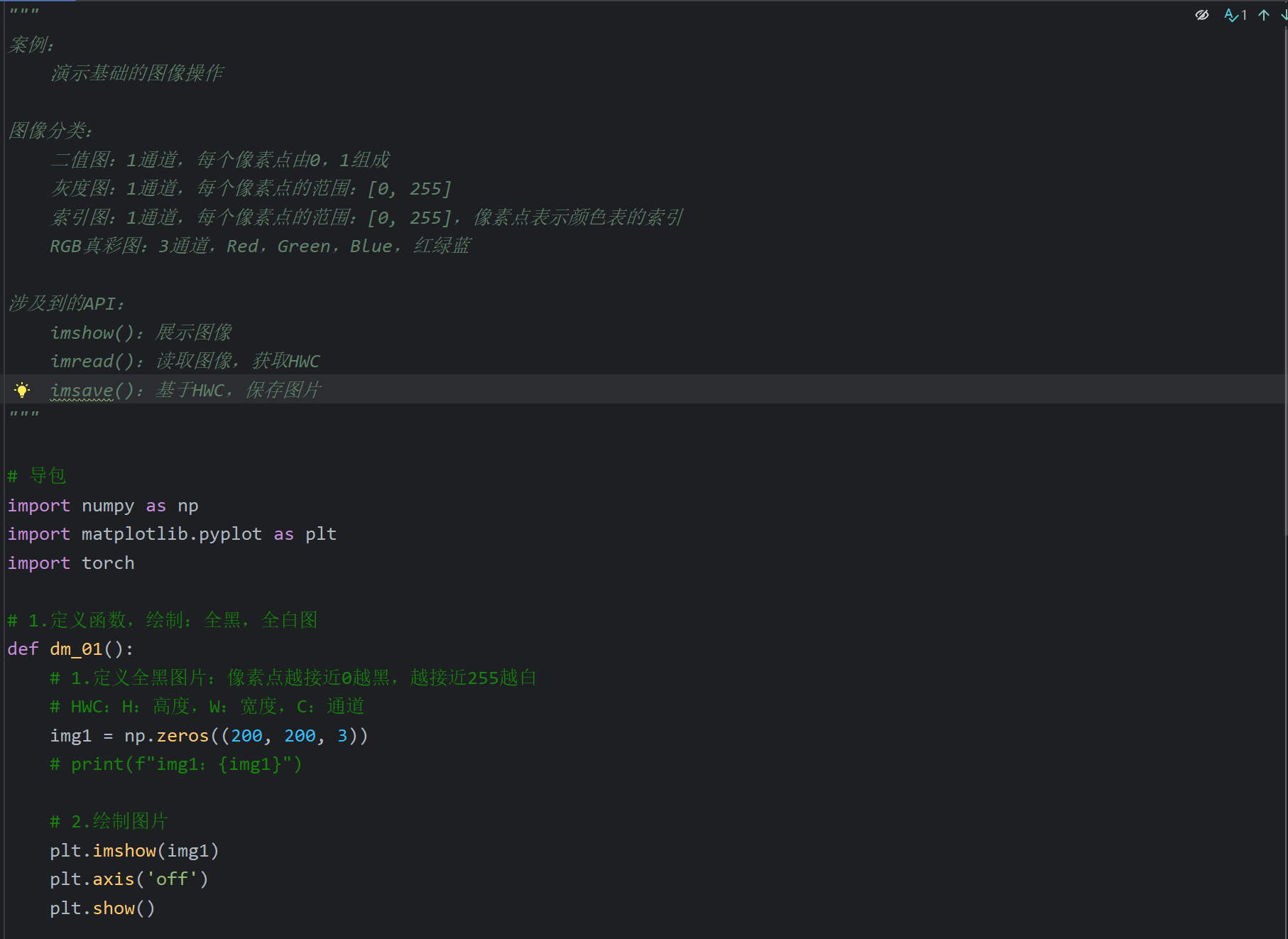

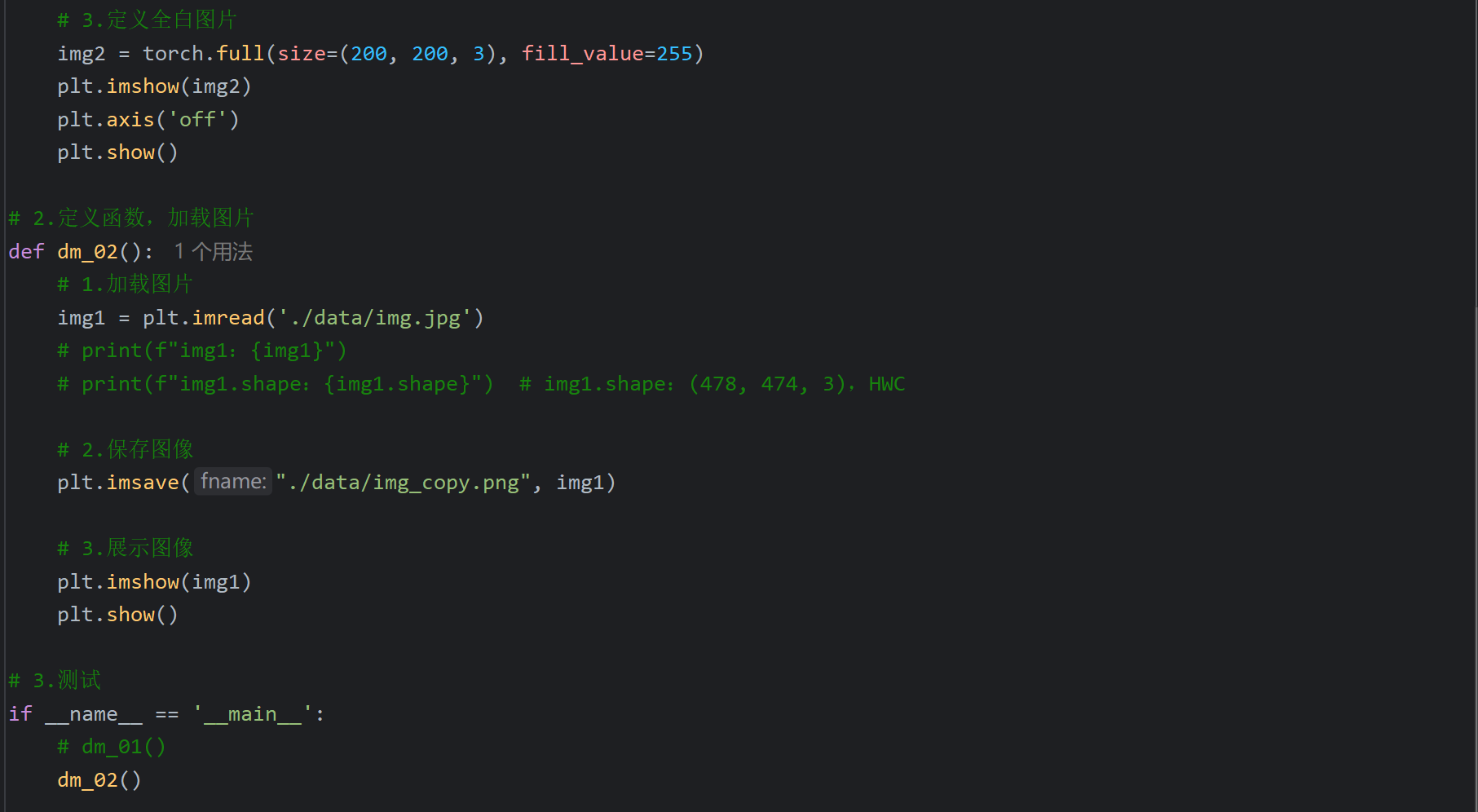

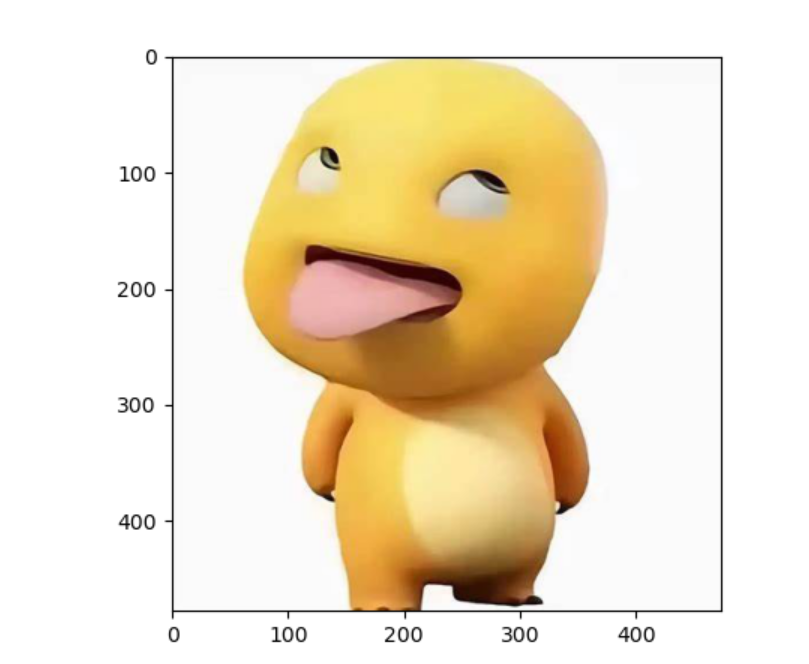

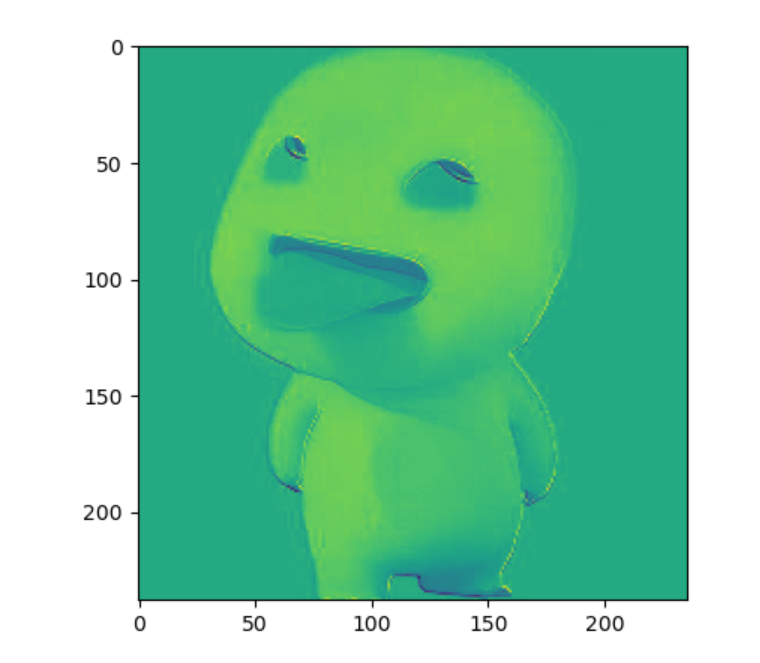

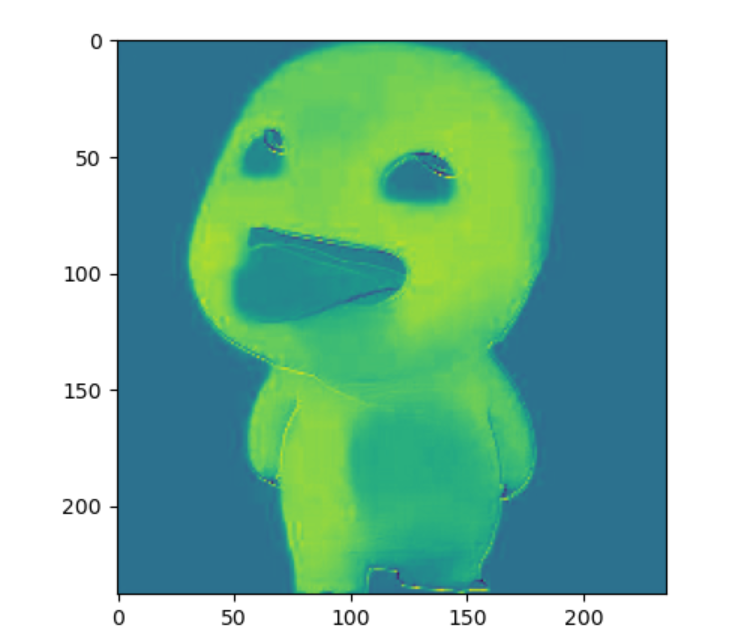

6、图像相关知识介绍

我现在去掉坐标轴也是可以画出全白的图片的

7、上午内容回顾

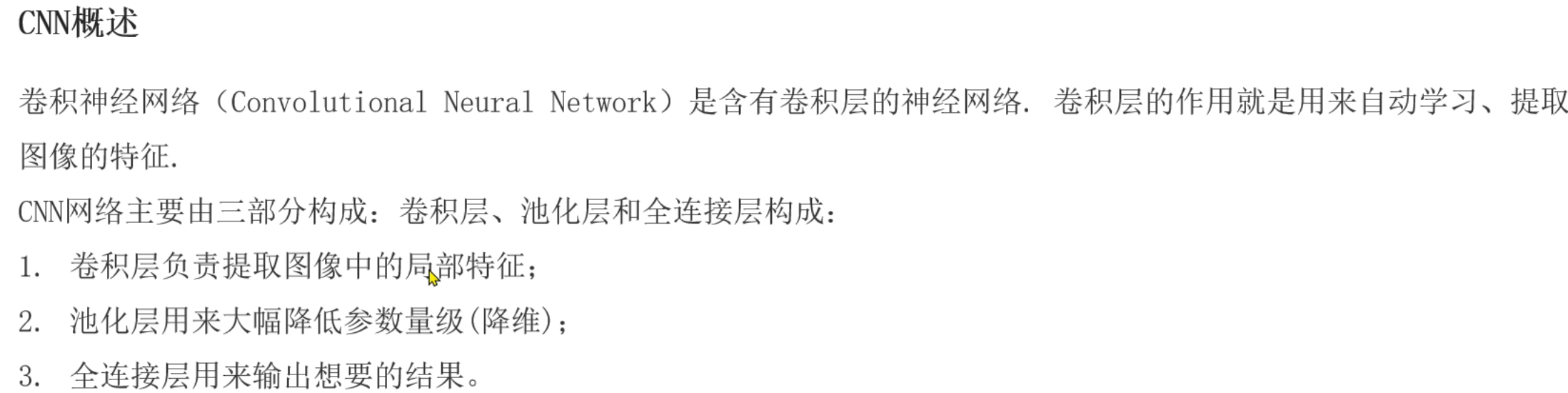

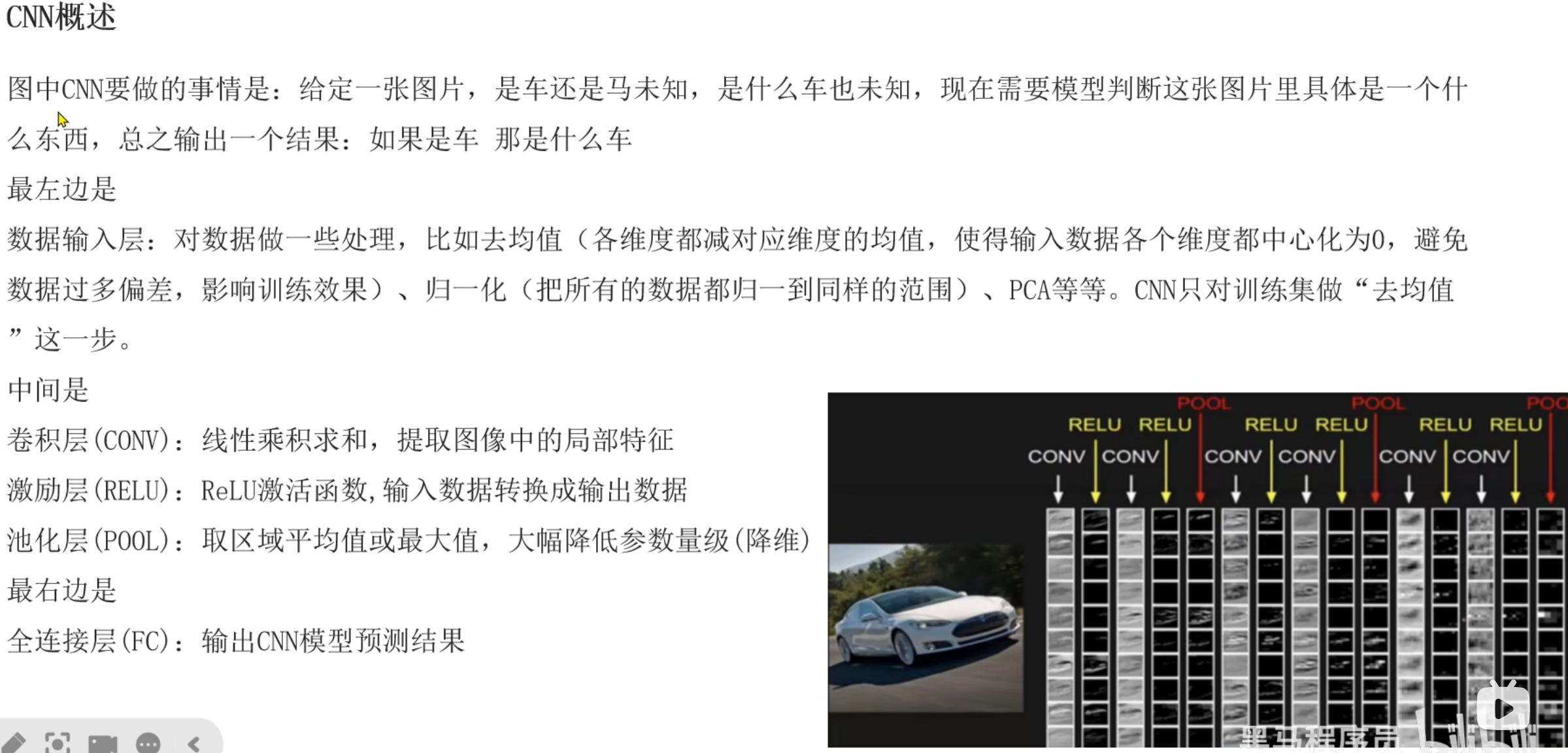

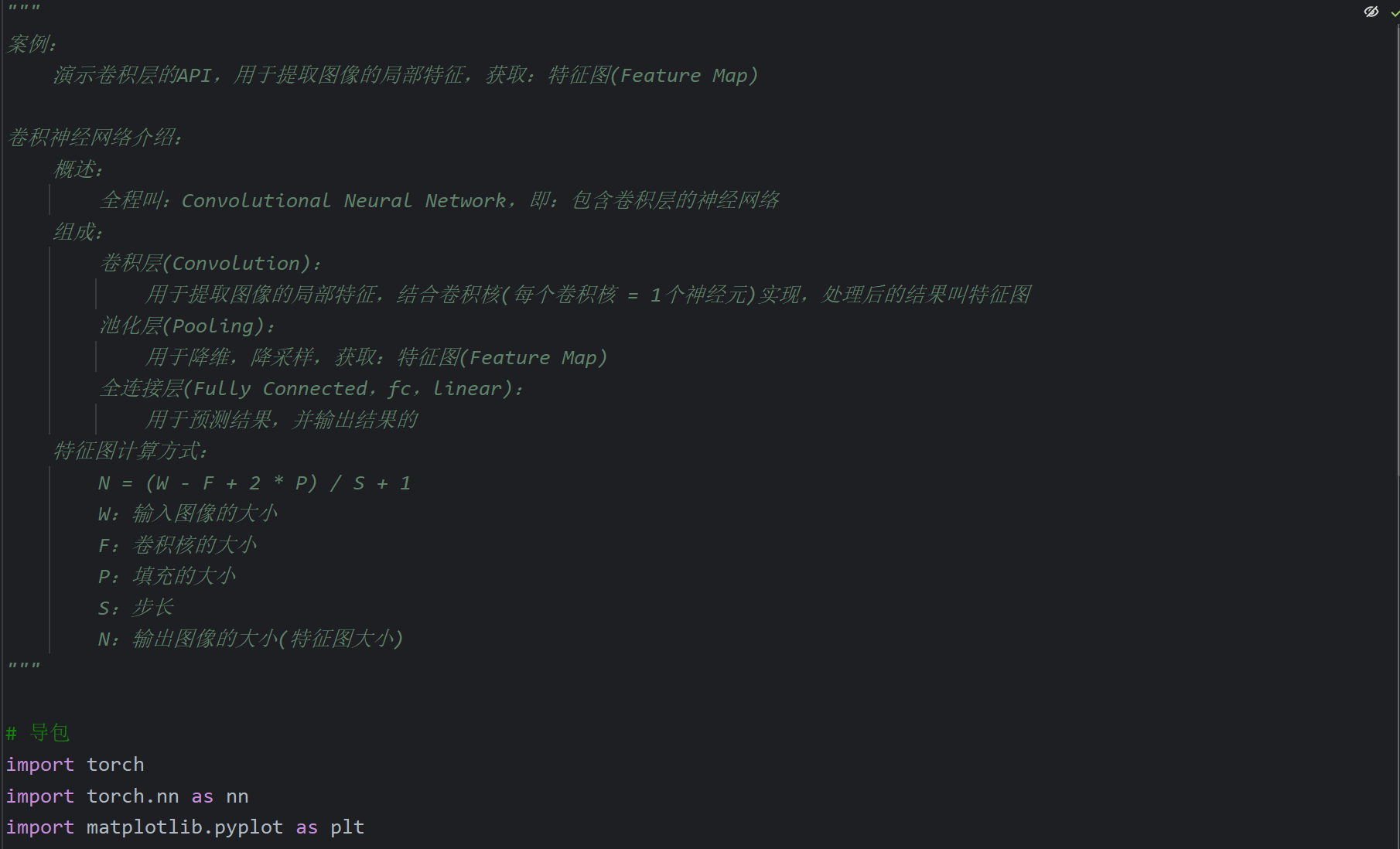

8、CNN概述介绍

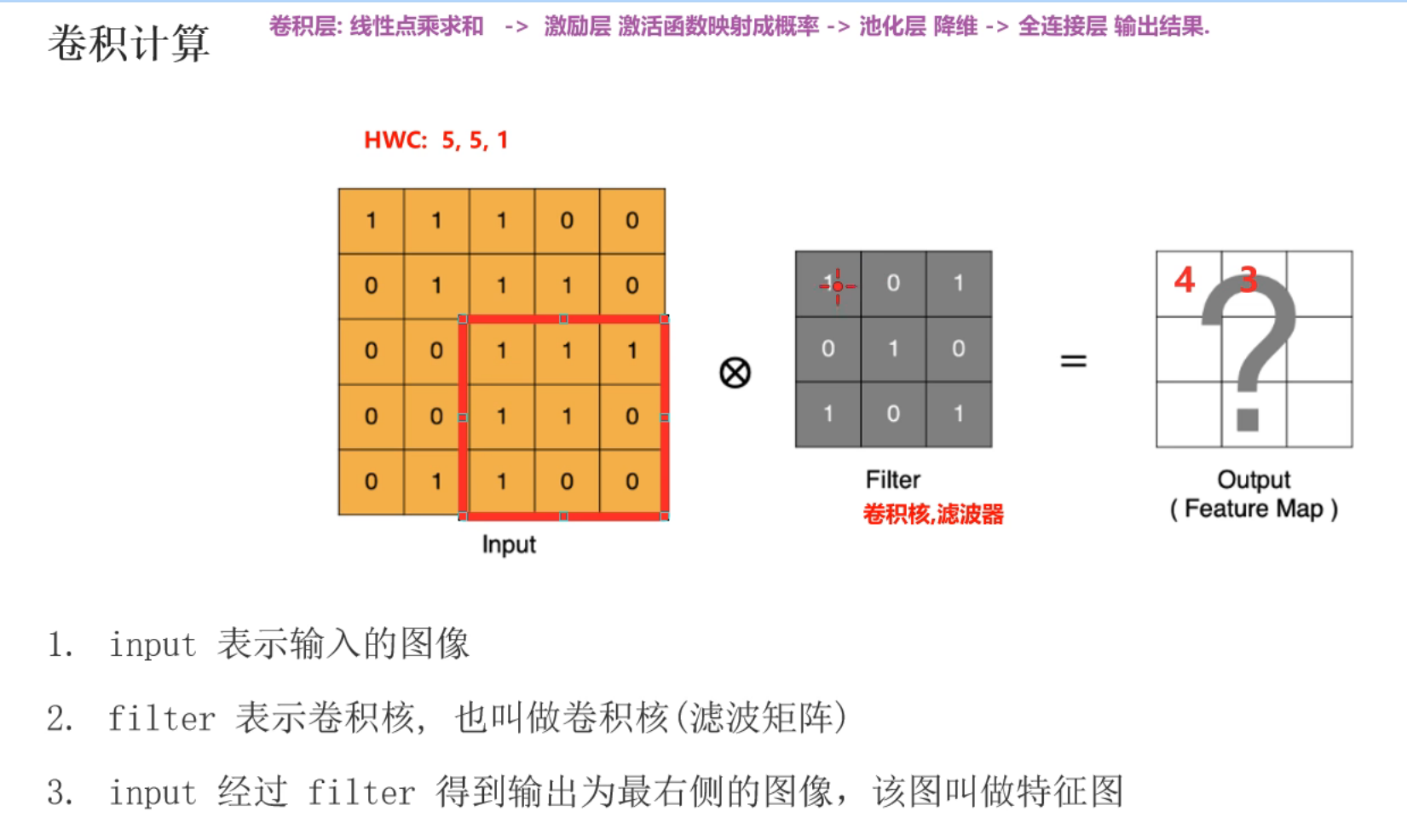

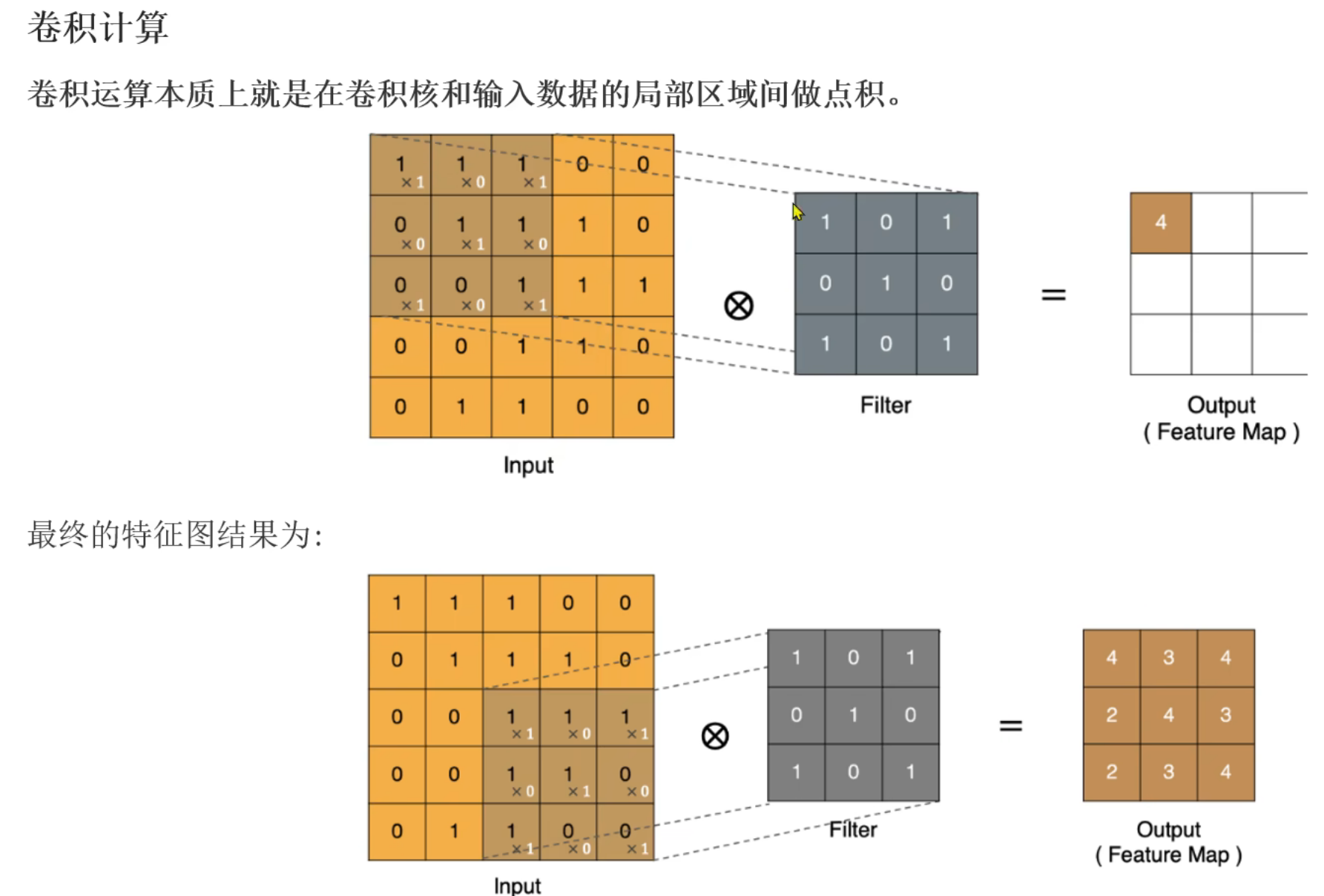

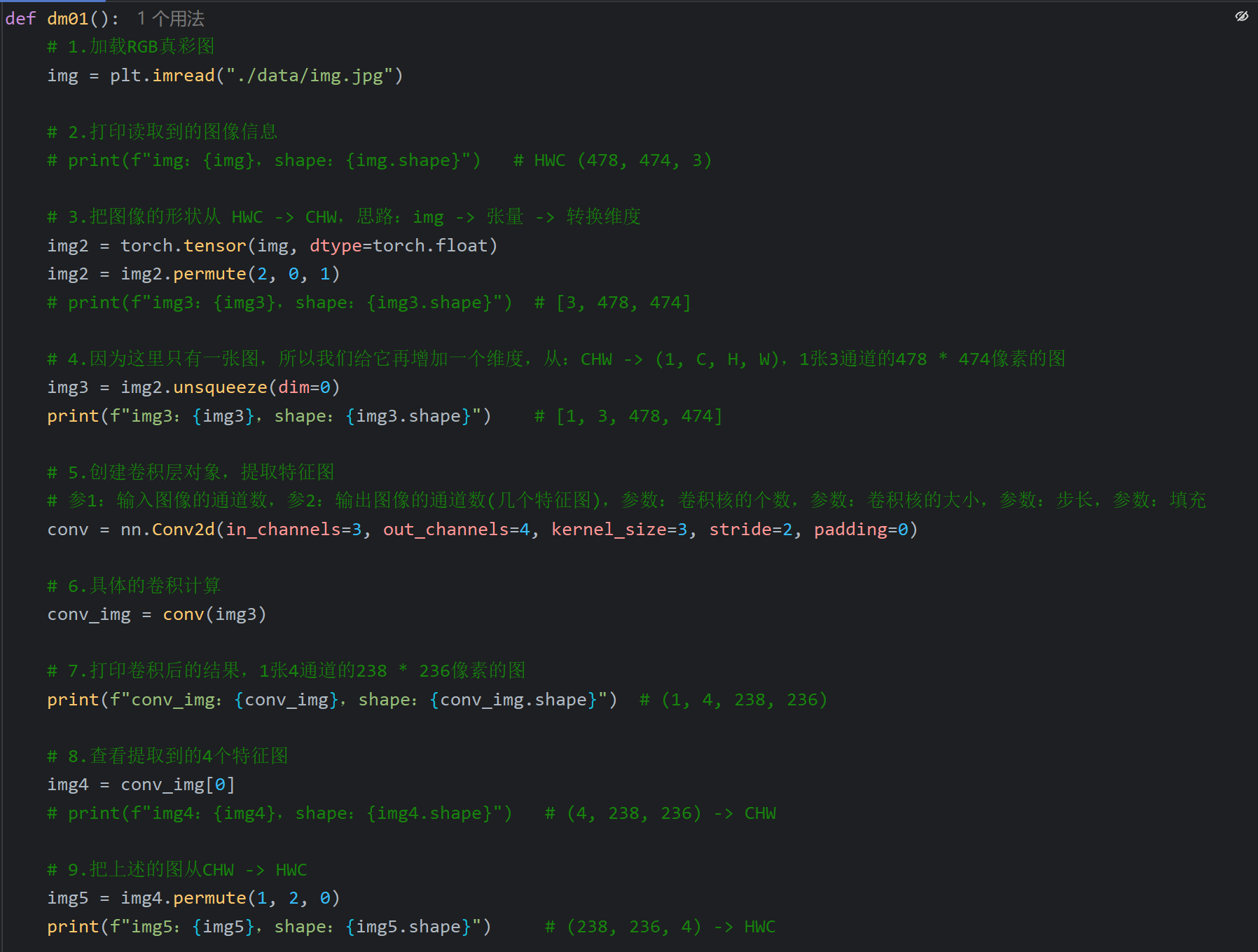

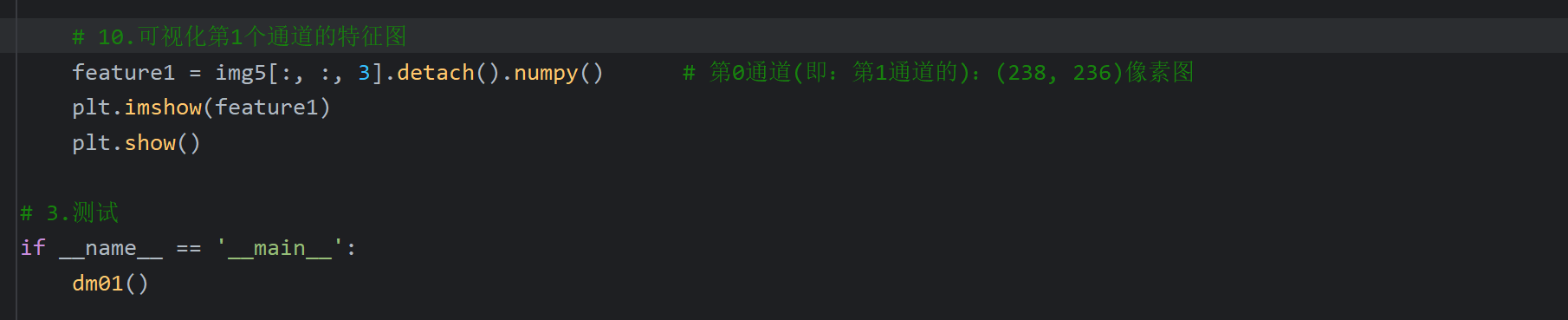

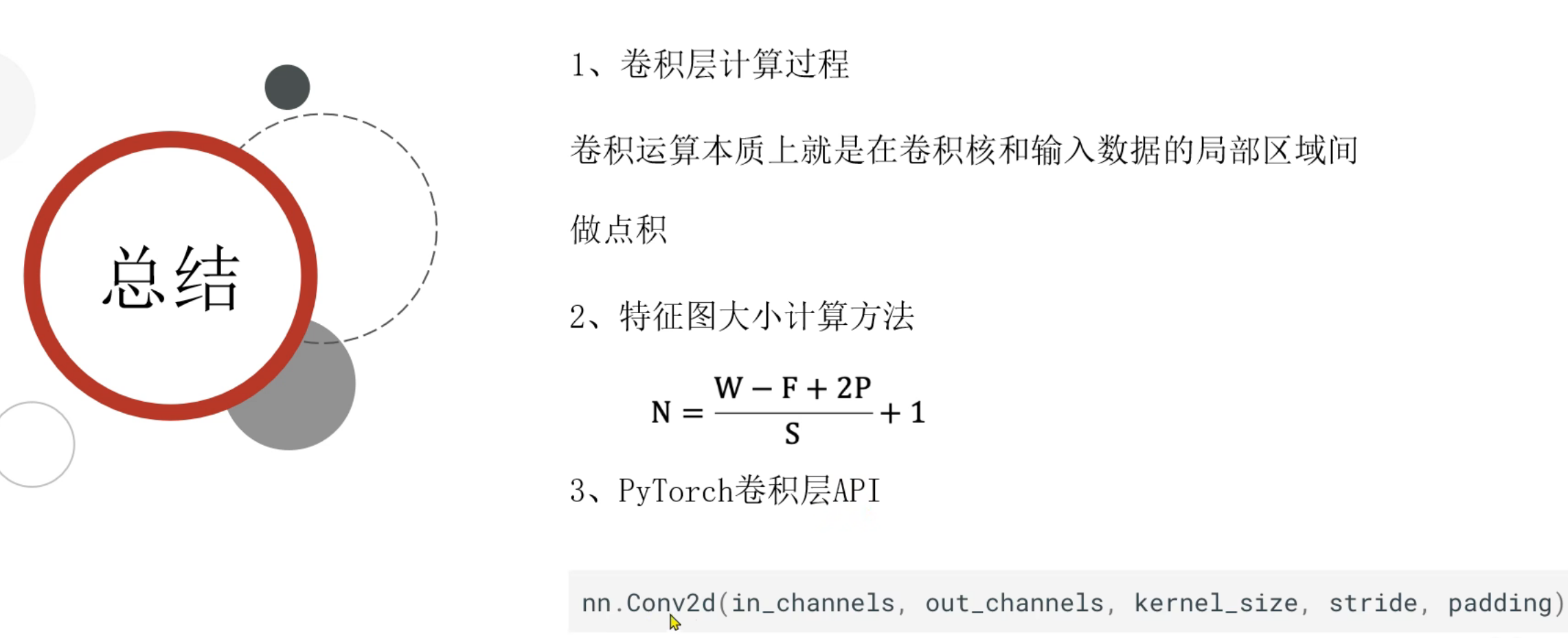

9、卷积层_计算规则介绍

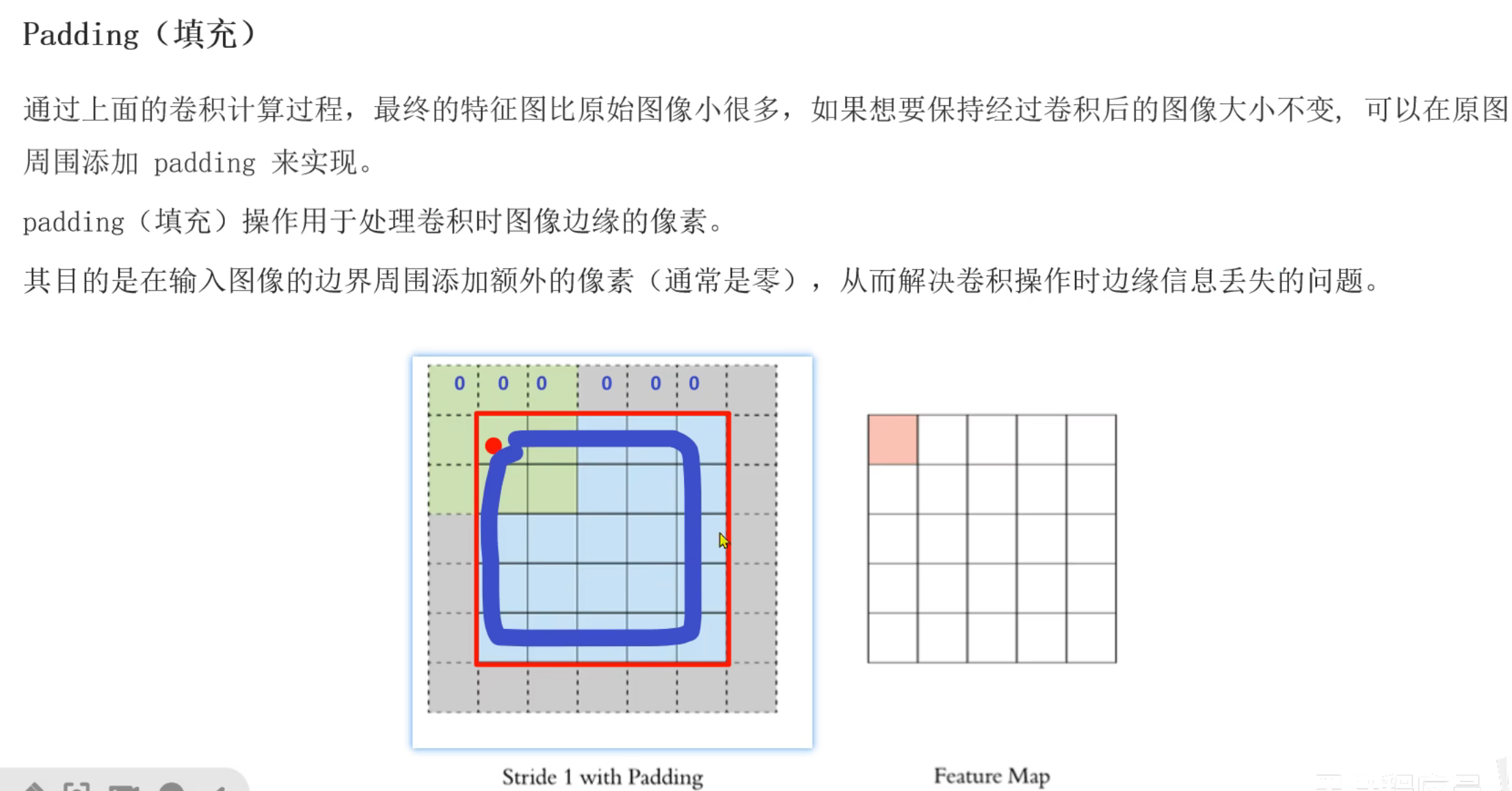

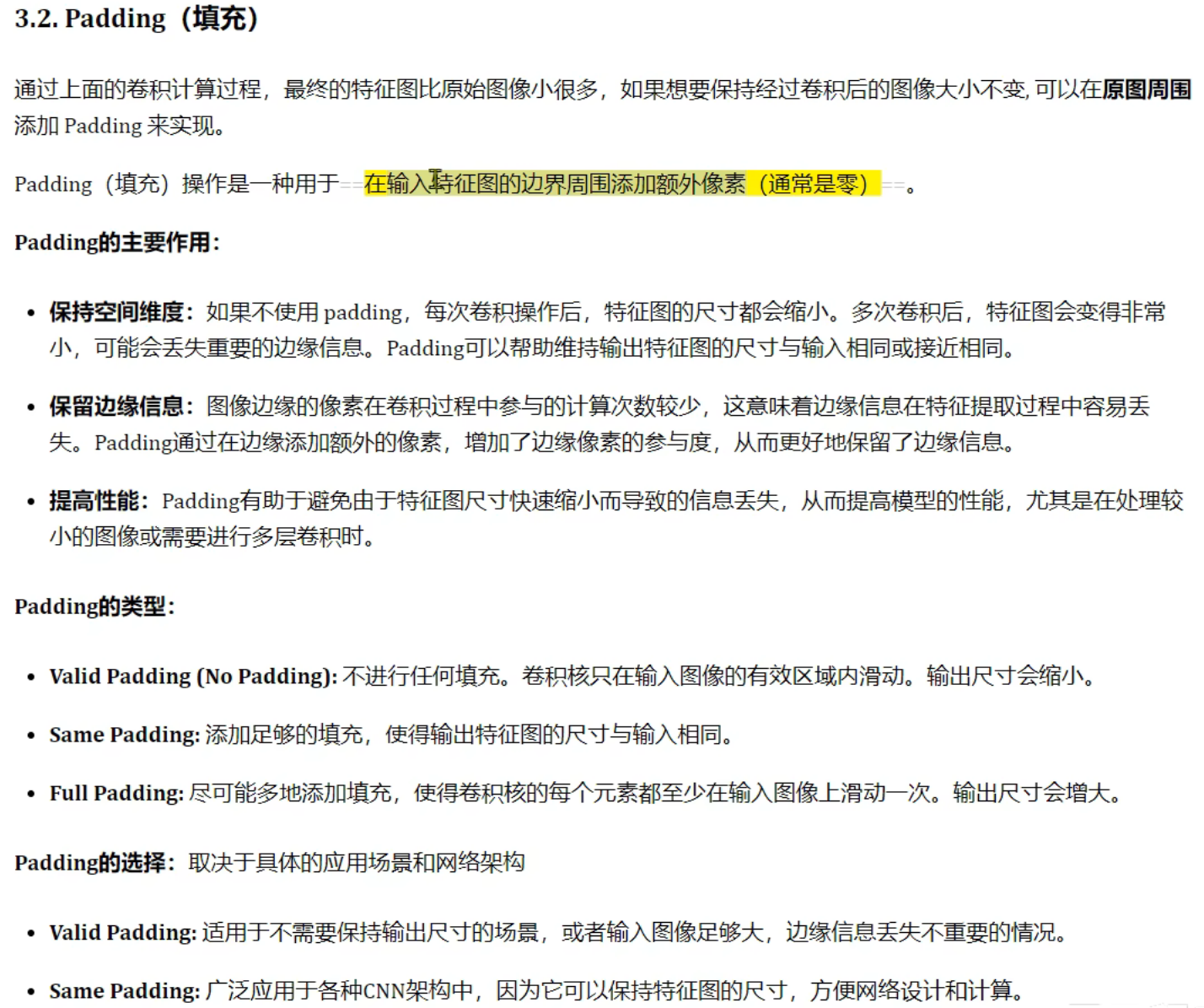

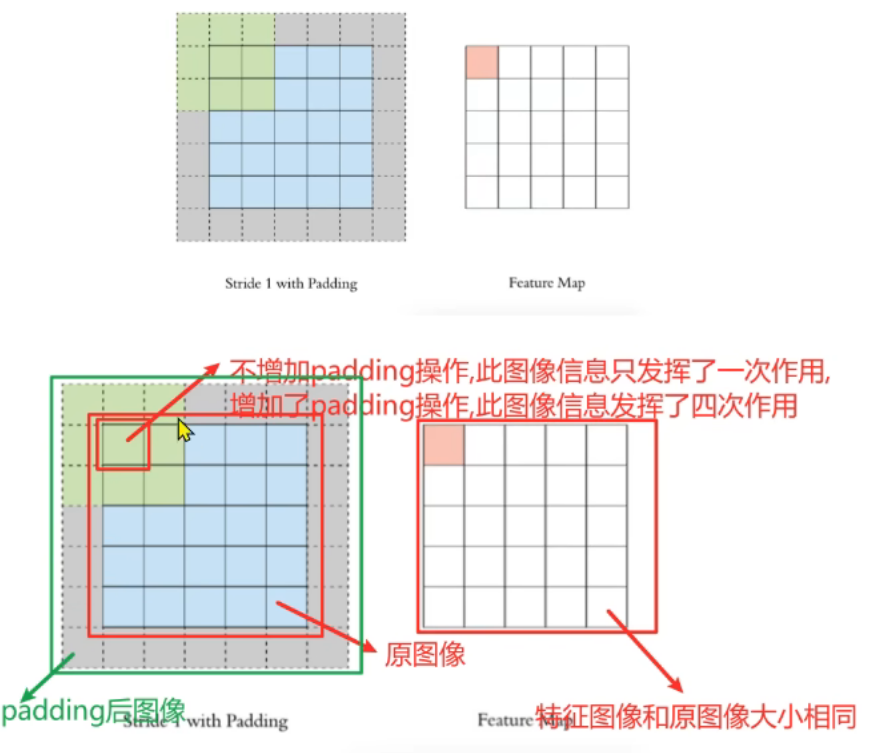

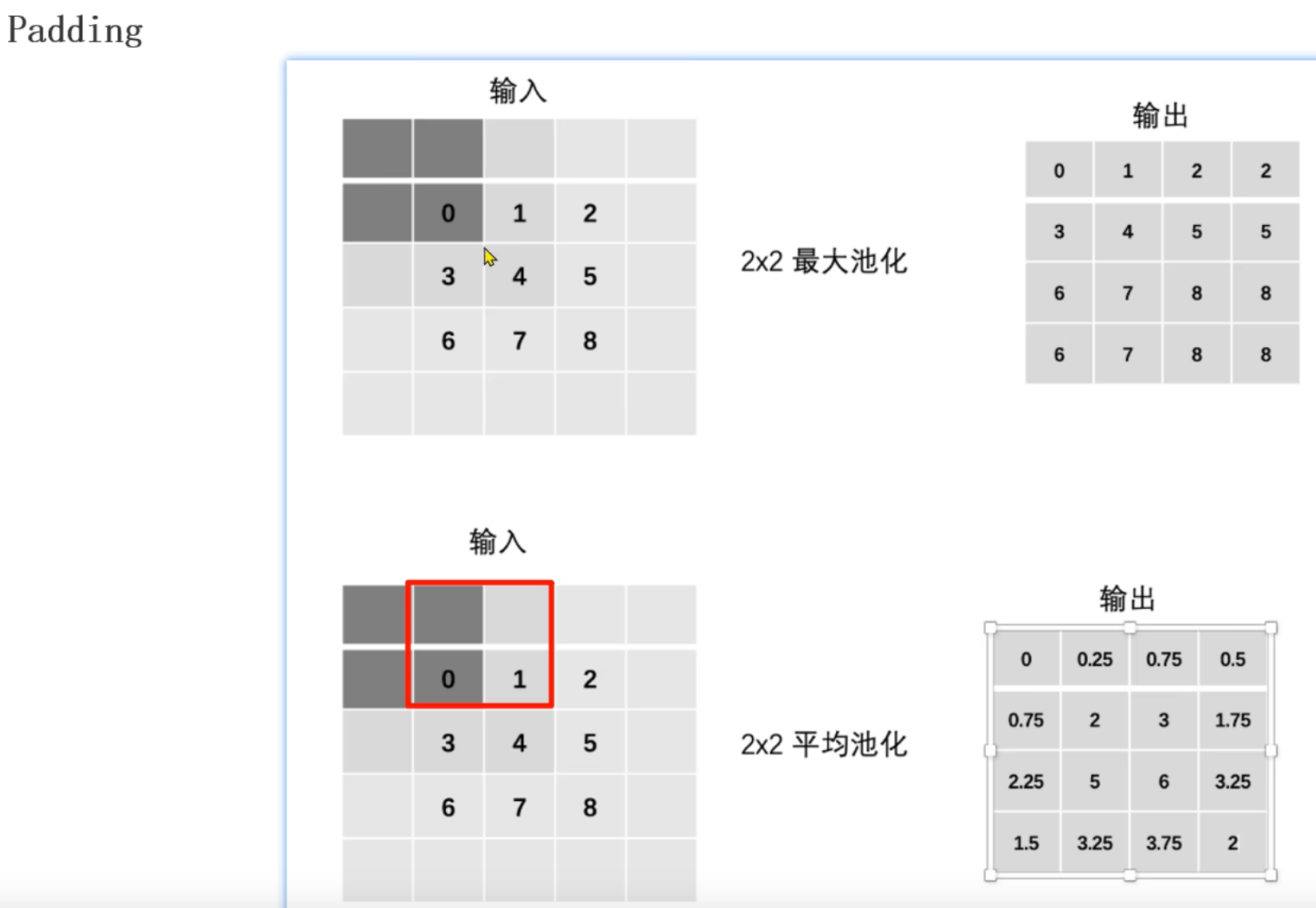

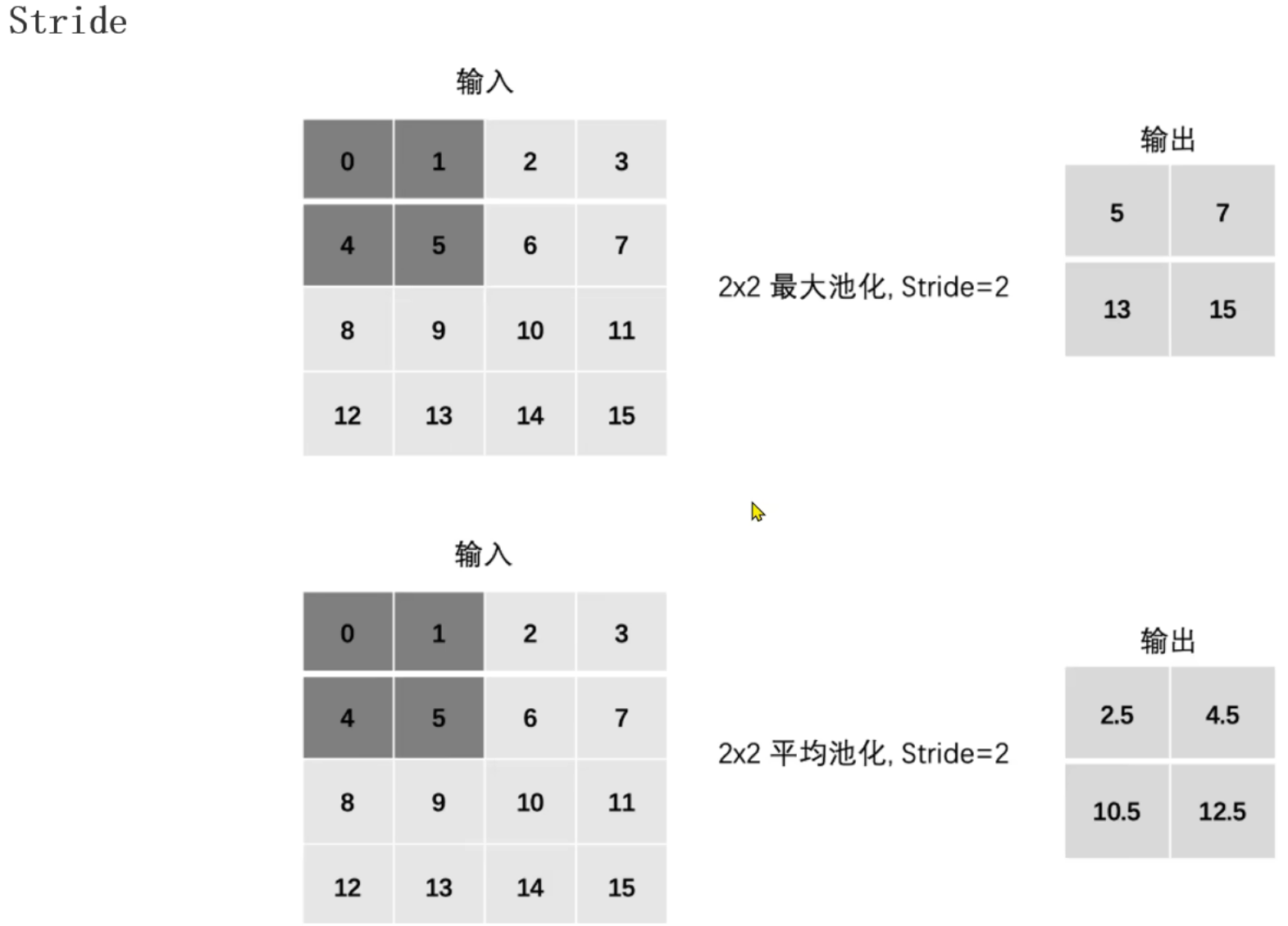

10、卷积层_填充(Padding)介绍

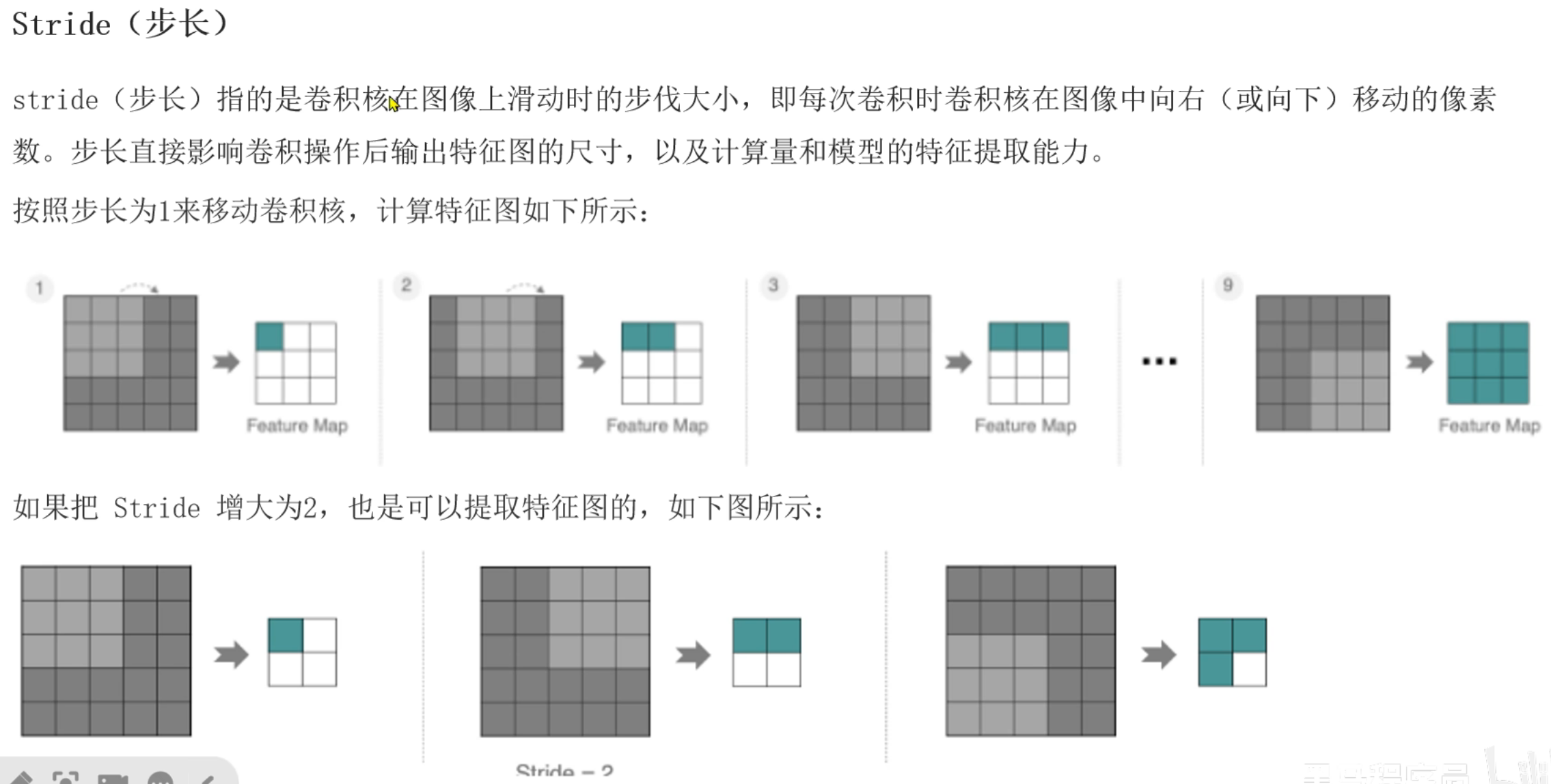

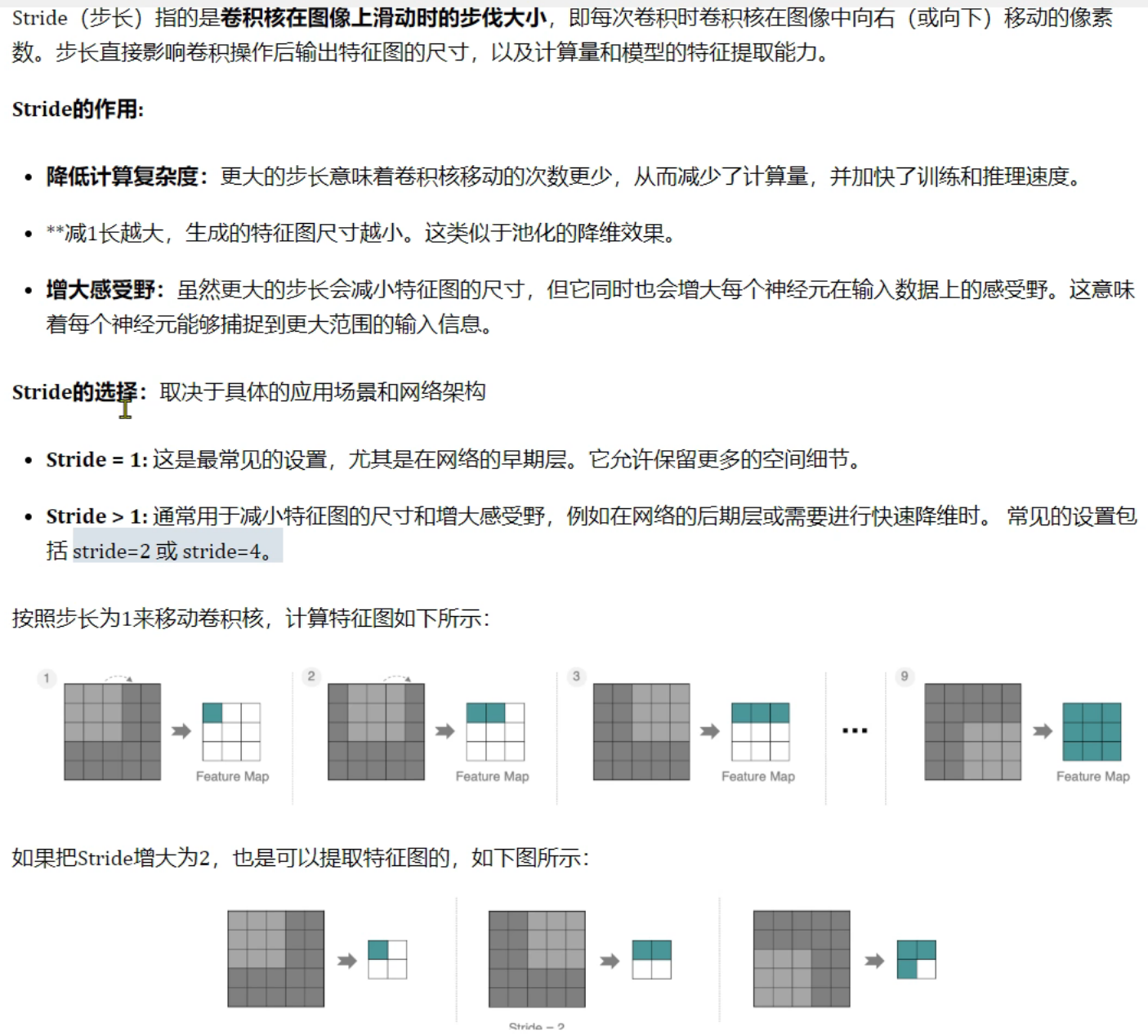

11、卷积层_步长(Stride)介绍

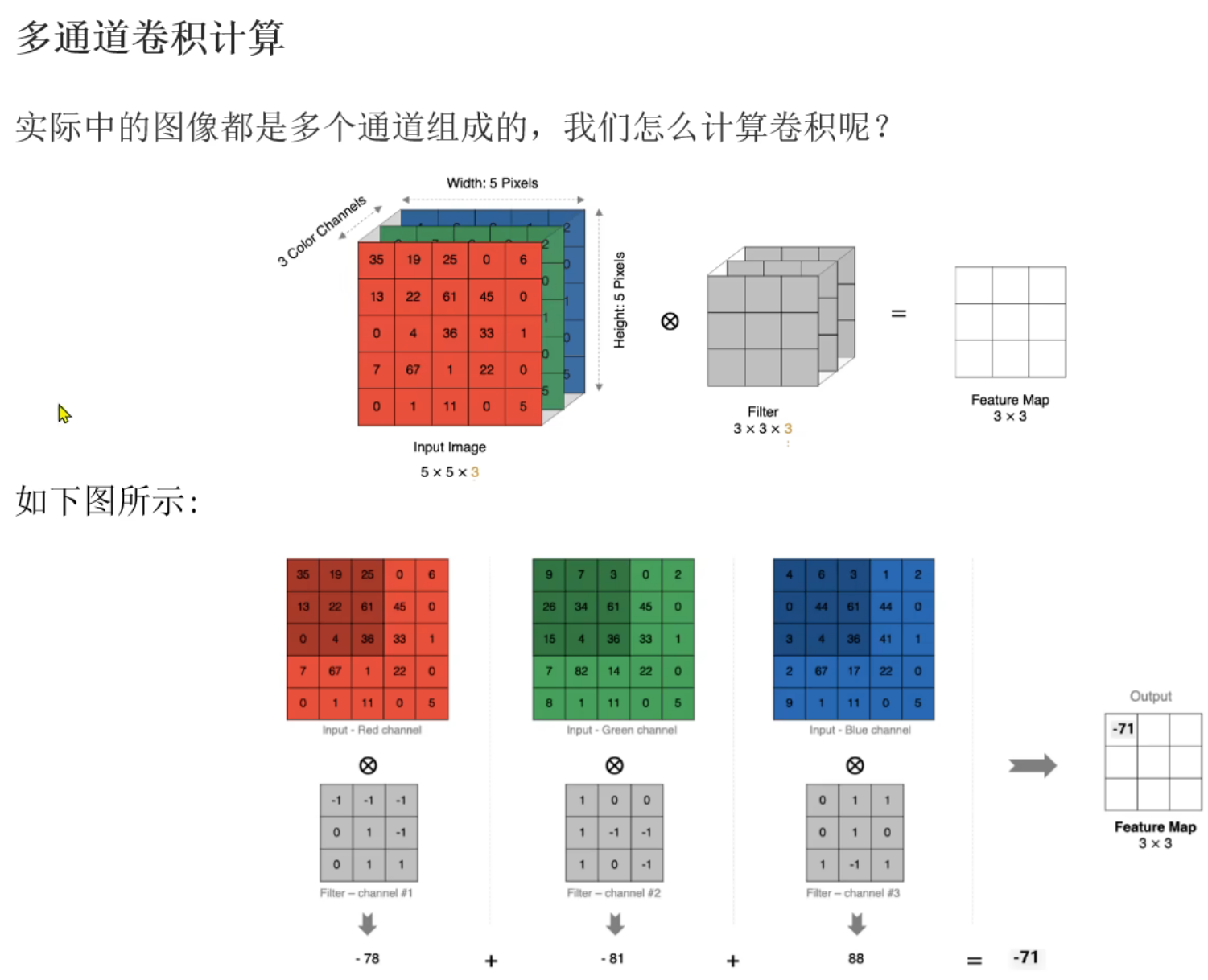

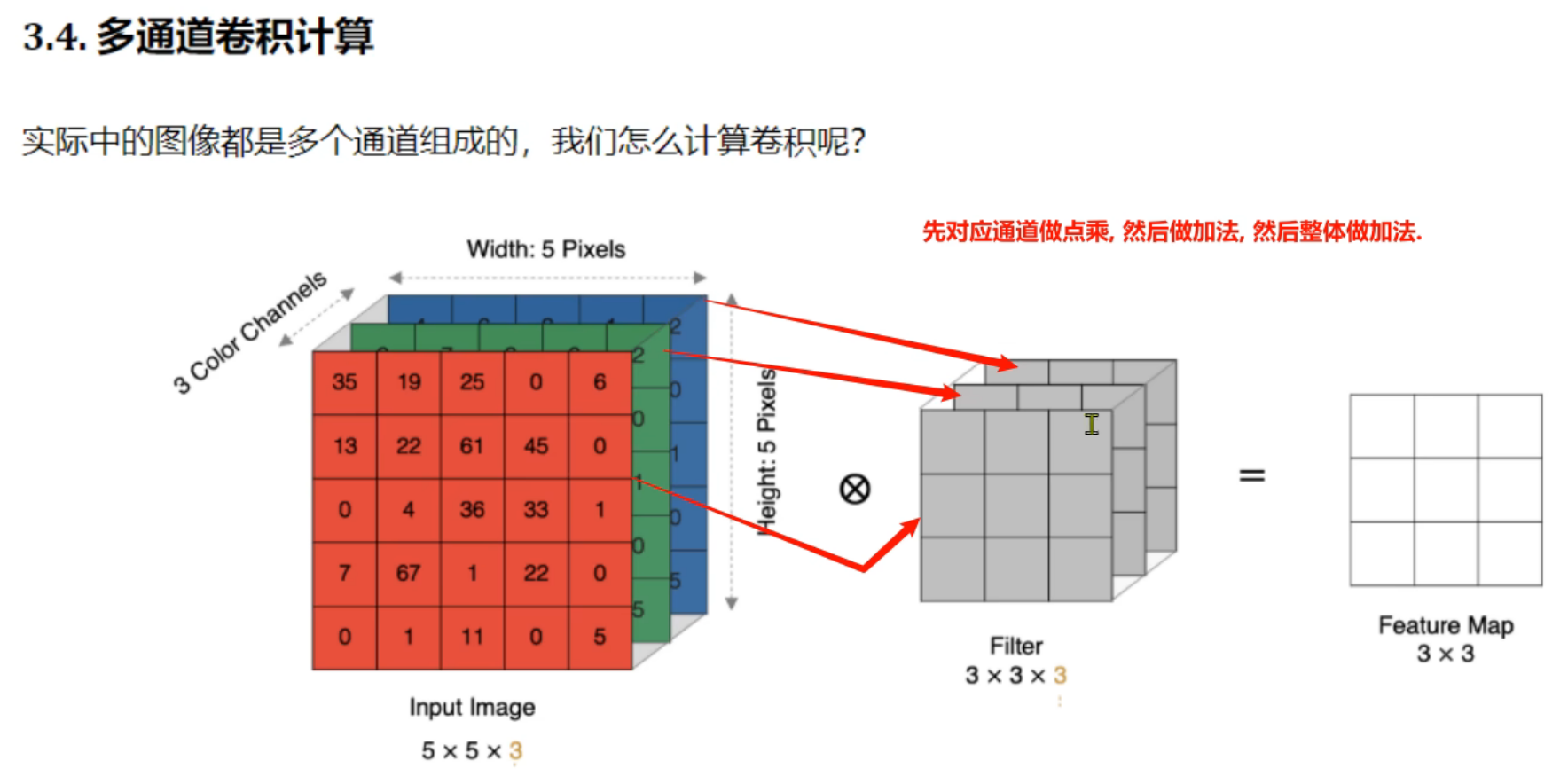

12、卷积层_多通道卷积计算

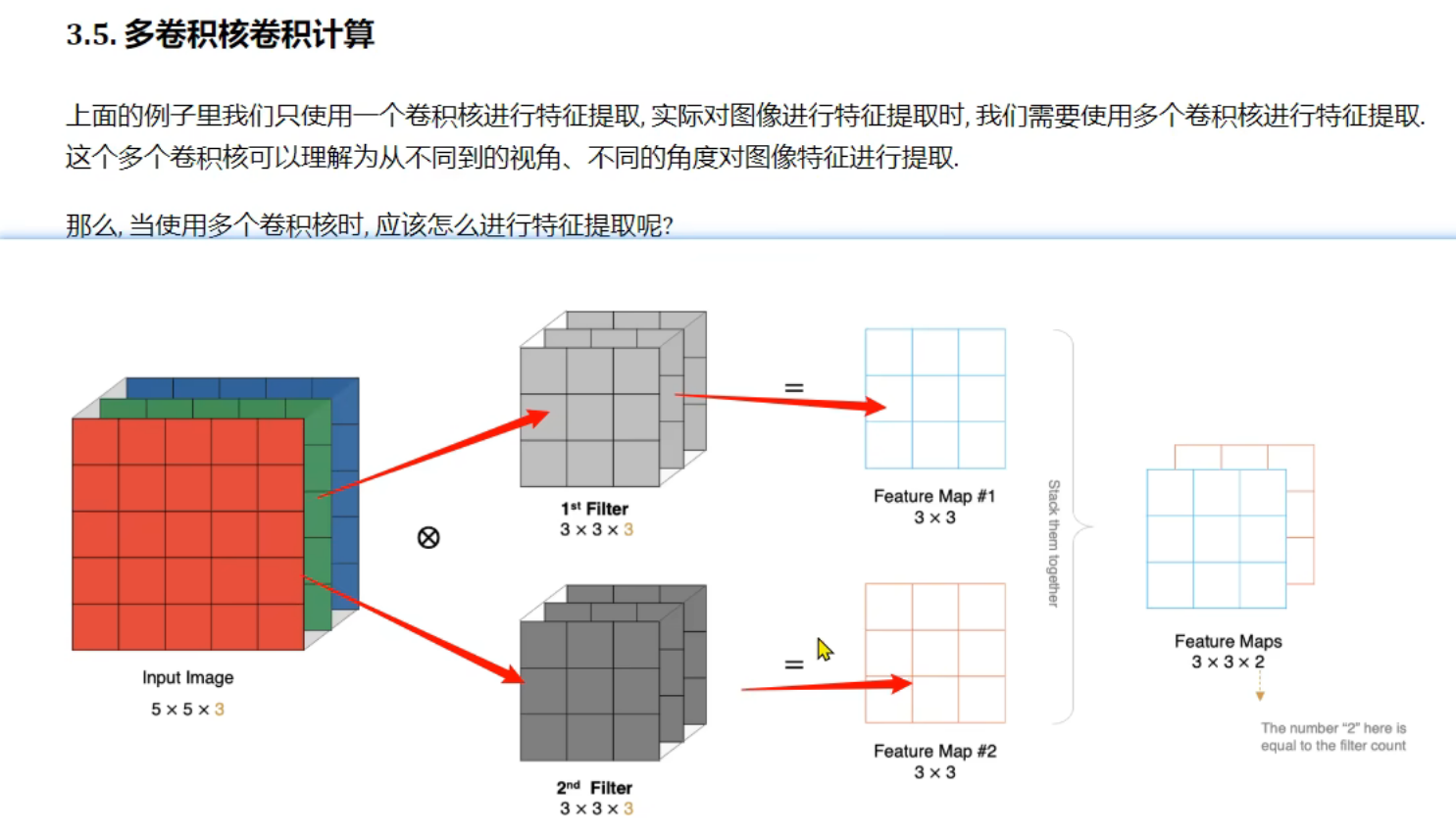

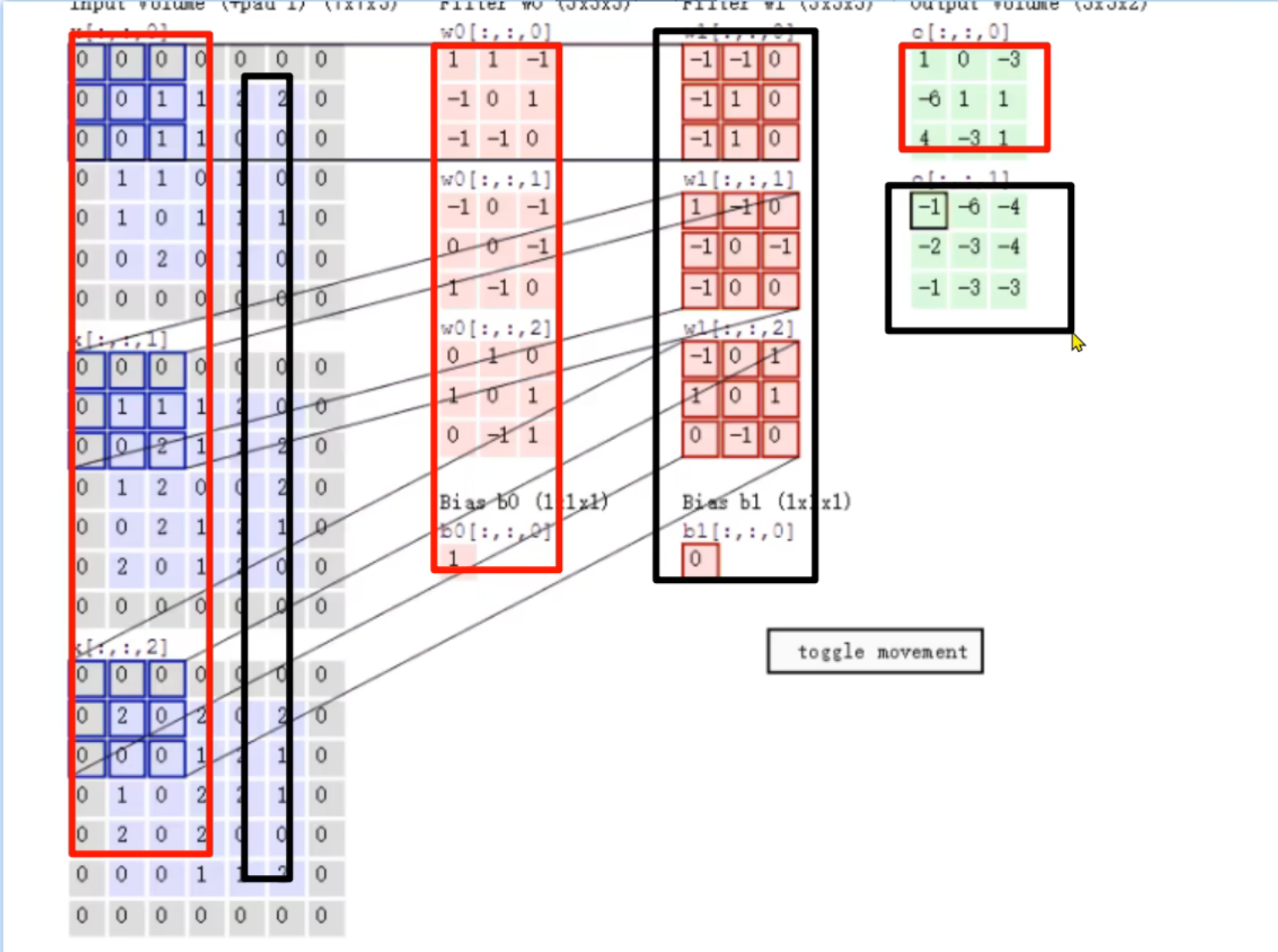

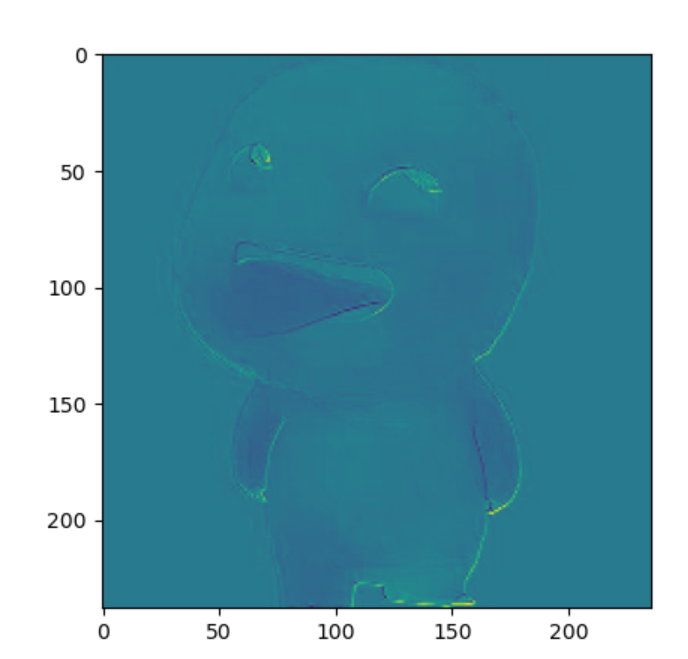

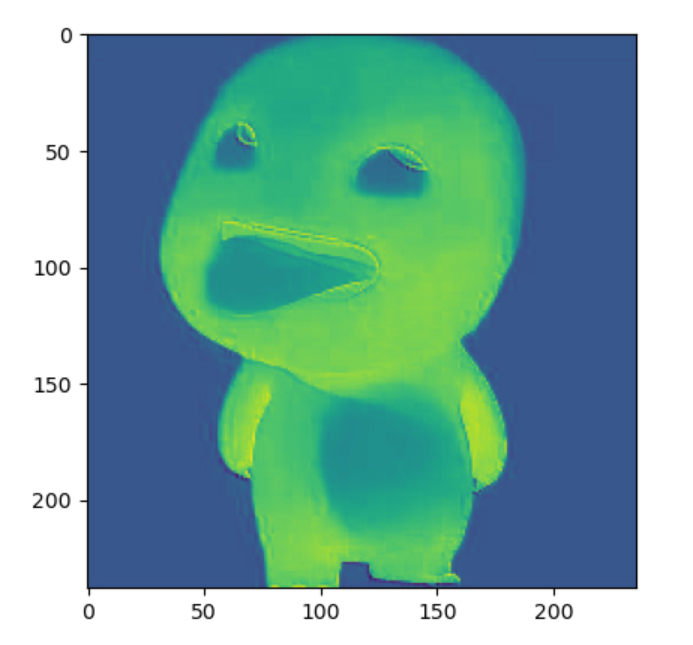

13、卷积层_多卷积核卷积计算

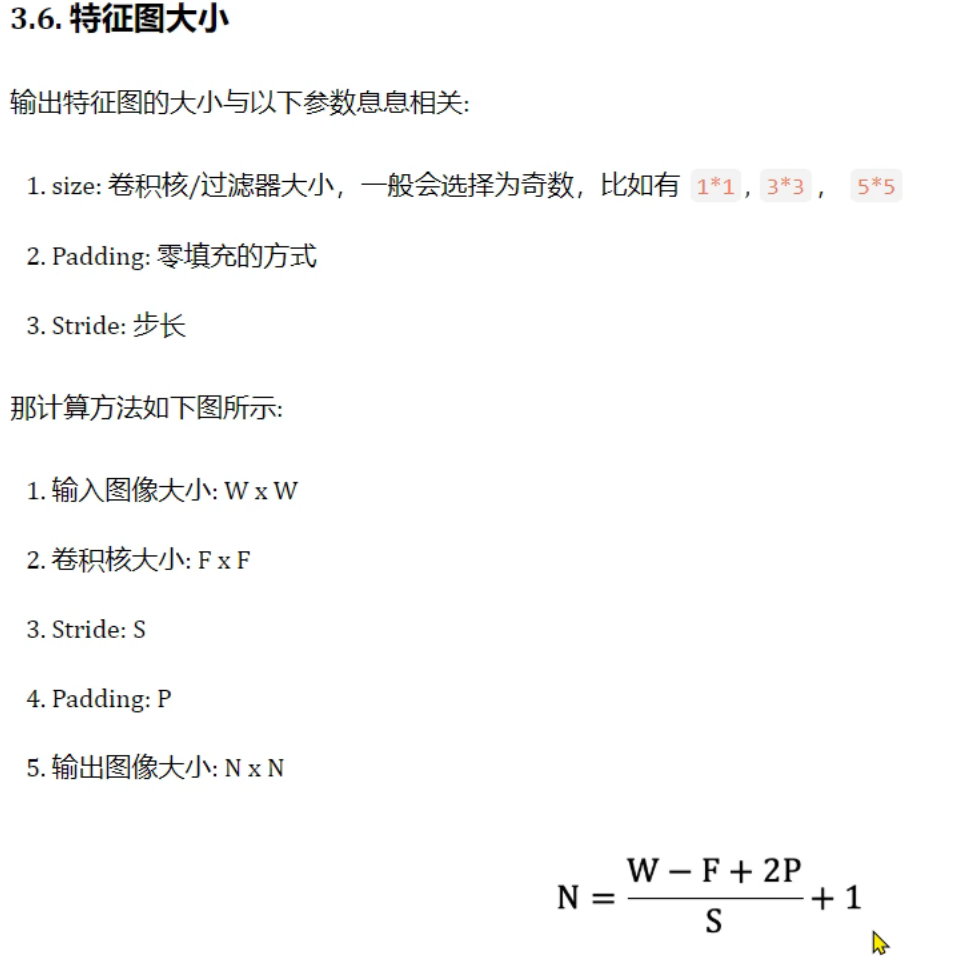

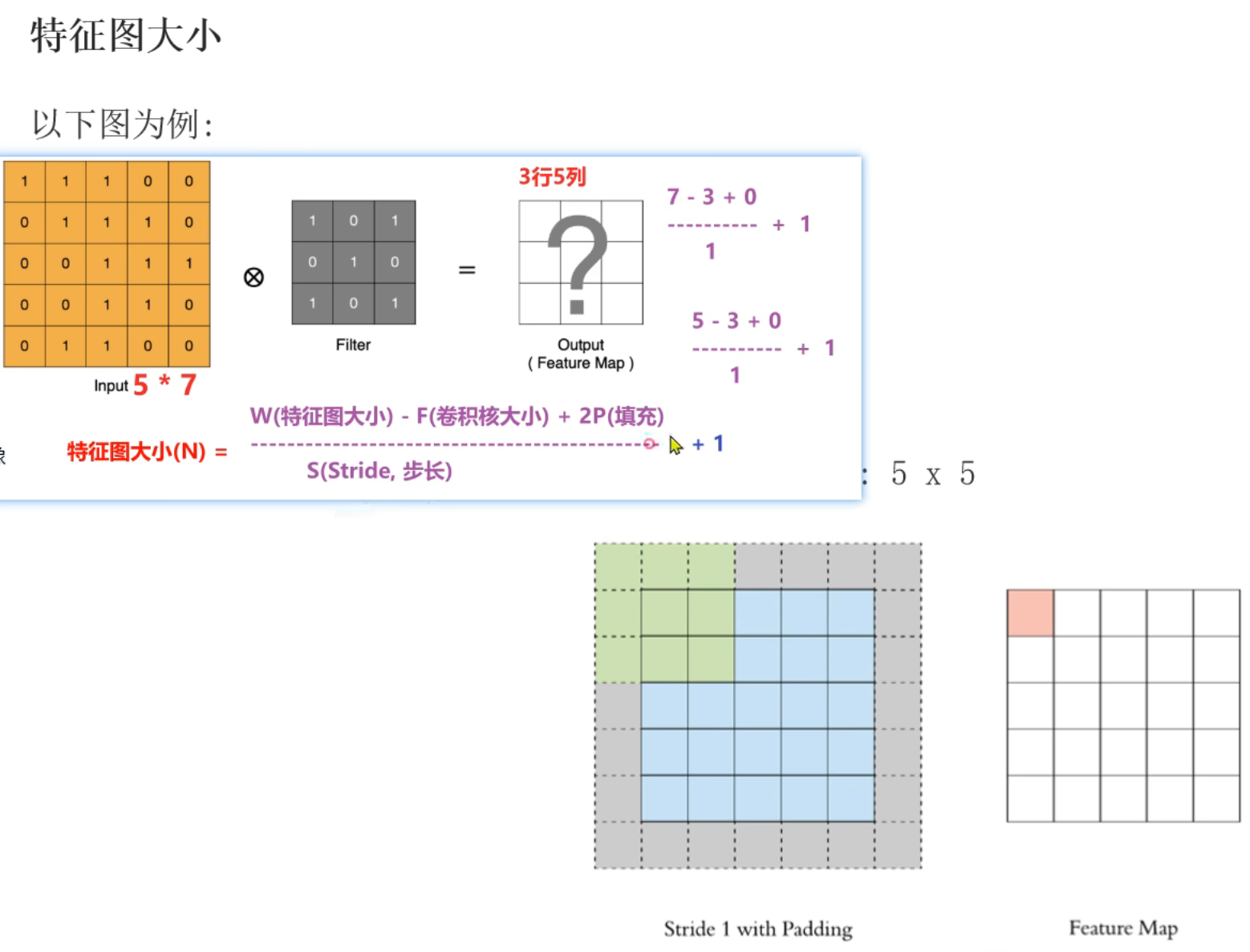

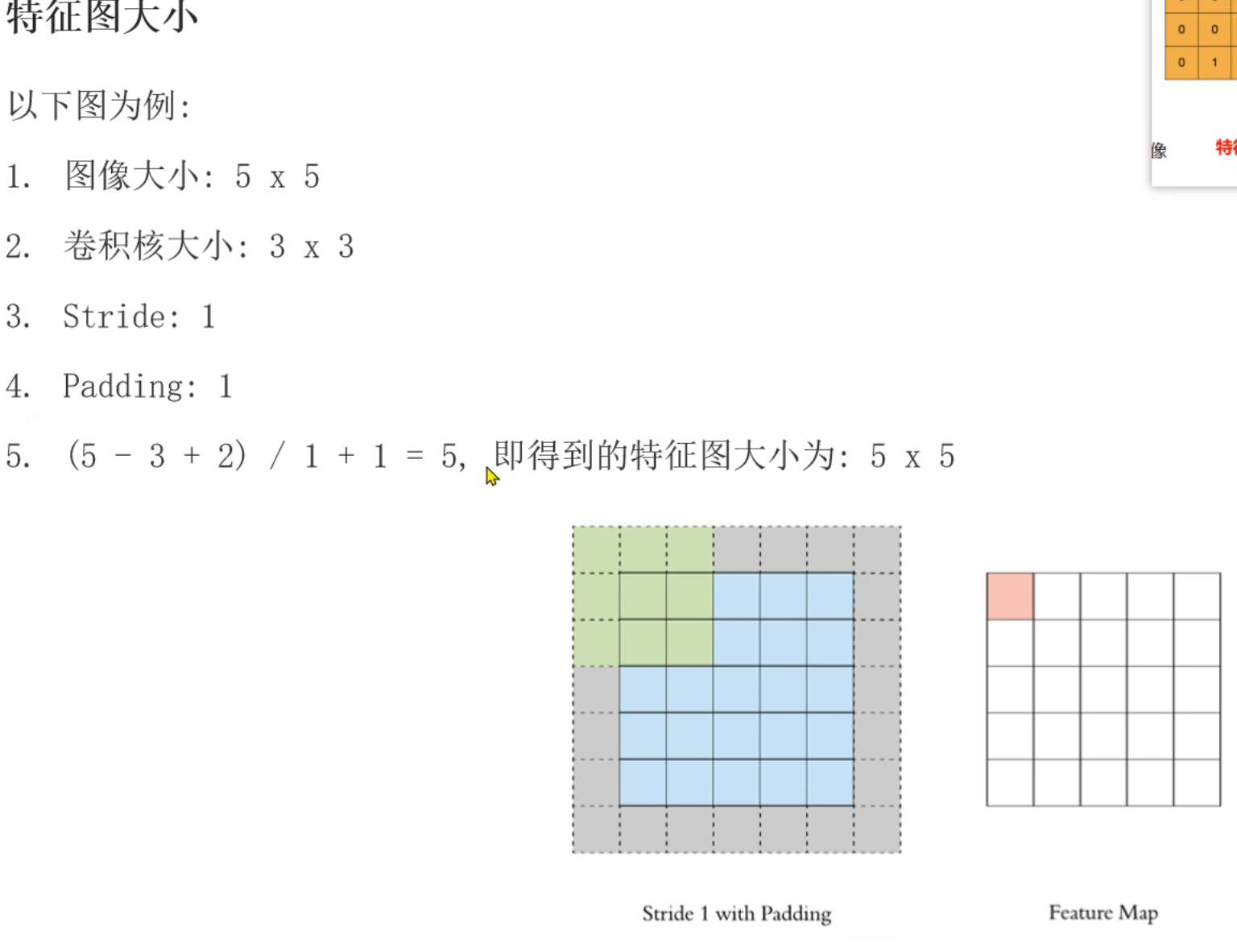

14、卷积层_特征图(FeatureMap)计算规则

下面笔记中的W是原图大小,老师打错了。也可以按照上面的解释,W是输入图像大小,N是输出图像大小

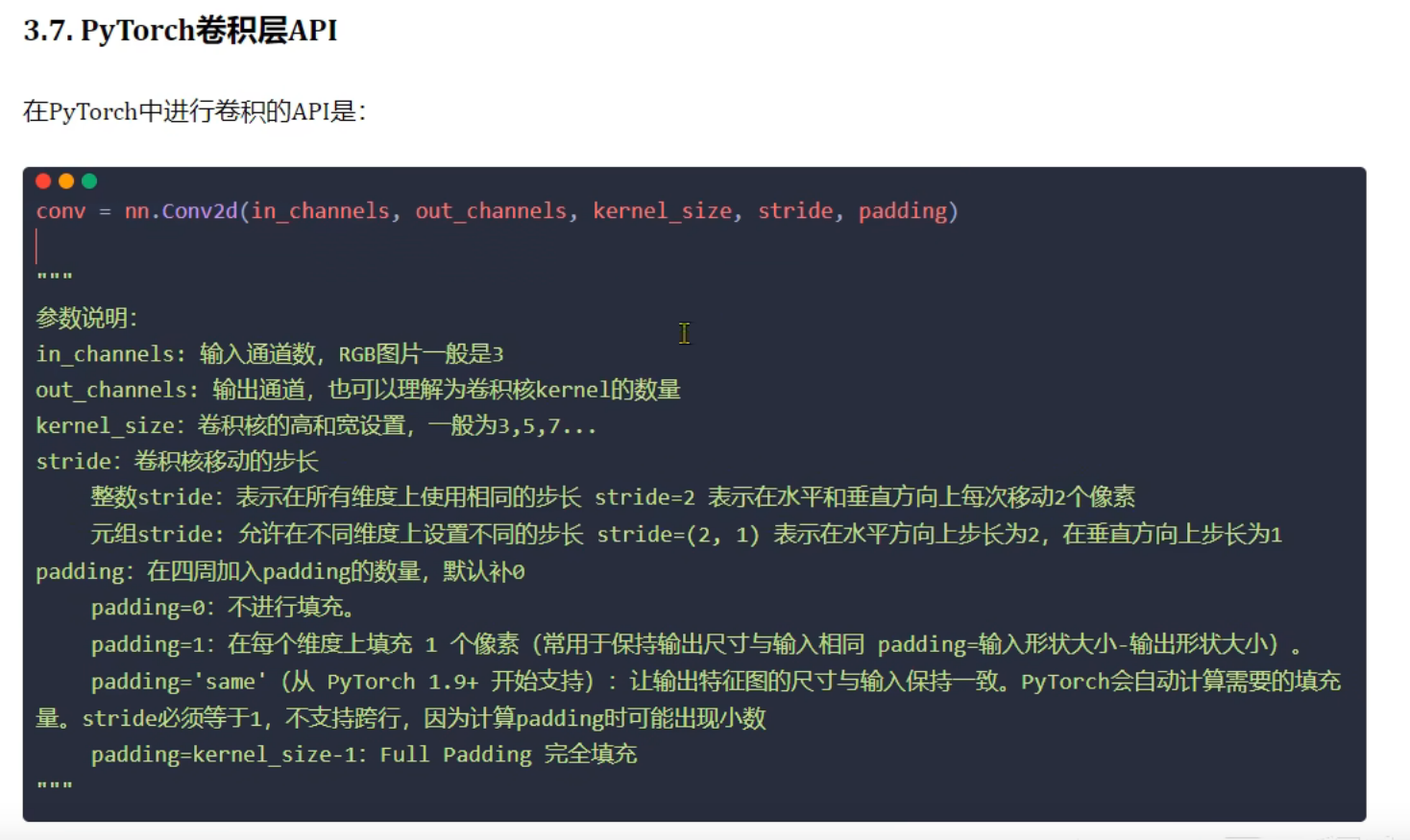

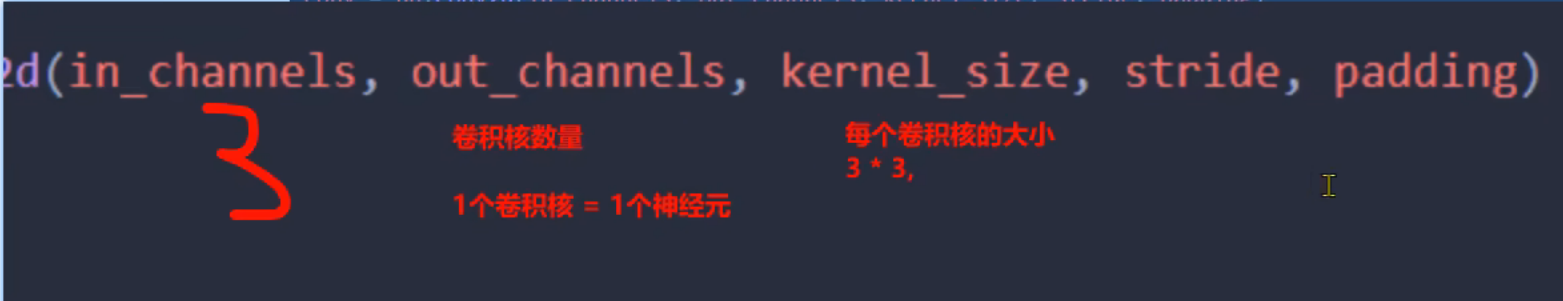

15、卷积层_API介绍

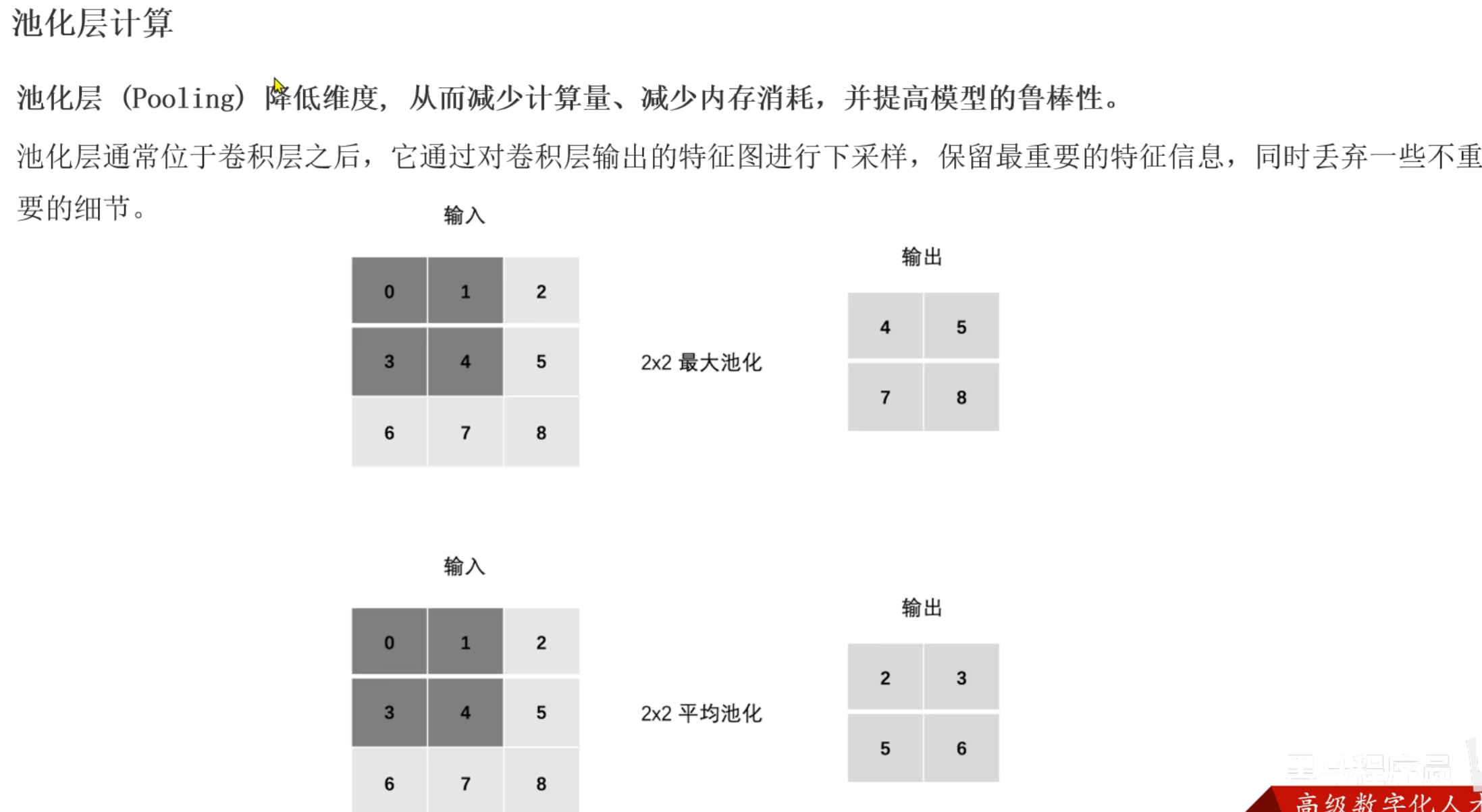

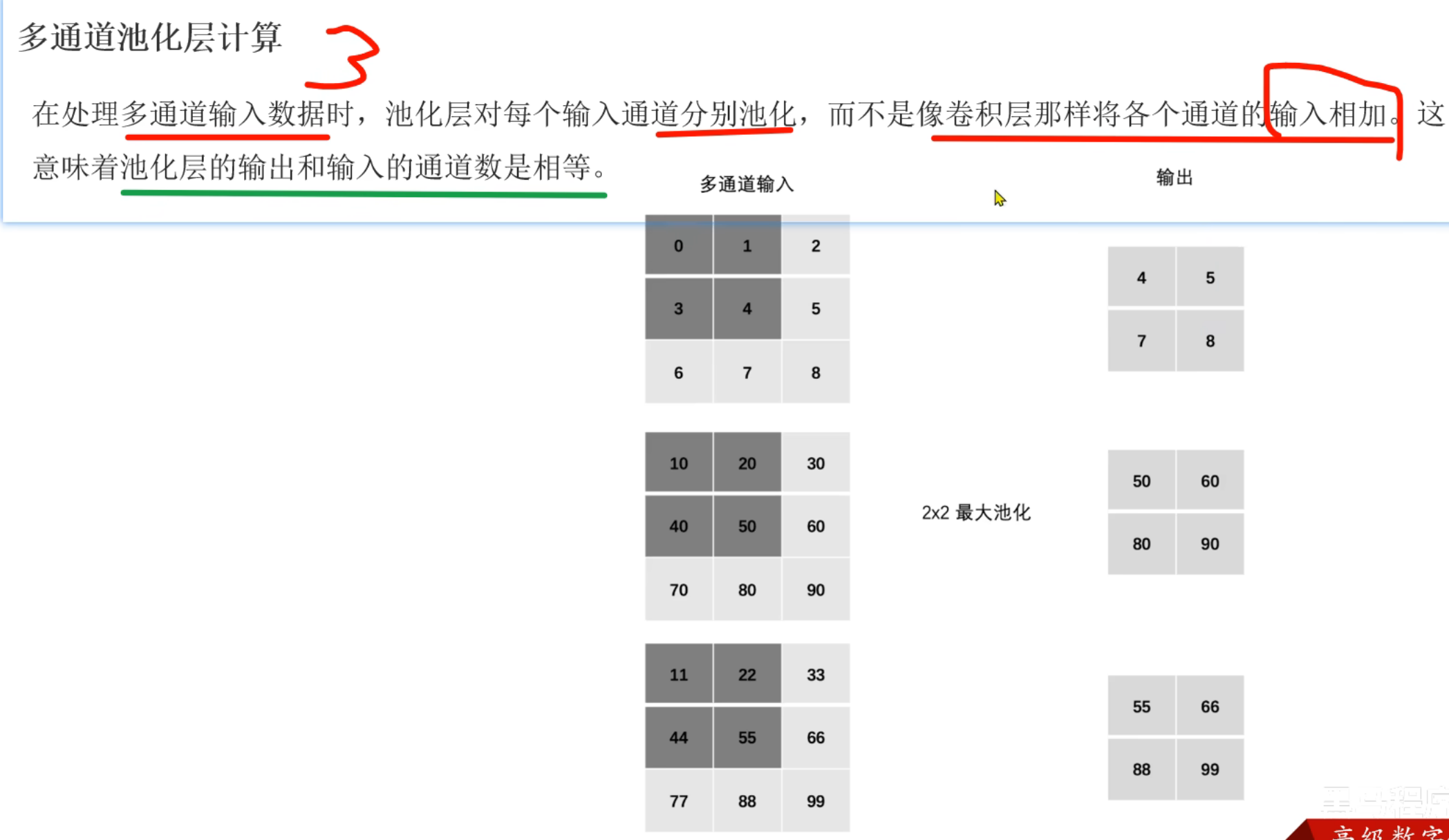

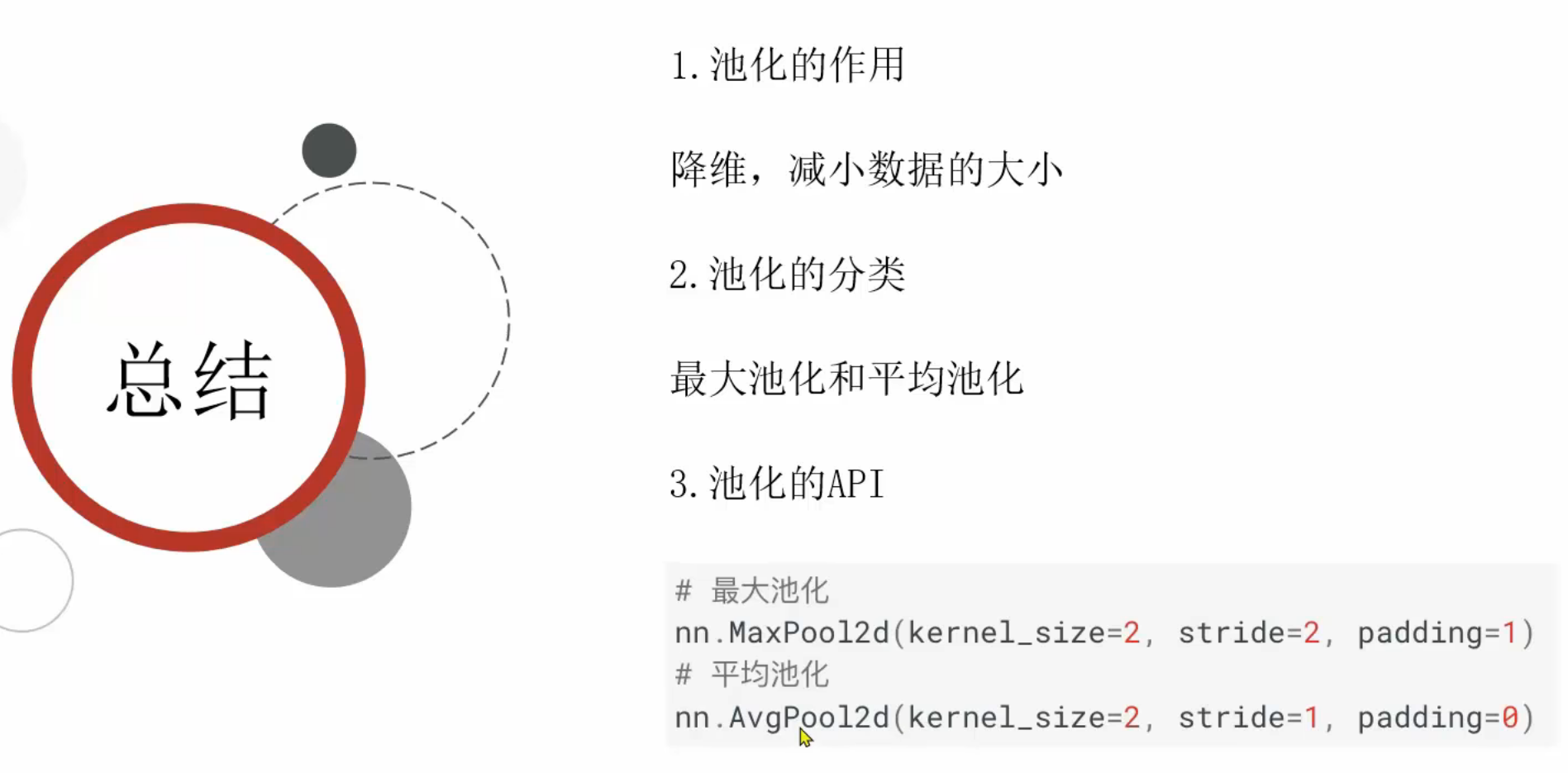

16、池化层_介绍

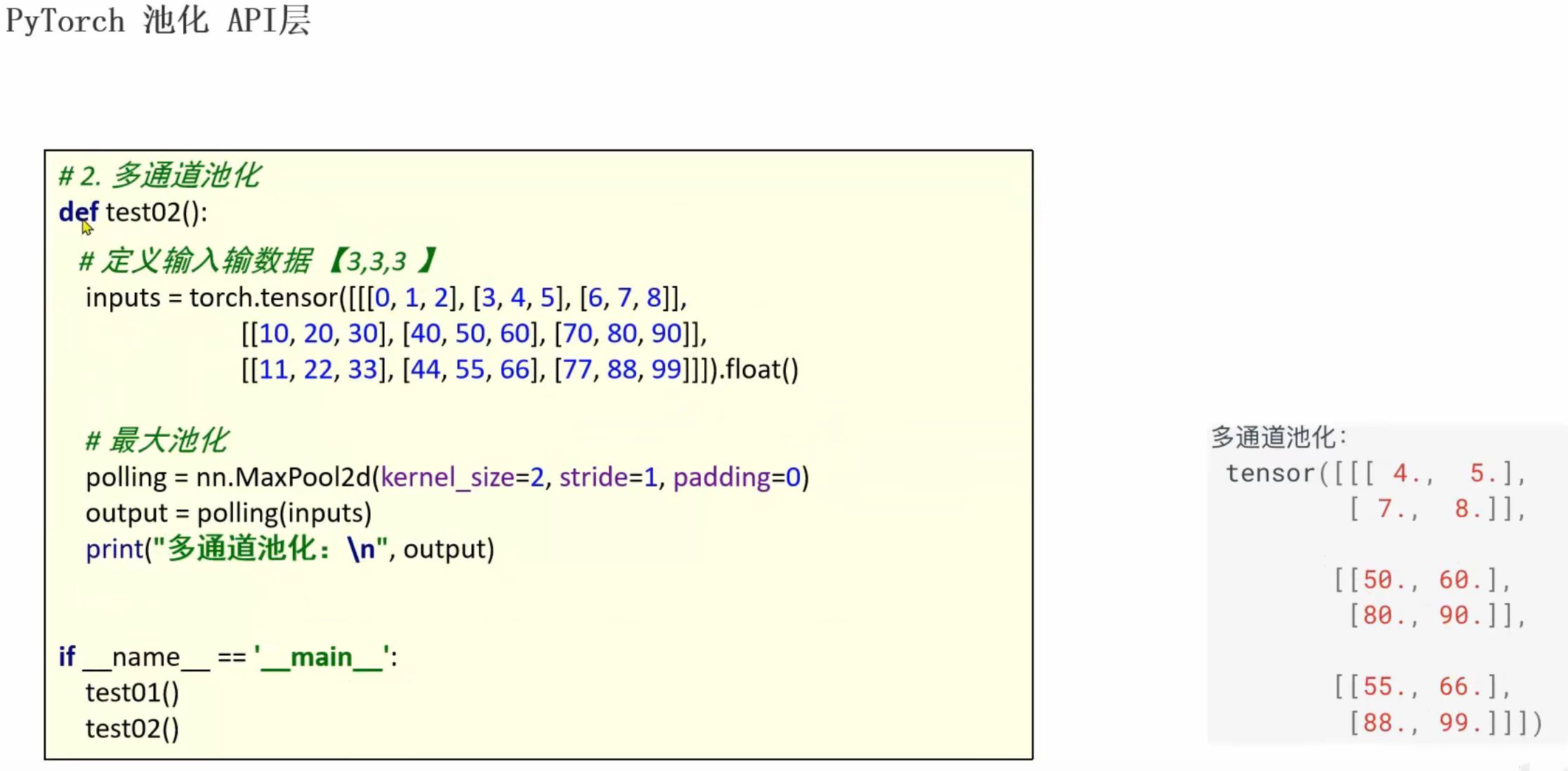

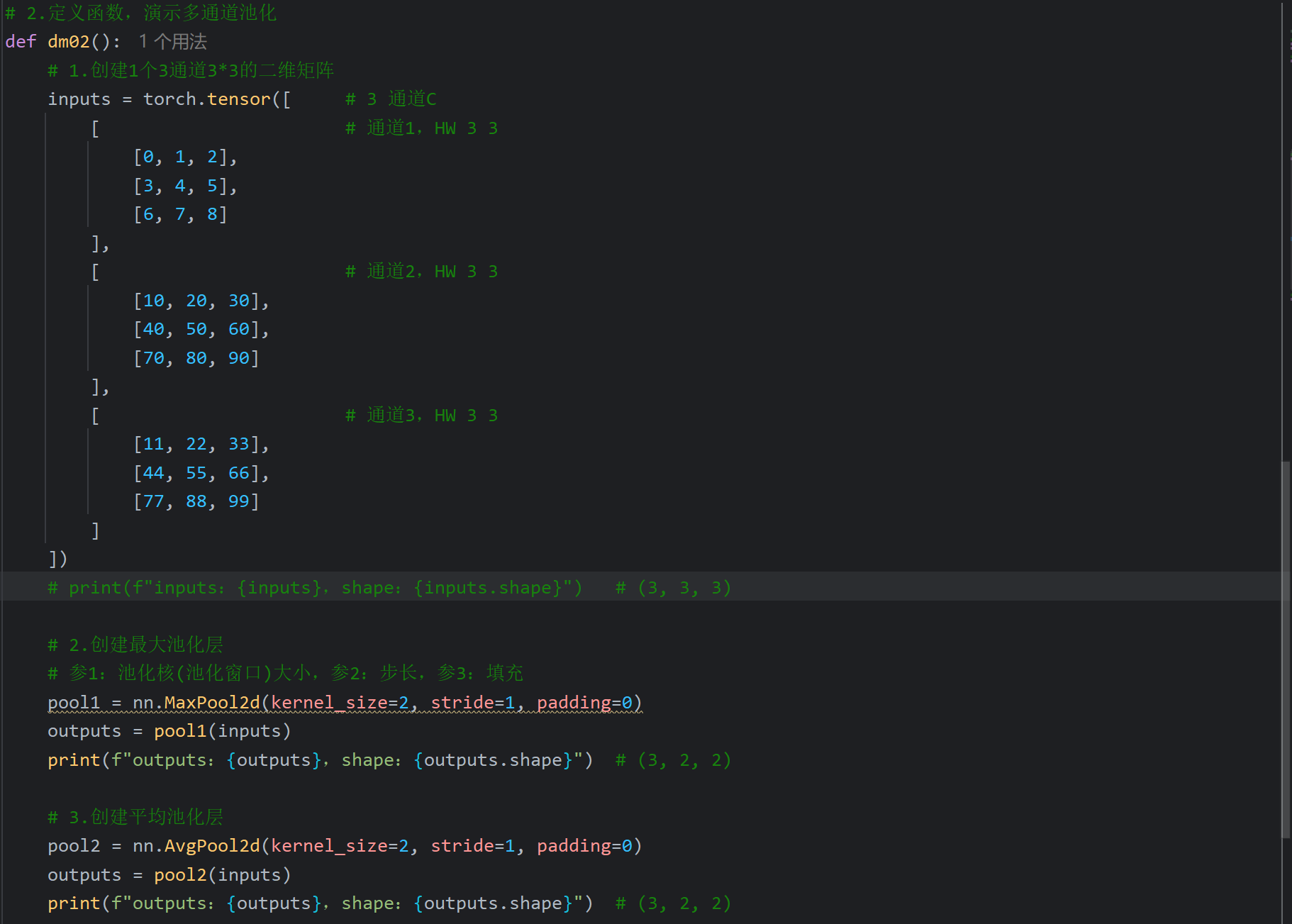

卷积可以改变通道数,池化不会改变通道数

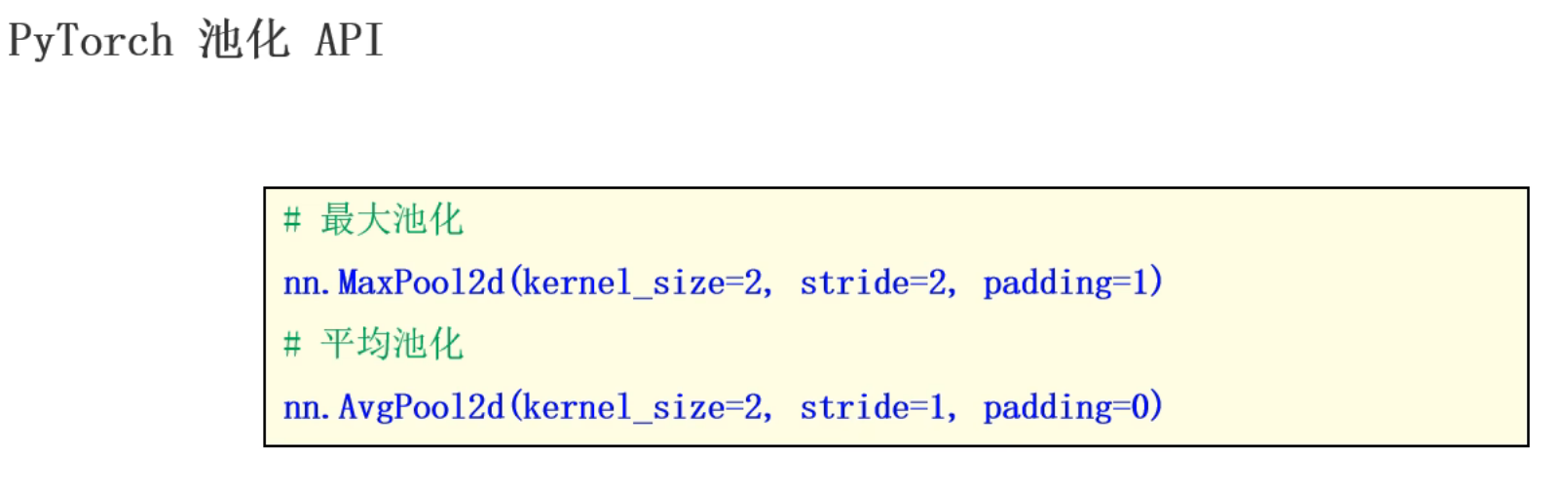

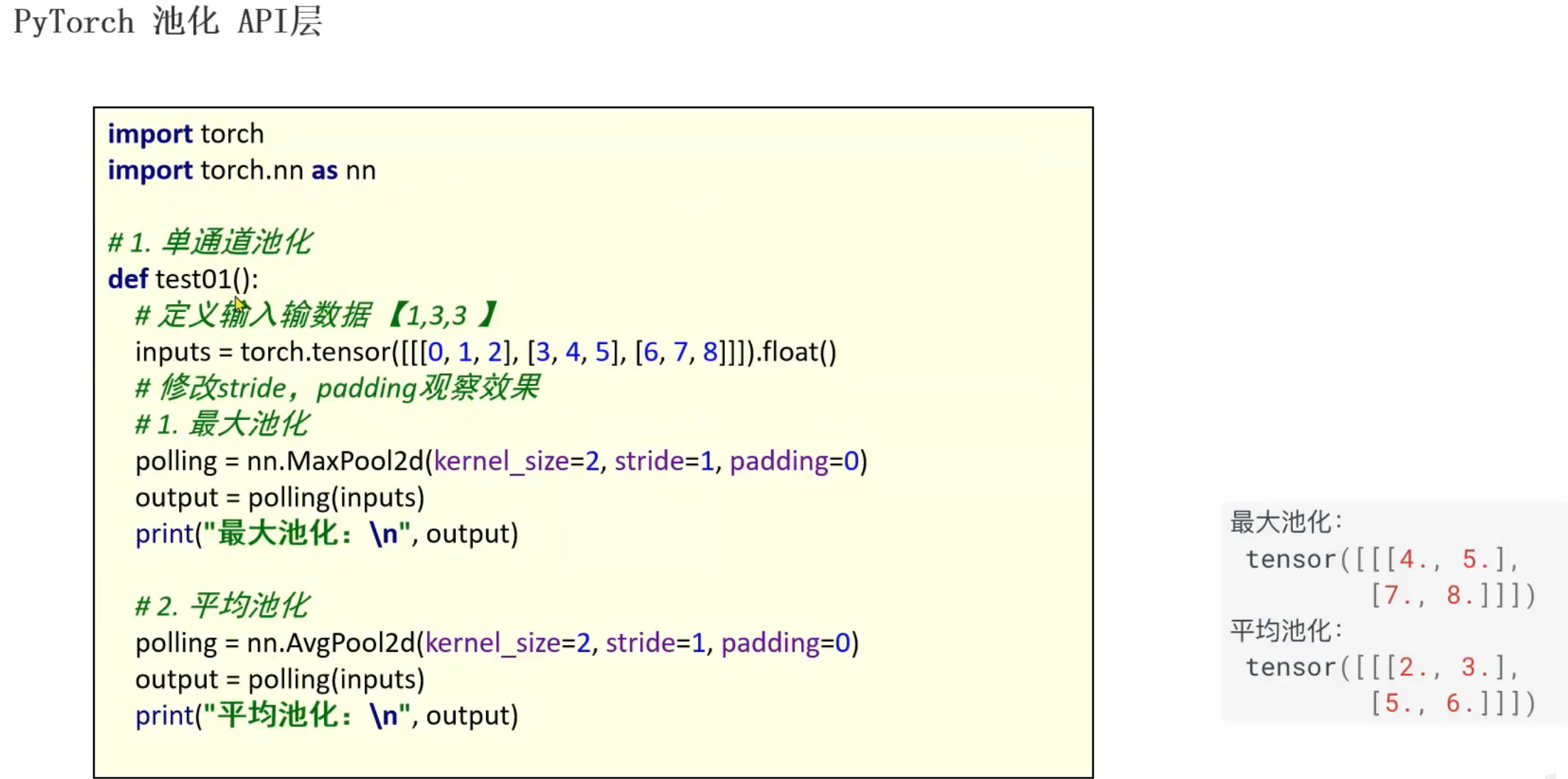

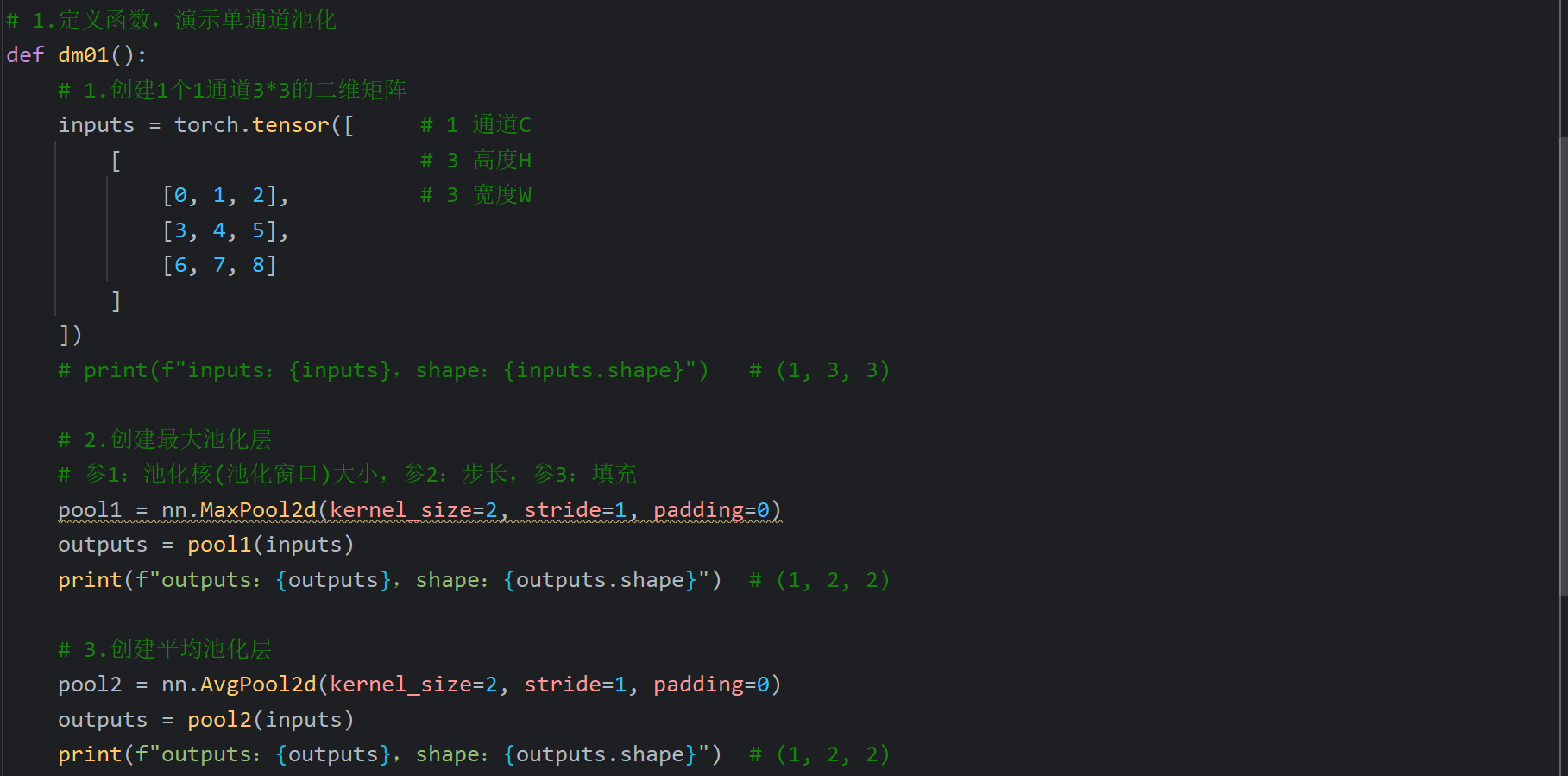

17、池化层_API介绍

八、Day07

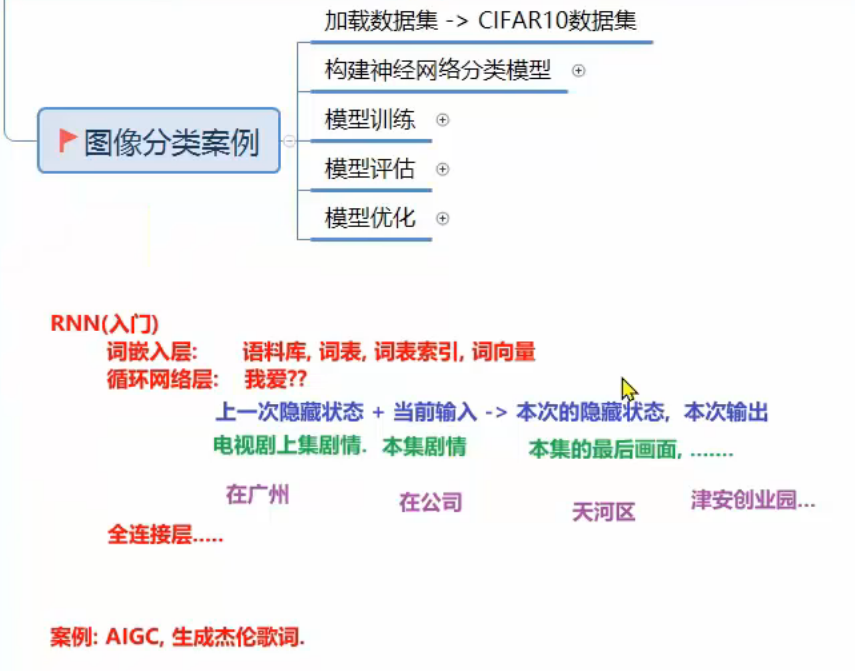

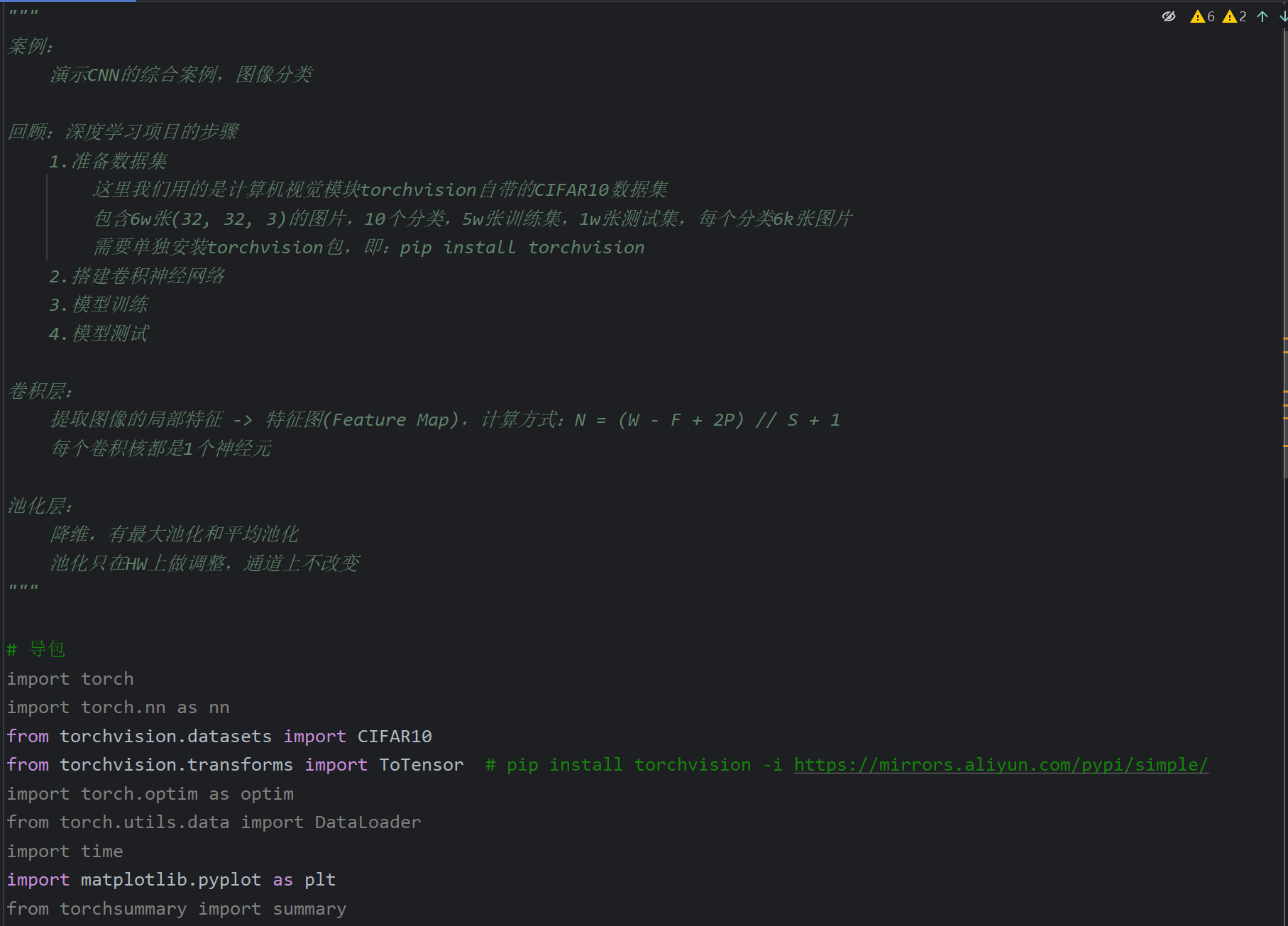

1、今日内容大纲介绍

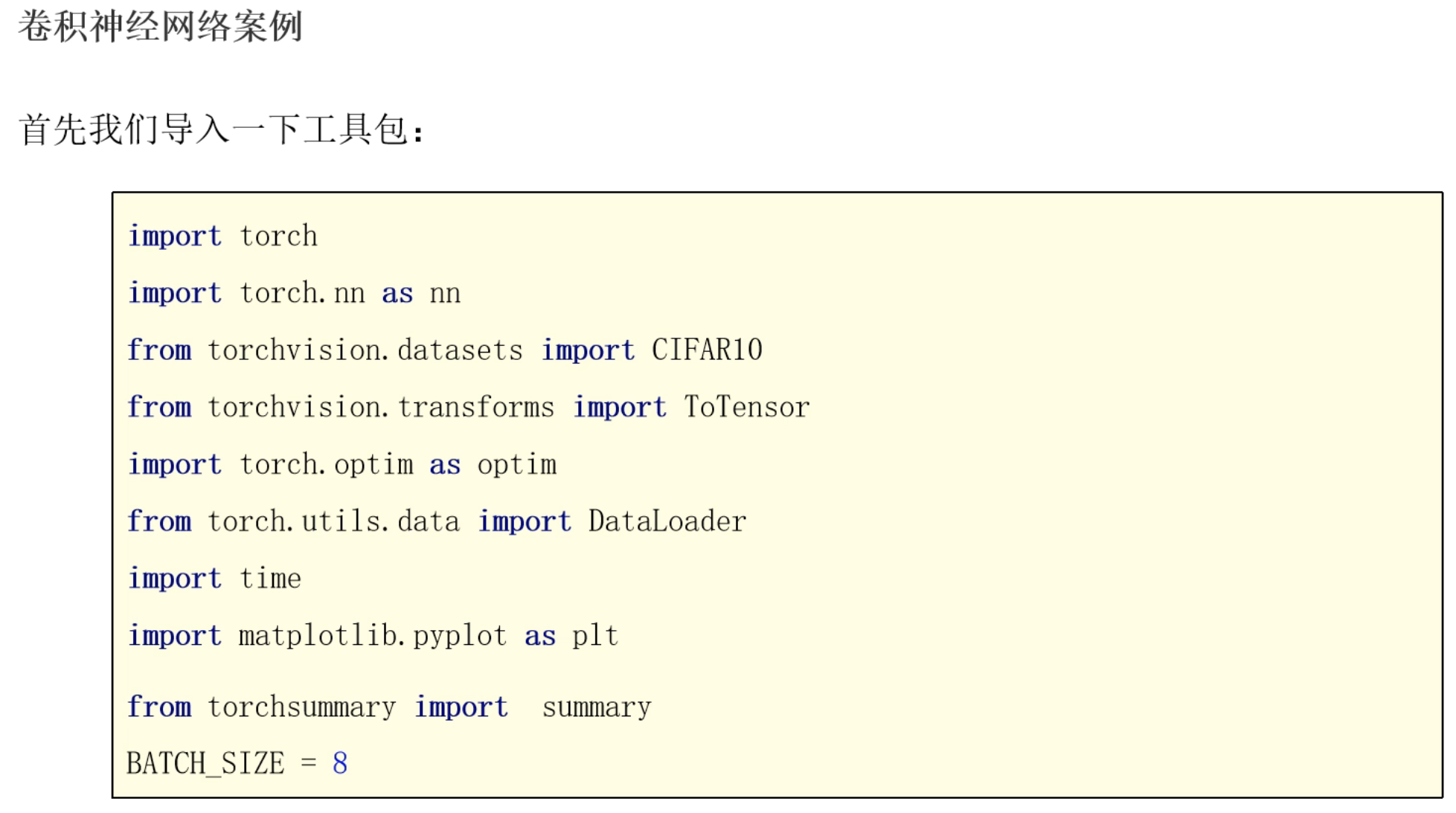

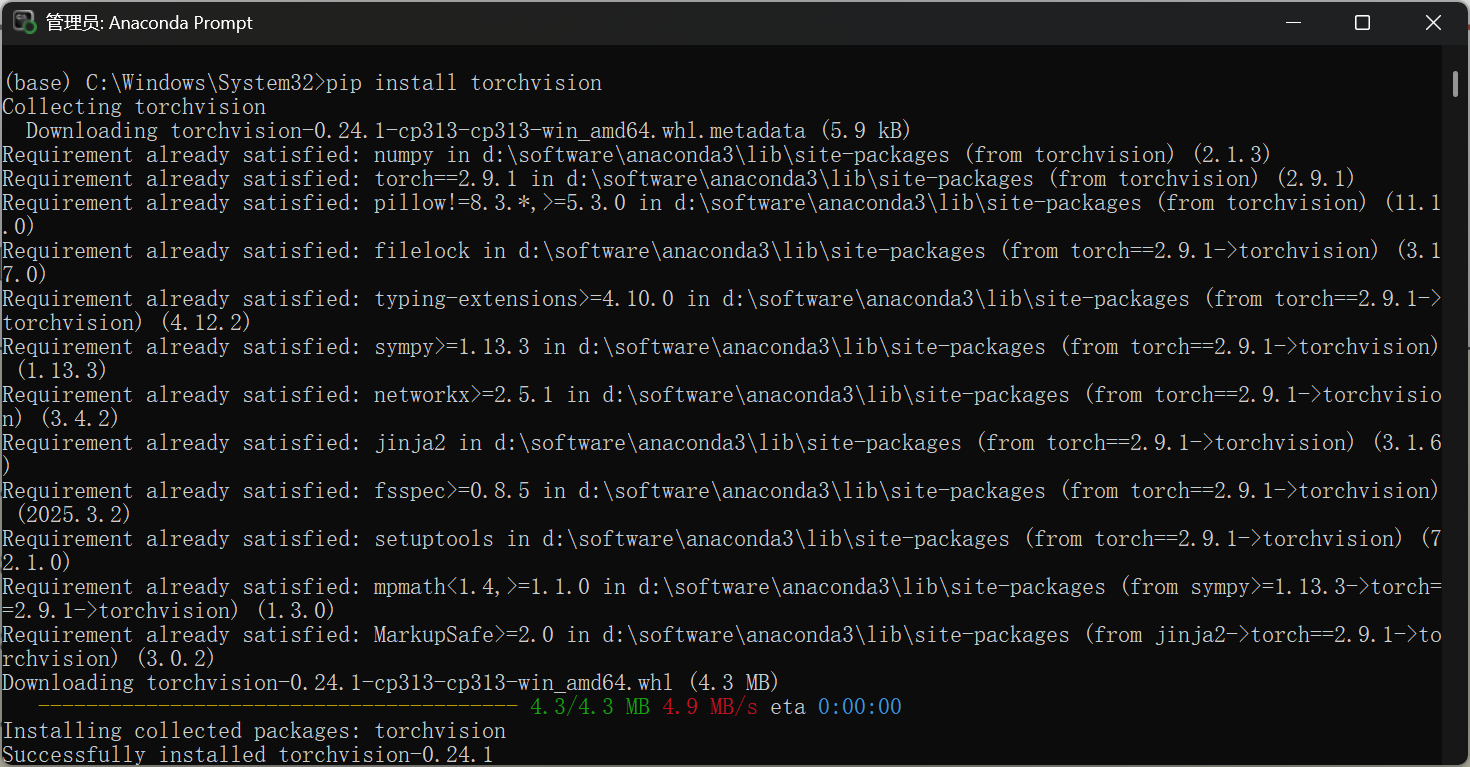

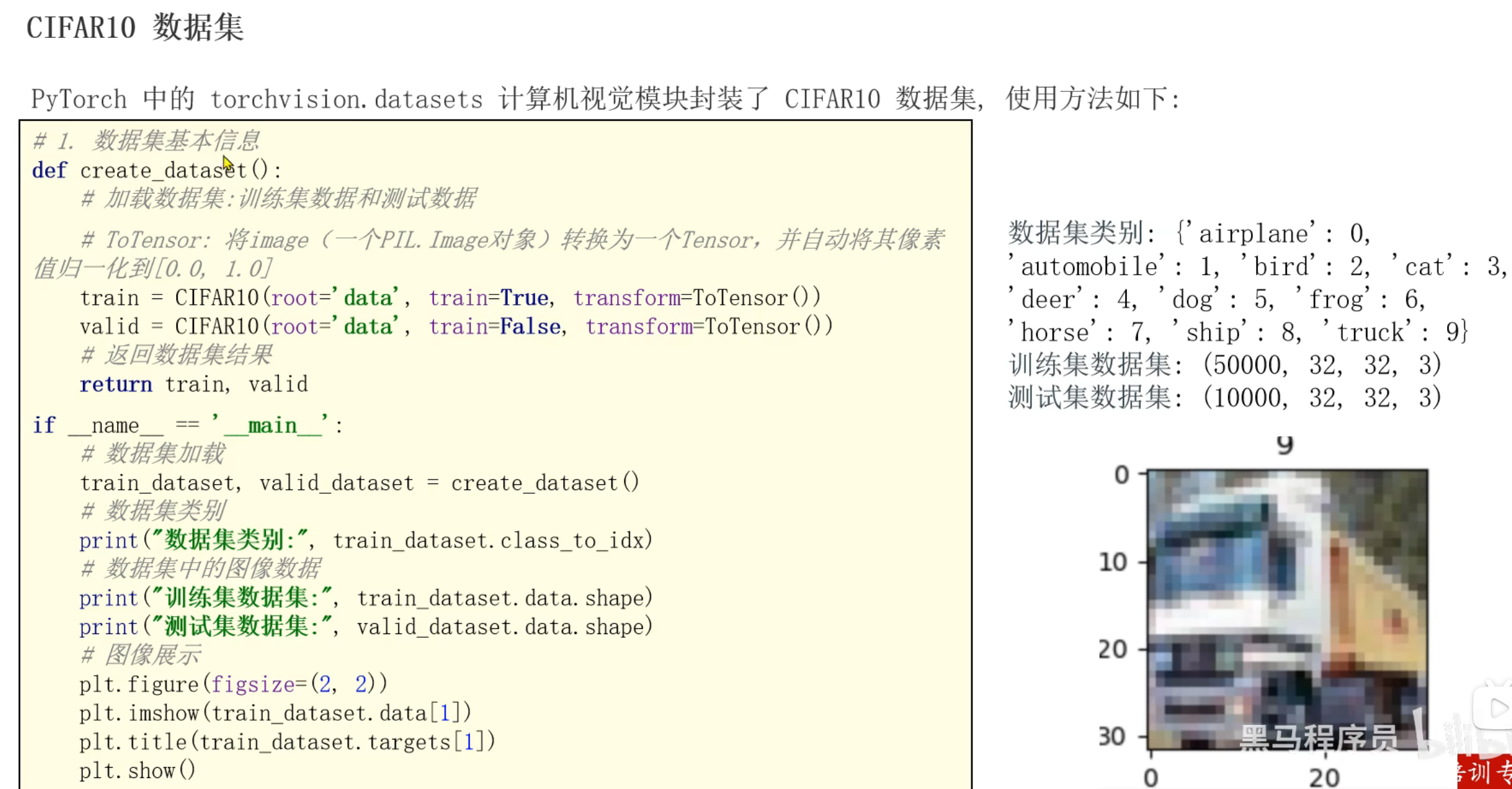

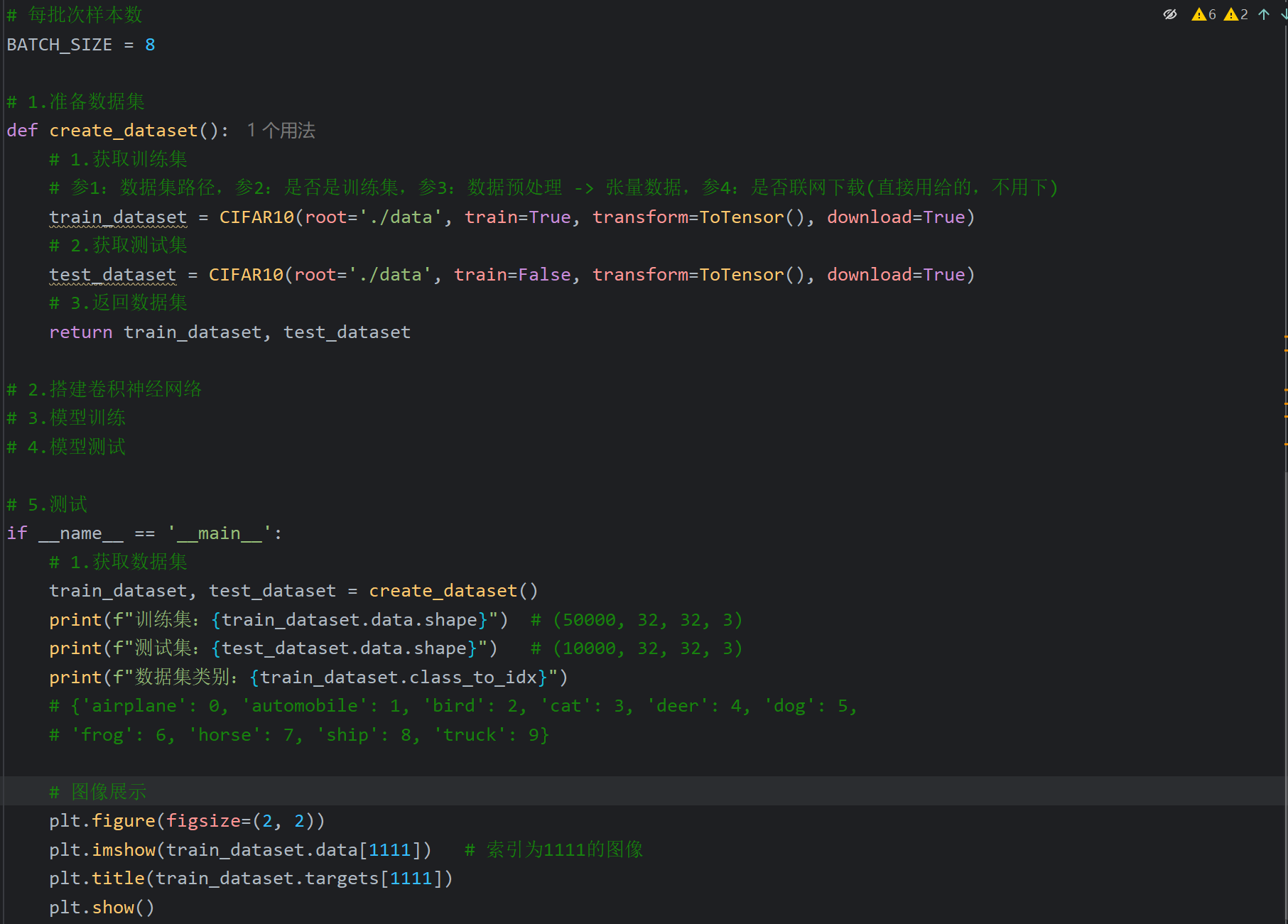

2、CNN图像分类案例_准备数据集

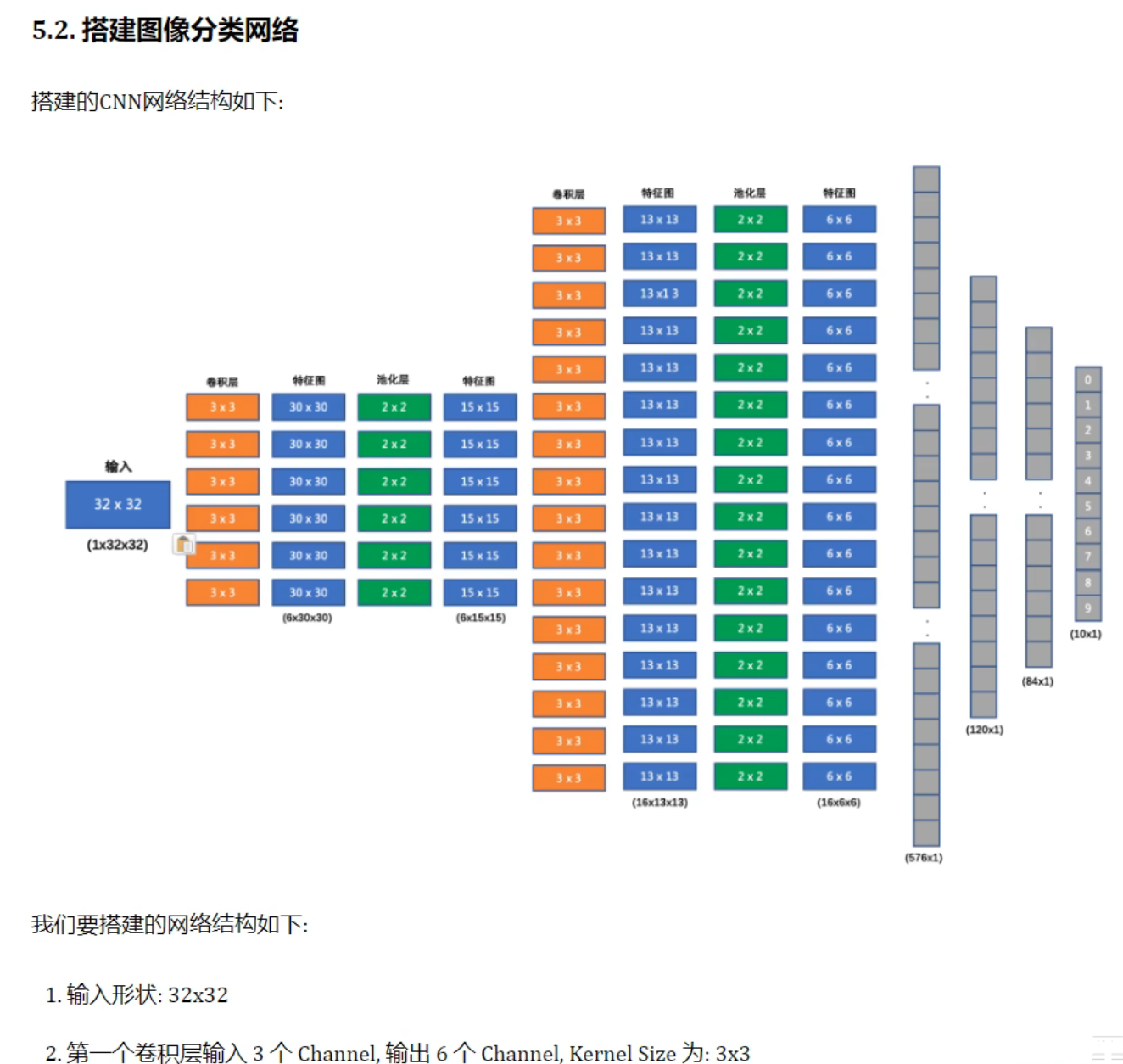

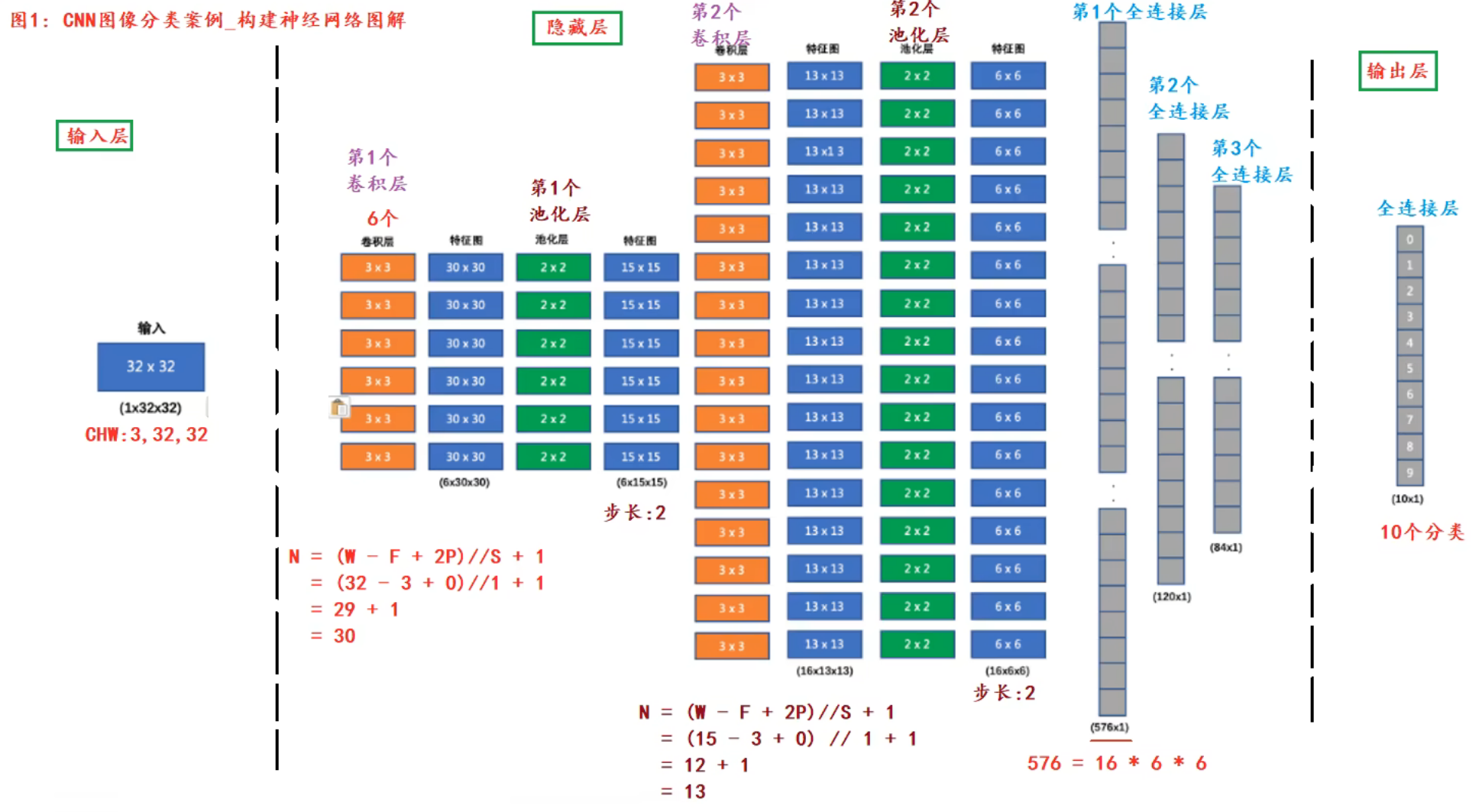

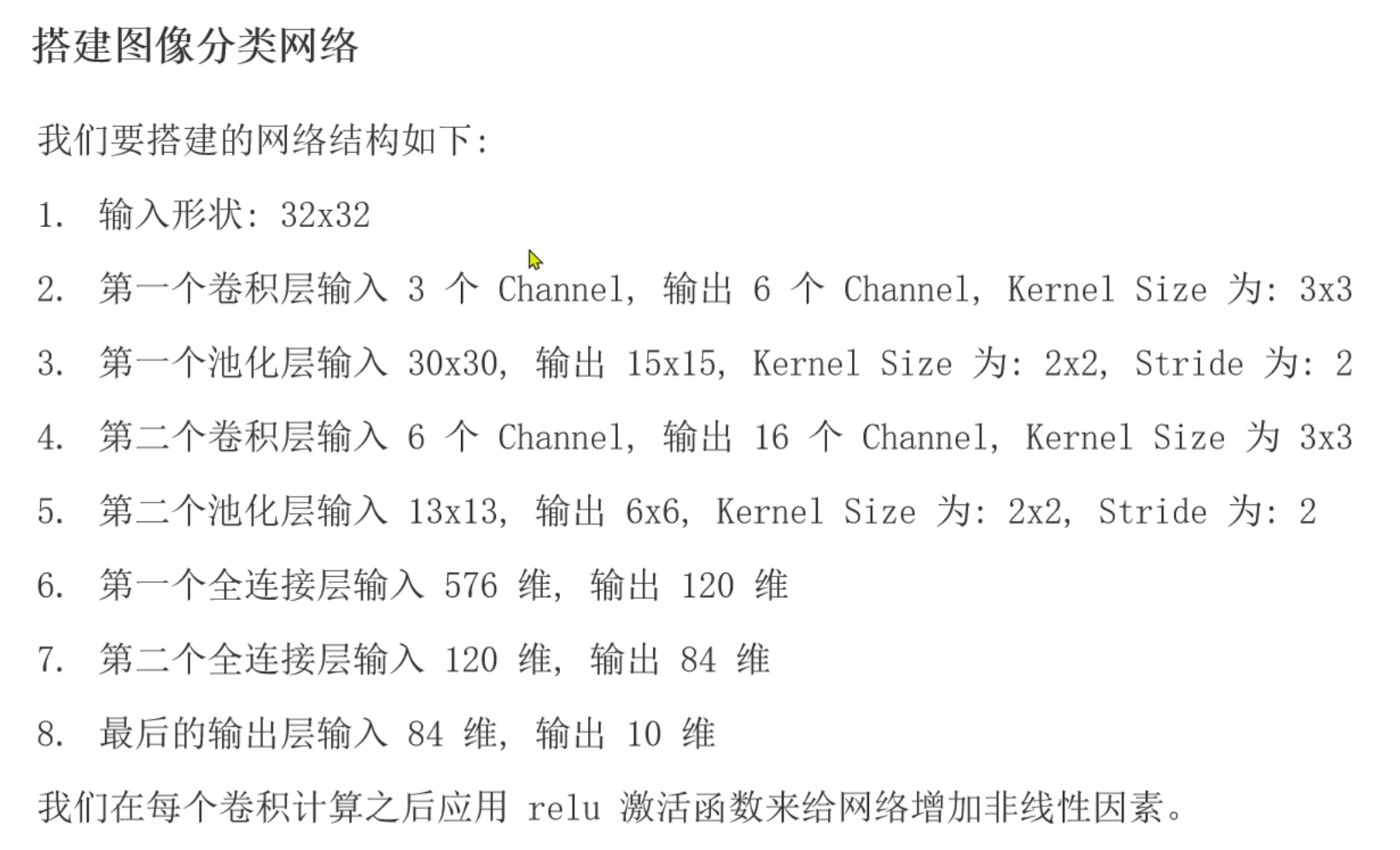

3、CNN图像分类案例_搭建神经网络_思路分析

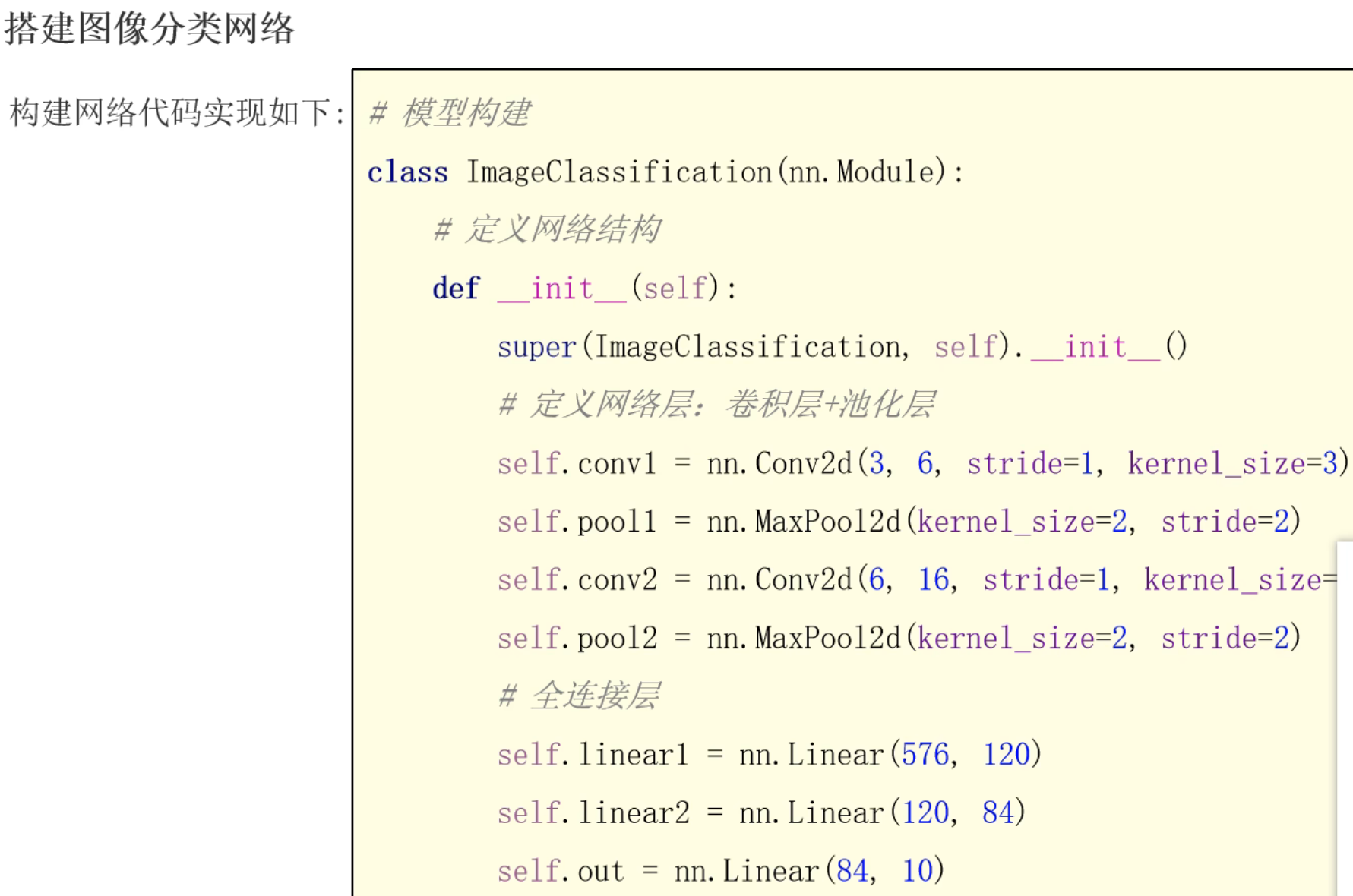

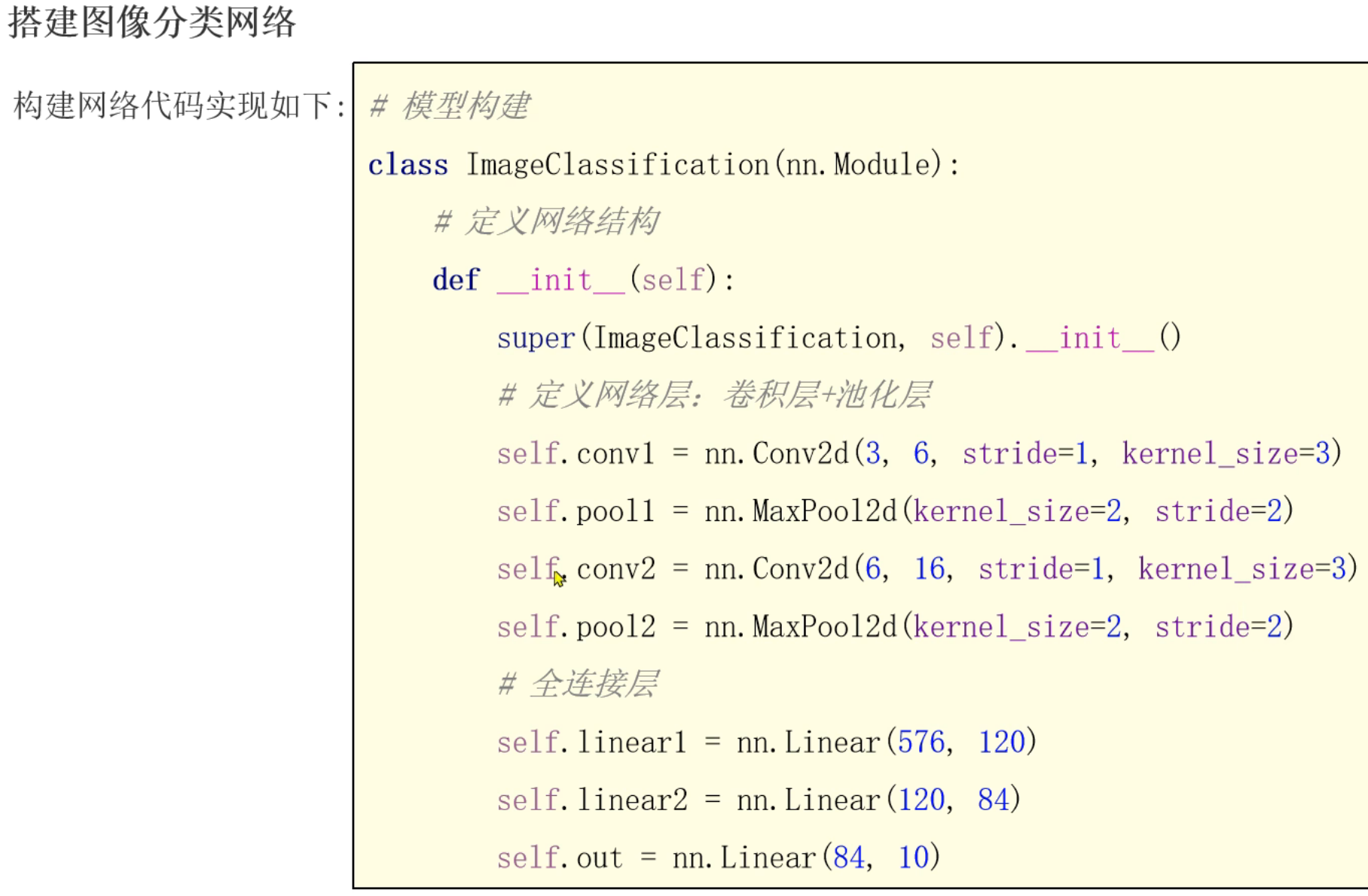

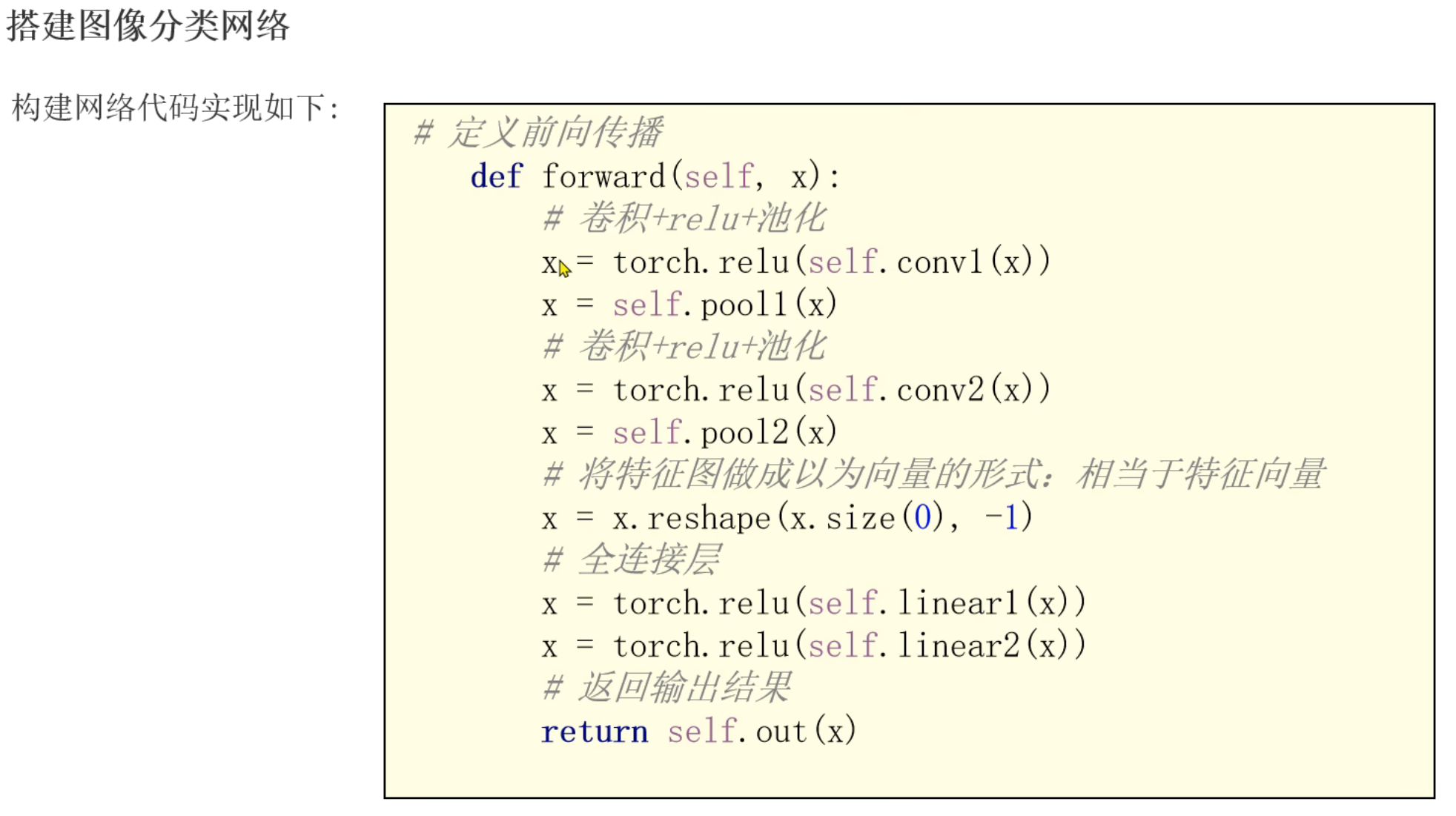

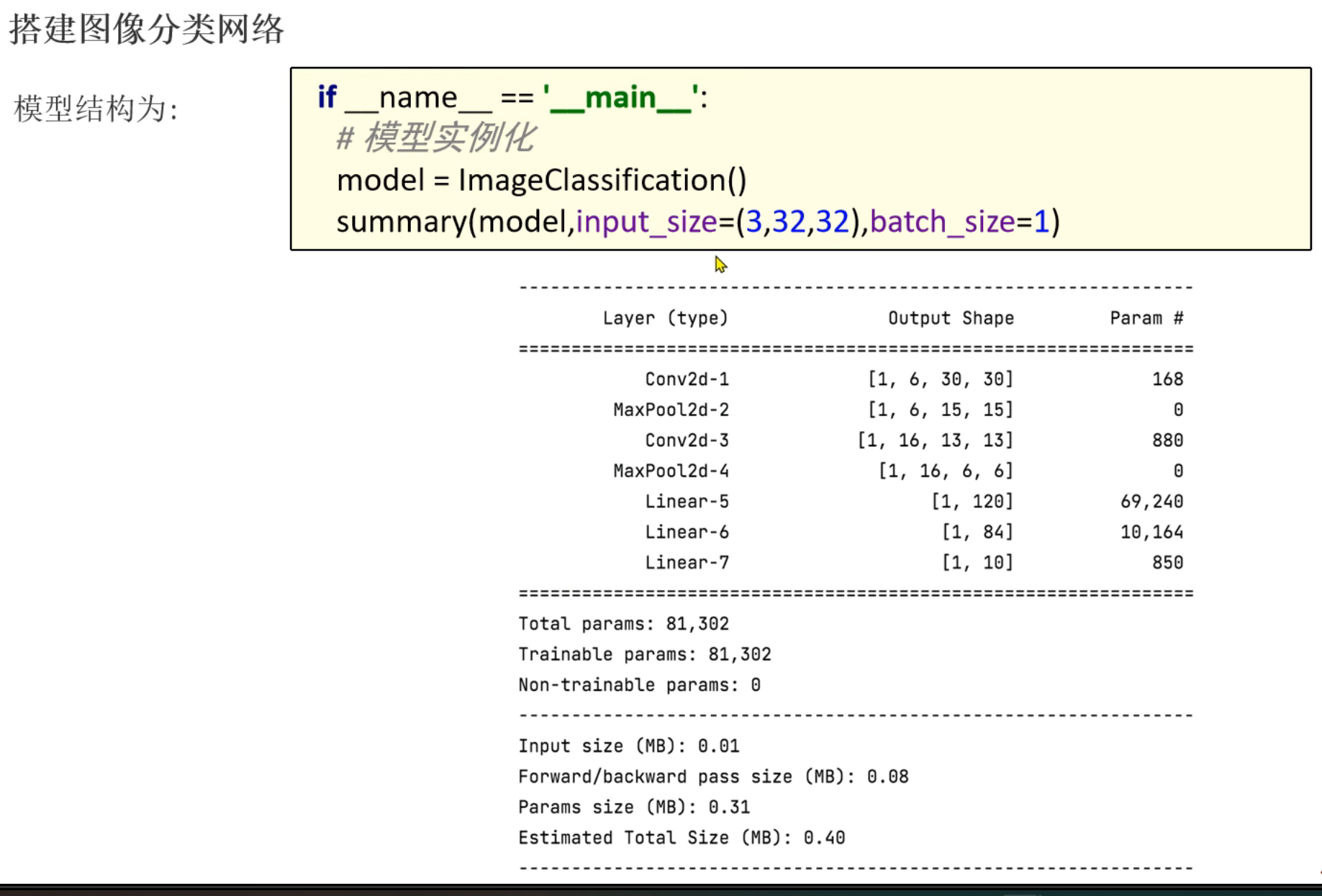

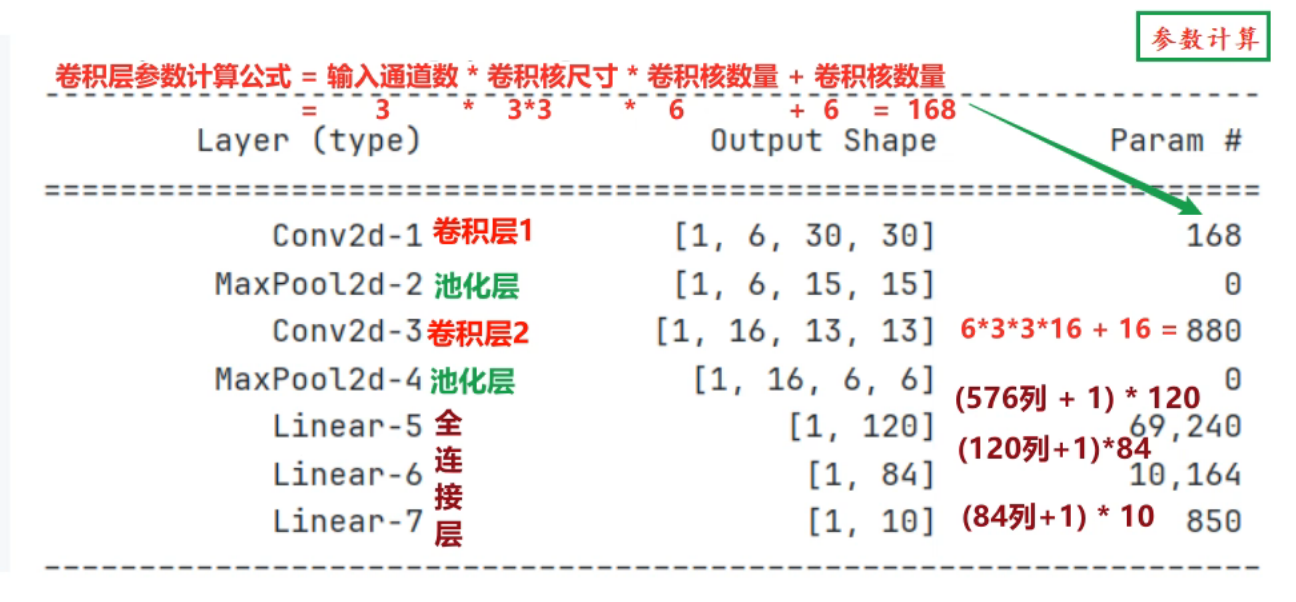

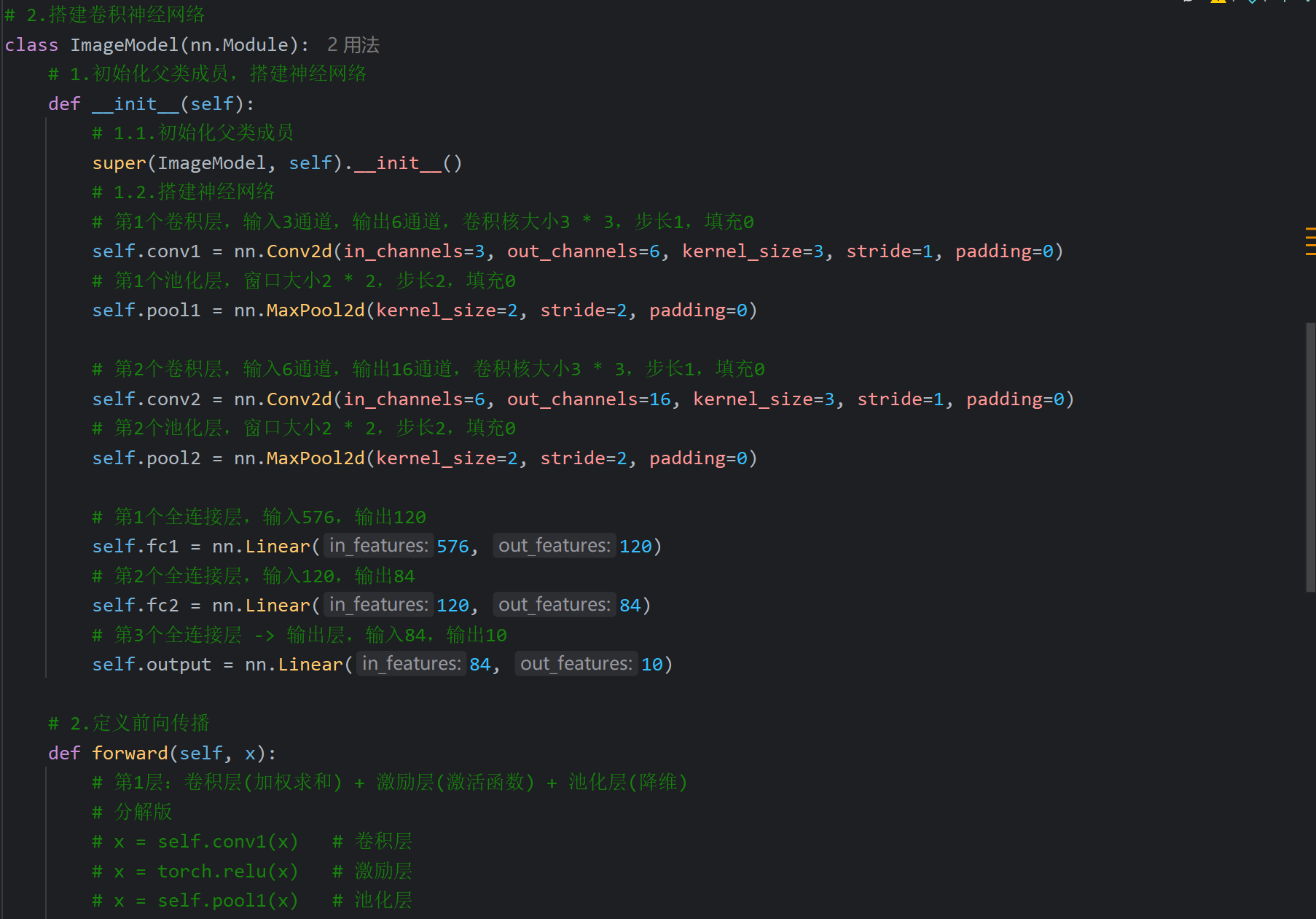

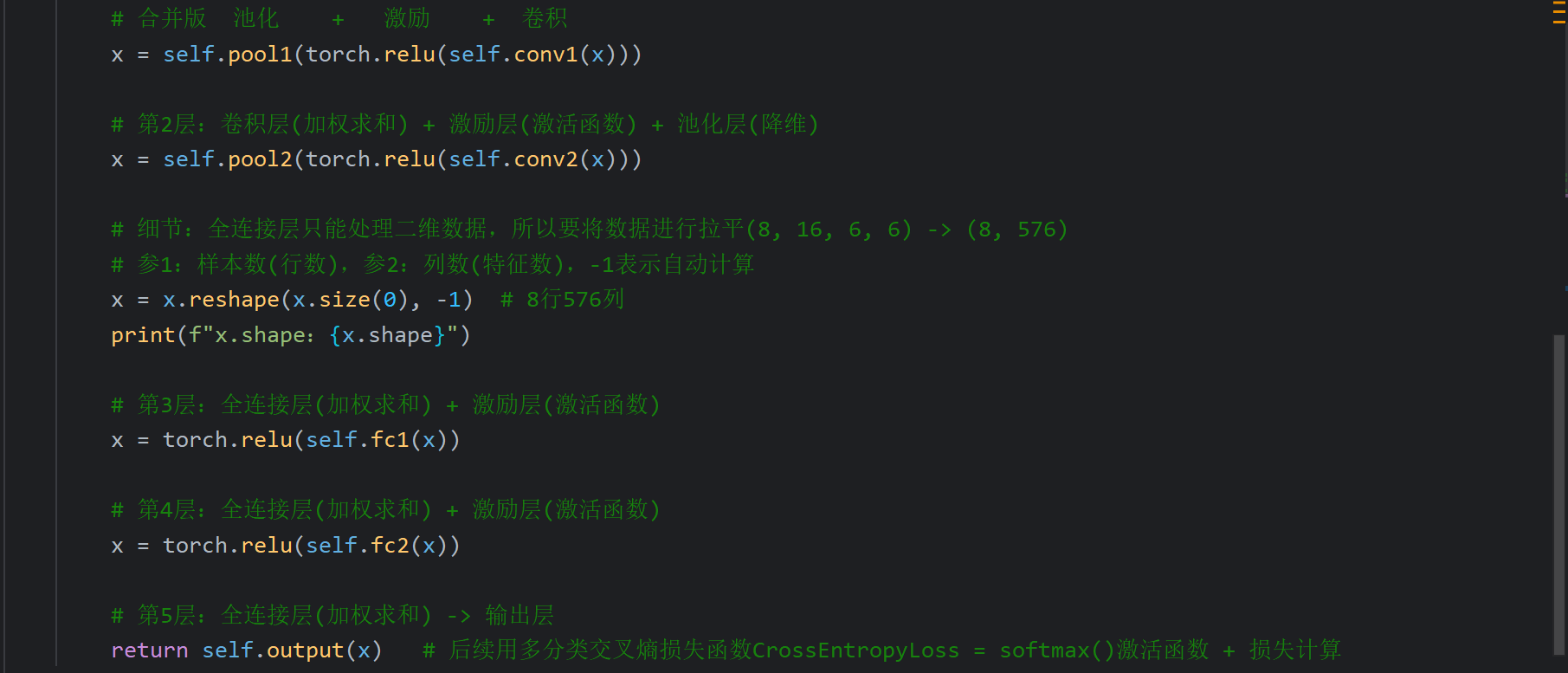

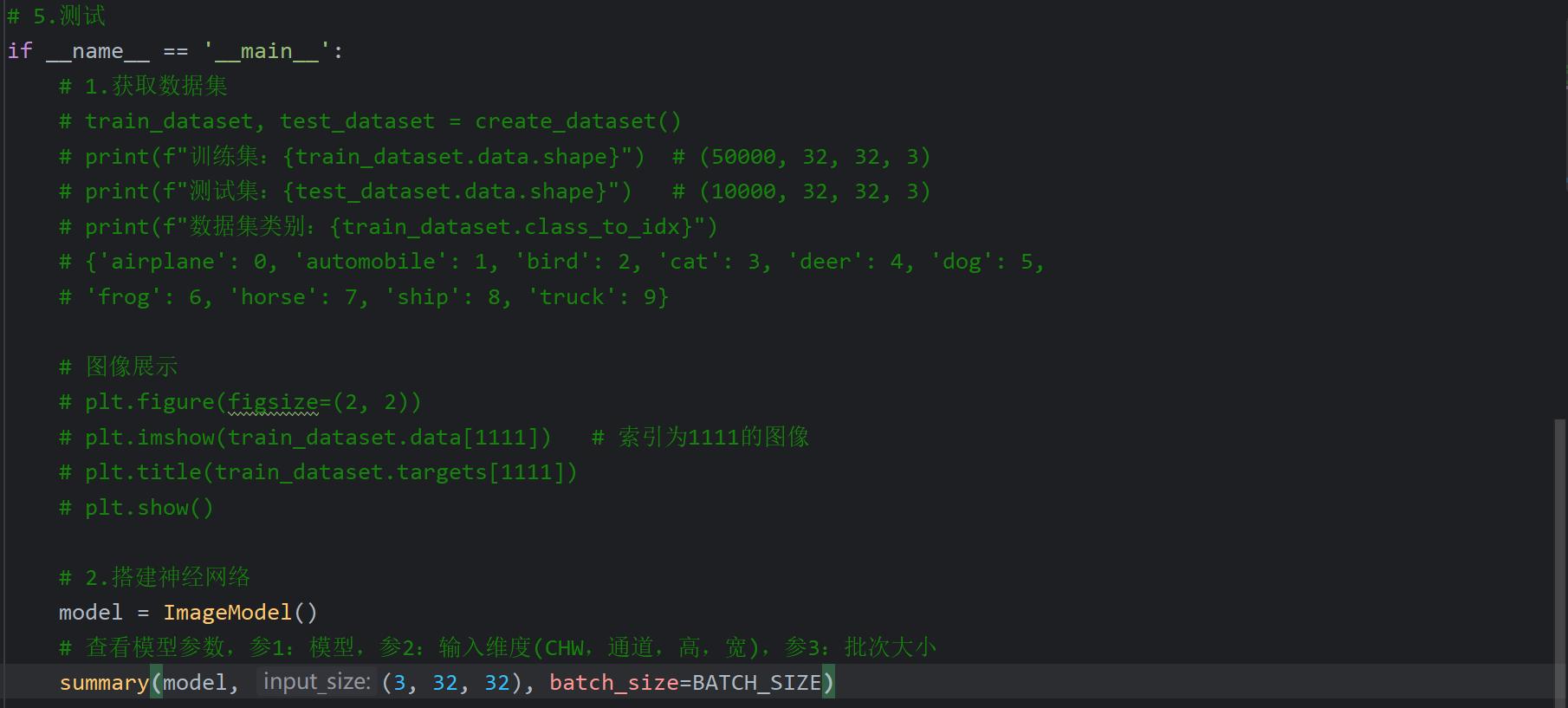

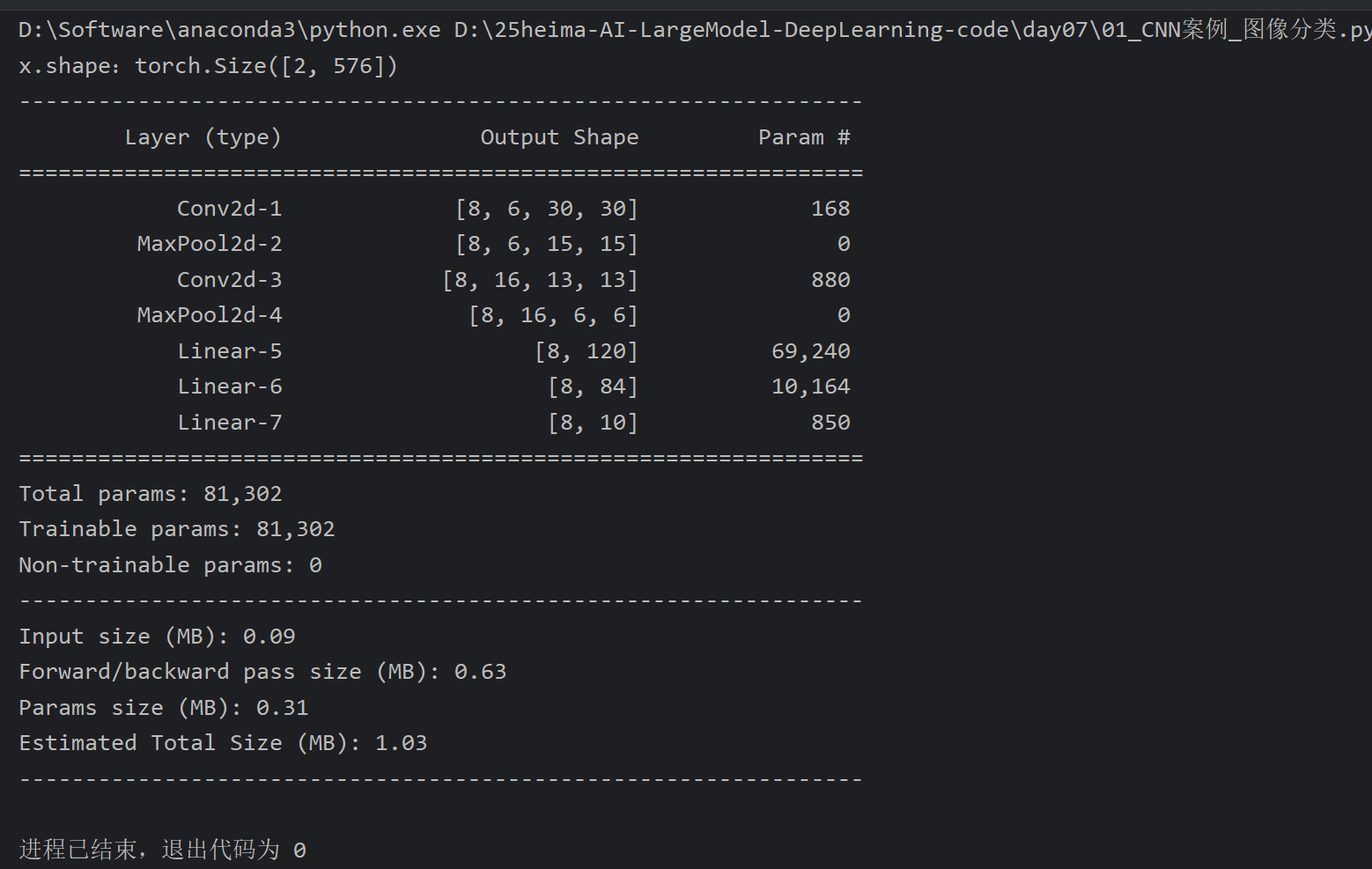

4、CNN图像分类案例_搭建神经网络_代码实现

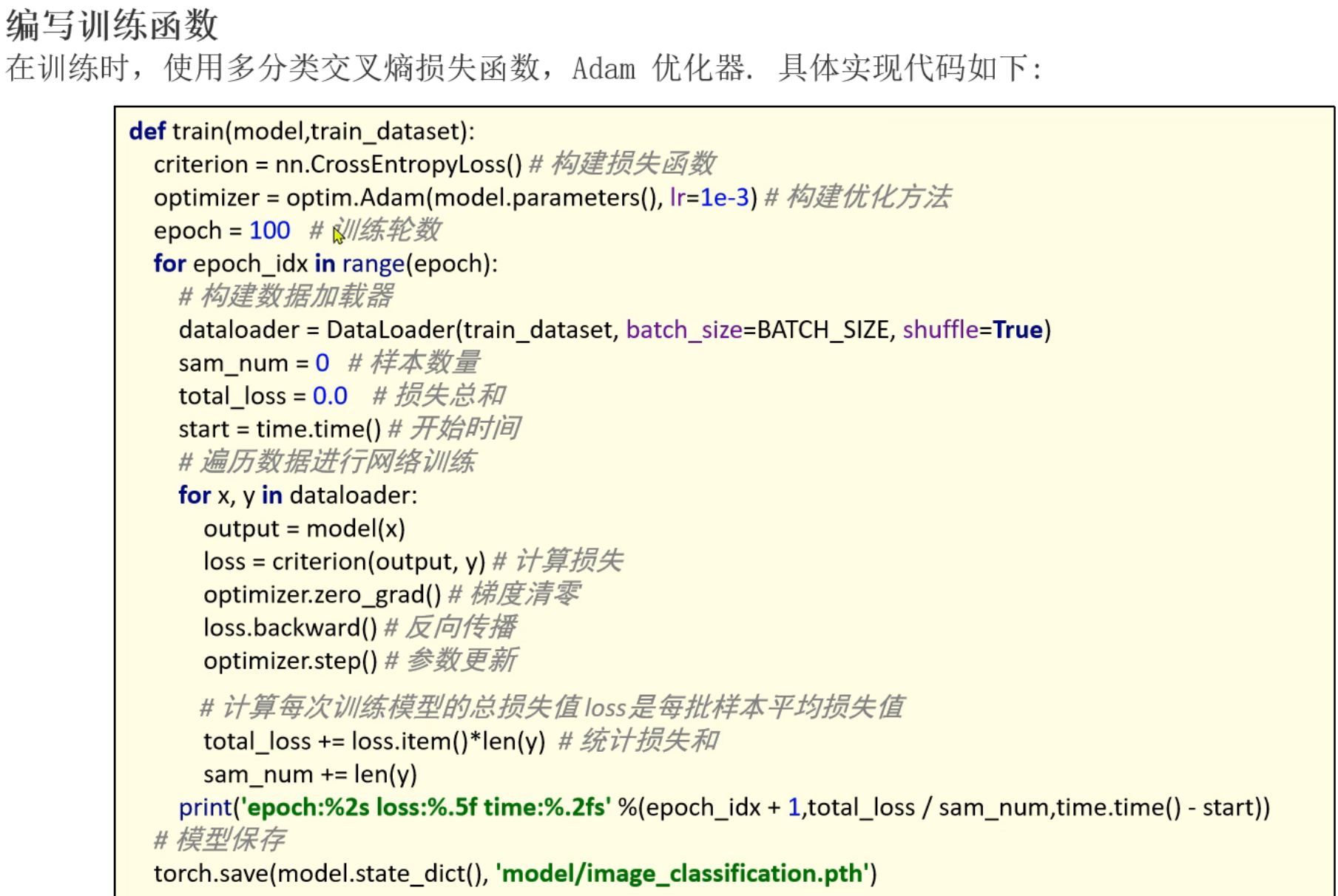

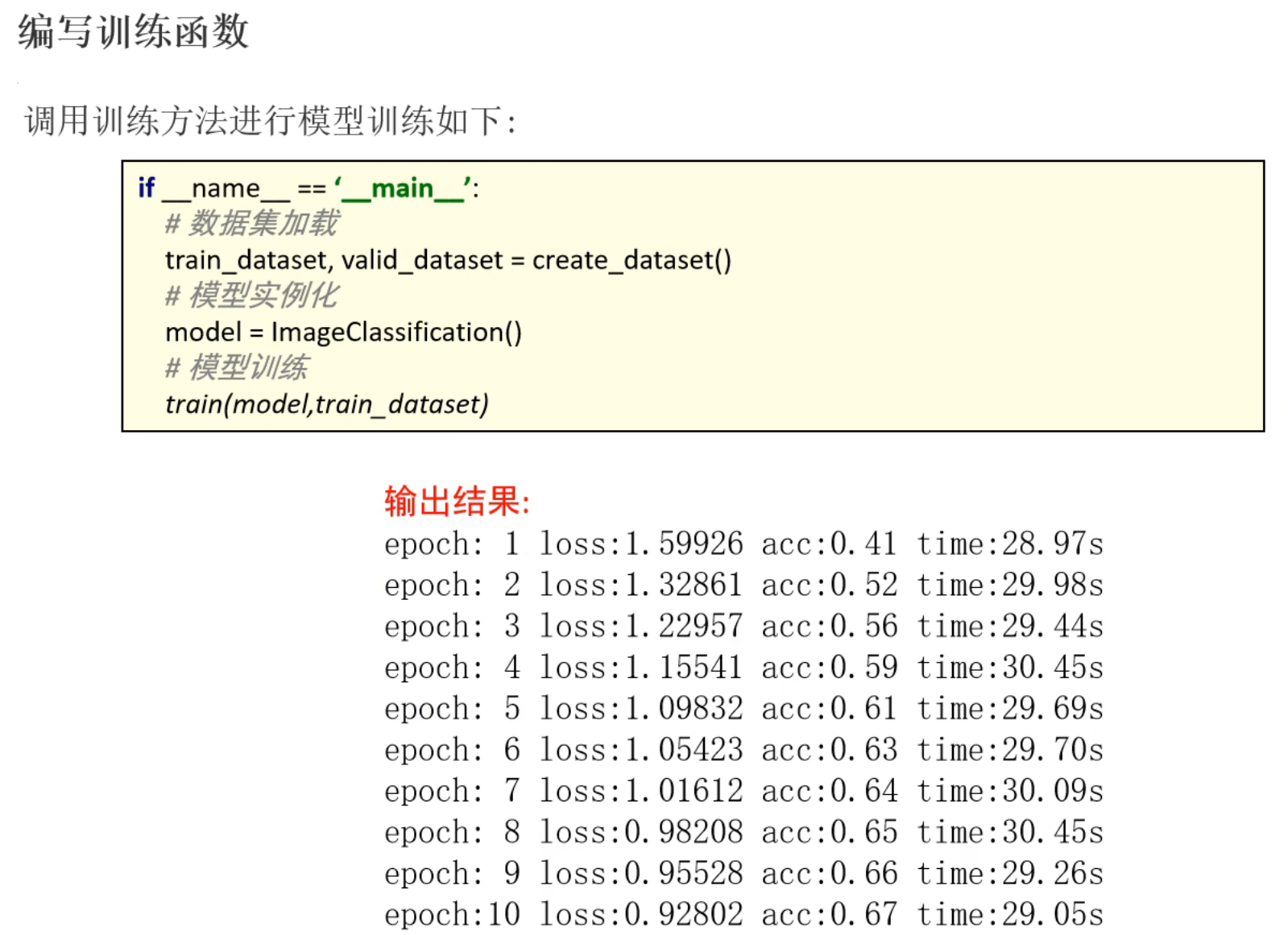

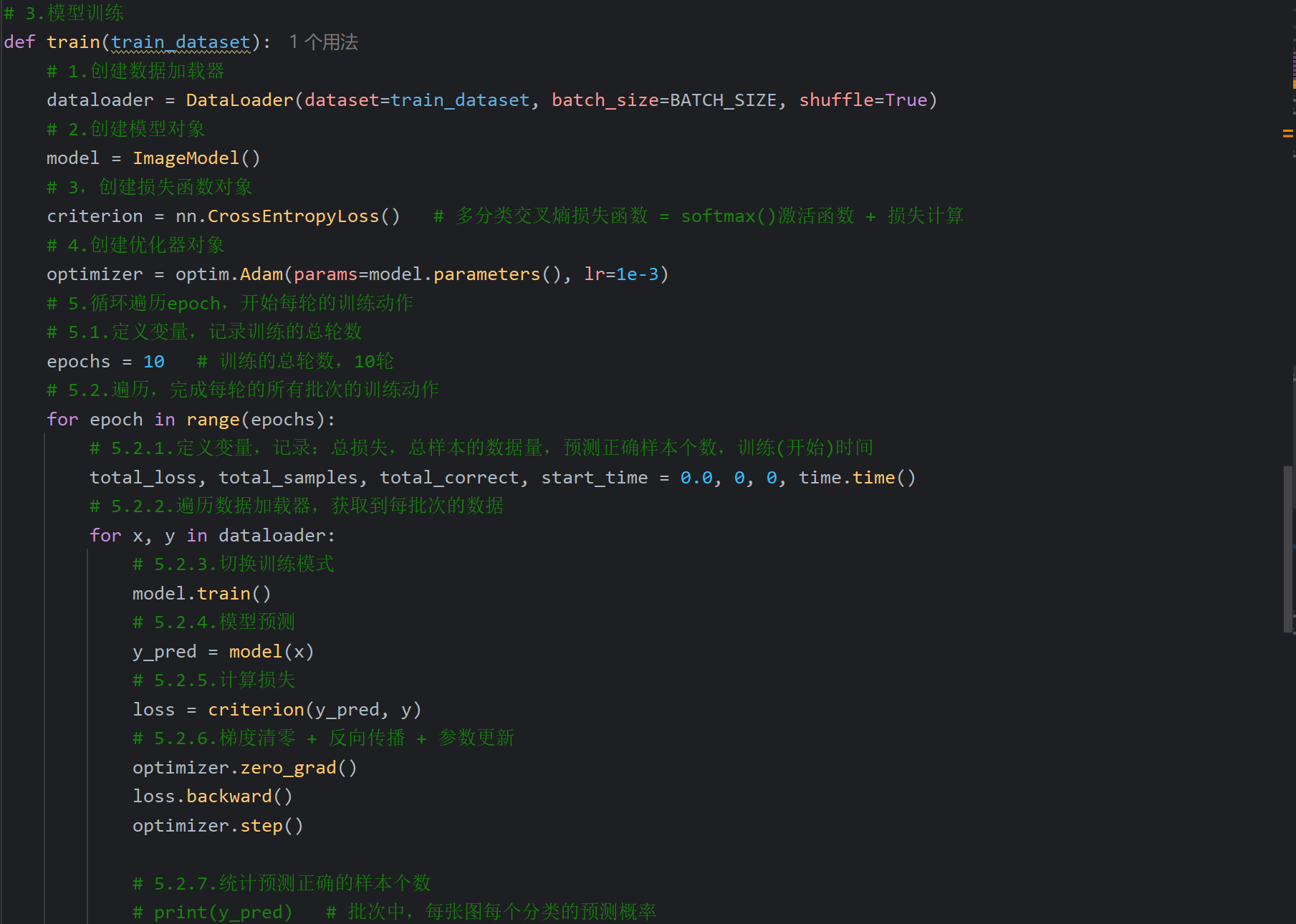

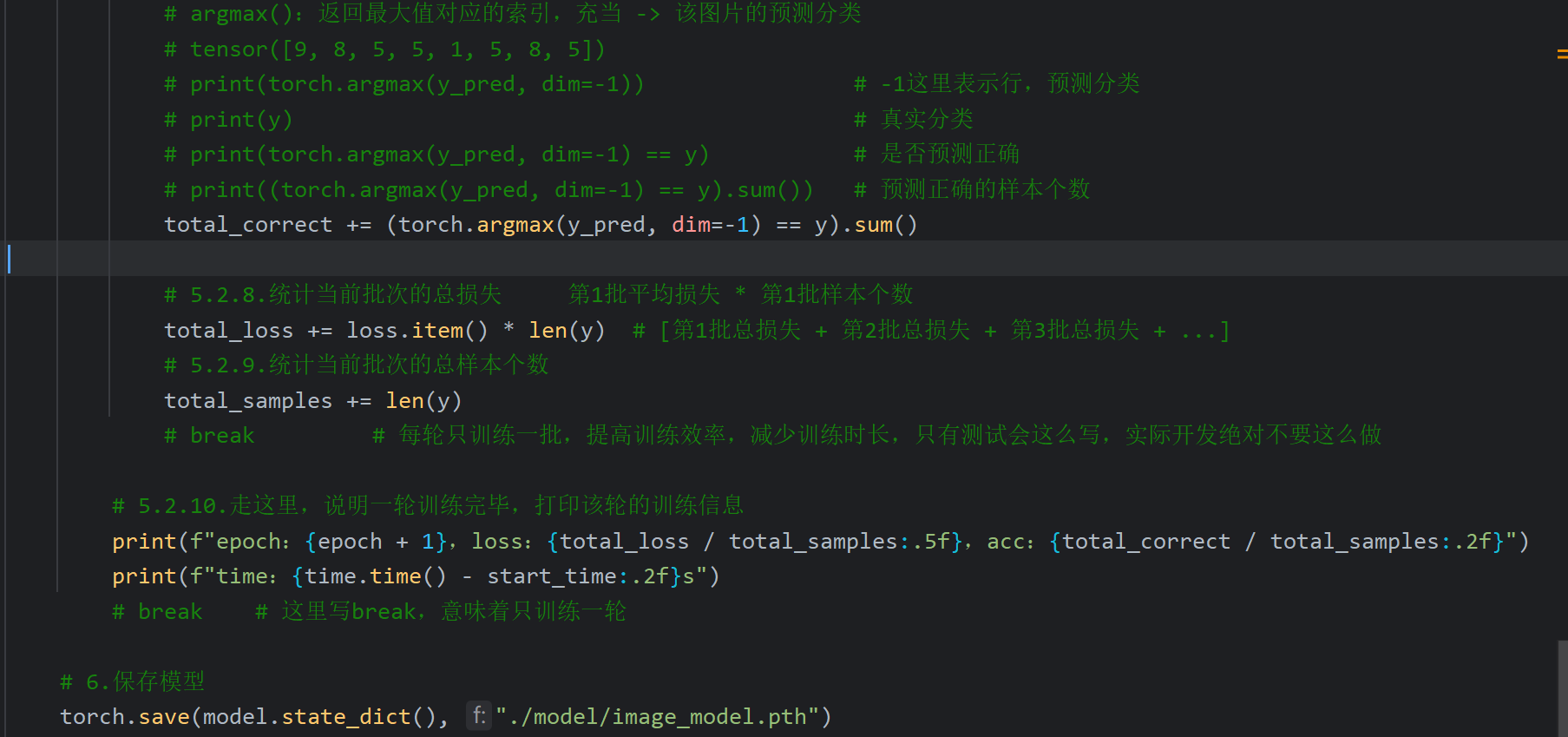

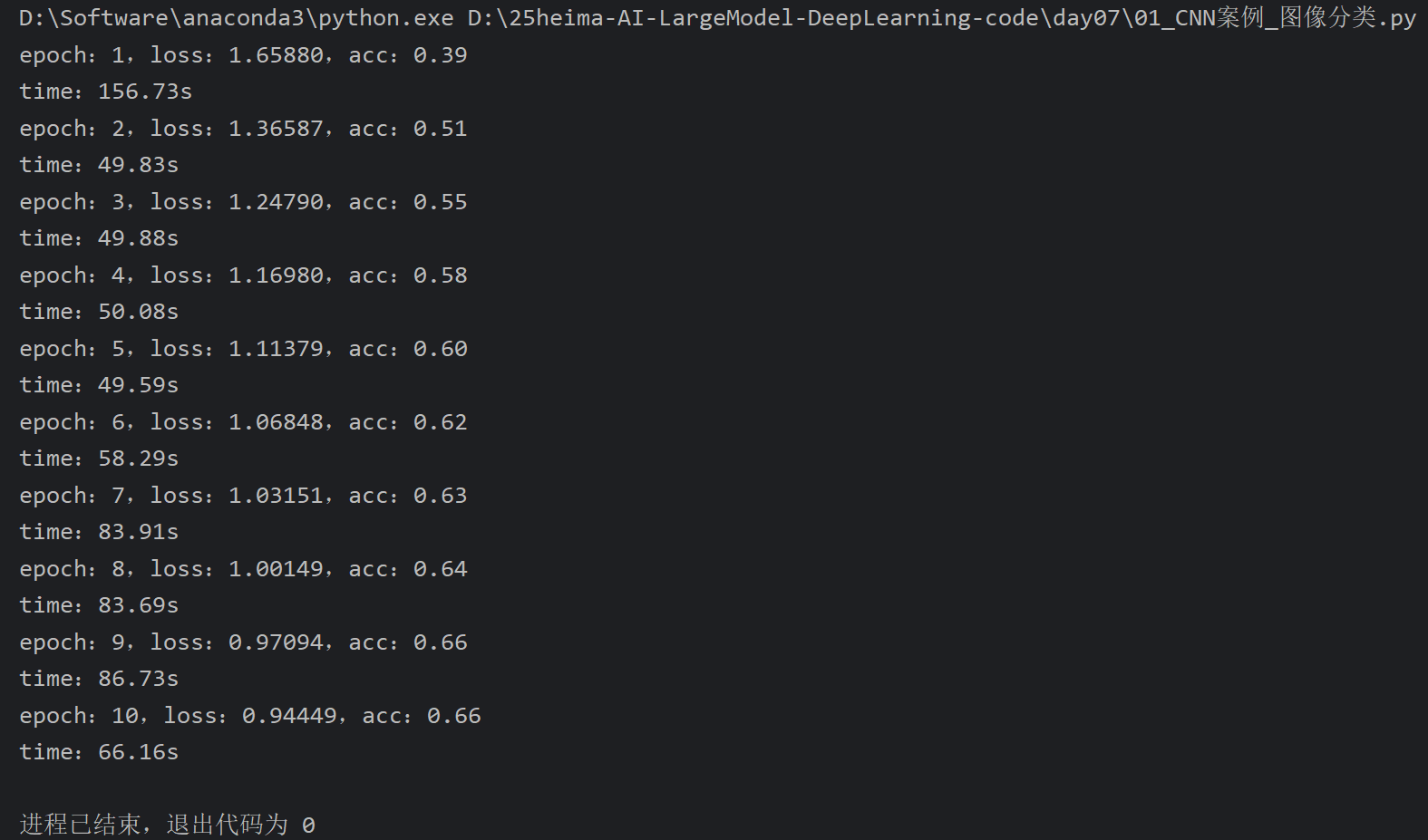

5、CNN图像分类案例_模型训练

我这里跑的还是比较慢的

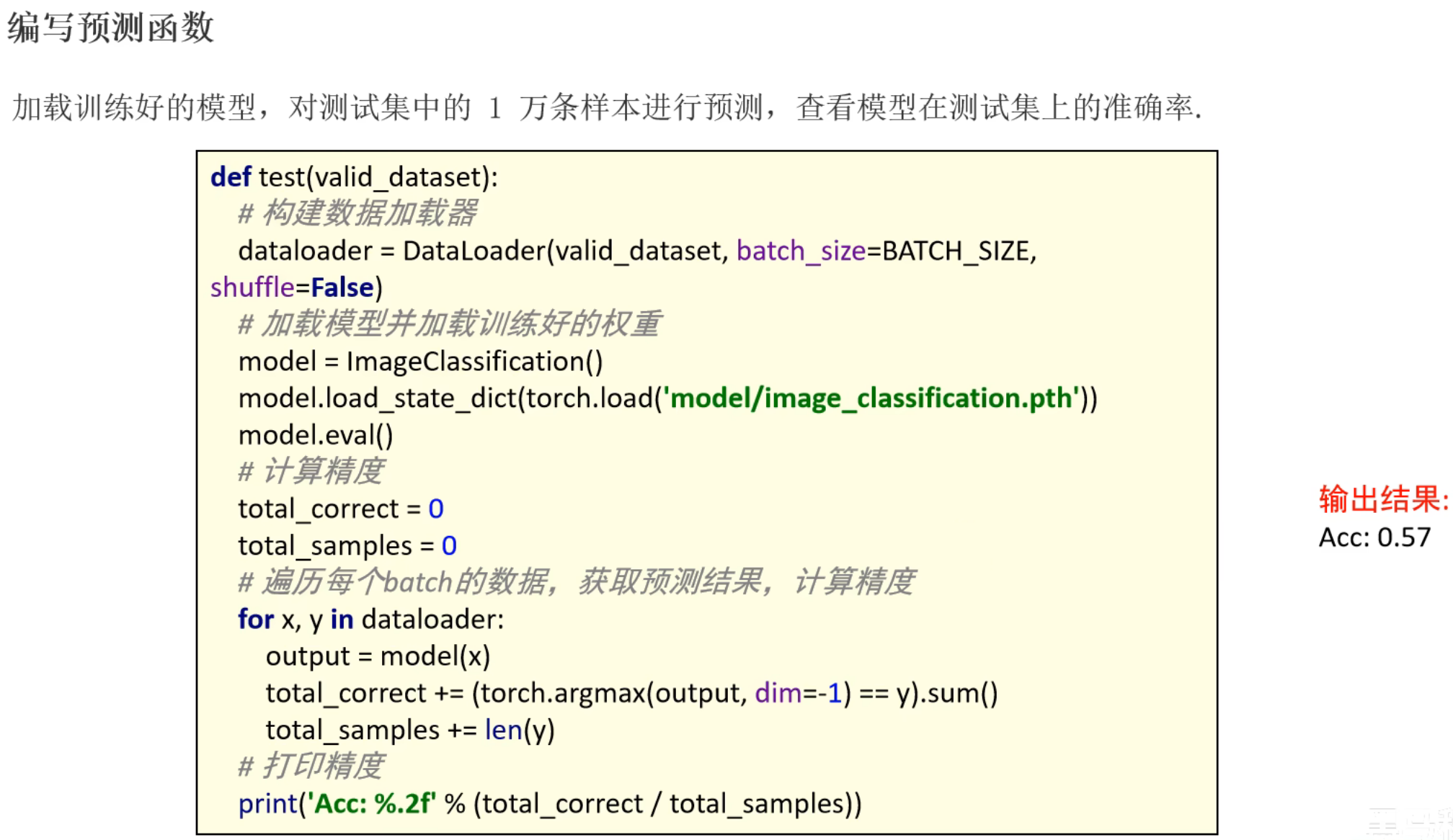

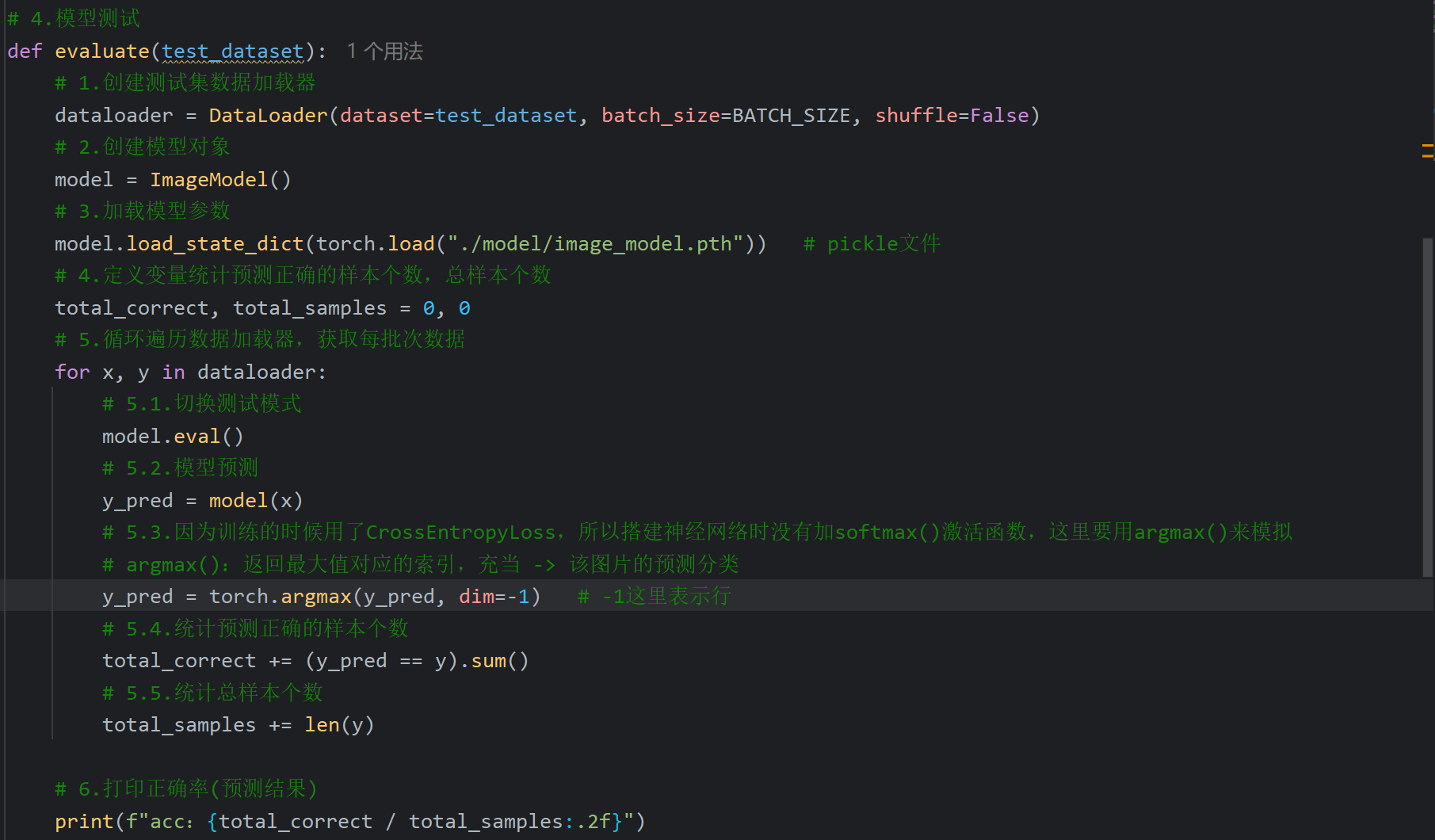

6、CNN图像分类案例_模型测试

7、CNN图像分类案例_优化及总结

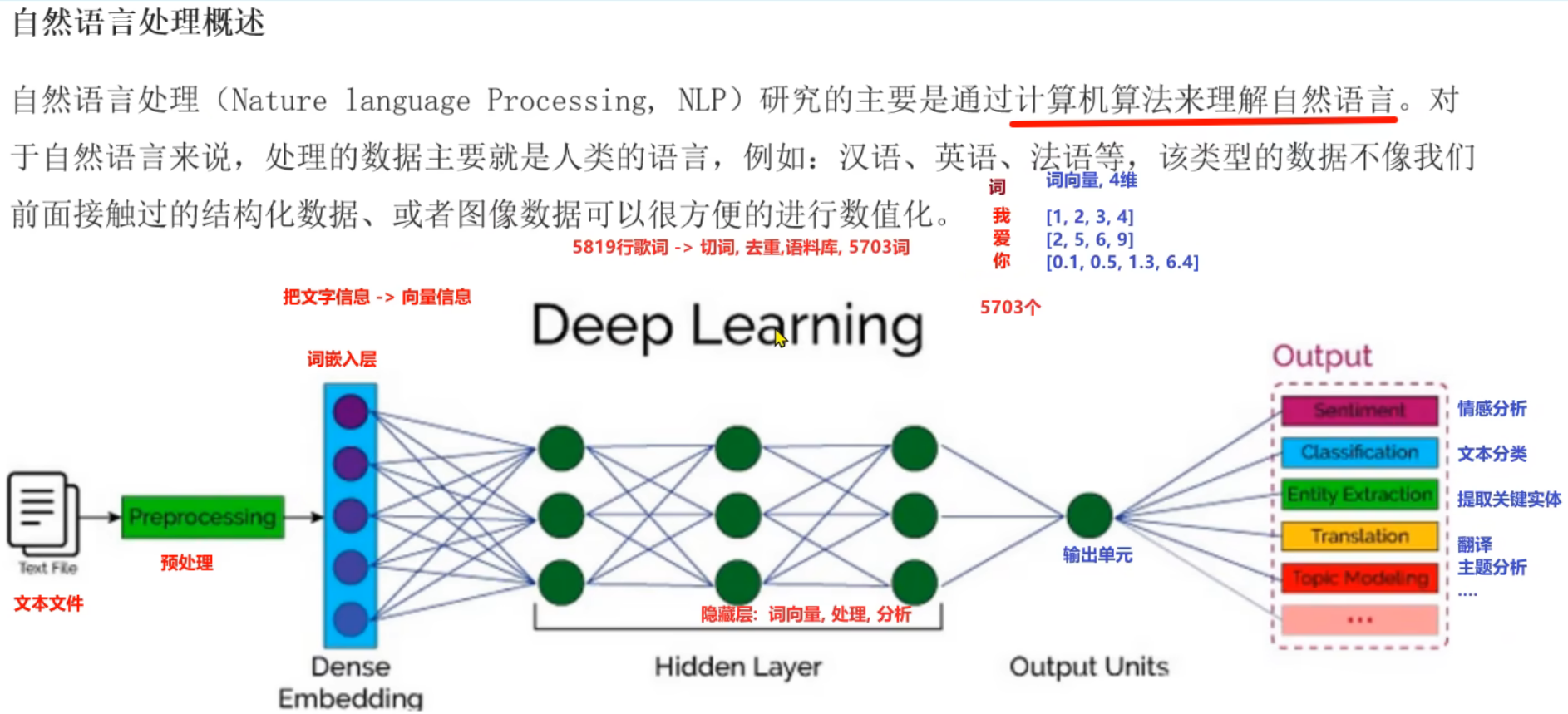

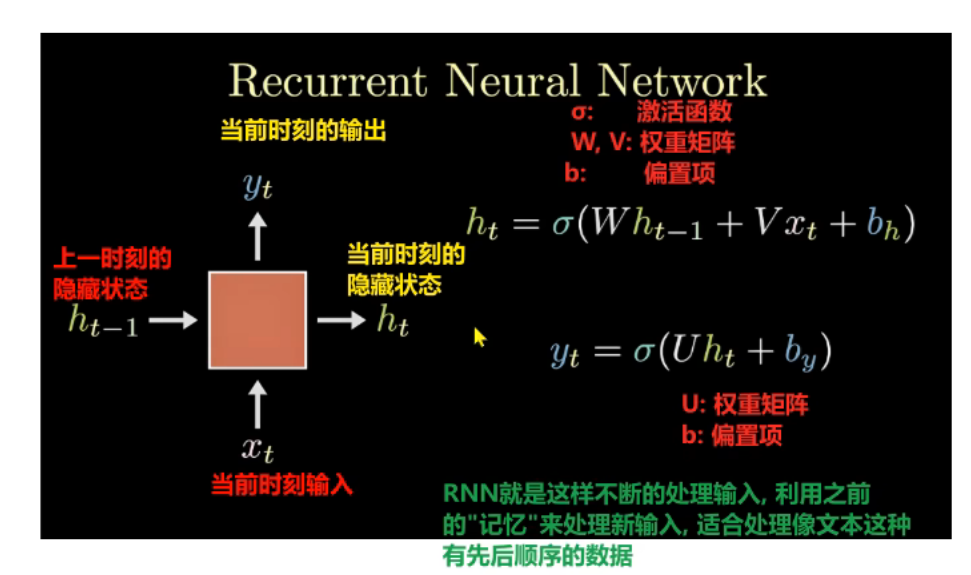

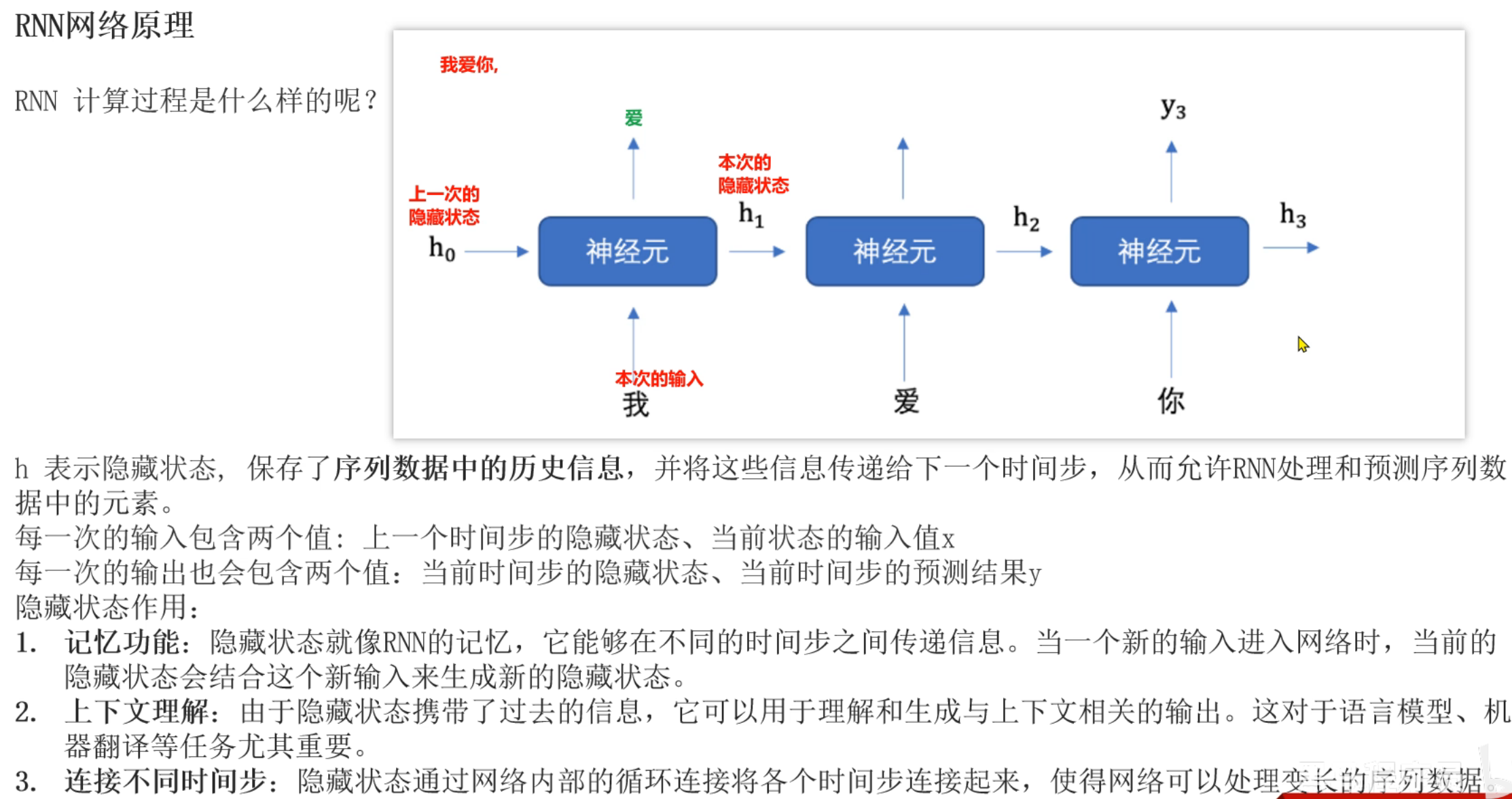

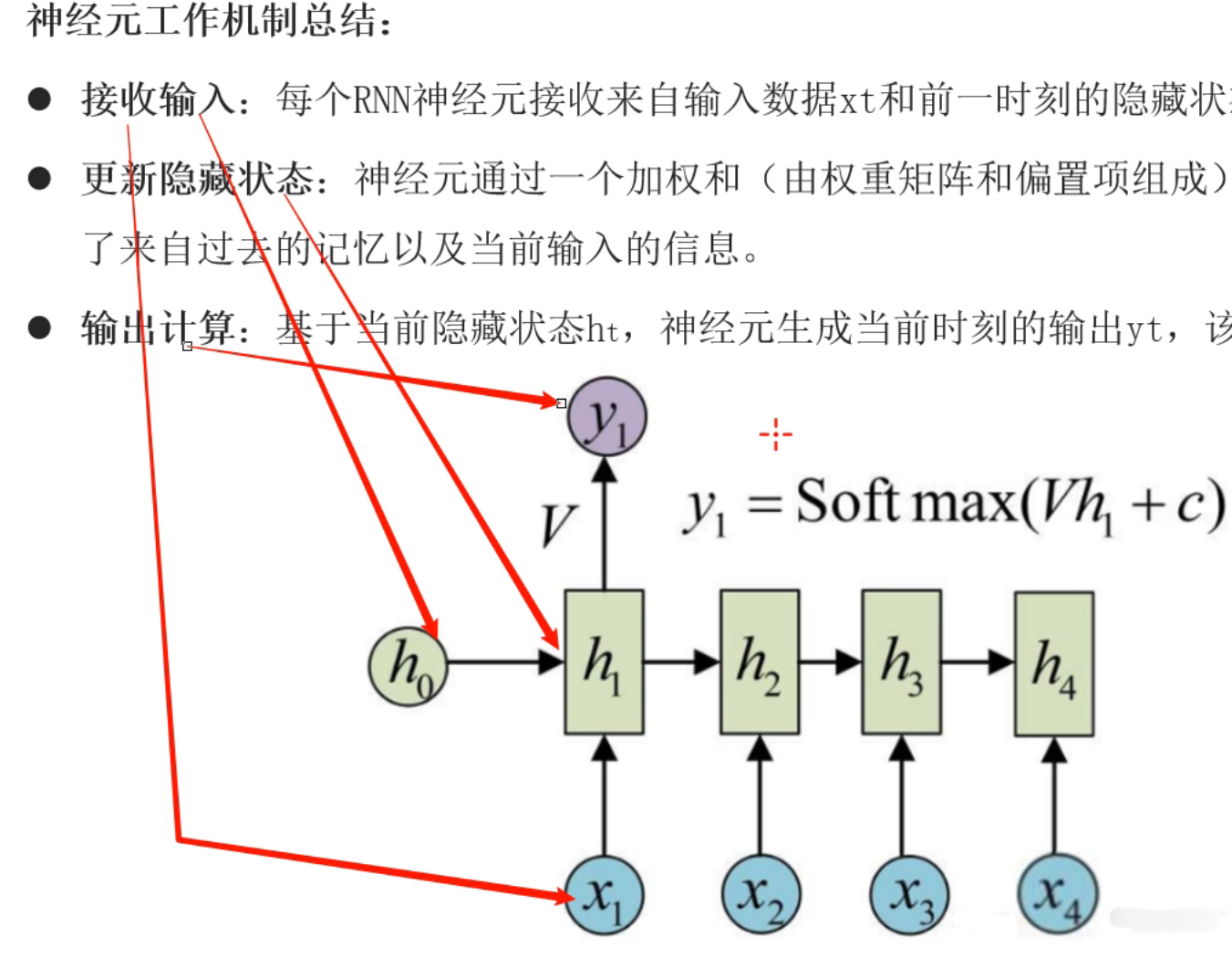

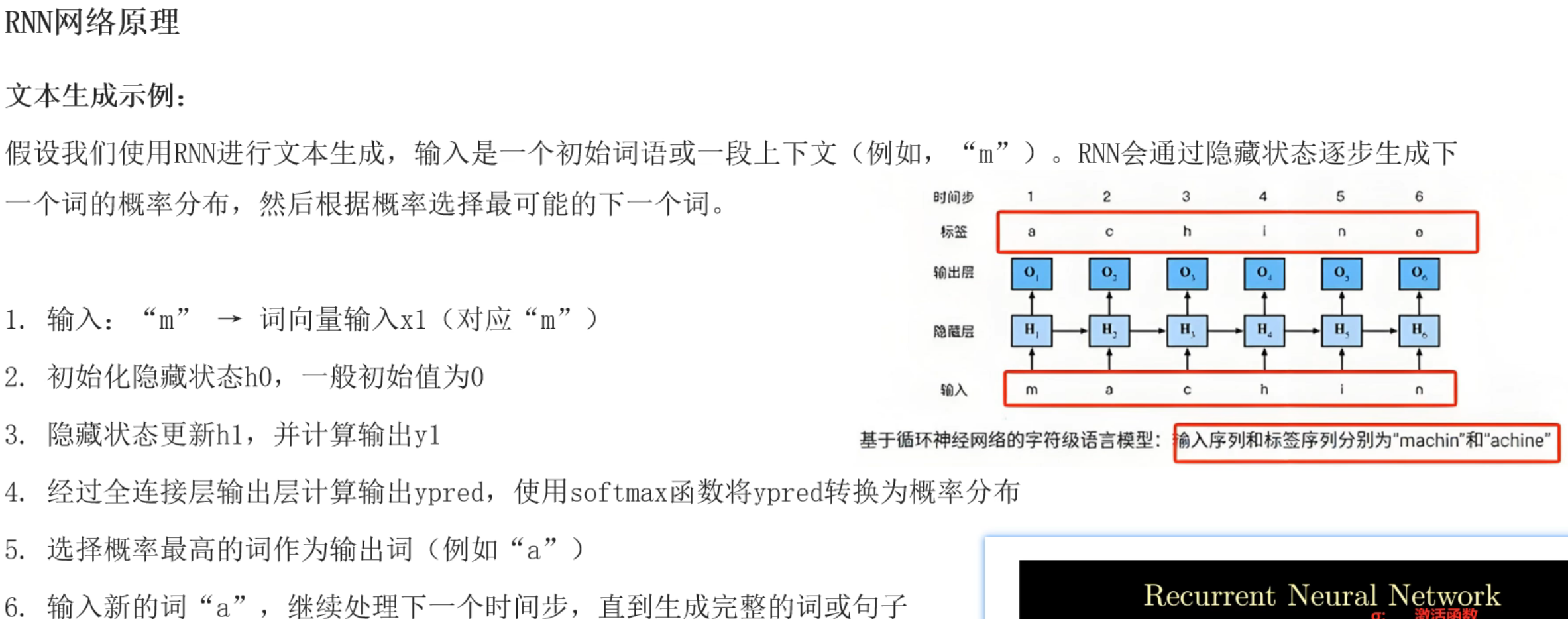

8、RNN介绍

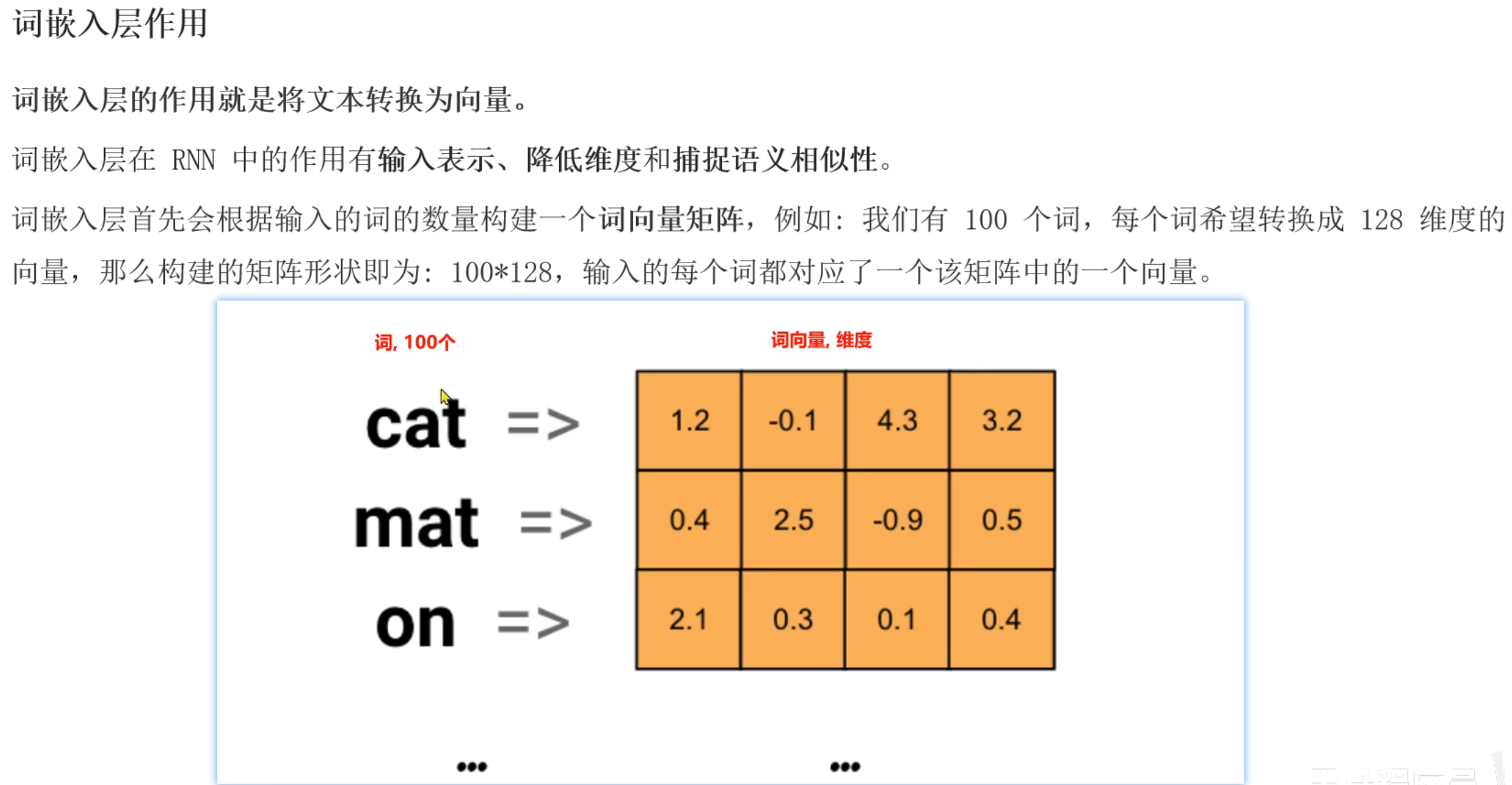

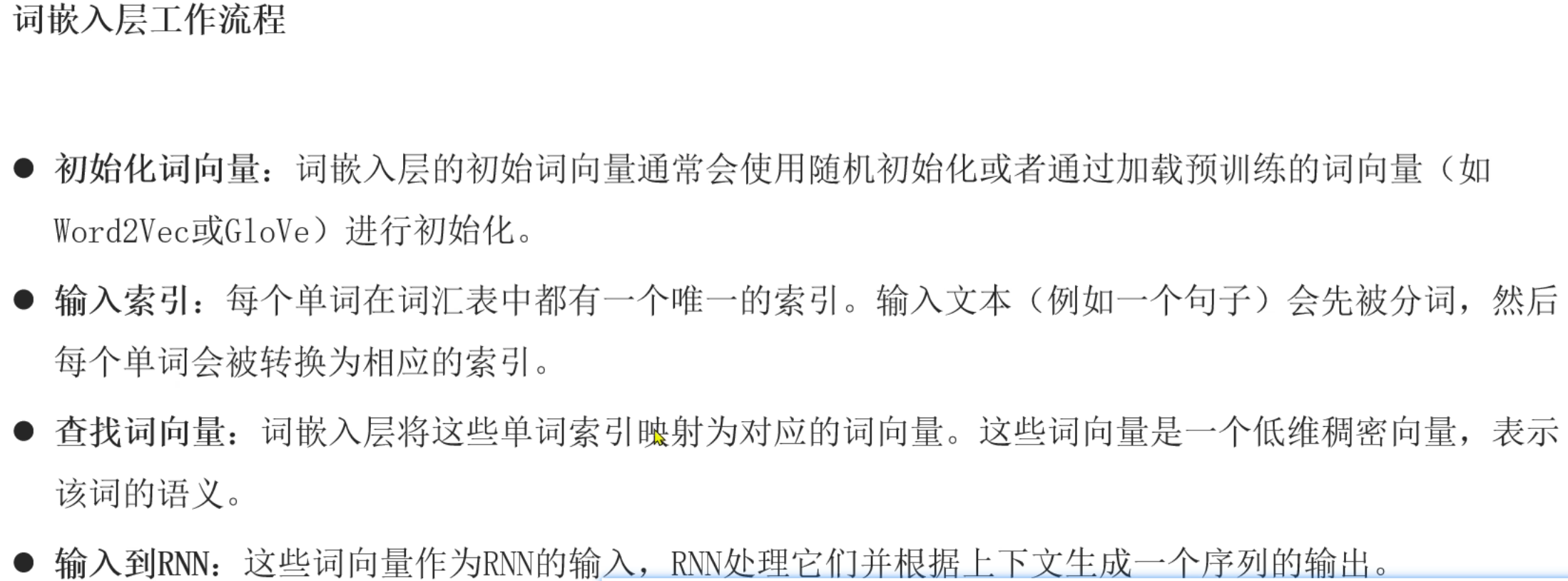

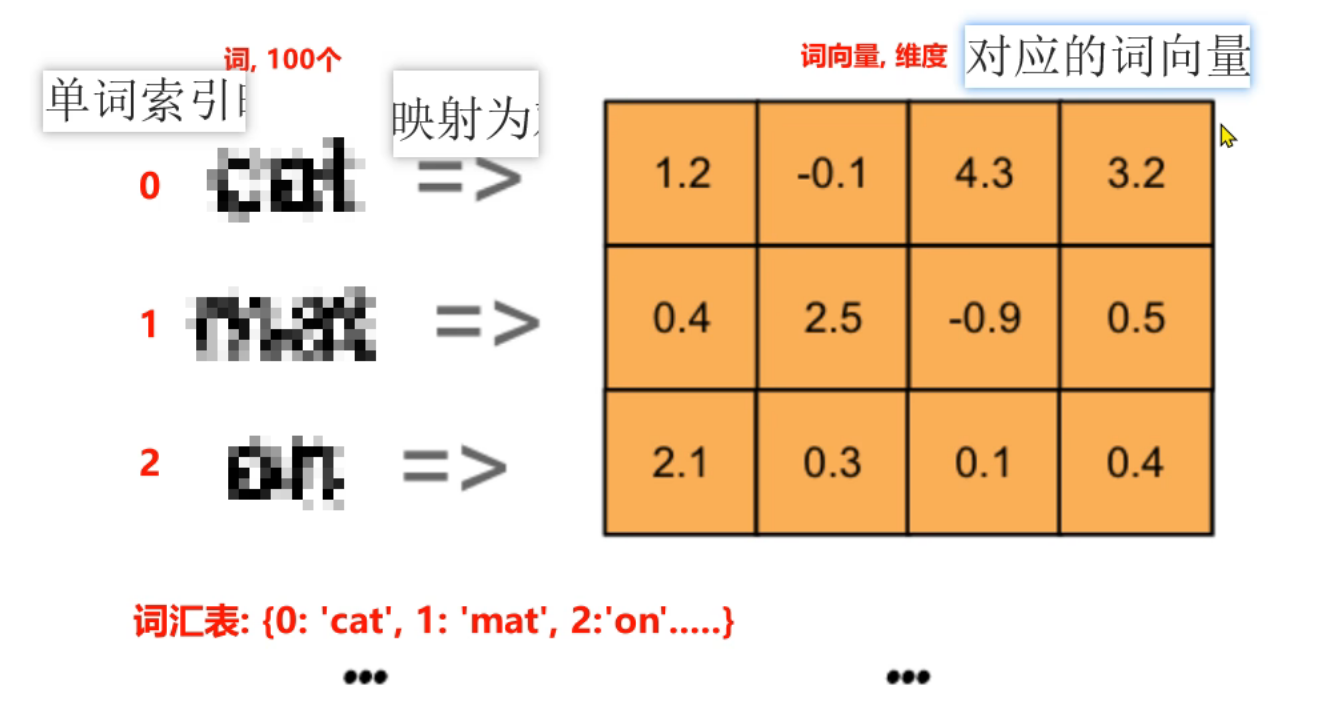

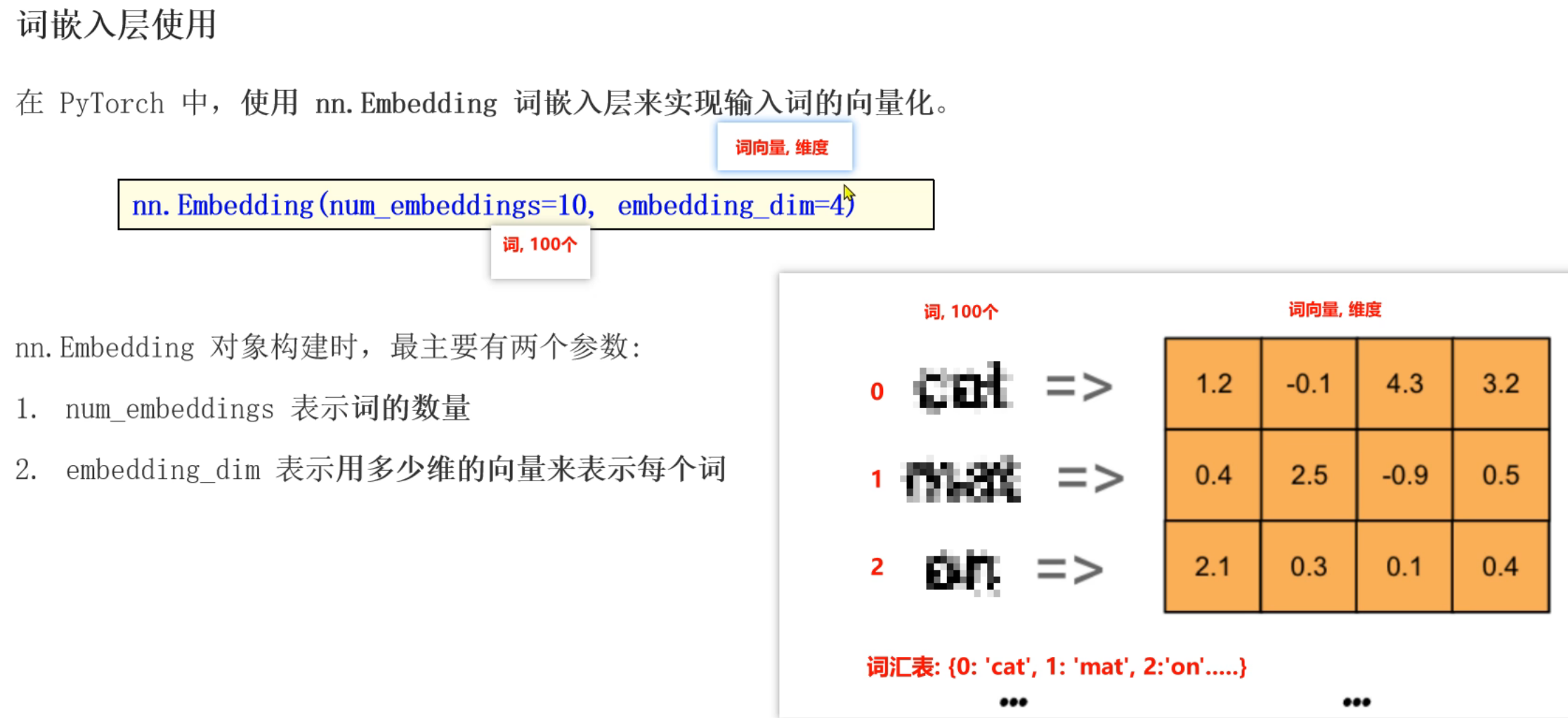

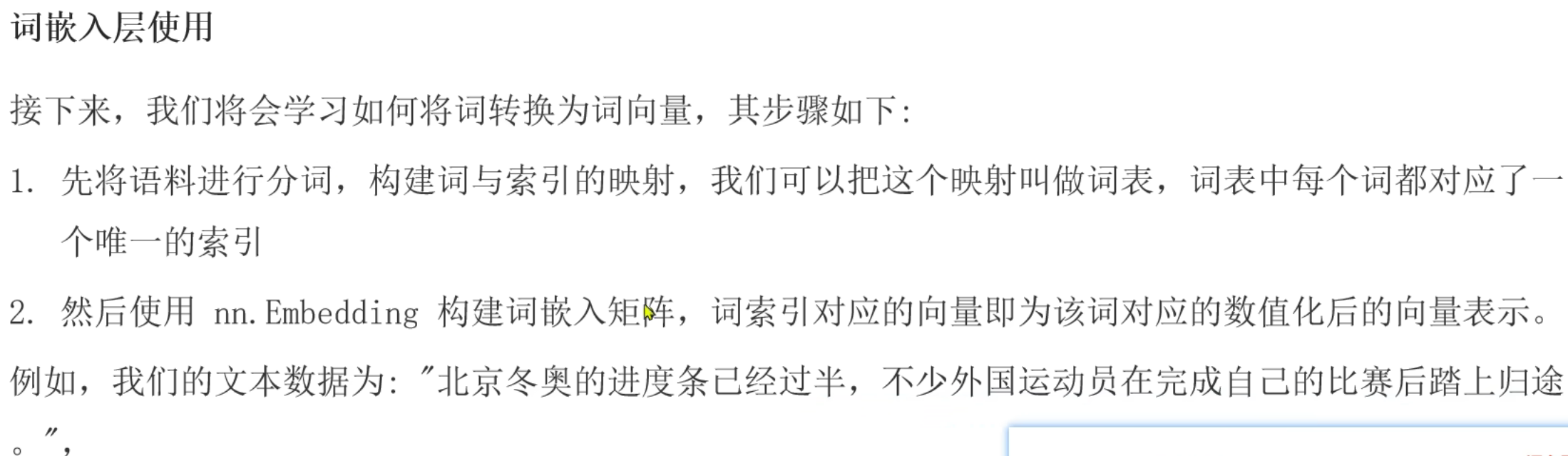

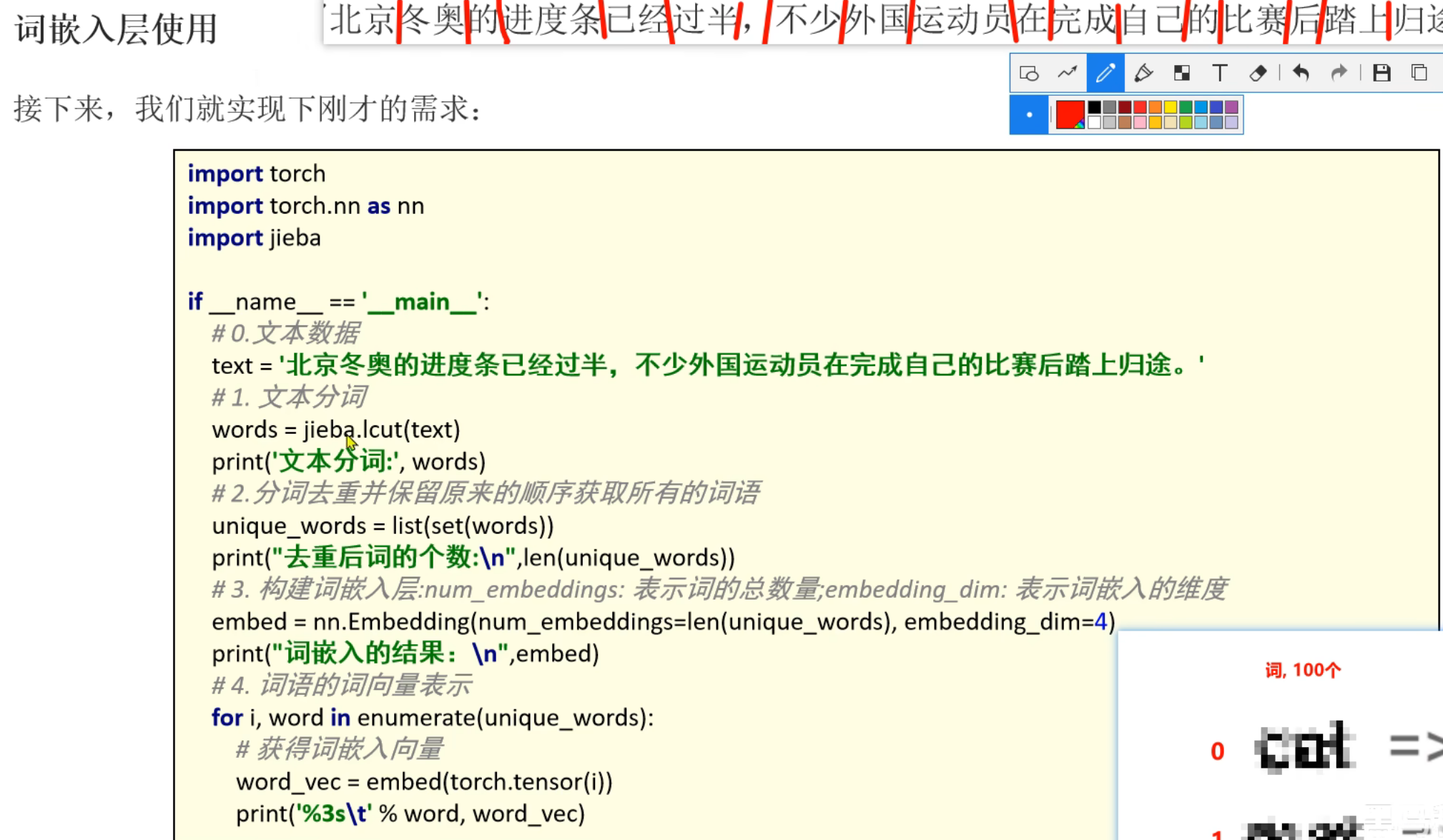

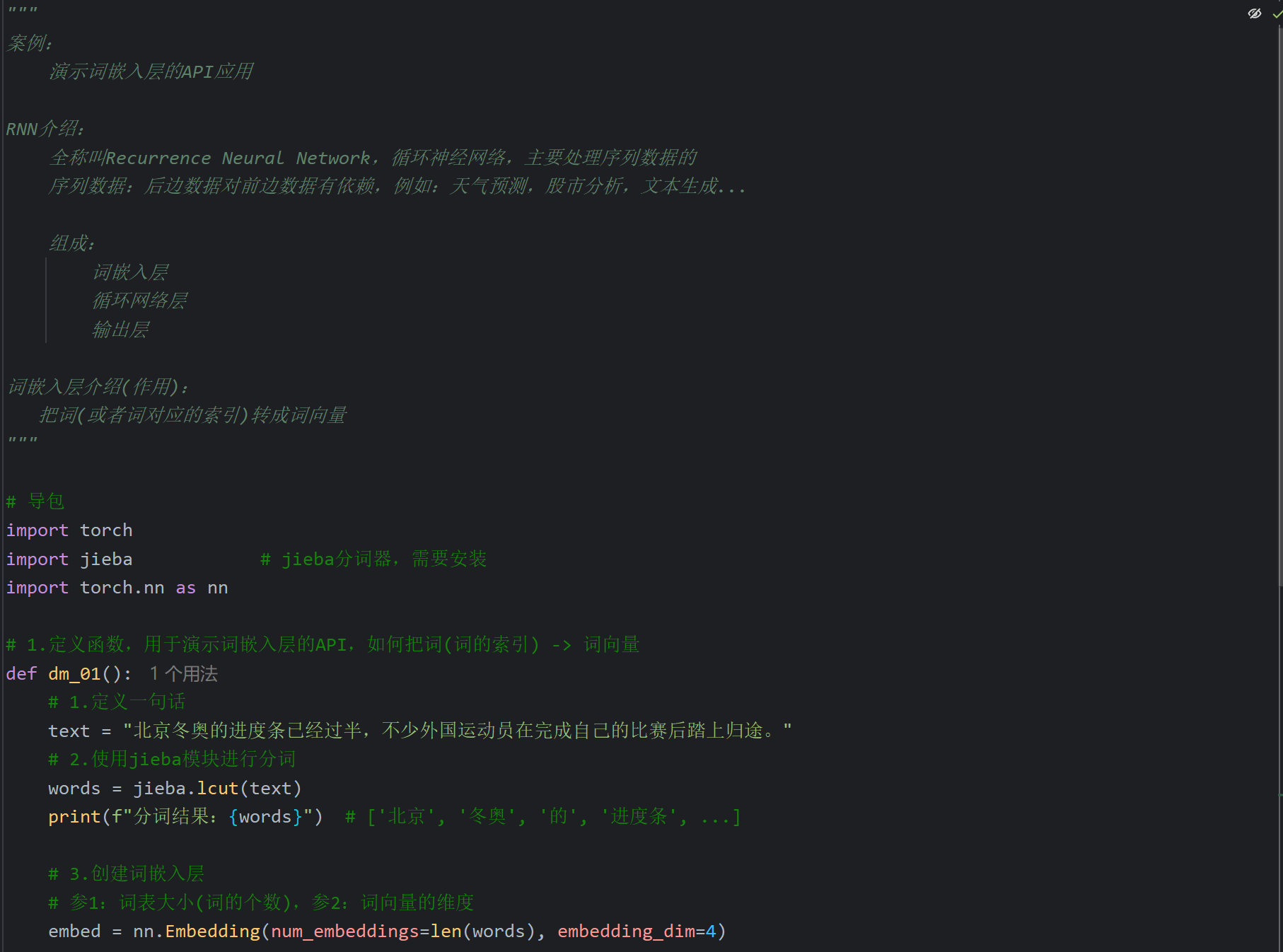

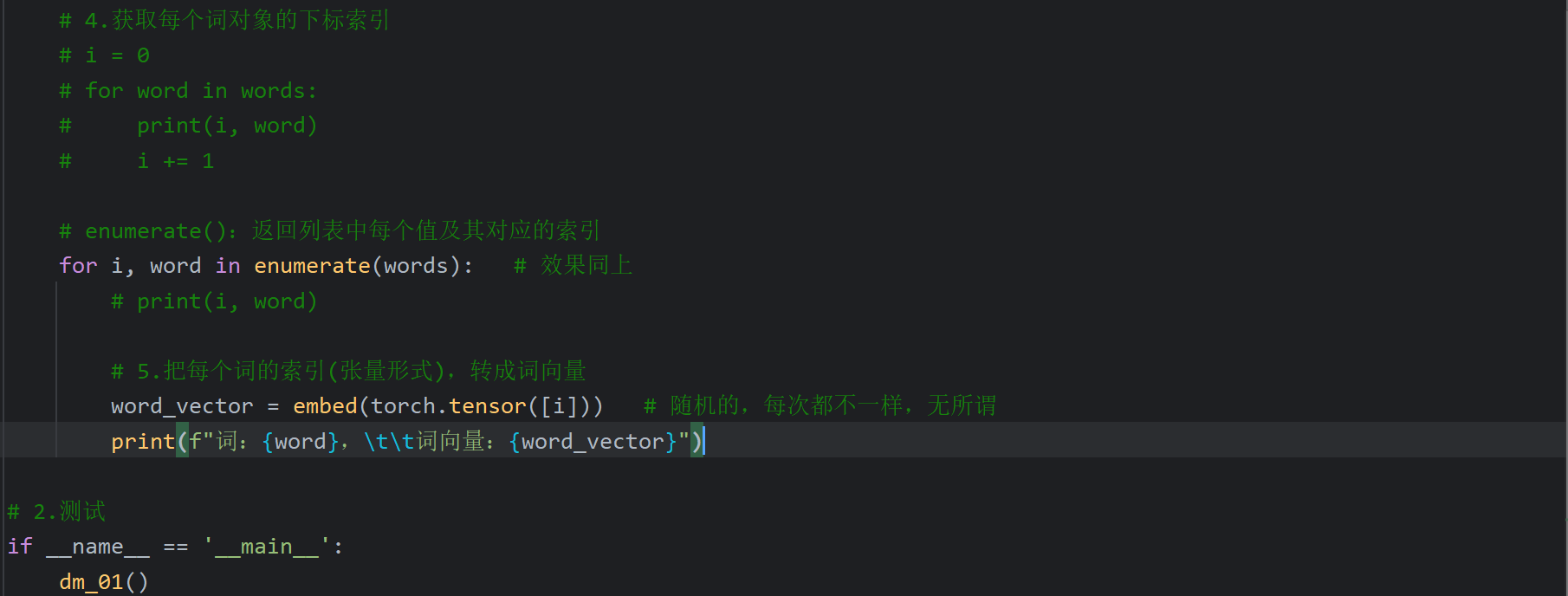

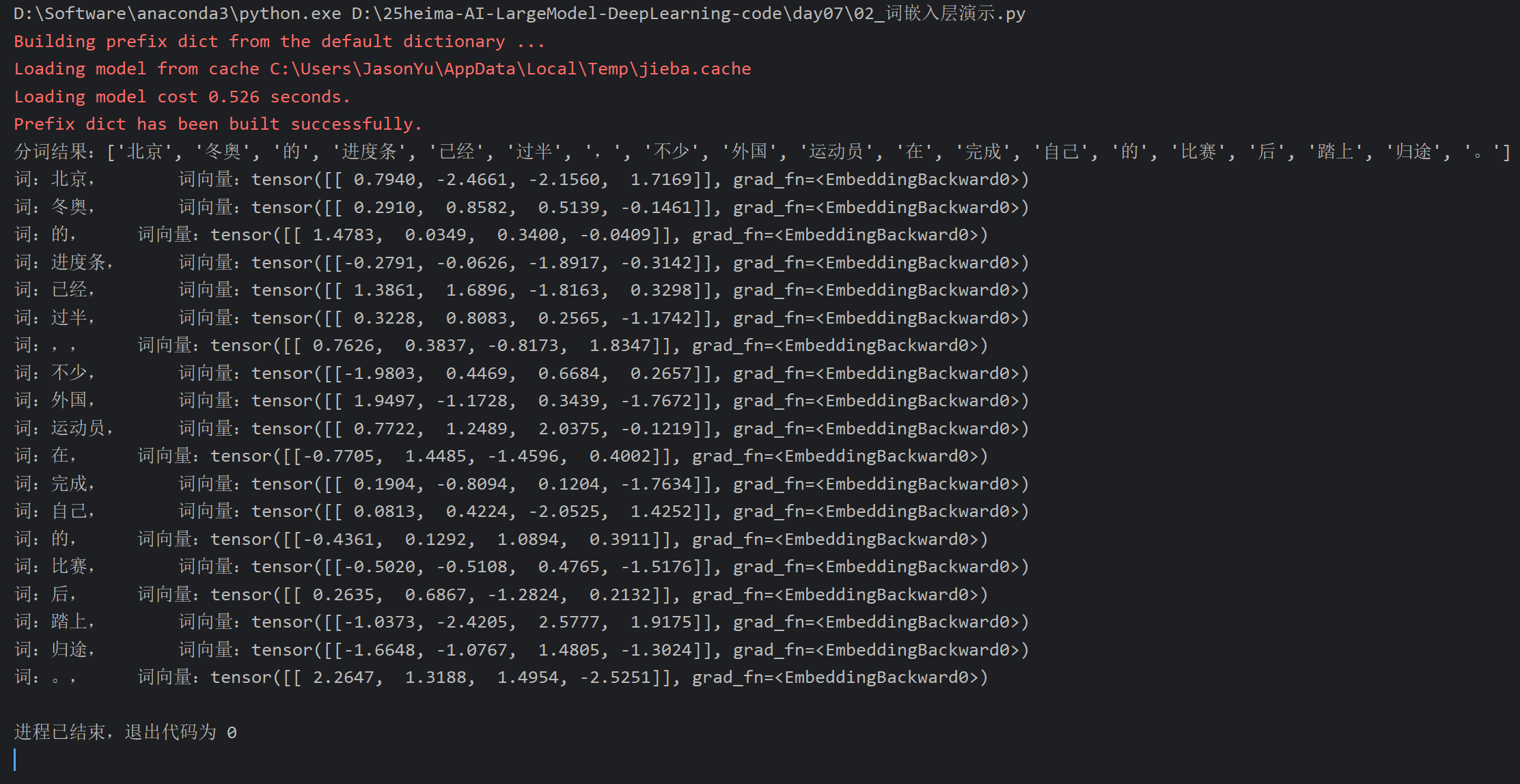

9、词嵌入层_解释

10、词嵌入层_API演示

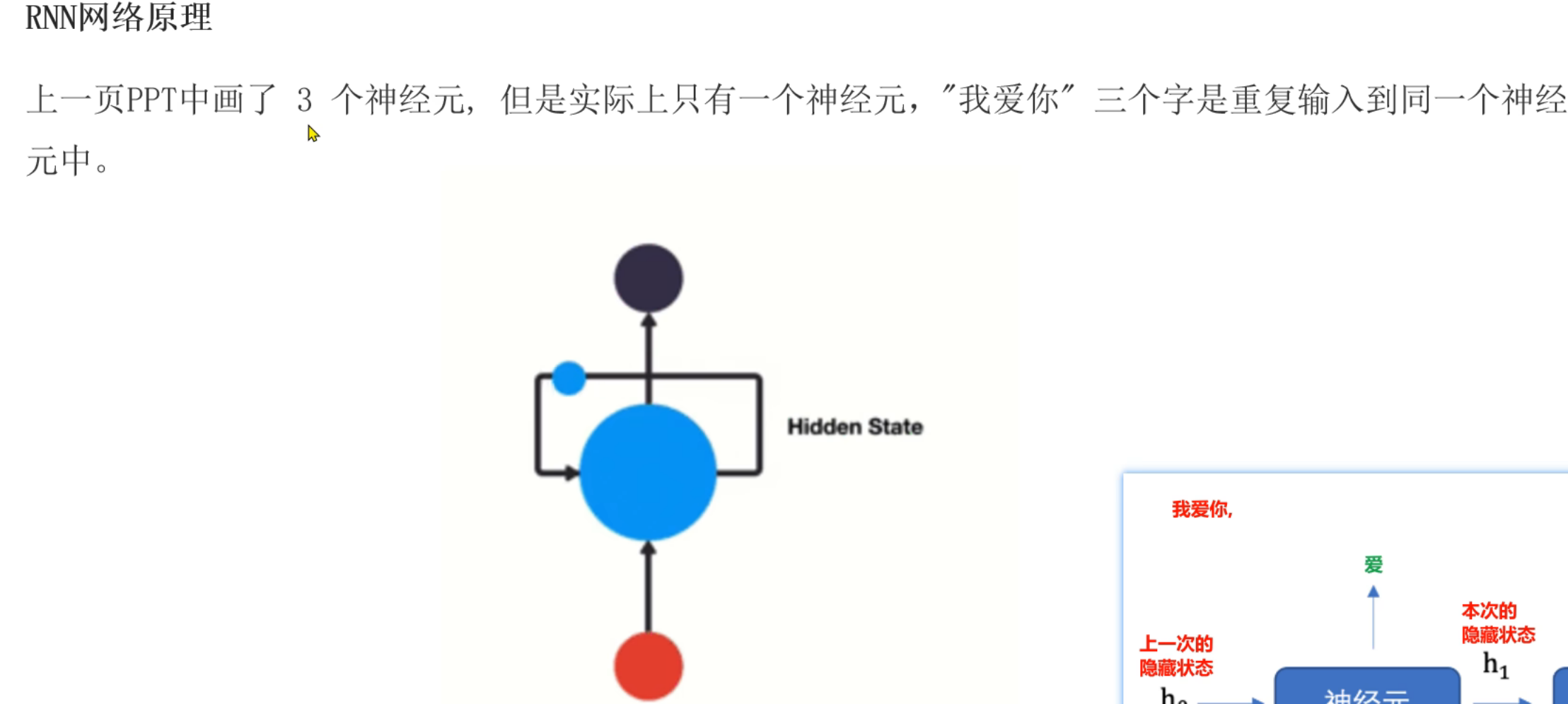

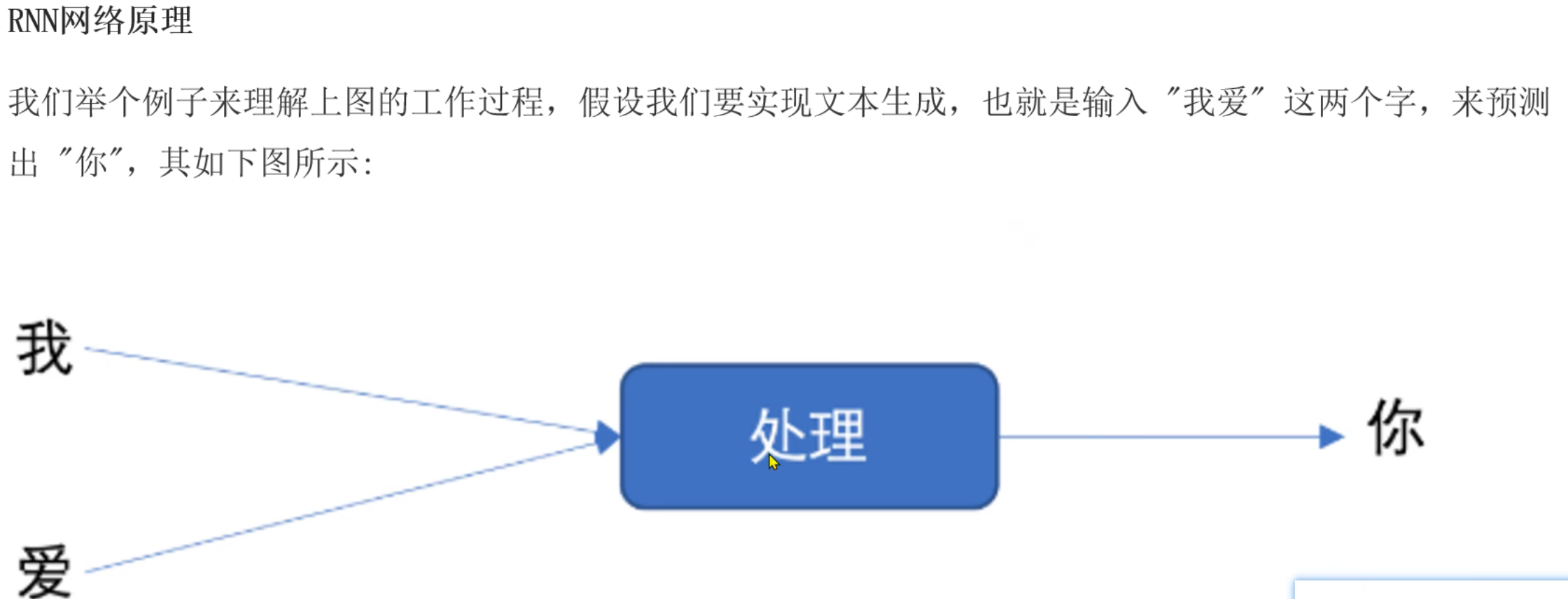

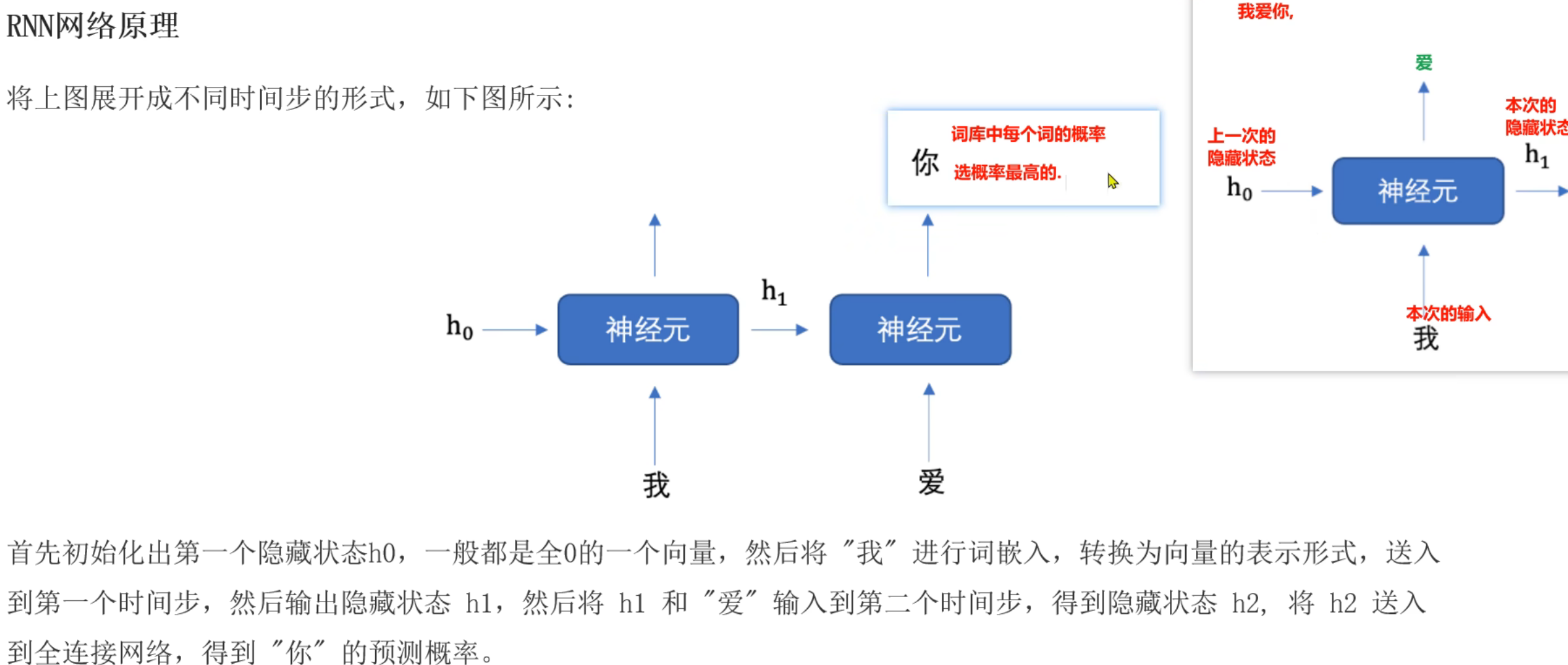

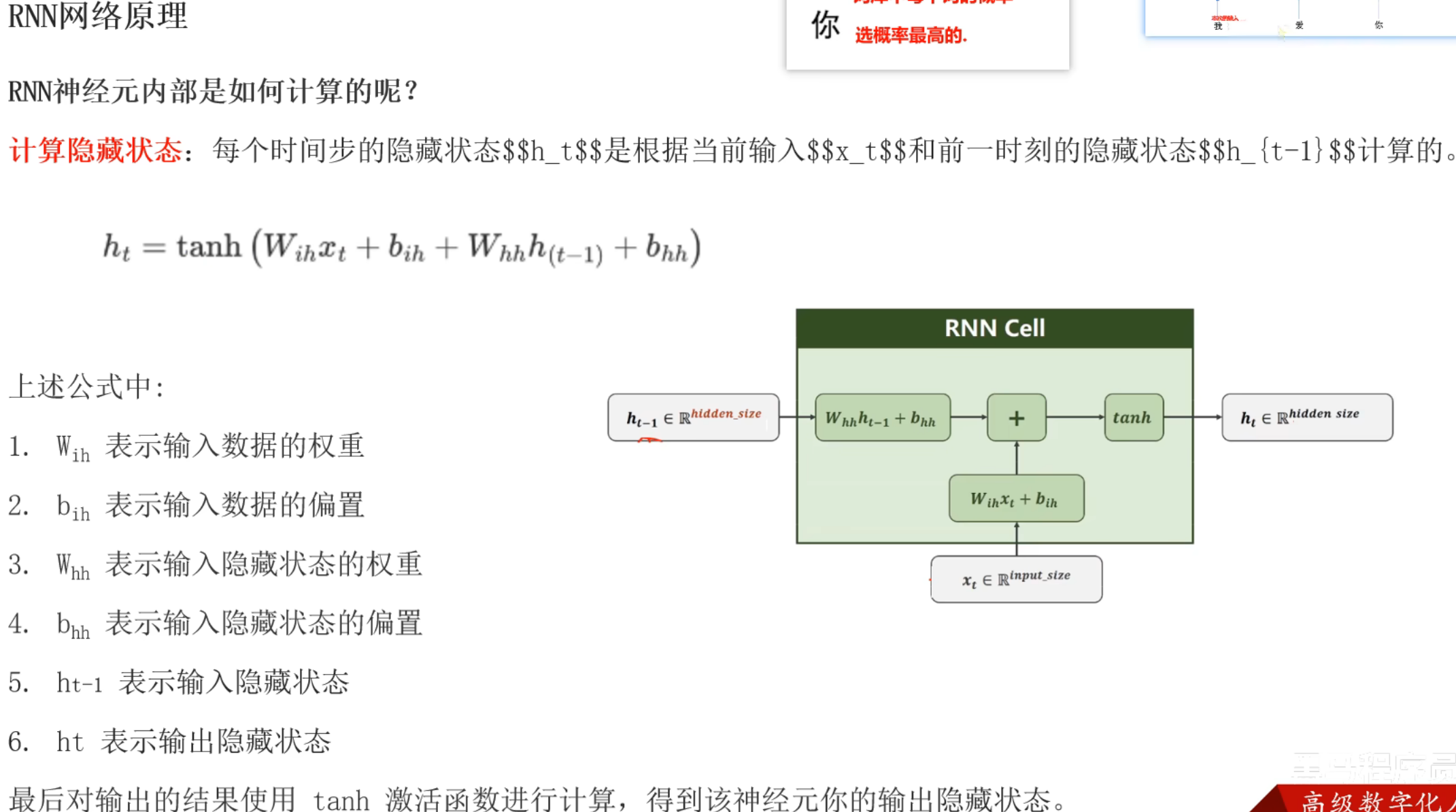

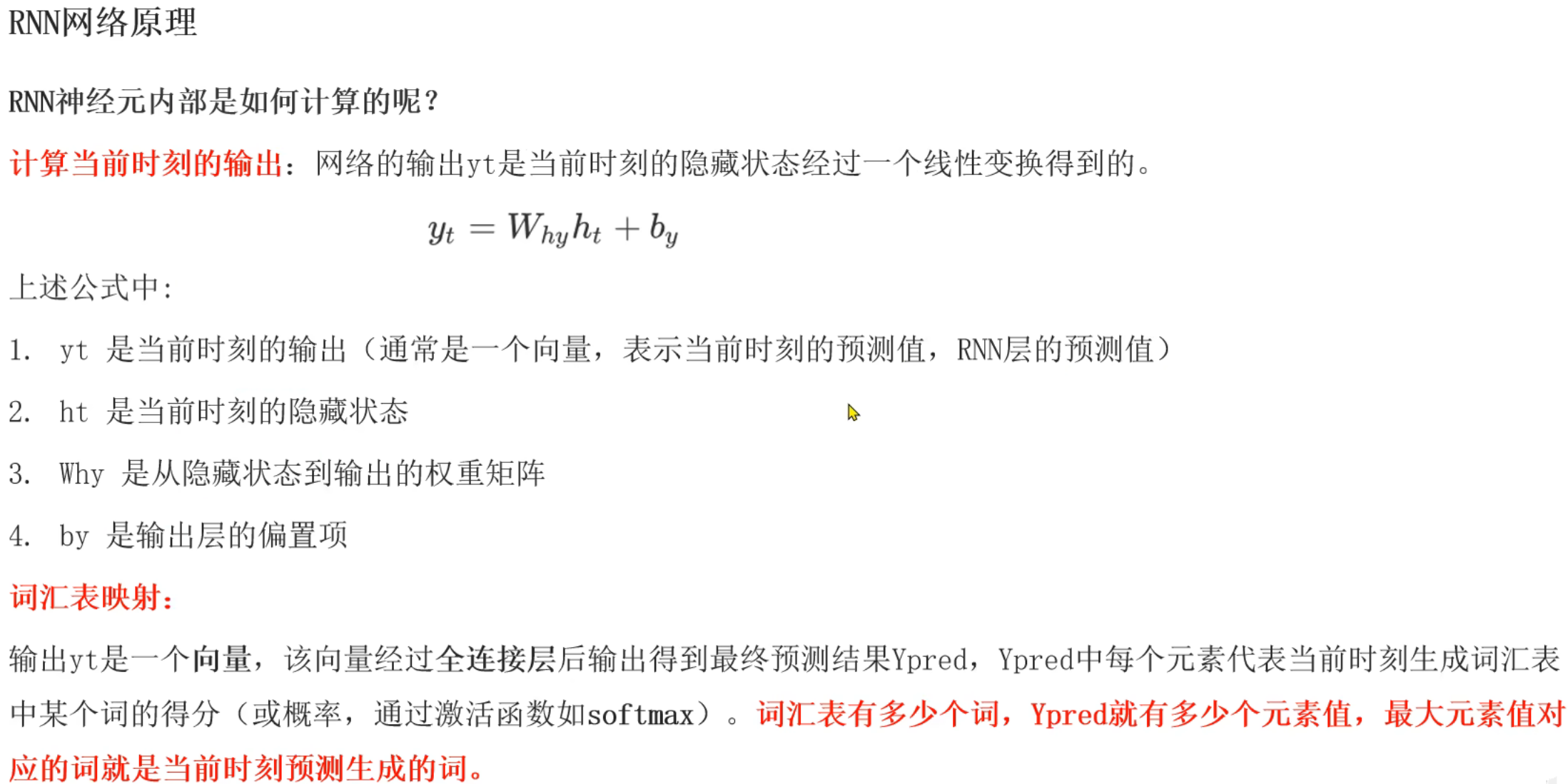

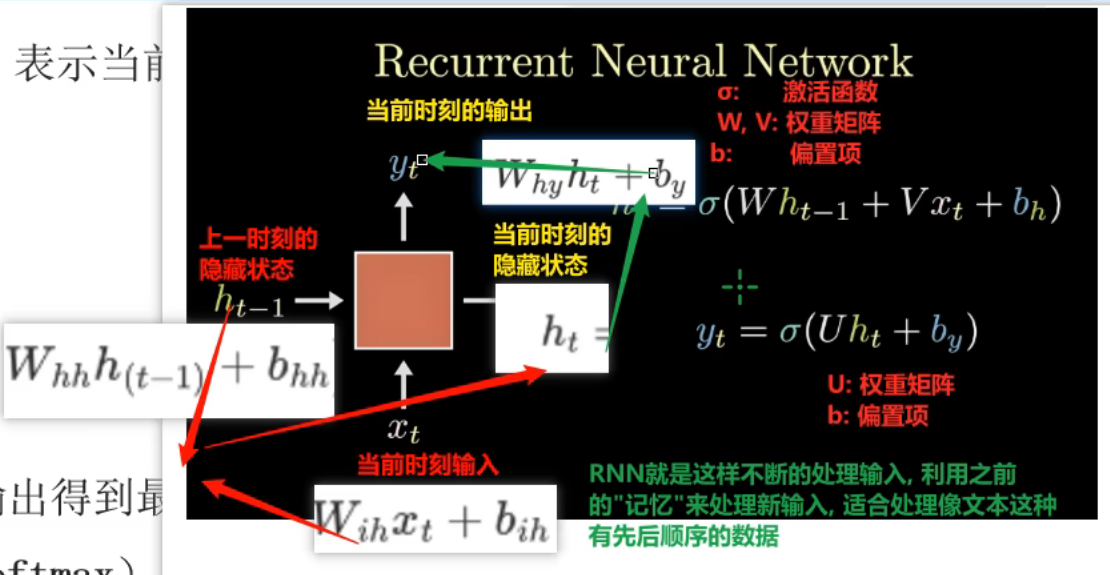

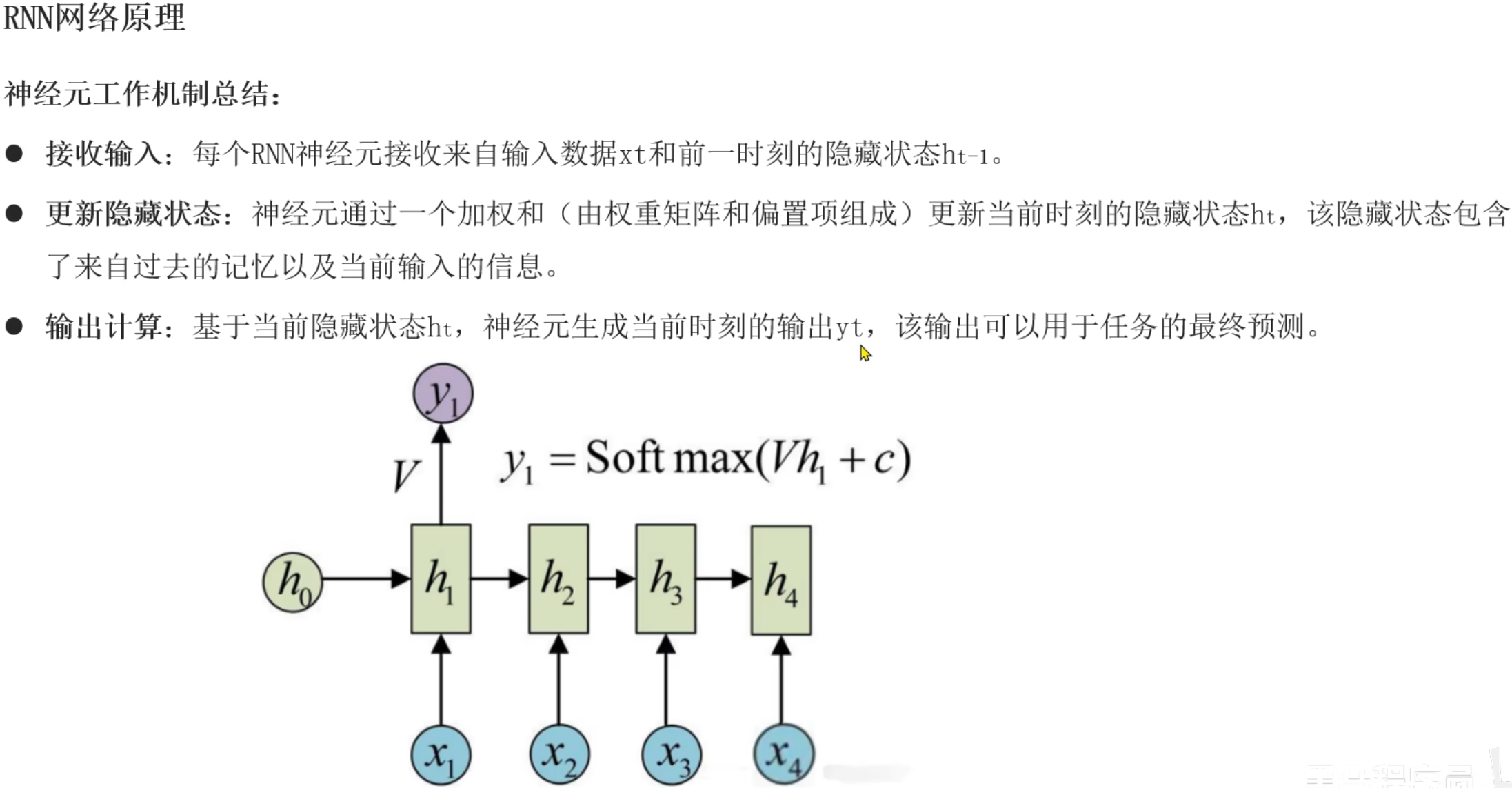

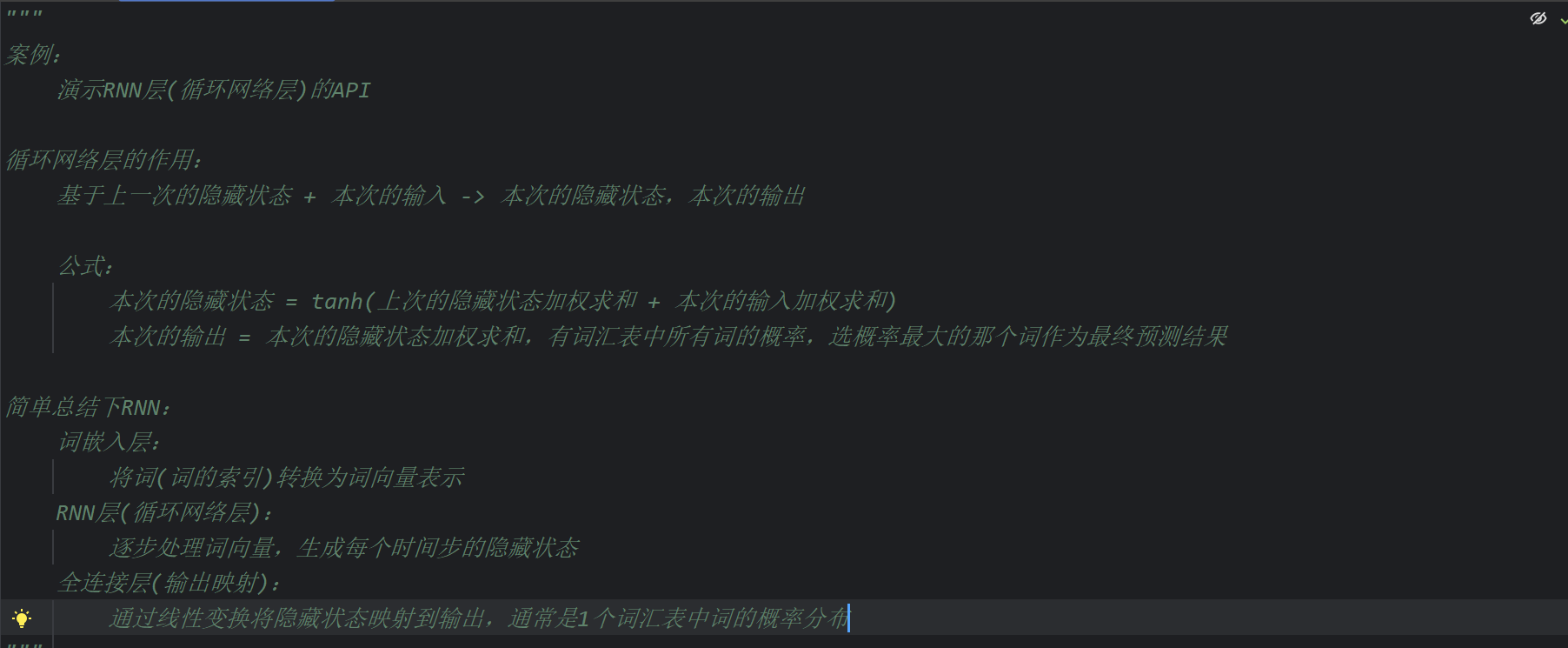

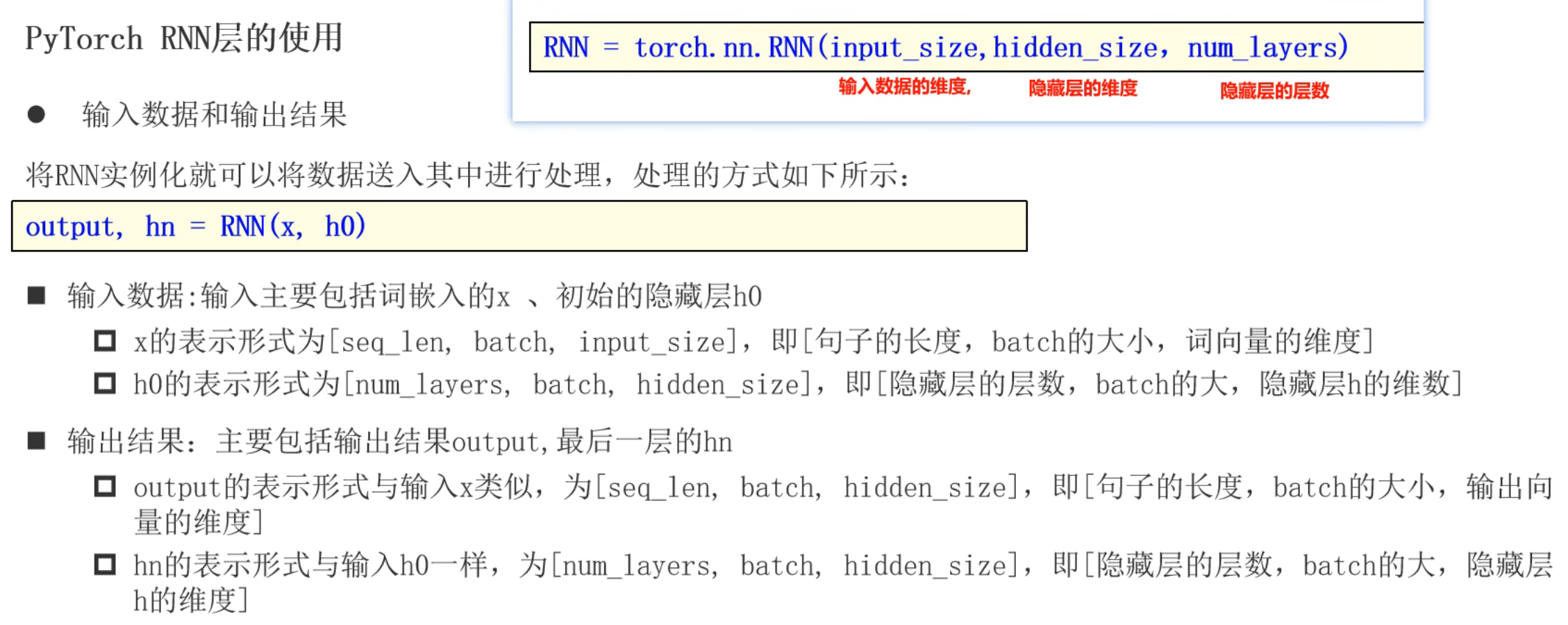

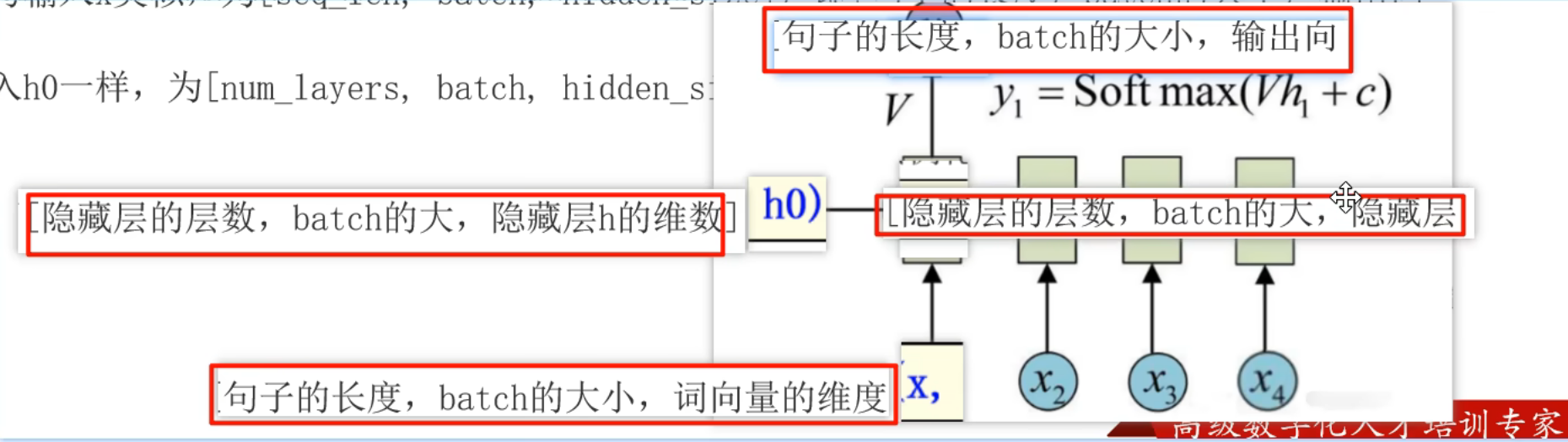

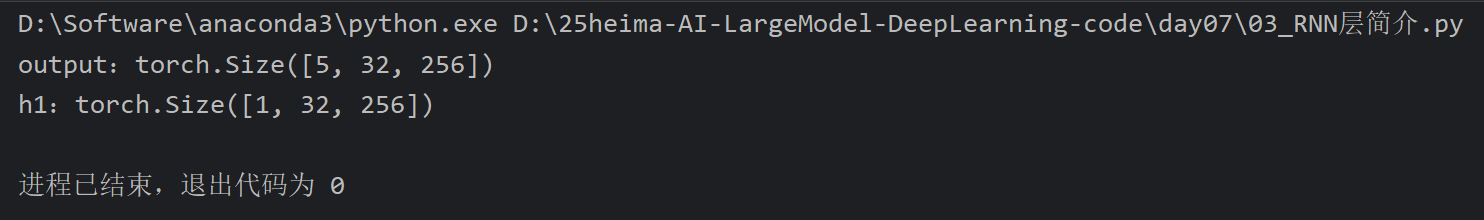

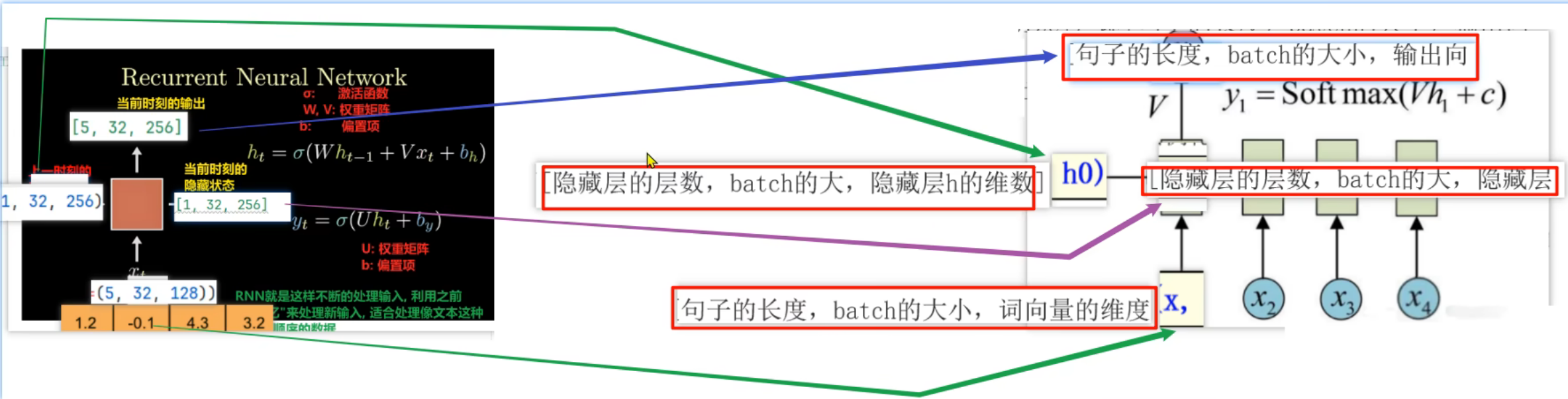

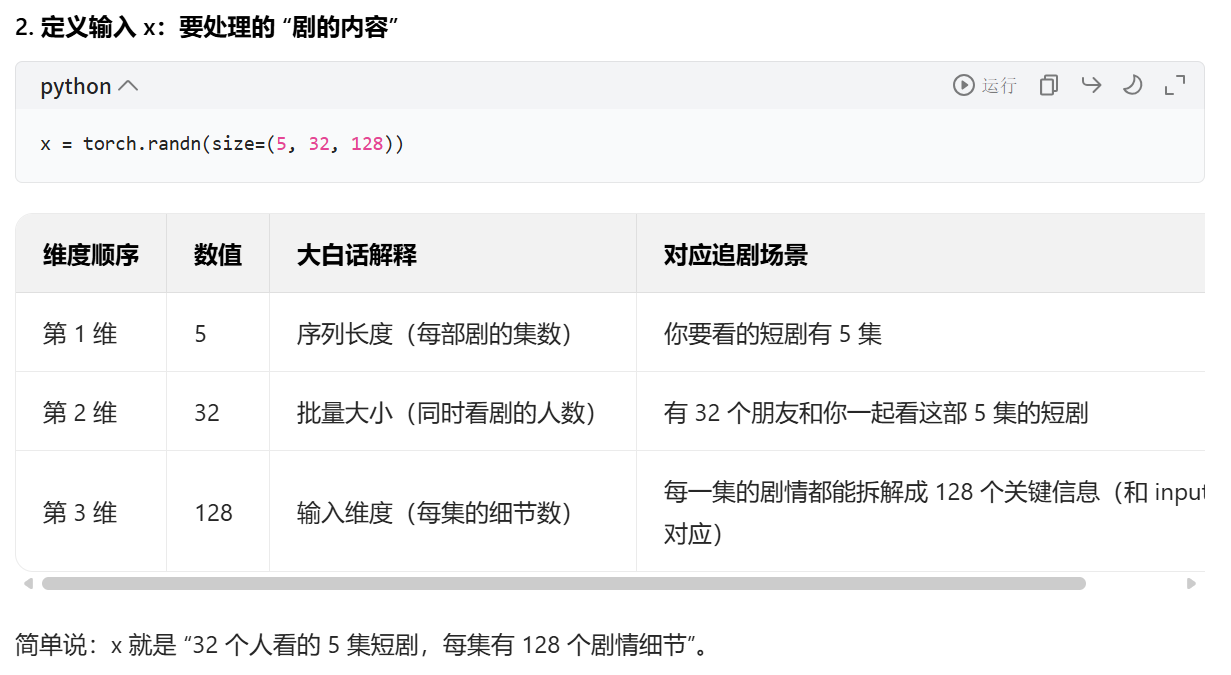

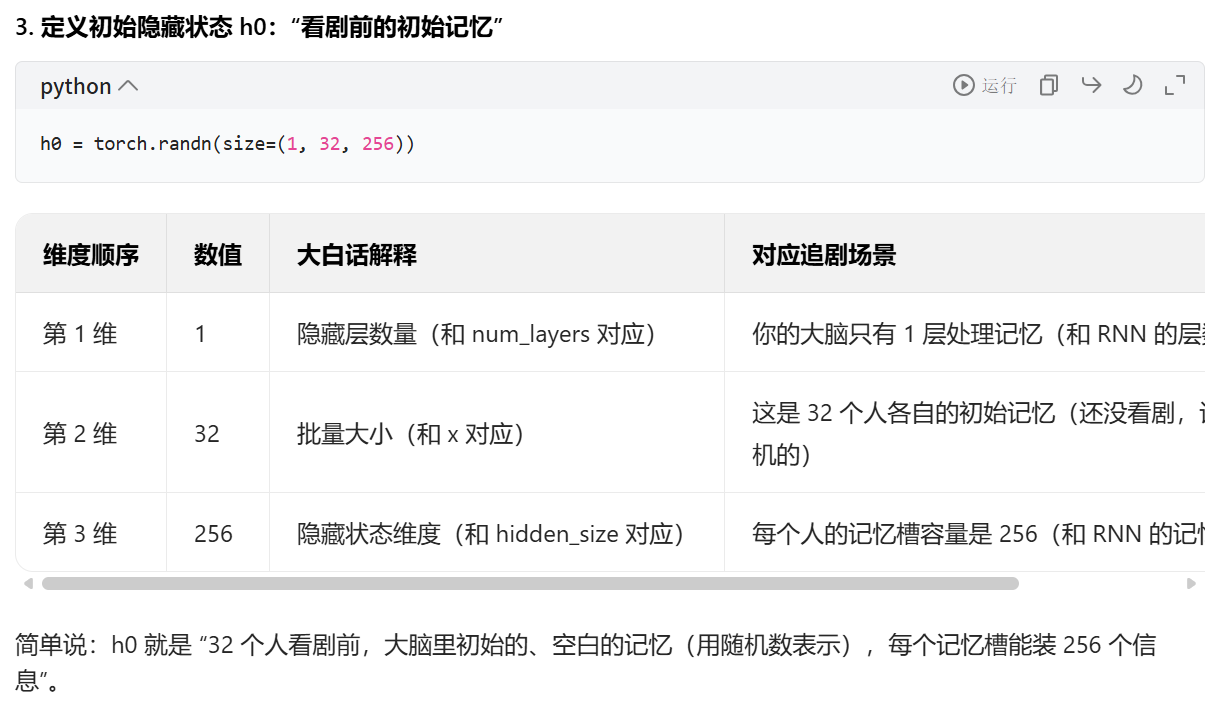

11、RNN层(循环网络层)_简介

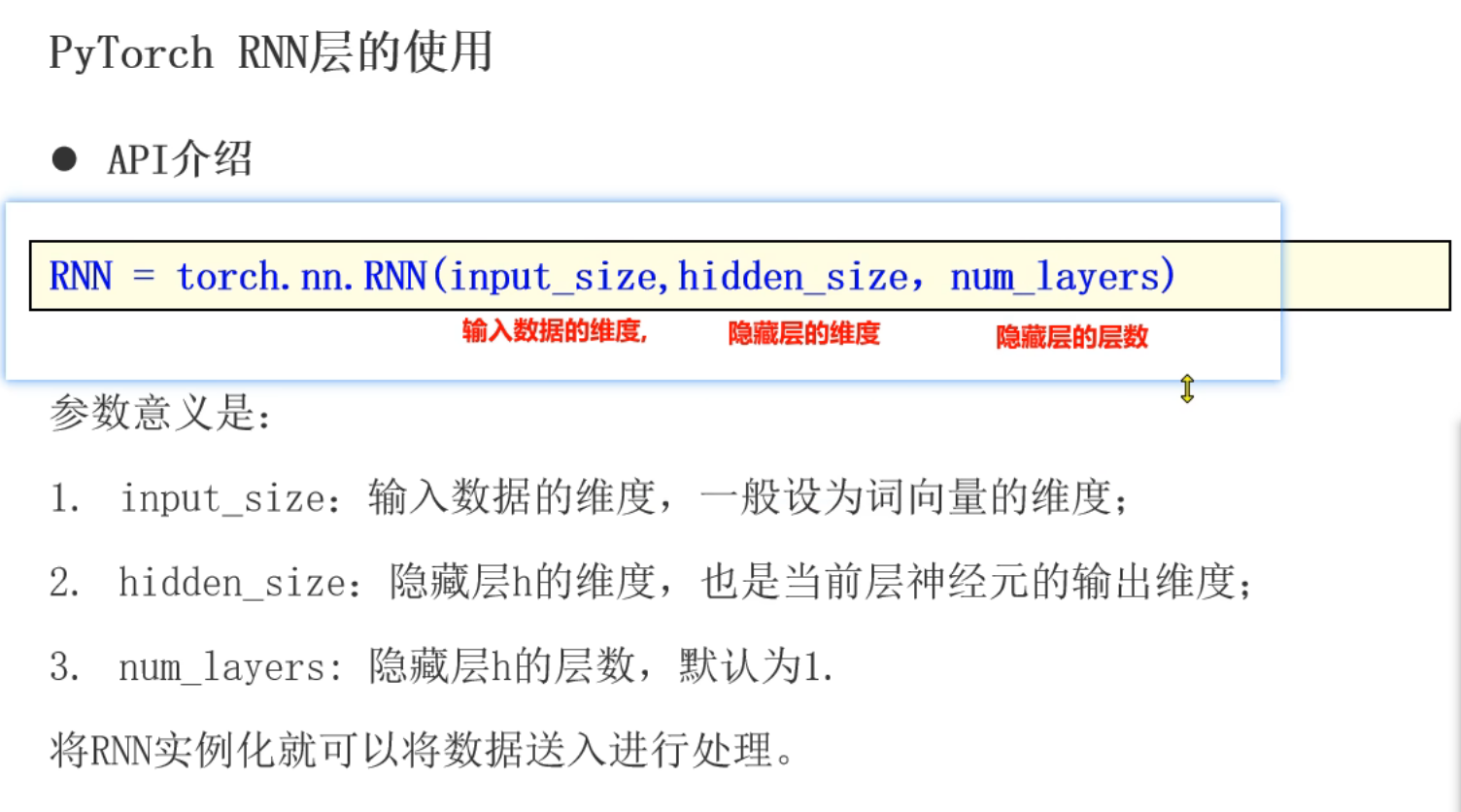

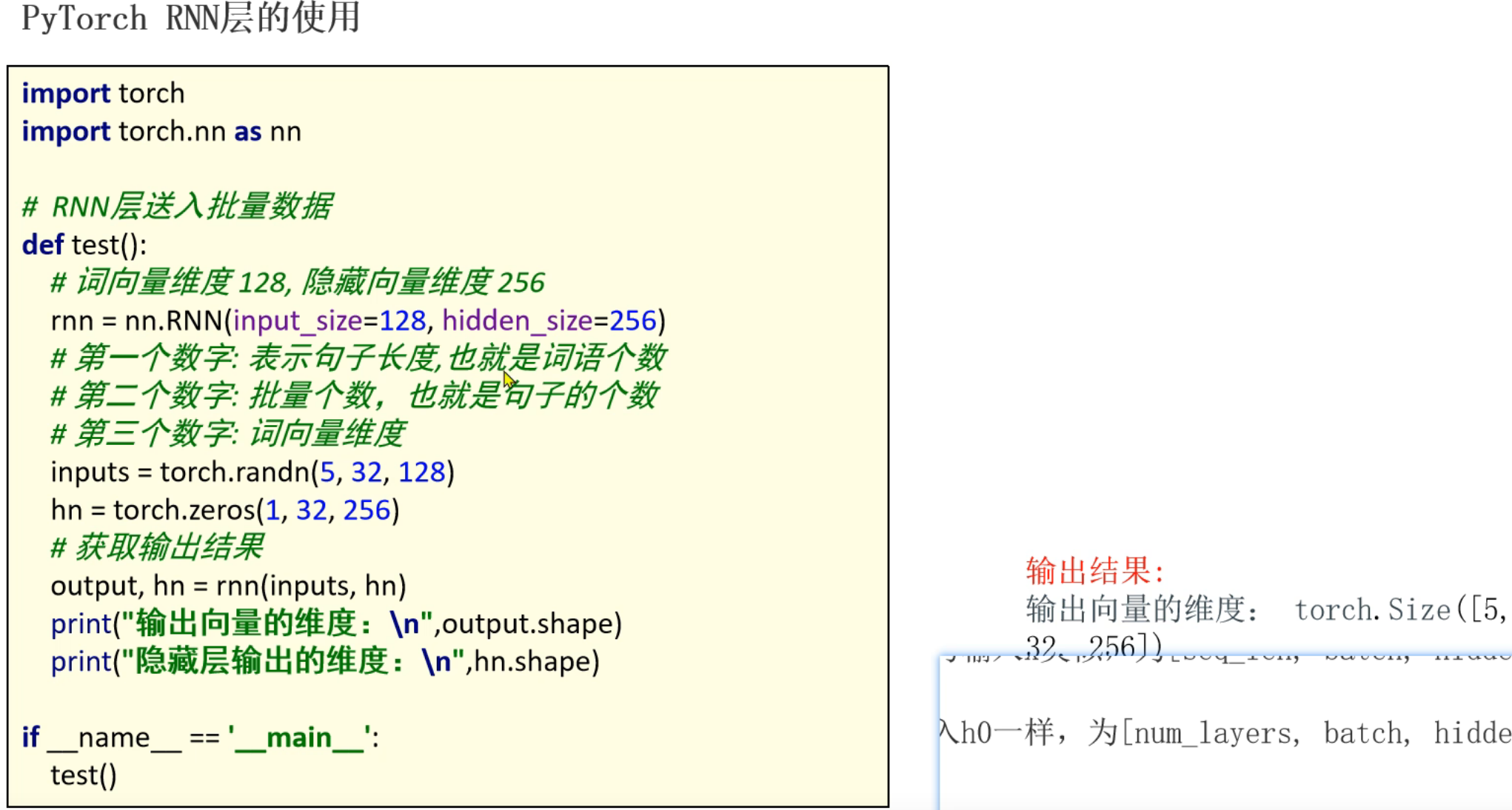

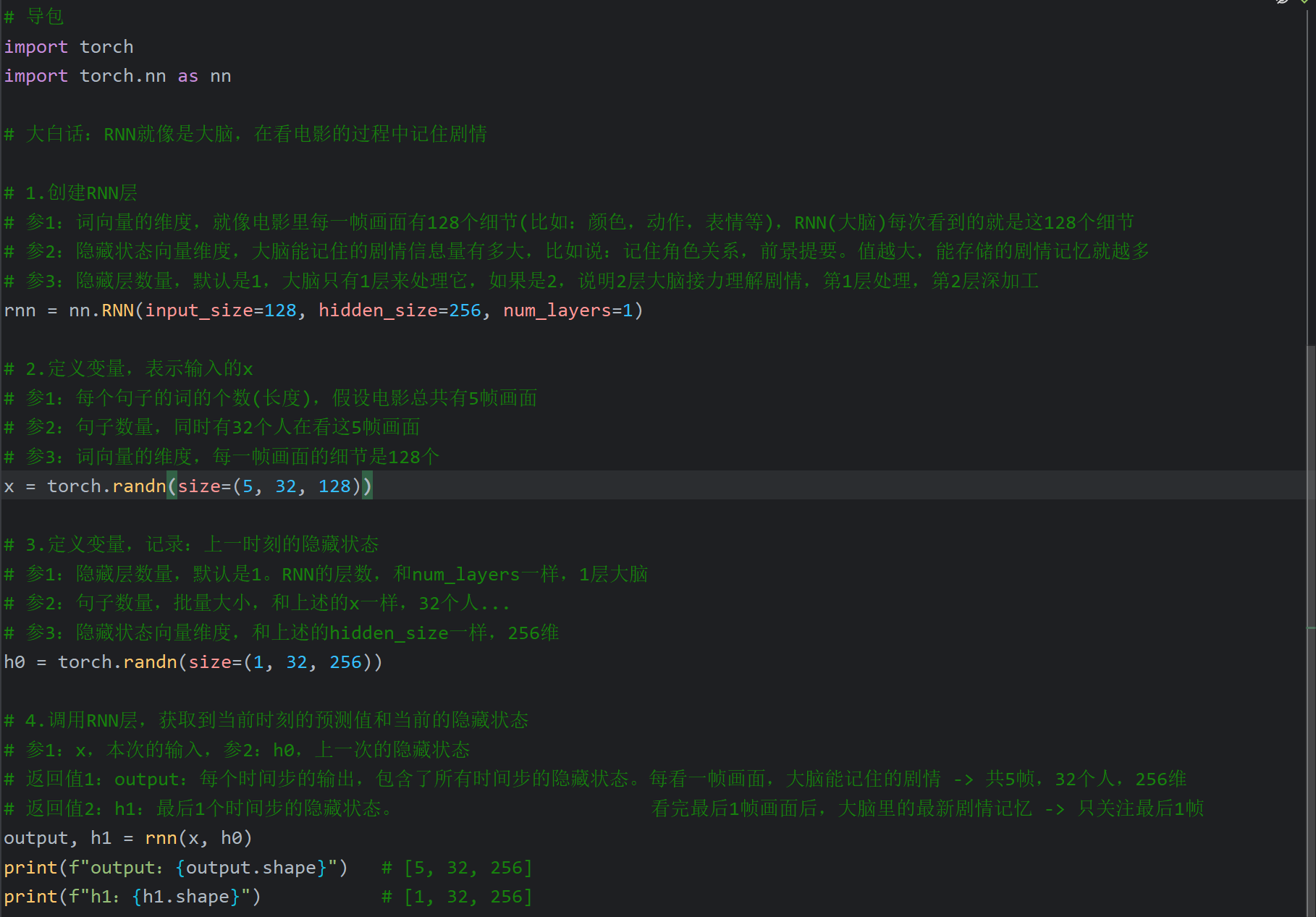

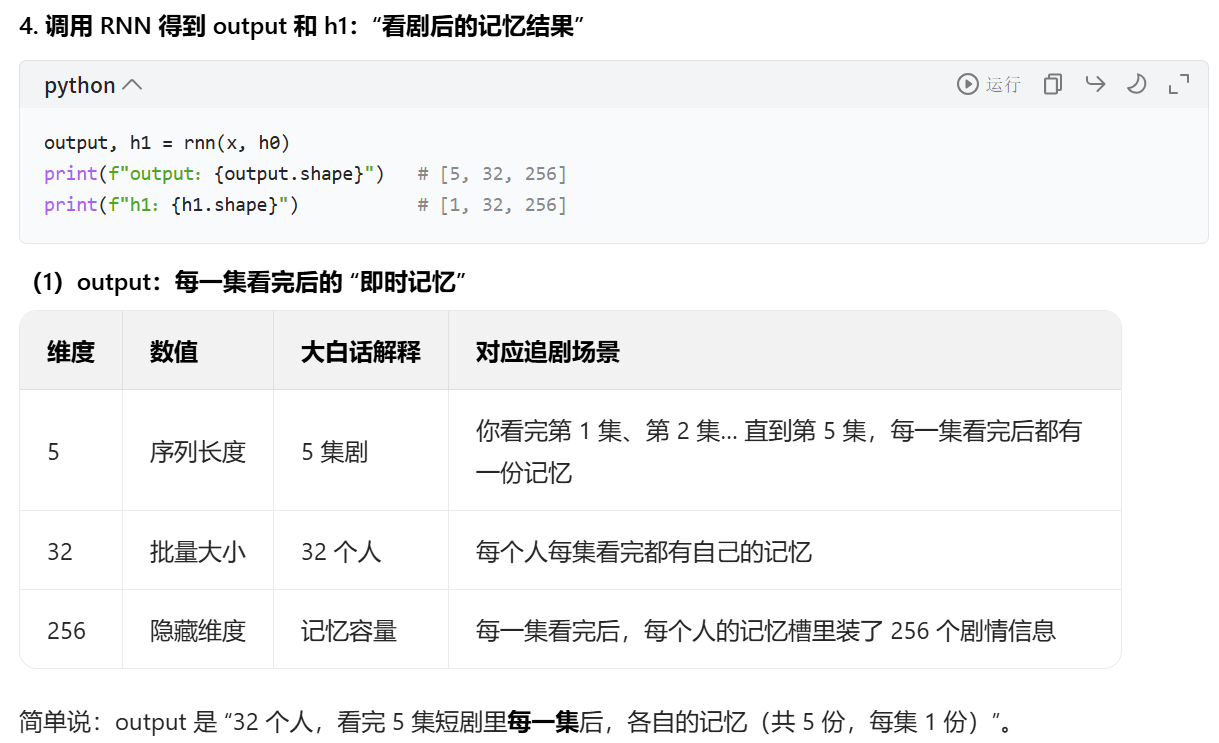

12、RNN层(循环网络层)_API演示

我个人认为老师举的电影这个例子没有问题,但是他解释的有点混乱,最后我让ai帮我重新总结了一下,感觉ai给出的总结要合理一点(截图放到最后)

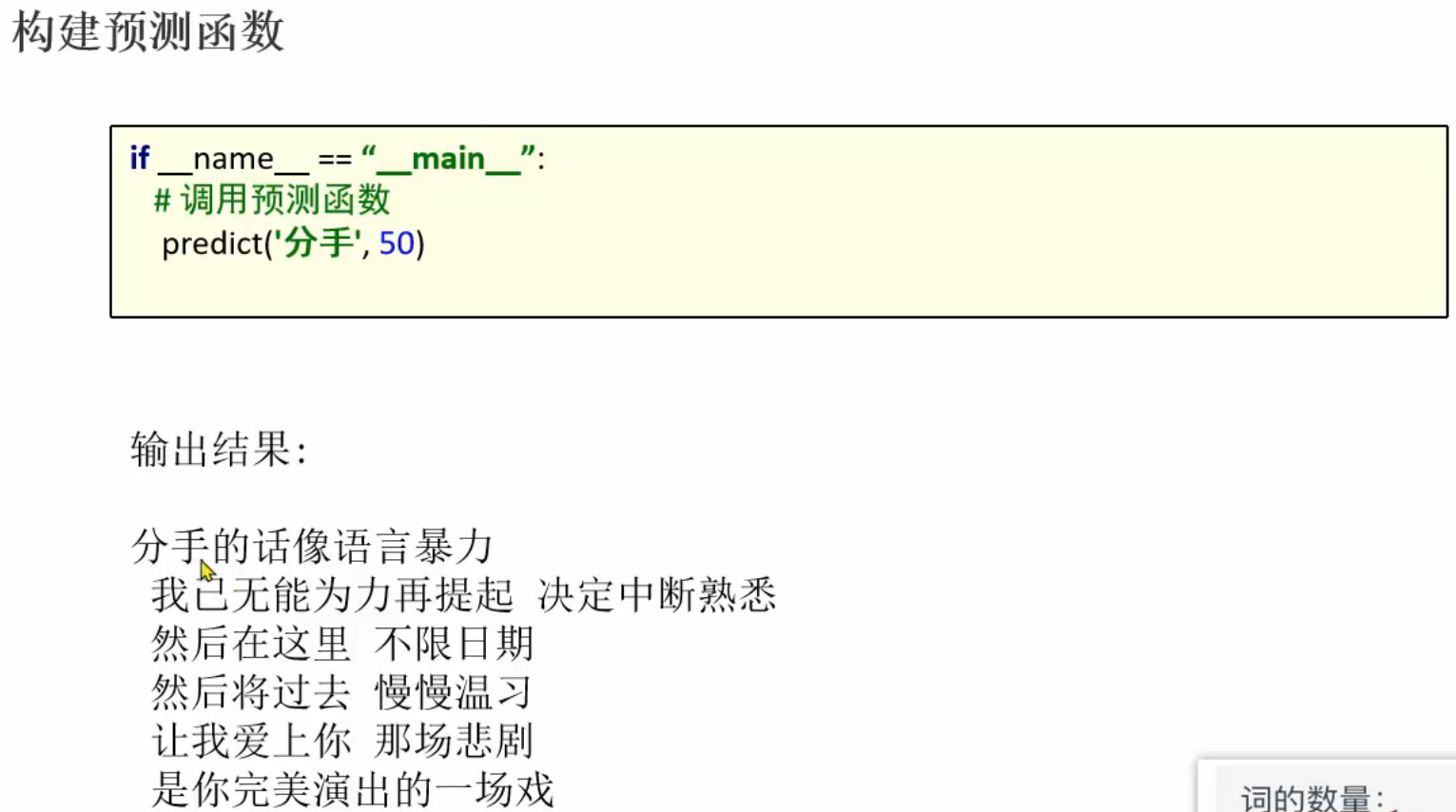

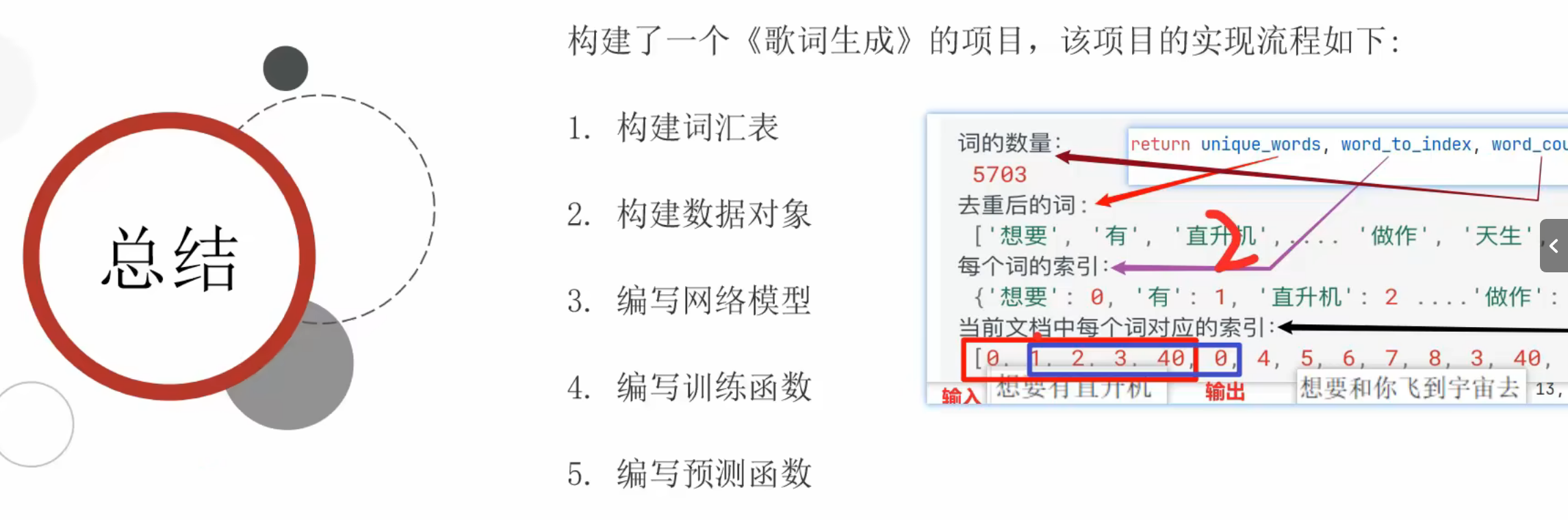

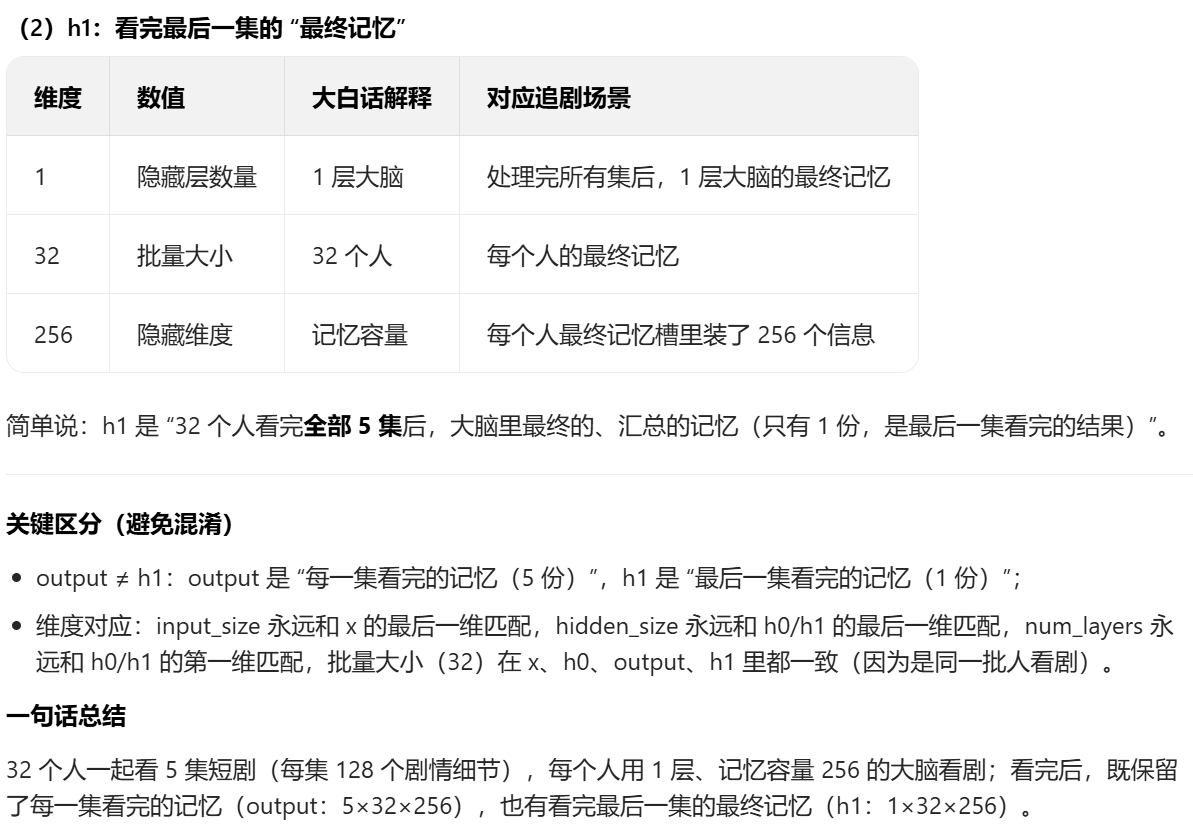

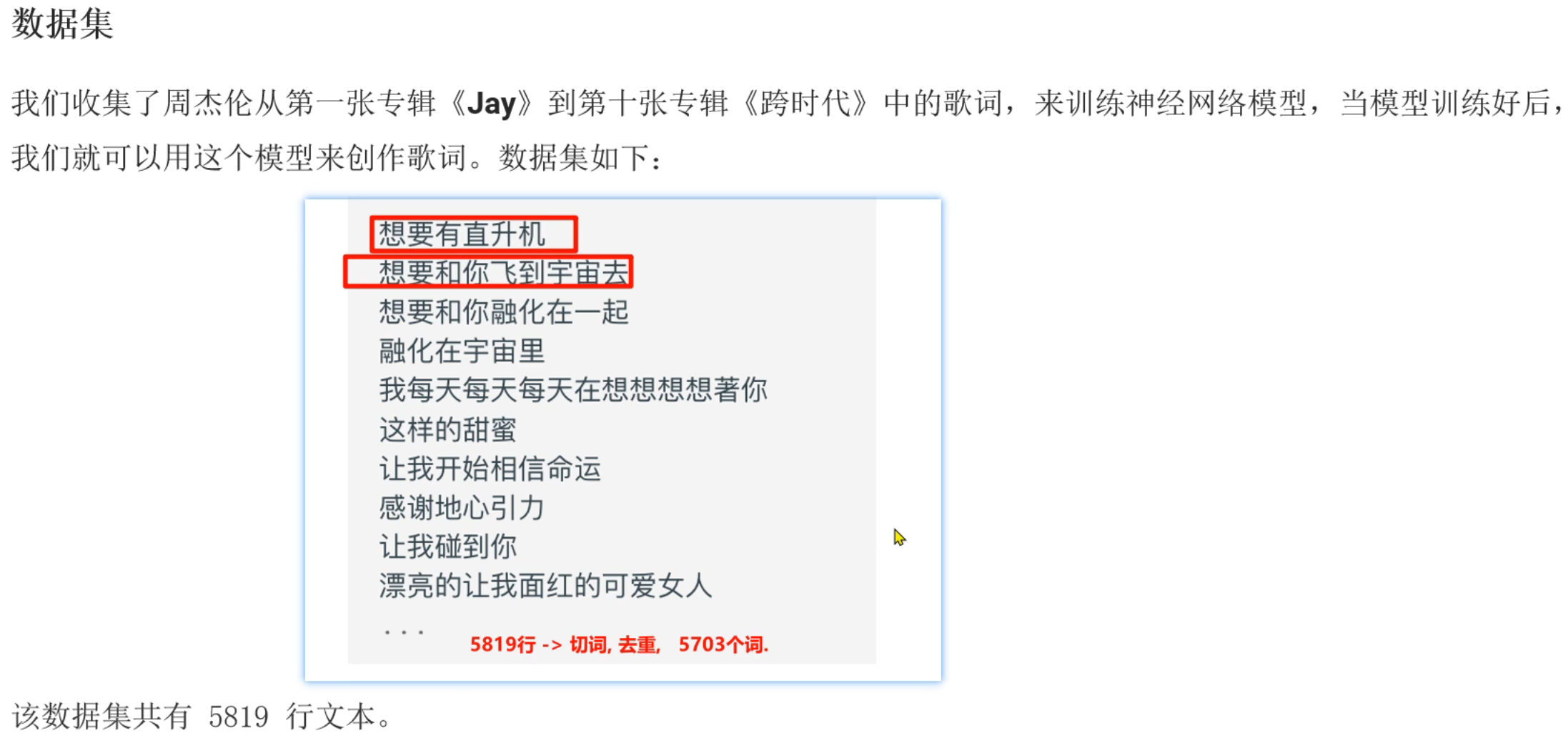

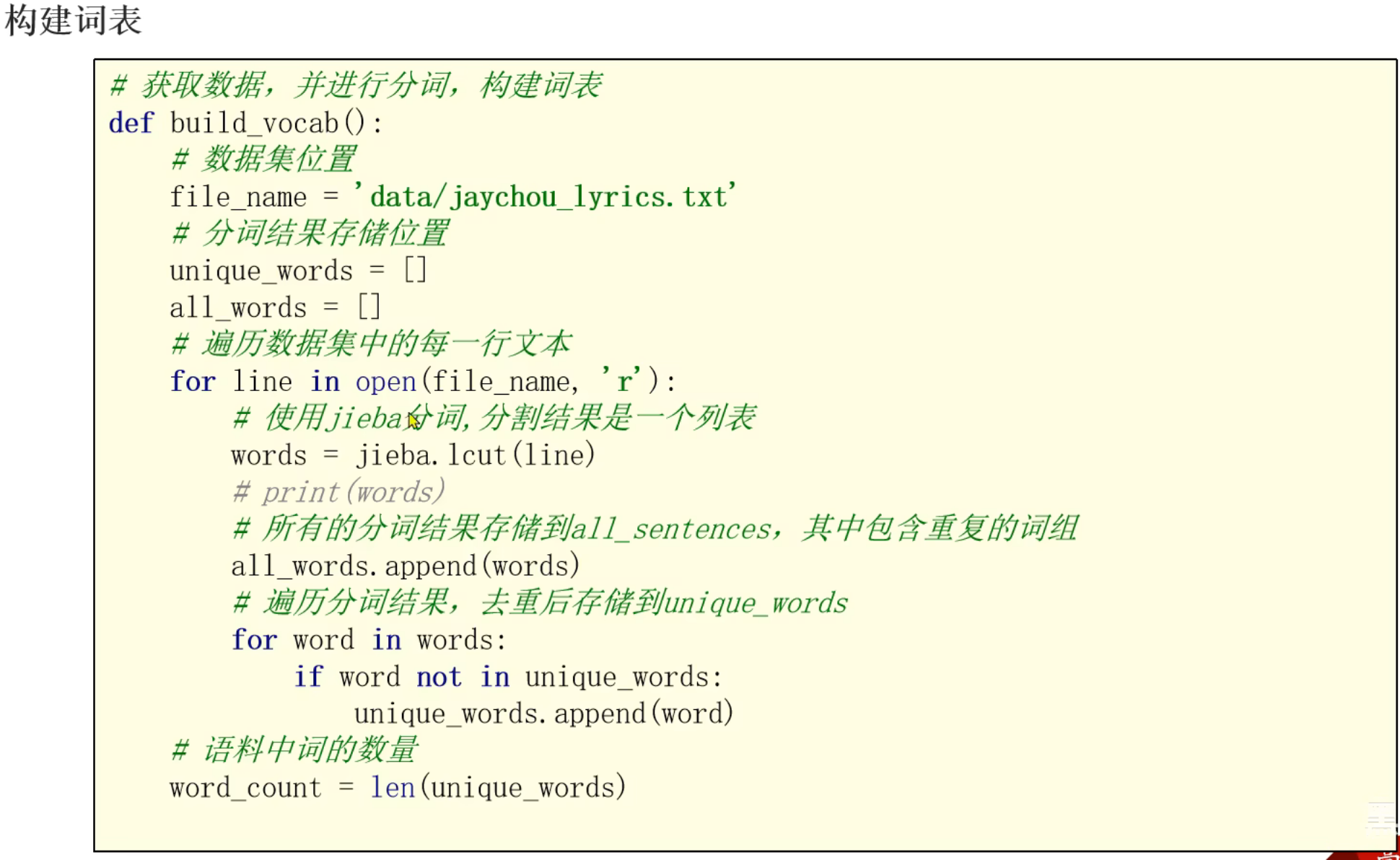

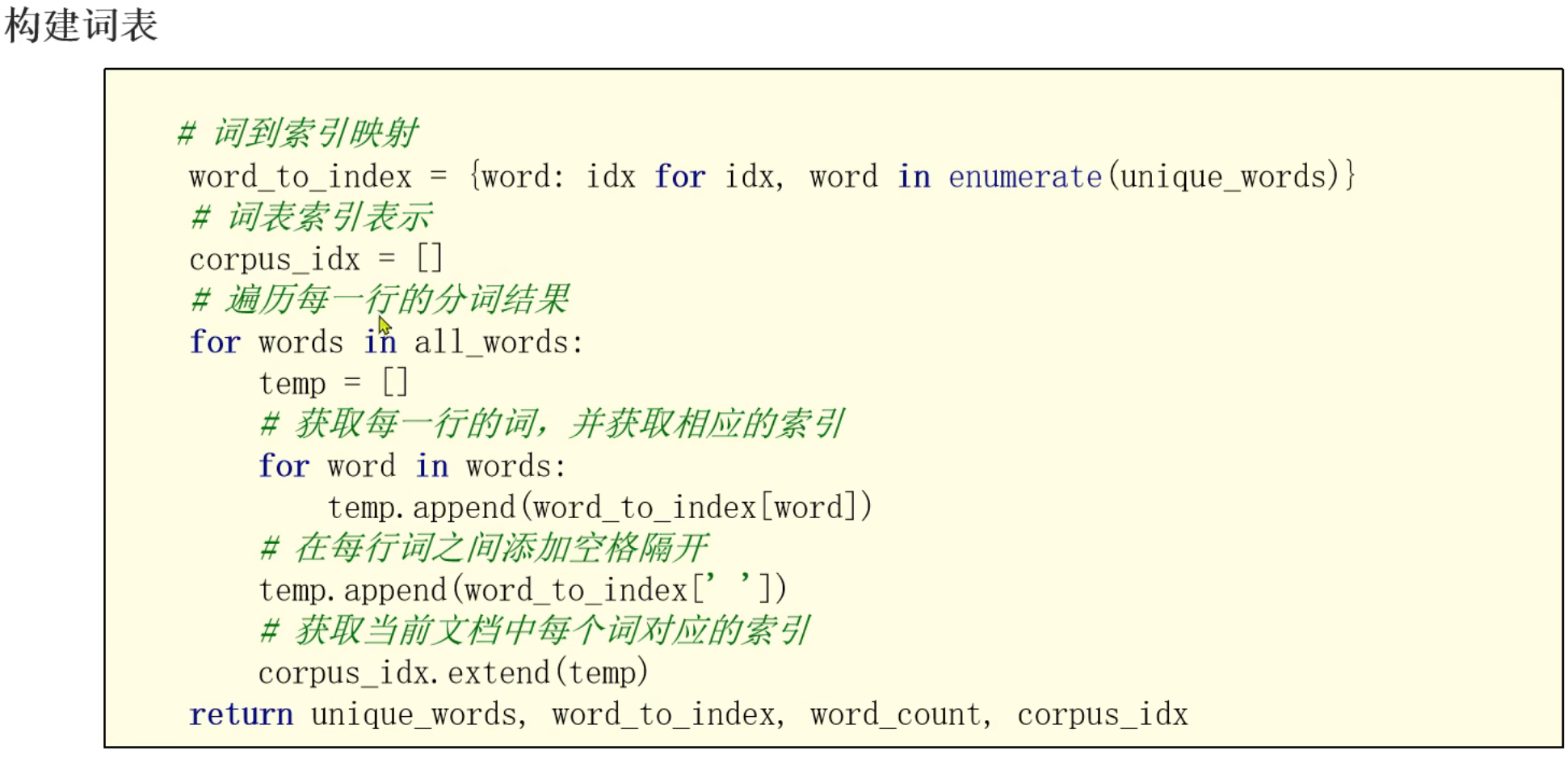

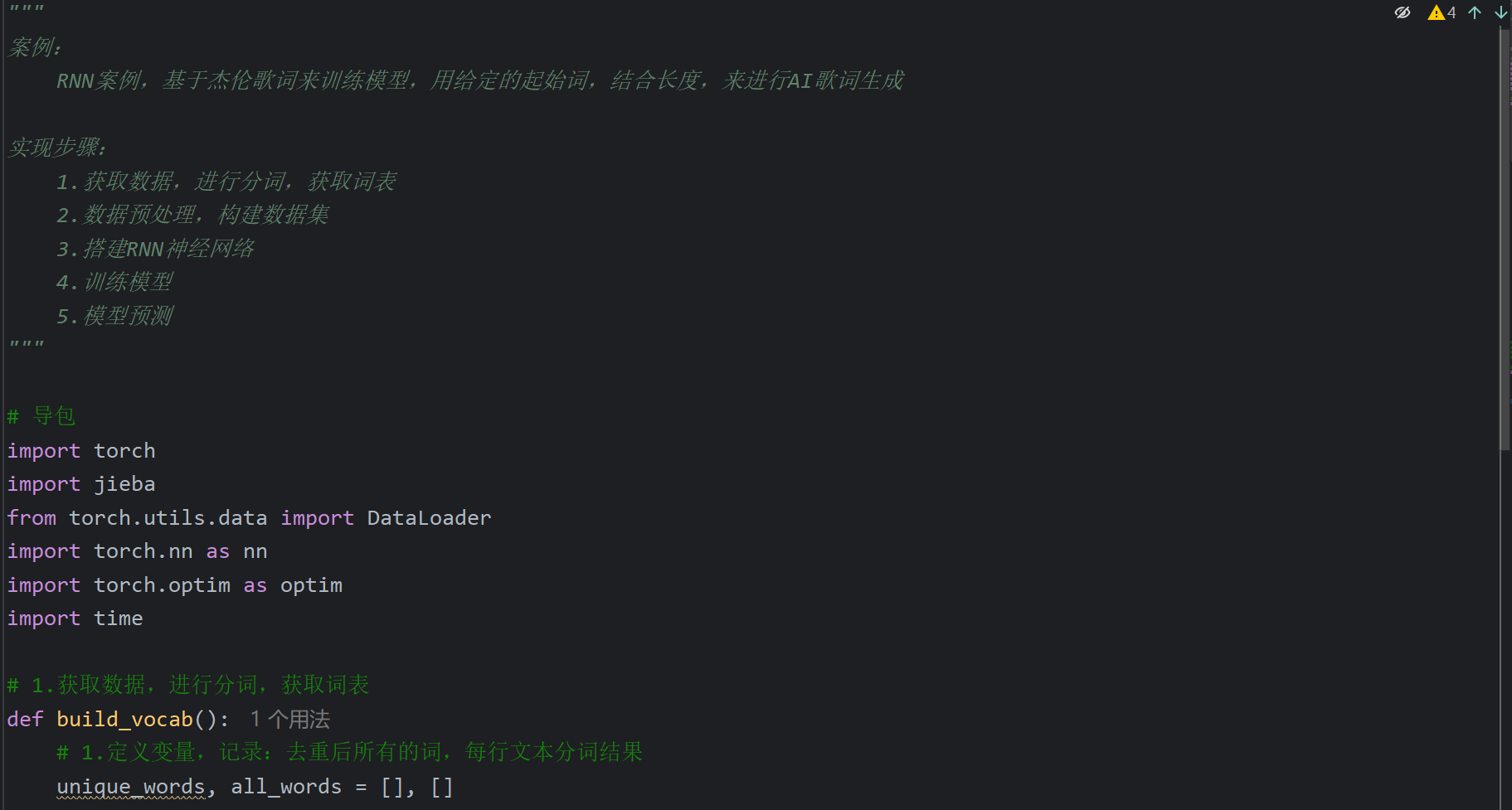

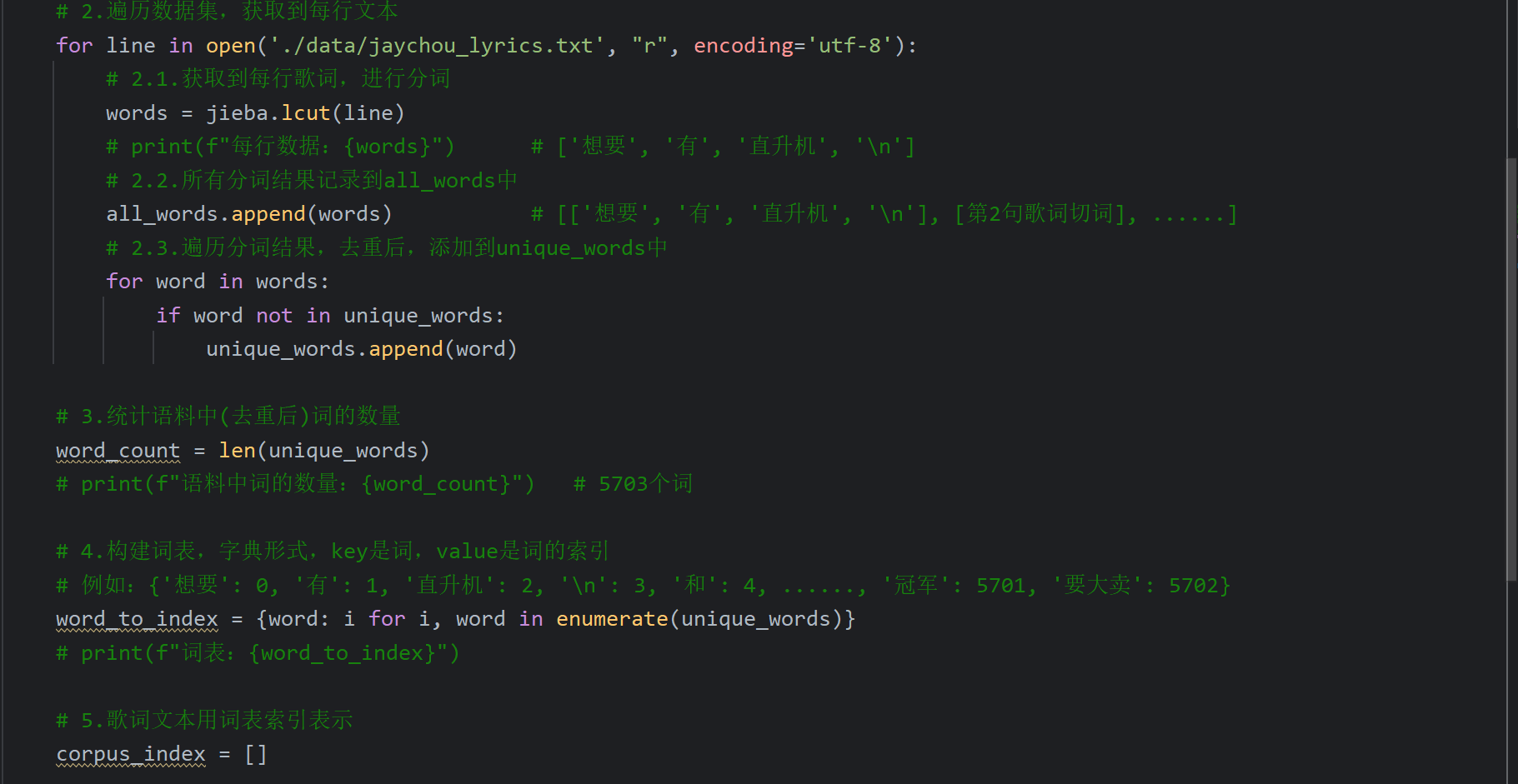

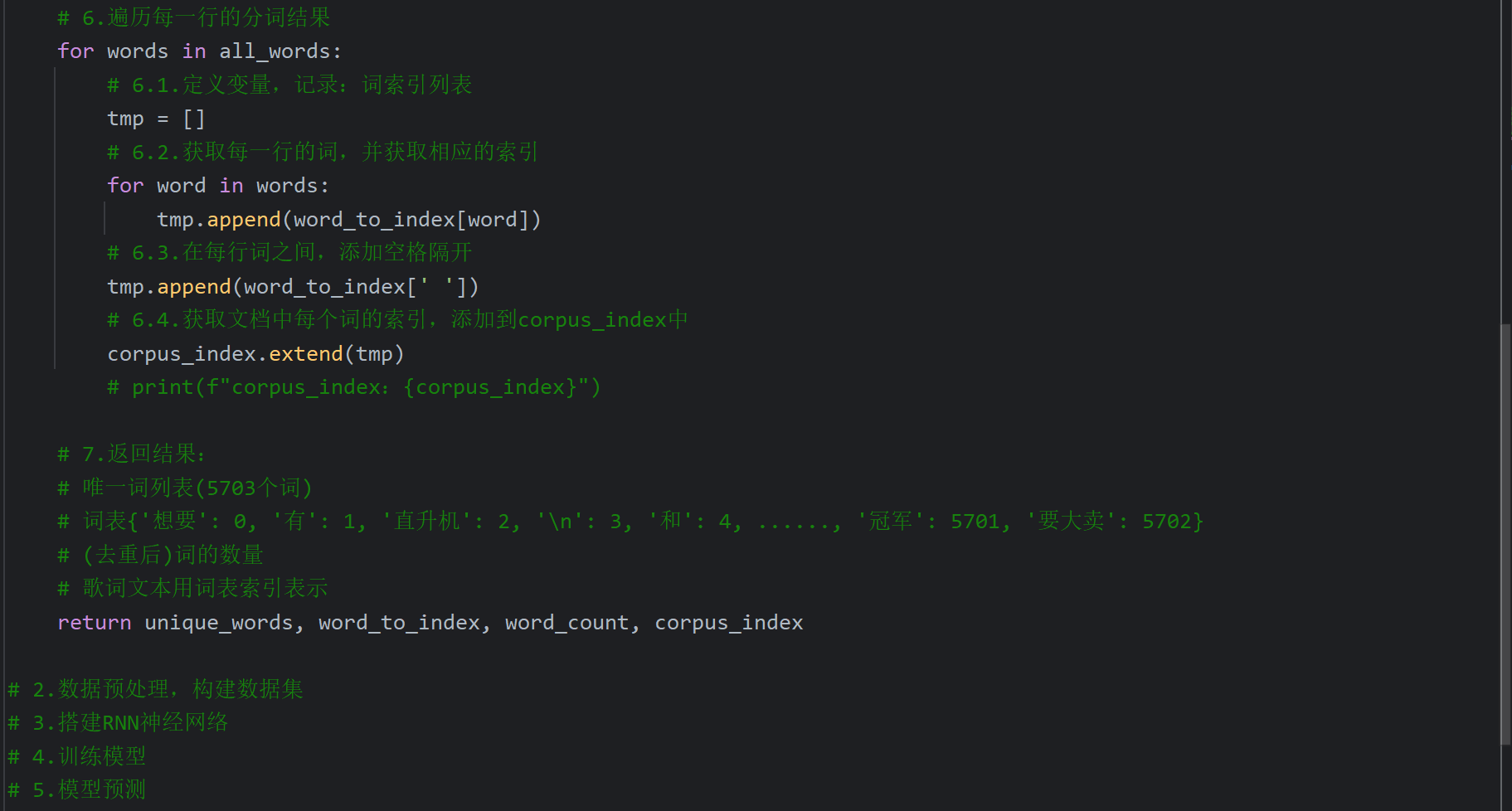

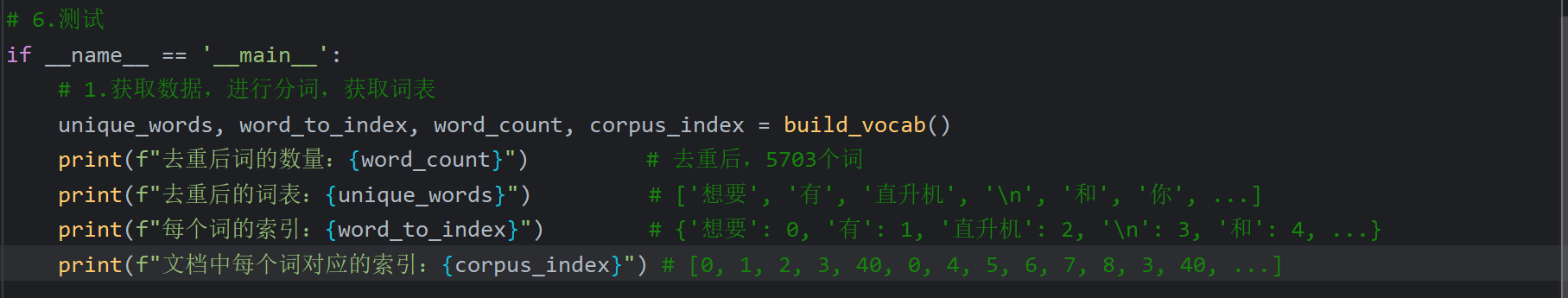

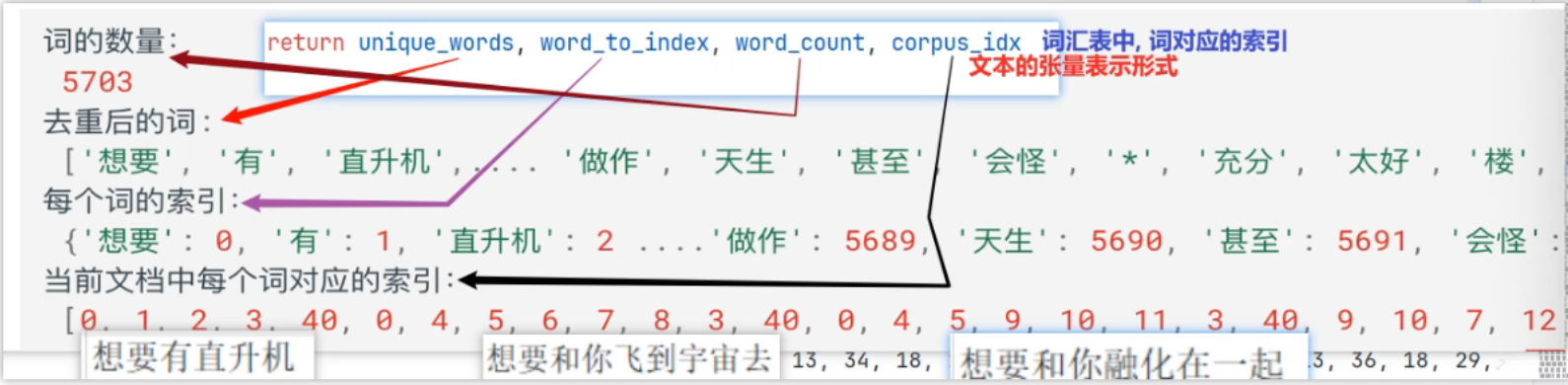

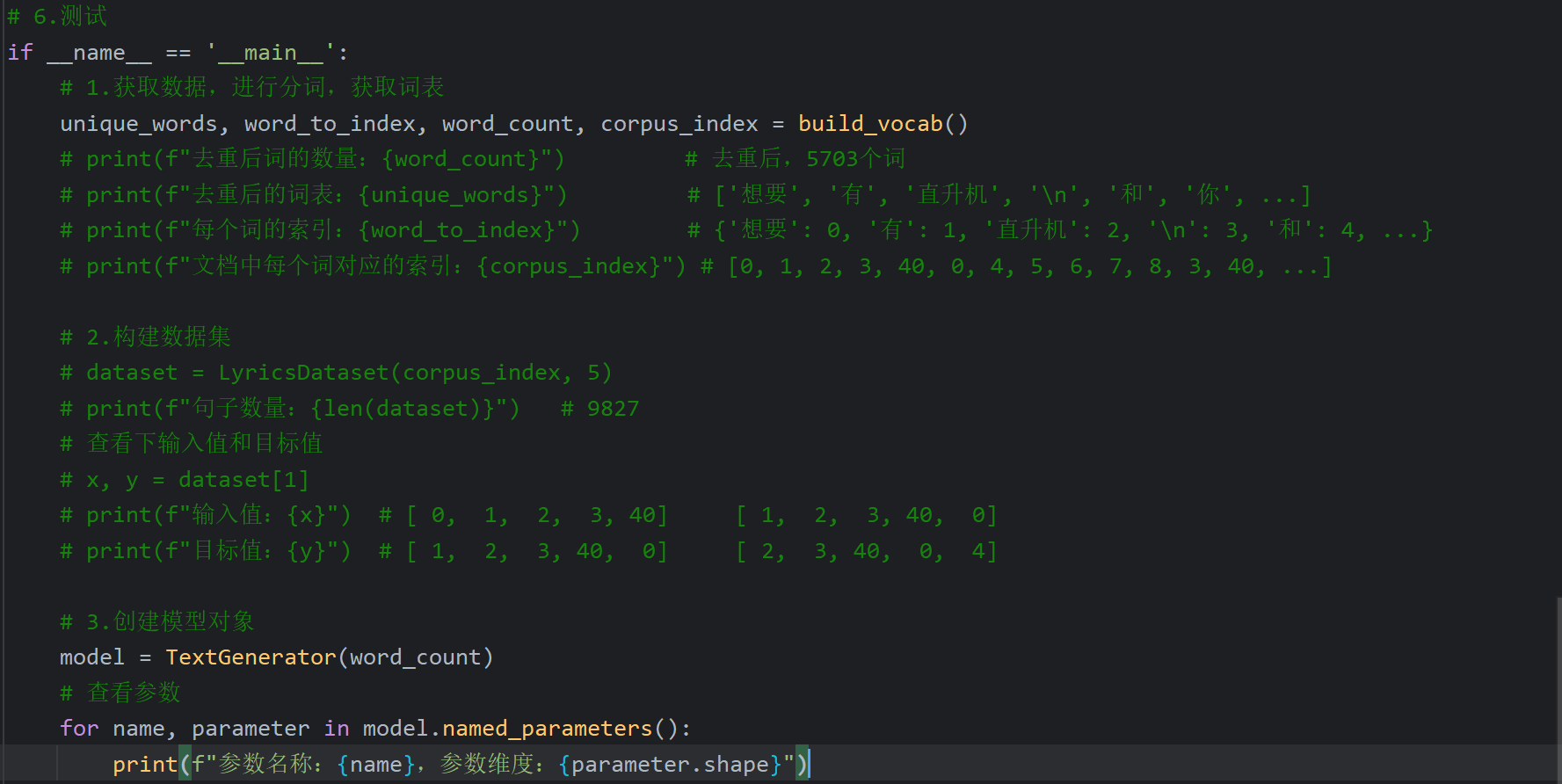

13、RNN_AI歌词生成器案例_构建词表

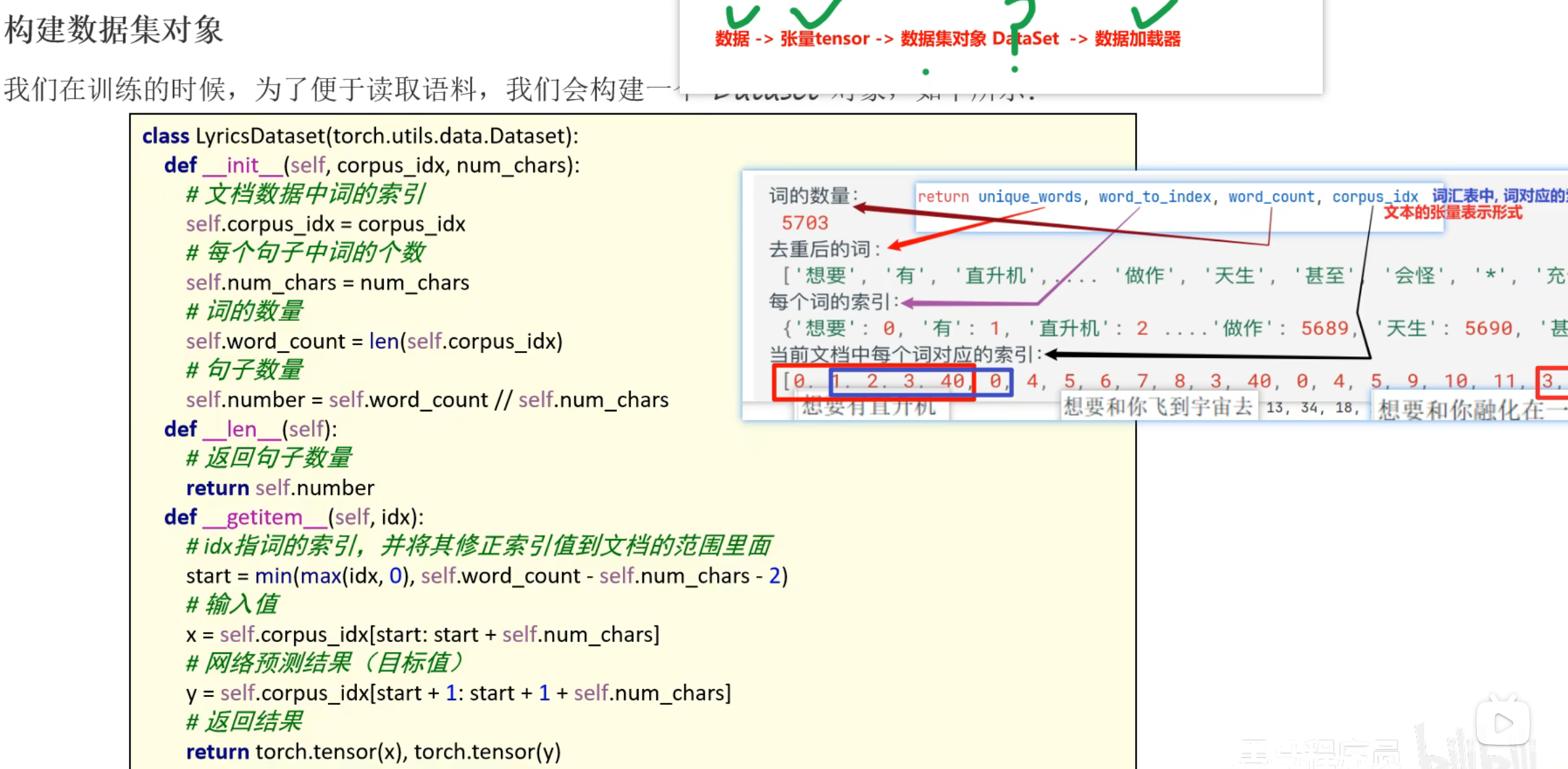

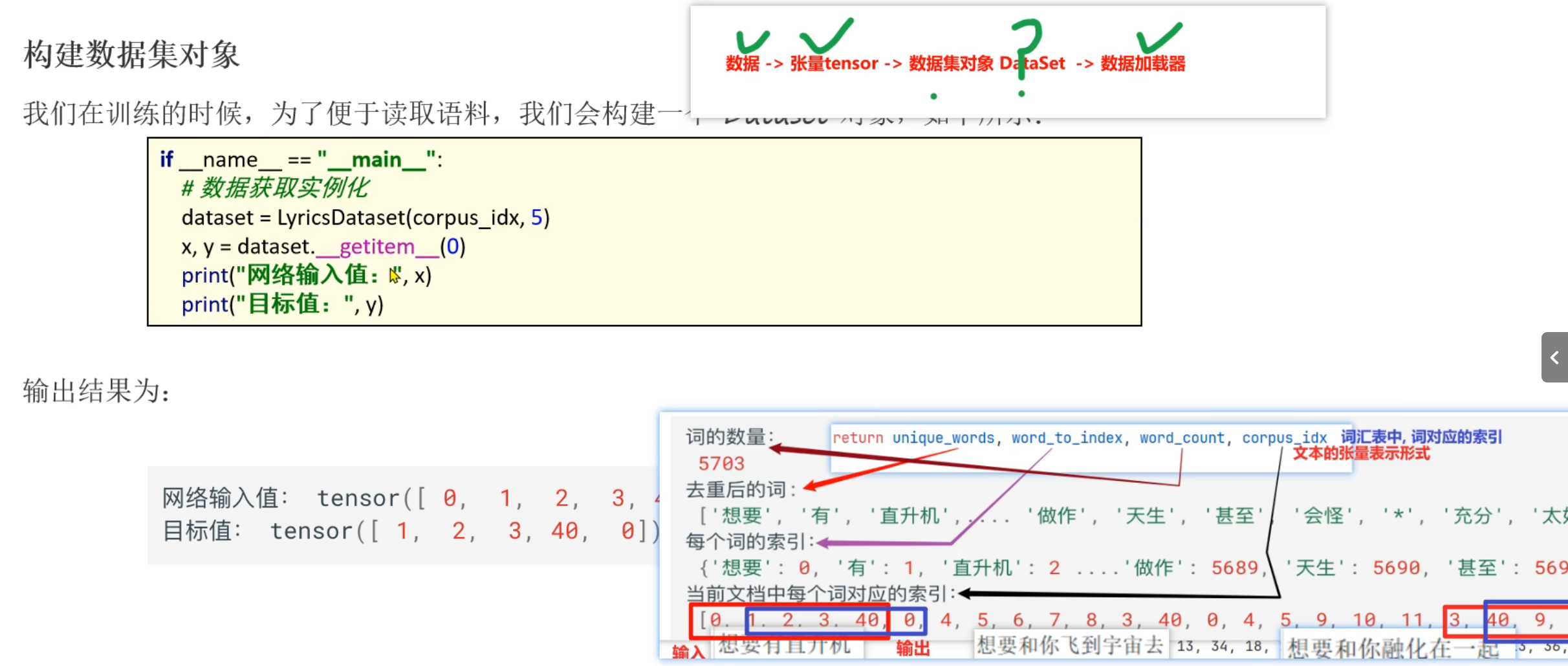

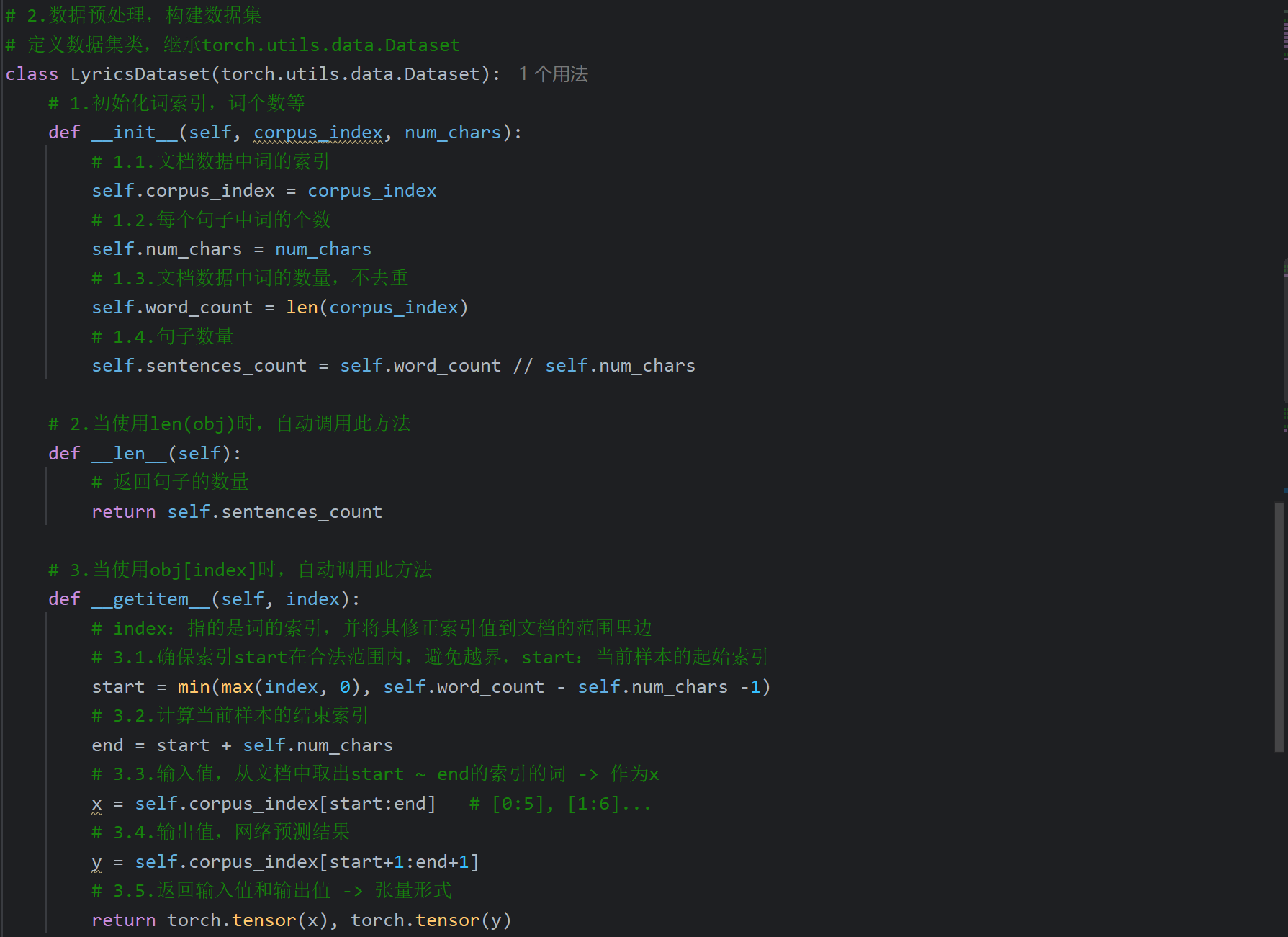

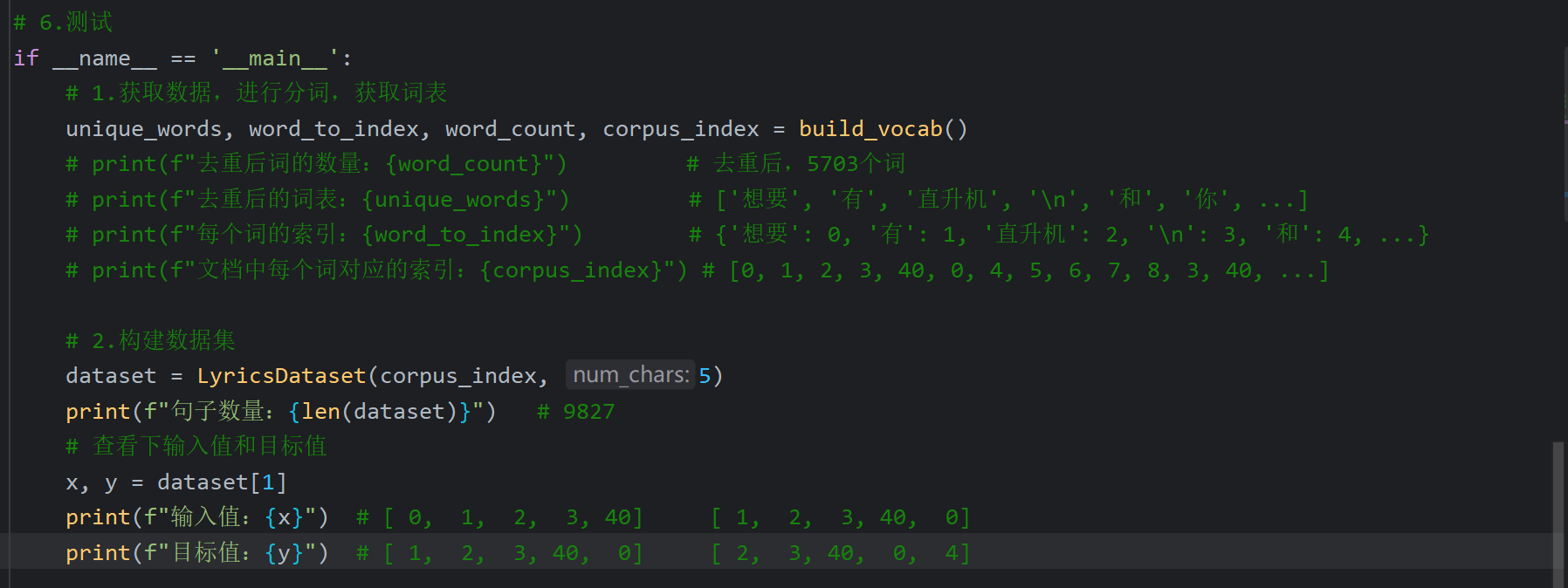

14、RNN_AI歌词生成器案例_构建数据集

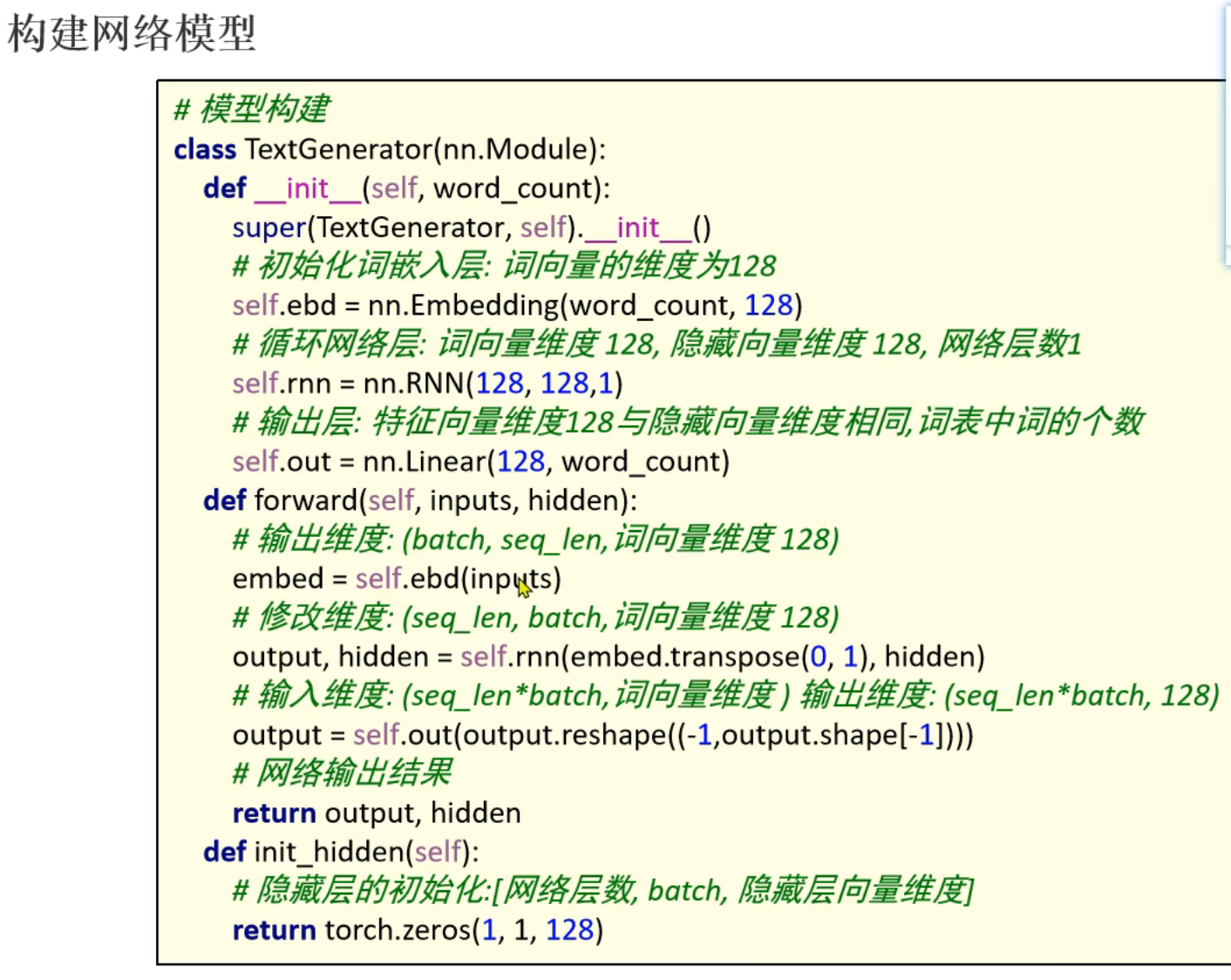

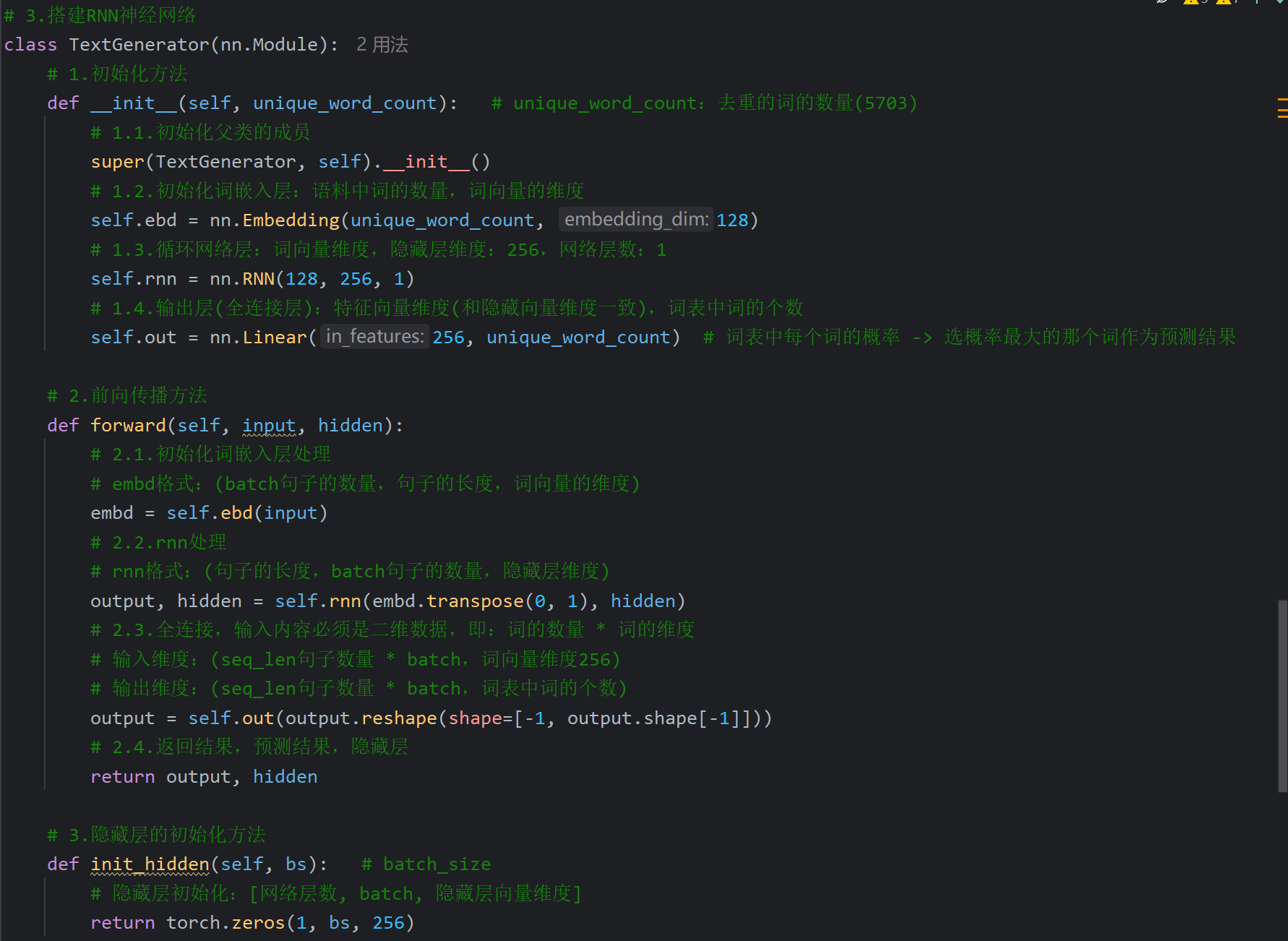

15、RNN_AI歌词生成器案例_搭建神经网络

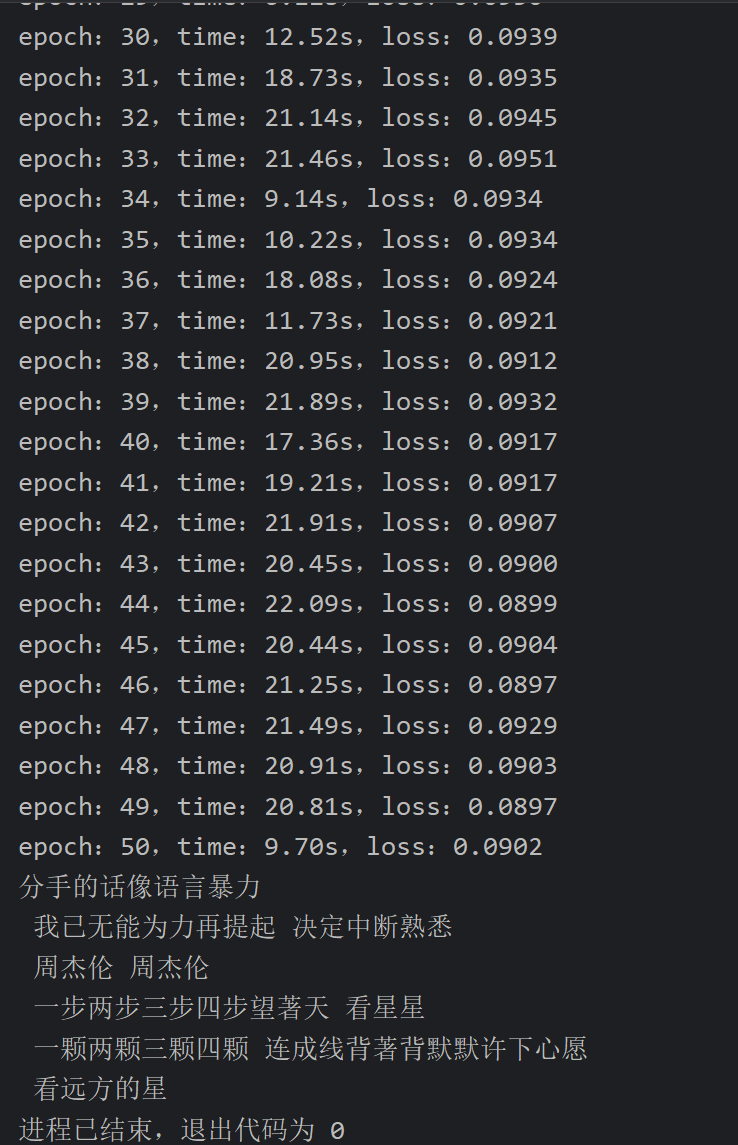

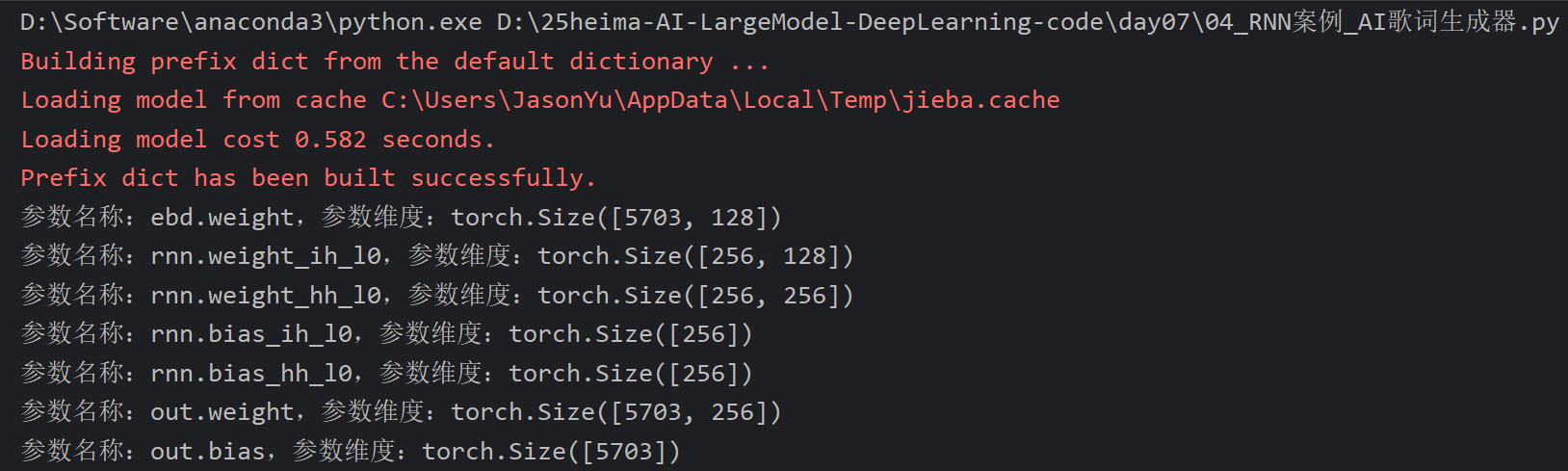

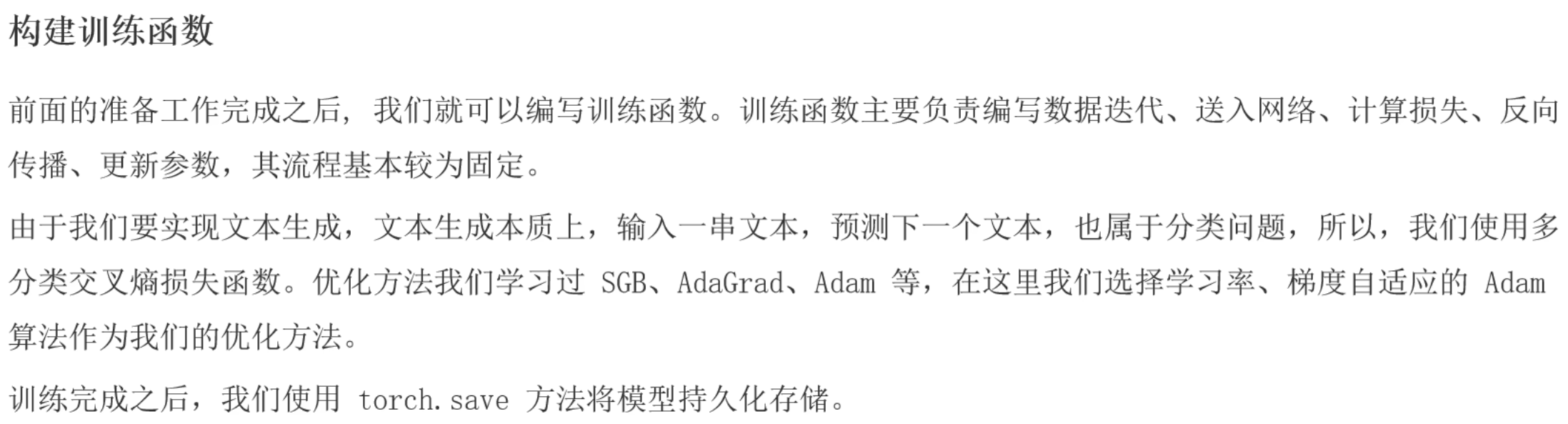

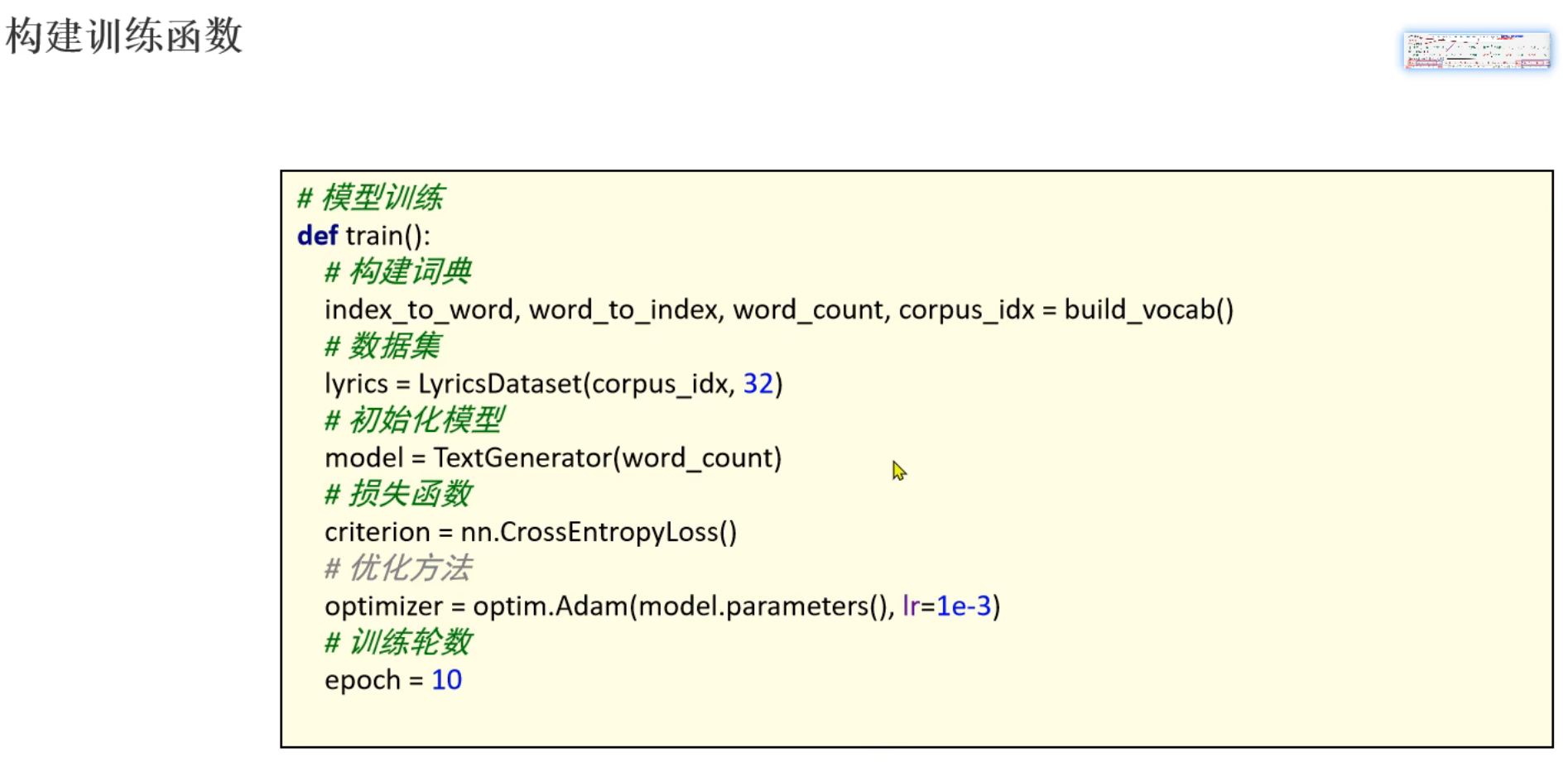

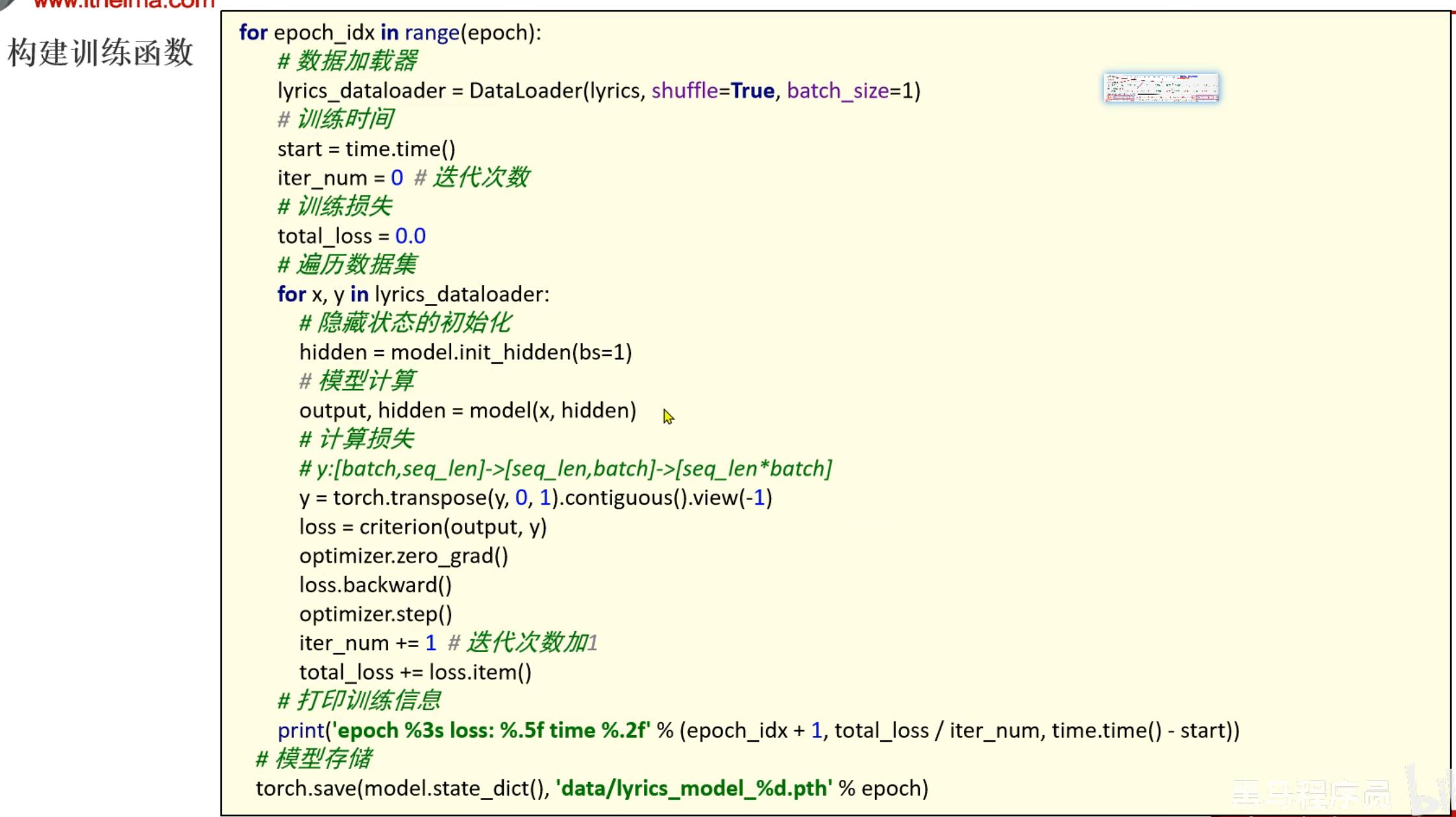

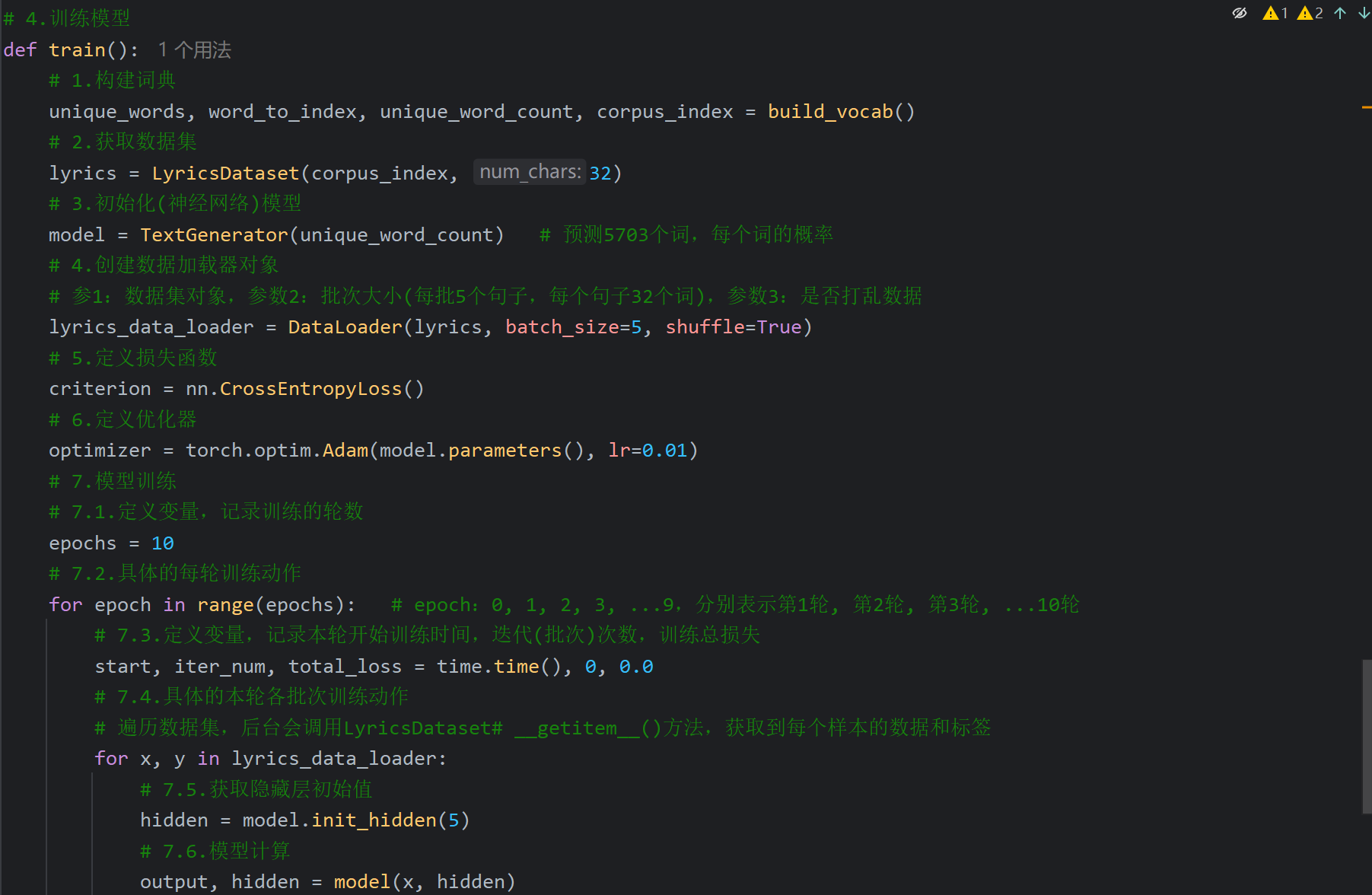

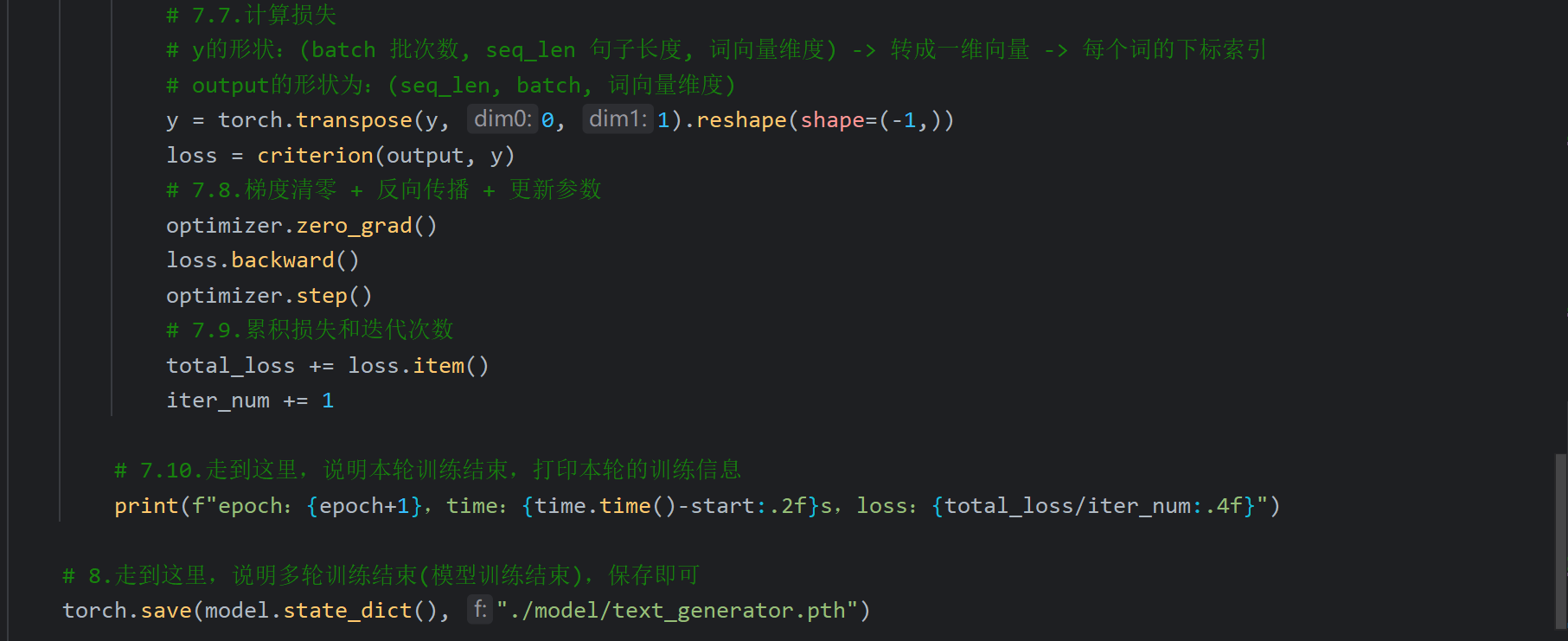

16、RNN_AI歌词生成器案例_模型训练

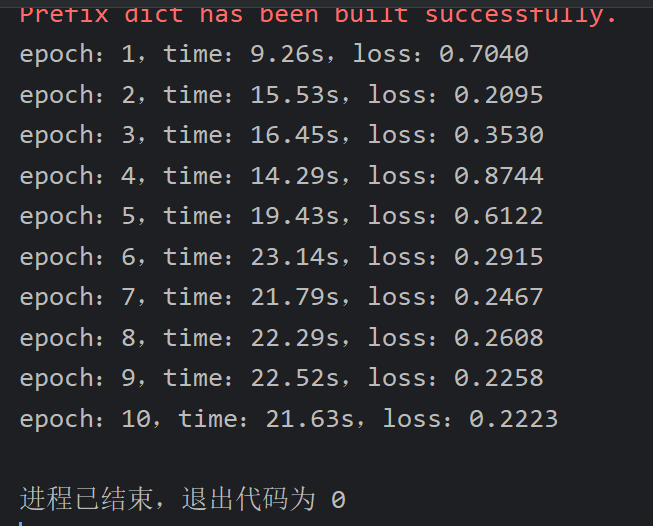

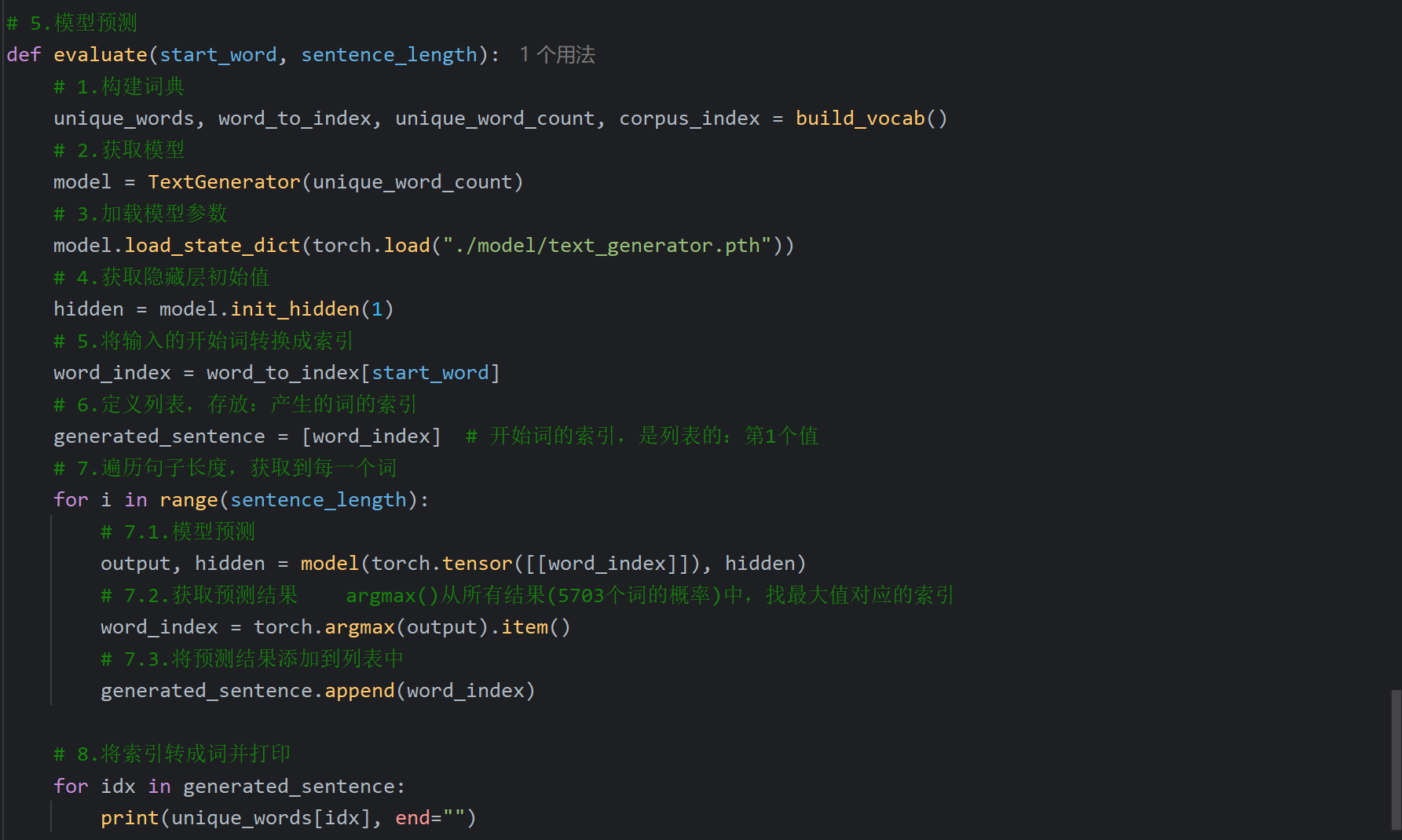

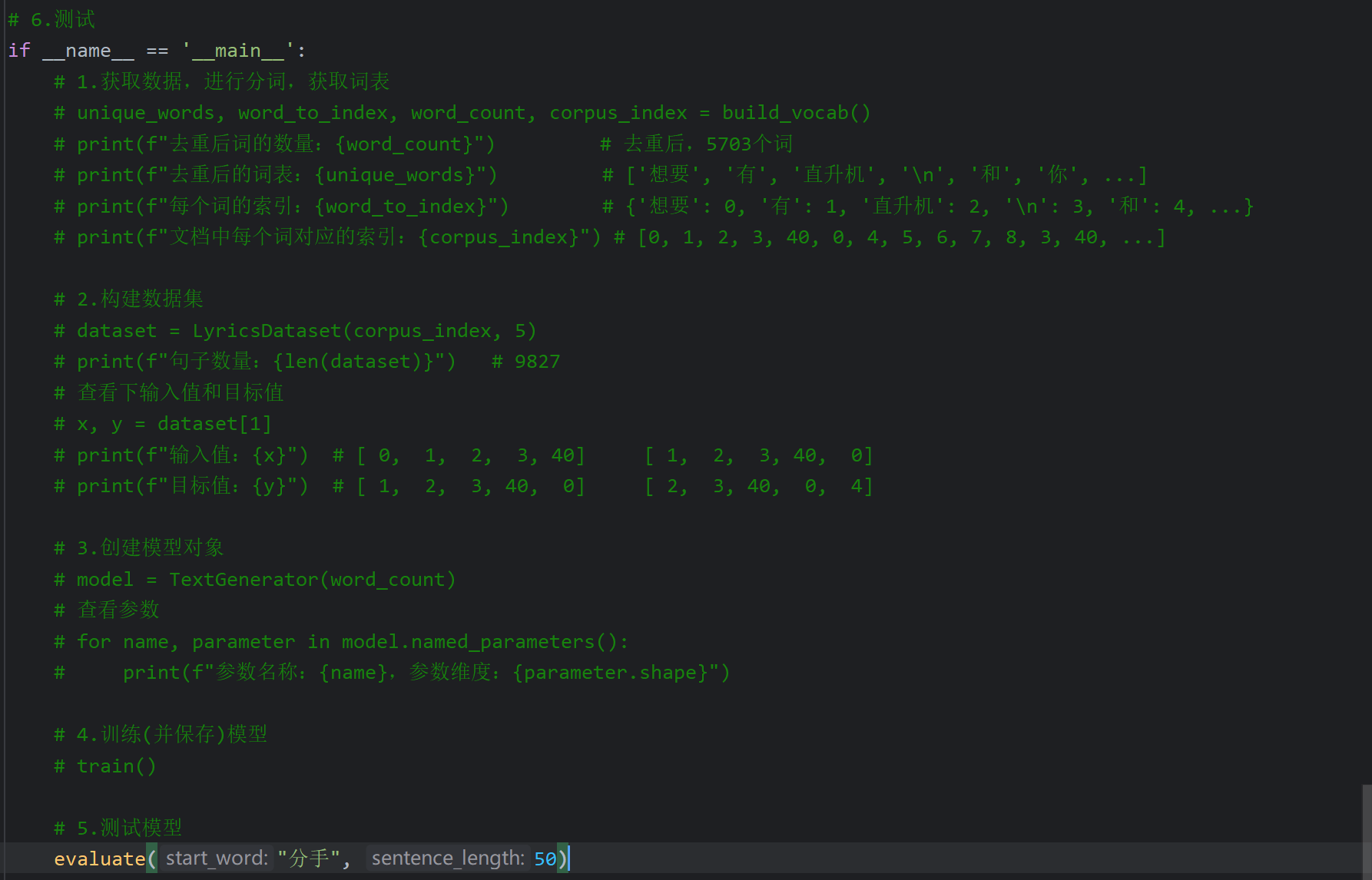

17、RNN_AI歌词生成器案例_模型测试

我这里是学着老师一样把轮数epochs改为了50,然后把学习率改为了0.001,等一会也是能跑出结果的,就是我配置不如老师跑的比较久一点