在机器学习中,直接建立一个高性能的分类器是很困难的但是,如果能找到一系列性能较差的分类器,并把它们集成起来的话,也许就能得到更好的分类器。日常生活中,所谓的民主决策,便是部分的利用了这种想法。譬如选总统,每个人都以自己的考虑,投下自己的一票,但最后由多数人选出的总统,似乎应该好于由一个人指定的总统。

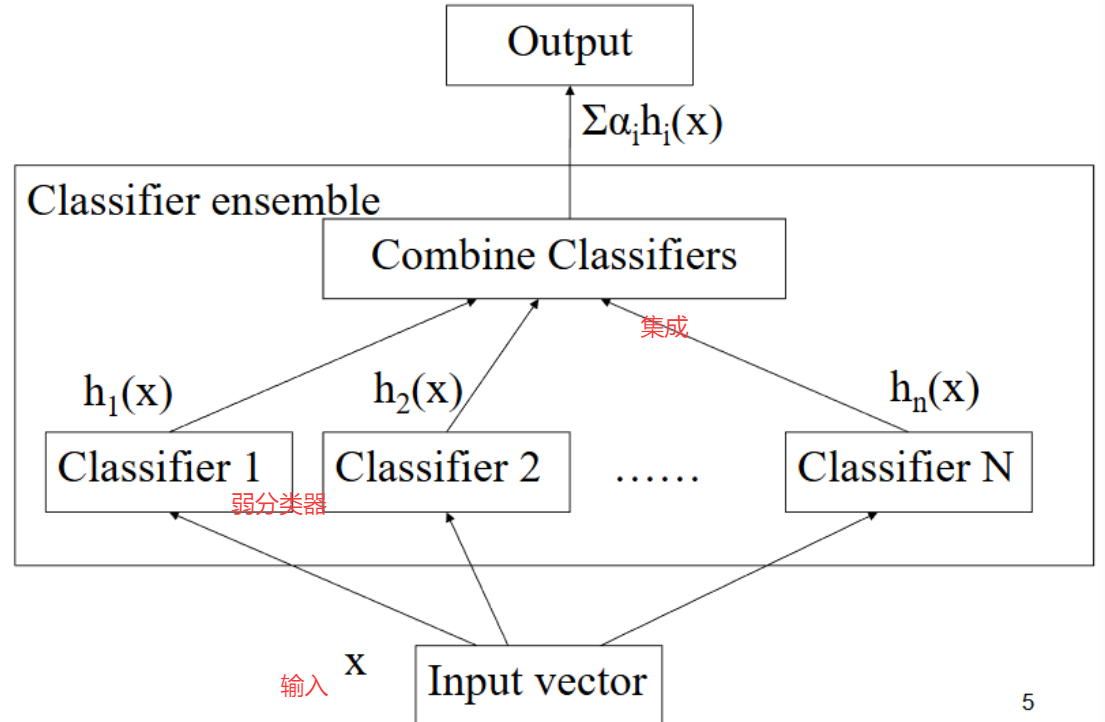

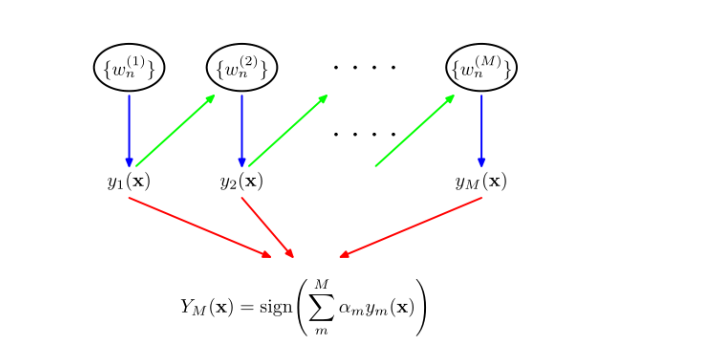

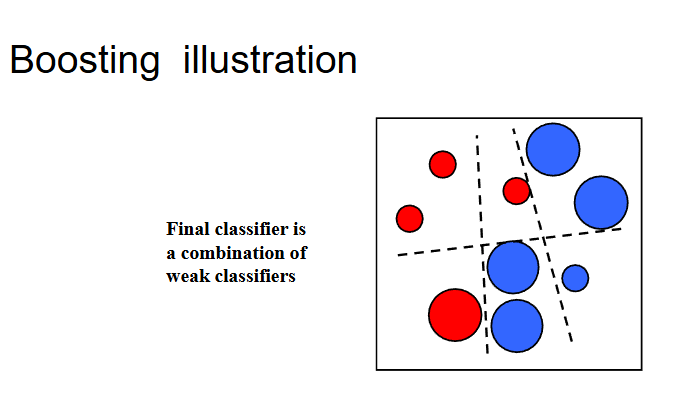

集成学习就是把输入送入多个学习器,再通过某种方法把学习的结果集成起来的方法,每一个学习器哦都是"弱学习器"

我们一般选定加权平均的方法来构造学习的最终学习器,但是每一个分类器该如何设计,如果用同样的学习算法构造不同的弱学习器的方法。

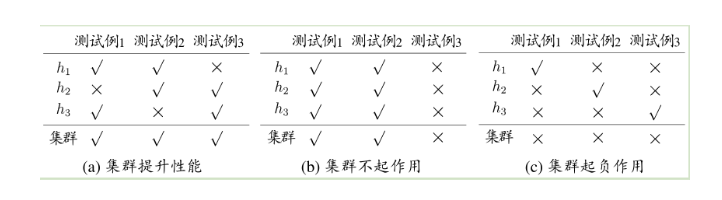

考虑一个简单的例子,再二分类问题中,有以下三个类别:

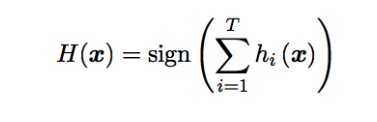

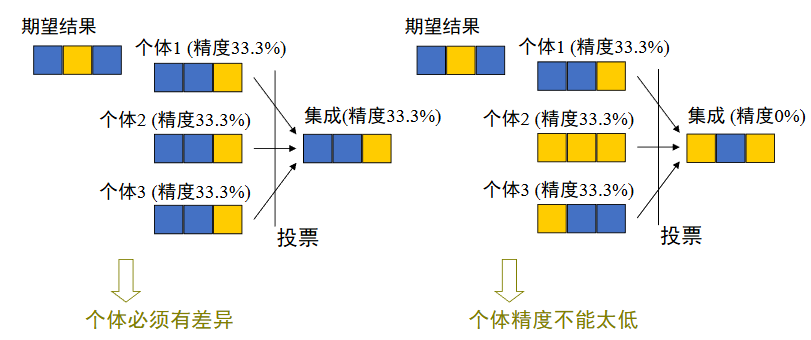

集成个体应该好而不同。假设集成通过简单的投票法结合T个分类器,若有超过半数的基分类器正确,则分类就正确。

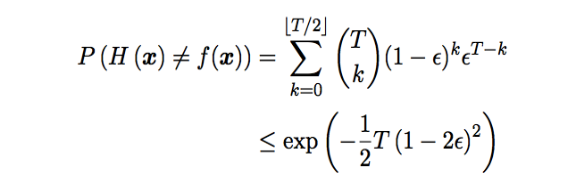

假设基分类器的错误率相互独立,则由Hoeffding不等式可得集成的错误率为:

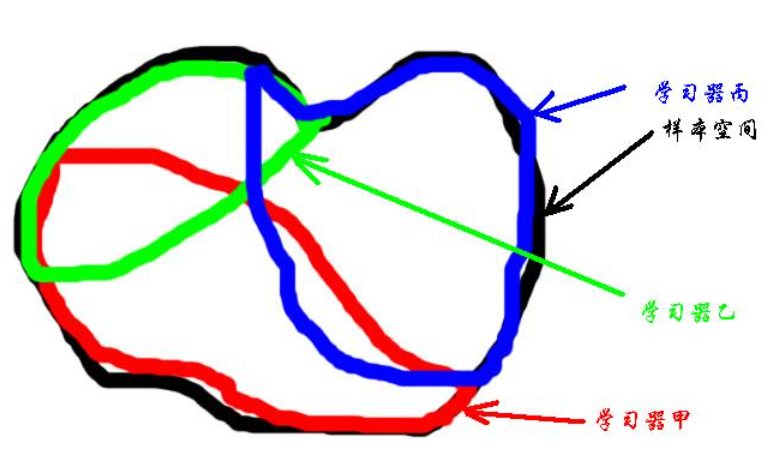

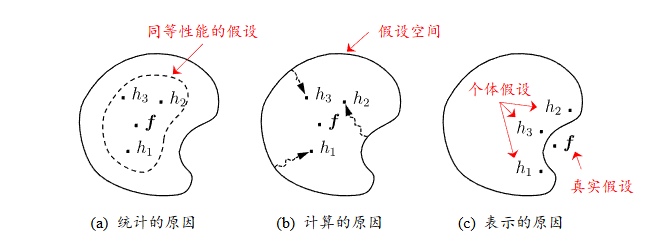

这就说明,在一定条件下,随着集成分类器数目的增加,集成的错误率将指数下降。上面的分析有一个关键假设:基学习器的误差相互独立。现实任务中,个体学习器是为解决同一个问题训练出来的,显然不可能互相独立。

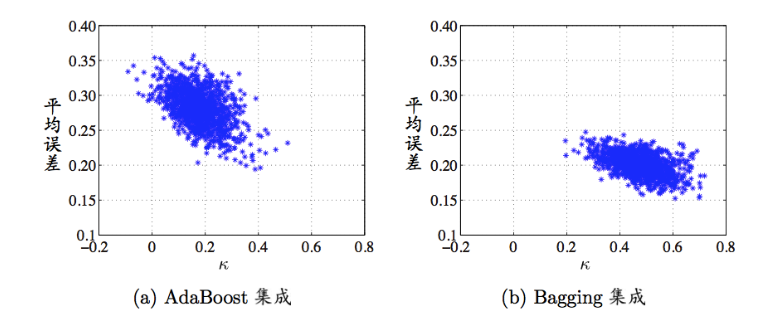

事实上,个体学习器的"准确性"和"多样性"本身就存在冲突,如何产生"好而不同"的个体学习器是集成学习研究的核心集成学习大致可分为两大类 Boosting 和 Bagging。

一、采样

1.1 随机采样

采样是一个区分不同集成的重要方式,在原来的训练集上随机采样,可以得到新的训练集。

1.2 带权采样

采样时,可以给训练集里的每个元素不同的权,权值可以通过上一次训练的结果来确定。

通过给训练数据赋予不同的权,实际上使得每个学习器关注训练集中的某一部分,这也是民主投票的想法。直观来看,每个学习器关注训练集中的某一部分,很多个训练集应该可以覆盖训练集中的大部分,只要巧妙地加权平均,就可以得到很好的学习效果。

集成学习一般自认为是单模型,对于模型的分析是在整体上完成的,但是其实这些模型都可以看作是一种加权平均的多模型。

在算法上,集成学习典型代表Adaboost 算法是和SVM并立的方法,而且集成学习比SVM更为一般。其中,泛化能力generalization是机器学习关注的基本问题之一。

二、集成学习

集成学习使用多个同质的学习器来解决同一个问题。当个体为决策树时,称为决策树集成,个体为神经网络时为神经网络集成。

构建一个好的集成,个体学习器需要足够精确,差异足够大。通常的学习算法,根据训练集的不同,会给出不同的学习器。这时就可以通过改变训练集来构造不同的学习器,然后再把它们集成起来。

2.1 分类设计的重采样技术

分类设计的重采样技术也被称为自适应权值重置和组合。这类方法利用一个训练样本集合构造多个分类器,然后以某种方式将这些分类器组合成一个分类器。包括了bagging和boosting。

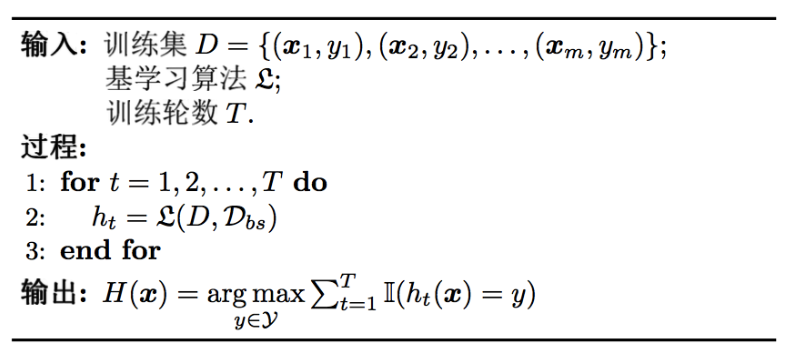

2.2 boost算法

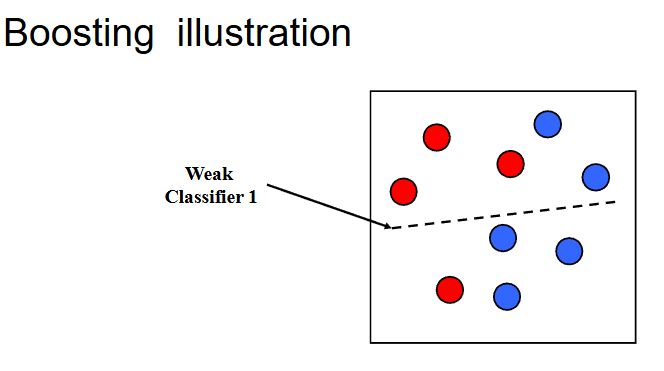

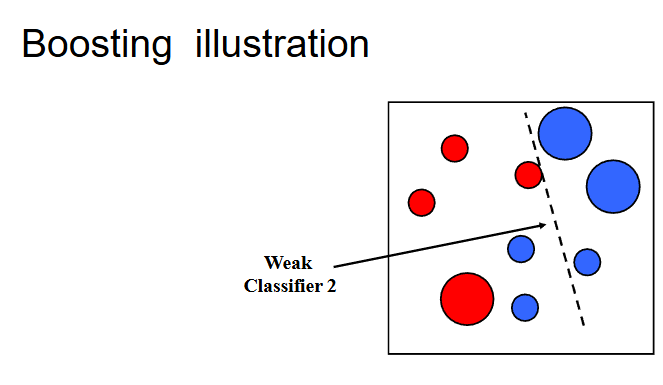

Boosting算法同样利用训练样本集合构造多个分量分类器。它要求这个分类器是一个 弱分类器----准确率比平均性能好。

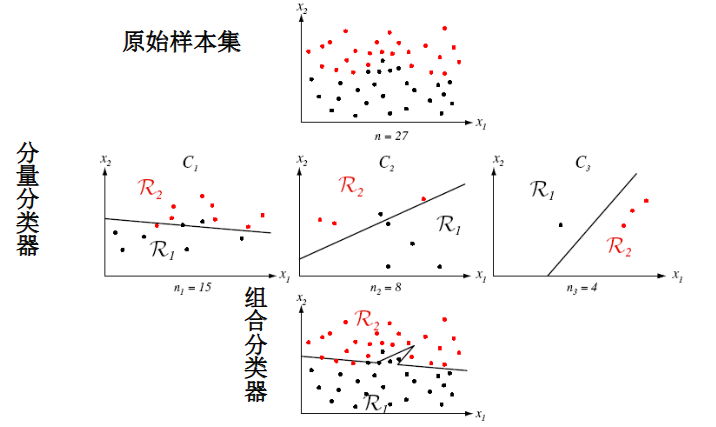

举例:2类问题,3个分量分类器的训练算法

1.在数量为n的原始样本集D中选取n1个样本构成D1,利用D1 训练出一个C1。

2.在样本集D-D1 中选择被正确C1分类的样本和错误分类的样本各一半组成样本D2,用D2训练出一个分类器C2。

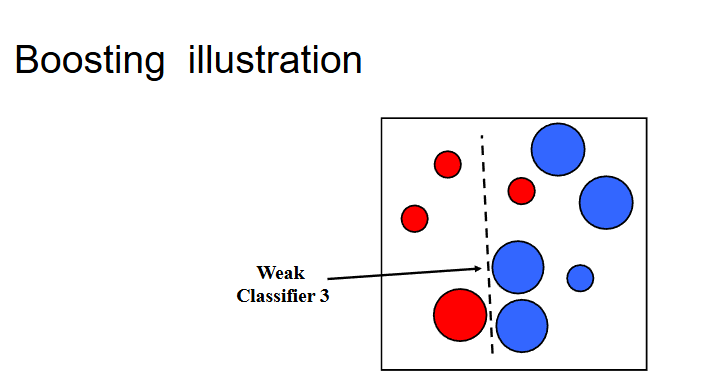

3.将样本集合D-D1-D2中所有的C1 C2分类不同结果的样本组成样本集合D3,训练出一个分类器C3。

个体学习器存在强依赖关系,且是串行生成,每次调整训练数据的样本分布:

对新的样本x进行分类,如果C1 C2判别结果相同,则将x判别为此类,否则以C3的结果作为X的类别。

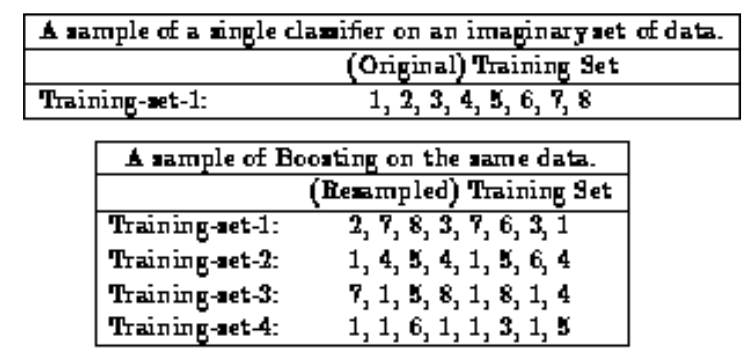

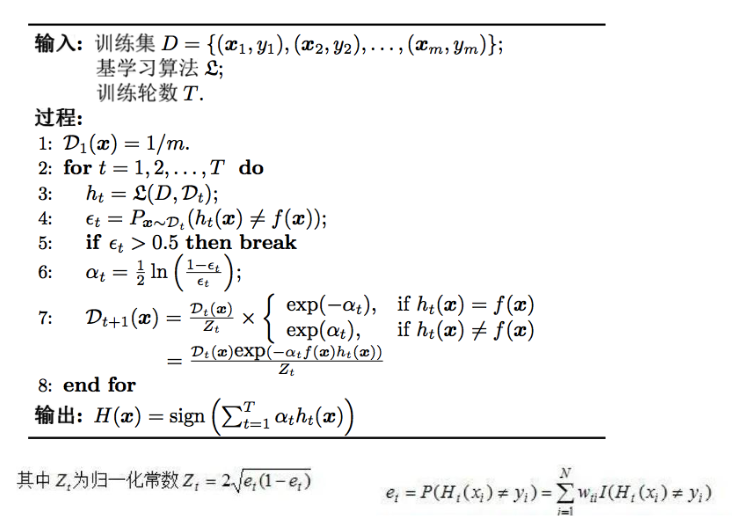

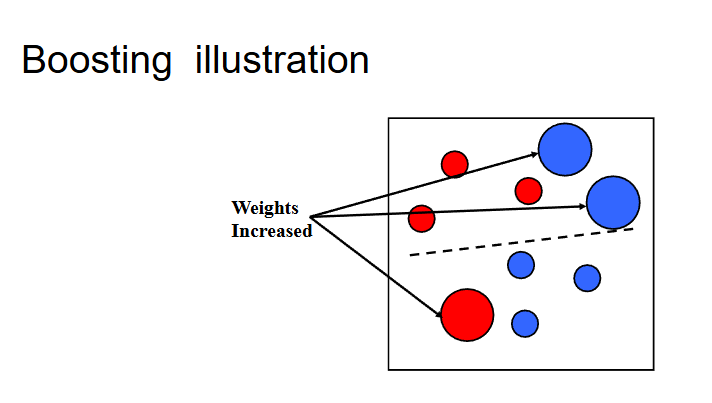

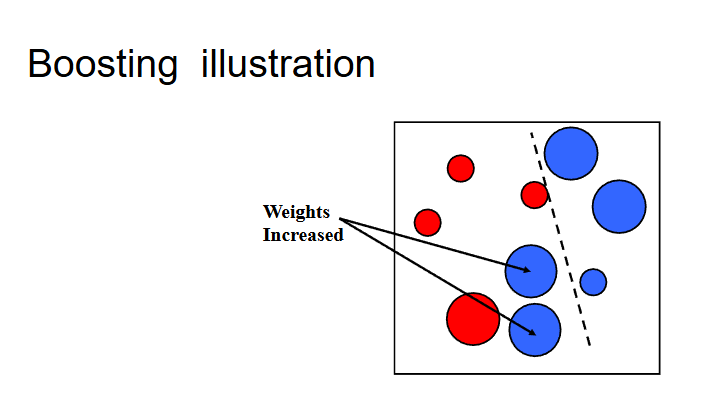

Boosting算法首先给每一个训练样例赋予相同的权重,然后训练第一个基本分类器并用他来对训练集进行训练。对于分类错误的测试样例提高其权重 ,实际上是降低分类正确的权重。然后调整后的带权训练集训练第二个分类器,重复这个过程,知道最后得到一个足够好的学习器。

三、Adaboost

考虑问题,每一轮如何改变训练数据的权值或概率分布。Ada 提高了那些前一轮被弱分类器错误分类样本的权值,降低了正确分类的样本。如何将弱分类器组合成一个强分类器?Ada 加权多数表决,加大分类器误差率小的弱分类器权值,在表决中起大作用。

可以考虑下面的例子:

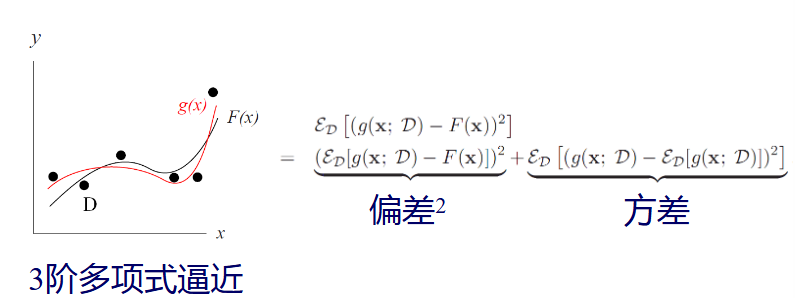

从偏差-放方差的角度:降低偏差可对泛化能力弱的分类器构造出很强的集合。

四、Bagging

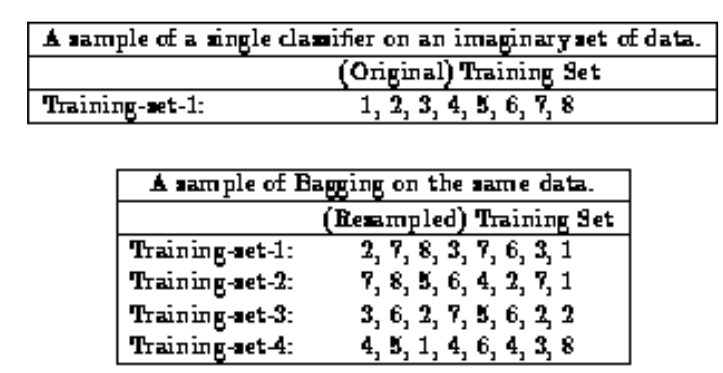

对训练集有放回的抽取训练样例,从而为每一个基本分类器都构造出跟训练集相当大小,但大小不同的训练集,从而训练出不同的基本分类器;该算法是基于对训练集进。处理的集成方法中最简单的一种。

Bagging和Boosting的区别在于在Bagging训练集的选择是随机的,各轮训练集之间的选择相互独立,而Boosting是和前面有关。同时,Bagging的各个预测函数没有权重,Boost是有权重的,Bagging的各个预测函数是可以并行生成的。一般情况下,Bagging方法比较稳定,但boost却是时好时好是坏,取决于上一次预测的效果。

五、随机森林

Bagging的时间复杂度为Om,采样与投票的平均过程难度为Os,那么bagging集成和直接使用基学习器的复杂度同阶。

随机森林RF是bagging的一个扩展变种,其采样的随机性,属性选择的随机性。取决于森林中单树的分类强度:每棵树分类强度越大,则随机森林的分类器性能越好;而树之间的相关度越大,分类性能则是越差。

随机森林随两个随机性的引入,使得RF不容易键入过拟合,同时需要较好的抗噪声能力,对数据集适应能力强,离散和连续数据都能够处理无需泛化。

六、结合策略

学习器的组合可以从三个方面带来好处:

回归分析确定两种或两种以上变数间相互依赖的定量关系和一种统计分析方法,根据一组函数Fx的含噪采样点的点集D,确定了一个近似函数Gx拟合未知函数Fx

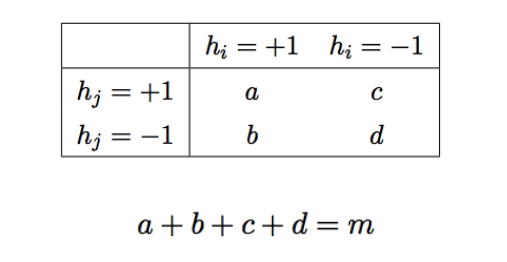

多样性度量用于度量集成学习中个体学习器的多样性,对于二分类问题,分类器的预测结果联立表:

常见的多样度量包括:不合度量,相关系数,Q-统计量和K-统计量

增加个体学习器的多样性方法包括 : 数据样本扰动,输入属性扰动,输出表示扰动,算法参数扰动,。数据样本扰动通常是基于采样法的,对于不稳定基学习器很有效。

。对于比如决策树和神经网络,但是稳定基学习器,线性学习器,svm,朴素贝叶斯,KNN等则对其不敏感。

输入属性扰动通常可以用随机子空间算法。输出表示扰动可以用翻转法,输出调剂法,ECOC法。

七、选择性集成

在有一组个体学习器可用时,从中选择一部分进行集成,可能比用所有个体学习器进行集成更好。