Transformer--NeurIPS2017:首次提出

ViT:首次将Transformer引入到视觉任务中

DETR--ECCV2020:首次用来检测

Efficient DETR--ArXiv2021:使用RPN初始化object query

Conditional DETR--ICCV2022

Anchor-DETR-AAAI2022

DAB-DETR--ICLR2022

DN-DETR--CVPR2022

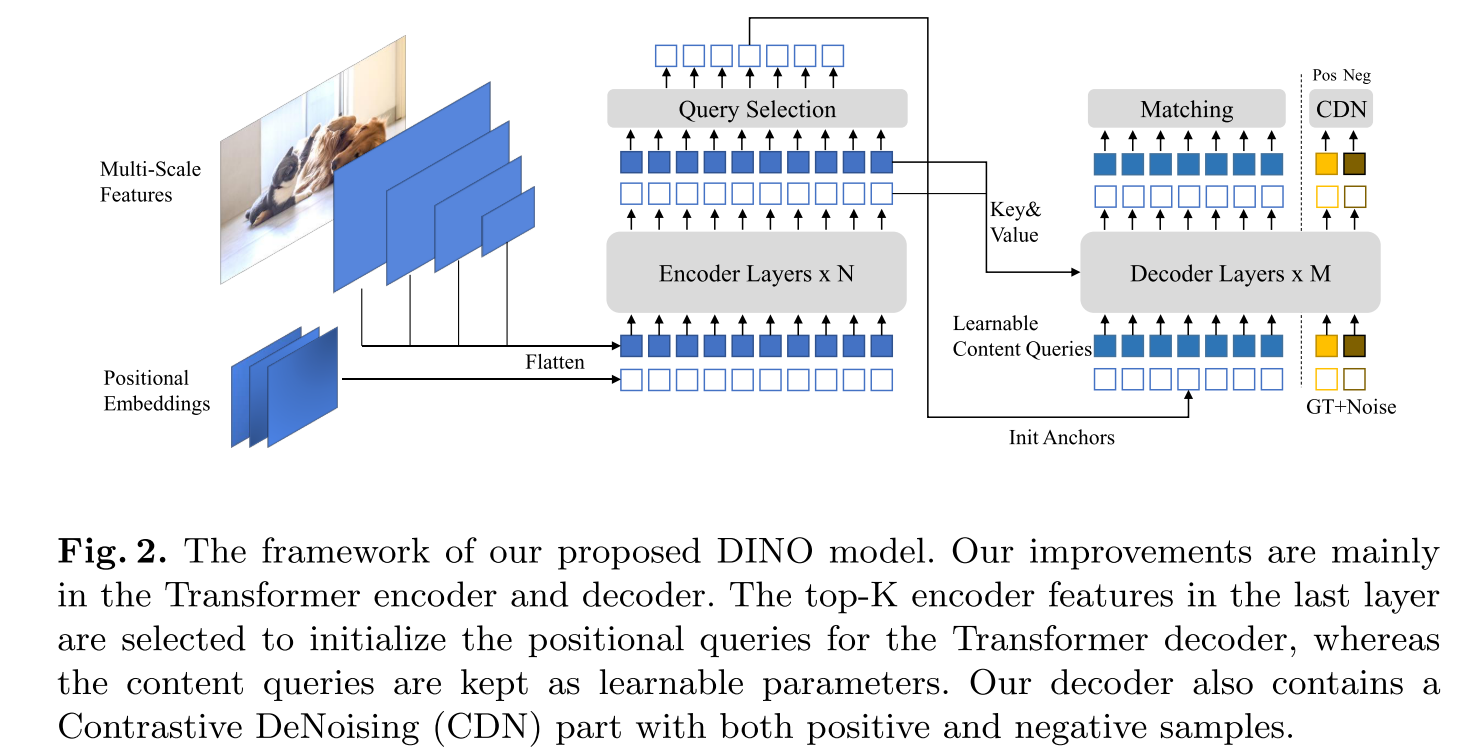

DINO--ICLR2023

Group-DETR--ICCV2023

H-DETR--CVPR2023,与Group DETR有点类似

《DAC-DETR: Divide the Attention Layers and Conquer》--NIPS2023

文中指出Decoder阶段的self-attention让各个query远离,而cross-attention将query的各个部分聚集,因此提出将self和cross分而治之。

《Detection Transformer with Stable Matching Shilong》--ICCV2023

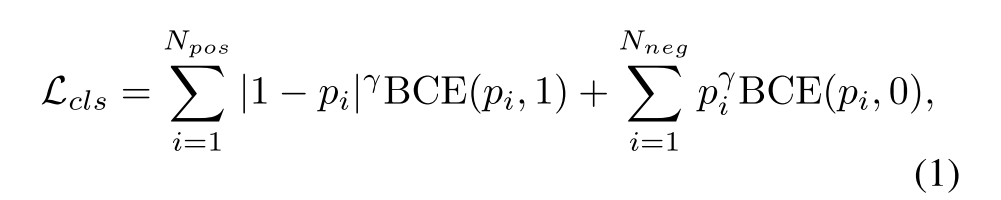

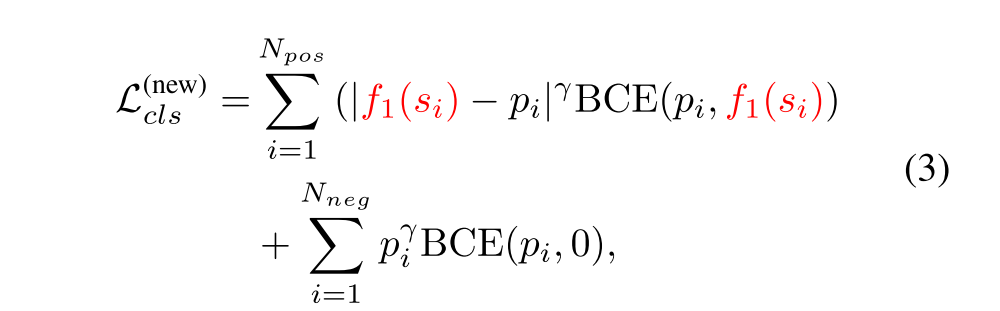

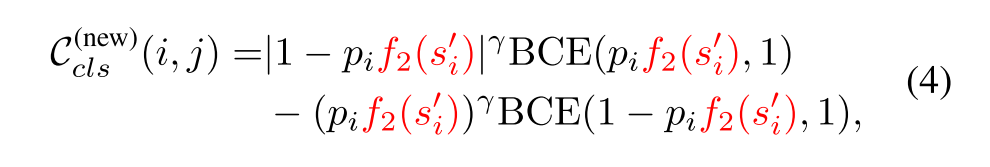

论文指出DETR类模型的匹配不稳定来源于匈牙利匹配是基于得分和位置的,有的得分相近但位置距离远,有的位置距离近但得分远。基于此,本文提出在在匹配的得分中使用

原来的匹配损失

论文提出的匹配损失

或者

《Cascade-DETR: Delving into High-Quality Universal Object Detection》--Cascade-DETR:ICCV2023

基于Conditional DETR的基础上,在backbone输出的不同层之间使用注意力机制,同时使用预测的边界框作为mask。同时,本文也指出Detr类方法缺少了归纳偏置,而使用数据驱动的方法来学习。但是,由于缺少数据,从而使得学习效果并不好。

RT-DETR--CVPR2024

AlignDETR--BMCV2024

《Relation DETR: Exploring Explicit Position Relation Prior for Object Detection》--ECCV2024

MR-DETR--CVPR2025