在自动驾驶技术的发展进程中,世界模型扮演着核心角色,精准的场景理解与未来预测是保障驾驶安全的关键。当前,尽管已有研究尝试将视觉 - 语言模型(VLMs)应用于规划任务,但大多将感知、预测和规划视为独立模块,存在信息传递瓶颈与误差累积等问题。为此,来自博世北美研究院、华盛顿大学等机构的研究团队提出了 UniDrive-WM,一种基于 VLM 的统一世界模型,在单一架构中实现了驾驶场景理解、轨迹规划和轨迹条件下的未来图像生成。

原文链接:https://arxiv.org/pdf/2601.04453

项目主页:https://unidrive-wm.github.io/UniDrive-WM

代码链接:Coming Soon (主页)

沐小含持续分享前沿算法论文,欢迎关注...

一、研究背景与动机

1.1 领域发展现状

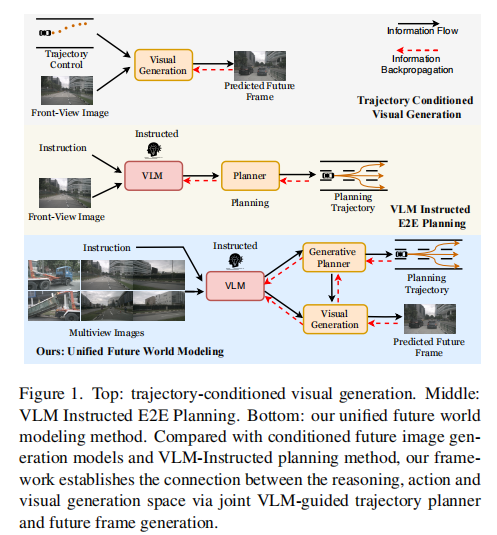

近年来,多模态大型语言模型(MLLMs)凭借 VLMs 强大的感知、推理和指令遵循能力取得了显著进展,同时视觉生成技术沿着自回归(AR)tokens 预测和基于扩散的连续生成两条互补路线不断演进,实现了多样化任务下的高保真图像合成。受这些趋势启发,越来越多的统一模型致力于在单一 VLM 中结合理解与生成能力,让系统能在共享语义空间中 "思考与生成"。

在自动驾驶领域,世界模型通常被定义为通过学习推断当前场景的 latent 表示,并基于动作预测未来状态,从而支持鲁棒的规划与控制。现有方法可按输出模态大致分类:部分专注于视觉场景生成,部分强调未来轨迹规划,还有一些以占用率、激光雷达或点云形式进行 3D 场景重建。然而,这些方法大多仅聚焦于单一预测模态。

同时,现有基于 VLM 的自动驾驶方法存在明显缺陷:许多方法依赖纯文本中间件,先生成未来轨迹或场景的自然语言描述,再通过单独阶段解码轨迹或渲染图像,这导致丰富的视觉 - 几何线索被抽象为文本,不可避免地造成信息损失,且误差会在各阶段累积;而生成模型虽能生成视觉上合理的帧,但缺乏明确的状态估计和推理能力,无法可靠地利用多视图线索或高层指令,也无法为可验证规划提供与动作空间的可微桥梁,难以处理因果查询、执行安全约束或向感知反馈规划一致的信号。

1.2 核心研究动机

人类驾驶的认知过程本质上是一个联合任务:感知当前场景、预测未来轨迹并想象下一个视觉场景。这种认知特性促使研究人员探索一种统一的框架,将理解、规划和视觉预测在单一 VLM 框架中进行端到端学习,实现推理、动作和生成之间的双向信息流动。UniDrive-WM 正是基于这一动机提出,旨在打破现有方法的局限,通过紧密集成 VLM 驱动的推理、规划和生成式世界建模,提升自动驾驶系统的性能与安全性。

二、核心方法:UniDrive-WM 模型架构详解

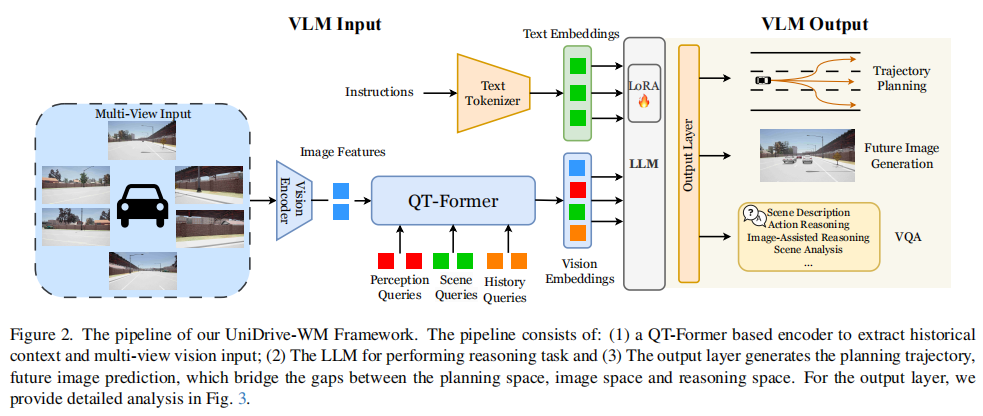

UniDrive-WM 的核心目标是在单一 VLM 中心架构中联合执行场景理解、轨迹规划和未来图像生成。其整体 pipeline 如图 2 所示,主要包含视觉语言模型(VLM)、轨迹规划器和未来图像生成器三大核心组件,同时通过独特的训练策略实现各组件的协同优化。

图 2 清晰展示了 UniDrive-WM 的整体流程,主要包括:(1)基于 QT-Former 的编码器,用于提取历史上下文和多视图视觉输入;(2)用于执行推理任务的 LLM;(3)生成规划轨迹和未来图像预测的输出层,该层架起了规划空间、图像空间和推理空间之间的桥梁。

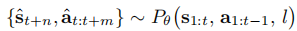

2.1 问题定义

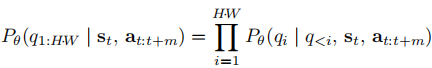

UniDrive-WM 的任务被定义为联合预测未来场景状态和规划轨迹,其数学表达如下:

进一步分解为:

其中, 表示时间

时的多模态状态信息,包括多视图图像、历史上下文和感知特征;模型预测的未来前视图

是未来状态

是未来状态  的一部分;

的一部分; 表示时间

表示时间 时的预测轨迹路点;

是高层语言或指令条件。该模型旨在在统一的视觉 - 语言世界模型下,联合推理未来世界状态并规划一致的轨迹。

2.2 视觉语言模型(VLM)

VLM 是世界模型的核心,负责理解当前状态并指导轨迹规划器和图像生成器的工作。UniDrive-WM 基于 Orion(一种用于自动驾驶规划任务的 VLM 模型)构建,主要包含视觉编码器和大型语言模型(LLM)两部分。

2.2.1 视觉编码器

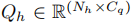

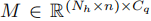

视觉编码器采用了此前方法中使用的 QT-Former,通过两组可学习查询(query),在自注意力(SA)模块中交换信息,并在交叉注意力模块中与带有 3D 位置编码的图像特征 进行交互。之后,感知查询被输入到多个辅助头,用于目标检测(包括关键目标、车道、交通状态和动态目标的运动预测)。

此外,模型引入了一组历史查询  和记忆库

和记忆库  来检索和存储过去

来检索和存储过去 帧的历史信息,其数学表达如下:

其中, 表示相对时间戳嵌入。更新后的历史查询

被存储在记忆库

被存储在记忆库 中,记忆库的更新公式为:

最后,通过两层多层感知器(MLP)将更新后的历史查询  和当前场景特征

和当前场景特征 转换为 LLM 推理空间中的历史token

和场景token

。

2.2.2 大型语言模型(LLM)

LLM 作为框架的推理核心,支持基于文本的理解和高层推理任务,如场景描述、视觉问答(VQA)和动作推理。为了高效地使 LLM 适应自动驾驶场景下的特定领域推理和指令遵循,研究团队采用 LoRA(低秩适配)对 LLM 进行微调,在不显著增加计算成本的前提下,实现模型性能的提升。

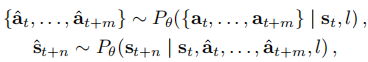

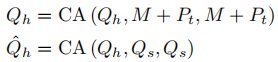

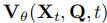

2.3 轨迹规划器

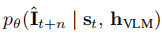

轨迹规划器通过潜在空间中的分布学习,在 VLM 的语义推理空间和轨迹预测的数值动作空间之间建立可微连接。轨迹生成被表述为一个条件分布问题,规划器基于 VLM 的高层推理嵌入,对未来轨迹建模多模态分布,其数学表达为:

其中, 表示预测的轨迹路点,

表示预测的轨迹路点, 表示当前状态嵌入,

表示从 VLM 中提取的高层推理嵌入(隐藏表示),该嵌入编码了融合后的多视图观测、时间历史和文本指令。

为了捕捉未来运动的随机性,模型引入了潜在变量 ,其位于高斯潜在空间中,规划器从

中解码出多样化且语义一致的轨迹。在实践中,研究团队省略了传统 VAE 目标中使用的显式 KL 正则化项,因为经验发现该正则化项可能会在大规模多模态设置中破坏训练稳定性。这种设计在基于语言的推理和连续轨迹预测之间搭建了稳定且可微的桥梁。

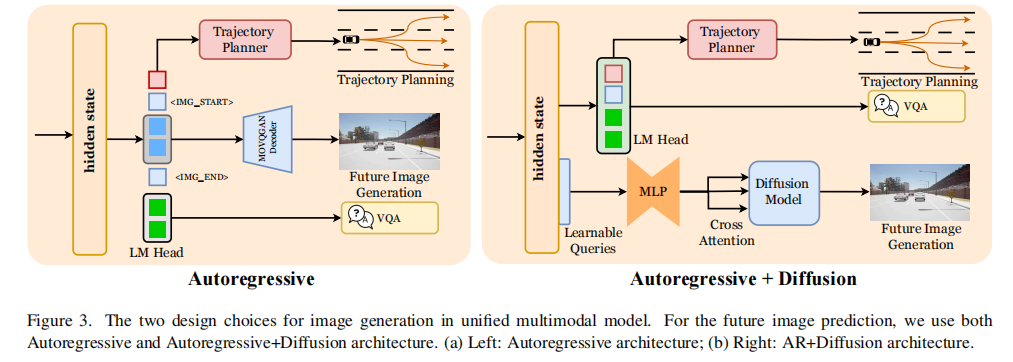

2.4 未来图像生成

未来图像生成模块是 UniDrive-WM 的一大亮点,研究团队采用了两种不同的图像生成架构,分别是离散表示的自回归生成(AR)和连续表示的自回归 + 扩散生成(AR+Diffusion),如图 3 所示。

图 3 展示了两种图像生成架构:(a)左侧为自回归架构;(b)右侧为 AR+Diffusion 架构。

两种架构均基于统一的概率表述,旨在基于语义表示预测未来前视图帧  ,其数学表达为:

,其数学表达为:

其中, 表示多模态状态信息(包括多视图观测、时间历史和感知特征),

是从 VLM 中提取的高层推理嵌入,编码了视觉和文本上下文。

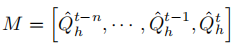

2.4.1 自回归生成(离散表示)

对于离散图像生成,研究团队首先通过扩大 VLM 的码本(codebook)来激活其视觉生成能力。假设语言 - 视觉模型使用联合码本  ,扩大码本后,VLM 能够在语言和视觉空间中自回归地执行多模态下一个token预测。

,扩大码本后,VLM 能够在语言和视觉空间中自回归地执行多模态下一个token预测。

为了指示视觉token序列的边界以及何时使用视觉头,模型引入了特殊token ⟨image start⟩ 和 ⟨image end⟩。具体来说,基于输入的视觉token和规划token  ,模型自回归地执行下一个token预测,其数学表达为:

,模型自回归地执行下一个token预测,其数学表达为:

其中, 是视觉token,

表示当前多模态状态(包括视觉观测、时间历史和感知特征),

表示对应的规划token,用于条件化后续视觉token的生成。

表示对应的规划token,用于条件化后续视觉token的生成。

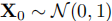

2.4.2 AR+Diffusion 生成(连续表示)

除了完全自回归生成,研究团队还设计了 AR+Diffusion 架构以提升视觉质量。基于扩散的生成可表述为一个条件去噪过程,其数学表达与未来图像生成公式一致:

其解码器条件依赖于高层推理嵌入 和自回归模块生成的潜在图像特征。

生成过程从高斯噪声  开始,扩散过程逐渐将

开始,扩散过程逐渐将 细化为真实未来图像的潜在嵌入

。在提取连续视觉嵌入后,模型采用自回归转换器,基于

生成相应的潜在图像特征。

具体来说,输入指令经过 tokenized 后映射为文本嵌入序列  ,随后在 LM 头前附加一个可学习的查询token

,随后在 LM 头前附加一个可学习的查询token (随机初始化并在训练过程中更新)。转换器处理组合序列

,在此过程中

,在此过程中 关注

中编码的语义上下文,并聚合与图像合成相关的特征。输出查询令牌

作为预测的视觉潜在表示,并通过监督使其与视觉编码器提取的真实图像嵌入

匹配。

为了使 与

对齐,模型使用了流匹配(flow matching)目标来建模连续特征分布。给定真实图像特征

和文本条件化的潜在查询

,采样时间步

和噪声向量

和噪声向量  ,沿插值路径计算潜在点:

,沿插值路径计算潜在点:

对应的目标速度为:

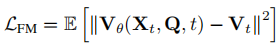

扩散转换器预测速度  ,流匹配损失为:

,流匹配损失为:

值得注意的是,模型冻结了视觉编码器的权重,仅微调扩散解码器。尽管解码器采用扩散架构,但它通过确定性重建损失而非概率采样目标进行训练。因此,在推理过程中,模型执行确定性重建,这虽然降低了多样性,但确保了自动驾驶场景中未来帧预测的稳定性和准确性。

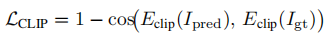

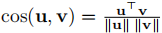

此外,模型还在解码的未来图像和真实图像之间应用了基于 CLIP 的监督,以维持语义对齐:

其中, ,

, 表示 CLIP 图像编码器产生的嵌入,

表示 CLIP 图像编码器产生的嵌入, 是预测图像,

是真实图像。该扩散路径通过为未来帧合成提供连续的、几何感知的潜在空间,补充了离散自回归生成分支,在统一世界模型框架内实现了稳定且语义一致的视觉预测。

2.5 联合图像生成与规划

为了实现联合图像生成与规划,研究团队将规划token直接放置在图像token之前,使得每个图像token的生成都以生成的规划表示为条件。这样一来,图像生成同时以当前状态视觉嵌入和未来状态的预测轨迹为条件,能够合成与规划运动对齐的一致未来帧。

对于自回归生成,图像token预测与语言生成类似,并通过带有交叉熵损失的教师强制(teacher-forcing)进行监督。模型采用了来自 ORION 的预训练 QT-Former,并在训练过程中冻结其检测头。对于规划分支,遵循 VAD 和 ORION 的实现,仅训练规划头,其损失函数为:

其中, 表示碰撞损失,

表示边界损失,

表示均方误差损失。

自回归架构的整体目标为:

而对于 AR+Diffusion 架构,其潜在空间中的可学习潜在查询作为图像生成的条件嵌入,完整目标为:

其中, 是流匹配损失,

是基于 CLIP 的语义对齐损失。

2.6 训练策略

为了在保留底层 VLM 的 VQA 能力的同时实现规划和图像生成,研究团队采用了两阶段训练策略:

阶段 1:联合规划与图像生成

对整个模型进行端到端训练,通过 LoRA 更新 LLM。对于自回归生成器,将图像起始token直接放置在规划token之后,以强制规划条件化的自回归解码。对于 AR+Diffusion 架构,在潜在空间中,将 64 个可学习潜在查询token附加在规划特征之后,以条件化扩散解码器。

阶段 2:联合规划、图像生成与 VQA

使用混合的 VQA 和驾驶数据继续训练,同时保持与阶段 1 相同的架构设置。该阶段通过联合优化 VQA、轨迹规划和未来图像预测,强化视觉 - 语言 - 规划空间的对齐,在单一框架内实现统一的多模态推理。

三、实验设计与结果分析

3.1 实验设置

3.1.1 硬件与模型配置

实验在 8×NVIDIA H200 GPU 上进行。视觉编码器采用 EVA-02-L,基础 LLM 选用 Vicuna 1.5,并通过 LoRA(rank=16,α=16)进行微调。场景查询、感知查询和历史查询的数量分别设置为 512、600 和 16,记忆库大小为 16 帧。输入图像经过增强后调整为 640×640 分辨率;对于未来帧预测,自回归分支使用 192×128 分辨率,AR+Diffusion 分支使用 256×256 分辨率,以平衡质量和速度;扩散解码器使用 64 个潜在可学习查询token。

3.1.2 数据集

实验在 Bench2Drive 数据集上进行训练和评估,该数据集是基于 CARLA v2 构建的闭环基准测试集。遵循先前的工作,使用包含 1000 个驾驶场景的基础分割:950 个用于训练,50 个用于开环验证。每个场景涵盖约 150 米的连续驾驶,包含不同的交通场景。闭环评估遵循官方协议,包含 220 条短路线,跨越 44 个交互场景(每个场景 5 条路线)。

3.1.3 评估指标

- 闭环评估:采用 Bench2Drive 的四个关键指标,包括驾驶分数(DS)、成功率(SR)、效率(Efficiency)和舒适度(Comfortness)。成功率衡量在指定时间限制内成功完成路线的百分比;驾驶分数遵循 CARLA 协议,结合路线完成度和违规惩罚;效率和舒适度分别评估自动驾驶策略在整个驾驶过程中的速度性能和平顺性。

- 开环评估:报告 L2 轨迹误差和碰撞率;使用标准 nuScenes 指标评估 3D 检测性能,包括平均精度(mAP)、平均平移误差(mATE)、平均尺度误差(mASE)、平均方向误差(mAOE)、平均速度误差(mAVE)和整体检测质量(NDS);对于未来帧预测,使用弗雷歇 inception 距离(FID)评估生成帧分布与真实未来帧分布的接近程度。

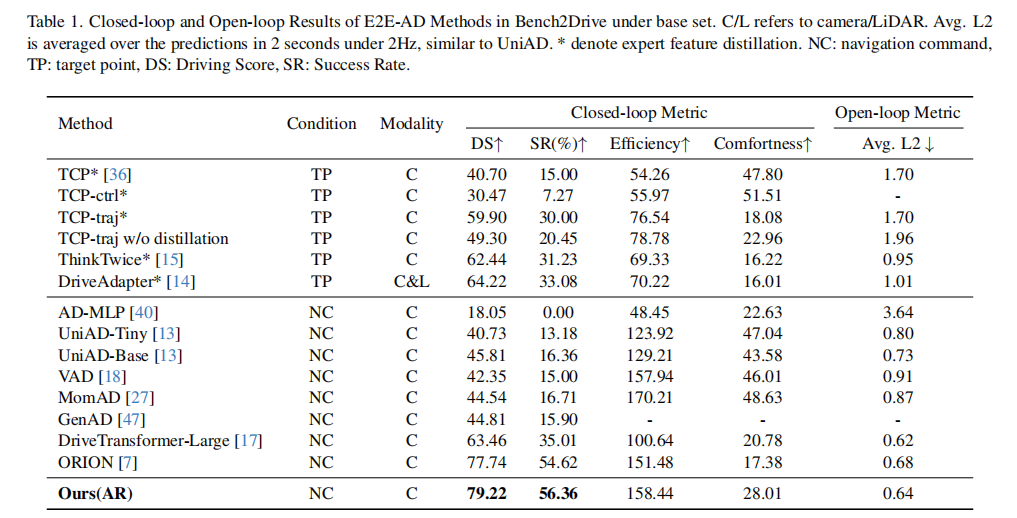

3.2 轨迹规划结果评估

3.2.1 闭环评估结果

闭环评估结果如表 1 所示,UniDrive-WM(AR 架构)在驾驶分数(DS=79.22)、成功率(SR=56.36%)等关键指标上显著优于所有以目标点(TP)和导航指令(NC)为条件的对比方法。这表明,图像生成模态的引入有效提升了规划任务的性能,验证了统一框架的有效性。

注:C/L 指相机 / 激光雷达;Avg. L2 是在 2Hz 下对 2 秒内的预测值取平均;* 表示专家特征蒸馏;NC:导航指令,TP:目标点,DS:驾驶分数,SR:成功率。

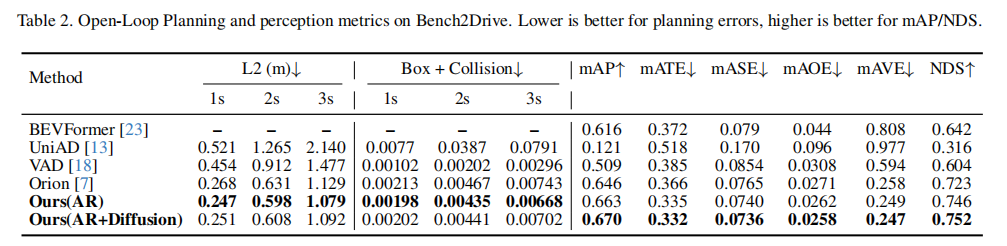

3.2.2 开环评估结果

开环评估结果如表 2 所示,与先前的 VLM 引导规划方法和端到端规划方法相比,UniDrive-WM 的两种架构(AR 和 AR+Diffusion)在规划和检测任务上均取得了更优的性能。在 L2 轨迹误差方面,AR 架构在 1s、2s、3s 时的误差分别为 0.247m、0.598m、1.079m,均低于对比方法;在碰撞率(Box + Collision)上也保持了较低水平;同时,在 mAP(0.663)和 NDS(0.746)等检测指标上也有显著提升。这进一步验证了未来图像预测对规划任务性能的改善作用。

注:规划误差越低越好,mAP/NDS 越高越好。

3.3 图像生成结果评估

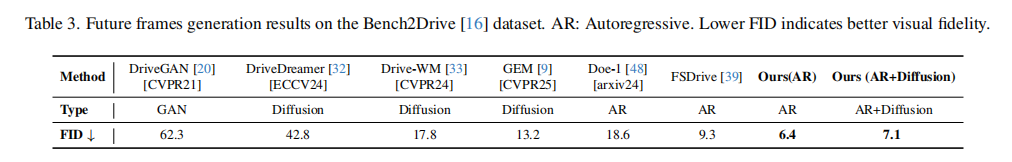

3.3.1 定量结果

图像生成的定量结果如表 3 所示,UniDrive-WM 的两种架构均取得了优异的 FID 分数。其中,AR 架构的 FID 为 6.4,AR+Diffusion 架构的 FID 为 7.1,显著低于对比方法(如 FSDrive 的 FID 为 9.3,Doe-1 的 FID 为 18.6)。这表明,UniDrive-WM 生成的未来帧与真实未来帧的分布更为接近,视觉保真度更高。

值得注意的是,与 FSDrive(一种基于图像特征条件化规划的统一视觉 - 规划框架)相比,UniDrive-WM 直接基于规划令牌条件化图像生成,在 AR 和 AR+Diffusion 分支中均实现了规划条件化的未来帧预测。这种规划与视觉预测之间更紧密的耦合改善了轨迹对齐,使得未来帧更准确地遵循预期运动,从而提升了 FID 性能。

注:FID 越低表示视觉保真度越好。

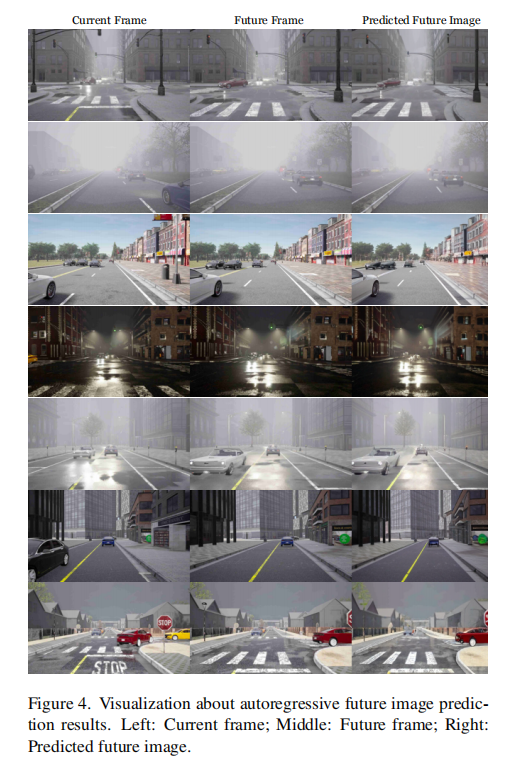

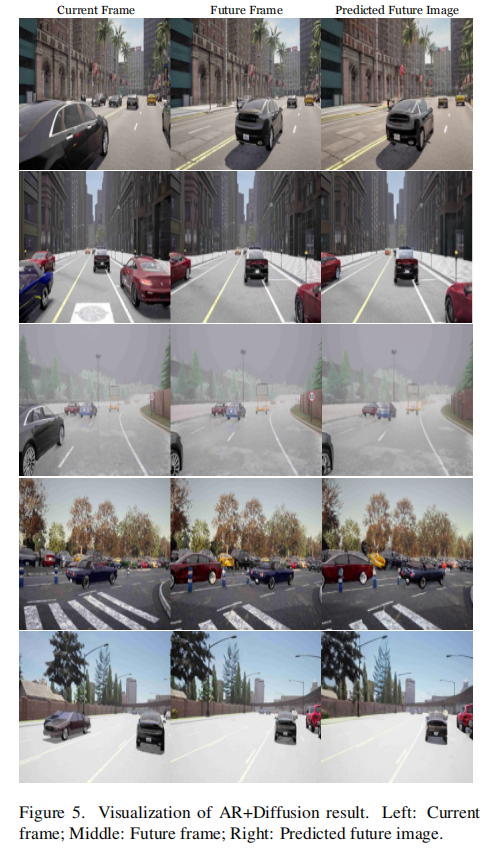

3.3.2 定性结果

图 4 和图 5 分别展示了 AR 架构和 AR+Diffusion 架构的未来图像预测定性结果。可以看出,两种架构生成的未来帧在视觉上具有连贯性,与真实未来场景的演变高度匹配,并且与预测轨迹保持一致。例如,在包含交通灯、其他车辆等关键元素的场景中,生成的未来帧能够准确捕捉这些元素的位置变化和状态转换,验证了模型在复杂驾驶场景中生成高质量未来图像的能力。

图 4 中,左列是当前帧,中列是未来帧,右列是预测的未来图像。

图 5 中,左列是当前帧,中列是未来帧,右列是预测的未来图像。

3.3.3 两种图像生成架构的对比分析

离散自回归(AR)和连续 AR+Diffusion 两种范式各有优劣,呈现出互补的权衡关系:

- AR 架构:基于离散令牌的设计使其能够实现实时生成和快速决策,但表示能力受到令牌粒度的限制。增加图像分辨率需要插入更多令牌,这会显著减慢 VLM 的训练和适配速度。

- AR+Diffusion 架构:在连续潜在空间中运行,特征对齐与图像分辨率无关,能够实现更高保真度的未来帧预测。它利用连续嵌入和可学习潜在查询,在视觉复杂或推理密集的场景中表现更优,其连续潜在表示支持更灵活的条件化,并提高了未来帧预测的重建保真度。但由于基于采样的表述,扩散解码器比 AR 方法具有更高的方差。

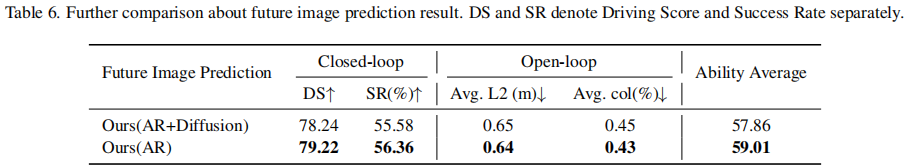

进一步的对比结果如表 6 所示,AR 架构在闭环指标(DS=79.22,SR=56.36%)、开环指标(Avg. L2=0.64m,Avg. col=0.43%)和能力平均值(59.01)上略优于 AR+Diffusion 架构。研究团队认为,这是因为图像令牌在令牌空间中的插入比在隐藏状态中插入可学习查询为规划提供了更明确的监督。然而,AR+Diffusion 架构有潜力生成更高分辨率的输出(512×512),提供更优的生成质量。未来的工作可能会将离散预测的图像令牌作为扩散模型的额外条件信号,以扩散最终的 VAE 特征,进一步提升规划性能。

注:DS 和 SR 分别表示驾驶分数和成功率。

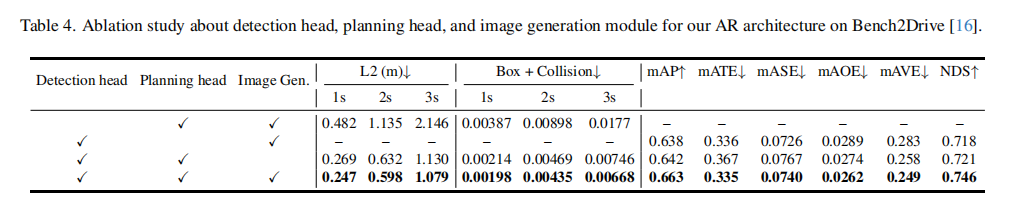

3.4 消融实验

为了评估检测头、规划头和图像生成模块对模型性能的贡献,研究团队在 AR 架构上进行了消融实验,结果如表 4 所示。

实验结果表明:

- 移除图像生成头会显著降低轨迹准确性并增加碰撞案例,说明未来帧预测为规划提供了有用的辅助信号。

- 禁用检测监督会通过削弱感知质量进一步损害规划性能。

这些发现验证了感知和未来帧预测具有互补作用,在统一世界模型中联合优化所有组件能够产生更可靠的驾驶行为。

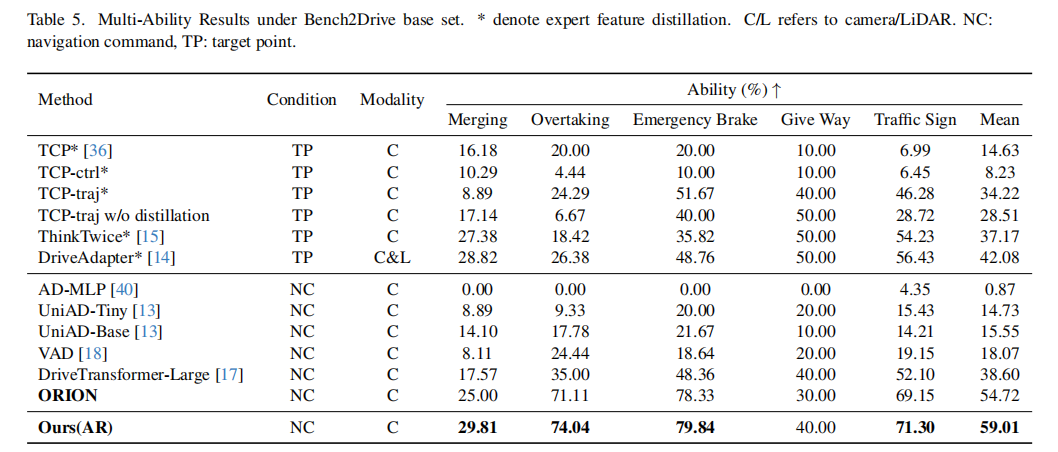

3.5 多能力评估

表 5 展示了 Bench2Drive 基础集上的多能力评估结果,UniDrive-WM(AR 架构)在合并(Merging)、超车(Overtaking)、紧急制动(Emergency Brake)和交通标志(Traffic Sign)等能力上均优于基线方法,平均得分达到 59.01。这表明,得益于 VLM 的推理能力和未来图像预测能力,UniDrive-WM 在多种驾驶场景下均表现出卓越的性能。

注:* 表示专家特征蒸馏;C/L 指相机 / 激光雷达;NC:导航指令,TP:目标点。

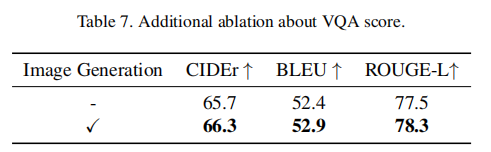

3.6 VQA 结果评估

表 7 展示了 VQA 分数的额外消融结果,与没有图像生成模块的模型变体相比,融入图像生成模块后,所有 VQA 指标(CIDEr、BLEU、ROUGE-L)均得到了持续提升。这表明,未来帧预测提供了额外的结构线索,有助于提升问答性能。从直观上看,更好地建模未来视觉状态能够增强模型对当前场景的理解,这与人类的感知过程一致。

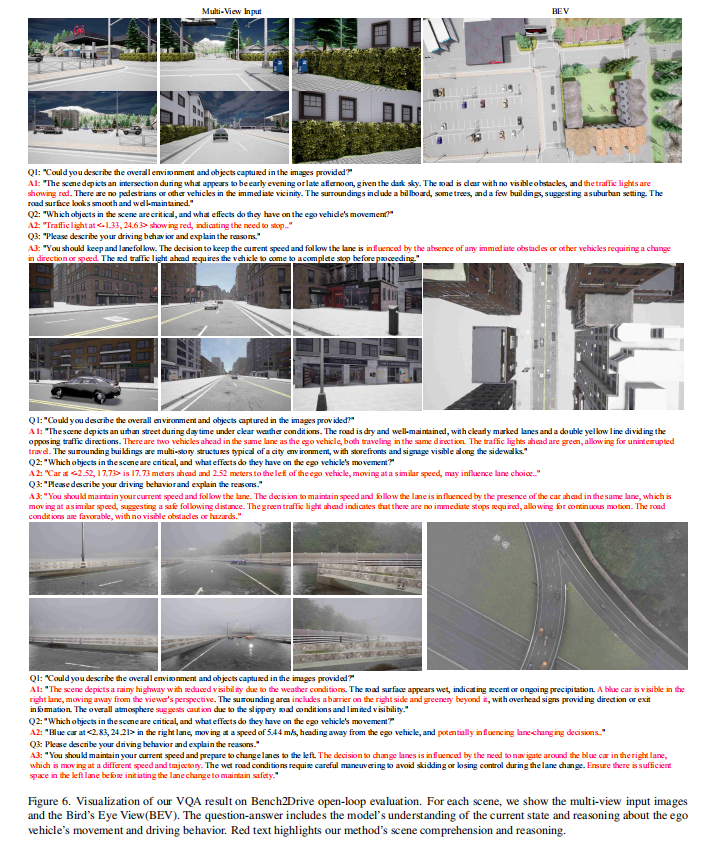

图 6 展示了 Bench2Drive 开环评估中 VQA 结果的可视化,模型不仅能够理解当前场景,还能对未来状态进行有效推理,即使在复杂的驾驶场景和恶劣的天气条件下,也能生成可靠的、面向决策的答案。

图 6 中,对于每个场景,展示了多视图输入图像和鸟瞰图(BEV),问答内容包括模型对当前状态的理解以及对 ego 车辆运动和驾驶行为的推理,红色文本突出了模型的场景理解和推理能力。

四、核心贡献与创新点

- 提出了 UniDrive-WM:一种统一的视觉 - 语言世界模型(VLM),无缝集成了场景理解、轨迹规划和未来图像生成,能够从时空观测中进行直接的视觉推理。

- 开发并分析了两种互补的解码范式:针对轨迹条件化的未来图像预测,提出了离散自回归(AR)路径和连续 AR+Diffusion 路径,揭示了它们在自动驾驶中的各自优势和权衡关系。

- 大量实验验证了统一框架的有效性:实验结果表明,UniDrive-WM 实现了高保真的、规划条件化的视觉生成,并在标准驾驶基准测试中显著提升了规划准确性和感知性能。

五、结论与未来工作

UniDrive-WM 通过将场景理解、轨迹规划和视觉生成集成到单一的世界模型驱动管道中,为自动驾驶技术提供了一种新的解决方案。该模型以视觉 - 语言模型(VLM)为骨干,基于当前和历史的多视图观测以及规划令牌预测未来图像帧,而规划条件化的视觉预测通过提供预期未来场景的视觉预测,反过来增强了轨迹规划。实验结果验证了该方法在图像生成、规划准确性和碰撞率降低方面的显著优势。

未来,研究团队计划将该框架扩展到更具交互性和长时域的驾驶场景,为下一代自动驾驶世界模型铺平道路。潜在的研究方向包括:进一步优化 AR+Diffusion 架构,结合离散令牌与连续扩散的优势;探索更复杂的交互场景建模,提升模型在多车辆、多行人交互场景下的性能;以及拓展模型的泛化能力,使其能够适应更多样化的天气、路况和地理环境。

六、总结

UniDrive-WM 的提出打破了自动驾驶领域中感知、规划与生成模块分离的传统模式,通过统一的 VLM 架构实现了三者的深度融合,有效解决了信息瓶颈和误差累积问题。其创新的双路径未来图像生成设计、可微的轨迹规划器以及协同优化的训练策略,为自动驾驶系统的性能提升提供了关键技术支撑。实验结果充分证明了该模型在场景理解、轨迹规划和未来图像生成等方面的卓越性能,为自动驾驶技术的进一步发展提供了重要的参考和借鉴。随着技术的不断迭代和优化,UniDrive-WM 有望在未来的自动驾驶系统中发挥重要作用,推动自动驾驶技术向更安全、更可靠、更智能的方向发展。