在 embodied AI 领域,视觉 - 语言 - 动作(VLA)模型与世界模型的发展虽展现出通用自主能力的巨大潜力,却始终受限于核心瓶颈------大规模、多样化机器人训练数据的稀缺。现有解决方案要么依赖成本高昂的真实机器人数据采集,要么通过简单叠加机器人部件编辑第一视角人类视频,均无法应对第三人称视频中的全身复杂动作、动态背景与严重遮挡问题。

新加坡国立大学 Show Lab 提出的 X-Humanoid 框架,以 "数据合成 - 模型适配 - 大规模生成" 为核心逻辑,首次实现第三人称人类视频到类人机器人视频的高质量转化,为机器人训练提供了全新的数据生成范式。

论文题目:X-Humanoid: Robotize Human Videos to Generate Humanoid Videos at Scale

项目链接:https://showlab.github.io/X-Humanoid/

作者单位:新加坡国立大学 Show Lab

问题根源:机器人数据稀缺的三大核心矛盾

要破解机器人训练数据困境,需先明确现有方案与真实需求的根本性矛盾,这是 X-Humanoid 设计的逻辑起点:

数据规模与采集成本的矛盾

真实机器人数据的采集不仅需要昂贵的硬件设备,还需耗费大量人力进行场景布置与动作设计,导致数据规模有限且场景单一。而互联网上的人类活动视频虽存量巨大(如 Ego-Exo4D 数据集含数千小时视频),却因 "人类 - 机器人视觉形态差异" 无法直接使用,形成 "数据富矿" 与 "可用数据短缺" 的鲜明对比。

编辑能力与场景复杂度的矛盾

现有 "机器人化" 方案多针对第一视角视频,通过规则化叠加机器人手臂替换人类肢体,但这种简单的 "涂抹 - 叠加" 技术在第三人称场景中完全失效------第三人称视频涉及全身复杂动作、动态背景交互与严重遮挡,传统方法难以处理关节运动一致性、环境 occlusion 等关键问题,生成结果常出现肢体变形、动作错位等 artifacts。

模型适配与任务需求的矛盾

现有视频编辑模型多支持图像条件下的视频生成,缺乏针对 "人类 - 机器人转化" 的专项优化:要么无法保证动作与原始视频的严格对齐,要么会篡改背景信息,导致生成的机器人视频因 "运动不一致""形态不精准" 无法满足 VLA 模型与世界模型的训练要求。

方案设计:X-Humanoid 的三层技术闭环

针对上述矛盾,X-Humanoid 构建了 "合成数据生成 - 模型适配优化 - 大规模视频转化" 的三层技术闭环,各环节层层递进,确保从数据到模型再到应用的全链路有效性:

第一层:数据合成------构建大规模配对训练数据集

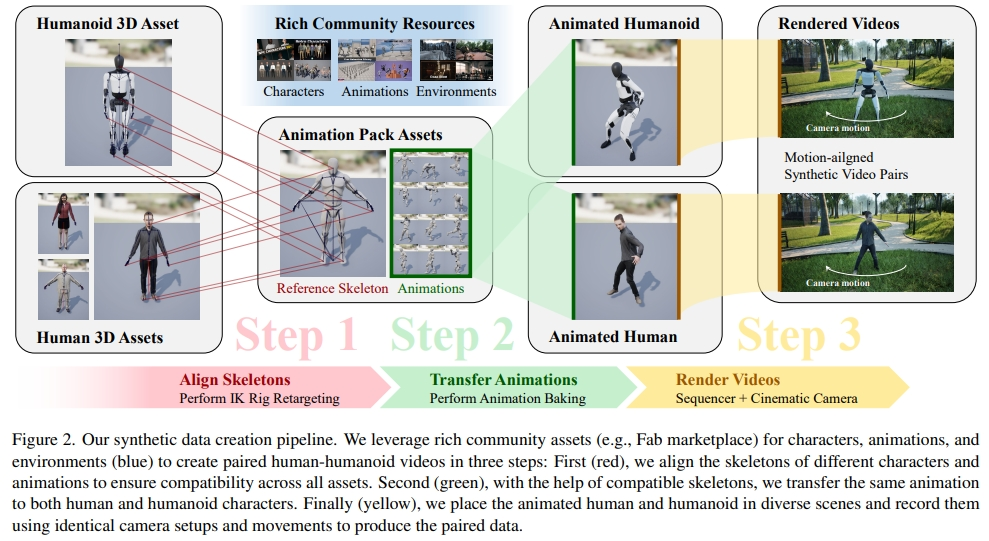

解决 "无配对训练数据" 的核心矛盾,X-Humanoid 利用 Unreal Engine 设计了可扩展的数据生成流水线,将社区资源转化为高质量人类 - 机器人配对视频:

- 骨骼对齐:通过手动 IK 骨骼重定向技术,解决不同角色(人类 / 机器人)与动画资产的骨骼不兼容问题,确保同一动作可跨角色复用;

- 动作迁移:将单一运动动画烘焙到所有人类和机器人角色上,保证配对视频中的动作完全一致;

- 场景录制:在 14 个多样化虚拟场景中,通过相同的相机参数(焦距 14-80mm、光圈 f/2.8-f/5.6)和运动轨迹录制视频,刻意融入遮挡、偏心构图等挑战性条件,提升模型鲁棒性。

最终生成 17 小时以上的 1080p 30fps 配对视频,含 280 万帧数据,仅需 10 天即可在单张 NVIDIA RTX 3060 GPU 上完成渲染。

第二层:模型适配------视频到视频的生成架构优化

为实现 "动作精准对齐、背景完整保留" 的核心目标,X-Humanoid 对强大的 Wan 2.2 扩散 Transformer(DiT)模型进行专项适配:

- 输入输出设计:将模型改造为视频 - 视频架构,输入人类活动视频,输出机器人替换后的视频,严格保证每帧动作对齐;

- 令牌处理机制:将输入视频编码为条件令牌,与生成令牌拼接后输入模型,通过单向掩码防止条件令牌被生成过程污染,确保背景等原始信息不被篡改;

- 微调目标:采用流匹配微调策略,训练模型预测从噪声到干净潜令牌的速度向量,通过均方误差损失优化,仅使用 6.4% 的合成数据即可完成 LoRA 微调。

第三层:大规模转化------释放互联网视频的数据价值

将微调后的模型应用于真实世界视频,完成从 "合成训练" 到 "真实应用" 的落地:

- 数据处理:将 Ego-Exo4D 数据集的 60 小时视频下采样至 15fps,调整为 864×400 分辨率,分割为 6 秒(90 帧)的片段;

- 批量生成:通过模型处理生成 360 万帧机器人视频,形成大规模机器人化数据集,可直接用于 VLA 模型与世界模型训练;

- 复杂场景适配:成功处理含运动模糊、镜头切换、黑边等复杂效果的互联网视频,展现出强大的真实场景适应性。

验证逻辑:从定量到定性的全面性能验证

X-Humanoid 采用 "定量指标 + 用户研究 + 消融实验" 的递进式验证逻辑,全面证明方案的优越性:

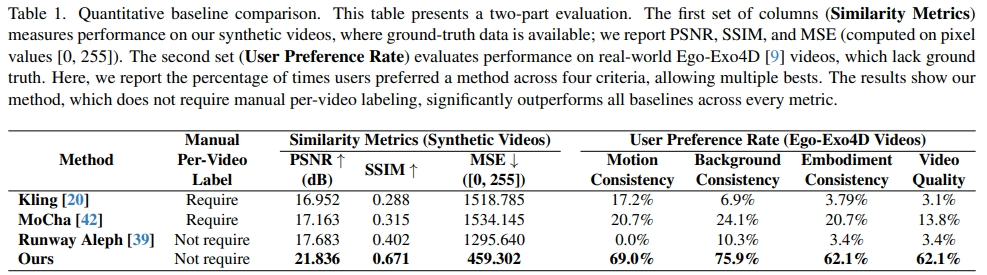

整体性能:碾压现有基线模型

在合成数据集上,通过 PSNR、SSIM、MSE 三大指标评估,X-Humanoid 表现远超 Kling、MoCha、Runway Aleph 等基线模型:

- PSNR 达 21.836 dB(基线最高为 MoCha 的 17.683 dB),SSIM 达 0.671(基线最高为 Runway Aleph 的 0.402),MSE 低至 459.302(基线最低为 MoCha 的 1295.640);

- 在 29 名计算机视觉 / 机器人领域参与者的用户研究中,69.0% 的用户认为其运动一致性最佳,75.9% 认可其背景一致性,62.1% 肯定其机器人形态准确性,62.1% 偏好其整体视频质量。

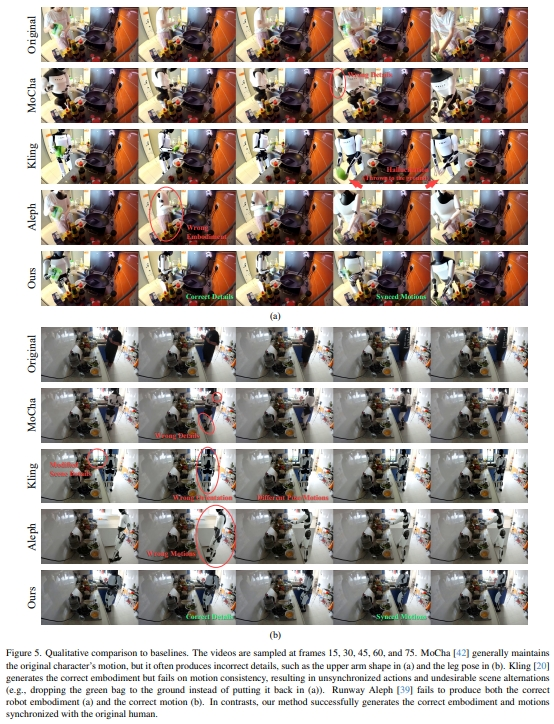

定性对比:解决基线模型核心痛点

- 运动一致性:MoCha 虽能维持部分动作,但常出现手臂形状错误、腿部姿势偏差;Kling 则存在动作不同步问题(如将绿色袋子掉落而非放回),而 X-Humanoid 完全复刻原始人类动作;

- 形态准确性:基线模型难以还原机器人肩颈、腿部关节细节,X-Humanoid 能精准复现特斯拉 Optimus 机器人的关键形态特征;

- 背景保留:Kling 会额外生成 faucet、窗户等无关元素,X-Humanoid 则完全保留原始场景信息,符合 "仅替换主体、不篡改背景" 的核心需求。

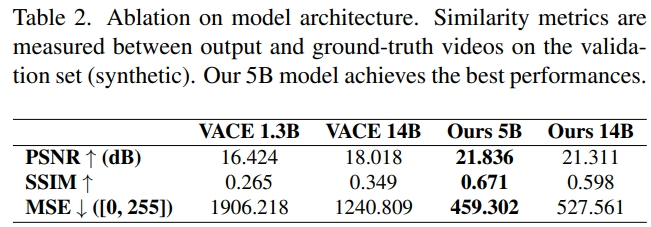

消融实验:验证核心设计的必要性

- 模型架构选择:对比 VACE 1.3B、VACE 14B 与 X-Humanoid 5B/14B 模型,X-Humanoid 5B 不仅性能最优(PSNR 21.836 dB),且训练 / 推理效率远超 14B 版本(每帧训练时间 0.10s vs 1.05s,推理时间 5.00s vs 69.16s);

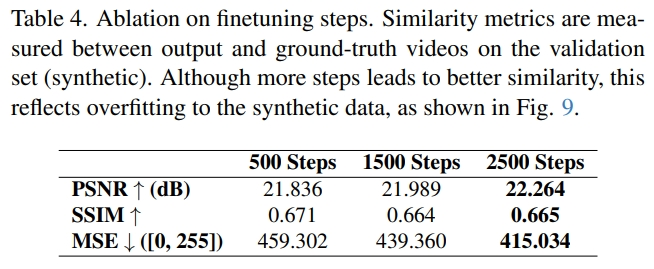

- 微调步数优化:2500 步微调为最优选择。

局限与未来方向:基于现有框架的延伸优化

X-Humanoid 作为第三人称视频机器人化的开创性工作,仍存在可提升空间,其局限也指向了明确的未来方向:

- 多人生成支持:当前仅针对单人视频,多人场景下行为定义不明确,未来可通过添加显式控制机制解决;

- 零样本形态适配:现有方案需为新机器人形态训练专属 LoRA,未来可探索单图条件下的零样本转化技术;

- 细节优化:部分场景中存在小物体消失、遮挡处理不精准等问题,可通过增强合成数据中的细节多样性进一步提升模型鲁棒性。

总结:X-Humanoid 的范式价值与行业影响

X-Humanoid 的核心贡献不仅在于生成了大规模机器人训练数据,更在于建立了 "合成数据驱动 - 模型专项适配 - 真实场景落地" 的完整链路:通过 Unreal Engine 破解配对数据稀缺难题,通过 Wan 2.2 模型适配实现高精度视频转化,最终将互联网上海量的人类视频转化为机器人可用的训练资源。

其释放的 17 小时合成数据集与 60 小时机器人化 Ego-Exo4D 数据集,为 VLA 模型与世界模型的训练提供了关键支撑,同时其技术框架为 "数据稀缺型机器人任务" 提供了可复用的解决方案,推动机器人从 "依赖真实数据" 向 "利用虚拟合成 + 互联网数据" 转型,加速通用自主机器人的落地进程。

具身求职内推来啦

国内最大的具身智能全栈学习社区来啦!

推荐阅读

从零部署π0,π0.5!好用,高性价比!面向具身科研领域打造的轻量级机械臂

工业级真机教程+VLA算法实战(pi0/pi0.5/GR00T/世界模型等)

具身智能算法与落地平台来啦!国内首个面向科研及工业的全栈具身智能机械臂

VLA/VLA+触觉/VLA+RL/具身世界模型等!具身大脑+小脑算法与实战全栈路线来啦~

MuJoCo具身智能实战:从零基础到强化学习与Sim2Real

Diffusion Policy在具身智能领域是怎么应用的?为什么如此重要?