目录

[1. 相对路径:依赖运行上下文](#1. 相对路径:依赖运行上下文)

[2. 绝对路径:确定但不灵活](#2. 绝对路径:确定但不灵活)

[3. 工程建议](#3. 工程建议)

[(四)os 与 pathlib 的角色分工](#(四)os 与 pathlib 的角色分工)

[1. os:系统级接口](#1. os:系统级接口)

[2. pathlib:路径即对象](#2. pathlib:路径即对象)

[(三)文件复制:内容 vs 元数据](#(三)文件复制:内容 vs 元数据)

[(五)目录创建:单层 vs 多层](#(五)目录创建:单层 vs 多层)

[1. 删除空目录](#1. 删除空目录)

[2. 删除非空目录(高风险操作)](#2. 删除非空目录(高风险操作))

[(九)操作不是 API,而是模型](#(九)操作不是 API,而是模型)

[(二)两种遍历视角:浅层 vs 递归](#(二)两种遍历视角:浅层 vs 递归)

[1. 浅层遍历:只看当前目录](#1. 浅层遍历:只看当前目录)

[2. 递归遍历:遍历整个目录树](#2. 递归遍历:遍历整个目录树)

[1. 不要在遍历同一目录时修改结构](#1. 不要在遍历同一目录时修改结构)

[2. 推荐模式:先收集,再操作](#2. 推荐模式:先收集,再操作)

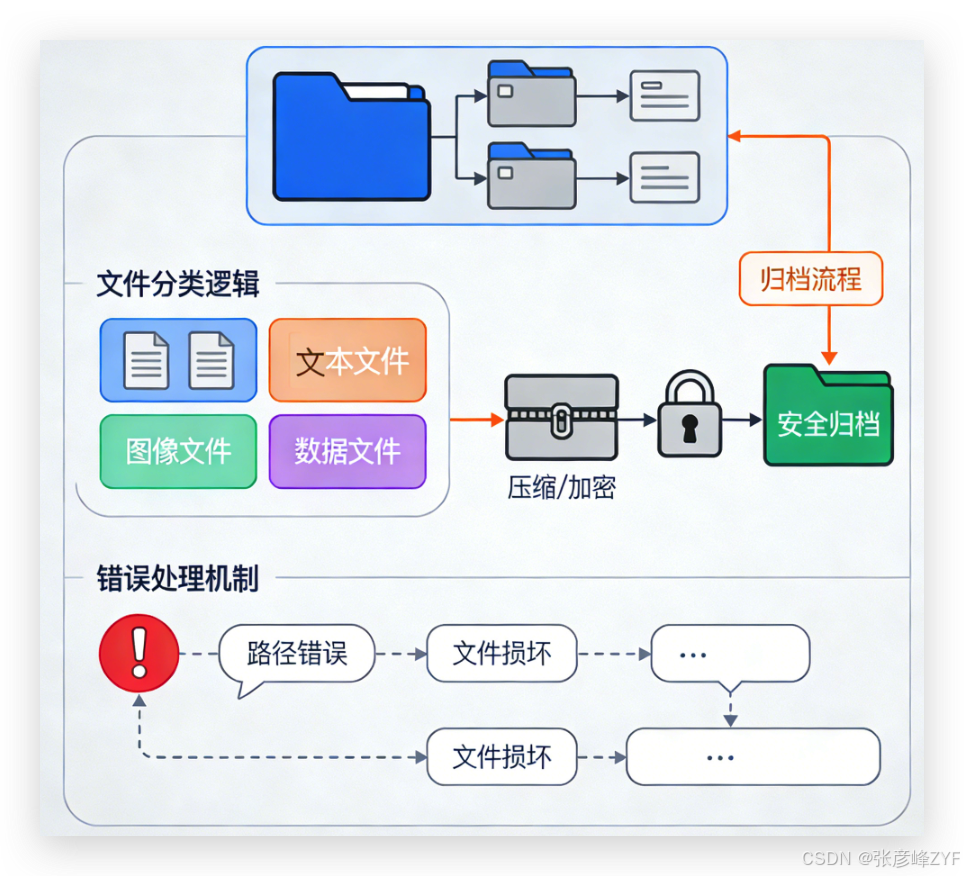

[1. 归档(Archive)](#1. 归档(Archive))

[2. 压缩(Compress)](#2. 压缩(Compress))

[3. 工程中的现实情况](#3. 工程中的现实情况)

[(三)为什么 ZIP 是工程中最通用的选择](#(三)为什么 ZIP 是工程中最通用的选择)

[1. 确认目录存在且非空](#1. 确认目录存在且非空)

[2. 排除不应进入归档的文件](#2. 排除不应进入归档的文件)

[六、zipfile 模块:ZIP 压缩与解压实战](#六、zipfile 模块:ZIP 压缩与解压实战)

[(一)zipfile 的工程定位](#(一)zipfile 的工程定位)

[(二)ZIP 文件的基本结构认知](#(二)ZIP 文件的基本结构认知)

[(三)创建 ZIP 文件:最小正确示例](#(三)创建 ZIP 文件:最小正确示例)

[(六)ZIP 内容检查与读取](#(六)ZIP 内容检查与读取)

[1. 列出归档内容](#1. 列出归档内容)

[2. 读取单个文件内容](#2. 读取单个文件内容)

[(七)解压 ZIP:功能与风险并存](#(七)解压 ZIP:功能与风险并存)

[1. 基本解压](#1. 基本解压)

[2. 路径穿越风险(必须理解)](#2. 路径穿越风险(必须理解))

[3. 安全解压示例(工程必备)](#3. 安全解压示例(工程必备))

[(九)ZIP 作为"最终交付物"的设计原则](#(九)ZIP 作为“最终交付物”的设计原则)

[(五)shutil.rmtree 的误用(最高风险)](#(五)shutil.rmtree 的误用(最高风险))

[(六)ZIP 归档中的路径错误](#(六)ZIP 归档中的路径错误)

[1. 绝对路径泄漏(严重设计缺陷)](#1. 绝对路径泄漏(严重设计缺陷))

[2. 解压路径穿越漏洞(安全漏洞)](#2. 解压路径穿越漏洞(安全漏洞))

干货分享,感谢您的阅读!

在现代软件工程中,文件组织不仅是简单的文件操作,而是工程系统中不可或缺的一环。无论是日志管理、数据处理,还是发布打包、资源交付,合理、高效、安全的文件组织流程都能显著提升开发效率与系统可靠性。我们将以 Python 为工具,系统讲解从路径抽象、目录遍历、文件操作,到归档压缩的完整实践,并结合工程级注意事项,帮助大家掌握可复用、可维护的文件组织方法。

整体内容难免存在理解不够严谨或表述不够完善之处,欢迎各位读者在评论区留言指正、交流探讨,这对我和后续读者都会非常有价值,感谢!

一、本章目标与适用场景

(一)为什么要系统性地学习文件组织

在真实工程中,"文件操作"几乎从不以单个文件的形式出现,而是以目录结构 + 批量规则 + 自动化流程的形态存在,例如:

-

构建系统生成的大量中间产物

-

日志文件的按日期/模块归档

-

数据集的清洗、分发与版本管理

-

发布包、离线资源、模型文件的压缩交付

如果仅停留在 open()、read()、write() 这一层,代码很快会演变为:

-

强耦合路径

-

大量重复逻辑

-

难以维护和扩展的脚本型代码

文件组织能力,本质上是对文件系统进行"结构化操作"的能力。

(二)要解决的核心问题

我们聚焦三个明确目标:

-

如何安全、清晰地批量操作文件与目录

-

如何遍历整个目录树并进行规则化处理

-

如何将一组文件自动打包、归档、交付

对应到 Python 标准库,将围绕三类能力展开:

| 能力 | 核心模块 |

|---|---|

| 路径与目录结构 | os / pathlib |

| 高层文件操作 | shutil |

| 压缩与归档 | zipfile |

(三)典型应用场景

场景一:日志与产物归档

python

logs/

├── app_2025-01-01.log

├── app_2025-01-02.log

└── error_2025-01-02.log目标:

-

遍历日志目录

-

按日期或类型归类

-

压缩归档后清理原始文件

场景二:数据集或资源文件整理

python

dataset_raw/

├── img_001.jpg

├── img_002.jpg

├── label_001.json

└── label_002.json目标:

-

批量扫描目录树

-

按规则移动到不同子目录

-

生成最终可分发的数据包

场景三:构建产物自动打包

python

build/

├── bin/

├── conf/

└── static/目标:

-

自动收集构建产物

-

打包成一个 ZIP 文件

-

作为发布或交付物

(四)一个最小但完整的"文件组织"示例

从一个目录出发 → 处理 → 输出一个结构化结果。

python

from pathlib import Path

import shutil

import zipfile

source_dir = Path("build")

output_dir = Path("release")

zip_path = Path("release.zip")

# 1. 创建输出目录

output_dir.mkdir(exist_ok=True)

# 2. 拷贝构建产物

for item in source_dir.iterdir():

if item.is_dir():

shutil.copytree(item, output_dir / item.name, dirs_exist_ok=True)

else:

shutil.copy2(item, output_dir / item.name)

# 3. 压缩归档

with zipfile.ZipFile(zip_path, "w", zipfile.ZIP_DEFLATED) as zf:

for file in output_dir.rglob("*"):

zf.write(file, file.relative_to(output_dir))这个示例中已经隐含了本章的全部关键点:

-

使用

pathlib表达路径语义 -

使用

shutil做高层文件复制 -

使用目录遍历完成批处理

-

使用

zipfile输出最终交付物

后续我们将逐一拆解这些能力,而不是堆砌 API。

二、文件系统基础抽象(快速回顾)

(一)为什么"路径抽象"决定了代码质量

在文件组织类代码中,路径是第一等公民。大量混乱、不可维护的脚本,其根源并不是 API 不熟,而是:

-

路径拼接依赖字符串

-

相对路径语义不清

-

平台差异未被显式建模

错误示例(典型反例):

python

log_path = "logs/" + date + "/app.log"问题不在"能不能跑",而在于:

-

路径分隔符被写死

-

语义(目录 / 文件)不可区分

-

无法进行结构化操作

工程化代码必须先解决路径表达问题。

(二)绝对路径与相对路径的工程语义

1. 相对路径:依赖运行上下文

python

with open("config/app.yaml") as f:

...-

相对于当前工作目录(CWD)

-

在不同启动方式(IDE / CLI / 定时任务)下可能不同

-

不适合作为核心业务路径

2. 绝对路径:确定但不灵活

python

with open("/opt/app/config/app.yaml") as f:

...-

路径唯一、无歧义

-

强依赖部署环境

-

可读性与可移植性较差

3. 工程建议

-

内部计算使用相对路径

-

入口处统一解析为绝对路径

-

禁止在业务逻辑中硬编码环境路径

python

from pathlib import Path

BASE_DIR = Path(__file__).resolve().parent

config_path = BASE_DIR / "config" / "app.yaml"(三)文件路径与目录路径的语义区分

字符串无法区分"这是文件还是目录",而路径对象可以。

python

from pathlib import Path

p = Path("data/input.txt")

p.exists() # 是否存在

p.is_file() # 是否为文件

p.is_dir() # 是否为目录工程价值在于:

-

操作前可校验对象类型

-

避免对目录执行文件操作(反之亦然)

-

降低运行期错误概率

(四)os 与 pathlib 的角色分工

1. os:系统级接口

os 提供的是偏底层、偏过程式的能力:

python

import os

os.path.exists("data")

os.path.join("data", "input.txt")

os.listdir("data")特点:

-

API 繁多

-

返回值多为字符串

-

更接近操作系统模型

2. pathlib:路径即对象

pathlib 提供的是面向对象的路径抽象:

python

from pathlib import Path

data_dir = Path("data")

file_path = data_dir / "input.txt"优势非常明确:

-

/运算符即路径拼接,语义清晰 -

路径方法集中、可发现性强

-

天然跨平台

(五)常用路径操作的等价对照

| 语义 | os.path |

pathlib |

|---|---|---|

| 拼接路径 | os.path.join(a, b) |

Path(a) / b |

| 判断存在 | os.path.exists(p) |

Path(p).exists() |

| 目录名 | os.path.dirname(p) |

Path(p).parent |

| 文件名 | os.path.basename(p) |

Path(p).name |

| 扩展名 | 手动解析 | Path(p).suffix |

示例:

python

p = Path("logs/app.log")

p.parent # logs

p.name # app.log

p.stem # app

p.suffix # .log(六)路径解析与规范化

在文件组织场景中,路径是否"真实、唯一"非常重要。

python

p = Path("./logs/../logs/app.log")

p.resolve()resolve() 的作用:

-

消除

./.. -

返回规范化的绝对路径

-

可用于日志、缓存、索引等场景

(七)遍历入口:目录对象是"集合"

一个目录,本质上是路径对象的集合。

python

data_dir = Path("data")

for item in data_dir.iterdir():

print(item, item.is_file(), item.is_dir())这一认知非常关键,因为:

-

后续的"目录树遍历"就是对集合的递归

-

文件组织逻辑 = 遍历 + 规则 + 操作

(八)路径是结构,不是字符串

在进入 shutil、目录树遍历和压缩之前,必须先建立以下共识:

-

路径必须是对象,而不是字符串

-

目录和文件在语义上是不同类型

-

所有文件组织逻辑,都建立在路径抽象之上

接着我们将进入真正的高层文件操作 :使用 shutil 安全、批量地操作文件与目录。

三、文件与目录的基本操作模型

(一)文件操作的核心语义

在文件组织类任务中,对"文件"的操作本质只有三类:

-

创建(Create)

-

复制 / 移动(Copy / Move)

-

删除(Delete)

理解这些操作的语义差异,比记住函数名更重要。

(二)文件创建:先明确"写入语义"

文件创建几乎总是伴随写入行为,但需要区分两点:

-

是否覆盖已有文件

-

是否确保父目录存在

python

from pathlib import Path

file_path = Path("output/result.txt")

# 确保父目录存在

file_path.parent.mkdir(parents=True, exist_ok=True)

# 写入文件(覆盖)

file_path.write_text("hello world", encoding="utf-8")工程建议:

-

永远不要假设目录已存在

-

写入前明确覆盖行为(不要"顺手覆盖")

(三)文件复制:内容 vs 元数据

复制文件时,有三个容易被忽略的维度:

-

文件内容

-

文件权限

-

时间戳等元数据

python

import shutil

from pathlib import Path

src = Path("data/input.txt")

dst = Path("backup/input.txt")

dst.parent.mkdir(parents=True, exist_ok=True)

shutil.copy2(src, dst)-

copy:复制内容 + 权限 -

copy2:复制内容 + 权限 + 元数据 -

copyfile:只复制内容(最底层)

工程默认:优先使用 copy2。

(四)文件移动:重命名还是跨目录迁移

文件"移动"并不总是同一类操作。

python

shutil.move("data/input.txt", "archive/input.txt")底层行为取决于场景:

-

同一文件系统内:通常是重命名(O(1))

-

不同文件系统间:复制 + 删除(O(n))

工程影响:

-

大文件移动可能是昂贵操作

-

移动失败可能留下"半成品"

(五)目录创建:单层 vs 多层

python

from pathlib import Path

Path("a/b/c").mkdir(parents=True, exist_ok=True)参数语义必须清楚:

-

parents=True:递归创建父目录

-

exist_ok=True:目录已存在不报错

不要依赖异常控制流程来判断目录是否存在。

(六)目录删除:空目录与非空目录

1. 删除空目录

python

Path("tmp").rmdir()限制非常严格:

-

目录必须存在

-

目录必须为空

2. 删除非空目录(高风险操作)

python

import shutil

shutil.rmtree("tmp")这是一个不可逆操作,工程中必须做到:

-

明确路径来源

-

禁止拼接用户输入

-

必要时增加白名单校验

示例防护:

python

tmp_dir = Path("tmp").resolve()

project_root = Path.cwd().resolve()

if project_root in tmp_dir.parents:

shutil.rmtree(tmp_dir)(七)文件与目录的批量操作模型

单个文件操作并不构成"文件组织",批量规则才是核心。

python

from pathlib import Path

import shutil

src_dir = Path("raw")

dst_dir = Path("processed")

dst_dir.mkdir(exist_ok=True)

for file in src_dir.iterdir():

if file.is_file() and file.suffix == ".log":

shutil.move(file, dst_dir / file.name)这里隐含了一个通用模式:

遍历 → 判断 → 操作

后续所有复杂逻辑,都是这个模式的组合与递归。

(八)文件覆盖与冲突处理策略

真实工程中,文件名冲突是常态。

示例策略:自动重命名

python

def unique_path(path: Path) -> Path:

if not path.exists():

return path

stem = path.stem

suffix = path.suffix

parent = path.parent

index = 1

while True:

new_path = parent / f"{stem}_{index}{suffix}"

if not new_path.exists():

return new_path

index += 1使用:

python

target = unique_path(Path("archive/app.log"))

shutil.move("app.log", target)(九)操作不是 API,而是模型

核心结论是:

-

文件操作必须明确语义边界

-

目录操作永远比文件操作更危险

-

批量处理 = 遍历 + 规则 + 防护

你现在已经具备了:

-

安全创建、复制、移动、删除文件与目录的能力

-

构建可控文件组织流程的基础模型

接下来我们将进入文件组织的"发动机":遍历整个目录树,并在遍历中执行规则化操作。

四、遍历目录树:文件批处理的核心能力

(一)为什么"遍历"是文件组织的发动机

任何非平凡的文件组织任务,本质都等价于:

对一个目录树中的每个节点,按规则执行操作

如果遍历不可控,将直接导致:

-

文件遗漏或重复处理

-

性能问题(无意义扫描)

-

风险操作(误删、误移)

因此,遍历必须是可预测、可剪枝、可中断的过程。

(二)两种遍历视角:浅层 vs 递归

1. 浅层遍历:只看当前目录

python

from pathlib import Path

for item in Path("data").iterdir():

print(item)特性:

-

不进入子目录

-

适合结构已知、层级固定的场景

-

不会产生递归风险

2. 递归遍历:遍历整个目录树

python

for file in Path("data").rglob("*"):

print(file)特性:

-

自动递归所有子目录

-

适合未知结构或全量处理

-

必须配合过滤规则使用

(三)os.walk:工程级目录遍历接口

尽管 pathlib 更优雅,但在工程中,os.walk 仍然是最可控的遍历工具。

python

import os

for root, dirs, files in os.walk("data"):

print(root)

print(dirs)

print(files)返回值语义必须非常清楚:

-

root:当前目录路径 -

dirs:当前目录下的子目录名列表 -

files:当前目录下的文件名列表

(四)遍历顺序与可控性

os.walk 默认是自顶向下(top-down)遍历。

python

os.walk("data", topdown=True)这意味着:

-

父目录先于子目录被处理

-

可以在遍历过程中动态修改

dirs来剪枝

示例:跳过隐藏目录

python

for root, dirs, files in os.walk("data"):

dirs[:] = [d for d in dirs if not d.startswith(".")]这是 os.walk 的工程级优势,pathlib 无法直接做到。

(五)在遍历中执行规则化操作

遍历本身毫无意义,规则才是价值所在。

示例:只处理 .log 文件

python

from pathlib import Path

import os

for root, _, files in os.walk("logs"):

for name in files:

path = Path(root) / name

if path.suffix == ".log":

print("process:", path)规则应当满足:

-

明确(可读)

-

可组合

-

不依赖外部状态

(六)遍历中的"危险操作"防护

在遍历中执行删除、移动等操作时,必须格外谨慎。

1. 不要在遍历同一目录时修改结构

错误示例:

python

for root, dirs, files in os.walk("data"):

for f in files:

os.remove(Path(root) / f)问题:

-

可能影响后续遍历

-

在某些系统上行为不可预测

2. 推荐模式:先收集,再操作

python

from pathlib import Path

import os

to_delete = []

for root, _, files in os.walk("data"):

for name in files:

path = Path(root) / name

if path.suffix == ".tmp":

to_delete.append(path)

for path in to_delete:

path.unlink()这是工程中最安全的遍历模型。

(七)遍历性能与范围控制

递归遍历的成本与目录规模成正比,必须主动限制范围。

示例:限制最大深度

python

from pathlib import Path

base = Path("data").resolve()

for path in base.rglob("*"):

if len(path.relative_to(base).parts) > 3:

continue

print(path)(八)目录遍历的通用抽象模式

总结一个通用、可复用的遍历模板:

python

from pathlib import Path

import os

def walk_files(root: Path, predicate):

for current, _, files in os.walk(root):

for name in files:

path = Path(current) / name

if predicate(path):

yield path使用:

python

logs = walk_files(

Path("logs"),

lambda p: p.suffix == ".log" and p.stat().st_size > 0

)

for log in logs:

print(log)(九)遍历是数据流,不是循环

需要牢牢记住三点:

-

遍历是数据流过程 ,不是简单循环

-

os.walk 是最可控的目录树遍历工具

-

修改文件系统前,应先冻结遍历结果

至此,你已经具备了:

-

安全遍历任意规模目录树的能力

-

在遍历中执行复杂规则的工程模型

接着我们将进入文件组织的最后一环:文件归档与压缩 ------ 将结构化结果交付为单一产物。

五、文件归档与压缩的工程需求

(一)为什么文件组织最终一定会走向"归档"

在工程实践中,文件组织的终点通常不是"整理完目录",而是:

-

交付:发布给他人或系统

-

传输:跨网络、跨环境

-

存储:长期保存、版本冻结

这些目标有一个共同前提:需要将一组文件,稳定地封装为一个整体。

如果不进行归档,往往会遇到以下问题:

-

文件数量多,易遗漏

-

目录结构在传输中被破坏

-

无法对"一个版本"进行整体校验

(二)归档与压缩:两个经常被混用的概念

这是一个必须先讲清楚的概念边界。

1. 归档(Archive)

归档解决的是:"如何把多个文件组织为一个逻辑整体"

特点:

-

保留目录结构

-

强调结构完整性

-

不一定减少体积

2. 压缩(Compress)

压缩解决的是:"如何减少数据体积"

特点:

-

针对内容做编码优化

-

可能增加 CPU 开销

-

与文件组织结构无关

3. 工程中的现实情况

在绝大多数工程中:归档 + 压缩 是同时发生的

例如:zip、tar.gz

(三)为什么 ZIP 是工程中最通用的选择

在 Python 标准库支持范围内,ZIP 具有明显优势:

-

跨平台通用

-

原生支持目录结构

-

标准库直接支持(

zipfile) -

可随机读取、可列目录

这也是为什么很多发布包、资源包、导出文件选择 ZIP。

(四)归档阶段的输入与输出模型

从工程视角看,归档不是"随便压个包",而是一个明确的模型:

java

输入:

一个或多个目录 / 文件 + 已整理好的结构 + 确定的根目录

输出:

一个归档文件 + 稳定的内部路径 + 可预测的内容归档阶段不应该再做文件整理。

(五)一个最小但正确的归档前结构示例

python

release/

├── bin/

│ └── app

├── conf/

│ └── app.yaml

└── static/

└── logo.png这个结构具备三个特征:

-

根目录清晰(

release/) -

所有路径相对该根目录

-

无临时文件、无冗余内容

这是归档的理想输入状态。

(六)归档路径稳定性的工程意义

归档文件内部路径不稳定,是严重缺陷。

错误示例(绝对路径泄漏):

bash

/Users/xxx/project/release/bin/app正确做法:归档内始终使用相对路径。

这要求在代码中明确"归档根"。

python

from pathlib import Path

base_dir = Path("release").resolve()

file = base_dir / "bin/app"

relative_path = file.relative_to(base_dir)(七)归档前的安全与质量检查

在真正压缩之前,建议做最少但必要的检查:

1. 确认目录存在且非空

python

if not base_dir.exists():

raise RuntimeError("archive source not found")

if not any(base_dir.iterdir()):

raise RuntimeError("archive source is empty")2. 排除不应进入归档的文件

例如:

-

临时文件(

.tmp) -

日志文件

-

缓存目录

python

def should_include(path: Path) -> bool:

return path.is_file() and not path.name.endswith(".tmp")(八)归档阶段的职责边界

在工程中,归档阶段只做三件事:

-

确定归档根目录

-

确定哪些文件被包含

-

输出一个稳定、可复现的包

不应在此阶段:

-

修改文件内容

-

移动或删除原始文件

-

动态生成结构

(九)归档是交付边界,不是整理过程

本节需要形成以下明确认知:

-

归档解决的是"整体交付"问题

-

归档与压缩是不同但常同时出现的概念

-

归档前必须已有稳定、干净的目录结构

-

路径稳定性比压缩率更重要

接着我们将进入具体实现层面:使用 zipfile 模块创建、读取与解压 ZIP 文件。

六、zipfile 模块:ZIP 压缩与解压实战

(一)zipfile 的工程定位

zipfile 是 Python 标准库中唯一同时支持归档与压缩的官方实现,适合以下场景:

-

构建产物或资源包交付

-

数据导出、离线分发

-

工具类脚本的标准输出格式

它的核心价值不在"压得多小",而在:

-

结构稳定

-

跨平台一致

-

可精确控制归档内容

(二)ZIP 文件的基本结构认知

ZIP 并不是"一个大文件",而是:

-

多个文件条目(entry)

-

每个条目都有独立路径

-

目录本身不是必须的实体

这意味着一个 ZIP 的关键在于:每个文件写入时使用的路径名。

(三)创建 ZIP 文件:最小正确示例

python

import zipfile

from pathlib import Path

base_dir = Path("release")

zip_path = Path("release.zip")

with zipfile.ZipFile(zip_path, "w", zipfile.ZIP_DEFLATED) as zf:

for file in base_dir.rglob("*"):

if file.is_file():

zf.write(file, file.relative_to(base_dir))这里有三个关键点:

-

使用

"w"明确为创建模式 -

使用

ZIP_DEFLATED启用压缩 -

使用

relative_to()保证归档内路径稳定

(四)写入模式与覆盖语义

ZipFile 支持三种模式:

| 模式 | 语义 |

|---|---|

"w" |

新建或覆盖 |

"a" |

追加 |

"r" |

只读 |

工程建议:

-

发布包、交付物:只使用

"w" -

"a"仅用于调试或增量工具 -

不在生产流程中对 ZIP 做"补丁式修改"

(五)控制归档内容:过滤是必需的

不要盲目把整个目录塞进 ZIP。

python

def should_include(path: Path) -> bool:

if not path.is_file():

return False

if path.suffix in {".log", ".tmp"}:

return False

return True使用:

python

with zipfile.ZipFile(zip_path, "w", zipfile.ZIP_DEFLATED) as zf:

for file in base_dir.rglob("*"):

if should_include(file):

zf.write(file, file.relative_to(base_dir))这是工程中最基本的质量控制手段。

(六)ZIP 内容检查与读取

ZIP 不只是"写完就算",很多场景需要读取和校验。

1. 列出归档内容

python

with zipfile.ZipFile("release.zip") as zf:

for name in zf.namelist():

print(name)这是验证归档结构是否正确的第一步。

2. 读取单个文件内容

python

with zipfile.ZipFile("release.zip") as zf:

with zf.open("conf/app.yaml") as f:

content = f.read().decode("utf-8")注意:

-

返回的是类文件对象

-

内容默认是字节流

(七)解压 ZIP:功能与风险并存

1. 基本解压

python

with zipfile.ZipFile("release.zip") as zf:

zf.extractall("output")这是最简单、也是最危险的用法。

2. 路径穿越风险(必须理解)

恶意 ZIP 可能包含如下路径:

php

../../etc/passwd直接解压将覆盖系统文件。

3. 安全解压示例(工程必备)

python

from pathlib import Path

import zipfile

def safe_extract(zip_path: Path, target_dir: Path):

target_dir = target_dir.resolve()

with zipfile.ZipFile(zip_path) as zf:

for member in zf.namelist():

dest = (target_dir / member).resolve()

if not str(dest).startswith(str(target_dir)):

raise RuntimeError(f"unsafe path: {member}")

zf.extractall(target_dir)任何来自外部的 ZIP,必须使用安全解压逻辑。

(八)压缩等级与性能取舍

zipfile 允许指定压缩级别(Python 3.7+):

python

zipfile.ZipFile(

zip_path,

"w",

compression=zipfile.ZIP_DEFLATED,

compresslevel=6

)工程经验:

-

归档包:默认等级即可

-

构建流水线:优先速度

-

网络传输极端敏感时再调优

(九)ZIP 作为"最终交付物"的设计原则

一个合格的 ZIP 产物,应满足:

-

解压后结构清晰

-

不依赖解压位置

-

内部路径稳定、可预测

-

不包含临时与无关文件

这不是压缩技术问题,而是工程设计问题。ZIP 是边界,而不是中间态---核心结论:

-

zipfile是稳定、可靠的工程级归档工具 -

归档路径控制比 API 使用更重要

-

解压永远要考虑安全边界

-

ZIP 文件应视为"最终交付产物"

至此,你已经具备了:

-

从目录到 ZIP 的完整实现能力

-

安全读取与解压 ZIP 的工程模型

接着我们将把前面所有能力组合起来,完成一个自动化文件组织与归档的完整实战流程。

七、组合实战:自动化文件组织流程设计

(一)实战目标与输入输出定义

目标:从一个原始目录中,自动完成以下流程:

-

遍历目录树

-

按规则整理文件结构

-

生成干净的发布目录

-

输出一个 ZIP 归档包

输入目录(示例)

python

input/

├── logs/

│ ├── app.log

│ └── error.log

├── data/

│ ├── raw.csv

│ └── temp.tmp

└── config.yaml输出结果

python

release/

├── conf/

│ └── config.yaml

├── data/

│ └── raw.csv

└── logs/

├── app.log

└── error.log

release.zip(二)流程拆解:不要写"一步到位"的脚本

整个流程必须拆解为明确阶段:

-

初始化输出目录

-

遍历并筛选文件

-

执行规则化迁移

-

校验输出结构

-

归档压缩

每一步都应可单独调试。

阶段一:初始化工作区

python

from pathlib import Path

import shutil

INPUT_DIR = Path("input").resolve()

RELEASE_DIR = Path("release").resolve()

ZIP_PATH = Path("release.zip").resolve()

if RELEASE_DIR.exists():

shutil.rmtree(RELEASE_DIR)

RELEASE_DIR.mkdir()原则:

-

发布目录必须是全新状态

-

禁止在原始目录上做就地修改

阶段二:规则定义(先定义规则,再写逻辑)

python

def classify(path: Path) -> Path | None:

if path.suffix == ".log":

return Path("logs") / path.name

if path.suffix == ".csv":

return Path("data") / path.name

if path.name == "config.yaml":

return Path("conf") / path.name

return None说明:

-

返回 相对发布目录的路径

-

返回

None表示该文件被丢弃

阶段三:遍历并执行迁移

python

import os

import shutil

for root, _, files in os.walk(INPUT_DIR):

for name in files:

src = Path(root) / name

rel = classify(src)

if rel is None:

continue

dst = RELEASE_DIR / rel

dst.parent.mkdir(parents=True, exist_ok=True)

shutil.copy2(src, dst)这里体现了标准工程模型:遍历 → 分类 → 复制 → 构建结构

阶段四:结果校验(必须有)

python

expected = [

RELEASE_DIR / "conf/config.yaml",

RELEASE_DIR / "data/raw.csv",

RELEASE_DIR / "logs/app.log",

RELEASE_DIR / "logs/error.log",

]

for path in expected:

if not path.exists():

raise RuntimeError(f"missing file: {path}")发布目录不校验,是工程事故的起点。

阶段五:归档输出

python

import zipfile

with zipfile.ZipFile(ZIP_PATH, "w", zipfile.ZIP_DEFLATED) as zf:

for file in RELEASE_DIR.rglob("*"):

if file.is_file():

zf.write(file, file.relative_to(RELEASE_DIR))要点:

-

永远使用相对路径

-

发布目录即归档根

将流程封装为可复用函数

python

def build_release(input_dir: Path, output_dir: Path, zip_path: Path):

# 初始化

if output_dir.exists():

shutil.rmtree(output_dir)

output_dir.mkdir()

# 组织文件

for root, _, files in os.walk(input_dir):

for name in files:

src = Path(root) / name

rel = classify(src)

if rel is None:

continue

dst = output_dir / rel

dst.parent.mkdir(parents=True, exist_ok=True)

shutil.copy2(src, dst)

# 归档

with zipfile.ZipFile(zip_path, "w", zipfile.ZIP_DEFLATED) as zf:

for file in output_dir.rglob("*"):

if file.is_file():

zf.write(file, file.relative_to(output_dir))这一步的意义在于:

-

流程具备函数边界

-

易于测试、复用、集成到 CI

(三)组合能力才是工程能力

我们完成了从"工具"到"系统"的转变:

-

单点 API 不构成工程能力

-

明确阶段与边界,流程自然稳定

-

文件组织的本质是规则驱动的数据流

到这里,你已经具备了:

-

设计完整文件组织流程的能力

-

将目录、遍历、复制、归档组合为稳定系统的经验

最后我们将从工程经验出发,总结常见错误、风险点与最佳实践,帮助你避免"能跑但不可靠"的实现。

八、常见错误与工程级注意事项

(一)路径拼接错误:字符串是隐患源头

错误示例:

python

path = "data/" + filename问题:

-

分隔符被硬编码

-

无法处理复杂路径

-

跨平台不可靠

正确做法:

python

from pathlib import Path

path = Path("data") / filename工程原则:

文件组织代码中,禁止使用字符串拼接路径。

(二)相对路径失控:运行环境一变就出错

典型问题场景:

-

本地运行正常

-

CI / 定时任务 / 容器中失败

错误根因:

- 依赖当前工作目录(CWD)

修正模式:入口统一解析路径

python

BASE_DIR = Path(__file__).resolve().parent

DATA_DIR = BASE_DIR / "data"工程原则:

相对路径只能相对于"明确锚点",不能相对于运行环境。

(三)覆盖文件导致数据丢失

高风险代码:

python

shutil.copy2(src, dst) # dst 已存在默认行为:直接覆盖

安全策略:显式冲突处理

python

def safe_copy(src: Path, dst: Path):

if dst.exists():

raise RuntimeError(f"file exists: {dst}")

dst.parent.mkdir(parents=True, exist_ok=True)

shutil.copy2(src, dst)或使用自动重命名策略(前文已示)。

(四)在遍历过程中修改目录结构

危险示例:

python

for root, _, files in os.walk("data"):

for f in files:

os.remove(Path(root) / f)风险:

-

遍历状态被破坏

-

行为不可预测

正确模型:先收集,后操作

python

to_delete = []

for root, _, files in os.walk("data"):

for f in files:

to_delete.append(Path(root) / f)

for path in to_delete:

path.unlink()(五)shutil.rmtree 的误用(最高风险)

典型事故:

-

路径拼错

-

根目录被删除

-

无法恢复

最低防护要求:

python

def safe_rmtree(path: Path, allowed_root: Path):

path = path.resolve()

allowed_root = allowed_root.resolve()

if allowed_root not in path.parents:

raise RuntimeError(f"refuse to delete: {path}")

shutil.rmtree(path)工程原则:

非空目录删除,必须有"作用域校验"。

(六)ZIP 归档中的路径错误

1. 绝对路径泄漏(严重设计缺陷)

错误示例:

python

zf.write(file)可能导致 ZIP 内路径包含完整本地路径。

正确做法:

python

zf.write(file, file.relative_to(base_dir))2. 解压路径穿越漏洞(安全漏洞)

危险代码:

python

zf.extractall("output")必须使用安全解压逻辑。

(七)把"文件整理"和"归档"混在一起

反模式:

-

一边遍历

-

一边移动

-

一边写 ZIP

问题:

-

状态复杂

-

难以回滚

-

难以测试

正确工程分层:

原始数据 -> 整理输出目录(中间态) -> 归档压缩(最终态)

**工程原则:**ZIP 是终点,不是中间过程。

(八)忽略异常与中断恢复能力

文件系统操作天然不可靠:

-

权限不足

-

磁盘满

-

文件被占用

最低限度异常处理示例:

python

try:

shutil.copy2(src, dst)

except OSError as e:

print(f"copy failed: {src} -> {dst}: {e}")工程中应进一步:

-

记录失败清单

-

支持重试或回滚

(九)可复现性检查:工程级"最后一道关"

在流程结束后,至少应做到:

python

def assert_tree(root: Path):

for path in root.rglob("*"):

if path.is_file() and path.stat().st_size == 0:

raise RuntimeError(f"empty file: {path}")**工程原则:**文件组织流程,必须有"结果校验"。

(十)文件系统操作没有"试试看"

需要牢牢记住以下结论:

-

文件操作的错误不可逆

-

目录操作永远比文件操作危险一个数量级

-

ZIP 解压是安全边界,不能掉以轻心

-

清晰分阶段,是工程可靠性的基础

至此,你已经不仅会用文件组织相关模块,而且:

-

知道哪些地方最容易出事故

-

掌握最低限度的工程防护模型

接着我们将对全章进行收束,总结文件组织的结构设计心法,帮助你在未来的任何工程中快速建立正确模型。

九、总结:文件组织的结构设计心法

(一)文件组织的本质:结构化的数据流

回顾以上所有内容,可以用一句话概括:文件组织不是零散的文件操作,而是一条有结构的数据流。

这条数据流具有清晰形态:

路径抽象-> 遍历产生文件流-> 规则映射结构-> 生成稳定输出-> 归档为交付物

任何跳过其中一步的实现,都会在规模或复杂度上失控。

(二)六条心法

心法一:路径是模型,不是参数

低质量代码的典型特征是:

-

路径作为字符串到处传递

-

逻辑与目录结构强耦合

工程级代码应当做到:

python

from pathlib import Path

class Workspace:

def __init__(self, root: Path):

self.root = root.resolve()

def input(self) -> Path:

return self.root / "input"

def release(self) -> Path:

return self.root / "release"路径应当被建模,而不是临时拼接。

心法二:遍历即数据流,规则即函数

遍历不是 for 循环,而是数据产生器。

python

def iter_files(root: Path):

for path in root.rglob("*"):

if path.is_file():

yield path规则应当是纯函数:

python

def rule(path: Path) -> Path | None:

if path.suffix == ".log":

return Path("logs") / path.name

return None工程收益:

-

易测试

-

易组合

-

易复用

心法三:中间态比最终态更重要

一个稳定流程,必然存在中间目录:

input → staging → release → zip

代码层面:

python

staging = Path("staging")

release = Path("release")意义在于:

-

便于调试

-

便于回滚

-

便于质量校验

没有中间态的流程,一定难以维护。

心法四:归档是"封口",不是过程

ZIP 文件的工程角色非常明确:

-

不可变

-

只读

-

可校验

错误认知:

"先压缩,后再补点文件进去"

正确做法:

python

# 所有文件就绪之后,才进行归档

build_release(...)

build_zip(...)心法五:防护优先于效率

在文件系统领域:

-

一次误删 > 千次性能优化

-

一次路径错误 > 所有算法复杂度

示例:删除前明确边界

python

def guarded_delete(path: Path, scope: Path):

if scope not in path.resolve().parents:

raise RuntimeError("delete scope violation")

path.unlink()安全是默认需求,而不是附加选项。

心法六:流程必须可验证、可复现

任何文件组织流程,都应回答三个问题:

-

输入是什么?

-

输出应该长什么样?

-

如何自动验证?

示例校验函数:

python

def assert_release(root: Path):

required = [

root / "conf/config.yaml",

root / "data/raw.csv",

]

for p in required:

if not p.exists():

raise RuntimeError(f"missing: {p}")没有验证的流程,本质上是"脚本"。

(三)一个可迁移的最小模板

可以沉淀为一个通用工程模板:

python

def run_pipeline(input_dir: Path, output_dir: Path):

prepare(output_dir)

files = collect(input_dir)

mapped = map_rules(files)

materialize(mapped, output_dir)

validate(output_dir)

archive(output_dir)只要这六步不乱,项目规模再大也不会失控。

(四)最终结论

完成本章后,你应当已经形成以下稳定认知:

-

文件系统操作不是"杂活",而是工程能力

-

路径、遍历、规则、归档是四个不可分割的核心

-

好的文件组织代码,结构先于实现

这套心法不仅适用于 Python,也适用于任何需要与文件系统打交道的工程场景。