认识 Haink,Redis 的全天候 AI 队友

各行各业的团队正在转向使用 AI 智能体,以加快工作节奏并提升工作智能化水平。在 Redis,我们从零开始构建了一个,以展示将 Redis 作为基础能实现何种可能。

来认识一下 Haink,一个由 Redis 应用 AI 团队专门打造的 AI 队友。Haink 全天候待命,帮助 Redis 团队成员理解客户架构、洞察 AI 市场动态,并识别 Redis 在何处能最有效地助力成功。Haink 的真正独特之处在于,它并非一个演示或原型,而是一个生产级的智能体,Redis 的工程师、解决方案架构师和一线团队每天都在使用它。

我们为何打造 Haink

我们的一线和解决方案工程团队常常面临一个挑战:既要跟上瞬息万变的 AI 格局,又要帮助客户理解 Redis 在其中的独特价值。AI 世界的演进速度超过了模型的再训练速度,这意味着随着新技术、新架构和新最佳实践的涌现,静态系统往往会落后。从实时缓存到向量相似性搜索,Redis 是许多 AI 部署的核心组件,然而,要将这一价值精准地映射到客户的特定环境中,需要花费大量时间。

我们打造 Haink,就是为了让它成为解决该问题的"第 N 位团队成员"。Haink 将 Redis 的集体专业知识系统化呈现,从技术博客、代码示例到真实世界的部署案例,并让 Redis 的每位员工都能即时访问这些知识。它还被设定为遵循我们团队偏好的代码风格和技术标准,确保了 Redis 的概念和建议在全公司范围内以一致的方式共享。通过这种方式,Haink 帮助我们规模化地运用知识,让其他人能够实时地与其互动并从中学习。

Haink 能做什么

Haink 就像一位随时待命的 Redis 专家。您可以向它索要代码示例、架构建议,甚至是技术对比。

例如,您可以在 Slack 中给 Haink 发消息说:给我一个使用 RedisVL 进行语义缓存的代码示例。

数秒之内,Haink 会搜索 Redis 的内部知识库,找到相关示例,并返回应用 AI 团队已经测试过的可用代码。

Haink 也能处理基于推理的问题,例如:

在什么情况下 Redis 比 Pinecone 更好?

在这种情况下,它会分析来自 Redis 资料的上下文,并解释架构上的权衡,包括 Redis 的统一数据模型或低延迟在哪些场景下能带来更大价值。

Haink 的能力不限于总结或检索。它可以即时执行复杂的计算。例如,您可以给 Haink 传递一个 JSON 示例和预估的文档数量,它会运行一个自定义工具来计算客户工作负载所需的分片数量。这种能力将推理与实时计算相结合,展示了 Redis 除了能支持 AI 推理外,还能如何驱动基于逻辑的操作。

像任何优秀的队友一样,Haink 会持续学习。每一次对话都会被保存为一个回归测试,帮助我们的工程团队衡量准确性并逐步减少幻觉。如果 Haink 答错了,这次互动就会成为一个测试用例,用于改进未来的版本。

Haink 的幕后工作原理

Haink 存在于 Slack 中,但其运行系统是复杂且完全自研的。它基于 Redis 和 AWS 从零开始构建,展示了实时数据平台、托管模型服务和可扩展基础设施如何协同工作,以驱动企业级的 AI 智能体。

架构概览

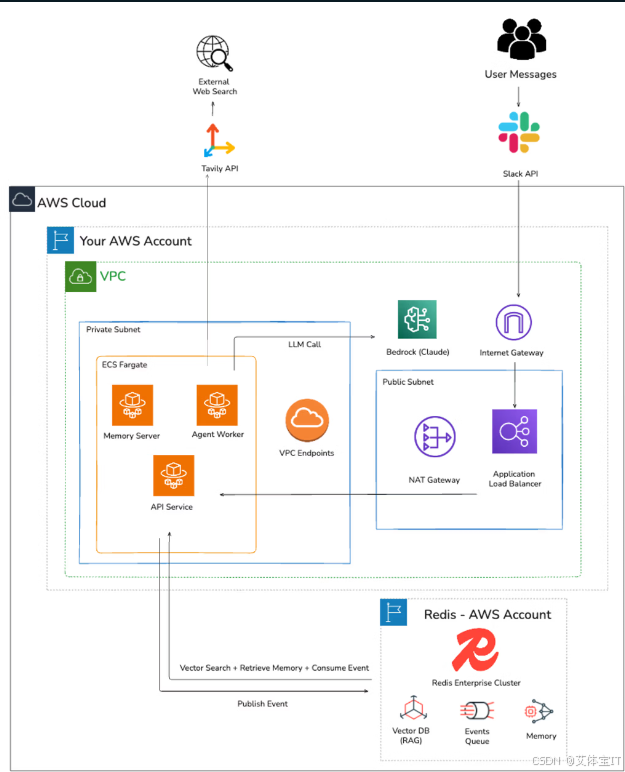

该架构完全构建在 AWS 之上,包括:

- ECS Fargate:用于服务编排

- Redis Cloud:用于实时数据和记忆存储

- **AWS Bedrock (Claude)**:用于托管式大型语言模型推理

这些组件无缝集成:

- 用户在 Slack 中提及 Haink。

- Slack 向一个应用负载均衡器发送 HTTPS POST 请求。

- API 服务将请求排入 Redis Streams 队列。

- 一个工作程序服务轮询 Redis Streams:

- 消费任务

- 从 Redis 检索对话状态

- 搜索 Redis 向量数据以获取相关文档。

- 使用 Tavily API 执行网络搜索。

- 在 AWS Bedrock 上调用 Claude 模型。

- 将响应写回 Redis。

- 将响应发布回 Slack。

图 1:Haink 系统架构,连接用于实时数据的 Redis Cloud 和用于托管式 LLM 推理的 AWS Bedrock。

每个组件扮演着不同的角色:

- Slack API:处理用户交互并触发工作流。

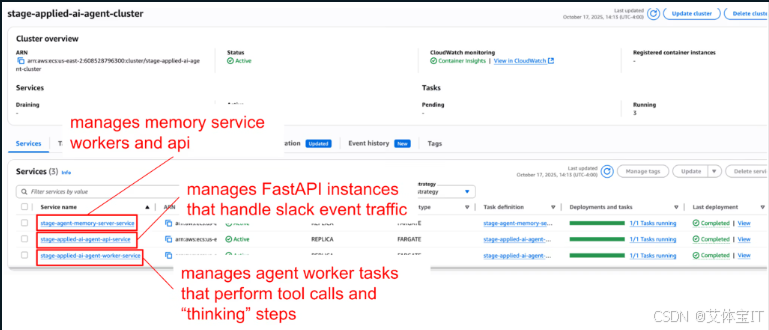

- ECS Fargate:运行包括 API 和智能体工作程序在内的容器化服务。

- **AWS Bedrock (Claude)**:为推理和文本生成提供可扩展的、托管式的基础模型访问。

- 部署在 AWS 上的 Redis Cloud:存储记忆、管理事件队列、为检索增强生成(RAG)提供向量搜索能力。

图 2:Haink 在 AWS ECS 集群上的部署,集成了 API、工作程序和记忆服务。

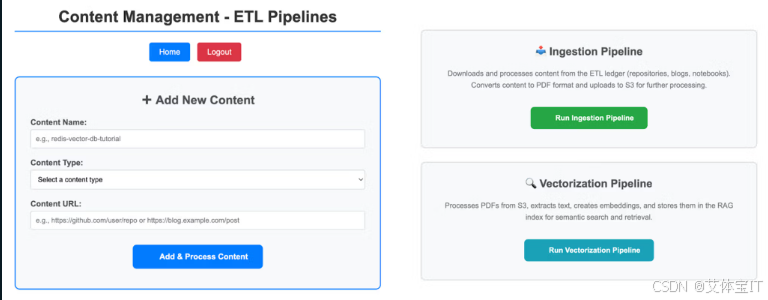

除了其运行时环境,Haink 还包含一个内部内容管理面板,为其知识摄取管道提供动力。该界面追踪每条内容从摄取、向量化到完成等各个阶段的状态,确保 Redis 的知识源保持最新并随时可供检索。

图 3:内容管理后台面板,展示了 Redis 知识源的摄取和向量化管道。

这一架构使 Haink 实现了模块化、可扩展且达到生产就绪状态。Redis 实现了对记忆和向量数据的亚毫秒级访问,而 Bedrock 则为推理和文本生成提供了托管式且安全的大型语言模型推理服务。它们共同构成了一个可大规模部署的实时系统。

记忆的角色

记忆使 Haink 感觉更像一个队友,而非一个工具。通过使用 Redis 作为记忆服务器,Haink 存储了短期和长期两种上下文。

短期记忆,或称"工作记忆",追踪最近的交流,以便 Haink 能够维持有上下文的对话。随着时间的推移,这些信息被提升为长期记忆,使得 Haink 能够回忆起之前的会话并发现互动中的模式。

这种方法模拟了人类大脑利用记忆的方式,并体现了 Redis 在 AI 记忆层中的工程优势。对于需要高效思考和信息检索的 AI 团队而言,Redis 是理想的选择。

Haink 为何重要

Haink 证明了使用 Redis 可以构建一个远超简单工具的智能体。Haink 的行为方式更像一个人类团队成员,而非一个软件工具。作为一个辅助性的团队成员,使得 Haink 的能力更强,与某些应用场景的关联性也更高。这个例子展示了通过 Redis 构建智能体的可能性。

Haink 的未来规划

Haink 背后的团队已经在试验新功能。一项正在进行的工作是增加多模态输入,使 Haink 不仅能理解和响应文本,还能处理代码块和其他数据类型。与 Salesforce 等企业工具通过 Glean 进行集成的计划也已排定,旨在扩展 Haink 处理复杂任务的能力。

未来的更新将改进测试系统,使 Haink 能从每一次会话中持续学习。Redis 团队每天都在高频使用 Haink,收集反馈,优化其推理能力,并改进其功能。这个生命周期过程为 Redis 的客户经理和解决方案架构师提供了支持,并进一步向其他公司展示了,将 Haink 作为 Redis 应用平台的一部分,可以如何通过架构示例和 Redis 专属的 AI 用例,帮助他们为客户会议做好准备。应用团队每天都在使用 Haink,这个在内部使用我们自己技术的过程(通常被称为"吃自己的狗粮"),在推动 Redis 自身实时软件平台进步的同时,也展示了 Haink 的持续演进。