视觉大模型(Visual Language Models,VLM)作为人工智能与计算机视觉的交叉技术,在自动驾驶领域正从感知层向决策层深度渗透,推动系统从"数据驱动"向"认知驱动"演进。其应用覆盖环境理解、交互优化及开发流程革新等多个维度。

1)在环境感知与场景理解方面,视觉大模型通过融合图像、视频流与文本信息,实现对交通场景的语义级解析。例如,VLM不仅能识别车辆、行人等物体,还可推断"行人挥手示意过马路"或"前方车辆双闪可能故障"等动态意图,弥补传统视觉模型在开放词汇场景下的不足。

这种能力依赖于多模态预训练架构,如跨注意力机制,将摄像头、激光雷达等异构数据映射到统一语义空间,提升系统在复杂天气或遮挡条件下的鲁棒性。

实际案例中,GPT-4V通过串联时间序列图像输入,展现出对交通参与者行为的时序关联分析能力,为自动驾驶系统提供更贴近人类认知的环境模型。

2)决策规划与可解释性增强是视觉大模型的另一核心应用。基于大模型的逻辑推理能力,系统可直接解析交通法规文本或路况描述,生成符合常识的驾驶决策序列。例如,DriveGPT等模型通过微调语言模型,将感知输出转化为具体轨迹指令;Talk2BEV框架则结合鸟瞰视图与自然语言交互,实现路径规划的动态调整。

同时,VLM能将复杂决策过程转化为自然语言描述(如"因前方施工变道"),不仅便于开发调试,也为乘客或监管方提供透明化的驾驶意图说明,增强人机信任。

3)交互体验与数据闭环优化方面,视觉大模型支撑自然语言指令理解与个性化服务。乘客可通过口语化指令(如"下一个便利店靠边停")与车辆交互,VLM负责意图识别与任务拆解,推动智能座舱向认知交互升级。

4)在开发层面,大模型通过构建云端数据闭环,显著降低自动驾驶系统的数据处理成本。例如,CurricuVLM框架利用多模态大语言模型分析真实事故报告,自动生成高风险场景的仿真数据,解决安全关键案例稀缺问题,从而提升算法在长尾场景下的泛化能力。

- 实时性与安全性增强:结合轻量化部署技术,大模型能在车端实现实时感知。例如,通过注意力机制动态聚焦关键区域(如行人密集区),平衡计算资源与响应速度,提升复杂城市道路的安全性。

- 数据闭环与低成本迭代:大模型通过云端数据积累与自学习机制,优化数据处理效率。例如,自动驾驶系统可自动筛选高价值数据(如罕见事故场景),降低标注与存储成本,加速算法迭代。

当前技术演进呈现从专用模型向通用基础模型融合的趋势。2025年,端到端视觉语言模型(如视觉语言行动模型VLA)已应用于城市NOA等场景,实现感知-决策-控制的统一建模;具身智能大模型更通过实时反馈机制,在50ms内完成"感知-决策-控制"闭环,支持机器人在动态环境中执行复杂操作。

这些进展标志着自动驾驶系统正从模块化管道向认知智能体跃迁,为L4级自动驾驶的商业化落地提供关键技术支撑。

自动驾驶的感知系统概述

把自动驾驶想像成一个有眼耳和大脑的司机。感知系统就是它的"眼睛"和"耳朵",负责把诸如前方有一辆车、左侧有个行人过马路、右边车道被施工封闭了、红灯亮了等外界的光、雷达回波、距离、速度这些原始信号变成机器能看懂的"事实"。感知并不是单一模块的工作,而是一整套从硬件到软件、从标定到算法、从实时性到冗余设计的组合工程。没有可靠的感知,后面的预测和规划就像盲驾,再聪明的决策也可能撞上现实。

如果将感知拆分,可以分为"传感器"和"算法"两大块,但其中还包含时间同步、标定、数据融合、状态估计,以及在线自检与降级(当某种传感器失效时系统如何优雅退化)等内容。

感知系统由哪些核心部分组成

- 感知系统最主要的就是传感器,常见的有摄像头、激光雷达(LiDAR)、毫米波雷达、超声波以及惯性测量单元(IMU)与车轮里程计等。摄像头擅长识别如识别交通灯、交通标识和文本信息等颜色和细节;激光雷达能给出高精度的三维点云,适合检测物体形状和测距;毫米波雷达在雨雪雾等能见度差的情况下仍然能稳定测出物体距离和速度;超声波适合近距离的低速泊车感知;IMU 和里程计则提供车辆自身的运动状态,帮助把传感信息放到一致的时间与空间坐标系里。不同传感器各有长短,在车辆上常常把它们按能力互补地组合起来,形成稳健的感知"传感网"。

- 感知算法链路,通常分为感知前处理、检测与分割、跟踪与轨迹估计、语义理解与场景解析这几层。前处理包含去噪、点云下采样、图像增强等;检测与分割负责把原始数据变成"我看见了什么",检测框、实例掩码或语义类别;跟踪模块把一帧帧的检测结果关联起来,给每个目标一个稳定的ID并估计速度、加速度;语义理解则把这些目标放进更复杂的语境里,比如判断某个行人是否有横穿马路的意向、车道哪儿是可通行区域、哪里可能有临时障碍物。

- 自动驾驶系统涉及到多个传感器,无可避免地就要涉及到传感器融合。融合的层级可以是像素级、特征级或决策级,也可以是把点云先换成鸟瞰视图再与相机特征融合的方式。融合要解决如不同传感器的分辨率差异、视角遮挡、时间延迟、数据频率不一致等问题。合理的融合策略能显著提升远近、静动目标的探测能力,也更容易满足冗余与安全要求。

- 定位与地图(有时候感知和定位会耦合得很紧)也是感知系统中非常重要的一环。高精地图或局部地图能提供车道线、静态障碍、路缘等先验,使感知在复杂场景下更稳。当地图不可用时,感知需要承担更多的工作,像实时构建占用网格或做视觉里程计(VO)/激光SLAM。这部分对实时性和算力要求都不低。

- 评估与在线自检在感知系统中也很重要。评估包括离线的指标(mAP、召回率、F1、跟踪精度等)和在线健康检测(传感器是否有异常、模型是否漂移)。在线自检非常关键,当某个传感器被雪覆盖或者相机镜头被污渍遮挡时,系统必须能迅速发现并切换到安全策略,提醒乘客接管或降低功能级别。

自动驾驶中的视觉感知与大模型的应用

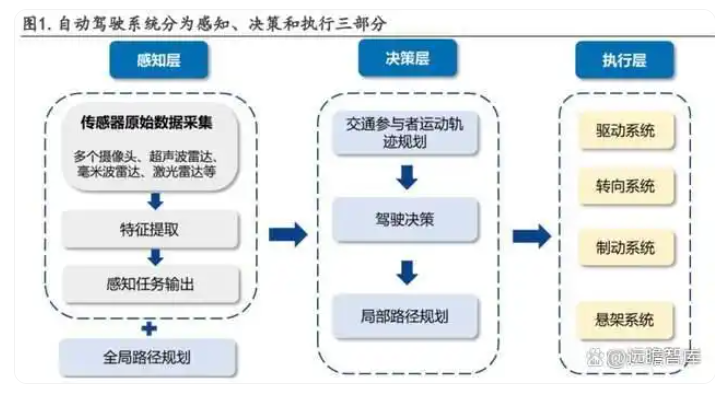

算法是决定自动驾驶车辆感知能力的核心要素。当前主流的自动驾驶模型框架分为感知、规划决策和执行三部分。感知模块是自动驾驶系统的眼睛,核心任务包括对采集图像进行检测、分割等,是后续决策层的基础,决定了整个自动驾驶模型的上限,在自动驾驶系统中至关重要。感知模块硬件部分主要为传感器,软件为感知算法,其中算法是决定自动驾驶车辆感知能力的核心要素。

自动驾驶中的视觉感知是车辆理解周围环境的基础,主要依赖摄像头等传感器捕捉图像数据,并通过算法进行处理。大模型的应用则显著提升了视觉感知的精度和智能化水平。

视觉感知的核心在于从图像中提取有用信息,如识别车道线、交通标志和行人。传统方法使用2D检测技术处理图像,但现代系统更倾向于3D目标检测,以获取深度信息。例如,通过多摄像头生成点云数据,再利用点云检测器(如PointPillars)进行3D物体识别。为了提升性能,技术如BEV(鸟瞰图)感知和全景分割被引入,使系统能更好地处理遮挡和复杂场景。

- 多模态数据融合与特征提取:大模型,特别是多模态大模型,通过融合视觉、语言和传感器数据,增强了自动驾驶系统的环境理解能力。这些模型能够统一处理图像、激光雷达等异构数据,打破模态间的语义隔阂,实现更鲁棒的感知。例如,在极端天气或光照条件下,大模型通过预训练获得的泛化能力,能保持较高的感知精度。

- 端到端感知架构的优化:大模型支持端到端的自动驾驶解决方案,直接从传感器输入生成驾驶决策,简化了传统模块化架构的复杂性。大模型(如基于Transformer的架构)替代传统分模块(感知-决策-控制)设计,直接从原始传感器数据生成驾驶决策。这种方法减少了模块间误差累积,提升了系统整体效率。例如,BEV(鸟瞰图)+Transformer模型能同时处理空间和时序信息,实现更精准的物体检测与轨迹预测。

- 开放词汇感知与动态场景理解:在实际应用中,大模型还帮助解决自动驾驶的"长尾效应",即罕见场景下的表现不稳定问题。通过生成模拟数据(如使用GAN技术),模型能在训练中覆盖更多边缘案例,提升安全性。传统感知系统对未见过的物体或罕见场景(corner cases)处理能力有限,而大模型通过大规模数据训练,可识别开放词汇中的新物体,并理解交通参与者的意图与行为。例如,GPT-4V等模型通过分析图像序列,能评估其他车辆或行人的位置、状态及潜在动作,增强对动态环境的适应性。

自动驾驶感知与决策的协同工作

自动驾驶系统中,感知与决策的协同工作是实现安全、高效自主驾驶的核心。感知模块负责从传感器数据中提取环境信息,而决策模块则基于这些信息制定驾驶策略,两者通过紧密的数据交互和联合优化实现协同。

-

感知模块的作用与输出

感知模块相当于车辆的"眼睛和耳朵",通过摄像头、激光雷达、雷达等传感器获取原始环境数据。经过预处理(如噪声去除、点云下采样)后,感知系统利用深度学习模型(如卷积神经网络或点云网络)进行检测、语义分割和跟踪,识别道路、障碍物、行人、信号灯等要素,并构建动态环境模型。

关键的是,感知输出不仅包括物体的类别和位置,还包含不确定性度量(如置信度或概率分布),这为决策层提供了风险敏感的输入。

-

决策模块的输入与处理

决策模块扮演"大脑"的角色,负责制定路径规划、行为选择(如变道、跟车)和运动规划。 它接收感知模块的输出,并结合车辆状态、交通规则和目标位置,通过多层架构(路径规划、行为规划、局部运动规划)进行决策。例如,行为规划可能使用规则基线与学习型模型混合的方法:规则确保安全合规,而学习模型(如强化学习或模仿学习)优化驾驶灵活性。

决策过程还需考虑交互影响,即预测其他交通参与者对自身行为的反应,这通常通过博弈论或条件预测模型实现。

-

协同工作机制

感知与决策的协同主要体现在两个方面:

- 数据流交互:感知模块的输出(如物体轨迹和不确定性)直接作为决策模块的输入。决策层将反馈(如期望轨迹)传递给感知模块,用于动态调整感知重点(如聚焦于高风险区域)。这种闭环交互提升了系统对动态环境的适应性。

- 联合优化与一体化设计:传统模块化方案中,感知和决策独立优化,可能导致信息损失或延迟。当前趋势是向感知-决策一体化发展,例如端到端模型直接从传感器输入生成控制信号,减少中间环节的误差。 这种一体化设计通过共享特征表示或联合训练,增强系统整体鲁棒性,尤其在复杂场景中(如交叉路口或恶劣天气)。

-

挑战与发展趋势

协同工作仍面临挑战,如感知不确定性如何影响决策可靠性,以及交互建模的复杂性。未来方向包括更紧密的传感器-决策融合、基于Transformer等架构的实时交互预测,以及通过仿真测试提升系统安全性。

自动驾驶中的目标检测与跟踪

1)基于视觉大模型的目标检测与语义分割

语义分割更侧重于对整个图像进行精细的分类和标注,而目标检测则更注重于识别和定位特定类型的对象。在实际应用中,需要根据具体需求选择合适的技术来实现图像分析和处理的目标。

语义分割

- 定义:语义分割是一种像素级别的分类任务,旨在将图像的每个像素都归类到某个特定的类别中。

- 目的:通过识别并标记出图像中的不同对象或区域,实现对场景的全面理解。

- 输入:通常是单张彩色图像。

- 处理过程:利用深度学习模型(如卷积神经网络)对输入图像进行特征提取和分类,生成一个与输入图像大小相同的输出图像(称为分割图)。在分割图中,每个像素都被赋予了一个类别标签。

- 输出:一个包含多个类别的分割图,其中每个类别对应一种颜色或编码方式。

目标检测

- 定义:目标检测是在图像中识别和定位感兴趣的对象(如人、车、动物等)的任务。

- 目的:通过确定对象的类别和位置信息,为后续的图像处理或决策提供依据。

- 输入:同样是单张彩色图像。

- 处理过程:使用深度学习模型(如基于区域的卷积神经网络R-CNN系列、YOLO系列等)在图像中提取候选区域,并对这些区域进行分类和边界框回归。最终,模型会输出一系列包含类别信息和位置信息的检测结果。

- 输出:一组包含类别标签、置信度和边界框的检测结果。每个结果都表示图像中一个被识别的对象及其位置。

基于视觉大模型的语义分割算法在自动驾驶中通过结合大规模视觉预训练模型与语义分割技术,实现了对复杂交通场景的精细化理解。这类算法的核心目标是将图像中的每个像素分类为预定义类别(如道路、车辆、行人等),为环境感知和决策规划提供基础。

自动驾驶中基于视觉大模型的目标检测算法是实现环境感知的核心技术,主要依赖摄像头等视觉传感器,通过深度学习模型从图像中识别和定位物体。

主流算法类型:基于视觉的目标检测算法主要包括:

-

两阶段检测器:这类方法先生成候选区域,再进行分类和回归,典型代表包括Faster R-CNN和Mask R-CNN。它们通过区域建议网络(RPN)提高检测精度,但计算成本较高。

-

单阶段检测器:直接预测目标类别和边界框,强调速度与效率,适合实时自动驾驶场景。例如YOLO系列(You Only Look Once)和SSD(Single Shot MultiBox Detector)。YOLOv7等版本在保持高速的同时优化了小目标检测能力。

-

Transformer-based模型:利用自注意力机制进行全局特征建模,例如DETR(DEtection TRansformer),基于集合的检测器,通过全局损失函数避免了传统NMS(非极大值抑制)步骤,提升了检测效率。它实现了端到端的目标检测,但训练阶段需要大量计算资源。

技术挑战与优化:视觉系统需应对低光照、遮挡等复杂环境。例如,在低照度条件下,YOLO-LKSDS模型通过结合CLAHE图像增强和SEAM注意力机制,有效减少了误检和漏检。此外,针对多尺度物体检测,Kmeans++算法和空间池化金字塔被用于优化特征提取。硬件部署方面,多核异构平台(如FPGA与ARM结合)通过Vitis-AI框架加速模型推理,平衡了实时性与功耗。

评估指标与数据集:目标检测性能通常采用平均精度(AP)衡量,基于3D边界框与真实值的交并比(IoU)计算。常用数据集包括nuScenes、KITTI和Waymo Open Dataset,这些数据集覆盖多种天气和场景,支持模型在真实环境下的验证。

最新进展:当前研究聚焦于提升模型对小障碍物(如石头)的检测能力,通过语义分割和大规模训练将未标注物体识别为潜在障碍物。结合BEV(鸟瞰图)感知架构,视觉模型能更好地理解3D场景,增强自动驾驶安全性。

2)视觉大模型在多目标跟踪中的应用

多目标跟踪是指在一个视频序列中同时跟踪多个目标的过程。它通常包括以下几个步骤:

-

目标检测(Object Detection):目标检测是指在图像或视频帧中定位和识别目标的过程。常见的目标检测方法有基于深度学习的方法(如Faster R-CNN、YOLO等)和传统的基于特征提取和分类器的方法(如Haar特征和级联分类器)等。

-

目标跟踪(Object Tracking):目标跟踪是指在连续的图像帧中追踪目标的过程。目标跟踪算法需要利用目标的外观特征和运动信息来推断目标在后续帧中的位置。常见的目标跟踪算法有基于相关滤波器的方法(如均值滤波器、核相关滤波器等)、基于粒子滤波器的方法(如卡尔曼滤波器、粒子滤波器等)和基于深度学习的方法(如Siamese网络、MDNet等)等。

-

目标关联(Object Association):目标关联是指将目标在不同帧中的跟踪结果进行关联,以保持目标的身份一致性。目标关联算法需要根据目标的外观、运动和时空信息,将不同帧中的目标进行匹配和关联。常见的目标关联算法有基于外观特征的匹配方法(如卡尔曼滤波器、匈牙利算法等)和基于运动模型的匹配方法(如最近邻匹配、多目标数据关联等)等。

视觉大模型在多目标跟踪中通过融合深度学习与大规模数据训练,显著提升了跟踪精度、鲁棒性和泛化能力,尤其在复杂场景下表现突出。

多目标跟踪旨在对视频序列中的多个目标进行定位、关联和轨迹生成。基于视觉大模型的方法通常以Transformer架构或大规模预训练模型(如视觉-语言模型)为核心,通过自监督学习从海量数据中提取通用特征。

这类方法可分为两类:一是基于检测的跟踪(Tracking By Detection),先通过大模型生成高精度目标检测结果,再通过关联策略(如深度学习优化的相似度度量)建立轨迹;二是端到端的联合检测与跟踪框架,直接利用大模型的全局上下文理解能力同步处理检测和关联任务。例如,一些方法采用对比学习或掩码建模预训练策略,增强模型对遮挡、外观变化等复杂场景的适应性。

视觉大模型的优势在于其强大的泛化能力,能有效缓解小目标、遮挡等传统挑战,并通过大规模数据学习运动规律和语义上下文。然而,该领域仍面临显著挑战:一是计算成本高,大模型的推理延迟限制了实时应用;二是对标注数据的依赖性,尽管自监督预训练减少需求,但高质量标注仍对微调至关重要;三是跨场景适应性,模型在未见场景中的性能可能下降。此外,轨迹关联的准确性受相似目标干扰影响较大,需结合运动模型或上下文信息优化。

经典视觉大模型及端到端自动驾驶应用

端到端自动驾驶是一种利用单一、统一的模型直接将从传感器(如摄像头、激光雷达等)获取的原始数据映射到车辆控制信号(如转向、油门、刹车等)的自动驾驶技术。与传统的模块化自动驾驶系统不同,它无需分步处理感知、决策、规划等任务,而是通过深度学习模型直接学习输入到输出的映射关系。

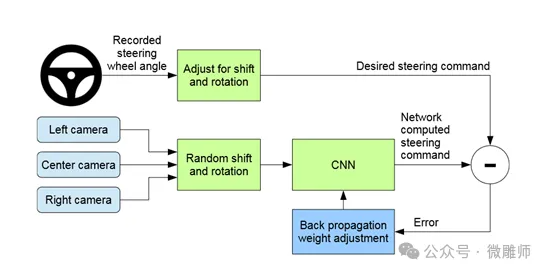

2016年,NVIDIA团队的论文《End to End Learning for Self-Driving Cars》首次证明端到端深度学习可直接从像素映射到方向盘控制 ,为端到端自动驾驶的后续研究奠定了基础。该论文提出名为 PilotNet 的卷积神经网络结构,输入是66×200×3的图像,中间经过了5层卷积提取视觉特征,如边缘、纹理,经过3层全连接回归转向角度,最终输出方向盘转向角度,该数值是一个可以直接控制车辆的连续值。

在NVIDIA团队纯模仿学习的基础上,Waymo团队于2018年通过论文《ChauffeurNet: Learning to Drive by Imitating the Best and Synthesizing the Worst》提出了一种混合模仿学习和对抗生成数据的自动驾驶方法,该方法的输入值是BEV鸟瞰图,包含车道、障碍物、交通灯等语义分割结果,以及车辆过去一秒的历史轨迹。输入的值通过CNN + LSTM组成的编码器提取空间和时间特征,在解码器中输出未来路径点进行路径轨迹预测,同时输出用于动作控制的速度和转向角信息。除了通过传统的模仿学习从人类驾驶数据中学习最佳行为之外,还通过对抗训练生成"边缘案例"(如突然切入、违规行人),强制模型学习应对高风险场景。

混合模仿学习和对抗生成数据的自动驾驶方法依赖高精地图和语义分割的输入,还不是纯端到端。2022年Waymo和Google Research团队联合发表的论文《End-to-End Model-Free Reinforcement Learning for Urban Driving》提出了一种完全基于无模型强化学习的端到端自动驾驶方法,能够在复杂的城市环境中实现高效决策,而无需依赖传统的高精地图或预定义规则。该方法能够从原始传感器输入(如摄像头、激光雷达)直接输出控制信号(转向、油门、刹车等)。

当前端到端自动驾驶的前沿框架主要包括纯视觉的端到端框架,多模态融合的端到端框架以及基于大模型的端到端框架。

- 在纯视觉端到端框架方面,英伟达推出了一款基于云的仿真平台NVIDIA DRIVE Sim,它利用高性能计算和逼真的虚拟环境,帮助开发者安全、高效地测试和训练自动驾驶系统,而无需依赖成本高昂且耗时的真实道路测试。其中的核心技术就是基于视觉Transformer的端到端控制。

- 在多模态融合的端到端框架方面,英国自动驾驶初创公司 Wayve 推出新一代端到端人工智能自动驾驶系统Wayve AV 2.0。该平台的多模态融合技术采用"视觉主导,雷达辅助"的设计理念,实现视觉-雷达跨模态对齐。该框架首先采集多摄像头阵列及4D毫米波雷达数据,再将雷达点云转换为2D密度图,与BEV特征图相加,同时使用TCN时序卷积网络补偿摄像头与雷达的时序差异。

- 在基于大模型的端到端框架方面,中国首个自动驾驶大模型毫末智行DriveGPT,该模型基于Transformer架构实现端到端的感知-决策一体化。其核心创新在于采用"驾驶链"技术,将复杂驾驶场景分解为逻辑子任务序列,并引入人类反馈强化学习优化决策过程。该模型通过日均100万公里真实道路数据与10亿公里仿真数据训练,已成功部署至长城汽车量产车型,支持城市NOH功能在100多个中国城市的复杂路况下运行,实现了接近人类司机的博弈能力和场景适应性。

DriveGPT的特别之处在于将大语言模型的思维链技术迁移到自动驾驶领域,使系统能像人类一样逐步推理"变道-减速-转向"的决策过程,同时通过在线学习持续进化。