更多内容:XiaoJ的知识星球

目录

- [论文:《An overview of text-to-speech systems and media applications》](#论文:《An overview of text-to-speech systems and media applications》)

-

- 1.介绍

- [2. 端到端TTS](#2. 端到端TTS)

- [3. 若干重要TTS技术](#3. 若干重要TTS技术)

-

- 1)WaveNet

- [2)DEEP VOICE 1](#2)DEEP VOICE 1)

- [3)DEEP VOICE 2](#3)DEEP VOICE 2)

- [4)DEEP VOICE 3](#4)DEEP VOICE 3)

- 5)Char2Wav

- 6)Tacotron

- [7)Tacotron 2](#7)Tacotron 2)

- [8)Transformer TTS 网络](#8)Transformer TTS 网络)

- [4. 讨论与结论](#4. 讨论与结论)

- 参考:

论文:《An overview of text-to-speech systems and media applications》

文本到语音(TTS)技术利用深度学习生成逼真合成语音,已成为交互式媒体的关键创新。典型TTS系统包含文本分析、声学建模和声码器三大模块。本文综述了代表性深度学习TTS系统(如Tacotron 2、Transformer TTS、WaveNet 和 FastSpeech 1),并从骨干架构、输入类型、转换方式、声码器及主观评估(MOS)等方面进行对比。最后,针对实际应用提出了TTS系统开发建议。

.

1.介绍

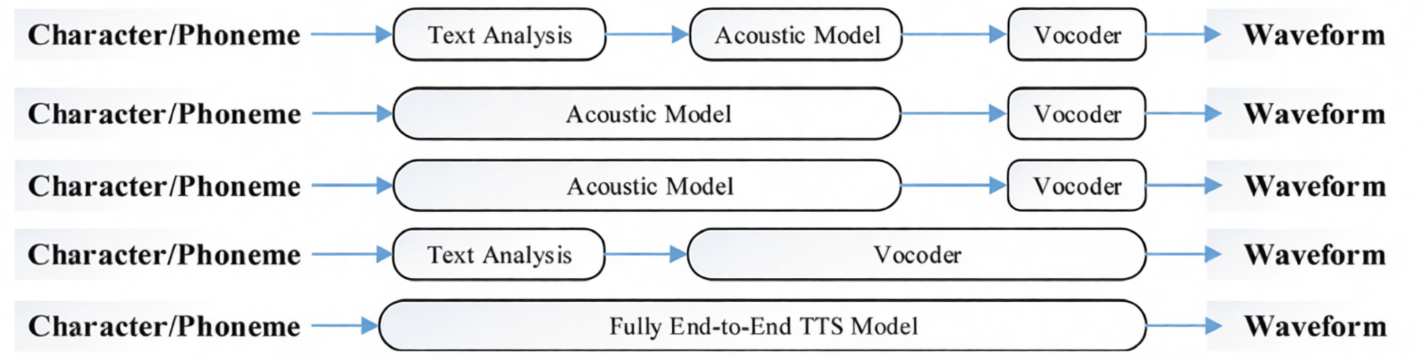

1)TTS结构

典型的现代文本到语音(TTS) 系统设计复杂,如图1所示。这些系统通常需要:

-

一个文本前端来提取语言学特征,

-

一个模型来预测声学特征,

-

以及一个基于信号处理的声码器来重构最终的波形。

这些模块中的每一个都需要专家设计并且需要独立训练。

图1: TTS系统总体结构

Linguistic Features

Acoustic Features

Text

Waveform

Text Analysis

Acoustic model

Vocoder

.

2)语音合成方式

基于神经网络的TTS,相比传统的拼接式和统计参数化方法已经实现了更高质量。

拼接式合成主要依赖于数据库中存储的分离语音片段的拼接。拼接式合成可以生成接近原始声音的高可懂度语音,但它需要大量数据来匹配所有可能的语音单元组合;另一方面,由于在情感和韵律特征拼接方面的灵活性不足,此类系统生成的语音自然度较低。

为了解决拼接式系统的这些缺点,提出了统计参数合成语音 (SPSS,statistical parametric synthesis speech)。实际上,SPSS不是直接生成输出波形,而是首先提取声学特征,然后通过这些预测参数重构最终波形。SPSS的优势在于输出的自然度以及修改参数的灵活性,从而可以创建具有不同韵律的音频。然而,生成的语音仍然存在可懂度低和机械音伪影的问题。

一些早期的神经网络建模遵循与SPSS相同的架构,但用相应的神经网络替换了每个模块,如Deep Voice 1/2。后来,出现了端到端(E2E)模型,如Tacotron 1/2、Deep Voice 3、FastSpeech 1/2,这些模型直接以字符/音素序列作为输入,生成梅尔频谱图作为声学特征,最后利用知名声码器生成最终波形。

另一类是完全端到端模型,旨在直接从输入字符/音素序列生成波形,如FastSpeech 2s、ClariNet和EATS。

.

3)TTS系统的关键组件

文本分析

文本分析在TTS系统中也称为前端,它将输入文本转换为包含丰富发音和韵律信息的语言学特征。Char2Wav和DeepVoice1/2完全基于神经网络实现字符到语言学特征的转换。韵律信息,如语音的节奏、重音和语调,对应于音节时长、响度和音高的变化。通常会利用手动收集的字形到音素词典进行G2P(grapheme-to-phoneme)转换。

声学模型

声学特征由语言学特征或直接由音素和字符生成。一些重要的声学特征包括:梅尔倒谱系数(MCC)、梅尔广义系数(MGC)、频带非周期性(BAP)、基频(F0)、浊音/清音(V/UV)、巴克频率倒谱系数(BFCC),以及使用最广泛的梅尔频谱图。与传统声学模型相比,基于神经网络的TTS系统大多以字符或音素序列作为输入,并生成高层的梅尔频谱图作为输出。神经端到端声学模型相对于传统模型的一个重要优势在于对齐方式的实现。实际上,传统声学模型需要在语言学特征和声学特征之间进行对齐,而基于序列到序列的神经模型则通过注意力机制隐式学习对齐,或者联合预测时长。

声码器

一般来说,声码器可分为传统的SPSS和基于神经网络的两类。STRAIGHT和WORLD是流行的SPSS声码器。传统声码器通常以声学特征作为输入,而基于神经网络的声码器可以同时接受声学和语言学特征。例如,WaveNet、WaveRNN和char2wave接受语言学特征,而LPCNet、WaveGlow和MelGAN则接受声学特征。

.

2. 端到端TTS

1)为何采用端到端TTS系统?

端到端TTS意味着仅通过<文本,音频>对来训练模型。此类系统通过消除独立设计每个模块的需求,使整个结构更加简化。这类系统的另一个优势在于能够灵活地适应不同类型的输入。例如:

- 可以将<文本,音频>替换为<特定特征,音频>,如<MFCC,音频>、<梅尔频谱图,音频>等。

此外,与多阶段系统相比,此类系统具有更高的鲁棒性。因此,这些优势意味着端到端系统能够让我们更好地利用海量真实世界数据。

值得注意的是,集成式端到端与基础端到端之间存在细微差别:

-

基础端到端结构是由独立训练的分离模块组合连接而成的端到端系统,如Deep Voice;

-

而在集成式合成器中,仅存在一个从随机初始化开始从头训练的单一结构,如Tacotron。

.

2)端到端TTS系统的挑战

在TTS系统中,给定的文本输入可能导致不同的发音或说话风格输出。这使得端到端TTS比其他简单的端到端任务更加困难。此外,与自动语音识别(ASR)和神经机器翻译(NMT)不同,TTS的输出是连续的,并且通常具有更长的序列。这些特性中的每一个都可能导致错误快速累积。

图2: 不同类型的TTS模型

图2展示了不同类型的TTS系统。(图/描述有问题?)

-

类型1:基于传统结构,包括文本分析、声学模型和声码器(SPSS)。

-

类型2和类型3:将文本分析和声学模型结合,分别使用输入字符直接预测通用声学特征或梅尔频谱图。Tacotron 2、DeepVoice 3和FastSpeech 1/2就是此类例子。

-

类型4:TTS将声学模型和最终声码器结合,直接将语言学特征转换为波形(WaveNet)。

-

最后,完全端到端模型将所有三个模块合并为一个,直接将字符转换为波形(WaveTacotron、Char2Wav、ClariNet)。

.

3. 若干重要TTS技术

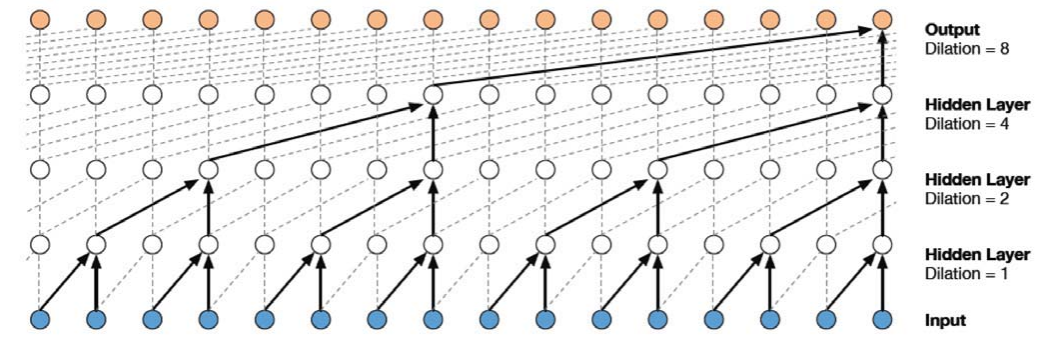

1)WaveNet

受图像生成自回归模型启发,WaveNet首次解决了高保真原始音频波形生成 问题(采样率≥16kHz)。其核心创新在于采用膨胀因果卷积(Dilated Causal Convolution) 克服长时序依赖建模难题。

因果卷积(Causal Convolution)

-

作用:禁止"偷看未来" → 只用过去的信息生成当前点。

-

图解(看图3):

-

所有箭头只能从左指向右(时间顺序),没有回头箭头。

-

输入层(蓝色)→ 隐藏层 → 输出层(橙色),单向流动。

-

膨胀卷积(Dilated Convolution)

-

作用:扩大"视野",让网络看到更长的上下文(比如跳着看 1, 3, 5, 7... 点)。

-

关键参数:膨胀率(Dilation)

-

Dilation=1:连续看 3 个点(普通卷积)。

-

Dilation=2:跳 1 个点看(看第 1,3,5... 点)→ 覆盖范围扩大 2 倍。

-

Dilation=4:跳 3 个点看 → 覆盖范围扩大 4 倍。

-

Dilation=8:跳 7 个点看 → 覆盖范围扩大 8 倍。

-

图3:扩张卷积层结构

条件输入(Conditioning):让模型"听懂"指令

WaveNet 需要额外信息控制生成内容(如文本、语调),分两类:

| 类型 | 作用 | 如何实现 |

|---|---|---|

| 全局条件 | 控制整体风格(如"这是中文还是英文") | 输入一个固定向量(如说话人ID) |

| 局部条件 | 控制每时刻细节(如"这个字要重读") | 将低分辨率文本特征 (如音素序列);上采样到音频分辨率(用转置卷积) |

.

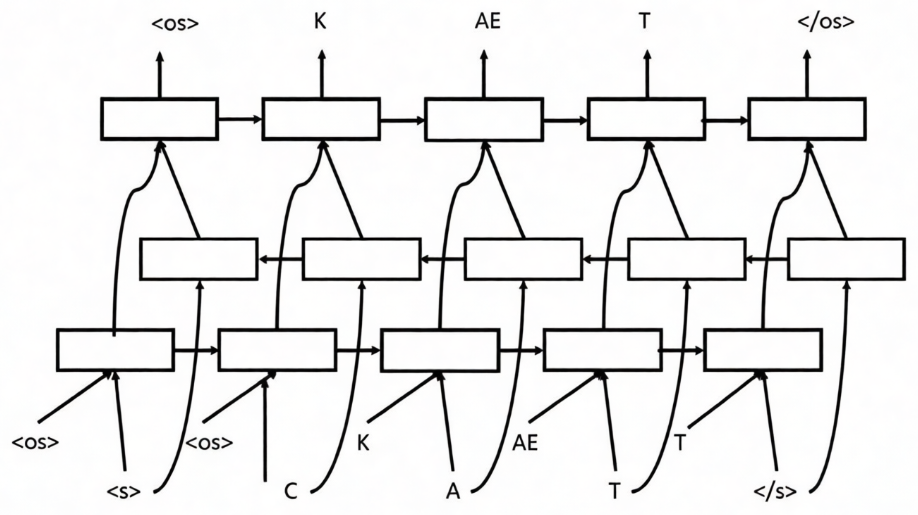

2)DEEP VOICE 1

Deep Voice基于传统的文本到语音(TTS)流水线,采用相同的结构,但将每个组件替换为其对应的神经网络。根据Deep Voice,TTS系统由五个主要构建模块组成:

(1)字形到音素模型(Grapheme-to-phoneme model)

字形到音素(G2P)转换是根据单词的书面形式生成其发音的过程。Deep Voice的G2P模型基于编码器-解码器架构。图4展示了双向LSTM。

双向LSTM在字形到音素模型中,通过同时分析字符的前后上下文(前向和后向),解决同一字符在不同单词中发音不同的问题(如英语"c"在"cat"和"city"中的不同发音),从而更准确地预测音素序列。

图4:双向LSTM("CAT"表示前进,"TAC"表示后退)

(2)分割模型(Segmentation model)

给定一个音频文件和该音频的音素级转录,分割模块找到每个音素的起始和时间点。采用最先进的语音识别系统可以帮助分割和标注给定的音素序列及相应的音频话语。该模块采用基于CTC的RNN。

(3)音素时长模型(Phoneme duration model)

预测话语中每个音素的时间持续长度。此处使用的模型架构与基频模型共享,并在下文部分进行说明。

(4)基频模型(Fundamental frequency model)

Deep Voice把音素时长预测 和基频预测合并成一个模型,因为它们密切相关(长音素通常需要更复杂的音高变化)。

模型结构:

-

两个全连接层(各256个神经元):对输入音素信息初步处理;

-

两个GRU循环层(各128个单元):记住语音的上下文信息(前面音素对后面音素的影响);

-

输出层:一是音素时长、二是音素为浊音的概率(浊音就是有声带振动的音,如元音;无声带振动的音如"s"、"sh"就没有基频)、三是在预测时长内均匀采样的基频(F0)。

(5)音频合成模型(Audio synthesis model)

结合字形到音素、时长和基频预测模型的输出,该模块合成输出原始波形。Deep Voice采用WaveNet作为其音频合成的核心。

实际上,Deep Voice已使用相应的基于神经网络的模型对每个模块进行了升级。然而,该模型在这方面并未显著超越最先进的系统。它得出结论:实现自然TTS的主要障碍在于时长和基频预测。

.

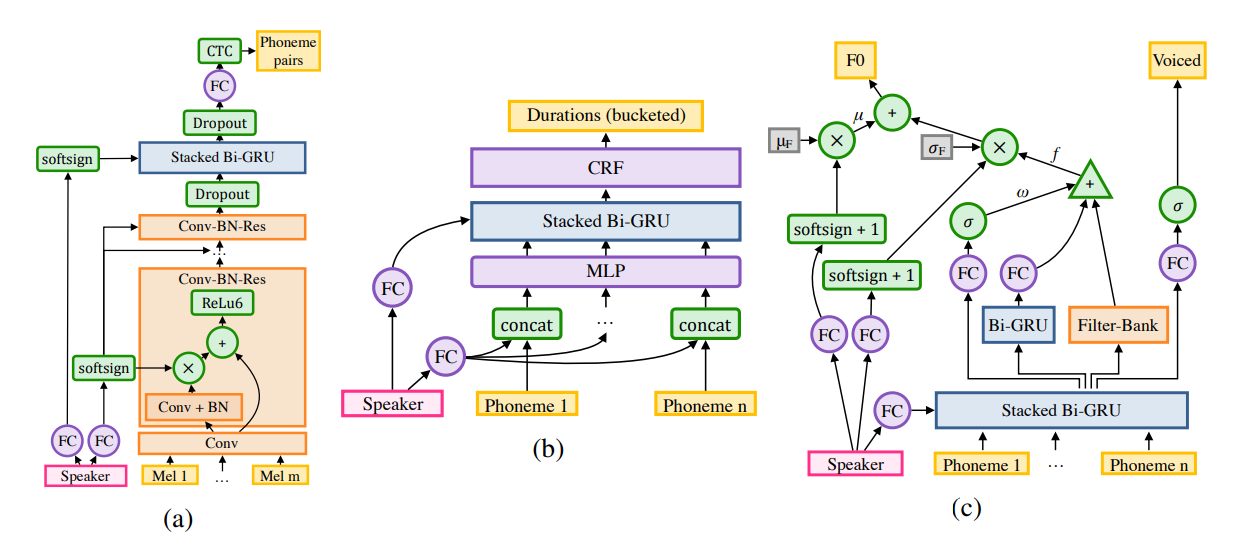

3)DEEP VOICE 2

该模型保持了Deep Voice 1的整体结构,主要区别在于将音素时长模型和基频模型进行了分离。首先预测音素时长,然后将其作为输入提供给基频模型。所有模型都是单独训练的。

每个模块还通过低维说话人嵌入(就是用一个简短的数字代码 来代表每个人独特的声音特征)进行了增强。在每个模块中使用说话人嵌入技术,使Deep Voice 2成为一个多说话人文语转换系统。

Deep Voice 2是一个高质量的文本到语音系统,并明确证明了神经语音合成模型能够从分散在数百个不同说话人中的少量数据中有效学习。

图5:Deep Voice 2每个模块的说话人嵌入:a) 分割 b) 时长 c) 频率模型

.

4)DEEP VOICE 3

Deep Voice 3 是一种完全基于卷积神经网络的字符到声谱图架构的文本到语音合成系统。它能够生成单调的注意力行为,从而避免序列到序列模型中常见的错误模式。

.

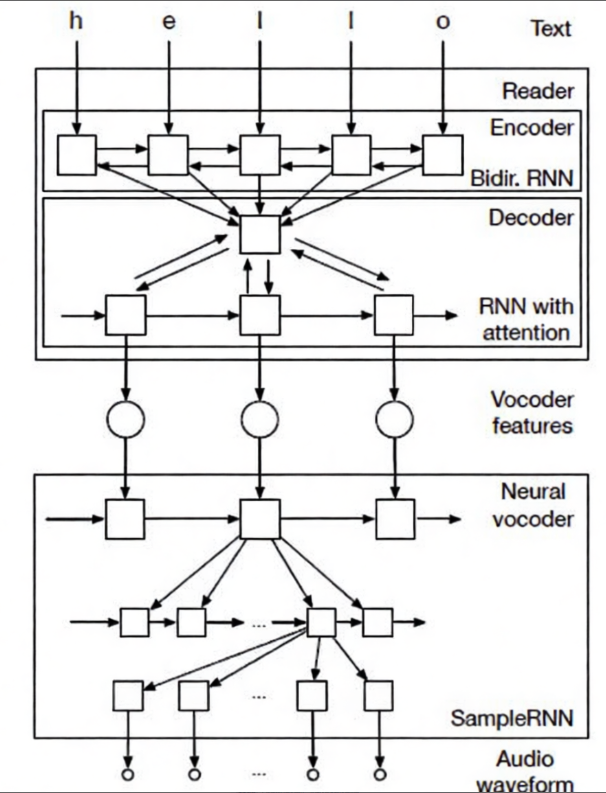

5)Char2Wav

Char2Wav将文本到语音模型的建模分为两个部分:一个读取器(前端)和一个神经声码器(后端)。

-

读取器 (reader):采用带有注意力机制的编码器-解码器架构,以文本或音素作为输入,并将其转换为语言学特征。

-

神经声码器 (neural vocoder):接收语言学(声学)特征并生成相应的音频。在此定义中,WaveNet被视为一种神经后端。Char2Wav采用SampleRNN作为分层声码器。

Char2Wav集成了前端和后端,并以端到端的方式同时学习整个模型。Char2Wav的总体结构如图6所示。然而,Char2Wav需要首先预测声码器特征,并且此处使用的SampleRNN声码器需要单独进行预训练,而Tacotron则直接预测输出原始波形。

图6:Char2Wav:端到端语音合成模型

.

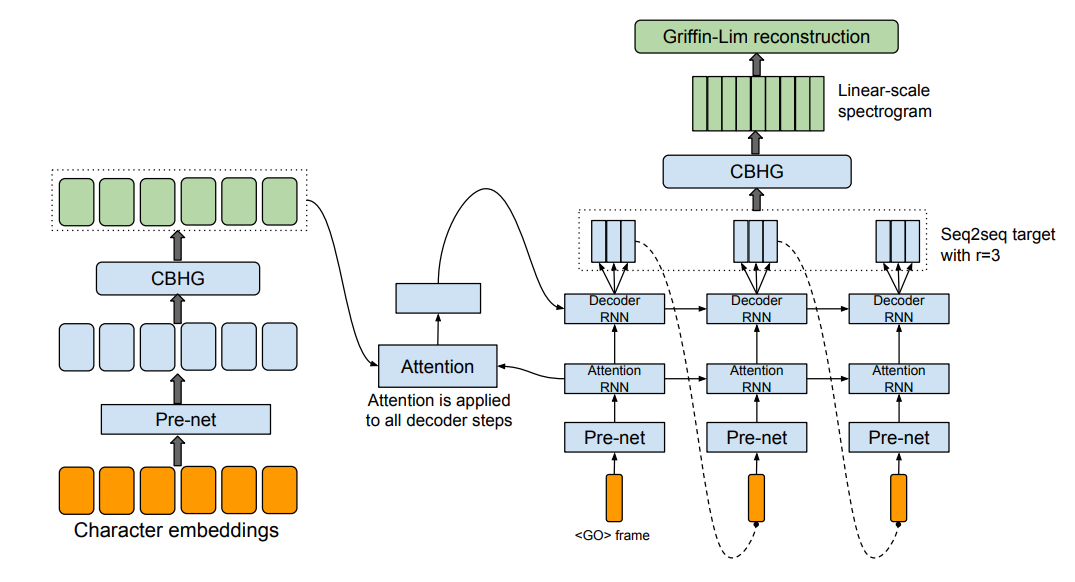

6)Tacotron

Tacotron是一种端到端的生成式文本到语音模型,能够直接从字符合成语音。Tacotron采用序列到序列架构,从字符序列生成幅度谱图,用单一神经网络取代了传统的语言学和声学特征处理流程。

Tacotron由三个模块组成:编码器、基于注意力机制的解码器和后处理网络。

Tacotron以字符作为输入,生成谱图帧,然后使用Griffin-Lim算法将这些谱图帧转换为波形。编码器中的CBHG模块(1D卷积组+高速公路网络+双向GRU)有效减少了过拟合问题。

图7:Tacotron架构

表2: Tacotron的平均意见得分(MOS,Mean Score Opinion)

| Tacotron | 3.82±0.085 |

|---|---|

| Parametric | 3.69±0.109 |

| Concatenative | 4.09±0.119 |

.

7)Tacotron 2

与使用Griffin-Lim算法生成最终音频波形的Tacotron不同,Tacotron 2采用WaveNet作为声码器,以补偿格Griffin-Lim算法产生的典型人工痕迹。

Tacotron 2由两个主要模块组成:

-

一个带有注意力机制的循环序列到序列特征预测网络,用于预测梅尔频谱图的帧;

-

一个WaveNet声码器,用于生成最终的音频波形。

Tacotron 2显著优于所有其他TTS系统,其平均意见得分(MOS)与真实音频相当。

.

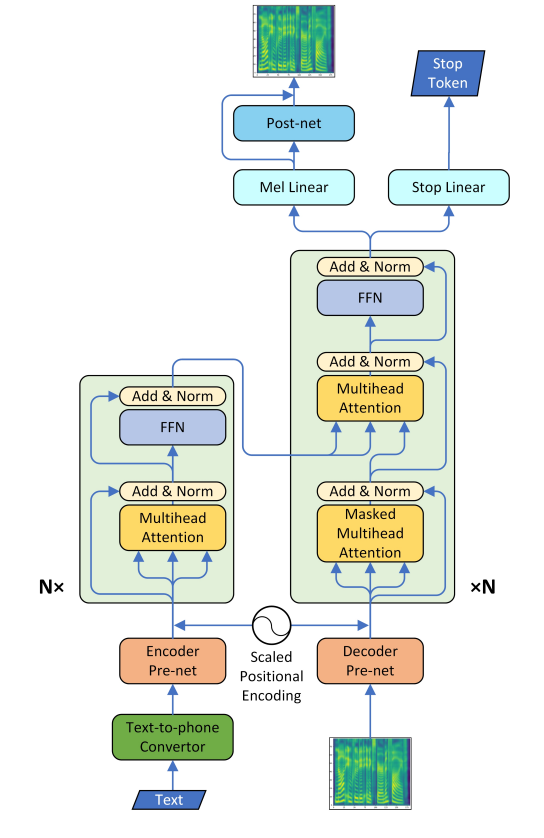

8)Transformer TTS 网络

Transformer TTS网络基于Tacotron 2和Transformer网络构建。该方法提出将Transformer与Tacotron 2相结合来预测梅尔频谱图,并利用WaveNet重建最终波形。

由于使用WaveNet重建最终原始波形,该模型是自回归的,仍然存在推理速度慢的问题。根据论文报告的结果,该方法的效果以0.048的差距优于Tacotron 2,且非常接近人类水平(4.39 vs 4.44 MOS)。

图8:Transformer-TTS架构

.

4. 讨论与结论

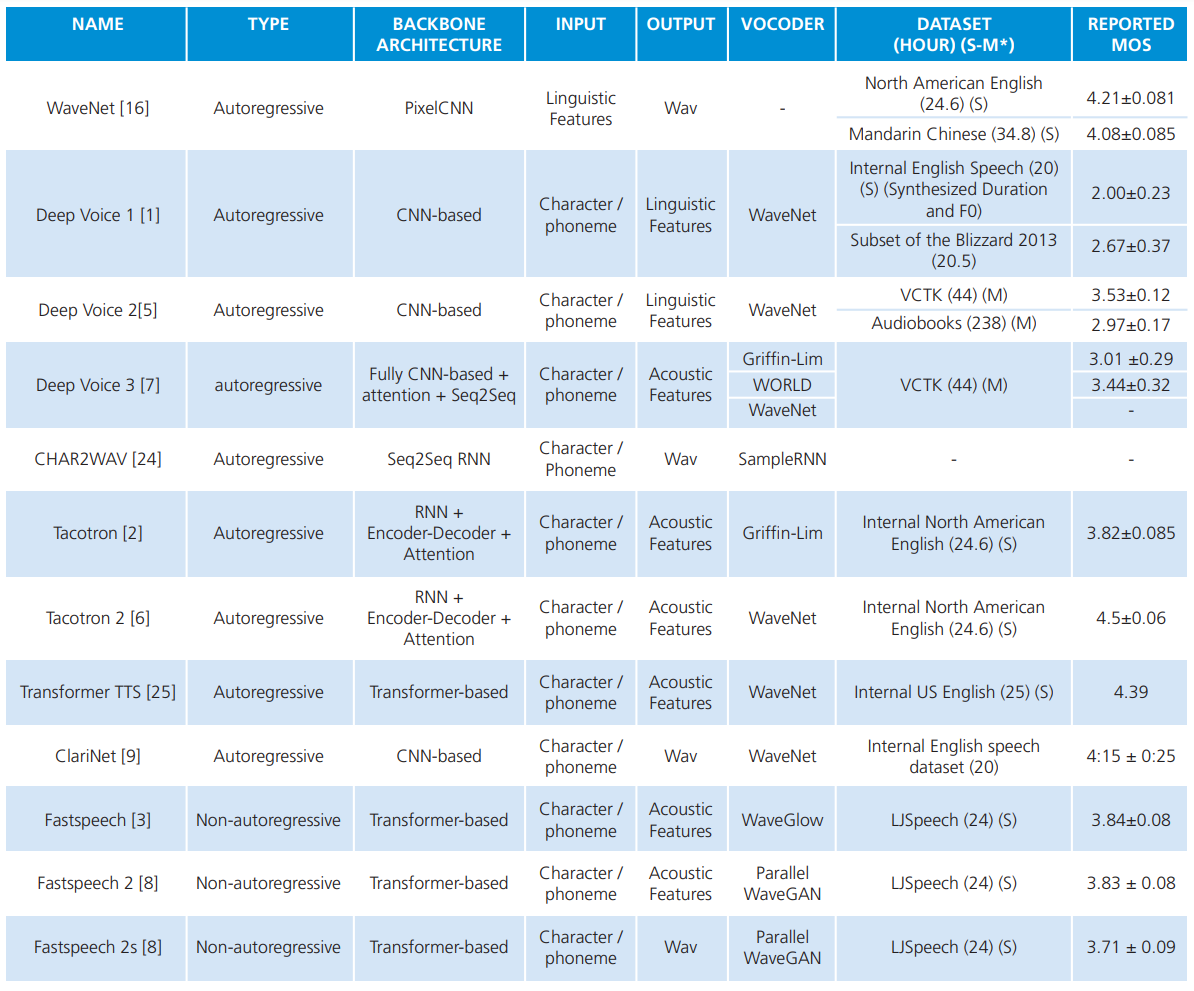

表3汇总了当时最先进的TTS系统。据此,Tacotron 2、Transformer TTS、WaveNet、FastSpeech 1和ClariNet是当时最成功的TTS系统。

TTS模型主要分为两类:端到端模型(将字符转换为梅尔频谱图,再用WaveNet等声码器生成波形)和完全端到端模型(直接将字符/音素转换为波形,如Char2Wav、ClariNet、FastSpeech 2s),需注意区分两者。早期TTS系统通常在单说话人数据集(如LJSpeech)上训练,后续版本则转向多说话人数据集(如VCTK),并通过嵌入说话人向量实现个性化定制。

表3:当时最先进TTS模型比较

.

参考:

论文:https://arxiv.org/abs/2310.14301

.

声明:资源可能存在第三方来源,若有侵权请联系删除!