在AI模型训练领域,混合精度训练和分布式训练技术是提升效率的关键。NVIDIA Apex作为PyTorch生态中的重要工具库,为这些技术提供了便捷实现。而针对华为昇腾AI处理器,通过Apex Patch适配的apex for Ascend则让昇腾用户也能享受类似的效率提升。下面我将详细解析apex for Ascend的编译流程、环境配置要点及常见问题解决方案,为昇腾昇腾平台部署AI训练任务提供全面参考。

一、Apex与昇腾适配版本的核心概念

在深入编译流程前,有必要明确两个核心概念的区别与联系:

- NVIDIA Apex:作为PyTorch的扩展工具库,其核心价值在于简化了混合精度训练和分布式训练的实现门槛。通过封装底层优化逻辑,让开发者无需深入硬件硬件细节,就能显著提升训练速度并降低显存占用。

- apex for Ascend:华为昇腾团队通过代码补丁(Patch)的形式,将NVIDIA Apex适配到昇腾AI处理器。除了保留原有的自动混合精度训练功能外,还针对昇腾NPU的架构特点,新增了梯度融合、融合优化器等特色功能,进一步释放昇腾硬件的计算潜力。

二、容器化编译流程详解

容器化编译因其环境隔离性和一致性,成为推荐的编译方式。整个流程包括代理配置、镜像构建、容器操作及编译安装四个关键环节:

- Linux代理配置

- Docker代理配置

- 容器创建与进入

- 编译与安装操作

2.1 网络代理配置

在受限网络环境中,代理配置是确保编译过程顺利进行的前提。

系统级代理设置

通过环境变量配置系统代理,适用于curl、wget等命令行工具:

plain

# 替换为实际代理地址和端口

proxy_ip="your_proxy_ip"

proxy_port="your_proxy_port"

export http_proxy="http://${proxy_ip}:${proxy_port}"

export https_proxy="http://${proxy_ip}:${proxy_port}"Docker守护进程代理配置

Docker服务作为独立系统进程,需要单独配置代理:

- 检查当前代理配置状态:

plain

docker info | grep -i proxy- 创建代理配置目录:

plain

sudo mkdir -p /etc/systemd/system/docker.service.d- 配置HTTP代理(http-proxy.conf):

plain

[Service]

Environment="HTTP_PROXY=http://your_proxy_ip:your_proxy_port"- 配置HTTPS代理(https-proxy.conf):

plain

[Service]

Environment="HTTPS_PROXY=http://your_proxy_ip:your_proxy_port"- 重启Docker服务使配置生效:

plain

sudo systemctl daemon-reload

sudo systemctl restart docker2.2 容器环境准备

完成代理配置后,即可进行容器镜像的构建与运行:

- 克隆昇腾Apex代码仓库:

plain

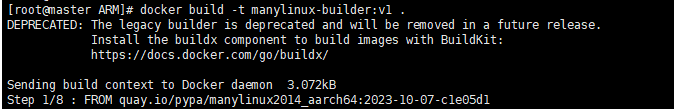

git clone -b master https://gitcode.com/Ascend/apex.git- 构建对应架构的镜像(X86或ARM):

plain

# 根据实际架构选择目录

cd apex/scripts/docker/x86 # 或 apex/scripts/docker/arm

docker build -t manylinux-builder:v1 .- 启动容器并挂载代码目录:

plain

# 将{code_path}替换为本地apex代码的实际路径

docker run -it -v /{code_path}/apex:/home/apex manylinux-builder:v1 bash2.3 编译与安装操作

进入容器后,依次完成PyTorch安装与Apex编译:

- 安装指定版本的PyTorch(以Python3.8和torch2.1.0为例):

plain

pip3.8 install torch==2.1.0提示:可参考PyTorch官方文档(https://pytorch.org/get-started/previous-versions/)选择适合的版本安装命令。

- 执行编译脚本:

plain

cd /home/apex

bash scripts/build.sh --python=3.8三、直接编译方案

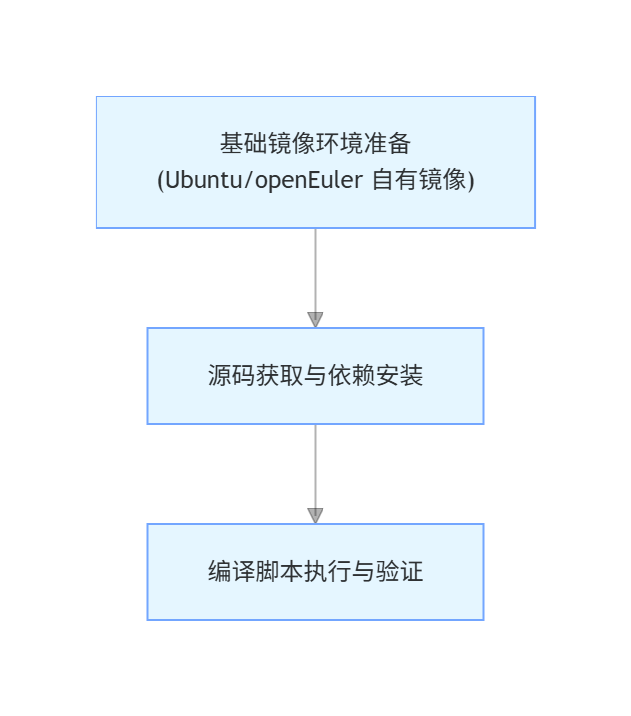

对于需要自定义基础环境的场景,可采用直接编译方式。该方案跳过官方容器镜像,基于自有镜像(如Ubuntu、openEuler)构建环境,架构图如下:

操作步骤如下:

- 克隆源码:

plain

git clone -b master https://gitcode.com/Ascend/apex.git- 安装必要依赖(根据基础镜像系统自行调整):

plain

# Ubuntu/Debian系统示例

apt-get update && apt-get install -y python3.8 python3.8-dev gcc g++ make

# OpenEuler系统示例

yum install -y python3.8 python3.8-devel gcc gcc-c++ make- 执行编译:

plain

cd apex

bash scripts/build.sh --python=3.8四、安装与验证

编译完成后,在dist目录会生成对应版本的wheel包,执行以下命令完成安装:

plain

cd apex/dist/

# 先卸载可能存在的旧版本

pip3 uninstall apex -y

# 安装新编译的版本,注意替换{version}为实际版本信息

pip3 install --upgrade apex-0.1+ascend-{version}.whl安装验证可通过简单的Python导入测试:

plain

import apex

print("Apex for Ascend installed successfully. Version:", apex.__version__)五、常见问题及解决方案

5.1 Docker镜像拉取失败

_【问题现象】_构建镜像过程中出现网络超时或无法连接仓库的错误。

_【解决思路】_这类问题通常与代理配置相关,需确保:

- Docker守护进程的代理配置正确

- 代理服务器可正常访问目标仓库地址

- 配置完成后已重启Docker服务

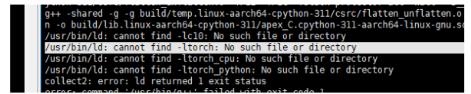

5.2 使用mindie openEuler镜像构造容器编译时报错

【报错截图】

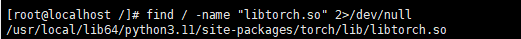

提示链接torch库失败,我们通过find / -name "libtorch.so" 2>/dev/null命令确认torch库路径 回显如下

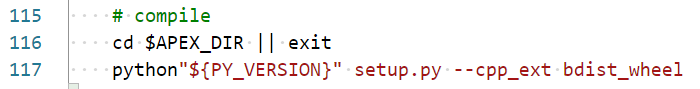

且import torch正常说明torch应该是正常安装的。 检查apex/script/build.sh脚本可以看到使用的应用完patch后NV apex仓库的setup.py脚本进行编译

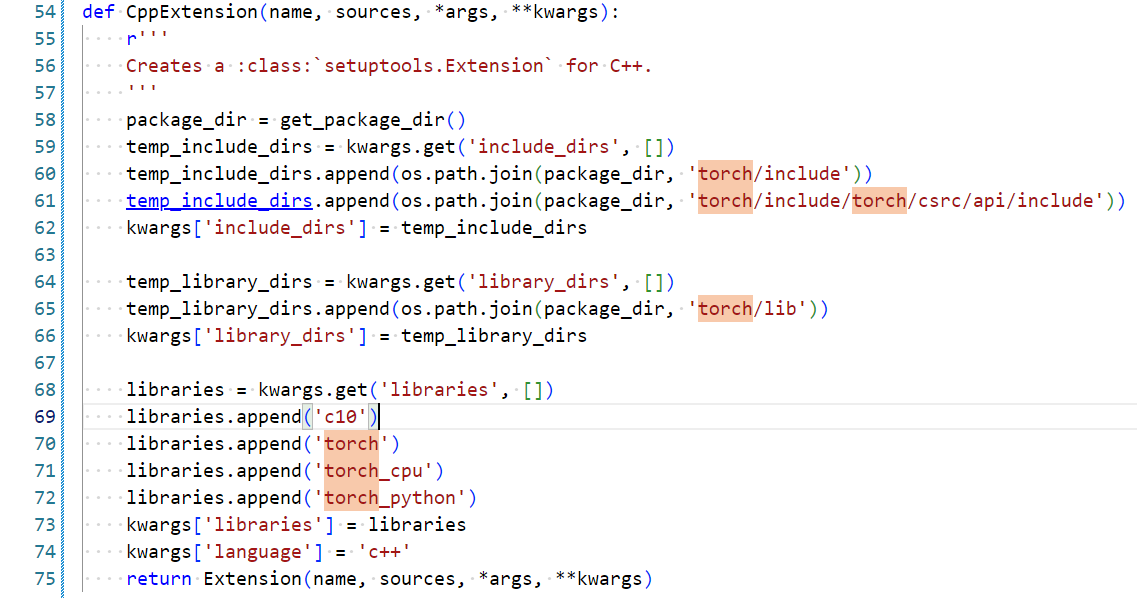

在apex/apex/setup.py中搜索torch关键字寻找链接torch的配置

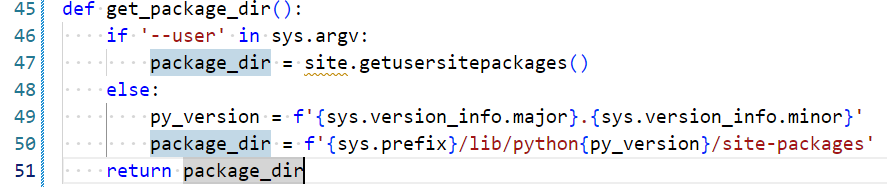

查看func get_package_dir()

发现未输入--user参数时脚本默认将包路径配置为/usr/local/lib/python3.11/site-packages 与前面torch安装路径不一致导致查找torch库失包

_【解决方法】 _直接修改setup.py中get_package_dir的package_dir默认值 bash package_dir = f'{sys.prefix}/lib/python{py_version}/site-packages' -> package_dir = f'{sys.prefix}/lib64/python{py_version}/site-packages'

然后执行python setup.py --cpp_ext bdist_wheel (执行scritp/build.sh会重新clone apex导致修改被覆盖) 成功后会在dist目录生成apex whl包

六、总结

apex for Ascend作为昇腾平台上实现高效训练的重要工具,其编译过程涉及环境配置、容器操作、跨平台适配等多个环节。本文我们介绍的容器化编译和直接编译两种方案,开发者可根据实际环境需求选择合适的方式。在遇到问题时,应重点关注网络代理配置和系统架构差异带来的路径问题,通过针对性调整确保编译顺利完成。

掌握apex for Ascend的编译部署技术,能够帮助开发者充分发挥昇腾AI处理器的性能优势,为大规模AI模型训练提供有力支持。

注明:昇腾PAE案例库对本文写作亦有帮助。