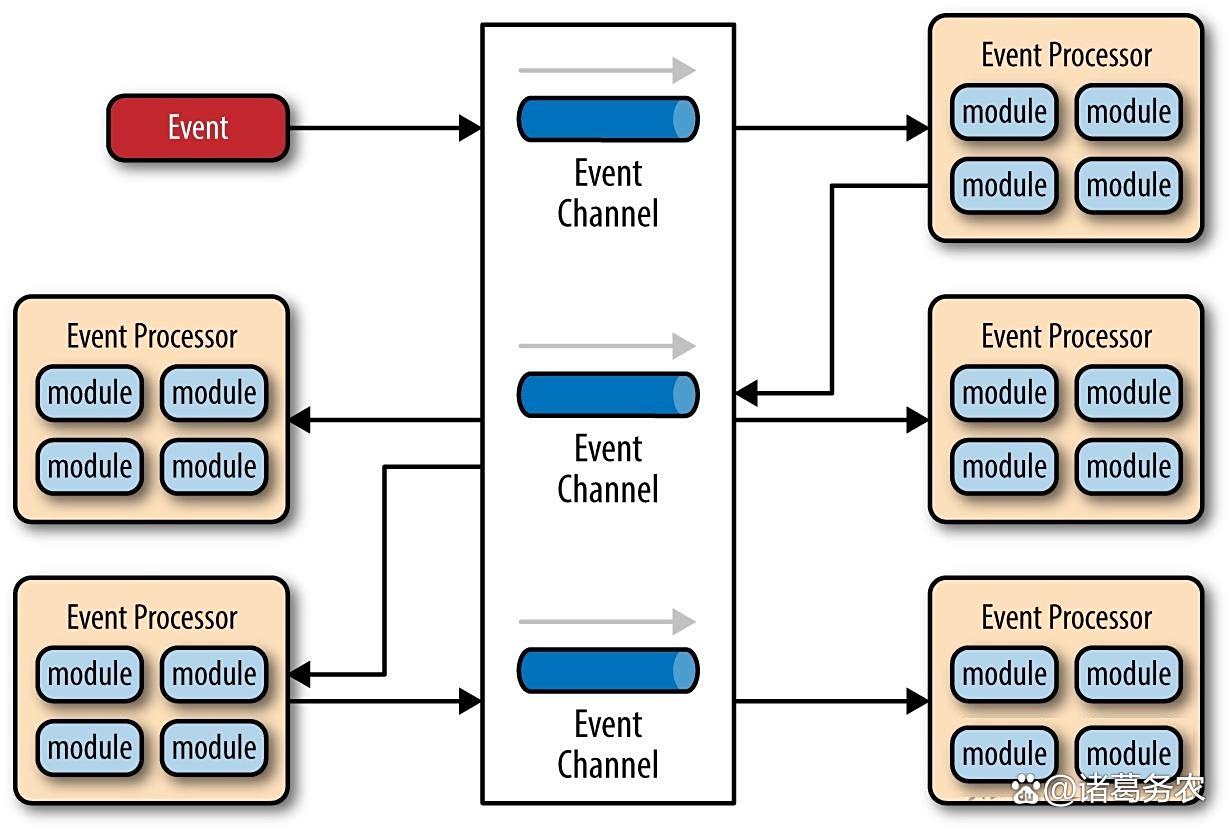

事件驱动架构

第一节:类脑大模型架构及其进展和前沿

一、什么是类脑大模型?其核心架构理念是什么?

- 概念:

类脑大模型是指借鉴生物大脑的结构与信息处理机制(如稀疏性、脉冲通信、动态网络、存算一体等)来构建的大规模人工智能模型。其目标不是精确复制大脑,而是汲取其设计精髓,克服当前Transformer架构大模型在能耗、逻辑推理、持续学习等方面的固有瓶颈。

- 核心架构理念:

稀疏性与事件驱动:大脑不是时刻全功率运行的。类脑大模型模仿这一点,采用脉冲神经网络(SNN) 作为基础,神经元仅在需要时才发放稀疏的脉冲,从而大幅降低能耗。

时序与动态计算:信息在大脑中编码于脉冲的精确时序中,而不仅仅是频率。类脑大模型强调时空联合编码与处理,使其天生擅长处理视频、语音等时序信号。

记忆与处理融合(存算一体):大脑没有独立的"内存"和"CPU"。类脑大模型的架构设计倾向于将存储与计算紧密耦合(无论是在算法层面还是硬件层面),以消除"内存墙",提升能效。

模块化与层次化:大脑由多个功能各异但又协同工作的脑区组成。类脑大模型往往采用异构、模块化的架构,不同部分可能采用不同的模型(如SNN与ANN融合),分别处理感知、决策、记忆等不同任务。

持续与在线学习:大脑能够在不遗忘旧知识的前提下持续学习新知识。类脑大模型致力于整合类脑的局部学习规则(如STDP),实现高效的终身学习。

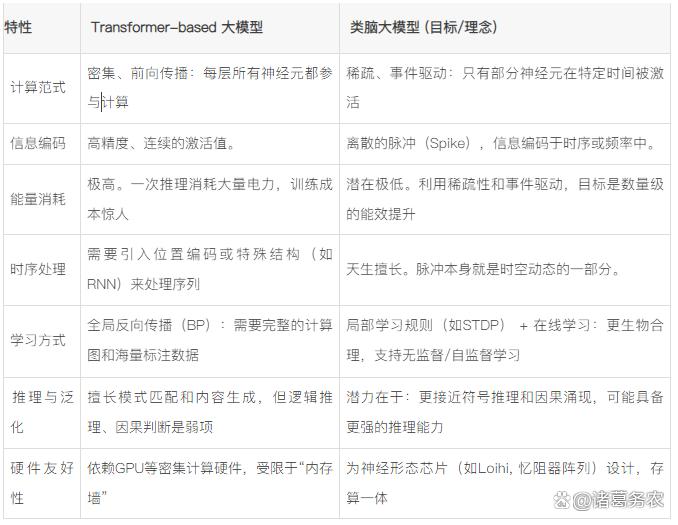

二、与传统大模型(如Transformer)的核心区别

为了更清晰地理解,将其与占据主导地位的Transformer架构进行对比:

类脑大模型与传统大模型的区别

三、核心进展与前沿架构探索

类脑大模型尚处于早期阶段,但已出现一些非常有代表性的架构探索和技术路径:

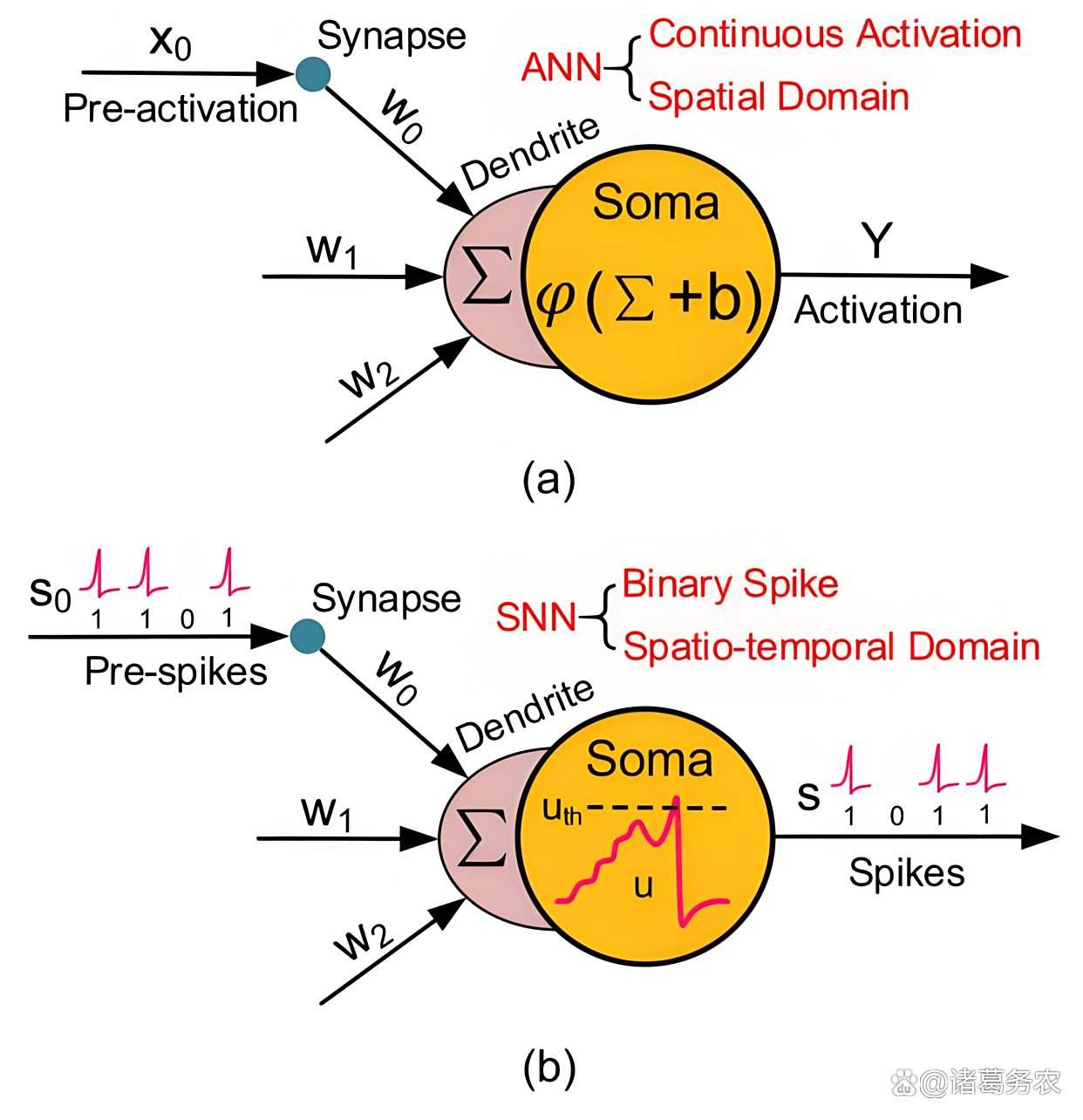

- 纯脉冲神经网络(SNN) scaling up

进展:研究者们正在尝试简单地将SNN的规模扩大,并探索如何有效训练深度SNN。例如,通过代理梯度法等方法,成功训练了深度SNN在ImageNet等大型数据集上达到接近ANN的精度。

代表:一些研究展示了数十层的深度SNN。这表明,至少在视觉感知任务上,纯SNN架构具备成为大模型的潜力。

ANN 和 SNN 的基本神经元

- 脑启发大语言模型(Brain-inspired LLM)

1)进展:这是最前沿的探索,旨在设计替代Transformer的类脑架构。

2)代表:上海交通大学的BriLLM(Brain-inspired Large Language Model):

非Transformer架构:完全摒弃了Transformer的核心模块(自注意力、MLP)。

脑启发机制:其核心是模拟大脑皮层的兴奋-抑制平衡(E-I Balance) 和前馈/反馈连接。信息像"神经信号"一样在网络中全连接流动和竞争。

优势:据论文所述,BriLLM在低功耗、长上下文(支持无限长上下文?)、可解释性和逻辑推理方面展现出潜力。这是一种颠覆性的架构创新。

- 多尺度脑模拟与树突计算模型

1)进展:不满足于简单的LIF神经元,开始在模型中引入更复杂的生物细节。

2)代表:中科院自动化所等团队的工作:

树突计算:在模型中引入多房室神经元模型,其中树突可以进行非线性计算,极大地增强了单个神经元的信息处理能力,为模型带来了更丰富的计算动态。

多尺度:尝试构建从微观(离子通道)、介观(神经元、突触)到宏观(脑区)的多尺度耦合模型,以期涌现出更复杂的智能行为。

- 异构融合架构

进展:不追求纯粹的"类脑",而是务实性地将ANN的高性能与SNN的高能效相结合。

代表:清华大学的"天机(Tianjic)"芯片架构(虽然主要是硬件,但体现了架构思想):在同一芯片上,同时支持ANN和SNN两种范式。可以让ANN处理擅长的高精度任务,SNN处理其擅长的低功耗感知和时序任务,通过异构融合实现最佳效能。

四、关键挑战与未来趋势

(一)面临的巨大挑战:

-

训练难题:如何高效训练超大规模的SNN或类脑架构?代理梯度法是否还能scale up?全新的类脑学习算法(如基于STDP的)能否支撑起大模型?

-

算法与理论缺失:缺乏为类脑大模型设计的高效注意力机制、记忆机制和推理模块。其理论基础远不如Transformer深厚。

-

硬件生态瓶颈:类脑大模型需要神经形态硬件才能发挥其能效优势,但后者目前仍处于早期,软件工具链、编程模型、生态系统都极不成熟。

-

评估标准不一:如何公平地比较类脑大模型与Transformer大模型的性能?除了准确率,能耗、推理速度、鲁棒性、持续学习能力等都应成为核心指标。

(二)未来趋势:

-

新架构探索:BriLLM只是一个开始,未来会看到更多非Transformer的、受神经科学启发的foundational architecture出现。

-

"更多"生物机制的引入:树突计算、神经调制(如多巴胺、乙酰胆碱等全局信号)、预测编码理论等将被更深入地整合到模型设计中。

-

软硬件协同设计:类脑大模型的架构将与神经形态芯片(如忆阻器交叉阵列、光子计算芯片) 的设计紧密耦合,算法和硬件共同演进。

-

从感知走向认知:当前重点仍在感知层面。未来的类脑大模型将更注重记忆、推理、决策等高级认知功能的实现,可能会融合符号主义的方法。

-

开放与合作:如同当前的大模型社区,开源开放的类脑大模型(如BrainCog平台倡导的)将对整个领域的快速发展起到至关重要的推动作用。

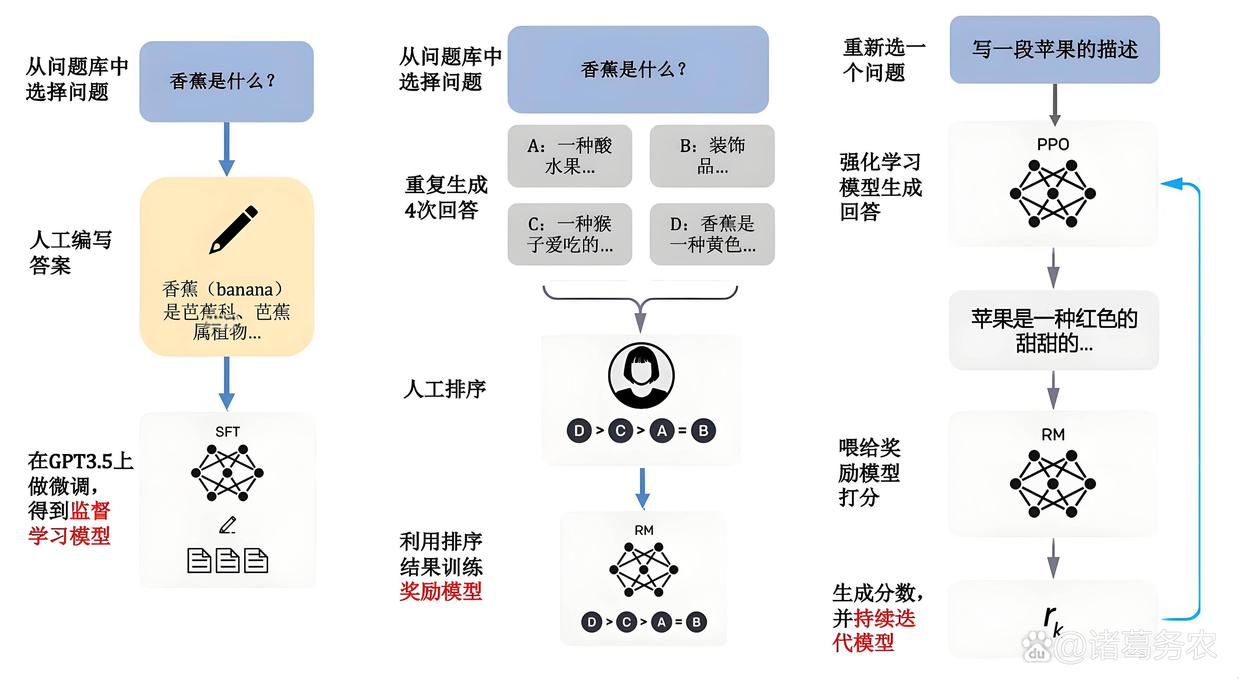

大语言模型训练

五、总结

类脑大模型代表着一条不同于Transformer的、潜力巨大的技术路径。并非要完全复制人脑,而是希望从亿万年进化锤炼出的"终极智能设备"中汲取灵感,以解决当前AI在能耗、推理、自适应等方面的核心痛点。

虽然目前仍处于萌芽期,面临着从理论、算法到硬件的全方位挑战,但像BriLLM这样的架构已经向我们展示了另一种可能。但是一场高风险、高回报的探险,其最终目标是为人工智能带来一场效率革命与能力革命,从而更接近真正意义上的通用人工智能(AGI)。

这条道路需要计算科学家、神经科学家、硬件工程师的深度跨界合作。其发展,或许将决定下一个AI时代的走向。

第二节:脑启发大语言模型

"脑启发大语言模型"(Brain-inspired Large Language Model),是类脑大模型架构中最前沿、也最大胆的分支。其并非简单地用脉冲神经网络(SNN)处理文本,而是从原理层面挑战Transformer的统治地位,试图构建一种全新的、受神经科学启发的大模型基础架构。

一、什么是脑启发大语言模型?核心理念是什么?

- 设计原则

脑启发大语言模型是指其核心设计原则借鉴了生物大脑(尤其是皮层)的结构和信息处理机制的大规模语言模型。其终极目标不是精确复制大脑,而是汲取其高效性、适应性和推理能力的精髓,以解决当前Transformer架构在能耗、逻辑推理、持续学习等方面的根本性瓶颈。

- 核心理念:

摒弃"注意力",转向"全局竞争与协作":大脑没有类似于Self-Attention的全局精确加权机制。取而代之的是,信息通过前馈(Feedforward)和反馈(Feedback)连接,在神经元群体间通过兴奋与抑制(E-I balance)的动态平衡进行传递、竞争和筛选。

稀疏性与事件驱动:大脑的活动是稀疏和事件驱动的。脑启发LLM追求在计算过程中只有部分单元被激活,从而在理论上实现极低的能耗。

连续学习与动态记忆:大脑能够无缝地融合新知识而不遗忘旧知识。脑启发LLM旨在将记忆直接编码于网络连接的动态变化中,支持高效的在线和持续学习,避免"灾难性遗忘"。

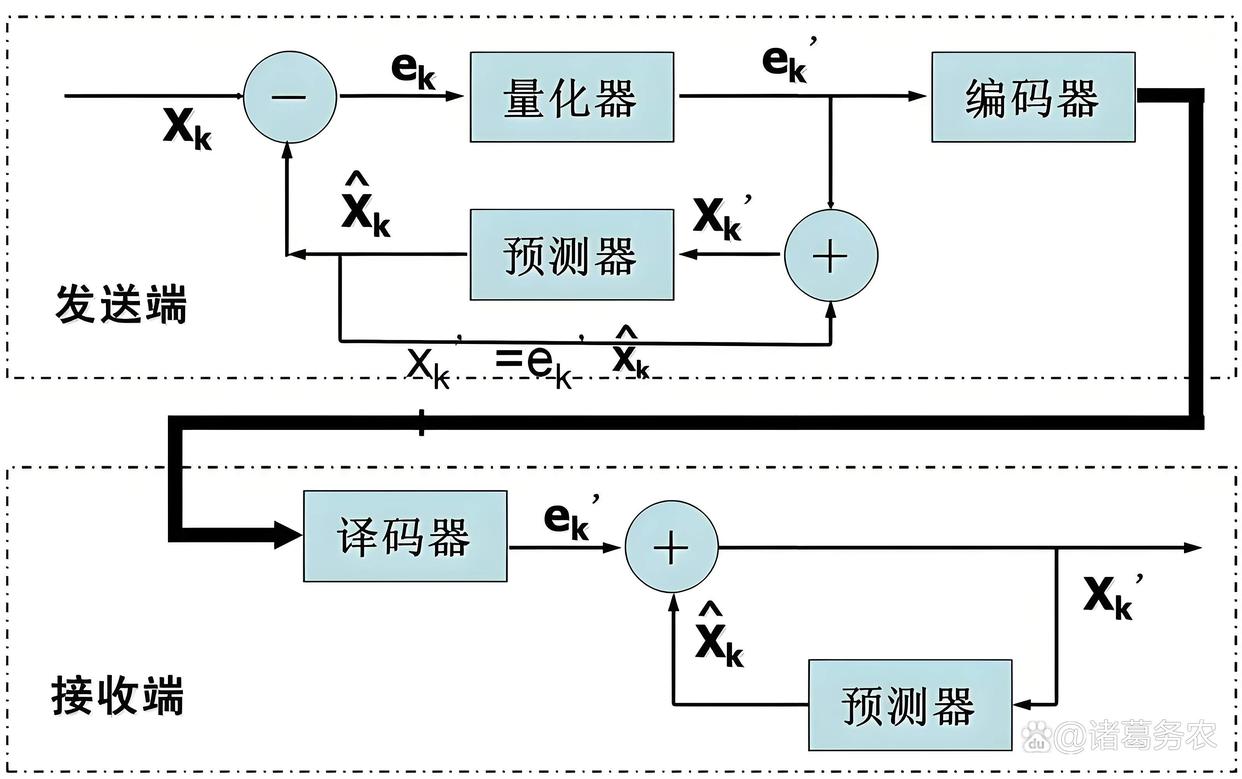

预测编码与生成模型:神经科学中的"预测编码"理论认为,大脑是一个不断生成预测、并用感官输入修正预测误差的器官。脑启发LLM将自身视为一个动态的生成模型,而不仅仅是进行模式匹配的函数逼近器。

二、与传统Transformer架构的根本区别

脑启发大语言模型与Transformer比对

三、前沿进展与代表性架构

该领域仍处于非常早期的探索阶段,但已出现一些开创性的工作:如上海交通大学 - BriLLM 模型,另外还有:

- 预测编码架构 (Predictive Coding Frameworks)

基于神经科学的"预测编码"理论构建模型。

核心思想:模型不断自上而下地生成对输入的预测,并自下而上地计算预测误差。网络的学习目标是最小化预测误差。

模型由多层组成。每一层都尝试预测下一层的活动。将误差向上传递,同时将预测向下传递。通过多次迭代,让整个网络的预测误差最小化,此时的网络状态就是最终输出。被认为可能是大脑皮层处理信息的一种普遍策略。

价值:这类架构天生地支持在线学习、异常检测和概率推理,为构建能真正"理解"世界的模型提供了新路径。

- 基于脉冲神经网络(SNN)的探索

虽然纯SNN做大语言模型极其困难,但已有研究开始尝试。

挑战:文本数据本质上是离散和符号化的,而SNN擅长处理连续时空信号。如何用脉冲序列有效地表示单词和语法结构是一大难题。

进展:一些研究通过将Transformer的某些组件(如FFN)替换为SNN,或者设计基于时间编码的SNN语言模型来进行初步探索。其核心优势依然是潜在的极致能效。

预测编码

四、关键挑战与未来趋势

- 面临的巨大挑战:

可扩展性(Scaling Laws)未知:Transformer的成功很大程度上建立在清晰的"缩放定律"上。脑启发架构的缩放规律完全未知,我们不清楚需要多少"神经元"和"突触"才能达到与千亿参数Transformer相当的能力。

训练难题:如何训练这样一个动态系统?BriLLM等模型可能需要全新的基于能量的训练方法或生物启发的新颖优化算法,这远不如反向传播成熟。

硬件生态缺失:这类模型为神经形态芯片(如忆阻器、Loihi)设计才能发挥其能效优势。但当前的AI生态完全建立在GPU上,缺乏成熟的硬件和软件栈支持。

评估体系缺失:如何公平地评估?除了困惑度(PPL)等传统指标,可能需要引入推理效率、能耗、持续学习能力等新标准。

- 未来趋势:

跨学科深度融合:这条路径的成功极度依赖计算神经科学的进展。我们需要更深入地理解大脑皮层的微电路原理、记忆的形成机制和决策的生物学基础。

混合架构探索:在短期内,更现实的路径可能是构建混合模型,例如用Transformer处理核心语义,用类脑模块处理感官信息、实现记忆检索或负责决策推理。

聚焦优势场景:初期可能不会在通用文本生成上挑战GPT,而是聚焦于特定优势场景,如:

低功耗边缘部署:手机、IoT设备上的私人AI助手。

机器人控制:需要实时、低功耗、持续学习的 embodied AI。

科学发现:需要强大因果和类比推理能力的领域。

开源社区建设:如同Transformer依靠Hugging Face等社区蓬勃发展,脑启发LLM也需要类似的开源项目(如BrainCog)和社区来推动算法、数据和模型的共享。

五、总结

脑启发大语言模型是一场高风险、高回报的"豪赌"。不是在原有Transformer架构上修修补补,而是试图从头开始重新思考"智能"的计算基础。

其价值不仅仅在于可能带来的能效提升,更在于可能打开一扇通向更强大、更鲁棒、更接近人类智能的AI的大门。如果成功,可能解决Transformer在推理、因果和常识方面的根本性弱点。

目前,仍处于"有蓝图,但大厦还未建成"的阶段。上海交大的BriLLM是第一面旗帜,证明了这条道路的可行性(尽管仍需更多验证)。未来的发展将依赖于算法创新、神经科学发现和硬件进步三者的螺旋式上升。

树突计算模型

(未完待续)