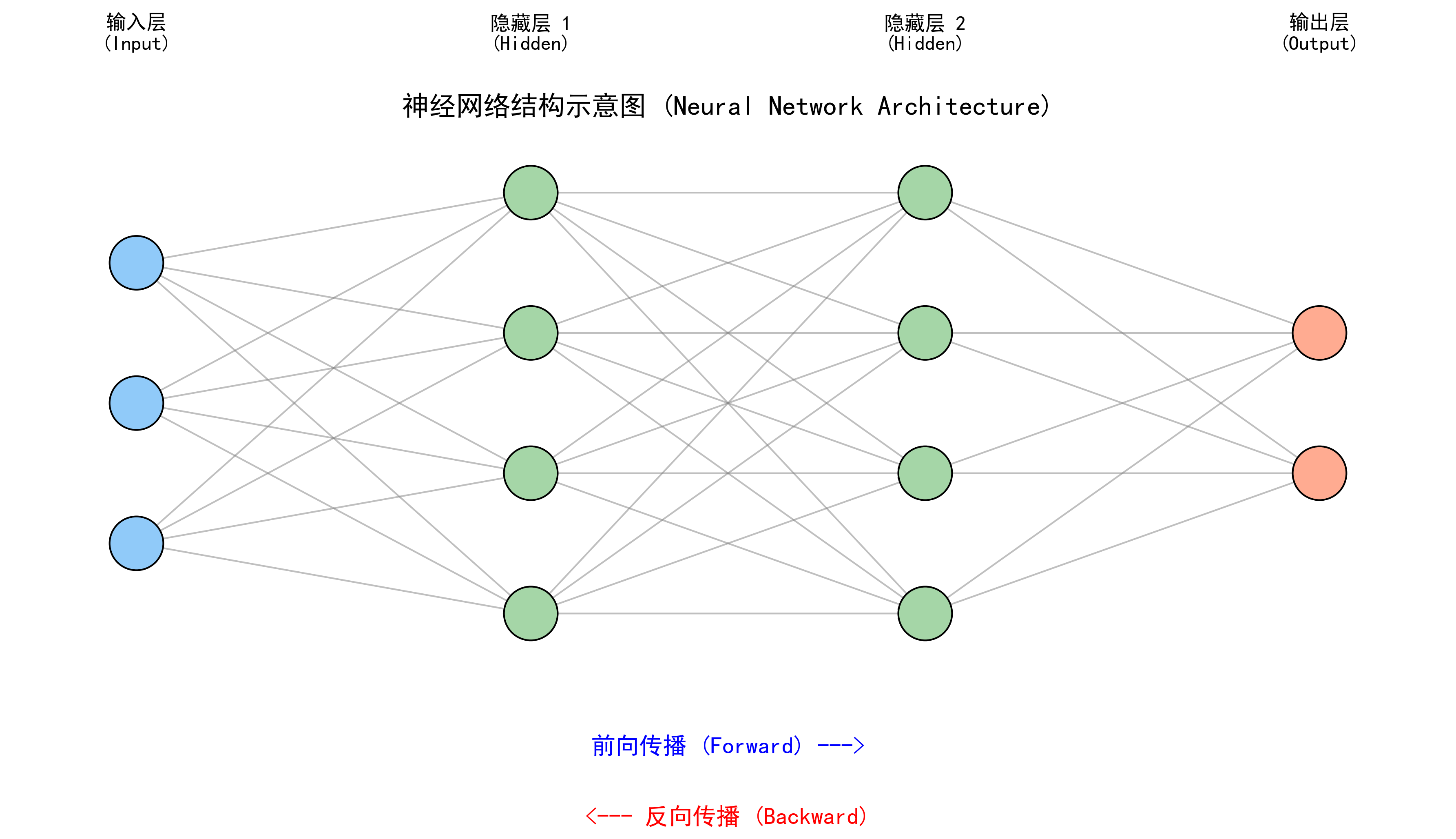

图解说明:

- 🔵 蓝色节点 (输入层):接收外部信息(比如图片的像素)。

- 🟢 绿色节点 (隐藏层):负责思考和提取特征(比如识别线条、形状)。

- 🔴 红色节点 (输出层):给出最终结论(比如"是猫")。

- ➡️ 箭头:代表信息传递的方向。

你好!今天我们要聊的是人工智能领域最核心、最火爆的概念------神经网络 (Neural Networks)。

现在的 AI 这么厉害,能画画、能聊天(比如 ChatGPT)、能开自动驾驶汽车,其实背后主要靠的都是它。

如果你完全不懂算法,没关系。想象一下,你正在教一个小孩子认动物。

1. 它是模仿谁?(灵感来源)

神经网络,顾名思义,就是模仿我们人类大脑里的神经元网络。

- 人脑:由 860 亿个神经元组成。这些神经元之间通过"突触"连接,传递电信号。

- 电脑:我们也造了很多"人造神经元",把它们连成一张大网。

虽然电脑的"神经元"只是数学公式,但它的学习逻辑和人脑非常像。

2. 神经网络长什么样?(三层结构)

一个典型的神经网络,就像一个三明治,分三层:

1. 输入层 (Input Layer) ------ 眼睛

这是网络的"感官"。

比如你要识别一张猫的照片。

- 照片里的每一个像素点(颜色深浅),就是输入给这一层的信息。

2. 隐藏层 (Hidden Layer) ------ 大脑

这是网络的"思考区",夹在中间。

它可以有一层,也可以有几十层(这就叫深度学习)。

- 这一层负责提取特征:有的神经元看"有没有耳朵",有的看"有没有胡须",有的看"是不是毛茸茸"。

3. 输出层 (Output Layer) ------ 嘴巴

这是网络的"结论"。

- 它会吐出几个概率值:猫 (90%),狗 (8%),兔子 (2%)。

- 最后大喊一声:"这是猫!"

3. 它是怎么学习的?(核心机制)

神经网络刚生下来的时候,脑子是一片空白的(参数是随机的)。

它之所以能变聪明,全靠**"猜"和"挨打"**。

第一步:前向传播 (瞎猜)

你给它看一张猫的照片。

信号从输入层传到隐藏层,再传到输出层。

因为它还没学过,它可能会瞎猜:"我觉得是... 飞机!"

第二步:计算损失 (对答案)

你告诉它:"错!这是猫!"

这时候,算法会计算一个**"损失值 (Loss)"**。

- 损失值越大,说明错得越离谱(把猫认成飞机,该打)。

- 损失值越小,说明猜得越准。

第三步:反向传播 (挨打长记性)

这是神经网络最神奇的地方------Backpropagation (反向传播)。

既然猜错了,就要找原因。

- 输出层说:"是上一层那个神经元告诉我这是飞机的!"

- 隐藏层说:"是再上一层那个参数误导了我!"

于是,误差信号从后往前传,把每一个导致错误的参数都修正一点点 (这就叫梯度下降)。

- "下次看到尖耳朵,别猜飞机了,要往猫那边猜!"

第四步:循环往复

经过成千上万次"猜 -> 挨打 -> 改正"的循环,神经网络终于练成了火眼金睛。

4. 举个生动的例子:品尝师 🍷

假设你要训练一个神经网络来评价红酒好不好喝。

- 输入层 :你把红酒的酸度、甜度、酒精度、颜色等数据喂给它。

- 隐藏层 :

- 第一个神经元发现:"酸度高 + 甜度低 = 口感涩"。

- 第二个神经元发现:"颜色深 + 酒精度高 = 味道浓"。

- (这些复杂的组合逻辑,是它自己琢磨出来的)。

- 输出层 :打分 ------ 85 分。

- 反向传播 :

- 真实的大师评分是 95 分。

- 网络发现自己打低了,于是回去调整参数:"下次遇到这种深颜色的,分数要给高一点!"

5. 神经网络的优缺点

✅ 优点 (为什么它是神?)

- 能力上限极高:只要数据够多、网络够深,它几乎能学会任何复杂的规律(万能逼近定理)。

- 自动提取特征:不用像传统算法那样人工告诉它"猫有胡须",它自己能从像素里学会看胡须。

- 通用性强:图像、声音、文本、视频,它通吃。

❌ 缺点 (也要注意)

- 黑盒:它虽然很准,但你问它"为什么觉得这是猫?",它很难解释清楚(只是一堆数字的计算)。

- 数据饥渴:需要海量的数据来喂养,数据少了学不会。

- 算力杀手:训练一个大模型需要昂贵的显卡 (GPU) 和大量的电费。

6. 总结

神经网络 就是一个勤能补拙的学生:

- 结构:输入 -> 思考(隐藏) -> 输出。

- 学习方法:先瞎猜,然后根据正确答案反向修正自己的认知。

- 关键:只要练得足够多,它就能从量变引起质变,涌现出惊人的智能!🧠