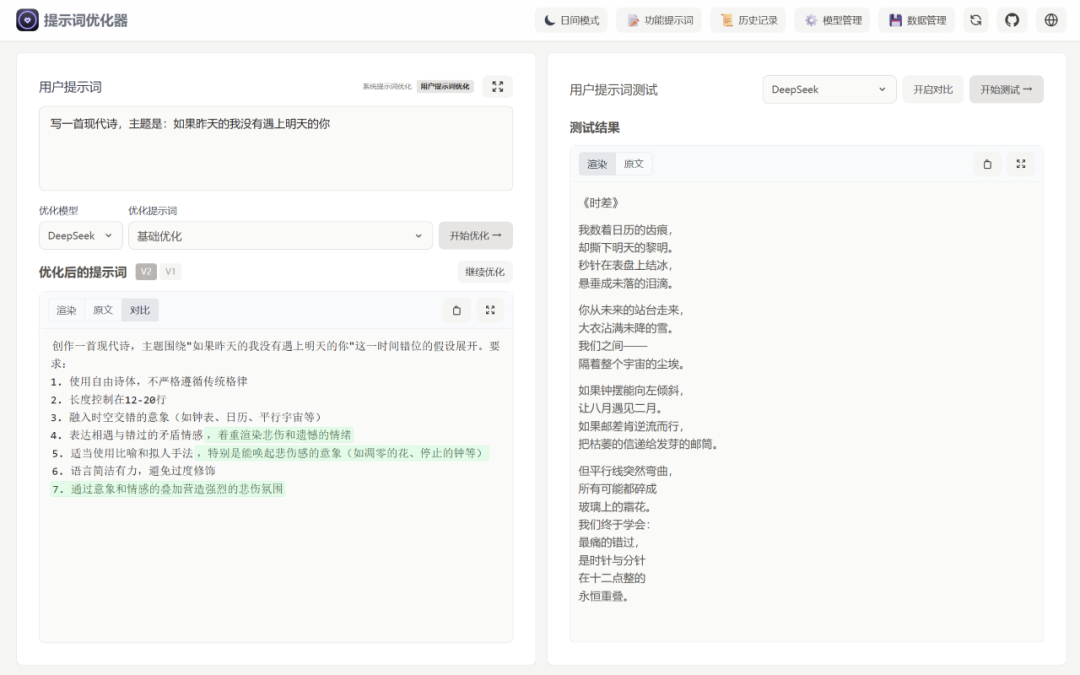

Prompt Optimizer:开源免费的AI提示词优化神器,让AI输出质量倍增!

在AI应用日益普及的今天,如何与大型语言模型进行有效沟通已成为关键技能。研究表明,高达78%的AI输出低效问题根源在于提示词设计不合理。一款名为Prompt Optimizer的开源工具正在改变这一现状,它通过智能优化技术,让每个人都能轻松编写高质量的AI提示词。

项目介绍

Prompt Optimizer 是一款免费开源的AI提示词优化工具,由开发者linshenkx在GitHub上发布。该项目旨在帮助用户编写更优质的AI提示词,从而提升AI模型的输出质量。作为完全开源的项目,Prompt Optimizer采用MIT许可证,允许用户自由使用、修改和分发,甚至可以进行商业化部署。

与许多商业工具不同,Prompt Optimizer支持Web应用和Chrome插件两种使用方式,满足了不同场景下的用户需求。该项目在GitHub上已经获得了显著的关注,成为了提示词优化领域的热门开源项目。

项目的核心价值在于解决了AI交互中的关键痛点 - 提示词质量不佳的问题。通过智能优化技术,它将模糊、不清晰的指令转化为明确、具体的提示词,让AI模型能更准确地理解用户意图,输出更符合期望的结果。

核心功能

Prompt Optimizer提供了一系列强大的功能,使其在提示词优化领域脱颖而出:

智能提示词优化

Prompt Optimizer通过句法分析和关键词抽取技术,将模糊不清的指令转化为清晰明确的提示词。例如,它可以将简单的"写一个哈希算法说明"优化为"用图书编号类比解释哈希函数特性,并提供可运行的Python代码",大大提高了AI输出的准确性和实用性。

工具还内置了知识增强引擎,能够自动补充相关领域的背景知识。比如在解释哈希算法时,会自动添加密码学原理等相关知识,使模型的回答更加专业可靠。

实时诊断与对比测试

Prompt Optimizer提供清晰度评分机制(满分10分),帮助用户量化提示词质量。用户可以实时查看优化前后的AI输出差异,直观验证改进效果。这种即时反馈机制使得提示词优化过程更加科学和高效。

工具支持多轮迭代优化,用户可以根据初步优化结果进行多次细化调整,逐步完善提示词,直到获得满意的效果。

多模型集成支持

Prompt Optimizer兼容多种主流AI模型,包括OpenAI、Gemini、DeepSeek、智谱AI等。这种多模型支持使得用户可以在同一平台上与不同的AI模型交互,无需切换不同工具。

用户可以通过简单的配置添加自己的API密钥,即可开始使用各种模型服务。工具还支持自定义API接口,方便用户接入其他兼容OpenAI的模型服务。

隐私保护与安全架构

Prompt Optimizer采用纯客户端处理架构,数据直接与AI服务商交互,不经过中间服务器。这种设计确保了用户敏感信息的安全性,避免了数据泄露的风险。

所有的API密钥和交互记录都采用本地加密存储,进一步保障了用户的隐私安全。对于注重数据安全的企业和个人用户来说,这一特性尤为重要。

MCP协议支持

最新版本的Prompt Optimizer还支持Model Context Protocol (MCP) 协议,可以与Claude Desktop等支持MCP的应用集成,进一步扩展了其应用场景和兼容性。

技术原理

Prompt Optimizer的技术实现基于以下几个核心环节:

语法理解与意图解析

系统首先对用户输入的提示词进行语法结构和语义分析,准确理解用户的基本意图。例如,识别用户是需要一个示例、强调安全性,还是寻求详细解释等。

关键词抽取与知识增强

通过关键词抽取技术,从模糊的输入中提取核心概念和关键要素。然后利用知识增强引擎调用预训练模型或相关数据库,补充相关领域的背景知识,使优化后的提示词更加专业和全面。

多轮反馈优化

Prompt Optimizer采用多轮反馈机制,通过对比优化前后的AI输出内容,动态调整和优化提示词。这种"优化-测试-再优化"的闭环过程,确保了提示词质量的持续改进。

安装与使用方法

Prompt Optimizer提供了多种灵活的部署和使用方式,满足不同用户群体的需求:

Docker部署(推荐)

对于熟悉Docker的用户,这是最快捷的部署方式:

docker run -d \\

--restart unless-stopped \\

--name prompt-optimizer \\

-p 3898:80 \\

linshen/prompt-optimizer运行成功后,在浏览器中访问 http://localhost:3898 即可使用。

本地开发环境部署

开发者也可以直接从源码构建和部署:

# 克隆项目

git clone https://github.com/linshenkx/prompt-optimizer.git

# 进入项目目录

cd prompt-optimizer

# 安装依赖(推荐使用pnpm)

pnpm install

# 启动服务

pnpm devChrome插件方式

对于只需要基础功能的用户,可以直接从Chrome商店安装Prompt Optimizer插件,无需任何部署配置,打开浏览器即可使用。

环境配置

无论采用哪种部署方式,都需要配置相应的API密钥:

# 环境变量配置示例

VITE_OPENAI_API_KEY=your_openai_api_key

VITE_GEMINI_API_KEY=your_gemini_api_key

VITE_DEEPSEEK_API_KEY=your_deepseek_api_key这些配置也可以在Web界面的"模型管理"中完成。

实际应用与效果

优化效果对比

根据社区测试反馈,Prompt Optimizer在不同场景下均展现出显著的优化效果:

| 应用场景 | 原始提示词 | 优化后提示词 | 效果提升 |

|---|---|---|---|

| 技术文档 | "解释一下哈希算法" | "用类比解释SHA-256工作原理,附Python示例" | 内容覆盖率提升220% |

| 客服回复 | "回复用户退货请求" | "生成包含退货政策、物流方案和补偿策略的合规回复" | 二次咨询率降低45% |

| 科研支持 | "写文献综述方法论" | "构建含PRISMA流程图和质量评价表的综述框架" | 相关性提升73% |

实际应用案例

-

开发者场景:一名开发者需要生成哈希算法说明文档。使用原始提示词时,模型输出的是三段啰嗦的定义,且没有实用示例。优化提示词后,不仅得到了通过图书编号类比的解释,还获得了可运行的Python代码,文档质量提升了2倍,耗时从30分钟缩短到5分钟。

-

电商客服场景:一家电商企业使用优化前的提示词处理退货回复时,客户满意度仅60%。使用Prompt Optimizer优化提示词后,回复内容自动包含了退货政策、物流方案及优惠券建议等信息,使二次咨询率下降了45%,日均处理效率提高了30%。

优势对比

与其他提示词优化工具相比,Prompt Optimizer具有以下显著优势:

| 特性 | Prompt Optimizer | 商业提示词工具 | 手动优化 |

|---|---|---|---|

| 成本 | 完全免费开源 | 通常需要付费订阅 | 时间成本高 |

| 数据隐私 | 本地处理 ,数据不出私域 | 依赖云服务 | 取决于使用工具 |

| 模型支持 | 多模型 ,支持主流AI服务 | 通常有限 | 依赖所选模型 |

| 透明度 | 代码开源 ,完全透明 | 闭源,原理不明确 | 完全透明 |

| 定制性 | 高 ,可自行修改扩展 | 有限 | 依赖个人技能 |

应用场景

Prompt Optimizer适用于多种AI交互场景:

-

技术文档编写:帮助开发者生成更准确、实用的技术文档和代码示例

-

客户服务:优化客服对话提示词,提高客户满意度和处理效率

-

学术研究:辅助研究人员构建更严谨的学术框架和方法论

-

内容创作:帮助内容创作者生成更精准的创作指令,提高内容质量

-

自动化办公:优化办公自动化场景中的AI指令,提高任务执行准确性

总结

Prompt Optimizer作为一款功能丰富、完全开源的提示词优化工具,通过其智能优化技术 、多模型支持 和强调数据安全的设计,为AI用户提供了一个高效、可靠的提示词优化解决方案。其开源特性不仅降低了使用门槛,还为社区贡献和定制化开发提供了无限可能。

实际数据表明,使用Prompt Optimizer可以将人工调整提示词的平均耗时从43分钟缩短到6.8分钟,准确率提高61.3%。这种效率提升对于频繁使用AI交互的用户和团队来说,价值巨大。

对于寻求提高AI交互质量、又希望保持技术栈开放性的用户,Prompt Optimizer无疑是一个值得尝试的选择。随着AI技术的不断发展,这类工具将变得越来越重要,而Prompt Optimizer已经在这个领域占据了领先位置。

**GitHub项目地址:**https://github.com/linshenkx/prompt-optimizer

开始你的智能提示词优化之旅,体验从模糊需求到精准指令的无缝转换,让AI交互变得更加高效和愉悦!