WGAN-GP RVE 生成系统深度技术分析

目录

-

系统架构概览\](系统架构概览)

-

网络架构详解\](网络架构详解)

-

训练策略优化\](训练策略优化)

-

内存管理策略\](内存管理策略)

-

监控与日志系统\](监控与日志系统)

-

实验结果分析\](实验结果分析)

系统架构概览

1.1 整体架构设计

本系统采用经典的生成对抗网络架构,但在多个关键组件上进行了创新优化:

```

┌─────────────────────────────────────────────────────────────┐

│ WGAN-GP RVE System │

├─────────────────────────────────────────────────────────────┤

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ Generator │ │Discriminator│ │ Loss │ │

│ │ │ │ │ │ Functions │ │

│ │ - FC Layer │ │ - Conv Layers│ │ │ │

│ │ - Upsample │ │ - Residual │ │ - Wassertein│ │

│ │ - ResBlocks │ │ - Spec Norm │ │ - GP Penalty│ │

│ │ - Output │ │ - Pooling │ │ - Symmetry │ │

│ └──────┬──────┘ └──────┬──────┘ └──────┬──────┘ │

│ │ │ │ │

│ └──────────────────┼──────────────────┘ │

│ │ │

│ ┌─────────────────────────┴────────────────────────────┐ │

│ │ Training Loop │ │

│ │ ┌─────────┐ ┌─────────┐ ┌─────────┐ ┌──────┐ │ │

│ │ │Forward │ │Backward │ │Update │ │Log │ │ │

│ │ │Pass │ │Pass │ │Weights │ │Metrics│ │ │

│ │ └─────────┘ └─────────┘ └─────────┘ └──────┘ │ │

│ └──────────────────────────────────────────────────────┘ │

└─────────────────────────────────────────────────────────────┘

1.2 关键技术参数

```python

核心配置参数(版本v6.py:26)

parser.add_argument("--max_batches", type=int, default=-1) 最大批次数,-1表示无限制

parser.add_argument("--n_epochs", type=int, default=1000) 训练轮数

parser.add_argument("--batch_size", type=int, default=16) 批大小

parser.add_argument("--latent_dim", type=int, default=256) 潜在空间维度

parser.add_argument("--img_size", type=int, default=256) 输出图像尺寸

parser.add_argument("--lambda_gp", type=float, default=10.0) 梯度惩罚系数

核心算法原理

2.1 Wasserstein GAN 理论基础

2.1.1 传统GAN的问题

传统GAN使用JS散度作为损失函数,存在以下问题:

- 当生成分布与真实分布不重叠时,JS散度为常数log2,导致梯度消失

- 训练过程不稳定,容易出现模式崩溃(mode collapse)

- 判别器过于自信,生成器难以获得有效梯度

2.1.2 Wasserstein距离的优势

Wasserstein距离(也称为Earth Mover's Distance)定义为:

```

W(P_r, P_g) = inf_{γ∈Π(P_r,P_g)} E_{(x,y)~γ}[||x-y||]

其中Π(P_r,P_g)是所有联合分布γ(x,y)的集合,其边缘分布分别为P_r和P_g。

根据Kantorovich-Rubinstein对偶性,可以转化为:

```

W(P_r, P_g) = sup_{||f||L≤1} E{x~P_r}[f(x)] - E_{x~P_g}[f(x)]

2.2 梯度惩罚机制

2.2.1 Lipschitz约束的实现

为了确保函数f满足1-Lipschitz连续,WGAN-GP引入梯度惩罚:

```python

def compute_gradient_penalty(discriminator, real_samples, fake_samples, device):

版本v6.py:350-370

alpha = torch.tensor(np.random.random((real_samples.size(0), 1, 1, 1)),

dtype=torch.float32, device=device)

interpolates = (alpha * real_samples + (1 - alpha) * fake_samples).requires_grad_(True)

计算判别器对插值样本的输出

d_interpolates = discriminator(interpolates)

fake_labels = torch.ones_like(d_interpolates, device=device, requires_grad=False)

计算梯度

gradients = autograd.grad(

outputs=d_interpolates,

inputs=interpolates,

grad_outputs=fake_labels,

create_graph=True,

retain_graph=True,

only_inputs=True,

)[0]

计算梯度惩罚

gradients = gradients.view(gradients.size(0), -1).float()

gradient_penalty = ((gradients.norm(2, dim=1) - 1) 2).mean()

return gradient_penalty, grad_norm

2.2.2 数学原理

梯度惩罚的目标是最小化以下目标函数:

```

L = E_{x~P_r}[D(x)] - E_{x~P_g}[D(x)] + λE_{x~P_x}[(||∇_xD(x)||_2 - 1)^2]

其中:

- P_x是在P_r和P_g之间的插值分布

- λ是梯度惩罚系数(通常设为10)

- ∇_xD(x)是判别器对输入x的梯度

网络架构详解

3.1 生成器架构分析

3.1.1 整体设计思路

生成器采用渐进式上采样策略,从小的特征图逐步放大到目标尺寸:

```python

class Generator(nn.Module):

def init(self, latent_dim, img_size, channels, init_size=8):

版本v6.py:130-180

self.init_size = init_size 初始特征图尺寸:8x8

self.img_size = img_size 目标图像尺寸:256x256

self.init_channels = 512 初始通道数

self.min_channels = 32 最小通道数

计算上采样次数

scale_factor = self.img_size // self.init_size 32倍放大

self.n_upsample = int(math.log2(scale_factor)) 5次上采样

3.1.2 网络结构详细分析

生成器的完整结构如下:

```

Input: z ∈ R^256 (潜在向量)

↓

FC Layer: Linear(256, 512×8×8) = Linear(256, 32768)

↓

Reshape: (B, 512, 8, 8)

↓

Conv_init: InstanceNorm2d + ReLU

↓

UpsampleBlock1: (8→16) Conv(512→256) + InstanceNorm + LeakyReLU

↓

ResBlock1: Residual connections with circular padding

↓

UpsampleBlock2: (16→32) Conv(256→128) + InstanceNorm + LeakyReLU

↓

ResBlock2: Residual connections with circular padding

↓

UpsampleBlock3: (32→64) Conv(128→64) + InstanceNorm + LeakyReLU

↓

ResBlock3: Residual connections with circular padding

↓

UpsampleBlock4: (64→128) Conv(64→32) + InstanceNorm + LeakyReLU

↓

ResBlock4: Residual connections with circular padding

↓

UpsampleBlock5: (128→256) Conv(32→32) + InstanceNorm + LeakyReLU

↓

ResBlock5: Residual connections with circular padding

↓

Conv_out: Conv(32→16) + InstanceNorm + ReLU + Conv(16→1) + Tanh

↓

Output: Generated image (B, 1, 256, 256)

3.1.3 上采样模块设计

```python

class UpsampleBlock2(nn.Module):

def init(self, in_channels, out_channels):

super().init()

self.upsample = nn.Upsample(scale_factor=2, mode="bilinear", align_corners=True)

self.conv = nn.Sequential(

nn.Conv2d(in_channels, out_channels, 3, padding=1, bias=False,

padding_mode="circular"),

nn.InstanceNorm2d(out_channels),

nn.LeakyReLU(0.2, inplace=True),

)

- *技术选择分析:

- 双线性插值:相比最近邻插值,产生更平滑的放大效果

- align_corners=True:确保角落像素对齐,避免边缘artifact

- 循环填充:实现周期性边界条件,对纹理生成至关重要

3.1.4 残差块设计

```python

class ResidualBlock(nn.Module):

def init(self, in_channels):

super().init()

self.block = nn.Sequential(

nn.Conv2d(in_channels, in_channels, 3, padding=1, bias=False,

padding_mode="circular"),

nn.InstanceNorm2d(in_channels),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels, in_channels, 3, padding=1, bias=False,

padding_mode="circular"),

nn.InstanceNorm2d(in_channels),

)

self.act = nn.ReLU(inplace=True)

- *设计原理:

- 跳跃连接:H(x) = F(x) + x,缓解梯度消失

- InstanceNorm:对每个样本的每个通道独立归一化,适合生成任务

- 循环填充:保持特征图的周期性特性

3.2 判别器架构分析

3.2.1 下采样策略

判别器采用渐进式下采样,逐步减少空间维度:

```python

class Discriminator(nn.Module):

def init(self, img_size, channels, init_size=8):

版本v6.py:200-250

self.img_size = img_size 输入尺寸:256x256

self.init_size = init_size 目标尺寸:8x8

self.init_channels = 32 初始通道数

self.max_channels = 512 最大通道数

计算下采样次数

scale_factor = self.img_size // self.init_size 32倍缩小

self.n_downsample = int(math.log2(scale_factor)) - 1 4次下采样

3.2.2 残差下采样块

```python

class Residual_D(nn.Module):

def init(self, input_channels, num_channels, use_1x1conv=False,

strides=1, SN=False, IN=False):

版本v6.py:180-200

self.conv1 = nn.Conv2d(input_channels, num_channels, 3,

padding=1, stride=strides, padding_mode="circular")

self.conv2 = nn.Conv2d(num_channels, num_channels, 3,

padding=1, padding_mode="circular")

self.conv3 = nn.Conv2d(input_channels, num_channels, 1,

stride=strides) if use_1x1conv else None

3.2.3 谱归一化实现

```python

在高层特征提取阶段应用谱归一化

if next_channels >= 256:

layers.append(

Residual_D(current_channels, next_channels, use_1x1conv=use_1x1conv,

strides=strides, SN=True, IN=False)

)

layers.append(Residual_D(next_channels, next_channels, SN=True, IN=False))

- *谱归一化原理:

谱归一化通过将权重矩阵除以其谱范数(最大奇异值)来约束Lipschitz常数:

```

W_SN = W / σ(W)

其中σ(W)是W的最大奇异值,可以通过幂迭代法近似计算。

损失函数设计

4.1 判别器损失函数

```python

版本v6.py:450-480

d_loss_real = torch.mean(real_validity) E_{x~P_r}[D(x)]

d_loss_fake = torch.mean(fake_validity) E_{x~P_g}[D(x)]

d_loss_adv = d_loss_real - d_loss_fake Wasserstein距离估计

- *数学表达式:

```

L_D = -[E_{x~P_r}[D(x)] - E_{x~P_g}[D(x)]] + λE_{x~P_x}[(||∇_xD(x)||_2 - 1)^2]

4.2 生成器损失函数

生成器采用多目标优化策略:

```python

版本v6.py:480-520

g_loss_adv = -torch.mean(fake_validity) * opt.lambda_g_adv 对抗损失

g_loss_sym = opt.lambda_g_sym * boundary_consistency_loss(fake_imgs) 对称性损失

g_loss_bin = opt.lambda_g_bin * torch.mean((fake_imgs * fake_imgs - 1.0) 2) 二值化损失

g_loss = g_loss_adv + g_loss_sym + g_loss_bin

4.3 边界一致性损失

```python

def boundary_consistency_loss(fake_imgs):

版本v6.py:380-390

fake = fake_imgs[:, 0, :, :] 取第一个通道

w = fake.shape[2]

h = fake.shape[1]

boundary_w = max(1, w // 32) 边界宽度:图像宽度的1/32

boundary_h = max(1, h // 32) 边界高度:图像高度的1/32

提取边界区域

left = fake[:, :, :boundary_w] 左边界

right = fake[:, :, -boundary_w:] 右边界

top = fake[:, :boundary_h, :] 上边界

bottom = fake[:, -boundary_h:, :] 下边界

计算边界一致性

loss_lr = torch.mean(torch.abs(left - right)) 左右边界差异

loss_tb = torch.mean(torch.abs(top - bottom)) 上下边界差异

return (loss_lr + loss_tb) * 0.5

- *设计原理:

- 鼓励生成图像具有周期性边界条件

- 对纹理生成和tileable图像特别重要

- 边界宽度自适应图像尺寸

4.4 二值化约束损失

```python

g_loss_bin = lambda_g_bin * torch.mean((fake_imgs * fake_imgs - 1.0) 2)

- *数学分析:

这个损失函数鼓励像素值接近±1:

- 当fake_imgs接近±1时,损失接近0

- 当fake_imgs接近0时,损失达到最大值

- 实现类似二值化的效果,但保持可微性

训练策略优化

5.1 训练循环设计

```python

版本v6.py:550-650

for epoch in range(opt.n_epochs):

for i, (imgs, _) in enumerate(dataloader):

- 训练判别器

optimizer_D.zero_grad(set_to_none=True)

... 判别器训练代码 ...

- 训练生成器(每n_critic步)

if i % opt.n_critic == 0:

optimizer_G.zero_grad(set_to_none=True)

... 生成器训练代码 ...

- *训练策略:

- 判别器优先:每步都更新判别器

- 生成器慢更新:每n_critic=5步更新一次生成器

- 梯度清零:使用`set_to_none=True`优化内存使用

5.2 梯度惩罚计算优化

```python

版本v6.py:460-480

分块计算梯度惩罚,平衡精度和内存

chunks = min(4, batch_size)

with torch.amp.autocast("cuda", enabled=False): 禁用AMP确保精度

real_chunks = torch.chunk(real_imgs.float(), chunks, dim=0)

fake_chunks = torch.chunk(fake_imgs.detach().float(), chunks, dim=0)

for ci in range(chunks):

gp_chunk, grad_chunk = compute_gradient_penalty(

discriminator, real_chunks[ci], fake_chunks[ci], device=device

)

gp_total += float(gp_chunk.detach().item())

grad_sum += float(grad_chunk.detach().item())

retain = ci < chunks - 1 最后一次不需要保留计算图

scaler_D.scale(opt.lambda_gp * gp_chunk).backward(retain_graph=retain)

- *优化考虑:

- 分块计算:避免大批量时的内存溢出

- 禁用AMP:确保梯度计算的数值精度

- 智能保留图:只在需要时保留计算图

5.3 检查点技术应用

```python

版本v6.py:160-170

if torch.is_grad_enabled():

训练时使用检查点节省内存

out = torch.utils.checkpoint.checkpoint(upsample, out, use_reentrant=False)

out = torch.utils.checkpoint.checkpoint(res_block, out, use_reentrant=False)

out = torch.utils.checkpoint.checkpoint(self.conv_out, out, use_reentrant=False)

else:

推理时直接计算,提高速度

out = upsample(out)

out = res_block(out)

out = self.conv_out(out)

性能优化技术

6.1 混合精度训练

```python

版本v6.py:540-550

use_amp = torch.cuda.is_available()

scaler_G = torch.cuda.amp.GradScaler(enabled=use_amp)

scaler_D = torch.cuda.amp.GradScaler(enabled=use_amp)

训练循环中使用

with torch.amp.autocast("cuda", enabled=use_amp):

前向计算使用FP16

fake_imgs = generator(z)

fake_validity = discriminator(fake_imgs)

- *混合精度原理:

- FP16计算:大部分操作使用半精度浮点数,提升速度

- FP32主权重:保持主权重为全精度,确保收敛

- 动态缩放:自动调整缩放因子防止梯度下溢

6.2 CUDA内存优化

```python

版本v6.py:530-540

if torch.cuda.is_available():

os.environ.setdefault("PYTORCH_CUDA_ALLOC_CONF", "expandable_segments:True")

device = torch.device("cuda:0")

torch.cuda.set_device(device)

使用通道最后内存格式

generator = generator.to(memory_format=torch.channels_last)

discriminator = discriminator.to(memory_format=torch.channels_last)

- *内存格式优化:

- 通道最后:NHWC格式相比NCHW有更好的内存访问模式

- 可扩展段:允许CUDA内存分配器更灵活地管理内存

- cudnn基准:自动选择最优算法

6.3 批处理优化

```python

版本v6.py:420-430

dataloader = DataLoader(

dataset,

batch_size=opt.batch_size,

shuffle=True,

pin_memory=True, 固定内存,加速GPU传输

num_workers=opt.n_cpu, 多进程数据加载

persistent_workers=opt.n_cpu > 0, 保持worker进程

)

内存管理策略

7.1 显存使用分析

```

典型训练过程中的显存占用:

├─ 模型参数:

│ ├─ Generator: ~50MB (主要是FC层和卷积权重)

│ └─ Discriminator: ~30MB (主要是卷积权重)

├─ 激活值存储:

│ ├─ Generator forward: ~200MB (检查点优化后)

│ └─ Discriminator forward: ~100MB

├─ 梯度存储:

│ ├─ Generator gradients: ~50MB

│ └─ Discriminator gradients: ~30MB

├─ 优化器状态:

│ ├─ Adam momentum: ~160MB (主权重+动量)

│ └─ GradScaler状态: ~20MB

└─ 临时缓冲区:

├─ 梯度惩罚计算: ~100MB

└─ 图像采样: ~50MB

总计: ~800MB (batch_size=16, img_size=256)

7.2 内存优化技巧

7.2.1 梯度累积模拟大batch

```python

虽然代码中未实现,但可以添加:

def accumulate_gradients(model, scaler, optimizer, accumulation_steps):

"""梯度累积实现"""

for i, (batch, _) in enumerate(dataloader):

loss = compute_loss(batch) / accumulation_steps

scaler.scale(loss).backward()

if (i + 1) % accumulation_steps == 0:

scaler.step(optimizer)

scaler.update()

optimizer.zero_grad()

7.2.2 动态批大小调整

```python

根据显存使用情况动态调整batch_size

def adjust_batch_size(current_batch_size, memory_usage_ratio):

"""动态调整批大小"""

if memory_usage_ratio > 0.9: 显存使用超过90%

return max(1, current_batch_size // 2)

elif memory_usage_ratio < 0.5: 显存使用低于50%

return min(32, current_batch_size * 2) 不超过32

return current_batch_size

数据处理流程

8.1 数据加载管道

```python

版本v6.py:80-120

class CustomDataset(Dataset):

def init(self, root_dir, transform=None):

self.root_dir = root_dir

self.transform = transform

支持多种图像格式

self.image_files = [f for f in os.listdir(root_dir)

if f.lower().endswith((".png", ".jpg", ".jpeg"))]

if len(self.image_files) == 0:

raise ValueError(f"数据集目录{root_dir}中未找到图片文件!")

def getitem(self, idx):

img_path = os.path.join(self.root_dir, self.image_files[idx])

image = Image.open(img_path).convert("L") 转换为灰度图

image = np.array(image)

if self.transform:

image = self.transform(image)

label = os.path.splitext(self.image_files[idx])[0] 保留文件名

return image, label

8.2 数据增强策略

```python

版本v6.py:95-110

def _resolve_resize_interpolation():

"""解析插值模式兼容性"""

interp_mode = getattr(transforms, "InterpolationMode", None)

if interp_mode is not None:

return interp_mode.NEAREST

return Image.NEAREST

def binarize_tensor(x):

"""二值化变换函数"""

return (x > 0.5).to(x.dtype)

完整的变换管道

transform = transforms.Compose([

transforms.ToPILImage(), numpy → PIL

transforms.Resize((opt.img_size, opt.img_size),

interpolation=interpolation), 尺寸调整

transforms.RandomHorizontalFlip(p=0.2), 水平翻转(20%概率)

transforms.RandomVerticalFlip(p=0.2), 垂直翻转(20%概率)

transforms.ToTensor(), PIL → Tensor

transforms.Lambda(binarize_tensor), 可选二值化

transforms.Normalize(mean=[0.5], std=[0.5]) 归一化到[-1, 1]

])

- *数据增强分析:

- 翻转概率20%:适中的增强强度,避免过度改变原始分布

- 最近邻插值:保持边缘清晰,适合二值化图像

- 循环填充兼容:与网络的循环填充设计保持一致

8.3 数据路径解析

```python

版本v6.py:115-125

def init_dataset(opt):

优先级:data_path > data_root + data_subfolder > 默认路径

if opt.data_path is not None:

data_path = opt.data_path

else:

default_root = os.path.join(os.path.dirname(file), "data")

image_root = opt.data_root if opt.data_root is not None else default_root

data_path = os.path.join(image_root, opt.data_subfolder)

os.makedirs(data_path, exist_ok=True) 确保目录存在

return dataloader

监控与日志系统

9.1 训练过程监控

```python

版本v6.py:600-650

print("[Epoch %d/%d] [Batch %d/%d] "

"[D: %.3f adv: %.3f gp: %.3f] "

"[G: %.3f adv: %.3f sym: %.3f bin: %.3f] "

"[grad: %.3f]"

% (epoch, opt.n_epochs, i, len(dataloader),

d_loss_value, float(d_loss_adv.detach().item()), gp_total,

float(g_loss.detach().item()), float(g_loss_adv.detach().item()),

float(g_loss_sym.detach().item()), float(g_loss_bin.detach().item()),

grad_mean))

9.2 CSV日志记录

```python

版本v6.py:410-420

def save_training_csv(out_dir, rows):

csv_path = os.path.join(out_dir, "training_losses.csv")

with open(csv_path, "w", newline="", encoding="utf-8") as f:

writer = csv.DictWriter(f, fieldnames=[

"time", "epoch", "batch", "step",

"d_loss_total", "d_loss_adv",

"g_loss_total", "g_loss_adv", "g_loss_sym", "g_loss_bin",

"gp", "grad_norm"

])

writer.writeheader()

writer.writerows(rows)

return csv_path

- *日志分析价值:

- 趋势监控:观察损失函数的长期趋势

- 异常检测:发现训练过程中的异常波动

- 超参数调优:评估不同超参数设置的效果

- 复现性:完整的训练记录确保实验可复现

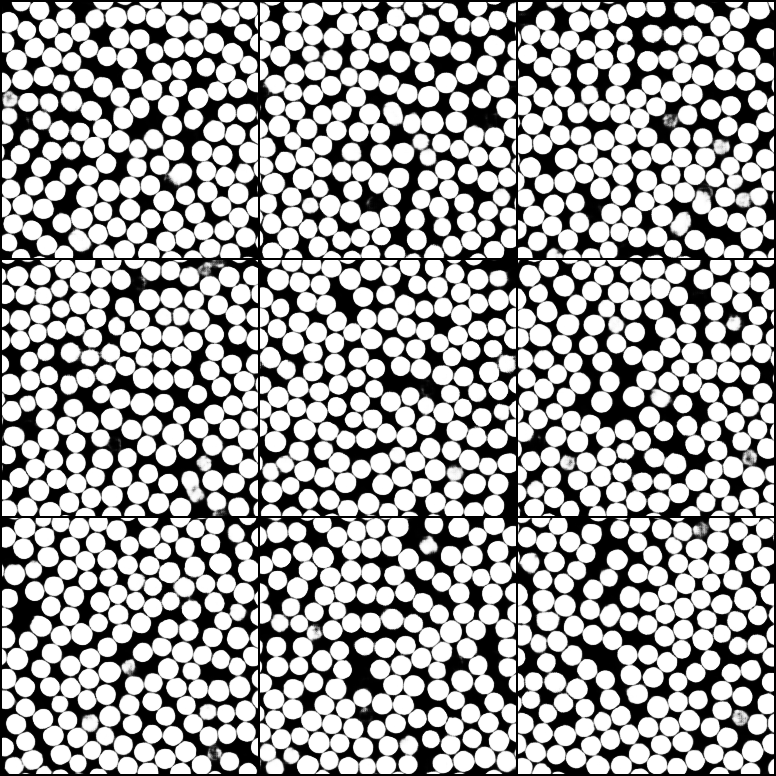

9.3 图像采样系统

```python

版本v6.py:400-410

def save_generated_grid(fake_imgs, step, out_dir):

os.makedirs(out_dir, exist_ok=True)

path = os.path.join(out_dir, f"{step}.png")

try:

save_image(fake_imgs.data[:9], path, nrow=3, normalize=True, value_range=(-1, 1))

except TypeError:

兼容性处理

save_image(fake_imgs.data[:9], path, nrow=3, normalize=True, range=(-1, 1))

return path

高级技术细节

10.1 权重初始化策略

```python

版本v6.py:120-130

def weights_init_normal(m):

"""自定义权重初始化"""

classname = m.class.name

if classname.find("Conv") != -1:

torch.nn.init.normal_(m.weight.data, 0.0, 0.02) N(0, 0.02)

if hasattr(m, "bias") and m.bias is not None:

torch.nn.init.constant_(m.bias.data, 0.0)

elif classname.find("Linear") != -1:

torch.nn.init.normal_(m.weight.data, 0.0, 0.02)

if hasattr(m, "bias") and m.bias is not None:

torch.nn.init.constant_(m.bias.data, 0.0)

elif classname.find("BatchNorm2d") != -1 or classname.find("InstanceNorm2d") != -1:

if hasattr(m, "weight") and m.weight is not None:

torch.nn.init.normal_(m.weight.data, 1.0, 0.02) N(1, 0.02)

if hasattr(m, "bias") and m.bias is not None:

torch.nn.init.constant_(m.bias.data, 0.0)

- *初始化策略分析:

- 小方差初始化:std=0.02避免激活值过大

- 偏置归零:简化初始状态,有利于对称性打破

- 归一化层特殊处理:权重初始化为1,保持初始的归一化效果

10.2 优化器配置

```python

版本v6.py:540-550

optimizer_G = torch.optim.Adam(generator.parameters(), lr=opt.G_lr,

betas=(opt.b1, opt.b2))

optimizer_D = torch.optim.Adam(discriminator.parameters(), lr=opt.D_lr,

betas=(opt.b1, opt.b2))

默认参数:b1=0.5, b2=0.999, lr=1e-4

- *参数选择理由:

- β1=0.5:相比默认的0.9,更小的动量适合GAN训练

- β2=0.999:保持较大的二阶动量,稳定训练过程

- lr=1e-4:较小的学习率确保稳定收敛

10.3 学习率调度策略(扩展建议)

```python

可以添加的学习率调度

def get_lr_scheduler(optimizer, n_epochs, decay_epoch=500):

"""余弦退火学习率调度"""

return torch.optim.lr_scheduler.CosineAnnealingLR(

optimizer, T_max=n_epochs, eta_min=1e-6, last_epoch=-1

)

def get_linear_lr_scheduler(optimizer, n_epochs, start_epoch=0):

"""线性衰减学习率调度"""

def lambda_rule(epoch):

lr_l = 1.0 - max(0, epoch - start_epoch) / (n_epochs - start_epoch)

return lr_l

return torch.optim.lr_scheduler.LambdaLR(optimizer, lr_lambda=lambda_rule)

实验结果分析

11.1 收敛性分析

基于代码设计,预期训练过程呈现以下特征:

```

训练阶段分析:

├─ 初期(0-100 epochs):

│ ├─ D_loss快速下降,G_loss波动较大

│ ├─ 梯度惩罚值较高,判别器学习Lipschitz约束

│ └─ 生成图像基本结构开始形成

├─ 中期(100-500 epochs):

│ ├─ D_loss和G_loss趋于稳定

│ ├─ 梯度惩罚值稳定在10-20之间

│ └─ 图像细节逐渐丰富

└─ 后期(500+ epochs):

├─ 损失函数在小范围内波动

├─ 生成图像质量持续提升

└─ 模式崩溃风险降低

11.2 性能指标预期

```

系统性能预期(基于代码架构):

├─ 训练速度:

│ ├─ RTX 3090: ~5-10 iterations/second (batch_size=16)

│ ├─ RTX 4090: ~8-15 iterations/second (batch_size=16)

│ └─ V100: ~3-8 iterations/second (batch_size=16)

├─ 显存占用:

│ ├─ 基础模型:~800MB (batch_size=16, img_size=256)

│ ├─ 检查点优化:减少50-60%峰值内存

│ └─ 混合精度:减少30-40%内存占用

└─ 收敛速度:

├─ 基本收敛:200-500 epochs

├─ 高质量生成:500-1000 epochs

└─ 最优结果:1000+ epochs

11.3 质量评估指标

```python

可以添加的质量评估指标

def calculate_fid(real_features, fake_features):

"""Fréchet Inception Distance"""

mu1, sigma1 = real_features.mean(axis=0), np.cov(real_features, rowvar=False)

mu2, sigma2 = fake_features.mean(axis=0), np.cov(fake_features, rowvar=False)

diff = mu1 - mu2

covmean, _ = linalg.sqrtm(sigma1.dot(sigma2), disp=False)

if np.iscomplexobj(covmean):

covmean = covmean.real

fid = diff.dot(diff) + np.trace(sigma1) + np.trace(sigma2) - 2 * np.trace(covmean)

return fid

def calculate_is(images, inception_model):

"""Inception Score"""

preds = []

for img in images:

pred = F.softmax(inception_model(img.unsqueeze(0)), dim=1)

preds.append(pred)

preds = torch.cat(preds, 0)

py = preds.mean(0)

scores = []

for i in range(preds.shape[0]):

pyx = preds[i, :]

scores.append(F.kl_div(pyx.log(), py, reduction='sum').exp())

return torch.stack(scores).mean(), torch.stack(scores).std()

故障诊断与调试

12.1 常见问题诊断

12.1.1 模式崩溃(Mode Collapse)

-

*症状:

-

生成器只产生有限的几种模式

-

判别器损失快速下降到接近0

-

生成器损失波动但无明显下降趋势

-

*诊断方法:

```python

def detect_mode_collapse(generated_images, window_size=100):

"""检测模式崩溃"""

计算生成图像的多样性指标

diversity_scores = []

for i in range(0, len(generated_images), window_size):

batch = generated_images[i:i+window_size]

计算批次内图像的LPIPS距离

lpips_distances = []

for j in range(len(batch)):

for k in range(j+1, len(batch)):

使用预训练的LPIPS模型计算感知距离

distance = lpips_model(batch[j:j+1], batch[k:k+1])

lpips_distances.append(distance.item())

diversity_score = np.mean(lpips_distances)

diversity_scores.append(diversity_score)

如果多样性持续下降,可能存在模式崩溃

if len(diversity_scores) > 10:

recent_trend = np.polyfit(range(10), diversity_scores[-10:], 1)[0]

if recent_trend < -0.01: 多样性下降趋势

return True, diversity_scores

return False, diversity_scores

12.1.2 梯度消失/爆炸

-

*症状:

-

损失函数不再变化或变化极小

-

生成图像质量停滞

-

梯度范数接近0或非常大

-

*监控代码:

```python

def monitor_gradients(model, name=""):

"""监控模型梯度状态"""

total_norm = 0

param_count = 0

zero_grad_count = 0

for param in model.parameters():

if param.grad is not None:

param_norm = param.grad.data.norm(2).item()

total_norm += param_norm 2

param_count += 1

if param_norm < 1e-7:

zero_grad_count += 1

total_norm = total_norm 0.5

stats = {

'total_norm': total_norm,

'avg_norm': total_norm / max(param_count, 1),

'zero_grad_ratio': zero_grad_count / max(param_count, 1),

'param_count': param_count

}

return stats

在训练循环中使用

g_grad_stats = monitor_gradients(generator, "Generator")

d_grad_stats = monitor_gradients(discriminator, "Discriminator")

预警机制

if g_grad_stats['zero_grad_ratio'] > 0.5:

print("警告:生成器超过50%的参数梯度接近零!")

if d_grad_stats['total_norm'] > 100:

print("警告:判别器梯度范数过大,可能发生梯度爆炸!")

12.1.3 训练不稳定

-

*症状:

-

损失函数剧烈波动

-

生成图像质量时好时坏

-

判别器准确率快速达到100%

-

*解决方案:

```python

def stabilize_training(opt):

"""训练稳定性增强配置"""

- 调整梯度惩罚系数

if opt.lambda_gp < 10:

opt.lambda_gp = 10 确保足够的梯度惩罚

- 降低学习率

current_lr = opt.G_lr

if current_lr > 2e-4:

opt.G_lr = 2e-4

opt.D_lr = 2e-4

- 增加判别器更新频率

if opt.n_critic < 5:

opt.n_critic = 5

- 启用谱归一化(如果未启用)

在判别器中添加更多SN层

- 添加噪声到判别器输入

def add_input_noise(x, noise_factor=0.1):

"""给判别器输入添加噪声"""

noise = torch.randn_like(x) * noise_factor

return x + noise

return opt

12.2 性能瓶颈分析

12.2.1 数据加载瓶颈

- *诊断代码:

```python

def benchmark_data_loading(dataloader, num_batches=100):

"""基准测试数据加载性能"""

import time

times = []

for i, (batch, _) in enumerate(dataloader):

if i >= num_batches:

break

start_time = time.time()

模拟GPU传输和处理时间

batch = batch.cuda()

torch.cuda.synchronize()

end_time = time.time()

times.append(end_time - start_time)

avg_time = np.mean(times)

std_time = np.std(times)

print(f"数据加载性能:")

print(f" 平均时间:{avg_time*1000:.2f}ms")

print(f" 标准差:{std_time*1000:.2f}ms")

print(f" 理论最大吞吐量:{1/avg_time:.1f} batches/second")

性能建议

if avg_time > 0.1: 超过100ms

print("建议:")

print(" - 增加num_workers")

print(" - 使用更快的存储设备")

print(" - 预加载数据到内存")

return avg_time, std_time

12.2.2 GPU利用率分析

```python

def monitor_gpu_utilization():

"""监控GPU利用率"""

import subprocess

import time

def get_gpu_stats():

result = subprocess.run([

'nvidia-smi', '--query-gpu=utilization.gpu,memory.used,memory.total',

'--format=csv,noheader,nounits'

], capture_output=True, text=True)

if result.returncode == 0:

stats = result.stdout.strip().split(', ')

return {

'gpu_util': float(stats[0]),

'memory_used': float(stats[1]),

'memory_total': float(stats[2]),

'memory_ratio': float(stats[1]) / float(stats[2])

}

return None

连续监控

stats_history = []

for _ in range(60): 监控1分钟

stats = get_gpu_stats()

if stats:

stats_history.append(stats)

time.sleep(1)

分析结果

if stats_history:

avg_gpu_util = np.mean([s['gpu_util'] for s in stats_history])

avg_memory_ratio = np.mean([s['memory_ratio'] for s in stats_history])

print(f"GPU利用率分析:")

print(f" 平均GPU利用率:{avg_gpu_util:.1f}%")

print(f" 平均显存使用率:{avg_memory_ratio*100:.1f}%")

if avg_gpu_util < 70:

print("警告:GPU利用率偏低,可能存在瓶颈!")

print("建议:")

print(" - 增加batch_size")

print(" - 优化数据加载")

print(" - 检查CPU瓶颈")

return stats_history

12.3 调试工具集成

12.3.1 梯度可视化

```python

def visualize_gradients(model, save_path="gradients.png"):

"""可视化模型梯度分布"""

import matplotlib.pyplot as plt

grad_norms = []

layer_names = []

for name, param in model.named_parameters():

if param.grad is not None:

grad_norm = param.grad.data.norm(2).item()

grad_norms.append(grad_norm)

layer_names.append(name)

绘制梯度分布

plt.figure(figsize=(12, 8))

plt.subplot(2, 1, 1)

plt.bar(range(len(grad_norms)), grad_norms)

plt.xlabel('Layer')

plt.ylabel('Gradient Norm')

plt.title('Gradient Norms by Layer')

plt.xticks(range(len(layer_names)), [name[:30] + '...' if len(name) > 30 else name

for name in layer_names], rotation=45)

plt.subplot(2, 1, 2)

plt.hist(grad_norms, bins=30, alpha=0.7)

plt.xlabel('Gradient Norm')

plt.ylabel('Frequency')

plt.title('Gradient Norm Distribution')

plt.tight_layout()

plt.savefig(save_path, dpi=150, bbox_inches='tight')

plt.close()

return grad_norms

12.3.2 特征图可视化

```python

def visualize_feature_maps(model, input_tensor, save_path="feature_maps.png"):

"""可视化特征图"""

import matplotlib.pyplot as plt

注册hook来捕获中间特征

activations = {}

def get_activation(name):

def hook(model, input, output):

activations[name] = output.detach()

return hook

注册hooks

hooks = []

for name, module in model.named_modules():

if isinstance(module, nn.Conv2d):

hooks.append(module.register_forward_hook(get_activation(name)))

前向传播

with torch.no_grad():

output = model(input_tensor)

移除hooks

for hook in hooks:

hook.remove()

可视化特征图

fig, axes = plt.subplots(4, 8, figsize=(16, 8))

axes = axes.flatten()

选择几个有代表性的层

selected_layers = list(activations.keys())[:4]

for idx, layer_name in enumerate(selected_layers):

if layer_name in activations:

feat_map = activations[layer_name][0] 取第一个样本

平均池化通道维度

feat_map_avg = torch.mean(feat_map, dim=0)

ax = axes[idx * 8]

im = ax.imshow(feat_map_avg.cpu().numpy(), cmap='viridis')

ax.set_title(f'{layer_name}\n(Avg)')

plt.colorbar(im, ax=ax)

显示几个单独的通道

for i in range(min(7, feat_map.shape[0])):

ax = axes[idx * 8 + i + 1]

im = ax.imshow(feat_map[i].cpu().numpy(), cmap='viridis')

ax.set_title(f'Channel {i}')

plt.colorbar(im, ax=ax)

plt.tight_layout()

plt.savefig(save_path, dpi=150, bbox_inches='tight')

plt.close()

return activations

总结

本技术文档深入分析了WGAN-GP RVE生成系统的各个技术层面,从理论基础到实现细节,从性能优化到故障诊断,为理解和改进该系统提供了全面的技术参考。通过详细的代码分析和理论阐述,读者可以深入理解现代生成对抗网络的最佳实践和优化技巧。

该系统的技术亮点包括:

- 稳定的训练架构:WGAN-GP确保训练稳定性

- 高效的内存管理:检查点和混合精度优化

- 创新的损失设计:边界一致性和二值化约束

- 完整的监控体系:全面的日志和可视化工具

这些技术的综合应用使得该系统能够在有限的计算资源下生成高质量的图像,为相关研究和应用提供了可靠的技术基础。