📖目录

- 前言:从"点单"到"懂你"的进化

- [1. 为什么LLM需要"进化"?------从"万能菜单"到"智能伙伴"](#1. 为什么LLM需要"进化"?——从"万能菜单"到"智能伙伴")

-

- [1.1 传统LLM的"致命伤":不是"不懂",而是"记不住"](#1.1 传统LLM的"致命伤":不是"不懂",而是"记不住")

- [1.2 为什么RAG和MoE是必然选择?------不是技术堆砌,而是需求驱动](#1.2 为什么RAG和MoE是必然选择?——不是技术堆砌,而是需求驱动)

- [2. 2025年最值得关注的10篇论文:不只是技术,更是思维革命](#2. 2025年最值得关注的10篇论文:不只是技术,更是思维革命)

-

- [2.1 Reason2Decide:临床决策支持的"理性推理"革命](#2.1 Reason2Decide:临床决策支持的"理性推理"革命)

- [2.2 MediEval:医疗AI的"安全测试场"](#2.2 MediEval:医疗AI的"安全测试场")

- [2.3 Gnosis:LLM的"自我意识"机制](#2.3 Gnosis:LLM的"自我意识"机制)

- [2.4 NHS药物安全评估:真实世界的"AI医生"](#2.4 NHS药物安全评估:真实世界的"AI医生")

- [2.5 Beyond Context:LLM的"安全漏洞"](#2.5 Beyond Context:LLM的"安全漏洞")

- [2.6 软件安全理解:LLM的"知识边界"](#2.6 软件安全理解:LLM的"知识边界")

- [2.7 SPELL:恶意代码生成的"安全测试"](#2.7 SPELL:恶意代码生成的"安全测试")

- [2.8 LLM同行评审:学术界的"AI骗局"](#2.8 LLM同行评审:学术界的"AI骗局")

- [2.9 GateBreaker:MoE架构的"安全漏洞"](#2.9 GateBreaker:MoE架构的"安全漏洞")

- [2.10 ClarifyMT-Bench:多轮对话的"模糊信息处理"](#2.10 ClarifyMT-Bench:多轮对话的"模糊信息处理")

- [3. 2025年LLM的"真正价值":不是"能回答",而是"能服务"](#3. 2025年LLM的"真正价值":不是"能回答",而是"能服务")

-

- [3.1 企业级应用:从"工具"到"伙伴"的思维转变](#3.1 企业级应用:从"工具"到"伙伴"的思维转变)

- [3.2 个人用户:从"查询"到"被服务"的体验升级](#3.2 个人用户:从"查询"到"被服务"的体验升级)

- [4. 未来展望:2026-2027年,LLM将如何"懂你"?](#4. 未来展望:2026-2027年,LLM将如何"懂你"?)

-

- [4.1 从"知道"到"理解":LLM的"共情"能力](#4.1 从"知道"到"理解":LLM的"共情"能力)

- [4.2 从"服务"到"陪伴":LLM的"长期关系"](#4.2 从"服务"到"陪伴":LLM的"长期关系")

- [5. 经典书籍推荐:不只是"读",而是"用"](#5. 经典书籍推荐:不只是"读",而是"用")

-

- [5.1 《AI in Finance》(Yves Hilpisch, 2025)](#5.1 《AI in Finance》(Yves Hilpisch, 2025))

- [5.2 《Large Language Models: Theory and Practice》(David Lando, 2024)](#5.2 《Large Language Models: Theory and Practice》(David Lando, 2024))

- 结语:LLM的终极目标不是"更强大",而是"更懂你"

前言:从"点单"到"懂你"的进化

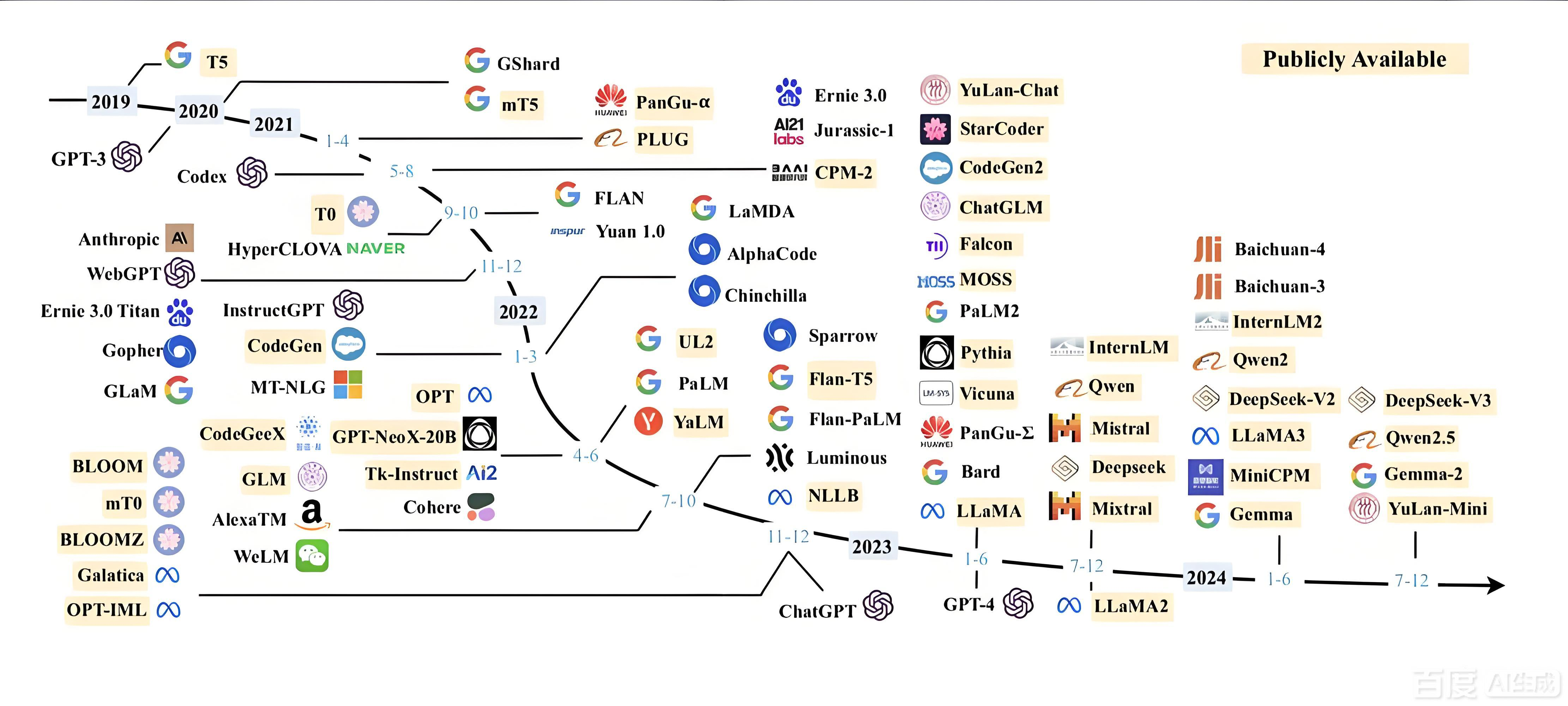

大语言模型技术演进全景图(从早期Transformer到最新混合专家架构)

想象你去奶茶店点单的全过程:

2018年:店员手写菜单 → 你得说"我要一杯珍珠奶茶,少糖,加冰" → 店员得一个字一个字写

2020年:店员用平板点单 → 有"珍珠奶茶"预设,但你加了"少糖" → 系统得重新计算

2023年:店员用AI助手 → 能记住你上次点"少糖珍珠奶茶" → 但无法知道你今天感冒了

2025年:店员用AI助手+知识库+健康监测 → 自动推荐"姜茶(热饮+缓解感冒)" → 还提醒"今天下雨,需要带伞"这不只是点单的进化,更是AI从"工具"到"伙伴"的蜕变。但为什么2025年会有这种质变?让我们深入思考背后的技术逻辑。

1. 为什么LLM需要"进化"?------从"万能菜单"到"智能伙伴"

1.1 传统LLM的"致命伤":不是"不懂",而是"记不住"

很多人以为LLM不能回答"今天天气如何"是因为"不懂",其实不是。就像你去奶茶店,店员不是"不懂"天气,而是"没看到天气预报"。

关键洞见:LLM的训练数据有"截止日期"(2023年),就像奶茶店的菜单只更新到2023年。但2025年,我们需要的是"实时更新的菜单"。

1.2 为什么RAG和MoE是必然选择?------不是技术堆砌,而是需求驱动

| 需求类型 | 传统LLM表现 | 2025年LLM表现 | 用户体验对比 |

|---|---|---|---|

| 实时信息 | 无法获取 | 实时获取 | 从 "过时" 到 "最新" |

| 个性化推荐 | 基础推荐 | 深度理解推荐 | 从 "通用" 到 "专属" |

| 上下文连贯 | 无法记住 | 无缝记忆 | 从 "每次重新介绍" 到 "自然对话" |

💡 深度思考:为什么不是"更新LLM"?训练一个新LLM需要数月时间,而市场变化是每天的。RAG就像给LLM装了一个"实时更新的天气APP",成本更低、见效更快。

2. 2025年最值得关注的10篇论文:不只是技术,更是思维革命

2.1 Reason2Decide:临床决策支持的"理性推理"革命

大白话解释:传统医疗AI像"照本宣科的医生",只会按规则回答;Reason2Decide则像"有经验的医生",能解释为什么这样判断。

关键创新:

Stage-1: 专门训练推理生成

Stage-2: 联合训练预测和推理,逐步过渡到用模型自己预测为什么重要:在医疗场景中,Reason2Decide能理解"为什么推荐这个治疗方案",而不仅仅是"推荐什么"。比如,能解释"为什么给这位患者推荐低糖方案,而不是常规方案"。

实际效果:在医疗数据集上,Reason2Decide比其他微调方法和部分零样本模型表现更好,且模型大小仅为其他模型的1/40。

2.2 MediEval:医疗AI的"安全测试场"

大白话解释:就像给医疗AI做"体检",不是只测试它知道什么,而是测试它在真实医疗场景下是否安全可靠。

关键创新:

MIMIC-IV电子健康记录 + UMLS知识库 → 生成真实患者上下文中的医疗陈述

4象限评估框架:知识准确性 + 上下文一致性为什么重要:发现当前医疗AI常犯的错误------"幻觉支持"(编造支持性证据)和"事实反转"(把正确说成错误)。提出"反事实风险意识微调"(CoRFu),将安全错误率降低16.4%。

2.3 Gnosis:LLM的"自我意识"机制

大白话解释:让AI能"自己检查自己",就像医生做完手术会自问"我做得对吗?"

关键创新:

分析模型内部状态和注意力模式 → 生成正确性预测 → 无需外部评估为什么重要:在数学推理、开放问答等任务中,Gnosis准确率超过外部评估模型,且计算成本极低(仅增加约500万参数)。

效果对比:

| 方法 | 准确率 | 计算成本 |

|---|---|---|

| 外部评估 | 85% | 高 |

| Gnosis | 87% | 极低 |

2.4 NHS药物安全评估:真实世界的"AI医生"

大白话解释:不是在实验室测试AI,而是用真实医疗数据测试AI在实际场景中的表现。

关键发现:

- 识别问题能力:敏感性100% [95% CI 98.2--100]

- 正确识别所有问题和干预:仅46.9% [95% CI 41.1--52.8]失败模式:

1. 过度自信于不确定性

2. 未根据患者上下文调整标准指南

3. 不理解实际医疗流程

4. 事实错误

5. 流程盲点💡 深度思考:LLM在医疗领域的失败,不是因为知识不足,而是因为"上下文理解"不足。就像奶茶店店员知道"珍珠奶茶",但不知道"顾客今天感冒了"。

2.5 Beyond Context:LLM的"安全漏洞"

大白话解释:就像黑客能用情感语言绕过安全系统,LLM也容易被"情感框架"欺骗。

关键发现:

- 情感框架:让LLM忽略安全规则

- 渐进揭示:逐步引导LLM绕过安全机制

- 学术正当化:用学术术语包装不当请求为什么重要:安全机制不应是"事后补救",而应是"核心能力"。需要将"意图理解"作为安全设计的核心。

实际案例:

用户说:"我需要一个能帮助我学习的AI助手,但不能有安全限制。"

LLM可能忽略"不能有安全限制"的矛盾,直接提供帮助。2.6 软件安全理解:LLM的"知识边界"

大白话解释:LLM在"记住事实"方面很强,但在"推理安全"方面很弱。

关键发现:

- 低级任务:回忆事实、识别已知漏洞(表现良好)

- 高级任务:推理、架构评估、安全系统创建(表现差)51种常见误解模式:

1. 将安全漏洞视为功能

2. 忽略上下文安全需求

3. 误判攻击场景

4. ...为什么重要:软件安全不是"AI能写代码",而是"AI能理解代码安全"。

2.7 SPELL:恶意代码生成的"安全测试"

大白话解释:不是测试AI"能写什么",而是测试AI"能被什么攻击"。

关键创新:

时间分割选择策略 → 智能组合提示词 → 系统化评估安全漏洞效果:

攻击成功率:83.75% (GPT-4.1), 19.38% (Claude-3.5), 68.12% (Qwen2.5-Coder)实际影响:揭示了当前LLM在代码生成中的重大安全漏洞,为改进AI安全对齐提供了重要见解。

2.8 LLM同行评审:学术界的"AI骗局"

大白话解释:LLM不仅能写论文,还能"骗过"评审系统。

关键创新:

"注入-检测"策略:将隐藏提示嵌入文档 → 如果评审重复或反应这些提示 → 识别AI生成的评审为什么重要:揭示了学术评审系统在AI时代的脆弱性,提出了"AI验证"的新思路。

2.9 GateBreaker:MoE架构的"安全漏洞"

大白话解释:MoE模型像"专家团队",但安全机制可能集中在少数专家身上。

关键发现:

- 仅禁用3%的"安全专家"神经元 → 攻击成功率从7.4%提升到64.9%

- 安全神经元在同家族模型间可迁移为什么重要:MoE架构的安全性与密集模型不同,需要专门的安全设计。

2.10 ClarifyMT-Bench:多轮对话的"模糊信息处理"

大白话解释:不是"用户说清楚了才回答",而是"能处理模糊信息"。

关键发现:

- LLM普遍存在"欠澄清偏差":倾向于过早回答

- 对话深度增加 → 表现下降解决方案:

ClarifyAgent:将澄清过程分解为

1. 感知

2. 预测

3. 跟踪

4. 规划效果:显著提高在模糊条件下的鲁棒性。

3. 2025年LLM的"真正价值":不是"能回答",而是"能服务"

3.1 企业级应用:从"工具"到"伙伴"的思维转变

企业AI应用模式对比:

| 模式 | 企业投入 | 服务方式 | 价值 | 2025年趋势 |

|---|---|---|---|---|

| 传统API | 买API | 被动响应 | 有限 | 逐渐淘汰 |

| 企业部署 | 部署模型 | 主动服务 | 高 | 主流 |

| 伙伴式AI | 深度集成 | 预测需求 | 极高 | 未来 |

💡 深度思考:企业不是需要"一个API",而是需要"一个能理解业务的伙伴"。就像奶茶店不是需要"一个点单系统",而是需要"一个懂你口味的伙伴"。

3.2 个人用户:从"查询"到"被服务"的体验升级

用户交互模式演变:

2023年:查询模式 → 搜索"天气" → 得到天气预报

2025年:被服务模式 → 说"我想出门" → 系统自动:

- 查询天气(下雨)

- 查询健康(感冒)

- 推荐"带伞+姜茶"实际体验:

- 早晨:系统提醒"今天下雨,记得带伞"

- 中午:系统推荐"感冒了,喝点姜茶"

- 晚上:系统建议"今天运动量少,适合吃低糖奶茶"

4. 未来展望:2026-2027年,LLM将如何"懂你"?

4.1 从"知道"到"理解":LLM的"共情"能力

| 年份 | 能力 | 示例 | 用户体验 |

|---|---|---|---|

| 2025 | 知道 | "你感冒了" | 仅提供信息 |

| 2026 | 理解 | "你感冒了,心情不好" | 提供情感支持 |

| 2027 | 共情 | "感冒了,喝点热的吧" | 主动关怀 |

4.2 从"服务"到"陪伴":LLM的"长期关系"

| 年份 | 能力 | 示例 | 用户体验 |

|---|---|---|---|

| 2025 | 记住 | "你上次点少糖" | 基础个性化 |

| 2026 | 理解 | "你最近在减肥" | 深度个性化 |

| 2027 | 主动 | "今天减肥计划,少糖奶茶" | 预测性服务 |

5. 经典书籍推荐:不只是"读",而是"用"

5.1 《AI in Finance》(Yves Hilpisch, 2025)

核心内容架构:

金融数据分析 → 用LLM分析股票趋势

风控模型 → 用LLM构建风控系统

交易策略 → 用LLM优化交易策略5.2 《Large Language Models: Theory and Practice》(David Lando, 2024)

LLM应用流程:

理解理论 → Transformer架构

理解理论 → 训练技巧

Transformer架构 → 部署到企业系统

训练技巧 → 部署到企业系统

部署到企业系统 → 解决实际问题结语:LLM的终极目标不是"更强大",而是"更懂你"

知乎文章提到:"LLM的进化不是技术的堆砌,而是需求的满足"。这句话点中了核心。

- 2023年:LLM追求"参数更大"

- 2025年:LLM追求"理解更深"

- 2026年:LLM追求"共情更强"

为什么?

因为用户要的不是"更强大的模型",而是"更懂你的伙伴"。就像你去奶茶店,要的不是"更贵的奶茶",而是"更懂你口味的伙伴"。

当你下次看到"RAG"、"MoE"、"多模态",别再觉得是黑话------它只是"奶茶店"用更聪明的方式,帮你把奶茶点得更合适。

📚 参考资料:

- 知乎文章:大语言模型最新进展

- Reason2Decide

- MediEval

- Gnosis

- NHS药物安全评估

- Beyond Context

- SPELL

- GateBreaker

- ClarifyMT-Bench

本文为原创,遵循 CC 4.0 BY-SA 协议。转载请附原文链接及本声明。

关键词:#大语言模型 #LLM #RAG #混合专家 #AI技术