大家好,今天继续讲述关于人工智能学习的基础篇。

(1)收缩自编码器

收缩自编码器(Contractive Autoencoder,CAE)是正则自编码器的变体,通过在编码器函数的Jacobian矩阵上施加平方Frobenius范数惩罚项,迫使模型学习对输入扰动鲁棒的特征表示。该惩罚项通过约束编码器导数的大小,实现输入数据在局部邻域内的收缩映射,从而捕捉数据流形的切平面方向变化。

CAE通过平衡重构误差与收缩惩罚项的目标函数进行训练,其正则化效果在小高斯噪声条件下与去噪自编码器存在理论等价性。为防止解码器因惩罚项约束而失效,通常采用绑定编码器与解码器权重矩阵的策略。作为判别模型的一种,收缩自编码器与变分自编码器等生成模型共同构成自编码器家族的核心类型,主要应用于数据降维与特征提取任务。

编码维数小于输入维数的欠完备自编码器可以学习数据分布最显著的特征。我们已经知道,如果赋予这类自编码器过大的容量,它就不能学到任何有用的信息。

如果隐藏编码的维数允许与输入相等,或隐藏编码维数大于输入的 过完备(overcomplete)情况下,会发生类似的问题。在这些情况下,即使是线性编码器和线性解码器也可以学会将输入复制到输出,而学不到任何有关数据分布的有用信息。

理想情况下,根据要建模的数据分布的复杂性,选择合适的编码维数和编码器、解码器容量,就可以成功训练任意架构的自编码器。正则自编码器提供这样的能力。正则自编码器使用的损失函数可以鼓励模型学习其他特性(除了将输入复制到输出),而不必限制使用浅层的编码器和解码器以及小的编码维数来限制模型的容量。这些特性包括稀疏表示、 表示的小导数、以及对噪声或输入缺失的鲁棒性。即使模型容量大到足以学习一个无意义的恒等函数,非线性且过完备的正则自编码器仍然能够从数据中学到一些关于数据分布的有用信息。

除了这里所描述的方法(正则化自编码器最自然的解释),几乎任何带有潜变量并配有一个推断过程(计算给定输入的潜在表示)的生成模型,都可以看作是自编码器的一种特殊形式。强调与自编码器联系的两个生成式建模方法是 Helmholtz机的衍生模型,如变分自编码器和生成随机网络。这些变种(或衍生) 自编码器能够学习出高容量且过完备的模型,进而发现输入数据中有用的结构信息,并且也无需对模型进行正则化。这些编码显然是有用的,因为这些模型被训练为近似训练数据的概率分布而不是将输入复制到输出。

(2)欠完备自编码器

欠完备自编码器是一种基于神经网络的自编码器,其编码维度小于输入维度,通过最小化输入输出重构损失函数实现输入数据的复制与特征抽取。当解码器为线性且采用均方误差损失函数时,其生成子空间与主成分分析(PCA)等效。编码器与解码器容量过大时会导致特征提取失效,为此研究者通过添加稀疏性限制、输入噪声或维度约束等方法衍生出稀疏自编码器、去噪自编码器和收缩自编码器等变体。

该模型通过低维投影处理高维数据中的"维数灾难",强制捕捉数据最显著特征的特性使其广泛应用于特征抽取领域。在超材料智能设计中用于参数模型的特征提取,在扣件检测中与卷积自编码器组合使用使检测准确率达到95.59% ,在通信领域实现对BPSK/QPSK等调制信号的特征自动提取(10dB信噪比识别率超0.97) ,在电力数据分析中通过编码比率优选提高用户用电行为分类准确率。

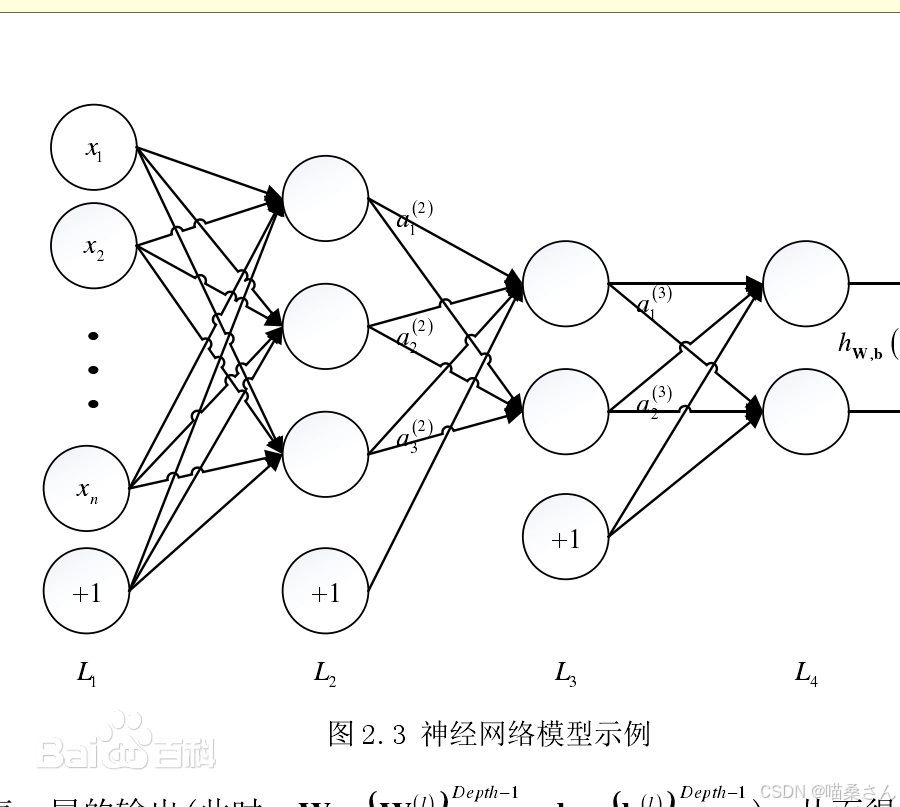

真实世界中存在大量非常复杂的事物和现象,通常我们希望能够以一种更加简洁且完整的方式去表示一个事物或现象,这就需要去揭示隐藏在复杂表象下的事物或现象的客观规律。

从某个事物或现象(例如天气状况)中抽象出一些数据(如温度、湿度、风力等),通过多个变量来表示或描述一个现象,这个多维变量叫做特征。特征作为机器学习系统的原材料,

对于最终模型的影响毋庸置疑。机器学习算法的性能在很大程度上取决于数据表达或特征表达的选择,当数据能够被很好地表达为特征时,即便使用简单的模型也可达到满意的精度。故在实际应用机器学习算法时,很重要的一个步骤是怎样预处理数据以得到一个好的特征表达。

真实世界中的数据通常是高维的。对高维数据的处理包括两点特性。第一点是"维数灾难",它给后面的数据处理带来困难,是处理高维数据时遇到的最大问题之一;第二点是"维数福音",高维数据中包含着关于客观事物和现象的极为全面和丰富的信息,蕴含着解决问题的可能性,当然也含有很多冗余信息。作为一类普遍存在的规律,在大多数情况下我们观察到的从表面上看是高维的、复杂的事物或现象,实际上是可以用少量的简单变量来支配的。

处理高维数据的关键是在众多的因素中找到事物的本质规律。表达转换指的是将原始表达转换为另一个不同的表达,表达维数小于原始表达维数的情形。在模式识别系统中,使用到的特征很重要,经常需要将高维的冗余的原始特征转换为低维的保留有效信息的特征,也就是特征转换。特征转换可以分为两类:第一类是"特征选择",即从原始表达中选择一个子集作为新的表达;第二类是"特征抽取",即将原始表达投影到一个低维特征空间中以得到一个更加紧凑的表达。

今天就讲这些,下篇文章见。