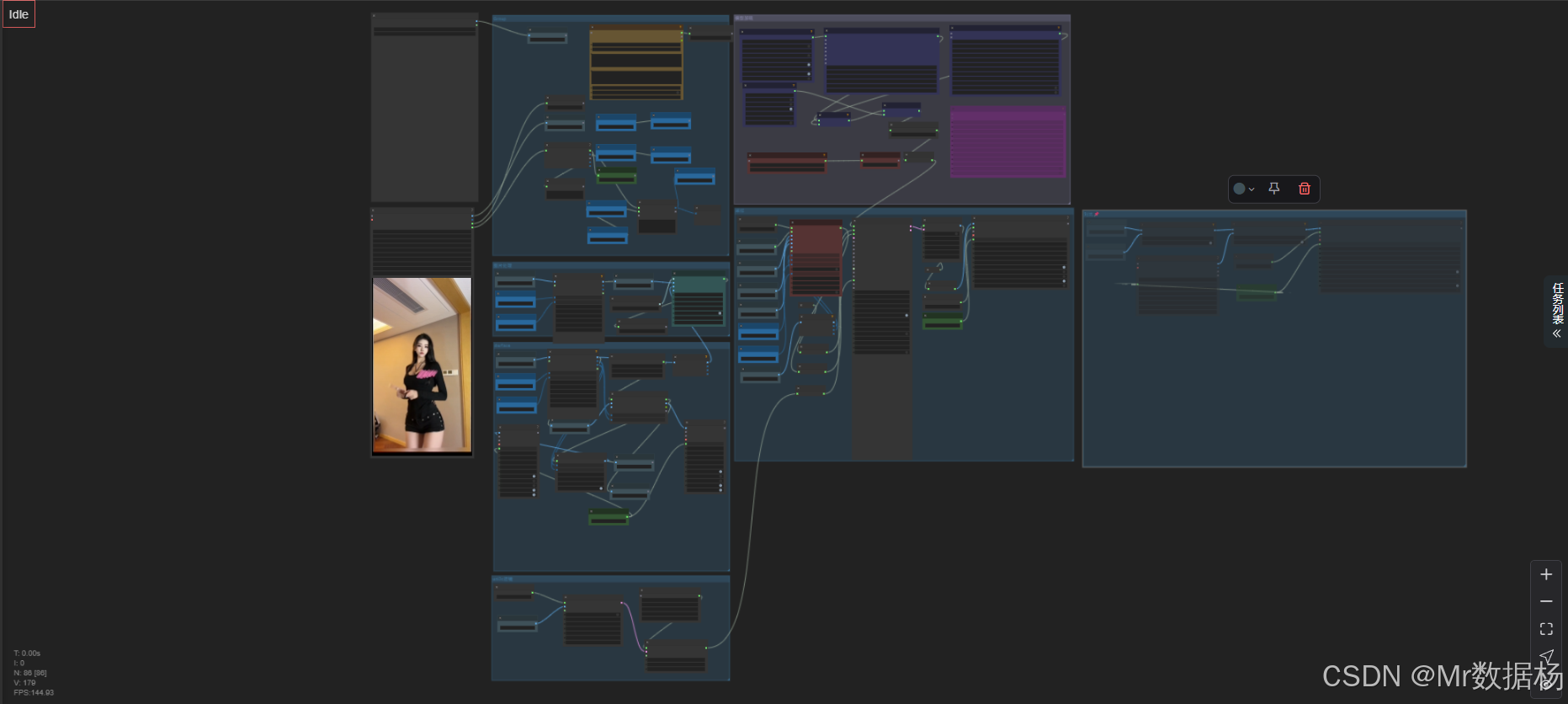

今天为大家带来一个ComfyUI强大的 Wan2.2 Animate 全局动作迁移与视频重绘视频生成。该工作流融合了视频帧重建、动作迁移、图像重绘和音频合成等多种 AI 技术,打造了一个可以将参考视频与图像进行动作与风格融合,并生成高质量新视频的全流程解决方案。通过视觉特征提取、模型解码器、动作采样器等节点,配合多种 LoRA 微调模块与 VAE 解码,还原并创造出具备细节、流畅度和风格统一性的全新视频输出结果。

文章目录

- 工作流介绍

- 工作流程

- 大模型应用

-

- [WanVideoTextEncodeCached 文本语义控制核心](#WanVideoTextEncodeCached 文本语义控制核心)

- 使用方法

- 应用场景

- 开发与应用

工作流介绍

本工作流围绕视频重绘与动作迁移两大主轴展开,结合输入图像、目标动作视频帧及文本/音频信息,使用 Wan2.2 Animate 大模型进行统一风格与运动建模。在重建过程中,采用 VAE 编码-解码机制保障细节保留,结合 LoRA 模块实现风格多样性控制,配合语义嵌入增强视频内容一致性。最终生成的视频支持帧率控制、格式自定义与音频合成,适用于 AI 创作、角色动画、风格迁移等复杂任务场景。

核心模型

本工作流使用的核心模型为 Wan2.2 Animate 14B_fp8,这是 Wan 系列中专为视频生成与动作迁移设计的旗舰模型,具备高维时序建模与图像细节保真能力。结合专属的 VAE 解码器与 LoRA 微调模型,实现高度可控的动作风格合成与图像风格迁移。

| 模型名称 | 说明 |

|---|---|

| Wan2.2 Animate 14B_fp8 | 主体模型,负责视频动作生成与风格控制,支持高分辨率生成与动态嵌入推理 |

| wan_2.1_vae.safetensors | 对应视频重建的 VAE 模型,辅助实现潜变量的图像解码重构 |

| 多个 LoRA 模块 | 用于注入不同动作风格与场景表现能力,例如光照、人物特征、风格变体等 |

Node节点

本工作流节点分布精细,涵盖图像获取、尺寸处理、视觉特征嵌入、模型加载、动作采样、图像解码、视频合成等功能模块。主要通过 WanVideo 系列节点协同工作,保证了视频生成的流畅性与高保真度。

| 节点名称 | 说明 |

|---|---|

| WanVideoModelLoader | 加载 Wan2.2 动作迁移视频模型 |

| WanVideoVAELoader | 加载对应的 VAE 解码模型 |

| WanVideoClipVisionEncode | 对参考图像进行视觉特征提取并生成嵌入向量 |

| WanVideoSampler | 基于动作与视觉特征生成潜空间视频帧 |

| WanVideoDecode | 将潜变量解码为图像帧 |

| VHS_VideoCombine | 合成音频与图像生成最终视频输出 |

| easy cleanGpuUsed | 释放中间节点 GPU 资源 |

| Set/Get Nodes | 用于各类常量与中间变量设置及传递,如图片、音频、尺寸等 |

工作流程

本工作流的整体流程围绕图像、视频帧、音频与文本等多模态输入,通过一系列节点进行统一融合与生成,形成完整的视频动作迁移与重绘过程。流程主要分为六大阶段:

输入预处理 获取初始图像与视频尺寸参数,并调整为模型可接受的分辨率。模型与参数加载 加载 Wan2.2 Animate 主模型与配套 VAE,应用多组 LoRA 风格控制参数。特征嵌入生成 参考图像通过视觉编码器生成视觉嵌入,文本或动作嵌入同步输入,构建多模态条件。动作采样与生成 通过 Sampler 节点在潜空间内进行动作生成,控制步数、CFG、scheduler 等生成细节。解码与输出 将潜变量解码为图像帧,添加音频、设置帧率等,最终输出为可播放的视频。资源清理与合成 合并所有输出结果,进行资源回收,生成完整的音视频内容成品。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 输入初始化 | 获取初始图像、视频宽高、帧率,标准化输入尺寸 | GetNode, ImageResizeKJv2 |

| 2 | 模型加载 | 加载主模型、VAE 解码器、LoRA 参数 | WanVideoModelLoader, WanVideoVAELoader |

| 3 | 特征提取 | 对图像进行视觉嵌入提取,生成 clip 视觉向量 | CLIPVisionLoader, WanVideoClipVisionEncode |

| 4 | 动作采样生成 | 基于图像嵌入、动作嵌入进行视频帧生成 | WanVideoSampler |

| 5 | 解码输出 | 潜空间图像解码,生成图像帧并设置帧率格式输出 | WanVideoDecode, VHS_VideoCombine |

| 6 | 清理合并 | 清理 GPU 占用,整合所有输出结果 | easy cleanGpuUsed, SetNode |

下面根据你提供的工作流文件内容,严格按你的结构要求输出「大模型应用」与「使用方法」。

本工作流中属于 大模型/LLM 类的节点只有一个:WanVideoTextEncodeCached,它负责将 Prompt 转成可供视频模型使用的语义嵌入,其本质属于文本编码大模型。

大模型应用

WanVideoTextEncodeCached 文本语义控制核心

这个节点承担整个工作流中最关键的语义输入任务。它接收用户提供的正向与反向 Prompt,再通过内置的文本编码大模型将这些文字转成结构化的文本嵌入。

这些嵌入会直接影响角色外观、动作风格、场景光线、画面质感等视觉特征。Prompt 的写法决定了视频生成的语义方向,只要调整文字,就能精准控制最终效果。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| WanVideoTextEncodeCached | Positive Prompt: 一个美女正在跳舞 Negative Prompt: 色调艳丽,过曝,静态,细节模糊不清,字幕,风格,作品,画作,画面,静止,整体发灰,最差质量,低质量,JPEG压缩残留,丑陋的,残缺的,多余的手指,画得不好的手部,画得不好的脸部,畸形的,毁容的,形态畸形的肢体,手指融合,静止不动的画面,杂乱的背景,三条腿,背景人很多,倒着走 | 将用户输入的 Prompt 文本转换为视频模型可理解的语义 embeddings,用于控制画面风格、动作表现、镜头质量,是整个工作流中唯一的文本大模型处理节点。 |

使用方法

整个工作流的运行逻辑从用户素材开始:用户只需准备角色图、动作图或参考视频、搭配音频及自定义 Prompt,系统就会自动执行从文本解析、动作提取、角色迁移、视频重绘到最终合成导出的一系列步骤。

角色图决定外形,动作图或视频提供运动轨迹,音频用于匹配节奏或口型,Prompt 则负责定义风格与画面细节。

当用户替换任意素材后,工作流会在内部自动重新生成对应的动作嵌入、视频帧与最终成片,无需手动调整节点连接,实现高度自动化的视频生成体验。

| 注意点 | 说明 |

|---|---|

| Prompt 要简洁明确 | 模糊或堆叠过多描述容易导致画面混乱或语义漂移 |

| 反向 Prompt 建议保持全面 | 可降低畸形、涂抹、过曝等问题出现的概率 |

| 角色图需清晰无遮挡 | 影响动作迁移后的主体一致性 |

| 动作视频要光线稳定 | 模型更容易提取准确的动作骨骼 |

| 音频长度应与预期视频时长匹配 | 避免导出视频出现黑屏或尾段空白 |

| 视频输出前建议检查帧率 | 帧率不同会影响动作流畅度与音画同步 |

应用场景

该工作流特别适用于以图像为基础、结合参考视频进行动作迁移与风格生成的复杂 AI 视频生成任务。无论是虚拟角色动态生成、影视级人物表演重现,还是 AI 剧情动画创作、虚拟主播动作合成等领域,都能发挥其高保真、可控性强的优势。结合高质量的图像解码与风格控制,该工作流生成的视频在细节表现、动作连贯度与风格一致性方面均表现出色,适合个人创作、商业生产与内容批量生成使用。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 虚拟角色视频生成 | 为静态人物图像添加真实动作 | 动画师、视频创作者 | 角色走动、跳舞、说话动作演绎 | 实现动作迁移与图像风格统一 |

| AI 动画制作 | 批量生成特定风格动作场景视频 | 内容创作团队 | 多人视频合成、多场景变化 | 快速输出可控的定制视频内容 |

| 虚拟主播驱动 | 将音频与动作映射至虚拟角色表演 | 虚拟人公司 | 口型同步、情绪动作表达 | 高精度同步 + 动态一致性 |

| 二次创作视频生成 | 将已有视频风格迁移至新图像角色 | 同人作者 | 原作动作重现,角色替换 | 实现风格替换与角色切换 |

| 教学演示与研究 | 演示 AI 动作生成与图像重绘流程 | 教师、开发者 | 可视化每步生成逻辑与结果 | 教学演示/调试复现/科研测试 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用