学习视频链接:Pi0 - generalist Vision Language Action policy for robots (VLA Series Ep.2) - YouTube

首先补一下Transformer基础:

Transformer从零详细解读(可能是你见过最通俗易懂的讲解)_哔哩哔哩_bilibili

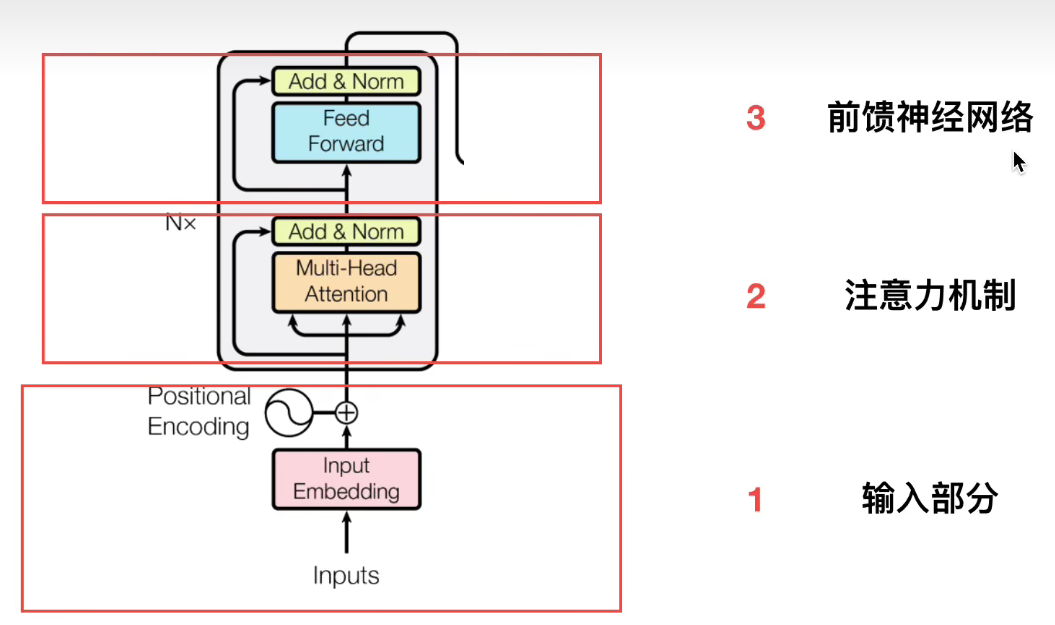

Encoder部分

分为输入部分、注意力机制部分和前馈神经网络部分。

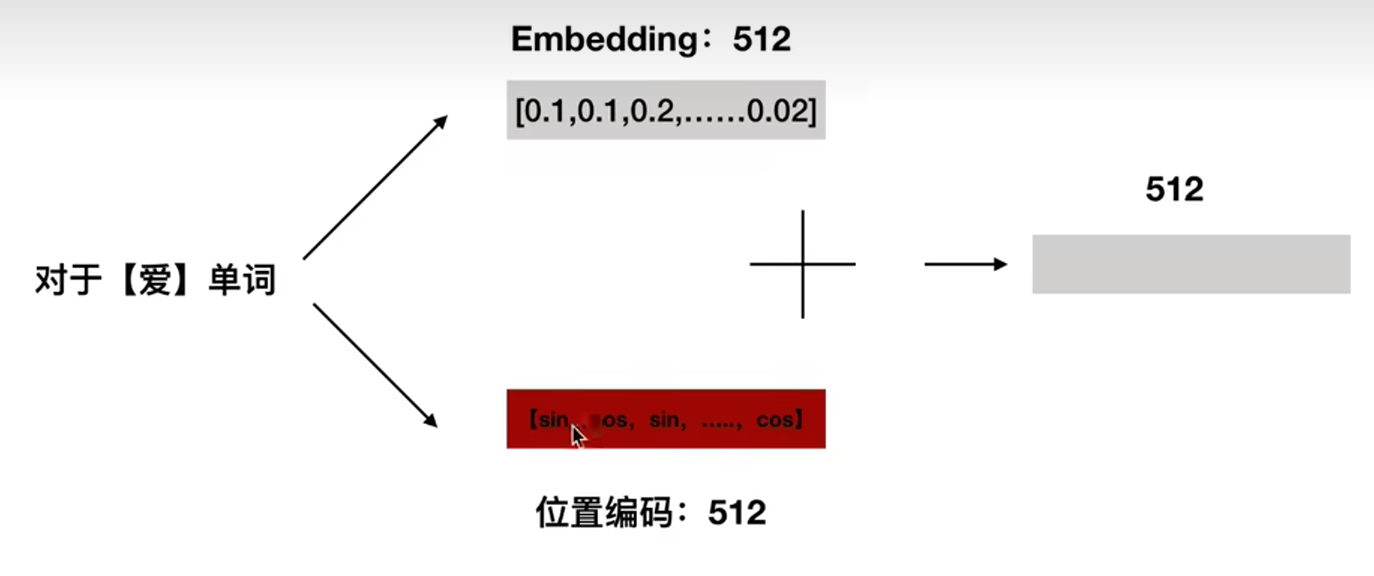

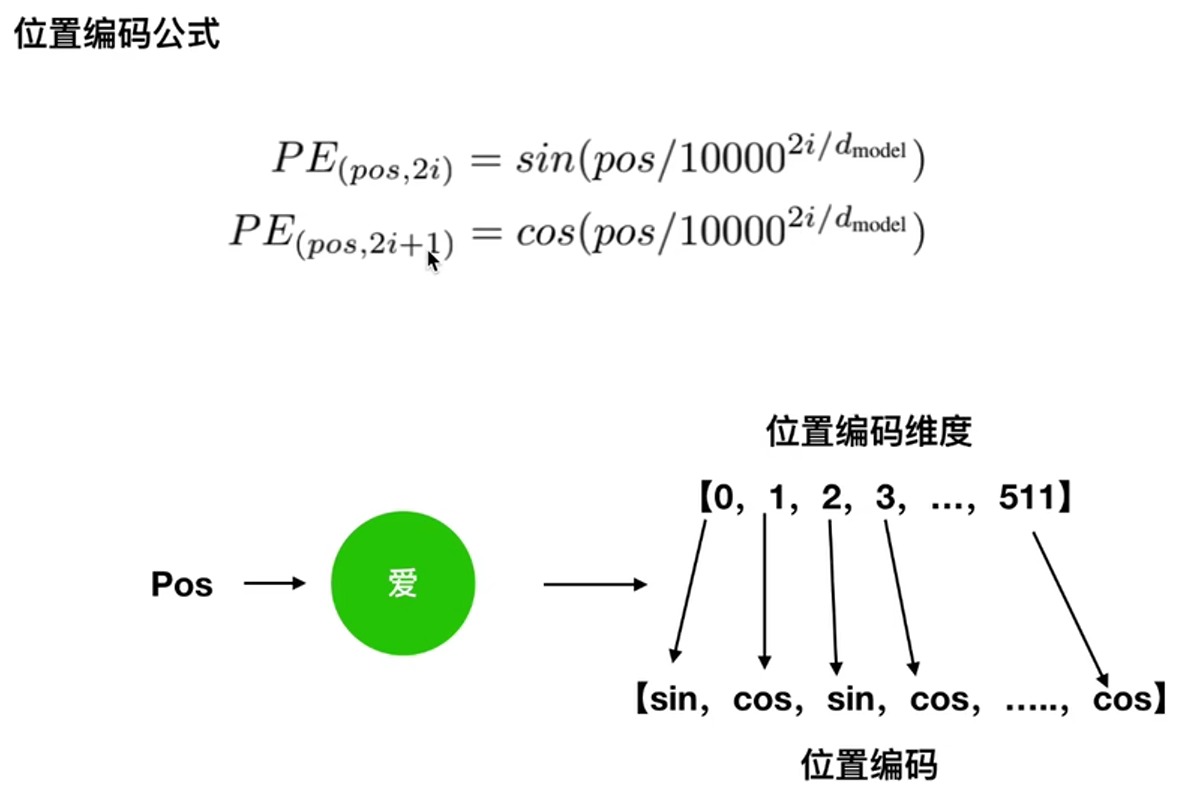

位置编码

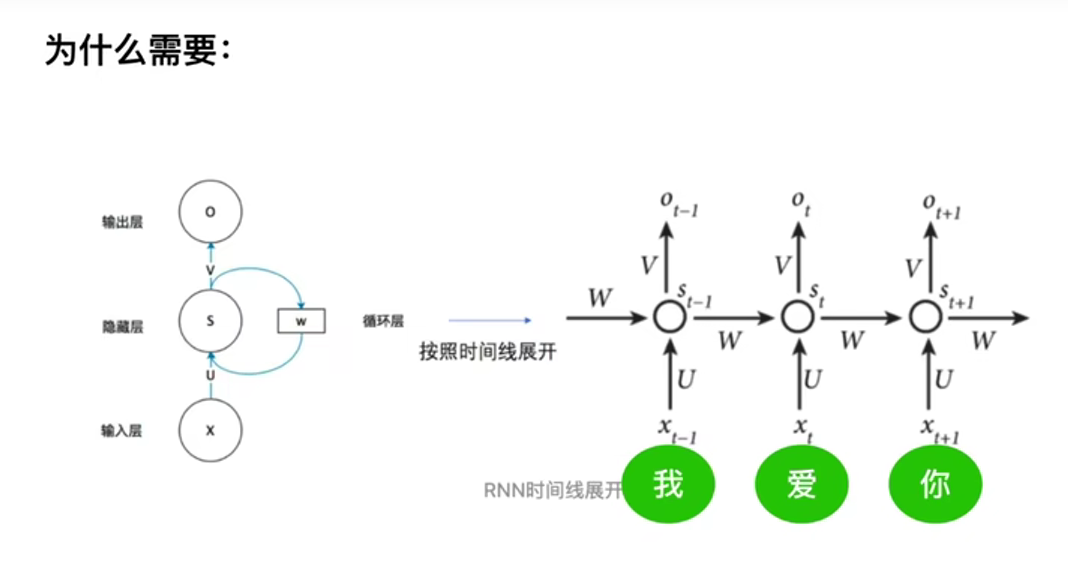

知识点:RNN梯度消失是总的梯度受近距离梯度的主导,远距离梯度的消失 (就是如果句子太长,RNN无法保留前面的信息)。

**为什么需要位置编码:**因为RNN是串行输入各个字符的,而Transformer是并行、一起输入的,需要记录一下字符的位置信息。

pos指的是"爱"这个单词在句子中的位置,position。i为0-512,是embedding的序号。