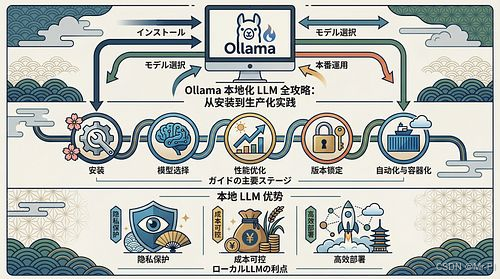

Ollama 本地化 LLM 全攻略:从安装到生产化实践

-

- [0. 先选路线:你部署的不是一个工具,而是一种"运行形态"](#0. 先选路线:你部署的不是一个工具,而是一种“运行形态”)

-

- [路线 A(轻量快速):直接 CLI + 本地模型(推荐初学者)](#路线 A(轻量快速):直接 CLI + 本地模型(推荐初学者))

- [路线 B(工程化路线):CLI + API + 容器化 + 集成开发/应用](#路线 B(工程化路线):CLI + API + 容器化 + 集成开发/应用)

- [1. 为什么要本地部署 Ollama?(核心价值)](#1. 为什么要本地部署 Ollama?(核心价值))

- [2. 你需要的"工程链路"(Mermaid 图)](#2. 你需要的“工程链路”(Mermaid 图))

- [3. 路线 A:本地快速部署(CLI)](#3. 路线 A:本地快速部署(CLI))

-

- [3.1 系统 & 环境准备](#3.1 系统 & 环境准备)

- [3.2 拉取 & 运行模型](#3.2 拉取 & 运行模型)

- [4. 成果转向工程化(路线 B)](#4. 成果转向工程化(路线 B))

-

- [4.1 版本 & 兼容基线](#4.1 版本 & 兼容基线)

- [4.2 自动化安装 + 自检脚本](#4.2 自动化安装 + 自检脚本)

- [4.3 容器化部署(Docker / Compose)](#4.3 容器化部署(Docker / Compose))

- [5. 集成开发体验:VS Code / Continue](#5. 集成开发体验:VS Code / Continue)

- [6. 生产部署注意事项](#6. 生产部署注意事项)

-

- [6.1 HTTP API & 版本锁定](#6.1 HTTP API & 版本锁定)

- [6.2 性能与资源管理](#6.2 性能与资源管理)

- [7. 故障定位 & 调试顺序(工程思维)](#7. 故障定位 & 调试顺序(工程思维))

- [8. 安全 & 风险](#8. 安全 & 风险)

- [总结:Ollama 的工程可用性](#总结:Ollama 的工程可用性)

你是否想把大型语言模型(LLM)放在本地运行,而非依赖 OpenAI/云服务?

或者刚接触 Ollama,不知道如何构建可维护、可复现、可扩展的本地 AI 环境?

我先把一个"反直觉结论"放在最前面:

Ollama 安装不是门槛,真正的挑战是"把本地AI从实验变成工程可交付的产品",包括模型选择、性能优化、版本锁定、自动化验证与容器化。

下面这篇我按"工程交付"路径重写:不追求花哨,而是给你一套 可复用、可回滚、可版本化、生产可用 的路线图。(Pinggy)

0. 先选路线:你部署的不是一个工具,而是一种"运行形态"

Ollama 本地 LLM 的部署分为两条主路线(你可以理解为"轻量快速"和"生产稳定"):

路线 A(轻量快速):直接 CLI + 本地模型(推荐初学者)

这是最直接的起步方式:安装 Ollama + 拉取模型 + 命令行运行 。

特点是方便、快速,可以马上看到效果。

示例命令:

bash

ollama pull gemma3:4b

ollama run gemma3:4b适合快速验证、桌面开发、个人项目。(Pinggy)

路线 B(工程化路线):CLI + API + 容器化 + 集成开发/应用

这个路径适合把 Ollama 做成可重复交付的生产级组件:

- 稳定版本锁定(模型 & 工具 & Dockerfile)

- 自动化安装脚本 / 自检脚本

- 容器化部署(Docker/Compose/K8s)

- Code Assistant 与前端集成

优点是可维护、可升级、可回滚,适合团队协作。后面我会详细展开。

1. 为什么要本地部署 Ollama?(核心价值)

我总结成一句话:

本地 LLM 带来:隐私 + 无订阅 + 低延迟 + 可定制 + 生产可控 。(Thunder Compute)

具体落地价值:

- 隐私保护:不外发用户数据,企业敏感信息不离网。

- 成本可控:省去按调用付费/依赖第三方订阅。

- 离线工作:网络不稳定或断网环境,不影响服务。

- 自定义模型推理:可优化 quantization、上下文长度、工具调用。

- 可扩展到生产服务:通过 API + 容器化,可集成到微服务体系。

2. 你需要的"工程链路"(Mermaid 图)

下面这张图是我在写工程化部署时常用的定位链路:

环境准备 / 硬件检测

命令行安装 Ollama

模型拉取与版本锁定

API 服务化 / REST 接口

容器化部署 / Docker Compose

自动化自检 & CI/CD 集成

前端/IDE 集成(VSCode, Continue)

整个链路对应的关键成果是:

可执行资产(脚本/镜像/版本矩阵)+ 自动化验证 + 可集成服务化能力。

3. 路线 A:本地快速部署(CLI)

这里不啰嗦,直接给你最简可工作的步骤:

3.1 系统 & 环境准备

支持平台:Windows / macOS / Linux 。Ollama 官方提供了跨平台安装包。(CSDN博客)

- Windows: 双击安装或使用 ZIP 包部署。

- macOS: 官方 pkg / Brew。

- Linux: 包 or CLI ZIP 解压运行。

验证安装

bash

ollama --version3.2 拉取 & 运行模型

Ollama 官方库支持 100+ 模型 ,包括 Llama 3、Gemma3、Phi‑3、Codellama、Qwen 系列等,覆盖文本、代码、视觉等任务。(skywork.ai)

bash

# 拉取模型

ollama pull llama3.3:8b

# 运行

ollama run llama3.3:8b特点

- 支持大模型与轻量模型混合运行

- 支持 quantized 版本加速(在硬件受限时也能跑)(Pinggy)

4. 成果转向工程化(路线 B)

如果你要把 Ollama 用在项目/团队/服务环境里,下面是你必须补齐的三张"工程护栏":

4.1 版本 & 兼容基线

写一份 Baseline 文档,格式示例:

text

Ollama Baseline:

- Ollama CLI: v1.x.y

- 拉取模型: llama3.3:8b (quantized)

- 系统: Ubuntu 22.04

- Docker: 24.0这一份 Baseline 是团队成员共享的"工程合同"。

4.2 自动化安装 + 自检脚本

一个简单的 install.sh:

bash

#!/bin/bash

ollama pull llama3.3:8b

ollama pull gemma3:4b

ollama list一个自检 check.sh:

bash

#!/bin/bash

if ollama list | grep llama3.3:8b; then

echo "模型已安装"

else

echo "需要重新拉取模型"

fi

ollama run llama3.3:1 -q "Hello world"这样每次部署后跑一遍,就知道系统是否健康。

4.3 容器化部署(Docker / Compose)

Dockerfile 示例

dockerfile

FROM ollama/ollama:latest

COPY . /app

WORKDIR /app

CMD ["ollama", "serve", "--model", "llama3.3:8b"]docker‑compose.yml 示例

yaml

version: '3'

services:

ollama:

build: .

ports:

- "11434:11434"

restart: always这样你可以把本地 LLM 变成一个可水平扩展的服务。

5. 集成开发体验:VS Code / Continue

你可以把 Ollama 的本地模型直接接入开发环境,提升代码/文档智能提示能力。

如 VS Code + Continue 配置通常需要指向本地 API:

json

{

"apiBase": "http://localhost:11434/",

"provider": "ollama",

"model": "codellama:7b"

}集成后你可以实现:

- 智能补全

- 代码生成

- 多轮对话辅助开发

不再依赖云端服务。(Keyhole Software)

6. 生产部署注意事项

这些在生产环境里必考:

6.1 HTTP API & 版本锁定

用 Ollama Serve 暴露 API:

bash

ollama serve --host 0.0.0.0 --model llama3.3:8b在生产环境中务必将模型版本锁定,避免意外升级。(CSDN博客)

6.2 性能与资源管理

- 小模型(≤4B):可在普通服务器或笔记本上快速运行

- 中模型(7B‑12B):建议 GPU + 16GB RAM

- 大模型(≥30B) :需要高端 GPU 或 Ollama 的 Cloud/Offload 支持(skywork.ai)

7. 故障定位 & 调试顺序(工程思维)

如果遇到问题,按这个顺序定位:

- CLI 层 :

ollama list是否显示模型 - API 层 :

curl http://localhost:11434/api/chat是否可连通 - 性能瓶颈:检查显存、CPU 饱和情况

- 模型响应:用简单 prompt 验证模型是否能执行

8. 安全 & 风险

本地部署带来的风险常被忽视:

- 默认无认证暴露服务风险

- 错误配置可能导致数据泄露

- 在未经隔离的网络上暴露端口存在攻击面

建议:

- 在生产环境启用认证

- 部署反向代理 + TLS

- 仅在内网访问 API

这些都是现实工程中必须护栏。(TechRadar)

总结:Ollama 的工程可用性

Ollama 不只是一个 CLI 工具,它正在成为本地化 AI 部署的真实基础设施:

可以做到离线、隐私、无订阅、易用,同时具备工程可扩展性。

不过它的成熟度在 CLI 体验更强,而在生产高并发服务化上,需要结合容器/自动化/API 管理一起工程化处理。(Pinggy)