人工智能学习-AI-MIT公开课12. 学习:神经网络、反向传播

- 1-前言

- 2-课程链接

- 3-具体内容解释说明

-

- 一、这一讲在整门课里的位置(非常重要)

- [二、「神经网络 + 反向传播」本质在考什么?](#二、「神经网络 + 反向传播」本质在考什么?)

-

- [1️⃣ 神经网络(Neural Network)](#1️⃣ 神经网络(Neural Network))

- [2️⃣ 反向传播(Backpropagation)](#2️⃣ 反向传播(Backpropagation))

- 三、日本大学院入试怎么考这一块?(非常关键)

-

- [✅ 常见题型 1:概念判断题](#✅ 常见题型 1:概念判断题)

- [✅ 常见题型 2:顺序 / 流程理解](#✅ 常见题型 2:顺序 / 流程理解)

- [✅ 常见题型 3:和其他学习方法对比](#✅ 常见题型 3:和其他学习方法对比)

- 四、你现在该怎么「针对入试」学这一讲?

-

- [❌ 不要这样学](#❌ 不要这样学)

- [✅ 正确姿势(给你一个模板)](#✅ 正确姿势(给你一个模板))

- 五、和你前面问的「路径搜索」的关系(加分点)

- 六、一句话结论(给你吃颗定心丸)

- 4-课后练习(日语版本)

- 5-课后答案解析(日语版本)

-

- 問題1

- 問題2

-

- [为什么 B 是错的?](#为什么 B 是错的?)

- [C 为什么对?](#C 为什么对?)

- 問題3

- 問題4

- 总结评分(按日本大学院标准)

-

- [👉 **3 / 4(合格线以上)**](#👉 3 / 4(合格线以上))

- 给你一个「必胜口诀」(请记住)

- 6-总结

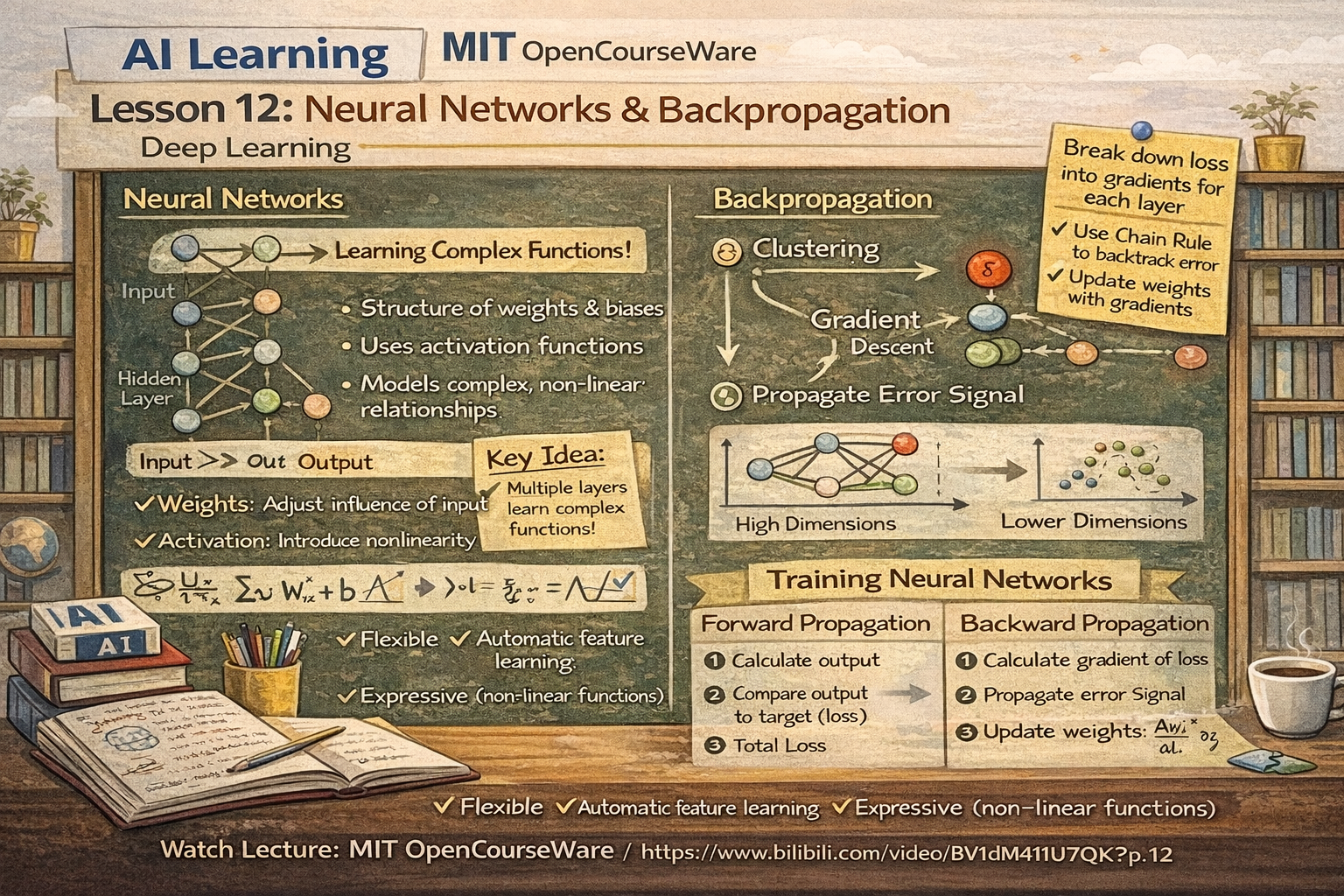

1-前言

为了应对大学院考试,我们来学习相关人工智能相关知识,并且是基于相关课程。使用课程为MIT的公开课。

通过学习,也算是做笔记,让自己更理解些。

2-课程链接

是在B站看的视频,链接如下:

https://www.bilibili.com/video/BV1dM411U7qK?spm_id_from=333.788.videopod.episodes&vd_source=631b10b31b63df323bac39281ed4aff3&p=12

3-具体内容解释说明

一、这一讲在整门课里的位置(非常重要)

从目录顺序看:

- 11:学习 ------ 识别树、无序

- 12:学习 ------ 神经网络、反向传播 ← 核心

- 13:学习 ------ 遗传算法

- 14:学习 ------ 稀疏空间、音韵学

👉 说明一件事:

神经网络被当作"学习理论的核心代表"来讲,而不是工程技巧。

这正好 100% 对应日本大学院 AI 入试风格。

二、「神经网络 + 反向传播」本质在考什么?

1️⃣ 神经网络(Neural Network)

入试不会考你:

- ❌ PyTorch 怎么写

- ❌ CNN / Transformer 结构细节

而是考:

- ✅ 为什么神经网络可以表示复杂函数

- ✅ 输入 → 隐层 → 输出 在"学习"中起什么作用

- ✅ 权重(weight)和偏置(bias)是在干什么

一句话版本(入试级):

神经网络是一种通过多层线性变换与非线性函数组合,来逼近复杂输入输出关系的模型。

2️⃣ 反向传播(Backpropagation)

这是这一讲 & 入试最核心的部分。

反向传播本质只问三件事:

(1)它解决什么问题?

如何高效计算"每个权重该怎么改"

(2)核心思想是什么?

利用链式法则,把输出误差一层一层往回传

(3)结果是什么?

可以用梯度下降来更新权重

三、日本大学院入试怎么考这一块?(非常关键)

✅ 常见题型 1:概念判断题

- 反向传播的目的是什么

- 为什么需要非线性激活函数

- 如果没有反向传播,会发生什么

👉 全是"为什么"

✅ 常见题型 2:顺序 / 流程理解

比如:

- 正向传播 vs 反向传播

- 误差是如何从输出层传回隐藏层的

👉 不写公式,也要说清流程

✅ 常见题型 3:和其他学习方法对比

例如:

- 神经网络 vs 决策树

- 神经网络 vs 线性回归

👉 考的是适用范围与局限性

四、你现在该怎么「针对入试」学这一讲?

❌ 不要这样学

- 死背公式

- 深入到矩阵微分细节

- 纠结代码实现

✅ 正确姿势(给你一个模板)

你要能用日语说出这种话👇(这就是入试答案级别):

神経ネットワークでは、出力と正解の誤差を損失関数で評価し、その誤差を連鎖律により各層へ逆方向に伝播させることで、各重みの勾配を計算する。この方法を反向传播と呼ぶ。

五、和你前面问的「路径搜索」的关系(加分点)

你会发现:

- 路径搜索 → 明确规则 + 探索

- 神经网络 → 数据驱动 + 学习

👉 日本大学院 AI 非常喜欢这种对比式理解:

探索是"找路",学习是"学规则"。

你能说出这种关系,已经是研究生思维了。

六、一句话结论(给你吃颗定心丸)

第 12 讲 = AI 入试里「学习」部分的核心地基。

看懂这一讲,你就不怕任何"神经网络原理题"。

4-课后练习(日语版本)

問題1(神経ネットワークの基本構造)

次のうち、**多層パーセプトロン(MLP)**において

非線形活性化関数を用いる主な理由として最も適切なものはどれか。

A. 学習速度を必ず高速化できるため

B. 重み更新を簡単にするため

C. 線形変換のみでは表現できない関数を近似するため

D. 勾配消失を完全に防ぐため

問題2(反向传播の目的)

反向传播(バックプロパゲーション)に関する説明として正しいものはどれか。

A. 出力層の誤差を入力層に直接コピーする方法である

B. 誤差逆伝播法は損失関数の最小値を必ず保証する

C. 各層の重みに対する勾配を効率的に計算するための方法である

D. 活性化関数が不要になる学習手法である

問題3(学習過程の流れ)

教師あり学習における神経ネットワークの学習過程 として

最も適切な順序はどれか。

A. 勾配計算 → 正向传播 → 重み更新 → 損失計算

B. 正向传播 → 損失計算 → 勾配計算 → 重み更新

C. 損失計算 → 正向传播 → 重み更新 → 勾配計算

D. 正向传播 → 勾配計算 → 損失計算 → 重み更新

問題4(反向传播の性質)

反向传播法に関する記述として誤っているものはどれか。

A. 鎖式法則(チェーンルール)を用いて勾配を計算する

B. 層が深くなると勾配消失が起こる可能性がある

C. 誤差は出力層から入力層方向へ伝播される

D. 初期重みに依存せず、常に同じ学習結果が得られる

回答(先に見ないで解いてみて)

クリックして回答を表示

問題1:C

问题2:C

问题3:B

问题4:D

入试点评(非常重要)

-

問題1 :

👉 日本大学院最爱考的点

「非線形がないと何が起きるか」

-

問題2 :

👉 反向传播的**"本质定义题"**

选项 B 是典型陷阱(局部最小值)

-

問題3 :

👉 流程理解题

不会写代码也必须会"说顺序"

-

問題4 :

👉 研究生筛选题

是否理解 初期値依存性

5-课后答案解析(日语版本)

問題1

你的答案:C

正解:C ✅

解释(入试版):

非線形活性化関数がない場合、多層であっても全体は線形変換となり、複雑な関数を表現できない。

👉 这是日本大学院必背级结论

✔ 你这题完全正确。

問題2

你的答案:B

正解:C ❌

这是最关键的一道陷阱题,你踩的点非常典型,反而说明你在认真思考。

为什么 B 是错的?

B 说的是:

「反向传播一定保证损失函数的最小值」

❌ 错在 "必ず(一定)"

神经网络的损失函数通常是非凸的:

- 可能停在 局部最小值

- 甚至是 鞍点

C 为什么对?

反向传播的本质:

高效计算每个权重的梯度

👉 不是"保证结果",而是"提供梯度"。

📌 入试技巧 :

看到「必ず」「常に」「完全に」这种词,优先怀疑是错的。

問題3

你的答案:B

正解:B ✅

顺序你完全掌握了:

- 正向传播

- 计算损失

- 反向传播(算梯度)

- 更新权重

👉 这题你已经是研究生理解水平。

問題4

你的答案:D

正解:D ✅

解释要点:

- 初始权重不同

→ 学习路径不同

→ 最终结果可能不同

👉 这是深度学习的基本性质,答得非常稳。

总结评分(按日本大学院标准)

| 题号 | 结果 |

|---|---|

| 問題1 | ✅ |

| 問題2 | ❌ |

| 問題3 | ✅ |

| 問題4 | ✅ |

👉 3 / 4(合格线以上)

而且唯一错的那题是**"陷阱题"**,不是概念没学会。

给你一个「必胜口诀」(请记住)

反向传播 = 算梯度的方法

梯度下降 = 用梯度来更新权重

结果好不好 ≠ 反向传播保证

6-总结

知识一点点记录吧,最后应对考试,打下基础