💎 本文价值提示

阅读时长:约 8 分钟

核心收获:

- 打破壁垒:从大数据视角解构 Milvus 架构,你会发现这全是你的"老熟人"。

- 实战选型:深度对比 Milvus 与 Elasticsearch 8.0+,掌握企业级落地的决策逻辑。

- 架构思维:理解从"玩具级 Demo"到"生产级集群"的质变关键。

适用人群:正在从大数据/后端转型 AI Infra、RAG 架构师的技术人员。

👋 前言:欢迎回到"舒适区"

大家好!在上一期的 《Python 高级工程化》 和 《大模型基础理论》 专题中,我们已经打好了地基。而在本专题的第一篇,我们通过 Chroma 跑通了 RAG 的最小闭环(MVP)。

很多同学在后台留言:"跑个 Demo 很简单,但数据量一上亿,查询就崩,内存就爆,这咋整?"

恭喜你,问到了点子上。

如果说跑 Demo 是 AI 算法工程师的"游乐场",那么大规模、高并发、分布式 的向量检索,就是我们大数据工程师的 "核心战场"。

今天,我们将进入RAG 架构与数据工程------向量数据库专项计划的第二阶段 。我们将暂时放下 Python 脚本,拿起我们最擅长的武器------分布式架构 ,去解剖两个生产级的重量级选手:Milvus 和 Elasticsearch。

你会惊讶地发现:原来向量数据库的底层,竟然长得和 Kafka、HDFS 这么像! 😲

🏗️ 一、Milvus:披着 AI 外衣的大数据组件

如果你第一次看 Milvus 的架构图,可能会被那一堆 Coord、Node、Proxy 搞晕。但作为大数据老兵,请允许我为你戴上一副 "大数据透视镜"。

Milvus 是典型的云原生(Cloud-Native)架构,它的核心设计哲学是存储与计算分离 ,以及控制平面与数据平面分离。

1.1 架构映射:找找"老朋友"

让我们用 Hadoop/Kafka 的概念来翻译 Milvus 的组件:

- Proxy (代理层) ➡️ Gateway / Router

- 它是集群的门户,负责接收请求、聚合结果。就像 Nginx 或数据库中间件,它不存数据,只管路由。

- Coord (协调服务) ➡️ Master / NameNode / Zookeeper Controller

RootCoord、DataCoord、QueryCoord。它们是大脑,负责分配任务、管理元数据。这不就是 HDFS 的 NameNode 吗?

- Worker Node (执行节点) ➡️ DataNode / RegionServer

DataNode(负责写)、QueryNode(负责查)、IndexNode(负责建索引)。它们是干苦力的,且无状态(Stateless),随时可以扩缩容。

- Log Broker (消息骨干) ➡️ Kafka / Pulsar

- 这是 Milvus 最精妙的设计! 它用消息队列(默认 Pulsar)来做 WAL(预写日志)。一切操作皆消息,保证了数据的最终一致性。

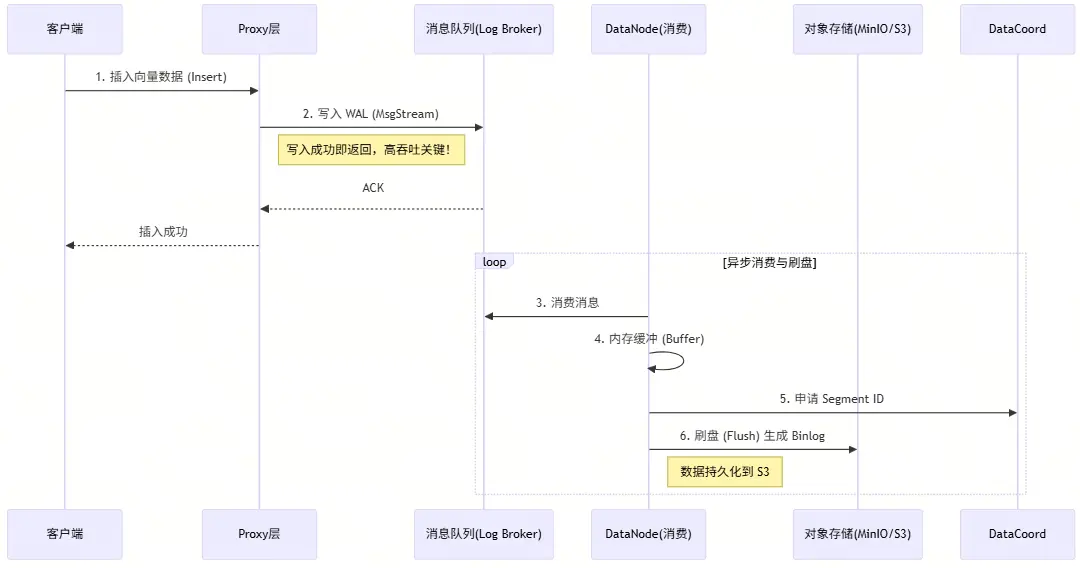

1.2 核心数据流:WAL 与 刷盘

为什么说 Milvus 适合大数据工程师?因为它解决"数据丢失"和"高并发写入"的思路,和我们做数仓 ETL 是一模一样的。

请看下面的数据写入流程图:

🧐 架构师视角的解读:

- 写操作是异步的:客户端只要把数据塞进消息队列(Log Broker)就算成功。这保证了极高的写入吞吐量(Write Throughput)。

- 流批一体 :数据先在内存(Growing Segment),达到阈值后刷写到对象存储(Sealed Segment)。这不就是我们熟悉的 LSM-Tree 或者 Hudi/Iceberg 的逻辑吗?

- 存算分离:数据最终存在 S3/MinIO 上,计算节点(QueryNode)如果挂了,起个新的拉取数据即可,不丢数据。

1.3 部署实战:Kubernetes 是标配

在生产环境,你不会用 docker-compose 跑 Milvus,你会用 K8s。 作为大数据工程师,你对 Helm Charts、Pod 资源限制、PVC 挂载早已烂熟于心。

- 挑战:AI 工程师可能不懂为什么 Etcd 挂了整个集群就瘫痪了。

- 你的价值 :你可以通过配置 K8s 的

Affinity(亲和性),让计算密集型的IndexNode跑在 GPU 机器上,让 IO 密集型的DataNode跑在高带宽机器上。这就是工程化落地的价值!

🔍 二、Elasticsearch (8.0+):老树发新芽

如果说 Milvus 是为了向量而生的"特种部队",那么 Elasticsearch 就是企业里的"瑞士军刀"。

很多公司的数据本来就在 ES 里(日志、商品信息、用户画像)。如果为了做 RAG,非要引入一套复杂的 Milvus,运维成本(Etcd+Pulsar+MinIO+Milvus)会直接劝退老板。

这时候,Elasticsearch 8.0+ 的 Vector Search 就是你的救命稻草。

2.1 核心特性:dense_vector

在 ES 8.x 中,向量检索不再是插件,而是原生的一等公民。

json

PUT /my-rag-index

{

"mappings": {

"properties": {

"content": { "type": "text" }, // 传统倒排索引

"embedding": {

"type": "dense_vector", // 向量字段

"dims": 1536, // OpenAI 模型维度

"index": true,

"similarity": "cosine" // 余弦相似度

}

}

}

}2.2 倒排索引 vs 向量索引:资源消耗战

作为架构师,你需要清楚 ES 做向量检索的代价。

| 特性 | 倒排索引 (Inverted Index) | 向量索引 (HNSW in ES) |

|---|---|---|

| 原理 | 关键词 -> 文档 ID | 图导航 (Graph Navigation) |

| 内存消耗 | 低 (主要存 Term Dictionary) | 极高 (图结构常驻堆外内存) |

| 查询速度 | 极快 (O(1) ~ O(logN)) | 快,但受限于内存带宽 |

| 准确率 | 100% 精确匹配 | 近似匹配 (Approximate) |

⚠️ 避坑指南 : ES 的 HNSW 索引非常吃内存(Off-heap memory)。如果你在只有 16G 内存的节点上存 1000 万条 1536 维的向量,ES 可能会频繁 GC 甚至 OOM。 大数据工程师的直觉 :这时候你需要做索引分片(Sharding)规划,或者通过Force Merge减少 Segment 数量,这都是我们的拿手好戏。

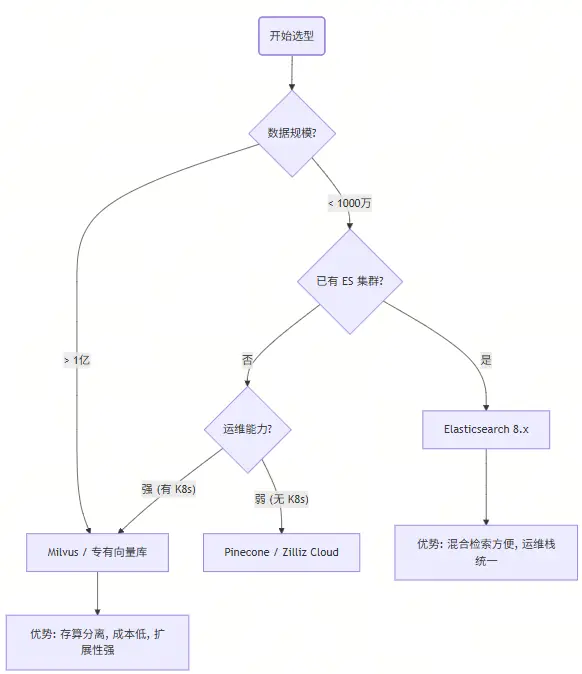

⚔️ 三、巅峰对决:Milvus vs Elasticsearch

在做架构选型报告时,老板问你:"为什么选 A 不选 B?" 你可以直接甩出这张对比图:

- 选 Milvus:当你数据量极大(亿级),或者需要极致的向量检索性能,且团队有 K8s 运维能力。

- 选 Elasticsearch:当你数据量中等(千万级),且强依赖"关键词+向量"的混合检索(Hybrid Search),或者不想引入新组件。

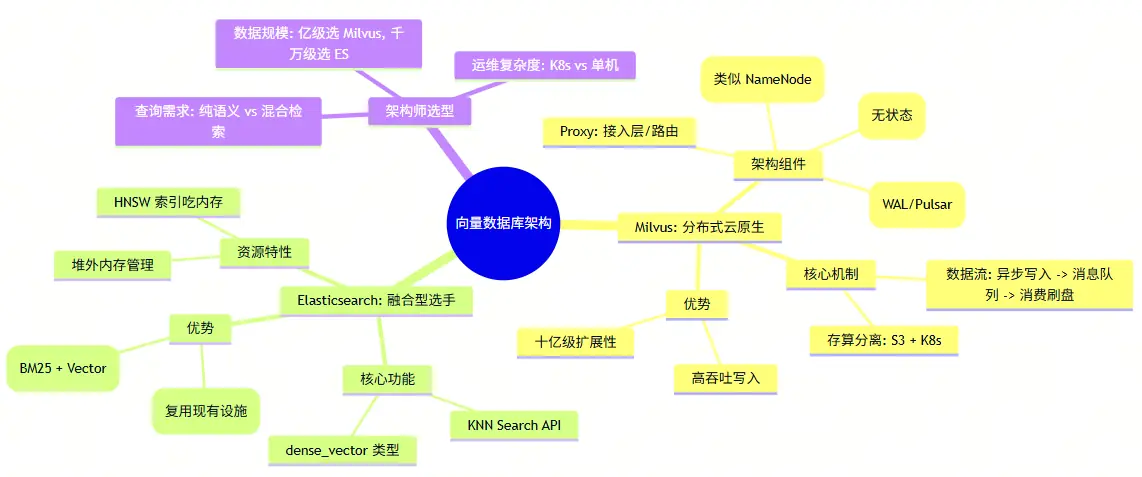

🧠 四、总结与思维导图

从大数据工程师转型 AI 架构师,不要丢掉你的"旧锤子",因为 AI 的世界里到处都是"钉子"。

Milvus 的架构设计证明了:AI 系统本质上还是分布式数据系统。你对一致性哈希、WAL、LSM-Tree、Sharding 的理解,就是你驾驭 RAG 架构的内功心法。

在下一阶段,我们将深入 索引算法(HNSW, IVF, DiskANN) 的底层。那是纯算法与数据结构的暴力美学,敬请期待!

🗺️ 本文核心知识点思维导图

💬 互动话题

你的公司目前的数据基础设施是怎样的?

- A. 全套 Hadoop/Spark/Kafka,准备上 Milvus。

- B. 只有 MySQL/ES,想直接用 ES 做向量搜索。

- C. 还在用 Python 本地跑 Chroma/Faiss,经常内存溢出。

欢迎在评论区回复 A、B 或 C,或者分享你在搭建向量库时遇到的"坑",我会挑选典型问题在下一期文章中解答!

👉 下一篇预告: 我们将硬核拆解 HNSW 和 IVF 算法,教你如何通过调整参数,在"速度"与"精度"之间跳出完美的探戈。

喜欢这篇文章吗?记得点赞、在看、转发,带你的大数据兄弟们一起转型 AI 架构师!