Ansible 自动化运维实战:2000+ 节点配置标准化教程

🌸你好呀!我是 lbb小魔仙

🌟 感谢陪伴~ 小白博主在线求友

🌿 跟着小白学Linux/Java/Python

📖 专栏汇总:

《Linux》专栏 | 《Java》专栏 | 《Python》专栏

- [Ansible 自动化运维实战:2000+ 节点配置标准化教程](#Ansible 自动化运维实战:2000+ 节点配置标准化教程)

-

- 一、大规模节点配置标准化实施流程

-

- [1.1 实施流程总览(Mermaid流程图)](#1.1 实施流程总览(Mermaid流程图))

- [1.2 各环节核心目标](#1.2 各环节核心目标)

- 二、核心配置代码段实战

-

- [2.1 动态Inventory示例(基于CMDB API)](#2.1 动态Inventory示例(基于CMDB API))

- [2.2 Roles目录结构示例](#2.2 Roles目录结构示例)

- [2.3 group_vars与host_vars最佳实践](#2.3 group_vars与host_vars最佳实践)

-

- [2.3.1 group_vars配置(按环境与分组拆分)](#2.3.1 group_vars配置(按环境与分组拆分))

- [2.3.2 host_vars配置(特殊节点个性化变量)](#2.3.2 host_vars配置(特殊节点个性化变量))

- [2.4 ansible.cfg大规模节点优化配置](#2.4 ansible.cfg大规模节点优化配置)

- [2.5 典型Playbook示例(NTP+日志轮转+安全基线)](#2.5 典型Playbook示例(NTP+日志轮转+安全基线))

- 三、关键策略:幂等性、可审计性与滚动更新

-

- [3.1 幂等性保障](#3.1 幂等性保障)

- [3.2 可审计性设计](#3.2 可审计性设计)

- [3.3 滚动更新策略](#3.3 滚动更新策略)

- 四、性能调优与常见陷阱规避

-

- [4.1 性能调优建议](#4.1 性能调优建议)

-

- [4.1.1 控制节点优化](#4.1.1 控制节点优化)

- [4.1.2 节点端优化](#4.1.2 节点端优化)

- [4.2 常见陷阱规避](#4.2 常见陷阱规避)

- 五、总结

在大规模服务器集群(2000+节点)运维场景中,配置标准化是保障系统稳定性、降低运维成本的核心手段。Ansible 凭借其无代理架构、声明式语法及强大的可扩展性,成为大规模节点配置标准化的首选工具。本文将从实施流程、核心配置、关键策略及性能调优等维度,深入讲解如何基于 Ansible 实现大规模节点的配置标准化落地,为中高级运维工程师提供可直接复用的实战方案。

一、大规模节点配置标准化实施流程

大规模节点配置标准化的核心目标是实现"环境一致、配置可追溯、操作可复用",基于 Ansible 的实施流程需兼顾效率、稳定性与可扩展性,完整流程涵盖Inventory构建、角色设计、变量管理、Playbook开发、执行与验证、迭代优化六大环节,各环节环环相扣,确保标准化落地的完整性。

1.1 实施流程总览(Mermaid流程图)

是

否

需求梳理与规范定义

动态Inventory构建

角色(Roles)设计与开发

变量分层管理(group_vars/host_vars)

Playbook编写与幂等性验证

大规模执行策略配置(滚动更新/并行优化)

执行部署与实时监控

结果验证与审计日志收集

是否达标

配置固化与迭代维护

定期巡检与配置漂移修正

1.2 各环节核心目标

-

需求梳理与规范定义:明确服务器基线配置(如时区、内核参数)、应用依赖、安全标准(如端口限制、用户权限)等,输出标准化配置手册,作为后续开发的依据。

-

动态Inventory构建:解决大规模节点动态增减问题,通过对接云API或CMDB系统,自动同步节点信息,避免静态Inventory维护成本过高。

-

角色设计:按功能模块拆分角色(如NTP、日志轮转、安全基线),实现配置复用与模块化管理,降低Playbook复杂度。

-

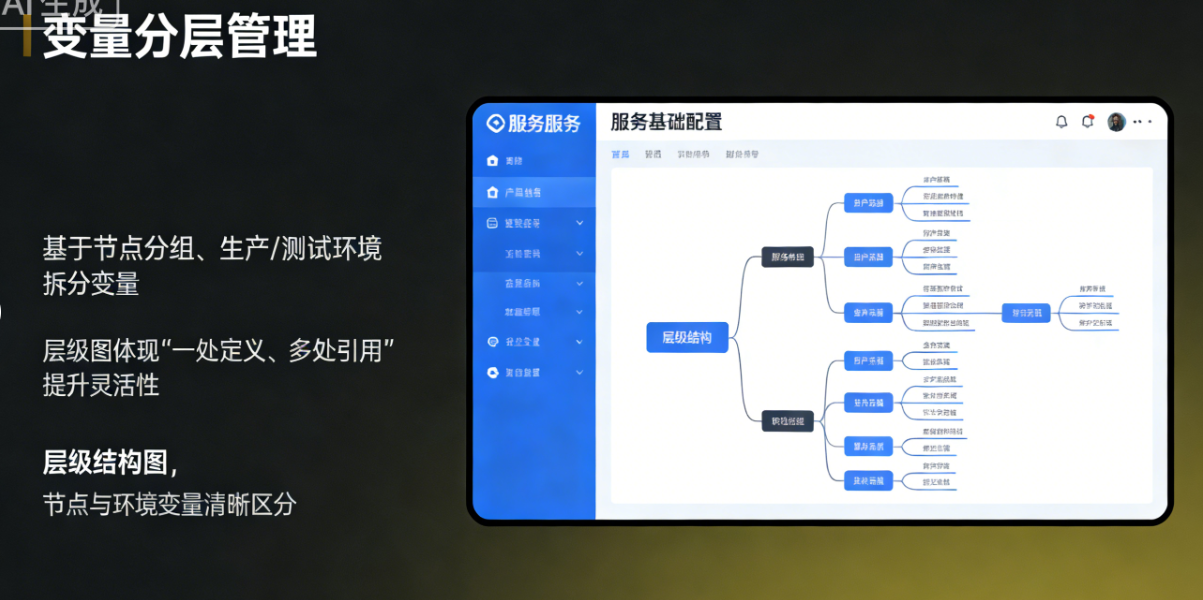

变量分层管理:基于节点分组、环境(生产/测试)拆分变量,实现"一处定义、多处引用",提升配置灵活性。

-

执行与验证:结合大规模场景优化执行策略,通过自动化校验与人工复核确保配置达标,同时记录审计日志。

-

迭代维护 :定期巡检配置漂移情况,基于业务变化更新标准化规则,形成闭环管理。

二、核心配置代码段实战

2.1 动态Inventory示例(基于CMDB API)

大规模节点环境中,静态Inventory无法应对节点动态增减,需通过动态脚本对接CMDB系统或云平台API,实时获取节点列表与分组信息。以下为Python编写的动态Inventory脚本,支持从CMDB API拉取节点数据,按业务线分组。

python

#!/usr/bin/env python3

import requests

import json

# CMDB API配置

CMDB_API_URL = "http://cmdb.example.com/api/v1/servers"

CMDB_API_TOKEN = "your-api-token"

def get_cmdb_servers():

"""从CMDB获取服务器列表"""

headers = {"Authorization": f"Token {CMDB_API_TOKEN}"}

response = requests.get(CMDB_API_URL, headers=headers, timeout=10)

response.raise_for_status()

return response.json()

def build_inventory(servers):

"""构建Ansible Inventory结构"""

inventory = {

"_meta": {"hostvars": {}},

"all": {"children": []},

"web_servers": {"hosts": []},

"db_servers": {"hosts": []},

"cache_servers": {"hosts": []}

}

for server in servers:

hostname = server["hostname"]

ip = server["private_ip"]

business_line = server["business_line"]

# 存储主机变量(如操作系统、主机名)

inventory["_meta"]["hostvars"][ip] = {

"ansible_host": ip,

"ansible_user": "ops",

"os_type": server["os_type"],

"hostname": hostname

}

# 按业务线分组

if business_line == "web":

inventory["web_servers"]["hosts"].append(ip)

elif business_line == "db":

inventory["db_servers"]["hosts"].append(ip)

elif business_line == "cache":

inventory["cache_servers"]["hosts"].append(ip)

# 补充子组到all节点

inventory["all"]["children"] = ["web_servers", "db_servers", "cache_servers"]

return inventory

if __name__ == "__main__":

try:

servers = get_cmdb_servers()

inventory = build_inventory(servers)

print(json.dumps(inventory, indent=2))

except Exception as e:

print(f"Error building inventory: {str(e)}", file=sys.stderr)

sys.exit(1)使用说明:将脚本命名为cmdb_inventory.py,添加可执行权限(chmod +x cmdb_inventory.py),Ansible调用时指定脚本路径即可动态获取节点信息:ansible all -i cmdb_inventory.py -m ping。

2.2 Roles目录结构示例

Roles是Ansible实现模块化配置的核心,通过按功能拆分角色,可实现配置的复用与版本化管理。针对大规模节点配置标准化,建议按"基础配置+应用配置"拆分角色,目录结构如下:

bash

roles/

├── base_init/ # 基础初始化角色(时区、主机名、yum源)

│ ├── defaults/ # 默认变量(低优先级)

│ │ └── main.yml

│ ├── files/ # 静态文件(如yum源配置文件)

│ │ └── CentOS-Base.repo

│ ├── handlers/ # 处理器(如服务重启)

│ │ └── main.yml

│ ├── meta/ # 角色元信息(作者、依赖)

│ │ └── main.yml

│ ├── tasks/ # 核心任务

│ │ └── main.yml

│ ├── templates/ # 模板文件(如hostname模板)

│ │ └── hostname.j2

│ └── vars/ # 角色变量(高优先级)

│ └── main.yml

├── ntp/ # NTP时间同步角色

│ ├── defaults/

│ ├── files/

│ ├── handlers/

│ ├── tasks/

│ └── templates/

├── logrotate/ # 日志轮转角色

└── security_baseline/ # 安全基线角色(防火墙、用户权限)核心原则:每个角色仅负责单一功能模块,通过meta/main.yml定义依赖关系(如security_baseline依赖base_init),确保角色调用的顺序性。

2.3 group_vars与host_vars最佳实践

大规模节点环境中,变量管理需遵循"分层隔离、最小权限"原则,通过group_vars(分组变量)和host_vars(主机变量)实现配置的精细化控制,优先级从高到低为:host_vars > group_vars > roles/vars > roles/defaults。

2.3.1 group_vars配置(按环境与分组拆分)

创建group_vars目录,按分组创建对应YAML文件,示例如下:

yaml

# group_vars/all.yml (所有节点通用变量)

ntp_servers:

- "ntp1.example.com"

- "ntp2.example.com"

logrotate_retention_days: 7

firewall_default_policy: "drop"

# group_vars/web_servers.yml (Web节点专属变量)

listen_port: 8080

max_open_files: 65535

security_baseline_allow_ports:

- 80

- 443

- 8080

# group_vars/db_servers.yml (数据库节点专属变量)

listen_port: 3306

max_open_files: 102400

security_baseline_allow_ports:

- 3306

- 22

security_baseline_deny_ssh_root: true2.3.2 host_vars配置(特殊节点个性化变量)

针对少数特殊节点(如主数据库节点),通过host_vars定义个性化变量,覆盖分组变量:

yaml

# host_vars/192.168.1.100.yml (主库节点专属配置)

ntp_servers:

- "ntp-master.example.com" # 优先同步主NTP服务器

max_open_files: 204800

security_baseline_allow_ports:

- 3306

- 22

- 9100 # 暴露监控端口2.4 ansible.cfg大规模节点优化配置

默认ansible.cfg配置无法适配2000+节点场景,需针对性优化并行数、管道化、事实缓存等参数,提升执行效率,减少节点负载。

ini

[defaults]

# 并行进程数,根据控制节点CPU核心数调整(建议CPU核心数*2,最大不超过500)

forks = 200

# 关闭SSH密钥检查(大规模节点统一密钥时启用)

host_key_checking = False

# 超时时间,避免节点响应慢导致任务挂起

timeout = 15

# 事实缓存配置,减少重复收集节点信息的开销

gathering = smart

fact_caching = jsonfile

fact_caching_connection = /var/cache/ansible/facts

fact_caching_timeout = 86400 # 缓存有效期1天

# 日志配置,开启审计日志

log_path = /var/log/ansible/ansible.log

# 模块路径,自定义模块存放目录

library = /etc/ansible/modules

[privilege_escalation]

# 允许sudo提权

become = True

become_method = sudo

become_user = root

become_ask_pass = False

[ssh_connection]

# 开启管道化,减少SSH连接次数

pipelining = True

# 控制持久连接数与超时时间

control_path = %(directory)s/%%h-%%r

control_path_dir = /tmp/ansible_control_path

ssh_args = -o ControlMaster=auto -o ControlPersist=300s -o StrictHostKeyChecking=no

# 批量复制文件时使用sftp(效率高于scp)

transfer_method = sftp优化说明:forks参数需结合控制节点性能调整,过高易导致控制节点资源耗尽;fact_caching可避免每次执行Playbook都重新收集节点信息,大幅提升执行效率。

2.5 典型Playbook示例(NTP+日志轮转+安全基线)

以下Playbook整合基础配置角色,实现2000+节点的NTP时间同步、日志轮转与安全基线统一部署,兼顾幂等性与可扩展性。

yaml

- name: 大规模节点配置标准化部署

hosts: all

gather_facts: true

become: true

roles:

- role: base_init

tags: [base, init]

- role: ntp

tags: [ntp, time_sync]

- role: logrotate

tags: [logrotate, logs]

- role: security_baseline

tags: [security, baseline]

tasks:

- name: 验证NTP服务状态

ansible.builtin.service_facts:

register: service_status

tags: [ntp, verify]

- name: 确保NTP服务已启动并开机自启

ansible.builtin.assert:

that:

- "'ntpd' in service_status.ansible_facts.services"

- service_status.ansible_facts.services.ntpd.state == "running"

- service_status.ansible_facts.services.ntpd.status == "enabled"

fail_msg: "NTP服务未正常启动"

success_msg: "NTP服务状态正常"

tags: [ntp, verify]

- name: 验证日志轮转配置

ansible.builtin.stat:

path: /etc/logrotate.d/global

register: logrotate_conf

tags: [logrotate, verify]

- name: 确保日志轮转配置已生效

ansible.builtin.assert:

that:

- logrotate_conf.stat.exists

- logrotate_conf.stat.isfile

fail_msg: "日志轮转配置未生效"

success_msg: "日志轮转配置正常"

tags: [logrotate, verify]

- name: 收集安全基线检查结果

ansible.builtin.command: /usr/local/bin/security_check.sh

register: security_check_result

changed_when: false

tags: [security, verify]

- name: 输出安全基线检查结果

ansible.builtin.debug:

msg: "{{ security_check_result.stdout_lines }}"

tags: [security, verify]使用说明:通过tags实现按需执行(如仅部署安全基线:ansible-playbook -i cmdb_inventory.py site.yml --tags security);通过assert模块实现自动化验证,确保配置达标。

三、关键策略:幂等性、可审计性与滚动更新

3.1 幂等性保障

幂等性是Ansible大规模部署的核心要求,确保"多次执行同一Playbook结果一致",避免重复操作导致节点异常。核心实现方法如下:

-

使用状态型模块 :优先使用

copy、service、user等状态型模块,避免直接使用command、shell(如需使用,需通过creates、removes参数控制幂等性)。 -

变量化配置:通过变量定义配置目标状态,避免硬编码,确保每次执行都指向同一目标。

-

when使用条件判断 :针对特殊场景,通过条件判断跳过已执行的任务,示例:when: not ntp_service_running。 -

角色内任务拆分:将复杂任务拆分为细粒度任务,每个任务仅负责单一状态变更,便于控制幂等性。

3.2 可审计性设计

大规模节点环境中,配置变更的可审计性是合规要求的核心,需实现"谁操作、何时操作、操作内容、操作结果"全链路追溯。

-

日志强化 :通过

ansible.cfg开启详细日志,记录每个任务的执行节点、时间、结果,日志文件定期归档,保留90天以上。 -

配置版本控制:将Playbook、Roles、变量文件纳入Git版本控制,每次变更提交时填写清晰的注释(如"优化Web节点防火墙规则"),实现变更追溯。

-

审计结果输出:在Playbook中添加审计任务,收集每个节点的配置变更结果,生成JSON格式审计报告,上传至CMDB系统。

-

权限管控:通过Ansible Tower/AWX实现操作权限分级,普通运维仅能执行预定义Playbook,管理员负责Playbook审核与发布,避免越权操作。

3.3 滚动更新策略

2000+节点全量部署易导致服务雪崩,需采用滚动更新策略,分批次执行配置变更,确保业务连续性。核心实现方式如下:

yaml

- name: 大规模节点滚动更新配置

hosts: web_servers

serial: "20%" # 每次更新20%的节点(可按数量指定,如serial: 100)

max_fail_percentage: 5 # 失败率超过5%则停止更新

gather_facts: true

become: true

roles:

- role: web_config

tags: [web, rolling_update]

pre_tasks:

- name: 将节点从负载均衡移除

ansible.builtin.uri:

url: "http://lb.example.com/api/remove_node"

method: POST

body: '{"node": "{{ ansible_host }}"}'

body_format: json

tags: [lb, pre_task]

post_tasks:

- name: 等待服务启动完成

ansible.builtin.wait_for:

port: "{{ listen_port }}"

delay: 10

timeout: 60

tags: [verify, post_task]

- name: 将节点重新加入负载均衡

ansible.builtin.uri:

url: "http://lb.example.com/api/add_node"

method: POST

body: '{"node": "{{ ansible_host }}"}'

body_format: json

tags: [lb, post_task]策略说明:serial参数控制每次更新的节点数量/比例;max_fail_percentage设置失败阈值,避免故障扩散;通过pre_tasks和post_tasks实现节点在负载均衡中的上下线,确保业务不中断。

四、性能调优与常见陷阱规避

4.1 性能调优建议

4.1.1 控制节点优化

-

硬件配置:CPU核心数≥16,内存≥32GB,硬盘采用SSD(减少日志与缓存IO开销)。

-

系统优化:调整内核参数(

net.core.somaxconn、fs.file-max),提升并发连接能力;关闭不必要的服务(如SELinux、防火墙,需在安全可控环境下)。 -

Ansible优化:开启事实缓存、合理设置

forks参数,使用async/poll实现异步任务执行(如软件包安装)。

4.1.2 节点端优化

-

SSH优化:配置SSH长连接,减少连接建立时间;统一SSH密钥,避免密码认证。

-

模块优化:优先使用原生模块(效率高于自定义脚本);避免在Playbook中执行大量本地命令,减少节点负载。

-

配置预热:首次执行Playbook时,先小批量节点(10-20个)验证,再逐步扩大范围,避免控制节点瞬间压力过大。

4.2 常见陷阱规避

-

陷阱1:事实收集耗时过长

规避方案:开启事实缓存(

fact_caching),使用gather_facts: smart仅收集变更节点的事实;必要时通过setup模块指定收集字段(如仅收集操作系统信息)。 -

陷阱2:并行执行导致节点资源耗尽

规避方案:合理设置

forks参数,避免全量并行;对资源密集型任务(如软件包安装),使用serial分批执行,或通过throttle限制单任务并发数。 -

陷阱3:配置漂移问题

规避方案:定期执行Playbook(如每日凌晨),修正配置漂移;结合监控工具(如Prometheus+Grafana),实时告警配置异常节点。

-

陷阱4:幂等性失效导致配置异常

规避方案:编写Playbook时严格遵循幂等性原则,避免使用无状态命令;每次更新Playbook后,在测试环境验证多次执行结果一致性。

-

陷阱5:日志丢失或审计不完整

规避方案:配置Ansible日志轮转,避免日志文件过大;将审计报告自动上传至CMDB或对象存储,长期留存;开启Git提交校验,确保变更注释清晰。

五、总结

基于Ansible实现2000+节点配置标准化,核心在于"模块化设计、精细化控制、稳定性保障"。通过动态Inventory应对节点动态增减,Roles实现配置复用,分层变量管理提升灵活性,结合幂等性、可审计性与滚动更新策略,可确保大规模部署的安全性与高效性。同时,需针对性优化控制节点与节点端性能,规避常见陷阱,形成"部署-验证-审计-迭代"的闭环管理。

在实际落地过程中,需结合业务场景调整方案(如对接云平台、适配混合架构),不断优化Playbook与角色设计,最终实现大规模节点运维的自动化、标准化与智能化。

📕个人领域 :Linux/C++/java/AI

🚀 个人主页 :有点流鼻涕 · CSDN

💬 座右铭 : "向光而行,沐光而生。"